Nvidia GeForce GTX 1080, le premier GPU 16nm en test !

Pascal et le SMPE pour la VR et le surround

Avec les GPU Maxwell, Nvidia a introduit une fonctionnalité dénommée Multi Projection Acceleration. Elle est à la base de VXGI et VXAO ainsi que du Multi-Resolution Shading qui permet d'optimiser les performances en VR en réduisant la résolution sur les côtés. Le moteur de projection multiple de Maxwell était cependant limité dans le sens où toutes les projections devaient se faire à partir du même point de vue (le VXAO et le VXGI représentant une approche particulière qui peut s'y rattacher).

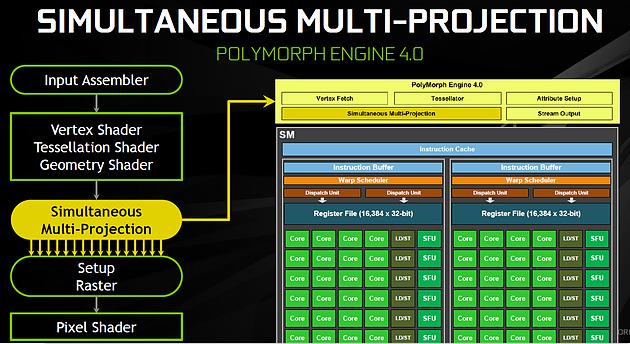

Présent en partie dans le Polymorph Engine et en partie dans le Rasterizer, le SMPE (Simultaneous Multi Projection Engine) des GPU Pascal va plus loin. Cette unité est capable de générer plusieurs projections du flux de géométrie jusqu'à 16, voire jusqu'à 32 dans le cas d'un rendu stéréoscopique.

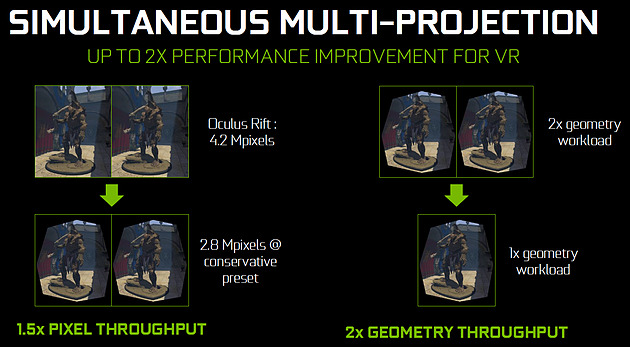

Quelle utilité ? Le meilleur exemple est un rendu VR simple : au lieu de calculer séparément l'image pour chaque oeil, la géométrie peut n'être traitée qu'une fois et projetée ensuite directement, en une seule passe, dans les 2 images. Le SMPE se charge automatiquement de tout cela et de dédoubler les triangles qui doivent l'être. Suivant la complexité de la géométrie, des vertex shaders, de la tessellation, les gains peuvent être plus ou moins conséquents. Cela ne change par contre rien au niveau du calcul des pixels.

Mais le SMPE ne s'arrête pas là et permet également de faire du Lens Matched Shading. Grossièrement il s'agit d'aller encore plus loin que le Multi Resolution Shading en utilisant plusieurs viewports pour simuler une image incurvée qui se rapproche le plus possible de l'image qui sera affichée après déformation pour être adaptée à la lentille. Voici ce que cela donne en image :

[ Rendu classique ] [ Lens Matched Shading ]

Sur la seconde image, on peut deviner à travers la silhouette de l'image rendue les 4 viewports. En retenant une haute qualité, 33% de pixels en moins sont calculés pour un résultat final identique ou très proche après déformation. De base, dans le cas de l'Oculus Rift par exemple, des images de 2.1 MPixels sont déformées (warping) pour pouvoir être vue correctement à travers les lentilles du casque. Après cette déformation, la résolution effective n'est plus que de 1.4 MPixels et le SMPE autorise donc un débit effectif de pixels 50% supérieur.

De quoi autoriser des gains conséquents en VR mais il faudra pour cela un support spécifique de la part des applications. A noter qu'il est possible d'utiliser plus de 4 viewports pour simuler un écran incurvé plus précis, mais cela apporte peu de bénéfices par rapport au coût engendré. Exploiter plus de 4 viewports pourra par contre avoir plus de sens dans le cadre des CAVE (cave automatic virtual environment) ou des dômes.

L'autre utilité concerne les écrans larges incurvés ainsi que les systèmes surrounds inclinés de manière à simuler un tel écran incurvé comme c'est généralement le cas. Actuellement, le rendu se fait assez naïvement en faisant comme si le système d'affichage était une surface plane, ce qui implique un champ de vision trop étroit et des erreurs de projections qui s'amplifient aux extrémités.

[ Rendu surround classique ] [ et avec correction du champ de vision ]

Le SMPE permet d'opérer une projection différente pour chaque écran ou pour chaque zone de l'écran large incurvé de manière à ce que le champ de vision soit correct par rapport à l'angle d'inclinaison et par rapport à la position de l'utilisateur. Nvidia prépare un utilitaire qui permettra de configurer ces systèmes.

2 - GP104 : 7.2 milliards de transistors en 16 nm

3 - Pascal et Async Compute : du mieux ?

4 - Pascal et le SMPE pour la VR et le surround

5 - SLI amélioré, Fast Sync, Moteur vidéo HDR

6 - Spécifications et Direct3D 12

7 - La GeForce GTX 1080 Founders Edition

8 - Protocole de test

9 - Performances théoriques : pixels

10 - Performances théoriques : géométrie

11 - Fermi vs Kepler vs Maxwell vs Pascal

12 - Consommation, efficacité énergétique

13 - Nuisances sonores, températures, photos IR

14 - Benchmark : 3DMark Fire Strike

15 - Benchmark : Anno 2205

16 - Benchmark : Ashes of the Singularity

17 - Benchmark : Battlefield 4

18 - Benchmark : Crysis 3

20 - Benchmark : DOOM

21 - Benchmark : Dying Light

22 - Benchmark : Evolve

23 - Benchmark : Fallout 4

24 - Benchmark : Far Cry Primal

25 - Benchmark : Grand Theft Auto V

26 - Benchmark : Hitman

27 - Benchmark : Project Cars

28 - Benchmark : Rise of the Tomb Raider

29 - Benchmark : Star Wars Battlefront

30 - Benchmark : The Division

31 - Benchmark : The Witcher 3 Wild Hunt

32 - Récapitulatif des performances

33 - GPU Boost : pourquoi ? comment ?

34 - Overclocking : 2 GHz à portée de click

35 - Conclusion

Contenus relatifs

- [+] 26/10: Nvidia pré-annonce les GeForce GTX ...

- [+] 17/10: Destiny 2 de retour chez Nvidia

- [+] 27/09: Nvidia offre Middle Earth: Shadow o...

- [+] 22/08: Destiny 2 de nouveau offert chez Nv...

- [+] 14/06: Destiny 2 pour les GTX 1080 et 1080...

- [+] 31/05: Computex: Nvidia annonce les GTX 10...

- [+] 29/05: Desktop, mobile et en box : la GTX ...

- [+] 25/04: Les GTX 1080 et 1060 ''OC'' disponi...

- [+] 28/03: For Honor ou Ghost Recon en bundle ...

- [+] 01/03: GDC: Nvidia va proposer des GTX 108...