Les contenus liés au tag Maxwell

Afficher sous forme de : Titre | FluxDossier: Nvidia GeForce GTX 980 et GTX 970 : le GM204 Maxwell et les Gigabyte G1 Gaming en test

Nvidia lance les Quadro K5200, K4200, K2200, K620, K420

GTX 800 Gaming G1 pour Gigabyte à la rentrée

GTC: Tegra: Kit Jetson TK1, SoC Erista en 2015

Nvidia lance les GeForce 800M avec Battery Boost

Dossier: Nvidia GeForce GTX 960 et GM206 : l'Asus Strix, l'Inno3D iChill Ultra et la MSI Gaming en test

CES: Nvidia lance la GeForce GTX 965M

CES: Nvidia Tegra X1: Maxwell + Cortex A57/53

Focus: MFAA : un nouveau mode d'antialiasing pour les GeForce

Nvidia annonce les GeForce GTX 980M et 970M

Dossier : Nvidia GeForce GTX 960 et GM206 : l'Asus Strix, l'Inno3D iChill Ultra et la MSI Gaming en test

Après les GeForce GTX 980 et 970, Nvidia entame la démocratisation de son architecture Maxwell dans le milieu de gamme à travers l'introduction de la GeForce GTX 960...

[+] Lire la suite

CES: Nvidia lance la GeForce GTX 965M

Alors que nous attendions un nouveau GPU dans la gamme Maxwell, le GM206, c'est finalement un dérivé de plus du GM204 que Nvidia vient d'annoncer : la GeForce GTX 965M. Grossièrement, il s'agit d'une demi GeForce GTX 980, le GPU étant massivement castré tant au niveau de ses unités de calcul que de son bus mémoire qui sont réduits de moitié. Ses performances devraient se situer quelque peu sous celles de la GeForce GTX 870M, mais avec un rendement énergétique supérieur.

Asus, MSI et Gigabyte ont d'ores et déjà prévu de l'intégrer. Nous avons d'ailleurs pu observer le premier portable 15" d'Aorus qui embarque un couple de GTX 965M en SLI. Les responsables de la filiale de Gigabyte nous ont indiqué une nouvelle fois que le recours au SLI leur permet de proposer un meilleur compromis entre finesse et performances que l'intégration d'un plus gros GPU, par exemple une GeForce GTX 980M. Dans le cas présent, le rapport performances / prix serait également supérieur, Nvidia profitant de sa position de force dans le monde mobile pour tirer les prix vers le haut sur les versions supérieures.

L'Aorus 15" embarque des GTX 965M en SLI.

CES: Nvidia Tegra X1: Maxwell + Cortex A57/53

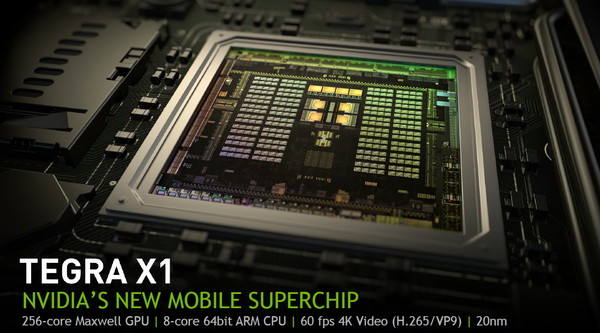

Comme chaque année, Nvidia profite du CES de Las Vegas pour dévoiler un nouveau SoC. Pour cette édition 2015, c'est le Tegra X1 qui est mis en avant. Au menu, le passage au 20nm, un GPU Maxwell de seconde génération optimisé pour le monde mobile et un ensemble de cœurs Cortex-A57 et A53 pour former le CPU.

Après les Tegra K1 32-bits et 64-bits, Nvidia passera dans le courant de 2015 au Tegra X1, connu précédemment sous le nom de code Erista. Une évolution qui était attendue mais qui réserve quelques surprises, notamment au niveau de sa partie CPU qui ne fait pas appel aux cœurs ARMv8 maison (nom de code Denver) exploités dans le Tegra K1 64-bits. A la place, Nvidia reprend, comme Qualcomm et Samsung, les cœurs ARM 64-bits "standards", des Cortex-A57 et des Cortex-A53.

Des cœurs ARM 64-bits standards en 20nmNvidia explique ce choix par le fait que le développement du Tegra K1 64-bits et du Tegra X1 s'est fait en parallèle en visant des procédés de fabrication différents. Il n'aurait ainsi pas été possible de profiter de l'expérience du développement du premier avec les cœurs Denver pour mettre au point le second. Dans ce sens il faut voir le Tegra X1 comme le successeur du Tegra K1 32-bits alors qu'une variante équipée des cœurs Denver sera dévoilée plus tard (Parker ?).

Cette approche permet à Nvidia de réduire les risques lors du passage au 20 nanomètres puisque, en amont, ARM s'est assuré de proposer un design adapté à cette technologie du fondeur TSMC. Pour son implémentation, Nvidia a d'ailleurs abandonné l'approche 4+1 des précédents Tegra qui consistait à associer un unique cœur optimisé basse consommation à un ensemble de 4 cœurs similaires mais orientés performances. L'an passé, Nvidia nous expliquait que ce mode 4+1 était beaucoup plus efficace que ce que faisait la concurrence qui avait opté pour une approche 4+4 mais avec 2 types de cœurs différents.

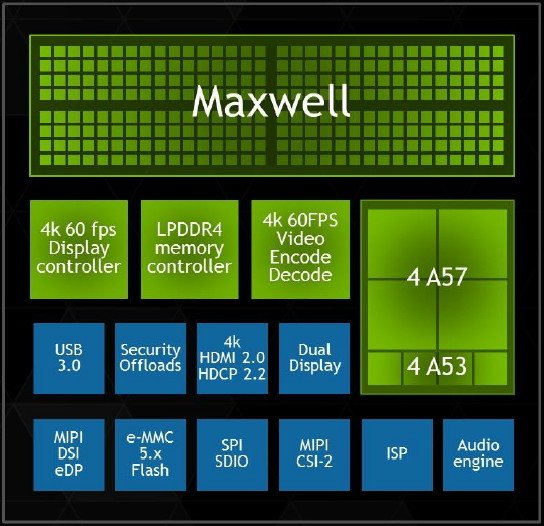

Changement de discours cette année, probablement parce que Nvidia n'a pas eu le choix, l'implémentation proposée par ARM a été optimisée pour du 4+4. Nvidia a donc opté pour 4 Cortex-A57 (en version cache L1 I/D de 48/32 Ko) associés à 4 Cortex-A53 (avec cache L1 I/D de 32/32 Ko). Contrairement à ce que le marketing essayera de vous vendre, cela n'en fait cependant pas un SoC octocore. Le Tegra X1 reste un SoC quadcore puisque ces 2 groupes de cœurs ne peuvent en aucun cas être exploités simultanément. Au repos ou à très faible charge CPU, les Cortex-A53 sont exploités et dès qu'une charge CPU plus lourde est initiée, ils passent au repos et les Cortex-A57 entrent en action.

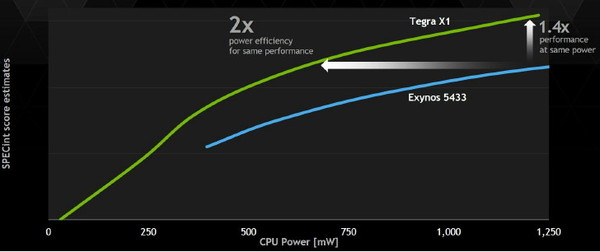

Nvidia indique que son implémentation est cependant plus efficace sur le plan énergétique que celle d'autres fabricants, notamment Samsung, qui ont fait un choix similaire. Il est question d'une réduction de moitié de la consommation à performances égales et d'un gain de performances de 40% à consommation égale. Nvidia explique cela d'une part par l'expérience acquise lors du design de puces 4+1 qui lui a donné une bonne maîtrise de l'exploitation des possibilités des process de TSMC pour intégrer sur une même puce deux ensembles de cœurs CPU au profil énergétique très différent. D'autre part, Nvidia exploite sa propre interconnexion, moins gourmande que celle proposée par ARM (CCI-400).

Au niveau du sous-système mémoire, l'ensemble de Cortex-A57 profite d'un cache L2 de 2 Mo, comme les précédents Tegra, alors que les Cortex-A53 se contentent de 512 Ko. Le bus mémoire reste large de 64-bit mais passe de la LPDDR3-1866 (au départ il était question de LPDDR3-2133 mais Nvidia n'en parle plus) à la LPDDR4-3200 (jusqu'à 4 Go) pour offrir un gain de bande passante de 70%. De quoi permettre notamment d'alimenter le GPU plus musclé.

Un GPU Maxwell de seconde génération avec support du FP16Rappelons que là où Kepler avait été portée dans le monde Tegra alors que Nvidia était déjà très avancé dans le développement de cette architecture, Maxwell est la première qui a été pensée dès le départ pour le monde mobile. Ce qui participe au fait que Nvidia ait fait un effort supplémentaire au niveau de son efficacité énergétique. Alors que de nombreux fabricants de SoC ont opté pour les mêmes cœurs CPU que ceux exploités par le Tegra X1, le GPU est bien entendu l'élément principal qui permet à Nvidia de se démarquer.

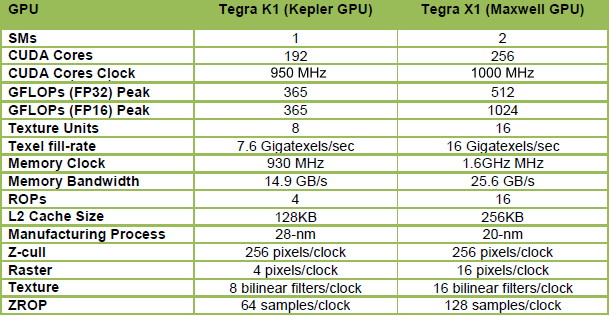

Le Tegra X1 fait ainsi appel à un GPU Maxwell de seconde génération, le GM20B, similaire au GM204 qui équipe les GeForce GTX 980 et GTX 970, mais bien entendu équipé de moins d'unités de calcul. Vous pourrez retrouver les détails à son sujet dans le dossier que nous avions consacré à ces cartes graphiques et à l'architecture Maxwell.

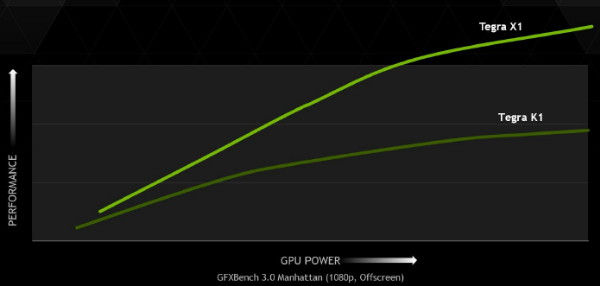

Là où le GM204 desktop embarque 16 blocs de 128 unités de calculs, appelés SMM, le GM20A s'en contente de 2. Le nombre d'unités de calcul principal passe donc de 2048 à 256, soit 1/8ème de la puissance de calcul du GPU le plus performant du moment, ce qui reste impressionnant pour un petit SoC. A noter que les Tegra K1 se contentaient d'un seul SMX, mais de 192 unités de calcul. Cependant sur cet ensemble, seules 128 unités était exploitables efficacement et les 64 supplémentaires n'offraient qu'un gain minime. En passant à 2 SMM avec le Tegra X1 et à une fréquence légèrement supérieure, Nvidia n'est pas loin de doubler la puissance de calcul pratique de son GPU.

Mais ce n'est pas tout. Les 256 unités de calcul du Tegra X1 évoluent pour supporter de nouvelles instructions qui vont pouvoir doubler la puissance de calcul dans certains cas. Ces instructions sont des opérations FP16 vectorielles pour les FMA, les multiplications et les additions. De plus faible précision, le format de calcul FP16 est suffisant pour bien des usages, notamment pour les jeux mobiles, et alors que la concurrence y a massivement recours pour booster les performances et l'efficacité énergétique, il était devenu inévitable pour Nvidia d'en profiter également.

Pour les GPU Nvidia précédents, aucune précision inférieure au FP32 n'est supportée directement par les unités de calcul. Si celles-ci doivent traiter une opération basse précision en FP16, elles doivent donc les traiter comme des opérations FP32 avec un débit identique et uniquement quelques petites optimisations mineures.

Pour le Tegra X1, l'ajout d'instructions vec2 permet à chaque unité de calcul FP32 de traiter deux opérations FP16 simultanément et donc de doubler le débit. Ces unités restent alimentées par des registres 32-bits classiques dans lesquels sont placées deux valeurs 16-bits. Une implémentation basique qui implique une modification mineure de l'architecture mais qui transpose tout le travail de l'exploitation du FP16 au compilateur qui devra faire en sorte de trouver des opérations vec2 dans le code et parvenir à optimiser l'utilisation du fichier registres entre les valeurs FP32 et FP16.

Cela permet de doubler la puissance de calcul théorique, qui atteint 1 TFlops à 1 GHz, mais en pratique le taux d'utilisation sera rarement optimal. Ceci étant dit il s'agit dans tous les cas d'un gain performances appréciable qui profitera notamment aux jeux mobiles friands de FP16.

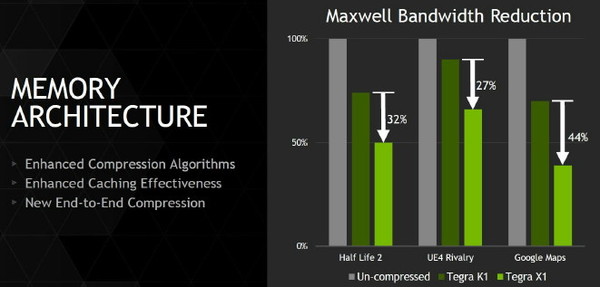

Nvidia a également implémenté la dernière itération de sa technologie de compression des couleurs, et plus spécifiquement du codage différentiel. Son principe de base consiste à ne pas enregistrer directement les couleurs mais leur différence par rapport à une autre qui fait office de repère. Suivant les spécificités de chaque scène, cette technique de compression sans perte permet d'économiser une part significative de la bande passante mémoire, ce qui profite aux performances.

L'ensemble de la chaine d'affichage supporte ces méthodes de compression, ce qui permet de réduire la bande passante à tous les niveaux, jusqu'au moteur d'affichage qui ne décompresse qu'au moment de l'envoi vers l'interface de l'écran. Le cache L2 passe par ailleurs de 128 à 256 Ko, de quoi également d'éviter certains accès à la mémoire centrale. Au final, les techniques de cache et de compressions sans perte permettent par exemple de réduire la bande passante nécessaire de moitié dans Half-Life avec un gain de 30% par rapport au Tegra K1 qui était pourtant déjà plutôt efficace de ce côté.

Pour le reste, toutes les technologies supportées par les gros GPU de bureau le sont par le Tegra X1 : Direct3D 12, OpenGL ES 3.1, AEP, OpenGL 4.5, CUDA 6.0, MFAA, VXGI…

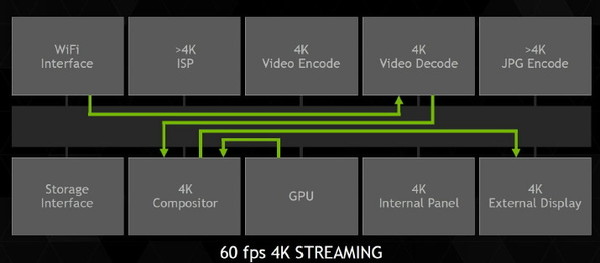

4K et 60 HzLe moteur vidéo, cette fois spécifique au SoC Tegra, a été lui aussi revu pour le X1. Nvidia s'est particulièrement penché sur le support de la 4K, qui lui permettra de se différencier par rapport à la concurrence sur un autre plan que la 3D. Tout le pipeline vidéo a ainsi été optimisé pour la lecture du contenu 4K à 60 fps, qui devrait être proposé notamment par le service de streaming de Netflix même s'il faut bien avouer que cela ne concernera qu'une minorité de vidéos et d'utilisateurs.

Cela passe bien entendu par un moteur de décodage 100% matériel. Il supporte la 4K à 60 fps en H.264, en H.265 (HEVC) ainsi qu'en VP9, avec un débit maximal non précisé. La profondeur des couleurs de 10-bit est également supportée en H.265 en 4K et 60 fps. Au niveau de l'encodage, Nvidia se "contente" par contre de la 4K à 30 fps en H.264 et H.265 et du 1080 à 60 Hz en VP8.

Deux écrans peuvent être supportés par le moteur d'affichage, compatible HDMI 2.0 et HDCP 2.2. Il supporte par ailleurs la technologie DSC de VESA qui permet de transmettre une image compressée à l'écran.

Le support de l'Adaptive Sync qui permettrait d'améliorer la fluidité dans le monde mobile de manière standardisée n'est par contre pas au menu. A cette question, Nvidia répond par son attachement à G-Sync accompagné d'un traditionnel "wait & see", de quoi nous laisser penser que cette technique d'affichage, ou un dérivé, pourrait être supporté sur le Tegra X1.

L'efficacité énergétique en démoPour mettre en avant les capacités de son SoC, Nvidia avait préparé quelques démos basées sur une plateforme de développement. Celle-ci est relativement compacte et se contente d'un dissipateur en aluminium relativement fin, censé représenter les capacités de refroidissement d'une tablette.

Quel est le TDP de ce SoC Tegra X1 ? Question délicate à laquelle il est toujours difficile d'obtenir une réponse directe. Pour ses démos, Nvidia parle d'environ 5W, mais lors de la présentation globale réalisée par son CEO, il était plutôt mentionné 10W.

Comme à son habitude, Nvidia exploite des comparaisons "isoperf" (à performances égales) pour mettre en avant l'efficacité énergétique de ses futurs SoC face aux solutions actuelles déjà sur le marché. Des données qui ont selon nous un intérêt limité puisque cette approche consiste à réduire drastiquement les fréquences et tensions du SoC le plus performant. Un calcul du rendement énergétique sur base des conditions d'utilisation réelles des puces est plus pertinent, mais cela ne permet pas d'aller chercher le fameux 2x, un must pour mettre en avant les nouveautés.

L'exemple le plus parlant est le test Manhattan, dans lequel le Tegra X1 se comporte très bien en doublant les performances par rapport au Tegra K1 et à l'A8x d'Apple. En réduisant les fréquences du Tegra X1, Nvidia observe un rendement énergétique supérieur de 77% (1.51W pour le GPU du Tegra X1, 2.68W pour celui de l'A8x). Nvidia nous indique par contre qu'à pleines performances (64 contre 33 fps), la consommation du GM20B se situe plutôt à environ 3.5W. Un petit calcul montre cette fois un gain du rendement énergétique de 48%. Un chiffre plus réaliste, mais qui reste un excellent résultat.

Le Tegra X1 face à la Xbox One ?Souvenez-vous, lors de l'introduction du Tegra K1, il avait été comparé à la Xbox 360. Nvidia poursuit dans cette voie et pour terminer la présentation du Tegra X1, nous avons eu droit à la démo de l'Unreal Engine qui avait été utilisée pour mettre en avant les consoles de "nouvelle génération", la PS4 et la Xbox One.

Il est sans aucun doute quelque peu exagéré de dire qu'un SoC Tegra X1 dispose de capacité CPU et GPU identique à celles de ces consoles, mais le fait que cette démo (ou même une version allégée) tourne correctement sur une telle puce, montre bien les progrès qui ont été accomplis.

Si Nvidia annonce donc une fois de plus un SoC prometteur au CES, la question du timing de sa disponibilité n'a pas été abordée. Ce sera plus tard dans l'année et la concurrence proposera probablement des évolutions d'ici-là. Nvidia estime cependant que son nouveau bébé gardera la tête au niveau des capacités et des performances de son GPU. De quoi proposer une évolution de sa tablette Shield dans le courant de l'été ? Avec fonction G-Sync ?

Restera ensuite à voir quand une variante à base de cœurs Denver pourra être proposée mais l'absence totale d'information ou de démos à son niveau laisse penser qu'elle n'arrivera pas avant fin 2015 ou 2016.

Focus : MFAA : un nouveau mode d'antialiasing pour les GeForce

Annoncé lors du lancement des GeForce GTX 900 et de l'architecture Maxwell de seconde génération, le MFAA est un nouveau type d'antialiasing avec lequel Nvidia compte pouvoir offrir un ensemble qualité et performances plus intéressant. Il vient d'être rendu disponible à travers de nouveaux pilotes et nous y avons jeté un rapide coup d'œil.

L'antialiasing, quelques rappels

Sans revenir dans trop de détails sur les modes d'antialiasing traditionnels, rappelons qu'ils ont pour but de...

[+] Lire la suite

Nvidia annonce les GeForce GTX 980M et 970M

Quelques semaines seulement après l'arrivée des GeForce GTX 980 et 970 de bureau, leurs versions mobiles débarquent et profitent du rendement énergétique très élevé de la génération Maxwell pour pousser les performances à la hausse.

Après pas moins de 3 transitions vers une nouvelle gamme, de la GeForce GTX 680M à la GeForce GTX 880M, en passant par les GTX 680MX et GTX 780M, le GPU GK104 de la génération Kepler tire sa révérence dans le haut de gamme mobile. Il est avantageusement remplacé par un GPU plus moderne de la génération Maxwell, le GM204 déjà aperçu avec les GeForce GTX 980 et GTX 970 de bureau.

Une arrivée plutôt rapide d'autant plus qu'il ne s'agit pas d'une simple annonce, mais également d'une disponibilité commerciale. C'est en partie l'efficacité énergétique plus élevée des GPU Maxwell qui facilite leur arrivée rapide dans le monde mobile. Nous pouvons par exemple supposer que l'effort est moindre qu'avec les GPU Fermi et Kepler pour déterminer quel tri des puces et quelles spécifications vont permettre de les commercialiser avec une enveloppe thermique de 100W ou moins.

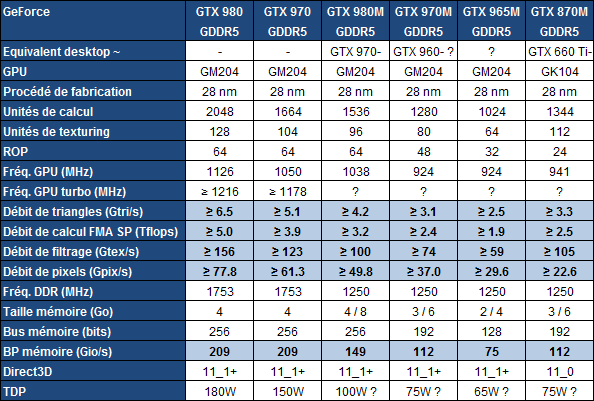

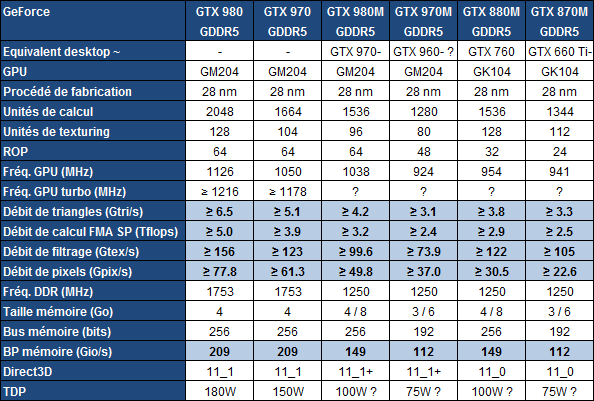

Les spécificationsPour faire rentrer le GM204 dans le monde mobile, Nvidia a malgré tout dû faire quelques coupes dans ses blocs actifs. Voici les spécifications des GTX 980M et 970M par rapport aux versions desktops et aux cartes graphiques mobiles qu'elles remplacent :

Sur les 16 blocs SMM qui composent le GPU GM204, la GTX 980M doit s'en contenter de 12 actifs, soit de 1536 unités de calcul, exactement comme la GTX 880M qu'elle remplace. Par contre, l'architecture Maxwell permet de maximiser l'utilisation de toutes ces unités de calcul là où une bonne partie se tournaient les pouces sur Kepler. A puissance de calcul théorique égale comptez un avantage en pratique de 20 à 25% pour les GPU Maxwell par rapport aux GPU Kepler.

Pour le reste, par rapport à la génération précédente, les GTX 980M et 970M reculent au niveau de la puissance de texturing mais progressent au niveau du débit de pixels. Comme pour les modèles desktops, elles supportent le niveau de fonctionnalité 11_1 de DirectX et supporteront le futur niveau commun à DirectX 11.3 et DirectX 12.

Tout comme les GTX 880M et 870M, elles pourront être accompagnées soit de 4/3 Go soit de 8/6 Go de mémoire GDDR5. Une seconde configuration qui semble être privilégiée par la plupart des fabricants même si cette quantité de mémoire n'est pas spécialement utile et grignote quelques watts qui auraient pu profiter au GPU.

Nvidia se refuse à communiquer un TDP, prétextant qu'il peut être adapté aux différents châssis. Il semble logique qu'il s'agisse ici des TDP standards de 100W et de 75W avec possibilité de le compresser quelque peu si nécessaire (ce qui réduit la fréquence GPU turbo).

Sur le plan des performances, Nvidia se contente d'annoncer un doublement par rapport à la GTX 680M. De son côté, MSI met en avant une progression de 27-28% par rapport à la GTX 880M, ce qui semble être réaliste et correspond également à peu près au gain d'efficacité énergétique entre Kepler mobile et Maxwell mobile.

A noter que MSI précise que la température GPU maximale spécifiée par Nvidia pour l'activation du turbo est de 93°C (contre 79 °C sur desktop). Au-delà, tout est fait pour enrayer la hausse de la température GPU : fréquence divisée par 4 à 96 °C, par 8 à 99 °C avec une coupure nette au-delà de 101 °C.

Maxwell et efficacité énergétiqueNvidia met fortement en avant un rapprochement des performances du monde mobile par rapport aux cartes graphiques dekstop, autorisé par l'efficacité énergétique de Maxwell. Il est question d'une GTX 980M qui offre 75% des performances d'une GTX 980. Un chiffre poussé à "presque 80%" dans certaines présentations faites à la presse. Est-ce bien la réalité ?

Ce n'est pas si simple de répondre à cette question du point de vue des spécifications, Nvidia ne communiquant pas de fréquence turbo pour ses puces mobiles récentes. Nvidia évite également de communiquer sur le fonctionnement de ce turbo qui est probablement différent de ce qui existe sur desktop.

Si nous partons du point de vue que les GPU mobiles seront plutôt très proches de leur fréquence de base, comme c'est le cas pour la GTX 980 de référence, voici ce que racontent les chiffres pour la GTX 980M :

Puissance de calcul : 69% de la GTX 980

Débit de pixels : 69% de la GTX 980

Débit de triangles : 69% de la GTX 980

Bande passante mémoire : 71% de la GTX 980

Nous serions donc plutôt face à une GTX 980M qui propose 70% des performances de la GTX 980. Certes tous les jeux ne sont pas 100% limités par le GPU ce qui réduit les écarts en pratique mais d'un autre côté la majorité des GTX 980 et 970 sont des cartes personnalisées qui, même sans overclocking d'usine, tournent plutôt à une fréquence bien plus élevée, qui va au-delà du turbo officiellement annoncé.

Quoi qu'il en soit, cela représente une évolution importante si nous observons ce qui s'est passé lors de l'introduction de la GTX 480M ou de la GTX 680M. Nvidia parle de seulement 40 et 60% des performances de leur équivalent desktop.

Par contre Nvidia oublie de dire que cet écart s'est déjà drastiquement resserré avec les GTX 680MX, GTX 780M et GTX 880M. Si nous comparons cette dernière à ce qui se fait de mieux sur desktop avec la configuration la plus véloce du même GPU (GK104), soit une comparaison avec la GTX 770, nous obtenons 88% de la puissance de calcul et 71% de la bande passante mémoire.

En ce sens, le GM204 et l'architecture Maxwell ne change pas réellement la donne si ce n'est qu'il est plus simple d'obtenir plus rapidement un bon résultat dans le monde mobile.

AMD exclu du mobile haut de gamme ?Nvidia qui dominait déjà largement le marché de la carte graphique mobile haut de gamme ou tout du moins à destination des joueurs, renforce encore un peu plus son avance, à tel point que la présence des Radeon d'AMD risque d'y devenir anecdotique. AMD n'a plus rien proposé de neuf depuis la Radeon HD 7970M renommée en HD 8970M puis en R9 M290X qui n'est autre qu'une R9 270X / HD 7870 sous-cadencée.

Il lui était déjà difficile de lutter face à la GTX 880M et la GTX 980M ne fait qu'enfoncer le clou. D'autant plus que le support logiciel de Nvidia est très abouti, que ce soit avec Optimus, technique de cohabitation avec l'IGP Intel, ou encore avec Battery Boost qui permet de limiter les FPS et la qualité graphique quand le portable passe en mode batterie.

Pour les joueurs, les GTX 980M et 970M sont donc ce qui se fait de mieux actuellement. Il faut par contre garder en tête que ces GPU mobiles restent gourmands et qu'ils sont destinés aux gros portables et aux transportables, même si les fabricants proposent des châssis toujours plus efficaces sur le plan du refroidissement. Jouer sur un ultra-portable dans des conditions proches de celles d'un PC de bureau n'est pas encore à l'ordre du jour !

Du côté de la disponibilité, MSI propose par exemple dès aujourd'hui le GT72 2Qx, une mise à jour de son châssis "transportable" 17" qui accueille les nouvelles venues.

D'autres modèles vont suivre, par exemple :

MSI GS60 2Qx : GTX 970M, 15.6", 2.0 cm d'épaisseur, 1.9 kg (en novembre)

MSI GS70 2Qx : GTX 970M, 17.3", 2.2 cm d'épaisseur, 2.6 kg (en novembre)

Gigabyte P35X : GTX 980M, 15.6", 2.1 cm d'épaisseur, 2.2 kg (2200€ fin octobre)

Gigabyte P35W : GTX 970M, 15.6", 2.1 cm d'épaisseur, 2.2 kg (fin octobre)

Gigabyte P34W : GTX 970M, 14", 2.1 cm d'épaisseur, 1.7 kg (1550€ en novembre)

Aorus X7 Pro : GTX 970M SLI, 17.3", 2.3 cm d'épaisseur, 3.0 kg (2400€ en novembre)

A noter enfin que MSI devrait proposer dès la fin de ce mois un kit de mise à jour pour les versions précédentes de son GT72. Ce kit comprendra une GTX 980M au format MXM ainsi qu'un bloc de refroidissement adapté et un guide de montage. Une initiative intéressante même si dans ce cas bien précis, passer d'une GTX 880M à une GTX 980M n'aura qu'un intérêt limité par rapport au coût d'une telle opération. Même si le tarif du kit n'a pas encore été communiqué, il est évident qu'il sera supérieur à 500€.