Les derniers contenus liés au tag Excavator

AMD pré-annonce Bristol Ridge

Excavator FM2+ et nouveaux ventirads AMD

CPU 28nm mi-2014 chez AMD ?

AMD Kaveri et Steamroller repoussés ?

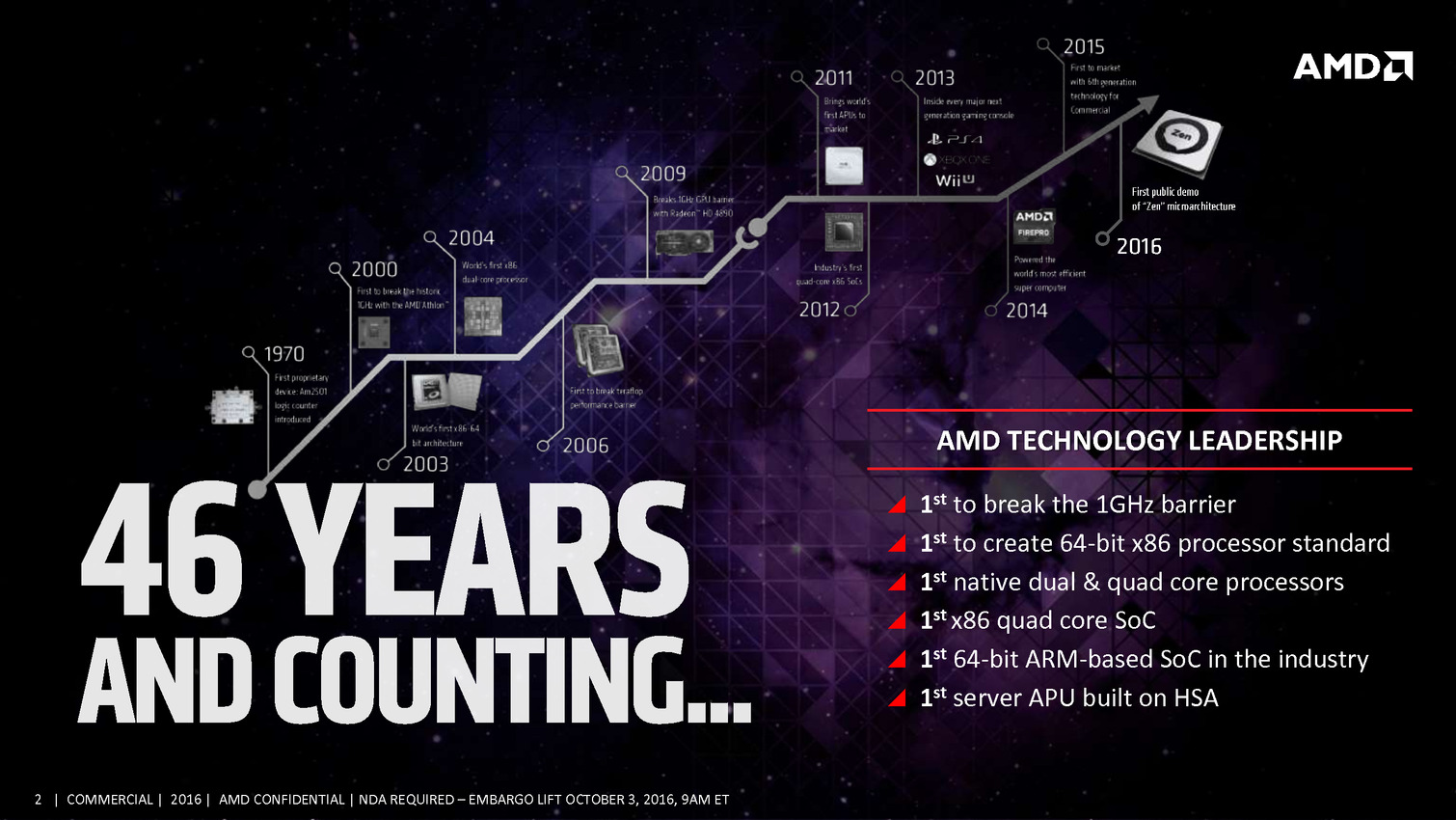

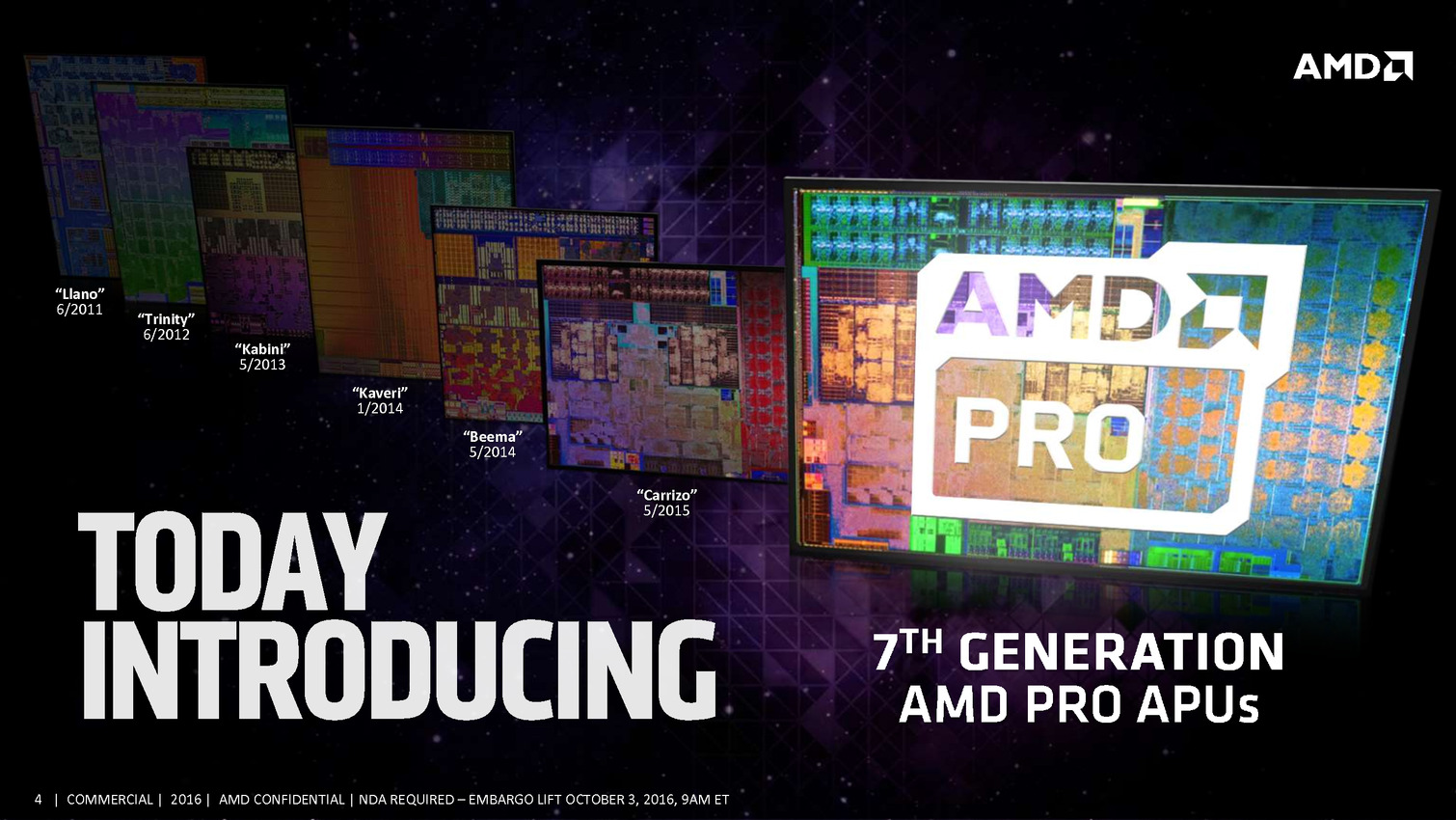

AMD lance les Bristol Ridge Pro

Chipset X370 pour les Zen Summit Ridge

AMD lance les Bristol Ridge desktop OEM

AMD détaille l'architecture de Zen

2 puces pour les APU de 7è génération

AMD lance les Bristol Ridge Pro

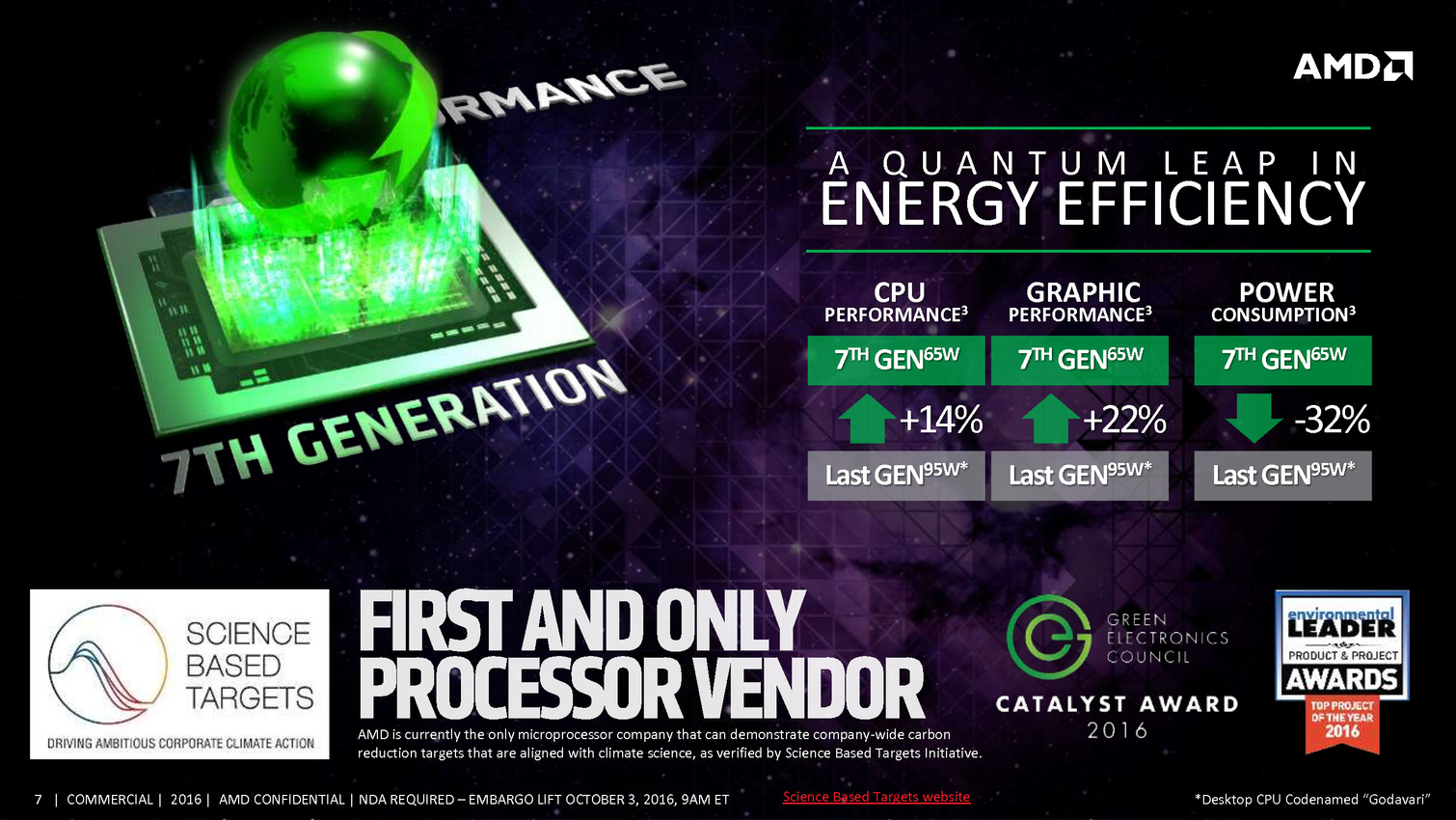

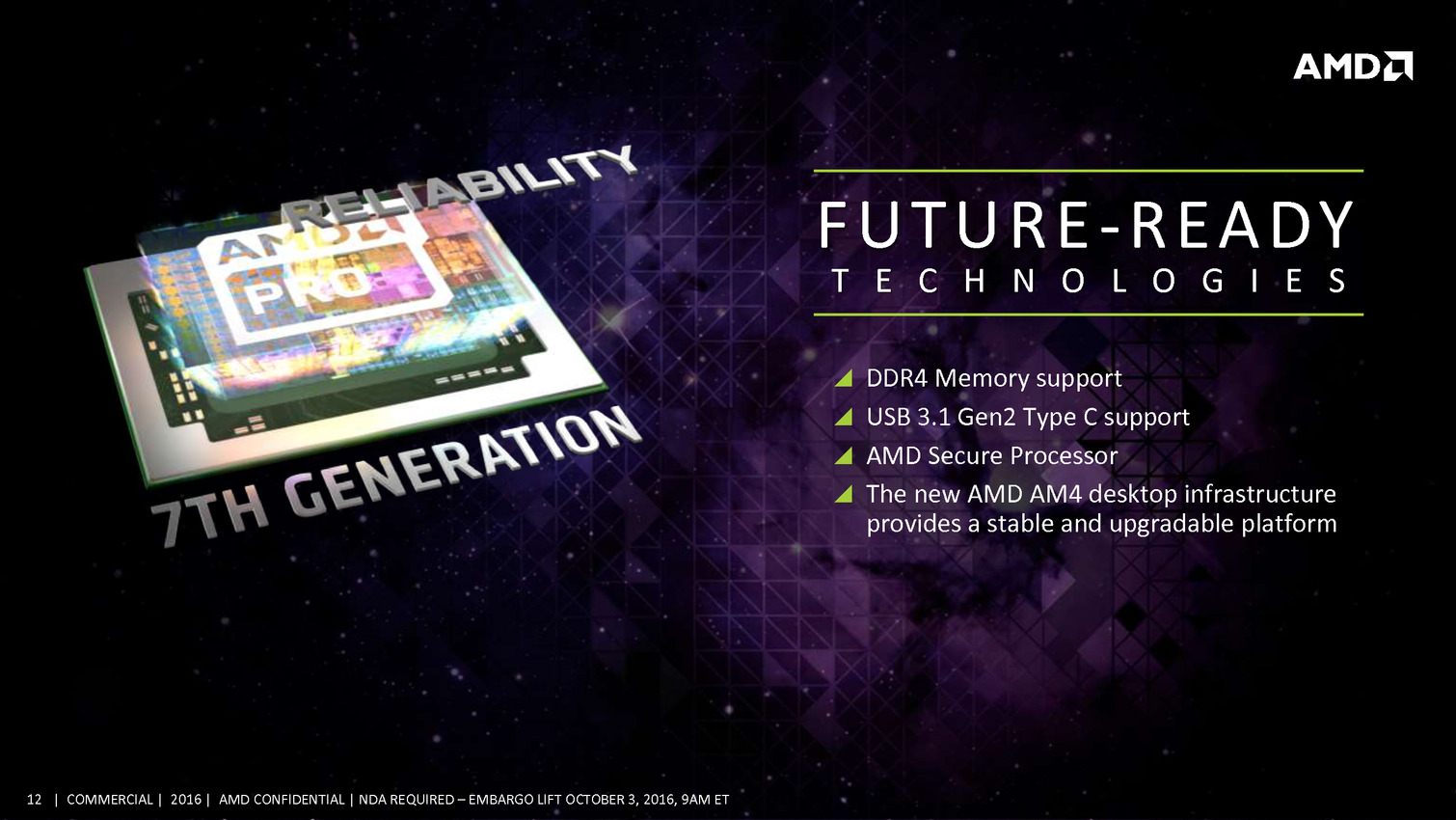

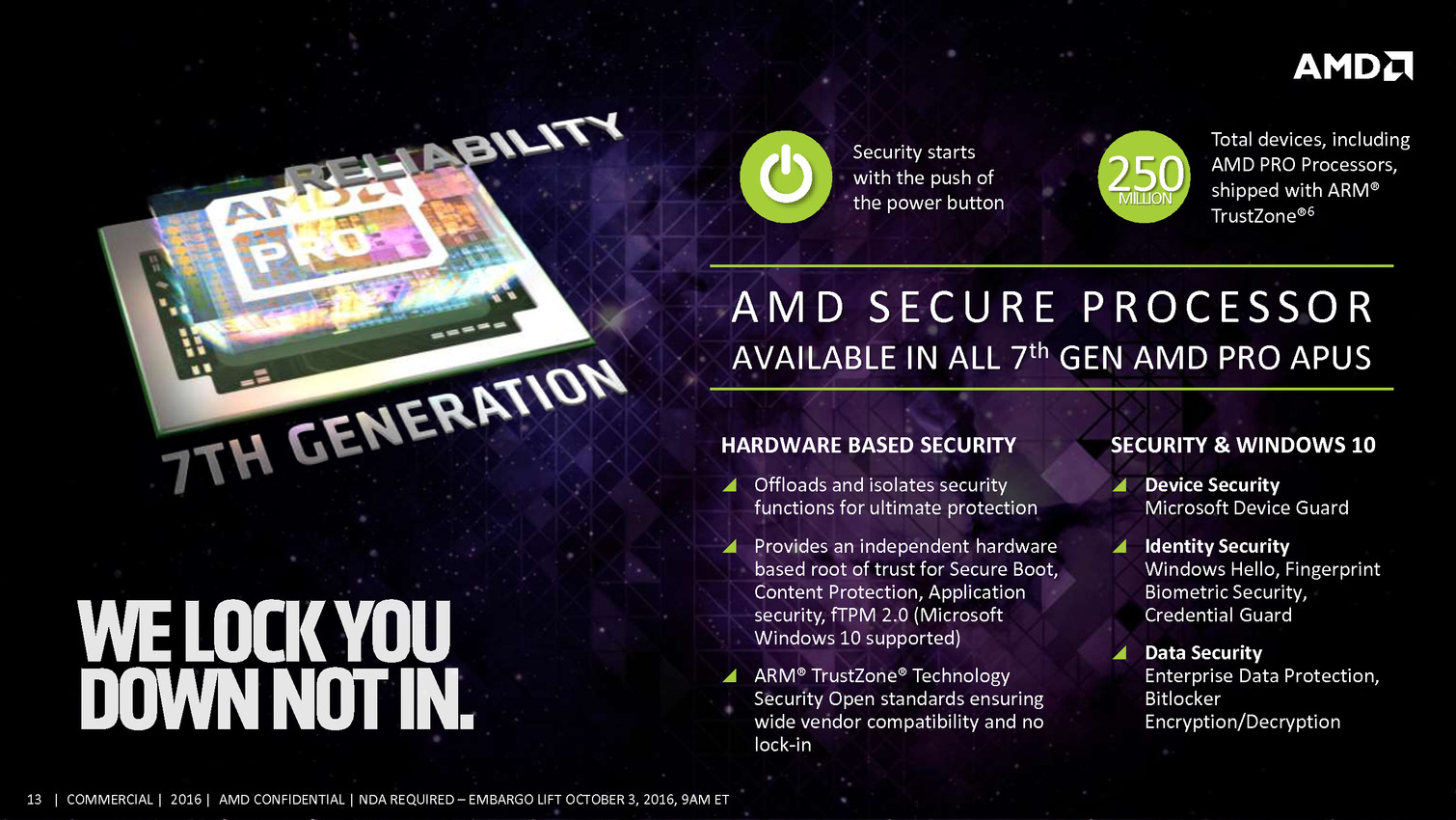

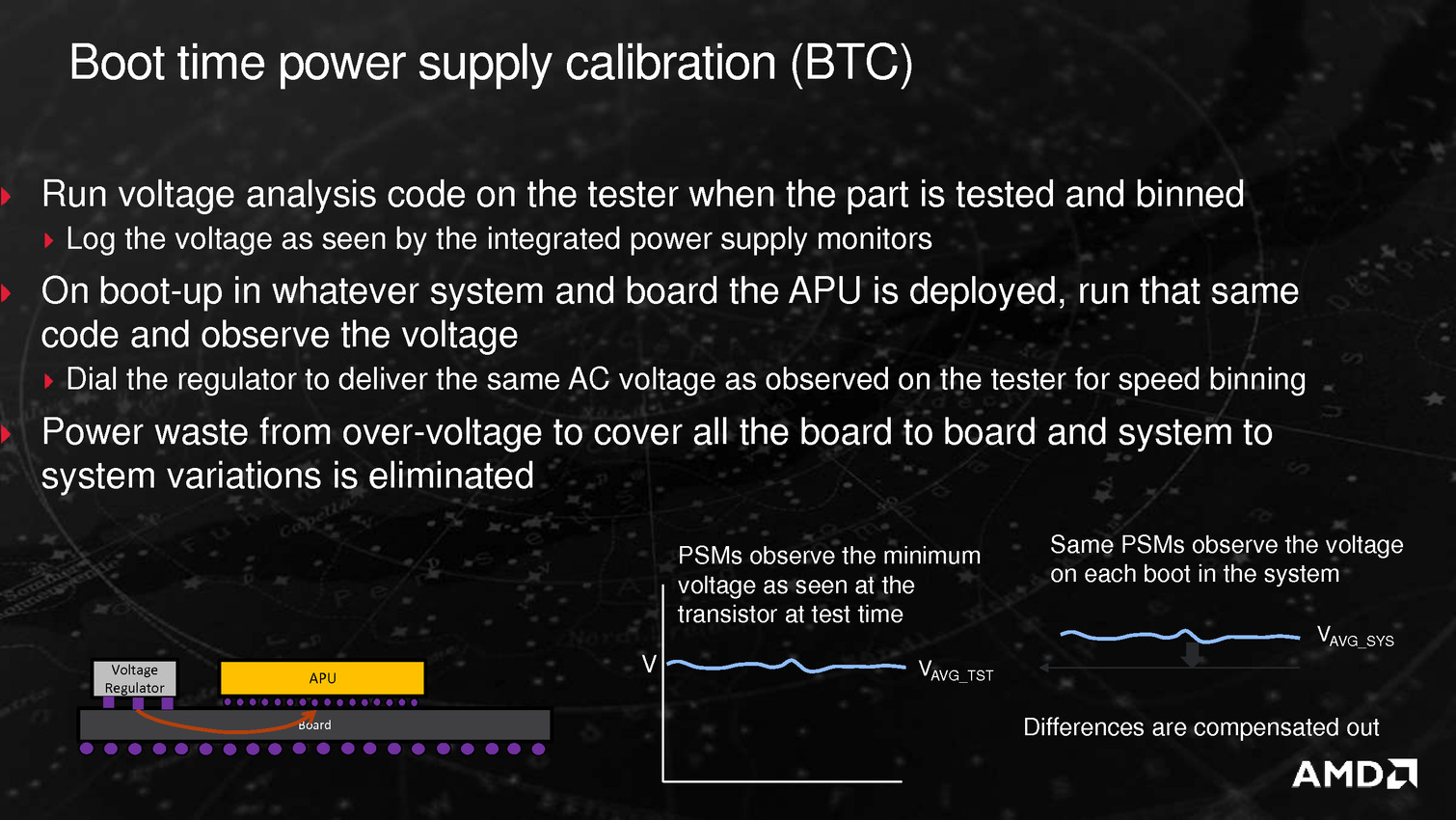

Après avoir lancé ses Bristol Ridge desktop en version OEM début septembre, AMD lance aujourd'hui une déclinaison "Pro" de ses puces Bristol Ridge.

Pour plus de détails sur Bristol Ridge, nous vous renvoyons à notre article précédent. Dans les grandes lignes on rappellera simplement qu'il s'agit d'une version Desktop des APU Carrizo, utilisant l'architecture Bulldozer/Excavator et gravée en 28nm.

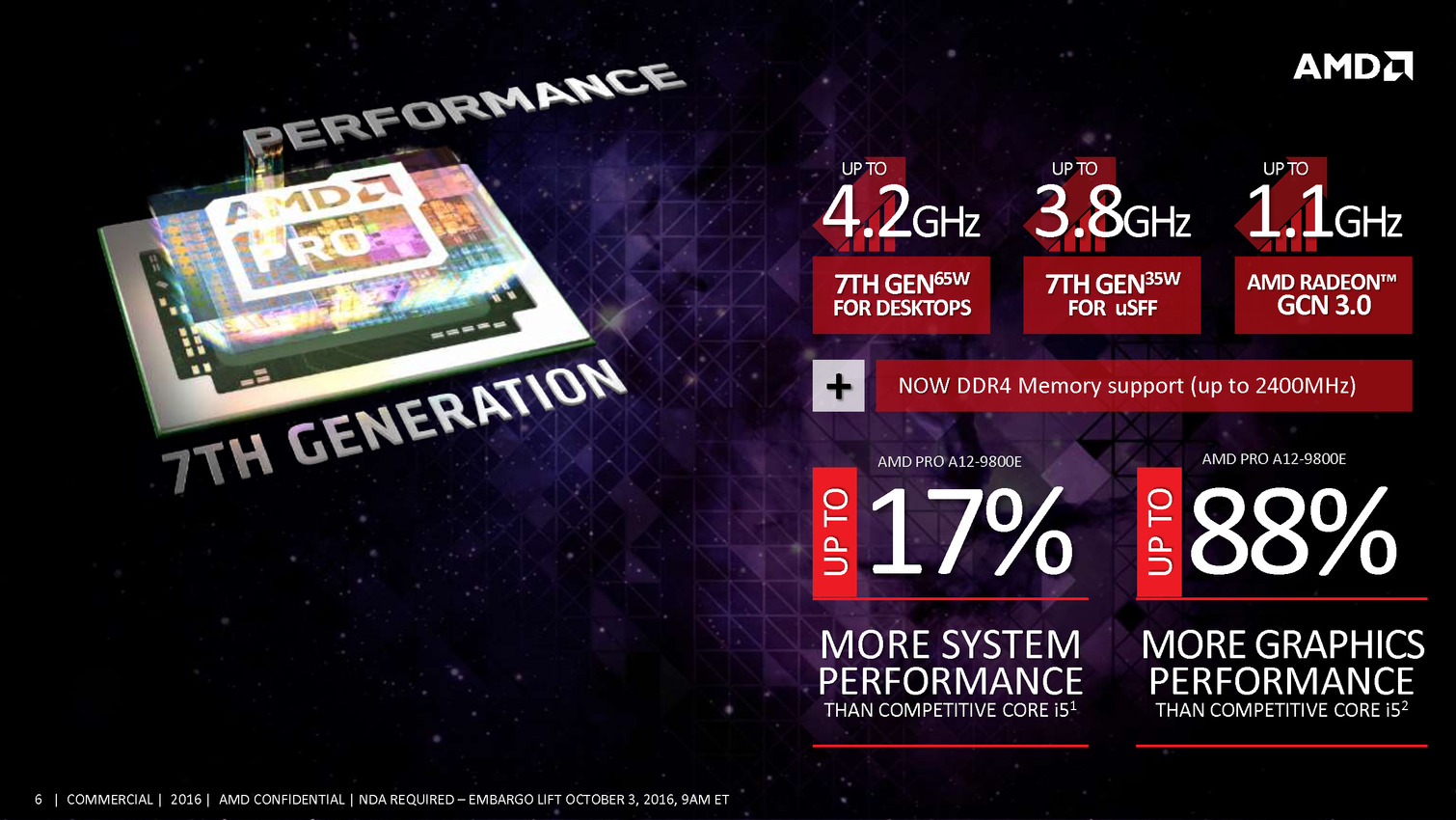

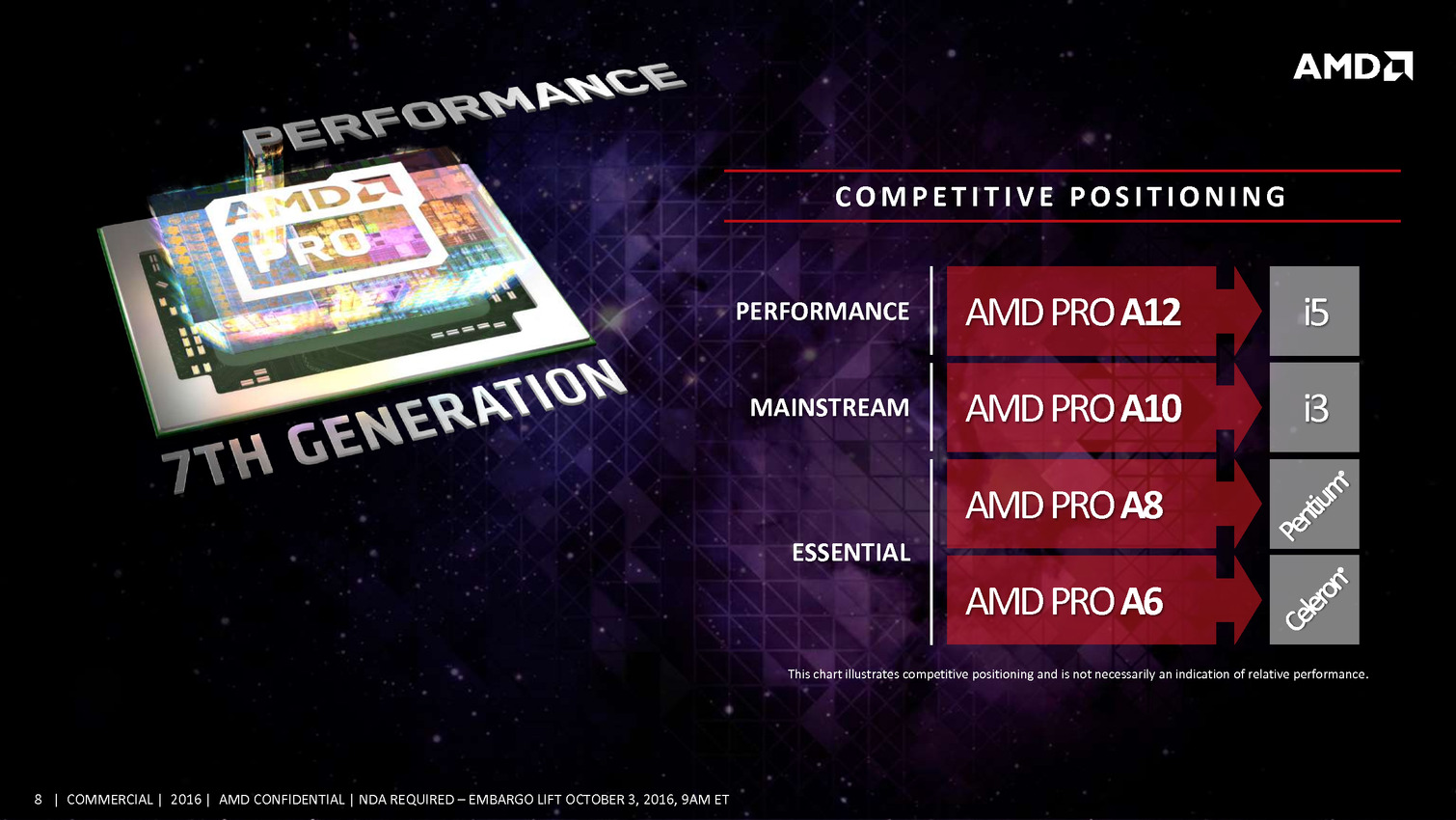

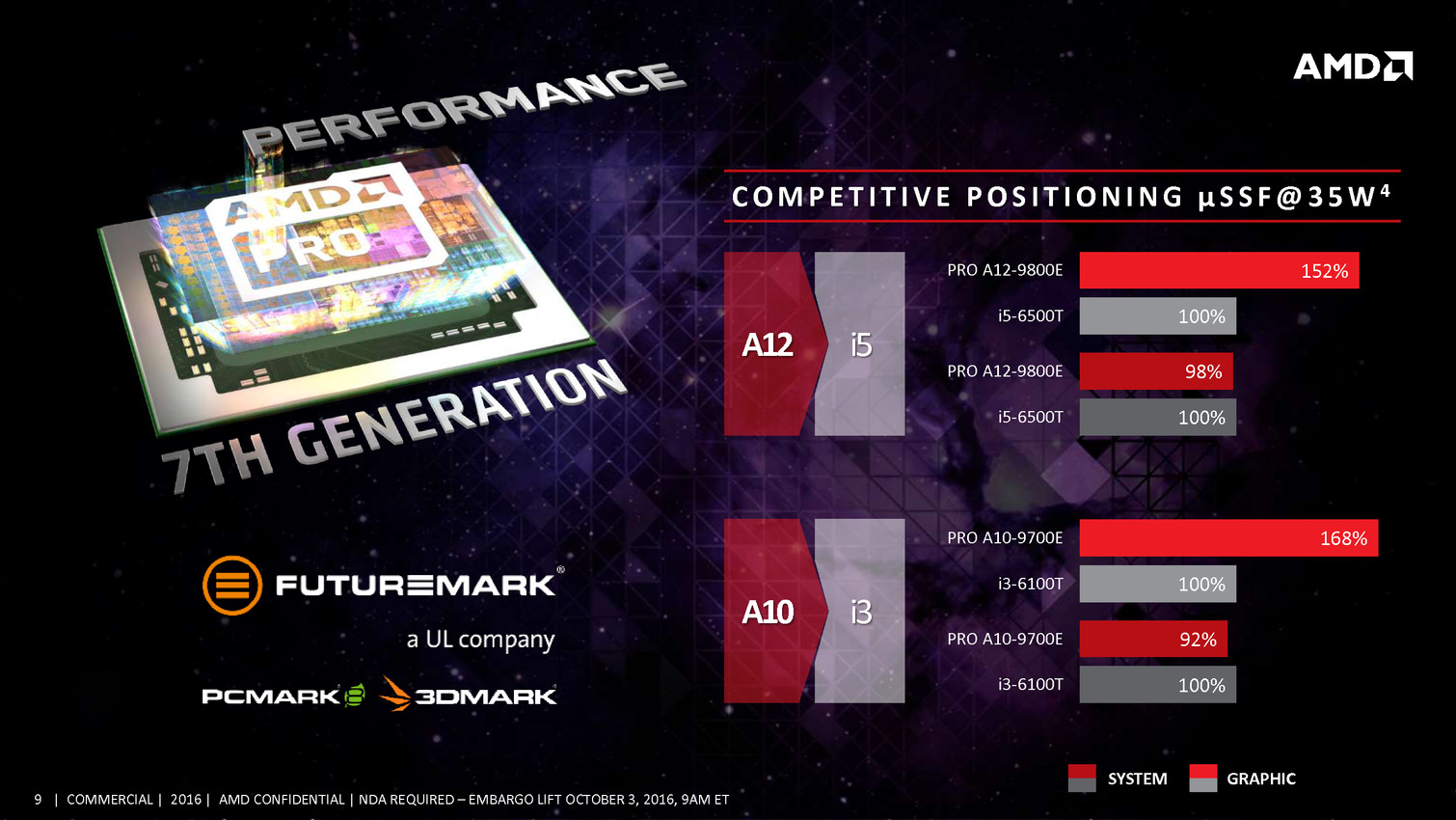

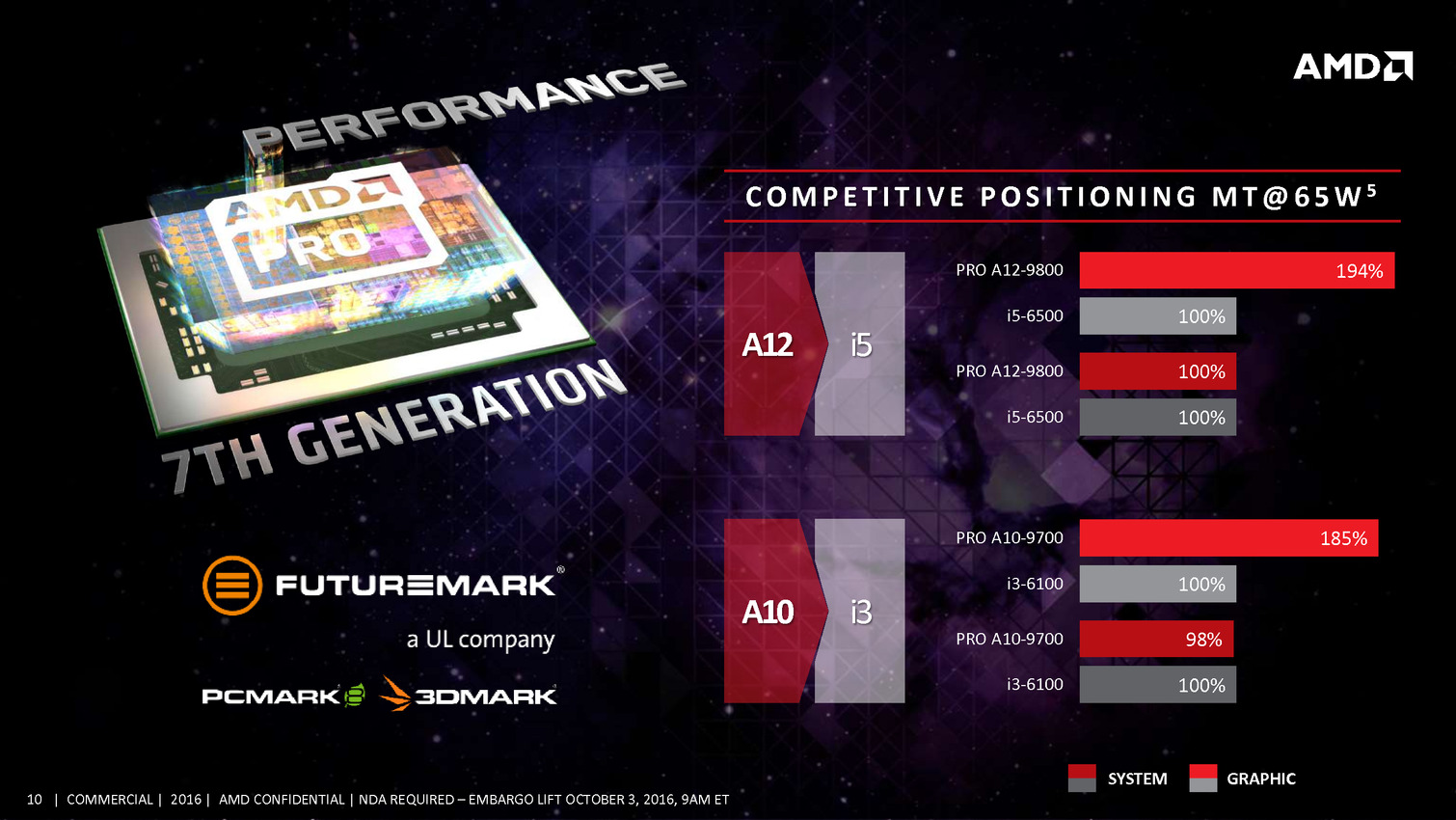

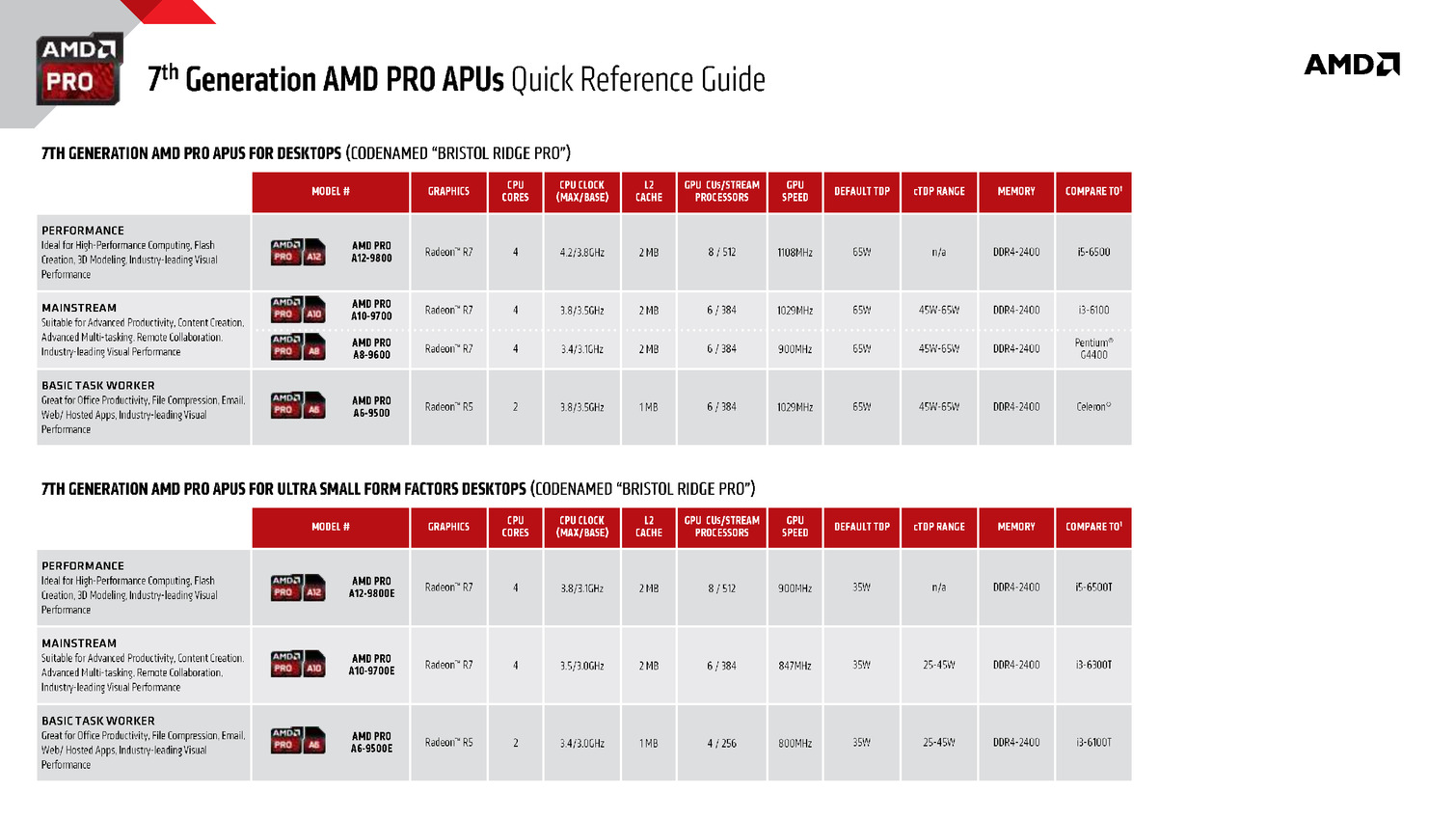

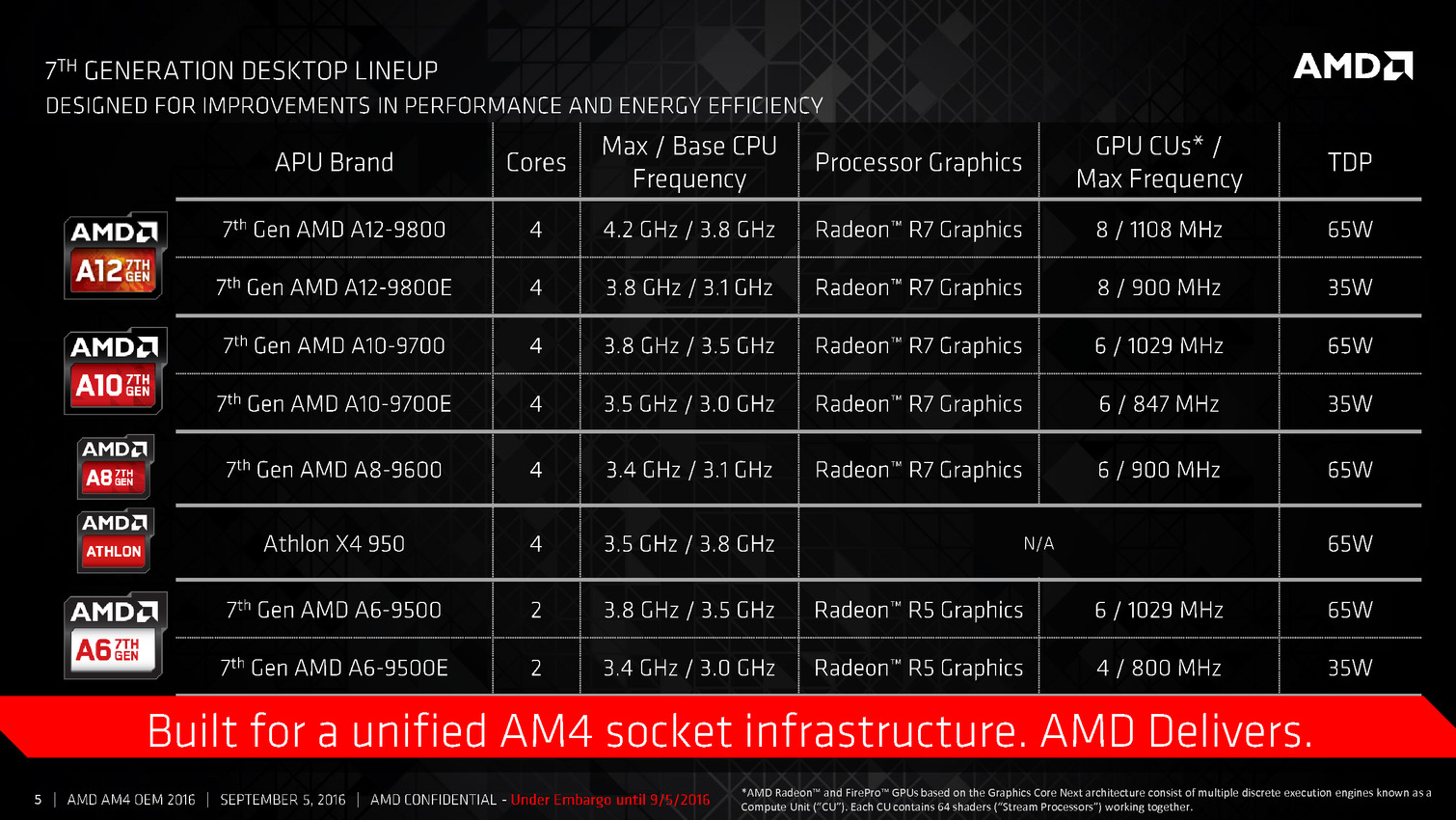

Sur le papier les références "Pro" lancées sont identiques aux versions classiques, que ce soit en termes de fréquences CPU/GPU ou de TDP. On retrouvera donc des versions 65 et 35 watts. Les nomenclatures sont d'ailleurs identiques, AMD n'ayant pas cherché à brouiller les pistes, on notera juste que le Pro vient se placer en début de nomenclature (AMD Pro A12-9800 contre AMD A12-9800).

Quelles sont les différences ? On notera ce point assez intriguant au fond de la présentation d'AMD (page 21) :

Commercial Grade Quality: Building on exceptional AMD product dependability, identifying manufacturing variability and sourcing AMD PRO products from wafers with the highest yields ensures fewer defective parts and commercial-grade quality for AMD PRO products.

Les AMD Pro seraient donc tirés des wafers disposant des meilleurs yields, une affirmation invérifiable et difficile a comprendre. En pratique, les yields indiquent le pourcentage de puces fonctionnelles sur un wafer. Dire que cela génère effectivement moins de puces non fonctionnelles est vrai, mais c'est avant tout un problème interne à AMD de qualification ! Tirer de cela une "qualité commerciale" (faut il comprendre que les Bristol Ridge non Pro sont vendus avec une qualité "non commerciale" ?) est un exercice dont seule la magie du marketing est capable !

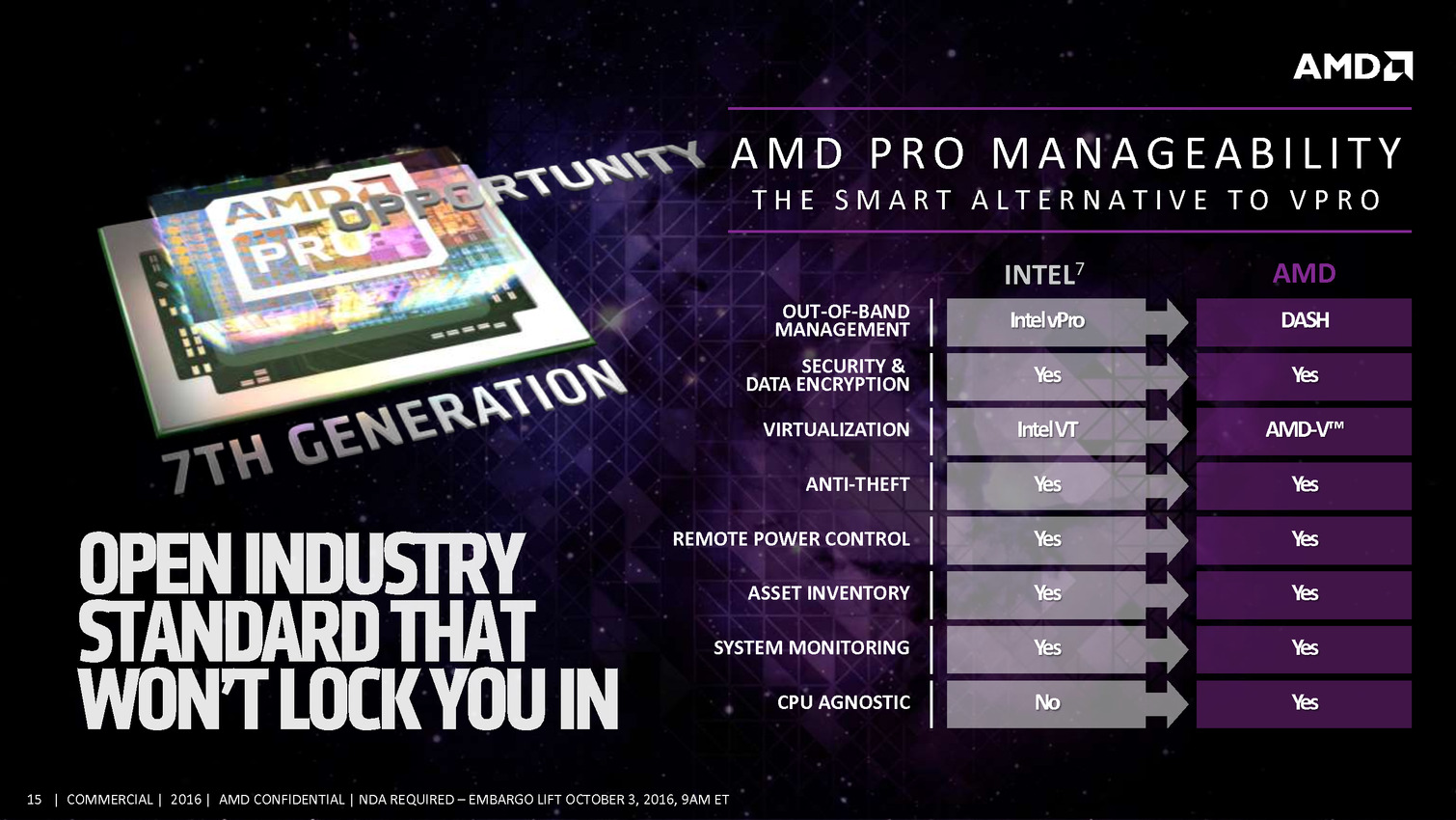

Pour le reste des différences, AMD met en avant le support de DASH , le protocole de gestion de parc. Ce dernier est surtout lié au chipset et au contrôleur réseau. On imagine que la certification Pro par AMD réclame une implémentation compatible mais sur ce point, AMD ne s'étend malheureusement pas.

Ces puces restent réservées aux OEM pour leurs gammes business, HP et Lenovo seront les deux premiers à proposer des PC visant le marché entreprise utilisant les Bristol Ridge Pro.

Vous pouvez retrouver ci dessous en intégralité la présentation d'AMD :

Chipset X370 pour les Zen Summit Ridge

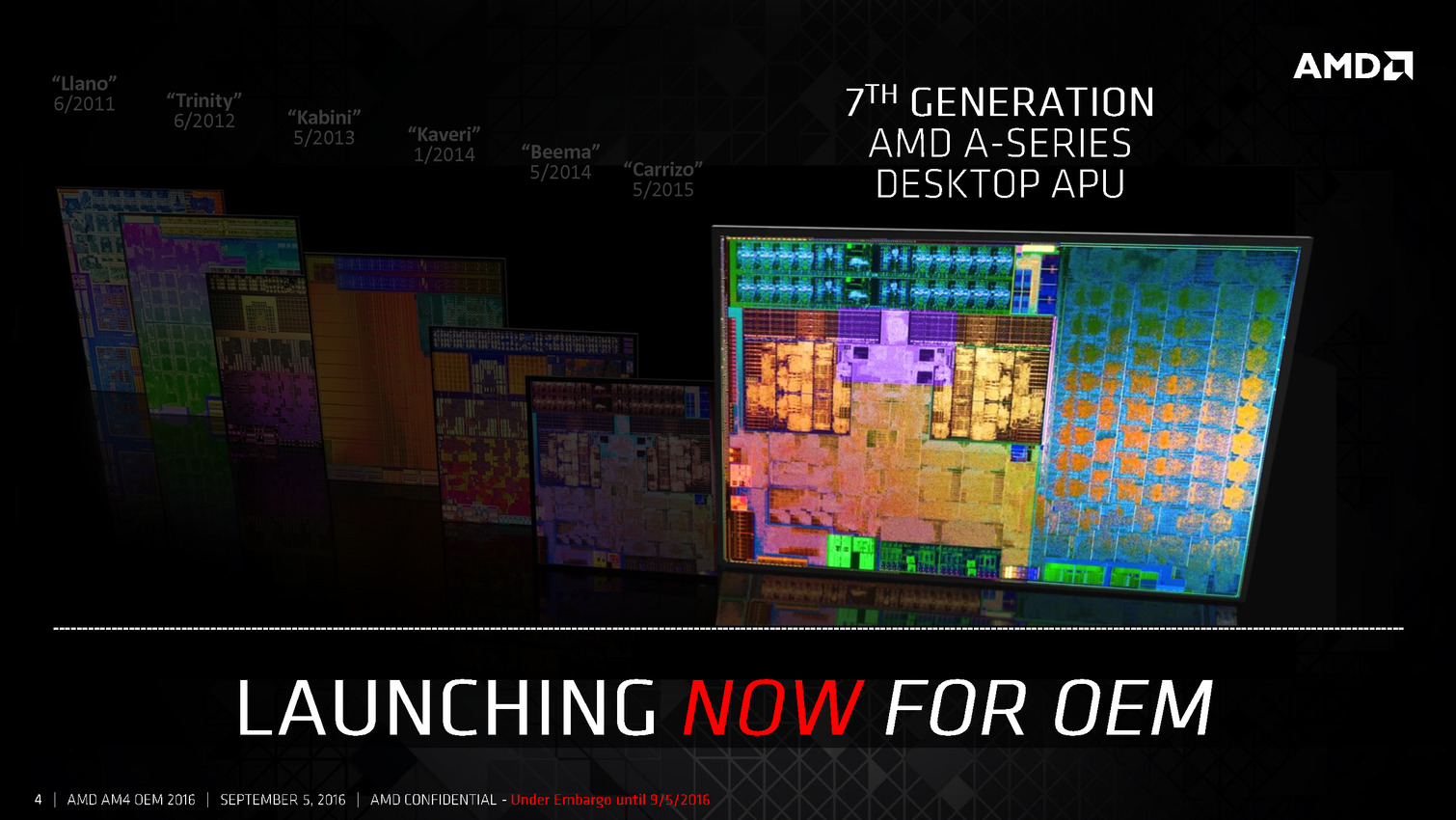

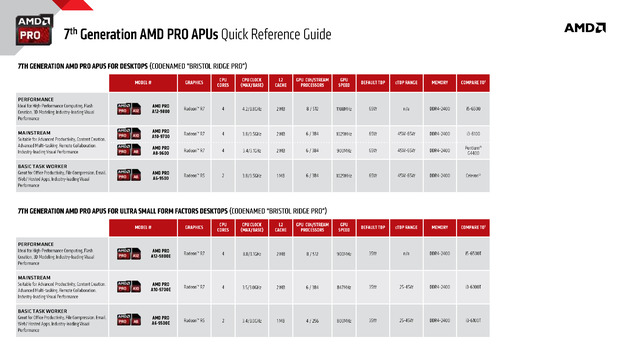

Il y a deux semaines de cela, AMD A lancé sa "7ème" génération d'APU desktop, les Bristol Ridge. Il s'agit pour rappel d'une version desktop de l'APU mobile Carrizo, utilisant toujours l'architecture Bulldozer/Excavator et fabriqués en 28nm.

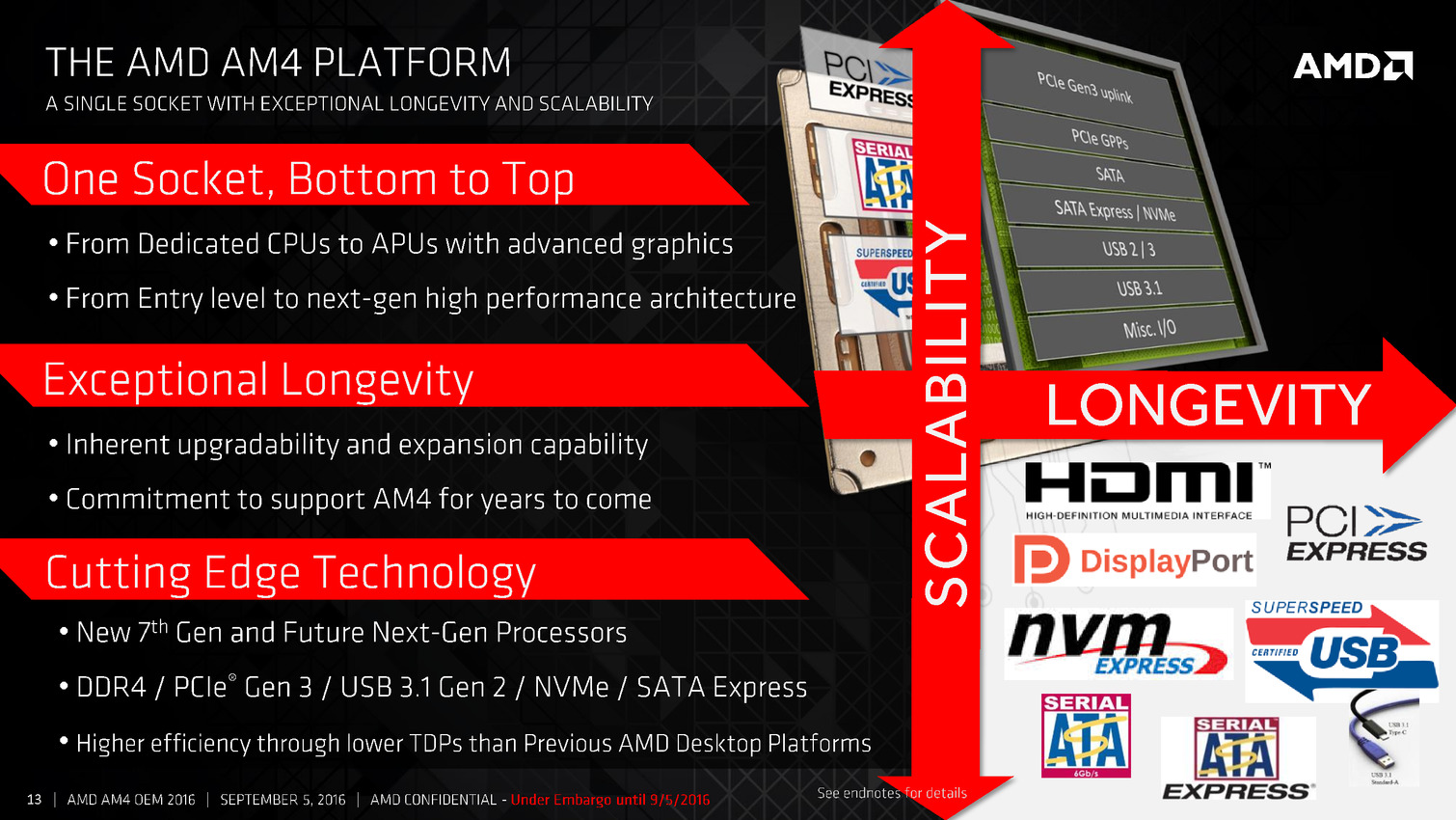

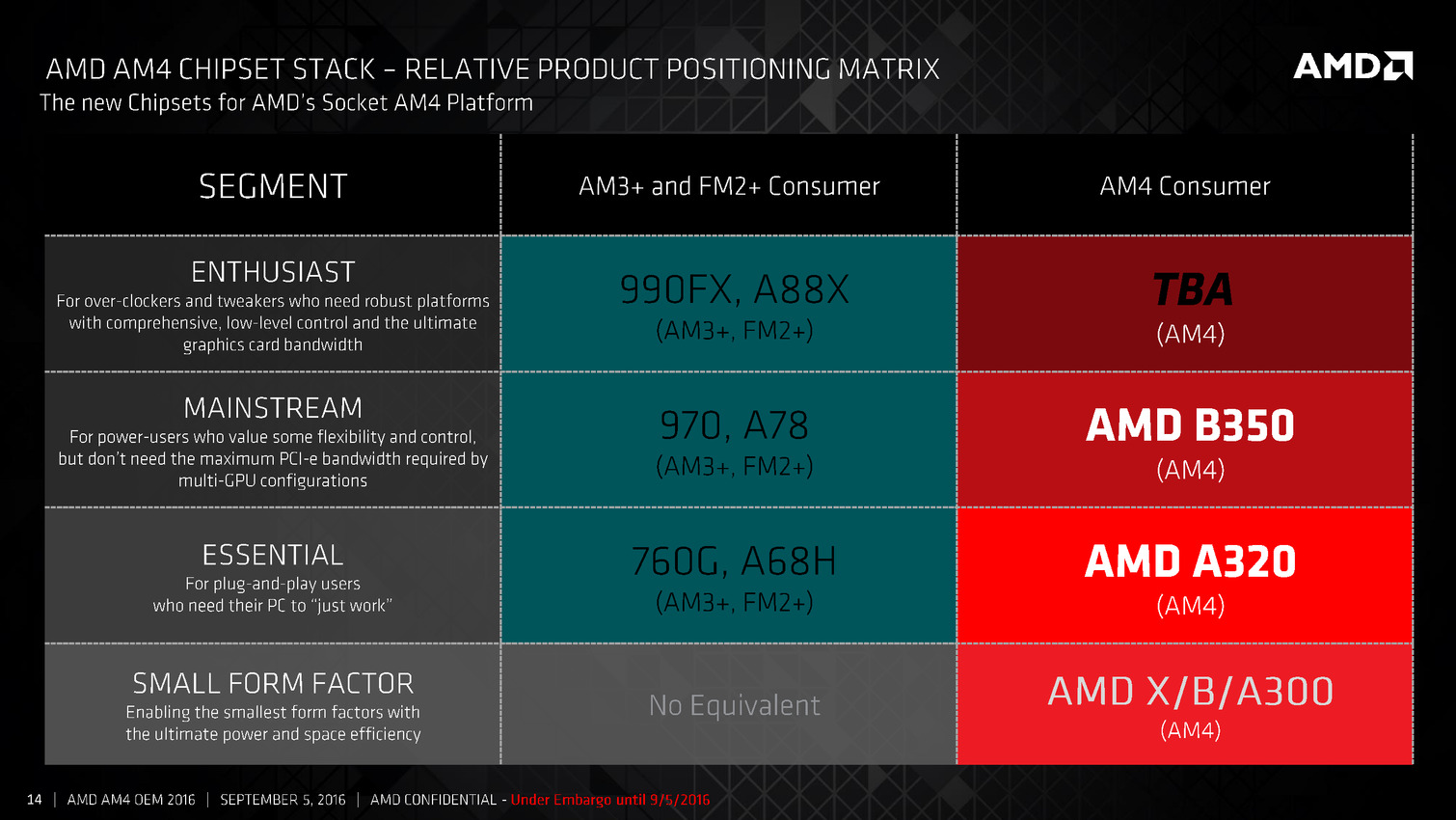

Contrairement aux APU précédentes, elles ne sont pas compatibles avec le socket FM2+, mais avec le nouveau socket AM4 qui sera également utilisé avec par les futurs Zen Summit Ridge.

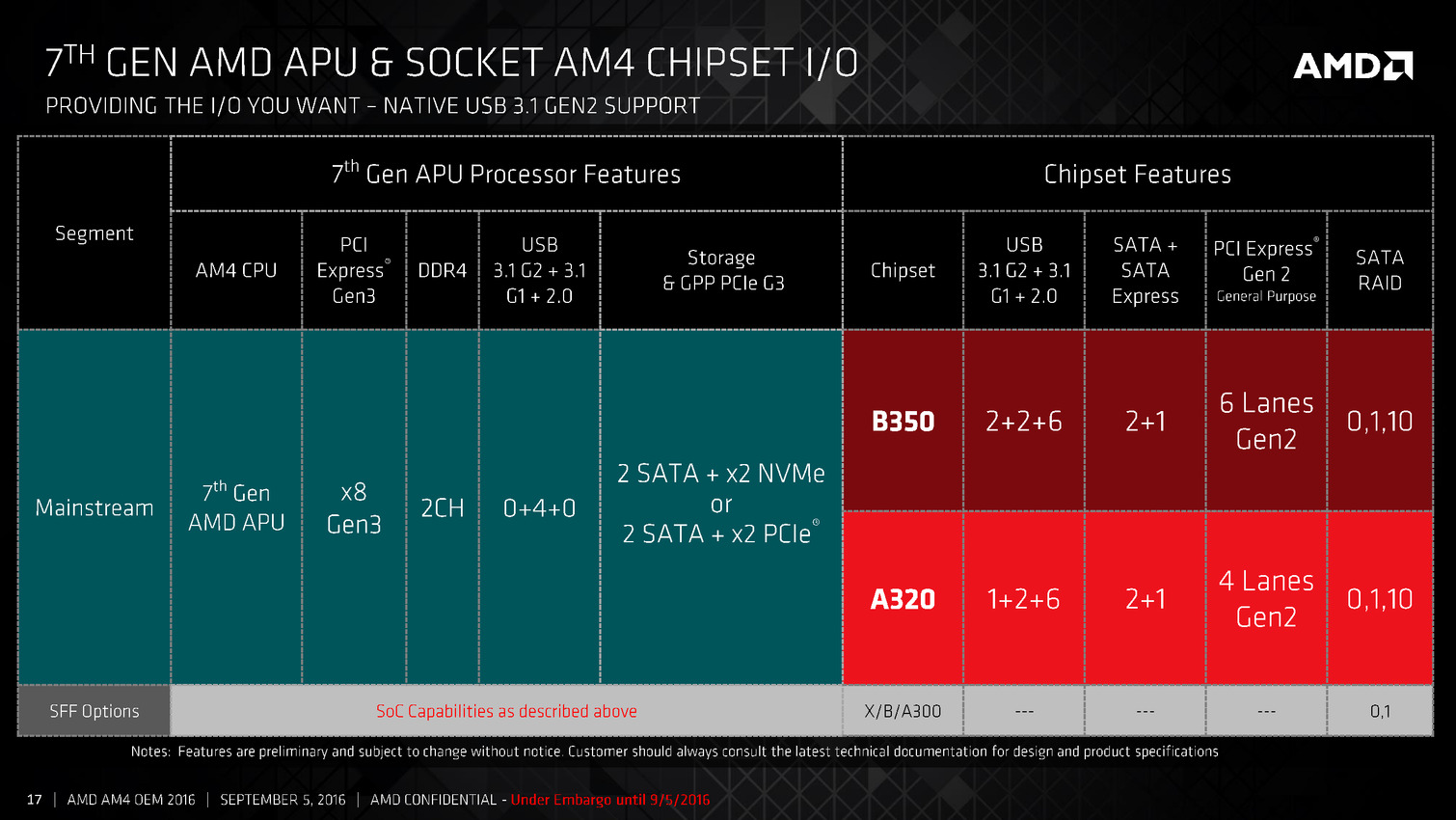

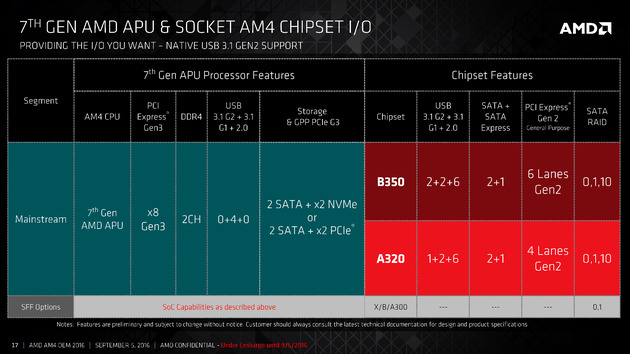

Deux chipsets ont été lancés pour l'occasion, les A320 et B350 mais nous notions qu'un modèle plus haut de gamme était prévu pour le lancement des Zen. Le site Benchlife confirme en annonçant le nom du chipset qui s'appellera X370.

Ce chipset devrait se retrouver sur des cartes mères plus haut de gamme qui seraient dévoilées au CES. Officiellement le lancement de Zen est prévu pour le premier trimestre, nos confrères s'avançant à parler d'une fenêtre probable pour le mois de février pour les Summit Ridge et les cartes mères X370.

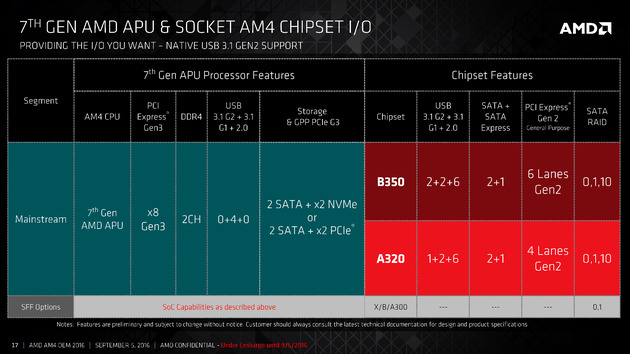

AMD lance les Bristol Ridge desktop OEM

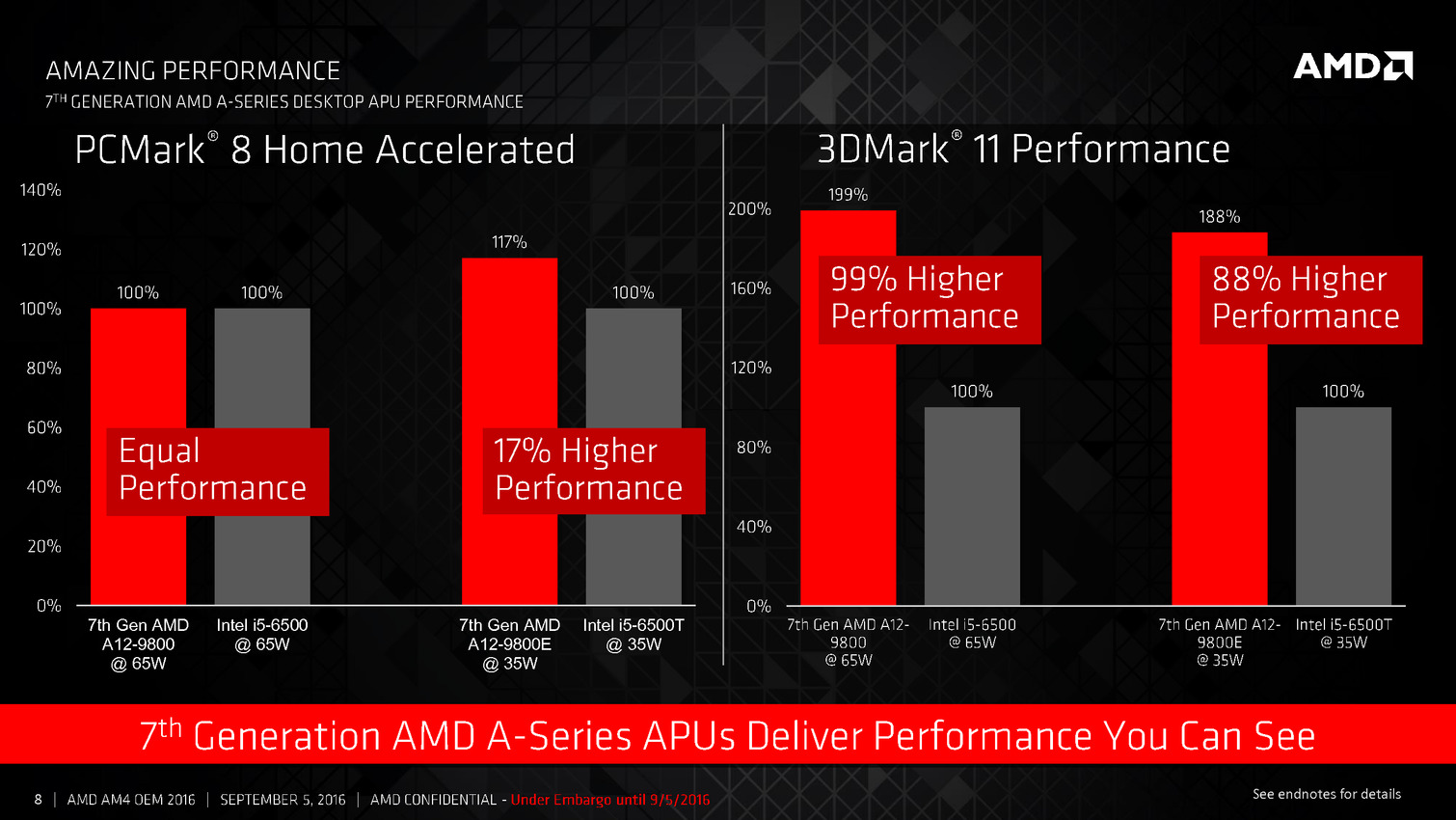

Après avoir annoncé les versions mobiles en juin, AMD lance aujourd'hui la version desktop de ses APU de "7ème génération", les Bristol Ridge. Le lancement s'est fait par le biais d'un simple communiqué de presse en ce jour férié aux Etats-Unis.

Le lancement est pourtant important puisque c'est en simultanée la première apparition de la nouvelle plateforme AM4 d'AMD, qui acceuillera non seulement les Bristol Ridge, mais également les Zen Summit Ridge. Une apparition toute relative puisque ce lancement est réservé aujourd'hui uniquement aux OEM.

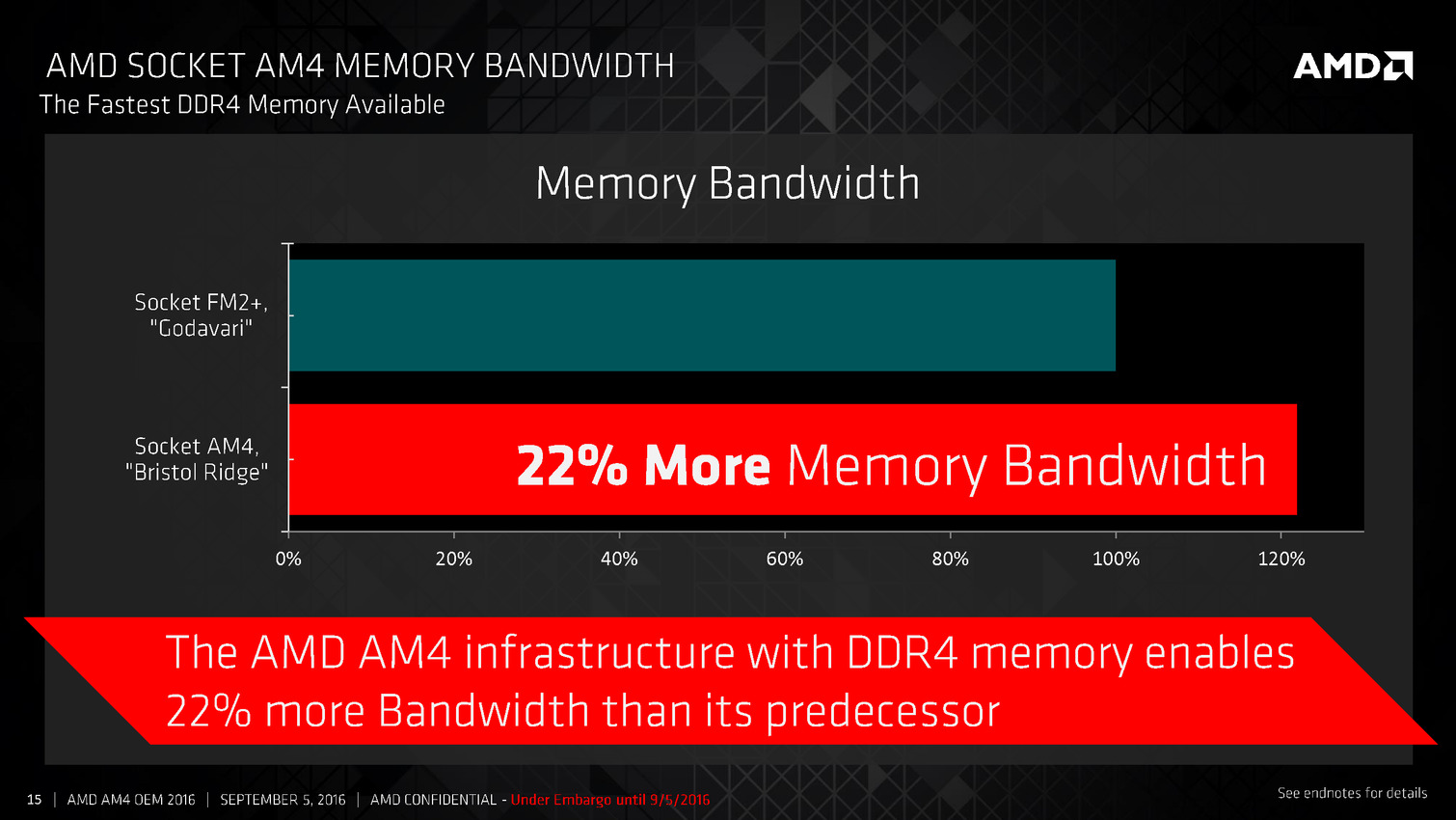

Par rapport aux APU desktop précédentes (Kaveri/Godavari), on trouve un peu plus de changement que côté mobile, en grande partie parce que Carrizo (duquel Bristol Ridge est très très proche) n'avait pas été décliné sur le socket FM2+.

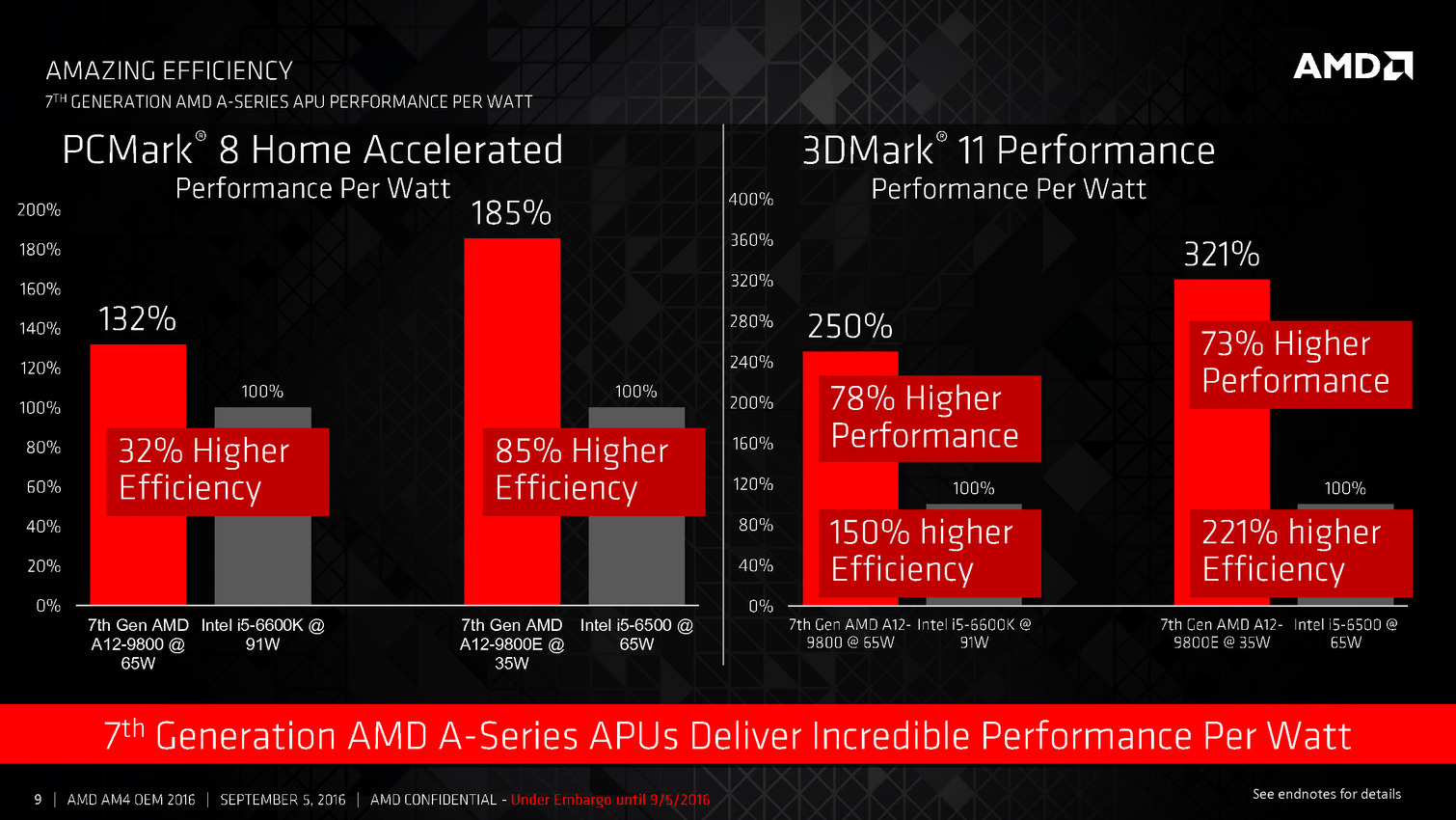

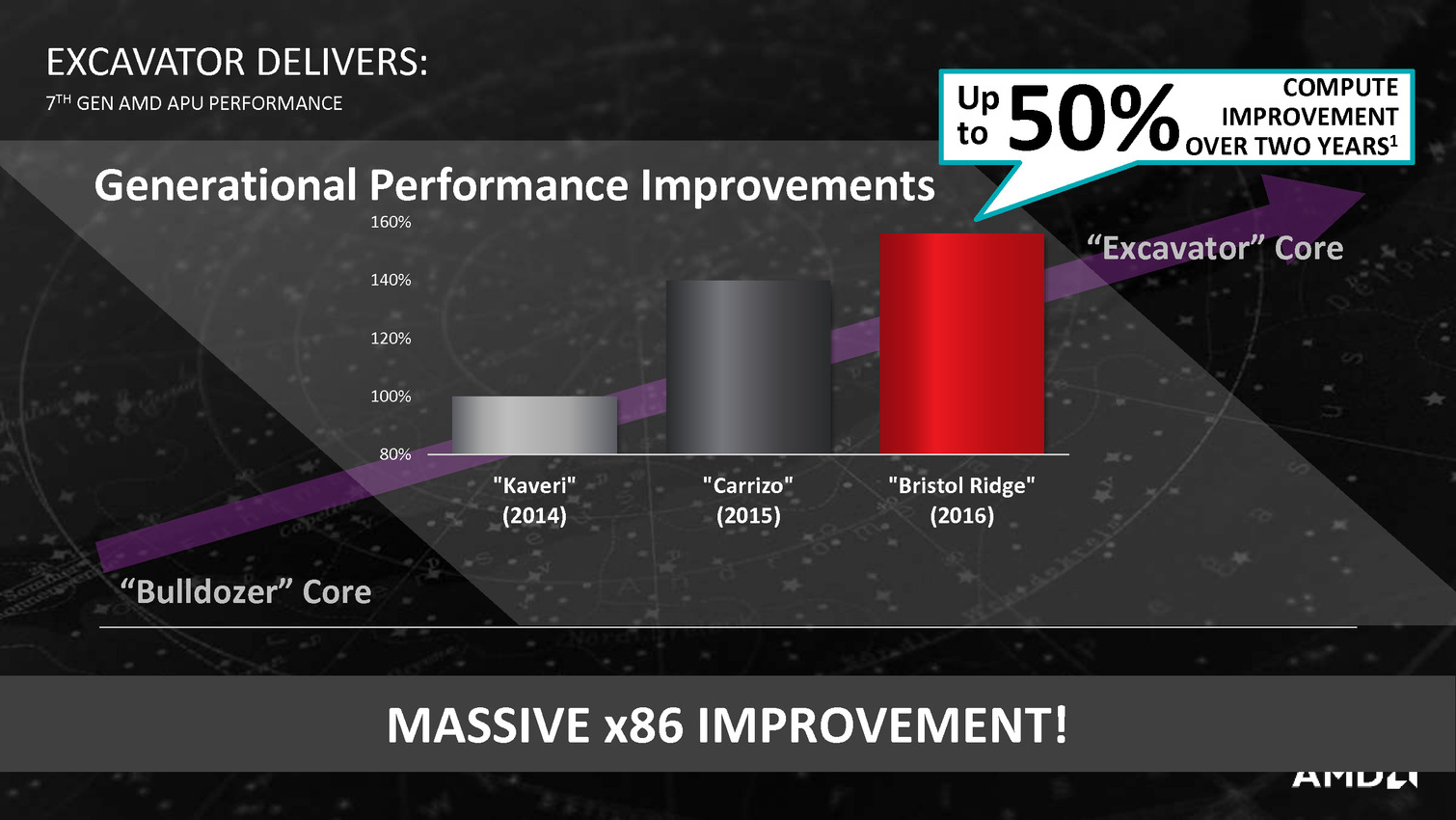

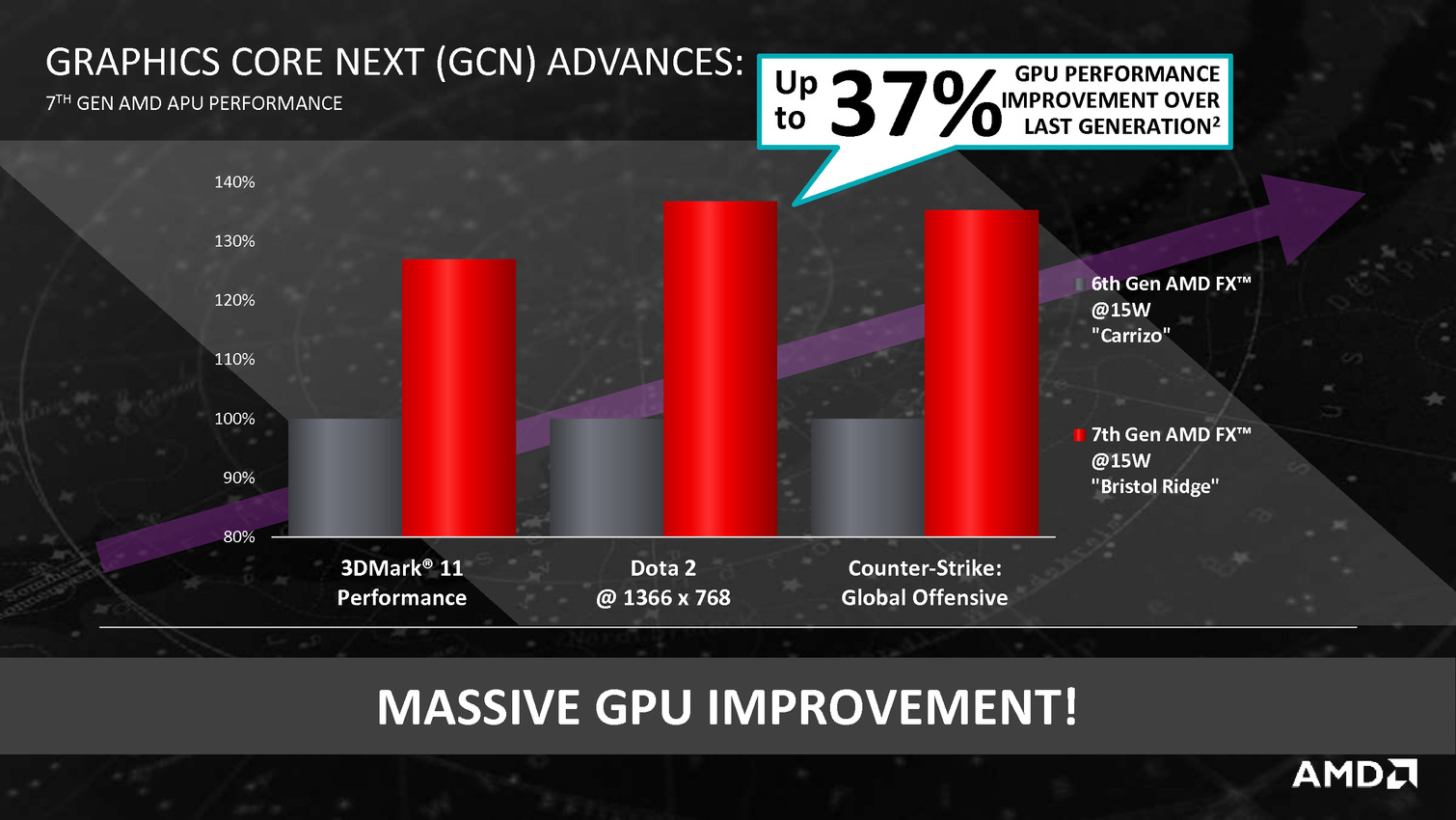

On reste bien entendu sur l'architecture Bulldozer, mais dans sa version Excavator contre SteamRoller précédemment, tandis que côté graphique on passe à la version 3 de GCN. De quoi proposer des gains d'efficacité par rapport a Kaveri... lancé début 2014.

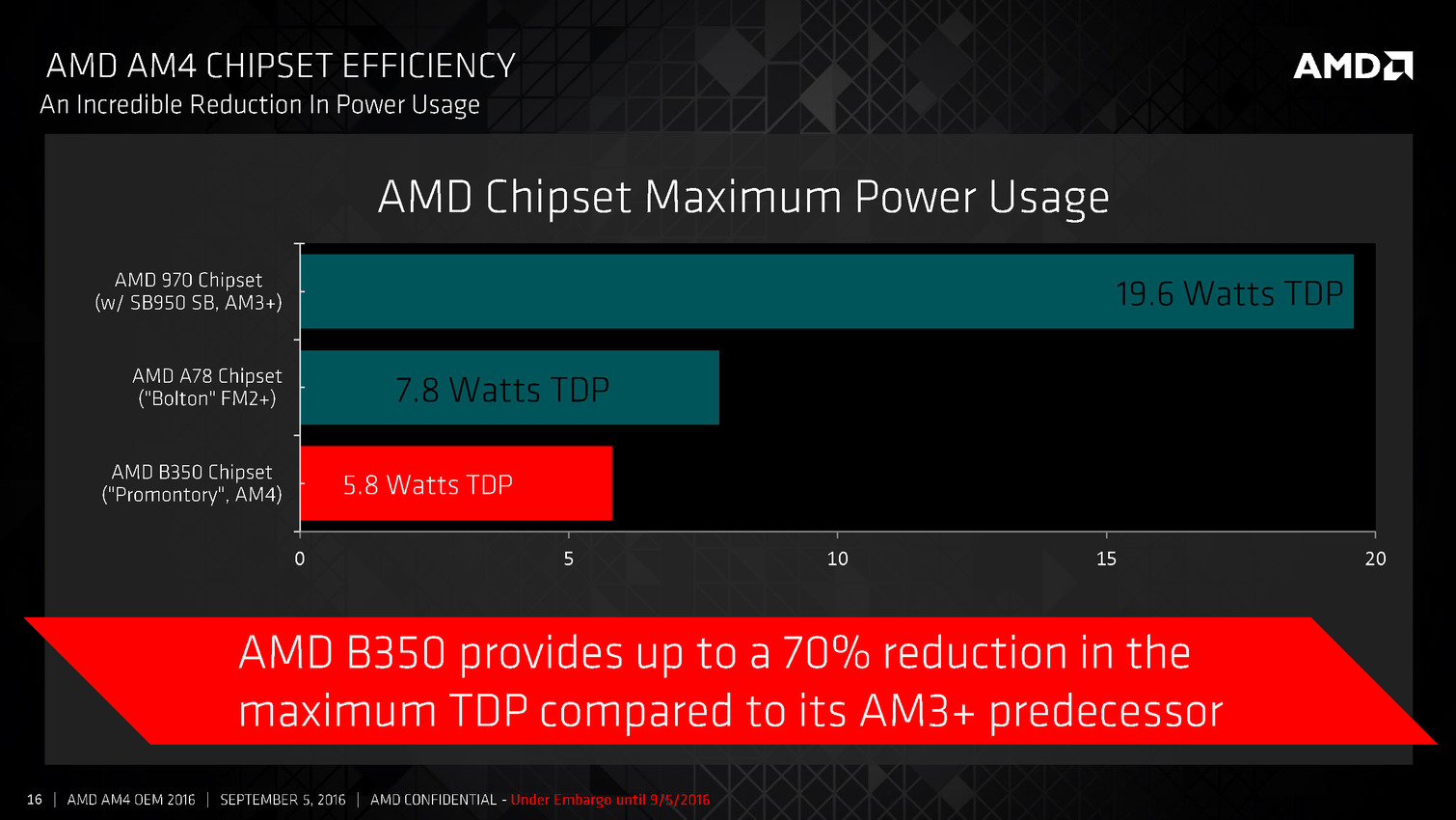

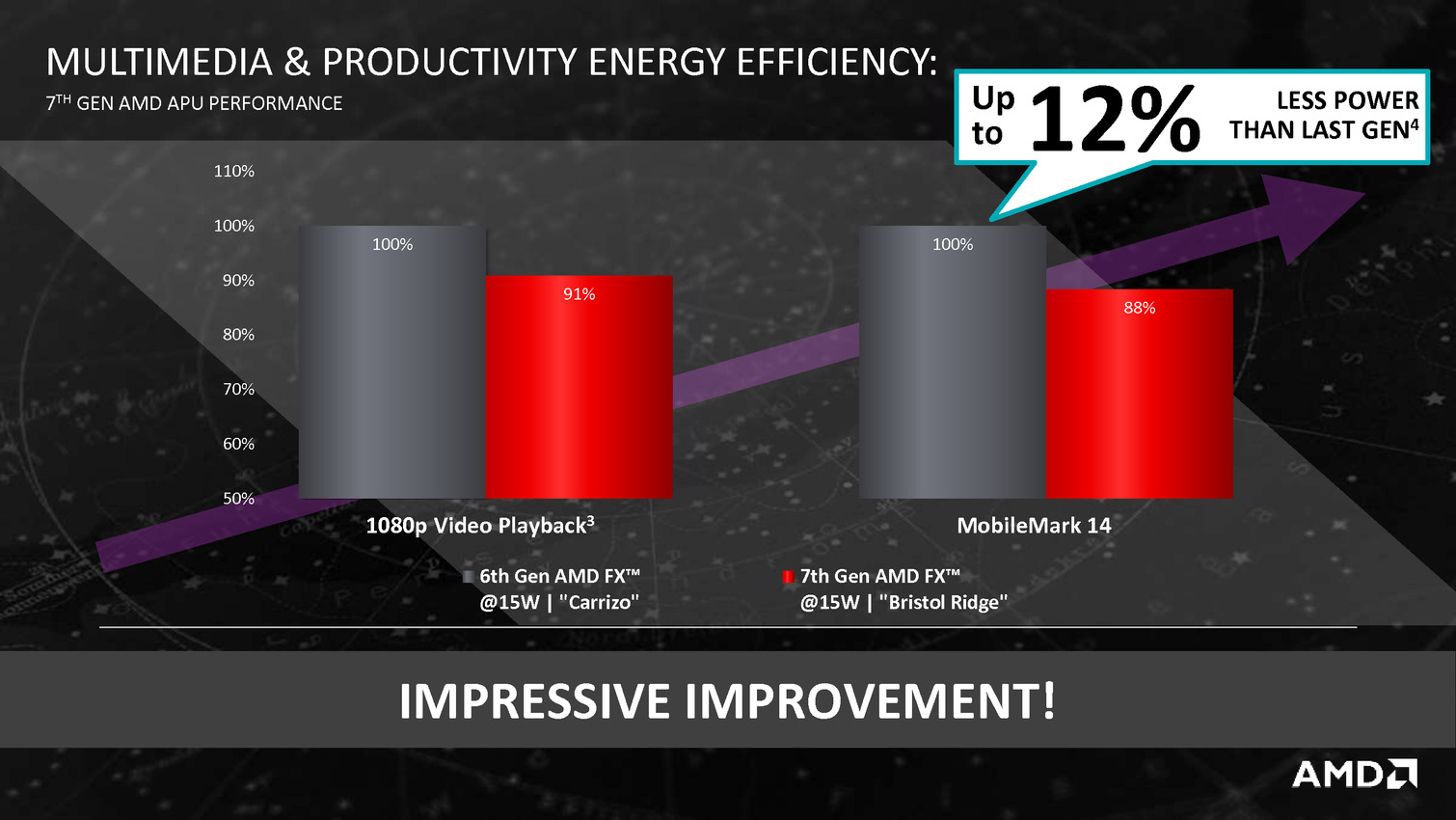

Cela permet à AMD de faire baisser le TDP : bien que l'on reste en 28nm, ces nouvelles APU sont annoncées pour 65 watts. Le modèle le plus haut de gamme, l'A12-9800 est cadencé à 3.8/4.2 GHz pour ses deux modules (4 coeurs), et 1108 MHz pour les 8 CU côté graphique. Des versions 35 watts sont également lancées.

Les Bristol Ridge sont pour rappel des SoC et intègrent entre autre 8 lignes PCIe Gen3, la gestion de quatre ports USB 3.0 ainsi que 2 SATA et deux lignes PCIe Gen3 supplémentaires pouvant être utilisées pour des ports NVMe. AMD lance en simultanée deux chipsets, les A320 (!) et B350 qui rajoutent des ports USB, y compris des ports 3.1 ainsi qu'un plus grand nombre de ports SATA et de lignes PCIe. Un modèle spécifique "Enthusiast" sera annoncé plus tard, on l'imagine à l'occasion de la sortie de Zen.

AMD indique que ces puces seront disponibles dans un premier temps uniquement dans des configurations HP et Lenovo, et que d'autres OEM suivront.

Le communiqué de presse évite par contre la question d'une disponibilité de ces puces en dehors des OEM, ce qui élude la question du prix (la liste de prix d'AMD n'a pas encore été mise à jour au moment ou nous écrivons ces lignes).

Vous pouvez retrouver l'intégralité de la présentation ci-dessous :

AMD détaille l'architecture de Zen

Comme annoncé, AMD a profité de la conférence Hot Chips pour dévoiler les détails de l'architecture des cores CPU Zen, utilisée par ses prochains processeurs. AMD avait déjà dévoilé la semaine dernière quelques grandes lignes, cette fois on dispose de beaucoup plus de détails techniques.

Notez qu'en ce qui concerne les versions disponibles des puces, le nombre de cores, la fréquence, ou le fonctionnement du contrôleur mémoire, il faudra attendre, AMD ne dévoilera ce type de détails qu'ultérieurement. On a tout de même droit à nombre de détails techniques.

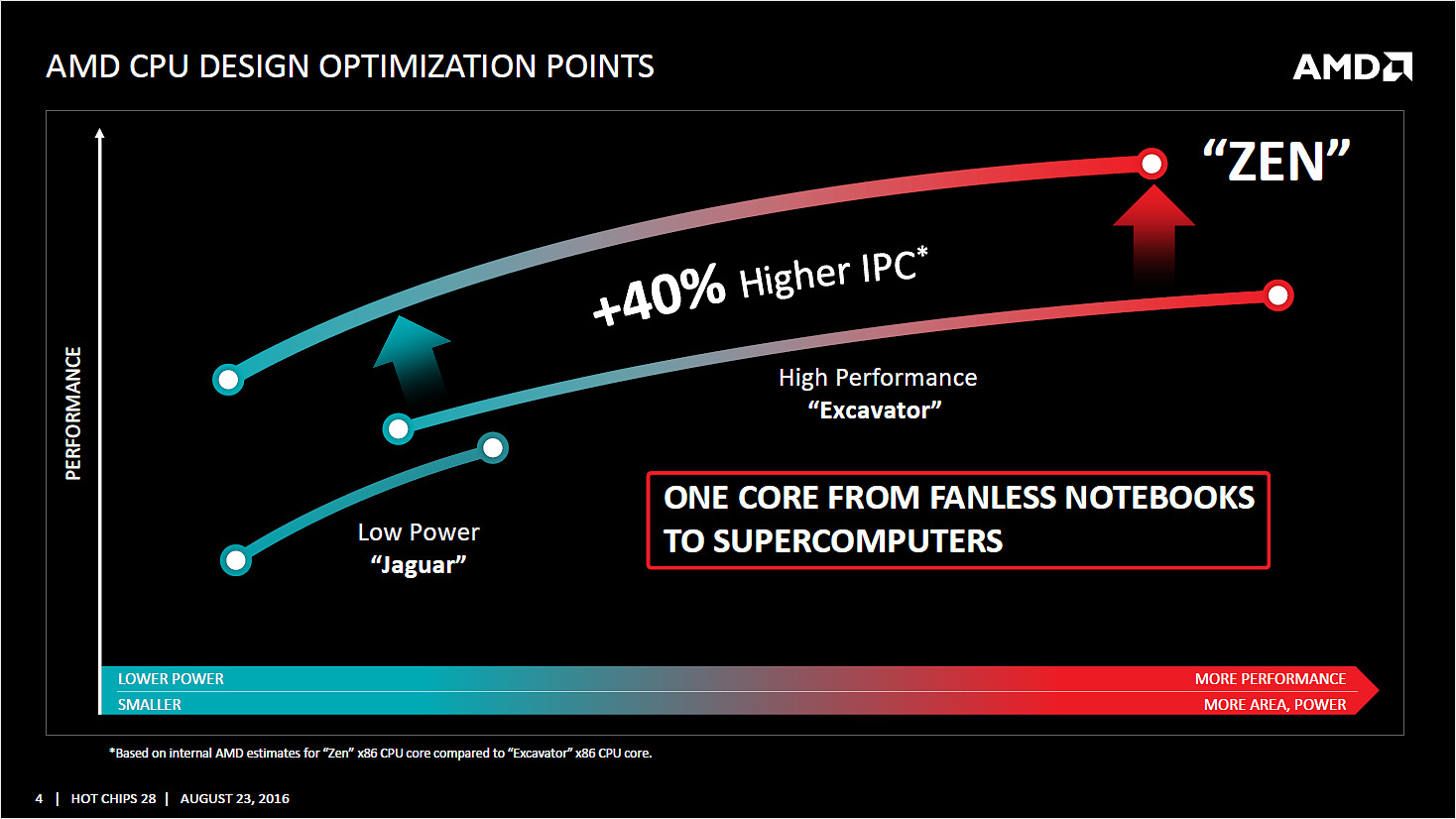

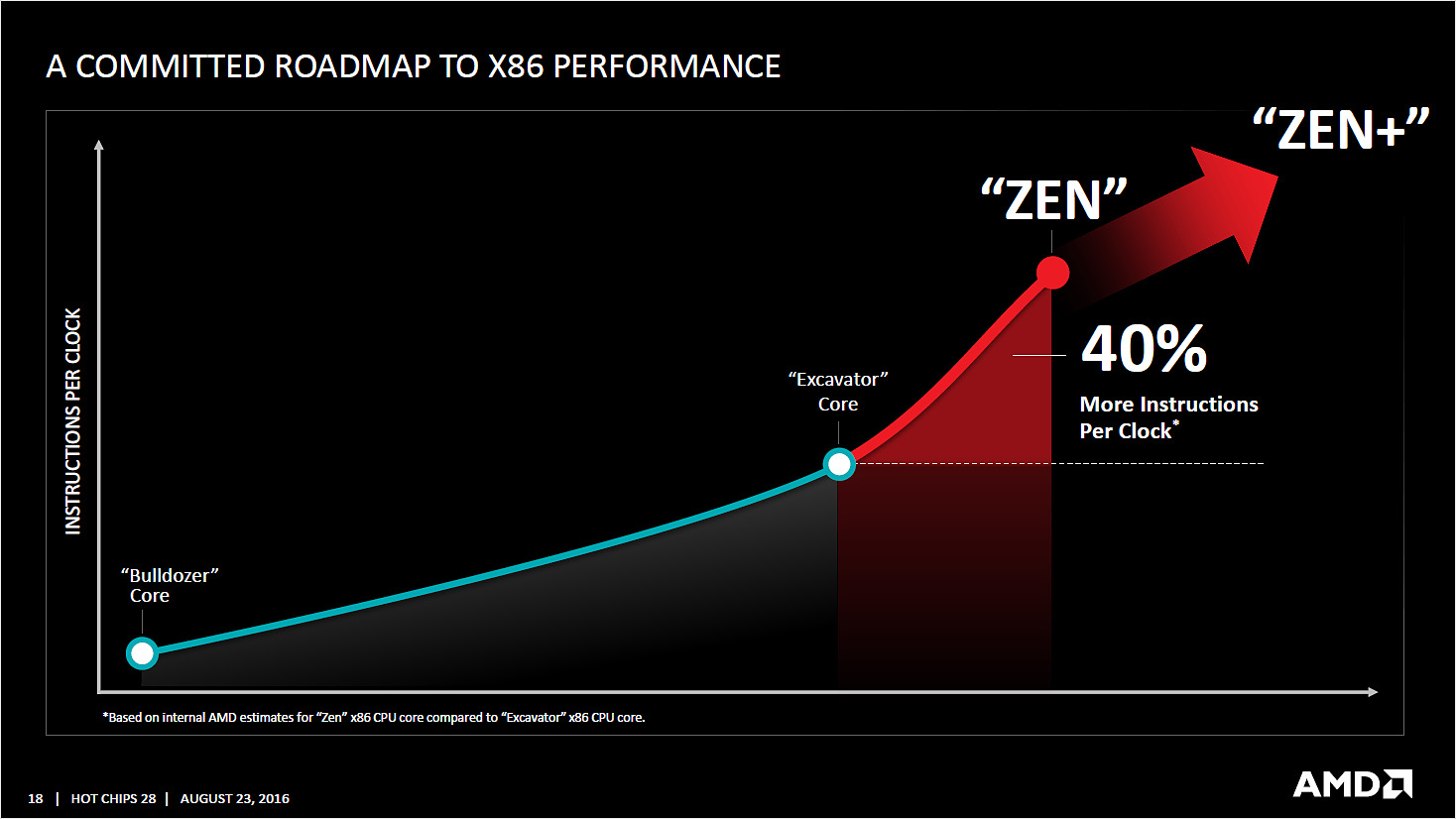

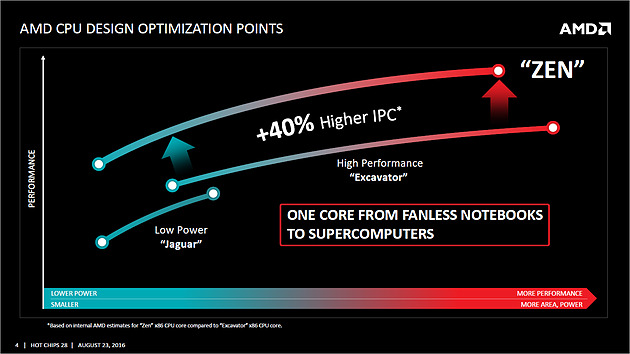

Le message de base d'AMD est de dire que l'architecture est repartie d'une feuille blanche, même si AMD concède avoir réutilisé certains blocs fonctionnels de ses architectures précédentes. En pratique, Zen aura été développé pour remplacer intégralement Jaguar et Excavator, ce qui laisse penser qu'on verra Zen décliné dans de larges gammes de TDP dans les mois à venir.

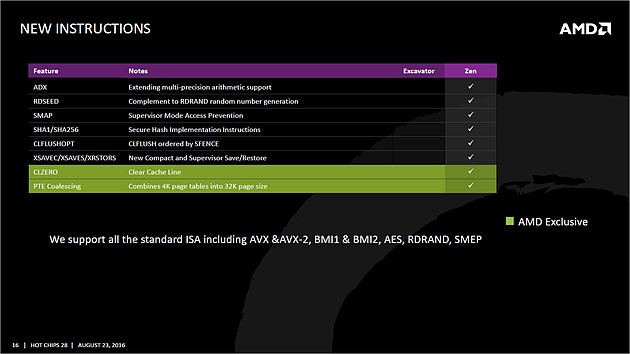

Le jeu d'instruction

Avant d'entrer dans les détails, un point sur les jeux d'instructions. AMD se met à jour en supportant à peu près toutes les extensions existantes, on retrouve ainsi AVX et AVX2, l'accélération des instructions SHA, mais aussi des choses plus originales comme les instructions de mémoire transactionnelle (TSX), introduites avec assez peu de succès par Intel pour Haswell. AMD rajoute en prime deux instructions, dont une pour libérer une ligne de cache, et l'autre pour combiner des pages mémoires. AMD est donc aligné sur ce que proposait Intel jusque Broadwell, Skylake n'ajoutant que SGX et MPX dont l'utilisation est plus particulière.

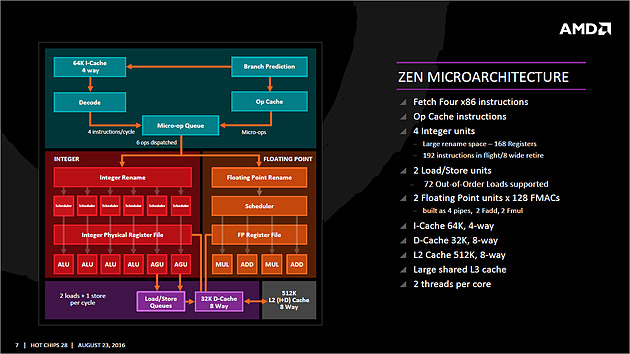

Zen dans les grandes lignes

Ce schéma des grandes lignes avait déjà été présenté mais désormais AMD y accole beaucoup plus de détails. Pour rappel ce schéma commence en haut à droite, avec la partie Branch Prediction ou les instructions arrivent avant d'être décodées. Le point important à retenir est qu'AMD distingue clairement le chemin "Integer" (bloc rouge, opérations sur les nombres entiers, et toutes les opérations classiques comme les boucles, etc...) et le chemin "Floating Point" (bloc orange, opération sur les nombres à virgules). Ils disposent de chaque côté de leurs propres schedulers et Mike Clark, l'architecte en chef de Zen qui a effectué la présentation pour AMD les décrit comme des coprocesseurs indépendants.

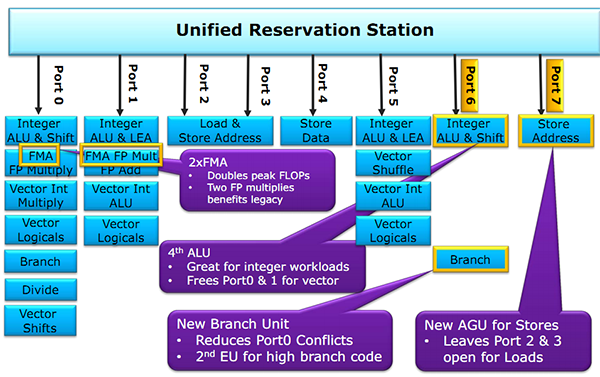

Schéma de fonctionnement des Haswell avec leurs ports d'exécution qui mélangent entiers et flottants sur les ports 0 et 1

Comme vous pouvez le voir ci dessus, il s'agit d'une implémentation qui diffère de ce que propose Intel sur ses architectures Core ou les instructions flottantes sont traitées sur les mêmes ports que les autres instructions (un port peut regrouper plusieurs unités d'execution), avec un scheduler unique. Par le passé, cette scission était nécessaire pour AMD, l'architecture Bulldozer regroupait dans un module deux blocs "Integer" et partageait un seul bloc "Floating Point". Ce qui ressemblait a une bonne idée s'est heurtée à de nombreux problèmes sur Bulldozer et ses dérivés. AMD a voulu conserver l'idée de la séparation tout en résolvant les problèmes restant, nous y reviendrons.

Le front-end

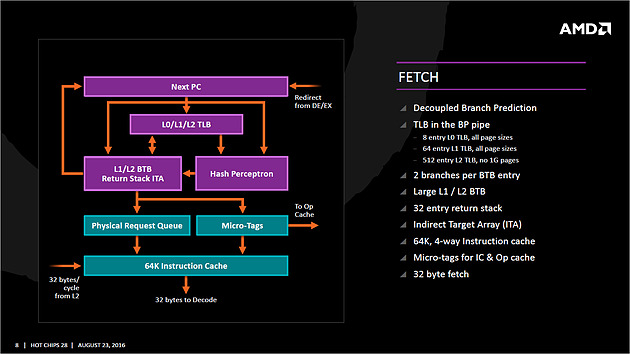

Tout en haut du graphique d'architecture précédent, on retrouve la partie du front end qui récupère (fetch) les instructions. Son rôle est d'extraire les instructions à exécuter, la prédiction de branchements (on parle de conditions, si elle est vraie, effectue ceci, sinon, effectue cela) tentant de déterminer lesquels seront nécessaires. Le TLB (un cache pour traduire les adresses mémoires virtuelles) est intégré et tout le mécanisme a été amélioré pour être plus efficace en ajoutant une table pour les adresses de retour des branches (l'endroit ou l'exécution doit se poursuivre à la fin de la branche, le bloc d'instruction exécuté après la condition).

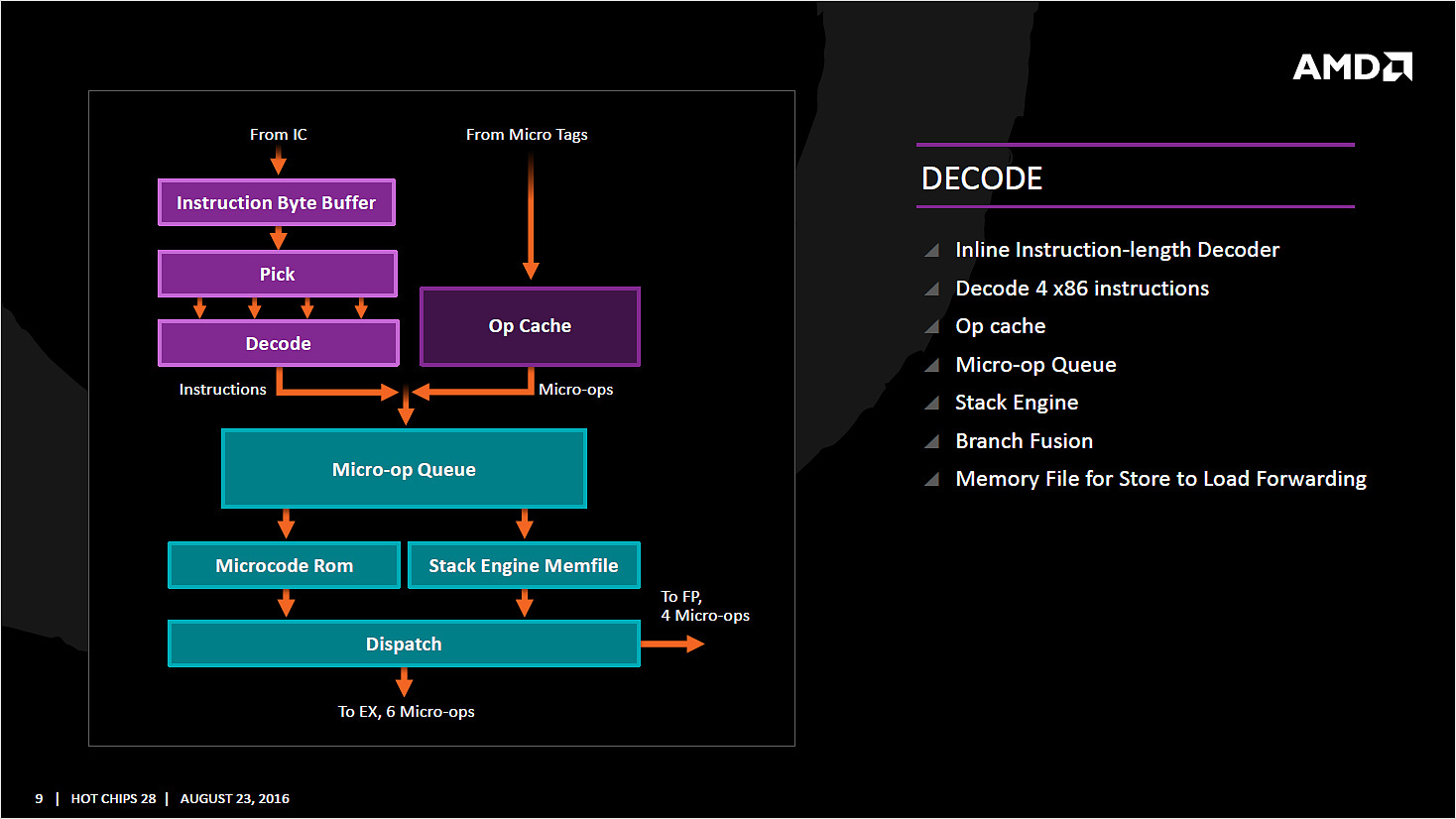

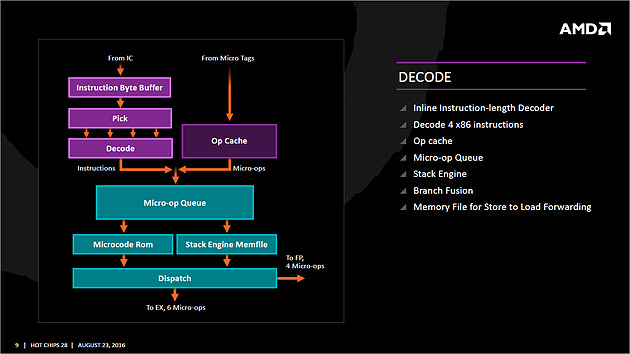

Les instructions récupérées vont ensuite être placées dans le cache d'instruction avant d'être décodées. C'est ici que les instructions x86 sont lues par le processeur, qui les transforme en des micro-opérations (micro-op) qui seront exécutées par la suite dans le pipeline. Les décodeurs sont capables de traiter jusque quatre instructions par cycle (c'est équivalent à ce que propose Intel sur Haswell et Skylake) qui sont transformés en jusque 6 micro-op. Certaines instructions peuvent être fusionnées en une seule micro-op (notamment celles de branchements), la encore les similarités avec ce que propose Intel sont fortes.

Comme chez Intel, AMD utilise un cache qui stocke la correspondance entre une instruction décodée et la micro opération qui en est issue. Le jeu d'instruction x86 comportant un bon millier d'instructions de tailles variables, l'idée est de garder en cache les instructions les plus récemment décodées en mémoire pour pouvoir les traduire automatiquement en micro-op sans repasser par la case décodage. Cela permet d'ajouter plusieurs micro-op supplémentaires par cycles a traiter.

Par rapport à ses architectures précédentes, AMD dit avoir "significativement" augmenté la taille de son Op Cache et que ce seul changement est responsable d'une grande partie des gains d'IPC et de consommation. On y retrouve une logique semblable aux évolutions architecturales que l'on a vu à la concurrence : le front end joue un rôle excessivement important dans les architectures x86 sur les performances du reste de la puce. Le voir soigné de la sorte est plutôt une bonne nouvelle pour Zen même si comme toujours nous réserverons notre jugement en pratique !

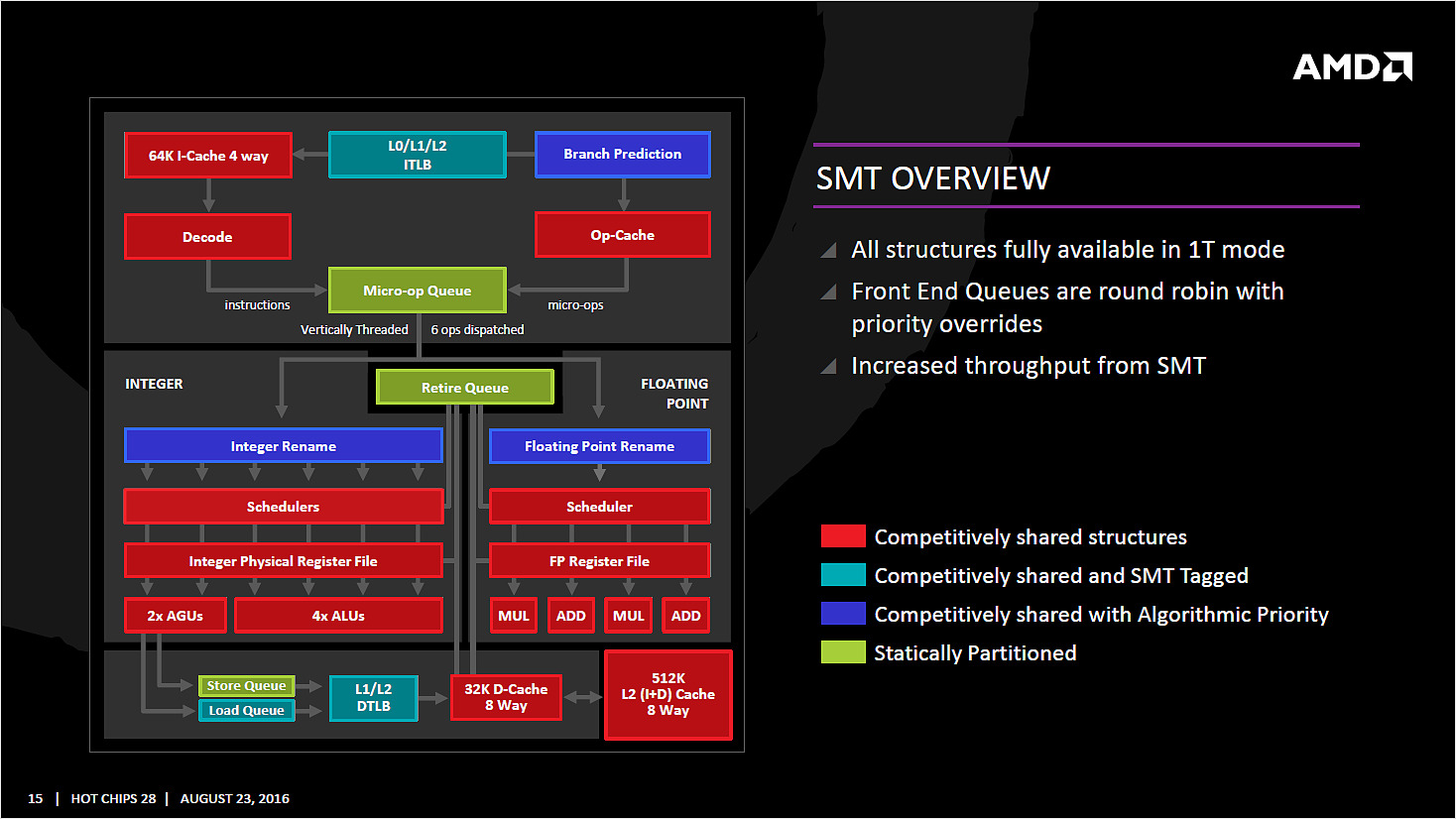

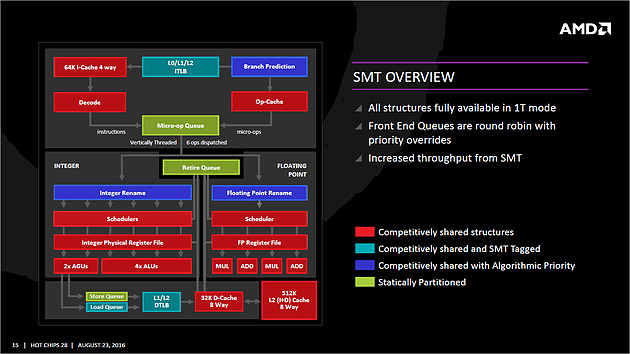

On notera que les micro-ops sont placées dans une file, ou plus exactement deux files. AMD implémente pour rappel le SMT (Simultaneous Multi Threading) qui permet de gérer deux threads par coeur (l'HyperThreading est le nom marketing de l'implémentation SMT d'Intel). La file de micro-op est ainsi scindée en deux (ce qui est identique à ce que fait Intel pour Sandy Bridge et Skylake, Haswell ayant utilisé une file commune). Les instructions vont enfin être dispatchées vers les ports. En pratique 10 micro ops peuvent être envoyées (6 vers la partie "Integer" de la puce, 4 vers la partie "Floating Point"), soit deux de plus que sur Haswell (Intel ne nous a pas donné l'information pour Skylake).

Les unités d'executions

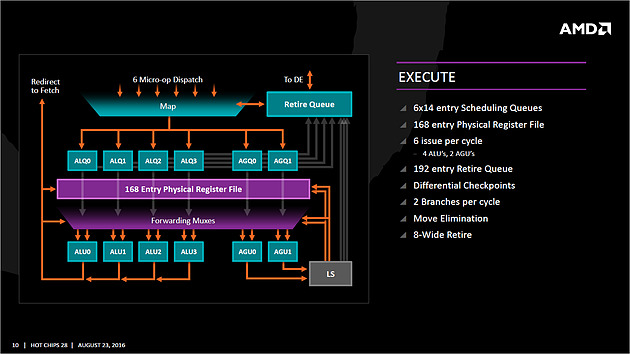

Les micro-op vont être dispatchées vers 6 files d'exécution (l'équivalent des ports d'Intel) dont la taille a été significativement augmentée (14 entrées par file, soit 84 pour cette partie de la puce, Skylake en compte 97 en tout mais il faut ajouter celles dédiées aux opérations FP, nous y reviendrons). AMD dispose de deux files dédiées aux opérations mémoires (AGU, adress génération unit) qui asservissent un système de lecture/écriture mémoire (Load/Store) sur lequel on reviendra. Quatre files sont dédiées aux instructions de "calcul" et de branchements. AMD les appelle ALU sur son schéma, il s'agit en pratique d'une série d'unités d'executions. Chaque ALU regroupe au minimum la possibilité de traiter les instructions logiques de base. AMD ne le détaille pas sur son schéma, mais d'autres unités sont présentes.

Le constructeur nous a confirmé que deux des ALU contiennent une unité dédiée au branchement, une ALU contient une unité gérant les divisions, une ALU contient une unité gérant les multiplications entières, et enfin une ALU contient une unité dédié au CRC32. AMD ne détaille pas la répartition exacte des unités sur les ALU, mais on apprécie les détails supplémentaires qui ont été donnés. L'efficacité de ces unités dépendra en grande partie de la capacité du front-end a les alimenter, mais sur le papier là encore, le design semble largement adéquat.

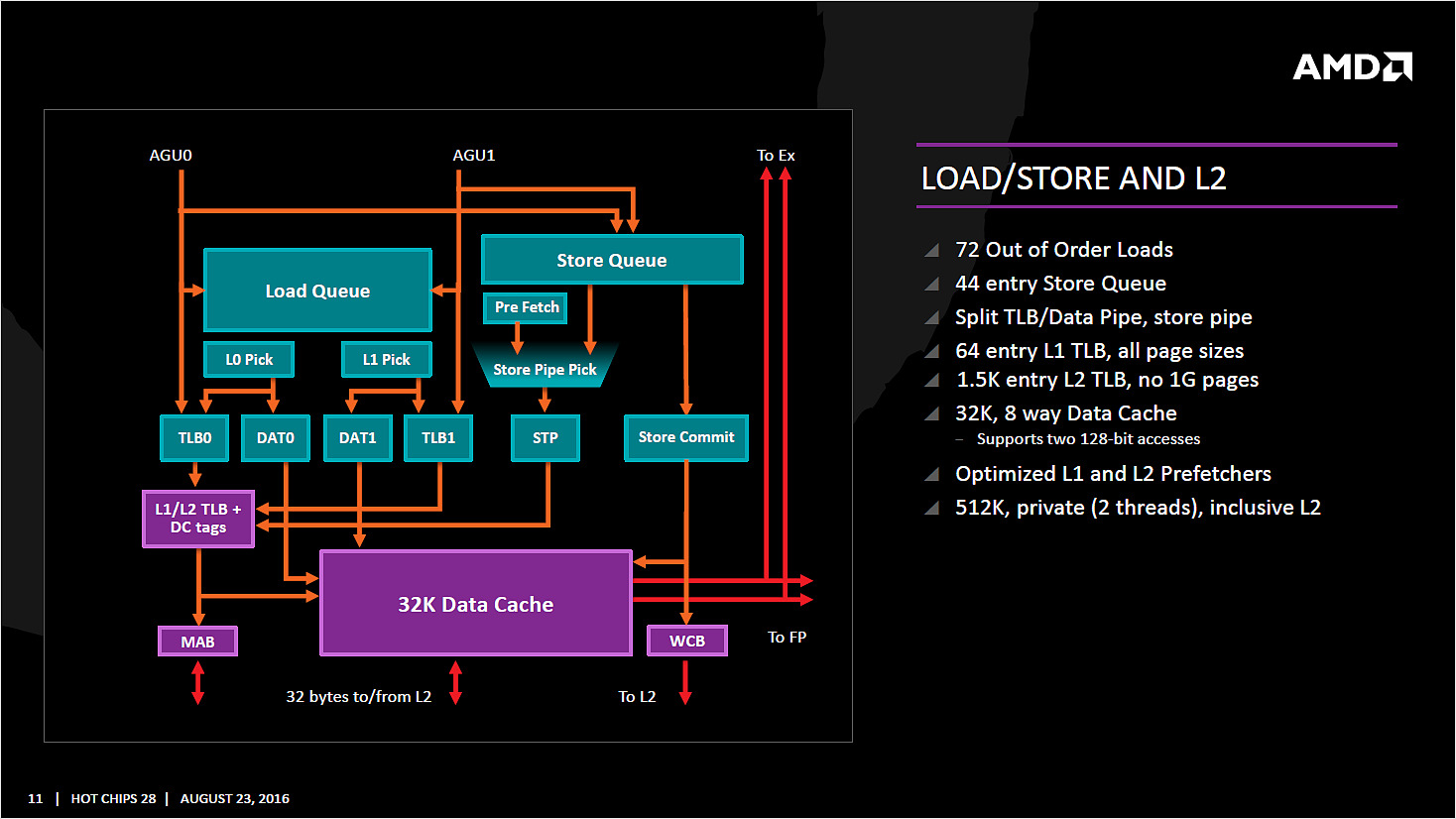

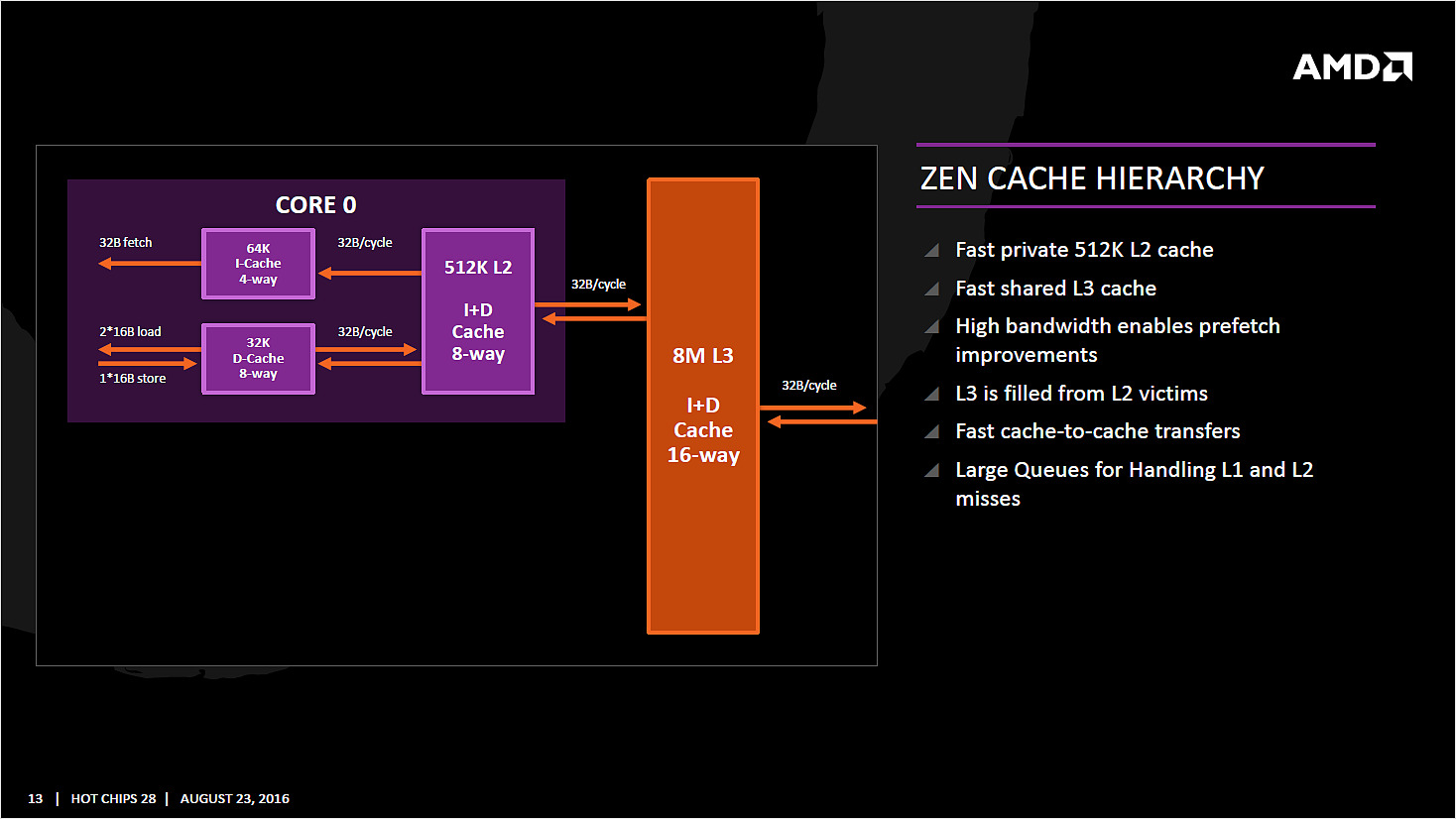

Comme nous le disions, les AGU asservissent les unités qui lisent et écrivent les données dans le sous système de cache. On retrouve des longueurs de files comparables à ce que l'on a chez le concurrent (72/44 pour Zen, 72/42 pour Haswell et 72/56 pour Skylake). Pour les chargements, AMD rentre dans le détail en indiquant qu'un des autres points faibles de ses architectures précédentes était lié aux opérations de chargement mémoire. Deux accès séparés 128 bits en lecture sont désormais possibles, et les unités peuvent accéder en simultanée au cache L1 et au cache TLB pour maximiser le débit, et ainsi streamer les données rapidement du cache L2 vers le L1.

L'efficacité des prefetchers (qui tentent de récupérer les informations en avance du moment ou le processeur en aura besoin) est indiquée comme meilleure et là encore il faudra attendre pour en savoir plus. Si AMD ne donne pas la rapidité de ses caches, il nous a été confirmé que la bande passante pratique est significativement plus rapide désormais, ce qu'on ne manquera pas de vérifier.

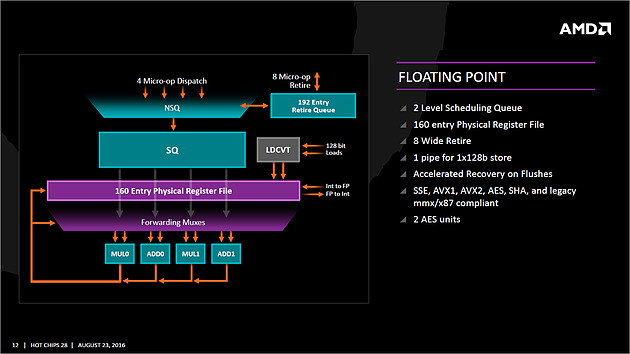

Si l'on revient en arrière, le dispatcher de micro-op pouvait envoyer jusque 6 instructions vers la partie Integer, et quatre vers la partie Floating point. Le scheduler dédié aux unités flottantes dispose ici de 96 entrées ce qui nous donne un total de 180 entrées par coeur (contre 97 pour Skylake). Il s'agit même en pratique d'un double scheduler.

C'était l'un des points faibles du design séparé que l'on évoquait plus haut : sur Bulldozer un scheduler trop petit sur la partie FP pouvait arriver à bloquer la partie Integer du CPU, un cas qui visiblement était assez fréquent. Avec un double scheduler, AMD dit avoir résolu le problème en pratique. On disposerais désormais bel et bien de deux blocs réellement indépendants pouvant travailler en parallèle (et ne se bloquant plus l'un l'autre).

Quatre unités d'exécution FP 128 bits sont donc présentes, deux dédiées plus spécifiquement aux multiplications et deux aux additions. Elles peuvent être combinées pour réaliser jusque 2 FMA 128 bits en parallèle par cycle. Sur ce point AMD est en retrait puisque Haswell pouvait effectuer deux FMA 256 bits par cycle. Il faudra voir l'impact pratique sur les performances, mais sur de micro benchmarks ou des cas spécifiques, ce sera un point limitant pour Zen.

Les caches mémoires

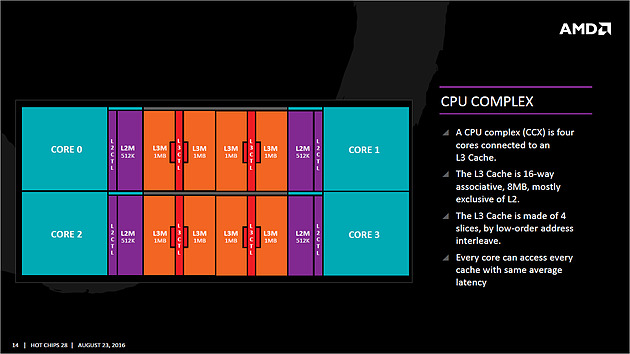

Sortons de la partie exécution pour regarder plus précisément les caches mémoires. AMD a choisi d'utiliser un cache L1 write back au lieu du write through utilisé précédemment, s'alignant là aussi sur ce que fait Intel. Cela devrait assurer une bien meilleure bande passante mémoire pour le L1 dont la taille est de 32 Ko. Chaque coeur dispose en prime d'un cache L2 de 512 Ko (le double de Skylake), et l'on retrouve un cache L3 partagé de 8 Mo assez spécial. Il est en prime (principalement) exclusif par rapport au cache L2.

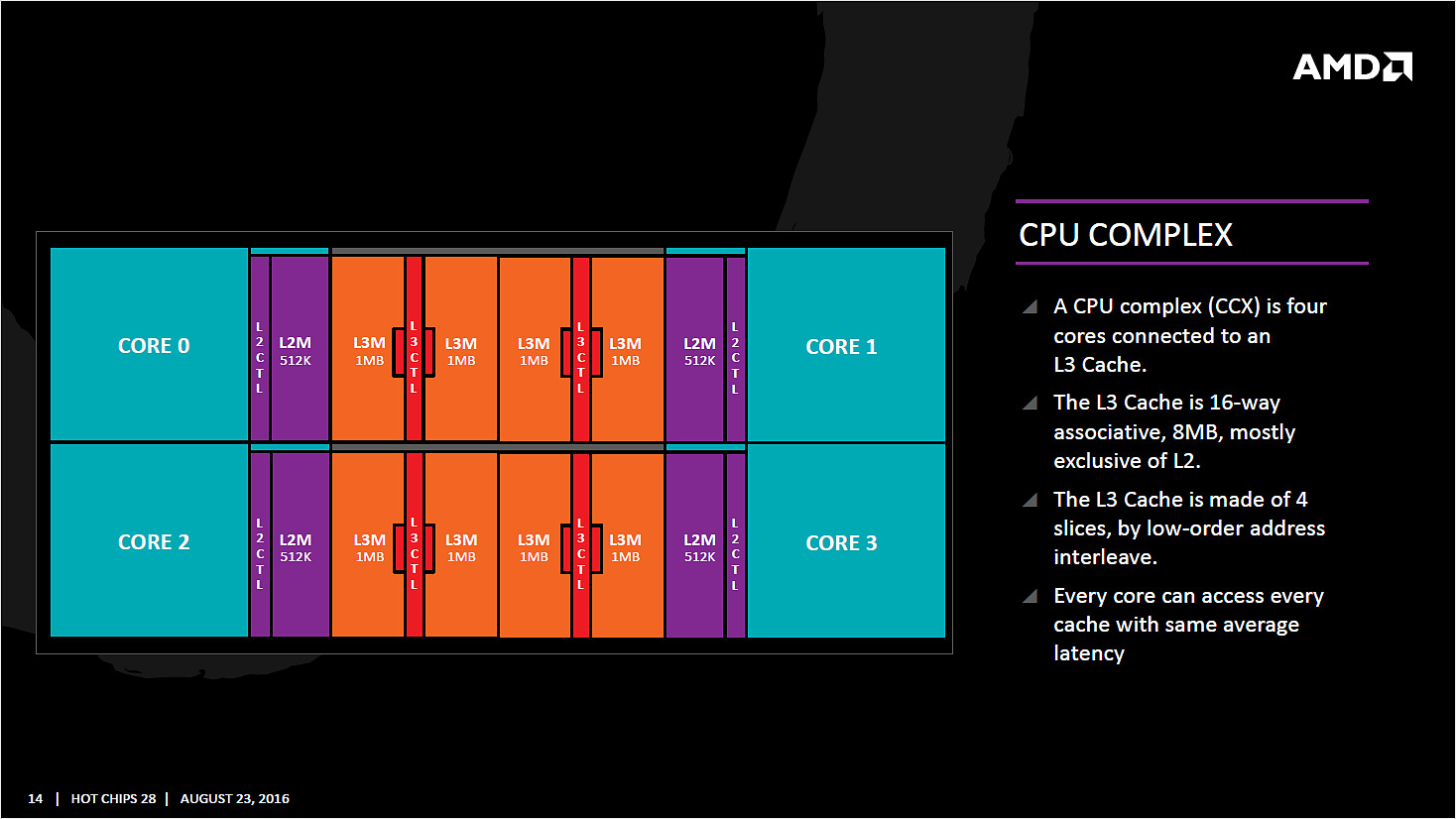

Les blocs de coeurs

C'est l'un des rares détails d'un peu plus haut niveau qu'aura partagé AMD : les coeurs Zen sont regroupés par blocs de quatre. Chaque coeur comme indiqué plus haut est relié a son propre cache L2 de 512 Ko, et également à 2 Mo de cache L3. Ces quatre partitions de cache L3 sont reliées ensemble et chaque coeur peut accéder a chacune des partitions. Selon l'emplacement des données, la latence ne sera pas la même, même si AMD n'a pas voulu quantifier l'éventuelle différence (on admirera la manière dont AMD a tenté de détourner le sujet en parlant de latence moyenne !). Chaque CCX (le nom donné au groupe) dispose donc au total de 8 Mo de cache, et AMD peut ainsi construire des puces utilisant plusieurs modules CCX.

Ces derniers sont reliés point à point au reste du système (notamment au contrôleur mémoire, etc) par un data fabric, un système de bus interne. Dans le cas d'une puce disposant de deux CCX, un coeur souhaitant accéder à la mémoire L3 de l'autre bloc CCX passera par les blocs en amont du contrôleur mémoire, avec un système de cohérence type MOESI. Il n'y a pas de lien direct point à point entre les CCX à ce qui nous a été indiqué, en tout cas pour ce qui concerne les premières versions de Zen (les déclinaisons serveurs pourraient être reliées différemment). On notera enfin que les coeurs/L2 et le L3 disposent d'un plan de fréquence séparé.

Un dernier mot sur le Simultaneous Multi Threading

AMD a terminé sa présentation en indiquant avec beaucoup de précisions la manière dont les blocs sont partagés lorsque l'on utilise le SMT. En pratique il n'y a que très peu de cas ou AMD partitionne en deux des buffers pour chacun des threads. C'est le cas, nous l'avons vu plus haut, de la file de micro-op principale, et l'on notera que c'est le cas aussi pour la file d'écriture vers les caches. Les autres structures sont partagées entre les threads en fonction des besoins, ce qui est plutôt une bonne nouvelle là aussi.

En résumé

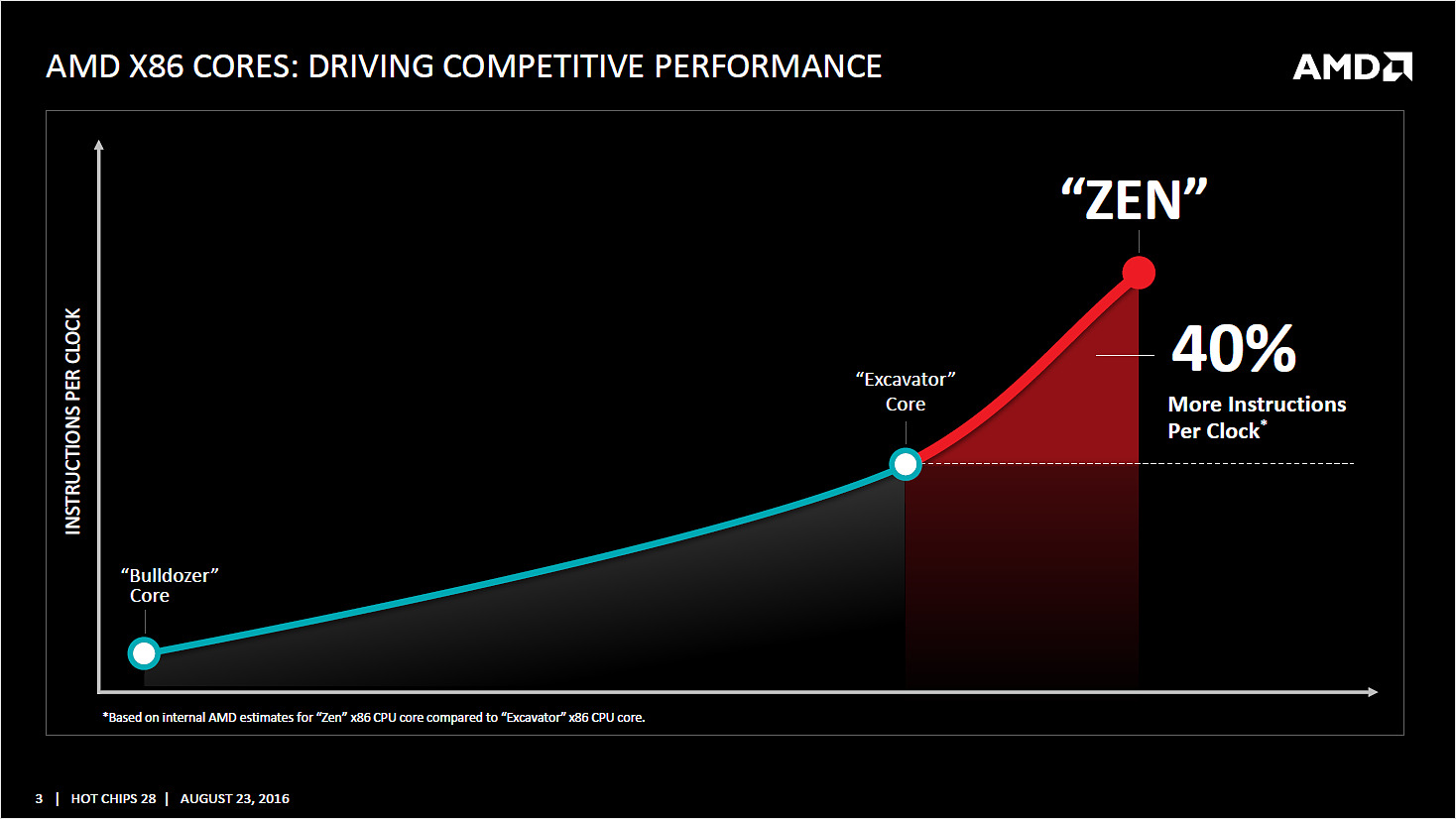

Cette présentation de Hot Chips était l'une des plus attendues, et l'on est obligé de dire que sur le papier au moins, AMD semble proposer une architecture vastement supérieure à ce qu'il proposait auparavant avec ses coeurs Jaguar ou Excavator. Certains diront que c'était un moindre mal, mais les changements sont conséquents.

Sur le papier, le travail important réalisé sur le front-end nous rappelle de nombreux choix également effectués par Intel pour son architecture Core, ce qui semble être une très bonne chose pour les performances et la consommation.

AMD garde un design différent pour la partie exécution en scindant en deux les ports "Integer" et "FPU". Un design qui n'avait pas particulièrement réussi aux modules de Bulldozer, mais AMD semble avoir appris des problèmes que cette partition avait causé. Il faudra voir si en pratique cette séparation portera enfin les fruits attendus.

De la même manière l'architecture des caches semble avoir été revue dans le bon sens, le passage au write back pour le L1 devrait augmenter largement sa bande passante, et le reste des caches est confortablement dimensionné.

Sur le papier, le retard architectural d'AMD semble en très grande partie comblé, et il n'y a que sur le choix des unités 128 bits en virgule flottante que l'on émettra un bémol.

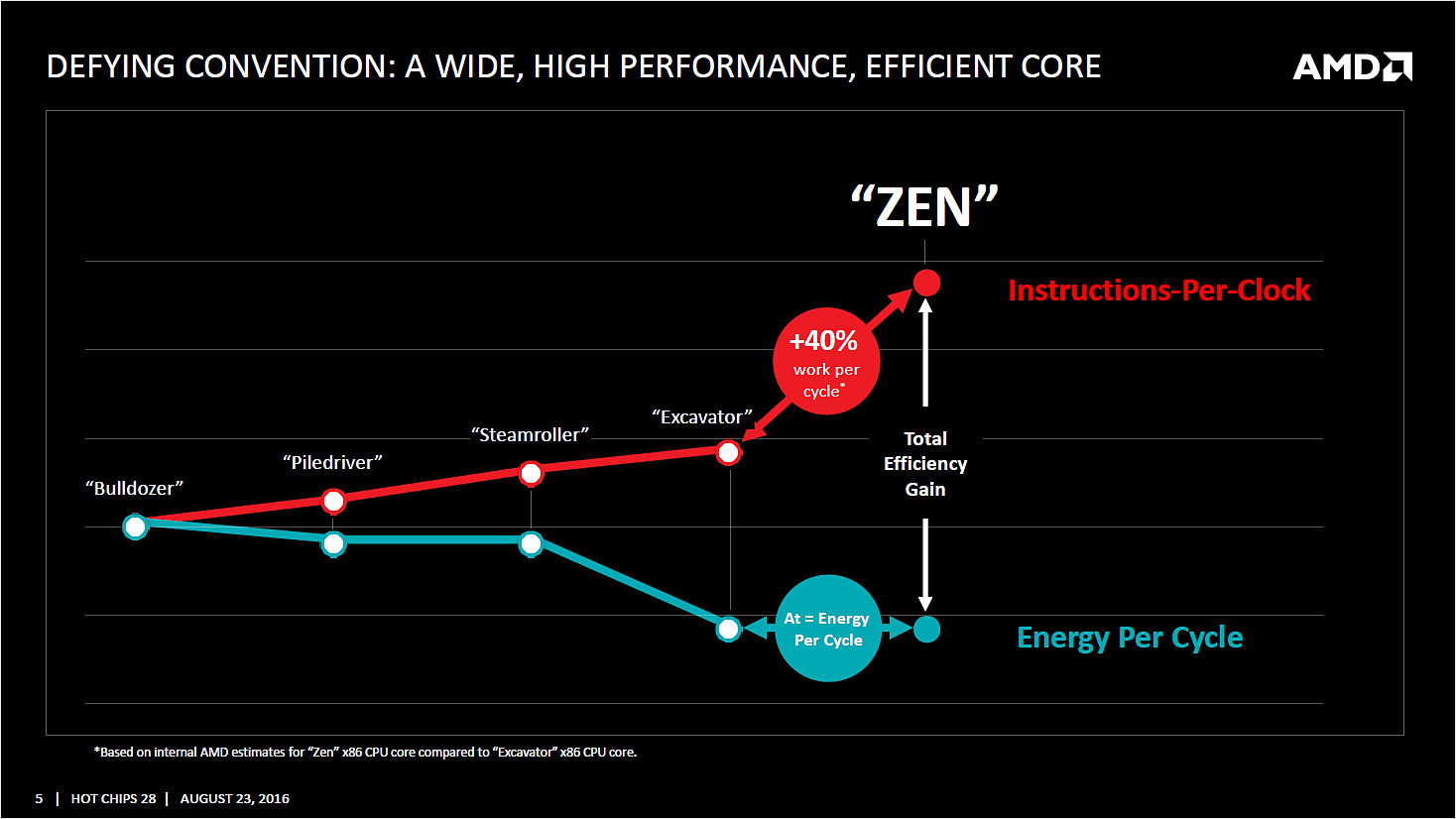

Reste qu'entre la théorie et la pratique, de nombreuses choses peuvent jouer et si AMD martèle avoir fait progresser de 40% l'IPC par rapport à son architecture précédente, on rappellera que le chiffre est obtenu en comptant l'effet de l'intégration du Simultaneous Multi Threading. Sur ce qui est des performances monothread, point primordial, rien n'a été indiqué. Le fait que la notion de coeur ait été malmenée par Bulldozer et Excavator complique de toute manière l'interprétation de ces chiffres.

Comme toujours, seuls des tests pratiques pourront nous donner la réalité de la situation. Dans l'attente d'autres détails, que ce soit sur la partie uncore, et bien évidemment sur les fréquences et quantités de coeurs embarqués (sans parler des prix), nous n'irons pas plus loin dans les prédictions.

Dans tous les cas, le retour d'un semblant de concurrence dans le marché du x86 ne serait pas pour nous déplaire !

Vous pouvez retrouver ci dessous l'intégralité de la présentation d'AMD :

2 puces pour les APU de 7è génération

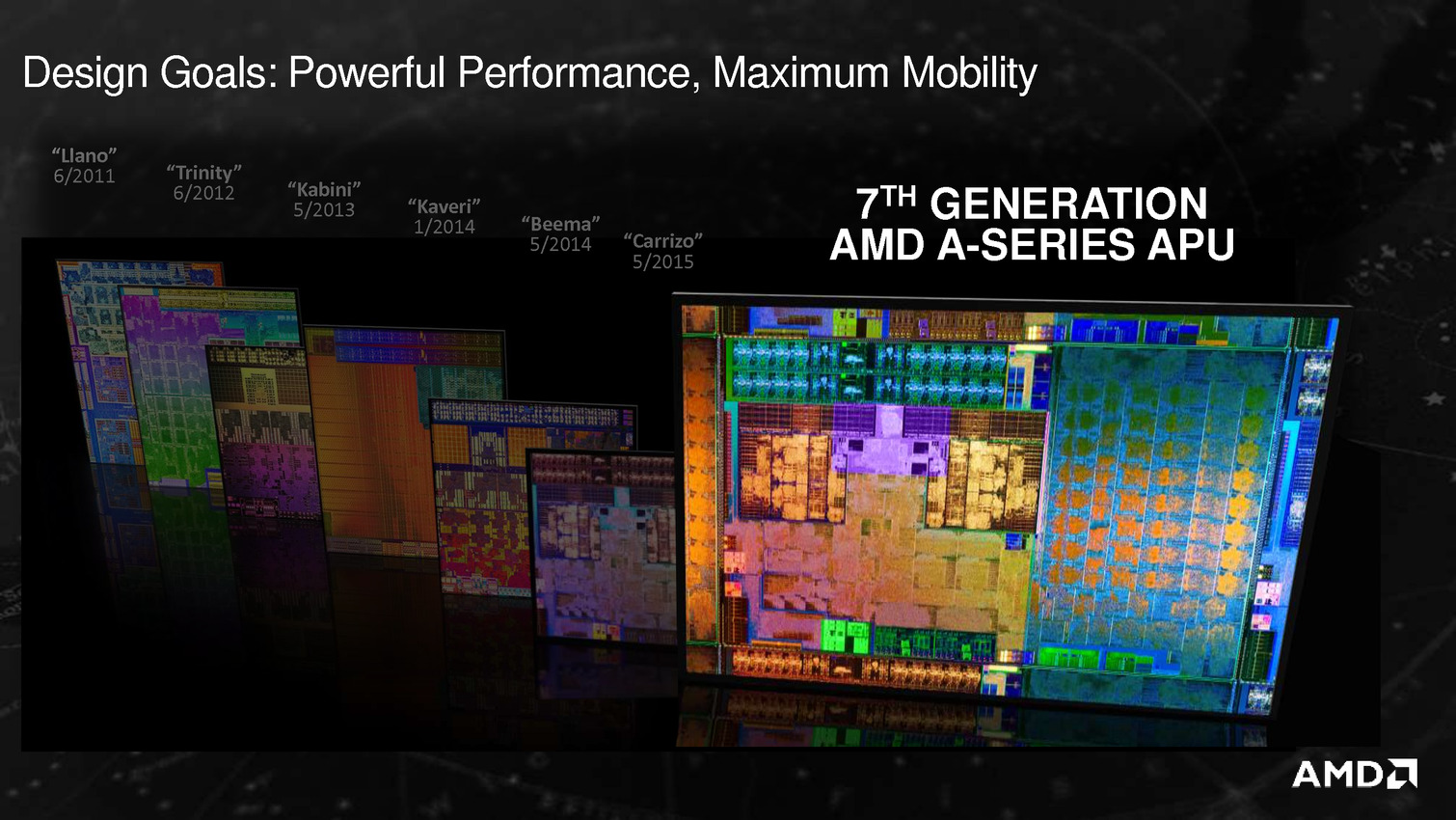

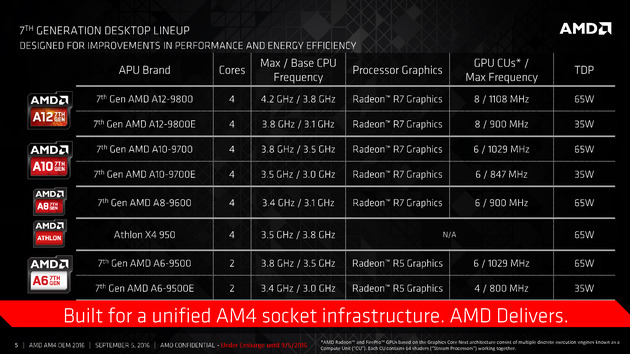

AMD profite du Computex pour annoncer ce qu'il appelle sa 7è génération d'APU, composée de deux puces : Bristol Ridge et Stoney Ridge.

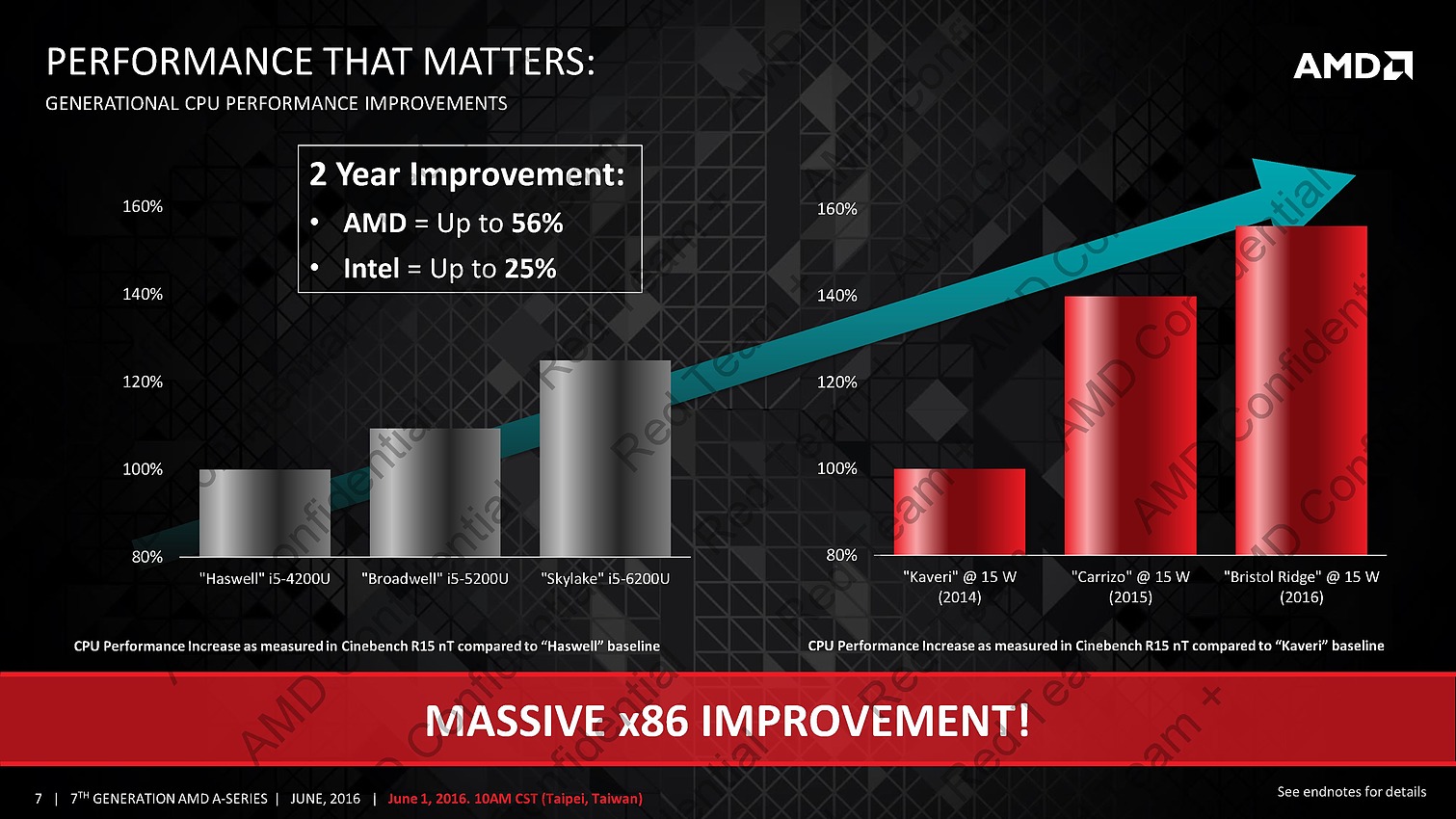

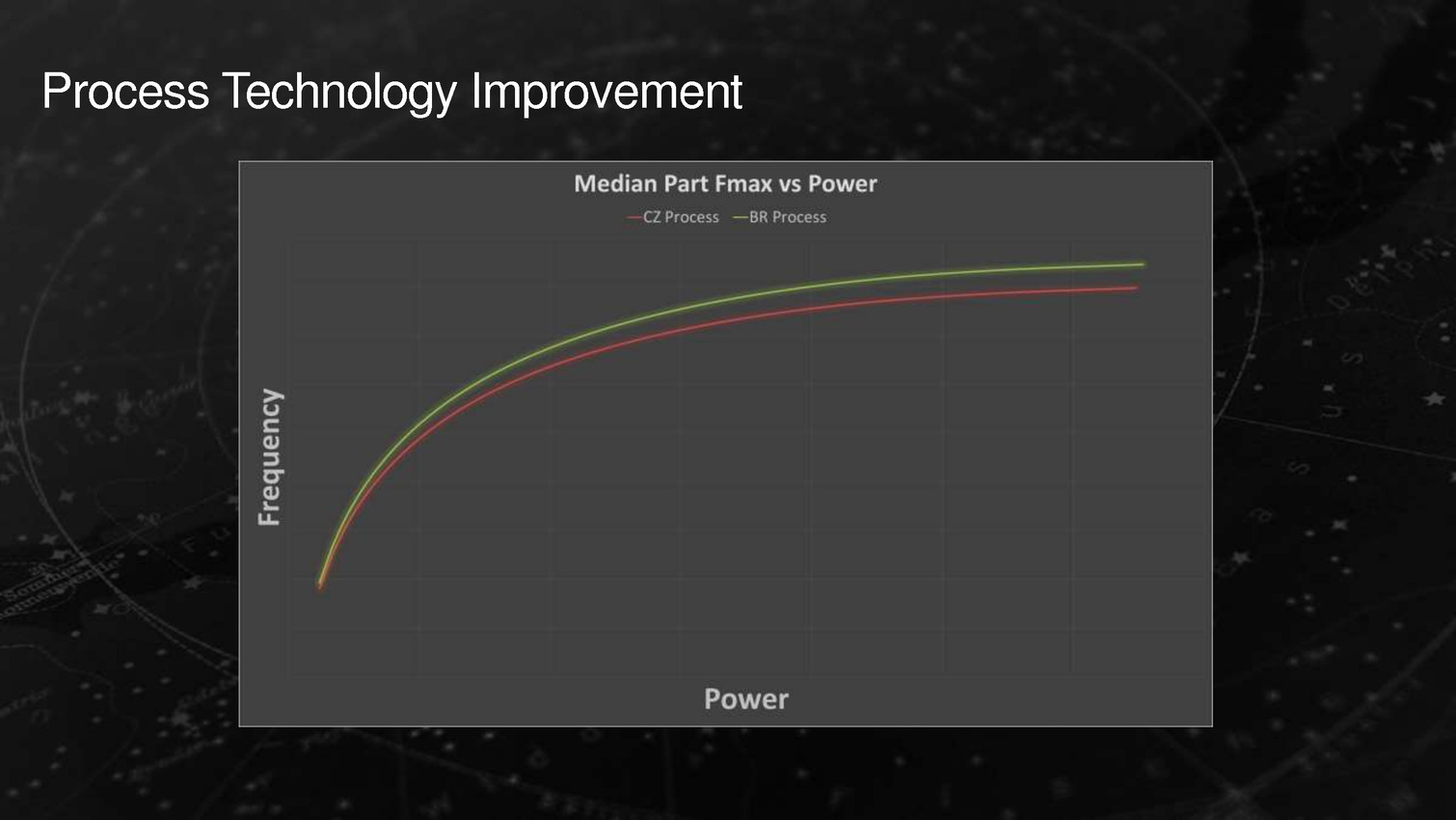

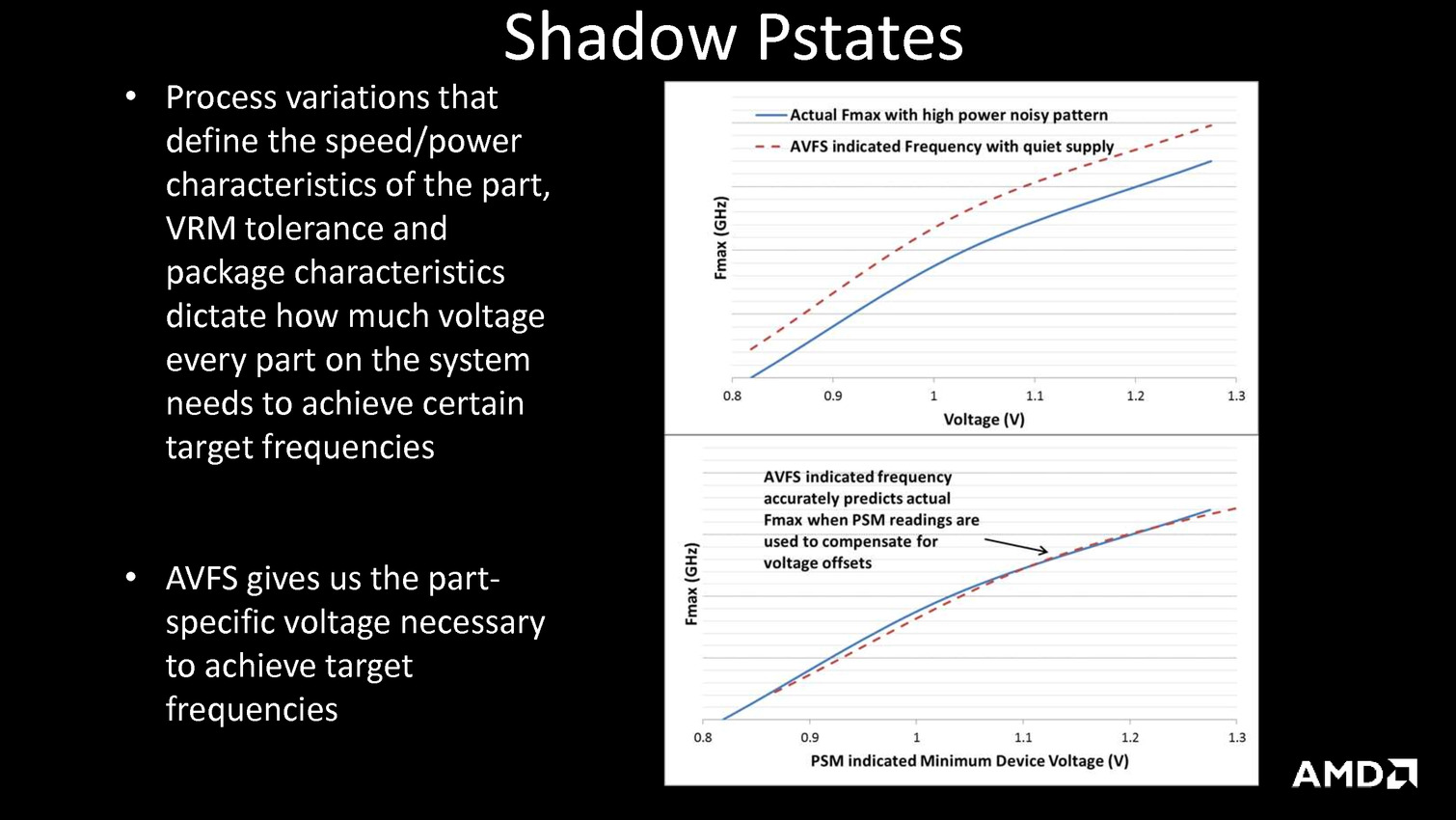

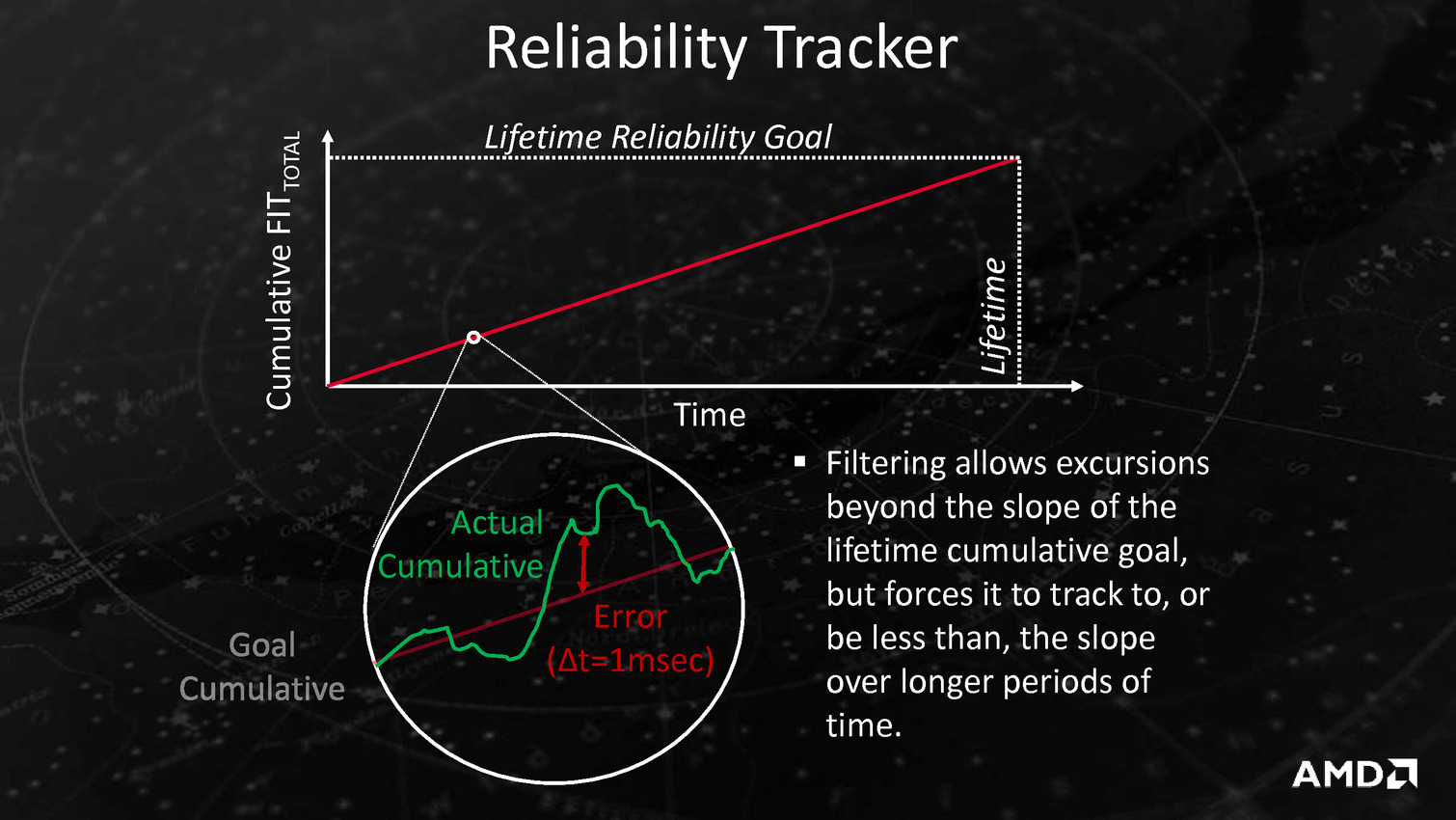

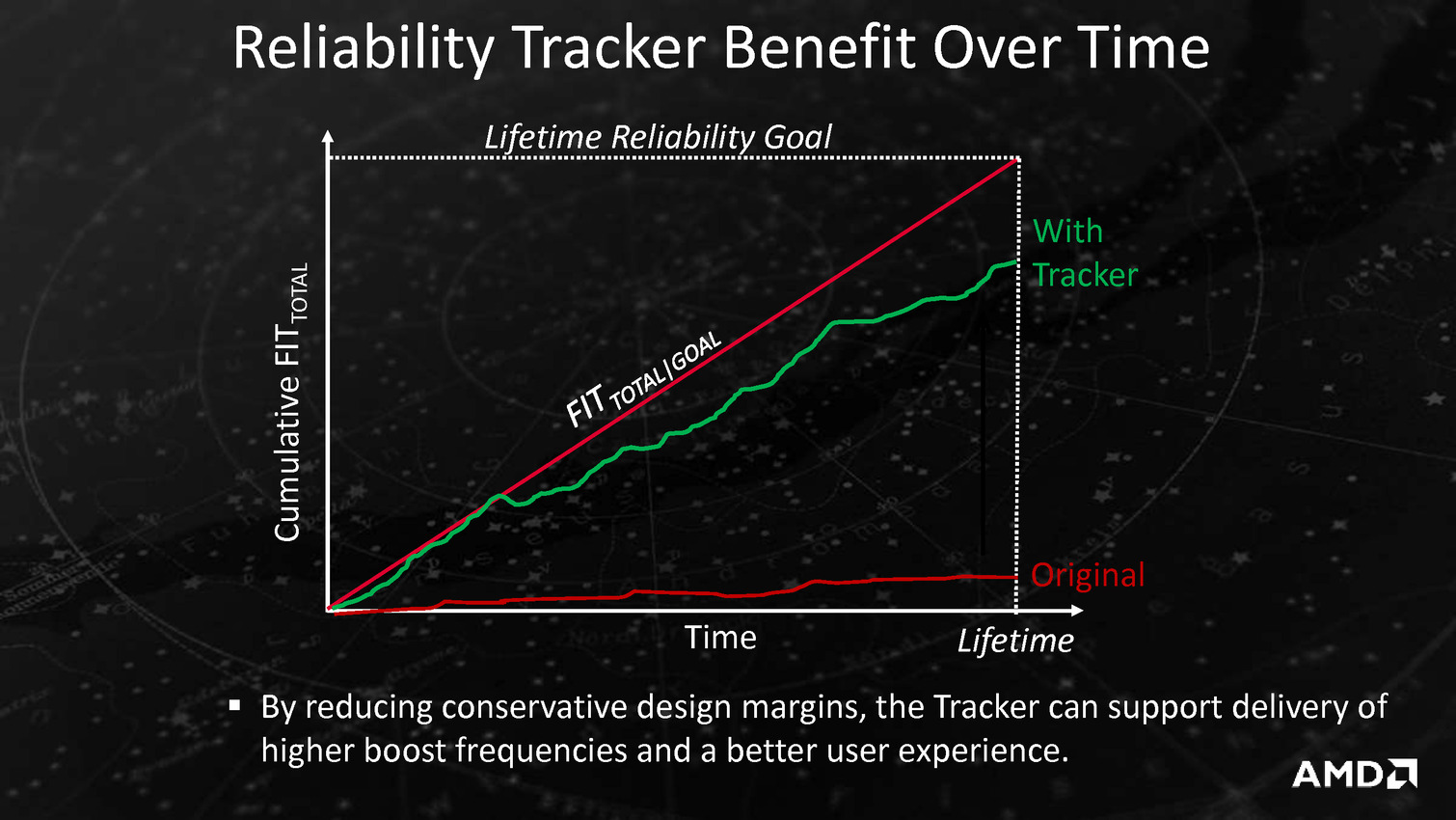

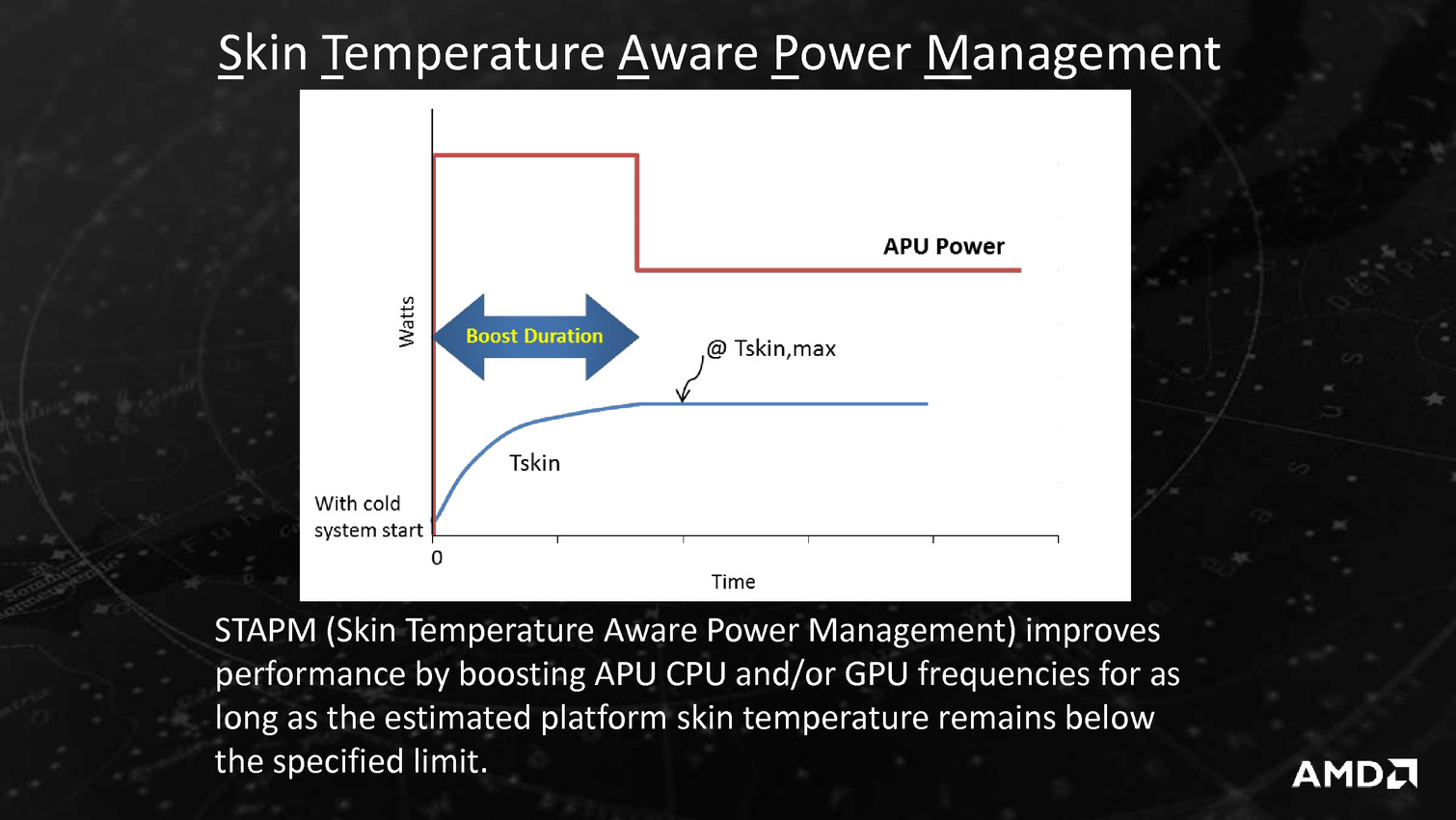

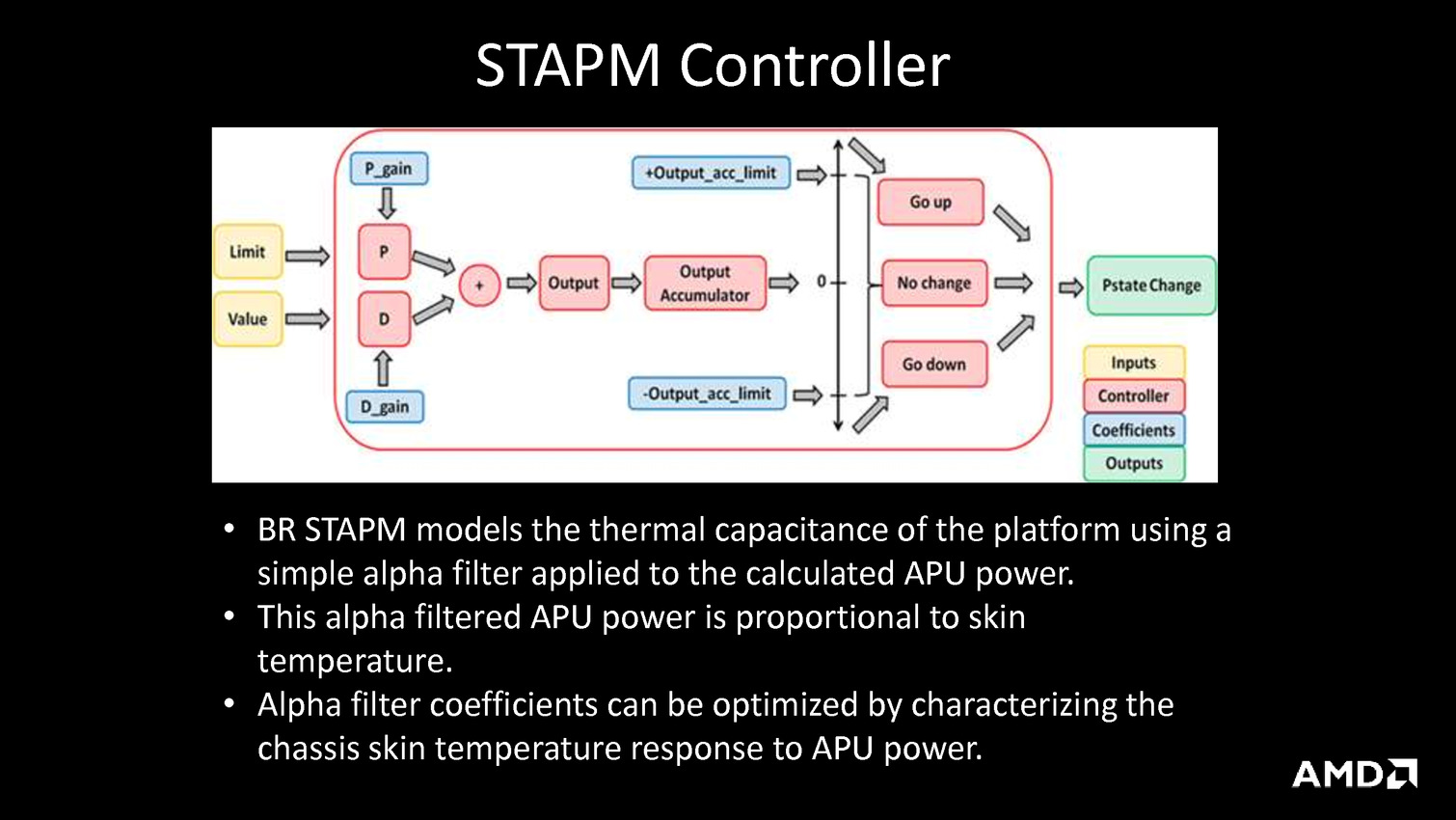

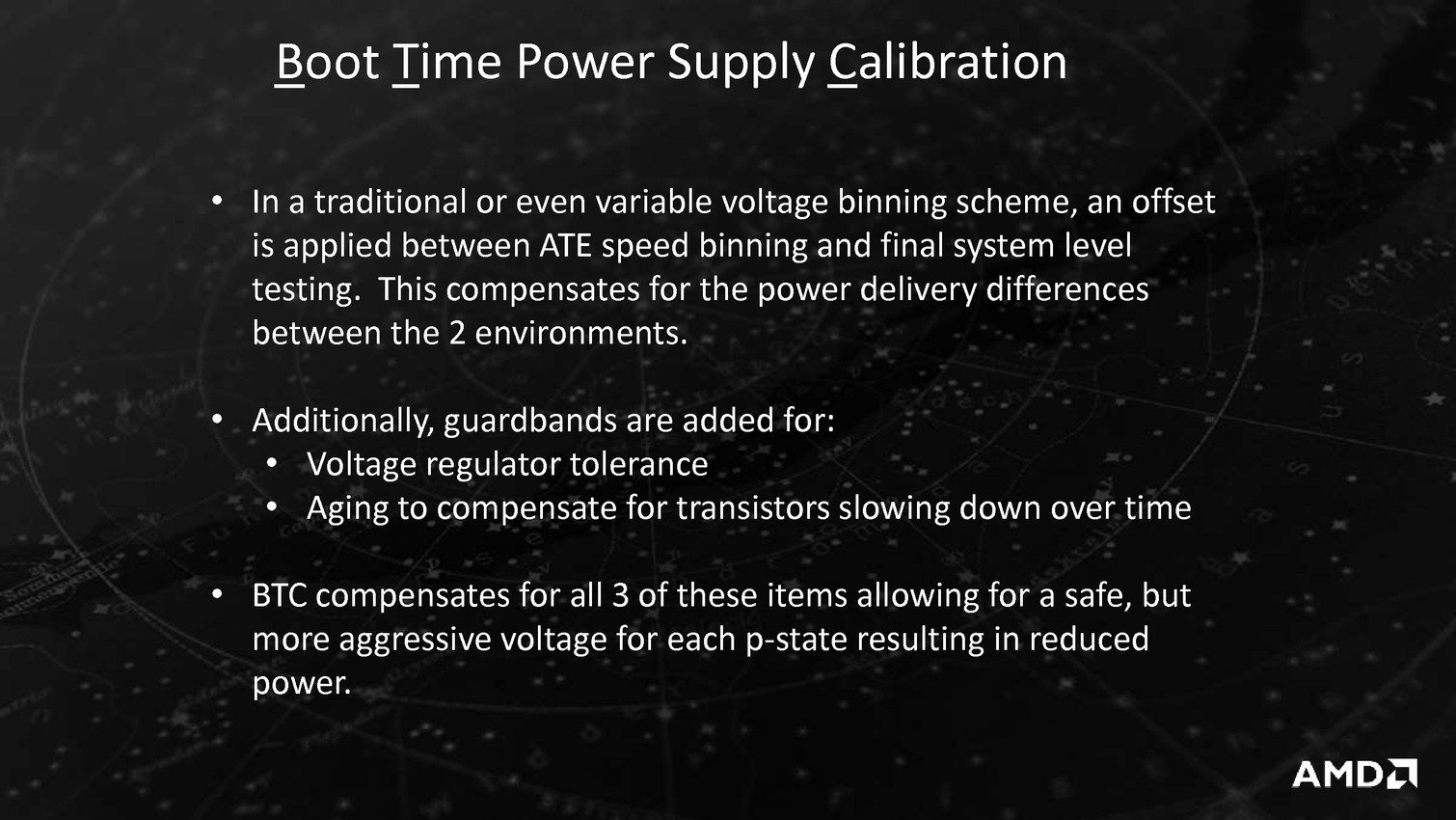

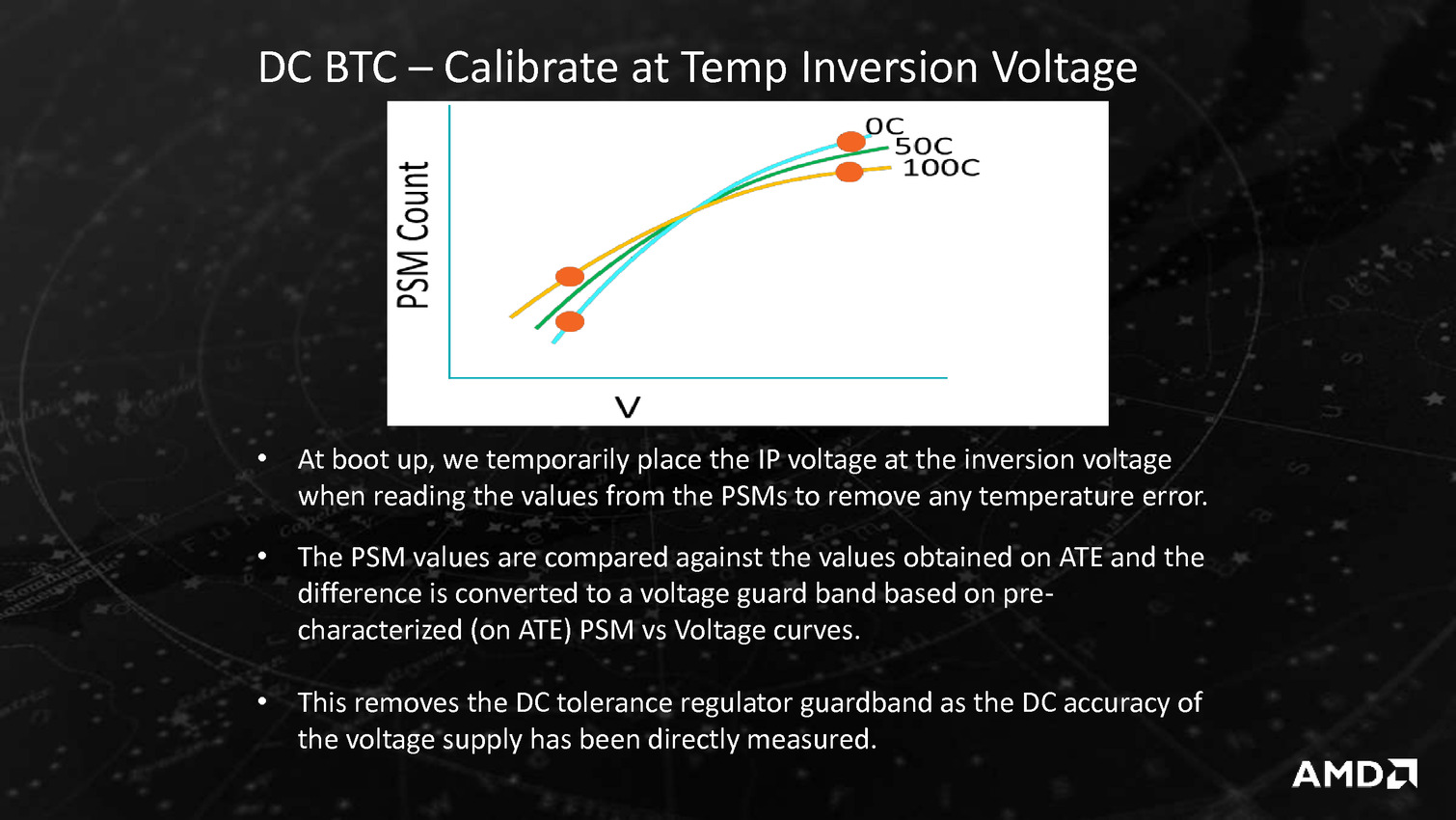

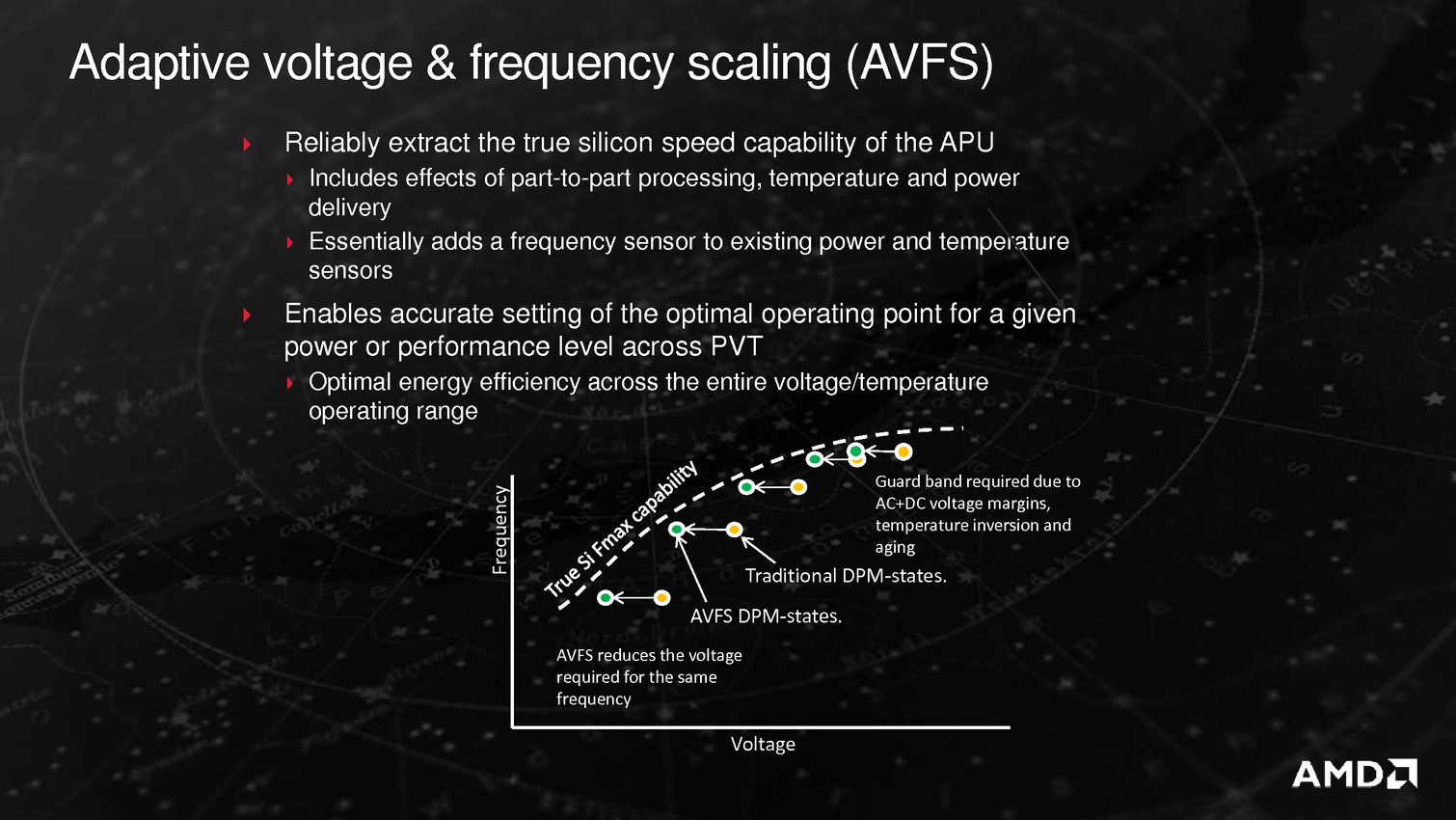

Derrière ces puces se cache en fait la combinaison Excavator et GCN 1.2 déjà utilisée sur Carrizo, avec de menues améliorations destinées à tirer encore plus de ces puces malgré une gravure toujours en 28nm. La moitié des gains viendraient ainsi de modification de l'architecture des transistors chez GlobalFoundries, l'autre de modification permettant de mieux coller aux capacités individuelles de chaque puce ainsi que de la gestion, comme chez Intel depuis les Core M, de la température du système en sus de la température processeur afin d'allonger si possible la durée pendant laquelle l'APU peut aller au-delà de sa consommation de base.

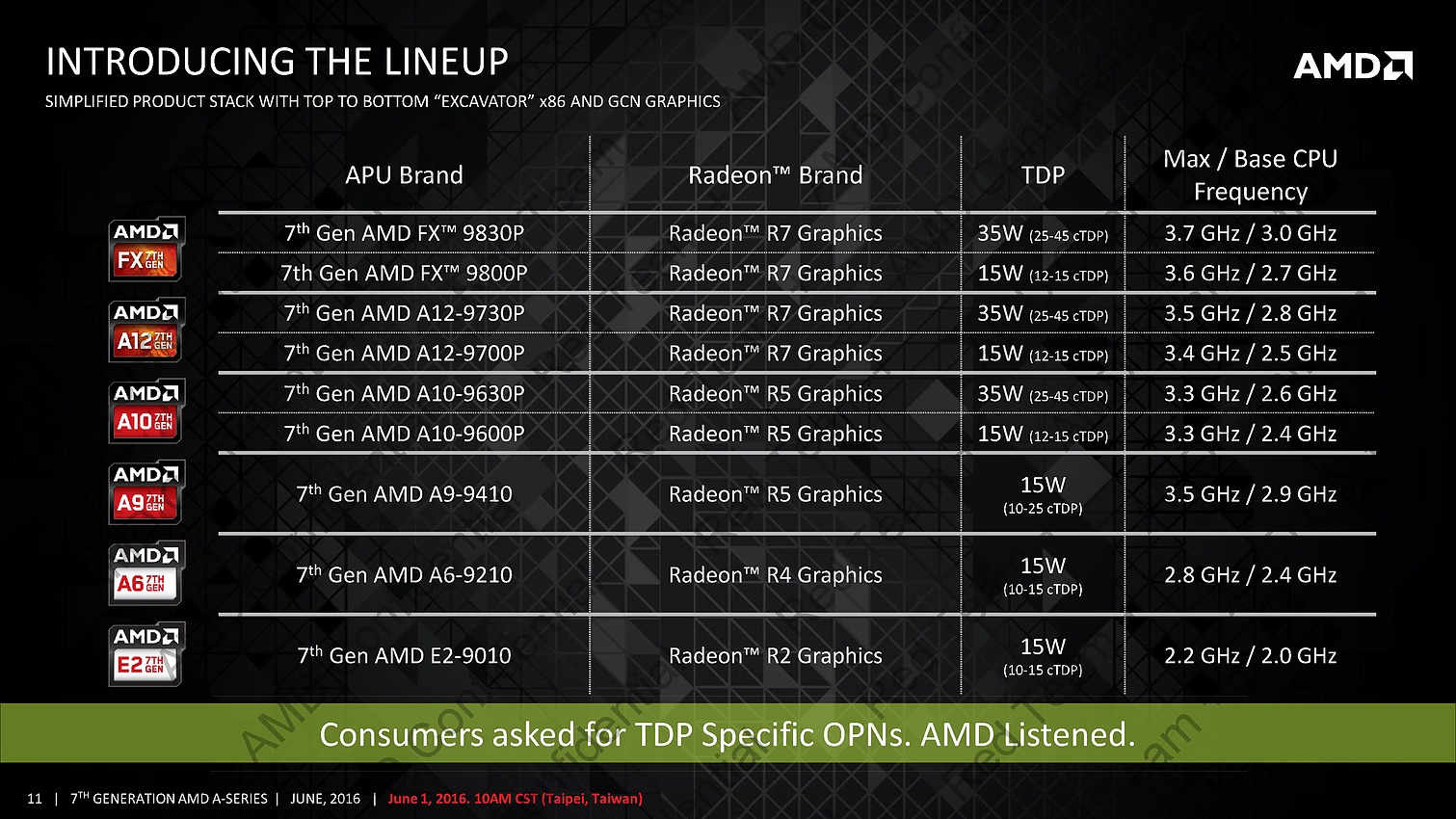

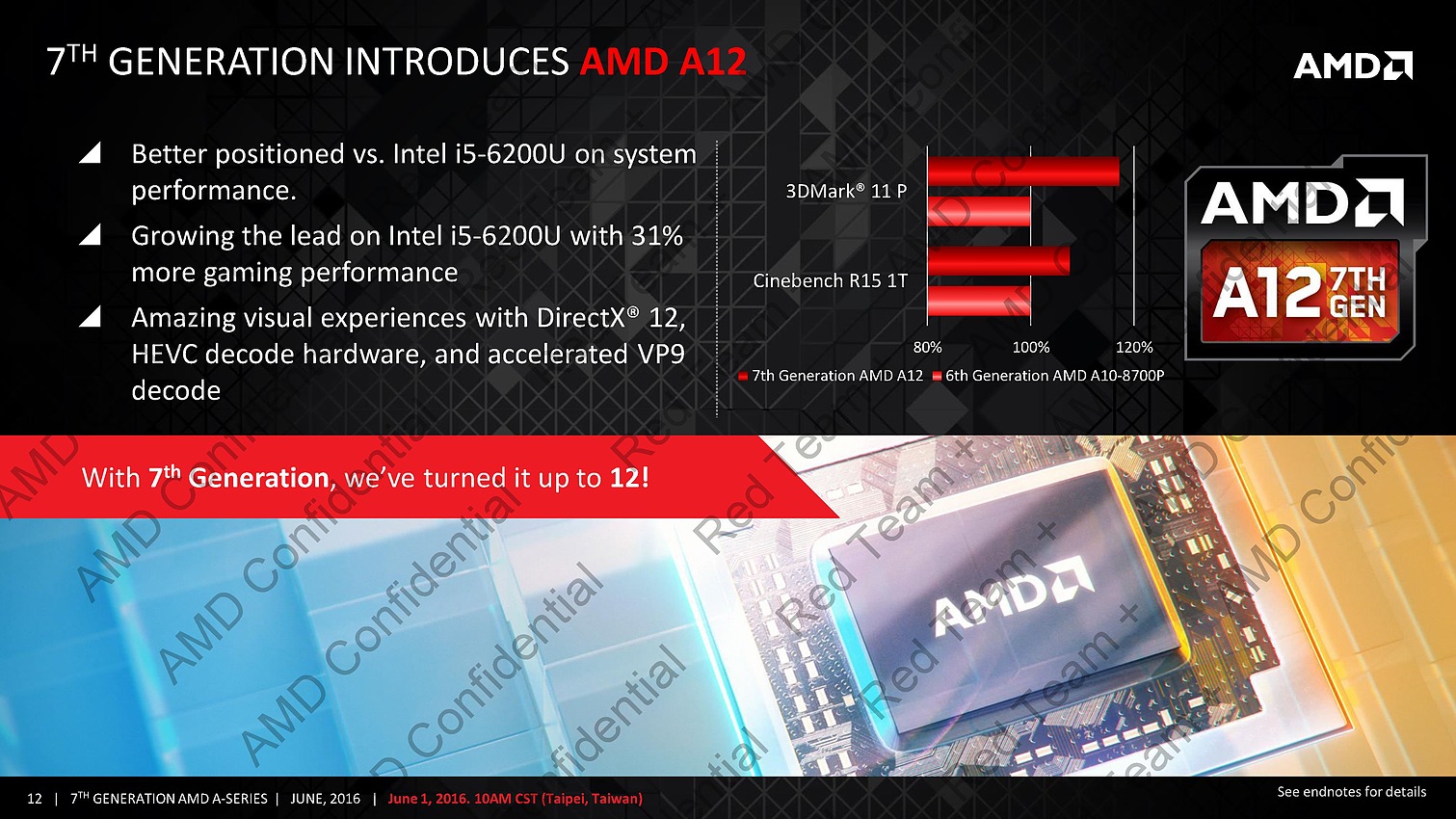

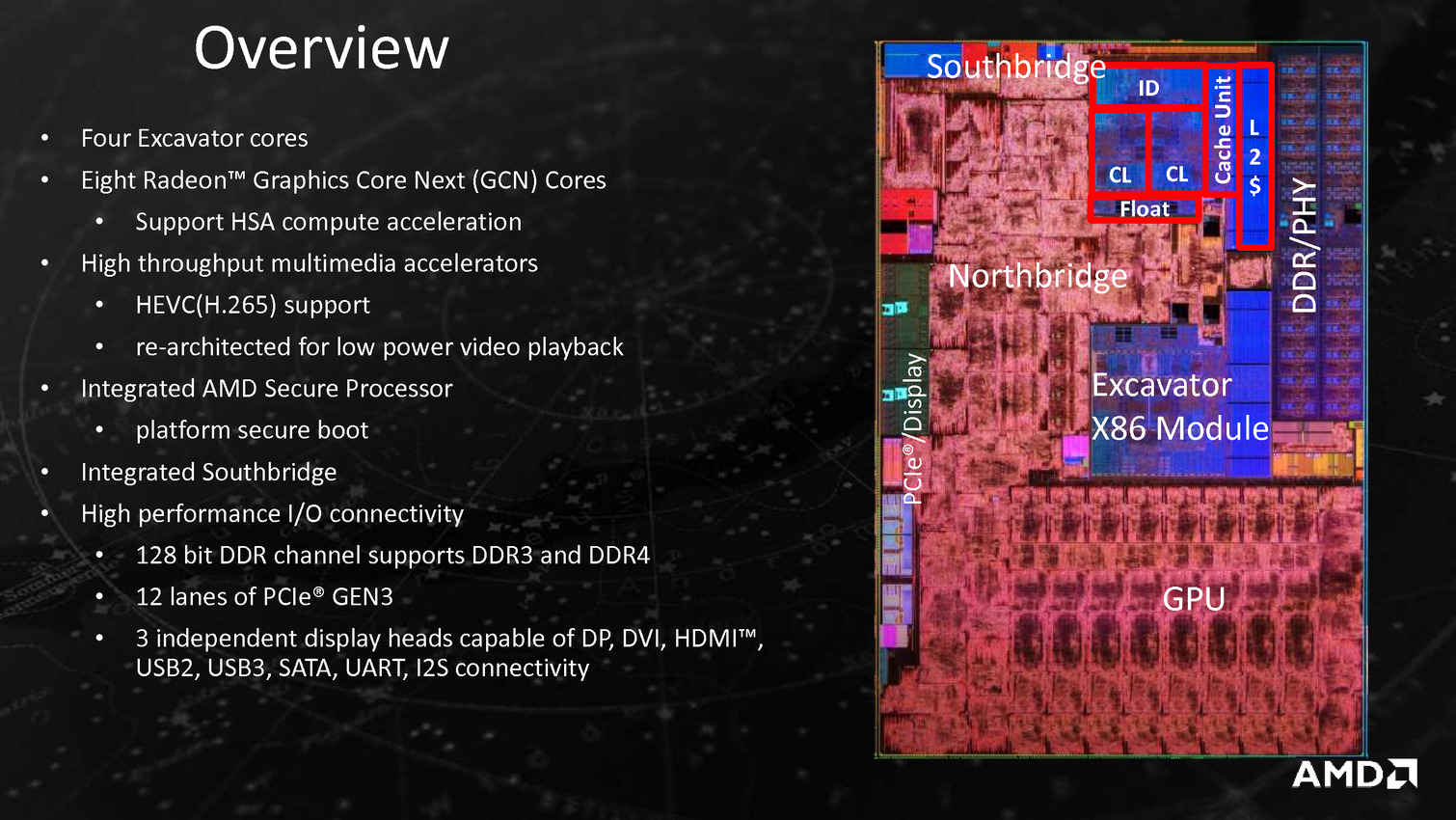

Bristol Ridge est très (très) proche de Carrizo, d'ailleurs le nombre de transistor est identique à 3,1 milliards alors que la surface varie légèrement (250.4mm² au lieu de 244.6mm²). On trouve 2 modules x86 Excavator associés à 8 Compute Units GCN 1.2 et un soutbhridge gérant 4 USB 3.0, 4 USB 2.0 et 2 SATA 6 Gbs. La mémoire est gérée sur deux canaux et peut être de type DDR3-2133 ou DDR4-2400, alors que le nombre de ports PCIe Gen3 est de 12 (dont 8 pour un GPU externe). Il est décliné en gammes FX, A12 et A10, avec des variations au niveau des fréquences et du TDP mais aussi du nombre de CUs actives (6 à 8). Les puces les plus haut de gamme sont le FX 9830P qui avec un TDP de 35w fonctionne à 3/3.7 GHz côté CPU et 900 MHz au mieux côté GPU (en Carrizo on était au mieux à 3.4 GHz et 900 MHz), et d'autre part le FX 9800P qui est à 2.7/3.6 GHz et 758 MHz.

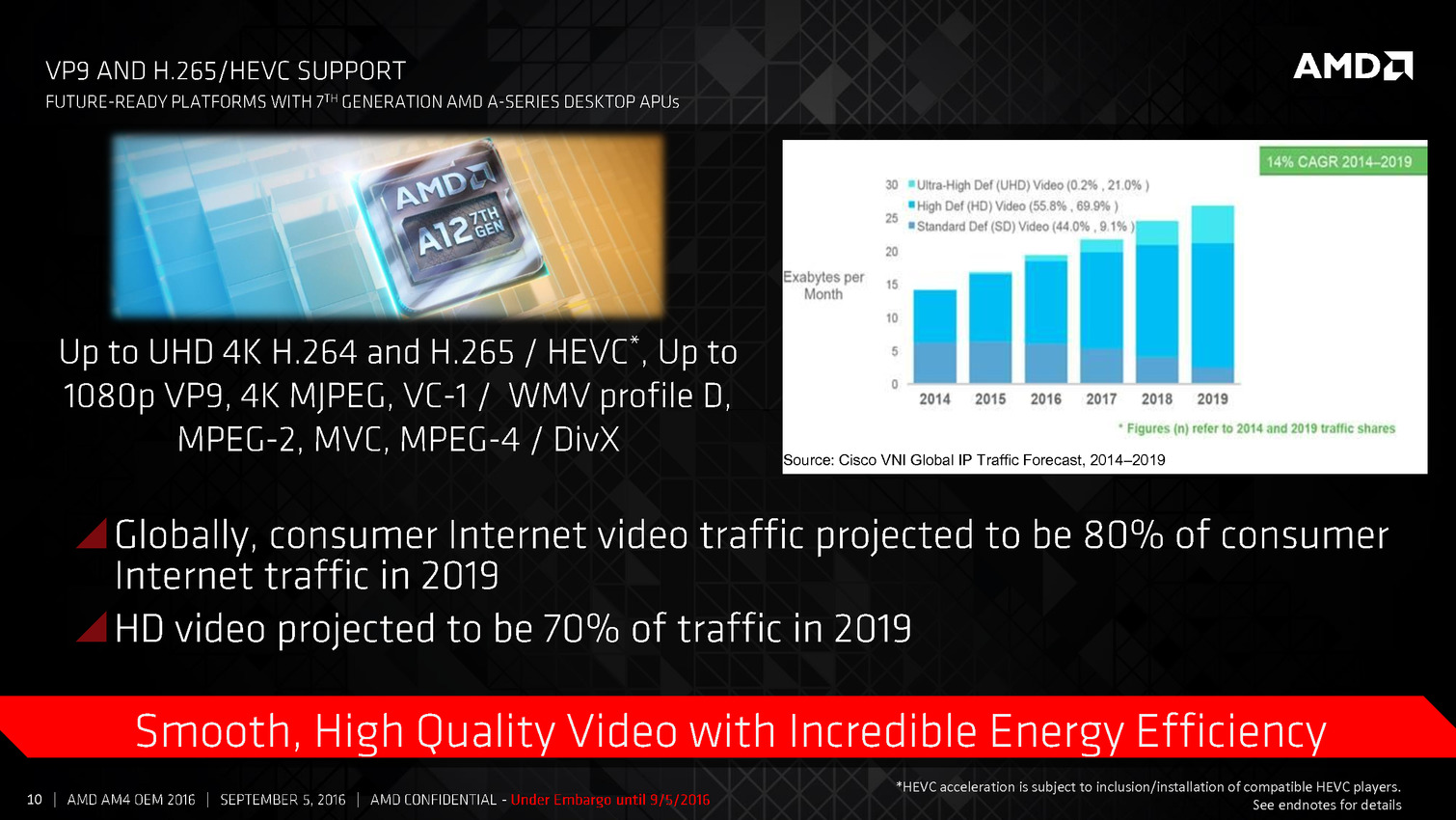

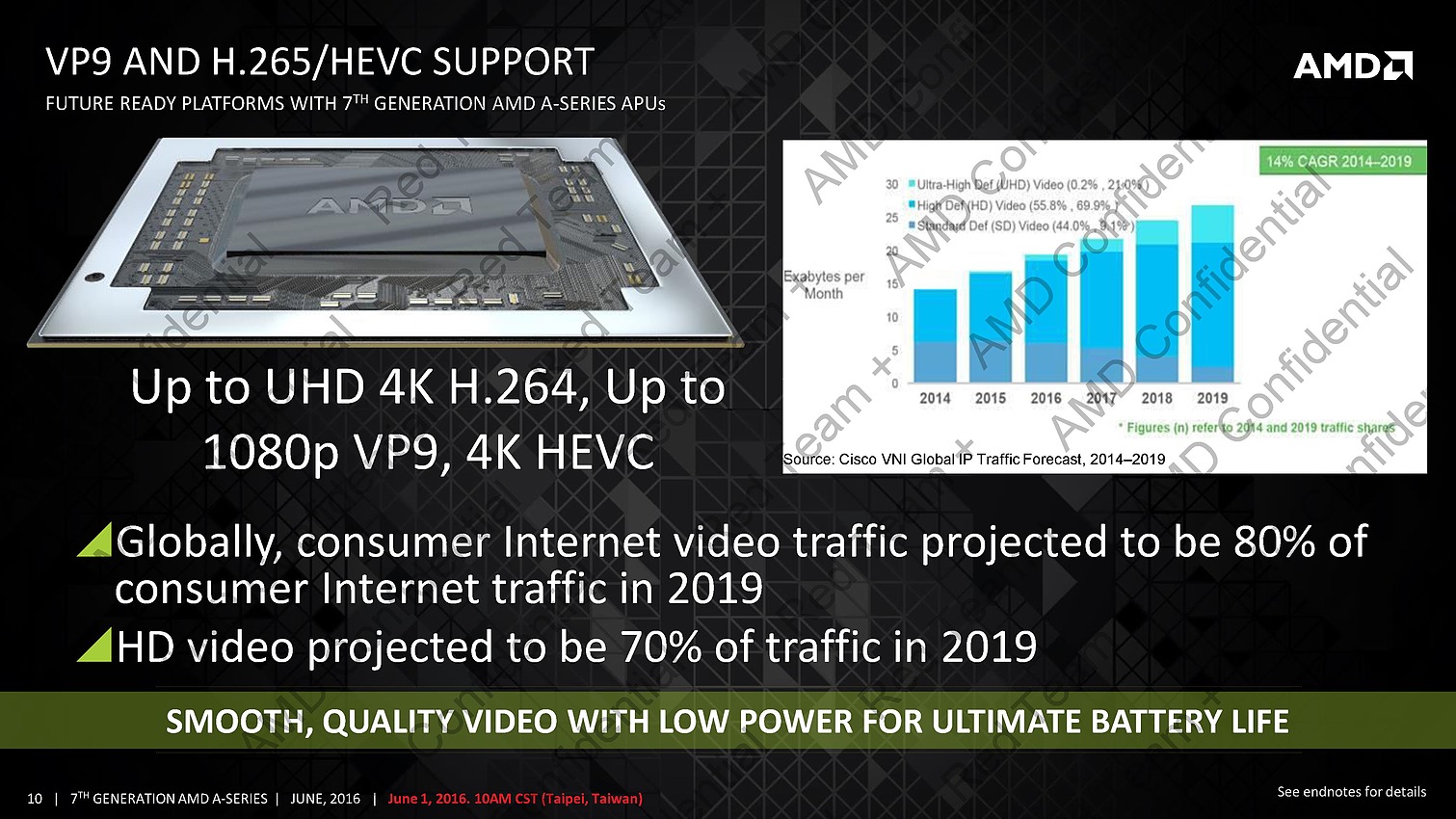

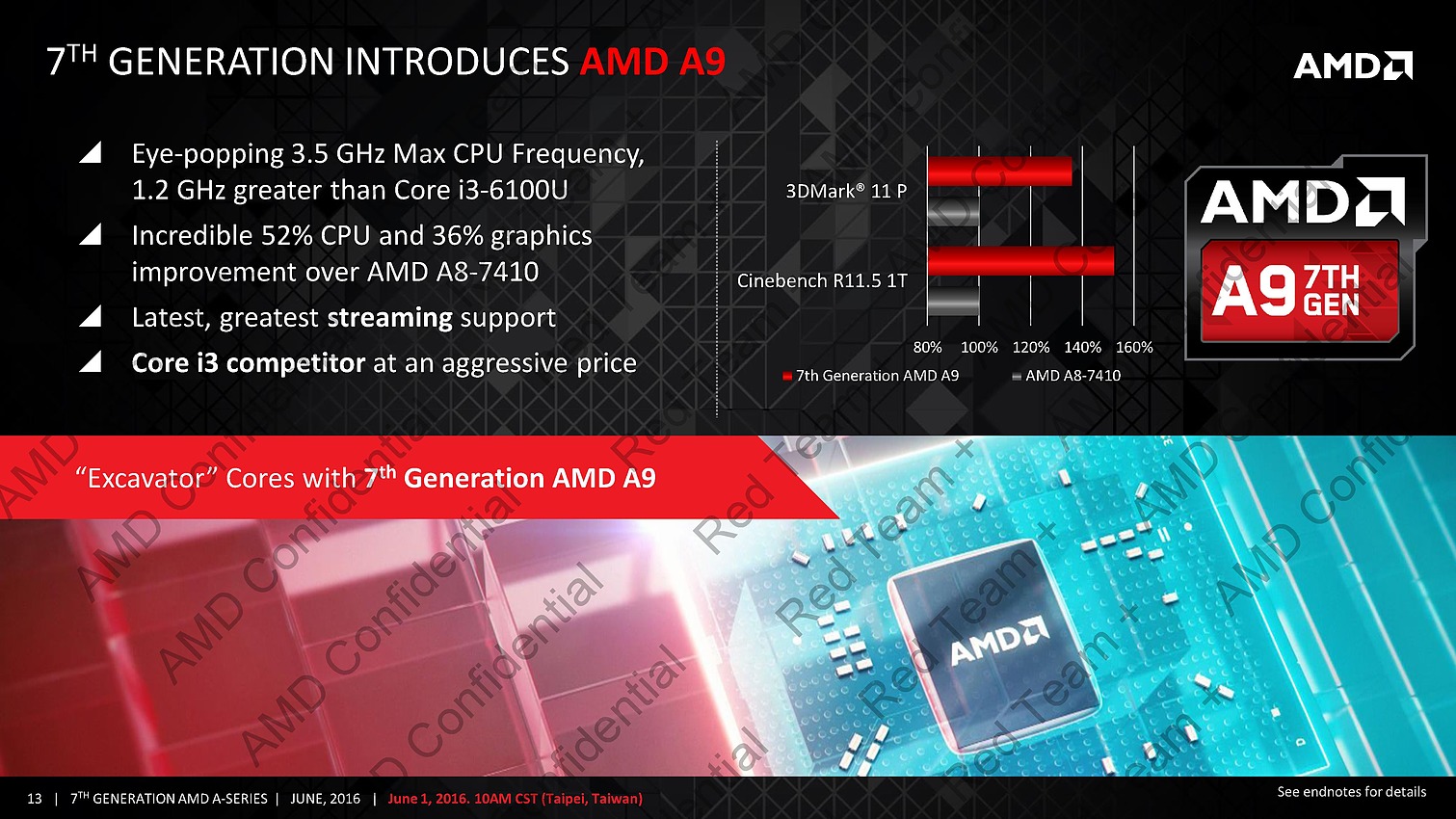

Stoney Ridge est pour sa part composé de 1.2 milliards de transistor sur 124.5mm², cette puce remplace Carrizo-L et permet à AMD d'unifier les architectures de sa gamme APU, chose qu'on ne pensait pas voir venir avant Zen. Cette fois on a droit à un module x86 Excavator et 3 Compute Units GCN 1.2 alors que la mémoire est gérée sur un canal permettant au mieux d'atteindre la DDR4-2133. On troque donc entre autre 4 petits coeurs x86 pour 2 plus performants, et le nombre d'unités GCN augmente de 50% alors qu'on dispose d'un moteur vidéo plus à jour capable de décoder le H.265 et de disposer d'une sortie HDMI 2.0. Cette puce est déclinée en tant que A9, A6 et E2, avec toujours un TDP de 15 watts mais des fréquences CPU et GPU qui varient ainsi qu'un nombre de CUs limité à 2 en E2.

Le premier produit utilisant ces APU sera l'HP ENVY x360 déjà annoncé il y a quelques semaines, il utilisera selon les versions l'une ou l'autre des puces.