Les derniers contenus liés au tag Pascal

Afficher sous forme de : Titre | FluxGDC: Nvidia annonce la GeForce GTX 1080 Ti 11 Go (maj)

Nvidia lance les Quadro Pascal dont une GP100

Dossier: Radeon RX 460 vs GeForce GTX 1050 / GTX 1050 Ti : le test de cartes Asus, Gigabyte, MSI, Sapphire et Zotac

Dossier: Radeon RX 470 4 Go vs GeForce GTX 1060 3 Go : le test de cartes Asus, EVGA, MSI, Sapphire et XFX

Nvidia annonce les GTX 1050 et 1050 Ti mobiles

CES: Silence sur l'après Pascal chez Nvidia

Alors que le CES ouvrira ses portes officiellement dans quelques heures, les conférences de presse s'enchaînent. Celle de Nvidia (comme d'autres acteurs du monde PC, on le verra) était axée a peu près exclusivement sur les deux autres moteurs de croissance sur lesquels la société mise aujourd'hui : l'intelligence artificielle, et le marché automobile.

Bien peu de mots auront été prononcés au sujet du PC, si ce n'est peut être une bien vague allusion au fait que de "nouveaux produits gaming" seraient lancés cette année. Malheureusement, pas un mot n'a été prononcé par le CEO sur le lancement de l'après Pascal côté GeForce.

On suppose que la déclinaison gaming de Volta pourrait être lancée cette année, même si Nvidia n'est pas particulièrement pressé par la concurrence. La société qui plus est, est l'un des partenaires de TSMC sur le développement du 7nm. Elle pourrait être parmi les premières à proposer des produits sur ce node, possiblement vers la fin de l'année ou le début de l'année prochaine (la primauté allant toujours aux très gros volumes comme Apple, la production de gros GPU se faisant en prime toujours dans un second temps, afin de diminuer les coûts engendrés par les yields assez bas sur les puces larges en début de vie des process).

C'est au final par un communiqué de presse que Nvidia a tout de même annoncé quelques petites nouveautés pour les joueurs. La première concerne GeForce Experience, Nvidia rajoute une fonctionnalité baptisée "Freestyle" qui permet de rajouter, via l'overlay GFE, des filtres au rendu temps réel des jeux. De nombreux filtres (empilables) sont disponibles permettant de "styliser" ses jeux.

Si l'on peut y voir une sorte de gadget, il y a tout de même deux filtres qui pourront avoir leur intérêt. Le premier est un filtre permettant de modifier les couleurs des jeux pour les daltoniens et améliorer leur perception, quelque chose qui pourra être très utile. Le second est un filtre permettant de réduire l'intensité des "bleus", sous la forme d'un mode nuit réglable.

Techniquement, la fonctionnalité n'est pas universelle, elle est pour l'instant limité à certains titres DirectX 11 (une centaine selon le constructeur) qui doivent être whitelistés. Pour ce qui est du coût de ces effets, Nvidia nous a indiqué qu'il peut varier entre 2 et 7% de performances en fonction des filtres.

La seconde nouveauté annoncée est l'arrivée de "Big Format Gaming Display", des écrans 65 pouces 3440x1440 120 Hz compatibles G-Sync et incluant un Nvidia Shield. La proposition est surprenante pour ne pas dire autre chose, et trois partenaires sont annoncés : Asus, Acer et HP. Nous devrions pouvoir vous en dire plus dans les jours à venir.

Il nous est difficile cependant de ne pas y voir un parallèle avec l'arrivée du "Game Mode Variable Refresh Rate", le pendant de l'Adaptative Sync/Freesync intégré dans la norme HDMI 2.1 et que Nvidia ne s'est pas engagé jusqu'à aujourd'hui a supporter (contrairement à son concurrent).

Dernière nouvelle à noter, le service de streaming GeForce Now (toujours en beta) dispose désormais d'un client PC en plus de son client Mac. Le rendu côté serveur peut en prime se faire désormais jusque 120Hz pour certains titres, dans le but de réduire la latence (l'encodeur vidéo éjectant les frames supplémentaires).

Nvidia lance la GeForce GT 1030

Relativement discrètement, Nvidia vient de débuter la commercialisation d'une nouvelle déclinaison dans la famille GeForce 10 : la GeForce GT 1030. Une carte graphique d'entrée de gamme qui va venir se positionner face à la récente Radeon RX 550 d'AMD.

Bien qu'il ait souvent peu d'intérêt pour l'utilisateur final, le marché des cartes graphiques d'entrée de gamme reste important pour AMD et Nvidia puisqu'il permet de faire du volume dans la durée avec des produits qui restent au catalogue bien plus longtemps que le reste de la gamme.

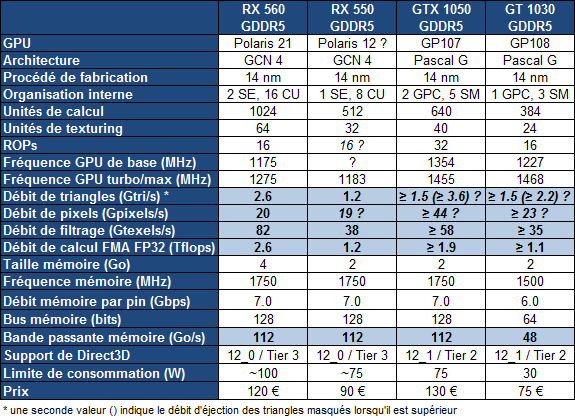

Nvidia se devait donc de réagir à la Radeon RX 550 d'AMD, basée sur Polaris 12, un nouveau GPU 14nm. La GeForce GT 1030 va ainsi succéder aux vieillissantes GeForce GT 700 (Kepler) avec un nouveau GPU de génération Pascal : le GP108. Comme le GP107 et contrairement aux plus grosses puces de la famille, celui-ci est fabriqué en 14nm par Samsung.

Grossièrement, le GP108 est un demi GP107 avec 3 SM (384 unités de calcul) et un bus mémoire de 64-bit. La GT 1030 affiche une puissance similaire à celle de la RX 550 mais profite d'une architecture plus efficace. Par contre sa bande passante est nettement inférieure puisqu'elle doit se contenter d'un bus de 64-bit.

Là où la solution de Nvidia se démarque c'est évidemment au niveau de la consommation qui tombe à 30W et permet de généraliser le refroidissement passif avec des radiateurs compacts. Cela se ressent aussi au niveau de la note puisque la GT 1030 se trouve à 75€ contre 90€ pour la RX 550.

Evidemment, de telles cartes graphiques n'ont à peu près aucun intérêt pour les joueurs. Elles vont permettre la mise à jour d'anciens systèmes vers une connectique d'affichage et des moteurs vidéos modernes (HDMI 2.1, DP 1.3/1.4, HEVC…), mais également aux OEM d'apposer un sticker Radeon ou GeForce sur des machines d'entrée de gamme.

Ces GPU auront un peu plus d'intérêt dans le monde mobile et devraient y débarquer sous peu. Nvidia aura l'avantage de la consommation alors qu'AMD aura plus de facilités à attirer le chaland avec une mémoire vidéo plus importante.

Dossier : Nvidia GeForce GTX 1080 Ti 11 Go Founders Edition en test

Nvidia renforce une fois de plus son offre haut de gamme, qui reste sans concurrence. La GeForce GTX 1080 Ti promet les performances de la Titan X pour 500€ de moins...

[+] Lire la suite

GDC: Nvidia parle du Tile Caching de Maxwell et Pascal

En parallèle de la GDC et lors de la présentation à la presse de la GeForce GTX 1080 Ti, Nvidia a communiqué officiellement pour la première fois au sujet d'une optimisation introduite depuis les GPU Maxwell : le Tile Caching.

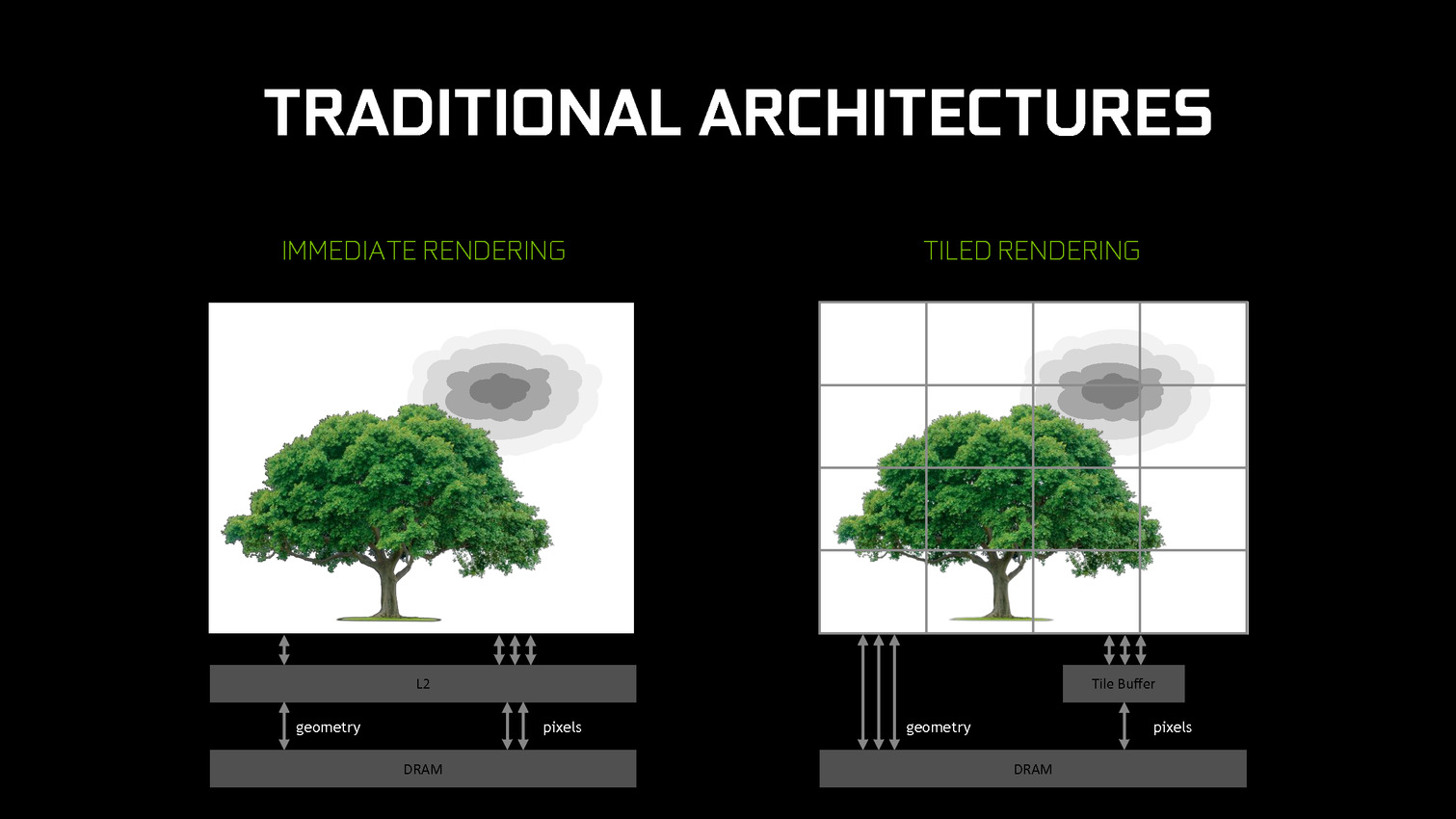

Cet été, David Kanter de real world technologies avait mis en évidence un comportement étrange pour les GPU Maxwell et Pascal. Avec ceux-ci, la rastérisation de plusieurs triangles progressait par blocs plus ou moins petits de l'image (appelés tiles en anglais) et non pas strictement triangle par triangle. Contrairement à certaines analyses, nous étions alors sceptiques par rapport au rapprochement qui était fait avec le tile based rendering (TBR) ou tile based deffered rendering (TBDR) des GPU mobiles Adreno, Mali ou PowerVR. Ces modes de rendu sont peu efficaces avec une géométrie complexe et posent problème avec certaines techniques de rendu avancées. Des contraintes qui sont incompatibles avec un GPU haut de gamme destiné au PC. Nous estimions alors qu'il s'agissait d'une optimisation opportuniste spécifique à certaines situations.

Face à ces discussions et à l'introduction par AMD d'une approche similaire, voire identique, Nvidia vient de clarifier le fonctionnement de la rastérisation sur ses GPU Maxwell et Pascal. Ce qui commence par lui donner un nom : le Tile Caching.

Traditionnellement, les GPU d'AMD et de Nvidia fonctionnent suivant le principe du rendu immédiat. Un triangle est pris en charge, il est découpé en pixels, les pixels sont écrits en mémoire. Si un second triangle traité par la suite se trouve entre le premier et la caméra, des pixels auront inutilement été calculés et écrits en mémoire. Différentes approches sont utilisées pour éviter ce gaspillage de ressources, mais il reste en partie présent.

De leur côté, les GPU mobiles font appel au TBR/TBDR qui fonctionne en deux passes. La première consiste à traiter toute la géométrie et à la récrire en mémoire en la réorganisant de manière à savoir quels triangles sont présents chaque bloc de l'image. Lors d'une seconde passe, ces triangles sont envoyés vers le moteur de rastérisation tile par tile (avec tri de visibilité dans le cas du TBDR). La construction de l'image dans de petites tiles en cache fait que les pixels ne seront écrits qu'une seule fois en mémoire. Cela revient à utiliser plus de bande passante pour la géométrie mais moins pour les pixels. Un compromis dont l'intérêt dépend évidemment du ratio entre la charge sur ces deux points.

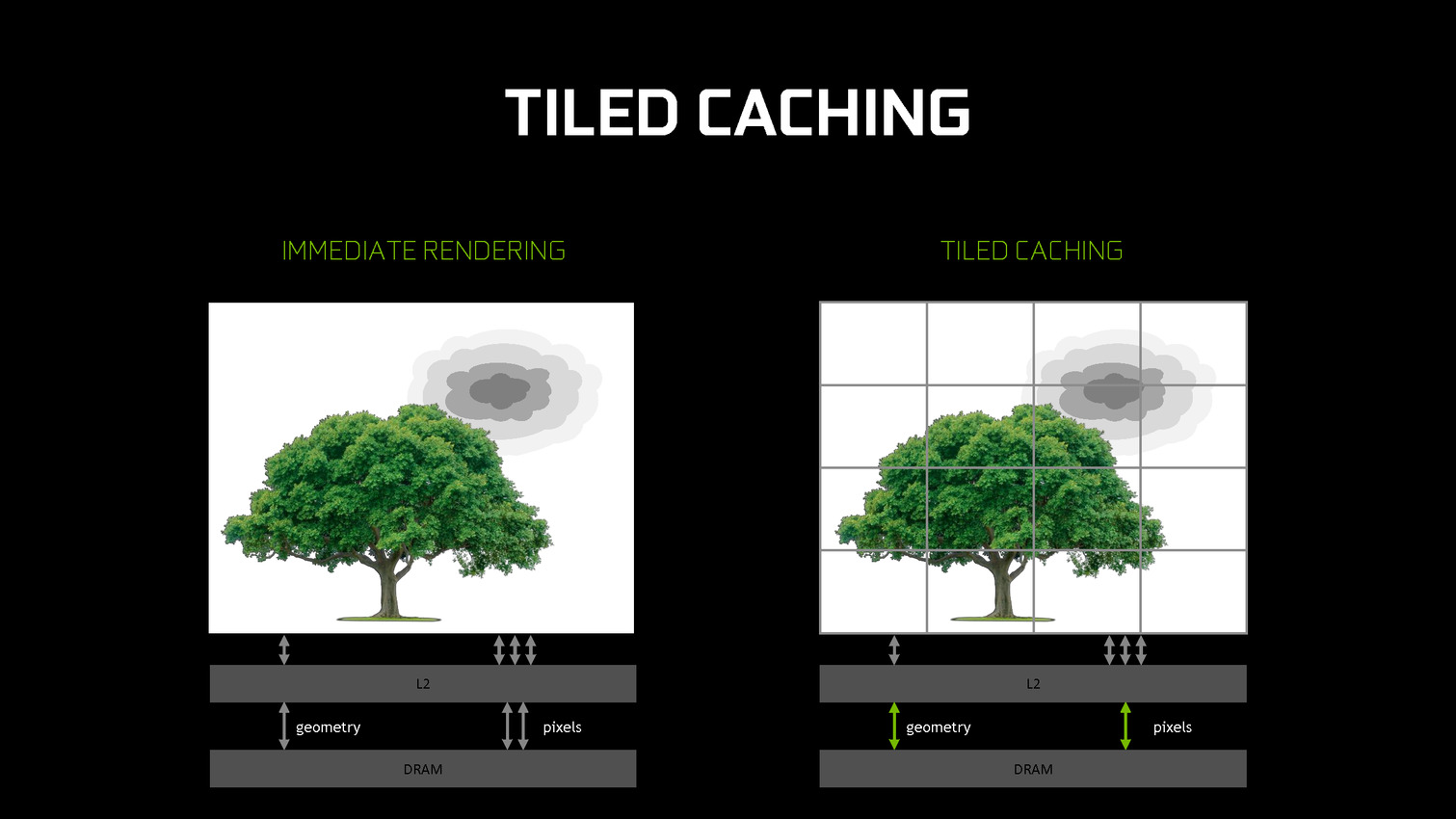

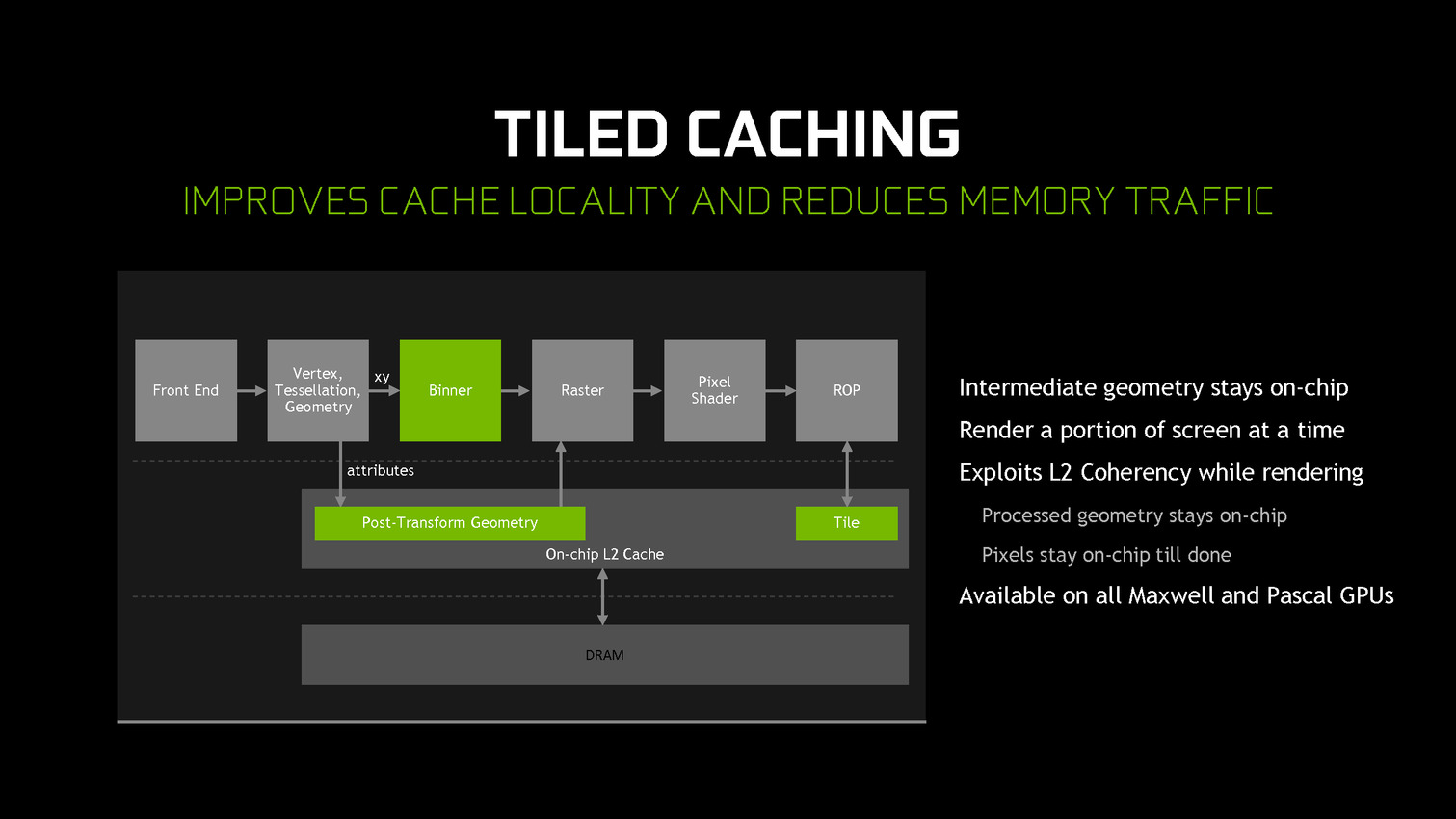

A partir des GPU Maxwell, Nvidia a cherché à pouvoir bénéficier d'une partie des avantages de cette seconde approche sans perdre la flexibilité du rendu immédiat. C'est le Tile Caching qui peut être vu comme un "rendu avec rastérisation retardée". Une fois un triangle traité, au lieu de l'envoyer vers le moteur de rastérisation, Nvidia le conserve en cache interne, ainsi que tous ses paramètres. Quand ce cache est rempli, la rastérisation peut débuter. Grossièrement, il s'agit d'interrompre le rendu et d'attendre d'avoir un plus d'informations (mais pas toutes) avant de le poursuivre plus efficacement.

Une petite unité fixe supplémentaire, appelée binner, se charge de suivre la position et la couverture de chaque triangle en cache. Quand le temps de leur rastérisation est arrivé, parmi ces quelques triangles, le GPU sait lesquels seront assurément et totalement masqués. L'inverse n'est par contre pas vrai puisque, contrairement au TBR/TBDR, tous les triangles n'ont pas été traités en amont, juste quelques-uns. Il s'agit d'une optimisation localisée et opportuniste plus que d'un changement de philosophie global pour ces GPU.

Cette approche permet de traiter la rastérisation par tile et non pas par triangle. Il y a un surcoût au niveau de la rastérisation (même si Nvidia profite probablement de son moteur de projection multiple pour le limiter) mais ces tiles peuvent rester en cache. Elles ne sont alors écrites en mémoire que quand que tous les triangles en cache et qui y sont visibles ont été traités. Contrairement au TBR/TBDR, ces tiles seront réécrites en mémoire plusieurs fois lorsque d'autres morceaux de géométrie qui les parcourent seront traités.

Nvidia nous précise qu'aucun cache spécifique n'a été implémenté et que c'est le cache L2 qui est exploité. C'est la raison pour laquelle il a fait un bond énorme en taille à partir des GPU Maxwell (1 voire 2 Mo par 128-bit de bus contre 256 Ko sur Kepler). Un système d'optimisation automatique à base d'heuristiques a été mis en place pour opter pour la taille la plus adaptée au niveau du buffer de triangle et des tiles, mais Nvidia peut configurer tout cela manuellement pour chaque jeu ou débrayer le Tile Caching s'il est contreproductif.

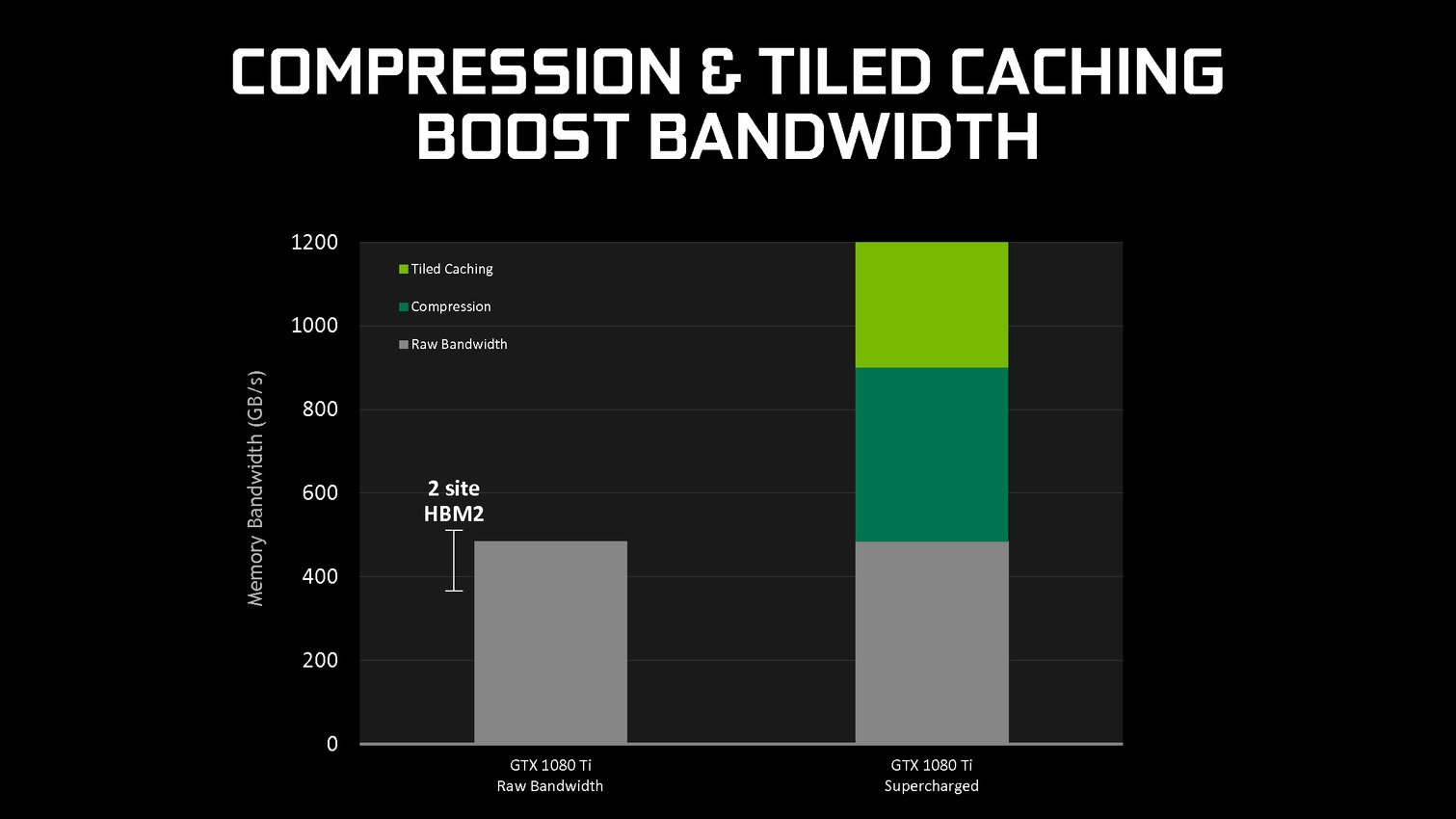

En se contentant de chercher des opportunités d'optimisation locales, par morceau de géométrie, Nvidia parvient à obtenir des gains sympathiques, certes inférieurs à ceux obtenus par une architecture purement TBR/TBDR, mais qui permettent de conserver plus de flexibilité et de performances dans un maximum de situations. C'est un des piliers de l'excellente efficacité des GPU Maxwell et Pascal. Cela fait également partie d'une stratégie réfléchie qui consiste à chercher à créer de la valeur au niveau de ses propres puces plutôt que via l'exploitation d'une mémoire plus onéreuse (bus 512-bit, HBM…).

GDC: Nvidia va proposer des GTX 1080 et 1060 OC

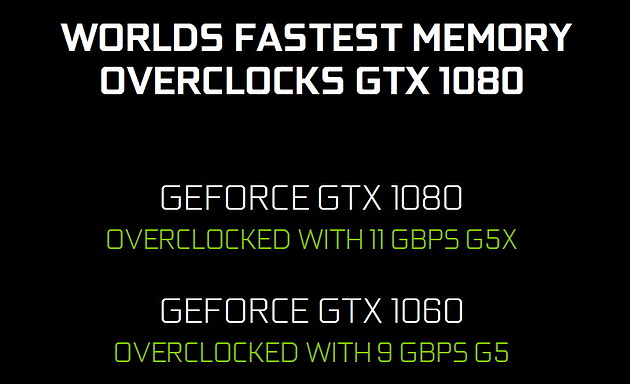

Nvidia va proposer à ses partenaires des versions OC de ses kits GPU et mémoire pour les GTX 1080 et GTX 1060 qu'ils conçoivent. Si les GPU seront identiques, ils seront associés à de la mémoire plus rapide.

La GeForce GTX 1080 8 Go OC profitera de la nouvelle GDDR5X 11 Gbps de Micron pour un gain de 10% au niveau de la bande passante mémoire. Du côté de la GeForce GTX 1060 6 Go OC, la mémoire GDDR5 passera de 8 Gbps à 9 Gbps. Aucune indication tarifaire ne nous a été donnée.

A voir bien entendu ce que feront les partenaires de ces nouvelles sous-déclinaisons et s'ils les réserveront à leurs versions OC les plus chères ou s'ils essayeront de les généraliser. Il sera également intéressant d'observer sur la marge d'overclocking, très élevée actuellement, progressera ou s'il s'agit uniquement de pouvoir proposer une certification à une fréquence légèrement supérieure.