Nvidia GeForce GTX 580 & SLI

Publié le 09/11/2010 (Mise à jour le 25/11/2010) par Damien Triolet

La GeForce GTX 580 de référencePour ce test, Nvidia nous a fourni une paire de GeForce GTX 580 de référence :

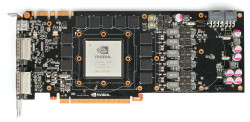

Pour cette GeForce GTX 580, Nvidia a repris un PCB similaire à de celui de la GeForce GTX 480 si ce n’est qu’il n’est plus troué étant donné que cela n’apportait en pratique aucun gain au niveau de l’apport en air frais. Le nouveau PCB a été optimisé pour être plus fiable par rapport à la consommation extrême de la GeForce GTX 580, identique à celle de la GeForce GTX 480.

La connectique est elle aussi identique avec 2 sorties DVI Dual Link, une sortie mini-HDMI, 2 connecteurs SLI et des connecteurs d’alimentation 8+6 broches.

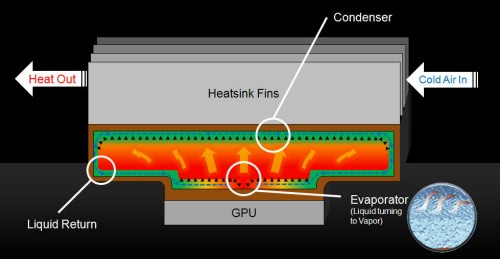

La plus grosse évolution réside dans le système de refroidissement de la GeForce GTX 580. Nvidia utilise une turbine légèrement différente, qui produit moins de nuisances sonores. Par ailleurs, la partie externe du radiateur qui accumulait beaucoup de chaleur et la dispersait dans le boîtier disparaît au profil d’un modèle plus classique. Celui-ci gagne cependant en efficacité grâce à l’utilisation d’une chambre à vapeur, comme le fait AMD sur la Radeon HD 5970 par exemple.

Nvidia parle d’un TDP dans les jeux de 244W mais il est en réalité plutôt de 300W dans les stress tests.Pour tenter de contenir la consommation, Nvidia a intégré des composants qui permettent aux pilotes (mais pas directement au GPU) de suivre la consommation du GPU ou plutôt l’intensité du courant qui passe par chacun des 3 canaux d’alimentation 12v (bus PCI Express et connecteurs).

Nvidia n’a cependant pas activé de monitoring global et, pour éviter de réduire les performances dans les jeux ou dans 3DMark, se contente de mettre son système en action dans les dernières versions de Furmark et d’OCCT, soit dans les tests de charge extrême utilisés par les testeurs pour mesurer la consommation. Dans ces applications, si le pilote observe une consommation qui va au-delà d’une certaine limite, il baisse les fréquences de moitié, et encore une fois de moitié si ce n’était pas suffisant.

En pratique, le système de Nvidia revient plus à empêcher d’utiliser de tels logiciels qu’à maintenir la consommation dans une enveloppe thermique bien définie. Nvidia nous a indiqué qu’il était voué à évoluer pour inclure plus d’applications à risque. Il n’est par contre pas certain qu’il évolue vers une surveillance permanente de la consommation.

Au niveau de l'overclocking, nos 2 échantillons ont accepté une fréquence de 875 MHz pour le GPU, testée stable sous une version de Furmark non ralentie par le mécanisme de Nvidia. Cela représente une augmentation de 13%.

Enfin, précisons que si toutes les cartes alimentent le GPU en 0.962V au repos, la tension varie en charge suivant les exemplaires, ce qui permet à Nvidia de maximiser le nombre de puces qualifiées pour tenir certaines spécifications. Ainsi, en charge, l'un de nos exemplaires de test tournait avec une tension GPU de 1.050V alors que le second se contentait de 1.025V.

Sommaire

Vos réactions

Contenus relatifs

- [+] 10/04: Nvidia : fin du support Fermi et 32...

- [+] 12/03: Nvidia lance les GeForce 800M avec ...

- [+] 12/03: 50 € de moins sur les GTX 580 et 57...

- [+] 16/12: EVGA GTX 580 Classified Ultra

- [+] 08/12: GTX 580 Twin Frozr III chez MSI

- [+] 18/11: GeForce GTX 580 tri écran chez Gala...

- [+] 08/10: Comparatif : les super GeForce GTX ...

- [+] 08/10: Test : GeForce GTX 580 Classified d...

- [+] 25/08: Test GeForce GTX 580 3Go vs 1.5Go, ...

- [+] 06/07: EVGA GTX 580 Classified