Les derniers contenus liés aux tags Radeon et GDC

Microsoft annonce DirectX Raytracing

GDC: Après les R9 Fury, les Radeon RX Vega

GDC: AMD annonce la Radeon Pro Duo

GDC: AMD, Intel, Nvidia, Qualcomm... à la GDC

GDC: La Radeon HD 7990 d'AMD en approche

Microsoft annonce DirectX Raytracing

Microsoft a profité de l'ouverture de la GDC pour annoncer une nouvelle API, DirectX Raytracing (DXR) . Comme son nom l'indique, il s'agit d'une nouvelle API qui vient s'ajouter aux autres API DirectX pour standardiser l'utilisation de certaines techniques dites de raytracing. Le raytracing tente pour rappel de représenter de manière plus exacte le parcours de la lumière pour proposer des rendus réalistes. L'inconvénient de la technique étant son coût généralement prohibitif, même si des approximations existent.

A l'inverse, le rendu 3D dans les jeux actuel est basé sur la rasterisation, la projection d'une scène 3D en 2D avant d'y appliquer les traitements pour obtenir la couleur des pixels, avec des techniques plus ou moins avancées de gestion de lumière (les premiers jeux 3D se contentant d'imiter les effets de lumière en les dessinant directement dans les textures, tandis qu'aujourd'hui les pixel shaders s'appliquent sur l'image 2D ce qui limite les possibilités même si les développeurs sont extrêmement créatifs). Comme le rappelle le sous titre de l'annonce de Microsoft, "3D Graphics is a lie" (le rendu 3D est un mensonge) !

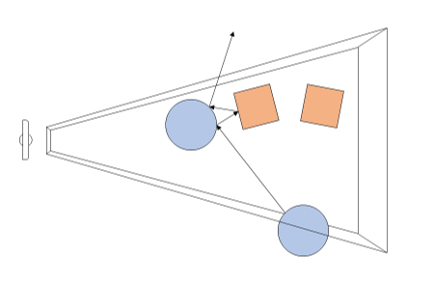

Avec DXR, Microsoft souhaite donc ajouter un peu de "réalisme" avec une petite dose de raytracing. Dans le détail, il s'agit d'une API complémentaire qui ajoute de nouvelles possibilités pour utiliser le raytracing par dessus les pipelines actuels de rasterisation. En pratique, DXR s'appuie sur une représentation de la géométrie pour lancer des rayons. Par dessus cette représentation, chaque objet ou groupe d'objet pourra définir des "raytracing shaders" et des textures spécifiques à utiliser. Une fois ceci crée, le lancé de rayons est appliqué, l'API définie les cas d'intersection, de non intersection, et de "presque" intersection (near miss), en gérant les cas ou les rayons rebondissent sur plusieurs surfaces (multi bounce).

Techniquement, le lancer de rayon est effectué a partir de la "caméra" dans la variante utilisée par DirectX, et peut se faire pour une sélection de pixels de l'écran ou la totalité (Microsoft prend l'exemple de ne le faire uniquement que pour les objets dont la surface est réfléchissante).

Un exemple de rendu DXR avec le moteur SEED d'EA, Project PICA

D'un point de vue compatibilité avec le matériel existant, Microsoft renvoi simplement vers les constructeurs pour les détails. Certains matériels sur le marché disposeraient déjà d'un support de DXR (on ne sait pas lesquels), et Microsoft semble proposer un mode de rendu alternatif s'appuyant sur Direct Compute pour fonctionner sur tout le matériel existant aujourd'hui (avec un niveau de performances on l'imagine réduit).

AMD nous a indiqué qu'ils collaboraient "étroitement" avec Microsoft "pour les aider à définir, améliorer et prendre en charge l'avenir de DirectX 12 et du ray tracing", un propos qui évite soigneusement de prononcer l'acronyme DXR. AMD dispose déjà d'une API de ce type utilisable sur de multiples plateformes avec Radeon Rays . Interrogé sur la question spécifique de l'accélération matérielle, AMD nous a indiqué qu'ils proposeraient, à un moment non défini, un pilote qui proposera une accélération DXR (au delà du mode "fallback" utilisant Direct Compute et qui lui marche sur tous les GPU, mais probablement en étant peu utilisable). Ce qui sera accéléré, et quelles cartes seront concernées n'est pas encore défini non plus selon le constructeur. On semble sentir une certaine précaution pour ne pas dire frilosité de la part de la société sur sa communication, il nous est difficile de savoir s'il s'agit d'un manque de préparation sur le sujet, d'un désaccord avec Microsoft sur certains choix effectués, ou d'autre chose.

Nvidia de son côté a évoqué son implémentation sous le nom de RTX, cette dernière ne s'appliquera qu'à compter des GPU Volta et ultérieurs (soit uniquement la Titan V dans les GPU "joueurs" actuels de la gamme du constructeur). Nvidia présente la technologie là aussi de manière assez vague, sous entendant que leur implémentation sera utilisable "via" DXR, mettant son API en avant sans que l'on sache si c'est simplement dans un but de démarcation compétitive ou autre chose. Là encore à l'image d'AMD, la communication des deux principaux constructeurs ne va pas exactement dans le même sens que celle de Microsoft (les relations entre Microsoft et les responsables GPU ont toujours été particulières, chacun tentant de tirer la couverture de son côté et de créer un avantage compétitif, que ce soit les constructeurs de GPU l'un face à l'autre, ou Microsoft à proposer une API et des fonctionnalités qui ne soient pas cross-platform).

Du côté des développeurs, Microsoft annonce que les moteurs Frostbite, SEED (plus haut), Unity et Unreal Engine proposeront une forme de support de DXR. Futuremark devrait également proposer un test de ce type pour une version de 3D Mark.

GDC: Après les R9 Fury, les Radeon RX Vega

Lors de la GDC, AMD n'a pas dévoilé de nouvelles informations techniques concernant sa future architecture et son futur GPU Vega 10. Mais à côté d'une démonstration du FP16 et du HBCC, le nom commercial des Radeon basées sur ce futur GPU haut de gamme a été dévoilé : ce sera tout simplement Radeon RX Vega.

AMD compte profiter de toute la communication qui a déjà été effectuée autour de ce nom de code pour en faire une marque, ce qui est assez logique. Et il n'est pas impossible que cette marque soit dérivée en Radeon RX Vega X, Radeon RX Vega ou encore Radeon RX Vega Nano, tout cela sera précisé à l'approche du lancement de ces cartes graphiques.

Parallèlement à ces Radeon haut de gamme, AMD devrait proposer des Radeon RX 500 qui reprendront les GPU Polaris actuels et peut-être un second plus petit GPU Vega. Après une année de recul, AMD pourra probablement profiter d'une nouvelle révision, d'un procédé de fabrication en 14nm qui a gagné en maturité ou tout simplement d'un tri plus fin des puces pour proposer des fréquences en hausse et/ou une consommation en baisse.

Les Radeon RX 500 et les Radeon RX Vega sont attendues pour le second trimestre 2017.

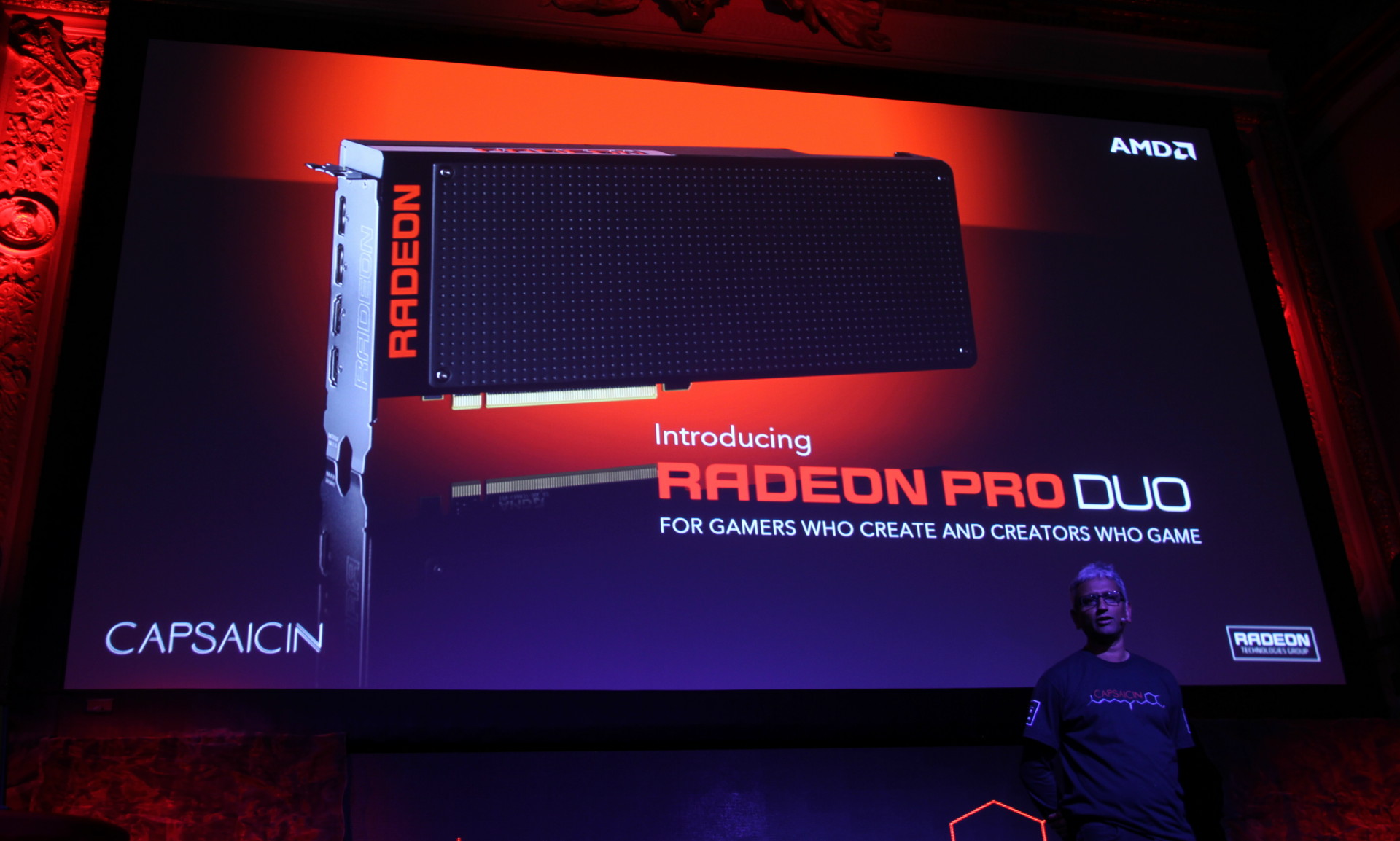

GDC: AMD annonce la Radeon Pro Duo

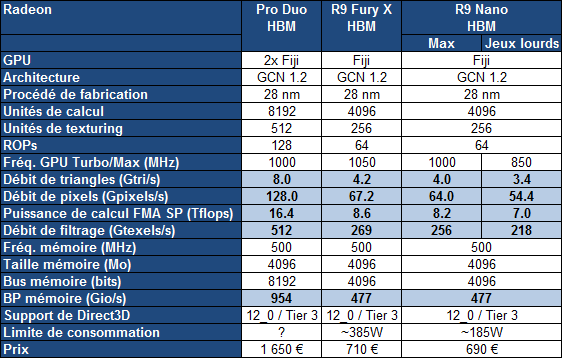

Depuis la présentation de la Radeon R9 Fury X, AMD a fait part de son intention d'en proposer une version bi-GPU. Initialement prévue pour fin 2015, cette solution graphique ultra haut de gamme a été repoussée de quelques mois et est aujourd'hui officiellement lancée en tant que Radeon Pro Duo.

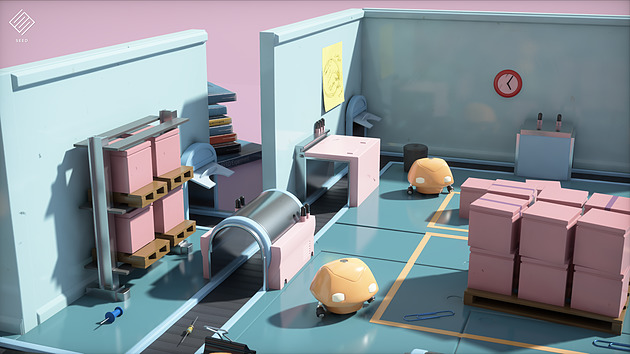

Après quelques mois de retard, AMD lance enfin la Fiji Gemini sous la référence Radeon Pro Duo. Comme son nom l'indique, il s'agit d'une Radeon mais qui vise avant tout un usage professionnel, particulièrement dans le cadre de la réalité virtuelle. Si les cartes graphiques bi-GPU ont traditionnellement permis à AMD et Nvidia de se battre pour la première place du podium, commercialement elles ne représentent qu'un minuscule marché auprès des joueurs. Leur intérêt n'est justifié que dans quelques situations bien précises et quand les jeux récents prennent correctement en charge le multi-GPU, ce qui n'a pas toujours été le cas au cours des 6 derniers mois.

AMD semble avoir bien compris ce problème de positionnement sur le marché et a décidé de réorienter presqu'exclusivement sa solution bi-GPU vers la réalité virtuelle. Un domaine qui a besoin de plus de performances et qui par nature permet de profiter correctement du bi-GPU puisqu'une image doit être rendue pour chaque oeil. La Radeon Pro Duo, qui supporte bien entendu Liquid VR, est ainsi présentée comme étant la solution ultime pour créer et visionner du contenu de type VR. De ce fait il s'agit de la première solution à recevoir la certification AMD VR Ready Creator.

C'est également la solution exclusive retenue par Crytek pour équiper les labos VR First qui seront progressivement installés dans différents établissement éducatifs à commencer par l'université de Bahçesehir d'Istanbul. Ces labos sont en quelque sorte de mini incubateurs destinés à faire émerger talents et vocations face au potentiel de la réalité virtuelle. Ils profiteront bien entendu d'un accès complet au CryENGINE et à LiquidVR.

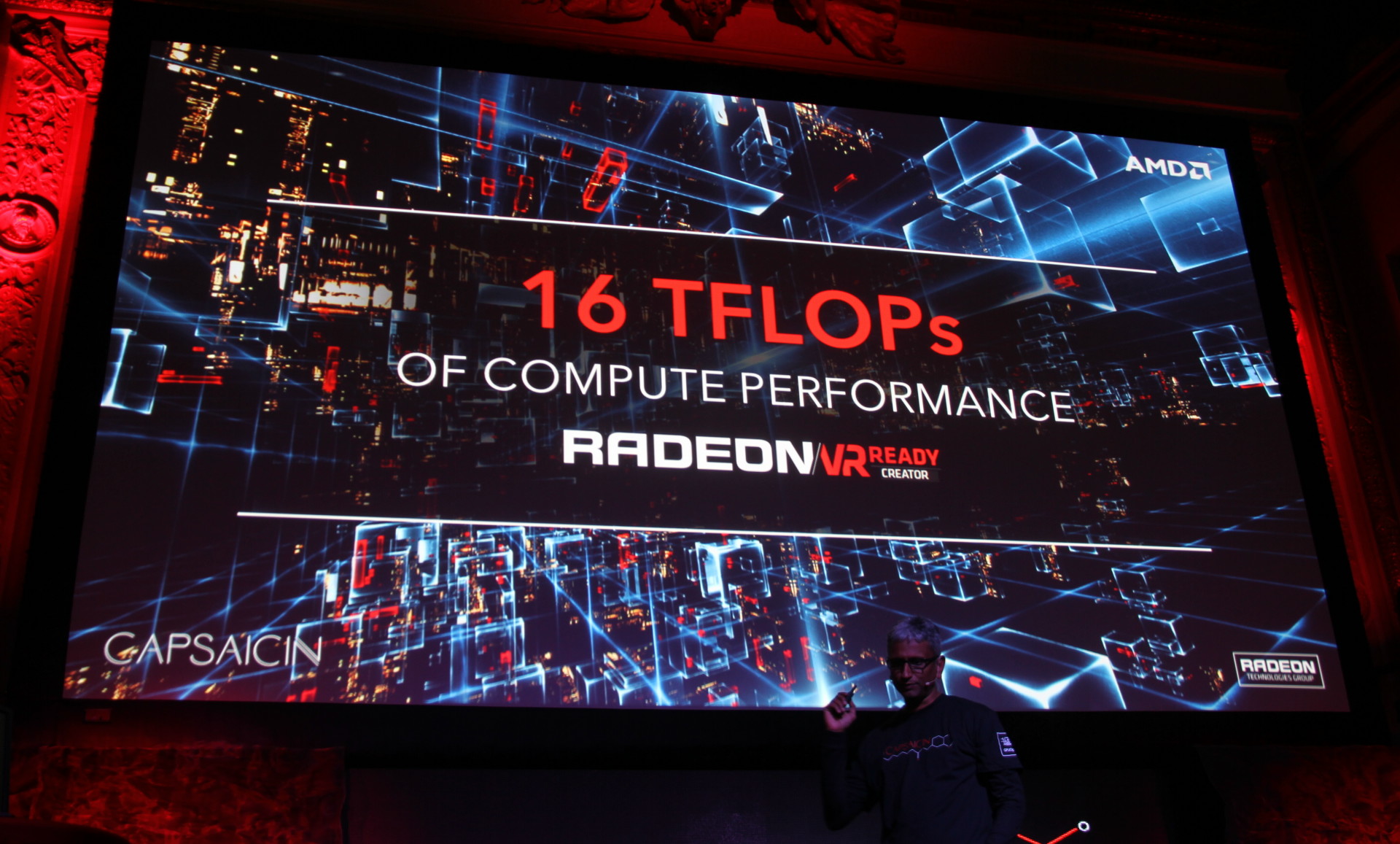

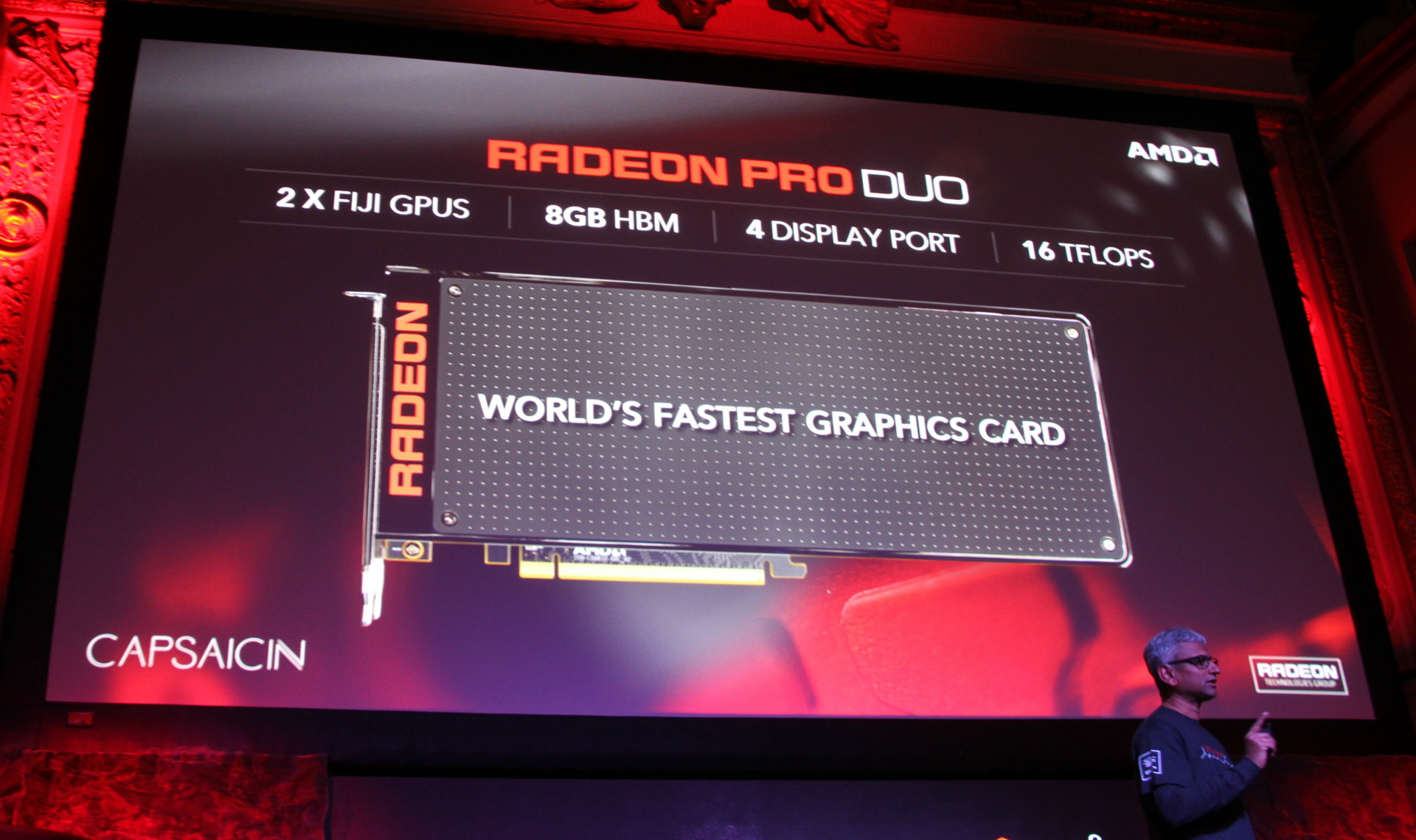

Avec la Radeon Pro Duo, AMD semble n'avoir fait aucun compromis sur les performances avec 16 Tflops au compteur et à priori une limite de consommation très élevée. Le premier PCB bi-Fiji qui avait été présenté était alimenté par 2 connecteurs 8 broches et il était alors logique de supposer que sa configuration serait de type bi Radeon R9 Nano, soit avec une limite de consommation très stricte de +/- 375W.

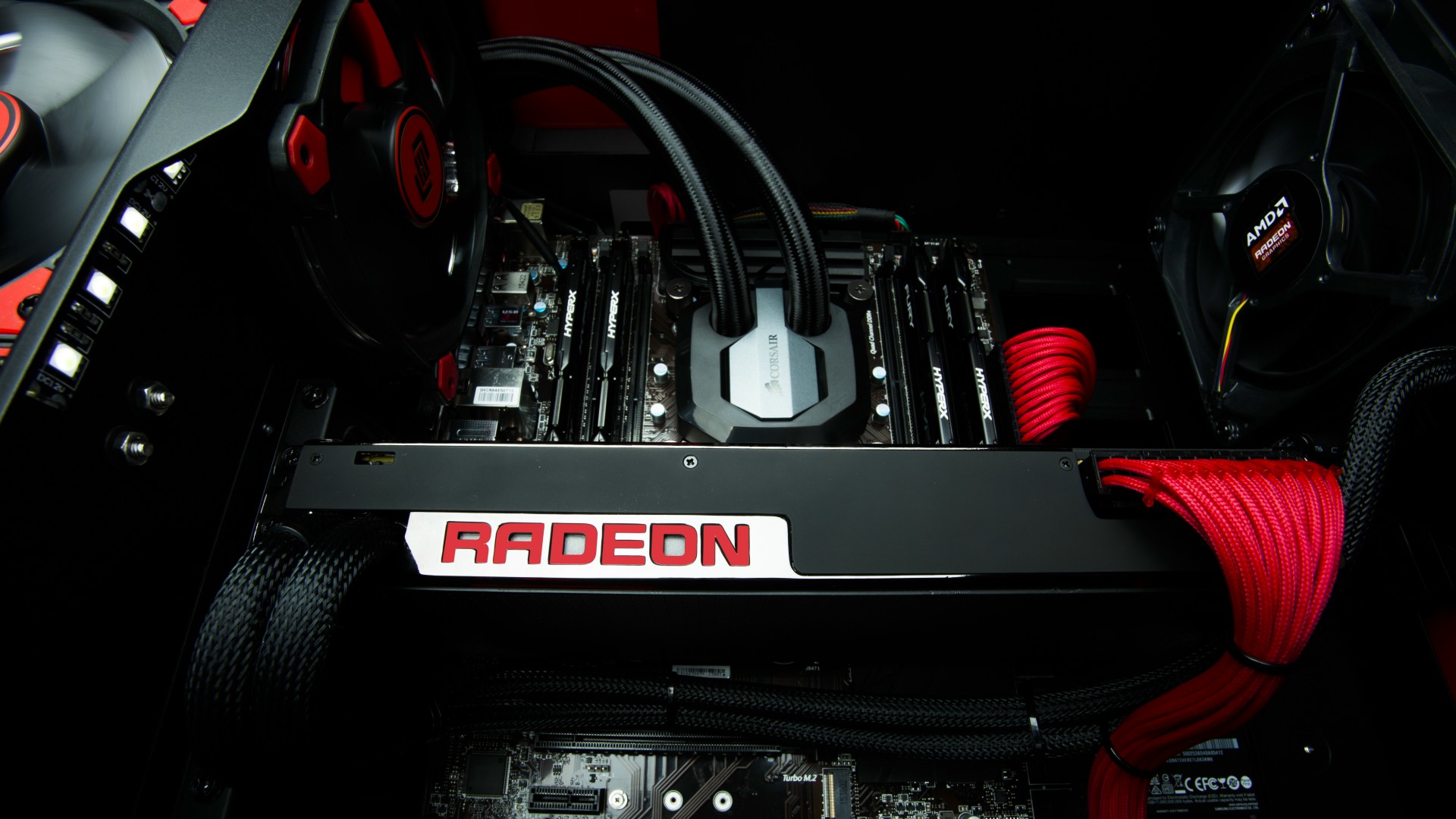

Pour cette Radeon Pro Duo, AMD exploite cependant un PCB différent avec pas moins de 3 connecteurs 8 broches, de quoi autoriser jusqu'à 525W. Nous ne savons cependant pas quelle est la limite de consommation réelle de la carte. Pour refroidir la bête, AMD reste sur une solution de watercooling personnalisée avec un design proche de celui de la R9 Fury X mais étendu au bi-GPU. Le radiateur reste au même format mais est nettement plus épais.

La Radeon Pro Duo est annoncée pour le début du printemps à un tarif de 1500$ soit environ 1650€ en Europe.

GDC: AMD, Intel, Nvidia, Qualcomm... à la GDC

Lors de la GDC, dont l'édition 2013 s'est terminée vendredi dernier à San Francisco, les plus importants fournisseurs de technologies graphiques (les GPU Radeon, Mali, PowerVR, HD Graphics, GeForce, Adreno) étaient présents avec notamment pour but de convaincre les développeurs de jeux vidéo d'exploiter toutes les possibilités de leurs produits récents à travers des techniques de rendu toujours plus évoluées que ce soit sur PC ou dans le monde mobile, qui progresse à vive allure.

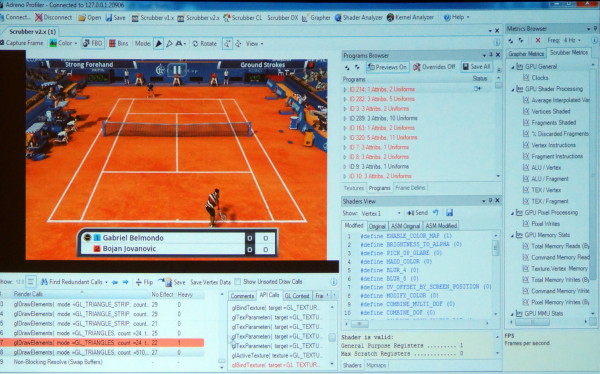

En plus de diverses présentations, AMD, ARM, Imagination, Intel, Nvidia et Qualcomm étaient présents à travers des stands principalement exploités pour mettre en avant leurs outils maisons : AMD GPU PerfStudio, ARM Mali Graphics Debugger, Imagination PVRTune, Intel Graphics Performance Analyzers, Nvidia Nsight, Qualcomm Adreno Profiler…

Ici en exemple, l'Adreno Profiler de Qualcomm qui permet d'observer assez facilement le comportement des GPU Adreno et d'appliquer des modifications à la volée pour identifier des bugs ou des goulots d'étranglement (bottlenecks). Il est ainsi possible de modifier un shader, de désactiver la synchronisation verticale, de réduire la taille de toutes les textures, etc., et d'observer l'impact en temps réel sur le smartphone ou sur la tablette.

Les outils de tous les acteurs cités proposent des possibilités similaires, chacun ayant des petits avantages ou inconvénients par rapport à la concurrence. Ils sont en général autant adapté au débogage et à l'optimisation de la partie graphique que de la partie "compute" éventuellement exposée pour les GPU.

Lors de plusieurs rencontres avec des développeurs, nous avons voulu savoir quels outils ils préféraient et pourquoi. La réponse de nos interlocuteurs a été unanime : aucun ! Pourquoi ? Tout simplement parce que la multiplication de ces outils devient problématique et que peu importe leurs qualités ou leurs défauts, devoir utiliser un outil spécifique à chaque marque de GPU est tout sauf pratique, d'autant plus quand il faut en supporter bon nombre comme c'est le cas sous Android.

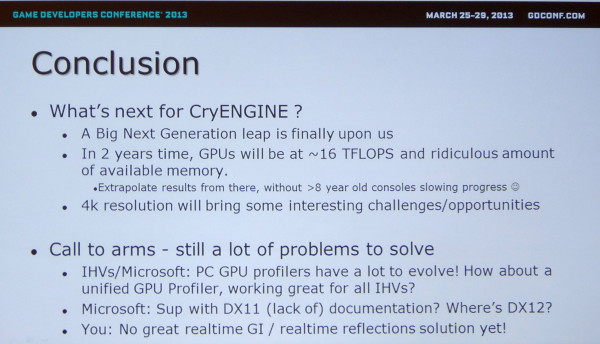

Même avec seulement 3 acteurs, c'est un problème dans le monde PC comme le rappelle Crytek en parlant des opportunités et défis à venir. Il serait ainsi intéressant que Microsoft et Google proposent des outils de développement plus évolués qu'actuellement et dans lesquels les concepteurs de GPU pourraient venir s'interfacer pour proposer autant de détails que dans leurs propres outils mais d'une manière plus ou moins unifiée.

Notez au passage que Crytek en profite pour rappeler à Microsoft qu'il serait peut-être bon de travailler sur la documentation de DirectX !

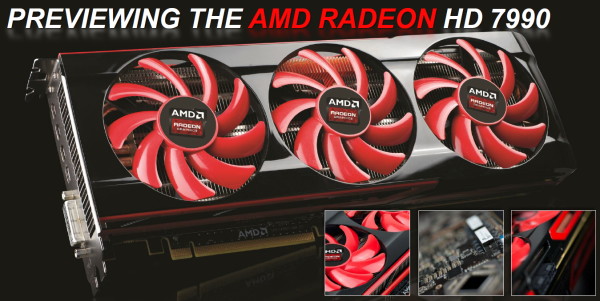

GDC: La Radeon HD 7990 d'AMD en approche

Un temps annulée puis laissée aux mains de quelques partenaires, la Radeon HD 7990 aura connu une gestation longue et compliquée. AMD vient cependant de confirmer qu'un design de référence était actuellement en cours de finalisation

Aucune information concernant les spécifications finales, si ce n'est que la carte est équipée de 2 connecteurs PCI Express 8 broches, mais nous pouvons cependant observer qu'il s'agit d'un design proche de celui présenté à l'AFDS 2012, qui est légèrement différent du design de la FirePro S10000.

Pour accompagner la sortie future de cette Radeon HD 7990 "officielle", AMD prépare une nouvelle démo technologique qui mettra une nouvelle fois en scène Ruby. Cette démo est développée en partenariat avec Crytek, elle repose donc sur le CryEngine 3, et Illfonic (Nexuiz) et a pour but de se rapprocher d'un rendu cinématographique avec une utilisation de nombreux effets de particules, de la tessellation et d'un effet de Depth of Field évolué.

Cette démo est encore en développement et nous n'avons pu en observer qu'un bref extrait sur un petit écran, difficile donc de se faire une idée précise de la qualité du rendu final. Notez que la technologie TressFX, dédiée au rendu des cheveux n'est pas encore de la partie, mais elle est bel et bien en cours d'intégration.