Les derniers contenus liés au tag HD Graphics

GDC: Intel PixelSync et InstantAccess

Dossier: Quelle solution graphique pour moins de 100€ ?

Les Skylake en fin de vie chez Intel

Intel a publié un PCN (pdf) indiquant la fin de vie des deux modèles les plus emblématiques de sa gamme Skylake, les Core-i7 6700K et Core i5-6600K. Deux processeurs lancés il y a un peu plus de deux ans et qui ont été "remplacés" dans la gamme d'Intel par les Kaby Lake que l'on considère au mieux comme un nouveau stepping des Skylake, corrigeant quelques bugs dans l'IGP.

A compter du 30 mars prochain, quatre références ne seront plus disponibles au catalogue du constructeur :

- Core i7-6700K

- Core i5-6600K

- Core i5-6402P

- Core i3-6098P

Le Core i5-6402P est une version du Core i5-6400 disposant d'un IGP plus léger (HD Graphics 510 contre 530) et qui propose en contre partie 100 MHz de plus. Le Core i3-6098P applique la même formule ou presque au Core i3-6100, cette fois ci il perd 100 MHz tout en ayant un IGP plus petit. Il gagne par contre 3 watts a son TDP officiel...

Pour rappel, Intel devrait lancer en octobre ses Coffee Lake qui reprendront une fois de plus l'architecture de Skylake, mais en faisant passer de 4 à 6 le nombre de coeurs. Un changement qui s'accompagnera de la nécessité de nouvelles cartes mères, bien que le socket reste semblable...

Dossier : Pentium G4560 : la fin des Core i3 ?

Avec Kaby Lake, Intel propose pour la première fois l'HyperThreading sur sa gamme Pentium, piquant l'argument phare des Core i3. Comment se comporte le G4560 face à un i3-7100 plus onéreux ?

[+] Lire la suite

IDF: Iris Pro 5200 et mini projecteur chez Gigabyte

Bien que lancé un peu plus tôt dans l'année, les machines équipées de la version Iris Pro 5200 des HD Graphics (celle qui est accompagnée de 128 Mo de mémoire eDRAM) ne sont pas particulièrement nombreuses sur le marché. Gigabyte proposait une version spéciale de sa plateforme Brix (des plateformes compactes dont nous vous avions déjà parlé et qui rappellent le concept NUC d'Intel, mais avec des processeurs plus haut de gamme) équipée d'un processeur 4770R, rebaptisée pour le coup Iris.

Nous avons pu jouer rapidement avec la machine Brix II/Iris qui était en démo sous GRID 2, et si l'on aura noté quelques artefacts qui semblaient surtout lié au câble HDMI (la machine était en accès libre et très manipulée, il ne s'agissait pas a proprement parler d'artefacts classiques de carte graphiques), on aura noté tout de même que le ventilateur était assez actif !

Gigabyte présentait également une autre version de son Brix, cette fois ci équipé d'un mini-projecteur intégré. Un trepied est également intégré et si l'on ne jugera pas la qualité de la projection, les allées très éclairées n'aidant vraiment pas, cette version avait le mérite d'être amusante ! Globalement, les plateformes Brix II seront toutes équipées de processeurs Haswell, qu'il s'agisse des versions R pour les Iris, ou des versions U pour les Brix II classiques. Vous noterez enfin qu'un Brix II + HDD, disposant d'un slot interne 2.5 pouces était lui aussi présenté par Gigabyte, la plateforme originale ne gérait pour rappel que le mSATA !

Haswell GT3e décliné en BGA pour Desktop

VR-Zone nous apprends qu'Intel prévoit de lancer des déclinaisons d'Haswell destinées au PC de bureau et au format BGA, c'est-à-dire soudés à la carte mère.

VR-Zone nous apprends qu'Intel prévoit de lancer des déclinaisons d'Haswell destinées au PC de bureau et au format BGA, c'est-à-dire soudés à la carte mère.

Ces processeurs affichant un TDP de 65 watts seront dotés d'un Intel HD Graphics 5200, soit la version la plus rapide de l'iGPU. Elle est pour rappel dotée de 40 blocs d'unités de shaders (2.5x plus que l'HD Graphics 4000) et associée à un cache mémoire directement intégré au sein du packaging du processeur.

Ce GT3e, que l'on croyait réservé aux portables, est donc en fait plus précisément réservé au format BGA. Les quelques watts de TDP supplémentaires leur permettent de monter plus haut côté CPU que les versions portables, puisque si le Core i7-4950HQ est à 2.4 GHz de base avec un Turbo à 3.6 GHz et un IGP pouvant monter à 1.3 GHz, ils sont pour leur part configurés de la sorte :

- Core i7-4770R : 3.2 GHz (Turbo à 3.9 GHz max), L3 6 Mo, iGPU à 1.3 GHz max

- Core i5-4670R : 3.0 GHz (Turbo à 3.7 GHz max), L3 4 Mo, iGPU à 1.3 GHz max

- Core i5-4570R : 2.7 GHz (Turbo à 3.2 GHz max), L3 4 Mo, iGPU à 1.1 GHz max

Comme les i7 et i5 LGA, il s'agit de processeurs 4 cœurs mais l'i7 se distingue par le support de l'Hyperthreading et un cache un peu plus grand. On perd par contre 2 Mo de cache L3 par rapport aux versions LGA, ainsi que des MHz à numérotation identique (exclusion faite de la dernière lettre).

Reste bien sûr à savoir quels produits utiliseront ces processeurs, on peut par exemple penser à des cartes mères Thin Mini-ITX.

GDC: AMD, Intel, Nvidia, Qualcomm... à la GDC

Lors de la GDC, dont l'édition 2013 s'est terminée vendredi dernier à San Francisco, les plus importants fournisseurs de technologies graphiques (les GPU Radeon, Mali, PowerVR, HD Graphics, GeForce, Adreno) étaient présents avec notamment pour but de convaincre les développeurs de jeux vidéo d'exploiter toutes les possibilités de leurs produits récents à travers des techniques de rendu toujours plus évoluées que ce soit sur PC ou dans le monde mobile, qui progresse à vive allure.

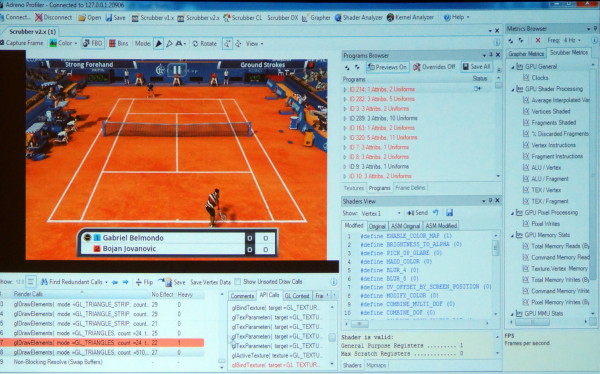

En plus de diverses présentations, AMD, ARM, Imagination, Intel, Nvidia et Qualcomm étaient présents à travers des stands principalement exploités pour mettre en avant leurs outils maisons : AMD GPU PerfStudio, ARM Mali Graphics Debugger, Imagination PVRTune, Intel Graphics Performance Analyzers, Nvidia Nsight, Qualcomm Adreno Profiler…

Ici en exemple, l'Adreno Profiler de Qualcomm qui permet d'observer assez facilement le comportement des GPU Adreno et d'appliquer des modifications à la volée pour identifier des bugs ou des goulots d'étranglement (bottlenecks). Il est ainsi possible de modifier un shader, de désactiver la synchronisation verticale, de réduire la taille de toutes les textures, etc., et d'observer l'impact en temps réel sur le smartphone ou sur la tablette.

Les outils de tous les acteurs cités proposent des possibilités similaires, chacun ayant des petits avantages ou inconvénients par rapport à la concurrence. Ils sont en général autant adapté au débogage et à l'optimisation de la partie graphique que de la partie "compute" éventuellement exposée pour les GPU.

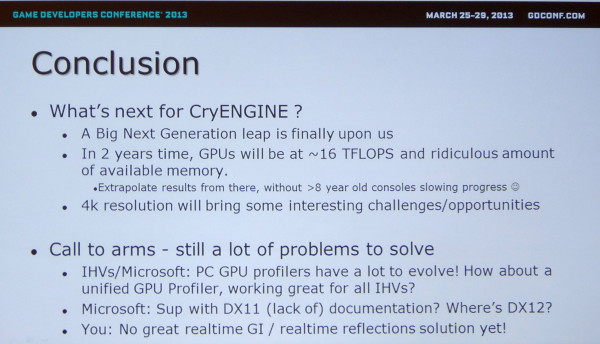

Lors de plusieurs rencontres avec des développeurs, nous avons voulu savoir quels outils ils préféraient et pourquoi. La réponse de nos interlocuteurs a été unanime : aucun ! Pourquoi ? Tout simplement parce que la multiplication de ces outils devient problématique et que peu importe leurs qualités ou leurs défauts, devoir utiliser un outil spécifique à chaque marque de GPU est tout sauf pratique, d'autant plus quand il faut en supporter bon nombre comme c'est le cas sous Android.

Même avec seulement 3 acteurs, c'est un problème dans le monde PC comme le rappelle Crytek en parlant des opportunités et défis à venir. Il serait ainsi intéressant que Microsoft et Google proposent des outils de développement plus évolués qu'actuellement et dans lesquels les concepteurs de GPU pourraient venir s'interfacer pour proposer autant de détails que dans leurs propres outils mais d'une manière plus ou moins unifiée.

Notez au passage que Crytek en profite pour rappeler à Microsoft qu'il serait peut-être bon de travailler sur la documentation de DirectX !