Les contenus liés aux tags Nvidia et GDC

Afficher sous forme de : Titre | FluxLe futur Direct3D dévoilé en mars, l'effet Mantle?

GDC: Démo Nvidia: RealTime Dynamic Fracture

GDC: AMD, Intel, Nvidia, Qualcomm... à la GDC

GDC: Nvidia dévoile la GTX Titan X 12 Go

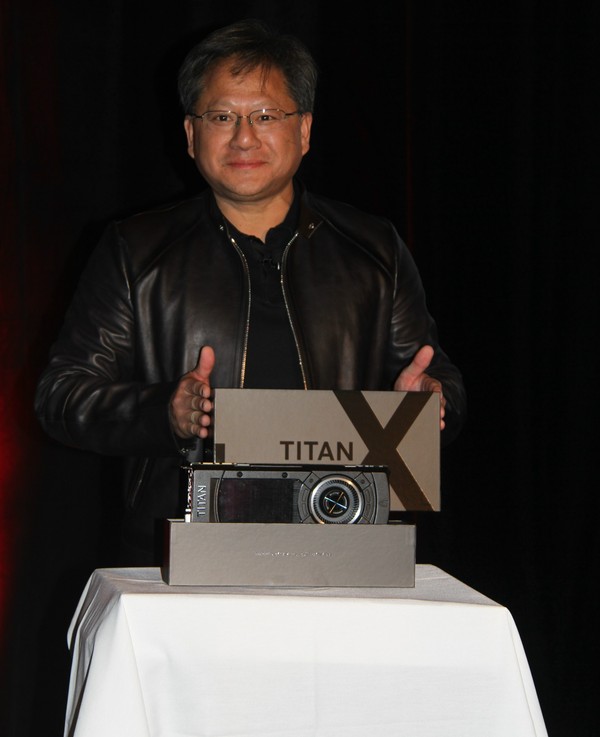

Petite surprise ce matin à la GDC. Lors d'une session d'Epic dans laquelle Tim Sweeney revenait sur les récents développements autour de l'Unreal Engine et demandait des GPU plus performants pour permettre à la VR de prendre son envol, le CEO de Nvidia, Jen-Hsun Huang, a fait une apparition furtive pour y dévoiler une nouvelle GeForce ultra haut de gamme, la Titan X.

Ce n'est pas un secret, depuis quelques temps, un gros GPU Maxwell est attendu chez Nvidia, probablement dénommé GM200. Les détails exacts le concernant resteront encore confidentiels quelques jours. Tout au plus Jen-Hsun Huang aura précisé que le GPU embarque pas moins de 8 milliards de transistors, ce qui en fait un nouveau record, et que la GeForce GTX Titan X dispose de 12 Go de mémoire vidéo, ce qui pointe vers l'utilisation d'un bus 384-bit, un classique sur les gros GPU Nvidia.

La carte en elle-même reprend le design maintenant devenu habituel pour les GeForce haut de gamme même s'il y aura probablement quelques petites améliorations au niveau du bloc de refroidissement. Changement de style par contre puisque la couleur de la coque passe au noir.

Avec la GTX Titan X, Nvidia entend bien asseoir sa domination sur la concurrence mais il faut évidemment s'attendre à un tarif d'au moins 1000€.

Si Jen-Hsun n'a pas donné de date de lancement exacte, au vu de son discours, il semble évident qu'il aura lieu durant la GPU Technology Conference qui ouvrira ses portes le 17 mars, soit dans 2 petites semaines. En attendant, Tim Sweeney pourra profiter du premier exemplaire qui lui a été remis et dédicacé par le CEO de Nvidia.

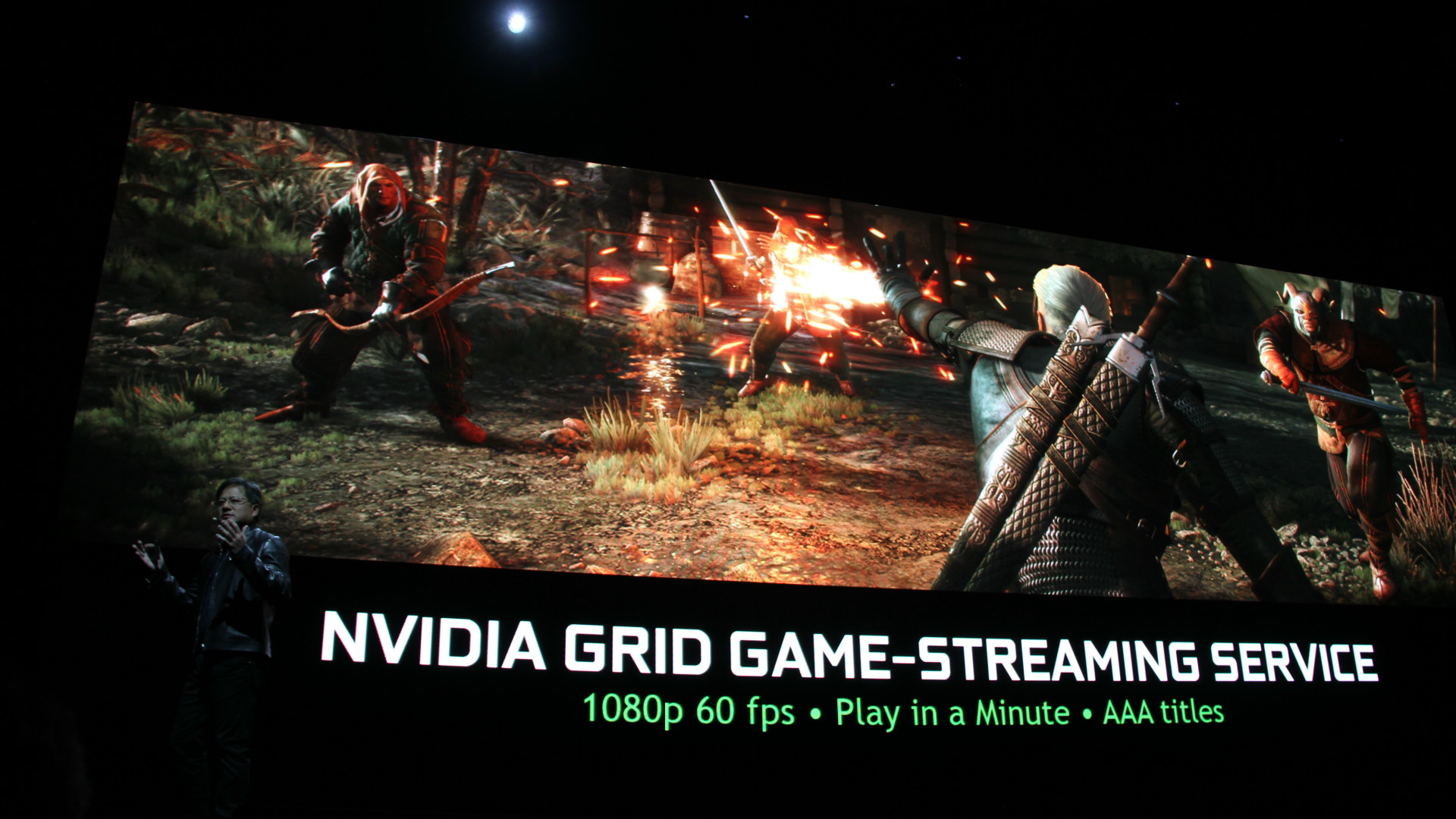

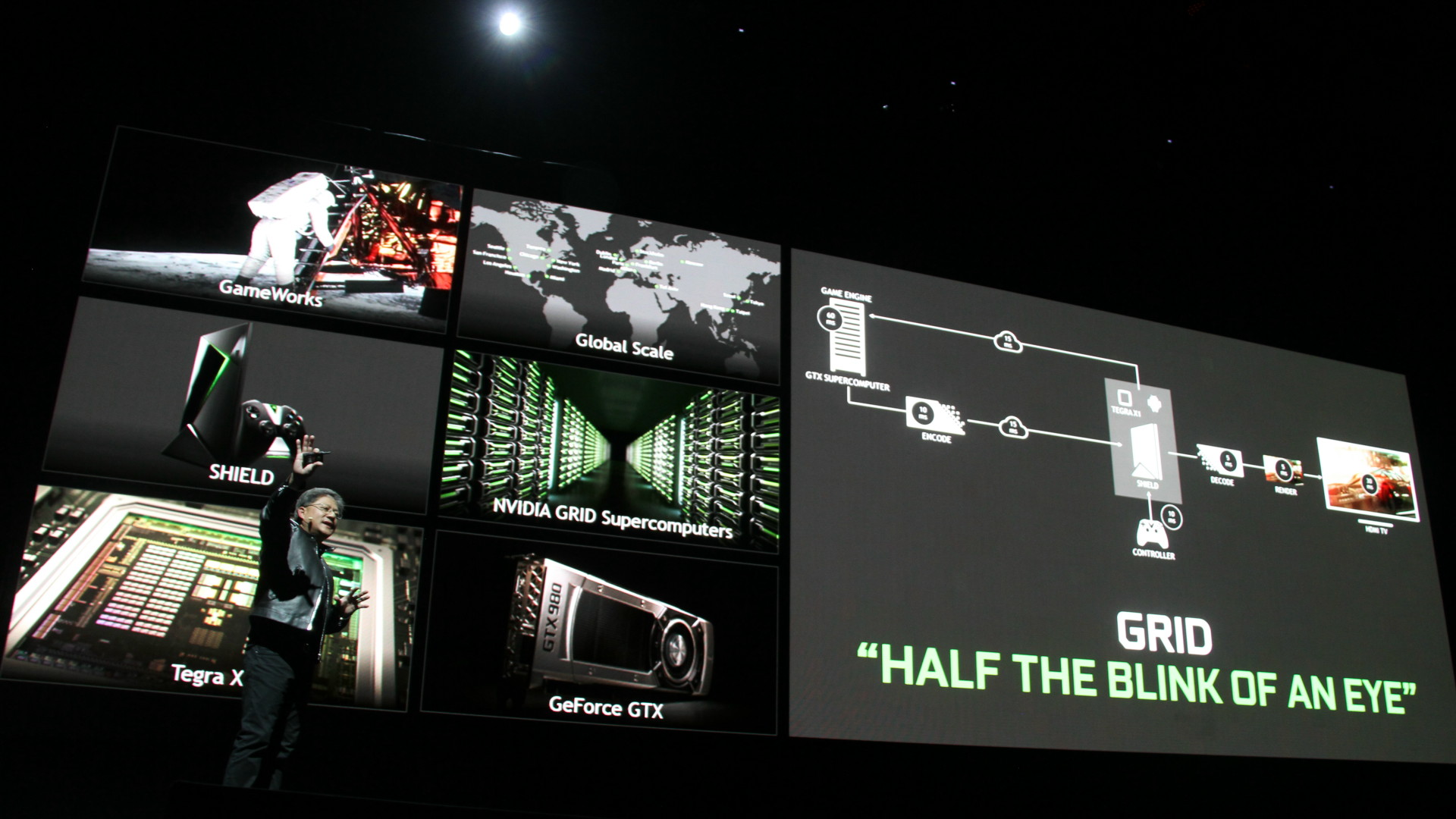

GDC: Nvidia GRID bientôt finalisé et payant

Nvidia a profité du lancement de sa console Shield pour confirmer que le service de cloud gaming GRID passerait bien, comme prévu, de la phase beta à la phase commerciale d'ici quelques mois. Il restera gratuit en 720p jusqu'à la fin du mois de juin pour les possesseurs d'une Shield (tablette ou console), mais un abonnement dont le tarif reste encore à définir sera nécessaire au-delà.

Deux niveaux d'abonnements seront proposés, l'un basique en 720p et l'autre premium en 1080p, toujours en 60 Hz. Une connexion 30 Mbps sera alors nécessaire pour profiter du streaming haute qualité dans de bonnes conditions.

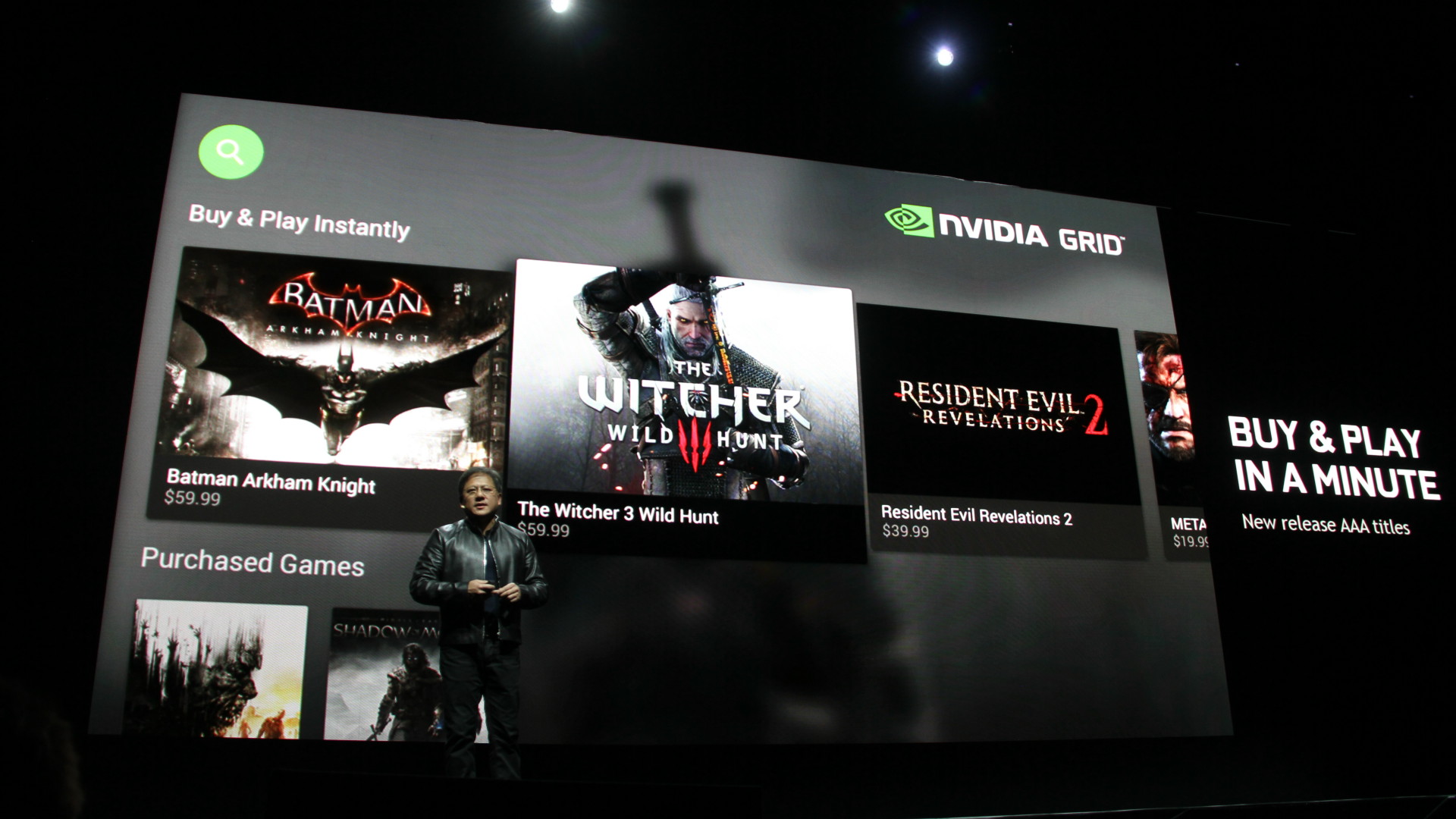

Ces abonnements donneront un accès illimité à un catalogue de jeu qui s'enrichi chaque semaine, mais qui n'intègre pas réellement les dernières nouveautés. Elles seront commercialisées à travers GRID d'une autre manière. Ainsi, les joueurs pourront acheter les jeux AAA récents sur GRID comme ils le font sur d'autres plateformes telles que Steam, à un tarif similaire. Suivant les conditions négociées par Nvidia avec les éditeurs de jeux vidéo, un achat de ce type sur GRID pourra dans certains cas donner l'accès à une version téléchargeable du jeu, en plus du streaming.

Pour profiter de GRID dans les meilleures conditions, passer par une connexion ethernet au niveau de la Shield (via adaptateur pour la tablette) est préférable. La qualité de jeu est alors plutôt bonne, avec une latence réduite à +/- 150ms et laisse entrevoir un large potentiel pour le cloud gaming, même si le jeu PC conserve l'avantage en termes de latence et de qualité graphique.

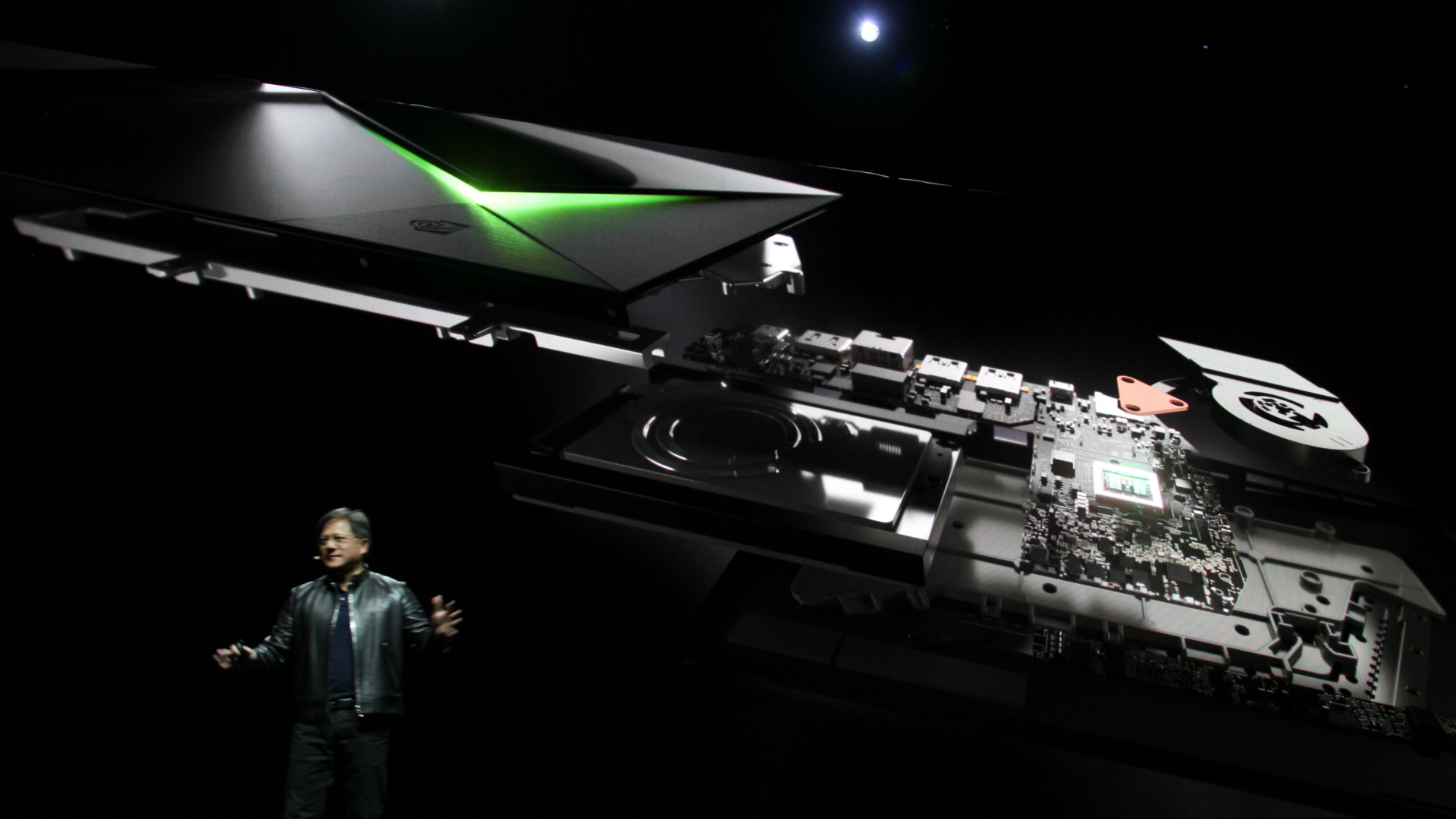

GDC: Nvidia annonce une console Shield pour Android TV

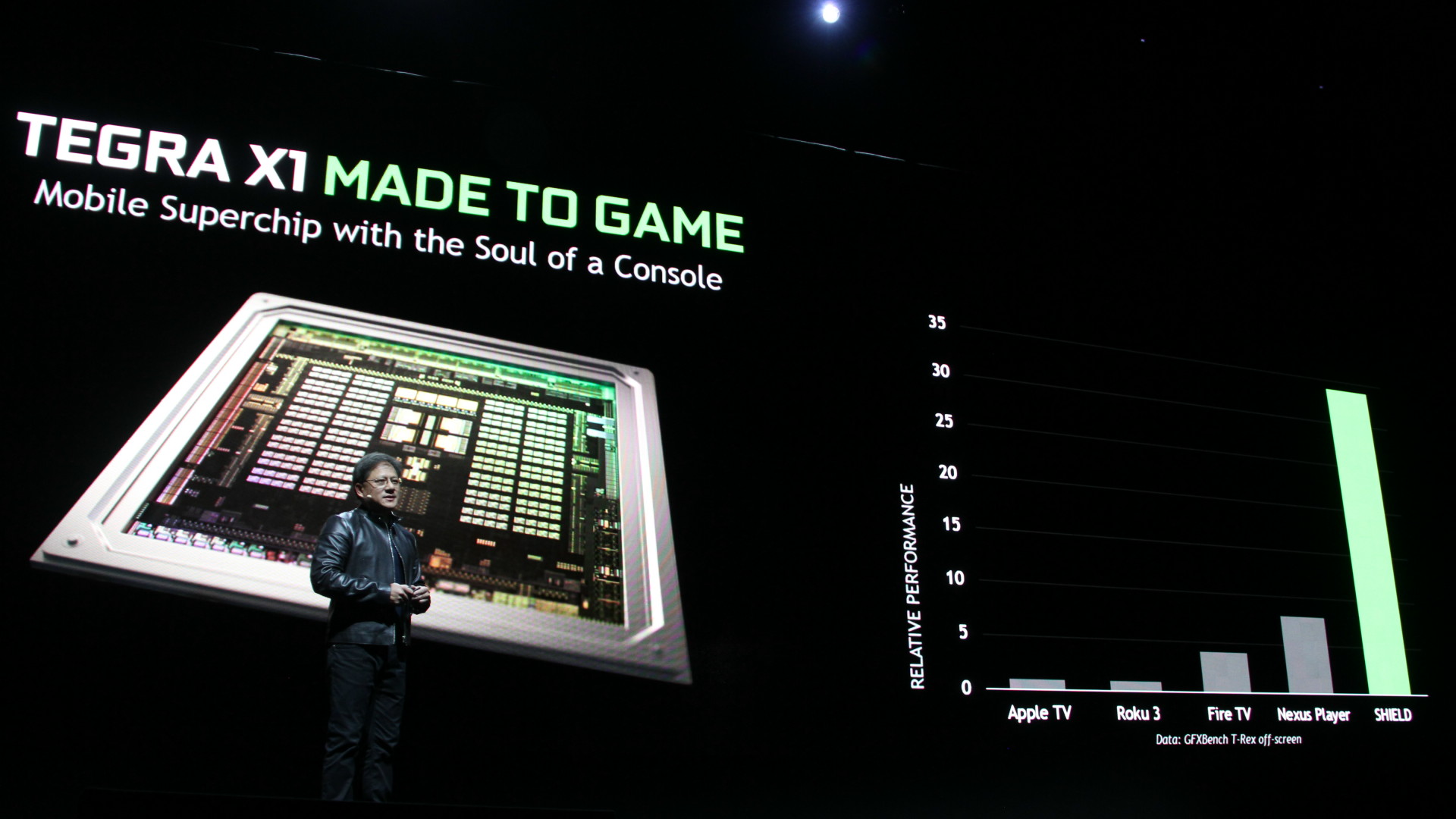

Nvidia organisait cette année l'une des plus grosses conférences de la GDC, intitulée Made to Game, à travers laquelle le spécialiste du GPU a lancé une nouvelle console Shield, équipée en Tegra X1 et destinée à prendre place à côté de votre TV.

Après la console portable Shield et la tablette Shield, Nvidia prépare un nouveau produit fini grand public dans cette famille : la console Shield pour TV. C'est un projet qui trotte dans la tête de Nvidia depuis quelques temps déjà et l'expérience acquise sur les précédents produits Shield, la mise en production imminente des serveurs GRID, l'arrivée du Tegra X1 et surtout de l'écosystème Android TV ont fait que tous les éléments étaient en place pour une première tentative de percer ce marché.

La Shield (à ne pas confondre avec les autres Shield!), est une set top box Android TV orientée gaming. Elle repose bien évidemment sur le dernier SoC Nvidia, le Tegra X1, dont le GPU correspond pour rappel grosso modo à une demi GeForce GTX 750 sur PC. Niveau connectique, il y a 3 ports USB (dont un micro-USB), un connecteur gigabit ethernet, un port microSD (pour étendre les 16 Go internes) et une sortie HDMI 2.0, ainsi que du wifi 802.11ac 2x2 et du Bluetooth 4.1.

La box, plutôt bien finie, est livrée avec un contrôleur Shield, le même que celui proposé avec la tablette Shield. Une télécommande ainsi qu'un support pour le positionnement vertical seront vendus séparément.

Sur la partie vidéo-ludique, la Shield peut être utilisée pour profiter des jeux PC à travers le streaming et les serveurs GRID, ou directement des jeux Android, dont certains commencent à afficher une qualité graphique semblable à ce qui se faisait sur PC il n'y a pas si longtemps de cela. Lors de la conférence de Nvidia, Crytek a d'ailleurs fait une démonstration du portage de Crysis 3 plutôt convaincante, même si quelques compromis ont probablement été faits au niveau de la qualité graphique par rapport à la version PC.

La Shield est également une box prévue pour la 4K, avec la prise en charge du décodage des vidéos jusqu'en 60 Hz 30-bit. C'est un argument important pour Nvidia puisque l'arrivée du contenu 4K sur les plateformes de streaming demandera un équipement adapté et pourrait donc pousser les premiers utilisateurs vers la Shield.

Elle sera introduite fin mai aux Etats-Unis au tarif de 199$, et devrait arriver quelques temps après dans les autres régions, dont l'Europe et principalement les pays dans lesquels des serveurs GRID sont déjà implantés, ce qui est le cas de la France.

GDC: Mantle, Direct3D 12, l'œuf et la poule

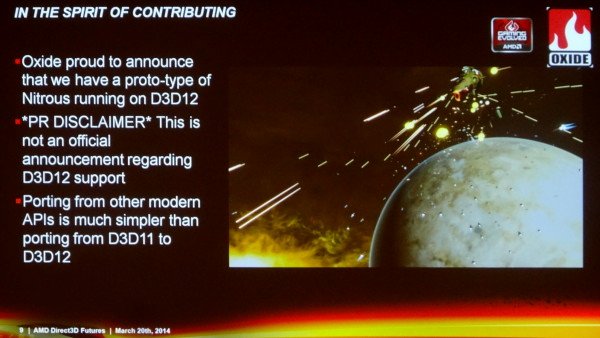

S'il y a bien un mot qui était tabou lors de toutes les sessions de la GDC consacrées à Direct3D 12, c'était Mantle. Microsoft, Nvidia et même AMD ont tout fait pour éviter de devoir mentionner cette autre API de bas niveau. Direct3D 12 est-il le résultat de la sortie de Mantle ? Voici ce qui nous semble être la meilleure actuelle théorie sur le sujet…

Durant la GDC, seul Oxide a osé un timide acte de rébellion en déclarant que "porter leur moteur depuis d'autres API modernes était plus simple que de porter de Direct3D 11 vers Direct3D 12". A chacune de ces sessions pourtant, la première question qui était posée était systématiquement la suivante : "comment se compare Direct3D 12 à Mantle ?". Eclats de rire assurés dans la salle mais aucune réponse en retour.

Nvidia, de son côté, explique travailler avec Microsoft sur DirectX 12 depuis plus de 4 ans et en collaboration rapprochée depuis un an. C'est sans aucun doute autant la réalité qu'un baratin énorme pour éviter d'admettre avoir été poussé dans cette direction par l'API Mantle d'AMD.

Microsoft travaille constamment avec ses partenaires au sujet de possibles évolutions de ses API. La machine ne s'arrête pas quand DirectX 11 sort, les discussions et autres phases de recherche continuent. Quand Nvidia indique travailler depuis plus de 4 ans avec Microsoft sur DirectX 12, cela veut simplement dire que Nvidia a poursuivi sa collaboration avec Microsoft au-delà de DirectX 11, comme tous les autres fabricants de GPU. Cela ne veut pas dire que Nvidia travaille depuis 4 ans sur le Direct3D 12 qui est présenté aujourd'hui.

Nous ne pensons pas que le fait que la démonstration de Microsoft d'un prototype de portage vers Direct3D 12 de Forza Motorsport ait été réalisée sur un GPU Nvidia, la GeForce GTX Titan Black, soit un élément significatif. Il est logique que Microsoft opte pour un GPU Nvidia pour mettre en avant l'aspect universel de sa solution. Une démonstration sur un GPU AMD aurait entraîné plus de liens vers Mantle et l'architecture d'AMD puisque le code de base de Forza Motorsport provient de la Xbox One équipée en GPU AMD.

Après de très nombreuses discussions avec tous les acteurs impliqués, à la GDC mais également auparavant, nous sommes convaincus que Mantle a été le déclencheur et l'accélérateur de la direction retenue pour Direct3D 12, quoi qu'en dise Nvidia. Cela ne veut pas dire que Direct3D 12 est un clone de Mantle, mais qu'il semble bel et bien avoir été bâti sur les mêmes bases ou tout du moins fortement tiré dans la même direction. Des bases qui impliquent de transférer une partie significative de la responsabilité des performances et des optimisations du pilote vers le moteur du jeu. Bien sûr, ce n'est pas un monde en noir et blanc, tout le pouvoir ne passe du pilote au moteur de jeu, les deux restent importants mais l'équilibre est modifié en faveur du second.

C'est selon nous la clé pour comprendre la position de chacun et la chronologie des évènements. Il ne faut pas être naïfs, AMD et Nvidia n'opèrent pas de virage important par pure conviction technologique, tous ces choix se font également avec une bonne dose de politique et de stratégie.

Pourquoi AMD a-t-il sorti Mantle ? Parce que Nvidia dispose de la meilleure équipe de développement des pilotes. Pourquoi Nvidia aurait-il été réticent jusqu'alors à faire évoluer Direct3D vers un niveau d'abstraction plus bas ? Parce que Nvidia dispose de la meilleure équipe de développement des pilotes.

Plus une API graphique est complexe, prend des chemins torturés et accuse un surcoût ou overhead élevé, plus les fabricants de GPU ont d'opportunités de se démarquer de la concurrence via leurs pilotes. Cela ne veut pas spécialement dire qu'AMD et Nvidia font ou ont fait volontairement en sorte de complexifier les API, mais que les simplifier et transférer une plus grosse part de la responsabilité de l'optimisation vers les développeurs pose des questions stratégiques importantes qui peuvent les inciter à trainer des pieds face à certaines évolutions.

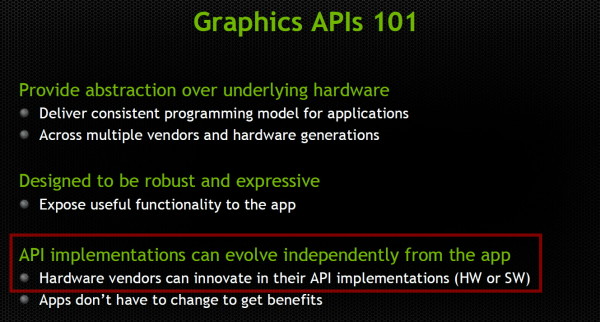

Les avantages d'une API de plus haut niveau, selon Nvidia.

Le travail important nécessaire pour obtenir des performances de premier plan, que ce soit globalement au niveau des pilotes ou spécifiquement au cas par cas pour chaque application, a permis à AMD et Nvidia de bénéficier de la sécurité d'un marché difficilement accessible à d'autres acteurs. Des sociétés telles que S3, Matrox, XGI etc. s'y sont cassé les dents, en partie pour cette raison. C'est également ce qui a permis à AMD et Nvidia de tenir Intel à l'écart.

Au cours de ses années les plus difficiles, AMD a dû se séparer de nombreux ingénieurs qui travaillaient sur ses pilotes alors même que Nvidia renforçait ses rangs. Même si AMD a récemment revu à la hausse ses investissements auprès du support des développeurs, il est évident que Nvidia dispose d'une force de frappe nettement plus importante sur le plan du développement des pilotes. AMD a probablement fini par prendre conscience du danger que cela pouvait représenter et revu sa stratégie en conséquence. Le réflexe qui pouvait être de trainer des pieds par rapport à un transfert de pouvoir des pilotes vers l'application n'avait plus lieu d'être. Au contraire, il a fini par devenir évident que pousser le marché dans cette direction serait utile pour la compétitivité de la société.

Pas facile cependant de convaincre tout le monde de bouger dans ce sens... Il nous semble évident que stratégiquement Nvidia n'avait au premier abord aucune raison d'abonder dans le sens d'AMD, et préférait opter pour d'autres approches de réduction du surcoût CPU, peut-être moins ambitieuses, qui lui auraient évité d'abandonner autant de contrôle sur les optimisations. Du côté de Microsoft il y avait probablement du pour et du contre, pas mal d'hésitation et d'avis contradictoires.

En développant et en concrétisant Mantle, avec le support de développeurs très enthousiastes, nous pouvons supposer qu'AMD a décidé de donner un coup de pied dans cette fourmilière. Le risque était limité. Dans le pire des cas, AMD pourrait bénéficier d'un mode spécifique dans quelques jeux, et dans le meilleur des cas, en profiter pour forcer la main des acteurs réticents de manière à pousser l'industrie dans une direction plus intéressante pour la société d'un point de vue compétitif.

De premiers résultats encourageants, l'engouement instantané de plusieurs développeurs pour les principes de Mantle (pas spécialement pour l'utilisation d'une API propriétaire !), la position délicate de la Xbox One, la menace de Steam OS, …, tout cela a mis en place une atmosphère qui a permis à tout le monde d'accepter d'aller vers un changement plus radical que certains ne le voulaient au départ pour Direct3D 12. Au final, avec Mantle, AMD a pu influencer significativement Direct3D 12, en plus d'apporter un bonus dans quelques jeux pour les utilisateurs de Radeon, ce qui est toujours bienvenu sur le plan commercial.

Sur la base de la même réflexion, nous pouvons supposer qu'OpenGL ES va évoluer rapidement vers une version à overhead réduit, alors qu'il sera beaucoup plus lent et difficile de faire évoluer OpenGL dont l'importance dans le monde professionnel en fait un élément stratégique crucial. Un responsable du développement d'un des moteurs de jeux majeurs nous a d'ailleurs confirmé qu'un tel OpenGL ES était déjà sur la table.

Nous pouvons par contre supposer que Nvidia sera extrêmement prudent par rapport à une évolution d'OpenGL qui pourrait impacter son très rentable marché professionnel. Même si la tendance va de plus en plus vers une exploitation de toute la puissance des GPU, de nombreuses applications professionnelles liées à la 3D restent fortement limitées par le CPU et les performances du pilote. Une caractéristique qui, comme vous pourrez l'imaginer, fait bien les affaires de Nvidia.

GDC: Nvidia met en avant son pilote Direct3D 11

Durant la GDC, Nvidia n'a pas seulement parlé de Direct3D 12 mais a également tenu à revenir sur le travail qui a été fait au niveau de son pilote Direct3D 11, de manière à réduire autant que possible le coût de la gestion des commandes de rendu. Nvidia estime qu'il disposait depuis longtemps d'un petit avantage sur ce point par rapport à la concurrence et l'annonce de Mantle l'a incité à aller plus loin dans ce sens.

Ses ingénieurs ont ainsi mis les bouchées doubles pour réduire le coût de plusieurs fonctions de Direct3D 11 mais également pour peaufiner l'implémentation des "deferred contexts". Pour rappel, ceux-ci permettent aux développeurs d'implémenter un support du multi-threading au niveau de la préparation des commandes de rendu. Malheureusement, ils sont peu efficaces et difficiles à implémenter compte tenu des interactions hors de contrôle entre l'application, l'API et les pilotes.

Nvidia a cependant estimé qu'il y avait moyen de mieux faire. Sa première implémentation des "deferred contexts" était très sommaire mais fonctionnelle et un peu plus performante que l'émulation proposée directement par l'API en cas de non intégration dans les pilotes comme cela serait le cas du côté d'AMD. Même si l'implémentation de Nvidia restait supérieure, ses résultats n'étaient pas très enthousiasmants pour les développeurs, ce qui explique la mauvaise réputation de cette fonctionnalité de Direct3D 11 auprès des développeurs. La deuxième implémentation de Nvidia serait par contre nettement plus efficace et rendrait la fonctionnalité enfin réellement bénéfique, si bien entendu les développeurs y font appel.

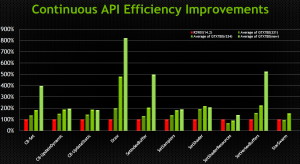

Nvidia nous a présenté quelques slides qui mettent en avant des gains observés en interne, autrement dit à prendre avec des pincettes même si la tendance affichée est probablement réaliste :

Ces slides comparent les pilotes Catalyst 14.2 aux pilotes r331, r334 ainsi qu'à une nouvelle version de ses pilotes qui ne devrait plus tarder à sortir (r336 ?). Suite à ces différentes évolutions, Nvidia met en avant des réductions du coût CPU de plusieurs fonctions de D3D11 de l'ordre de 2x, 4x, 5x, voire 8x dans le cas le plus favorable.

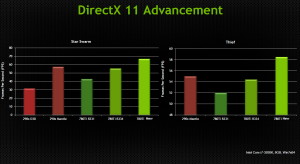

Avec ces gains associés à l'amélioration du support des "deferred contexts", Nvidia estime pouvoir même surpasser la solution d'AMD en version Mantle dans Star Swarm et Thief. Bien entendu il s'agit probablement ici de cas très favorables plus que de moyennes représentatives, mais force est de constater que Nvidia a entrepris un réel effort au niveau de ses pilotes Direct3D 11. Mantle aura décidemment été bénéfique pour tous !