Les derniers contenus liés aux tags Nvidia et CES 2013

CES: GeForce GT 730M et 710M : renommage

CES: Nvidia Tegra 4 et consommation

CES: Nvidia Shield : nos premières impressions

CES: Nvidia dévoile Shield, une console portable

CES: Nvidia dévoile le couple Tegra 4 / i500

CES: GeForce GT 730M et 710M : renommage

Tout comme AMD, et en l'absence de nouveaux produits, Nvidia débute un renommage de ses GPU mobiles pour accompagner l'arrivée des nouvelles gammes de portables. Il n'y a pas de réelle nouveauté, même si les fréquences semblent avoir été quelque peu adaptées.

Ce sont 2 premiers modèles qui passent de la série 600M à la série 700M. Notez que contrairement à ses autres produits, les spécifications exactes ne sont pas disponibles pour ces 2 modèles. Nvidia se contente de donner un "GeForce Performance Score" par rapport au HD 4000 d'Intel, ce qui ne veut pas dire grand-chose, d'autant plus les versions DDR3 et GDDR5 aux performances différentes ne sont pas différenciées. Si ce manque de transparence sur les spécifications de ces produit pose question, nous avons cependant pu observer les fréquences sur certains portables durant le CES.

La GeForce GT 645M DDR3, basée sur le GPU GK107, devient ainsi GeForce GT 730M DDR3. La fréquence GPU varie cependant quelque peu puisqu'elle passe de 710 MHz (780 MHz en turbo optionnel) à 725 MHz avec un turbo non exploité sur la nouvelle version du portable Gigabyte U2442 que nous avons observé. Un modèle GDDR5 est également au programme mais nous n'en connaissons pas les spécifications, puisque la fréquence GPU est en général inférieure à celle du modèle DDR3.

Ensuite, c'est la GeForce GT 620M, basée sur le GPU GF117 de la génération Fermi, qui deviendrait la GeForce 710M. D'autres modèles devraient compléter sous peu cette famille GeForce 700M.

CES: Nvidia Tegra 4 et consommation

Comme nous l'indiquions dans l'actualité consacrée à l'annonce de Tegra 4, Nvidia a évité de rentrer dans les détails concernant son architecture et l'aspect énergétique de son nouveau SoC. Nous avons bien entendu essayé d'en savoir mais les représentants de Nvidia nous ont indiqué que la communication technique autour de Tegra 4 n'était pas encore finalisée et que le temps n'était pas encore venu pour rentrer dans les détails quant à sa consommation. Face à la récente offensive d'Intel sur ce point, nous pouvons supposer que Nvidia préfère rester prudent.

Nvidia a cependant pu nous indiquer quelques généralités. Ainsi, comme nous le supposions, la consommation maximale de Tegra 4, typiquement avec un jeu qui sature ses cores CPU et son GPU, sera supérieure à celle de Tegra 3. Pas "énormément" supérieure mais "quelque peu" supérieure, la fabrication en 28nm ne pouvant pas faire de miracle face à l'augmentation significative de la complexité du SoC, notamment au niveau de son GPU. Nvidia a par contre apporté de nombreuses optimisations visant à gagner quelques milliwatts par-ci et par-là et dans la plupart des tâches classiques, au repos, en lecture vidéo, en navigation web, Tegra 4 serait significativement moins gourmand.

Nvidia nous a par ailleurs expliqué que même si, contrairement au procédé de fabrication 40nm de Tegra 3, le 28nm HPL de Tegra 4 ne permet plus d'utiliser deux technologies de transistors différentes sur un même die, l'utilisation d'un core compagnon permet toujours un gain de consommation significatif. Dans Tegra 4, ce 5ème core utilise le même type de transistors que les cores principaux, mais le fait qu'il ait été implémenté sur base des librairies basse consommation / basse fréquence d'ARM permet toujours un gain très important.

CES: Nvidia Shield : nos premières impressions

Entre deux conférences de presse, Nvidia nous a invité ce lundi à venir prendre en main sa console portable, annoncée la veille et actuellement baptisée projet Shield. La première chose frappante lors de la première prise en main est la proximité avec les contrôleurs de la Xbox 360, que nous utilisons régulièrement. Nvidia est toujours en train de finaliser les petits détails au niveau des contrôles, mais la similitude est frappante et permet dès le premier contact de trouver ses repères.

Il en va de même pour le poids de projet Shield, similaire à celui d'un gamepad Xbox 360 sans fil avec kit batterie. Le poids étant principalement distribué dans la partie gamepad, la présence d'un écran ne déséquilibre pas l'ensemble.

Le système embarqué étant un Android Jelly Bean classique, il n'y a rien de particulier à dire à son sujet, si ce n'est qu'il fonctionne comme prévu, comme sur un smartphone mais sans la partie téléphonie puisque projet Shield n'est pas équipé de modem.

Nous avons pu lancer autant des jeux Android que Windows. Les premiers sont exécutés nativement, comme sur n'importe quel smartphone mais profitent d'un "vrai" contrôleur ainsi que de la puissance de Tegra 4 pour les plus gourmands. Pour ces derniers jeux, Nvidia estime la durée d'utilisation de la batterie de sa console à environ 5h. Notez que Tegra 4 est ici intégré en version tablette, aux fréquences plus élévées que pour la version smartphone.

Une nouvelle version beta de GeForce Experience permet de streamer les jeux Windows vers la console projet Shield, une fonction dénommée GameStream. Le PC n'est alors plus accessible, en attendant l'arrivée d'une possibilité de virtualiser le GPU. Si quelques bugs sont encore à résoudre, Battlefield 3 refusait le streaming par exemple, le résultat était tout à fait satisfaisant avec le dernier Call of Duty. Dans ce mode, la batterie peut tenir environ 20h. Aucun problème de latence, que Nvidia indique être de l'ordre de 100ms (mesurée de l'action contrôleur à l'affichage, contre 150ms pour GRID - attention il ne s'agit pas de la latence réseau seule mais de la latence complète donc) ni d'artéfacts liés à la compression vidéo lors des déplacements rapides. Notez à ce sujet que la compression repose sur le h.264 high profile avec un débit de 10 mbits pour une résolution de 720p.

Il faut cependant préciser que cette résolution de 720p sur un écran de 5" que l'on observe à +/- 40cm de distance, lors de l'utilisation classique de cette console, ne permet pas de distinguer tous les détails de l'image et participe probablement à masquer des artéfacts qui pourraient être visibles sur une TV de grande taille. Car il sera également possible de n'utiliser Shield que comme contrôleur et de streamer la vidéo du jeu vers la TV soit en direct, soit en passant par Shield, ce qui ajoute environ 20ms de latence.

La densité de pixels de près de 300 DPI pose par ailleurs problème avec certains jeux PC, certains éléments de l'interface étant difficilement identifiables, notamment les textes. Si à l'avenir, les développeurs devraient prendre en compte des densités plus élevées pour leurs interfaces, il faudra que Nvidia trouve des solutions pour certains jeux actuels. Un écran de 6" en 720p, sans bandes noires sur le côté, aurait sans aucun doute été un peu plus confortable.

La console chauffe relativement peu, tout du moins sur la durée de notre essai. Pour cela, elle est équipée d'un radiateur et d'un petit ventilateur qui s'active dans les jeux les plus lourds. Nous n'avons pas pu l'entendre, mais nous avons pu sentir le léger flux d'air qui traversait alors la console. Lors de l'annonce de projet Shield, Nvidia avait insisté sur la qualité de ses petits haut-parleurs. Un point que nous pouvons confirmer puisque les hauts parleurs de type bass reflex donnent un résultat étonnant pour un périphérique de cette taille.

Au final, notre première impression est plutôt positive. La prise en main est intuitive et agréable, la qualité est au rendez-vous, bref cela fonctionne plutôt bien. Reste la question plus délicate du public visé. Le marché des consoles est relativement complexe et Nvidia prend un risque en s'y attaquant de la sorte et préfère d'ailleurs ne pas positionner Shield en tant que concurrent des consoles de Nintendo ou de Sony. D'une part parce que Shield repose sur un système ouvert (l'argument peut prêter à sourire venant de Nvidia) contrairement au système fermé des consoles traditionnelles qui disposent de jeux spécifiques. D'autre part compte tenu du lien et de la complémentarité avec le PC.

De notre côté, nous voyons deux types d'utilisateurs principaux pour Shield. D'un côté, celui qui joue sur un smartphone Android, apprécie réellement certains jeux et veut en profiter avec un système plus confortable pour le jeu. Reste qu'il faut réellement être accro à certains jeux pour acheter un périphérique qui leur serait dédié et il ne nous semble pas que des jeux de qualité suffisante et capables de profiter d'un contrôle autre que tactile existent déjà sous Android pour que ce soit le cas. Mais cela pourrait bien entendu changer dans les mois à venir.

L'autre utilisateur type est le joueur PC qui désire pouvoir continuer à jouer lorsqu'il doit s'éloigner de sa machine pour une raison ou pour une autre. Ainsi Shield permet de ne pas abandonner ses personnages favoris à leur sort lorsque respirer un peu d'air frais dans le jardin s'avère être une bonne idée, voire de remplacer la traditionnelle BD dans les lieux les plus intimes. La question du coût se pose également, mais compte tenu du succès relativement important des cartes graphiques haut de gamme, Nvidia peut supposer qu'avec une tarification raisonnable par rapport aux consoles portables, certains joueurs PC seront prêts à investir dans un tel périphérique.

Si ce premier essai s'avère concluant, Nvidia ne compte pas s'arrêter là et de nouvelles versions devraient progressivement voir le jour. Il semble ainsi évident qu'à terme un streaming via la 4G fera sens.

CES: Nvidia dévoile Shield, une console portable

Selon les rumeurs qui courent depuis quelques temps, les solutions de Nvidia n'auraient été retenues ni par Microsoft ni par Sony pour le GPU de leurs prochaines consoles. Pour éviter d'être exclu du salon et de tout un pan du monde du jeu vidéo, Nvidia a cependant mis les bouchées doubles pour proposer d'autres approches.

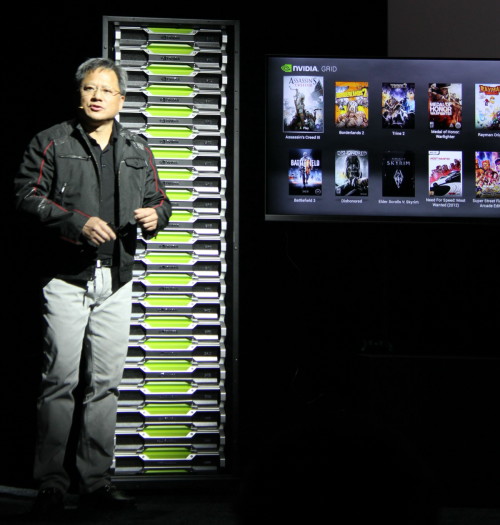

Tout d'abord, Nvidia a finalisé GRID (au départ appelé GeForce GRID), une plateforme de cloud gaming qui repose sur ses GPU. Le principe est simple : la TV est connectée au réseau et les commandes sont transférées à un serveur qui se charge du rendu puis renvoie les images sous forme de flux h.264. Toute la problématique de cette approche repose sur la qualité de l'encodage et la latence supplémentaire liée au passage par le réseau.

Grâce aux encodeurs vidéo présents dans les GPU et à une couche logicielle présentée comme très efficace, Nvidia estime avoir limité la latence à un niveau suffisant pour que GRID puisse réellement concurrencer les consoles. Un point qu'il faudra bien entendu vérifier en pratique et en conditions réelles, tout le monde n'ayant pas la possibilité de se connecter en Ethernet directement au serveur !

Si au départ Nvidia présentait GRID comme une plateforme qui serait proposée à différents partenaires qui pourraient développer leurs propres serveurs, il s'agit finalement d'un produit fini. Nvidia a ainsi décidé de concevoir en interne un serveur complet prêt à l'emploi et qui intègre pas moins de 240 GPUs. Etant donné la puissance de calcul affichée, 200 Teraflops, il s'agit probablement de GPU GK107 relativement modestes, comme ceux qui équipent les GeForce GTX 650 et GT 640. Nvidia précise que cela représente malgré tout la puissance de 700 Xbox 360.

Nvidia imagine par exemple convaincre les ISP de mettre en place des serveurs GRID pour pouvoir proposer un service jeu à leurs abonnés.

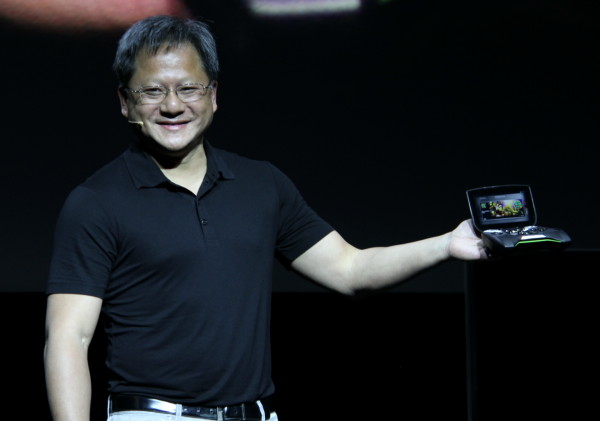

Ce n'est pas tout ! En plus de GRID, Nvidia travaille depuis quelques temps sur un autre projet, qui est resté secret jusqu'à ce jour : une console de jeu portable. Dénommée actuellement projet Shield, il s'agit d'un périphérique Android (Jelly Bean) dédié au jeu vidéo. Un smartphone intégré dans un gamepad en quelque sorte. Ou encore un mix entre un gamepad Microsoft et une Wii U, une image utilisée par Nvidia pour s'assurer de ne laisser aucune ambiguïté sur son intention de concurrencer les consoles traditionnelles.

Jen Hsun Huang, le CEO de Nvidia, dévoile le projet Shield.

Projet Shield repose bien évidemment sur le SoC Tegra 4 maison. Il est accompagné d'une batterie de 38 Wh, similaire à ce que l'on retrouve sur les tablettes, et dispose d'un écran multi-touch de 5" en 720p. Nvidia précise avoir soigné la qualité des éléments de contrôle ainsi que le système sonore et la connectique qui comprendra une sortie HDMI, un port micro-USB et un slot microSD. Enfin, un contrôleur wifi 802.11n 2x2 MIMO est de la partie.

Si Nvidia a opté pour un contrôleur wifi performant, c'est parce que la stratégie n'est pas simplement de supporter la bibliothèque de jeu Android compatibles avec Tegra 4. Tous les PC équipés d'une GeForce Kepler (à partir des GTX 650/660M) pourront ainsi à travers une future version du logiciel GeForce Experience, diffuser les jeux vers la console de Nvidia. Une connexion wifi performante du côté du PC sera bien entendu recommandée, et globalement le résultat sera proche de celui de GRID, sans le coût de l'abonnement.

Par ailleurs, Nvidia prévoit également la possibilité d'utiliser Shield comme contrôleur alors que le PC diffusera les images du jeu directement vers la TV, qui devra être équipée d'un adaptateur WiFi avec décodeur H.264. Reste qu'un PC de jeu et une TV étant par essence fixes, une liaison HDMI entre les deux en gardant Shield en tant que manette WiFi parait être une meilleure solution, il faudra voir si Nvidia le permettra.

Projet Shield devrait se concrétiser dans le courant du printemps. La tarification reste inconnue (300€ ?) tout comme la stratégie de distribution de Nvidia. En direct ? Via ses partenaires habituels ? Sera-t-il réellement possible pour Nvidia de se battre face aux grands noms de la console de jeu ? Face aux smartphones ?

Nvidia disposant pour sa présentation de plusieurs prototypes fonctionnels, nous supposons que nous pourrons les approcher de plus près durant le CES.

CES: Nvidia dévoile le couple Tegra 4 / i500

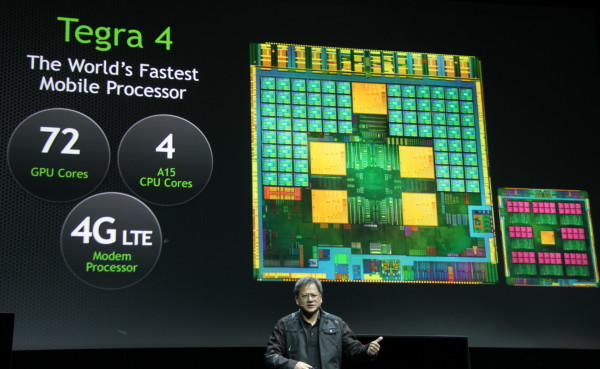

Comme prévu, Nvidia profite du CES 2013 pour dévoiler officiellement un nouveau SoC destiné au monde mobile : Tegra 4. Connu précédemment sous le nom de code Wayne, en référence au superhéros, il s'apprête à succéder au Tegra 3.

Nvidia reprend ici une structure similaire à celle de ce dernier mais profite d'une fabrication en 28 nanomètres, sur le process HPL de TSMC (optimisé pour réduire les courants de fuite et donc la consommation). L'utilisation de cette technologie plus avancée permet de pouvoir augmenter la complexité de la puce par rapport au 40nm de Tegra 3.

La base de Tegra 4 reste composée d'un CPU ARM quadcore, mais il évolue du Cortex A9 vers l'architecture Cortex A15 nettement plus performante et passe de 1.7 GHz à 1.9 GHz. Nvidia conserve l'architecture Variable SMP qui consiste à implémenter un cinquième core CPU optimisé pour une faible consommation, notamment à travers une fréquence réduite. En pratique ce core CPU supplémentaire est une doublure basse consommation d'un des 4 cores principaux qui rentre en scène dès que la charge CPU est faible.

Dans Tegra 3, ce cinquième core était implémenté via un type de transistors différents, mais cette possibilité n'existe pas sur le procédé de fabrication 28nm HPL de TSMC. Il est donc possible que son influence soit moindre sur Tegra 4, bien que Nvidia ne donne pas de détails à ce sujet.

Le die de Tegra 4. Ne cherchez pas à y trouver les secrets du SoC, il s'agit d'un montage photoshop créé pour faire ressortir visuellement ses spécifications principales.

Le GPU évolue également et passe de 12 à 72 cores, encore une fois sans précision au niveau des capacités exactes de ces cores, si ce n'est qu'il s'agit d'une architecture non-unifiée, c'est-à-dire qui se rapproche plus de l'architecture des GeForce 6800 que des GPU récents de la marque. Nvidia annonce un gain de 6x par rapport à Tegra 3 ce qui nous laisse penser qu'il s'agit de 24 unités de calcul pour le traitement de la géométrie et de 48 unités de calcul pour le traitement des pixels.

La conservation de ce type d'architecture GPU, similaire pour Tegra 2 et Tegra 3, est lié au fait qu'elle permet de réduire la consommation, notamment en réduisant la précision de calcul de la majorité des unités qui sont dédiées au calcul des pixels (20-bit au lieu de 32-bit). Nvidia semble ainsi faire le choix de la puissance brute plutôt que des fonctionnalités graphiques avancées.

Pour alimenter le Tegra 4, le contrôleur mémoire de Nvidia passe enfin au double canal et supporte la LPDDR3 alors que le Tegra 3 devait se contenter de LPDDR2 (ou de DDR3 basse tension) en simple canal.

Le moteur vidéo évolue pour passer en version VP8. Il supporte l'encodage et le décodage en 1440p et le h.264 high profile. Le moteur d'affichage de son côté peut piloter des résolutions jusqu'au 4Kx2K ainsi que le 1080p 120 Hz grâce au support du HDMI 1.4b.

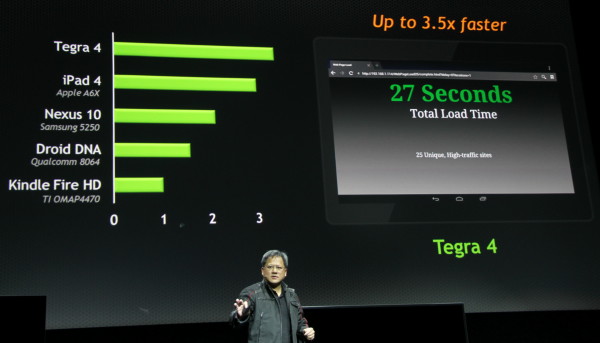

Pour mettre en avant les performances de Tegra 4, Nvidia l'a comparé au SoC Exynos 5 de Samsung intégré dans une Nexus 10, un SoC plus modeste qui se contente de 2 cores Cortex A15 à 1.7 GHz. Le test représentait le chargement/rendu de 25 pages web stockées sur un serveur local et comme vous vous en doutez, le Tegra 4 était presque 2x plus rapide. Il faut par contre préciser que les navigateurs n'étaient pas les mêmes, ce qui peut avoir une grande influence dans ce type de test...

Pour exploiter cette puissance de calcul, Nvidia a mis en avant 2 autres exemples. Tout d'abord les jeux vidéo, qui ne demandent qu'à exploiter toute la puissance disponible, ne serait-ce que pour s'adapter à la résolution grandissante des smartphones et tablettes.

Ensuite Nvidia a pris longuement en exemple le cas des photos HDR qui peuvent profitent des 4 cores et du GPU pour être traitées et affichées presque instantanément. Par ailleurs, Nvidia a intégré directement le support du HDR dans le driver du processeur d'image et du capteur pour pouvoir faciliter son support par les applications et pour réduire le temps entre les clichés exploités pour créer l'image finale : Nvidia parle de 0.2s d'intervalle pour Tegra 4 contre 2s pour certains smartphones actuels. En pratique ce type d'évolution va se retrouver progressivement dans l'ensemble des solutions mobiles équipées de capteurs photos et n'a pas de lien réellement spécifique avec le Tegra 4 autre que le fait qu'elle profite de l'évolution de la puissance de calcul et qu'en terme de communication, Nvidia aimerait pouvoir en faire un élément différenciateur pour son dernier SoC.

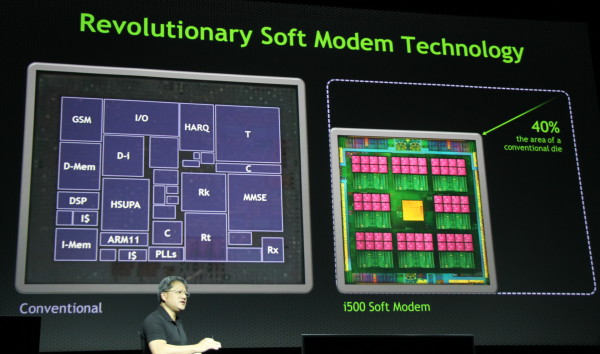

Notez que si le Tegra 4 n'intègre pas de modem, Nvidia propose optionnellement un modem 4G/LTE externe baptisé i500 et tiré du rachat d'Icera. Ce modem repose sur une architecture particulière qui fait la part belle aux unités programmables (il est annoncé avec 8 "cores") et laisse tomber les unités fixes. De quoi pouvoir supporter plus efficacement tous les standards et réduire considérablement la taille de la puce : -40% par rapport à une solution conventionnelle selon Nvidia.

Reste un point que Nvidia n'a pas abordé, que ce soit pour le Tegra 4 ou pour l'i500 : la consommation. Un point bien entendu primordial, et nous pouvons supposer que l'absence de communication à son sujet n'en fait pas le point fort de ces composants par rapport à leurs concurrents, certes moins puissants. Il faudra probablement attendre l'arrivée de produits finaux pour en savoir plus à ce sujet.