La GDC 2015 de San Francisco avec Hardware.fr

La GDC de San Francisco, Game Developers Conference, est le plus gros événement annuel dédié à l'univers du développement des jeux vidéo. Fabricants de processeurs graphiques ou de périphériques divers, fournisseurs d'API ou de middlewares et spécialistes de l'aspect business du jeu vidéo s'y retrouvent pour présenter leurs solutions.

Comme les années précédentes, nous avons fait le déplacement pour y suivre principalement les développements au niveau des API graphiques et du matériel PC.

GDC: Mantle a rempli son rôle et est réorienté par AMD

GDC: Nvidia GRID bientôt finalisé et payant

GDC: Nvidia annonce une console Shield pour Android TV

GDC: AMD mise sur la VR, annonce LiquidVR

GDC: Khronos annonce OpenCL 2.1

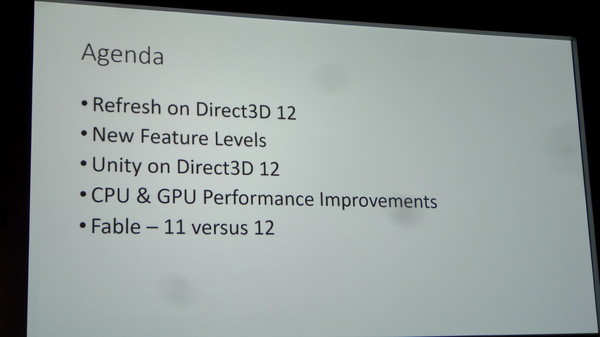

GDC: D3D12: Une guerre des specs en vue ?

Comme nous l'expliquions il y a peu, Microsoft a dévoilé à la GDC les 2 nouveaux niveaux de fonctionnalités de Direct3D 12 : 12_0 et 12_1. Mais d'autres segmentations plus subtiles existent, de quoi nous laisser penser que les départements communications d'AMD et de Nvidia pourraient se battre à coups de niveaux de support de DirectX 12.

De toute évidence, Microsoft avait demandé à AMD et Nvidia de ne pas lancer de polémique à la GDC sur le niveau de support des spécifications de Direct3D 12 de leurs GPU. Il n'y a ainsi eu aucune communication officielle à ce sujet mais nous avons pu gratter quelques détails lors de discussions informelles ou en posant des questions à la fin des différentes sessions.

Tout d'abord, nous pouvons confirmer que les GeForce Maxwell de seconde génération (GTX Titan X, 980, 970 et 960) supportent bien le niveau de fonctionnalité le plus élevé : 12_1. Il a de toute évidence été modelé d'après les spécifications de l'architecture de Nvidia. Nous ne savons par contre toujours pas s'il existe des GPU actuellement commercialisés de niveau 12_0.

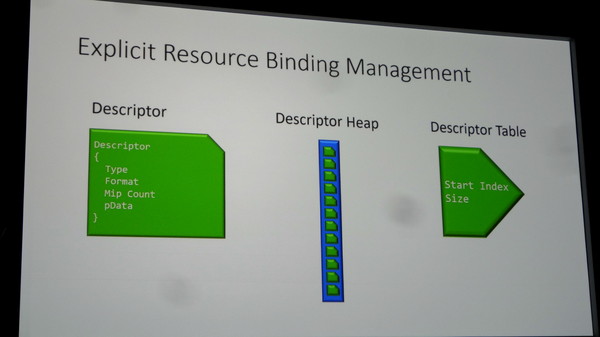

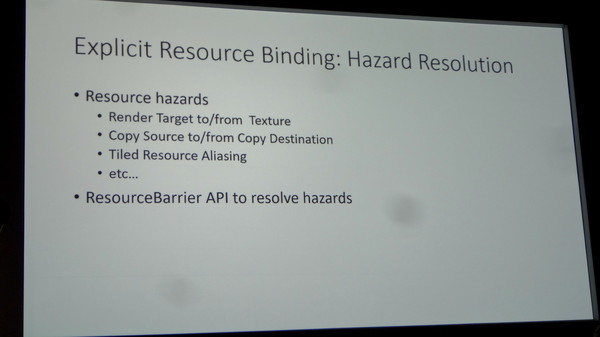

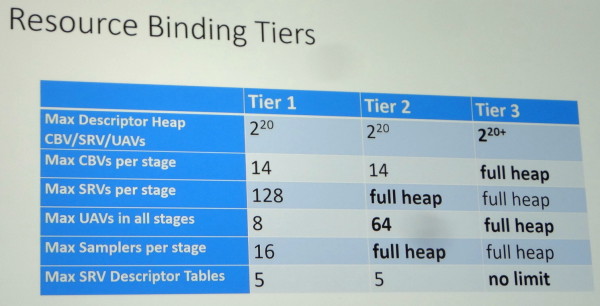

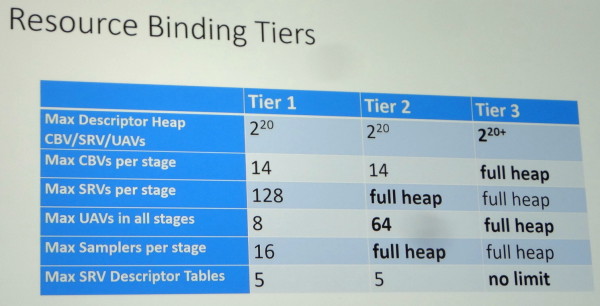

Cela ne veut pas dire pour autant que les dernières GeForce GTX supportent la totalité des possibilités de Direct3D 12. Ainsi, en plus des niveaux de fonctionnalités, des niveaux de support appelés Tiers existent pour différents points.

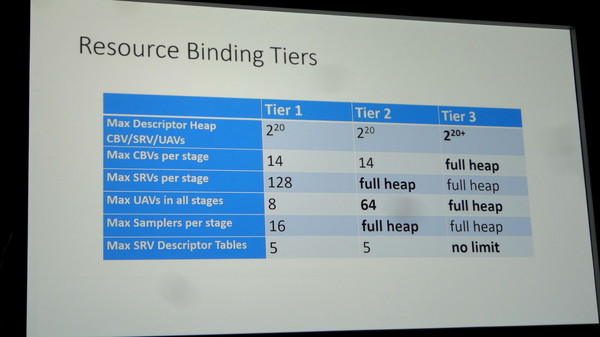

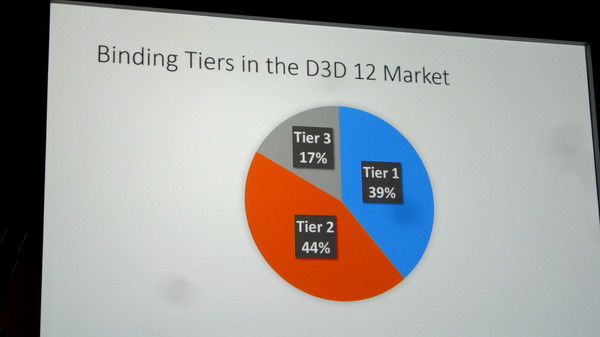

Le principal concerne les capacités de gestion des différentes ressources (Resource Binding) qui augmente en passant du Tier 1 au Tier 2 et atteint un niveau presqu'illimité au Tier 3. Microsoft a précisé que sur base des dernières statistiques de Steam, et en ne prenant en compte que le matériel compatible avec Direct3D 12, 39% du parc installé est limité au Tier 1, 44% au Tier 2 et 17% supporte le Tier 3. Mais quel GPU supporte quel Tier ?

Selon nos informations, les GPU Maxwell sont en fait limités au Tier 2, qui est nécessaire au support des niveaux 12_0 et 12_1 et qui a probablement lui aussi été modelé autour de leurs capacités. Une des différences les plus importantes avec le Tier 3 concerne la gestion des Constant Buffer Views (CBV) : ceux-ci ne sont pas virtualisés et sont limités en nombre à 14. Il est probable que l'architecture Maxwell soit capable de virtualiser les CBV, mais que l'implémentation logicielle/matérielle de Nvidia profite d'un mode plus performant avec une gestion "fixe" des Constant Buffers. Un compromis qui limite quelque peu la flexibilité accordée aux développeurs pour s'assurer que les GPU GeForce restent dans un mode optimal sur le plan des performances.

Mais alors à qui correspond les 17% de GPU compatibles Tier 3 ? Toujours selon nos informations, il s'agit des Radeon de type GCN qui profitent d'une architecture très flexible à ce niveau. D'un côté les GeForce GTX 900 supportent le niveau 12_1, d'un autre les Radeon R9 200 supportent le Resource Binding Tier 3. Un combat de spécifications en perspective ? Difficile pour AMD d'attaquer les GTX 900 sur base de cela pour l'instant… mais cela risque de changer avec Fiji. Si ce futur GPU supporte le niveau 12_1 et le Tier 3, nul doute que vous en entendrez parler ! Si par contre Fiji est limité au niveau 12_0 et Tier 3, chacun devra préparer ses arguments.

Au final, voici comment le support des Resource Binding Tiers est de toute évidence réparti sur PC :

Tier 1 : Nvidia Fermi, Intel Haswell et Broadwell

Tier 2 : Nvidia Kepler et Maxwell 1/2

Tier 3 : AMD GCN

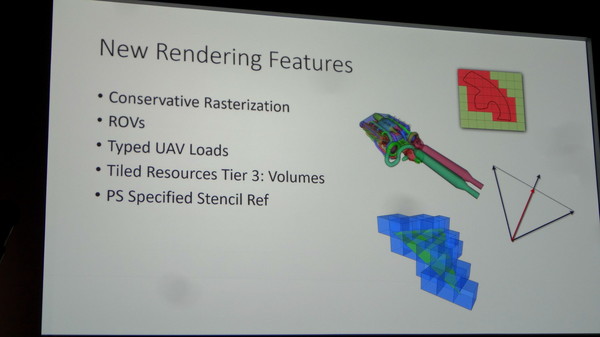

A noter que pour les fonctionnalités spécifiques au niveau 12_1, les Raster Ordered Views et la Conservative Rasterization, il existe également des Tiers 1 et 2 dont les spécificités nous sont pour l'heure inconnues. L'implémentation de Nvidia se limiterait au Tier 1 et il pourrait être possible là aussi pour AMD d'essayer de se démarquer. Affaire à suivre.

GDC: D3D12: Ashes of the Singularity et la BP mémoire

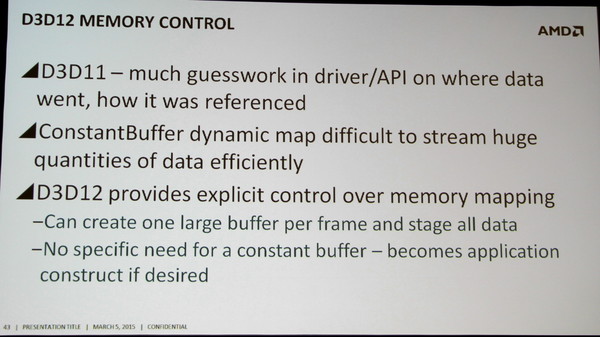

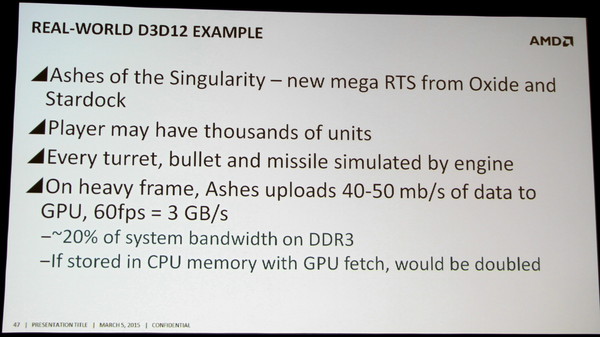

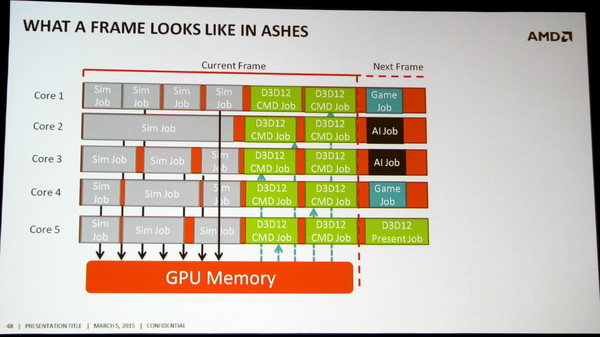

Ashes of the Singularity, développé par Oxide Games et Stardock fait partie des premiers jeux conçu pour exploiter les avantages d'une API de plus bas niveau. A la base du jeu, on retrouve le Nitrous Engine, qui a pour rappel été utilisé pour mettre en avant Mantle à travers la démonstration technologique Star Swarm.

Les développeurs d'Oxide Games expliquent que pour profiter des nouvelles API, et particulièrement de la possibilité d'exécuter un nombre bien plus élevé de commandes de rendu, c'est l'ensemble du moteur de jeu qui doit être adapté. Et il faut évidemment que le gameplay en profite. Dans Ashes of the Singularity, des milliers d'unités pourront ainsi être gérées par chaque joueur et affichées à l'écran.

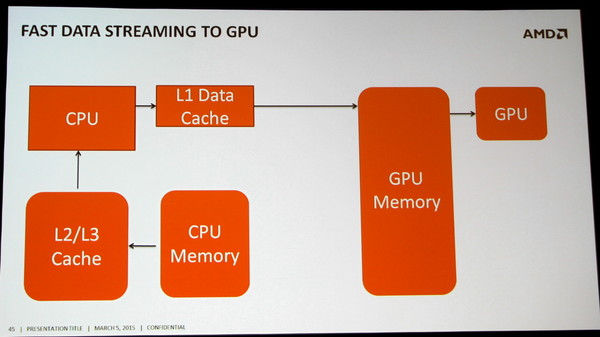

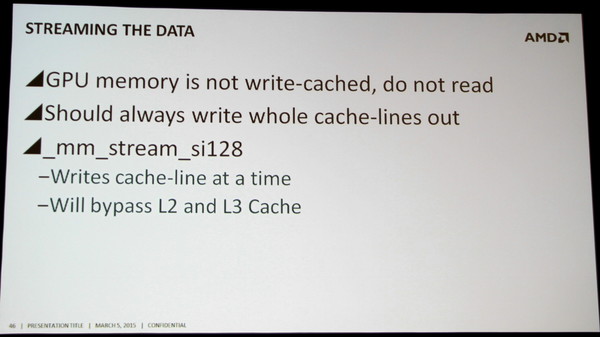

Cela représente une quantité énorme de données. Toutes ces unités et leurs projectiles sont simulés par le CPU et évidemment le résultat de ces simulations doit être transféré au GPU. Dans les scènes lourdes du jeu, il faut compter 40 à 50 Mo de données par image, soit 3 Go/s à 60 fps. Le bus PCI Express encaisse la charge sans trop de problème, mais c'est une partie importante de la bande passante de la mémoire système qui est ainsi monopolisée par cette seule tâche.

C'est un aspect qui a son importance pour les systèmes d'entrée de gamme, car peu importe si le jeu est rendu en basse résolution avec peu de détails, toutes ces informations devront quand même être transférée au GPU vu qu'elles font partie du gameplay. Et avec un GPU intégré, qui devra également lire ces mêmes données à partir de la mémoire centrale, c'est 6 Go/s qui seraient monopolisés. De quoi devenir une limitation potentielle aux performances.

Oxide Games rappelle ainsi que de nouveaux goulets d'étranglements pourront apparaître si les développeurs cherchent réellement à exploiter toutes les possibilités des API de bas niveau.

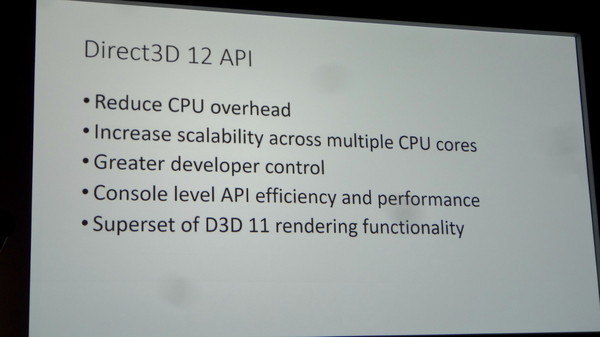

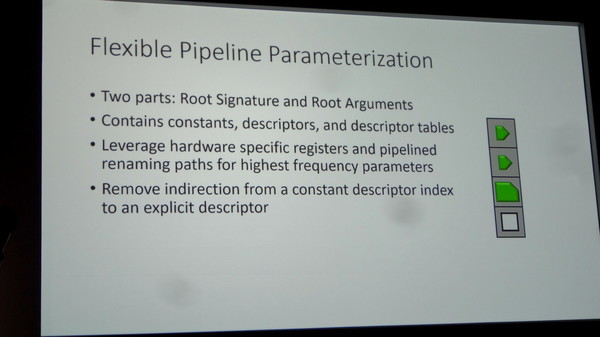

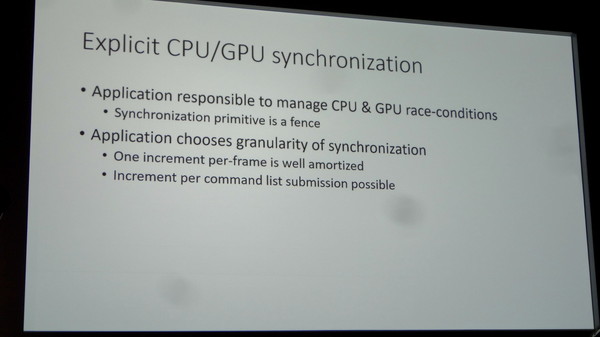

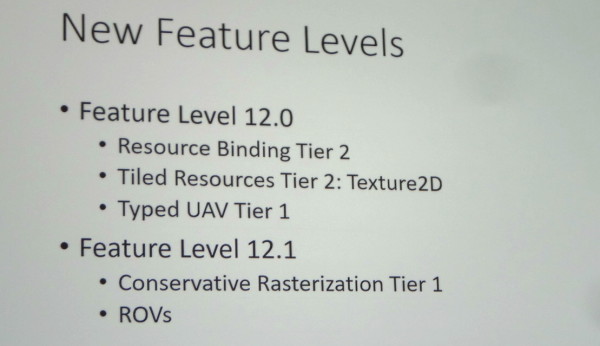

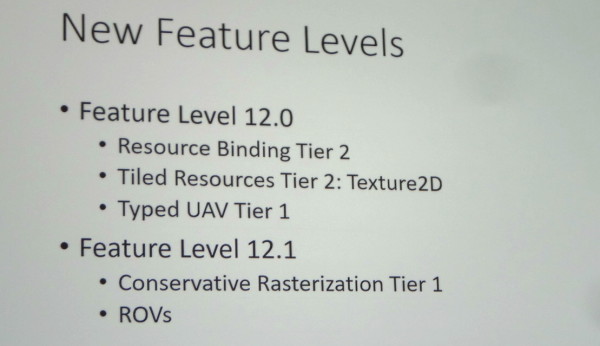

GDC: D3D12: des feature levels 12_0 et 12_1

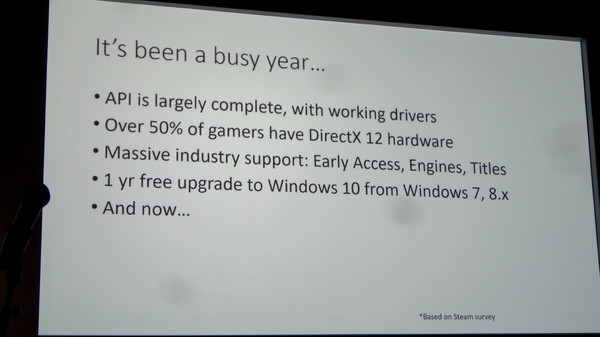

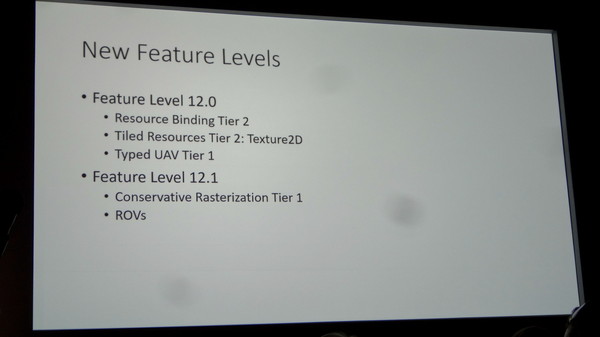

Microsoft a dévoilé cet après-midi l'organisation des feature levels, soit des nouveaux niveaux de fonctionnalités de Direct3D 12. Finalement ce seront 2 nouveaux niveaux qui vont être introduits : 12_0 et 12_1.

Le niveau 12_1 apporte spécifiquement le support des Raster Ordered Views et de la Conservative Rasterization. La première fonctionnalité permet de contrôler le respect de l'ordre de rendu des différents éléments de la scène, ce qui est par exemple nécessaire lorsqu'il y a plusieurs niveaux de transparence à respecter, et la seconde permet de vérifier si une primitive est présente dans n'importe quelle petite partie de la zone couverte par un pixel et pas simplement présente en son centre. De quoi pouvoir mieux évaluer sa couverture, ce qui est nécessaire pour certains algorithmes.

Nous vous avions déjà parlé de ces fonctionnalités lors du lancement de la GeForce GTX 980 et de Maxwell de seconde génération, ce qui implique que ces GPU Nvidia récents supporteront bien le niveau 12_1 en plus du 12_0.

Nous ne savons pas encore quels GPU supporteront le niveau 12_0, AMD ne nous ayant pas encore répondu par exemple. Il n'est pas impossible que certains GPU de génération DirectX 11 en soient capables. Rappelons qu'il sera bien entendu également possible d'exploiter à travers Direct3D 12 le matériel limité aux niveaux de fonctionnalités inférieurs, du moment que le GPU supporte une MMU (Memory Management Unit). Les niveaux 11_x seront ainsi exploitables pour la plupart des GPU de la génération DirectX 11 (pas avant GCN chez AMD).

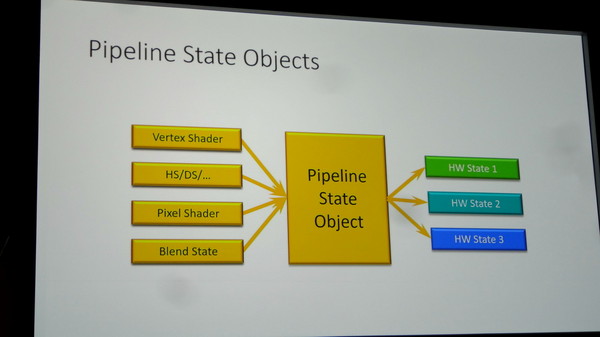

Une autre segmentation existera pour les GPU supportés avec 3 niveaux (Tiers) de capacités de gestion des différentes ressources (Resource Binding). Un GPU devra supporter au moins le Tier 2 pour pouvoir prétendre au niveau de fonctionnalité 12_0. Sans donner plus de détails, Microsoft indique que sur base des dernières statistiques de Steam, et en ne prenant en compte que le matériel compatible avec Direct3D 12, 39% du parc installé est limité au Tier 1, 44% au Tier 2 et 17% supporte le Tier 3. Des chiffres qui seront tirés vers le haut d'ici la sortie de Windows 10.

Nous avons pu poser quelques questions à Microsoft après la présentation et ainsi confirmer que ces niveaux de fonctionnalités 12_0 et 12_1 seront également exposés à travers Direct3D 11.3. Cette mise à jour pour Direct3D 11 ne sera par contre pas proposée en dehors de Windows 10. Microsoft tient d'ailleurs à insister à ce sujet sur le fait qu'un nouvel OS gratuit à la place d'une mise à jour de l'API n'est pas un mauvais deal pour les joueurs, ce qui n'est pas faux il est vrai.

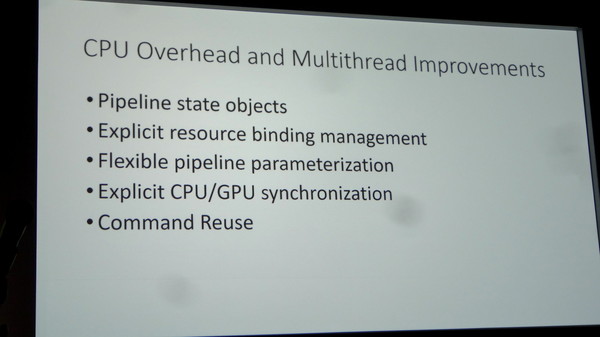

Enfin, au niveau des améliorations matérielles éventuelles à apporter pour parfaire le support de Direct3D 12, Microsoft nous a indiqué qu'un point inhabituel jusqu'ici était ressorti : les processeurs de commandes des GPU peuvent être saturés. C'est assez logique puisque Direct3D 12 permet d'augmenter fortement le nombre de commandes de rendu qu'ils doivent prendre en charge. Muscler ces processeurs de commandes pourra ainsi être bénéfique à l'avenir.

GDC: Le test D3D12 de Futuremark en démo chez Microsoft

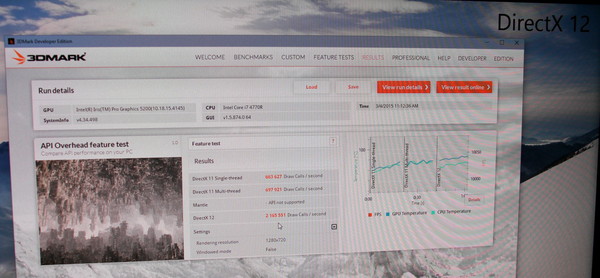

Sur le stand de Microsoft, nous avons pu apercevoir le premier test Direct3D 12 de Futuremark. Toujours en phase beta, il devrait être proposé en même temps que la sortie de Windows 10.

Il s'agit d'un test synthétique destiné uniquement à mesurer la capacité des systèmes à encaisser un nombre élevé de draw calls, soit d'objets dans la scène. Une sorte de ville futuriste est rendue avec une complexité qui augmente jusqu'à ce que le niveau de performances se stabilise autour de 30 fps. Plus le système est performant, plus le test dure longtemps.

Sur le stand de Microsoft, le benchmark tournait sur un CPU Intel Core i7 4770R dont le core graphique était chargé du rendu. Voici les performances relevées :

D3D11 Single Thread : 0.664 million de draw calls / seconde

D3D11 Multi Thread : 0.698 million de draw calls / seconde

D3D12 (Multi Thread) : 2.166 millions de draw calls / seconde

Dans ce test, le multi-threading sous D3D11, visiblement peu optimisé, n'apporte qu'un maigre gain de 5%, alors que D3D12 multiplie les performances par un facteur de plus de 3x.

Par ailleurs il faut noter que si la fréquence du GPU Intel est relativement faible en mode D3D11, elle grimpe en mode D3D12, signe que le GPU est soumis à une charge bien plus élevée. Il est donc possible qu'il devienne le facteur limitant et que les gains soient encore plus élevés dans ce test avec une GeForce ou une Radeon dédiée.

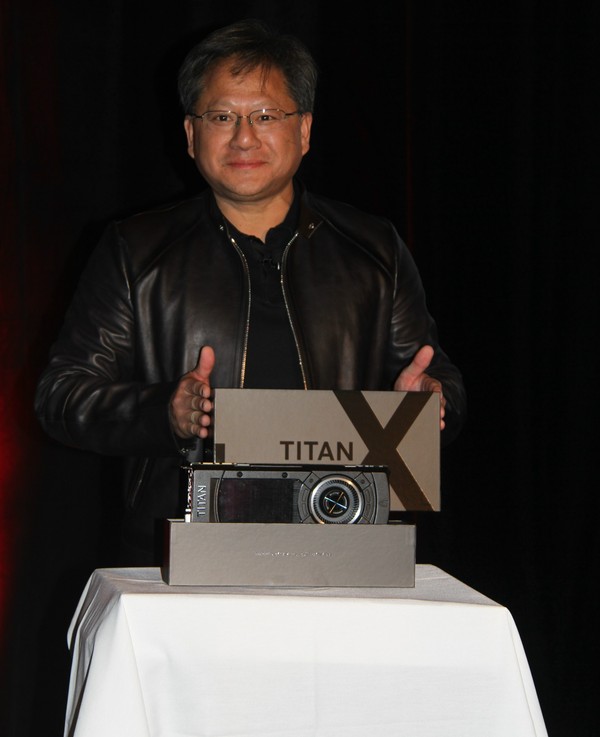

GDC: Nvidia dévoile la GTX Titan X 12 Go

Petite surprise ce matin à la GDC. Lors d'une session d'Epic dans laquelle Tim Sweeney revenait sur les récents développements autour de l'Unreal Engine et demandait des GPU plus performants pour permettre à la VR de prendre son envol, le CEO de Nvidia, Jen-Hsun Huang, a fait une apparition furtive pour y dévoiler une nouvelle GeForce ultra haut de gamme, la Titan X.

Ce n'est pas un secret, depuis quelques temps, un gros GPU Maxwell est attendu chez Nvidia, probablement dénommé GM200. Les détails exacts le concernant resteront encore confidentiels quelques jours. Tout au plus Jen-Hsun Huang aura précisé que le GPU embarque pas moins de 8 milliards de transistors, ce qui en fait un nouveau record, et que la GeForce GTX Titan X dispose de 12 Go de mémoire vidéo, ce qui pointe vers l'utilisation d'un bus 384-bit, un classique sur les gros GPU Nvidia.

La carte en elle-même reprend le design maintenant devenu habituel pour les GeForce haut de gamme même s'il y aura probablement quelques petites améliorations au niveau du bloc de refroidissement. Changement de style par contre puisque la couleur de la coque passe au noir.

Avec la GTX Titan X, Nvidia entend bien asseoir sa domination sur la concurrence mais il faut évidemment s'attendre à un tarif d'au moins 1000€.

Si Jen-Hsun n'a pas donné de date de lancement exacte, au vu de son discours, il semble évident qu'il aura lieu durant la GPU Technology Conference qui ouvrira ses portes le 17 mars, soit dans 2 petites semaines. En attendant, Tim Sweeney pourra profiter du premier exemplaire qui lui a été remis et dédicacé par le CEO de Nvidia.