Les derniers contenus liés au tag Volta

Afficher sous forme de : Titre | FluxNvidia dévoile le GV100: 15 Tflops, 900 Go/s

SK Hynix annonce sa GDDR6 pour GPU en 2018

Nvidia annonce le SoC Xavier avec GPU Volta

IBM Power9 et Nvidia Volta : 100+ petaFlops en 2017

GTC: Volta & Parker retardés, le 16nm TSMC responsable?

Microsoft annonce DirectX Raytracing

CES: Silence sur l'après Pascal chez Nvidia

Une Titan V en jeux, ça donne quoi ?

NVIDIA lance la Titan V, GV100 et 3000$

Nvidia préparerait son architecture Ampere

Microsoft annonce DirectX Raytracing

Microsoft a profité de l'ouverture de la GDC pour annoncer une nouvelle API, DirectX Raytracing (DXR) . Comme son nom l'indique, il s'agit d'une nouvelle API qui vient s'ajouter aux autres API DirectX pour standardiser l'utilisation de certaines techniques dites de raytracing. Le raytracing tente pour rappel de représenter de manière plus exacte le parcours de la lumière pour proposer des rendus réalistes. L'inconvénient de la technique étant son coût généralement prohibitif, même si des approximations existent.

A l'inverse, le rendu 3D dans les jeux actuel est basé sur la rasterisation, la projection d'une scène 3D en 2D avant d'y appliquer les traitements pour obtenir la couleur des pixels, avec des techniques plus ou moins avancées de gestion de lumière (les premiers jeux 3D se contentant d'imiter les effets de lumière en les dessinant directement dans les textures, tandis qu'aujourd'hui les pixel shaders s'appliquent sur l'image 2D ce qui limite les possibilités même si les développeurs sont extrêmement créatifs). Comme le rappelle le sous titre de l'annonce de Microsoft, "3D Graphics is a lie" (le rendu 3D est un mensonge) !

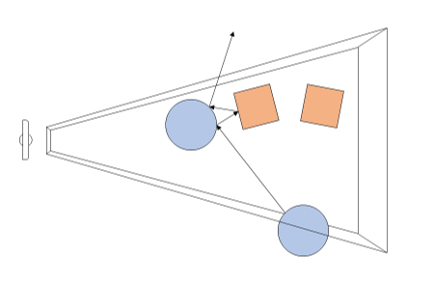

Avec DXR, Microsoft souhaite donc ajouter un peu de "réalisme" avec une petite dose de raytracing. Dans le détail, il s'agit d'une API complémentaire qui ajoute de nouvelles possibilités pour utiliser le raytracing par dessus les pipelines actuels de rasterisation. En pratique, DXR s'appuie sur une représentation de la géométrie pour lancer des rayons. Par dessus cette représentation, chaque objet ou groupe d'objet pourra définir des "raytracing shaders" et des textures spécifiques à utiliser. Une fois ceci crée, le lancé de rayons est appliqué, l'API définie les cas d'intersection, de non intersection, et de "presque" intersection (near miss), en gérant les cas ou les rayons rebondissent sur plusieurs surfaces (multi bounce).

Techniquement, le lancer de rayon est effectué a partir de la "caméra" dans la variante utilisée par DirectX, et peut se faire pour une sélection de pixels de l'écran ou la totalité (Microsoft prend l'exemple de ne le faire uniquement que pour les objets dont la surface est réfléchissante).

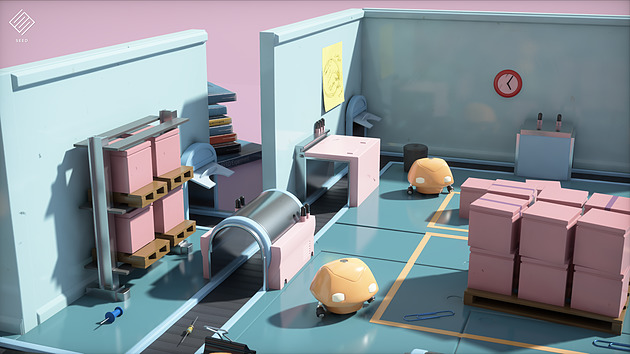

Un exemple de rendu DXR avec le moteur SEED d'EA, Project PICA

D'un point de vue compatibilité avec le matériel existant, Microsoft renvoi simplement vers les constructeurs pour les détails. Certains matériels sur le marché disposeraient déjà d'un support de DXR (on ne sait pas lesquels), et Microsoft semble proposer un mode de rendu alternatif s'appuyant sur Direct Compute pour fonctionner sur tout le matériel existant aujourd'hui (avec un niveau de performances on l'imagine réduit).

AMD nous a indiqué qu'ils collaboraient "étroitement" avec Microsoft "pour les aider à définir, améliorer et prendre en charge l'avenir de DirectX 12 et du ray tracing", un propos qui évite soigneusement de prononcer l'acronyme DXR. AMD dispose déjà d'une API de ce type utilisable sur de multiples plateformes avec Radeon Rays . Interrogé sur la question spécifique de l'accélération matérielle, AMD nous a indiqué qu'ils proposeraient, à un moment non défini, un pilote qui proposera une accélération DXR (au delà du mode "fallback" utilisant Direct Compute et qui lui marche sur tous les GPU, mais probablement en étant peu utilisable). Ce qui sera accéléré, et quelles cartes seront concernées n'est pas encore défini non plus selon le constructeur. On semble sentir une certaine précaution pour ne pas dire frilosité de la part de la société sur sa communication, il nous est difficile de savoir s'il s'agit d'un manque de préparation sur le sujet, d'un désaccord avec Microsoft sur certains choix effectués, ou d'autre chose.

Nvidia de son côté a évoqué son implémentation sous le nom de RTX, cette dernière ne s'appliquera qu'à compter des GPU Volta et ultérieurs (soit uniquement la Titan V dans les GPU "joueurs" actuels de la gamme du constructeur). Nvidia présente la technologie là aussi de manière assez vague, sous entendant que leur implémentation sera utilisable "via" DXR, mettant son API en avant sans que l'on sache si c'est simplement dans un but de démarcation compétitive ou autre chose. Là encore à l'image d'AMD, la communication des deux principaux constructeurs ne va pas exactement dans le même sens que celle de Microsoft (les relations entre Microsoft et les responsables GPU ont toujours été particulières, chacun tentant de tirer la couverture de son côté et de créer un avantage compétitif, que ce soit les constructeurs de GPU l'un face à l'autre, ou Microsoft à proposer une API et des fonctionnalités qui ne soient pas cross-platform).

Du côté des développeurs, Microsoft annonce que les moteurs Frostbite, SEED (plus haut), Unity et Unreal Engine proposeront une forme de support de DXR. Futuremark devrait également proposer un test de ce type pour une version de 3D Mark.

CES: Silence sur l'après Pascal chez Nvidia

Alors que le CES ouvrira ses portes officiellement dans quelques heures, les conférences de presse s'enchaînent. Celle de Nvidia (comme d'autres acteurs du monde PC, on le verra) était axée a peu près exclusivement sur les deux autres moteurs de croissance sur lesquels la société mise aujourd'hui : l'intelligence artificielle, et le marché automobile.

Bien peu de mots auront été prononcés au sujet du PC, si ce n'est peut être une bien vague allusion au fait que de "nouveaux produits gaming" seraient lancés cette année. Malheureusement, pas un mot n'a été prononcé par le CEO sur le lancement de l'après Pascal côté GeForce.

On suppose que la déclinaison gaming de Volta pourrait être lancée cette année, même si Nvidia n'est pas particulièrement pressé par la concurrence. La société qui plus est, est l'un des partenaires de TSMC sur le développement du 7nm. Elle pourrait être parmi les premières à proposer des produits sur ce node, possiblement vers la fin de l'année ou le début de l'année prochaine (la primauté allant toujours aux très gros volumes comme Apple, la production de gros GPU se faisant en prime toujours dans un second temps, afin de diminuer les coûts engendrés par les yields assez bas sur les puces larges en début de vie des process).

C'est au final par un communiqué de presse que Nvidia a tout de même annoncé quelques petites nouveautés pour les joueurs. La première concerne GeForce Experience, Nvidia rajoute une fonctionnalité baptisée "Freestyle" qui permet de rajouter, via l'overlay GFE, des filtres au rendu temps réel des jeux. De nombreux filtres (empilables) sont disponibles permettant de "styliser" ses jeux.

Si l'on peut y voir une sorte de gadget, il y a tout de même deux filtres qui pourront avoir leur intérêt. Le premier est un filtre permettant de modifier les couleurs des jeux pour les daltoniens et améliorer leur perception, quelque chose qui pourra être très utile. Le second est un filtre permettant de réduire l'intensité des "bleus", sous la forme d'un mode nuit réglable.

Techniquement, la fonctionnalité n'est pas universelle, elle est pour l'instant limité à certains titres DirectX 11 (une centaine selon le constructeur) qui doivent être whitelistés. Pour ce qui est du coût de ces effets, Nvidia nous a indiqué qu'il peut varier entre 2 et 7% de performances en fonction des filtres.

La seconde nouveauté annoncée est l'arrivée de "Big Format Gaming Display", des écrans 65 pouces 3440x1440 120 Hz compatibles G-Sync et incluant un Nvidia Shield. La proposition est surprenante pour ne pas dire autre chose, et trois partenaires sont annoncés : Asus, Acer et HP. Nous devrions pouvoir vous en dire plus dans les jours à venir.

Il nous est difficile cependant de ne pas y voir un parallèle avec l'arrivée du "Game Mode Variable Refresh Rate", le pendant de l'Adaptative Sync/Freesync intégré dans la norme HDMI 2.1 et que Nvidia ne s'est pas engagé jusqu'à aujourd'hui a supporter (contrairement à son concurrent).

Dernière nouvelle à noter, le service de streaming GeForce Now (toujours en beta) dispose désormais d'un client PC en plus de son client Mac. Le rendu côté serveur peut en prime se faire désormais jusque 120Hz pour certains titres, dans le but de réduire la latence (l'encodeur vidéo éjectant les frames supplémentaires).

Une Titan V en jeux, ça donne quoi ?

Nos confrères de PC Perspective ont pu mettre la main sur une Titan V et se sont amusés à voir ce que ce monstre à 3000$ pouvait donner en jeu.

Ça devient une habitude chez Nvidia, on note pour commencer que la carte va bien au-delà de sa fréquence annoncée à 1200-1455 MHz puisqu'elle démarre vers 1700 MHz avant de se stabiliser vers 1550-1600 MHz en charge. A 1700 MHz la consommation est au niveau du TDP soit 250W, quand la fréquence baisse car la limite de température de 84°C est atteinte on est à 210-220W.

En pratique la carte est clairement la plus véloce à ce jour pour le jeu, avec jusqu'à 38% de mieux qu'une Titan Xp sous Hellblade en 2560x1440 (29% en 3840x2160). Toujours sous ce même titre, on est à +55/41% face à une GTX 1080 Ti, +97/88% face à une 1080 et +103/77% face à une Vega 64 Liquid. Les gains sont plus limités sous Dirt Rally (+6% en 1440p et +15% en 2160p face à une Titan Xp) alors que Sniper Elite 4 semble dans la moyenne (+22% et +16%).

Bien entendu si on met en parallèle ces gains avec la débauche de transistors du GV100, 76% de plus qu'un GP102, les performances peuvent s'avérer un peu décevantes. Ce serait oublier qu'il intègre des unités dédiées au GPGPU non utile en jeu (double précision ou tensor cores) qui lui font prendre le large dans des usages spécifiques. Il ne fait pas vraiment de doute qu'un "GV102" offrira un meilleur rapport performance/milliards de transistors pour ce qui est du jeu.

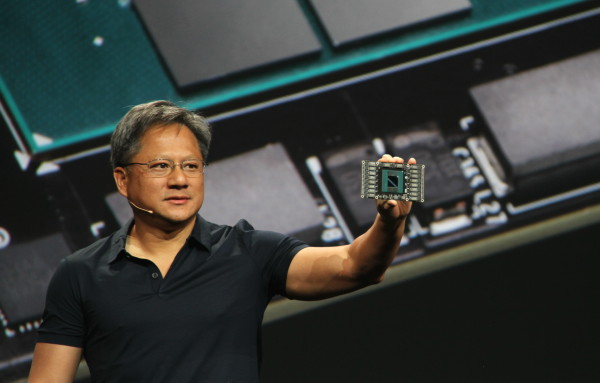

NVIDIA lance la Titan V, GV100 et 3000$

Nvidia vient d'annoncer la Titan V, première carte non-Tesla basée sur le GV100 annoncé en mai 2017. Ce monstre de 21,1 milliards de transistors gravés en 12nm FFN par TSMC est ici cadencé à 1200/1455 MHz pour une puissance maximale de 15 TFlops en FP32, contre 1370 MHz pour une Tesla V100. Comme sur les Tesla, 80 des 84 SM sont actifs soit 5120 unités de calculs et 320 unités de texturing là ou une Titan Xp et son GP102 en embarque 3840 et 240. Le nombre de ROPs du V100 n'est toujours pas connu.

Côté mémoire alors qu'une Tesla V100 embarque 16 Go de HBM 1.75 Gbps en 4096-bit, la Titan V se "contente" de 12 Go à 1.7 Gbps soit une bande passante de 653 Go/s au lieu de 900 Go/s. Le TDP est inchangé à 250 watts, la carte étant alimentée par deux connecteurs PCIe, un 8 broches et un 6 broches. Contrairement au Tesla on dispose de sorties graphiques, trois DisplayPort et une HDMI.

La carte reprend le design traditionnel des cartes Founders Edition de Nvidia si ce n'est qu'on a droit pour 3000$ au doré. A noter que l'association de deux cartes, qui requiert un ou deux ponts NVLink à 600$, n'est pas disponible sur Titan V.

A défaut d'être abordable et même peut être intéressante pour d'autres usages que le calcul, l'arrivée de la Titan V devrait permettre de voir l'architecture Volta à l'oeuvre dans d'autres domaines. Reste que l'arrivée d'une Titan basée sur un GV100 et non pas sur un "GV102" n'est pas forcément le signe d'une arrivée rapide de Volta sur des GPU plus grand public, ce qui serait regrettable !

Nvidia préparerait son architecture Ampere

Alors que Volta reste uniquement présent sur le marché du HPC avec le V100 annoncé à la GTC 2017, Nvidia devrait dévoiler selon nos confrères de Heise.de une nouvelle architecture dénommée Ampere - en référence à André-Marie Ampère - lors de sa GPU Technology Conference 2018 qui aura lieu fin mars.

Reste à voir ce que Nvidia annoncera donc réellement, notamment en ce qui concerne son planning. Ampere constituera-t-il la prochaine génération en 7nm, à attendre plutôt pour 2019 en attendant que Volta soit décliné en 2018, ou s'agit-il d'un intermédiaire prévu pour 2018 ?