Les contenus liés aux tags Nvidia et G-SYNC

AMD 'FreeSync': proposition pour le DP 1.2a

Durant le CES, AMD nous a surpris en dévoilant une alternative gratuite au G-Sync de Nvidia. Si de nombreuses questions restent en suspens, nous en savons aujourd'hui un peu plus : elle devrait passer par une nouvelle option intégrée au standard DisplayPort 1.2a actuel.

Pour rappel, en octobre dernier, Nvidia a dévoilé G-Sync, un mode d'affichage qui repose sur une fréquence de rafraîchissement variable (ou dynamique, ou encore non-isochrone, FRV) destinée à forcer l'écran à se synchroniser par rapport au GPU. L'intérêt est d'éviter les désagréments de la fréquence de rafraîchissement fixe traditionnelle : elle force le GPU, qui par nature ne produit pas les images à intervalle parfaitement régulier, à se contorsionner pour se synchroniser par rapport à l'écran, ce qui entraîne suivant les cas et le mode de V-Sync des cassures dans les images, des saccades et/ou une latence supplémentaire. Des désagréments que les joueurs PC doivent accepter depuis de nombreuses années, à moins de disposer de systèmes très puissants capables de maintenir en permanence un niveau de performances égal ou supérieur au taux de rafraîchissement de l'écran.

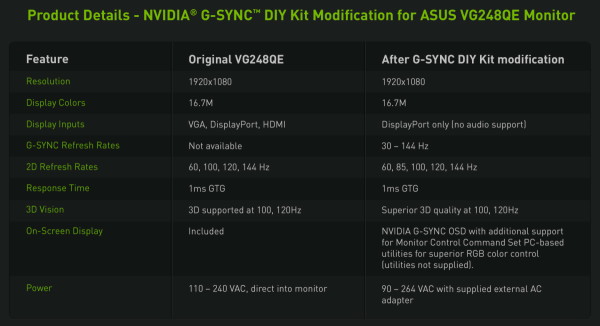

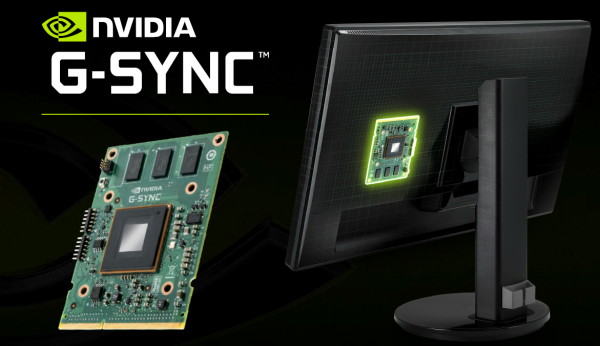

Pour pouvoir proposer ce mode d'affichage miracle, Nvidia a recours à un "module G-Sync", relativement onéreux, qui vient prendre la place des contrôleurs de dalles LCD tradionnels ("scalers"). Nous avons pu tester un écran compatible G-Sync et les résultats sont probants : aucune cassure dans les images et une fluidité qui progresse nettement quand les performances se situent entre 40 et 60 fps.

Durant le CES, soit 4 mois plus tard, AMD a enfin réagi en indiquant qu'un standard VESA (Video Electronics Standards Association) allait permettre de faire de même sans devoir passer par un module spécial. Une initiative surnommée "FreeSync" en référence au surcoût élevé de la solution de Nvidia, et directement mise en démonstration à travers Toshiba Satellite Click (2-in-1 13.3") pour lequel la fréquence de rafraîchissement variable a été activée.

Bien que très brève, cette démonstration a mis en avant un résultat identique à celui de G-Sync et pour cause, son fonctionnement est exactement le même : partir de la fréquence de rafraîchissement maximale de l'écran et moduler la durée du VBLANK (espace entre 2 images sur le signal vidéo) pour forcer l'écran à "patienter" le temps que le GPU lui propose une nouvelle image à afficher.

Une démonstration qui a soulevé de nombreuses questions. Comment est-ce possible de faire aussi bien que G-Sync sans module spécial ? A quoi sert ce module G-Sync ? De quel standard s'agit-il ? Quand est-ce que cela pourrait être disponible ? Pourquoi Nvidia fait-il mine d'ignorer qu'un standard est en approche ? … Tant AMD que Nvidia ont préféré éviter de répondre à des questions trop précises, le premier probablement parce que sa solution n'est pas encore prête, le second probablement pour éviter d'avoir à admettre ne pas nous avoir tout dit…

Nous avions en effet dès le départ posé de nombreuses questions aux responsables de Nvidia concernant G-Sync, et à nouveau au début du mois de décembre en préparant le test du premier écran compatible. La possibilité qu'il fonctionne sur base d'un standard actuel ou futur ? Son intégration dans les portables qui pourrait être plus simple via l'eDP ? Nvidia n'a jamais répondu clairement à ces questions, se contentant de tourner autour du pot et de laisser penser que rien de tout cela n'était à l'ordre du jour, mais que tout était possible dans l'avenir. Après la démonstration d'AMD, Nvidia n'était pas plus pressé de répondre à ces questions, mais a tenu à préciser que la gestion de l'affichage est différente sur un écran intégré dans un portable par rapport à un moniteur de bureau et que sa solution repose sur une technologie propriétaire pour laquelle des brevets ont été déposés.

Rappelons à ce niveau qu'un brevet déposé n'est pas un brevet accordé (cela prend du temps) et encore moins un brevet validé puisque cela n'intervient en pratique aux Etats-Unis que s'il est contesté. Si la fameuse mention "patent pending" est prévue pour prévenir des concurrents éventuels qu'ils risquent d'enfreindre un brevet, son utilisation est devenue courante, toutes industries confondues, pour renforcer la communication en termes de crédibilité, de sentiment de complexité, d'exclusivité, etc.

Le plus simple aurait bien entendu été que VESA clarifie la situation. AMD indique que pas mal de personnes qui prennent part à l'organisation ont fait de gros yeux quand ils ont vus Nvidia annoncer une technologie propriétaire de gestion de la fréquence de rafraichissement variable. En fait, cette fonctionnalité existe depuis 2008 dans le standard eDP 1.0 (DisplayPort interne) puisqu'elle peut permettre des économies d'énergie, par exemple en ne rafraîchissant pas l'affichage du bureau Windows quand rien ne bouge. Nvidia ne ferait donc qu'en profiter dans une situation différente.

Malheureusement, VESA se contente de répondre qu'il ne leur est pas possible de commenter officiellement le sujet et qu'une communication officielle aura lieu plus tard dans l'année. L'accès à toutes les documentations des standards VESA est par ailleurs restreint à ses seuls membres.

En l'absence de plus de détails de la part de Nvidia, d'AMD ou de VESA, nous avons heureusement pu compter sur un lecteur bien informé, que nous remercions, puisqu'il a eu accès à ces documents et a pu nous les communiquer.

Nous apprenons ainsi qu'une demande de type SCR (Specification Change Request) a été déposée de manière à intégrer le support optionnel de la fréquence de rafraîchissement variable au standard DisplayPort 1.2a. Compte tenu du nom du document daté du 25 novembre, DP1.2a Extend MSA Tmg Para AMD SCR, il semble évident que la proposition a été soumise par AMD. Elle est actuellement au stade GMR (General Member Review) est donc en bonne voie d'être finalisée et ratifiée.

Voici un extrait du document en question :

Summary

Extend the "MSA TIMING PARAMETER IGNORE" option to DisplayPort to enable source based control of the frame rate similar to embedded DisplayPort.

Intellectual property rights

N/A

Benefits as a result of changes

This enables the ability for external DisplayPort to take advantage of the option to ignore MSA timing parameter and have the sink slave to source timing to realize per frame dynamic refresh rate.

Assessment of the impact

The proposed change enable per frame dynamic refresh rate for single stream devices that expose dynamic refresh rate capability in EDID for DisplayPort interface. The source will be able to enable this with an SST interface or MST hub with physical ports. Logical MST port support of the feature is not included as part of this SCR. A generic framework to enable such feature for logical port is required that can accommodate other feature where stream related configuration is programmed in DPCD.

Analysis of the device software implication

SST device which support "MSA TIMING PARAMETER IGNORE" option will be able to expose the capability in EDID and DPCD to let source enable dynamic refresh rate.

Source driver would have to be updated to parse EDID and enable "MSA TIMING PARAMETER IGNORE" feature when source want the sink to be refreshed based on its update rate.

Analysis of the compliance test and interop implications

Currently this feature is tested as part of eDP CTS. New test would have to be added as part of DP LL CTS and EDID CTS.

D'ici quelques temps, les écrans DisplayPort 1.2a pourront donc, si les fabricants le désirent, supporter une fréquence de rafraîchissement variable. Pour cela, il faudra que la dalle LCD l'accepte ainsi que le contrôleur de l'écran. Durant le CES, AMD avait affirmé que certains moniteurs actuels seraient capables de supporter cette évolution avec une simple mise à jour de leur firmware, sans donner plus de détails. Nos questions à ce sujet sont restées lettres mortes et nous n'en savons donc pas plus, ni quand ces écrans actuels pourraient être mis à jour, ni quand de nouveaux modèles pourraient être commercialisés.

AMD nous a affirmé que le support de la fréquence de rafraîchissement variable était déjà intégré aux pilotes Catalyst récents mais qu'une interface pour en donner le contrôle aux joueurs était toujours en cours de développement. Même si les moniteurs compatibles FRV tardent à arriver, AMD devrait ainsi pouvoir proposer cette fonction rapidement sur certains portables, ce qui tombe d'ailleurs très bien puisque leur puissance graphique plus limitée fait qu'ils en auraient bien besoin pour proposer plus de confort aux joueurs.

Il est probable que Nvidia ait été le premier à réaliser l'intérêt que pourrait avoir la fréquence de rafraîchissement variable pour les joueurs. Friand de solutions propriétaires, Nvidia a cependant évité de soumettre son idée à VESA et opté pour le développement confidentiel d'un G-Sync limité à ses seules cartes graphiques. Une approche qui réduit immanquablement l'offre et empêche de généraliser son utilisation, même chez les utilisateurs de GeForce, mais qui a l'avantage de permettre de tirer des revenus supplémentaires de cette fonctionnalité, de se démarquer de la concurrence… et d'aller vite.

Ajouter une fonctionnalité à un standard VESA existant ou en cours de développement demande de prendre le temps qu'elle soit débattue par tous ses membres, validée et exploitée par l'industrie. Avec G-Sync, Nvidia a pu aller très vite, certes au prix d'un contrôleur écran émulé à l'aide d'un composant relativement cher. Ainsi, le module G-Sync est réellement utile à l'heure actuelle, car en attendant que des contrôleurs classiques supportent la FRV, que ce soit à travers un nouveau firmware, une nouvelle révision ou un nouveau modèle, c'est le seul moyen d'activer ce support sur les écrans de bureau.

Mais pourquoi Nvidia ne s'est-il pas contenté dans un premier temps de proposer G-Sync sur les portables, domaine où le lien eDP connecte la dalle au GPU d'une manière plus directe ? Sans surcoût ou revenu direct supplémentaire, cela aurait malgré tout apporté de la valeur à ses cartes graphiques mobiles. Le problème est que sur la majorité des portables équipés en GeForce, Nvidia n'est plus maître des sorties vidéos ! A travers la plateforme Optimus, toute cette partie est sous-traitée à l'IGP Intel. Ce dernier aurait donc dû collaborer à son support, or il a tout intérêt à préférer attendre un standard que favoriser une solution propriétaire de Nvidia.

Au final, vous l'aurez compris, aussi intéressante que soit la fréquence de rafraîchissement variable pour les joueurs, de nombreuses questions restent encore en suspens quant à sa généralisation éventuelle. Nvidia va-t-il supporter sa version standardisée dès qu'elle sera disponible ou tenter de forcer les joueurs à payer, en plus de leur carte graphique, la taxe d'une solution propriétaire ? Nvidia va-t-il arriver à s'entendre avec Intel pour l'arrivée de la FRV sur la plateforme Optimus ? Quand est-ce que des moniteurs DisplayPort 1.2a avec support de la FRV seront disponibles ? Si certains contrôleurs actuels acceptent la FRV via mise à jour de leur firmware, y aura-t-il des limitations telles que la désactivation de l'overdrive ?

En attendant d'en savoir plus, la technologie G-Sync de Nvidia doit être vue comme une manière d'accéder en primeur aux bénéfices du DisplayPort 1.2a + FRV, avec tout ce que cela implique : surcoût élevé et possibles limitations dans le futur en terme de compatibilité. Sans changer fondamentalement notre avis sur G-Sync tel que nous l'avions exprimé dans le test du premier écran compatible, avant d'apprendre l'arrivée d'une version standardisée, cela rend le surcoût plus difficile à accepter. Opter pour un des premiers écrans G-Sync en 1920x1080, les modèles de séries ne vont plus tarder, est difficilement justifiable s'ils s'accompagnent d'une surtaxe de 200€, de 150€ voire même de 100€.

Plus haut en gamme, par exemple sur le futur Asus RoG Swift PG278Q en 2560x1440 ou sur un éventuel moniteur UHD / 4K, notre avis est moins tranché. Il est plus difficile pour les cartes graphiques, même haut de gamme, de générer un affichage fluide dans cette résolution et dans les jeux gourmands. Nous pouvons donc comprendre que Nvidia se presse d'y apporter une solution d'autant plus que le tarif plus élevé de ces moniteurs, 800€ pour cet exemple, permet d'y intégrer plus facilement le surcoût actuel de G-Sync. Reste néanmoins à accepter de faire une croix sur toute possibilité d'évolution de son système vers une future carte graphique Radeon.

Le PG278Q d'Asus au CES.

Nous aurions bien entendu préféré que Nvidia se contente de lancer G-Sync tel qu'il existe aujourd'hui sur ce type d'écran, sans chercher à cacher le fait qu'il s'agit d'une version primeur d'un mode d'affichage qui est voué à être exploité par tous puisque basé sur le transfert d'une technologie qui existe déjà vers un autre type d'utilisation. Plus loin dans l'idéalisme il serait sans aucun doute bénéfique pour tous si Nvidia pouvait voir plus grand de temps en temps et viser des retours sur investissements indirects en transformant ses bonnes idées en propositions ouvertes, pour faire progresser l'écosystème PC, plutôt que de chercher une variante propriétaire à chaque technologie, dont la portée est mécaniquement plus limitée.

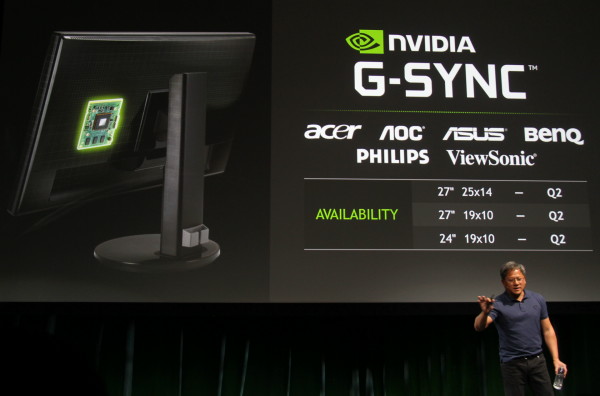

CES: Les écrans G-SYNC pour le printemps

Durant sa conférence du CES, Nvidia a précisé le timing de l'arrivée des premiers écrans G-SYNC de série. Ce sera finalement pour le printemps et devraient alors arriver des modèles chez Acer, AOC, Asus, Benq, Philips et Viewsonic. Nvidia mentionne par ailleurs qu'il y aura autant du 27" que du 24" en 1920x1080 mais surtout au moins un modèle 27" en 2560x1440, pour lequel G-SYNC devrait représenter le plus d'intérêt.

Nous n'en savons par contre toujours pas plus concernant le surcoût de l'intégration de la version de production du module G-SYNC, ni s'il utilisera les mêmes composants que sur les prototypes actuels. Nous estimons cependant probable que ce coût reste relativement élevé dans un premier temps.

Dossier : Nvidia G-SYNC en test : les jeux fluides dès 40 fps ?

Avec G-SYNC, Nvidia s'introduit dans les écrans pour leur permettre de mieux s'adapter au rythme des GPU. De quoi améliorer le confort de jeu sur PC en termes de fluidité, de latence et de qualité.

[+] Lire la suite

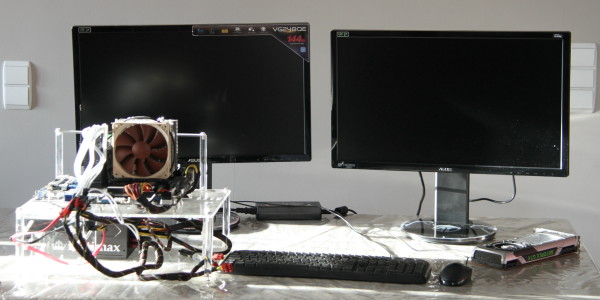

Nvidia G-SYNC : les tests sont en cours

C'est à partir d'aujourd'hui 15h que Nvidia autorise la publication des premières previews de la technologie G-SYNC qui avait été dévoilée il y a près de 2 mois. Pour rappel, à travers une synchronisation verticale variable, G-SYNC fluidifie l'affichage et se débarasse des défauts des modes V-sync ON/OFF. En attendant la disponibilité commerciale d'un premier écran Asus, Nvidia a modifié lui-même l'électronique du VG248QE de la même marque en y ajoutant son contrôleur qui prend en charge G-SYNC.

Malheureusement pour nous, suite à un cafouillage lors de l'envoi de l'écran, celui-ci nous est parvenu plus tard que prévu. A moins de bâcler les tests, il s'est avéré impossible de vous proposer un article dès aujourd'hui. Sauf mauvaise surprise, nous devrions pouvoir publier notre preview très bientôt.

Nous pouvons d'ores et déjà vous dire que nos premiers résultats sont tout simplement excellents, le confort de jeu évolue significativement lorsque les performances se trouvent sur la plage 40-60 fps. Nous avons observé un petit impact sur les performances, impact qui reste à évaluer plus précisément.

Comme nous l'avions indiqué précédemment, Nvidia a prévu un kit de modification pour le VG248QE d'Asus de manière à permettre l'arrivée accélérée de la technologie chez quelques premiers utilisateurs. Finalement, probablement pour des raisons liées à la garantie, ce kit ne sera pas commercialisé au détail mais proposé à certains grossistes/revendeurs qui pourront faire la modification eux-mêmes et ensuite vendre l'écran équipé du contrôleur G-SYNC. En Europe c'est l'anglais Scan qui a été retenu pour modifier les écrans et éventuellement les distribuer vers d'autres pays. Ce sera le cas en France à travers une poignée de revendeurs en ligne.

Alors que le VG248QE original est proposé à 300€, cette version G-SYNC devrait être commercialisée en France au tarif de 525€. Avec des volumes très limités il n'est pas impossible que les prix gonflent encore quelque peu. Pour des tarifs plus intéressants, il faudra probablement attendre l'arrivée de modèles de série prévue pour début 2014.

Nvidia G-SYNC: la v-sync enfin dynamique !

Au cours de sa seconde conférence, et après avoir tiré en longueur sur une utilisation tordue de la console Shield, Nvidia a dévoilé une technologie pour le moins intéressante que la société est parvenue à maintenir secrète durant son développement : G-SYNC. Oubliez les compromis de la synchronisation verticale activée / désactivée, l'approche de Nvidia offre le meilleur des deux mondes.

Pour rappel, lorsque la synchronisation verticale (v-sync) est activée, la fluidité est affectée dès que la carte graphique ou le reste du système ne parviennent pas à produire une image dans l'intervalle d'un rafraîchissement de l'écran. La même image doit alors être affichée deux fois, ce qui entraîne une saccade et augmente la latence d'affichage moyenne. C'est particulièrement un problème sur PC, plateforme hétérogène pour laquelle il n'est pas possible pour les développeurs de garantir un temps de rendu adapté à la v-sync.

Désactiver la synchronisation verticale permet d'éviter en partie ces problèmes mais au prix d'une cassure dans l'image affichée qui peut être très gênante (tearing). Par ailleurs, si la fluidité s'en trouve améliorée, elle n'est pas parfaite : puisque l'affichage est constitué de deux morceaux d'images successives (ou plus), la fluidité n'est pas identique sur la totalité de l'écran.

Plusieurs tentatives ont permis de mettre en place des compromis entre le jeu en v-sync ON et OFF, mais sans jamais proposer de solution parfaite. C'était le cas notamment chez Nvidia avec la synchronisation verticale adaptative, approche que certains développeurs utilisent par ailleurs d'une manière plus globale dans leurs moteurs.

Avec G-SYNC, Nvidia s'attaque à la source du problème : l'écran doit en principe être rafraîchi à une cadence fixe. Cette limitation pénalise le jeu PC depuis des années et G-SYNC la fait enfin voler en éclats à travers une synchronisation verticale dynamique. Si un écran n'est pas capable d'accepter un taux de rafraîchissement supérieur à une certaine valeur, rien ne l'empêche cependant d'être rafraîchi à une vitesse inférieure et rien ne l'empêche d'être rafraîchi à une vitesse variable. Fort de ce constat, Nvidia a développé une logique de contrôle de l'écran plus flexible et en combinaison avec un support logiciel adapté au niveau des pilotes, le GPU est capable de contrôler quand l'écran va être rafraîchi.

Typiquement cela revient à dire à l'écran d'oublier toute cadence et de se rafraîchir en synchronisation avec le GPU, soit dès que ce dernier a terminé le rendu d'une image et inverse ses buffers de rendu. L'affichage est alors direct et aucun délai ne doit être inséré. Une fenêtre d'action est définie pour que la technologie soit active, avec un délai de rafraîchissement minimal lié aux spécifications de l'écran (16.667 ms pour un écran 60 Hz) ainsi qu'un délai maximal qui semble tourner autour de 33ms (~30fps, ~30 Hz).

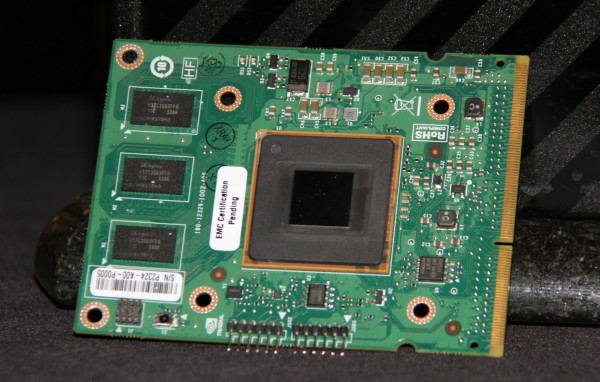

La carte contrôleur développée par Nvidia qui sera nécessaire au bon fonctionnement des premiers moniteurs G-SYNC.

Nvidia a développé des prototypes sur base d'un moniteur d'Asus, qui fait partie des partenaires principaux pour G-SYNC et qui devrait être le premier sur le marché. Ce moniteur 24" 1080p est équipé d'une dalle adaptée à un taux de rafraîchissement maximal de 144 Hz, ce qui correspond également à la limite actuelle de la partie contrôle de Nvidia. Une fois G-SYNC activé dans les pilotes, le taux de rafraîchissement effectif varie dynamiquement entre 30 ou 40 Hz et 144 Hz, Nvidia n'est pas très clair sur la limite basse.

La cadence d'affichage ne peut par contre pas correspondre parfaitement à la cadence d'avancement de la simulation du jeu par le moteur graphique, ce dernier n'étant pas capable de prédire le temps de rendu et donc le délai de rafraîchissement pour une image particulière. En pratique cependant, en moyenne l'erreur à ce niveau semble être relativement bien lissée et sur les quelques exemples que nous avons pu observer, aucune sensation étrange ne se faisait ressentir.

La sensation de fluidité avec G-SYNC activé est excellente dès 40 fps, alors qu'entre 40 et 60 fps elle est souvent très mauvaise avec v-sync et tout juste passable sans v-sync. Nvidia a développé une petite démonstration technique pour mettre en avant G-SYNC, mais nous avons également pu le vérifier en pratique sur la scène de Tomb Raider que nous avons l'habitude d'utiliser pour nos tests de fluidité. Entre 30 et 40 fps par contre, G-SYNC n'apporte plus réellement d'avantage significatif.

Pour vanter cette technologie de Nvidia, trois pointures du développement de moteurs graphiques ont fait le déplacement : Johan Andersson (DICE, Frostbite), John Carmack (id Software, id Tech) et Tim Sweeney (Epic, Unreal Engine). Ce n'est pas courant que ces développeurs soient réunis au même endroit et encore moins qu'ils parlent d'une seule voix. Tous trois approuvent sans équivoque l'arrivée d'une technologie telle que G-SYNC. En partie parce qu'elle améliore l'expérience de jeu sur PC, mais avant tout parce qu'elle apporte la promesse de faciliter leur travail.

Pour vanter les mérites de G-SYNC, Jen-Hsun Huang, le CEO de Nvidia, a accueilli la crème des développeurs de moteurs graphiques : Tim Sweeney, Johan Anderson et John Carmack.

Essayer d'avoir un temps de rendu plus ou moins constant représente un challenge important lors du développement d'un jeu et d'un moteur graphique, ce qui peut dans certains cas conduire à une limitation par le bas. Ne plus devoir s'en soucier, ou tout du moins pouvoir moins s'en soucier permet de pouvoir accepter des charges momentanément plus lourdes, par exemple un effet d'explosion qui va faire chuter les performances de 60 à 40 fps pendant quelques secondes. Sans G-SYNC, la fluidité est affectée, avec G-SYNC cela passe avec un impact mineur.

Reste bien entendu que G-SYNC sera limité, tout du moins au départ à une poignée de joueurs : il s'agit d'une technologie propriétaire qui sera introduite sur des écrans relativement haut de gamme. Comme le précise John Carmack sur ce point, fondamentalement, la technologie n'est pas si complexe et onéreuse que cela sur le plan matériel, ce qui devrait à terme lui permettre de se généraliser. Reste bien entendu à voir quelle sera la politique de Nvidia qui licenciera sa technologie aux fabricants de moniteurs.

G-SYNC fonctionne actuellement sur base du DisplayPort, mais Nvidia nous a indiqué que le DVI et le HDMI étaient possibles également avec des limites maximales de taux de rafraîchissement adaptées à leur bande passante. Le protocole utilisé par Nvidia sort probablement des spécifications des normes standards et il serait utile qu'un mode avec synchronisation verticale dynamique soit intégré à leurs prochaines évolutions, ce qui ouvrirait la porte à un support standardisé et généralisé. Dans l'immédiat, il sera obligatoire de passer par la carte contrôleur de Nvidia mais à terme tous les contrôleurs pourraient supporter une version standardisée de la technologie.

Dans tous les cas, G-SYNC se présente réellement comme une évolution majeure pour l'affichage des jeux PC, à tel point qu'il est impossible de ne pas se demander pourquoi il a fallu tant de temps pour qu'elle voit le jour. Les premiers moniteurs seront commercialisés au mois de janvier selon Nvidia et nous présumons que le concepteur de GPU s'efforcera d'avoir des systèmes en démonstration chez certains revendeurs tant il est nécessaire d'avoir l'écran en face de soi pour prendre la mesure du gain de confort au niveau de la fluidité.

Notez par ailleurs que l'affichage de plus d'images sur un écran qui peut monter jusqu'à 144 Hz peut également être bénéfique, la netteté étant mieux préservée lors de mouvements longs ou rapides. C'est le même principe que pour le passage de 24 à 48 Hz au cinéma ou l'interpolation effectuée par les TV modernes. Il pourrait d'ailleurs être intéressant que Nvidia mette en place une telle interpolation, qui pourrait être un compromis intéressant par rapport au calcul gourmand de toutes les images.

La réponse de Nvidia au gain de performances des Radeon dans la version Mantle de Battlefield 4 serait-elle simplement qu'avec G-SYNC, les GeForce n'ont pas besoin de ce gain de performances ?

Mise à jour 23h30: Nvidia vient de donner un petit peu plus de détails concernant le moniteur utilisé pour les démonstrations. Il s'agit d'un VG248QE d'Asus qui a été modifié. La bonne nouvelle c'est que Nvidia envisage, mais ce n'est pas encore confirmé, la commercialisation d'un kit de modification dédié à ce moniteur pour apporter le support de G-SYNC. Une carte contrôleur devra être remplacée ainsi que le système d'alimentation. Le tarif reste inconnu et bien entendu la garantie Asus sera invalidée par l'opération.