| |

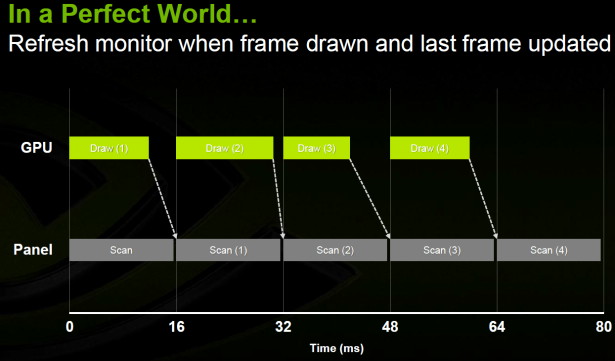

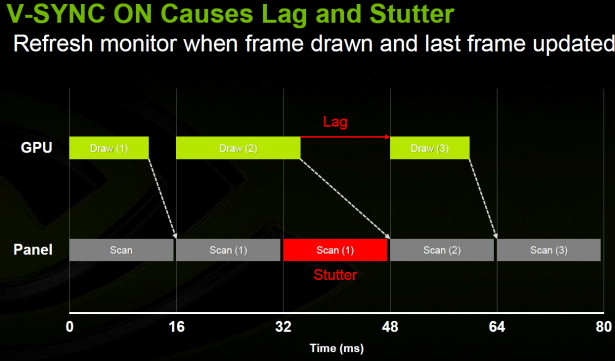

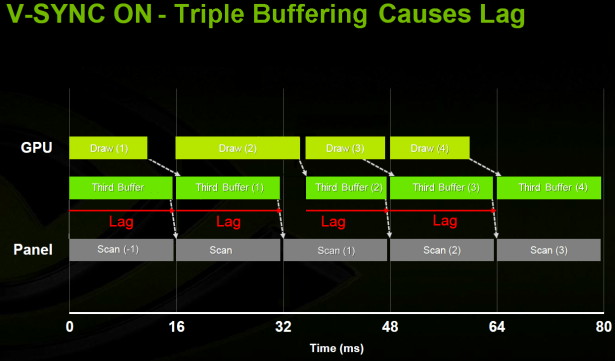

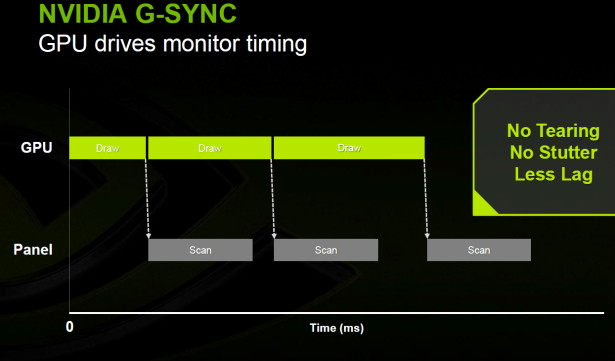

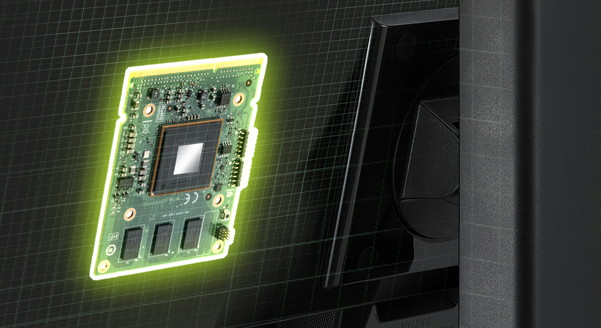

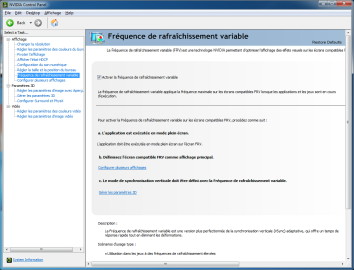

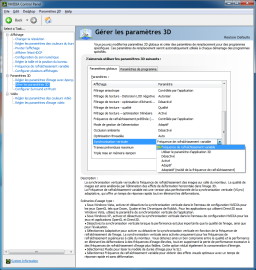

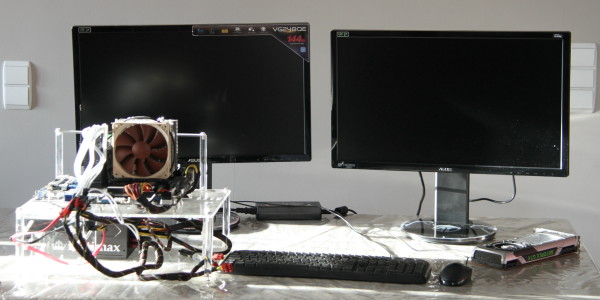

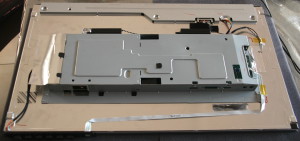

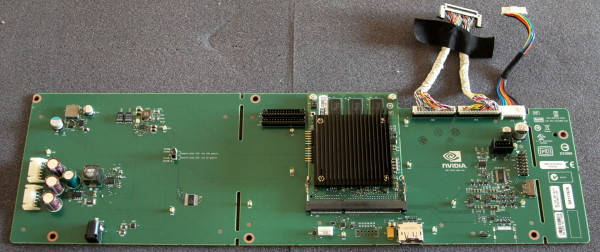

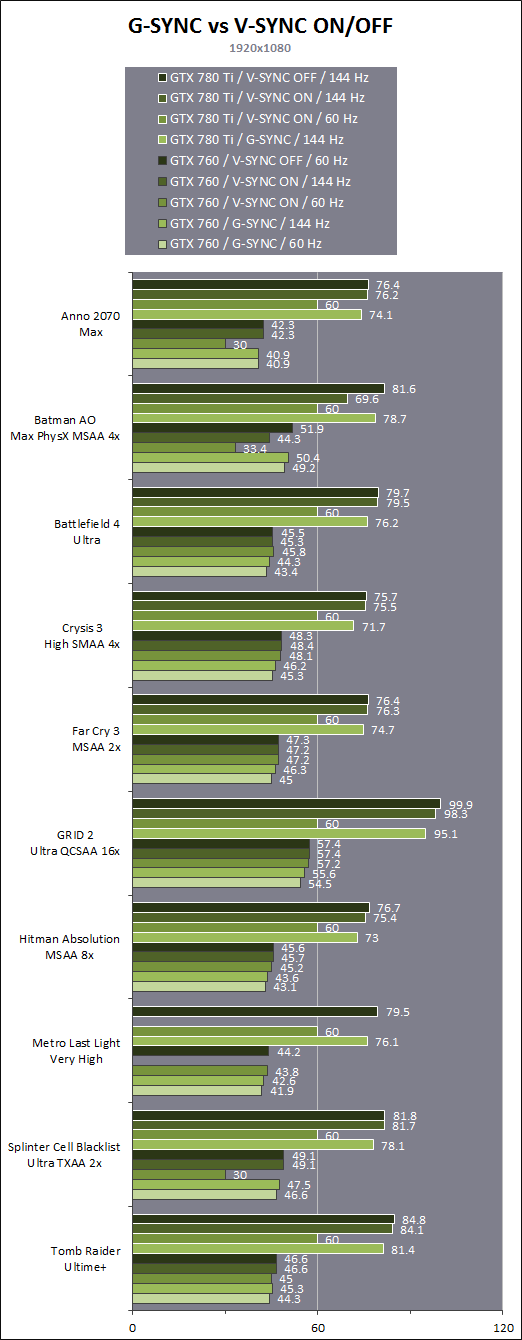

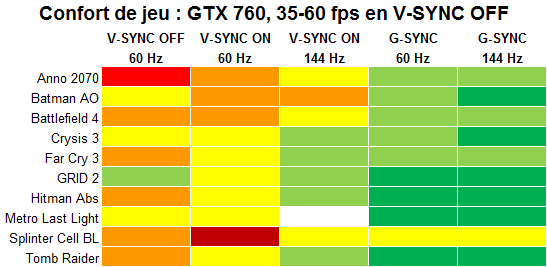

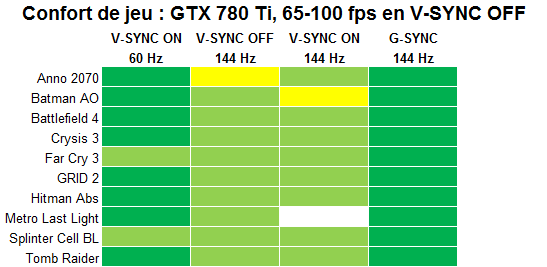

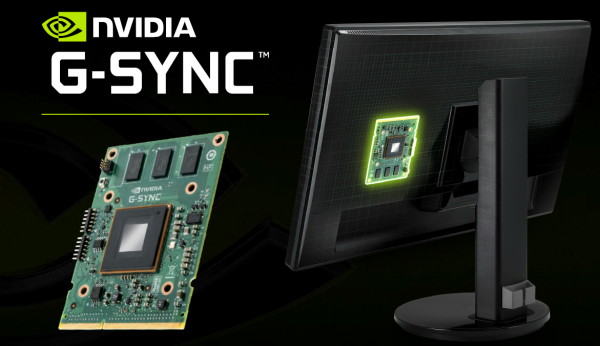

| Nvidia G-SYNC en test : les jeux fluides dès 40 fps ? Cartes Graphiques Publié le Lundi 30 Décembre 2013 par Damien Triolet URL: /articles/914-1/nvidia-g-sync-test-jeux-fluides-des-40-fps.html Page 1 - Introduction Avec G-SYNC, Nvidia s'attaque à nouveau à la problématique du confort de jeu sur PC avec la promesse d'améliorer fluidité, latence et qualité. Pour y parvenir le spécialiste du GPU se glisse dans les écrans pour leur permettre de se débarrasser d'une de leurs limitations : la fréquence de rafraîchissement fixe. De quoi apporter une vraie amélioration ?  Depuis quelques temps, Nvidia a décidé de s'attaquer au problème du confort et particulièrement de la fluidité ressentie par les joueurs PC, qui ne colle pas toujours aux chiffres de performances brutes. Différentes optimisations ont découlé de ces travaux et ont été introduites dans les pilotes, citons le frame metering qui consiste à s'assurer d'une cadence d'affichage aussi régulière que possible en multi-GPU ou encore le logiciel GeForce Experience qui aide le néophyte à configurer les options graphiques de ses jeux. Globalement, la stratégie de Nvidia est de faire en sorte que la plateforme PC, équipée en GeForce, soit à-même de profiter de toutes ses capacités graphiques pour offrir une expérience de jeu supérieure à celle des consoles. Au cours de ses recherches et phases de réflexion, Nvidia en est venu à la conclusion qu'il était temps d'essayer de venir à bout du vieux compromis de la synchronisation verticale fixe, vestige des écrans CRT, qui est restée au cœur des moteurs d'affichage en grande partie pour des raisons de rétrocompatibilité. Le balayage des tubes cathodiques imposait de nombreuses contraintes là où les technologies LCD et dérivées sont bien plus flexibles. Parmi les contraintes héritées des écrans CRT, nous retrouvons la fréquence de rafraîchissement fixe, source de bien des problèmes pour les GPU, forcés de jouer aux contorsionnistes pour s'y adapter. Soit ils se synchronisent avec l'écran, ce qui peut réduire les performances, entrainer des saccades importantes ou augmenter la latence, soit ils ignorent le rythme de l'écran et des défauts visuels apparaissent dans les images affichées avec dans certains cas quelques saccades également. En désactivant la synchronisation verticale, la plupart des joueurs voient dans cette seconde option un moindre mal. Quelle solution pour venir à bout de ces problèmes ? Le triple buffering ? Pas vraiment, il entraîne lui aussi son lot de désavantages. Voici ce qu'indiquait au printemps 2012 un célèbre développeur à ce sujet : La fluidité et la latence sont deux aspects importants pour John Carmack, d'autant plus depuis qu'il travaille sur le système Oculus Rift, très sensible sur ce point. Ce qu'il propose ici, le rafraîchissement non-isochrone de l'affichage, c'est en fait ce que Nvidia a décidé d'implémenter sous le nom de Fréquence de Rafraîchissement Variable (FRV) et sous la marque G-SYNC. Avec une fréquence de rafraichissement variable, c'est cette fois l'écran qui doit s'adapter au rythme du GPU, ce qui promet de se débarrasser d'une vieille contrainte pour offrir un meilleur compromis entre fluidité, saccades et latence d'affichage. Dès que le GPU a terminé de calculer une image, l'écran l'affiche, c'est aussi simple que cela. Ce n'est pas bien compliqué à implémenter, les moteurs d'affichage des GPU sont devenus très flexibles, mais encore fallait-il le faire et surtout pousser les écrans à évoluer eux aussi. C'est avant tout là qu'intervient Nvidia qui a décidé de prendre le taureau par les cornes et de développer le premier contrôleur pour écran capable de gérer cette fréquence de rafraîchissement variable. Page 2 - Rappel : CRT et LCD, VBLANK Avant de rentrer dans les détails de l'implémentation de G-SYNC et de vous présenter nos résultats, il est important de rappeler quelques bases au sujet du fonctionnement des écrans LCD, de la synchronisation verticale, du triple buffering, des fréquences de rafraîchissement élevées etc. Ecrans CRT et LCD, origine du VBLANKTraditionnellement, les écrans travaillent avec une fréquence de rafraîchissement fixe, par exemple 60 Hz. Cela signifie que l'écran va mettre à jour l'affichage 60 fois par seconde, soit toutes les 16.7 ms. La fréquence de rafraîchissement maximale supportée fait partie des caractéristiques techniques des écrans et peut également être de 50 Hz, de 75 Hz, de 85 Hz, de 100 Hz, de 120 Hz ou encore de 144 Hz. Avec les écrans CRT, plus la fréquence de rafraîchissement était élevée moins le balayage était visible puisque pour rappel, les différents points de l'écran étaient illuminés successivement et très brièvement mais avec une forte luminosité. Une faible fréquence de rafraîchissement donnait ainsi l'impression que l'écran clignotait. Ce n'est pas le cas des écrans LCD et assimilés pour lesquels l'image reste affichée durant la totalité du cycle, soit durant 16.7 ms à 60 Hz. Dernièrement des exceptions à cela sont apparues, certains écrans peuvent ainsi éteindre l'éclairage le temps de la mise à jour de l'affichage, pour réduire l'effet type "flou de mouvement" et compenser avec une luminosité plus élevée, mais cela se fait pour la totalité de l'écran et n'entraîne pas d'effet de type balayage. Cela ne veut pas dire pour autant qu'une fréquence de rafraîchissement élevée est inutile pour un écran LCD.  La fréquence de rafraîchissement des écrans CRT était limitée par la vitesse à laquelle les canons à électrons étaient capables de parcourir la surface de l'écran. Il fallait ajouter à cela l'intervalle vide horizontal et surtout l'intervalle vide vertical, soit le temps nécessaire pour que les aimants ramènent le flux d'électrons du bas de l'écran vers le dessus de l'écran en vue de commencer un nouveau cycle d'affichage. Ce paramètre est connu en anglais sous le nom de Vertical Blanking Interval, VBI ou encore VBLANK et est implémenté en ajoutant à l'image des lignes qui ne sont pas destinées à être affichées (par exemple 1125 lignes en tout pour une image 1080p). Alors que ce délai supplémentaire n'a aucun sens direct pour un LCD, il fait cependant toujours partie des standards récents, pour des raisons historiques mais également parce qu'au fil du temps il a été exploité pour diverses utilisations secondaires. De nos jours, la période de VBLANK sert à transférer des informations au système d'affichage, à inverser les buffers de rendu etc. La durée du VBLANK varie suivant les standards et sur PC, où son utilité est limitée, on utilise en général une durée aussi courte que possible pour maximiser la résolution à bande passante donnée. La plupart des problèmes d'affichage rencontrés avec et sans synchronisation verticale, que nous allons décrire par la suite, sont en fait liés directement à celle-ci, dont l'existence découle de l'utilisation d'une fréquence de rafraîchissement fixe. Le GPU doit s'adapter à l'écran. Mais est-ce bien nécessaire ? Ce mode de fonctionnement nous vient tout droit des écrans de type CRT et n'a pas évolué avec l'arrivée des écrans LCD, ni avec les nouvelles interfaces vidéos telles que le DVI, le HDMI et le DisplayPort. Ces dernières, exclusivement exploitées sur des écrans LCD et apparentés, conservent en leur cœur les vestiges des limitations des écrans CRT. Ceci s'explique par des évolutions qui ont été progressives, sans aucune réelle remise à plat de la gestion des systèmes d'affichages. Comme nous l'expliquions précédemment, c'est le cas du VBLANK mais plus fondamentalement, il se trouve que la fréquence de rafraîchissement fixe des écrans LCD n'est pas une nécessité technique non plus. S'il s'agit là aussi d'une caractéristique héritée, transmisse de génération en génération, elle a par contre une utilité directe puisqu'il est logique de vouloir rechercher de la régularité dans l'affichage des images. Dans le cas des jeux vidéo, particulièrement sur PC, il se trouve cependant que la source qui génère les images n'est par nature pas régulière et vouloir forcer un tel flux non régulier sur une cadence d'affichage fixe est source de problèmes. Les écrans LCD sont limités principalement par leur temps de réponse qui caractérise le délai de transition de leurs pixels d'une couleur à une autre. Ce temps de réponse n'est pas lié au taux de rafraîchissement, mais participe à en définir la limite maximale. Rien ne sert en effet de passer plus rapidement d'une image à l'autre si les pixels n'ont déjà pas le temps d'être modifiés. Les premiers écrans LCD, bien qu'utilisés en 60 Hz, souffraient par exemple d'un temps de réponse de 50 ms, qui entraînait un flou de mouvement très important et empêchait de réellement afficher 60 images par seconde. Les écrans LCD récents profitent de temps de réponse de 8, 4, 2, voir 1 ms, grâce à différentes techniques telles que l'overdrive qui consiste à viser un changement de couleur plus radical pendant un bref instant pour forcer le pixel à basculer plus rapidement vers le nouvel état. Les valeurs annoncées représentent toujours le meilleur des cas puisque le temps de réponse varie suivant le changement demandé au pixel (passer du blanc au noir peut être plus rapide que passer du gris au gris, ou le contraire, suivant l'écran), mais globalement l'évolution a été très importante à ce niveau. De quoi rendre le LCD adapté au jeu et pouvoir aujourd'hui proposer des écrans capables de prendre en charge une fréquence de rafraîchissement maximale de 120 ou 144 Hz avec des cycles d'affichage de 8.3 et de 6.9 ms. Si un écran 120 Hz propose par exemple des modes 100 Hz, 60 Hz et 50 Hz, c'est uniquement pour s'aligner sur les standards les plus courants. Techniquement toutes les valeurs intermédiaires sont utilisables à condition que l'interface le permette au niveau de la carte graphique et de l'écran. Mieux, du point de vue de la dalle LCD, rien n'empêche que cette fréquence de rafraîchissement varie dynamiquement. L'adage "qui peut le plus, peut le moins" est bien d'application ici. Si une dalle accepte un rafraîchissement après 6.9 ms, elle peut également l'accepter après 7.0 ms, 7.2 ms, 12 ms etc. Il y a cependant une limite maximale du temps d'affichage à prendre en compte, au-delà de laquelle l'état d'un pixel pourrait se dégrader. Les fabricants ne communiquent en général pas sur cette valeur qui n'a pas d'intérêt lors d'une utilisation traditionnelle de leurs dalles, mais dans le cas d'une fréquence de rafraîchissement variable, elle devra être prise en compte. Page 3 - Rappel : V-SYNC ON, OFF, triple buffering… Le dilemme de la synchronisation verticaleSi le GPU calcule directement l'image dans la zone mémoire (buffer) lue par le moteur d'affichage en vue du transfert vers l'écran, le résultat sera loin d'être à la hauteur : les images ne seront pas affichées finalisées mais en construction progressive. Pour éviter ce problème, certaines vieilles consoles n'utilisaient leur processeur graphique pour manipuler l'image que pendant le VBLANK. Une situation intenable au fur et à mesure que les processeurs graphiques ont vu leurs fonctionnalités sa démultiplier. Ne les exploiter que pendant cette petite fraction du temps d'affichage d'une image aurait bien entendu été ridicule. La solution est le double buffering qui consiste, en acceptant une latence supplémentaire, à maintenir en permanence deux buffers. L'un est utilisé par le GPU pour le rendu de l'image (back buffer) alors qu'un autre contient l'image précédente en cours d'affichage (front buffer). Durant le VBLANK, l'image était au départ copiée du back buffer vers le front buffer mais une optimisation a rapidement été mise en place : l'inversion des buffers. Les GPU et leurs moteurs d'affichage peuvent accéder à l'ensemble de la mémoire vidéo et il est alors plus simple et plus rapide d'inverser les pointeurs vers les adresses mémoires dédiées à chaque buffer, sans réellement déplacer la moindre donnée. Le back buffer devient front buffer et vice versa. Voici comment cela se passe dans un cas idéal : (notez que par soucis de simplification, l'échelle des illustrations qui suivent se base sur des cycles d'affichages de 16ms, ce qui correspond à 62.5 Hz et non au classique 60 Hz)  Les rectangles verts clairs représentent le back buffer dans lequel le GPU calcule l'image, leur longueur représente ce temps de calcul. Les rectangles gris représentent le front buffer dont la longueur correspond à la période durant laquelle ils sont lus et les images sont transférées à l'écran. Vous remarquerez un petit intervalle entre les rectangles gris, c'est le VBLANK. Le GPU inverse le back et le front buffer durant la période VBLANK, nous parlons alors de synchronisation verticale activée (V-SYNC ON). Dans le cas illustré, idéal, le GPU est capable de générer une image dans un délai inférieur au cycle d'affichage, il tourne à 60 fps constants avec une marge confortable. A chaque rafraîchissement de l'écran, une nouvelle image peut être affichée, pour une sensation de fluidité et de régularité des mouvements parfaite. Pour cela, la carte graphique et le reste du système, doivent être capable de toujours travailler au moins à 60 fps, ou en moins de 16.7ms par image. Les développeurs peuvent s'en assurer sur console (même si en général ils visent plutôt 2 cycles de rafraîchissement et donc 30 fps constants), mais l'environnement PC divers et varié ne permet pas de faire de même. Bien des systèmes ne sont pas capables de maintenir 60 fps en permanence et donc de proposer une nouvelle image toutes les 16.7ms. C'est là que les problèmes commencent.  V-SYNC ON [ cas parfait ] [ cas classique ] - [ V-SYNC OFF ] Toujours avec V-SYNC ON, lorsque le délai de 16.7ms est dépassé et que le GPU n'a pas terminé le calcul de la nouvelle image, l'écran doit être rafraîchi une seconde fois avec la précédente. Le résultat est une saccade peu agréable. Par exemple si la nouvelle image a nécessité un temps de calcul de 18 ms, et donc "raté" le rafraîchissement écran, elle doit attendre le suivant, et ne sera ainsi affichée qu'après un total de 33.3 ms bien supérieur à son temps de calcul et au délai idéal de 16.7 ms. Entre 18 et 33.3 ms, le GPU est bloqué, puisqu'il ne peut inverser les buffers que pendant le VBLANK. Dans le cas où ce temps de calcul trop long n'est pas ponctuel mais généralisé, les performances se retrouvent limitées à 30 fps, voire moins, ce qui réduit la fluidité et augmente la latence. La parade couramment utilisée par les joueurs consiste alors à désactiver la synchronisation verticale (V-SYNC OFF). Le GPU est libre d'inverser le front et le back buffer dès qu'il a terminé le calcul d'image, ignorant la période de VBLANK. Avec une carte graphique performante, les performances peuvent s'envoler bien au-delà du taux de rafraîchissement de l'écran et en cas de ralentissement, la perte de performances n'est pas amplifiée comme dans l'exemple précédent. Il n'y a plus de grosse saccade, ni de perte de fluidité généralisée.  Par contre, les buffers sont alors très souvent inversés alors que la lecture de l'image est en cours. En conséquence, l'affichage à l'écran d'une image donnée est subitement coupé pour continuer avec l'image suivante. A l'écran, nous n'observons plus une image pleine mais bien 2 (ou plus) morceaux d'images qui se succèdent. Suivant la situation, mouvement important à l'écran ou pas, la frontière entre ces 2 images est plus ou moins importante et visible, ce qui donne la sensation de cassure dans l'image (tearing en anglais). Les problèmes de fluidité, de saccades et de latence sont réduits en VSYNC OFF, mais ils ne disparaissent pas pour autant. Si un affichage est composé de plusieurs morceaux d'images, la latence est différente pour chacun de ces morceaux et certains peuvent ne pas avoir été rafraîchis depuis l'affichage précédent. Des sensations de saccades peuvent alors se faire ressentir à leur niveau avec un impact plus ou moins ressenti s'ils se situent ou pas là où se focalise le regard du joueur. Par ailleurs, sans limite de performances, la variation du temps de rendu d'une image à l'autre va augmenter, ce qui peut impacter la régularité de leur affichage et la sensation de fluidité. Il peut ainsi parfois être difficile pour les joueurs PC de faire le choix d'activer ou pas la synchronisation verticale, d'autant plus que le résultat va varier d'un jeu à l'autre, voire d'une scène à l'autre. Plusieurs tentatives de réponse à cette problématique ont été proposées, telles que le triple buffering ou la synchronisation verticale adaptative. Le triple bufferingLe triple buffering n'est pas une technique récente, elle fait partie du panel de possibilités depuis de nombreuses années mais n'a pas pu représenter une solution généralisée à la problématique de la synchronisation verticale puisqu'elle souffre également de défauts. Le triple buffering est souvent mal compris par certains joueurs en partie parce que des interprétations incorrectes de cette technique se sont répandues. Le triple buffering n'est pourtant pas bien compliqué et pousse simplement un peu plus loin le concept du double buffering. Il s'utilise exclusivement en VSYNC ON.  V-SYNC ON [ double buffering ] [ triple buffering ] [ cas parfait ] En plus du front buffer (gris) et du back buffer (vert clair), un troisième buffer, intermédiaire, est exploité (vert). L'image se déplace du back buffer ou troisième buffer et enfin au front buffer en vue d'être affichée. Ce troisième buffer permet au GPU d'éviter dans certains cas d'être bloqué quand il a terminé son travail mais devrait en double buffering attendre la période de VBLANK pour inverser le front et le back buffer et commencer le calcul d'une nouvelle image. Cette fois, il peut placer l'image dans le troisième buffer et commencer directement le traitement de la suivante. Il y a une bien entendu une limitation importante : toutes les images doivent être affichées et si le GPU est très rapide, il se retrouve malgré tout bloqué une fois tous les buffers remplis et en attente d'affichage. Dans cet exemple, l'image (2) prend plus de temps que la normale à être calculée. En double buffering classique, cela entraîne une saccade puisque ce retard implique que l'image (1) doit être affichée deux fois. En triple buffering, le troisième buffer est libre quand l'image (2) est finalement terminée, et cette dernière peut y prendre place directement pour permettre au GPU de libérer à son tour le back buffer et d'enchaîner sur le calcul de l'image (3). La saccade est ainsi évitée. Si toutes les images ont besoin de 18 ms pour être calculées, le GPU pourra tourner à 55 fps de moyenne, là où en double buffering il aurait été limité à 30 fps. Toutes les saccades ne peuvent bien entendu pas être évitées de la sorte, le tampon n'est que d'un cycle d'affichage soit 16.7 ms à 60 Hz. Si le retard combiné du rendu de plusieurs images successives dépasse cette valeur, une image est affichée deux fois et une saccade apparaît. Au final, sans devenir parfaite, la fluidité progresse significativement dans bien des cas. Le gros défaut du triple buffering est d'ajouter un cycle d'affichage de latence supplémentaire. A 55 fps en triple buffering, la latence est équivalente à celle obtenue à 30 fps en double buffering et plus élevée au moment des petites saccades. Que font les jeux actuels ? La plupart ne proposent pas d'option à ce niveau et en V-SYNC ON, les développeurs font le choix d'activer ou pas le triple buffering à la place des joueurs, dans certains cas d'après la fréquence de rafraîchissement de l'écran. C'est par exemple le cas de Splinter Cell Blacklist qui fait appel au double buffering en 60 Hz mais au triple buffering en 120/144 Hz. Du faux triple buffering ?Existe-t-il un "vrai" triple buffering en opposition à un "faux" triple buffering de DirectX, semblable à ce que nous venons de décrire et qui serait en fait du "render ahead" ? C'est un point de vue selon nous erroné répandu il y a quelques années par un confrère qui exprimait probablement une opinion personnelle de ce qu'il aimerait que soit le triple buffering, sans avoir considéré tous les aspects de la question, peut être influencé par le discours simplifié de l'un ou l'autre acteur de l'industrie qui y aurait vu un moyen de donner de l'intérêt aux systèmes capables d'atteindre de très haut fps. "Render ahead" dans le cadre de DirectX représente le buffer d'images préparées par le moteur du jeu et l'API avant l'envoi vers le GPU, de manière à lisser l'arrivée des images. Il s'agit d'un niveau de compromis supplémentaire entre latence et fluidité proposé par DirectX. Il n'a strictement aucun lien avec le double ou le triple buffering qui sont des buffers différents utilisés après le calcul des images. Render ahead peut-être utilisé dans tous les cas, aussi bien en double qu'en triple buffering, avec un niveau de profondeur par défaut de 3 images mais configurable par le développeur. Ce qui a été décrit comme étant le "vrai" triple buffering est en fait la suppression d'une restriction de cette méthode de gestion de l'affichage. Si le GPU a terminé une nouvelle image, il la place alors directement dans le troisième buffer, même s'il contient une image qui n'a pas encore été affichée, ce qui n'est pas possible avec du triple buffering classique. Encore une fois, cela fonctionne avec ou sans "render ahead". L'avantage est de permettre au GPU de calculer plus d'images que l'écran n'est capable d'en afficher. Le GPU peut par exemple tourner à 300 fps en 60 Hz, de quoi réduire la latence, tout en n'affichant que des images entières, sans tearing. Ce triple buffering magique reviendrait ainsi à combiner le meilleur du V-SYNC ON (pas de tearing) et du VSYNC OFF (faible latence). C'est vrai à 300 fps +/- constants, et dans ces conditions c'est probablement utile pour une poignée de joueurs professionnels. Le problème est qu'à un niveau de fps plus réaliste pour la majorité des joueurs, par exemple 50 à 70 fps, ce triple buffering avec possibilité de sauter des images, réintroduit des saccades ou à-coups. Le moteur du jeu ne peut pas prédire qu'une image va être sautée en bout de piste et du coup les mouvements de caméra ou des éléments de la scène ne seront pas réguliers à l'écran, ce qui, du point de vue du joueur, revient au même qu'une saccade. C'est la raison pour laquelle cette possibilité, en réalité complémentaire au triple buffering, est peu appréciée de la part des développeurs qui par conséquent ne poussent ni Microsoft, ni AMD et Nvidia à l'implémenter. A noter que c'est très proche dans l'esprit de ce que fait Lucid avec certaines options de ses logiciels d'optimisation, si ce n'est que Lucid pousse le système jusqu'à essayer de prédire quelles images pourront être sautées pour simplifier leur rendu au niveau du GPU et gagner en performances. En ce qui nous concerne, il n'y a donc pas de vrai ou de faux triple buffering. Il n'y a qu'une méthode exploitée en pratique et elle est destinée à favoriser la régularité de l'affichage, la fluidité, en faisant un compromis au niveau de la latence. Une variante existe et déplace le compromis pour s'adapter aux très hauts fps mais n'est pas utilisée en pratique, posant plus de problème qu'elle n'en résout dans des conditions de jeu normales. La synchronisation verticale dynamiqueUne nouvelle fois c'est un même nom qui revient. En 2011, John Carmack avait fait du lobbying auprès des fabricants de GPU en leur demandant de donner accès aux développeurs à une gestion dynamique et automatique de la synchronisation verticale. Nvidia avait alors été le plus réactif et a intégré quelques temps après une option dédiée dans ses pilotes dénommées synchronisation verticale adaptative. Cette option consiste à faire travailler le GPU et le moteur d'affichage en VSYNC ON quand le temps de rendu est inférieur à la durée d'un cycle d'affichage (le GPU tourne à plus de 60 fps en 60 Hz) et à passer automatiquement en VSYNC OFF quand il y est supérieur (le GPU tombe à moins de 60 fps). De quoi limiter le tearing du VSYNC OFF et éviter les grosses saccades ou chutes de performances du VSYNC ON. Il reste cependant un petit peu de tearing et quelques saccades lorsque les performances passent sous 60 fps. C'est une nouvelle fois un compromis différent et non une solution miracle. Compromis qui nous semble cependant pertinent dans bien des cas pour améliorer le confort de jeu. A noter qu'utiliser un limiteur de performances, que ce soit à 59 ou 60 fps en 60 Hz VSYNC OFF, permet d'obtenir un résultat très proche de celui d'une synchronisation verticale dynamique. Passer à 120 ou 144 Hz ?Ce détail est souvent ignoré des joueurs, mais passer à un taux de rafraîchissement supérieur, par exemple 120 ou 144 Hz alors que les performances tournent entre 40 et 60 fps permet de limiter les défauts des modes VSYNC ON et OFF. Dans ce dernier cas, les raisons sont évidentes, le tearing apparaîtra moins souvent, les petites saccades seront quelque peu étouffées et la latence moyenne sera légèrement réduite. En VSYNC ON, c'est un petit peu plus compliqué et l'avantage est lié au fait que plus de temps d'affichage intermédiaires vont être possibles : 60 Hz : 16.7 ms, 33.3 ms, 50 ms (60, 30, 20 fps) 120 Hz : 8.3 ms, 16.7 ms, 25 ms, 33.3 ms, 41.7 ms, 50 ms (120, 60, 40, 30, 24, 20 fps) 144 Hz : 6.9 ms, 13.9 ms, 20.8 ms, 27.8 ms, 34.7 ms, 41.7 ms, 48.6 ms (144, 72, 48, 36, 28.8, 24, 20.5 fps) Dans notre exemple précédent, lorsqu'une image nécessite un temps de rendu de 18 ms sur un écran 60 Hz en VSYNC ON, l'image précédente doit être affichée pendant 33.3 ms, ce qui entraîne une saccade importante et augmente la latence de 15.3 ms. En 120/144 Hz, l'image précédente n'aurait dû être affichée que pendant 25/20.8 ms, avec une latence supplémentaire de 7/2.8 ms. De quoi l'atténuer significativement. Ce n'est pas le cas pour toutes les saccades mais statistiquement, ce sera en moyenne toujours mieux avec un taux de rafraîchissement supérieur. A noter qu'en 120/144 Hz, le triple buffering profite de son côté d'une latence réduite au niveau de celle du double buffering en 60 Hz et la synchronisation verticale dynamique se comporte comme le mode VSYNC OFF vu le niveau de performances pris en exemple. Page 4 - G-SYNC, fréquence de rafraîchissement variable G-SYNC ou la fréquence de rafraîchissement variableAprès avoir fait le constat d'une part que la fréquence de rafraîchissement fixe pose problème dans le cadre du jeu PC et d'autre part qu'elle n'est pas une nécessité pour les écrans LCD et assimilés, il est apparu évident à Nvidia qu'il y avait matière à creuser le sujet. Quelques phases de réflexion et de recherches plus tard, Nvidia est arrivé à la conclusion qu'il était possible de résoudre ce problème relativement simplement et sans investissement initial démesuré. En d'autres termes, il n'y avait aucun risque à entreprendre la mise en place d'une fréquence de rafraîchissement variable et cela pourrait se faire rapidement. A la clé, un nouvel argument différentiateur potentiel pour les GeForce face aux Radeon et la possibilité de faire progresser la plateforme PC, ce qui est important pour Nvidia qui ne dispose d'aucune présence dans les dernières consoles. Le spécialiste du GPU a opté pour la marque G-SYNC, en opposition ou V-SYNC et en référence au fait que la synchronisation se fait par rapport au GPU.  Pour implémenter la fréquence de rafraîchissement variable, qui force l'écran à attendre le GPU, Nvidia a dû s'assurer de son support au niveau de ces 4 éléments qui entrent en jeu dans la chaîne d'affichage : - le GPU - les pilotes - l'interface - le contrôleur de l'écran Il faut bien entendu que la carte graphique et le moteur d'affichage du GPU en soient capables. C'est bien le cas, au moins depuis les premiers GPU de la génération Kepler qui disposent de suffisamment de flexibilité à ce niveau. Encore fallait-il implémenter ce support dans les pilotes, ce qui a pu se faire sans trop de mal. Quant à l'interface, les protocoles DVI, HDMI et DisplayPort peuvent selon Nvidia être exploités sans soucis, même si cela se fait probablement en dehors des standards et d'une manière propriétaire. Reste le point le plus délicat : le contrôleur de l'écran. Ce dernier, souvent appelé "scaler" en référence à l'une de ses fonctions, est responsable de la fin de chaîne de l'affichage. Malheureusement, les contrôleurs disponibles et intégrés actuellement dans les écrans sont incapables de supporter une fréquence de rafraîchissement variable.  Nvidia alors entrepris de développer son propre contrôleur mais pas de développer une puce dédiée, tout du moins dans un premier temps. Concevoir une puce coûte très cher en développement, prend beaucoup de temps et n'a de sens que pour des volumes importants, ce qui n'était pas le but visé pour un premier essai. L'option retenue par Nvidia a ainsi été de se baser sur un FPGA, un circuit logique programmable. Ces composants intègrent un certain nombre de cellules logiques élémentaires qui peuvent être configurées et interconnectées pour former certains circuits. De quoi émuler une puce classique en quelque sorte. Le désavantage est que ces composants coûtent relativement chers, raison pour laquelle ils sont en général réservé aux phases de tests et à des utilisations professionnelles très spécifiques. Ce FPGA prend place sur un module qui ressemble au format MXM, que Nvidia va pouvoir proposer aux fabricants qui désireront intégrer la fréquence de rafraîchissement variable à la sauce G-SYNC. Visiblement pressé de pouvoir présenter cette évolution, Nvidia n'a pas voulu attendre l'arrivée de nouveaux écrans et a entrepris de modifier lui-même un modèle actuel : le VG248QE d'Asus. Le fonctionnement de G-SYNCNvidia a configuré le FPGA pour supporter l'overdrive et 4 modes d'affichage : - Standard - 3D Vision 2 - G-SYNC - Ultra Low Motion Blur (ULMB) Ce dernier mode, dérivé de la technique Lightboost de 3D Vision, consiste à éteindre l'éclairage de la dalle durant la période de transition des pixels (ou tout du moins durant une partie de celle-ci), de manière à masquer ou atténuer le flou de mouvement. Le tout est en principe compensé par une luminosité supérieure. Comment fonctionne G-SYNC en pratique ? Ce mode de rendu doit être activé dans les pilotes et se substitue aux modes de synchronisation verticale classiques. G-SYNC s'enclenche alors automatiquement dès qu'une application 3D est lancée en mode plein écran. Aucun paramétrage n'est nécessaire du côté de l'écran.   Une fréquence de rafraîchissement reste d'application en mode G-SYNC, elle représente alors le temps d'affichage minimal (par exemple 6.9ms en 144 Hz) d'une image et le débit de l'interface vidéo qui doit, lui, rester fixe. Sur ce signal vidéo, Nvidia prolonge la période VBLANK (que vous pouvez imaginer comme l'ajout de lignes vides sous l'image en cours d'affichage) jusqu'à ce que l'image suivante soit terminée et proposée par le GPU. G-SYNC n'ajoute aucune image de latence, ni au niveau de la carte graphique, ni au niveau du module. Par ailleurs il est important de comprendre que le temps d'affichage d'une image donnée correspond en fait au temps de rendu de l'image qui la suit. Comme nous l'indiquions dans les quelques petits rappels sur la technologie LCD, il y a une limite de temps d'affichage au-delà de laquelle la dalle pourrait ne pas arriver à maintenir la couleur du pixel dans un état parfaitement figé. Pour éviter les défauts que cela pourrait entraîner, quand le temps d'affichage atteint 33.3ms (ce qui correspond à une fréquence instantanée de 30 Hz ou 30 fps), G-SYNC affiche une seconde fois la même image. Au final, G-SYNC accepte donc des temps d'affichages variables compris entre la limite de l'écran et 33.3ms. Il n'y a pas de limite au niveau de cette variation qui peut être aussi bien graduée que très brusque, cas qui n'est cependant pas idéal en terme de régularité des mouvements à l'écran. Rappelons que rien ne permet à l'heure actuelle au moteur du jeu de connaître le temps d'affichage réel des images, G-SYNC ne change rien à cela. Il reste donc important que les pilotes et la carte graphique n'ignorent pas la régularité de l'affichage. Notez qu'actuellement, c'est le pilote qui demande au GPU de renvoyer la même image une seconde fois au-delà de 33.3ms, mais Nvidia nous a indiqué qu'une fois G-SYNC passé en production de série, le module sera capable de répéter de lui-même l'image. De quoi participer à réduire le petit impact qu'a G-SYNC sur les performances. Nvidia ne désire pas rentrer dans trop de détails concernant l'implémentation de ce nouveau mode d'affichage et se contente d'admettre qu'il y a bien un petit coût en termes de performances lié au fait que le GPU doit sonder régulièrement le contrôleur de l'écran pour connaître son statut. Nvidia précise que tout cela est encore en phase d'optimisation, ce qui nous laisse penser qu'une partie du surcoût de G-SYNC découle probablement d'un certain conservatisme pour éviter tout bug d'affichage, le temps de pouvoir resserrer les spécifications plus précisément. G-SYNC est par nature incompatible avec le clignotement de l'éclairage que ce soit dans le cadre de 3D Vision ou du mode ULMB. C'est donc l'un ou l'autre mais il n'est pas possible de combiner G-SYNC avec l'un de ces modes. La raison est assez simple, avec un temps d'affichage variable des images mais un temps d'extinction fixe de l'éclairage, la luminosité effective varierait constamment. La solution serait d'adapter la luminosité à la durée d'affichage, sauf que cette durée n'est pas connue à l'avance, à moins bien entendu d'ajouter une image de latence. Il n'est pas impossible que Nvidia envisage à l'avenir cette possibilité mais d'une manière optionnelle. Page 5 - Asus VG248QE G-SYNC Edition, le module G-SYNC Asus VG248QE G-SYNC EditionLe VG248QE d'Asus est l'un des meilleurs écrans actuels destiné aux joueurs. Sa dalle 24" 1080p en technologie TN met en avant un temps de réponse de 1ms et il supporte une fréquence de rafraîchissement maximale de 144 Hz. Il représentait ainsi le candidat idéal pour servir de cobaye pour G-SYNC. Ce n'est par contre pas le moniteur parfait ou le plus polyvalent. TN + Edge LED oblige, ses angles de vision sont réduits, les couleurs fantaisistes, les noirs peu profonds (ce qu'Asus tente de masquer par une luminosité très élevée par défaut), l'éclairage peu homogène… Les graphistes passeront leur chemin et cet aspect n'est pas le but de ce test. Le VG248QE vise très clairement les joueurs et leur propose de base une réactivité exemplaire. Avec G-SYNC, Nvidia compte en faire le prototype de l'écran ultime à ce niveau.  Pour le transformer en G-SYNC Edition, ce n'est pas bien compliqué, Nvidia le débarrasse de toute son électronique d'origine et la remplace par la sienne équipée du module G-SYNC. Au départ prototype interne, cet écran customisé a été étendu en échantillons de test pour les développeurs et la presse et enfin en modèle commercial. Nvidia a au départ envisagé de commercialiser le kit de mise à jour, et bien que cela puisse être le cas sur certains marchés, ce ne le sera pas en Europe. Par contre l'importateur anglais Scan a été autorisé à modifier lui-même quelques écrans Asus et à les redistribuer par la suite en Europe, et donc en France, avec bien entendu un surcoût non négligeable. De 300€ l'écran passe ainsi à 525€. C'est cher, ce qui s'explique en partie par le fait que l'électronique d'affichage est en fait payée 2 fois et qu'il a fallu résoudre le problème de la garantie. Il s'agit ici de très petits volumes, le but de Nvidia n'étant clairement pas d'inonder le marché, mais simplement de rendre G-SYNC disponible puisqu'il est difficile d'en saisir l'intérêt sans se trouver devant l'écran. Nvidia nous a fait parvenir l'un de ces prototypes qui, comme il se doit, a rencontré notre tournevis :  Par rapport à la version classique de l'écran, au-dessus, nous pouvons tout d'abord observer que la connectique a été simplifiée au strict minimum : seul un connecteur DisplayPort est proposé, exit le DVI, le HDMI et les 2 mini-jacks. Par ailleurs, l'alimentation a été déportée à l'extérieur de l'écran et Nvidia fourni un adaptateur 24V 5.0A. A noter que si les haut-parleurs sont toujours présents dans l'écran, ils ne sont plus connectés, l'électronique actuelle de Nvidia ne prenant pas en charge le son.    Le bloc électronique est enfermé dans une carcasse métallique, simplement scotchée contre la dalle. Nous pouvons y découvrir un PCB principal marqué du logo Nvidia et sur lequel prend place le module G-SYNC surmonté d'un radiateur. Ce PCB n'offre qu'une connectique DisplayPort, probablement parce qu'au niveau du signal vidéo il s'agit de la plus simple à implémenter. Le prototype de module G-SYNCSur ce module G-SYNC, nous pouvons observer la présence de 3 puces de mémoire DDR3 pour un total de 768 Mo. Nvidia nous a expliqué que cette quantité de mémoire n'est pas réellement nécessaire mais que le FPGA peut avoir besoin de la bande passante combinée de ces 3 puces. L'image précédente est par exemple conservée dans cette mémoire pour être comparée à la nouvelle en vue du calcul des valeurs de l'overdrive.   Nous pouvons observer que le FPGA est un modèle Altera fabriqué en 28 nm, l'Arria V GX A3 (5AGXMA3D4F31I3N). L'Arria V est décliné en plusieurs versions et Nvidia a opté pour l'une des plus simples, probablement la moins chère capable d'implémenter toutes les fonctions nécessaires. Vendu au détail ce FPGA en version "simple" coûte tout de même la bagatelle de 650€. Certes Nvidia a sans aucun doute accès à des tarifs plus intéressants mais il semble évident qu'il représente un coût non négligeable dans l'implémentation actuelle de G-SYNC. Dans le cas de ces premiers écrans Asus VG248QE modifiés après coup, il n'est même pas certain que Nvidia rentre dans ses frais. Nous ne savons pas si Nvidia utilisera exactement le même FPGA sur les modules G-SYNC de série, le spécialiste du GPU se contentant de nous indiquer que les écrans de série utiliseront la version de série du module. Notez que dans le cas de l'Asus VG248QE G-SYNC Edition, il n'est pas possible pour l'utilisateur d'opérer une mise à jour du firmware de l'écran et du module G-SYNC. Cela ne peut se faire qu'en démontant l'écran et en connectant le module via un appareillage spécial. En d'autres termes, ces premiers écrans ne seront jamais mis-à-jour une fois vendus. Page 6 - G-SYNC en test : les performances G-SYNC : les performancesComment tester G-SYNC ? C'est bien entendu la première question problématique à se poser face à une évolution de la manière d'afficher les images dont l'appréciation relève principalement du ressenti de l'utilisateur avec toute la subjectivité que cela implique. Il n'est pas possible de vous "montrer G-SYNC", de proposer de vraies vidéos comparatives puisqu'un écran classique est incapable d'afficher ce qu'affiche un écran G-SYNC. Certaines vidéos comparatives telles que celles proposées par Nvidia ne sont en fait que des simulations approximatives qui opposent des situations problématiques des modes V-SYNC ON/FF (40 à 60 fps) à un cas de V-SYNC ON parfait (60 fps constants), mais pas à G-SYNC. Nous l'avions indiqué dès la première présentation de G-SYNC, à laquelle Nvidia nous avait conviés : notre première impression était très positive. Il s'agissait cependant d'un environnement contrôlé avec un nombre très limité de jeux. Nous avons bien entendu voulu vérifier que notre impression était toujours identique et pour creuser le sujet, nous avons opté pour 10 jeux avec plusieurs paramètres et deux niveaux de performances représentés par 2 cartes graphiques : GTX 760 / V-SYNC OFF / 60 Hz GTX 760 / V-SYNC ON / 60 Hz GTX 760 / V-SYNC ON / 144 Hz GTX 760 / G-SYNC ON / 60 Hz GTX 760 / G-SYNC ON / 144 Hz GTX 780 Ti / V-SYNC ON / 60 Hz GTX 780 Ti / V-SYNC OFF / 144 Hz GTX 780 Ti / V-SYNC ON / 144 Hz GTX 780 Ti / G-SYNC ON / 144 Hz Nous avons visé dans tous les jeux un framerate de 35 à 60 fps pour la GeForce GTX 760 et utilisé les mêmes paramètres graphiques pour la GeForce GTX 780 Ti ce qui lui permettait d'atteindre 65 à 100 fps. Sur nos scènes de test, la GeForce 760 ne dépassait jamais 60 fps en V-SYNC OFF alors que la GeForce GTX 780 Ti ne descendait jamais sous 60 fps, en dehors de l'une ou l'autre brève saccade. De quoi observer différents cas de figure et ne pas nous contenter de simplement opposer G-SYNC en 144 Hz contre V-SYNC ON/OFF en 60 Hz avec 40 à 60 fps comme le préconisait Nvidia. Cette opposition est bien entendu la plus favorable pour G-SYNC mais il était important de prendre le temps d'élargir nos observations, d'autant plus que nous n'avions jamais réellement traité les gains, bien réels, apportés par le 120/144 Hz. il est d'ailleurs dommage que Nvidia ait fait le choix de limiter sa propre démonstration technologique à 60 Hz... Afin de juger de la fluidité, il est important de connaître le niveau de performances dont voici les moyennes mesurées :  Plusieurs choses sont à noter, tout d'abord concernant la gestion du double ou du triple buffering quand la synchronisation verticale est activée : Anno 2070 : double buffering à 60 Hz, triple buffering à 144 Hz Batman Arkham Origins : double buffering Battlefield 4 : triple buffering Crysis 3 : triple buffering Far Cry 3 : option dans les paramètres graphiques (avec bugs aléatoires) GRID 2 : triple buffering Hitman Absolution : triple buffering Metro Last Light : triple buffering Splinter Cell Blacklist : double buffering à 60 Hz, triple buffering à 144 Hz Tomb Raider : option dans les paramètres graphiques Dans Far Cry 3 et Tomb Raider, qui proposent une option à ce niveau, nous avons opté pour le triple buffering, plus confortable que le double buffering, excepté dans Tomb Raider en V-SYNC ON 60 Hz, cas où nous avons trouvé le lag vraiment gênant. A noter que tous les jeux ne proposent pas d'option au niveau de la fréquence de rafraîchissement. Ceux qui ne le font pas se basent en général sur la fréquence de rafraîchissement utilisée sur le bureau Windows. C'est par exemple le cas dans Batman Arkham Origins, dans Crysis 3 et dans Metro Last Light. Une fois en V-SYNC ON, ce dernier repasse par contre en 60 Hz, quels que soient les paramètres du bureau. Nous n'avons pas trouvé de solution à ce problème dans ce jeu. Dans les jeux qui forcent l'utilisation du double buffering, les performances se trouvent impactées en V-SYNC ON, dans certains cas fortement comme dans Anno 2070 ou dans Batman Arkham Origins. Dans ce dernier qui reste dans ce mode en 144 Hz, nous pouvons observer comme prévu que l'impact est moindre, ce taux de rafraîchissement proposant plus de temps d'affichage intermédiaires. Quant au coût de G-SYNC que nous avons pu calculer sur base de le comparaison avec les performances en V-SYNC OFF, le voici : GTX 760 G-SYNC 60 Hz : -5% GTX 760 G-SYNC 144 Hz : -3% GTX 780 Ti G-SYNC 60 Hz : -4% Un coût qui est relativement constant d'un jeu à l'autre. S'il est plutôt réduit, il est bel et bien là et Nvidia travaille à le réduire. Même si au fond, les promesses de G-SYNC valent bien quelques fps de moins, encore faut-il vérifier qu'elles soient tenues en pratique ! Page 7 - G-SYNC en test : notre ressenti dans 10 jeux G-SYNC : notre ressenti dans 10 jeuxPour traiter la question de la fluidité, l'élément essentiel dans l'analyse de G-SYNC, nous avons repris la même formule que pour nos analyses similaires dans le cadre du multi-GPU en notant notre ressenti et en lui attribuant une couleur. L'approche n'a rien de scientifique et est totalement subjective mais nous permet de vous présenter un récapitulatif de nos impressions.  Dans le cas de doutes, nous sommes passés et repassés d'un mode à l'autre. Dans certains cas directement et puis éventuellement après une pause d'une heure de manière à distinguer plus clairement une différence légère qui ne se remarque qu'en comparaison directe d'une différence plus importante. Voici ce que nous avons observé avec la GeForce GTX 760 :  La GeForce GTX 760 avec des options graphiques qui entraînent des performances comprises entre 35 et 60 fps, profite pleinement de l'activation de G-SYNC. Passer de V-SYNC ON/OFF en 60 Hz à G-SYNC en 60 Hz fait une différence énorme en terme de confort de jeu, le tearing disparaît et surtout la fluidité progresse d'une manière nette, malgré la légère baisse de performances. Passer en G-SYNC 144 Hz donne des résultats encore légèrement meilleurs, même si le gain est cette fois mince. Splinter Cell Blacklist est le seul jeu qui ne nous a pas donné satisfaction sur la GeForce GTX 760 avec G-SYNC. En cause, certaines combinaisons de mouvements clavier et de mouvements souris entraînent des saccades importantes par endroit à ce niveau de performances. Ce n'est pas lié à G-SYNC, mais ce mode de rendu ne permet pas de masquer les saccades dans ce cas. Sur les 10 jeux testés, seuls 3 nous ont proposé un confort quelque peu supérieur en V-SYNC OFF par rapport au V-SYNC ON 60 Hz, ce qui est lié au fait que la plupart implémentent le triple buffering. Passer en V-SYNC ON 144 Hz améliore sensiblement le confort de jeu par rapport au V-SYNC ON 60 Hz, malgré des performances qui restent sous la barre des 60 fps (rappelons que Metro Last Light refuse de se lancer en V-SYNC ON 144 Hz). Le résultat reste néanmoins systématiquement meilleur avec G-SYNC, même si la différence est dans certains cas vraiment légère, raison pour laquelle cela ne se ressent pas dans la couleur attribuée à Crysis 3 et Far Cry 3. Avec la GeForce GTX 780 Ti :  En 144 Hz, activer G-SYNC fait progresser le confort de jeu dans tous les cas par rapport aux modes V-SYNC ON/OFF 144 Hz qui proposent pourtant déjà de très bons résultats à la base. Contrairement au 60 Hz, l'augmentation de lag est peu sensible en 144 Hz quand on passe en V-SYNC ON. Par contre autant en V-SYNC ON que OFF, toujours en 144 Hz, on ressent en général encore quelques petits à-coups sans activer G-SYNC, même dans GRID 2 qui tourne à 100 fps. Le mode V-SYNC ON 60 Hz, qui limite les performances de la GeForce GTX 780 Ti à 60 fps constants, offre en général de meilleurs résultats que les modes V-SYNC ON/OFF 144 Hz, justement parce que ces à-coups disparaissent : il convient donc de ne pas choisir forcément le taux de rafraîchissement fixe le plus élevé possible, ici le 144 Hz est donc bénéfique par rapport au 60 Hz si le framerate est inférieur à 60 fps mais contre-productif si il est supérieur à 60 fps et inférieur à 144 fps. Avec un tel niveau de performance, la différence est alors ténue entre le V-SYNC 60 Hz par rapport à G-SYNC 144 Hz (elle serait nulle avec G-SYNC 60 Hz bien entendu). G-SYNC 144 Hz reste malgré tout un poil au-dessus, les performances supplémentaires rendent les jeux quelque peu plus réactifs et les déplacements rapides sont plus nets qu'en V-SYNC 60 Hz, sans les petits défauts du V-SYNC ON/OFF 144 Hz. Il faut cependant bien admettre qu'il s'agit dans ce cas de détails que peu de joueurs remarqueront à moins de se concentrer sur ceux-ci en comparant deux écrans côte-à-côte. Des cas à problème avec G-SYNC ?Toujours lors de nos tests pratiques, nous avons cherché à déterminer des problèmes éventuels avec G-SYNC. Est-ce qu'il peut arriver que G-SYNC fasse moins bien que la synchronisation verticale ? Après de multiples essais dans de nombreux jeux, nous n'avons trouvé qu'un seul cas qui pose problème. Si les performances se situent tout juste au-dessus de 30 fps en V-SYNC ON/OFF, activer G-SYNC peut les faire passer tout juste sous la barre des 30 fps. A ce moment, nous tombons au-dessus du délai maximal d'affichage d'une image, et elle doit être affichée une seconde fois, ce qui limite encore un peu plus les performances. C'est actuellement le pire des cas pour G-SYNC et Nvidia indique essayer d'améliorer ce point même si il est de toute manière préférable de viser un niveau de performances supérieur à 30 fps. Pour le reste nous n'avons actuellement pas trouvé de faille, G-SYNC se comporte comme annoncé. En proposant une meilleure fluidité, il peut cependant faire ressortir plus certaines saccades qui ne sont pas liées à la partie graphique du traitement des images, par exemple un accès disque. Mais nous n'avons trouvé aucun cas de ce type où désactiver G-SYNC était préférable. Ressenti par jeuAnno 2070 - Max GTX 760 / V-SYNC OFF / 60 Hz : tearing très gênant, grosses saccades GTX 760 / V-SYNC ON / 60 Hz : fluidité insuffisante, lag GTX 760 / V-SYNC ON / 144 Hz : des à-coups réguliers impactent quelque peu la fluidité GTX 760 / G-SYNC ON / 60 Hz : petits à-coups de temps en temps GTX 760 / G-SYNC ON / 144 Hz : petits à-coups de temps en temps GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : tearing important, petites saccades GTX 780 Ti / V-SYNC ON / 144 Hz : petits à-coups de temps en temps GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Batman Arkham Origins - Max - GPU PhysX – MSAA 4x GTX 760 / V-SYNC OFF / 60 Hz : léger tearing, quelques saccades GTX 760 / V-SYNC ON / 60 Hz : manque de fluidité, petit lag GTX 760 / V-SYNC ON / 144 Hz : à-coups par endroits GTX 760 / G-SYNC ON / 60 Hz : très petits à-coups par endroits GTX 760 / G-SYNC ON / 144 Hz : fluidité excellente GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : léger tearing GTX 780 Ti / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Battlefield 4 - Ultra GTX 760 / V-SYNC OFF / 60 Hz : tearing gênant, saccades quand il y a de la fumée GTX 760 / V-SYNC ON / 60 Hz : manque de fluidité par endroits, petit lag GTX 760 / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 760 / G-SYNC ON / 60 Hz : petits à-coups par endroits GTX 760 / G-SYNC ON / 144 Hz : très petits à-coups par endroits GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : léger tearing GTX 780 Ti / V-SYNC ON / 144 Hz : très petits à-coups par endroits GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Crysis 3 - High - SMAA 4x GTX 760 / V-SYNC OFF / 60 Hz : léger tearing, petits à-coups par endroits GTX 760 / V-SYNC ON / 60 Hz : manque de fluidité et à-coups par endroits, petit lag GTX 760 / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 760 / G-SYNC ON / 60 Hz : très petits à-coups par endroits GTX 760 / G-SYNC ON / 144 Hz : fluidité excellente GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : léger tearing, très petits à-coups par endroits GTX 780 Ti / V-SYNC ON / 144 Hz : très petits à-coups par endroits GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Far Cry 3 – HDAO – MSAA 4x GTX 760 / V-SYNC OFF / 60 Hz : tearing gênant, manque de fluidité GTX 760 / V-SYNC ON / 60 Hz : petit manque de fluidité, lag GTX 760 / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 760 / G-SYNC ON / 60 Hz : petits à-coups par endroits GTX 760 / G-SYNC ON / 144 Hz : petits à-coups par endroits GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : petits à-coups par endroits GTX 780 Ti / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente GRID 2 – Ultra – QCSAA 16x GTX 760 / V-SYNC OFF / 60 Hz : léger tearing GTX 760 / V-SYNC ON / 60 Hz : petits à-coups par endroits, lag GTX 760 / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 760 / G-SYNC ON / 60 Hz : fluidité excellente GTX 760 / G-SYNC ON / 144 Hz : fluidité excellente GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : léger tearing GTX 780 Ti / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Hitman - MSAA 8x GTX 760 / V-SYNC OFF / 60 Hz : tearing gênant, fluidité insuffisante par endroits GTX 760 / V-SYNC ON / 60 Hz : manque de fluidité moins prononcé, lag GTX 760 / V-SYNC ON / 144 Hz : très petits à-coups par endroits, petit lag GTX 760 / G-SYNC ON / 60 Hz : fluidité excellente GTX 760 / G-SYNC ON / 144 Hz : fluidité excellente GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : léger tearing GTX 780 Ti / V-SYNC ON / 144 Hz : très petits à-coups par endroits, petit lag GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Metro Last Light – Very High GTX 760 / V-SYNC OFF / 60 Hz : tearing gênant, petit manque de fluidité GTX 760 / V-SYNC ON / 60 Hz : petit manque de fluidité, lag GTX 760 / V-SYNC ON / 144 Hz : impossible de lancer le jeu à plus de 60 Hz en V-SYNC ON GTX 760 / G-SYNC ON / 60 Hz : fluidité excellente GTX 760 / G-SYNC ON / 144 Hz : fluidité excellente GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : tearing mais fluidité excellente GTX 780 Ti / V-SYNC ON / 144 Hz : impossible de lancer le jeu à plus de 60 Hz en V-SYNC ON GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Splinter Cell Blacklist – Ultra – TXAA 2x GTX 760 / V-SYNC OFF / 60 Hz : tearing gênant, à-coups par endroits, léger lag GTX 760 / V-SYNC ON / 60 Hz : fluidité très mauvaise, gros lag, injouable GTX 760 / V-SYNC ON / 144 Hz : à-coups par endroits, léger lag GTX 760 / G-SYNC ON / 60 Hz : à-coups par endroits, léger lag GTX 760 / G-SYNC ON / 144 Hz : à-coups par endroits, léger lag GTX 780 Ti / V-SYNC ON / 60 Hz : léger lag GTX 780 Ti / V-SYNC OFF / 144 Hz : très petits à-coups par endroits GTX 780 Ti / V-SYNC ON / 144 Hz : très petits à-coups par endroits, léger lag GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Tomb Raider – Ultime – Shadows Ultra GTX 760 / V-SYNC OFF / 60 Hz : tearing gênant, saccades et léger lag par endroits GTX 760 / V-SYNC ON / 60 Hz : manque de fluidité par endroits, lag GTX 760 / V-SYNC ON / 144 Hz : petits à-coups par endroits, léger lag GTX 760 / G-SYNC ON / 60 Hz : fluidité excellente GTX 760 / G-SYNC ON / 144 Hz : fluidité excellente GTX 780 Ti / V-SYNC ON / 60 Hz : fluidité excellente GTX 780 Ti / V-SYNC OFF / 144 Hz : tearing, petits à-coups par endroits GTX 780 Ti / V-SYNC ON / 144 Hz : petits à-coups par endroits GTX 780 Ti / G-SYNC ON / 144 Hz : fluidité excellente Page 8 - Conclusion ConclusionAméliorer le confort de jeu sur PC passe généralement par une augmentation significative des performances, ce qui se traduit du côté du joueur par l'achat d'une nouvelle carte graphique. Du côté d'AMD et de Nvidia, cela implique le développement d'un nouveau GPU, dans certains cas l'utilisation d'un nouveau procédé de fabrication ou d'une nouvelle architecture. Un travail titanesque : des centaines de millions de $ sont investis et des centaines d'ingénieurs sont aux fourneaux pendant quelques années pour y parvenir. Sans abandonner cette voie, rassurez-vous, Nvidia nous démontre toutefois avec G-SYNC que d'autres approches permettent également de faire progresser la plateforme PC, dans ce cas "simplement" en affichant les images générées par le GPU d'une manière plus intelligente. G-SYNC, ou la fréquence de rafraîchissement variable, est un mode d'affichage dont nous ne pouvons que nous demander pourquoi il n'a pas été mis en place plus tôt. Il part en effet d'un postulat évident : si le confort de jeu est impacté par le fait que le GPU doive essayer de se plier en deux pour se synchroniser par rapport à l'écran, pourquoi ne pas faire en sorte que ce soit l'écran qui se synchronise par rapport au GPU ? Cela semble évident et c'est exactement ce que fait G-SYNC. Et ça marche.  A un niveau de performances dont se contentent bon nombre de joueurs, 35 à 60 fps, G-SYNC fait des merveilles, la fluidité devient très bonne, voire excellente, alors que les coupures disgracieuses dans les images s'évanouissent. Dans certains cas, c'est le jour et la nuit entre les modes V-SYNC ON ou OFF traditionnels et G-SYNC. Vous l'aurez compris, notre impression positive initiale se trouve confirmée à l'issue de ce test. Observer toutes les possibilités et pas seulement la comparaison la plus avantageuse pour G-SYNC était important. Nous avons par exemple pu constater que passer d'un écran 60 Hz à 144 Hz en V-SYNC ON améliore significativement le ressenti, même à ce niveau de performances de 35-60 fps. Un taux de rafraîchissement plus élevé participe à déminer le terrain pour le GPU qui se retrouve moins en décalage par rapport à l'écran. Ainsi, dans certains jeux, passer de V-SYNC ON 144 Hz à G-SYNC n'entraîne plus qu'un gain réduit. Certes l'amélioration est toujours bel et bien là, mais les défauts à corriger sont à la base moins importants. Pour la première implémentation de G-SYNC, Nvidia est parti sur la modification d'un des meilleurs écrans destinés aux joueurs du moment : l'Asus VG248QE, 1080p 144 Hz. Un choix qui peut par contre être discutable d'autant plus qu'il s'agit d'un écran dont le tarif d'origine a du mal à encaisser le surcoût de G-SYNC, très élevé dans son implémentation actuelle à base de FPGA. De 300€ l'Asus VG248QE G-SYNC Edition passe à 525€. Certes, bien que distribué dans le commerce, il s'agit plus d'un prototype que d'un modèle de série aux coûts de fabrication optimisés. Nvidia estime ainsi que les coûts vont baisser lorsque les premiers moniteurs G-SYNC sortiront des usines. Une affirmation que nous devons cependant tempérer par le fait que l'implémentation actuelle de G-SYNC repose sur un module équipé d'un composant relativement cher. A moins d'un changement radical, ce qui ne devrait pas arriver directement, le support de G-SYNC ne pourra pas être indolore pour le portefeuille. Nous comptons plus sur un supplément de 150€ que de 50€. La question légitime à se poser face au surcoût actuel et au surcoût supposé des premiers écrans de série est la suivante : faut-il investir dans un écran G-SYNC ou dans une carte graphique plus performante ? Notre ressenti nous indique que cela peut revenir au même en terme de confort. Une carte graphique plus performante capable de maintenir 60 fps en V-SYNC ON, ce qui n'est pas bien compliqué à trouver pour alimenter un écran 1080p, fera aussi bien qu'une plus petite carte graphique avec un écran G-SYNC. D'un côté la carte graphique plus performante aura une durée de vie plus longue, avec un niveau de confort en baisse progressive, d'un autre côté l'écran G-SYNC pourra permettre de maintenir ce confort de jeux sur plusieurs générations à travers des mises à jour moins onéreuses de la carte graphique, à condition bien sûr d'accepter d'être limité à l'offre Nvidia. Pour répondre à cette question, il faudra attendre l'arrivée des écrans de série. Dans l'immédiat, l'Asus VG248QE G-SYNC Edition est réservé à quelques passionnés qui veulent profiter de la primeur de ce mode d'affichage optimal. Quoi qu'il en soit, par la suite, G-SYNC intéressera au moins les puristes à la recherche du top du top en termes de fluidité et de réactivité, prêts à accepter un surcoût important pour cela, même pour un écran limité au 1080p.  De notre côté, là où nous attendons G-SYNC, c'est dans de futurs écrans haute résolution, en 2560x1440 ou en 4K. De telles résolutions mettent la pression en termes de performances aux GPU actuels, même aux plus véloces d'entre eux. Par ailleurs, la plupart de ces écrans sont limités à une fréquence de rafraîchissement maximale de 60 Hz, avec laquelle les problèmes liés à la synchronisation verticale ressortent le plus. Plus qu'un raffinement, G-SYNC est de toute évidence une nécessité pour ces écrans. Il en va de même d'ailleurs pour les systèmes multi-écran, ou surround, qui augmentent significativement la charge graphique et peuvent être difficiles à alimenter avec une fluidité parfaite même sur base d'écrans 1080p. Reste à voir si pour Nvidia G-SYNC est voué à rester un produit de niche, haut de gamme, ou à se généraliser pour profiter à un maximum de joueurs. Sans vouloir rentrer dans le détail, Nvidia nous a indiqué que toutes les portes étaient actuellement ouvertes pour le futur du support de G-SYNC. Nvidia pourrait ainsi concevoir son propre contrôleur, ou scaler, pour réduire les coûts de fabrication à une fraction de ceux du FPGA, mais cela peut prendre du temps et n'être envisageable que pour des volumes énormes. D'autres options existent, telles que proposer G-SYNC en licence à d'autres concepteurs de contrôleurs, son support n'étant pas extrêmement complexe à intégrer. Le coût du module G-SYNC actuel n'est pas son seul soucis, sa taille et sa consommation le rendent incompatible avec le monde mobile qui pourrait profiter lui aussi de G-SYNC. Pour cela, plus d'intégration est nécessaire, ce que ne peut ignorer Nvidia. Pour conclure, nous ne pouvons que souhaiter que la fréquence de rafraîchissement variable soit à terme standardisée et généralisée. Après avoir passé quelques semaines avec un écran G-SYNC, il est difficile de ne pas se demander pourquoi un tel mode n'a jamais été intégré dans un standard tel que le DisplayPort. Quant à la concurrence, d'une manière ou d'une autre, AMD devra réagir pour éviter que le confort de jeu sur Radeon ne soit limité à la seconde classe. En fin stratège, Nvidia aime placer AMD dans la position de celui qui court derrière le train en marche, ce qui lui permet d'orienter les débats et de choisir les champs de bataille. Espérons pour AMD que ses équipes chargées du développement graphique auront anticipé la possibilité très probable que le combat autour de la fluidité ne s'arrête pas à la régularité de la cadence d'affichage dans le cadre du multi-GPU... Si ce n'est pas le cas, piqué au vif par l'initiative de l'API graphique Mantle, Nvidia ne fera certainement pas cadeau de la fréquence de rafraîchissement variable à AMD… Mise à jour du 07/01/2014 : Nvidia n'aura finalement pas à faire cadeau de G-SYNC puisque AMD a profité du CES pour annoncer qu'un standard VESA permettant de faire la même chose était finalisé ! Cette implémentation se ferait sans carte additionnelle coûteuse contrairement à ce que fait Nvidia, d'où le surnom de "FreeSync" (cf. actualité). Nous devrions en savoir plus dans les prochaines semaines, voilà en tout cas une très bonne nouvelle qui devrait aider au développement de la FRV. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |