Nvidia G-SYNC: la v-sync enfin dynamique !

Publié le 18/10/2013 à 20:55 par Damien Triolet

Au cours de sa seconde conférence, et après avoir tiré en longueur sur une utilisation tordue de la console Shield, Nvidia a dévoilé une technologie pour le moins intéressante que la société est parvenue à maintenir secrète durant son développement : G-SYNC. Oubliez les compromis de la synchronisation verticale activée / désactivée, l'approche de Nvidia offre le meilleur des deux mondes.

Pour rappel, lorsque la synchronisation verticale (v-sync) est activée, la fluidité est affectée dès que la carte graphique ou le reste du système ne parviennent pas à produire une image dans l'intervalle d'un rafraîchissement de l'écran. La même image doit alors être affichée deux fois, ce qui entraîne une saccade et augmente la latence d'affichage moyenne. C'est particulièrement un problème sur PC, plateforme hétérogène pour laquelle il n'est pas possible pour les développeurs de garantir un temps de rendu adapté à la v-sync.

Désactiver la synchronisation verticale permet d'éviter en partie ces problèmes mais au prix d'une cassure dans l'image affichée qui peut être très gênante (tearing). Par ailleurs, si la fluidité s'en trouve améliorée, elle n'est pas parfaite : puisque l'affichage est constitué de deux morceaux d'images successives (ou plus), la fluidité n'est pas identique sur la totalité de l'écran.

Plusieurs tentatives ont permis de mettre en place des compromis entre le jeu en v-sync ON et OFF, mais sans jamais proposer de solution parfaite. C'était le cas notamment chez Nvidia avec la synchronisation verticale adaptative, approche que certains développeurs utilisent par ailleurs d'une manière plus globale dans leurs moteurs.

Avec G-SYNC, Nvidia s'attaque à la source du problème : l'écran doit en principe être rafraîchi à une cadence fixe. Cette limitation pénalise le jeu PC depuis des années et G-SYNC la fait enfin voler en éclats à travers une synchronisation verticale dynamique. Si un écran n'est pas capable d'accepter un taux de rafraîchissement supérieur à une certaine valeur, rien ne l'empêche cependant d'être rafraîchi à une vitesse inférieure et rien ne l'empêche d'être rafraîchi à une vitesse variable. Fort de ce constat, Nvidia a développé une logique de contrôle de l'écran plus flexible et en combinaison avec un support logiciel adapté au niveau des pilotes, le GPU est capable de contrôler quand l'écran va être rafraîchi.

Typiquement cela revient à dire à l'écran d'oublier toute cadence et de se rafraîchir en synchronisation avec le GPU, soit dès que ce dernier a terminé le rendu d'une image et inverse ses buffers de rendu. L'affichage est alors direct et aucun délai ne doit être inséré. Une fenêtre d'action est définie pour que la technologie soit active, avec un délai de rafraîchissement minimal lié aux spécifications de l'écran (16.667 ms pour un écran 60 Hz) ainsi qu'un délai maximal qui semble tourner autour de 33ms (~30fps, ~30 Hz).

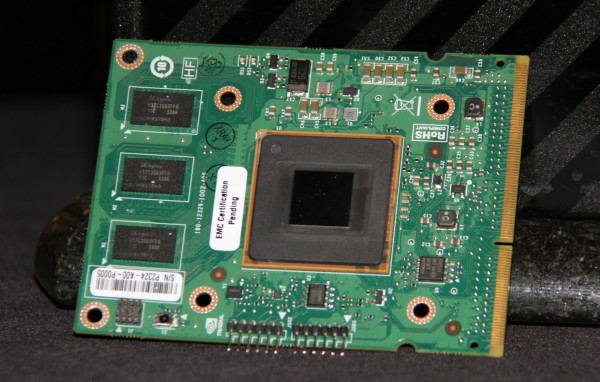

La carte contrôleur développée par Nvidia qui sera nécessaire au bon fonctionnement des premiers moniteurs G-SYNC.

Nvidia a développé des prototypes sur base d'un moniteur d'Asus, qui fait partie des partenaires principaux pour G-SYNC et qui devrait être le premier sur le marché. Ce moniteur 24" 1080p est équipé d'une dalle adaptée à un taux de rafraîchissement maximal de 144 Hz, ce qui correspond également à la limite actuelle de la partie contrôle de Nvidia. Une fois G-SYNC activé dans les pilotes, le taux de rafraîchissement effectif varie dynamiquement entre 30 ou 40 Hz et 144 Hz, Nvidia n'est pas très clair sur la limite basse.

La cadence d'affichage ne peut par contre pas correspondre parfaitement à la cadence d'avancement de la simulation du jeu par le moteur graphique, ce dernier n'étant pas capable de prédire le temps de rendu et donc le délai de rafraîchissement pour une image particulière. En pratique cependant, en moyenne l'erreur à ce niveau semble être relativement bien lissée et sur les quelques exemples que nous avons pu observer, aucune sensation étrange ne se faisait ressentir.

La sensation de fluidité avec G-SYNC activé est excellente dès 40 fps, alors qu'entre 40 et 60 fps elle est souvent très mauvaise avec v-sync et tout juste passable sans v-sync. Nvidia a développé une petite démonstration technique pour mettre en avant G-SYNC, mais nous avons également pu le vérifier en pratique sur la scène de Tomb Raider que nous avons l'habitude d'utiliser pour nos tests de fluidité. Entre 30 et 40 fps par contre, G-SYNC n'apporte plus réellement d'avantage significatif.

Pour vanter cette technologie de Nvidia, trois pointures du développement de moteurs graphiques ont fait le déplacement : Johan Andersson (DICE, Frostbite), John Carmack (id Software, id Tech) et Tim Sweeney (Epic, Unreal Engine). Ce n'est pas courant que ces développeurs soient réunis au même endroit et encore moins qu'ils parlent d'une seule voix. Tous trois approuvent sans équivoque l'arrivée d'une technologie telle que G-SYNC. En partie parce qu'elle améliore l'expérience de jeu sur PC, mais avant tout parce qu'elle apporte la promesse de faciliter leur travail.

Pour vanter les mérites de G-SYNC, Jen-Hsun Huang, le CEO de Nvidia, a accueilli la crème des développeurs de moteurs graphiques : Tim Sweeney, Johan Anderson et John Carmack.

Essayer d'avoir un temps de rendu plus ou moins constant représente un challenge important lors du développement d'un jeu et d'un moteur graphique, ce qui peut dans certains cas conduire à une limitation par le bas. Ne plus devoir s'en soucier, ou tout du moins pouvoir moins s'en soucier permet de pouvoir accepter des charges momentanément plus lourdes, par exemple un effet d'explosion qui va faire chuter les performances de 60 à 40 fps pendant quelques secondes. Sans G-SYNC, la fluidité est affectée, avec G-SYNC cela passe avec un impact mineur.

Reste bien entendu que G-SYNC sera limité, tout du moins au départ à une poignée de joueurs : il s'agit d'une technologie propriétaire qui sera introduite sur des écrans relativement haut de gamme. Comme le précise John Carmack sur ce point, fondamentalement, la technologie n'est pas si complexe et onéreuse que cela sur le plan matériel, ce qui devrait à terme lui permettre de se généraliser. Reste bien entendu à voir quelle sera la politique de Nvidia qui licenciera sa technologie aux fabricants de moniteurs.

G-SYNC fonctionne actuellement sur base du DisplayPort, mais Nvidia nous a indiqué que le DVI et le HDMI étaient possibles également avec des limites maximales de taux de rafraîchissement adaptées à leur bande passante. Le protocole utilisé par Nvidia sort probablement des spécifications des normes standards et il serait utile qu'un mode avec synchronisation verticale dynamique soit intégré à leurs prochaines évolutions, ce qui ouvrirait la porte à un support standardisé et généralisé. Dans l'immédiat, il sera obligatoire de passer par la carte contrôleur de Nvidia mais à terme tous les contrôleurs pourraient supporter une version standardisée de la technologie.

Dans tous les cas, G-SYNC se présente réellement comme une évolution majeure pour l'affichage des jeux PC, à tel point qu'il est impossible de ne pas se demander pourquoi il a fallu tant de temps pour qu'elle voit le jour. Les premiers moniteurs seront commercialisés au mois de janvier selon Nvidia et nous présumons que le concepteur de GPU s'efforcera d'avoir des systèmes en démonstration chez certains revendeurs tant il est nécessaire d'avoir l'écran en face de soi pour prendre la mesure du gain de confort au niveau de la fluidité.

Notez par ailleurs que l'affichage de plus d'images sur un écran qui peut monter jusqu'à 144 Hz peut également être bénéfique, la netteté étant mieux préservée lors de mouvements longs ou rapides. C'est le même principe que pour le passage de 24 à 48 Hz au cinéma ou l'interpolation effectuée par les TV modernes. Il pourrait d'ailleurs être intéressant que Nvidia mette en place une telle interpolation, qui pourrait être un compromis intéressant par rapport au calcul gourmand de toutes les images.

La réponse de Nvidia au gain de performances des Radeon dans la version Mantle de Battlefield 4 serait-elle simplement qu'avec G-SYNC, les GeForce n'ont pas besoin de ce gain de performances ?

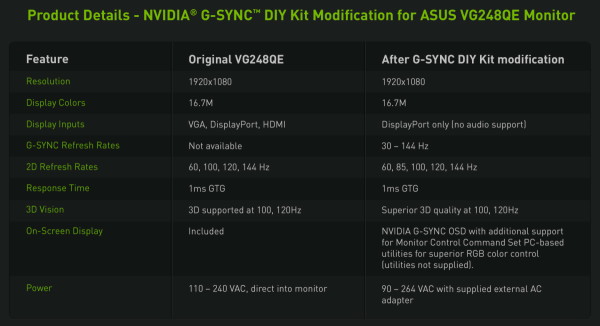

Mise à jour 23h30: Nvidia vient de donner un petit peu plus de détails concernant le moniteur utilisé pour les démonstrations. Il s'agit d'un VG248QE d'Asus qui a été modifié. La bonne nouvelle c'est que Nvidia envisage, mais ce n'est pas encore confirmé, la commercialisation d'un kit de modification dédié à ce moniteur pour apporter le support de G-SYNC. Une carte contrôleur devra être remplacée ainsi que le système d'alimentation. Le tarif reste inconnu et bien entendu la garantie Asus sera invalidée par l'opération.

Vos réactions

Contenus relatifs

- [+] 11/01: CES: Un écran OLED 4K 21.6 pouces c...

- [+] 09/01: CES: Silence sur l'après Pascal che...

- [+] 20/01: AOC lance un 35" UWQHD 100 Hz à 900...

- [+] 06/01: Un 1er moniteur HP compatible G-Syn...

- [+] 05/01: 1er moniteur 4K en 144 Hz G-SYNC po...

- [+] 04/01: HDMI 2.1 : 48 Gbps, Dynamic HDR et ...

- [+] 04/01: Acer : 3 écrans G-SYNC à 200 Hz et ...

- [+] 21/12: AMD FreeSync : Efficace et pas chèr...

- [+] 01/06: G-SYNC passe sur mobile, sans modul...

- [+] 01/06: Pilotes GeForce 353.06, G-SYNC évol...