Les derniers contenus liés aux tags Nvidia et HBM

Hot Chips : M1, SVE, Parker, InFo et Skylake !

GTC: Nvidia Tesla P100: 10 Tflops, HBM2...

La VRAM des GPU trop gourmande dans quelques années ?

IDF: Samsung lancera sa HBM en 2016

GDDR5 8 Gbps et HBM 128 Go /s chez Hynix

Hot Chips : M1, SVE, Parker, InFo et Skylake !

La conférence Hot Chips qui se tenait la semaine dernière a donné lieu a d'autres annonces intéressantes que nous avons essayé de regrouper dans cette actualité !

Rajouter des tiers de mémoire côté serveur

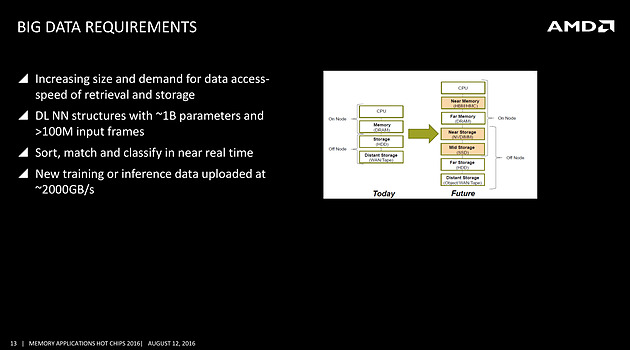

On avait déjà noté un peu plus tôt la volonté de rajouter de la mémoire HBM à divers endroits, et même la volonté de Samsung de travailler sur une version moins onéreuse, mais l'on rajoutera ce slide issu d'une présentation d'AMD qui rappelle les objectifs de la société côté serveurs, prenant pour le coup l'exemple du big data

On s'attardera sur le graphique à droite qui pointe l'ajout d'une mémoire intermédiaire côté CPU, type HBM ou HMC (AMD misera plutôt sur la HBM pour les déclinaisons serveurs de Zen), et aussi l'utilisation de NVDIMM pour s'intercaler avant un SSD. Il faudra attendre encore un peu pour voir comment seront déclinées ces technologies, mais il est intéressant de noter la manière dont les avancées côté mémoire sont mises en avant, parfois un peu trop tôt comme l'a fait Intel avec 3D XPoint, dans toute l'industrie.

Quelques détails de plus sur SVE

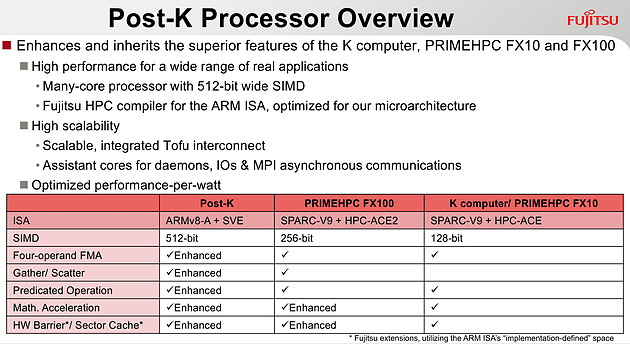

Chez ARM, outre une présentation de Bifrost côté GPU dont on vous avait déjà parlé, l'annonce principale concernait SVE, la nouvelle extension vectorielle introduite par la société.

Le premier partenaire annoncé par ARM est Fujitsu, qui mettra au point des processeurs ARMv8 avec extension SVE pour le futur supercalculateur japonais Post-K. Fujitsu a donné quelques détails, indiquant par exemple que les unités vectorielles auraient une largeur de 512 bits sur ses puces.

Chez ARM, le constructeur présente plusieurs benchmarks assez théoriques, on notera surtout sur les barres grises les améliorations qui ont été effectuées côté auto-vectorisation, c'est a dire la capacité du compilateur à utiliser des instructions vectorielles pour extraire du parallélisme. ARM devrait proposer dans les semaines qui viennent des patchs pour les différents compilateurs open source, incluant LLVM et GCC.

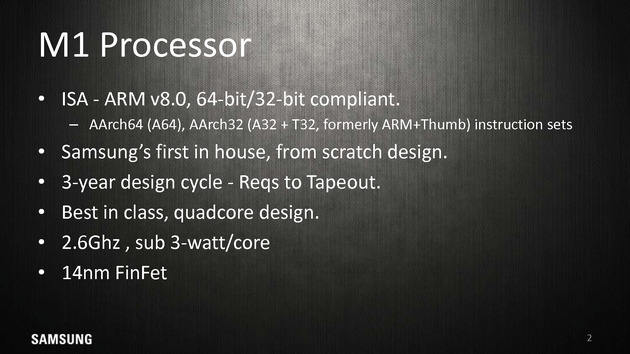

Le Samsung M1, un timide premier pas

La particularité de l'écosystème d'ARM est que les partenaires peuvent soit utiliser des coeurs "clefs en main", développés par ARM (les gammes Cortex, comme par exemple le Cortex A57), ou créer leurs propres implémentations de l'architecture ARM (qui restent compatibles, tout en étant différentes, à l'image des processeurs d'AMD et d'Intel qui diffèrent bien que restant compatibles). Plusieurs sociétés disposent de licences "architecture" qui permettent de créer ces puces, Apple étant jusqu'ici la société la plus à la pointe sur armv8 même si de nombreuses sociétés proposent tour à tour leurs architectures.

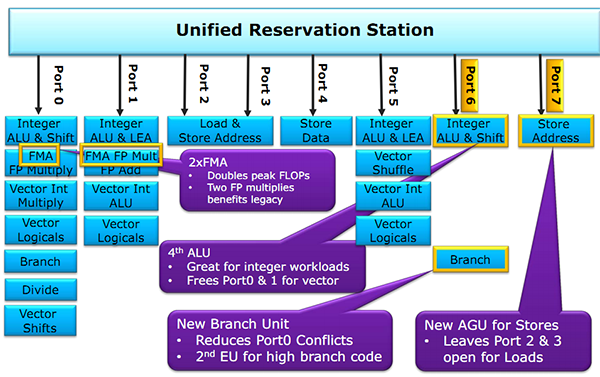

Parmi les nouveaux venus, il y a Samsung qui s'est lancé lui aussi dans le design d'une architecture armv8 custom pour ses Exynos M1. A la tête du projet, on retrouve Brad Burgess qui était architecte chez AMD pour les Bobcat. Il aura même été rejoint un court instant par Jim Keller (K8 chez AMD, A7 chez Apple, puis Zen chez AMD), qui n'est cependant pas resté très longtemps chez Samsung et qui n'aura probablement pas eu un grand impact. Le projet aura nécessité trois années, et en soit arriver a produire quoique ce soit du premier coup en un temps si court est un exploit.

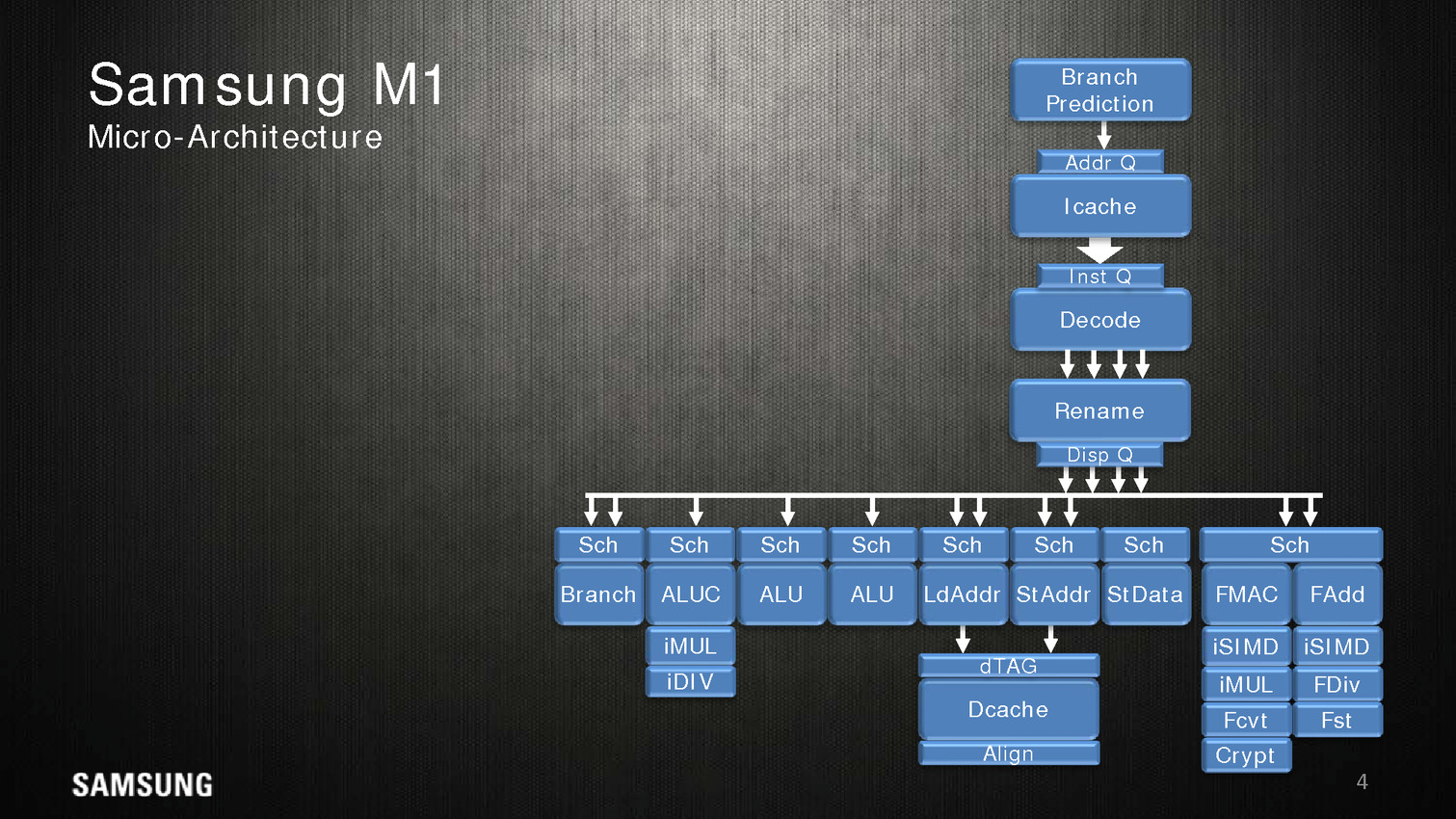

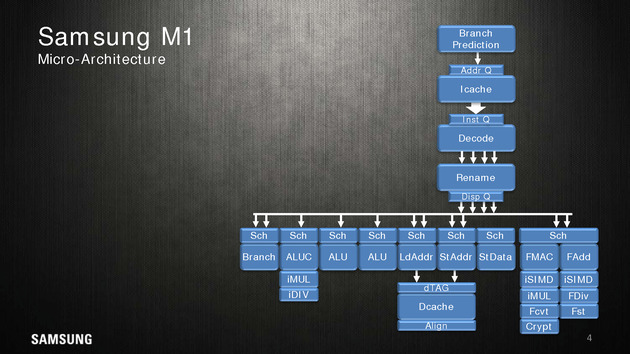

Côté architecture, Samsung indique utiliser un perceptron (un réseau de neurones simple) au niveau de ses mécanismes de prédiction de branches. Deux branches sont considérées par cycle, mais il est difficile d'estimer quoique ce soit sur l'éventuelle efficacité.

Quatre instructions peuvent être décodées/dispatchées par cycle aux unités d'exécutions qui sont regroupées sur sept files. On note deux files dédiées aux écritures mémoires, trois aux opérations mathématiques simple (avec un port sur lequel sont ajoutés les multiplications/divisions) et une aux branchements. Les opérations en virgules flottantes sont regroupées séparément avec un scheduler unique pour deux files. Samsung annonce 5 cycles pour effectuer une opération FMA.

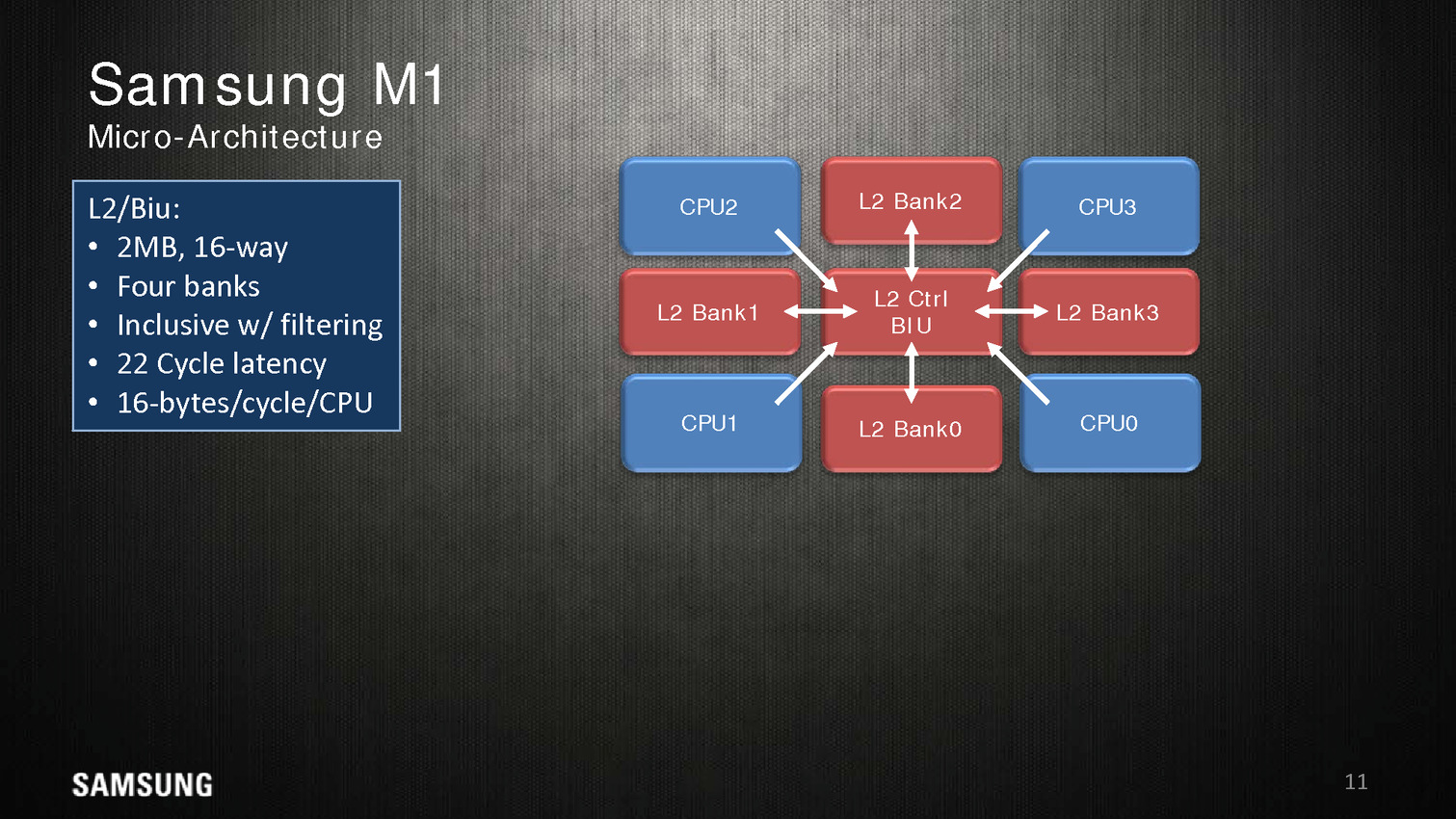

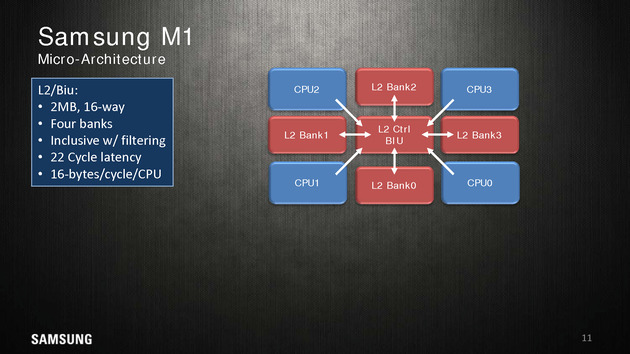

Dans une configuration quatre coeurs, le M1 dispose de 2 Mo de cache L2 coupé en quatre blocs, les coeurs accèdent au L2 via une interface commune. On appréciera aussi les schémas très spécifiques que propose Samsung, pas vraiment avare de détails techniques.

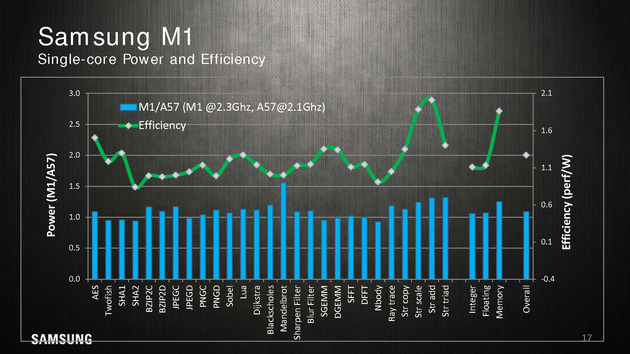

Reste qu'en pratique, les benchmarks mis en avant par Samsung ne sont pas forcément très convaincants. Avec 200 MHz de plus, sur un coeur, un M1 propose 10% de performances en plus qu'un Cortex A57 à consommation égale, ce qui est tout de même très peu. Samsung fait beaucoup mieux sur les opérations mémoires (c'est relativement facile, on l'a évoqué de nombreuses fois, les contrôleurs mémoires ARM ne sont pas particulièrement véloces/adaptés aux hautes performances), mais n'en tire pas particulièrement profit hors des benchmarks théoriques.

La présentation se termine en indiquant que ce n'est qu'un premier pas pour Samsung et que d'autres designs sont en cours d'élaboration. En soit si les performances ne vont pas révolutionner le monde des SoC ARM, Samsung a au moins une base de travail qu'ils pourront faire évoluer par la suite. A condition évidemment que Samsung continue d'investir sur le sujet dans les années à venir !

Les curieux pourront retrouver la présentation en intégralité ci dessous :

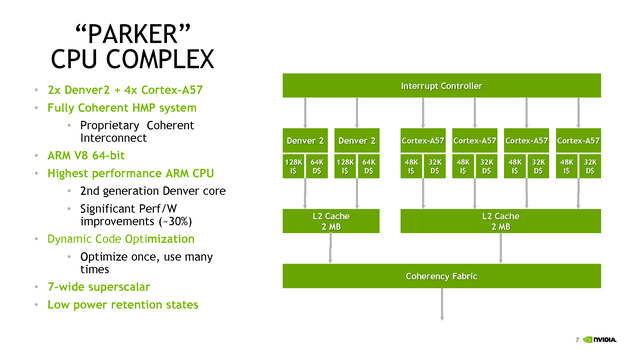

Parker/Denver 2 : design asymétrique

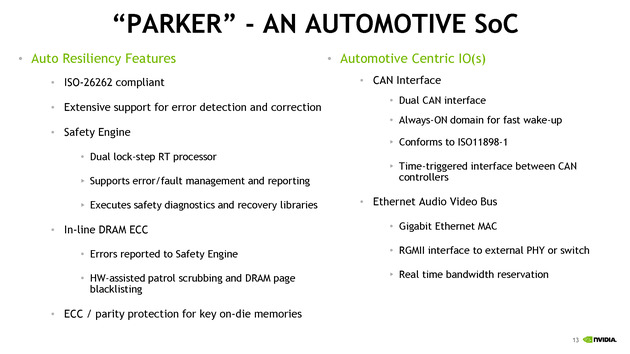

Nvidia était également présent à Hot Chips, donnant quelques détails sur son futur SoC baptisé Parker. Ce dernier est annoncé comme crée spécifiquement pour le marché automobile avec des fonctionnalités dédiées à ce marché. On ne sait pas si le constructeur le déclinera en d'autres versions plus génériques.

Les détails techniques ne sont pas particulièrement nombreux, on notera côté SoC que l'encodage 4K est désormais accéléré à 60 FPS, que l'on peut contrôler jusque trois écrans en simultanée, et que le contrôleur mémoire passe sur 128 bits (contre 64 précédemment). Côté GPU, Parker utilisera une version dérivée de son architecture Pascal.

C'est du côté CPU que les choses sont les plus originales, après avoir utilisé son architecture Denver sur les TK1, puis être revenu aux Cortex A57 sur les TX1, Nvidia propose une architecture asymétrique avec deux coeurs "Denver 2" (sur lesquels aucun détail n'aura été donné, à part un gain performance/watts de 30% donné sans précision sur les process comparés) et quatre coeurs Cortex A57. Ce n'est pas la première fois que l'on voit des configurations originales, durant Hot Chips, le taiwannais MediaTek présentait un SoC 10 coeurs avec quatre coeurs Cortex A53 à 1.4 GHz, quatre coeurs Cortex A53 à 2 GHz, et deux coeurs Cortex A72 à 2.5 GHz !

Dans le cas de MediaTek, l'idée est de proposer différentes options à différents niveaux de consommation. Pour ce qui est de Nvidia, le choix est différent, le Cortex A57 étant "haute performance" contrairement aux A53 de MediaTek. Il faut dire surtout que le marché visé, l'automobile, n'a pas les mêmes contraintes de consommation que le marché mobile. Reste que Nvidia se doit de gérer cette asymétrie avec un scheduler qui doit décider sur quel coeur placer les threads, ce qui n'est pas particulièrement simple. On notera que chaque groupe de coeurs dispose de son propre cache L2 de 2 Mo.

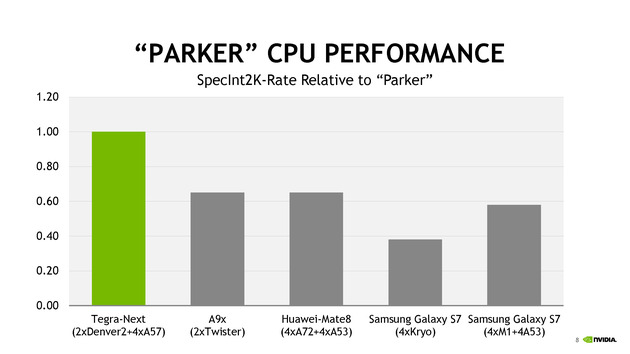

Côté performances, Nvidia avec ses 6 coeurs se présente comme moitié plus rapide qu'un A9X d'Apple en deux coeurs. Le graphique mélangeant des puces à TDP différents (on y retrouve des puces pour smartphones et pour tablettes), on admettra que la comparaison n'est pas faite à TDP identique.

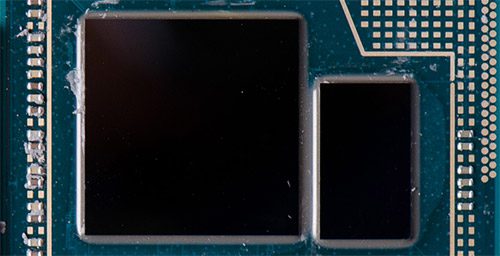

TSMC parle de ses packages InFo

Une des nouveautés présentées cette année par TSMC est la disponibilité d'un nouveau type de packaging, l'InFo-WLP. L'idée est de permettre de relier plusieurs dies en les "moulant" dans un substrat commun très fin qui contient également les interconnexions entre les puces. Il s'agit d'une version à cout beaucoup plus faible que les interposer (utilisés par exemple par AMD pour Fiji).

La présentation de TSMC est dédiée aux interconnexions entre les puces, et présente une puce 16nm reliant un SOC à une puce mémoire avec une bande passante de 89.6 Go/s sur 256 bits, le tout avec une consommation très réduite.

En plus de la solution présentée qui évoque le cas simple d'une puce mémoire et d'un Soc, TSMC évoque la solution comme permettant un jour de relier également plusieurs dies de logique, par exemple des groupes de coeurs séparés, pour réduire le coût de fabrication des puces (qui augmentent exponentiellement avec la taille des dies).

La présentation est technique mais reste intéressante, l'InFo-WLP ouvre des opportunités supplémentaires pour réaliser des produits qui mélangent processeur et mémoire. Le coût réduit et la finesse de l'interconnexion fait qu'on pourrait retrouver assez rapidement cette technique utilisée, y compris sur le marché mobile. Les prochains SoC d'Apple pourraient par exemple utiliser un tel package.

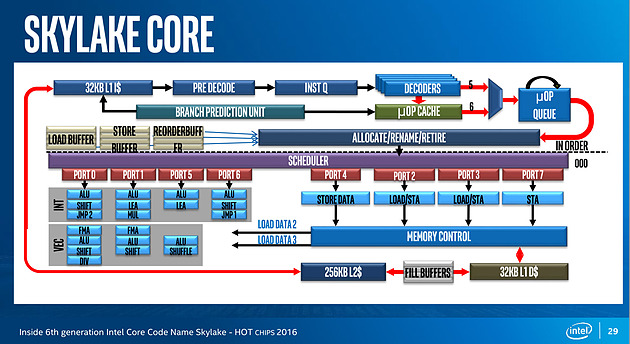

Et Skylake !

Juste avant la présentation de Zen, Intel proposait aussi une présentation de son architecture Skylake, lancée l'année dernière. Si la majorité du contenu est déjà connu, on aura noté un détail intéressant : un diagramme sur les unités d'exécution de Skylake. On rappellera que l'année dernière durant l'IDF, Intel nous avait promis plus de détails sur le sujet, sans jamais nous les donner !

Pour rappel, voici la répartition sur Haswell :

Récapitulatif des ports/unités d'exécution sur Haswell

Un an après, voici enfin un diagramme similaire pour Skylake :

Conformément à ce que nous avaient indiqué les ingénieurs d'Intel l'année dernière, le nombre d'unité a bel et bien augmenté. Le nombre de ports reste constant, à 8, mais l'on compte... une nouvelle unité. Sur le port 1, Intel a en effet ajouté une unité de shift vectorielle. Pour le reste, la répartition reste similaire à celle d'Haswell. Un mystère enfin élucidé !

GTC: Nvidia Tesla P100: 10 Tflops, HBM2...

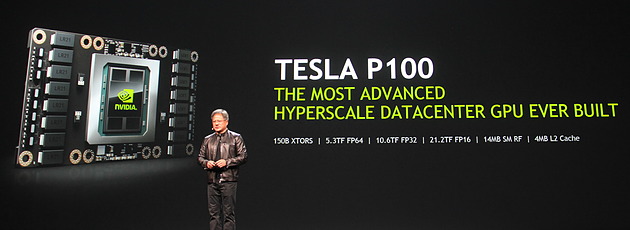

Comme prévu, Jen-Hsun Huang, le CEO de Nvidia, a levé un coin du voile concernant le premier produit Pascal, l'accélérateur Tesla P100. Au menu : 15 milliards de transistors, 10 Tflops, HBM2, 4 Mo de L2…

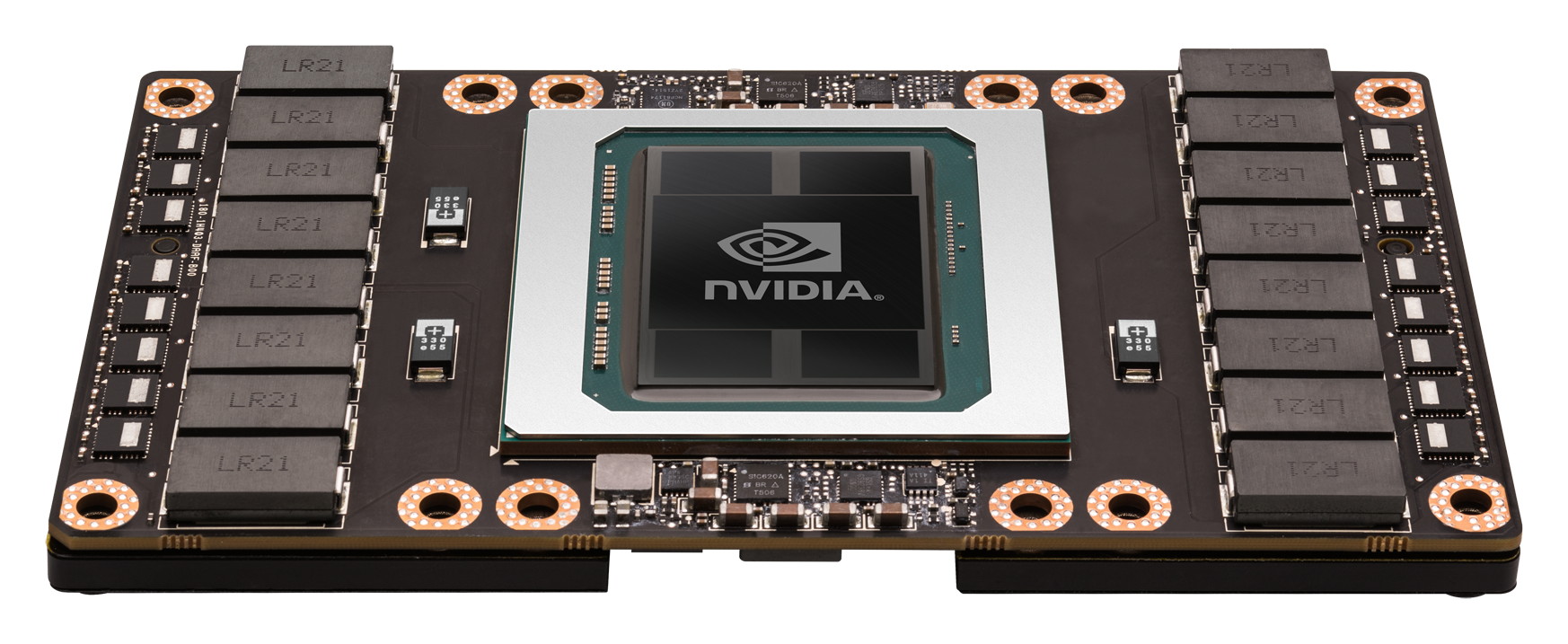

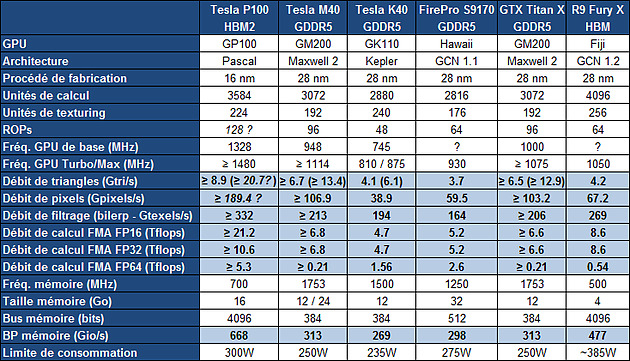

Le Tesla P100 est un nouvel accélérateur dédié au calcul massivement parallèle qui embarque un GPU GP100, auquel nous faisions référence précédemment en tant que Pascal, nom de code de son architecture. Il s'agit bel et bien d'un nouveau monstre de puissance. Pour cette première utilisation de procédé de fabrication 16nm FinFET Plus, Nvidia n'a pas eu peur de concevoir un énorme GPU et le GP100 intègre pas moins de 15.3 milliards de transistors répartis sur 610 mm². A comparer aux 8 milliards de transistors de l'actuel GM200 qui mesure également 600 mm².

De quoi pouvoir pousser la puissance de calcul vers le haut mais surtout intégrer de nouvelles fonctionnalités avant tout dédiées au monde du HPC telles que la connectique NVLink qui offre une bande passante combinée de 160 Go/s.

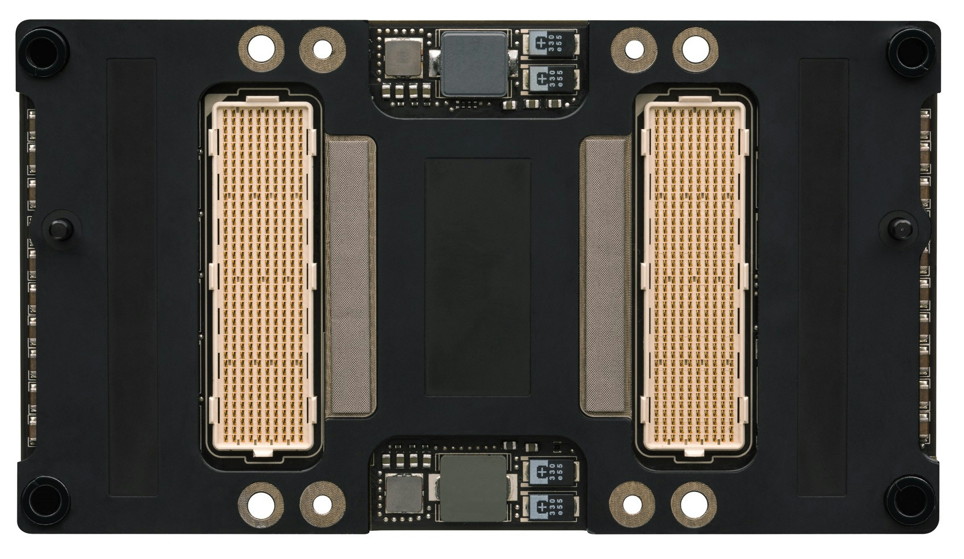

Le Tesla P100 se présente sous la forme d'un module au format mezzanine qui revient à superposer 2 PCB, avec un ou plusieurs connecteurs entre ceux-ci. Sur le Tesla P100 il s'agit de 2 connecteurs de 400 broches qui vont permettre de proposer la connectique NVLink. Ce format facilite également l'intégration dans les serveurs et la mise en place d'un refroidissement performant ce qui permet à Nvidia de pousser le TDP à 300W.

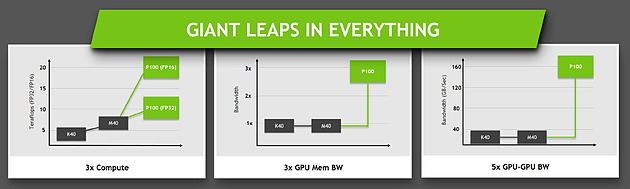

Concernant la puissance brute du Tesla P100, Nvidia annonce 10.6 Tflops avec GPU Boost en FP32, la précision classique, un gain de 60% par rapport aux 6.6 Tflops de la Titan X. L'architecture Pascal dans cette implémentation supporte également la double précision en demi-vitesse, soit 5.3 Tflops, un nouveau bond en avant par rapport au record actuel : 2.6 Tflops pour le GPU Hawaii d'AMD des FirePro W9100 et S9170. Dans l'autre sens, Pascal supporte également la demi-précision, le FP16, et peut alors monter à 21.2 Tflops.

A quelle configuration de GPU pourrait correspondre tout cela ? Au départ, nous supposions que le nombre d'unités de calcul passerait de 3072 sur le GM200 à 4608 sur le P100, réparties dans 36 blocs d'unités de calcul (SMP ?), ce qui aurait permis assez facilement d'augmenter à peu près toutes les capacités brutes du GPU de 50%. Il n'en est cependant rien et les changements sont plus profonds au niveau de l'architecture. Il s'agit ainsi pour le Tesla P100 de 3584 unités de calcul réparties dans 56 blocs de 64, mais le GP100 continent physiquement 60 de ces blocs.

Le gain de puissance de calcul brute provient ainsi principalement d'une hausse de la fréquence du GPU (+/- 1.5 GHz) alors que le GPU computing devrait profiter de cette organisation en plus petits blocs d'unités de calcul, mais également des autres évolutions de l'architecture Pascal, pour gagner en efficacité.

Sur ce point, Nvidia se contente de parler d'une augmentation de la taille du fichier registre. Au total le GM200 embarque +/- 6 Mo de registres, ce qui correspond à 256 Ko par SMM ou encore à 512 registres 32-bit par unités de calcul. Le GP100 passe à 15 Mo de registres, ce qui implique une augmentation de 100%, soit 256 Ko par SMP ou encore 1024 registres 32-bit par unité de calcul. De quoi permettre de maintenir un meilleur taux d'occupation des unités de calcul, particulièrement en double précision.

Le cache L2 passe de son côté de 3 à 4 Mo alors que l'interface mémoire est large de 4096-bit en HBM2. Nvidia annonce une bande passante de 720 Go/s pour les 16 Go de mémoire HBM2 CoWoS, le nom donné par TSMC à sa technologie 2.5D, similaire à celle employée par AMD pour son GPU Fiji.

Ce passage à la mémoire HBM2, associé à NVLink, à la puissance de calcul en hausse et au support de la précision FP16 permet au Tesla P100 d'afficher une progression conséquente sur différents plans par rapport à ses prédécesseurs.

Jen-Hsun Huang a terminé le chapitre consacré à Pascal en déclarant que la production en volume avait débuté et que son propre serveur basé sur le Tesla P100 serait commercialisé à partir du mois de juin. Il est probablement raisonnable de s'attendre à une nouvelle GeForce Titan d'ici là, mais sera-t-elle basée sur le GP100 ?

La VRAM des GPU trop gourmande dans quelques années ?

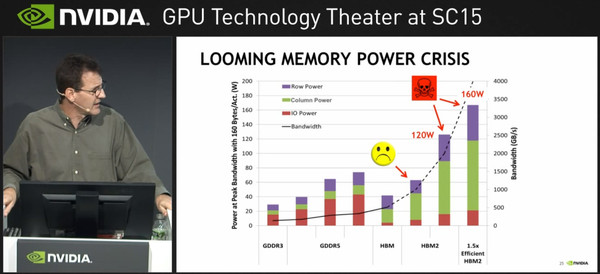

Lors du forum SC15, Nvidia a effectué une présentation concernant les pistes qu'il explorait afin d'arriver aux super-ordinateurs de type Exascale (capables d'effectuer au moins exaFLOPS) les plus efficaces possibles d'un point de vue énergétique. Si on n'apprend rien de précis concernant les architectures GPU à venir, le NVLink ou encore le support de la précision FP16 étant déjà connus, le constructeur a publié un graphique intéressant pour ce qui est de la consommation des différents type de mémoire.

Selon Nvidia, la HBM2 consommera ainsi jusqu'à 60 watts pour une bande passante de l'ordre de 1 To /s. Si son efficacité est en hausse par rapport à la HBM (40W pour 500 Go /s) et bien sûr la GDDR5 (75W pour 350 Go /s), il faut rappeler que la présence de la mémoire sur le même packaging fait que le GPU doit en contrepartie consommer moins sans quoi la densité de puissance à dissiper serait trop importante.

Si avec 60 watts pour la HBM2 la situation commencera à être problématique, Nvidia met en avant le fait que pour atteindre une bande passante de 2 To /s en HBM2 on arrivera à un niveau intenable de 120 watts. Même en envisageant une mémoire 1.5x plus efficace, pour atteindre une bande passante de 4 To /s qui devrait être nécessaire d'ici quelques générations de GPU on serait à 160 watts et il est bien entendu inimaginable d'attribuer autant de puissance à la mémoire.

S'il reste encore quelques années avant d'être confronté à ce problème grâce au remplacement de la GDDR5 par la HBM puis la HBM2, il faudra donc de nouvelles technologies mémoire pour accompagner l'augmentation en puissance des GPU. Le fabricant indique travailler sur le sujet, mais n'a dévoilé aucune piste à ce jour.

IDF: Samsung lancera sa HBM en 2016

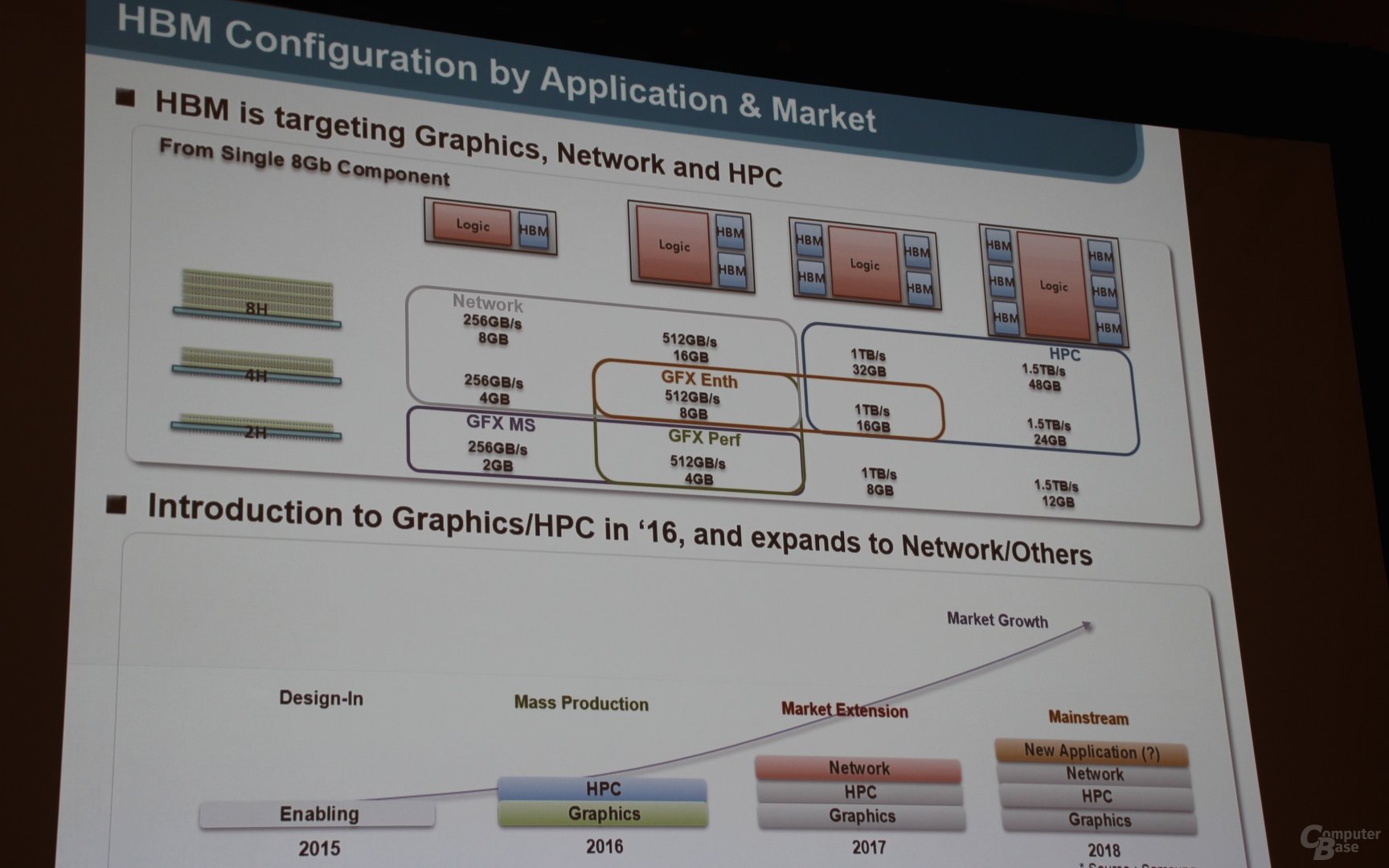

Lors de l'IDF, Samsung a annoncé qu'il allait lancer en 2016 de la mémoire HBM. Pour rappel ce type de mémoire a été co-développée par AMD et Hynix et est devenu un standard ratifié par le Jedec, il a fait sa première apparition sur les R9 Fury X.

A l'instar de la seconde génération de HBM Hynix prévue également pour l'an prochain, la HBM de Samsung sera basée sur des dies de 8 Gb qui seront empilés par 2, 4 ou 8 au sein de puces capables de fournir une bande passante de 256 Go /s chacune.

Cela permettra d'envisager de nombreuses configurations, de 2 Go à 256 Go /s à 48 Go à 1.5 To /s, les GPU haut de gamme devant probablement se "contenter" de 8 à 16 Go à 1 To /s, une bande passante doublée par rapport à la Fury X qui devrait être la bienvenue avec le passage des GPU au 14/16nm.

Alors que certaines rumeurs indiquaient qu'AMD allait avoir les faveurs d'Hynix en ce qui concerne l'approvisionnement en HBM de seconde génération du fait de leur passif, l'arrivée de Samsung sur ce marché devrait donc faire les affaires de Nvidia qui prévoit également d'utiliser ce type de mémoire avec sa prochaine architecture Pascal.

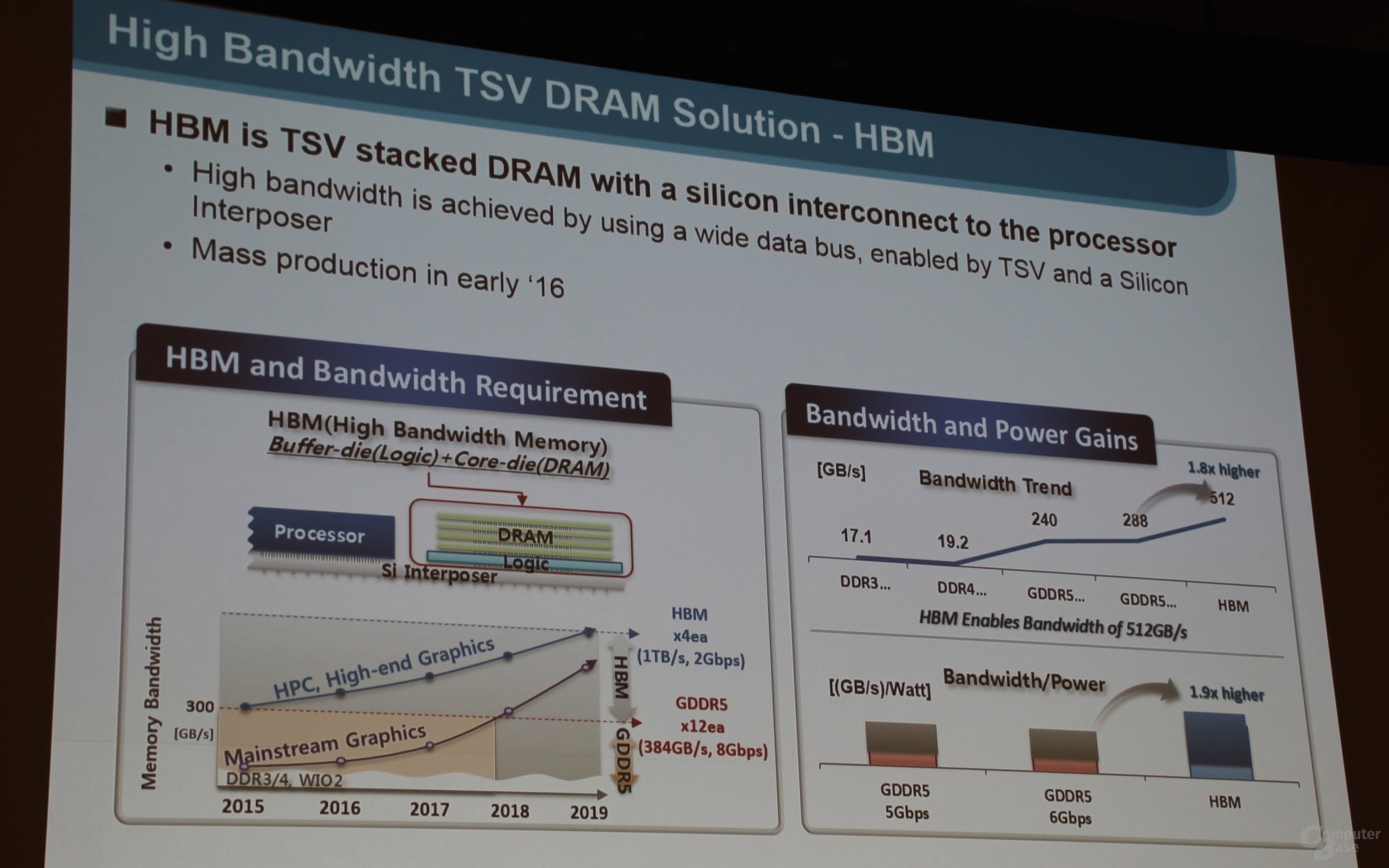

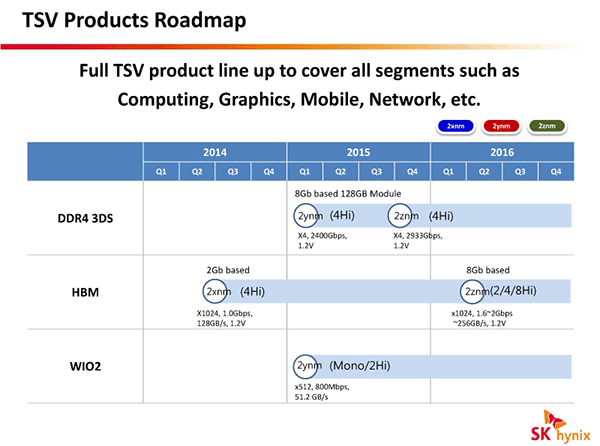

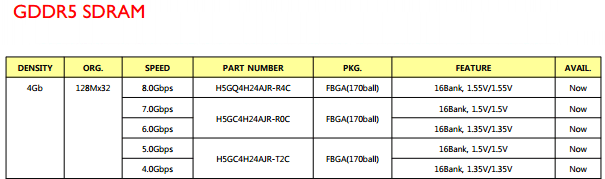

GDDR5 8 Gbps et HBM 128 Go /s chez Hynix

Dans son dernier catalogue destiné aux mémoires pour les puces graphiques, SK Hynix introduit une nouvelle GDDR5 à 8 Gbps soit 2000 MHz. La puce H5GQ4H24AJR-R4C est disponible en version 512 Mo et 32 bits, et offre seule une bande passante de 32 Go /s. Interfacée en 256 bits elle permet d'atteindre une bande passante de 256 Go /s contre 224 Go /s pour la GDDR5 7 Gbps qui prend place dans les GTX 970/980 par exemple.

Bien entendu une autre possibilité pour augmenter la bande passante mémoire disponible pour un GPU est d'augmenter la taille du bus, comme le fait AMD sur les R9 290/290X qui combinent de la mémoire à 5 Gbps et un bus 512 bits pour atteindre 320 Go /s.

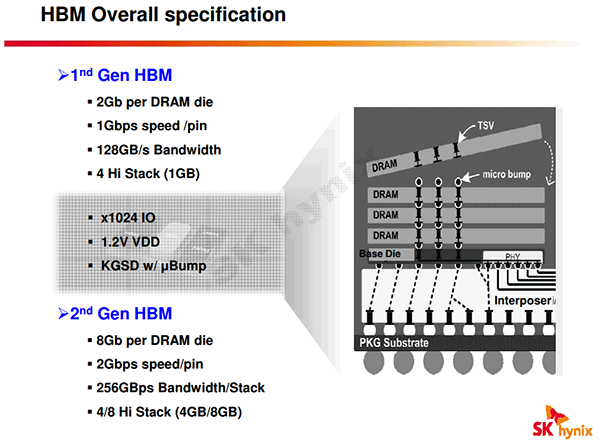

On note également la présence de mémoire HBM (High Bandwith Memory), avec cette fois une puce de... 128 Mo seulement (1 Gbits) ! A l'instar de la mémoire HMC (Hybrid Memory Cube), ce type de mémoire est composé d'un die logique de contrôleurs mémoire avec de multiples dies de mémoire, ici 4, le tout étant relié les uns aux autres par des TSV (Through Silicon Vias). Cette mémoire fonctionne a seulement 1 Gbps mais avec un bus 1024 bits, ce qui lui permet d'atteindre une bande passante pour une seule puce de 128 Go /s, 4 fois plus que la GDDR5 la plus rapide donc.

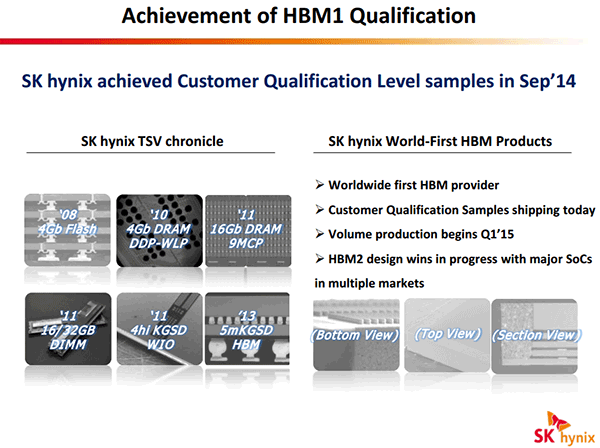

Si certains voient dans l'arrivée de la HBM au catalogue d'Hynix les prémices d'une association de la HBM avec des GPU AMD dès le 1er trimestre 2015, il faut temporiser ces ardeurs. Premièrement, la mémoire HBM n'est en fait pas nouvelle dans le catalogue Hynix, elle était déjà présente au troisième trimestre .

De plus, si AMD a effectivement collaboré avec SK Hynix au développement de la HBM, une puce de 128 Mo n'est pas assez dense pour être utilisée sur des GPU qui ont besoin de beaucoup plus de mémoire - il est plus qu'improbable d'avoir 16 à 32 puces HBM 1024 bits intégrées sur le packaging GPU ou sur le PCB ! Nvidia a déjà fait une présentation de sa génération de GPU Pascal prévue pour 2016 qui utilisera un type de mémoire proche, on pouvait voir 4 puces intégrées sur le packaging du GPU ce qui fait déjà un bus 4096-bit.

Toutefois la capacité annoncée pour cette puce HBM est en fait très étrange, SK Hynix a probablement fait une typo d'autant que la présence d'un "8G" dans la désignation fait penser à une capacité de 1 Go / 8 Gbits. C'est d'ailleurs de la HBM de 1 Go (4 die de 2 Gbits), atteignant également une bande passante de 128 Go /s avec un bus 1024 bits, qui a été qualifiée en septembre 2014 auprès des clients de SK Hynix, avec une production en volume devant débuter au cours du premier trimestre 2015 - on est donc loin de la disponibilité "Now" indiquée dans les catalogues des deux derniers trimestres. Courant 2016, une nouvelle génération de HBM doublera les débits alors que la capacité passera à 4 voir 8 Go (4 ou 8 die de 8 Gbits), mais on ne sait pas encore comment les fabricants de GPU utiliseront ces deux générations de HBM... est-ce qu'ils attendrons comme Nvidia le fait la seconde ou alors est-ce que AMD sautera le pas dès la première en 2015 ? L'avenir nous le dira !

Reste que si la puce de 128 Mo HBM qui est au catalogue de SK Hynix existe, elle sera pour sa part plutôt utile sur des APU en tant que cache externe, comme le fait déjà Intel sur les Haswell GT3e / Iris Pro 5200 qui intègrent sur leur packaging une puce d'eDRAM maison de 128 Mo interfacée en 512 bits et offrant une bande passante de 50 Go /s dans chaque sens, ce qui permet un gain de performance net vu la faible bande passante de la mémoire centrale (25,6 Go /s en DDR3-1600 sur deux canaux).