GPU Boost et GTX 680 : une double variabilité

Lors de notre test de la GeForce GTX 680, nous avions émis quelques réserves par rapport au comportement de GPU Boost, le turbo de Nvidia. Celui-ci est en effet non-déterministe dans le sens où, pour permettre au GPU de monter en fréquence, il se base sur la consommation réelle et non une estimation qui a l'avantage d'être identique pour tous les GPU. Une approche qui a l'avantage de maximiser les performances des échantillons qui consomment le moins, par exemple parce qu'ils souffrent de moins de courants de fuite, mais qui introduit par contre une dose de variabilité dans les performances de 2 échantillons.

Lors de notre test de la GeForce GTX 680, nous avions émis quelques réserves par rapport au comportement de GPU Boost, le turbo de Nvidia. Celui-ci est en effet non-déterministe dans le sens où, pour permettre au GPU de monter en fréquence, il se base sur la consommation réelle et non une estimation qui a l'avantage d'être identique pour tous les GPU. Une approche qui a l'avantage de maximiser les performances des échantillons qui consomment le moins, par exemple parce qu'ils souffrent de moins de courants de fuite, mais qui introduit par contre une dose de variabilité dans les performances de 2 échantillons.

Nvidia est peu loquace sur le sujet, bien que nous ayons insisté longuement pour avoir plus de détails sur cette marge de variabilité. Le fabricant se contente ainsi d'annoncer une fréquence GPU Boost qui est la fréquence minimale garantie que le GPU peut atteindre, précise que ses ingénieur étaient ébahis en observant le GPU monter plus haut dans de nombreux cas et refuse d'en dire plus. En réalité cette fréquence GPU Boost n'est qu'une spécification de façade, et sa référence dans le bios ou les pilotes n'a strictement aucun effet si ce n'est de permettre aux outils de monitoring de la reporter.

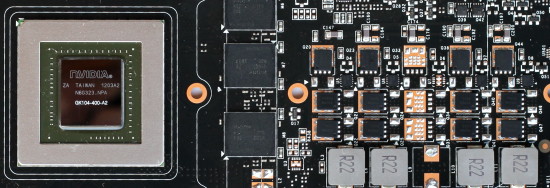

Quelle est donc la vraie fréquence maximale de GPU Boost ? En observant le comportement de quelques cartes du commerce, nous avons pu commencer à comprendre pourquoi Nvidia est embarrassé par les questions qui tournent autour de ce point. Tous les GK104-400 (version du GPU destinée à la GeForce GTX 680) ne sont pas qualifiés à la même fréquence maximale !

Par exemple, l'échantillon que nous a fourni Nvidia pour le test est qualifié à 1110 MHz alors qu'un exemplaire Gigabyte que nous avons tiré du commerce dispose d'un GPU qui n'a été qualifié "que" à 1084 MHz. D'autres le sont à 1071 MHz, d'autres encore à 1097 MHz etc. Cela signifie qu'en plus du fonctionnement non-déterministe de GPU Boost, la montée en fréquence sera limitée différemment suivant l'échantillon, peu importe que la température du GPU et sa consommation soient largement sous les limites.

Mis face à ces observations, Nvidia refuse toujours de répondre, arguant du fait, après insistance, qu'il veut garder sa procédure de qualification secrète pour éviter que ne s'en inspire la concurrence. En général, et en simplifiant, les premiers lots de GPU sont testés et des spécifications communes sont définies qui permettent de disposer d'un certain volume de production avec un certain niveau de performances et une certaine enveloppe thermique.

Dans le cas du GK104-400, probablement parce que la GeForce GTX 680 est au coude à coude avec la Radeon HD 7970, Nvidia semble vouloir profiter du moindre point de performances disponible… même si l'atteindre est incompatible avec un volume de production suffisant. En d'autre termes, Nvidia veut profiter des performances d'un GPU à 1110 MHz et du volume de production d'un GPU à 1058 MHz.

Comment cela fonctionne en pratique ? Nous pouvons supposer que chaque GPU reporte en nombre de bins de 13 MHz (crans) l'écart entre la fréquence de base et la fréquence turbo maximale, tout comme chaque GPU reporte depuis quelques temps déjà une tension qui lui est propre. Notre échantillon presse est ainsi un GK104-400 qualifié à 1006 MHz + 8 bins (1110 MHz) alors que l'échantillon Gigabyte se contente d'un GK104-400 qualifié à 1006 MHz + 6 bins (1084 MHz).

En pratique nous avons pu observer que la variation de performances entre deux cartes provient plus de l'utilisation de GPU qualifiés à des fréquences maximales différentes qu'au fonctionnement non-déterministe de GPU Boost, la plupart des jeux restant bien en-dessous de sa limite de consommation. Quel écart de performances entre ces deux échantillons ?

Cet écart de 2% dans les spécifications réelles de ces 2 GeForce GTX 680 se traduit par une différence pratique de 1.5%, qui peut monter à 5% dans le cas d'Anno 2070, très gourmand et qui est également influencé par la consommation GPU, visiblement plus faible sur l'échantillon presse.

Tout ça pour ça ?

Pourquoi nous soucier de ce point de détail ? Après tout, 2% d'écart, voire moins dans les jeux ne font pas une grande différence, ce que ne manque pas de souligner Nvidia... qui ne compte cependant pas s'en passer ! Nous supposons en effet que le concepteur de GPU a opté pour cette approche de manière à grappiller le moindre point de performances face à la concurrence.

Qui plus est, il ne s'agit que d'un exemple sur lequel nous sommes tombés, sans rechercher le plus grand écart possible. Des GK104-400 peuvent être validés à une fréquence turbo supérieure ou inférieure à ce que nous avons observé, produisant des écarts de performances plus importants. Nvidia refusant catégoriquement de communiquer sur ces écarts, probablement parce qu'il serait embarrassant d'admettre une différence dans les spécifications, nous ne pouvons pas connaître la marge de variation.

Quid des cartes overclockées par les partenaires ? Un de ces modèles équipés d'un GPU qui dispose de peu de marge GPU Boost pourrait en réalité ne pas être plus performant qu'un modèle de base tel que l'échantillon de test fourni par Nvidia !

Cela pose également des questions plus fondamentales par rapport aux spécifications des composants dont nous sommes habitués à ce qu'elles soient fixes par modèle de produit. Est-il acceptable qu'elles ne soient pas fixes ? Est-ce que moins de 1% est acceptable ? 2% ? 3% ? 5% ? 10% ? A partir de quel moment y aurait-il abus ? Imagineriez-vous un CPU Intel dont le Turbo pourrait être au hasard de 3.9 GHz ou de 4 GHz suivant l'échantillon ? Un SSD de 128 Go ou de 130 Go ? Préférez-vous que les performances soient déterministes ou que la consommation et les nuisances sonores le soient, comme c'est plus ou moins le cas sur la GeForce GTX 600 ?

Il sera intéressant d'observer si cette marge de variation augmente ou pas sur de futurs produits Nvidia, bien que cela soit en général difficile à déterminer, surtout au lancement quand nous devons nous contenter d'un exemplaire presse qui n'a selon toute vraisemblance pas été choisi au hasard. Comment savoir si les performances de la GeForce GTX 690 que nous vous proposerons demain seront bien représentatives des cartes du commerce ?

Contenus relatifs

- [+] 17/10: Nouveau bundle Nvidia: Assassin's C...

- [+] 30/08: Nvidia passe de Splinter Cell à Bat...

- [+] 09/07: Bundle GTX 600/700: Splinter Cell B...

- [+] 30/05: Une baisse pour les GTX 670 et 680

- [+] 19/03: UEFI GOP chez Asus pour les GTX 680

- [+] 11/02: Un bundle jeux free-to-play pour le...

- [+] 09/11: GTX680 4 Go DirectCU II pour Asus

- [+] 06/09: Sparkle Calibre X680 et X670 Captai...

- [+] 31/07: MSI GTX 680 Twin Frozr III en versi...

- [+] 09/07: PoV GTX 680 BEAST: 1162 MHz de base