ATI CrossFire - Le test

Publié le 26/09/2005 par Damien Triolet

Alors que tout le monde attend avec impatience l´arrivée de la nouvelle génération de GPUs ATI, c´est avec CrossFire que le fabricant canadien a décidé d´ouvrir le bal. Présenté en mai dernier, le concurrent du SLI arrive enfin. Répond-il aux attentes ?

Alors que tout le monde attend avec impatience l´arrivée de la nouvelle génération de GPUs ATI, c´est avec CrossFire que le fabricant canadien a décidé d´ouvrir le bal. Présenté en mai dernier, le concurrent du SLI arrive enfin. Répond-il aux attentes ?Du retardLorsque ATI a annoncé CrossFire, cela faisait 11 mois que Nvidia avait annoncé le SLI et 6 mois qu´il était disponible, il était donc grand temps pour les rouges de réagir, d´autant plus que le service marketing de Nvidia avait très bien travaillé notamment en usant d´astuces pour faire apparaître le SLI comme une technologie dont l´utilisation se répandait très rapidement afin d´amorcer un effet d´entraînement et de finir par augmenter ses ventes de chipsets et de cartes graphiques. S´il ne fait aucun doute que les chipsets nForce 4 connaissent un énorme succès (mérité), la quantité réelle d´utilisateurs du SLI est beaucoup plus floue. Mais peu importe en terme d´image ATI se devait de réagir rapidement, peut-être trop rapidement puisque CrossFire annoncé fin mai arrive seulement aujourd´hui soit 4 mois plus tard, ce que Nvidia n´hésite pas à dénoncer (en oubliant au passage avoir fait la même chose avec un paper launch de 5 mois sur le SLI).

Pourquoi ce retard ? ATI parle de problème avec le câble d´interconnexion de CrossFire et de recul stratégique, mais pour notre part et bien que ces 2 éléments fassent probablement partie des raisons, nous tablons principalement sur une annonce faite alors que les drivers étaient encore à l´état d´ébauche, ce qui signifierait qu´ATI savait très bien que CrossFire ne serait pas disponibles aux dates annoncées (à partir de juillet) et que les tests ne seraient pas effectués en juin. Lors de l´annonce de CrossFire, ATI a présenté une technologie sympathique et bien pensée qui reprenait les capacités du SLI en comblant ses lacunes, tout en promettant plus de gains au niveau des performances, ce que nous vous avions décrit dans notre preview.

Compositing EngineEtant donné qu´ATI a été surpris par le SLI de Nvidia, il n´avait pas d´intégration de technologie similaire prévue dans ses GPU ce qui l´a forcé a trouvé une solution externe : le Compositing Engine. Cette solution aurait pu être un petit boîtier externe ou une carte additionnelle mais ATI a décidé de l´intégrer directement sur ses cartes graphiques ou plutôt de sortir des déclinaisons avec Compositing Engine de ses Radeon X800 et X850 ce qui a donné naissance aux Radeon X800 et X850 CrossFire Edition, qui ne sont pas encore disponibles mais ne devraient pas tarder à l´être et dont l´utilisation est bien entendu obligatoire pour pouvoir utiliser CrossFire.

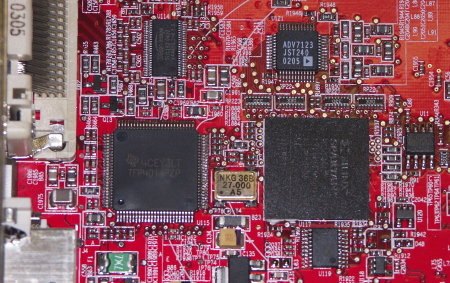

Le Compositing Engine englobe un récepteur DVI Texas Instrument (au lieu du Silicon Image de la preview), une puce FBGA Xilinx et sa ROM ainsi qu´un RAMDAC et un émetteur DVI.

L´utilisation d´un Compositing Engine a des avantages et des inconvénients. Il permet d´améliorer les performances puisque ce n´est pas le GPU maître qui doit s´occuper de l´assemblage du travail de chacun mais en contrepartie il augmente le coût de la carte et demande la production de nouvelles cartes graphiques. ATI a décidé de prendre ce coût à sa charge en commercialisant les cartes CrossFire Edition au même prix que les cartes classiques.

Le connecteur externe CrossFire et les connecteurs internes SLI flexibles et rigides.

Pour relier les 2 cartes entre elles, ATI a décidé d´utiliser ingénieusement la sortie DVI de la carte classique. Si l´idée nous a paru élégante au départ force est de constater qu´elle souffre d´un gros problème : elle est limitée au 1600x1200 en 60 Hz. Comme les utilisateurs d´écrans 1920x1200 le savent il est malgré tout possible de sortir dans cette résolution avec les sorties DVI mais au prix d´une astuce qui n´est visiblement pas utilisable avec CrossFire. Il s´agit là du gros point noir de la technologie d´ATI : limitée au 1600x1200 en 60 Hz que ce soit en DVI ou en VGA (alors que dans notre preview nous tablions sur du 1920x1200 75 Hz, ce qui correspond au ramdac utilisé). Les utilisateurs de très grands écrans TFT devront donc passer leur chemin, tous comme ceux de CRT qui tiennent à leurs yeux. Dommage.

Chipset, SLI 32, modes de rendu

Sommaire

1 - Introduction, retard, Compositing Engine

2 - Chipset, SLI 32, modes de rendu

3 - Super AA

4 - CrossFire en pratique

5 - Half-Life 2, Doom 3

2 - Chipset, SLI 32, modes de rendu

3 - Super AA

4 - CrossFire en pratique

5 - Half-Life 2, Doom 3

Vos réactions

Contenus relatifs

- [+] 04/05: Nvidia abandonne son GeForce Partne...

- [+] 27/04: AMD Vega 7nm en labo, Zen 2 échanti...

- [+] 18/04: ASUS AREZ, l'effet GeForce Partner ...

- [+] 10/04: Nvidia : fin du support Fermi et 32...

- [+] 27/03: Pilotes Radeon et GeForce pour Far ...

- [+] 20/03: Pilotes GeForce 391.24 pour Sea of ...

- [+] 20/03: Microsoft annonce DirectX Raytracin...

- [+] 20/03: Radeon Software 18.3.3 beta avec Vu...

- [+] 08/03: 3 millions de GPU vendus pour le mi...

- [+] 08/03: Radeon Software 18.3.1 optimisé pou...