Nvidia lance les GeForce 800M avec Battery Boost

Publié le 12/03/2014 à 18:54 par Damien Triolet

Après l'arrivée plus ou moins discrète de la GeForce 820M, Nvidia présente une famille GeForce 800M complète. Au menu de ce mélange de générations Maxwell, Kepler et même Fermi, des hausses de fréquences et l'introduction du système Battery Boost pour réduire la consommation en mode nomade.

C'est devenu une habitude chez Nvidia, en dehors de quelques renommages qui interviennent en décembre ou janvier, c'est en mars, juste avant l'arrivée du printemps qu'est introduite la nouvelle famille de GPU mobiles. Après les GeForce 600M et 700M, nous passons ainsi aux GeForce 800M. Il ne faut pas chercher de lien entre cette dénomination commerciale et une génération technologique, cela fait quelques temps déjà que les deux ne sont plus liées, raison pour laquelle 3 générations prennent part à cette famille de cartes graphiques.

Nvidia insiste fortement sur son écosystème logiciel dont GeForce Experience est devenu la pierre angulaire. Pour rappel, à sa base il permet de configurer automatiquement les jeux suivant des paramètres prédéfinis par Nvidia qui effectue des batteries de tests en interne pour déterminer le meilleur compromis pour chacun de ses GPU. De quoi permettre au néophyte de ne passer par le panneau d'options graphiques de jeux tout en profitant de réglages plus adaptés aux possibilités de sa machine. GeForce Experience a par la suite intégré ShadowPlay, pour enregistrer et diffuser des séquences de jeu, et GameStream, pour pouvoir jouer sur son PC depuis la console Shield.

Une nouvelle fonctionnalité propre aux GeForce 800M fait son apparition : Battery Boost. Sous cette appellation, Nvidia a implémenté différentes options qui permettent de limiter la consommation des portables en phase de jeu. L'option principale est un limiteur de fps, par défaut à 30 fps mais configurable, qui associé avec le mécanisme de contrôle du GPU permet à ce dernier de tourner à une fréquence/tension réduite. Un compromis fluidité (quoique la régularité à 30 fps peut être appréciable) contre consommation qui autorise des économie d'énergie substantielles.

Il était déjà possible de faire de même avec d'autres outils sur les GPU précédents, mais Battery Boost permet à cette option de s'enclencher automatiquement (sauf quand le jeu est déjà lancé) quand le portable passe sur sa batterie. Nvidia indique aller plus loin que le simple limiteur de fréquence, à travers des "algorithmes innovants" mais sans donner plus de détails. La réduction de fréquence pourrait par exemple être plus agressive à moins qu'il ne s'agisse de l'activation d'une autre possibilité de Battery Boost : réduire la qualité graphique en mode batterie (là aussi le tout est configurable jeu par jeu, option par option). Le GPU travaille alors moins et consomme moins. En résumé, Battery Boost permet de conserver les pleines performances quand l'alimentation est raccordée mais d'étendre l'autonomie quand le portable est sur batterie, à travers divers compromis.

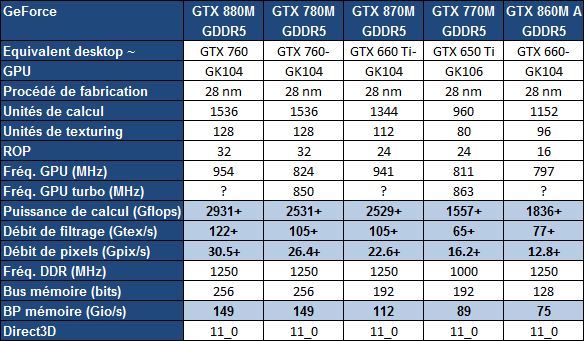

L'aspect logiciel étant traité, passons à la partie matérielle :

Sur le haut de la gamme, nous retrouvons le GPU GK104, génération Kepler, qui sévit depuis près de 2 ans, en tant que GeForce GTX 600M puis GeForce GTX 700M et maintenant GeForce GTX 800M. Il profite à chaque fois d'une sélection et d'une configuration plus précises, ce qui permet à Nvidia de pousser les fréquences. Le GK106, par contre utilisé dans de nombreuses GeForce GTX 700M disparaît de la gamme.

La GeForce GTX 880M profite d'une fréquence GPU (de base, Nvidia ne communique aucune fréquence turbo) en hausse de 15% par rapport à la GeForce GTX 780M. A noter que cette carte graphique mobile pourra exister en version 2 Go GDDR5, mais également en version 4 Go GDDR5 peu utile et surtout en version spéciale "piège à pigeon" avec 8 Go GDDR5. Eurocom a d'ores et déjà annoncé intégrer cette version dans le X7, voire même en SLI avec 16 Go de GDDR5 au total !

La GeForce GTX 870M, qui devrait cette fois se contenter de 3 Go de GDDR5, représente une grosse évolution par rapport à la GTX 770M puisqu'elle utilise un GPU plus costaud, le GK104 au lieu du GK106. La GTX 860M "A" devrait pour sa part se rapprocher de cette GTX 770M. Elle exploite elle aussi le GK104 mais massivement castré, notamment au niveau de son interface mémoire limitée de 256 à 128-bit. Nous devons malheureusement préciser version "A" puisque Nvidia a eu la très mauvaise idée de proposer deux cartes graphiques totalement différentes sous cette même appellation.

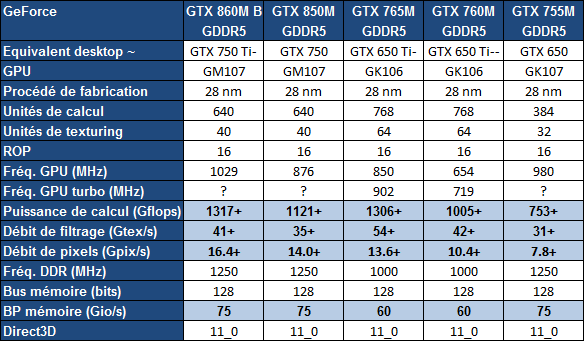

Dans le milieu de gamme, la nouvelle génération Maxwell, introduite sur PC de bureau avec les GeForce GTX 750 et 750 Ti, fait cette fois son apparition. Nous retrouvons le GPU GM107 dans la variante "B" de la GeForce GTX 860M. Par rapport à la variante "A" en génération Kepler, la puissance de calcul est en nette baisse, mais il est important de rappeler que la génération Maxwell exploite mieux les ressources disponibles. Sur base de nos observations avec les GeForce GTX 750, nous estimons que les performances pratiques seront proches entre les 2 versions de la GTX 860M. La seconde devrait par contre être plus efficace sur le plan énergétique. Malheureusement, Nvidia a estimé préférable que le consommateur ne puisse pas faire de différence à ce niveau.

La GeForce GTX 850M est similaire à la GTX 860M "B" mais avec une fréquence GPU revue à la baisse. La tension devrait avoir suivi le même chemin ce qui devrait en faire une carte graphique mobile au rendement énergétique particulièrement intéressant. Le gain de performance sera important par rapport aux GTX 755M et GTX 750M qui étaient équipées d'un GPU nettement moins véloce mais tout aussi gourmand.

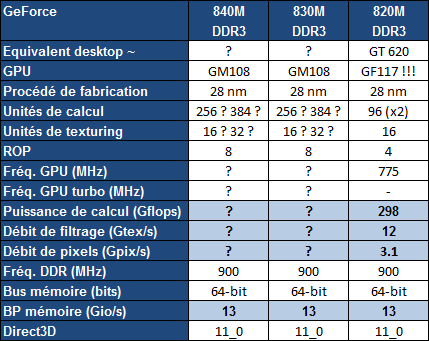

Enfin, dans le bas de la gamme nous retrouvons tout d'abord la GeForce 820M, déjà disponible. Etonnamment, il s'agit d'un ancien GPU de la génération Fermi que nous pensions abandonnée. Ce GPU a selon nous peu d'intérêt par rapport aux solutions graphiques intégrées aux CPU. A noter que Nvidia abandonne le préfixe GT en entrée de gamme.

Plus intéressant, Nvidia introduit les GeForce 840M et 830M basées sur un nouveau GPU Maxwell : le GM108. Nous n'en saurons pas plus à leur sujet, Nvidia refuse de communiquer les spécifications de ces produits en estimant que le consommateur peut se contenter de faire confiance à son estimation : un indice de performances de 3.5 à 5x en comparaison au HD Graphics 4400 d'Intel. Dans l'immédiat, nous vous conseillerons de ne pas faire confiance à ces accélérateurs graphiques tant que leurs spécifications ne seront pas connues. Ils pourraient tout aussi bien représenter une solution d'entrée de gamme intéressante qu'une taxe Maxwell avec autocollant GeForce sans plus-value utile par rapport aux GPU intégrés. C'est à Nvidia de le démontrer et pas au consommateur de lui faire confiance en achetant des spécifications surprises.

Ceci étant dit, sur le plan de l'architecture, nous supposons que ce GPU GM108 est similaire au GK208, bus 64-bit, bus PCI Express 8x, mais avec 2 ou 3 SMM Maxwell (256 à 384 unités de calcul) à la place de 2 SMX Kepler (384 unités de calcul moins efficaces). Nous confirmerons cela dès que possible.

La grosse limitation de ces GeForce 840M/830M semble venir du bus mémoire limité à la DDR3 pour tous les modèles. Il est possible que Nvidia ait simplifié ses contrôleur mémoire en supprimant le support de la GDDR5 mais également que ce support soit bien là mais non utilisé. En 64-bit, implémenter 2 Go de GDDR5 coûte relativement cher puisqu'il faut avoir recours aux modules de plus haute densité du moment. Se contenter de 1 Go de GDDR5 serait une bonne idée, malheureusement difficile à vendre au grand public par rapport à 2 Go de DDR3.

Au final, la GeForce GTX 850M semble être le dérivé le plus intéressant de la gamme et Battery Boost est une fonction bienvenue qui permettra aux joueurs de faire quelques compromis pour gagner en autonomie. Nous somme par contre déçus de ne pas retrouver de variante mobile de G-Sync annoncée avec ces GeForce 800M, probablement parce que Nvidia peut plus difficilement imposer une solution propriétaire quand la coopération d'Intel est nécessaire. Rappelons que ce sont les GPU intégrés HD/Iris Graphics qui pilotent l'affichage sur la plupart des plateformes via Optimus.

Vos réactions

Contenus relatifs

- [+] 10/04: Nvidia : fin du support Fermi et 32...

- [+] 08/03: GDC: Nvidia parle du Tile Caching d...

- [+] 01/08: Tile rendering pour Maxwell et Pasc...

- [+] 24/03: GDC: VR: Nvidia Multi-Res Shading e...

- [+] 23/03: GDC: Async Compute : ce qu'en dit N...

- [+] 22/09: Nvidia dévoile une 'vraie' GTX 980 ...

- [+] 09/09: Les GTX 900 supportent-elles correc...

- [+] 22/08: Nvidia GeForce GTX 950, MSI Gaming ...

- [+] 02/06: Computex: Nvidia: pas besoin de wat...

- [+] 01/06: Nvidia GeForce GTX 980 Ti 6 Go : la...