Nvidia GeForce GTX 1080, le premier GPU 16nm en test !

Avant de parler de l'overclocking de la GTX 1080 et de ses performances, il est utile de revenir sur GPU Boost ainsi que la gestion de la consommation et de la température du GPU. Un domaine complexe qui reste trop souvent mal compris.

GPU Boost : pourquoi ? comment ?

Nous vous en avons déjà parlé à plusieurs reprises, GPU Boost chez Nvidia et Powertune chez AMD représentent les ensembles matériels et logiciels chargés de la gestion de la consommation et de la température des GPU modernes. Ainsi, dans le cas des GeForce, c'est GPU Boost qui régule leur comportement de manière à s'assurer qu'elles restent dans les clous, c'est-à-dire qu'elles évoluent dans des conditions adaptées du point de vue de leur fiabilité et des nuisances.

Les GPU AMD intègrent un moteur de gestion très avancé capable d'autoréguler le GPU à travers de nombreux capteurs internes et externes, c'est Powertune. Du côté de Nvidia, quelques petits circuits présents sur le PCB reportent au pilote, en temps réel, le niveau de consommation de la carte graphique. Cet ensemble matériel et logiciel a été baptisé GPU Boost.

Le principe est le même : pouvoir proposer une carte graphique dont le GPU peut fonctionner à un niveau de spécification plus élevé que celui qu'elle est capable de maintenir dans le pire des cas. Grossièrement, au lieu de valider un GPU à une fréquence faible, par exemple 1.4 GHz, mais adaptée à tout type de charge, l'approche d'AMD et Nvidia consiste à le valider à une fréquence plus élevée, par exemple 1.8 GHz, mais qui sera réduite lorsque la charge dépasse un certain niveau. De quoi apporter un gain de performances significatif dans de nombreuses applications, dont la majorité des jeux vidéo.

Pour aller plus loin, les spécialistes du GPU ont intégré dans leur analyse la prise en compte de la température GPU. Le but est double : éviter l'envolée des nuisances sonores et leur permettre de valider leurs solutions à des fréquences encore plus élevées, cette fois sans devoir prendre en compte le pire des cas au niveau de la température ambiante. De quoi offrir quelques points de performances de plus lorsque le boîtier est très bien ventilé (ou en hiver… ou lorsque le testeur n'a pas le temps de laisser le GPU chauffer…).

Toutes ces évolutions sont bénéfiques pour l'utilisateur : elles permettent d'obtenir plus de performances. Elles peuvent cependant être source d'abus. Par exemple, si les testeurs se laissent abuser par l'inertie thermique, ils risquent de surévaluer les performances. C'est notamment le cas lorsque des benchmarks intégrés aux jeux sont utilisés par facilité puisque les performances sont alors mesurées après une plus ou moins longue période de chargement durant laquelle le GPU est au repos. La fréquence GPU, et donc ses performances, peut être significativement différente si les performances sont mesurées au milieu d'une session de jeu. Prendre en compte cette évolution des cartes graphiques allonge significativement les périodes de tests et demande à ce que l'environnement soit contrôlé lors des comparaisons. Une carte graphique testée en hiver à 20 °C puis en été à 28 °C n'affichera pas les mêmes performances.

Un autre abus possible est à chercher dans la sélection des échantillons de test. La consommation peut varier quelque peu d'un exemplaire à l'autre, la production n'étant pas uniforme, notamment au niveau des courants de fuite. Quand un exemplaire particulier de GPU consomme moins qu'un autre dans des conditions identiques, lorsque la consommation devient le facteur limitant, le moteur de gestion va l'autoriser à rester à une fréquence plus élevée. AMD, Nvidia et leurs partenaires ont ainsi l'opportunité de fournir à la presse les meilleurs échantillons, issus d'un tri plus ou moins sélectif de la production. Un détail qui, comme vous pouvez vous en douter, ne leur a pas échappé.

Petite variante de cet abus, la fréquence maximale variable spécifique aux GeForce. Sur le plan technique, Nvidia a décidé depuis les GTX 600 de ne plus spécifier une fréquence maximale mais uniquement une tension maximale. La fréquence GPU évoluant différemment par rapport à la tension pour chaque échantillon, la fréquence maximale devient variable, tout comme les performances maximales. Un tri sélectif permet de gagner quelques points par rapport à la moyenne, d'autant plus si les tests sont brefs et favorisent l'application en pratique de la fréquence maximale.

Enfin, la gestion du GPU et de ses limites est devenue une des variables d'ajustement compétitif les plus importantes, qui peut être actionnée en cas de déficit de performances. Par exemple, si le fabricant de la carte graphique X estime que les limites devraient être de 85 °C et de 250W mais constate que dans ces conditions il n'est pas possible lutter face à la carte graphique Y, après réflexion il pourra en conclure que finalement 95 °C et 300W c'est en fait très bien.

Si AMD et Nvidia en jouent, il en va de même pour leurs partenaires. Ainsi lorsqu'un fabricant nous demande comment sa carte se comporte face au même modèle de la concurrence et que nous l'informons que c'est un petit peu moins bien sur tel ou tel point, il n'est pas rare d'obtenir une réponse du type "Attendez, ne publiez pas le test comme ça, je vous envoie un BIOS dont vous me direz des nouvelles ! Top performances ! Bon par contre je vous demande de ne pas l'utiliser pour les mesures de bruit, cet aspect n'a pas été optimisé, mais ce sera nickel quand il sera rendu public, c'est promis."

Les paramètres de gestion d'une carte graphique représentent un compromis global qui lie entre eux différents aspects de son comportement tels que les performances, les nuisances sonores, la température du GPU et des autres composants, la consommation… Si un point est modifié, cela ne peut se faire sans conséquence sur au moins un autre point. Si les performances augmentent, les nuisances sonores et/ou la température GPU aussi. Si les nuisances sonores baissent, soit la température augmente, soit les performances baissent. Etc.

Quelle solution pour la presse technique ?

La parade pourrait être pour la presse de se fournir exclusivement dans le commerce et de tester à chaque fois plusieurs échantillons (3 ? 5 ? 10 ? de lots différents ?). Que ce soit en termes de coûts, s'il faut systématiquement acheter plusieurs cartes, ou de temps, s'il faut en tester de nombreux exemplaires, ce n'est malheureusement pas réaliste. Nous essayons ainsi pour notre part de prendre en compte autant que possible le comportement du système de gestion dans nos protocoles de tests, nos analyses et nos conclusions. Cela implique de prendre le temps de le comprendre, ce qui n'est pas toujours évident, AMD et Nvidia refusant en général de communiquer à son sujet au-delà de quelques détails grossiers, dans certains cas incorrects puisque dictés par des impératifs de communication qui n'ont que faire de la réalité technique.

Nous effectuons dès lors de très nombreux tests pour en savoir plus et, à chaque lancement de GPU, nous harcelons autant AMD que Nvidia pour plus de clarté à ce sujet, grignotant par-ci par-là un petit détail à force d'insistance ou lorsqu'ils se retrouvent face à des données qui pourraient leur causer du tort. En cas de doute ou si nous avons des indices qui pointent vers des performances potentiellement surévaluées à la suite d'un tri très sélectif, nous faisons en sorte de nous pencher sur des exemplaires issus du commerce.

Des freins bienvenus

Malgré toutes ces possibilités d'abus qui compliquent le travail des testeurs (à moins de faire en sorte de fermer les yeux sur cette problématique), la gestion de la consommation avancée des GPU, mise en avant en tant que "turbo", est globalement une très bonne chose pour l'utilisateur.

Un utilisateur qui peut cependant avoir l'impression, à tort, qu'il est anormal d'observer des baisses de fréquence significatives lors de sessions de jeu. Cette incompréhension est à chercher du côté de la communication autour de ces technologies : il ne s'agit pas vraiment de turbos mais plutôt de freins. Une réalité moins facile à vendre sur le plan commercial, qui explique en grande partie pourquoi AMD et Nvidia se contorsionnent pour éviter de décrire trop clairement leurs systèmes de gestion des GPU.

Grossièrement, que ce soit GPU Boost chez Nvidia ou Powertune chez AMD, l'approche est la même : le GPU part de sa fréquence maximale et freine si nécessaire pour rester dans les clous en terme de sécurité, de fiabilité et de nuisances.

La baisse de la fréquence GPU, ou le "throttling" en anglais, n'est pas une anomalie. C'est un phénomène voulu qui, en fin de compte, autorise plus de performances avec une limitation des nuisances. Ceci étant dit, un problème ou un défaut de conception peut causer une baisse de fréquence plus importante et, au contraire, un effort supplémentaire des fabricants de cartes graphiques au niveau de la capacité du ventirad et de l'étage d'alimentation peut limiter cette baisse.

AMD et Nvidia ont la possibilité de mettre en place une fréquence limite, en général appelée fréquence de base pour renforcer "l'effet turbo", sous laquelle ils estiment qu'il faut éviter de descendre. Pour ne pas trop pénaliser les performances ils peuvent alors prévoir leurs cartes graphiques pour accepter automatiquement des compromis différents, que ce soit au niveau de la fiabilité ou des nuisances. Par exemple, si les GeForce sont descendues jusqu'à un certain niveau de fréquence, Nvidia laisse la température du GPU s'apprécier au-delà de la limite fixée. Une approche qui permet de garantir un certain niveau de performances dans un maximum de situations (pas dans toutes, la fréquence GPU reprend sa chute au-delà d'un nouveau seuil).

GPU Boost en pratique

Comme les précédentes GeForce GTX, la GTX 1080 exploite une technologie de turbo et de contrôle de ses paramètres vitaux : GPU Boost. Il fonctionne de la sorte dès qu'une application est lancée :

- Le GPU est poussé à son couple tension et fréquence maximal

- Un système de monitoring s'enclenche et contrôle le GPU toutes les 100ms

- Si la consommation totale de la carte atteint la limite, tension et fréquence sont réduites par 6.25 mV/13MHz

- Le ventilateur accélère lentement jusqu'à 82 °C

- Si le GPU atteint 83 °C, tension et fréquence sont réduites jusqu'à revenir à 82 °C

- Si le GPU est descendu à sa fréquence de base, la température peut monter au-delà de 82 °C

- Si le GPU atteint 92 °C, la fréquence est fortement réduite et le ventilateur monte à 100%

- Si le GPU atteint 94 °C, la carte se coupe

Lorsque les GPU GeForce sont produits par Nvidia, ils sont testés à un moment donné pour vérifier s'ils sont totalement ou partiellement fonctionnels ainsi que pour leur attribuer différents paramètres tels que les fréquences et tensions. Nvidia ne donne aucun détail à ce niveau, mais nous pouvons supposer que les tests effectuées permettent de déterminer quelques couples de tensions et fréquences, avec une marge de sécurité suffisante pour assurer la fiabilité. Ces paramètres sont inscrits dans le GPU.

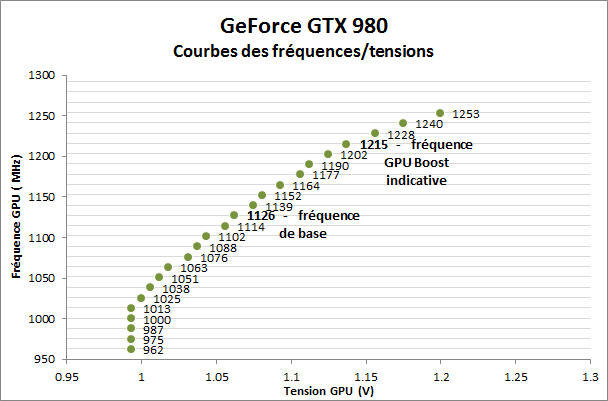

Ensuite, d'autres paramètres sont spécifiés dans le BIOS, c'est le cas de la fréquence de base et de la tension GPU maximale. Le pilote exploite ces quelques paramètres pour en extrapoler une courbe de couples tension et fréquence qui sera utilisée par GPU Boost pour moduler la consommation et les performances. Voici à quoi ressemble cette courbe, avec en exemple une GTX 980, mais c'est le même principe avec la GTX 1080, simplement avec une courbe plus longue compte tenu de sa fréquence élevée :

Nous pouvons y observer une vingtaine de valeurs entre lesquelles les performances vont évoluer. Nous avons fait ressortir la fréquence de base et la fréquence GPU Boost officielle. Vous remarquerez que celle-ci n'est pas la fréquence maximale. Il s'agit en fait d'une valeur factice spécifiée dans le BIOS de manière à pouvoir être affichée par exemple dans GPU-Z. Elle n'est exploitée ni pour définir la courbe, ni pour définir le comportement de GPU Boost.

Au bas de la courbe, il y a une tension minimale sous laquelle le GPU ne descend jamais. La fréquence peut continuer à chuter, mais la tension reste alors figée.

La fréquence maximale est déterminée par le point correspondant à la tension maximale autorisée dans le bios, elle est de 1.2125V pour l'ensemble des GTX 980/970 et de +/- 1.1V pour les GTX 1080. Il faut cependant noter qu'il n'y a pas de fréquence spécifiée à chaque niveau de tension, notamment dans le haut de la courbe, c'est alors la valeur inférieure la plus proche qui fait officie de limite pratique. La tension maximale du GPU peut ainsi varier entre 1.9V et 1.2125V suivant l'échantillon. La couple le plus élevé pour notre exemplaire est de 1.2V et 1253 MHz, sa courbe ne dispose pas de fréquence spécifiée pour 1.20625V et 1.2125V.

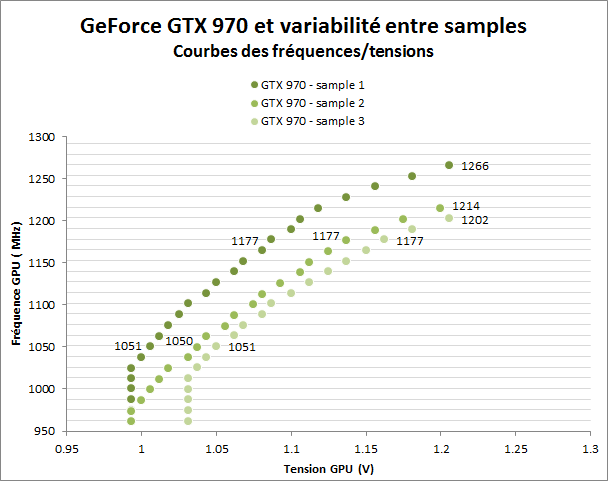

La courbe étant générée sur base de paramètres spécifiques à chaque GPU, elle est différente pour chacun d'entre eux. Voici par exemple les courbes de 3 GeForce GTX 970 cadencées aux mêmes fréquences de référence :

Tensions minimales, tensions maximales et fréquences maximales varient. Le premier échantillon est clairement le meilleur, il a besoin d'une tension inférieure pour chaque niveau de fréquence. Alors que les 3 cartes sont annoncées avec une même fréquence GPU Boost de 1177 MHz, un échantillon culmine en réalité à 1202 MHz, un autre à 1214 MHz et le meilleur à 1266 MHz. Un écart de 5% qui pourra se retrouver dans les performances en jeu.

A noter qu'il est très bien visible sur ce second graphe que les derniers paliers de fréquence sont atteints avec un bond grandissant au niveau de la tension. Ils entraînent ainsi une augmentation de la consommation toujours plus importante, ce qui explique pourquoi ils peuvent être difficiles à maintenir lorsque les limites de consommation et de température sont strictes.

Comment cette courbe est-elle affectée par l'overclocking ?

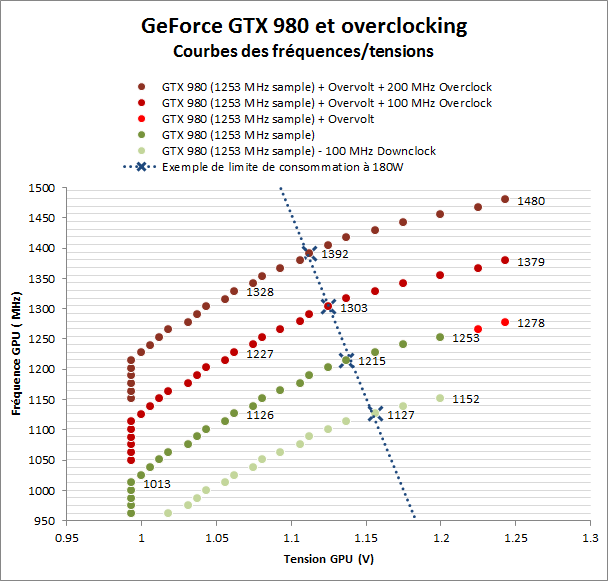

Un graphique pour résumer le tout :

Tout d'abord, intéressons-nous brièvement à la fonction d'overvolting proposée par Nvidia. Elle consister à autoriser une tension maximale plus élevée et revient donc à prolonger légèrement la courbe des fréquences, si des fréquences sont disponibles pour les nouvelles tensions. Notre GTX 980 gagne ainsi deux paliers et peut passer de 1253 à 1278 MHz avec une tension de 1.2425V. Certaines cartes par contre ne profiteront d'aucun gain si elles ne disposent pas sur leur courbe de fréquences associées à ces tensions plus élevées.

L'overclocking du GPU consiste en un offset ou biais appliqué à la totalité de la courbe des fréquences d'origine. Chaque palier progresse par exemple de 100 ou 200 MHz et pas seulement la fréquence maximale. Cela signifie que l'overclocking a de l'intérêt même quand les limites empêchent le GPU de tourner à sa fréquence maximale. Un offset positif revient à réduire la tension GPU pour chaque niveau de fréquence et augmente le rendement énergétique. A l'inverse un offset négatif impacte le rendement énergétique et n'a donc aucun intérêt à être utilisé.

Pour illustrer cela, nous avons relevé la fréquence à laquelle cette GTX 980 se stabilise lorsqu'une charge stable de 180W est exécutée avec ces différents offsets. Si nous appliquons un offset de 100 MHz, la fréquence observée passe de 1215 à 1303 MHz, soit un net gain à consommation égale qui profitera au rendement énergétique en plus de booster les performances.

Quelques détails de plus

Nous n'avons pas pu en déterminer le mécanisme exact, mais il existe quelques restrictions de plus au niveau de la gestion des fréquences et tensions. D'après nos observations, GPU Boost empêche l'accès aux derniers niveaux de tension et de fréquences lorsque la température et/ou la charge atteignent certaines valeurs inférieures aux limites de température et de consommation classiques.

Il s'agit pour Nvidia d'une part d'éviter autant que possible le fonctionnement du GPU à une tension et à une température élevé, deux éléments qui ne font pas bon ménage puisqu'ils impactent la fiabilité des puces. Nvidia semble cependant être extrêmement conservateur sur ce point. D'autre part cette approche permet de freiner la montée en température du GPU et donc de lisser plus facilement la courbe de ventilation.

Par exemple, si une carte donnée dispose d'une fréquence à un niveau de tension élevé, mais que la charge exécutée est lourde alors que la température GPU monte au-delà de 75 °C, cette fréquence ne sera pas exploitable. Le GPU redescendra au niveau inférieur, avec un impact mineur sur les performances.

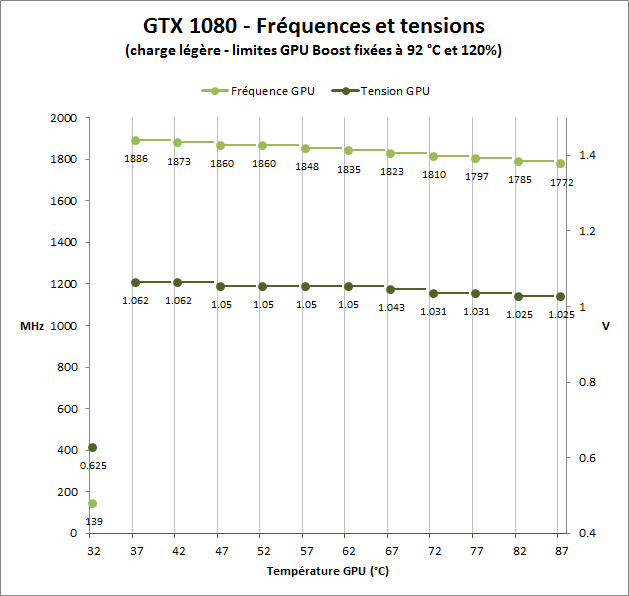

Ce phénomène était limité à un ou deux paliers sur GTX 900, mais il prend de l'ampleur sur la GeForce GTX 1080. Voici ce que nous avons pu observer en poussant ses limites de consommation et de températures à leur valeur maximale pour qu'elles n'aient pas d'influence :

A notre grand étonnement, Nvidia applique cette stratégie dès 37 °C ! Nous avons du mal à comprendre pourquoi Nvidia enclenche cet algorithme à un niveau de température si bas sur cette nouvelle GeForce, mais c'est bel et bien le cas.

Pour que le GPU puisse atteindre sa fréquence maximale, en plus de ne dépasser aucune limite, il doit donc rester sous les 37 °C. Ensuite, tous les 5 °C, il redescend d'un cran supplémentaire. Avec un système de refroidissement calibré pour stabiliser la fréquence GPU à 82 °C, notre échantillon de GTX 180 Founders Edition ne pourra donc jamais profiter de sa fréquence maximale de 1886 MHz et sera toujours limité au mieux à 1797 ou 1785 MHz.

Comment est mesurée la consommation ?

Avec GPU Boost, Nvidia ne protège pas le GPU de manière directe comme le fait AMD en mesurant sa consommation. Nvidia le fait de manière indirecte en mesurant la consommation totale de la carte graphique. C'est moins précis au niveau du GPU (la mesure englobe la consommation des autres composants, les pertes liées à l'étage d'alimentation etc.), mais cela a l'avantage de pouvoir protéger la carte dans son ensemble et de s'assurer que les normes d'alimentation soient bien respectées.

Les GeForce GTX sont équipées d'un petit circuit de mesure de l'intensité du courant pour chacune des entrées 12V présentes sur le PCB. Typiquement :

- Ligne 12V du bus PCI Express

- Ligne 12V du connecteur d'alimentation 1

- Ligne 12V du connecteur d'alimentation 2

La consommation en 3.3V est ignorée, mais elle n'est pas très importante au vu de la consommation totale de ces cartes (1 à 5W).

Le BIOS des GeForce GTX contient une limite de consommation globale (la somme des 3 lignes 12V) ainsi qu'une limite pour chacune des lignes 12V. Typiquement, ces dernières sont fixées à hauteur des normes PCI Express : 66W via le bus, 75W pour un connecteur 6 broches et 150W pour un connecteur 8 broches. Un taux d'utilisation est calculé pour chaque ligne 12V ainsi que par rapport à la limite de consommation globale.

Les outils de monitoring dérivés de RivaTuner reportent une valeur de consommation en % qui correspond au plus élevé des 4 taux de consommation, sans qu'il soit possible de savoir duquel il s'agit. Par exemple une carte limitée parce qu'elle affiche 100% de consommation peut en réalité consommer relativement peu, mais tirer trop de courant au niveau du bus. En général, si les étages d'alimentation sont bien conçus, avec une forte charge, c'est toujours le taux de consommation global qui est le plus élevé. C'est presque toujours le cas sur les cartes de référence Nvidia.

Le taux affiché par GPU-Z est par contre toujours le taux de consommation global de la carte graphique. Nvidia Inspector de son côté reporte les deux valeurs : le taux de consommation global (nommé GPU Power !?!) et le taux le plus élevé des quatre (nommé Board Power ?!?).

Que peuvent personnaliser les fabricants ?

Les partenaires de Nvidia ont la possibilité de personnaliser différents paramètres à commencer bien entendu par les fréquences.

Ils ont la possibilité de définir ou pas une marge de manoeuvre pour la fonction d'overvolting GPU Boost en spécifiant une tension maximale à cet effet. Il est possible de proposer une augmentation classique de la tension GPU, mais les fabricants doivent le faire en dehors du cadre défini par Nvidia, généralement via des composants additionnels.

Ils peuvent également revoir à la hausse la limite de consommation pour donner plus de marge de manoeuvre au GPU et s'assurer qu'il reste à une fréquence élevée même en charge très lourde. Ils modifient alors la limite totale, mais peuvent également augmenter les limites de chaque ligne 12V s'ils le souhaitent. Ils peuvent modifier au passage la marge de manoeuvre donnée à l'utilisateur pour augmenter la consommation maximale. Nvidia autorise par exemple de relever la limite globale de 25% sur la GTX 980 de référence, alors que certains partenaires se contentent de 6%.

Ils n'ont par contre pas le droit de modifier la limite de température fixée par Nvidia, ni la marge de manoeuvre donnée à l'utilisateur pour relever la température maximale. Pas question donc pour un fabricant de passer la limite à 90 °C pour éviter que le GPU ne voie sa fréquence réduite en chauffant. Nvidia nous a indiqué que cette mesure était destinée à garantir la durée de vie des GPU et à pousser ses partenaires à prendre le problème dans l'autre sens : installer des systèmes de refroidissement performants. Maintenir le GPU à moins de 80 °C, voire moins, permet de maintenir une fréquence turbo plus élevée.

Enfin, les fabricants doivent bien entendu calibrer la courbe de ventilation en faisant en sorte d'opter pour un bon compromis en termes de température GPU et de nuisances sonores. A ce petit jeu, tous ne sont pas aussi habiles, certains peuvent faire des choix radicaux qui ne sont pas des plus adaptés. Par exemple en faisant exploser les nuisances sonores pour éviter de dépasser 60 °C.

A noter que les partenaires ne sont pas les seuls responsables des paramètres de leurs cartes. Ils doivent proposer ces paramètres à Nvidia, qui doit signer les BIOS. C'est Nvidia qui a le dernier mot et peut les adapter si ses ingénieurs l'estiment nécessaire. Pour Nvidia il s'agit d'assurer une qualité cohérente pour l'ensemble des GeForce même si certains fabricants ne sont pas toujours d'accord avec d'éventuelles restrictions forcées sur leurs produits et estiment que certaines marques sont privilégiées lorsque ces décisions sont prises.

2 - GP104 : 7.2 milliards de transistors en 16 nm

3 - Pascal et Async Compute : du mieux ?

4 - Pascal et le SMPE pour la VR et le surround

5 - SLI amélioré, Fast Sync, Moteur vidéo HDR

6 - Spécifications et Direct3D 12

7 - La GeForce GTX 1080 Founders Edition

8 - Protocole de test

9 - Performances théoriques : pixels

10 - Performances théoriques : géométrie

11 - Fermi vs Kepler vs Maxwell vs Pascal

12 - Consommation, efficacité énergétique

13 - Nuisances sonores, températures, photos IR

14 - Benchmark : 3DMark Fire Strike

15 - Benchmark : Anno 2205

16 - Benchmark : Ashes of the Singularity

17 - Benchmark : Battlefield 4

18 - Benchmark : Crysis 3

20 - Benchmark : DOOM

21 - Benchmark : Dying Light

22 - Benchmark : Evolve

23 - Benchmark : Fallout 4

24 - Benchmark : Far Cry Primal

25 - Benchmark : Grand Theft Auto V

26 - Benchmark : Hitman

27 - Benchmark : Project Cars

28 - Benchmark : Rise of the Tomb Raider

29 - Benchmark : Star Wars Battlefront

30 - Benchmark : The Division

31 - Benchmark : The Witcher 3 Wild Hunt

32 - Récapitulatif des performances

33 - GPU Boost : pourquoi ? comment ?

34 - Overclocking : 2 GHz à portée de click

35 - Conclusion

Contenus relatifs

- [+] 26/10: Nvidia pré-annonce les GeForce GTX ...

- [+] 17/10: Destiny 2 de retour chez Nvidia

- [+] 27/09: Nvidia offre Middle Earth: Shadow o...

- [+] 22/08: Destiny 2 de nouveau offert chez Nv...

- [+] 14/06: Destiny 2 pour les GTX 1080 et 1080...

- [+] 31/05: Computex: Nvidia annonce les GTX 10...

- [+] 29/05: Desktop, mobile et en box : la GTX ...

- [+] 25/04: Les GTX 1080 et 1060 ''OC'' disponi...

- [+] 28/03: For Honor ou Ghost Recon en bundle ...

- [+] 01/03: GDC: Nvidia va proposer des GTX 108...