Les contenus liés aux tags Nvidia et GK110

Afficher sous forme de : Titre | FluxUne GeForce GK110 fin février ?

GK110 : Nvidia lance les Tesla K20 et K20X

Tesla K20 et GK110 : les specs finales ?

CUDA 5.0 final est disponible

GTC: Plus de détails sur le GK110

Nvidia Quadro K6000: GK110 complet et 12 Go

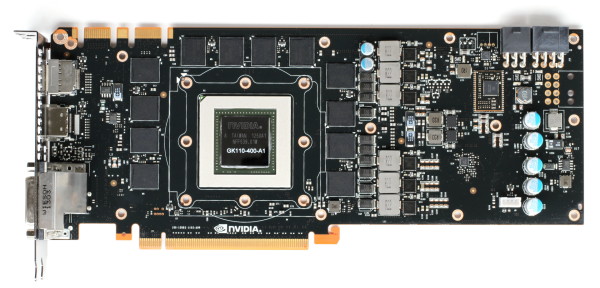

Lorsque Nvidia a dévoilé la famille de Quadro Kepler, en mars dernier, nous avions été étonnés de ne pas y retrouver de Quadro K6000 architecturée autour du GPU GK110, le plus complexe de cette génération. Elle était cependant bien au programme et Nvidia profite du SIGGRAPH pour l'officialiser.

La Quadro K6000 est le premier produit à embarquer un GPU GK110 complet, c'est-à-dire sans unités de calcul désactivées. Rappelons que les GPU Kepler sont conçus sur base d'un assemblage de SMX, des blocs de 192 unités de calcul, et que pour faciliter la production de ce monstre de 7.1 milliards de transistors, Nvidia en désactive 1 à 3 suivant les produits :

GeForce GTX 780 : 12 SMX

GeForce GTX Titan : 14 SMX

Tesla K20 : 13 SMX

Tesla K20X : 14 SMX

Quadro K6000 : 15 SMX

Avec 15 SMX, et donc 2880 unités de calcul, qui tournent à 900 MHz, la Quadro K6000 affiche une puissance de calcul de 5.2 Tflops en simple précision soit une progression d'un peu plus de 30% par rapport à l'accélérateur Tesla K20X. Et cela en réduisant le TDP de 235W à 225W, probablement à travers une technique de contrôle de la consommation dérivée du GPU Boost des GeForce. Toutes les fonctionnalités introduites par les Tesla K20 (Hyper Q, Dynamic Parallelism, calcul double précision rapide, ECC) sont bien entendu au programme puisque les Quadro représentent un superset des accélérateurs dédiés au calcul massivement parallèle, avec en plus toute la partie logicielle et certification liée au graphisme professionnel.

Particularité de cette Quadro K6000, elle embarque pas moins de 12 Go de mémoire GDDR5 (1.5 GHz) interfacés en 384-bit, pour une bande passante qui atteint 268 Gio/s. Cette quantité importante de mémoire est mise en avant par Nvidia comme un des points forts de cette nouvelle Quadro et est sans aucun doute la raison de son arrivée tardive puisque pour la mettre en place Nvidia a dû attendre la disponibilité d'une GDDR5 haute densité (4 Gbits – 512 Mo par puce) dont la production en volume vient de débuter.

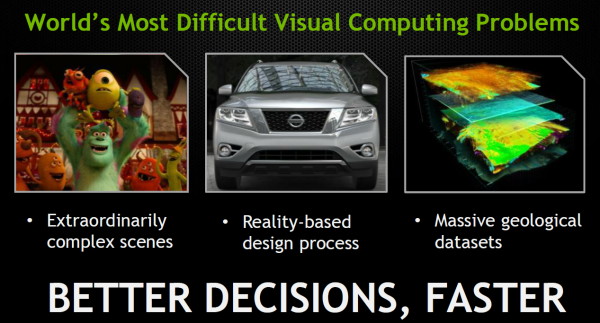

Par rapport à l'ancien haut de gamme, la Quadro 6000, l'évolution apportée par la Quadro K6000 est conséquente : bande passante doublée, quantité de mémoire doublée, puissance de calcul simple précision quintuplée et fonctionnalités plus avancées pour le GPU computing. Parmi les usages types visés par cette Quadro K6000, nous retrouvons la prévisualisation en temps-réel (qui se généralise progressivement avec un niveau de qualité qui s'approche du rendu final) ou encore le traitement de données énormes comme c'est le cas pour l'exploration des sols. Nul doute que les logiciels qui sont limités par la composante graphique apprécieront l'évolution, à condition bien entendu d'y mettre le prix.

Avec un écosystème logiciel reconnu et des spécifications qui dépassent en tout point la FirePro W9000 concurrente, Nvidia n'a pas réellement de pression au niveau tarifaire. Si Nvidia ne communique pas encore le tarif, qui sera probablement fixé à l'approche de la disponibilité prévue pour la rentrée, nous pouvons l'estimer à 5000 ou 6000€.

Dossier : Nvidia GeForce GTX 780 en test : GK110 pour tous (ou presque)

Nvidia inaugure les GeForce 700 avec la GTX 780 qui n'est autre qu'une GeForce GTX Titan aux spécifications revues à la baisse. De quoi démocratiser quelque peu le plus gros GPU Kepler ?

[+] Lire la suite

GTC: CUDA on ARM: Tegra 3 + Tesla K20

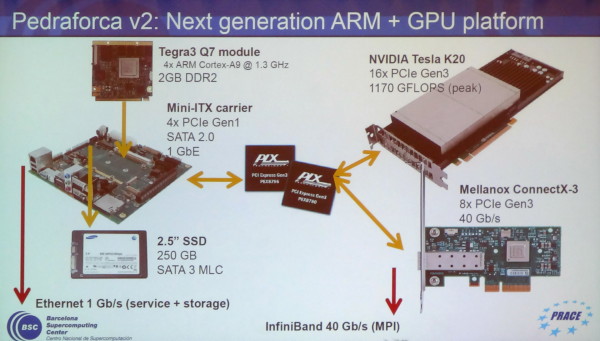

En plus des plateformes CUDA on ARM destinées à simuler de futurs SoC que ce soit pour une utilisation de type périphérique mobile grand public ou de type micro-serveur, des développements se font également autour d'accélérateurs très puissants tels que les Tesla K20.

C'est le cas chez l'européen PRACE qui développe des systèmes dédiés au supercomputing et s'intéresse à CUDA on ARM depuis quelques temps. En collaboration avec le Barcelona Supercomputing Center, PRACE est en train de mettre au point une plateforme ARM équipée en GK110 : Pedraforca v2. Celle-ci est composée d'une carte mini-ITX sur laquelle prend place un module Q7 Tegra 3 dont 4 des lignes PCI Express 2.0 sont connectées à un switch PLX PCI Express 3.0 sur lequel vont venir se greffer un accélérateur Tesla K20 et une carte contrôleur InfiniBand 40 Gbps.

Cette plateforme a la particularité de ne pas rechercher la complémentarité entre les cores CPU et GPU. Grossièrement, le but est d'utiliser le SoC ARM uniquement pour activer un système CUDA plus ou moins indépendant. C'est la raison pour laquelle le Tesla K20 est associé à un contrôleur InfiniBand sur un même switch PCI Express 3.0 : ils peuvent ainsi communiquer très rapidement avec les accélérateurs d'autres nœuds en ignorant autant que possible la communication avec les SoC et leurs mémoires.

Les développeurs de Pedraforca v2 sont bien conscients qu'une telle approche n'est pas une solution de remplacement générale à un système CUDA classique et se contentera de répondre avantageusement à un sous-ensemble de problématiques : si un problème massivement parallèle peut être résolu sans CPU, autant réduire l'encombrement et la consommation de celui-ci.

Une telle solution permet par ailleurs de simuler le comportement de futurs GPU haut de gamme qui pourraient intégrer un ou plusieurs cores ARMv8 Denver pour gagner en indépendance. De quoi commencer à préparer des algorithmes qui leur seront adaptés ?

Dossier : Nvidia GeForce GTX Titan en test : big Kepler débarque enfin !

Le GK110, ou big Kepler et ses 7.1 milliards de transistors, débarque dans la GeForce GTX Titan avec laquelle Nvidia vise la première place, sans faire exploser la consommation et, mieux, en réduisant les nuisances sonores.

[+] Lire la suite

Nvidia dévoile la GeForce GTX Titan

C'est ce mardi que Nvidia a finalement décidé de lever le voile sur la GeForce GTX Titan, l'incarnation grand public du GPU GK110 présenté en mai dernier et commercialisé en tant que Tesla K20 / K20X depuis quelques mois.

Notez qu'il n'y aura pas de mesures de performances et autres tests aujourd'hui mais seulement une présentation de la carte, Nvidia ayant opté pour un lancement en deux temps. Le test complet est prévu pour jeudi. Nous sommes loin d'être fans de cette approche qui nous met dans une position ridicule puisque nous avons déjà testé la carte… et que ces tests, dont nous ne pouvons pas encore vous parler, apportent des éléments d'information essentiels par rapport à la description officielle.

Officiellement ce décalage est destiné à laisser plus de temps pour les tests, les cartes et pilotes ayant été reçus plus tard que prévu, et le constructeur met en avant la difficulté de décaler le lancement de ce jour du fait des implications chez ses partenaires. D'un autre côté nous pouvons supposer qu'un tel lancement en deux temps permet à Nvidia de faire plus de bruit et de mieux contrôler la première impression que vous aurez de la carte...

Quelles que soient les raison de cette approche, elle nous dérange puisqu'elle ne nous permet pas de présenter les choses aux mieux de nos connaissances. Nous éviterons donc de donner le moindre avis aujourd'hui et nous vous conseillerons vivement d'attendre les tests complets pour former votre avis, et si la carte vous intéresse, de ne pas sauter aveuglément sur d'éventuelles précommandes.

La GeForce GTX Titan reprend un design similaire à celui de la GeForce GTX 690 : des matériaux de qualité pour une finition exemplaire. Le tarif est équivalent lui aussi, à près de 1000 € TTC. Cela ne veut pas dire que les deux cartes sont équivalentes en termes de performances, la GTX 690 va garder la tête, mais que Nvidia estime que le mono-GPU a une valeur relative plus élevée. Vous noterez que la carte ne prend pas place à l'intérieur de la gamme actuelle, d'où son nom différent, ce qui indique probablement que la GTX Titan restera supérieure à la probable future GeForce GTX 780.

Le GK110 embarqué, 7.1 milliards de transistors et 569 mm² en 28nm, est partiellement castré puisqu'il se contente de 14 SMX actifs sur les 15 qu'il intègre, soit 2688 unités de calcul sur 2880, un choix dicté par les impératifs de production pour une puce aussi large. Il conserve son bus mémoire de 384-bit qui s'interface à pas moins de 6 Go de GDDR5 cadencée à 1503 MHz, de quoi offrir un gain de 50% au niveau de la bande passante par rapport à la GeForce GTX 680.

La fréquence de base du GPU est de 837 MHz mais il dispose d'un turbo, dénommé GPU Boost. Officiellement il est annoncé à 876 MHz, mais comme pour les autres cartes de la génération Kepler, il est en réalité variable d'un exemplaire à l'autre. Nvidia indique que la fréquence du plus mauvais exemplaire dépasse 876 MHz mais refuse de communiquer le chiffre exact. Nous supposerons donc qu'il s'agit de 889 MHz, le premier pallier au-dessus de la fréquence annoncée.

Avec certains échantillons qui peuvent dépasser le GHz, la marge de variation peut ainsi être énorme ! Entre un bon échantillon de GTX 680 et un mauvais de Titan, la puissance de calcul théorique va progresser de 30% alors qu'entre un mauvais échantillon de GTX 680 et un très bon de Titan, elle pourra atteindre 75%. C'est le fillrate qui progresse le moins, puisqu'il ne passe "que" de 32 pixels par cycles à 40 pixels par cycle (bien qu'équipé de 48 ROP, le GK110 ne dispose que de 5 rasterizers capables chacun de générer 8 pixels).

Nvidia a voulu démontrer qu'il était possible d'exploiter un GPU aussi monstrueux que le GK110 sans faire exploser les nuisances en termes de bruit et de température. Ce dernier point est un élément essentiel pour la GeForce GTX Titan. Nvidia rappelle que températures et tensions élevées ne font pas bon ménage quand il s'agit de garantir la durée de vie d'un composant, ce qui concerne visiblement particulièrement le GK110. Ainsi, la limite de température visée par GPU Boost, soit la limite au-delà de laquelle le turbo ne peut pas s'enclencher passe de 95 °C sur une GTX 680 à 80°C seulement. La limite de consommation pour le turbo passe par contre de 170 à 235W, alors que le TDP passe de 195 à 250W, une valeur identique à celle de la Radeon HD 7970.

En pratique la limite de 95°C de la GTX 680 n'était que rarement un facteur limitant, et elle est d'ailleurs masquée par Nvidia. Avec 80°C pour la GTX Titan, la donne change et la température pourra avoir un aspect déterminant sur les performances. Cette limite de 80°C devient d'ailleurs un paramètre d'overclocking destiné à prendre place dans les utilitaires tels que Precision X.

Petite surprise, Nvidia a décidé de ne pas bloquer l'accès aux unités de calcul double précision du GK110. Un mode spécial doit cependant être activé dans les pilotes et précisons qu'il fixe la fréquence GPU à 850 MHz. La GTX Titan est ainsi capable de les traiter avec un débit équivalent à un tiers du débit en simple précision, contre 1/24ème sur les GTX 600. Rappelons qu'en dehors de la double précision, l'architecture du GK110 est identique à celle des autres GPU Kepler. Il a été pensé en priorité pour offrir plus de performances à tous les niveaux et ensuite à être polyvalent dans les domaines professionnels, exactement comme pour les GPU GT200, GF100, Cayman et Tahiti.

Rendez-vous jeudi pour un test complet de la GeForce GTX Titan !