Les contenus liés aux tags Nvidia et GTC

Afficher sous forme de : Titre | FluxGTC: 5W Pour Tegra 4 et 1W pour Tegra 4i ?

GTC: GRID VCA: Nvidia et la virtualisation

GTC: FaceWorks: rendu de visage réaliste

GTC: CUDA on ARM: Tegra 3 + Tesla K20

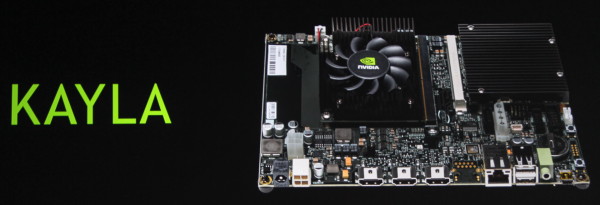

GTC: CUDA on ARM: Kayla, Tegra 3 et GK208

GTC: Tegra: Kit Jetson TK1, SoC Erista en 2015

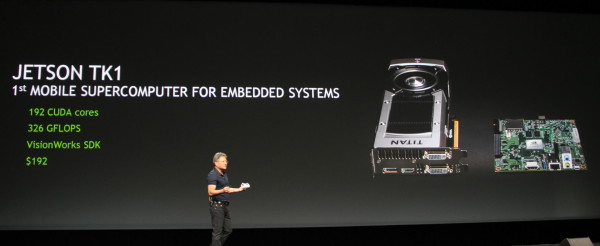

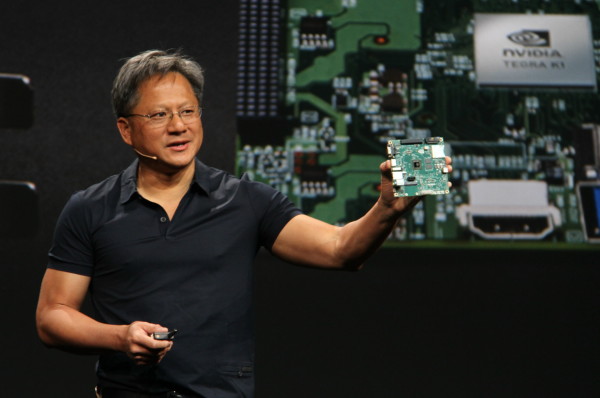

L'intégration d'un GPU Kepler dans le SoC Tegra K1 lui permet de débarquer dans l'univers de CUDA et du calcul massivement parallèle. Avec la plateforme Kayla annoncée l'an passé, Nvidia avait clairement annoncé la couleur et son ambition d'amener CUDA dans le monde de l'embarqué.

La version finale de cette initiative se nomme Jetson TK1 et correspond à un kit de développement articulé autour du SoC Tegra K1 et de son GPU qui propose 192 unités de calcul FMA 32-bit pour une puissance de calcul de 326 Gflops. Nvidia ne précise pas de quelle version du Tegra K1 il s'agit, mais nous pouvons supposer qu'il est question de la v1, qui repose sur des cores Cortex-A15, et que la v2 équipée de 2 cores Denver ARMv8 ne viendra que plus tard.

Cette plateforme intègre 2 Go de mémoire, de l'USB 3.0, du HDMI 1.4, du Gigabit Ethernet, de l'audio, du SATA, du mini-PCIe et un emplacement pour carte SD. Notez qu'en pratique un ventirad est placé sur le SoC, mais il était absent des photos officielles et de l'échantillon présenté lors de la keynote.

De quoi proposer un kit de développement relativement polyvalent et potentiellement ouvrir de nouvelles portes à Nvidia dans l'embarqué, principalement pour des solutions mobiles, compactes et/ou peu gourmandes. Ce kit Jetson K1 sera disponible sous peu (il est en précommande à partir de ce jour) à un tarif de 192$. En Europe, il sera distribué par Zotac, SECO et Avionic Design.

Comme d'habitude, le passage Tegra de la keynote principale de GTC a été l'occasion pour le CEO de Nvidia de présenter une roadmap mise à jour :

Nous n'apprendrons cependant que très peu de détails si ce n'est que le prochain SoC Tegra, qui succèdera au Tegra K1 (nom de code Logan), intégrera un GPU Maxwell, augmentera le rendement énergétique d'un peu plus de 50% et se prénommera Erista. Encore une fois il s'agit d'une référence aux superhéros de l'univers Marvel puisque Erista y représente le fils de Logan, alias Wolverine. A voir s'il disposera également de quelques pouvoirs…

Tout comme pour le GPU Volta, le SoC Parker, annoncé l'an passé par Nvidia, a été repoussé et Erista est une solution intermédiaire. Parker était pour rappel prévu pour 2015 avec un GPU Maxwell, des cores Denver et l'exploitation d'un procédé de fabrication à base de FinFET. Nous ne savons pas à l'heure actuelle quelle est la différence entre ce le projet Parker et ce nouveau projet Erista.

GTC: GeForce GTX Titan Z, 3000$, bi-GK110 en avril

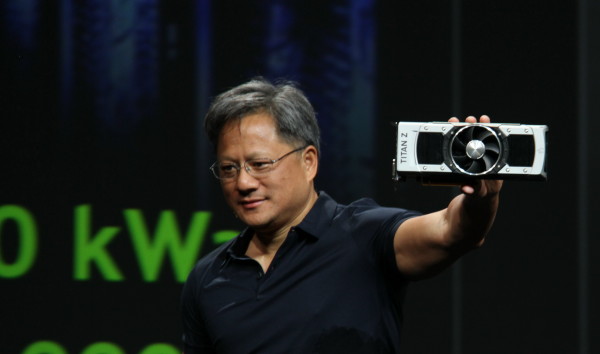

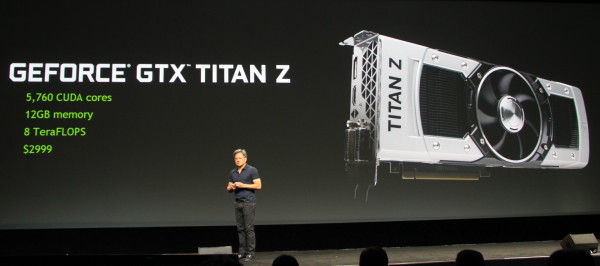

Nvidia profite de la GTC pour annoncer la GeForce GTX Titan Z. Le fabricant explique avoir été surpris par le succès des GeForce GTX Titan et GTX Titan Black, malgré leur tarif de 1000$ / 1000€, autant auprès des joueurs (fortunés) qu'auprès des amateurs de GPU computing qui ont besoin d'un maximum de puissance de calcul mais ne désirent pas investir dans des cartes Quadro ou Tesla. Dans ce cas, les GeForce GTX Titan s'intercalent ainsi assez bien entre les GeForce classiques et les cartes professionnelles.

Nvidia retente l'expérience avec la GeForce GTX Titan Z qui reprend le principe des cartes GTX Titan précédentes mais passe au bi-GPU. Elle est équipée de 2 GPU GK110 totalement fonctionnels pour un total de 5760 unités de calcul FMA 32-bit et 1920 unités de calcul FMA 64-bit. De quoi atteindre une puissance de calcul de 8 Tflops en simple précision. Chaque GPU dispose de sa propre mémoire de 6 Go interfacée en 384-bit et le système de refroidissement reprend le design haut de gamme cher à la marque. Il a cependant été quelque peu musclé pour l'occasion et semble passer de 2 à 2.5 slots d'épaisseur.

Par rapport à une GeForce GTX 690 en bi-GK104 (300W), le TDP a vraisemblablement dû être revu à la hausse mais Nvidia ne donne pas de précision à ce sujet. 350W ? 400W ? Nous ne devrions pas tarder à en savoir plus puisque la disponibilité est annoncée pour début avril avec un tarif de… 3000$ ! Il s'agit d'un nouveau record pour une carte non-issue d'une gamme professionnelle et nous sommes curieux de savoir si cette GeForce GTX Titan Z pourra réellement trouver son public, aussi réduit soit-il...

GTC: Nvidia annonce Pascal: NVLink, stacked DRAM, 2016

Le forum technologique GTC de Nvidia commence fort avec l'annonce du successeur de Maxwell. Prénommé Pascal et prévu pour 2016, ce GPU intégrera une nouvelle technologie d'interconnexion, NVLink, ainsi que le support de la mémoire 3D.

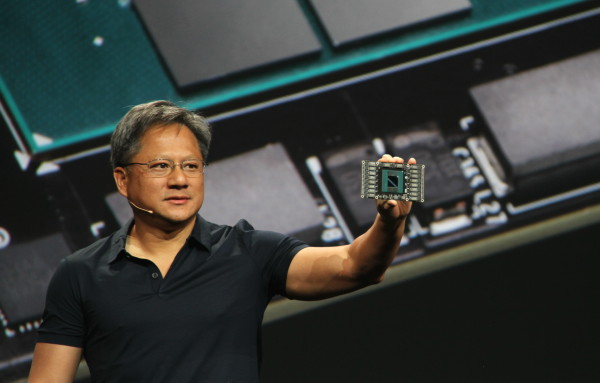

Jen Hsun Huang, le CEO de Nvidia présente le premier prototype du GPU Pascal.

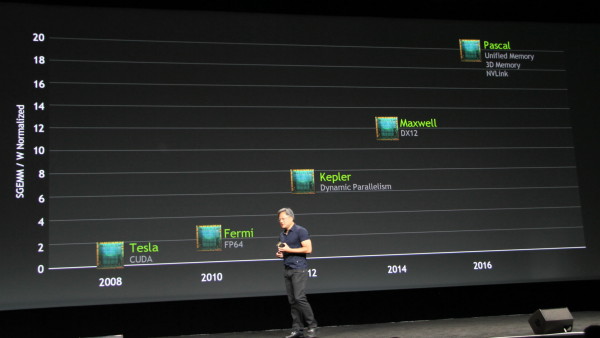

L'an passé, Nvidia nous avait présenté une roadmap qui mettait en avant l'arrivée des GPU Maxwell en 2014, nous y sommes, ainsi que des GPU Volta en 2016. Pour Maxwell, Nvidia mentionnait alors le support de la mémoire unifiée et pour Volta de la mémoire 3D ou stacked DRAM, qui consiste à empiler plusieurs puces mémoire pour former un module dont la bande passante va exploser.

A noter que dans ces présentations, le nom de l'architecture ou de la génération représente toujours le plus gros GPU de la famille. La nouvelle roadmap de Nvidia est quelque peu différente :

DirectX 12 est rentré dans l'air du temps et dorénavant mis en avant comme le point de communication principal pour la génération Maxwell. Etrangement la mémoire unifiée passe vers la génération suivante qui change de nom. Exit Alessandro Volta, bonjour Blaise Pascal. La génération Volta a en réalité été repoussée et une génération intermédiaire introduite. Avec Pascal, Nvidia entend s'attaquer aux goulets d'étranglements des GPU actuels, au moins sur 2 fronts.

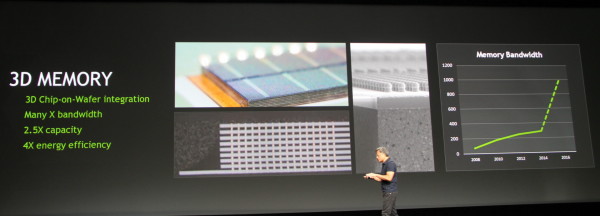

Tout comme cela était mis en avant pour Volta, Pascal bénéficie du DRAM stacking pour faire exploser la bande passante de sa mémoire locale. Nvidia précise avoir recours à la technique "3D chip-on-wafer integration" et estimer pouvoir atteindre une bande passante de 1 To par seconde en 2016. La quantité de mémoire pourra également progresser significativement, il est question de 2.5x plus de mémoire qu'aujourd'hui, soit probablement 10 Go dans le cas des GeForce et près de 30 Go dans le cas des cartes professionnelles. Tout ceci se ferait avec une progression de 4x de l'efficacité énergétique liée à la mémoire et à son interface.

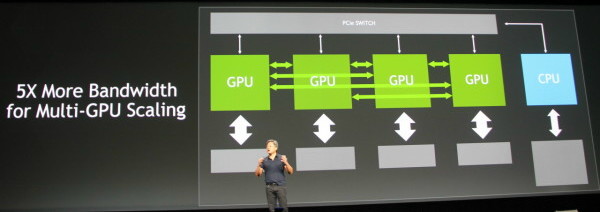

L'autre point sur lequel Nvidia travaille pour Pascal est l'interconnexion. Le bus PCI Express représente une limitation importante au niveau de la communication avec le CPU et entre GPU. Dans le cas d'une utilisation grand public, ce n'est pas un problème, mais cela peut le devenir dans d'autres situations liées au GPU computing.

Pour contourner ce problème et avoir le contrôle de sa propre interconnexion, Nvidia a mis au point NVLink. Il s'agit d'un bus de communication dont les protocoles sont annoncés similaires à ceux du PCI Express, prévus pour la mémoire unifiée et la cohérence des caches dès la génération 2.0, probablement pour le successeur de Pascal. NVLink pourra offrir 5 à 12X la bande passante du PCI Express, probablement avec une latence réduite. Dans un sens, NVLink peut être vu commme une version musclée et plus flexible du lien SLI.

NVLink pourra être implémenté pour la communication entre GPU, le schéma de Nvidia indique qu'au moins 4 GPU pourront ainsi disposer d'une connexion directe. Il sera également possible d'utiliser NVLink pour offrir au GPU un accès plus performant au CPU. Nvidia précise d'ailleurs avoir collaboré avec IBM lors du développement du NVLink et que ce dernier sera implémenté dans de futurs CPU POWER. Nous pouvons également raisonnablement estimer que Nvidia proposera ce support sur ses futurs SoC/CPU dérivés de ses propres cores ARMv8 Denver. Il est par contre improbable qu'Intel propose un jour une connexion NVLink sur ses Xeon.

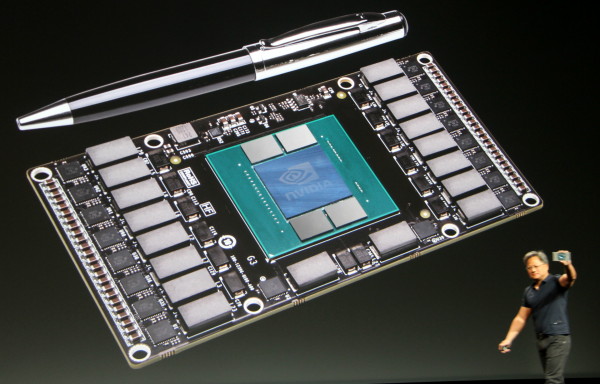

Pour terminer, Nvidia indique déjà disposer dans ses labos des premiers prototypes de Pascal. Une plateforme relativement compacte dont nous ne savons cependant pas si elle est réellement fonctionnelle. Nous pouvons y apercevoir 4 modules de stacked DRAM et Nvidia précise que cette carte Pascal lui permet de travailler sur NVLink. Sur la face avant du PCB, aucune interconnexion n'est cependant visible, celle-ci étant probablement au dos. Rien ne dit cependant que c'est ce format qui sera retenu pour la version commerciale de Pascal.

La guerre s'annonce rude entre Pascal et les futurs Xeon Phi !

GTC: Les Tesla K20X dans le Piz Daint suisse

Après le supercalculateur Titan du Laboratoire national d'Oak Ridge, Nvidia a annoncé qu'un second supercalculateur venait de faire le choix de CUDA et de l'accélérateur Tesla K20X. Ce supercalculateur se nomme Piz Daint et est construit par le Centre national Suisse de Calcul Scientifique (CSCS) en collaboration avec MeteoSwiss. Bien que plus modeste que Titan, il devrait devenir le supercalculateur le plus puissant d'Europe avec une puissance de calcul supérieure au pétaflop. Il sera destiné à la recherche et à la modélisation météorologique.

Détail important concernant Piz Daint, il est basé sur la plateforme XC30 de Cray, qui repose sur des Xeon E5 et supporte l'accélérateur Xeon Phi en plus du Tesla K20X. Une double victoire donc pour Nvidia qui en plus de pouvoir fournir un nouveau supercalculateur, le fait en battant le concurrent direct proposé par Intel.

GTC: Performances GPU de Logan = GT 640M ?

Durant la GTC 2013, nous avons pu nous entretenir avec Ian Buck qui est à l'origine de la première version de CUDA et actuellement General Manager chez Nvidia pour les technologies du GPU Computing. Interrogé au sujet de Kayla, la plateforme de développement CUDA on ARM équipée d'un GPU GK208, Ian Buck nous a indiqué que les performances GPU, au niveau de CUDA, étaient bel et bien représentatives de celles de Logan, sans vouloir en dire plus.

Bien que ce niveau de performances représente le bas de gamme sur PC, il s'agit d'une évolution énorme pour un SoC Tegra. Si le passage au 20nm et sans aucun doute plusieurs évolutions de l'architecture (avec probablement une réduction du nombre d'unités de texturing), faciliteront l'arrivée de l'architecture Kepler et de CUDA dans le monde ultra-mobile, il est difficile d'imaginer que ces 384 cores (ou équivalents) flexibles ne consommeront pas plus que les 72 cores avec pipeline fixe de Tegra 4.

De quoi nous laisser spéculer qu'avec Logan, Nvidia devra se contenter de versions bridées (en termes d'unités actives ou de fréquences) pour les "petites" tablettes et les superphones, mais compte par contre revoir ses prétentions à la hausse avec un SoC capable de monter en gamme pour viser les "grosses" tablettes voire des ultra-portables et bien entendu le successeur de Shield.

Parallèlement à cela, Ian Buck nous a indiqué que CUDA devrait progressivement devenir "power aware" et devenir capable de prendre en compte l'aspect consommation ou tout du moins de permettre aux développeurs de le faire. Cela se fera tout d'abord au niveau des outils tels que Nsight (et sa version Tegra) qui d'ici quelques temps reporteront des informations liées à la consommation.

Il est possible qu'à terme, les compilateurs CUDA, permettent optionnellement d'améliorer le rendement énergétique, mais cela est encore à l'état de recherche et prendra encore plusieurs années avant d'éventuellement se concrétiser. Globalement, la meilleure stratégie reste d'exécuter le plus rapidement une tâche pour retourner au repos dès que possible mais ce n'est pas toujours vrai, d'autant plus dans le cas d'une tâche continue telle que le rendu 3D sur GPU. Par exemple, calculer une valeur au lieu de la lire en mémoire peut avoir un léger impact sur les performances mais augmenter le rendement énergétique.

En plus de préparer le futur avec CUDA, dans l'immédiat, le plus important pour Nvidia est probablement d'arriver à convaincre un maximum de développeurs que faire l'effort nécessaire pour arriver à utiliser 2 threads ou plus à fréquence modérée offre un meilleur rendement que se contenter d'un seul thread mais des performances de la fréquence CPU maximale.

Correction du 01/07/2013: le nom du GPU que nous pensions être GK117 est en réalité GK208.