Les contenus liés aux tags GTC et Pascal

GTC: Deep-learning : +70% pour Pascal

Au détour d'une présentation consacrée à ses outils spécifiques au deep learning, soit à l'apprentissage progressif par un réseau de neurones artificiels, Nvidia a débuté le teasing concernant les performances de sa future architecture Pascal :

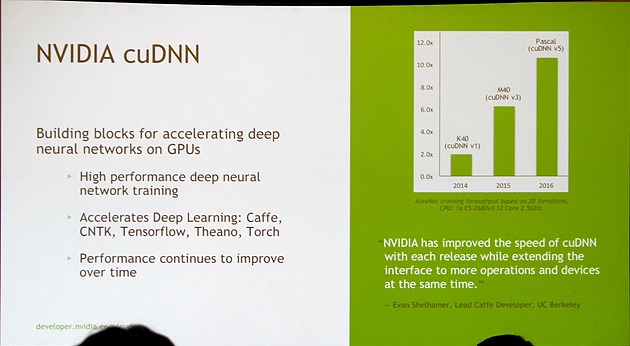

Nvidia fait évoluer régulièrement sa librairie cuDNN (CUDA Deep Neural Network) et en propose des évolutions majeures pour ses nouvelles architectures GPU. Ces évolutions vont d'ailleurs de pair pour booster les performances : cuDNN v1 avec une Tesla K40 (GK110) a doublé les performances par rapport aux précédentes solutions et cuDNN v3 avec une Tesla M40 (GM200) sous architecture Maxwell les a plus que triplées (6.25X).

Le deep learning étant l'une des priorités principales de Nvidia avec les performances en jeu, Pascal va bien entendu pousser la barre encore plus haut dans ce domaine. Il est ainsi question de 10.5X, soit +70% par rapport au GM200, pour un GPU Pascal indéterminé associé à cuDNN v5.

Difficile cependant de juger des performances globales de ce GPU Pascal sur base de ce seul chiffre puisqu'il reste bien entendu à savoir dans quelle proportion ces gains proviennent d'une augmentation de la puissance brute du GPU ou d'optimisations de l'architecture spécifiques au deep learning. Nous devrions en apprendre un peu plus dans le courant de la semaine.

Nvidia Pascal: le FP16 pour doubler les Tflops

Le CEO de Nvidia, Jen-Hsun Huang, a profité de l'ouverture de la GPU Technology Conference pour donner un détail de plus concernant sa future architecture GPU prévue pour 2016 : Pascal supportera la précision de calcul FP16.

L'an passé, les premiers détails avaient déjà été communiqués au sujet de Pascal, vous pourrez retrouver nos actualités dédiées ici et là.

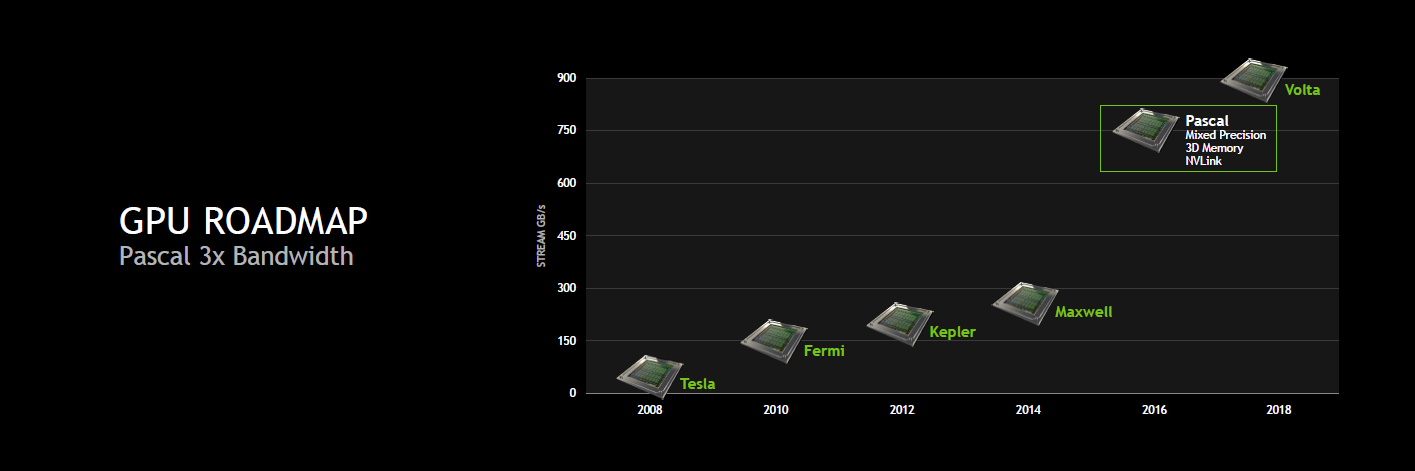

Ainsi, pour rappel, nous savions déjà au sujet de cette architecture intermédiaire entre Maxwell et Volta que Nvidia visait 32 Go de mémoire 3D et une bande passante totale de 1 To/s, soit à peu près le triple de ce dont est capable un GPU tel que le GM200 de la GeForce GTX Titan X. Nvidia avait également annoncé un format de type mezzanine pour les serveurs et une nouvelle interconnexion : NVLink.

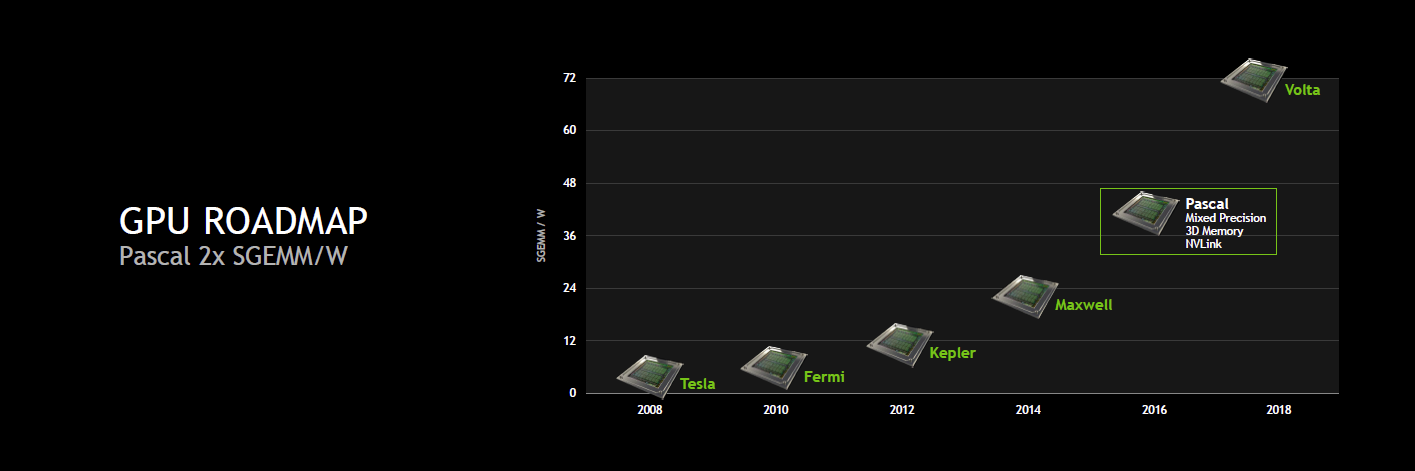

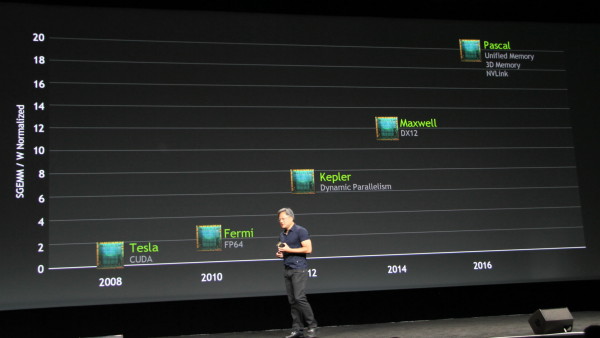

Il était par contre alors question d'une augmentation de 66% des performances par watts en SGEMM (FP32). Visiblement, Nvidia est plus ambitieux cette année et parle dorénavant d'un doublement des performances par watts.

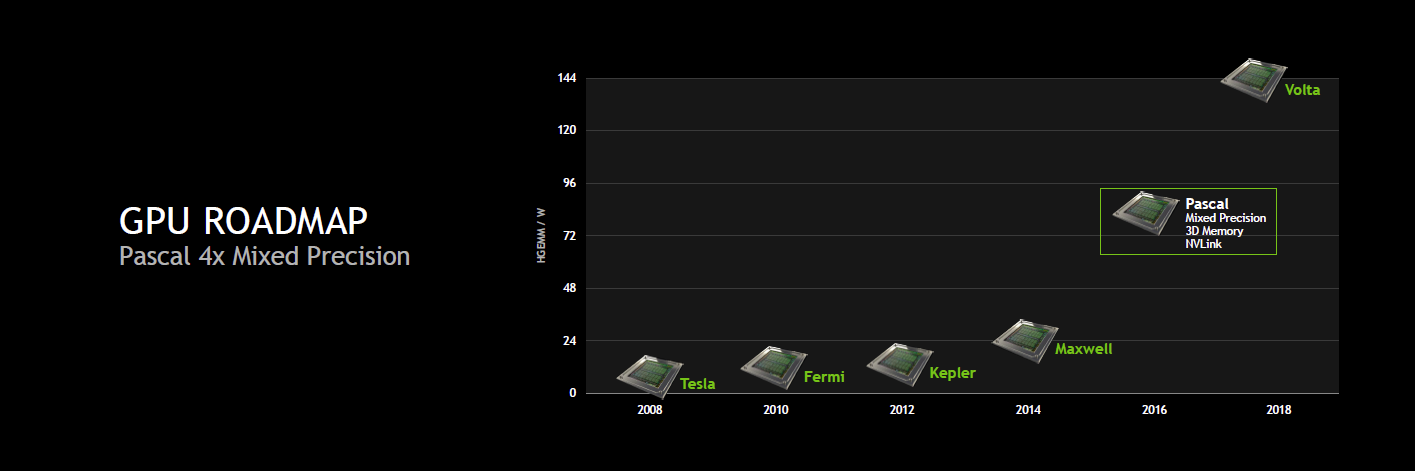

Mais surtout, Nvidia compte aller plus loin dans l'augmentation de la puissance de calcul et c'est là que se trouve le nouveau détail concernant Pascal : il supportera le calcul en FP16 et la précision mixte. Nvidia reprend probablement cette spécificité du Tegra X1 dont les unités de calcul FP32 sont également capables de traiter 2 opérations FP16, étendue pour plus de flexibilité. De quoi potentiellement doubler les performances pour les applications qui peuvent se satisfaire d'une précision de calcul réduite.

Le but de la précision mixte sera de pouvoir mélanger dans un algorithme des opérations des différents niveaux de précision supportés par le GPU, FP16, FP32, FP64, pour n'exploiter les instructions plus lentes et plus gourmandes que là où elles sont réellement nécessaires. Les optimisations potentielles sont légions mais les identifier et les exploiter efficacement en pratique est probablement une difficulté qui va se poser.

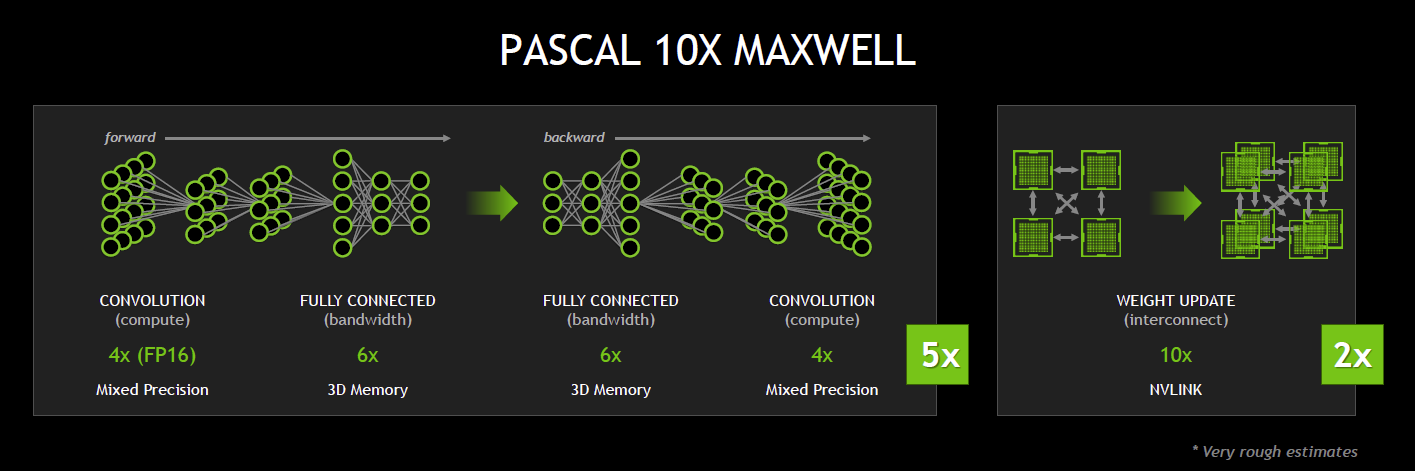

En combinant les évolutions au niveau du sous-système mémoire à cette précision mixte et en doublant le nombre de GPU d'un système à l'aide de NVLink, Nvidia table sur une multiplication par 10 des performances. Un chiffre qui est par contre probablement très optimiste.

GTC: Quelques détails de plus sur le GPU Pascal

Durant la GTC, nous avons pu poser quelques questions à Nvidia et en apprendre un peu plus sur le GPU Pascal qui a été introduit entre les générations Maxwell et Volta.

Si Nvidia se refuse à parler de process de fabrication, nous supposons que la raison du retard de Volta est à chercher de ce côté. Pascal devra donc se contenter du 20 nanomètres de TSMC, ce qui limitera quelque peu les possibilités de Nvidia par rapport à ses plans originaux pour la même période. Pour aller plus loin que les GPU Maxwell qui seront fabriqués en 20nm, Nvidia devra poursuivre la progression de l'efficacité énergétique, mais ce n'est pas tout.

Nvidia explique que certains développements entrepris pour Volta étaient prêts et pourront être proposés comme prévus à travers les GPU Pascal. C'est le cas des technologies NVLink et du DRAM stacking. NVLink, qui a été développé en partenariat avec IBM, devrait dans un premier temps rester spécifique au marché professionnel, mais le DRAM stacking fera son apparition du côté des dérivés grand public. Probablement uniquement dans le très haut de gamme au départ, mais Nvidia insiste sur le fait que la technique est utile pour tous les segments de marché. En dehors du coût et d'un travail important nécessaire pour assurer un assemblage fiable, ce recours au DRAM stacking ne présente que des avantages, aucun inconvénient selon Nvidia. Son implémentation généralisée n'est donc qu'une question de temps et de réduction progressive des coûts.

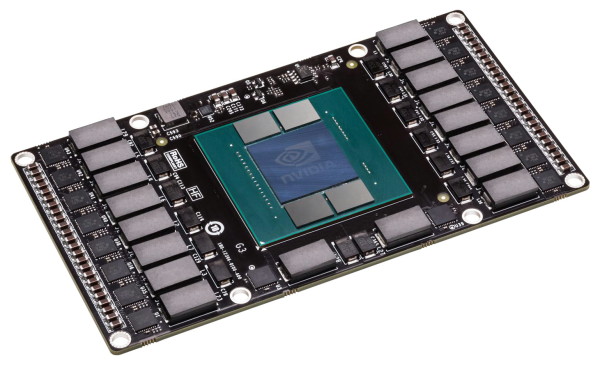

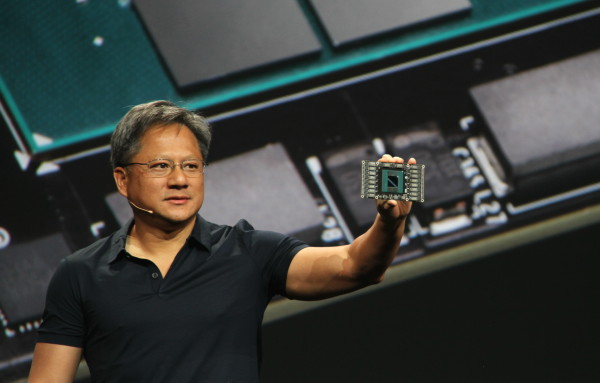

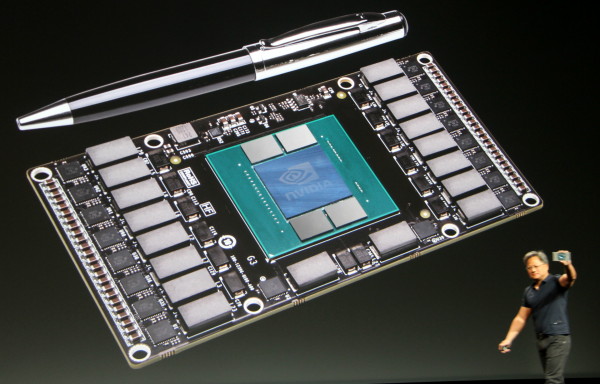

Concernant le prototype de Pascal qui a été présenté, il s'agit d'un "mechanical sample" qui n'est pas encore fonctionnel mais qui est utilisé par Nvidia pour développer un nouveau format de module "carte graphique". Sur ce module Pascal, nous pouvons observer le GPU avec ses 4 assemblages de puces mémoire qui prennent place sur le même packaging et sont connectés via un "interposer". Sur les côtés du module sont visibles les VRM nécessaires pour alimenter un GPU haut de gamme tel que devrait l'être Pascal. Nvidia précise que ce module n'aura pas de problème à délivrer au moins 300W.

Si aucun connecteur n'est visible au premier abord c'est parce qu'ils se situent en fait au dos, Nvidia ayant opté pour un format de type mezzanine qui consiste à superposer 2 PCB, avec un ou plusieurs connecteurs entre ceux-ci. Sur le module actuel, Nvidia précise que 2 connecteurs sont exploités.

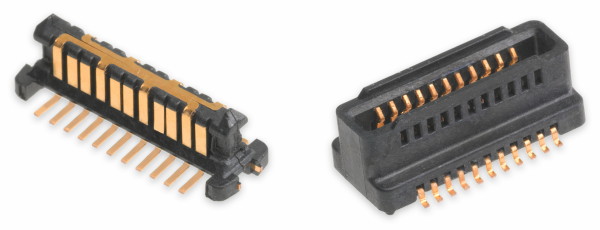

Un exemple de connecteur mezzanine, SpeedStack de Molex, capable de supporter des débits de 40 Gbps par paire.

Pourquoi ce changement de format ? Pour faciliter l'implémentation de NVLink, qui pourrait être exclusive au format mezzanine, mais également parce que ce dernier est plus fiable, notamment lorsqu'il est question de laisser les assembleurs de serveurs monter leur propre radiateur. Nvidia n'abandonne cependant pas le format "carte PCI Express" pour Pascal, il restera également disponible, même sur le marché professionnel.

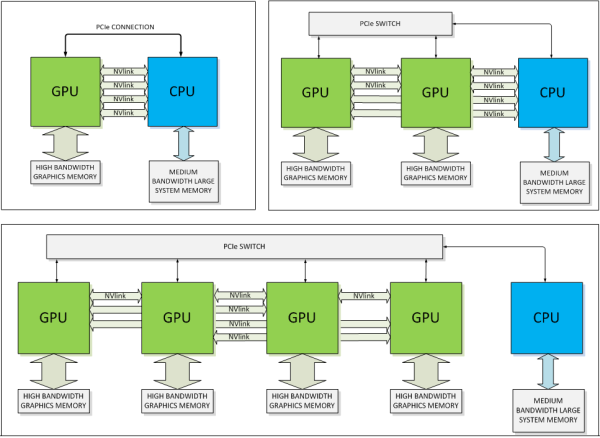

Nvidia a également publié des schémas un peu plus détaillés de systèmes NVLink :

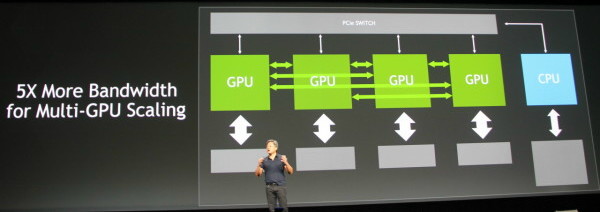

Sur ces schémas nous pouvons clairement observer 4 liens NVLink. Nvidia nous a précisé qu'il s'agissait d'un minimum et que certains modules Pascal, ou ses successeurs, pourraient en offrir plus, 8, 16… Il n'est d'ailleurs pas impossible que Nvidia en profite à l'avenir pour segmenter sa gamme professionnelle comme le fait aujourd'hui Intel avec les Xeon 2P/4P/8P. A noter que tous les liens peuvent être combinés pour former un très large bus de communication vers le CPU et/ou exploités pour connecter plusieurs GPU entre eux.

Chaque lien NVLink correspond à un bloc de 8 paires de lignes bidirectionnelles de type point-à-point. Une approche similaire à celle de l'HyperTransport et du QPI. Là où le bus PCI Express 3.0 16x apporte 16 Go/s dans chaque direction, l'ensemble NVLink pourra atteindre entre 80 et 200 Go/s. Nvidia indique par ailleurs que les déplacements de données à travers NVLink seront plus efficaces sur le plan énergétique que le PCI Express. Les premiers composants autres que Pascal qui supporteront NVLink seront de futurs CPU Power d'IBM. Nvidia précise par contre être en discussion avec d'autres fabricants de CPU, autres qu'Intel, mais sans en dire plus.

Enfin, nous avons interrogé Nvidia par rapport au recul du support complet de la mémoire unifiée qui était initialement prévu pour Maxwell mais est dorénavant annoncé pour Pascal. Ses responsables nous ont répondu que ce support avait bien été repoussé mais qu'il était présent partiellement depuis Kepler, reposant en partie sur une implémentation logicielle. Ils nous promettent que cette fois ce sera la bonne et que le dernier bloc nécessaire à la prise en charge matérielle complète de la mémoire unifiée fera enfin son apparition avec Pascal et NVLink.

GTC: Volta & Parker retardés, le 16nm TSMC responsable?

Les roadmaps présentées par Nvidia à la GTC ont semé pas mal de confusion en introduisant de nouveaux noms de codes, le GPU Pascal et le SoC Erista, à la place des anciens GPU Volta et SoC Parker. Nous avons pu confirmer avec Nvidia qu'en réalité les premiers, annoncés auparavant pour 2015, ont en fait été repoussés mais n'ont pas été annulés ou remplacés. Nvidia ne précise pas quelle est la raison de ce retard mais de nouvelles solutions ont dû être mises en place pour occuper le terrain et éviter que ses produits ne stagnent pendant trop longtemps.

Si Nvidia ne précise pas la raison de ce retard, un indice se trouve probablement dans les quelques informations communiquées l'an passé au sujet du SoC Parker. Nvidia parlait alors de l'utilisation d'un procédé de fabrication qui ferait appel aux FinFET, vraisemblablement le 16nm de TSMC. Nous pouvons supposer que c'était également le cas pour le GPU Volta.

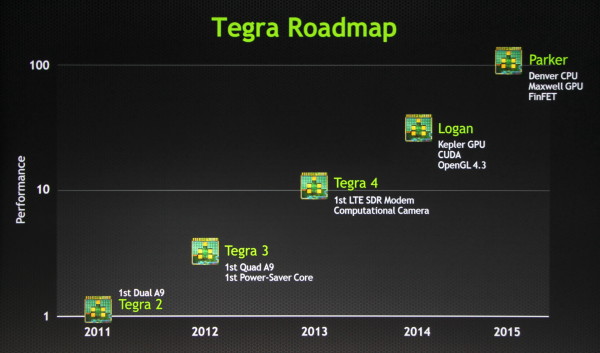

La roadmap des SoC Nvidia, version 2013.

Il semblerait donc que ce process 16nm FinFET ait posé problème, que ce soit en termes de timing, de volumes, de tarification et/ou de performances. Avec Pascal et Erista, Nvidia a dans tous les cas décidé d'introduire une génération intermédiaire en 20 nanomètres, ce qui explique ces changements sur les roadmaps.

GTC: Nvidia annonce Pascal: NVLink, stacked DRAM, 2016

Le forum technologique GTC de Nvidia commence fort avec l'annonce du successeur de Maxwell. Prénommé Pascal et prévu pour 2016, ce GPU intégrera une nouvelle technologie d'interconnexion, NVLink, ainsi que le support de la mémoire 3D.

Jen Hsun Huang, le CEO de Nvidia présente le premier prototype du GPU Pascal.

L'an passé, Nvidia nous avait présenté une roadmap qui mettait en avant l'arrivée des GPU Maxwell en 2014, nous y sommes, ainsi que des GPU Volta en 2016. Pour Maxwell, Nvidia mentionnait alors le support de la mémoire unifiée et pour Volta de la mémoire 3D ou stacked DRAM, qui consiste à empiler plusieurs puces mémoire pour former un module dont la bande passante va exploser.

A noter que dans ces présentations, le nom de l'architecture ou de la génération représente toujours le plus gros GPU de la famille. La nouvelle roadmap de Nvidia est quelque peu différente :

DirectX 12 est rentré dans l'air du temps et dorénavant mis en avant comme le point de communication principal pour la génération Maxwell. Etrangement la mémoire unifiée passe vers la génération suivante qui change de nom. Exit Alessandro Volta, bonjour Blaise Pascal. La génération Volta a en réalité été repoussée et une génération intermédiaire introduite. Avec Pascal, Nvidia entend s'attaquer aux goulets d'étranglements des GPU actuels, au moins sur 2 fronts.

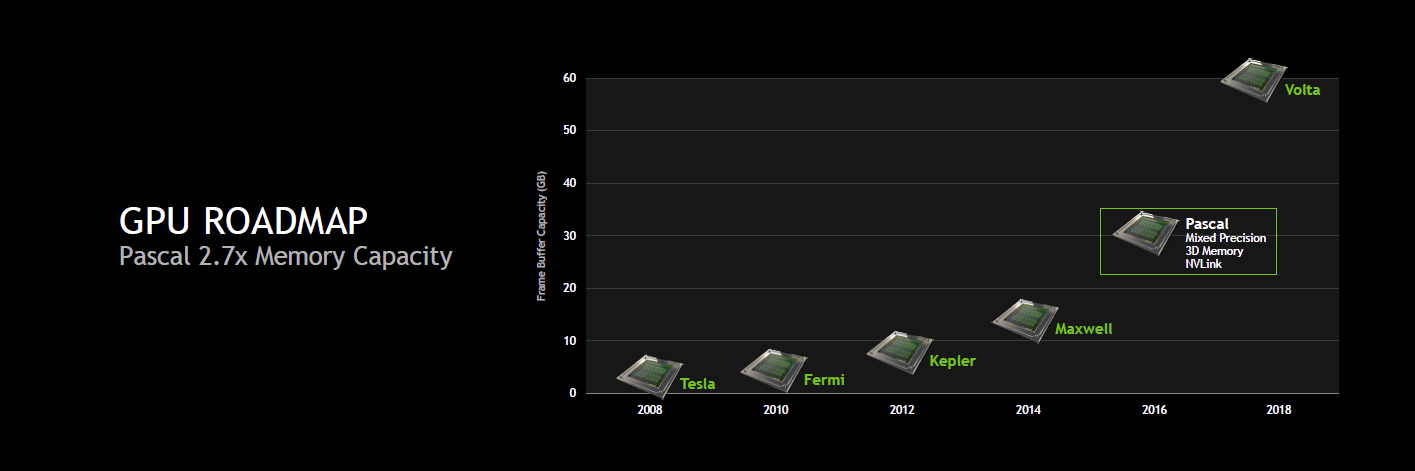

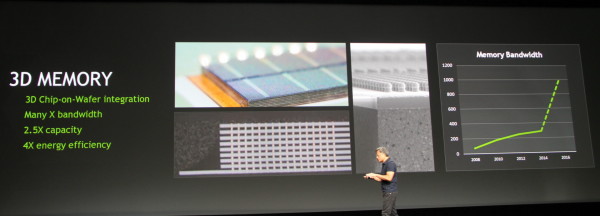

Tout comme cela était mis en avant pour Volta, Pascal bénéficie du DRAM stacking pour faire exploser la bande passante de sa mémoire locale. Nvidia précise avoir recours à la technique "3D chip-on-wafer integration" et estimer pouvoir atteindre une bande passante de 1 To par seconde en 2016. La quantité de mémoire pourra également progresser significativement, il est question de 2.5x plus de mémoire qu'aujourd'hui, soit probablement 10 Go dans le cas des GeForce et près de 30 Go dans le cas des cartes professionnelles. Tout ceci se ferait avec une progression de 4x de l'efficacité énergétique liée à la mémoire et à son interface.

L'autre point sur lequel Nvidia travaille pour Pascal est l'interconnexion. Le bus PCI Express représente une limitation importante au niveau de la communication avec le CPU et entre GPU. Dans le cas d'une utilisation grand public, ce n'est pas un problème, mais cela peut le devenir dans d'autres situations liées au GPU computing.

Pour contourner ce problème et avoir le contrôle de sa propre interconnexion, Nvidia a mis au point NVLink. Il s'agit d'un bus de communication dont les protocoles sont annoncés similaires à ceux du PCI Express, prévus pour la mémoire unifiée et la cohérence des caches dès la génération 2.0, probablement pour le successeur de Pascal. NVLink pourra offrir 5 à 12X la bande passante du PCI Express, probablement avec une latence réduite. Dans un sens, NVLink peut être vu commme une version musclée et plus flexible du lien SLI.

NVLink pourra être implémenté pour la communication entre GPU, le schéma de Nvidia indique qu'au moins 4 GPU pourront ainsi disposer d'une connexion directe. Il sera également possible d'utiliser NVLink pour offrir au GPU un accès plus performant au CPU. Nvidia précise d'ailleurs avoir collaboré avec IBM lors du développement du NVLink et que ce dernier sera implémenté dans de futurs CPU POWER. Nous pouvons également raisonnablement estimer que Nvidia proposera ce support sur ses futurs SoC/CPU dérivés de ses propres cores ARMv8 Denver. Il est par contre improbable qu'Intel propose un jour une connexion NVLink sur ses Xeon.

Pour terminer, Nvidia indique déjà disposer dans ses labos des premiers prototypes de Pascal. Une plateforme relativement compacte dont nous ne savons cependant pas si elle est réellement fonctionnelle. Nous pouvons y apercevoir 4 modules de stacked DRAM et Nvidia précise que cette carte Pascal lui permet de travailler sur NVLink. Sur la face avant du PCB, aucune interconnexion n'est cependant visible, celle-ci étant probablement au dos. Rien ne dit cependant que c'est ce format qui sera retenu pour la version commerciale de Pascal.

La guerre s'annonce rude entre Pascal et les futurs Xeon Phi !