Les derniers contenus liés au tag Tesla

Afficher sous forme de : Titre | FluxGTC: Tesla P100: débits PCIe et NVLink mesurés

GTC: Nvidia DGX-1: 8 Tesla P100 pour 129.000$

Nvidia lance la Tesla K80: double GK210 avec Boost

Nvidia annonce la Tesla K40 et CUDA 6

Nvidia rachète PGI, The Portland Group

Jim Keller rejoint... Intel !

Tesla V100 décliné en PCIe

Nvidia dévoile le GV100: 15 Tflops, 900 Go/s

GTC: Nvidia annonce CUDA 8, prêt pour Pascal

GTC: Supermicro premier sur le Tesla P100 ?

Jim Keller rejoint... Intel !

C'est une petite surprise, Jim Keller, ingénieur connu pour les plus gros succès d'AMD (Athlon, Athlon 64 et Zen) rejoint aujourd'hui Intel d'après nos confrères de Fortune .

Connu pour son rôle dans le design des DEC Alpha, il a également dirigé les équipes qui ont conçu les K7 (Athlon) et K8 (Athlon 64) pour AMD, avant de se retrouver suite à un rachat (de P.A. Semi) en charge de la future architecture ARM custom d'Apple. Il est retourné en 2012 chez AMD ou il s'est occupé de l'architecture de Zen.

Depuis, il avait tenu plusieurs postes, dont un passage éclair chez Samsung. Depuis deux ans, il avait rejoint Tesla en tant que Vice Président en charge du hardware custom embarqué. Suite au départ de Chris Lattner (ex-Apple), il avait également récupéré la direction d'Autopilot.

Intel n'a pas encore communiqué officiellement sur son rôle, le communiqué de Tesla indiquant simplement que "la passion principale de Jim était l'ingénierie de micoprocesseurs et qu'il rejoint une société ou il pourra de nouveau s'y consacrer exclusivement".

Tesla V100 décliné en PCIe

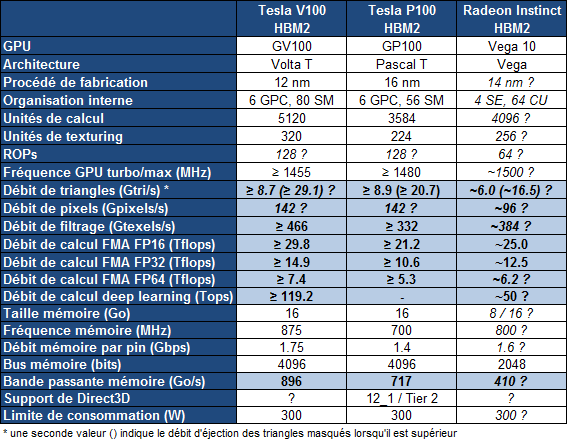

NVIDIA annonce la déclinaison PCIe de son accélérateur Tesla V100. Il utilise toujours l'énorme GV100, gravé en 12nm FFN par TSMC et disposant de pas moins de 21,1 milliards de transistors.

Avec un TDP réduit à 250W contre 300W pour la version mezzanine, les performances sont légèrement revues à la baisse avec une puissance annoncée à 7 Tflops en double précision et 14 Tflops en simple précision en boost, soit une fréquence passant de 1455 à 1370 MHz environ. On dispose par contre toujours de 16 Go de HBM2 à 900 Go/s.

La disponibilité est annoncée pour "plus tard dans l'année", sans plus de précisions. Nvidia indique au passage que le supercalculateur Summit à base de V100 du département de l'énergie américain, annoncé en 2014 et désormais prévu pour 2018, disposera d'une puissance de 200 petaFLOPS (l'intervalle donnée initialement était de 150-300).

Nvidia dévoile le GV100: 15 Tflops, 900 Go/s

Nvidia profite de sa GPU Technology Conference pour dévoiler quelques détails sur le GV100, le premier GPU de la génération Volta qui sera dédié au monde du calcul et en particulier de l'intelligence artificielle.

Comme c'est à peu près le cas chaque année, le CEO de Nvidia Jen Hsun Huang vient de profiter de la GTC pour dévoiler les grandes lignes du premier GPU de sa future génération Volta. Ce sera un monstre clairement orienté vers l'intelligence artificielle, un débouché qui monte en puissance pour les GPU Nvidia.

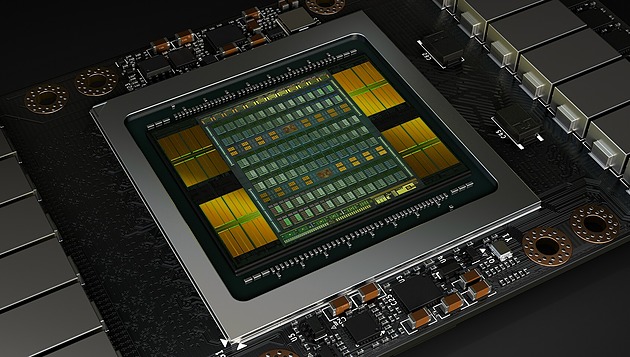

Le GV100 est le successeur direct du GP100 et reprend un format similaire : il s'agit d'une puce énorme placée sur un interposer avec 4 modules HBM2. Grossièrement c'est la même chose en mieux : plus gros et plus évolué.

Plus gros tout d'abord avec un GV100 qui profite de la gravure en 12 nm FFN de TSMC (personnalisé pour Nvidia) pour passer à 21.1 milliards de transistors, plus de 30% de plus que les 15.3 milliards du GP100. Malgré le passage au 12 nm, la densité ne progresse presque pas et le GV100 est énorme avec 815 mm² contre 610 mm² pour le GP100. Le 12 nm permet ici avant tout de pouvoir monter en puissance à consommation similaire.

Tout comme le GP100, le GV100 utilise des "demi SM" par rapport aux GPU grand public. Leur nombre passe de 60 à 84, ce qui représente 5376 unités de calcul. Ils restent répartis dans 6 blocs principaux, les GPC, ce qui laisse penser que Nvidia a tout misé sur un gain de puissance de calcul, sans trop toucher au débit de triangles ou de pixels qui étaient déjà à un niveau très élevé sur GP100.

Comme sur le GP100, ces SM sont capables de traiter différents niveau de précision : FP16 (x2), FP32 et FP64 (/2). Par ailleurs, Nvidia a ajouté quelques instructions spécifiques au deep learning et y fait référence en tant que tensor cores. Ils permettent aux algorithmes qui y feront appel de doubler la mise par rapport aux instructions 8-bits (produit scalaire avec accumulation) des GPU Pascal (sauf GP100) et du futur Vega d'AMD. A voir évidemment dans quelle mesure les différents algorithmes de deep learning pourront profiter de ces nouvelles instructions.

Nvidia en a profité pour améliorer le sous-système mémoire qui sera plus flexible pour demander moins d'efforts d'optimisation de la part des développeurs. Le cache L2 passe de 4 à 6 Mo et de la HBM2 Samsung plus rapide est exploitée mais qui restera au départ limitée à 4 Go par module soit 16 Go au total. Par ailleurs, le GV100 profite de 6 liens NV-Link de seconde génération (25 Go/s dans chaque direction) pour offrir une interface qui peut monter à 300 Go/s.

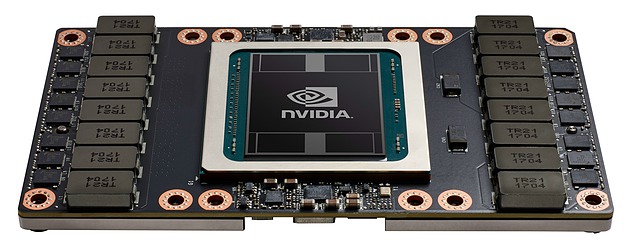

Le premier accélérateur qui profitera du GV100 est comme nous pouvions nous y attendre le Tesla GV100 qui sera initialement proposé dans un format de type mezzanine. Un tel module sera bien entendu gourmand mais Nvidia parle d'une enveloppe thermique maximale qui reste à 300W. Par ailleurs, deux modes énergétique seront proposé : Maximum Performance et Maximum Efficiency. Le premier autorise le GV100 à profiter de toute son enveloppe de 300W alors que le second limite probablement la tension maximale pour maintenir le GPU au meilleur rendement possible, ce qui a évidemment du sens pour de très gros serveurs.

Sur le Tesla GV100, le GPU sera amputé de quelques unités de calcul, pour faciliter la production seuls 80 des 84 SM seront actifs. Voici ce que cela donne :

Le Tesla GV100 augmente la puissance brute de 40% par rapport au Tesla GP100, mais ses différentes optimisations feraient progresser les performances en pratique de +/- 60% dans le cadre du deep learning selon Nvidia. La bande passante mémoire progresse un peu moins avec "seulement" +25%, mais le cache L2 plus important et diverses améliorations compensent quelque peu cela.

Le GV100 devrait devancer assez facilement le Vega 10 d'AMD, mais ce dernier devrait être commercialisé en version Radeon Instinct à un tarif nettement moindre que le Tesla GV100 et en principe plus tôt. Nvidia parle de son côté du troisième trimestre et de 150.000$ pour les premiers serveurs DGX-1 équipés en GV100 et de la fin de l'année pour les accélérateurs au format PCI Express. Nvidia proposera évidemment d'ici-là des versions mises à jour de ses logiciels, compilateurs et autres librairies dédiées au deep learning.

GTC: Nvidia annonce CUDA 8, prêt pour Pascal

Comme souvent, l'arrivée d'une nouvelle architecture est associée à une révision majeure de CUDA, l'environnement logiciel de Nvidia destiné au calcul massivement parallèle. Ce sera évidemment le cas pour les GPU Pascal qui pourront profiter dès cet été d'un CUDA 8 taillé sur mesure. Au menu : un support plus évolué de la mémoire unifiée, un profilage plus efficace et un compilateur plus rapide.

La principale nouveauté de CUDA 8 sera le support complet de l'architecture Pascal et particulièrement du GP100 qui équipe l'accélérateur Tesla P100. Déjà introduit avec CUDA 7.5 pour permettre aux développeurs de s'y préparer, le support de la demi-précision (FP16) sera finalisé et pourra permettre des gains conséquents pour les algorithmes qui peuvent s'en contenter. Dans le cas du GP100, CUDA 8 ajoutera évidemment le pilotage des accès mémoire à travers les liens NVLink.

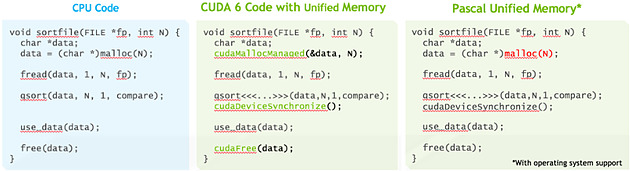

La plus grosse évolution est cependant à chercher du côté de la mémoire unifiée qui va faire un bond en avant avec Pascal, ou tout du moins avec le GP100 puisque nous ne sommes pas certains que les autres GPU Pascal en proposeront un même niveau de support. Si vous avez l'impression qu'on vous a annoncé le support de cette mémoire unifiée avec chaque nouveau GPU, ne vous inquiétez pas, vous n'avez pas rêvé, nous avons la même impression.

Elle est en fait supportée depuis CUDA 6 pour les GPU Kepler et Maxwell mais de façon limitée, que nous pourrions qualifier d'émulée. Pour ces GPU, l'espace de mémoire unifié est en fait dédoublé dans la mémoire centrale et dans la mémoire physiquement associée au GPU. L'ensemble logiciel CUDA se charge de piloter et de synchroniser ces deux espaces mémoires pour qu'ils n'en représentent qu'un seul du point de vue du développeur. De quoi faciliter sa tâche mais au prix de sérieuses limitations : la zone de mémoire unifiée ne peut dépasser la quantité de mémoire rattachée au GPU, le CPU et le GPU ne peuvent y accéder simultanément et de nombreuses synchronisations systématiques sont nécessaires pour forcer la cohérence entre les copies CPU et GPU de cette mémoire.

Pour proposer un support plus avancé de la mémoire unifiée, des modifications matérielles étaient nécessaires au niveau du GPU, ce qui explique pourquoi nous estimons possible que cela soit spécifique au GP100. Tout d'abord l'extension de l'espace mémoire adressable à 49-bit pour permettre de couvrir l'espace de 48-bit des CPU ainsi que la mémoire propre à chaque GPU du système. Ensuite la prise en charge des erreurs de page qui permet d'éviter les coûteuses synchronisations systématiques. Si un kernel essaye d'accéder à une page qui ne réside pas dans la mémoire physique du GPU, il va produire une erreur qui va permettre suivant les cas soit de rapatrier localement la page en question, soit d'y accéder directement à travers le bus PCI Express ou un lien NVLink.

La cohérence peut ainsi être garantie automatiquement, ce qui permet aux CPU et aux GPU d'accéder simultanément à la zone de mémoire unifiée. Sur certaines plateformes, la mémoire allouée par l'allocateur de l'OS sera par défaut de la mémoire unifiée, et il ne sera plus nécessaire d'allouer une zone mémoire spécifique. Nvidia indique travailler à l'intégration de ce support avec Red Hat et la communauté Linux. Par ailleurs, CUDA 8 étend également le support de la mémoire unifiée à Mac OS X.

Ce support plus avancé de la mémoire unifiée va faciliter le travail des développeurs et surtout rendre plus abordable leurs premiers pas sur les GPU tout en maintenant un relativement bon niveau de performances. Tout du moins si le pilote et le runtime CUDA font leur travail correctement puisque c'est à ce niveau que tout va se jouer. A noter que les développeurs plus expérimentés conservent la possibilité de gérer explicitement la mémoire.

Parmi les autres nouveautés, Nvidia introduit une première version de la librairie nvGRAPH (limitée au mono GPU) qui fournit des routines destinées à accélérer certains algorithmes spécifiques au traitement des graphes. Traiter rapidement les opérations sur ces structures mathématique prend de plus en plus d'importance, que ce soit pour les moteurs de recherche, la publicité ciblée, l'analyse des réseaux ou encore la génomique. Faciliter l'exécution de ces opérations sur le GPU est donc important pour leur ouvrir la porte à de nouveaux marchés potentiels.

Une autre évolution importante est à chercher du côté des outils de profilages qui vont dorénavant fournir une analyse des dépendances. De quoi par exemple permettre de mieux détecter que les performances sont limitées par un kernel qui bloque le CPU trop longtemps. Ces outils revus prennent également en compte NVLink et la bande passante utilisée à ce niveau.

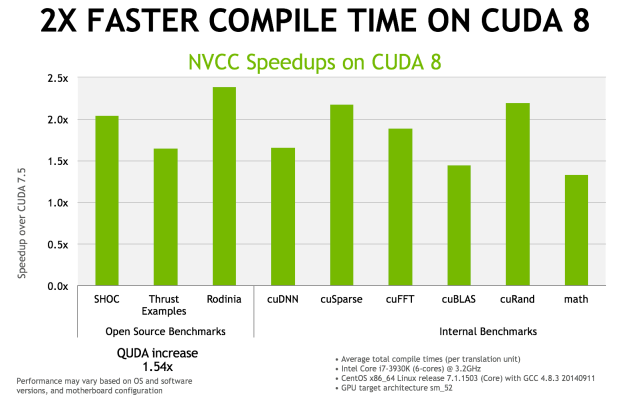

Enfin, le compilateur NVCC 8.0 a reçu de nombreuses optimisations pour réduire le temps de compilation. Nvidia annonce qu'il serait réduit de moitié, voire plus, dans de nombreux cas. Ce compilateur étend également le support expérimental des expressions lambda de C++11.

La sortie de CUDA 8.0 est prévue pour le mois d'août mais une release candidate devrait être proposée dès le mois de juin.

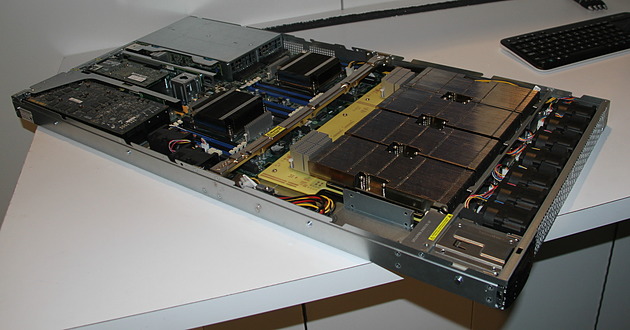

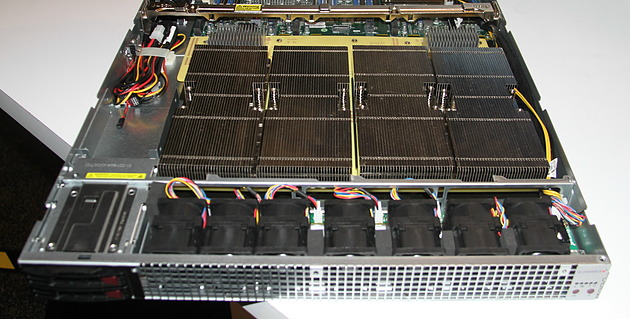

GTC: Supermicro premier sur le Tesla P100 ?

Supermicro exposait à la GTC un prototype non fonctionnel de serveur 1U à base de Tesla P100. Celui-ci est prévu pour embarquer 4 de ces accélérateurs ainsi qu'une configuration bi-Xeon et une carte graphique ou un autre accélérateur au format PCI Express 16x. Le fabricant taiwanais explique que le nouveau format de type mezzanine et les liens NVLink ont demandé pas mal de travail lors de la conception du serveur.

C'est notamment le cas au niveau du refroidissement qui est un challenge évident compte tenu de la consommation qui monte à 300W par Tesla P100 alors que la densité progresse compte tenu de la compacité de cette solution. Supermicro a ainsi décidé de placer ces 4 accélérateurs, surmontés d'imposants radiateurs, côte à côte juste après l'entrée d'air frais, ce qui permet de les refroidir tous de la même manière.

Supermicro précise que certains concurrents ont opté pour une autre organisation, avec par exemple un "carré" de Tesla P100, et que d'après ses essais, il y a beaucoup de risques que les GPU les plus éloignés de l'entrée d'air en souffrent, par exemple en atteignant plus rapidement leur limite de température.

Malgré l'état de la solution exposée, Supermicro nous a confirmé être très proche de la finalisation de ce serveur et s'attendre à être le premier sur le marché, tout du moins si Nvidia ne tarde pas à livrer les Tesla P100.