Actualités smartphones / tablettes

GTC: Le futur de Tegra: CUDA, Logan, Parker

Nvidia Tegra 4 et 4i : tout savoir de leur architecture

Intel lance les Atom Clover Trail+ Z2500

Nvidia annonce le Tegra 4i et Phoenix

CES: Snapdragon 600, 800: Qualcomm accélère

Computex: Tegra 4, DirectTouch et le calcul du stylet

Peu après le lancement de Tegra 3, Nvidia avait dévoilé la technologie DirectTouch qui consiste à remplacer le contrôleur de l'écran tactile par un pilotage logiciel. De quoi pouvoir profiter des performances plus élevées du SoC pour augmenter la sensibilité tactile par exemple. En pratique, de nombreuses tablettes ont cependant malgré tout fait appel à un contrôleur tel que ceux que propose Synaptics.

Au Computex, Nvidia a dévoilé une nouvelle technologie (le nom commercial viendra plus tard) qui se base sur DirectTouch ainsi que sur la puissance de traitement plus élevée des Tegra 4 et 4i pour offrir l'expérience d'un stylet actif avec un simple stylet passif. Actuellement, les surfaces tactiles manquent de sensibilité et pour améliorer le confort d'utilisation et la précision des tracés, un stylet actif est nécessaire. Wacom fourni de telles technologies par exemple, et elles impliquent bien entendu un surcoût, que Nvidia estime à 20$.

Avec la sensibilité de DirectTouch et l'exploitation de la puissance de calcul du GPU de Tegra 4 et 4i pour analyser les données, Nvidia est parvenu à obtenir un excellent résultat avec un simple stylet. De quoi permettre des courbes très précises, de varier l'épaisseur des traits avec la pression exercée (ce qui élargi la base du stylet) etc., et bien entendu de quoi ajouter de la valeur aux SoC Tegra vu l'économie non négligeable que cette approche autorise.

Démonstration de calligraphie chinoise par Jen-Hsun Huang, CEO de Nvidia.

Au passage, Nvidia démontre que même avec un GPU en retrait d'une génération sur la concurrence au niveau de la flexibilité de ses unités de calcul, ses équipes de développement sont loin d'être les mains liées par rapport à l'exploitation de cette puissance de calcul dans des domaines autres que le rendu 3D.

Reste à voir quand Nvidia pourra finaliser cette technologie et si elle séduira ses partenaires, d'autant plus que la question de l'incidence sur la consommation n'a pas été abordée et qu'il est possible qu'utiliser DirectTouch et le GPU soit moins efficace à ce niveau qu'utiliser un contrôleur dédié et un stylet actif.

Computex: Intel mise tout sur les portables 2-en-1

S'il est un message difficile à manquer sur le Computex, c'est bien celui d'Intel qui crie son amour aux portables 2-en-1 sur tous les toits de la capitale taiwanaise. Par portables 2-en-1, Intel vise tout ce qui peut se rattacher de près ou de loin à cette définition, que ce soit la possibilité de se transformer en tablette (peu importe la méthode) ou encore la présence d'un double écran. Nous n'aurons pas la confirmation que le portable/cafetière est également pris en compte, mais il ne semble visiblement pas exclu.

Le potentiel polyvalent et le côté tendance voire gadget de ces machines les rendent séduisantes aux yeux du grand public selon un sondage maison qui indiquerait que près de 75% des personnes qui considèrent l'achat d'un portable préfèrent un design 2-en-1, dont 20% avec une préférence pour un modèle qui permet de détacher l'écran du clavier.

Si Intel s'intéresse autant à ces portables 2-en-1, c'est également parce que les contraintes qui les accompagnent permettent de mettre en avant les derniers développements de l'architecture IA. Encore plus que dans un ultraportable classique, la maîtrise de la consommation revêt un aspect primordial et sur ce point Intel entend bien profiter d'Haswell mais également du futur Atom Bay Trail.

Par ailleurs, mettre au point de telles machines demande généralement de relever de nouveaux défis au niveau des chaînes de fabrication, là aussi un point sur lequel Intel a énormément investi pour pousser ses partenaires à suivre sa vision. Toujours concernant ses investissements, Intel annonce par ailleurs les premiers fruits du dernier en date : un fond de 100 millions de dollars dédié au Perceptual Computing. Intel a travaillé à la mise au point de sa propre technologie de webcam et ces travaux ont aboutis avec des premiers produits qui prendront place dans les ultraportables dès fin 2014. Nous n'en saurons pas plus même si de manière évidente il sera question de détection de mouvements, d'usages qui profitent des CPU modernes etc.

Kirk Skaugen, SVP et General Manager du PC Client Group, présente un prototype de la future webcam mise au point par Intel.

Développer le portable 2-en-1 est probablement la meilleure parade d'Intel face au tassement du marché PC puisqu'il permet de conserver dont son giron toute une frange de la population qui pourrait être tentée par abandonner le PC pour une simple tablette. C'est une approche qui permet d'attirer la concurrence ARM sur un champ de bataille mieux maîtrisé, cette concurrence n'étant pas encore capable d'offrir un niveau de performances suffisant pour une expérience PC complète. C'est également dans cette optique qu'Intel investi énormément dans la recherche qui concerne de nouveaux usages, de manière à donner des utilités à ses derniers composants et garder une longueur d'avance sur la concurrence.

Intel annonce avoir en préparation avec ses partenaires, principalement taiwanais (Acer, Asus etc.) plus de 50 designs de type 2-en-1, un chiffre qui englobe autant les plateformes Haswell que Bay Trail. Reste à voir si les prévisions optimistes d'Intel en termes d'intentions d'achat des utilisateurs face aux modèles 2-en1 se confirmeront en pratique.

Computex: Cortex-A12 : ARM sous pression ?

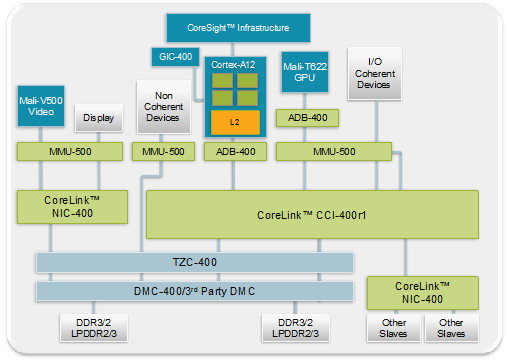

ARM a profité du Computex pour dévoiler plusieurs nouvelles propriétés intellectuelles qui seront proposées sous licences à ses clients. La plus importante est un nouveau core CPU ARMv7 : le Cortex-A12. Il se situera entre les actuels Cortex-A7 et A15 sur le plan des performances mais n'arrivera dans des SoC commerciaux qu'à la fin de l'an prochain. Un core qui a de toute évidence été développé relativement tard de manière à combler une lacune importante dans la gamme proposée par ARM.

Si le Cortex-A7 s'approche de du Cortex-A9 original en termes de performances, il ne permet pas réellement de le remplacer d'autant plus que la demande pour plus de puissance single thread est pressante. L'évolution r4 du Cortex-A9 qui sera par exemple utilisée dans le Tegra 4i permet de rajeunir quelque peu ce core, mais ce n'est pas suffisant pour lutter face à la compétition. Et bien entendu, le Cortex-A15, s'il est plus performant et pose une bonne base pour de futures évolutions, est également beaucoup plus imposant, très gourmand d'une manière absolue mais également relative puisqu'il réduit l'efficacité énergétique. Un point qu'Intel n'hésite par ailleurs pas à mettre en évidence lors d'une démonstration au Computex en comparant un SoC à base de Cortex-A15 à un Ivy Bridge 7W nettement plus véloce.

Un meilleur compromis est de toute évidence nécessaire et ce sera la tâche du Cortex-A12 de combiner évolutions de performances et du rendement énergétique, ce qui permettra de mettre enfin le Cortex-A9 à la retraite.

Le Cortex-A12 est un core OoO (out-of-order) complet dual-issue, à comparer au triple-issue du Cortex-A15 et au fonctionnement OoO limité du Cortex-A9. Le sous-système mémoire, peu performant sur le Cortex-A9 a été revu pour se rapprocher de celui du Cortex-A15 et la compatibilité est assurée avec big.LITTLE, même si l'écart de performances qui se réduit entre un Cortex-A7 et un Cortex-A12 rendra probablement cette approche peu intéressante.

Parallèlement, ARM a également dévoilé le GPU Mali-T622, une version double "cœur" du Mali-T628 et de ses 8 "cœurs", de quoi pouvoir proposer une architecture moderne, notamment au niveau compute, avec un coût moindre tant au niveau de l'implémentation sur le die que de la consommation. Un nouveau core vidéo, le Mali-V500 fait son apparition et est lui aussi destiné à réduire la consommation, à travers une nouvelle technique de compression lossless, l'utilisation de la bande passante mémoire ayant un coût énergétique très élevé.

Avec ces nouvelles solutions, ARM estime être enfin mieux armé pour s'attaquer au futur juteux marché des smartphones milieu de gamme, qui est en train d'exploser et devrait dépasser le marché des périphériques haut de gamme d'ici deux ans.

GTC: Performances GPU de Logan = GT 640M ?

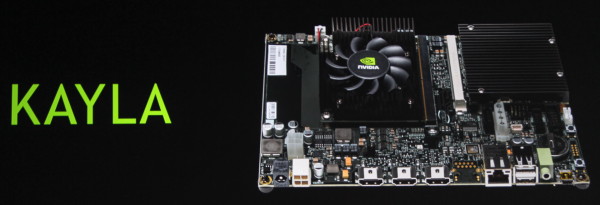

Durant la GTC 2013, nous avons pu nous entretenir avec Ian Buck qui est à l'origine de la première version de CUDA et actuellement General Manager chez Nvidia pour les technologies du GPU Computing. Interrogé au sujet de Kayla, la plateforme de développement CUDA on ARM équipée d'un GPU GK208, Ian Buck nous a indiqué que les performances GPU, au niveau de CUDA, étaient bel et bien représentatives de celles de Logan, sans vouloir en dire plus.

Bien que ce niveau de performances représente le bas de gamme sur PC, il s'agit d'une évolution énorme pour un SoC Tegra. Si le passage au 20nm et sans aucun doute plusieurs évolutions de l'architecture (avec probablement une réduction du nombre d'unités de texturing), faciliteront l'arrivée de l'architecture Kepler et de CUDA dans le monde ultra-mobile, il est difficile d'imaginer que ces 384 cores (ou équivalents) flexibles ne consommeront pas plus que les 72 cores avec pipeline fixe de Tegra 4.

De quoi nous laisser spéculer qu'avec Logan, Nvidia devra se contenter de versions bridées (en termes d'unités actives ou de fréquences) pour les "petites" tablettes et les superphones, mais compte par contre revoir ses prétentions à la hausse avec un SoC capable de monter en gamme pour viser les "grosses" tablettes voire des ultra-portables et bien entendu le successeur de Shield.

Parallèlement à cela, Ian Buck nous a indiqué que CUDA devrait progressivement devenir "power aware" et devenir capable de prendre en compte l'aspect consommation ou tout du moins de permettre aux développeurs de le faire. Cela se fera tout d'abord au niveau des outils tels que Nsight (et sa version Tegra) qui d'ici quelques temps reporteront des informations liées à la consommation.

Il est possible qu'à terme, les compilateurs CUDA, permettent optionnellement d'améliorer le rendement énergétique, mais cela est encore à l'état de recherche et prendra encore plusieurs années avant d'éventuellement se concrétiser. Globalement, la meilleure stratégie reste d'exécuter le plus rapidement une tâche pour retourner au repos dès que possible mais ce n'est pas toujours vrai, d'autant plus dans le cas d'une tâche continue telle que le rendu 3D sur GPU. Par exemple, calculer une valeur au lieu de la lire en mémoire peut avoir un léger impact sur les performances mais augmenter le rendement énergétique.

En plus de préparer le futur avec CUDA, dans l'immédiat, le plus important pour Nvidia est probablement d'arriver à convaincre un maximum de développeurs que faire l'effort nécessaire pour arriver à utiliser 2 threads ou plus à fréquence modérée offre un meilleur rendement que se contenter d'un seul thread mais des performances de la fréquence CPU maximale.

Correction du 01/07/2013: le nom du GPU que nous pensions être GK117 est en réalité GK208.

GTC: 5W Pour Tegra 4 et 1W pour Tegra 4i ?

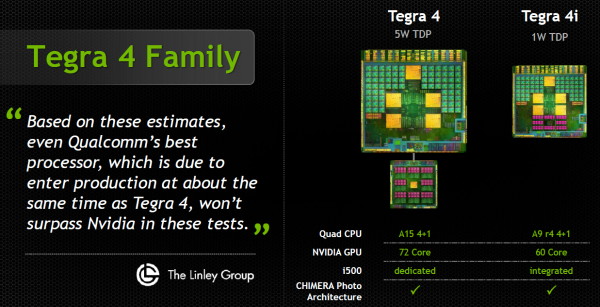

Lorsque nous avions rencontré Nvidia pour parler de l'architecture des Tegra 4 et 4i, il y a un point que le concepteur de ces SoC a catégoriquement refusé d'aborder : la consommation en charge et le TDP. Des chiffres délicats à avancer et à assumer puisque de toute évidence, la consommation maximale de Tegra 4 sera supérieure à celle de Tegra 3. Ceci n'étant bien entendu pas incompatible avec un rendement énergétique supérieur et avec une consommation en baisse lors de scénarios de types charge faible.

Lors d'une présentation dédiée aux investisseurs qui a suivi la keynote principale de la GTC, Jen-Hsun Huang, CEO de Nvidia, a avancé des chiffres concernant les TDP des futurs SoC : 5W pour Tegra 4 et 1W pour Tegra 4i. Deux chiffres relativement faibles, voire très faibles dans le cas du Tegra 4i qui intègre pour rappel 4 Cortex-A9 r4, un GPU relativement véloce et un modem 4G/LTE.

Pour comprendre ces chiffres, il faut cependant savoir que la définition du TDP est à géométrie variable, comme nous l'avions expliqué en nous intéressant de plus près au SDP d'Intel. Globalement le TDP représente la capacité de refroidissement nécessaire pour garantir le bon fonctionnement du composant. Historiquement cela représentait sa limite haute de consommation, mais progressivement, le fait de pouvoir fonctionner à une fréquence réduite pour éviter une surchauffe a été intégré à la définition même de "bon fonctionnement". Ajoutez-y les modes turbo et la prise en compte de l'inertie thermique et vous comprendrez qu'il devient difficile d'interpréter l'impact exact du TDP sur la consommation et sur les performances.

Les chiffres de 5W et de 1W avancés par Nvidia représentent ainsi probablement la capacité de dissipation nécessaire pour les variantes les moins gourmandes de Tegra 4 et de Tegra 4i. Des chiffres qui permettent de se faire une idée des types de designs et de formats qui pourront accueillir ces composants. De quoi confirmer que Tegra 4 est plutôt adapté à une tablette alors que Tegra 4i pourra être intégré facilement dans des smartphones compacts.

Difficile de dire par contre quel sera le niveau de performances soutenu autorisé par ces TDP puisqu'il est probable, comme c'est le cas pour la plupart des SoC actuels, que les Tegra 4 et 4i soient autorisés à consommer plus que cette valeur, jusqu'à atteindre une certaine température et voir leurs fréquences réduites. En plus de ces TDP, soit de la capacité de dissipation requise, il serait ainsi intéressant de connaître la capacité de dissipation conseillée par Nvidia pour pouvoir tirer le meilleur de ces SoC en termes de performances, notamment en ce qui concerne le jeu qui représente l'une des tâches les plus gourmandes qu'ils auront à exécuter.

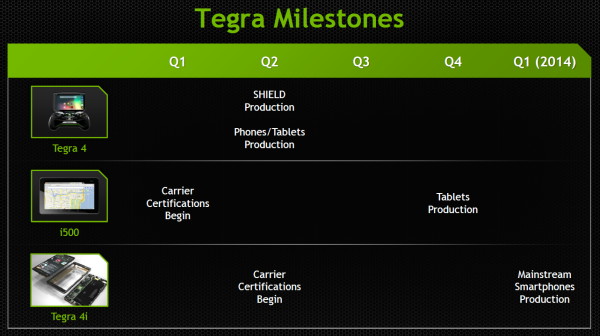

Enfin, notez que le CEO de Nvidia a précisé le timing de l'entrée en production des périphériques qui intégreront ces futurs SoC : Q2 2013 pour Shield, les tablettes et les superphones Tegra 4, Q4 2013 pour les tablettes Tegra 4 + modem i500 et enfin Q1 2014 pour les smartphones Tegra 4i (i500 intégré).