Nvidia GeForce GTX Titan en test : big Kepler débarque enfin !

Publié le 21/02/2013 par Damien Triolet

GPU Boost 2.0 ?

Tout comme les GeForce GTX 600, la GeForce GTX Titan profite d'un turbo dénommé GPU Boost pour pouvoir monter en fréquence sous certaines conditions. Officiellement, pour les GeForce GTX 600, il s'agit d'une seule condition, la limite de consommation. Par exemple, le turbo d'une GeForce GTX 680 ne pourra pas s'activer au-delà de 170W. Pour la GeForce GTX Titan, entre également en jeu une limite de température et son turbo doit faire en sorte de ne dépasser ni 235W, ni 80 °C. C'est la raison pour laquelle Nvidia communique sur un GPU Boost "2.0", en insistant sur le fait que cette nouvelle version permet de monter relativement plus haut en fréquence dans plus de cas.

Tout comme les GeForce GTX 600, la GeForce GTX Titan profite d'un turbo dénommé GPU Boost pour pouvoir monter en fréquence sous certaines conditions. Officiellement, pour les GeForce GTX 600, il s'agit d'une seule condition, la limite de consommation. Par exemple, le turbo d'une GeForce GTX 680 ne pourra pas s'activer au-delà de 170W. Pour la GeForce GTX Titan, entre également en jeu une limite de température et son turbo doit faire en sorte de ne dépasser ni 235W, ni 80 °C. C'est la raison pour laquelle Nvidia communique sur un GPU Boost "2.0", en insistant sur le fait que cette nouvelle version permet de monter relativement plus haut en fréquence dans plus de cas.Reste que selon nos observations, ce n'est pas correct : en réalité il ne semble y avoir aucune évolution technique et Nvidia semble simplement essayer de générer artificiellement un effet de nouveauté en mettant en avant un "2.0", qui plus est en présentant un bénéfice douteux.

Le turbo des GeForce GTX 600 doit lui aussi respecter une limite de température, 95 °C pour une GeForce GTX 680, toujours d'après nos observations puisque Nvidia refuse de communiquer à ce niveau. Plus qu'un nouveau GPU Boost, la GeForce GTX Titan exploite la même technologie que les GeForce GTX 600 mais avec une philosophie différente : la limite de température est nettement plus agressive de manière à s'assurer que les nuisances sonores restent réduites. En pratique, avec le ventirad de référence, ce sera donc elle qui régulera la fréquence du GPU, et non son niveau de consommation.

Cette calibration différente des limites à respecter pour GPU Boost permet-elle de monter plus haut et plus souvent en fréquence ? Nous ne sommes pas d'accord avec cet argument. Dans la plupart des situations, comme la logique le veut, une forte contrainte de plus à respecter ne peut pas donner plus de liberté à GPU Boost, bien au contraire.

Parmi les arguments avancés par Nvidia pour justifier son affirmation, l'un d'entre eux est cependant valide : la possibilité de valider une tension plus élevée. Le fabricant rappelle ainsi que tension et température élevées ne font pas bon ménage lorsqu'il s'agit de s'assurer de la longévité d'une puce électronique. En limitant la température à 80 °C, Nvidia peut valider en toute sécurité une tension plus élevée : 1.1625V pour la GeForce GTX Titan contre 1.1500V pour les GeForce GTX 600. Soit un palier de plus qui correspond à un gain de 13 MHz pour le turbo.

Le problème est qu'avec le système de refroidissement de référence, pourtant très efficace, il est presqu'impossible d'atteindre ce palier, si ce n'est pour quelques dizaines de secondes, soit juste le temps de lancer un bench…

GPU Boost , quelle fréquence ?Rappelons que GPU Boost n'est pas déterministe. D'une part parce qu'il repose sur des mesures de consommation et de température réelles et non sur une estimation basée sur de nombreux capteurs internes comme le font les CPU et les Radeon pour assurer un comportement identique sur tous les échantillons produits. Par ailleurs, Nvidia ne valide pas tous ces échantillons à la même fréquence turbo maximale.

AMD, et Nvidia auparavant, valide ses GPU à une fréquence fixe mais avec une tension qui peut être différente, pour s'adapter à la variabilité de la production : certains GPU peuvent avoir besoin d'une tension élevée pour être stables alors que d'autres ont besoin d'une tension plus faible pour respecter le TDP.

Depuis la génération Kepler, Nvidia a opté pour une approche différente. La tension, ou plutôt la courbe des tensions, est fixe et chaque GPU est validé pour les fréquences maximales qu'il est capable de tenir le long de cette courbe. Les tensions évoluent par pas de 0.0125V et les fréquences par 13 MHz.

La fréquence GPU Boost annoncée par Nvidia n'est fondée sur aucun élément technique, il s'agit d'un point de communication plus ou moins abstrait. La fréquence turbo maximale n'est pas liée à cette valeur. Comme pour les GeForce GTX 600, Nvidia refuse d'indiquer quelle est la plage sur laquelle les fréquences sont validées. Quelle est la fréquence turbo maximale à laquelle peut être validée une GeForce GTX Titan ? Quelle est la fréquence que son turbo doit au moins pouvoir atteindre pour que le GPU soit validé en tant que GTX Titan ?

Nvidia s'est contenté de nous dire que cette fréquence turbo devait au moins être supérieure à la fréquence GPU Boost officielle de la GTX Titan mais sans vouloir donner de chiffre. Nous devons donc présumer qu'il s'agit de la fréquence GPU Boost annoncée + 13 MHz soit 889 MHz. Notre échantillon est pour sa part capable de monter bien plus haut, jusqu'à 1006 MHz ! Entre deux GTX Titan, il peut donc y avoir un écart de performances significatif.

GPU Boost en graphique et overclockingNous avons mis en graphique différents exemples de courbes de couples fréquence/tension. Suivant la température et le niveau de consommation, chaque GPU évoluera sur sa propre courbe. Tout d'abord, en vert foncé, la courbe réelle de notre échantillon (notez qu'il ne dispose pas de palier à 1.1250V mais en dispose de 2 à 1.150V). En vert clair, ce que nous présumons correspondre à la moins douée des GTX Titan et un exemple moyen entre les 2.

Avec la GTX Titan, Nvidia autorise l'overvolting. Il est ainsi possible de prolonger la courbe des GTX Titan de quelques bins supplémentaires via des tensions de 1.1750V, 1.1875V et 1.2V, soit de quoi gagner 26 MHz dans le cas de notre échantillon. Nous avons représenté son influence en rouge. Notez que ces tensions plus élevées pourront avoir un impact sur la durée de vie du GPU, d'autant plus si vous augmentez également la limite de température, et que les fabricants seront libres de ne pas autoriser cet overvolting.

Overclocker un GPU passe traditionnellement par une augmentation de ses fréquences. La mémoire de notre échantillon a ainsi pu passer de 1.5 à 1.8 GHz. Quant au GPU, nous avons pu le pousser de 104 MHz. Attention, il ne s'agit pas d'une simple augmentation de la fréquence mais d'un biais, ou offset, appliqué à sa courbe des couples fréquences/tensions, ce qui est illustré en bordeaux.

Avec les GeForce GTX 600 et Titan, l'overclocking a pris une autre dimension et augmenter la fréquence maximale à travers un offset peut ne pas avoir d'importance si la consommation ou la température limite le turbo. Par contre, sur une GTX Titan, augmenter la limite de température permettra en pratique au GPU de fonctionner à une fréquence plus élevée.

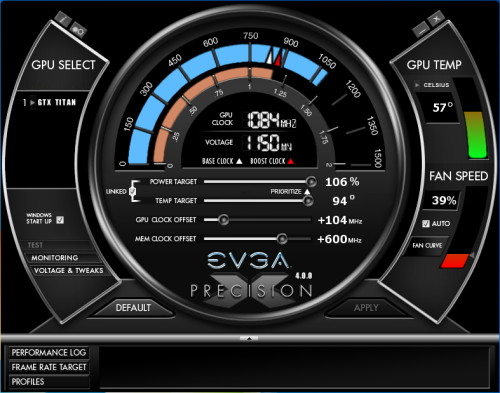

Precision X d'EVGA en version 4.0 est prêt pour la GTX Titan. Il expose la limite de température de GPU Boost, mais à travers ses pilote Nvidia bloque l'accès à ce paramètre pour les GeForce GTX 600.

L'offset pourra également jouer un rôle, mais bien souvent pour une raison autre que l'augmentation de la fréquence maximale : appliquer un offset positif revient à réduire la tension relative et donc la consommation relative. Ainsi, alors que notre échantillon, dont la fréquence maximale est de 1006 MHz, était limité à 901 MHz dans Anno, avec un offset de 104 MHz, il était capable de tenir 954 MHz. Cet offset revient en effet à réduire la tension de 0.1V ! Il ne faut donc pas penser uniquement en termes de fréquence maximale.

Autre remarque, lors d'un overclocking via l'offset de la fréquence GPU, il est possible que le GPU tienne la fréquence maximale, mais pas une fréquence plus faible : toujours sur base de notre graphe exemple, ce n'est pas parce que notre GPU est capable de tenir 1136 MHz à 1.2V qu'il est également capable de tenir 941 MHz à 1.0V !

Et en mode DP ?Lorsque la double précision rapide est activée, GPU Boost est désactivé et le GPU de la GTX Titan fonctionne d'une manière plus rigide. Voici ce que nous avons pu observer :

850 MHz @ 1.1625V si t° GPU < 80°C

837 MHz @ 1.1500V si 80°C ≤ t° GPU < 85°C

811 MHz @ 1.1375V si 85°C ≤ t° GPU < 95°C

405 MHz @ 1.1375V si t° GPU ≥ 95°C

Sommaire

1 - Introduction

2 - Le GK110

3 - Spécifications, la GeForce GTX Titan

4 - GPU Boost et overclocking

5 - Bruit et températures

6 - Consommation, efficacité énergétique

7 - Performances théoriques : pixels

8 - Performances théoriques : géométrie

9 - Protocole de test

10 - GPU Boost dans les tests

11 - GTX Titan vs GTX 660 Ti 3 Go SLI

12 - Benchmark : 3DMark et Unigine

13 - Benchmark : Alan Wake

14 - Benchmark : Anno 2070

2 - Le GK110

3 - Spécifications, la GeForce GTX Titan

4 - GPU Boost et overclocking

5 - Bruit et températures

6 - Consommation, efficacité énergétique

7 - Performances théoriques : pixels

8 - Performances théoriques : géométrie

9 - Protocole de test

10 - GPU Boost dans les tests

11 - GTX Titan vs GTX 660 Ti 3 Go SLI

12 - Benchmark : 3DMark et Unigine

13 - Benchmark : Alan Wake

14 - Benchmark : Anno 2070

15 - Benchmark : Assassin's Creed 3

16 - Benchmark : Batman Arkham City

17 - Benchmark : Battlefield 3

18 - Benchmark : Civilization V

19 - Benchmark : Crysis 2

20 - Benchmark : DiRT Showdown

21 - Benchmark : Far Cry 3

22 - Benchmark : Hitman Absolution

23 - Benchmark : Max Payne 3

24 - Benchmark : Sleeping Dogs

25 - Benchmark : The Witcher 2 Enhanced Edition

26 - Benchmark : Total War Shogun 2

27 - Récapitulatif des performances

28 - Conclusion

16 - Benchmark : Batman Arkham City

17 - Benchmark : Battlefield 3

18 - Benchmark : Civilization V

19 - Benchmark : Crysis 2

20 - Benchmark : DiRT Showdown

21 - Benchmark : Far Cry 3

22 - Benchmark : Hitman Absolution

23 - Benchmark : Max Payne 3

24 - Benchmark : Sleeping Dogs

25 - Benchmark : The Witcher 2 Enhanced Edition

26 - Benchmark : Total War Shogun 2

27 - Récapitulatif des performances

28 - Conclusion

Vos réactions

Contenus relatifs

- [+] 04/05: Nvidia abandonne son GeForce Partne...

- [+] 18/04: ASUS AREZ, l'effet GeForce Partner ...

- [+] 10/04: Nvidia : fin du support Fermi et 32...

- [+] 27/03: Pilotes Radeon et GeForce pour Far ...

- [+] 20/03: Pilotes GeForce 391.24 pour Sea of ...

- [+] 20/03: Microsoft annonce DirectX Raytracin...

- [+] 08/03: 3 millions de GPU vendus pour le mi...

- [+] 09/02: Résultats records pour Nvidia

- [+] 30/01: Pilotes GeForce 390.77 pour Metal G...

- [+] 25/01: AMD annonce la restructuration de R...