Les derniers contenus liés aux tags Nvidia et HBM2

Tesla V100 décliné en PCIe

Nvidia dévoile le GV100: 15 Tflops, 900 Go/s

GTC: Nvidia Tesla P100: 10 Tflops, HBM2...

Tesla V100 décliné en PCIe

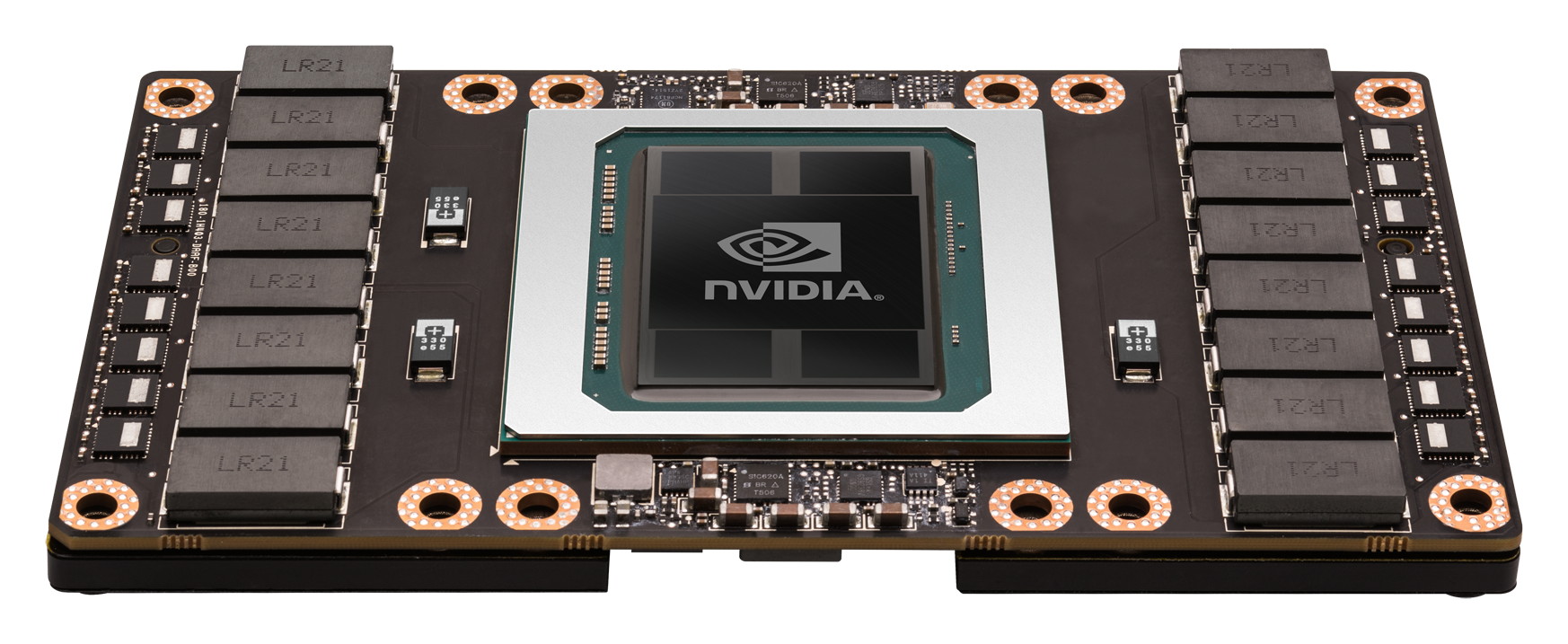

NVIDIA annonce la déclinaison PCIe de son accélérateur Tesla V100. Il utilise toujours l'énorme GV100, gravé en 12nm FFN par TSMC et disposant de pas moins de 21,1 milliards de transistors.

Avec un TDP réduit à 250W contre 300W pour la version mezzanine, les performances sont légèrement revues à la baisse avec une puissance annoncée à 7 Tflops en double précision et 14 Tflops en simple précision en boost, soit une fréquence passant de 1455 à 1370 MHz environ. On dispose par contre toujours de 16 Go de HBM2 à 900 Go/s.

La disponibilité est annoncée pour "plus tard dans l'année", sans plus de précisions. Nvidia indique au passage que le supercalculateur Summit à base de V100 du département de l'énergie américain, annoncé en 2014 et désormais prévu pour 2018, disposera d'une puissance de 200 petaFLOPS (l'intervalle donnée initialement était de 150-300).

Nvidia dévoile le GV100: 15 Tflops, 900 Go/s

Nvidia profite de sa GPU Technology Conference pour dévoiler quelques détails sur le GV100, le premier GPU de la génération Volta qui sera dédié au monde du calcul et en particulier de l'intelligence artificielle.

Comme c'est à peu près le cas chaque année, le CEO de Nvidia Jen Hsun Huang vient de profiter de la GTC pour dévoiler les grandes lignes du premier GPU de sa future génération Volta. Ce sera un monstre clairement orienté vers l'intelligence artificielle, un débouché qui monte en puissance pour les GPU Nvidia.

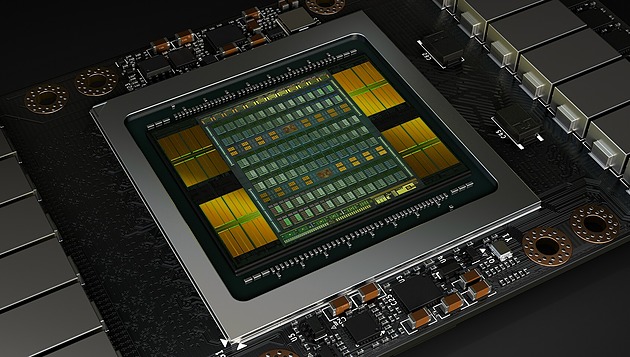

Le GV100 est le successeur direct du GP100 et reprend un format similaire : il s'agit d'une puce énorme placée sur un interposer avec 4 modules HBM2. Grossièrement c'est la même chose en mieux : plus gros et plus évolué.

Plus gros tout d'abord avec un GV100 qui profite de la gravure en 12 nm FFN de TSMC (personnalisé pour Nvidia) pour passer à 21.1 milliards de transistors, plus de 30% de plus que les 15.3 milliards du GP100. Malgré le passage au 12 nm, la densité ne progresse presque pas et le GV100 est énorme avec 815 mm² contre 610 mm² pour le GP100. Le 12 nm permet ici avant tout de pouvoir monter en puissance à consommation similaire.

Tout comme le GP100, le GV100 utilise des "demi SM" par rapport aux GPU grand public. Leur nombre passe de 60 à 84, ce qui représente 5376 unités de calcul. Ils restent répartis dans 6 blocs principaux, les GPC, ce qui laisse penser que Nvidia a tout misé sur un gain de puissance de calcul, sans trop toucher au débit de triangles ou de pixels qui étaient déjà à un niveau très élevé sur GP100.

Comme sur le GP100, ces SM sont capables de traiter différents niveau de précision : FP16 (x2), FP32 et FP64 (/2). Par ailleurs, Nvidia a ajouté quelques instructions spécifiques au deep learning et y fait référence en tant que tensor cores. Ils permettent aux algorithmes qui y feront appel de doubler la mise par rapport aux instructions 8-bits (produit scalaire avec accumulation) des GPU Pascal (sauf GP100) et du futur Vega d'AMD. A voir évidemment dans quelle mesure les différents algorithmes de deep learning pourront profiter de ces nouvelles instructions.

Nvidia en a profité pour améliorer le sous-système mémoire qui sera plus flexible pour demander moins d'efforts d'optimisation de la part des développeurs. Le cache L2 passe de 4 à 6 Mo et de la HBM2 Samsung plus rapide est exploitée mais qui restera au départ limitée à 4 Go par module soit 16 Go au total. Par ailleurs, le GV100 profite de 6 liens NV-Link de seconde génération (25 Go/s dans chaque direction) pour offrir une interface qui peut monter à 300 Go/s.

Le premier accélérateur qui profitera du GV100 est comme nous pouvions nous y attendre le Tesla GV100 qui sera initialement proposé dans un format de type mezzanine. Un tel module sera bien entendu gourmand mais Nvidia parle d'une enveloppe thermique maximale qui reste à 300W. Par ailleurs, deux modes énergétique seront proposé : Maximum Performance et Maximum Efficiency. Le premier autorise le GV100 à profiter de toute son enveloppe de 300W alors que le second limite probablement la tension maximale pour maintenir le GPU au meilleur rendement possible, ce qui a évidemment du sens pour de très gros serveurs.

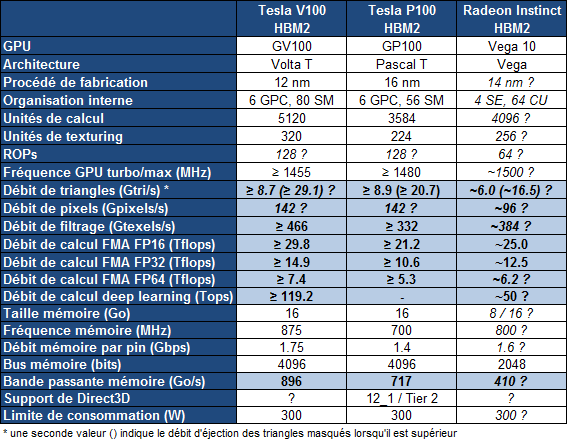

Sur le Tesla GV100, le GPU sera amputé de quelques unités de calcul, pour faciliter la production seuls 80 des 84 SM seront actifs. Voici ce que cela donne :

Le Tesla GV100 augmente la puissance brute de 40% par rapport au Tesla GP100, mais ses différentes optimisations feraient progresser les performances en pratique de +/- 60% dans le cadre du deep learning selon Nvidia. La bande passante mémoire progresse un peu moins avec "seulement" +25%, mais le cache L2 plus important et diverses améliorations compensent quelque peu cela.

Le GV100 devrait devancer assez facilement le Vega 10 d'AMD, mais ce dernier devrait être commercialisé en version Radeon Instinct à un tarif nettement moindre que le Tesla GV100 et en principe plus tôt. Nvidia parle de son côté du troisième trimestre et de 150.000$ pour les premiers serveurs DGX-1 équipés en GV100 et de la fin de l'année pour les accélérateurs au format PCI Express. Nvidia proposera évidemment d'ici-là des versions mises à jour de ses logiciels, compilateurs et autres librairies dédiées au deep learning.

GTC: Nvidia Tesla P100: 10 Tflops, HBM2...

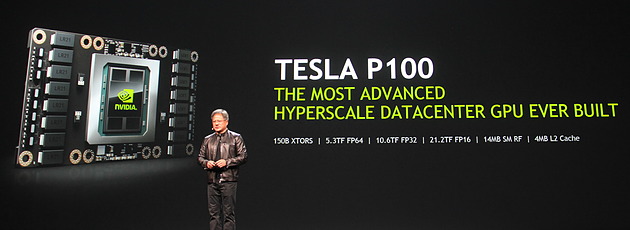

Comme prévu, Jen-Hsun Huang, le CEO de Nvidia, a levé un coin du voile concernant le premier produit Pascal, l'accélérateur Tesla P100. Au menu : 15 milliards de transistors, 10 Tflops, HBM2, 4 Mo de L2…

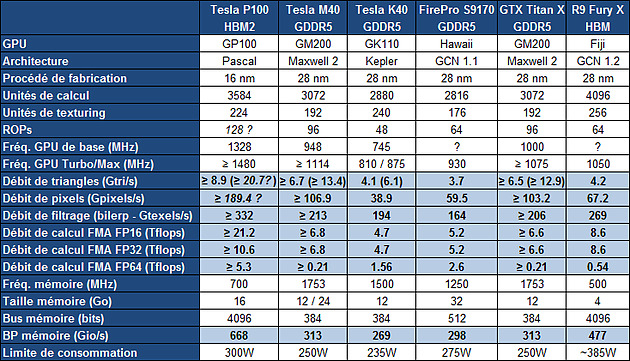

Le Tesla P100 est un nouvel accélérateur dédié au calcul massivement parallèle qui embarque un GPU GP100, auquel nous faisions référence précédemment en tant que Pascal, nom de code de son architecture. Il s'agit bel et bien d'un nouveau monstre de puissance. Pour cette première utilisation de procédé de fabrication 16nm FinFET Plus, Nvidia n'a pas eu peur de concevoir un énorme GPU et le GP100 intègre pas moins de 15.3 milliards de transistors répartis sur 610 mm². A comparer aux 8 milliards de transistors de l'actuel GM200 qui mesure également 600 mm².

De quoi pouvoir pousser la puissance de calcul vers le haut mais surtout intégrer de nouvelles fonctionnalités avant tout dédiées au monde du HPC telles que la connectique NVLink qui offre une bande passante combinée de 160 Go/s.

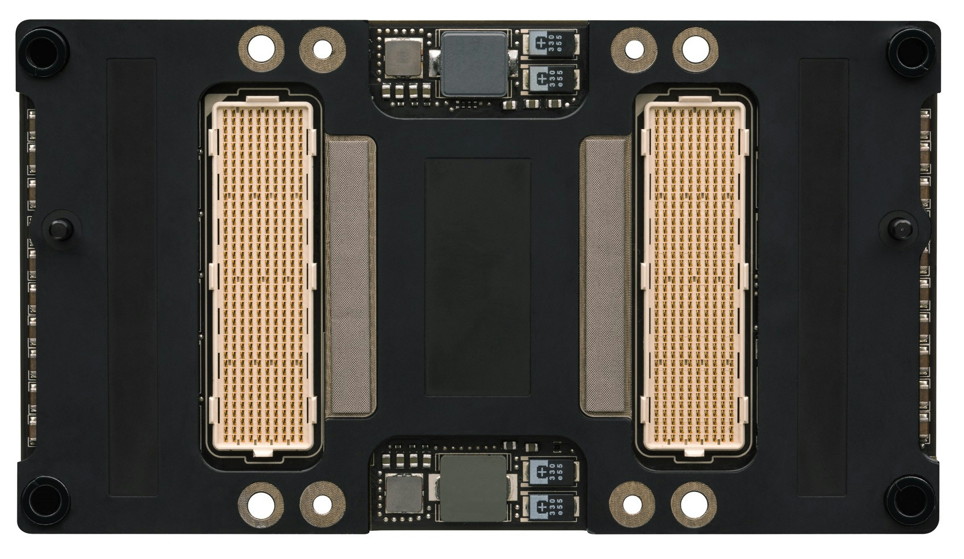

Le Tesla P100 se présente sous la forme d'un module au format mezzanine qui revient à superposer 2 PCB, avec un ou plusieurs connecteurs entre ceux-ci. Sur le Tesla P100 il s'agit de 2 connecteurs de 400 broches qui vont permettre de proposer la connectique NVLink. Ce format facilite également l'intégration dans les serveurs et la mise en place d'un refroidissement performant ce qui permet à Nvidia de pousser le TDP à 300W.

Concernant la puissance brute du Tesla P100, Nvidia annonce 10.6 Tflops avec GPU Boost en FP32, la précision classique, un gain de 60% par rapport aux 6.6 Tflops de la Titan X. L'architecture Pascal dans cette implémentation supporte également la double précision en demi-vitesse, soit 5.3 Tflops, un nouveau bond en avant par rapport au record actuel : 2.6 Tflops pour le GPU Hawaii d'AMD des FirePro W9100 et S9170. Dans l'autre sens, Pascal supporte également la demi-précision, le FP16, et peut alors monter à 21.2 Tflops.

A quelle configuration de GPU pourrait correspondre tout cela ? Au départ, nous supposions que le nombre d'unités de calcul passerait de 3072 sur le GM200 à 4608 sur le P100, réparties dans 36 blocs d'unités de calcul (SMP ?), ce qui aurait permis assez facilement d'augmenter à peu près toutes les capacités brutes du GPU de 50%. Il n'en est cependant rien et les changements sont plus profonds au niveau de l'architecture. Il s'agit ainsi pour le Tesla P100 de 3584 unités de calcul réparties dans 56 blocs de 64, mais le GP100 continent physiquement 60 de ces blocs.

Le gain de puissance de calcul brute provient ainsi principalement d'une hausse de la fréquence du GPU (+/- 1.5 GHz) alors que le GPU computing devrait profiter de cette organisation en plus petits blocs d'unités de calcul, mais également des autres évolutions de l'architecture Pascal, pour gagner en efficacité.

Sur ce point, Nvidia se contente de parler d'une augmentation de la taille du fichier registre. Au total le GM200 embarque +/- 6 Mo de registres, ce qui correspond à 256 Ko par SMM ou encore à 512 registres 32-bit par unités de calcul. Le GP100 passe à 15 Mo de registres, ce qui implique une augmentation de 100%, soit 256 Ko par SMP ou encore 1024 registres 32-bit par unité de calcul. De quoi permettre de maintenir un meilleur taux d'occupation des unités de calcul, particulièrement en double précision.

Le cache L2 passe de son côté de 3 à 4 Mo alors que l'interface mémoire est large de 4096-bit en HBM2. Nvidia annonce une bande passante de 720 Go/s pour les 16 Go de mémoire HBM2 CoWoS, le nom donné par TSMC à sa technologie 2.5D, similaire à celle employée par AMD pour son GPU Fiji.

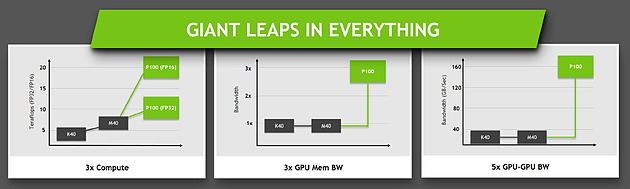

Ce passage à la mémoire HBM2, associé à NVLink, à la puissance de calcul en hausse et au support de la précision FP16 permet au Tesla P100 d'afficher une progression conséquente sur différents plans par rapport à ses prédécesseurs.

Jen-Hsun Huang a terminé le chapitre consacré à Pascal en déclarant que la production en volume avait débuté et que son propre serveur basé sur le Tesla P100 serait commercialisé à partir du mois de juin. Il est probablement raisonnable de s'attendre à une nouvelle GeForce Titan d'ici là, mais sera-t-elle basée sur le GP100 ?