| |

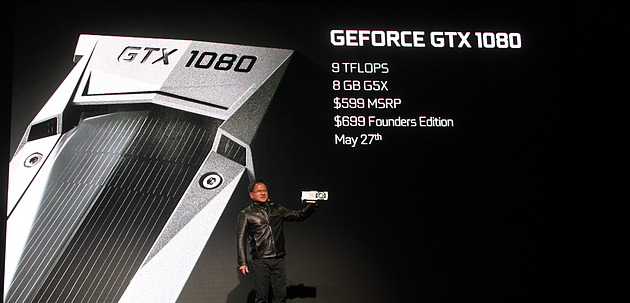

| Nvidia GeForce GTX 1080, le premier GPU 16nm en test ! Cartes Graphiques Publié le Mardi 24 Mai 2016 par Damien Triolet URL: /articles/948-1/nvidia-geforce-gtx-1080-premier-gpu-16nm-test.html Page 1 - Introduction  Après plus de 4 ans de bons et loyaux services auprès de nos GPU, le procédé de fabrication 28 nm de TSMC va progressivement tirer sa révérence pour laisser place à son propre 16 nm FinFET ainsi qu'au 14 nm de Samsung et GlobalFoundries, pour le plus grand bonheur des joueurs. Ce bond technologique va permettre à AMD et Nvidia de proposer des cartes graphiques plus intéressantes que ce soit en termes de fonctionnalités, de performances et / ou de rendement énergétique. Si AMD a communiqué le premier sur ses GPU Polaris fabriqués en 14 nm, c'est Nvidia qui débarque le premier sur le marché avec un GPU de la génération Pascal dédié aux joueurs : le GP104. En plus d'introduire le 16 nm de TSMC, il inaugure également l'utilisation de la mémoire GDDR5X qui permet de pousser la bande passante vers le haut sans faire exploser la consommation des modules. Ce GP104 s'inscrit directement dans la lignée des précédents GM204 et GK104 dans le sens où il ne s'agit pas encore du plus gros GPU que Nvidia proposera sur cette génération. Il arrivera plus tard, probablement l'an prochain. En attendant, cela ne va pas empêcher ce relativement petit GP104 de facilement prendre les devants face aux précédents ténors que sont les GeForce GTX 980 Ti et GTX Titan X. La première carte graphique à l'embarquer est donc un modèle très haut de gamme, positionné comme tel par Nvidia. Même si cela fera une nouvelle fois grincer quelques dents, ce positionnement est logique, d'autant plus qu'à ce niveau de performances la concurrence est inexistante. La GeForce GTX 1080 est annoncée à un tarif débutant à 599$ (670€) alors que le modèle de référence que nous allons vous présenter, et qui sera le premier disponible à partir du 27 mai, se négociera à partir de 699$, soit 790€ TTC en tarif officiel en Europe ! Pour rappel voici les tarifs de lancements des GeForce GTX x80 depuis 10 ans :

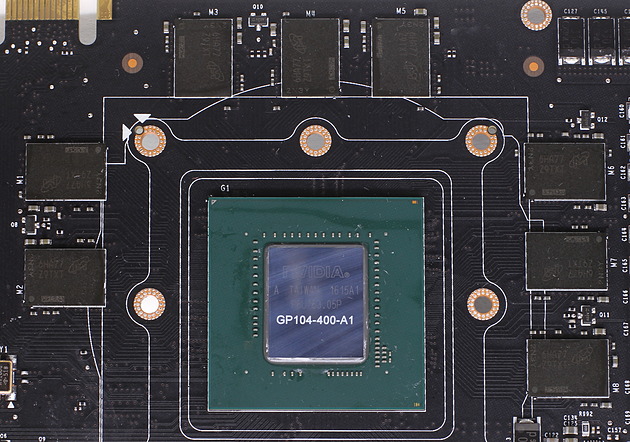

Mais à ce tarif, que vous propose exactement Nvidia ? Pour l'introduction de sa nouvelle architecture Pascal auprès des joueurs, Nvidia reprend la même approche que lors du lancement de la génération Maxwell. Le premier GPU à intégrer la famille GeForce est ainsi une puce de taille moyenne : le GP104. Après le GP100 dédié aux accélérateurs Tesla, il s'agit de la seconde puce Nvidia produite par TSMC sur le procédé de fabrication 16 nm FinFET Plus. (FF+). Après plus de 4 ans de GPU fabriqués en 28 nm chez le même TSMC, le passage au 16 nm FF+ représente une évolution significative qui permet de nouveaux compromis plus avantageux en termes de consommation énergétique, de performances et de fonctionnalités. Les choix de Nvidia pour ce GP104 peuvent se résumer en deux points : hautes fréquences et optimisations orientées vers la réalité virtuelle.  Le GP104 et sa mémoire GDDR5X.

Le GP104 et sa mémoire GDDR5X.Avant de rentrer dans les détails de son architecture, un petit rappel s'impose pour situer le GP104 parmi les GPU récents :

La taille maximale que les outils de productions actuels autorisent tourne autour des 600 mm², raison pour laquelle elle correspond aux plus gros GPU tels que le GP100. Avec 314 mm², le GP104 est donc bien un GPU de taille moyenne qui s'inscrit directement dans la lignée des GK104 (GTX 680) et GM204 (GTX 980). Comme nous allons le voir, un GPU de ce calibre en 16 nm exploite la même enveloppe thermique que le GM204 (180 W), ce qui laisse de la place pour un plus gros GPU basé sur les mêmes technologies mais destiné à une enveloppe thermique de 250W des GeForce GTX x80 Ti ou GTX Titan. Ce sera à priori un GPU différent du GP100, peut-être un futur GP102. Le passage au 16 nm permet évidemment de faire exploser la densité de transistors par rapport au 28 nm. Il ne faut cependant pas se fier à ces chiffres qui sont plus des noms commerciaux des procédés de fabrication que des mesures de la géométrie qui définissent leur densité. Ainsi, contrairement à ce qui a pu être vrai par le passé, le 16 nm ne permet pas de tripler le nombre de transistors par mm² par rapport au 28 nm. Ces technologies sont très complexes et la densité réelle est déterminée par de nombreux paramètres qui dépassent le cadre de cet article. Voici les densités relevées sur les GPU Nvidia les plus récents :

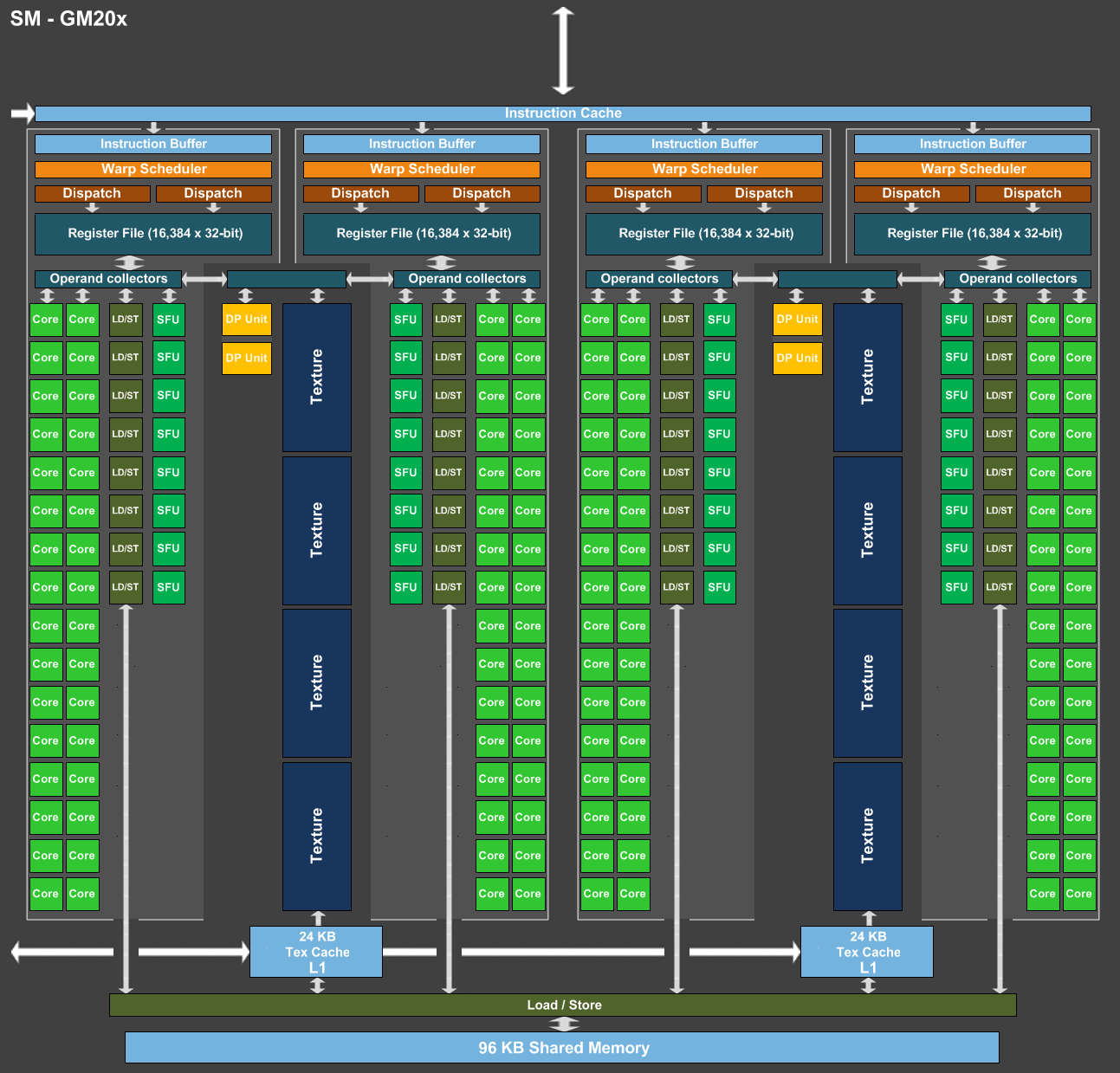

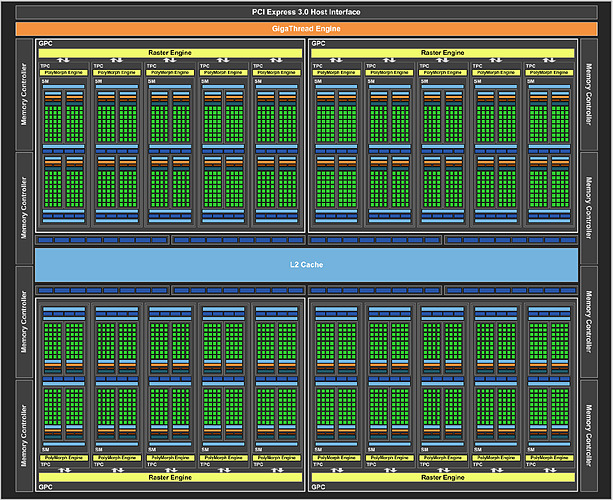

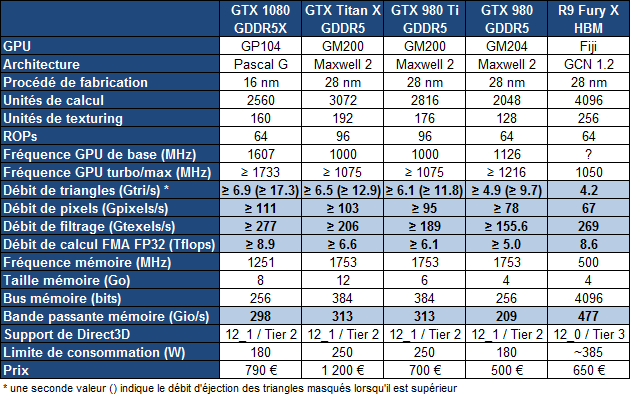

La densité est un petit peu plus élevée sur les plus gros GPU, probablement parce qu'une partie des E/S (entrées/sorties, I/O) à faible densité est identique et représente moins d'espace en proportion alors qu'à l'inverse ils intègrent en général plus de mémoire qui représente des structures plus denses. Entre le GP104 et le GM204, la densité progresse d'environ 75%. Mais cela ne veut pas dire que le GP104 embarque 75% de transistors en plus. Probablement en partie pour faire face aux coûts de production par wafer, et donc par mm², qui sont en hausse sur le 16 nm, Nvidia n'exploite à peu près que la moitié de ce gain potentiel de transistors et se contente d'une puce 20% plus petite. GP104 : SM, Pascal G et Pascal TPour comprendre l'architecture du GP104, quelques rappels s'imposent concernant la manière dont Nvidia schématise l'organisation interne de ses GPU. A un niveau élevé, ils se composent de un ou plusieurs GPC (Graphics Processing Cluster). Chacun contient un rasterizer chargé de projeter les primitives et de le découper en pixels. A l'intérieur de ces GPC, nous retrouvons un ou plusieurs TPC (Texture Processor Cluster). Ne vous fiez pas à ce nom, vestige de précédentes architectures, le TPC est aujourd'hui décrit comme la structure qui représente le Polymorph Engine, nom donné à l'ensemble des petites unités fixes dédiées au traitement de la géométrie (chargement des vertices, tessellation etc.). Enfin, au plus bas niveau, ces TPC intègrent un ou plusieurs SM (Streaming Multiprocessor) qui représentent le coeur de l'architecture. C'est à leur niveau que prennent place les unités de calcul, les unités de texturing, les registres ou encore la mémoire partagée utile au GPU computing. A noter que pour les GPU Kepler et Maxwell, Nvidia a mis de côté le TPC pour simplifier leur représentation schématique. Un seul SM est présent par TPC pour l'ensemble de ces GPU, il n'y avait donc pas de raison de faire une distinction entre ces deux structures. A l'intérieur d'un SM Maxwell ou Pascal, nous retrouvons une mémoire partagée (contrôlée par le développeur) et plusieurs partitions organisées en paires. Chaque partition contient entre autres sa propre logique d'ordonnancement, ses registres, une unité 32-bit vectorielle 32-way pour les instructions simples (qui représente 32 cores en termes marketing) et une unité SFU vectorielle 8-way pour certaines instructions complexes. Chaque paire de partitions partage 4 unités de texturing et un cache L1 de 24 Ko. Pour représenter les différents SM, nous avons modifié des diagrammes de Nvidia de façon à nous rapprocher de la réalité, au mieux de nos connaissances actuelles des différentes architectures :  [ SM - GM20x ] [ SM - GP104 ] [ SM - GP100 ] Comment se compare le SM de Pascal au SM de Maxwell ? Une question à laquelle il est à la fois simple et complexe de répondre puisque nous avons en fait affaire à 2 architectures Pascal différentes que nous qualifierons, en l'absence de mieux, de Pascal G comme GeForce dans le cas du GP104 et de Pascal T comme Tesla dans le cas du GP100. Pour Pascal G, c'est simple, le SM est fonctionnellement identique à celui des GPU Maxwell 2 (GM20x). Lorsque Nvidia a dévoilé l'architecture Pascal et le GP100, nous avons par contre pu découvrir une refonte importante du SM : il voit sa taille divisée par deux mais gagne de nombreuses unités de calcul en double précision (FP64) et profite de fichiers registres deux fois plus importants (128 Ko au lieu de 64 Ko par partition). La mémoire partagée des SM du GP100 passe de 96 à 64 Ko mais elle n'est associée qu'à deux partitions au lieu de 4 ce qui indique en réalité une augmentation relative de 33%. Ces représentations des architectures sont avant tout des vues d'esprit conçues par le département de marketing technique. Ainsi il est probablement correct de voir les choses sous un angle plus simple et d'imaginer un SM doté de 4 partitions pour Pascal T mais avec une mémoire partagée étendue à 128 Ko et une bande passante doublée. Il devait cependant être tentant de privilégier une communication technique sur 60 (petits) SM plutôt que sur 30 (gros) SM pour mettre en avant le GP100 dans le monde du GPU computing. Quoi qu'il en soit, Pascal T et Pascal G diffèrent sur plusieurs points. Tout d'abord, la puissance de calcul en double précision correspond à la moitié de la simple précision sur la première alors qu'elle chute à un débit de 1/32ème sur la seconde. Ensuite la quantité de mémoire disponible par partition est doublée sur Pascal T, ce qui permet de maintenir une bonne occupation des unités de calcul lorsque des programmes complexes sont exécutés (et qui ont par exemple besoin de beaucoup de registres). Deux points peu importants dans le cadre du jeu vidéo et qui justifient donc cette différence au niveau des architectures du GP100 et du GP104. Enfin, il y a au niveau des SM une troisième différenciation importante que nous n'avons pas encore abordée : le calcul en demi-précision ou FP16. Les unités de calcul 32-bit de Pascal T supportent un ensemble d'instructions supplémentaires qui au lieu d'une opération 32-bit regroupent 2 opérations de type FP16. De quoi potentiellement doubler la puissance de calcul pour les algorithmes qui peuvent se contenter d'une précision limitée (c'est le cas du deep learning) et quand le compilateur parvient à profiter pleinement de ce type d'instructions. Certains ont pu penser que cela implique un support généralisé de la demi-précision pour les GPU Pascal, pour booster les performances et/ou réduire l'empreinte énergétique. C'est un compromis que font certains GPU mobiles, y compris les Tegra de Nvidia, mais il n'en est rien ici. Le support du FP16 pour Pascal T est spécifique au GPU computing et par conséquent n'est pas présent sur Pascal G. GP104 : quelques unités de plus et un bond en fréquenceAprès avoir passé en revue le coeur de l'architecture Pascal G, il est temps de se pencher sur le GP104 dans son ensemble. Voici le traditionnel schéma communiqué par Nvidia :  Nous pouvons y observer 4 GPC contenant chacun 5 SM. Une organisation interne proche de celle du GM204, lui aussi équipé de 4 GPC mais qui se contentent de 4 SM. Chaque SM de ces GPU intègre 128 unités de calcul 32-bit (les "cores"), ce qui nous en donne un total de 2560 pour le GP104 contre 2048 pour le GM204, une progression de 25%. Les unités de texturing, 8 par SM, progressent dans la même proportion. Pour le reste nous retrouvons un même cache L2 de 2 Mo ainsi qu'un même ensemble de 64 ROP associés à un bus mémoire de 256-bit réparti sur 8 contrôleurs 32-bit. Voici pour comparaisons les spécificités de quelques GPU :

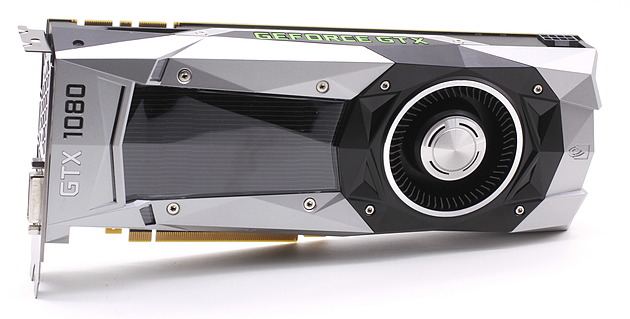

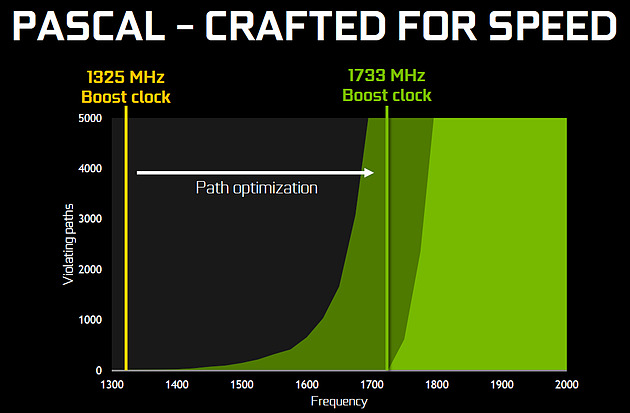

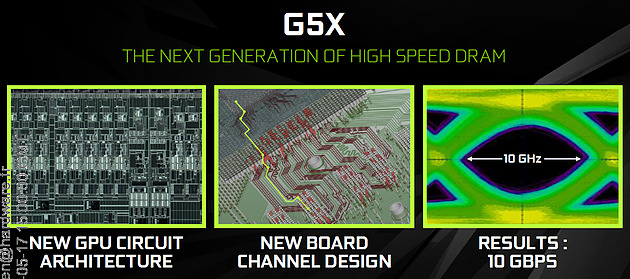

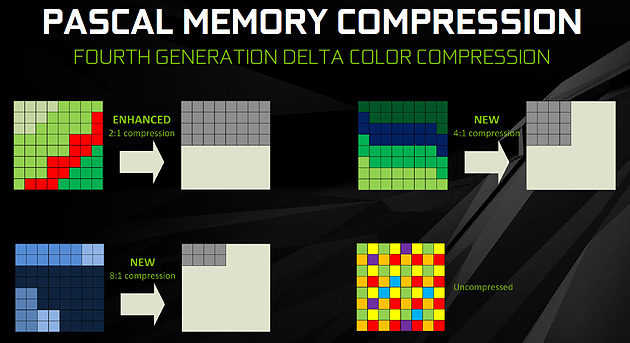

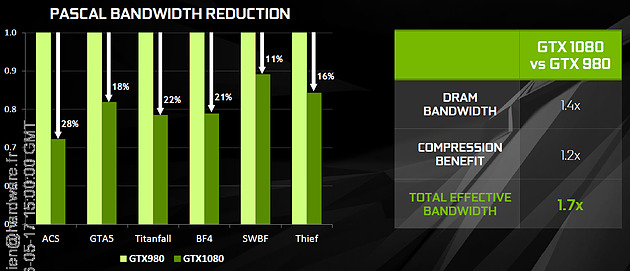

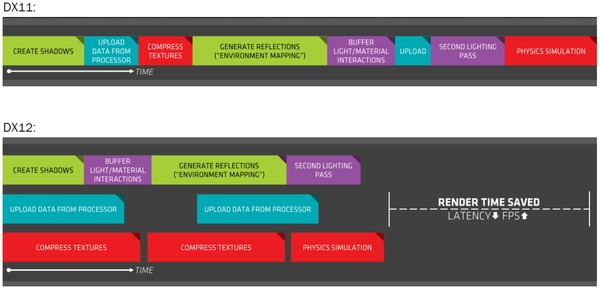

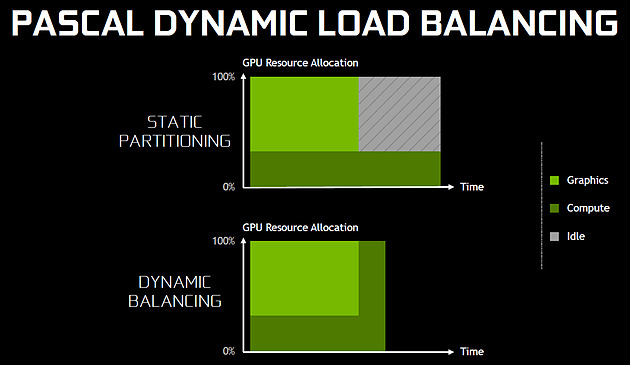

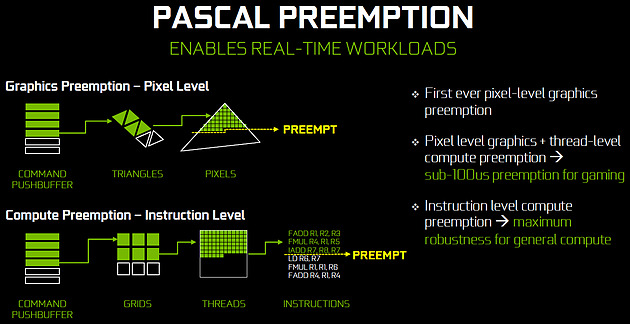

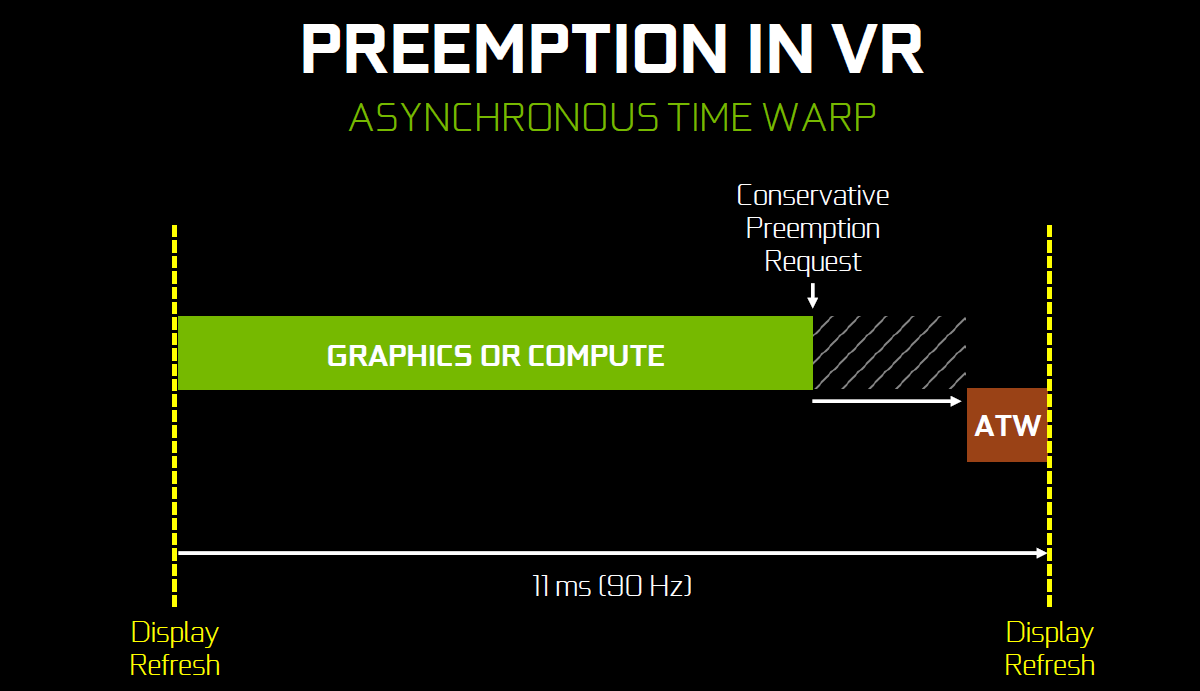

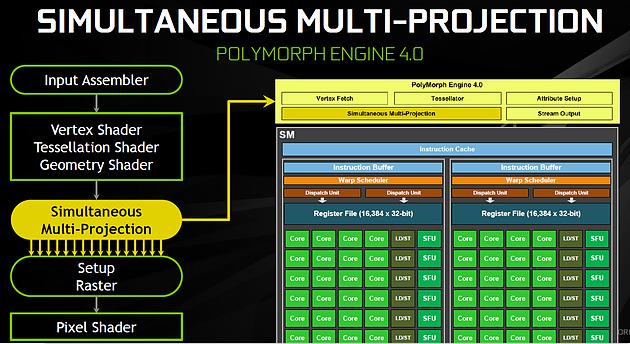

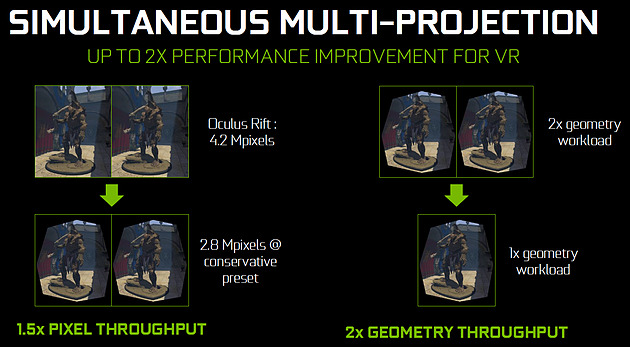

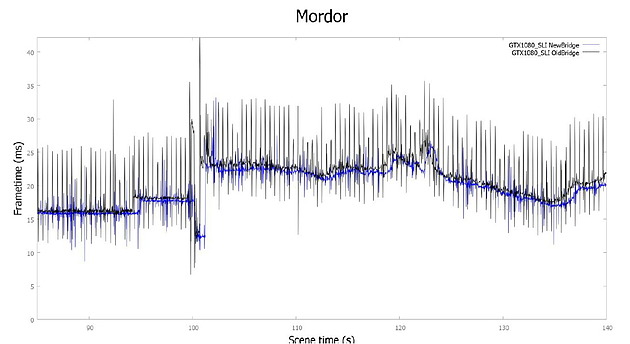

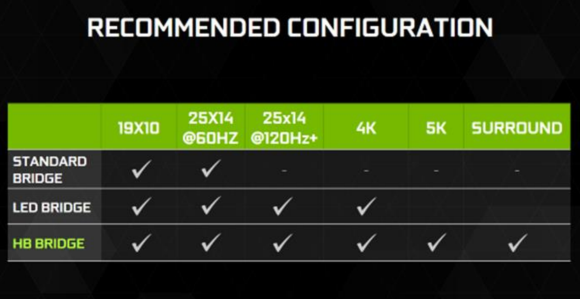

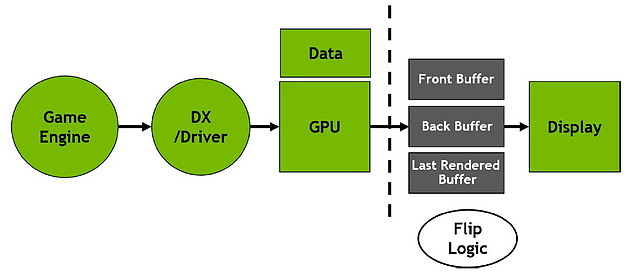

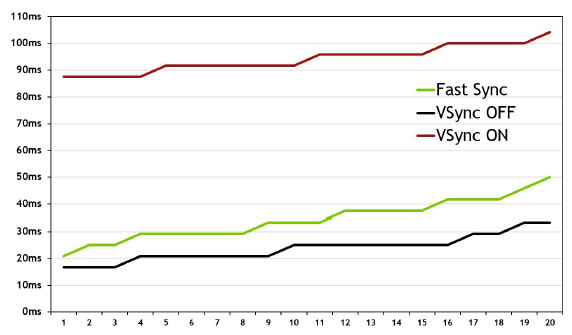

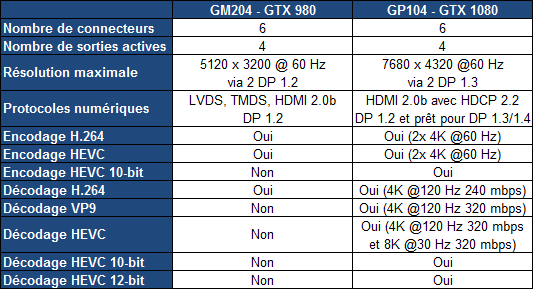

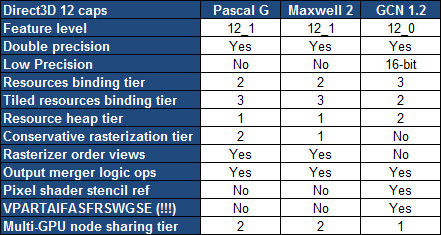

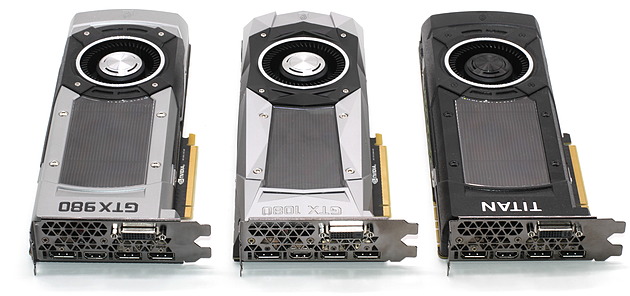

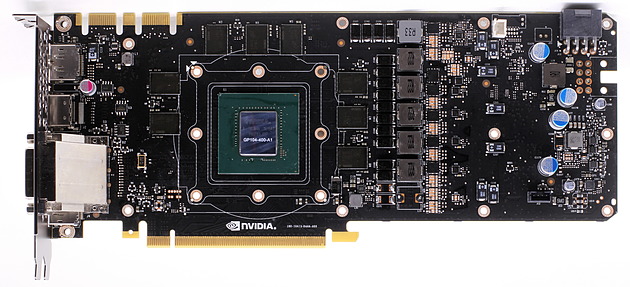

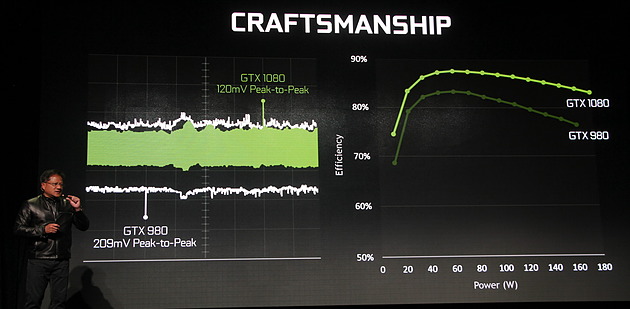

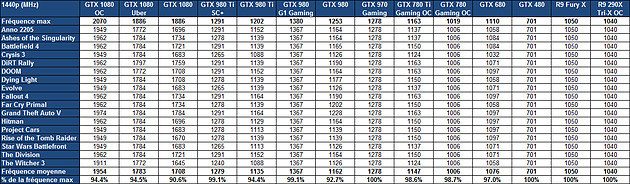

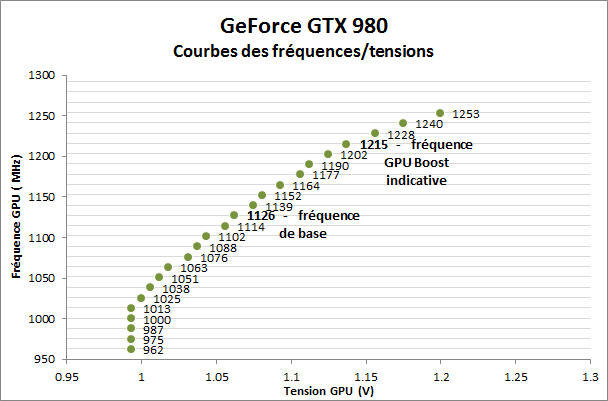

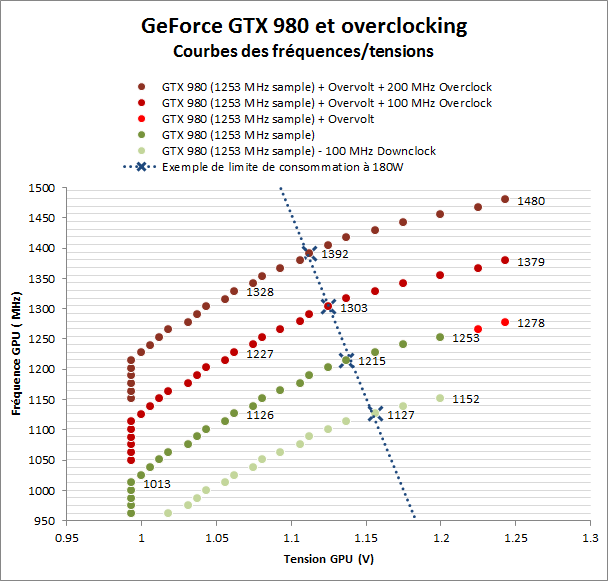

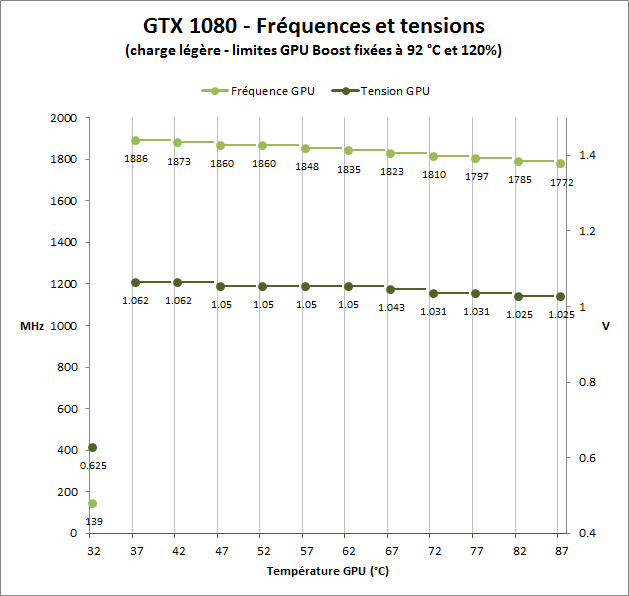

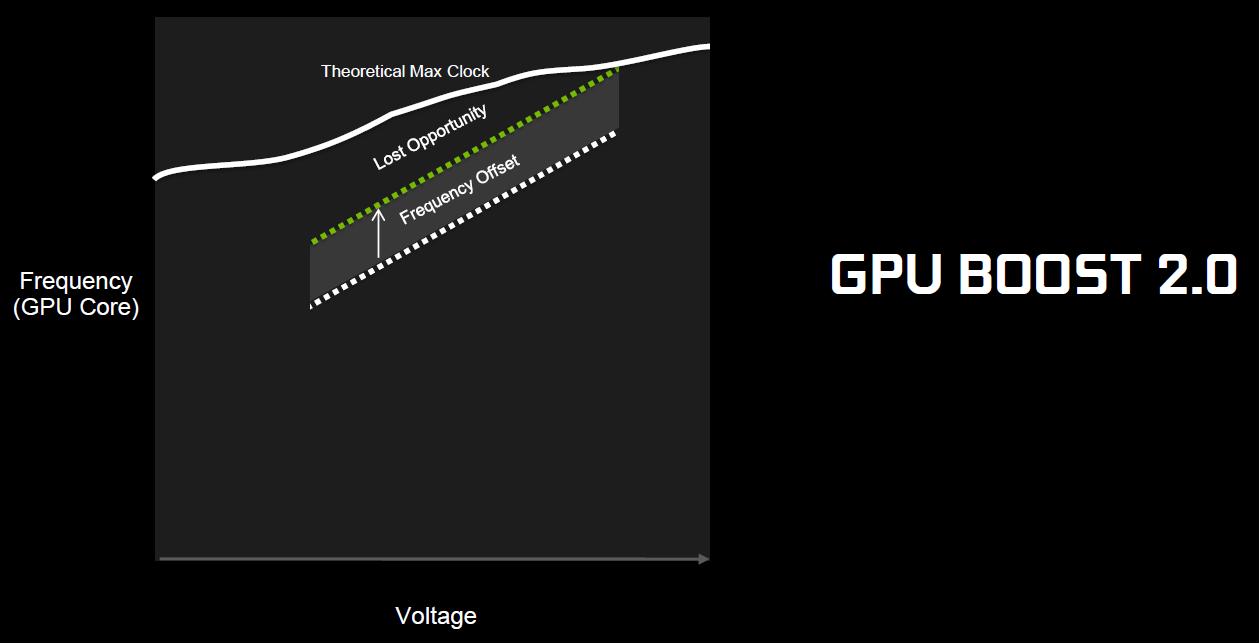

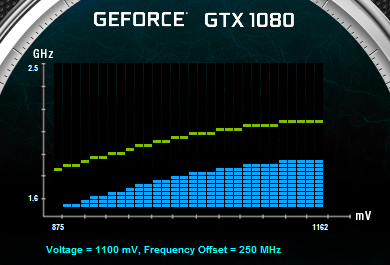

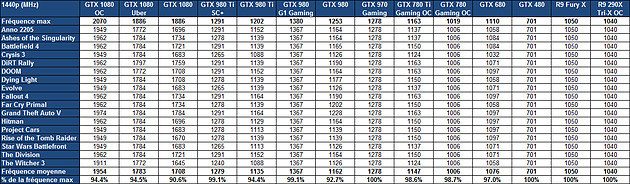

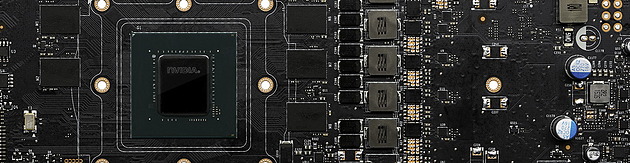

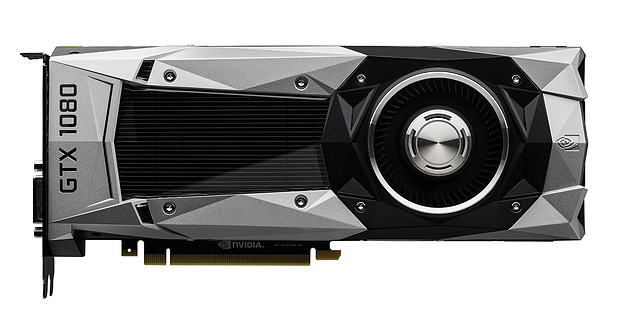

25% d'unités de calcul et de texturing en plus, aucune augmentation du nombre de ROP ou de la largeur de l'interface mémoire… Vu comme ça le GP104 et cette première exploitation du 16 nm n'impressionne pas réellement. C'est cependant sans compter sur un point crucial : les fréquences !  Nvidia nous avait indiqué ne pas avoir travaillé particulièrement les fréquences du GP100, qui profite simplement des gains automatiques liés au 16 nm, mais il en va tout autrement pour le GP104. Nvidia explique avoir passé en revue le moindre circuit du GPU pour retravailler tout point faible qui entravait la montée en fréquence. De quoi pouvoir proposer une fréquence turbo de référence de 1733 MHz sur la GTX 1080 soit un bond énorme de 40% par rapport aux 1216 MHz du GM204 qui équipe la GTX 980. Et cela tout en laissant une marge d'overclocking similaire puisqu'il est aisé d'atteindre plus de 2 GHz avec le GP104 ! Si nous combinons les +25% d'unités de calcul et les +40% en fréquence, cela nous donne cette fois une progression bien plus intéressante de la puissance brute par rapport au GM204 : +75%. Reste un bus mémoire limité à 256-bit, mais là aussi Nvidia pousse la fréquence en retravaillant les circuits de ses interfaces et en ayant recours à un nouveau type de mémoire : la GDDR5X.  Alors que la GDDR5 plafonne à 8 Gbps, la GDDR5X est prévue pour évoluer progressivement de 10 à 16 Gbps. Pour atteindre un tel débit la GDDR5X supporte un nouveau mode de transfert des données de type QDR permettant de doubler à fréquence égale le débit avec en contrepartie un prefetch et des accès qui sont également doublés à 16n et 512 bits. Deux points qui ne sont pas de réels problèmes pour les GPU alors qu'ils peuvent profiter d'un bus plus rapide avec une fréquence réduite pour les cellules mémoires, ce qui est bénéfique sur le plan de la consommation. Sur la GTX 980, le GM204 est associé à de la GDDR5 7 Gbps, mais sur la GTX 1080, le GP104 profite des premiers modules GDDR5X 10 Gbps, un gain de 42%. Et ce n'est pas tout, le passage au 16 nm permet à Nvidia de complexifier son système de compression sans perte du framebuffer. Plus spécifiquement, c'est le codage différentiel pour les couleurs, également appelé compression delta, qui progresse à nouveau. Pour rappel, son principe de base consiste à ne pas enregistrer directement la couleur mais sa différence par rapport à une autre qui fait office de repère. Ce n'est bien entendu utile que quand l'écart entre deux couleurs est suffisamment faible, de manière à ce que cette information représente moins de bits que la couleur en elle-même.  Pascal améliore tout d'abord la compression 2:1, dans le sens où elle s'enclenche dans plus de cas. Ensuite, un nouveau mode de compression 4:1 fait son apparition et est exploité quand le différentiel de couleur est très faible. Enfin, un mode 8:1 permet de combiner la compression classique des blocs de 2x2 pixels de couleur identique avec la compression delta 2:1.  Les outils de Nvidia mettent en avant une réduction significative de la bande passante mémoire nécessaire par image par rapport aux GPU Maxwell, ce qui transformerait ces optimisations en augmentation de 20% de la bande passante effective. Couplée à la GDDR5X 10 Gbps, le GP104 de la GTX 1080 profiterait ainsi d'une progression totale de sa bande passante effective de 70%, ce qui permet de maintenir l'équilibre par rapport à sa puissance de calcul. Pour démontrer que sa technologie a réellement un impact en jeu, Nvidia fourni des screenshots de Project Cars sur lesquels les zones compressées sont représentées en fushia :  [ Sans compression ] [ Sur GPU Maxwell ] [ Sur GPU Pascal ] A noter que cette amélioration de la compression sans perte permet également de retenir plus de données dans le cache L2 et de réduire la taille de certains transferts entre ce dernier et les SM, ce qui peut profiter aux performances. Nous vous en avons déjà parlé à plusieurs reprises, notamment ici, DirectX 12 ou encore Vulkan supportent plusieurs files de commandes, ce qui ouvre la voie à plusieurs types d'optimisations. A la base de leur moteur, les développeurs créent des Command Queues qui sont des files d'attente dans lesquelles vont prendre place des listes de commandes de rendu qui, sur les API classiques, seront exécutées séquentiellement par le GPU pour créer la représentation 3D de la scène. La 10ème liste de commandes à y prendre place devra toujours attendra que les 9 autres aient été exécutées par le GPU avant d'être traitée. Mais avec les API récentes et leur support du Multi Engine, il est possible d'exploiter plusieurs Command Queues de types graphics, compute ou copy, ce qui permet par exemple de faire traiter certaines tâches en priorité mais aussi en parallèle. Sur ce point Microsoft et Khronos ont repris exactement la structure qu'AMD avait mise en place avec son API Mantle. Une victoire pour AMD qui a dessiné le Multi Engine en suivant les contours de l'architecture de ses GPU. Son service de marketing technique en a profité pour communiquer énormément sur le sujet en mettant en avant des gains de performances sous la bannière Async Compute ou calcul asynchrone.  Illustration du Multi Engine de DirectX 12. Dans cet exemple extrême les performances progressent de 50%. Pourquoi un gain de performances ? Imaginez que deux commandes de rendu saturent les unités de calcul, il n'y a aucun intérêt à essayer de les traiter en parallèle par rapport à une exécution en série classique. Par contre si une partie du rendu sature les unités de calcul alors qu'une autre sature l'interface mémoire, l'intérêt de l'exécution concomitante est évident et le gain de performances peut être substantiel. C'est à cette sous-possibilité du Multi Engine qu'AMD fait référence en parlant de l'Async Compute. Une terminologie que nous estimons cependant très mal choisie puisqu'il est possible de traiter deux tâches de manière asynchrone sans que cela ne se fasse en parallèle et inversement. Comme nous l'avons vu avec Ashes of the Singularity, le premier jeu Direct3D 12 à exploiter cette possibilité, si les Radeon parviennent à en tirer en bénéfice, il n'en est rien pour les GeForce Kepler et Maxwell. Les Radeon disposent d'un processeur de commande plutôt évolué, associé à des ACE (Asynchronous Compute Engines), capable de prendre en charge automatiquement et efficacement plusieurs files de commandes. Malheureusement, il en va différemment pour les GeForce dont le processeur de commandes ne gère plusieurs files efficacement qu'en mode compute pur. Dès que du rendu 3D est impliqué, cela se complique. Nvidia explique que les GPU Maxwell sont capables de prendre en charge 32 files dont une peut être de type graphics mais ne peuvent pas gérer automatiquement la répartition des ressources. En d'autres termes, par défaut, ces GPU vont les exécuter en alternance tout en souffrant des commandes de synchronisation. Il est par contre possible de définir statiquement, via un profil de jeu, une répartition de ces ressources. Par exemple : 12 SM peuvent être attribués à un file et 4 à une autre. C'est en pratique peu efficace puisqu'un partage fixe correspond rarement aux charges instantanées traitées par le GPU.  Avec les GPU Pascal, Nvidia a fait évoluer quelque peu son processeur de commande pour permettre au GPU de piloter dynamiquement cette attribution des SM. Une petite évolution dont nous ne sommes pas certains de la portée réelle. Nous n'avons par exemple pas noté de gain dans Ashes of the Singularity. Certes nous pouvons observer que la petite baisse de performance de 1-2% (liée aux commandes de synchronisation qui pilotent "Async Compute"), notée sur Maxwell avec de précédents pilotes, a disparu. Nous pouvons même observer un gain de 1-2% avec certains paramètres graphiques, mais vous conviendrez que c'est loin d'être convainquant. Nvidia admet que dans ce jeu l'amélioration est anecdotique mais promet que dans d'autres titres à venir des gains plus importants devraient être mesurables. Nous vérifierons bien entendu cela dès que possible. Ceci étant dit, nous estimons que notre précédente analyse reste d'actualité. Le principe de base sur lequel repose la tentative d'exécution concomitante des tâches est que le GPU n'exploite pas à 100% ses différents types d'unités. Le gain potentiel est donc lié au taux d'utilisation de chaque unité. Plus il est élevé, moins le gain peut être important, d'autant plus qu'avoir recours à l'exécution concomitante implique de mettre en place de coûteuses barrières de synchronisation. Si les GeForce ont de base un meilleur taux d'utilisation de leurs unités que les Radeon, il y a moins de raison de chercher une synergie entre les exécutions de différentes tâches. Un autre élément à prendre en compte est que l'architecture des GeForce depuis plusieurs générations a décentralisé plusieurs aspects du pipeline graphique qui prennent place dans les SM. C'est le cas du traitement de la géométrie par exemple ou encore du transfert des pixels vers les ROP. Par conséquent, répartir les SM entre deux tâches ne permet pas à l'une d'elle d'exploiter la puissance géométrique ou le fillrate inutilisés par l'autre. Même la puissance de calcul est difficilement attribuable à une tâche donnée. Au vu de son architecture, il nous semble que pour réellement profiter de l'exécution concomitante, les GeForce Pascal devraient exécuter ces multiples tâches à l'intérieur de chaque SM et non leur attribuer un certain nombre de SM entiers, que ce soit dynamiquement ou pas. C'est assez différent pour les Radeon, dont l'architecture semble gérer ces tâches multiples bien plus finement. La préemption progresseUn autre aspect d'Async Compute représente la possibilité de traiter des tâches en alternance de manière désynchronisée et éventuellement en priorité. Pour cela, il faut interrompre et mettre en pause le travail en cours du GPU pour passer sur une autre tâche, c'est la préemption. Cela permet de supporter un environnement multitâche sur GPU, mais également d'exécuter le time warping dans le cadre de la VR. Cette technique consiste pour rappel, juste avant chaque rafraîchissement de l'écran, à déformer la dernière image terminée sur base des informations de positionnement les plus récentes. De quoi simuler le point de vue réel et réduire la latence perçue.  Peu loquace en détails concernant l'exécution concomitante, Nvidia met par contre fortement en avant les améliorations apportées à la préemption qui permet sur Pascal de stopper plus rapidement une tâche en cours pour passer à une autre. Les GPU Pascal peuvent faire de la préemption au niveau du pixel en mode graphics et au niveau du thread en mode compute. Les GPU Maxwell et les Radeon ne peuvent le faire que par triangle par exemple. De quoi réduire quelque peu la latence dans le cadre de la VR et du time warping.  [ Time warping sur Maxwell ] [ et sur Pascal ] Dans cet exemple, un GPU Pascal ne doit pas lancer la time warping aussi tôt qu'un GPU Maxwell, ce qui augmente les performances et réduit la latence en utilisant des données de positionnement plus récentes. Rappelons que dans certains cas, un triangle peu représenter un temps de rendu très élevé, notamment lorsqu'une image entière est plaquée sur 1 ou 2 triangles en vue de recevoir un effet de post processing très gourmand. Sur les GPU autres que Pascal, quand le time warping intervient à ce très mauvais moment, il est possible qu'il ne puisse pas être exécuté avant l'affichage à moins de prendre une marge de sécurité énorme. Nvidia précise par ailleurs que le délai pour le changement de tâches a été réduit à moins de 100 µs une fois la tâche en cours terminée, soit une fois que les pixels ou les threads sur lesquels le GPU a commencé à travailler sont terminés. En mode CUDA pur, les GPU Pascal peuvent aller plus loin et faire de la préemption au niveau le plus bas possible : celui des instructions. Dans ce cas, dès que la commande est passée, le GPU s'interrompt immédiatement et transfère le tout en mémoire. Bien plus d'informations doivent être conservées, telles que tous les registres de tous les threads en vol, ce qui peut avoir un coût plus important. Une possibilité à ne pas utiliser pour alterner en permanence entre deux tâches par exemple. Avec les GPU Maxwell, Nvidia a introduit une fonctionnalité dénommée Multi Projection Acceleration. Elle est à la base de VXGI et VXAO ainsi que du Multi-Resolution Shading qui permet d'optimiser les performances en VR en réduisant la résolution sur les côtés. Le moteur de projection multiple de Maxwell était cependant limité dans le sens où toutes les projections devaient se faire à partir du même point de vue (le VXAO et le VXGI représentant une approche particulière qui peut s'y rattacher).  Présent en partie dans le Polymorph Engine et en partie dans le Rasterizer, le SMPE (Simultaneous Multi Projection Engine) des GPU Pascal va plus loin. Cette unité est capable de générer plusieurs projections du flux de géométrie jusqu'à 16, voire jusqu'à 32 dans le cas d'un rendu stéréoscopique. Quelle utilité ? Le meilleur exemple est un rendu VR simple : au lieu de calculer séparément l'image pour chaque oeil, la géométrie peut n'être traitée qu'une fois et projetée ensuite directement, en une seule passe, dans les 2 images. Le SMPE se charge automatiquement de tout cela et de dédoubler les triangles qui doivent l'être. Suivant la complexité de la géométrie, des vertex shaders, de la tessellation, les gains peuvent être plus ou moins conséquents. Cela ne change par contre rien au niveau du calcul des pixels. Mais le SMPE ne s'arrête pas là et permet également de faire du Lens Matched Shading. Grossièrement il s'agit d'aller encore plus loin que le Multi Resolution Shading en utilisant plusieurs viewports pour simuler une image incurvée qui se rapproche le plus possible de l'image qui sera affichée après déformation pour être adaptée à la lentille. Voici ce que cela donne en image :  [ Rendu classique ] [ Lens Matched Shading ] Sur la seconde image, on peut deviner à travers la silhouette de l'image rendue les 4 viewports. En retenant une haute qualité, 33% de pixels en moins sont calculés pour un résultat final identique ou très proche après déformation. De base, dans le cas de l'Oculus Rift par exemple, des images de 2.1 MPixels sont déformées (warping) pour pouvoir être vue correctement à travers les lentilles du casque. Après cette déformation, la résolution effective n'est plus que de 1.4 MPixels et le SMPE autorise donc un débit effectif de pixels 50% supérieur.  De quoi autoriser des gains conséquents en VR mais il faudra pour cela un support spécifique de la part des applications. A noter qu'il est possible d'utiliser plus de 4 viewports pour simuler un écran incurvé plus précis, mais cela apporte peu de bénéfices par rapport au coût engendré. Exploiter plus de 4 viewports pourra par contre avoir plus de sens dans le cadre des CAVE (cave automatic virtual environment) ou des dômes. L'autre utilité concerne les écrans larges incurvés ainsi que les systèmes surrounds inclinés de manière à simuler un tel écran incurvé comme c'est généralement le cas. Actuellement, le rendu se fait assez naïvement en faisant comme si le système d'affichage était une surface plane, ce qui implique un champ de vision trop étroit et des erreurs de projections qui s'amplifient aux extrémités.  [ Rendu surround classique ] [ et avec correction du champ de vision ] Le SMPE permet d'opérer une projection différente pour chaque écran ou pour chaque zone de l'écran large incurvé de manière à ce que le champ de vision soit correct par rapport à l'angle d'inclinaison et par rapport à la position de l'utilisateur. Nvidia prépare un utilitaire qui permettra de configurer ces systèmes. Avec le GP104, Nvidia fait évoluer son interface SLI qui n'avait pas réellement bougé depuis très longtemps. Sur les GPU précédents, le frame pacing qui permet de lisser l'affichage des images en multi-GPU pour améliorer la fluidité, atteignait ses limites en très hautes résolutions. Le débit du lien SLI imposait une latence trop élevée pour les images en 4K ou en surround. C'est une des raisons pour lesquels AMD a abandonné son lien CrossFire au profit du PCI Express, et c'est ce qui fait que les Radeon s'en tiraient un petit peu mieux que les GeForce alors que ces dernières avaient un petit avantage en 1080p ou en 1440p. Nvidia estime que se baser uniquement sur le PCI Express n'est pas une solution qui lui permette de garantir un résultat optimal et donc plutôt que d'abandonner ses connecteurs SLI, ses ingénieurs les ont améliorés.  La première mise à jour concerne la fréquence de ce bus spécial qui passe de 400 à 650 MHz. Pour profiter de cette fréquence et donc de ce débit plus élevé, il faudra par contre un pont SLI compatible qualifié de HB pour High Bandwidth. Certains ponts "durs" à LED actuels en sont capables, mais les ponts souples par exemple ne le sont pas. Ils restent compatibles avec les GTX 10x0 mais la connexion SLI sera alors limitée à 400 MHz. La seconde mise à jour concerne la combinaison des 2 connections SLI pour doubler la bande passante qui est alors multipliée par 3.25x en combinaison avec les nouveaux ponts !  Nvidia propose pour l'occasion de nouveaux ponts SLI HB dans 3 formats qui correspondent à 3 options d'espacement des slots PCIE. Ses partenaires devraient également en proposer de nouveaux. Tous ces ponts sont limités au 2-way SLI. Les SLI 3-way et 4-way ont en effet besoin du second connecteur SLI pour connecter tous les GPU entre eux et ne peuvent donc pas combiner deux connecteurs pour augmenter la bande passante. Si Nvidia a opté pour cette approche c'est en fait suite à une décision relativement importante : l'abandon des modes 3-way et la 4-way. Alors qu'il est déjà devenu difficile de convaincre les développeurs de faire l'effort de supporter correctement le bi-GPU, Nvidia a dû réaliser qu'aller plus loin n'a plus beaucoup de sens alors que ça demande beaucoup de ressources en terme de support et de validation. Par défaut il n'y aura donc plus que le SLI 2-way de supporté à partir des GeForce GTX 1000. Il restera par contre possible de mettre en place un troisième GPU dédié à PhysX. Pas totalement fou non plus face aux records sous 3DMark et consorts, Nvidia proposera une interface à travers de laquelle les utilisateurs pourront demander une clé pour débloquer le 3-way et le 4-way. Le support sera limité au bon vouloir des développeurs et la fluidité ne profitera alors pas des améliorations apportées à Pascal. Nvidia communique un exemple d'amélioration avec la nouvelle interface SLI :  On peut observer, en bleu, que les micro-saccades sont nettement réduites avec un nouveau pont double canal à 650 MHz, par rapport à un ancien pont simple canal à 400 MHz, en noir. Il manque malheureusement les configurations intermédiaires, à savoir le simple canal à 650 MHz ou le double canal à 400 MHz.  D'après ce tableau de Nvidia, le simple canal à 650 MHz serait nécessaire pour garantir la fluidité au-delà du 1440p à 60 Hz, alors que le double canal 650 MHz serait nécessaire en 4K, 5K et Surround (mais la résolution n'est pas précisée, probablement en 3x1440p). Aucune précision n'est donnée concernant le double canal 400 MHz, une solution pourtant plus économique puisqu'elle permet de recycler de "vieux" ponts mais qui n'en est en fait pas supportée officiellement. Fast Sync, un nouveau type de compromisPour les joueurs qui recherchent une absence de tearing avec un faible niveau de latence à travers un niveau de fps très élevé, qui va au-delà de ce que permet le taux de rafraîchissement de leur écran, G-Sync ou pas, Nvidia a développé une nouvelle alternative au VSync OFF et VSync ON. Appelé Fast Sync, ce nouveau mode est en fait une variante du triple buffering mais implémentée en partie en hardware. Nvidia le nomme différemment d'une part pour des raisons marketing, d'autre part pour se démarquer de la confusion qui peut exister entre les types de triple buffering (le "vrai" et le render ahead) et enfin parce que le moteur d'affichage du GPU a été légèrement adapté pour le prendre en charge nativement. Traditionnellement, deux buffers sont utilisés lors du rendu : le front buffer et le back buffer. Le GPU effectue le rendu dans le back buffer et une fois terminé il devient le front buffer qui est lu par le moteur d'affichage et envoyé vers l'écran. L'ancien front buffer devient le nouveau back buffer et le GPU travaille sur l'image suivante. Cette inversion des deux buffers se fait soit instantanément en VSync OFF, ce qui cause un décalage entre les images (le tearing), soit de manière synchronisée avec le taux de rafraîchissement de l'écran en VSync ON, ce impose des temps d'attente qui limitent les performances et augmentent la latence.  Pour Fast Sync, Nvidia découple totalement le pipeline de rendu de l'affichage en insérant un troisième buffer appelé last rendered buffer, soit le buffer qui contient la dernière image rendue. Le GPU peut alors calculer les images aussi vite qu'il le veut en alternant entre le back buffer et le last rendered buffer alors que le moteur d'affichage fera la transition entre ce dernier et le front buffer pour se caler sur le taux de rafraîchissement. De quoi permettre de se rapprocher à haut fps de la faible latence du mode VSync OFF tout en évitant le tearing comme en VSync ON. En contrepartie, avec un framerate légèrement supérieur au taux de rafraîchissement on risque d'avoir un affichage moins fluide car certaines images calculées peuvent être sautées à l'affichage, dans ce cas et sur ce point le VSync ON est supérieur. La solution idéale reste bien entendu la fréquence de rafraîchissement variable (G-SYNC ou Adaptive-Sync / FreeSync) sur un écran permettant de monter à 120/144 Hz, ce qui permet tout en se passant de tearing d'éviter les problèmes de fluidité quand le framerate varie tout en ayant une latence similaire au VSync OFF tant que ce dernier ne dépasse pas la fréquence de rafraîchissement maximale. Côté latence, voici par exemple ce que cela donne selon Nvidia sur une section de 20s de Counter-Strike Global Offensive :  Le framerate et le taux de rafraîchissement ne sont pas précisés, il est probable qu'il s'agisse du cas le plus favorable à savoir un écran 60 Hz et un framerate dépassant allègrement la centaine de fps, un écran 120/144 Hz permettrait déjà de réduire fortement la latence en Vsync ON. Nvidia explique que ce découplage du pipeline de rendu avec le moteur d'affichage va permettre différentes innovations dans le futur, mais sans donner plus de détails. Un moteur vidéo et d'affichage revuLe GP104 reprend les capacités de prise en charge du GM204 au niveau du HDR. Les moteurs d'affichage de ces GPU supportent le HDMI 2.0b nécessaire pour prendre en charge les formats de couleurs 10-bit et 12-bit jusqu'en 4K, ainsi que les standards BT.2020 et le SMPTE 2084. Selon Nvidia il n'y a donc pas de différence sur ce point, mais le support logiciel n'est pas encore totalement là côté GeForce. Le GP104 y ajoute le support du décodage des vidéo HDR 10-bit et 12-bit jusqu'en 4K 60 Hz ainsi que l'encodage mais cette fois limité au HDR 10-bit. De quoi autoriser le streaming en HDR vers la console Shield. Par ailleurs, bien qu'il n'ait actuellement été certifié que pour le DisplayPort 1.2, le GP104 et les GTX 1080 supportent le DP 1.3 ainsi que le DP 1.4 qui vont permettre de transporter les metadatas nécessaires au HDR. Nvidia indique travailler avec les développeurs de jeux vidéo pour l'intégration du support de l'affichage HDR qui demande notamment de revoir l'algorithme de tone mapping. Cela devrait arriver rapidement dans Obduction, The Witness, Lawbreakers, Rise of the Tomb Raider, Paragon, The Talos Principle et Shadow Warrior 2. Voici un récapitulatif des capacités des moteurs d'affichages et video du GM204 et du GP104. A noter que nous précisons ici le type de GPU puisque cela peut varier au sein d'une même génération : le GM206 supporte par exemple le décodage du HEVC.  Page 6 - Spécifications et Direct3D 12 # Spécifications  La GeForce GTX 1080 embarque un GPU GP104 complet, c'est-à-dire que toutes les unités qu'il contient sont actives. Comme vous pouvez le constater, les débits bruts augmentent fortement par rapport à la GeForce GTX 980 avec une puissance de calcul en hausse de 78% ou encore une bande passante mémoire qui progresse de 42%. Par rapport aux dérivés du GM200, la comparaison est un peu plus complexe. Ceux-ci conservent un petit avantage au niveau de la bande passante grâce à leur bus 384-bit. La GTX 1080 ne profite ensuite que d'un très petit gain au niveau du débit de triangles (rendus) et du débit de pixels mais voit sa puissance de calcul et de texturing prendre un avantage de 46% sur la GTX 980 Ti. Sur le papier, la Radeon R9 Fury X n'a pas à rougir avec une puissance de calcul et de texturing similaire et une bande passante largement supérieure grâce à la HBM. Elle affiche par contre un lourd déficit au niveau des débits de pixels et de triangles. Il faut cependant rappeler que ces chiffres bruts ne veulent pas tout dire. A puissance de calcul théorique similaire, les GeForce sont plus efficaces, notamment parce qu'elles disposent de 25% d'unités de calcul supplémentaires dédiées aux fonctions spéciales et qui ne sont par conséquent pas intégrées dans ces chiffres. La GeForce GTX 1080 affiche une limite de consommation de 180W, identique à celle de la GeForce GTX 980 et nettement inférieure aux 250W d'une GTX 980 Ti. Nous avons ensuite rassemblé les fonctionnalités reportées par Direct3D 12 :  La seule évolution notable par rapport aux GPU Maxwell 2 concerne un support plus évolué de la rastérisation conservative. Les GPU AMD conservent globalement un avantage avec plus de flexibilité au niveau de la gestion des ressources mais les GeForce Maxwell et Pascal sont les seules à supporter les Volume tiled resources. L'accès aux données entre GPU (en dehors des copies) est également plus flexible en SLI qu'en CrossFire. Dans un premier temps, la GeForce GTX 1080 de référence devrait être la seule déclinaison disponible, mais les versions personnalisées partenaires devraient suivre très rapidement. Pour son ventirad de référence, Nvidia propose depuis quelques générations un design particulièrement efficace tant en termes d'esthétique et de finition que de performances dans le cadre d'une solution de type turbine. Après quelques hésitations, le fabricant compte afficher clairement l'aspect premium de son design, même s'il n'est pas accompagné d'un overclocking d'usine.  La première conséquence est qu'il reçoit un nom pour le mettre en avant : Founders Edition. Soit la carte construite par Nvidia, ce qui fait indéniablement pensé au feu Built-By-ATI (BBA) même s'il s'agissait à l'époque de cartes bien plus basiques. La seconde conséquence est que ce design va se payer au prix fort : 100 € de plus que le tarif de base annoncé. C'est peut-être un peu beaucoup et un ajustement se fera si le marché en décide ainsi, mais il est loin d'être délirant de penser que ce design proposé par Nvidia vaut plus cher que certains modèles personnalisés qui visent avant tout à réduire les coûts. D'ailleurs c'est un problème que Nvidia a rencontré par le passé avec la disparition progressive de ses cartes de référence, ses partenaires préférant la remplacer par un modèle moins cher. Avec la GeForce GTX 1080 Founders Edition, Nvidia garanti une disponibilité de son design sur toute la durée de vie du produit, et la commercialisera d'ailleurs directement via son site internet sur certains marchés. Tous les partenaires restent cependant libres de la commercialiser comme n'importe quelle autre carte de référence. Ceci étant dit passons aux photos :  Nvidia reprend ici la même base que pour le ventirad des GeForce GTX haut de gamme précédentes mais a revu le style. Après quelques années un peu de changement ne fait pas de mal même si nous sommes partagés entre le design classique et le nouveau plus agressif (en fait non, le ventirad noir de la GTX Titan X de référence a notre préférence).  Question de goûts. La qualité de finition reste irréprochable et participe au bon comportement de ces cartes sur le plan des nuisances sonores. Sur la génération Maxwell, les cartes 180W (GTX 980) se contentaient de petits caloducs insérés dans la base du radiateur alors que la chambre à vapeur était réservée aux modèles 250W (GTX 980 Ti, Titan X). Pour cette GTX 1080, pourtant spécifiée à 180W, Nvidia a opté pour une chambre à vapeur.  Comme pour les précédentes GeForce 180W, la GTX 1080 reçoit une backplate. Celle-ci gagne en qualité et en minceur par rapport à celle de la GTX 980. Nvidia a eu la très bonne idée de la composer de deux pièces de manière à permettre de dégager l'arrière de la carte pour favoriser un meilleur apprivoisement en air dans le cadre du multi-GPU ou encore pour optimiser le refroidissement de l'étage d'alimentation si cela s'avérait nécessaire. A noter que le démontage de chaque partie de la backplate, qui ne désolidarise pas le ventirad du PCB et n'annule pas la garantie, se fait via de nombreuses vis aussi fragiles que petites. Lors du remontage ne tentez pas de les serrer plus que très légèrement sans quoi la tête de vis se brise très facilement.  Nvidia indique avoir travaillé en profondeur sur l'étage d'alimentation du GPU, composé de 5 phases pour le GPU et d'une de plus pour sa mémoire GDDR5X Micron. Ils sont alimentés via 2 sources de 12V : un connecteur 6 broches et le bus PCI Express. Nvidia précise avoir sélectionné les composants de manière à éviter le coil whine. Notre échantillon en produit cependant un tout petit peu, rien de bien méchant ceci dit.  Nvidia explique également avoir travaillé l'étage d'alimentation de manière à augmenter la capacitance des circuits de filtrage du courant et à réduire l'impédance des circuits de distribution. De qui permettre d'augmenter le rendement de cet étage d'alimentation de +/- 6% tout en réduisant le bruit électrique pour éventuellement aider à pousser l'overclocking un petit peu plus loin. Ce rendement supérieur implique que pour une consommation totale de la carte de 180W, la part dissipée par le GPU sera supérieure. Par ailleurs, ce GPU est 20% plus petit que celui de la GTX 980. Ces deux points font qu'à consommation égale le stress sera plus important sur le ventirad de la GTX 1080 que sur celui de la GTX 980. C'est pour cette raison que Nvidia a recours à une chambre à vapeur et ce n'est pas suffisant. La limite de température a été relevée de 79.5 °C pour une GTX 980 à 82 °C, une valeur proche des 83 °C des modèles 250W. Au final cela permet à la GTX 1080 d'afficher des nuisances similaires à celles de la GTX 980.  Enfin, la connectique vidéo est similaire à celle des GeForce GTX 900 : une DVI Dual Link, une HDMI et 3 DisplayPort, dont 4 peuvent être utilisées simultanément. Il y a cependant une petite différence visible pour les plus attentifs : il s'agit d'une sortie DVI-D et non plus DVI-I. En d'autres termes, la GTX 1080 ne supporte plus la connectique VGA. Pour ce dossier, nous avons revu en profondeur notre protocole de test en remplaçant et intégrant de nombreux jeux. Anno 2070, GRID 2, Far Cry 4, Hitman Absolution et Tomb Raider laissent place à Anno 2205, DiRT Rally, Far Cry Primal, Hitman et Rise of the Tomb Raider. Nous ajoutons par ailleurs Ashes of the Singularity, le premier jeu à réellement tirer parti de DirectX 12 qui est donc testé dans ce mode. Hitman et Rise of the Tomb Raider supportent également cette nouvelle API mais avec des performances légèrement inférieures. Nous nous sommes donc contentés de DirectX 11 pour ces deux titres. DOOM est également intégré et marque le retour d'un jeu OpenGL dans notre protocole. Reste ensuite The Division, un titre plutôt gourmand, ainsi que Grand Theft Auto V, enfin, suite à une demande soutenue depuis sa sortie. Nous avons utilisé les pilotes 368.13 beta fournis par Nvidia et les Crimson Edition 16.5.2 hotfix pour les Radeon (excepte pour la R9 290X dans DOOM pour laquelle nous sommes passés aux 16.5.2.1 qui corrigent un problème de performances spécifiques aux GPU Hawaii). Tous les derniers patchs au 12/05/2016 ont été installés, la plupart des jeux étant maintenus à jour via Steam/Origin/Uplay. Nous apporterons au passage des remerciements chaleureux à EA et Origin qui ont décidé depuis quelques mois de bloquer les clés de Battlefield 4 et de Star Wars Battlefront après plusieurs changements de cartes graphiques dans une période de 12h. Face à un support désarmé et qui n'a pas été mis au courant, nous n'avons eu d'autre choix que d'acheter de multiples clés. Un passage à la caisse qui permet de multiplier les Battlefield 4 dans un même compte Origin mais qui se contente d'avaler les nouvelles clés de Star Wars Battlefront sans rien débloquer et sans aucun avertissement ! @#~!&!!!@ Nous avons opté tout d'abord pour la résolution de 1440p avec un niveau de détail maximal ou très élevé. Nous avons évité d'activer l'antialiasing de type SSAA, que nous jugeons beaucoup trop gourmand par rapport à ce qu'il apporte. Nous avons ensuite ajouté à ce dossier des mesures en 4K sur les cartes les plus performantes en essayant de nous rapprocher des 60 fps sur GTX 1080 si cela ne compromettait pas trop la qualité graphique. Face aux journées qui se limitent à 24h et au niveau de performances de la GTX 1080, nous avons laissé de côté les tests en 1080p mais nous reviendrons éventuellement sur ce point lors du test de la GTX 1070. Toutes les cartes ont été testées avec une température ambiante contrôlée à 26 °C et, pour chaque jeux, nous avons pris le temps nécessaire pour que la fréquence GPU se stabilise. Voici le rélevé des fréquences pour information :  On remarquera qu'en moyenne la GTX 1080 est plus éloignée de sa fréquence maximale que les autres cartes, nous y reviendrons dans les pages GPU Boost et OC. Ce test a été l'occasion de mettre à jour notre plate-forme de test qui passe au X99 et au Core i7-5960X, poussé à 4 GHz. Au niveau de l'affichage, pour les tests en 1440p nous avons opté pour l'Asus ROG Swift PG278Q mais limité à 120 Hz, certains Radeon étant capricieuses en 144 Hz avec certains câbles sur ce moniteur. G-Sync était désactivé. Configuration de test