| |

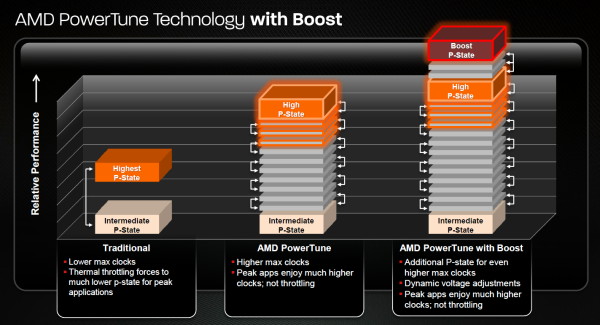

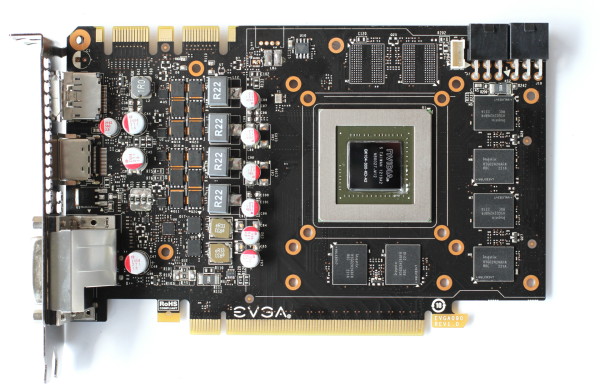

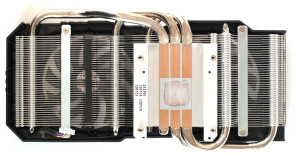

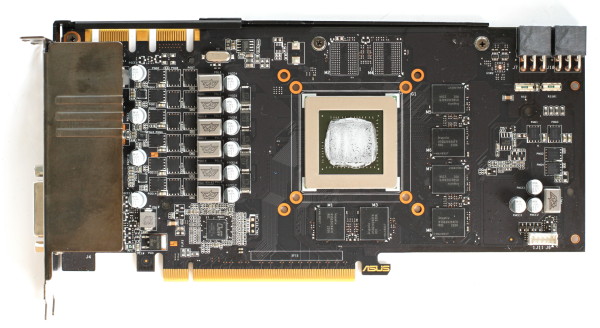

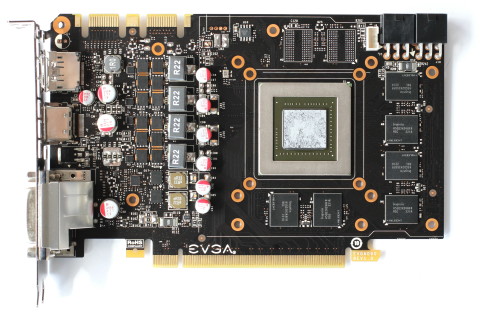

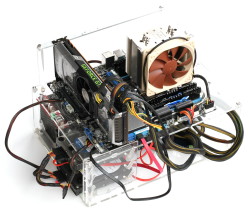

| Nvidia GeForce GTX 660 Ti, Asus DirectCU II TOP, EVGA SuperClocked et AMD Radeon HD 7950 v2 en test Cartes Graphiques Publié le Vendredi 7 Septembre 2012 par Damien Triolet URL: /articles/873-1/nvidia-geforce-gtx-660-ti-asus-directcu-ii-top-evga-superclocked-amd-radeon-hd-7950-v2-test.html Page 1 - Introduction Nvidia poursuit la déclinaison vers le bas de son architecture Kepler avec l'arrivée de la GeForce GTX 660 Ti. Très proche de la GeForce GTX 670 sur le plan des spécifications, elle pourrait s'avérer très intéressante pour les joueurs: nous en avons testé la version de référence ainsi que les modèles personnalisés d'Asus et d'EVGA. AMD a cependant bien l'intention de jouer les troubles fête avec la mise à jour des spécifications de la Radeon HD 7950…  GK104 pour tousContrairement à ce que vous pourriez penser, la GeForce GTX 660 Ti n'est pas basée sur un nouveau GPU, simplifié par rapport au haut de gamme actuel. Elle reprend le même GPU que les GeForce GTX 690, 680 et 670 : le GK104. Vous pourrez retrouver tous les détails le concernant dans le test de la GeForce GTX 680. Ironiquement, avec la GeForce GTX 660 Ti, ce GPU se retrouve probablement enfin là où sa place avait initialement été imaginée puisqu'il n'a pas été conçu en tant que haut de gamme traditionnel. Avec des meilleurs résultats que prévu, une concurrence moins rude qu'envisagée et un gros GPU annulé ou en retard, Nvidia a cependant pu introduire avec succès ce GK104 sur le segment haut de gamme voire très haut de gamme. Petit à petit il se décline dorénavant dans le segment "Performance", intermédiaire entre le milieu et le haut de gamme, et dans lequel nous retrouvons en général les solutions les plus intéressantes pour les joueurs qui recherchent un maximum de performances mais également un tarif plus raisonnable. Pour mettre en place la GeForce GTX 660 Ti, Nvidia exploite une version partiellement castrée du GK104 et très proche de la version exploitée sur la GeForce GTX 670 : le nombre d'unités de calcul et les fréquences sont identiques, mais le bus mémoire est ramené de 256 à 192 bits. De quoi faire tomber son tarif de 380 à 310€, sans trop impacter les performances. Malgré la présence de ce bus de 192 bits, Nvidia conserve une mémoire vidéo de 2 Go pour la variante principale de la GeForce GTX 660 Ti, profitant de la capacité de ses GPU à gérer une mémoire asymétrique. Comment est-ce possible ? 2 contrôleurs mémoire de 64 bits adressent chacun 512 Mo alors que le troisième contrôleur adresse 1 Go de mémoire. Cela signifie en d'autres termes que le GPU a accès à 1.5 Go à pleine vitesse, sur 192 bits, et dispose d'une réserve de 512 Mo, plus lente, en 64 bits. Une version 3 Go, avec une configuration mémoire symétrique, est également prévue et sera proposée par certaines partenaires. La Radeon HD 7950 mise à jourProbablement pour répondre à la GeForce GTX 660 Ti, AMD vient de mettre à jour, visiblement avec une précipitation certaine, les spécifications de référence de la Radeon HD 7950. L'évolution est similaire à celle qui a accompagné l'annonce de la Radeon HD 7970 GHz Edition : les fréquences sont revues à la hausse. AMD profite ici de PowerTune avec Boost, une mise à jour de sa technologie de contrôle de la consommation qui est plus précise et est dorénavant capable de faire varier la tension, ce qui permet de valider une fréquence GPU plus élevée. Alors qu'elle était au départ de 800 MHz sur la Radeon HD 7950, elle passe à 925 MHz sur la nouvelle version, la variation à la hausse de la tension se mettant en place à partir de 850 MHz. AMD indique que tous les GPU estampillés Radeon HD 7950 sont compatibles avec cette évolution qui peut se faire via une simple mise à jour du bios. C'est d'ailleurs via un nouveau bios fourni par AMD que nous l'avons testée. Ce bios distribué à la presse est cependant prévu uniquement pour les échantillons presse initiaux de la Radeon HD 7950 dont le design est différent de celui de la majorité des cartes disponibles dans le commerce. Ce design presse étant plus costaud au niveau du système de refroidissement et de l'étage d'alimentation, il peut encaisser sans soucis l'augmentation du TDP liée à cette évolution : il passe de 200 à 225W. Si en pratique toutes les autres Radeon HD 7950 devraient supporter cette évolution sans soucis, avec quelques réserves cependant au niveau des étages d'alimentation qui ne disposent pas d'un petit radiateur, il revient à chaque fabricant à valider ou pas son propre modèle et à proposer un nouveau bios, soit en terme de mise à jour offerte soit uniquement pour les cartes fabriquées à partir de ce moment. Notez que vu la manière dont tous les partenaires d'AMD semblent avoir ignoré la mise à jour des spécifications des Radeon HD 7700, il n'est pas certain que ce mouvement soit suivi par tous, d'autant plus que cela pourrait compliquer la donne pour leurs modèles overclockés, dont la mise à jour est plus difficile à mettre en place. Mise à jour du 07/09/12 : Asus a revu le bios de la GTX 660 Ti DirectCU II TOP de manière à augmenter sa limite de consommation de 10%. Nous avons mis à jour ce dossier avec les nouveaux résultats ainsi obtenus. Page 2 - PowerTune vs GPU Boost PowerTune vs GPU BoostAMD et Nvidia ont tous deux mis en place des systèmes de contrôle de la consommation de leurs cartes graphiques, ce qui leur permet de fixer des fréquences plus agressives tout en garantissant la fiabilité de leurs produits. Sans ces systèmes, il faudrait se contenter de fréquences plus réduites sans quoi la fiabilité pourrait être remise en cause puisque des tâches très lourdes pourraient entraîner les cartes graphiques et leurs GPU à un niveau de consommation pour lesquels ils ne sont pas prévus. Ce contrôle de la consommation, une fois implémenté, peut également être exploité à d'autres fins, par exemple pour mettre en place des modes turbo ou d'économie d'énergie. AMD est le premier à avoir développé une telle technologie, avec PowerTune, introduit sur les Radeon HD 6900 et intégré à toutes les Radeon HD 7000. A l'instar de la base des technologies turbo des CPU, elle consiste à estimer la consommation de la puce sur base d'une multitude de capteurs d'utilisation internes aux différents blocs qui la forment. Il peut sembler étrange au premier abord d'estimer la consommation eu lieu de la mesurer, mais cela permet de conserver un comportement déterministe sur le plan des performances. Une formule relativement complexe transpose ensuite ces niveaux d'utilisation en puissance consommée en prenant en compte des paramètres qui correspondent au cas le moins favorable : un GPU qui souffre de courants de fuite importants et qui fonctionne dans un environnement très chaud. Deux raffinements ont été apportés récemment par AMD à cette technologie. Le premier consiste à estimer la température du GPU en associant une valeur temporelle à la consommation estimée. Cette température estimée peut alors remplacer la constante qui représente le pire des cas et donner en pratique plus de marge dans les situations classiques. Pour simplifier : il s'agit d'estimer plus précisément la consommation pour éviter de devoir être trop conservateur. La température réelle est toujours mesurée et utilisée à un niveau de protection supérieur ainsi que pour réguler le ventilateur. Cette évolution est activée à partir des Catalyst 12.7 beta pour l'ensemble des Radeon HD 7900. En pratique cela ne fera pas de différence dans les jeux, en dehors de gros overclockings, mais cela permettra à celles-ci de conserver une fréquence plus élevée dans les stress tests. Notez qu'AMD pourrait exploiter cette nouvelle capacité pour autoriser le GPU à dépasser pendant quelques secondes son TDP, comme le fait Intel avec ses derniers CPU, mais dans le cas du rendu 3D en temps réel dont la charge est relativement constante dans la durée, cela n'aurait que peu d'intérêt. La seconde nouveauté est l'introduction d'un turbo dénommé Boost, une mode à laquelle il était devenu difficile d'échapper. Concrètement Boost représente la capacité de PowerTune à modifier la tension GPU, en plus de sa fréquence. Cette nouveauté est réservée aux Radeon HD 7970 GHz Edition et HD 7950 v2 puisque le bios doit contenir une table de couples fréquence/tension, mais surtout parce que le GPU doit être validé d'une manière plus complexe. La Radeon HD 7970 GHz est ainsi validée jusqu'à 1000 MHz avec une tension fixe classique mais également jusqu'à 1050 MHz avec une tension qui augmente progressivement (850 MHz et 925 MHz dans le cas de la Radeon HD 7950 v2). PowerTune peut actuellement gérer jusqu'à 256 étapes (P-states) avec une granularité de 4 MHz et une latence d'une poignée de millisecondes.  En pratique le TDP de la Radeon HD 7970 GHz Edition restant surdimensionné par rapport à la consommation des jeux vidéo (à de rares exceptions près), Boost peut être vu plus comme un moyen de valider en toute sécurité le GPU à une fréquence supérieure qui sera d'application constante dans presque tous les jeux, que comme un turbo qui apporterait un gain variable sous certaines conditions strictes. La situation est cependant différente pour la Radeon HD 7950 v2, pas uniquement parce que son enveloppe thermique ne dispose pas d'autant de marge, mais surtout parce qu'AMD a prévu de pouvoir écouler à travers ce modèle les échantillons de son GPU Tahiti qui souffrent de courants de fuite très élevés. En d'autres termes, AMD doit rester très conservateur au niveau des paramètres pris en compte pour l'estimation de sa consommation. Pour compenser quelque peu, le TDP est passé de 200 à 225W, mais cela reste insuffisant pour que Boost puisse s'enclencher d'une manière constante comme c'est le cas sur la Radeon HD 7970 GHz Edition. La Radeon HD 7950 v2 se contente ainsi la plupart du temps de 850 MHz, la fréquence maximale avant augmentation de la tension GPU. Notez que Boost entraînant une augmentation de la tension, la consommation progresse exponentiellement, ce qui ne fait pas de cette approche une solution destinée à augmenter le rendement énergétique. Une particularité partagée avec la technologie GPU Boost de Nvidia qui ne vise pas à améliorer le rendement par watt mais bien à profiter de chaque watt disponible pour proposer quelques points de performances supplémentaires. Il s'agit cependant du seul point commun entre les deux technologies : PowerTune reste totalement déterministe : dans des conditions identiques, toutes les Radeon HD 7900 se comporteront de la même manière. Ce n'est pas le cas du côté des GeForce. Notamment grâce à une consommation bien maîtrisée, Nvidia a pu introduire un premier turbo pour GPU, dénommé GPU Boost, qui est lui aussi destiné à maximiser la fréquence GPU pour profiter pleinement de l'enveloppe thermique disponible. Notre avis concernant l'approche de Nvidia est mitigé puisque GPU Boost n'est pas déterministe : contrairement aux CPU, il se base sur la consommation réelle, qui varie entre chaque exemplaire d'un GPU suivant sa qualité de fabrication et les courants de fuite qui l'affectent. Pourquoi une telle approche ? Nvidia a probablement été pris de court quand AMD a mis en place PowerTune avec les Radeon HD 6900, profitant de l'expérience de son équipe CPU, et n'a pas encore eu la possibilité d'intégrer une technologie similaire. Celles-ci doivent prendre place au cœur de l'architecture et nous pouvons supposer que le développement de Kepler était déjà trop loin dans son développement. La parade a été de mettre en place un monitoring externe au GPU avec les GeForce GTX 500. C'est ce même système qui reste utilisé sur les GTX 600 et il faudra attendre la génération suivante pour qu'une technologie plus évoluée soit implémentée. La technique actuelle de Nvidia a par ailleurs pour désavantage d'être relativement lente (100ms vs qqs ms) mais elle a par contre pour avantage de permettre à chaque échantillon de profiter pleinement de la totalité du TDP alors que les CPU et les Radeon, s'ils ne sont pas les pires des exemplaires, voient leur consommation surestimée par rapport à la réalité et ne profitent donc pas dans tous les cas de la totalité de leur TDP. Qui plus est, Nvidia ne valide pas tous les échantillons d'un même dérivé de ce GPU (le GK104-400 pour la GTX 680, le GK104-325 pour la GTX 670 et le GK104-300 pour la GTX 660 Ti) à la même fréquence turbo maximale. Officiellement, Nvidia se contente de donner une fréquence maximale garantie mais laisse le GPU monter bien au-delà s'il a pu être qualifié plus haut. En d'autres termes, GPU Boost représente également un overclocking automatique du GPU. Le problème est que la presse reçoit rarement un échantillon moyen et que du coup les performances que nous reportons peuvent être quelque peu surévaluées par rapport aux performances que vous pourriez rencontrer avec un exemplaire du commerce. Nvidia se défend en expliquant vouloir donner le maximum de performance à chaque exemplaire d'une même carte et précise que si la variation au niveau de la fréquence GPU Boost maximale peut être significative, la variation au niveau de la fréquence GPU Boost moyenne observée en pratique est plus réduite. La raison étant que la limite de consommation va empêcher le GPU de monter à un niveau très élevé dans les jeux les plus gourmands, mais également que sa température va le limiter. Ce que Nvidia oublie de préciser dans ce raisonnement, c'est qu'il revient également à dire que nous surévaluons légèrement les performances puisque les tests se font dans des conditions idéales : test bref sur table de bench. Bien que cela puisse rendre notre travail plus sympathique, nous ne pouvons malheureusement pas jouer une heure pour faire chauffer le GPU avant chaque mesure de performances ! Pour rappel, nous avons observé l'écart de performances entre deux GeForce GTX 680. Sans chercher le pire des cas nous avons observé une différence théorique de 2% et pratique de 1.5%. Ce n'est pas énorme mais embêtant sur le principe quand le match est serré avec la concurrence… La marge de manœuvre allouée à GPU Boost explosant avec les GeForce GTX 670 et GTX 660 Ti (15%), cela devient réellement problématique de notre point de vue. Quelle solution ? L'idéal serait que Nvidia permette aux testeurs de limiter les cartes au niveau du cas le moins favorable, avec une fréquence GPU Boost limitée à la valeur officiellement garantie. Nvidia ne proposant pas une telle solution pour limiter l'envergure de GPU Boost, nous avons donc opté pour la simulation d'un tel échantillon par nos propres moyens en jonglant avec les paramètres "d'overclocking". De quoi pouvoir vous proposer d'une manière très précise (malgré l'aspect "bricolage" de la solution) les performances garanties pour un échantillon basique en plus des performances que vous pouvez obtenir avec un échantillon plus favorable. Dans quelle proportion ces différents types d'échantillons se retrouveront-ils dans le commerce ? Malheureusement, nous ne le savons pas, Nvidia et ses partenaires refusant catégoriquement d'aborder le sujet. Page 3 - Spécifications, la GeForce GTX 660 Ti de référence Spécifications  Tout comme les autres GeForce 600, la GTX 660 Ti ne supporte pas complètement Direct3D 11.1, seules les Radeon HD 7700, 7800 et 7900 supportent le niveau de fonctionnalité 11_1, le plus évolué. Vous pourrez retrouver plus de détails à ce sujet dans notre dossier consacré à DirectX 11.1. La GeForce GTX 660 Ti est très proche de la GeForce GTX 670, dont elle se différencie par une bande passante mémoire réduite de 25% et par un fillrate qui baisse de 14%. Notez que bien que le nombre de ROP passe de 32 à 24 (soit -25%), la GeForce GTX 670 n'est en réalité capable de débiter que 28 pixels par cycle et non 32, un petit goulet d'étranglement étant présent en amont. Nvidia ne validant pas tous ses GPU à la même fréquence, leur puissance maximale variera dans une fourchette de 16%, et leur puissance pratique variera en plus de cela suivant la charge GPU et sa température. La Radeon HD 7950 v2 profite pour sa part d'un gain de puissance de traitement de 6 à 16% sur la Radeon HD 7950 originale, gain qui variera suivant la charge GPU mais sera identique sur toutes les cartes. La GeForce GTX 660 Ti de référence       La GeForce GTX 660 Ti de référence est presqu'identique à la GTX 670. Elle est relativement compacte avec 24cm de long et le PCB l'est encore plus puisqu'il se contente de 17.2 cm ! De quoi donner à ces GeForce un design pour le moins original avec une rallonge en plastique à l'arrière du PCB qui permet de rendre la carte suffisamment longue pour accueillir un ventilateur radial, ou turbine. Avec un TDP de 170W pour la GTX 670 et de 150W pour la GTX 660 Ti (et des consommations de 140 et 134W visées par GPU Boost), Nvidia peut se contenter d'un bloc de refroidissement très basique : un radiateur en aluminium équipé d'un large insert en cuivre à sa base. Un second petit radiateur est placé sur les composants sensibles de l'étage d'alimentation. Une coque classique referme le tout. La qualité de finition de l'ensemble est plutôt faible, bien en-déca de ce à quoi nous nous attendons pour des cartes de cette gamme de prix. Une partie des exemplaires semblent d'ailleurs souffrir d'un bruit mécanique au niveau du ventilateur ou de son support, un problème que nous avons rencontré sur notre échantillon de GeForce GTX 670. Pour alimenter le GK104, Nvidia a prévu 4 phases sur son PCB, en plus des deux dédiées à la mémoire GDDR5 Hynix R0C certifiée à 1.5 GHz. La GeForce GTX 660 Ti demande deux connecteurs d'alimentation 6 broches, qui correspondent à une consommation maximale de 225W selon les spécifications PCI Express. En pratique la consommation est nettement inférieure à cela. Le PCB diffère légèrement de celui de la GeForce GTX 670 au niveau de l'organisation de la mémoire, la moitié des canaux ne pouvant accueillir qu'un seul module au lieu de 2. La configuration maximale sur le PCB de la GeForce GTX 660 Ti est ainsi de 3 Go interfacés en 256 bits contre 4 Go interfacés en 256 bits sur celui de sa grande sœur. Il est du coup impossible de placer 3 Go en 192 bits sur ce PCB pour former cette variante de la GTX 660 Ti, qui reprendra probablement le PCB de la GTX 670. Bien que cela n'ait aucune incidence pour l'utilisateur, nous ne comprenons pas pourquoi Nvidia a organisé ses PCB de la sorte… La connectique est identique à celle de la GeForce GTX 680 et propose 2 connecteurs DVI Dual Link, un connecteur HDMI 1.4a 3 GHz et un connecteur DisplayPort 1.2. La fréquence GPU Boost officielle des GeForce GTX 670 et 660 Ti est de 980 MHz pour une fréquence de base de 915 MHz. Nos exemplaires profitaient cependant d'une fréquence maximale respective de 1084 et 1071 MHz. D'après les informations que nous avons recueillies jusqu'ici, cette fréquence maximale pourrait monter jusqu'à 1136 MHz sur les meilleurs exemplaires. En d'autres termes, la fréquence maximale peut être du même ordre que celle d'une GeForce GTX 680, bien que les spécifications de base et GPU Boost officielles soient en retrait par rapport à celle-ci. Page 4 - GTX 660 Ti Asus DirectCU II TOP et EVGA SC Asus et EVGA ont pu nous fournir à temps un exemplaire de leurs premiers modèles personnalisés : Asus GeForce GTX 660 Ti DirectCU IIAsus propose 3 versions de sa GeForce GTX 660 Ti personnalisée. Elles reprennent le même design que celui de l'excellente GTX 670 DirectCU II de la marque : Asus GeForce GTX 660 Ti DirectCU II (DC2) : 340€ Asus GeForce GTX 660 Ti DirectCU II OC + Borderlands 2 (DC2O) : 350€ Asus GeForce GTX 660 Ti DirectCU II TOP (DC2T) : 360€ Les deux premières sont dès à présent disponibles mais il faudra attendre la fin du mois pour la version TOP. La version OC voit son GPU passer de 915/980 MHz (base/boost garanti) à 967/1058 MHz et la version TOP à 1058/1136 MHz. La mémoire reste par contre à 1502 MHz, ce qui est dommage puisque le GPU GK104 qui anime ces cartes profite fortement d'une bande passante mémoire en hausse. Asus nous a fourni un échantillon de test du modèle TOP. Comme c'est souvent le cas, les échantillons presse sont soigneusement sélectionnés, soit pour leur potentiel d'overclocking soit pour leur faible consommation et par conséquent leur faibles nuisances sonores. Dans le cas présent c'est de toute évidence sa coopération vis-à-vis de GPU Boost qui lui a valu d'être sélectionné… Alors que la fréquence GPU Boost garantie est de 1136 MHz (+6 bins), notre exemplaire est capable de monter jusqu'à 1279 MHz (+ 17 bins) ! Un gain de puissance de plus de 12% par rapport aux spécifications qui sont garanties… tout du moins si la carte est capable d'en profiter. Pour la GTX 670 DirectCU II TOP, Asus avait revu à la hausse la limite de consommation de GPU Boost. Par défaut il pouvait ainsi s'enclencher jusque +/- 175W sur le modèle TOP contre 140W pour la carte de référence. Une modification nécessaire pour permettre à GPU Boost de profiter d'un GPU capable de monter si haut. Malheureusement, Asus n'a pas répété l'opération sur la GeForce GTX 660 Ti, de quoi couper les ailes du GPU de notre échantillon… tout du moins pour le moment. Il se pourrait bien qu'un bios corrige cela sous peu.       Asus reprend ici son système de refroidissement DirectCU II classique, en version double slot. La base en aluminium profite de 3 caloducs en cuivre nickelé de 8mm de diamètre incrustés et au contact direct avec le GPU. Ils rejoignent un large radiateur surmonté par 2 ventilateurs de 75mm low profile et une coque en métal relativement épais, et donc rigide, referme le tout. Asus n'a pas adapté le format de ce ventirad au PCB, sur lequel le GPU est positionné plus ou moins au centre alors que la base du radiateur est quelque peu déportée sur la gauche du ventirad. Ce dernier se retrouve donc décalé par rapport au PCB. Il dépasse à l'arrière de la carte de 35mm et l'équerre est chargée de boucher le trou à l'avant de la carte. La longueur totale de la carte passe alors à 27cm. Une barre de renfort est placée sur le dessus de la carte de manière à en garantir la rigidité. Si Asus a repris la connectique de référence (2 DVI, 1 HDMI, 1 DisplayPort), l'étage d'alimentation a été totalement revu. Alors que le PCB de référence prévoit 4 phases pour alimenter le GPU, ce modèle DirectCU II en dispose de 6. Asus a par ailleurs déporté le circuit d'alimentation dédié à la mémoire de l'autre côté du PCB, ce qui devrait améliorer quelque peu la qualité des différents signaux. Petit différence par rapport à la GTX 670 de la marque : une seule phase est ici chargée de la mémoire, contre 2 sur la première. Comme sur la carte de référence, 2 connecteurs d'alimentation 6 broches sont nécessaires. Autre petite évolution par rapport à la GTX 670 DirectCU II : ces connecteurs sont retournés, de manière à éviter de placer les ergots sous un caloduc, ce qui compliquait le démontage des câbles d'alimentation. La carte est livrée avec un CD qui contient les pilotes, un petit guide de montage, un adaptateur DVI vers VGA et un câble convertisseur d'alimentation double molex vers PCIE 6 broches. EVGA GeForce GTX 660 SuperClockedEVGA propose 4 versions de sa GeForce GTX 660 Ti basée sur le design de référence mais équipées d'un système de refroidissement quelque peu personnalisé. Elles reprennent le même design que celui des GTX 670 de la marque : EVGA GeForce GTX 660 2 Go : 310€ EVGA GeForce GTX 660 3 Go : 330€ EVGA GeForce GTX 660 2 Go SuperClocked (SC) : 330€ EVGA GeForce GTX 660 3 Go SuperClocked (SC) : 350€ Les versions SuperClocked voient leur GPU passer de 915/980 MHz (base/boost garanti) à 980/1058 MHz. La mémoire reste par contre à 1502 MHz, ce qui est dommage puisque le GPU GK104 qui anime ces cartes profite fortement d'une bande passante mémoire en hausse. Des modèles FTW sont également proposés mais leur design diffère quelque peu. EVGA nous a fourni un échantillon du modèle SuperClocked 2 Go dont la fréquence GPU Boost maximale est en pratique de 1150 MHz, soit 9% supérieure aux spécifications garanties.       EVGA reprend ici le PCB de référence de la GeForce GTX 660 Ti. Ce dernier est très court, 17cm, et le système de refroidissement, dérivé de celui de référence, la prolonge via un support en plastique qui porte la longueur totale de la carte à 24 cm. Le système de refroidissement reprend la même turbine que sur la carte de référence, la même structure globale et le même petit radiateur sur l'étage d'alimentation équipé de 4 phases dédiées au GPU. Le bloc de refroidissement principal est cependant légèrement différent de celui de référence : l'insert en cuivre est plus petit mais le radiateur est un peu plus large et ses ailettes sont plus épaisses et rigides. Enfin, la coque légèrement bombée qui recouvre l'ensemble profite d'un design personnalisé. La carte est livrée avec un CD qui contient les pilotes, un petit guide de montage, un adaptateur DVI vers VGA et deux câbles convertisseurs d'alimentation double molex vers PCIE 6 broches. Pour les fans de la marque, EVGA inclus également un kit complet : poster, badge et autocollants. Page 5 - Nuisances sonores et température GPU Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe +/- à 20 dBA. Notez que pour toutes les mesures de bruit et de températures, nous nous sommes basées sur le vrai design de référence pour la Radeon HD 7950, différent de la carte presse fournie par AMD. Nous n'avons pas pu faire de mesures similaires pour la Radeon HD 7950 v2.  Rappelons que notre exemplaire de GeForce GTX 670 fait partie des exemplaires qui souffrent de nuisances sonores excessives, leur système de refroidissement générant un bruit mécanique désagréable. Cela affecte bien plus le ressenti que les mesures. Les nuisances sonores de la GeForce GTX 660 Ti, basée sur le même design, sont quelque peu inférieures. La carte manque cependant de discrétion au repos. La solution d'EVGA fait légèrement mieux que cette dernière mais nous sommes très loin de l'excellent résultat de l'Asus, totalement silencieuse au repos et très discrète en charge, plus que la plupart des autres cartes graphiques au repos ! Précisons cependant que le modèle DirectCU II n'expulse pas l'air en dehors du boîtier, ce qui simplifie ici sa tâche. Le bios final augmente légèrement les nuisances sonores mais elles restent à un niveau excellent. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  Les GeForce GTX 660 Ti de référence et EVGA sont bien refroidies, mais la solution d'Asus reste un cran au-dessus. Page 6 - Relevés et thermographie infrarouge Relevés et thermographie infrarougePour ce test, nous avons repris le nouveau protocole décrit ici. Voici tout d'abord un récapitulatif de tous les relevés :  La différence au repos entre les cartes est presque nulle, si ce n'est que l'Asus est nettement plus silencieuse.  En charge, l'avantage de la carte Asus au niveau des nuisances sonores s'accentue nettement, au prix cependant d'une augmentation des températures internes. Voici enfin, ce que tout cela donne à travers l'imagerie thermique :

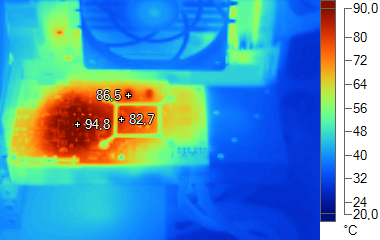

Si le GPU de la GeForce GTX 660 Ti DirectCU II TOP d'Asus est très bien refroidi, son étage d'alimentation chauffe autant, voire un peu plus que celui des 2 autres cartes. Ce n'est pas réellement un problème, mais il faudra être attentif à ce point si la limite de consommation est augmentée pour profiter pleinement du potentiel de la carte. L'augmentation de 10% de la limite de consommation sur la carte d'Asus a un impact sur les températures, mais il est relativement faible, le système de refroidissement étant à la hauteur. Page 7 - Consommation et performances/watt ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 7 ainsi qu'en veille écran de manière à observer l'intérêt de ZeroCore Power. Pour la charge, nous avons opté pour des mesures dans Anno 2070, en 1080p avec tous les détails poussés à leur maximum, ainsi que dans Battlefield 3, en 1080p dans le mode High :  La GeForce GTX 660 Ti de référence affiche une consommation identique à celle de la GeForce GTX 670. Les cartes d'Asus et d'EVGA, overclockées d'usine, maximisent de leur côté l'utilisation de l'enveloppe thermique disponible. Alors que le TDP de la Radeon HD 7950 v2 a augmenté de 12.5% par rapport à la version originale, sa consommation augmente de 21% dans Anno 2070 et de 32% dans Battlefield 3. Ceci s'explique par le gain en précision de PowerTune qui estime plus précisément la consommation et exploite donc mieux l'enveloppe thermique disponible. Le bios final de la GTX 660 Ti DirectCU II TOP augmente sa consommation en charge de 10%. Nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles :  [ Anno 2070 1080p Max ] [ Battlefield 3 1080p High ] Ces graphes mettent en lumière la réduction du rendement énergétique qui intervient mécaniquement lorsque l'utilisation du TDP est maximisée à travers un algorithme plus précis d'estimation de la consommation et/ou une augmentation de la tension. Ce rendement reste largement supérieur à ce qu'offrait la génération précédente, mais il chute significativement avec la Radeon HD 7950 v2. La Radeon HD 7870, les GeForce GTX 660 Ti et surtout la GeForce GTX 670 restent les plus efficaces. Vous remarquerez que l'efficacité énergétique baisse légèrement avec le nouveau bios Asus qui laisse plus de marge au turbo. Notons cependant que chaque jeu représente un cas particulier et que le rendement varie d'un exemplaire de chaque carte à l'autre, pour les Radeon parce que leur niveau de consommation réel varie et pour les GeForce parce que leur fréquence maximale et donc leurs performances varient. Dans cet exemple, la GeForce GTX 680 est capable de monter jusqu'à 1110 MHz, la GeForce GTX 670 jusqu'à 1084 MHz et la GeForce GTX 660 Ti jusqu'à 1071 MHz. Page 8 - Protocole de test Protocole de testPour ce test, nous avons repris le protocole précédent auquel nous avons ajouté Max Payne 3. Tous ces jeux sont testés avec leur dernier patch, la plupart étant maintenus à jour via Steam/Origin. Nous avons décidé de ne plus utiliser le niveau de MSAA (4x et 8x), comme critère principal pour segmenter nos résultats. De nombreux jeux au rendu différé proposent d'autres formes d'antialiasing, la plus courante étant le FXAA développé par Nvidia. Cela n'a donc plus de sens d'organiser un indice autour d'un certain niveau d'antialiasing, ce qui nous permettait par le passé de juger de l'efficacité du MSAA qui peut varier suivant l'implémentation. En 1920x1080, nous avons dès lors exécuté les tests avec 2 niveaux de qualité différents : extrême et très élevé, ce qui inclus d'office un minimum d'antialiasing (soit du MSAA 4x, soit du FXAA/MLAA/AAA). Nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Si vous êtes observateurs vous remarquerez que c'est également le cas pour la taille des barres dans les graphes. Toutes les Radeon ont été testées avec les pilotes Catalyst 12.8 fraîchement sortis (nous remercions AMD de l'avoir fait la veille de la publication de ce test :o) et toutes les GeForce ont été testées avec les pilotes beta 305.37. Nous avons fait en sorte de tester les GeForce GTX 600 à leurs spécifications minimales garanties au niveau de GPU Boost. Nous avons pour cela joué avec les paramètres d'overclocking pour réduire la fréquence de base, en ajustant légèrement la limite de consommation de manière à ce que la fréquence en pratique corresponde bien à celle d'une carte dont la fréquence turbo maximale serait la fréquence GPU Boost officielle. Insistons bien sur le fait que cela ne revient pas à désactiver GPU Boost ! Pour rappel, nous avions profité du dossier consacré à la GeForce GTX 690 pour faire évoluer notre système de test qui passe sur une plateforme X79 et un Core i7 3960X le but étant de profiter du PCI Express 3.0. Notez à ce sujet que son activation sur les GeForce GTX 600 n'est pas automatique et demande une modification dans la base des registres, ce que nous avons fait et qui donne un gain moyen de 2%.  Configuration de testIntel Core i7 3960X (HT désactivé, Turbo 1/2/3/4/6 cores: 4 GHz) Asus P9X79 WS 8 Go DDR3 2133 Corsair Windows 7 64 bits Pilotes GeForce beta 305.37 Catalyst 12.8 Page 9 - Benchmark : Alan Wake Alan Wake  Alan Wake est un portage console plutôt bien exécuté et basé sur DirectX 9. Nous utilisons les niveaux de qualité High proposés par le jeu auxquels nous ajoutons un niveau de qualité maximal qui fait passer le niveau de MSAA à 8x et le niveau de filtrage anisotrope à 16x. Nous effectuons un déplacement bien défini et mesurons les performances avec fraps. Le jeu est maintenu à jour via Steam.  Par rapport à la GeForce GTX 670, la GeForce GTX 660 Ti souffre dans ce jeu gourmand en bande passante mémoire que les Radeon apprécient particulièrement. Page 10 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons d'une part le mode de qualité très élevé proposé par le jeu et d'autre part un mode de qualité maximale qui complexifie les effets de post processing et augmente le niveau de filtrage anisotrope. Nous effectuons un déplacement sur une carte et mesurons les performances avec fraps.  Les performances de la GeForce GTX 660 Ti sont cette fois très proches de celles de la GeForce GTX 670. Page 11 - Benchmark : Batman Arkham City Batman Arkham City  Batman Arkham City est mis au point avec une version récente de l'Unreal Engine 3 qui supporte DirectX 11. Bien que ce mode ait souffert d'un gros bug dans la version d'origine du jeu, un patch 1.1 a corrigé cela. Nous utilisons le benchmark intégré. Toutes les options sont poussées au maximum, ce qui inclut un niveau de tessellation extrême sur une partie des scènes testées. Les performances sont mesurées en mode Extreme (qui inclus les effets DirectX 11 supplémentaires) avec MSAA 4x et MSAA 8x. Le jeu est maintenu à jour via Steam.  Les GeForce GTX 600 sont ici plus efficaces avec MSAA 4x, alors que les Radeon HD 7000 profitent de leur bande passante mémoire supérieure avec MSAA 8x. Des besoins en bande passante mémoire qui freinent la GeForce GTX 660 Ti dans ce jeu. Page 12 - Benchmark : Battlefield 3 Battlefield 3  Battlefield 3 repose sur le Frosbite 2, probablement la moteur graphique le plus avancé à ce jour. De type rendu différé, il supporte la tessellation et calcule l'éclairage via un compute shader. Nous testons les modes Ultra et High et relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin.  Les GeForce GTX 600 sont particulièrement efficaces en 1080p dans Battlefield 3, ce qui permet à la GTX 680 de battre la Radeon HD 7970 GHz Edition. La GeForce GTX 660 Ti s'en sort ici plutôt bien, devançant la Radeon HD 7950 v2 en mode de qualité élevée. Comme ce sera souvent le cas, elle recule un petit peu avec le MSAA 4x qui est activé par le mode Ultra. Page 13 - Benchmark : Bulletstorm Bulletstorm  Bulletstorm se contente de DirectX 9, mais propose un rendu plutôt sympathique, basé sur la version 3.5 de l'Unreal Engine. Toutes les options graphiques sont poussées au maximum (high) et nous mesurons les performances avec Fraps avec MSAA 4x et puis 8x.  Avec MSAA 8x, les GeForce GTX 600 accusent le coup par rapport aux Radeon, ce qui est particulièrement le cas pour les GTX 680 et 660 Ti qui manquent de toute évidence de bande passante mémoire. Page 14 - Benchmark : Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d'une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d'autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le jeu est maintenu à jour via Steam.  Les GeForce GTX 600 profitent ici des nouveaux pilotes de la série 300 qui apportent un gain significatif. Comme c'est souvent le cas, la GeForce GTX 660 Ti souffre quand le niveau de MSAA augmente. Page 15 - Benchmark : Crysis 2 Crysis 2  Crysis 2 reprend une évolution du moteur de Crysis Warhead optimisée pour être relativement moins gourmande mais y ajoute, via un patch, un support de DirectX 11 dont le coût peut être assez important. C'est par exemple le cas de la tessellation, que nous évitons d'activer compte tenu du fait qu'elle a été implémentée en collaboration avec Nvidia d'une manière abusive, dans le but de faire plonger les performances sur les Radeon. Nous avions dévoilé cette entourloupe ici. Nous mesurons les performances avec Fraps sur la version 1.9 du jeu.  La GeForce GTX 660 Ti se place ici au niveau de la Radeon HD 7870 en mode Ultra mais entre les deux Radeon HD 7950 en mode Extrême. Page 16 - Benchmark : DiRT Showdown DiRT Showdown  Dernier né chez Codemaster, DiRT Showdown reprend une évolution légère du moteur DirectX 11 maison. En partenariat avec AMD, les développeurs ont mis en place un éclairage avancé qui prend en compte de nombreuses sources de lumière directes et indirectes pour simuler une illumination globale. Ces options supplémentaires ont été activées avec le premier patch du jeu qui a donc été déployé sur notre système, le jeu étant maintenu à jour via Steam. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons fraps sur l'outil de test intégré.  Si la GeForce GTX 680 égale la Radeon HD 7970 en 1080p sans l'éclairage avancé, une fois celui-ci activé ses performances et celles de ses petites soeurs plongent, Nvidia n'ayant pas eu accès à ce patch suffisamment tôt que pour pouvoir proposer rapidement des optimisations spécifiques. Il faudra probablement attendre encore quelques semaines pour que cela soit en place. Page 17 - Benchmark : Max Payne 3 Max Payne 3  Max Payne 3 présente un rendu globalement réussi, bien qu'inégal par endroit, notamment à cause de textures de "qualité console". Il repose sur un moteur DirectX 11 au rendu différé qui supporte plusieurs effets avancés tels que le HDAO ou la tessellation qui est plutôt lourde une fois poussée au maximum. Il supporte le FXAA mais également le MSAA, très lourd compte tenu du type de rendu. Ce dernier reste nécessaire pour venir à bout de l'aliasing, le FXAA n'étant pas suffisant. Nous avons poussé toutes les options à leur maximum et utilisé Fraps sur un parcours bien défini.  Les GeForce GTX 600 sont particulièrement à l'aise dans ce jeu, pour lequel Nvidia a travaillé en amont avec les développeurs. Le niveau de tessellation maximal est très lourd, ce qui freine quelque peu les Radeon. Elles reviennent cependant dans la course quand le MSAA 4x est activé. La GeForce GTX 660 Ti est ainsi au niveau de la Radeon HD 7970 sans MSAA mais se contente du niveau de la Radeon HD 7950 avec. Page 18 - Benchmark : Metro 2033 Metro 2033  Toujours l'un des jeux les plus lourds, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n'avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l'avons testé en mode DirectX 11, avec une qualité maximale (ce qui inclut l'effet de DoF et le MSAA 4x) et une qualité très élevée avec la tessellation activée.  Aucune carte mono-GPU ne permet de jouer confortablement à Metro 2033 en 1080p avec une qualité maximale. Les GeForce GTX 600 souffrent dans ce mode d'un manque de bande passante mémoire, ce qui y limite leurs performances. Page 19 - Benchmark : The Witcher 2 EE The Witcher 2 Enhanced Edition  The Witcher 2 est un jeu dont le moteur graphique a été peaufiné progressivement, pour en arriver à la récente Enhanced Edition. Bien que basé sur DirectX 9, il est relativement gourmand une fois toutes ses options graphiques poussées au maximum, l'une d'elles étant particulièrement gourmande : l'UberSampling. Il s'agit en réalité d'un antialiasing de type supersampling 4x avec quelques optimisations. Nous avons testé le jeu en qualité maximale avec et sans l'UberSampling. Les performances sont mesurées avec Fraps.  Les Radeon HD 7000 dominent assez facilement dans ce jeu et la Radeon HD 7870 devance la GeForce GTX 660 Ti. Notez cependant que la fluidité n'y est pas toujours parfaite avec les Radeon. Page 20 - Benchmark : Total War Shogun 2 Total War Shogun 2  Total War Shogun 2 a reçu un patch DirectX 11, développé en collaboration avec AMD. Il apporte entre autre un support de la tessellation et un effet de profondeur de champ de meilleure qualité. Nous l'avons testé en mode DirectX 11, avec une qualité maximale, du MSAA 4x et du MLAA. Le jeu est maintenu à jour via Steam.  Une fois n'est pas coutume, c'est Nvidia qui domine quand le MSAA 4x est activé. Page 21 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 à la Radeon HD 7950 originale :  [ Standard ] [ Tri ] Au final, la GeForce GTX 660 Ti à ses fréquences garanties égale la Radeon HD 7870. Un bon exemplaire capable de monter nettement plus haut en fréquence est nécessaire pour se rapprocher de la Radeon HD 7950 originale. La nouvelle version de celle-ci consolide cette avance. L'ajout de Max Payne 3 au protocole aide quelque peu la GeForce GTX 680 qui passe d'un retard de 0.3% sur la Radeon HD 7970 à une avance de 0.4%. Une différence minime pour des cartes qui offrent en moyenne des performances similaires mais avec des différences marquées dans certains jeux. Enfin, voici les gains que nous avons notés entre le comportement de nos échantillons de GeForce GTX 600 et leurs spécifications GPU Boost garanties : GTX 680 (1110 MHz max) : +2.1% GTX 670 (1084 MHz max) : +5.3% GTX 660 Ti (1071 MHz max) : +4.4% Page 22 - Performances des cartes Asus et EVGA GTX 660 Ti Asus DirectCU II TOP et EVGA SuperClocked : performancesNous avons observé les performances des GeForce GTX 660 Ti d'Asus et EVGA sur une partie de notre protocole de test. Tout comme pour les benchs précédents, les cartes ont été testées telles quelles, c'est-à-dire avec la fréquence GPU Boost maximale spécifique à notre exemplaire, ainsi qu'en limitant le GPU à sa fréquence officiellement garantie :

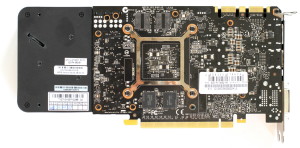

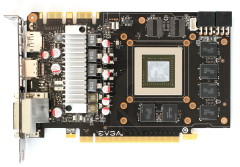

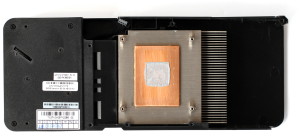

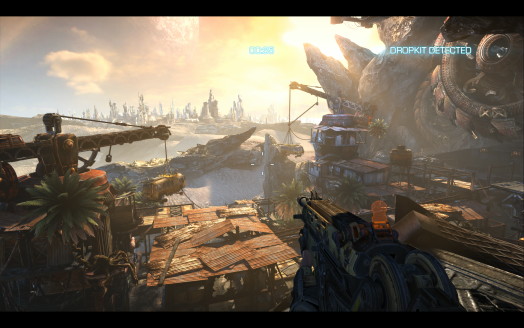

Nous pouvons constater ici que les gains apportés par ces cartes overclockées sont relativement modestes. Si nous comparons les résultats des GTX 600 entre elles, sans limiter GPU Boost, le modèle SC d'EVGA apporte un gain de 2.9% et le modèle TOP d'Asus un gain de 5.1% sur la carte de référence. Le nouveau bios proposé par Asus permet de faire passer ce gain à 8.3% et de se rapprocher de la GTX 670 de référence. Et pourtant sur le papier, la carte d'EVGA apporte un gain de 8% et la carte d'Asus un gain de 16%! Si nous observons les fréquences GPU maximales de nos échantillons, le gain potentiel sur la carte de référence est de toujours de 8% avec la carte d'EVGA mais passe à 19% du côté d'Asus. Comment se fait-il que le gain de performances en pratique soit aussi réduit ? Il y a deux explications principales. La première est que le GPU des GeForce GTX 660 Ti est en partie retenu par sa bande passante mémoire, mais la plus importante provient de la limite de l'enveloppe thermique. Les 134W dans lesquels GPU Boost peut monter la fréquence GPU sont insuffisants pour profiter des fréquences maximales de ces cartes dans la majorité des jeux. Les partenaires de Nvidia ont la possibilité de modifier cette limite de consommation, ce qu'Asus a fait avec le bios final de la GTX 660 Ti DirectCU II TOP. Une opération plus que bienvenue, le système de refroidissement de ce modèle pouvant encaisser la charge sans faire exploser les nuisances. Il est également possible de modifier manuellement cette limite via les outils d'overclockings tels que Precision X et GPU Tweak. Page 23 - Bus mémoire 192-bit : l'impact Bus mémoire 192-bit : l'impactNous avons tenté d'observer de plus près l'impact sur les performances lié au bus mémoire réduit à 192-bit en comparant les performances des GeForce GTX 660 Ti et GTX 670 lorsque leur fréquence GPU Boost maximale est identique : 980 MHz. Cet impact est lié à la réduction de bande passante mémoire qui en résulte mais également à la réduction du nombre de ROP qui passent de 32 à 24. L'impact lié à ceux-ci se retrouve principalement avec un niveau élevé de MSAA, puisque quand ce n'est pas le cas le débit de pixel est en partie limité en amont, au niveau de la communication entre les blocs d'unités de calcul et les ROP. Il se trouve que le MSAA est également gourmand en bande passante mémoire, ce qui ne permet pas de séparer l'influence de cette dernière de celle du nombre de ROP.  La perte de performances qui en résulte varie entre 3.4% et 22.4%, les chiffres les plus importants s'observant comme prévu lorsque le MSAA est utilisé. Page 24 - Radeon HD 7950 v2 : les gains Radeon HD 7950 v2 : les gainsVoici résumés les gains de performances apportés par la Radeon HD 7950 v2, dont la fréquence du GPU et la puissance brute augmentent de 6.3 à 15.6% suivant l'estimation de consommation liée à la charge en cours.  Les gains varient entre 3.9% et 8.4% avec une moyenne de 6.3%, ce qui est relativement modeste au vu de l'augmentation de la fréquence maximale. Tout comme pour les GTX 660 Ti overclockées d'usine, cela s'explique par l'absence d'évolution du côté de la fréquence mémoire ainsi que par une limitation liée à l'enveloppe thermique disponible. Page 25 - Conclusion ConclusionTrès vite lors de la réalisation de ce dossier, il est apparu qu'il ne pourrait pas déboucher sur une conclusion simple et des conseils d'achats universels. Pour jouer en 1080p, nous vous recommanderons au cas par cas de choisir entre la Radeon HD 7870, la GeForce GTX 660 Ti, la GeForce GTX 670 et la Radeon HD 7970 GHz Edition. Commençons par cette dernière que nous vous conseillerons si vous faites partie de ceux qui recherchent le maximum de performances sans devoir passer par le multi-GPU. Il faudra cependant éviter le modèle de référence, trop bruyant.  Parmi les 3 autres cartes, notre conseil de base reste la Radeon HD 7870. Elle propose des performances solides, est peu gourmande et, surtout, Sapphire la propose à un tarif défiant tout concurrence : 270€. C'est le meilleur rapport performances/prix pour les joueurs et nous vérifierons sous peu si son système de refroidissement est bien à la hauteur. Les GeForce GTX 660 Ti et GTX 670 représentent cependant des solutions intermédiaires à ne pas ignorer. La première vous donnera une dizaine de points de performances supplémentaires si son GPU Boost est coopératif et si vous n'avez que faire de l'antialiasing de type MSAA. Son accélération n'est pas le point fort de cette carte. Toujours suivant la bonne volonté de son GPU Boost, la GeForce GTX 670 apportera de son côté entre 15 et 20% de performances de plus mais cette fois sans souffrir plus que de raison avec MSAA. Outre le niveau de performances, une préférence personnelle pour l'une ou l'autre marque ou fonctionnalité vous aidera probablement à pencher pour l'une ou l'autre solution. De notre côté nous avons par exemple une petite préférence pour les pilotes Nvidia… mais nous apprécions également que les cartes graphiques s'éteignent en veille écran comme c'est le cas du côté d'AMD. Décidemment, rien n'est simple… à l'exception de la Radeon HD 7950 v2 ! Son arrivée sur le fil aurait pu compliquer encore plus nos conseils d'achat mais au final il n'en est rien : le jeu n'en vaut pas la chandelle. Un gain de performances moyen de 6% pour une consommation en hausse de 20 à 30% ne se justifie pas et AMD serait bien avisé de conseiller à ses partenaires de ne proposer qu'en option le nouveau BIOS qui permet de passer en v2.  Terminons par un petit mot sur les GeForce GTX 660 Ti SuperClocked et DirectCU II TOP personnalisées respectivement par EVGA et Asus. La première est préférable au modèle de référence et conserve l'avantage de l'extraction de l'air chaud, ce qui peut être important pour les boîtiers compacts. Toutefois, dans l'absolu, elle reste selon nous trop bruyante par rapport au nombre de watts à dissiper d'autant plus lorsqu'elle est comparée à la carte DirectCU II d'Asus dont c'est le point fort. Au repos comme en charge, cette dernière se montre d'une discrétion absolue. Certes la variante TOP n'est pas bon marché et a du mal à tirer pleinement partie de sa fréquence supérieure, la faute à une limite de consommation trop stricte (qui pourrait évoluer via un nouveau bios). Asus propose cependant deux autres variantes au tarif également élevé mais justifié pour les amateurs de silence au vu de la prestation du système de refroidissement : le modèle DirectCU II standard à 340€ et le modèle DirectCU II OC à 350€. Ce dernier est par ailleurs livré avec Borderlands 2, ce qui en fait une plutôt bonne affaire au final, si tant est que ce jeu vous intéresse bien entendu. Mise à jour du 07/09/12 : Comme nous le supposions, à travers un nouveau bios, Asus a modifié la limite de consommation de la GTX 660 Ti DirectCU II TOP de manière à mieux profiter de sa fréquence maximale supérieure. Toutes les cartes commerciales devraient être équipées de ce bios. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |