| |

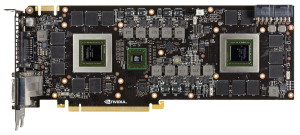

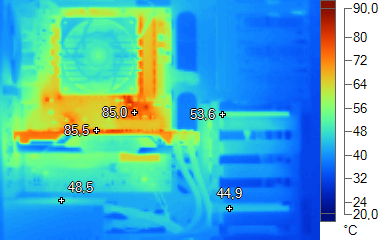

| Nvidia GeForce GTX 690 : la carte à 1000€ en test ! Cartes Graphiques Publié le Jeudi 3 Mai 2012 par Damien Triolet URL: /articles/864-1/nvidia-geforce-gtx-690-carte-1000-test.html Page 1 - Introduction, spécifications Alors que nous attendions tout d'abord AMD sur le créneau de la carte graphique bi-GPU ultra haut de gamme, c'est finalement Nvidia qui a dégainé le premier en présentant la GeForce GTX 690 dimanche dernier. Une carte graphique à 1000€, ça donne quoi ?  La GeForce GTX 690 s'inscrit de toute évidence dans la lignée de la GeForce GTX 590 dont elle reprend le format. Nvidia a cependant voulu proposer plus. D'une part sur le plan des performances, profitant de la consommation mieux maîtrisée de son nouveau GPU pour placer un maximum de puissance dans l'enveloppe thermique disponible. D'autre part sur le plan de la qualité de fabrication, en faisant le choix d'employer exclusivement des matériaux de qualité pour une finition exemplaire. De quoi en faire un modèle très exclusif, proposé à pas moins de 1000€ ! C'est cher, très cher, voire même un record pour une carte de référence. Vous l'aurez compris, en dehors de la petite niche intéressée par ce genre de produit, la GeForce GTX 690 est avant tout destinée à faire office de vitrine technologie ainsi qu'à faire rêver les passionnés. Un SLI de GeForce GTX 680, ou presqueLa GeForce GTX 690 embarque deux GPU GK104 basés sur l'architecture Kepler qui augmente significativement le rendement énergétique par rapport à l'architecture Fermi. Etant donné que l'enveloppe thermique est le premier facteur qui balise ce qu'il est possible de faire pour une carte bi-GPU, un meilleur rendement permet de proposer des spécifications plus élevées. C'est d'autant plus le cas quand les meilleurs GPU sont sélectionnés. Chaque GPU de la GTX 690 est ainsi très proche de celui de la GeForce GTX 680 :  Nvidia emploie ici des GK104 complets, c'est-à-dire disposant chacun de 1536 unités de calcul. Leur fréquence de base est plus faible que sur la GTX 680, 915 MHz vs 1006 MHz, mais leur fréquence GPU Boost officielle est proche : 1019 MHz pour la GTX 690 et 1058 MHz pour la GTX 680. En pratique, comme nous l'avons expliqué ici, cette fréquence GPU Boost ne correspond pas directement à une spécification mais représente la fréquence minimale à laquelle le GPU peut avoir été validé. Dans le cas de la GeForce GTX 680, cette fréquence peut monter jusque 1123 MHz. Les deux GPU de notre échantillon de GeForce GTX 690 pouvaient pour leur part monter jusqu'à 1071 MHz. Du côté de la mémoire, nous retrouvons sur les deux cartes 2 Go de GDDR5 cadencée à 1503 MHz et interfacée en 256 bits. Les performances s'annoncent ainsi bien plus proches entre en SLI de GTX 680 et une GTX 690 que ce que nous ont montré les oppositions similaires sur la précédente génération. Page 2 - La GeForce GTX 690, GPU Boost Deux GK104 dans un écrin de luxePour ce test, Nvidia nous a fourni un exemplaire de GeForce GTX 690 :       La GeForce GTX 690 reprend la structure de la GeForce GTX 590. Système de refroidissement et PCB sont ainsi très proches dans leur conception, bien que le niveau de qualité du premier soit très nettement en hausse avec la nouvelle venue. Pour les deux cartes, nous avons affaire à un PCB de 28cm qui accueille un GPU à chaque extrémité et en son centre leurs étages d'alimentation ainsi que le switch PCI Express qui le relie. Un design qui permet un refroidissement optimal grâce à un ventilateur central qui peut apporter de l'air frais au radiateur avec chambre à vapeur de chaque GPU. Par ailleurs les deux cartes graphiques disposent d'un étage d'alimentation similaire avec 5 phases dédiées à chaque GPU, ont besoin de 2 connecteurs 8 broches et proposent les mêmes sorties : 3 DVI Dual Link et une mini-DP. De quoi faciliter la mise en place d'un système Surround ou 3D Vision Surround. Petite différence, Nvidia a abandonné son swtich PCI Express 2.0 maison, le NF200, au profit d'un switch PCI Express 3.0, le PEX8747 de PLX. Ce dernier gère 3 ports PCI Express 16x 3.0 ce qui permet de relier chaque GPU au système mais également de mettre en place un lien direct entre les deux GPU. Grosse différence par contre cette fois, Nvidia a voulu proposer un produit exclusif et a pour cela mis les bouchées doubles sur la finition de son ventirad qui abandonne le mal aimé plastique au profit de matières plus nobles. Nous vous épargnerons les termes techniques industriels liés à ces matériaux et qui sont destinés à vous en mettre plein la vue : en réalité la même description du plastique le plus cheap qui soit aurait également l'effet "la NASA doit surement l'utiliser". Cette boutade ne saurait cependant amoindrir le travail qu'a fait Nvidia en utilisant exclusivement des matériaux de qualité, comme c'est le cas dans les ultraportables haut de gamme par exemple. De quoi pouvoir proposer un design très travaillé et assurer la robustesse sans faire exploser le poids de la carte graphique. La finition est remarquable, tant visuellement qu'au toucher. Esthétiquement c'est un sans faute.   GPU Boost  Pour rappel, Nvidia a introduit avec la GeForce GTX 680 une technologie turbo, GPU Boost, qui a la particularité d'être variable d'un échantillon à l'autre d'un même GPU. D'une part parce qu'en se basant sur la consommation réelle elle est de fait non-déterministe, contrairement aux CPU et aux GPU AMD qui se basent sur une estimation par rapport à leurs capteurs internes d'utilisation. D'autre part parce que Nvidia ne valide pas tous les GPU à la même fréquence turbo maximale. Vous pourrez retrouver plus de détails à ce sujet dans le focus qui y est consacré. Pour rappel, Nvidia a introduit avec la GeForce GTX 680 une technologie turbo, GPU Boost, qui a la particularité d'être variable d'un échantillon à l'autre d'un même GPU. D'une part parce qu'en se basant sur la consommation réelle elle est de fait non-déterministe, contrairement aux CPU et aux GPU AMD qui se basent sur une estimation par rapport à leurs capteurs internes d'utilisation. D'autre part parce que Nvidia ne valide pas tous les GPU à la même fréquence turbo maximale. Vous pourrez retrouver plus de détails à ce sujet dans le focus qui y est consacré.Nvidia se contente de communiquer une fréquence GPU Boost officielle qui est le minimum sur lequel vous pourrez tomber. Dans le cas de la GeForce GTX 690, il s'agit de 1019 MHz, à opposer aux 1071 MHz de notre échantillon de test. Plus précisément il s'agit du nombre de crans (bins) de 13 MHz que le GPU peut gravir à partir de sa fréquence de base : 8 bins minimum pour la GTX 690, 12 bins pour notre échantillon. Pour rappel, la GTX 680 profiter au minimum de 4 bins, mais ce nombre peut monter au moins à 9 suivant les échantillons. Cette marge de fréquence plus importante pour la GeForce GTX 690 est liée au fait que Nvidia a dû compresser son TDP autant que possible. Il est de 300W. GPU Boost vise cependant une consommation de 265W, ce qui correspond à la valeur de 100% qu'il reporte dans les outils de monitoring. Si la consommation dépasse 265W, la fréquence n'augmentera pas. Par contre GPU Boost ne passera pas en mode protection tant que le TDP de 300W n'est pas atteint. Pour la GeForce GTX 690, Nvidia a modifié légèrement l'implémentation de GPU Boost de manière à protéger chaque GPU indépendamment l'un de l'autre. Ainsi GPU Boost ne mesure pas la consommation totale de la carte mais bien la partie consommée par chaque GPU. Pour cela les mesures de courant ne se font pas aux sources 12V comme sur les autres cartes mais bien aux entrées des 4 étages d'alimentation principaux (GPU1, GPU2, MEM1, MEM2). Comme nous le supposions, Nvidia nous a indiqué que la consommation de certains circuits et du switch PLX n'était du coup pas mesurée. Elle est négligeable par rapport au reste, ce n'est pas donc pas très important, mais Nvidia la prend malgré tout en compte via une constante qui représente la valeur estimée de la consommation non mesurée. Page 3 - Nuisances sonores et température GPU Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe +/- à 21 dBA.  La GeForce GTX 690 est très discrète au repos, bien que ses deux GPU restent alimentés. En charge, elle est moins bruyante que tous les autres systèmes bi-GPU, qu'ils soient basés sur une ou deux cartes graphiques. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  La GeForce GTX 690 est plutôt bien refroidie, surtout au repos. Notez que nous reportons ici la température du GPU le plus chaud, qui est toujours le GPU principal. Dans le cas de la GTX 690, nous obtenons pour le second GPU 35/84 °C (repos/charge), et dans le cas des GTX 680 en SLI, 39/83 °C pour le second GPU. Page 4 - Relevés et thermographie infrarouge Relevés et thermographie infrarougePour ce test, nous avons repris le nouveau protocole décrit ici. Voici tout d'abord un récapitulatif de tous les relevés :  Au repos on note une température CPU légèrement plus élevée avec la GTX 690 qui n'expulse pas tout l'air chaud en dehors du boîtier.  En charge cette différence s'accentue et la plupart des composants présents dans le boîtier chauffent plus avec la GTX 690. C'est particulièrement le cas du disque dur situé dans la zone derrière la GeForce GTX 690. Il faudra éviter de d'en placer un à cet endroit, sans quoi sa durée de vie pourrait être compromise. Voici enfin, ce que tout cela donne à travers l'imagerie thermique :

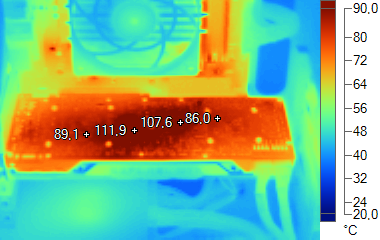

Si les GPU de la GTX 690 sont bien refroidis, leurs étages d'alimentation ont tendance à chauffer.

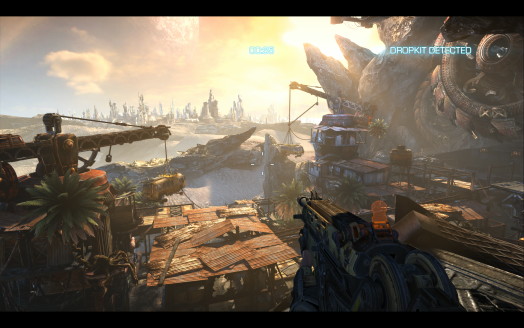

La GeForce GTX 690 n'expulsant qu'une petite partie de l'air chaud en dehors du boîtier, les températures internes augmentent. Page 5 - Consommation ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 7 ainsi qu'en veille écran de manière à observer l'intérêt de la technologie ZeroCore Power des Radeon HD 7000. Pour la charge, nous avons opté pour des mesures dans Anno 2070, en 1080p avec tous les détails poussés à leur maximum, ainsi que dans Battlefield 3, dans le mode High :  La GeForce GTX 690 ne disposant pas d'une technologie similaire à ZeroCore Power, ses 2 GPU restent alimentés au repos sur le bureau Windows ainsi qu'en veille écran. Le niveau de consommation est cependant divisé par 2 par rapport à la GeForce GTX 590. En charge elle dépasse quelque peu la limite jusqu'à laquelle GPU Boost peut augmenter les fréquences, mais reste en-dessous du TDP. Notez que dans Battlefield 3 GPU Boost augmente la fréquence malgré une limite de 265W dépassée, ce qui s'explique par le fait que la consommation d'une partie des circuits n'est pas directement mesurée mais est estimée d'une manière fixe par Nvidia. Une poignée de watts qui en pratique ne fait pas de différence. Page 6 - Protocole de test Le testPour ce test, nous avons repris le protocole utilisé pour le dossier consacré à la GeForce GTX 680 et qui inclut Alan Wake. Nous avons décidé de ne plus utiliser le niveau de MSAA (4x et 8x), comme critère principal pour segmenter nos résultats. De nombreux jeux au rendu différé proposent d'autres formes d'antialiasing, la plus courante étant le FXAA développé par Nvidia. Cela n'a donc plus de sens d'organiser un indice autour d'un certain niveau d'antialiasing, ce qui nous permettait par le passé de juger de l'efficacité du MSAA qui peut varier suivant l'implémentation. En 2560x1600, nous avons dès lors exécuté les tests avec 2 niveaux de qualité différents : extrême et très élevé, ce qui inclus d'office un minimum d'antialiasing (soit du MSAA 4x, soit du FXAA/MLAA/AAA). Nous avons également exécuté des tests avec le premier niveau de qualité en 1920x1080 ainsi qu'avec le second niveau de qualité en résolution surround, en 5760x1080. Nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Si vous êtes observateurs vous remarquerez que c'est également le cas pour la taille des barres dans les graphes. Les Radeon ont été testées avec les pilotes Catalyst 12.4 et toutes les GeForce ont été testées avec les pilotes 301.11. La GeForce GTX 680 principale testée est un exemplaire dont la fréquence GPU Boost maximale est de 1084 MHz. La seconde utilisée pour le SLI affiche par contre une fréquence GPU Boost maximale de 1097 MHz. Quant à la GeForce GTX 690, ses deux GPU sont qualifiés jusqu'à 1071 MHz. Nous avons profité de ce dossier pour faire évoluer notre système de test qui passe sur une plateforme X79 et un Core i7 3960X le but étant de profiter du PCI Express 3.0.  Configuration de testIntel Core i7 3960X (HT off, Turbo 1/2/3/4/6 cores: 4 GHz) Asus P9X79 WS 8 Go DDR3 2133 G.Skill Windows 7 64 bits Pilotes GeForce beta 301.11 Catalyst 12.4 Page 7 - Benchmark : Alan Wake Alan Wake  Alan Wake est un portage console plutôt bien exécuté et basé sur DirectX 9. Nous utilisons les niveaux de qualité High proposés par le jeu auxquels nous ajoutons un niveau de qualité maximal qui fait passer le niveau de MSAA à 8x. Nous effectuons un déplacement bien défini et mesurons les performances avec fraps.  La GeForce GTX 690 affiche ici des performances similaires à celles des GeForce GTX 680 en SLI. La Radeon HD 7970 est cependant nettement plus performante qu'une de ces dernières, ce qui se retrouve également en CrossFire.  Les Radeon dominent assez facilement. Page 8 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons d'une part le mode de qualité très élevé proposé par le jeu et d'autre part un mode de qualité maximale qui complexifie les effets de post processing et augmente le niveau de filtrage anisotrope. Nous effectuons un déplacement sur une carte et mesurons les performances avec fraps.  Si les GeForce GTX 500 étaient en retrait dans ce jeu, la GeForce GTX 680 affiche une progression importante, mais ne parvient pas à dépasser la Radeon HD 7970 lorsqu'une qualité maximale est appliquée. Le SLI offre par contre un meilleur rendement ce qui permet aux solutions bi-GPU Nvidia de compenser et même de reprendre les devants en 1080p.  En très hautes résolutions, nous observons ici une égalité entre la GeForce GTX 680 et la Radeon HD 7970. Page 9 - Benchmark : Batman Arkham City Batman Arkham City  Batman Arkham City est mis au point avec une version récente de l'Unreal Engine 3 qui supporte DirectX 11. Bien que ce mode ait souffert d'un gros bug dans la version d'origine du jeu, un patch 1.1 a corrigé cela. Nous utilisons le benchmark intégré. Toutes les options sont poussées au maximum, ce qui inclut un niveau de tessellation extrême sur une partie des scènes testées. Les performances sont mesurées en mode Extreme (qui inclus les effets DirectX 11 supplémentaires) avec FXAA High (haute résolution) et MSAA 8x.  Bonne nouvelle, après 5 mois AMD a enfin corrigé le problème de performances avec MSAA qui affectait les Radeon. La Radeon HD 7970 devance dorénavant la GeForce GTX 680. Mauvaise nouvelle, le CrossFire X ne fonctionne toujours pas…  En hautes résolutions avec FXAA, la Radeon HD 7970 se laisse dépasser. Page 10 - Benchmark : Battlefield 3 Battlefield 3  Battlefield 3 repose sur le Frosbite 2, probablement la moteur graphique le plus avancé à ce jour. De type rendu différé, il supporte la tessellation et calcule l'éclairage via un compute shader. Nous testons les modes Ultra et High et relevons les performances avec Fraps, sur un parcours bien défini. Notez qu'un patch destiné à améliorer les performances sur les Radeon HD 7000 est sorti le 14/02. Nous l'avons bien entendu installé et avons observé un gain de 1 à 2%.  La GeForce GTX 690 affiche ici des performances similaires à celles des Radeon HD 7970 en CrossFire X.  La GeForce GTX 690 permet de profiter du mode de qualité Ultra en 5760x1080, sur trois écrans. Page 11 - Benchmark : Bulletstorm Bulletstorm  Bulletstorm se contente de DirectX 9, mais propose un rendu plutôt sympathique, basé sur la version 3.5 de l'Unreal Engine. Toutes les options graphiques sont poussées au maximum (high) et nous mesurons les performances avec Fraps avec MSAA 4x et puis 8x.  Avec MSAA 8x, les Radeon devancent les GeForce.  Cet avance fond en très haute résolution avec MSAA 4x. Page 12 - Benchmark : Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d'une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d'autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le dernier patch est installé.  Si la GeForce GTX 680 devance ici la Radeon HD 7970, le rendement de CrossFire X est ici plus élevé ce qui inverse la tendance en bi-GPU. Bien que le jeu en lui-même supporte le surround gaming, ce n'est pas le cas de notre scène de test. Page 13 - Benchmark : Crysis 2 Crysis 2  Crysis 2 reprend une évolution du moteur de Crysis Warhead optimisée pour être relativement moins gourmande mais y ajoute, via un patch, un support de DirectX 11 dont le coût peut être assez important. C'est par exemple le cas de la tessellation, que nous évitons d'activer compte tenu du fait qu'elle a été implémentée en collaboration avec Nvidia d'une manière abusive, dans le but de faire plonger les performances sur les Radeon. Nous avions dévoilé cette entourloupe ici. Nous mesurons les performances avec Fraps sur la version 1.9 du jeu.  Egalité presque parfaite entre les GeForce GTX 680 en SLI et la GeForce GTX 690. Les Radeon sont cependant devant en 2560x1600.  En très hautes résolutions, nous retrouvons cette égalité. Page 14 - Benchmark : F1 2011 F1 2011  Dernier né chez Codemaster, F1 2011 reprend une évolution légère du moteur de F1 2010 et de DiRT 3, qui conserve le support de DirectX 11. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons l'outil de test intégré sur le circuit de Spa-Francorchamps avec une seule F1.  Alors que la Radeon HD 7970 devance légèrement la GeForce GTX 680, les performances en CrossFire X sont plombées par une forte limitation CPU.  En très haute résolution, la GTX 680 garde l'avantage mais il se réduit. Page 15 - Benchmark : Metro 2033 Metro 2033  Toujours l'un des jeux les plus lourds, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n'avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l'avons testé en mode DirectX 11, avec une qualité maximale (ce qui inclus l'effet de DoF et le MSAA 4x) et une qualité très élevée avec la tessellation activée.  Aucune carte mono-GPU ne permet de jouer confortablement à Metro 2033 avec une qualité maximale. La GeForce GTX 680 est d'ailleurs peu performante dans ce mode très gourmand en bande passante mémoire. Ce sont les Radeon HD 7970 en CFX qui s'en tirent le mieux.  C'est mieux du côté des GeForce mais pas encore assez pour battre les Radeon . Page 16 - Benchmark : Total War Shogun 2 Total War Shogun 2  Total War Shogun 2 a reçu un patch DirectX 11, développé en collaboration avec AMD. Il apporte entre autre un support de la tessellation et un effet de profondeur de champ de meilleure qualité. Nous l'avons testé en mode DirectX 11, avec une qualité maximale, du MSAA 4x et du MLAA.  Depuis la sortie du patch de fin mars, les GeForce souffrent d'un problème de performances, probablement parce que les optimisations spécifiques à ce jeu ne sont plus fonctionnelles. Du coup, les Radeon prennent le large.  En très haute résolution avec MLAA, la Radeon HD 7970 passe devant la GeForce GTX 680. Page 17 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats de chaque résolution et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 aux GeForce GTX 680 en SLI :  [ 1920x1080 ] [ 2560x1600 ] [ 5760x1080 ] En moyenne, la GeForce GTX 690 termine à 3% des GeForce GTX 680 SLI en 2560x1600 et à 2% en 1920x1080. Un excellent résultat pour une carte bi-GPU. Nous pouvons également observer que les performances moyennes des Radeon HD 7970 en CrossFire X sont similaires. Vous remarquerez que la tendance entre la GeForce GTX 680 et la Radeon HD 7970 s'est inversée par rapport au test de la première il y a un peu plus d'un mois. Cela s'explique par plusieurs points : - Nous avons ici utilisé une GeForce GTX 680 du commerce dont la fréquence maximale est de 1084 MHz contre 1110 MHz sur l'échantillon presse. - AMD a enfin (après 5 mois!) corrigé un problème de performances dans Batman AC avec MSAA. - Nvidia souffre d'un problème de performances dans la dernière version de Total War Shogun 2. - La part des benchs en qualité extrême est ici plus importante compte tenu de l'orientation ultra haut de gamme de ce dossier et la GeForce GTX 680 faibli quelque peu dans ces conditions. Page 18 - Performances GPU Boost et overclocking Performances GPU Boost et overclockingNous avons voulu observer les gains apportés en pratique par GPU Boost que nous nous sommes arrangés pour neutraliser. Nous avons par ailleurs pu overclocker la GeForce GTX 690 en augmentant la fréquence de ses GPU de 156 MHz (elle varie donc entre 1071 MHz et 1227 MHz) et de ses mémoires de 300 MHz, soit 1800 MHz (7.2 Gbps). La limite de consommation était alors poussée à son maximum, +35% soit 358W. Ces résultats ont été obtenus en 2560x1600 avec un niveau de qualité extrême:  Maintenez la souris sur le graphe pour afficher les résultats en fps. GPU Boost permet à la GeForce GTX 690 de gagner un peu plus de 5% en performances ce qui reste modeste par rapport à la marge de fréquence de 17% de notre exemplaire. Cela s'explique en partie par le fait que la contrainte du TDP est relativement importante, ce qui empêche les GPU d'atteindre leur fréquence maximale dans tous les jeux. Il faut également dire qu'en très haute résolution avec un niveau de qualité extrême, notamment au niveau de l'antialiasing, la bande passante mémoire joue un rôle important, elle est le point faible du GK104. La bonne nouvelle c'est que la GeForce GTX 690, comme la GeForce GTX 680, accepte un gros overclocking de sa mémoire : + 20%. Associé à une augmentation de 14% de la fréquence GPU et à une augmentation de la limite de consommation de 35%, nous obtenons un gain moyen dans les jeux de 19%. Pas mal pour une carte de ce calibre ! Page 19 - Conclusion ConclusionAvec la GeForce GTX 690, Nvidia nous propose une vitrine technologique qui fera rêver les passionnés même si elle ne résistera pas au jugement de la raison. Comme souvent dans le segment ultra haut de gamme, et encore plus dans le cas présent, un tel modèle est sans grande utilité pour le commun des mortels qui n'a ni besoin d'une telle puissance graphique, ni d'une telle finition pour un produit qui sera enfermé dans un boîtier PC et encore moins l'envie de débourser l'équivalent d'un système complet, 1000€, pour une carte graphique. Et pourtant il est difficile de rester indifférent face à la prestation excellente offerte par cette GeForce GTX 690 qui propose des performances très proches de celles d'une paire de GeForce GTX 680 en SLI, avec des nuisances réduites tant sur le plan du bruit que de l'encombrement. Pour renforcer le côté exclusif et justifier la tarification démesurée, Nvidia a travaillé le design avec un niveau de détail jamais atteint jusqu'ici. Une finition luxueuse qui ravira les amateurs de belles choses et qu'on aimerait retrouver plus souvent sur le haut de gamme.  Si une petite dose de rationalité vous est nécessaire avant de craquer pour cette GeForce GTX 690, dîtes vous qu'un couple de GeForce GTX 680 offre une prestation similaire pour un prix identique mais sans la petite touche exclusive. Il faudra par contre disposer d'un boîtier bien ventilé et soit d'un écran en 2560x1600/1440 soit d'un système surround pour profiter pleinement de sa puissance graphique. Si au contraire vous cherchez un moyen d'éviter de succomber à la tentation et de vous fâcher définitivement avec votre banquier, dîtes-vous que 2 Go par GPU ce n'est pas assez pour un tel monstre et que Nvidia aurait dû pousser l'extrême jusqu'au bout en passant à 4 Go. Et puis de toute manière un jour ou l'autre un plus gros GPU pointera le bout de son nez et sera probablement un choix plus raisonnable. Quid de la concurrence ? La Radeon HD 7990 d'AMD pourra-t-elle rivaliser avec cette GeForce GTX 690 ? Sur le plan des performances probablement. Sur le plan du rapport performances/prix, sans aucun doute. Par contre sur le plan de l'impression véhiculée par un objet aussi bien fini, c'est très peu probable. Le règne du plastique n'est malheureusement pas prêt de s'achever ! Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |