| |

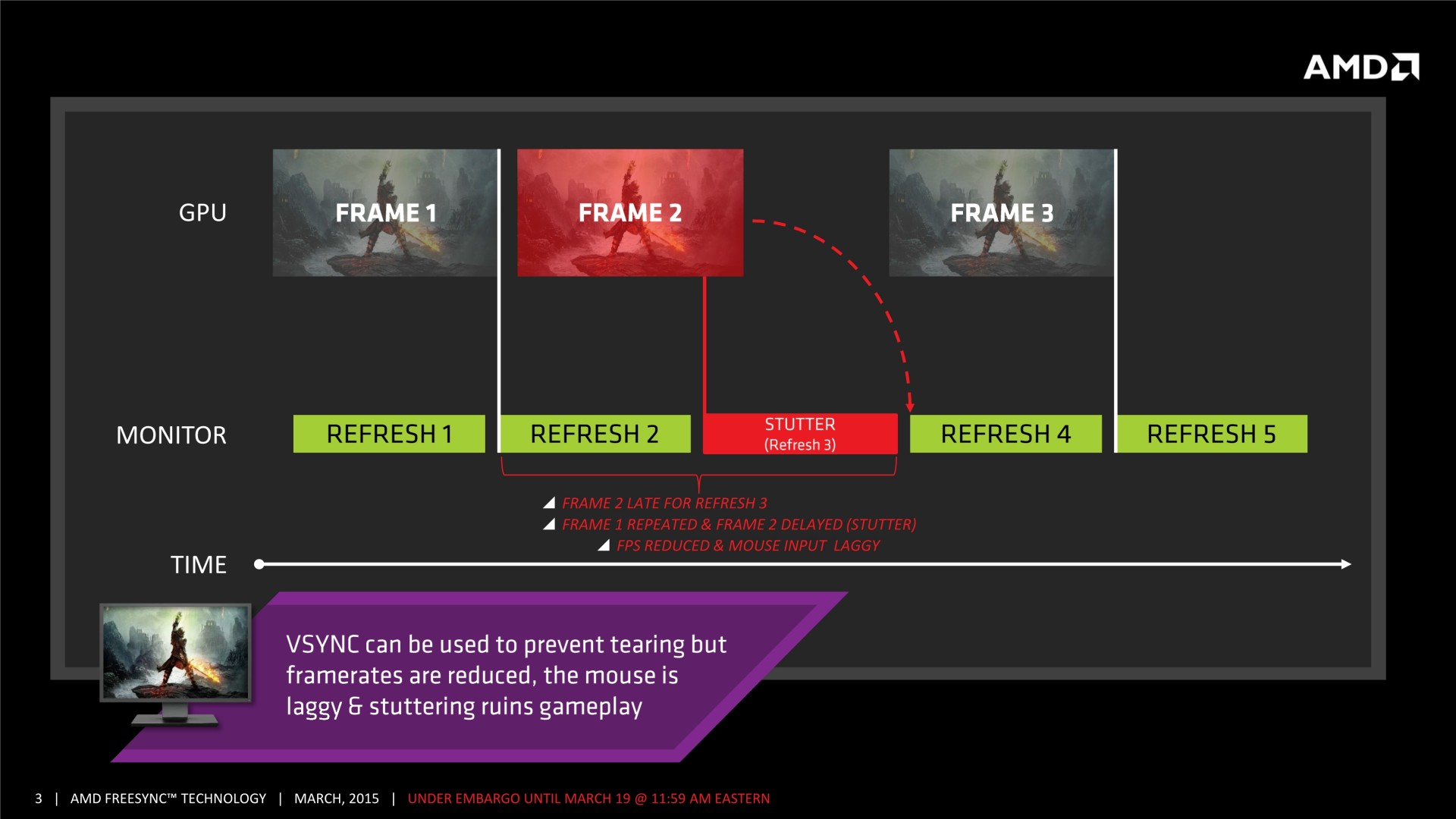

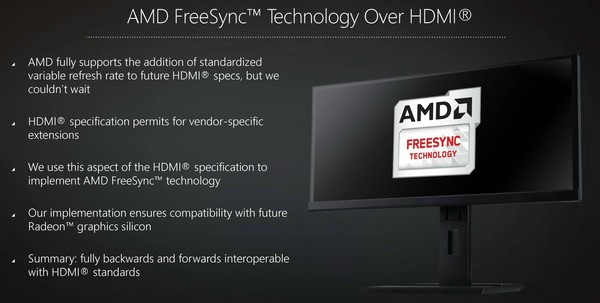

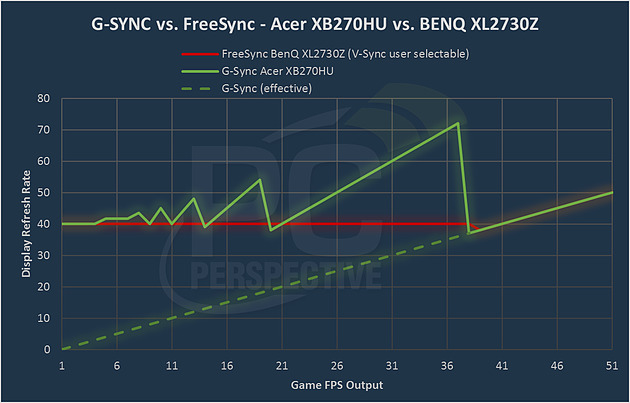

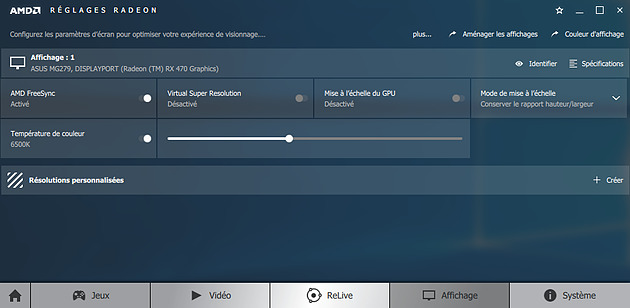

| AMD FreeSync : Efficace et pas chère, la FRV qu'on préfère ? Cartes Graphiques Publié le Mercredi 21 Décembre 2016 par Damien Triolet URL: /focus/120/.html Vous vous en souvenez probablement, notre première expérience avec FreeSync avait été pour le moins décevante. Rappelons que derrière ce nom se cache la réponse d'AMD au G-Sync de Nvidia, soit la prise en charge d'une fréquence de rafraîchissement variable au niveau de l'écran. De quoi permettre d'améliorer le ressenti du joueur en terme de fluidité. Où en est FreeSync aujourd'hui ? A condition de bien choisir son écran, il fonctionne très bien et permet une économie substantielle par rapport à G-Sync !  Après une annonce tonitruante en janvier 2014, l'arrivée dans le commerce des premiers écrans compatibles FreeSync avait dû attendre mars 2015. Et malheureusement ils étaient loin d'être convaincants. Sur le papier, les avantages de cette technique de gestion de l'affichage étaient pourtant multiples, à commencer par le fait qu'elle repose sur un standard ouvert et moins onéreux que le G-Sync de Nvidia. Mais des dalles d'entrée de gamme et une fluidité qui n'était pas toujours bien maîtrisée avaient alors fait retomber notre enthousiasme. Adaptive-Sync, FreeSync et G-SyncSous ces trois terminologies ou marques, se cache la prise en charge d'une fréquence de rafraîchissement variable (FRV). Avec une fréquence de rafraîchissement fixe classique, par exemple de 60 Hz, le confort visuel lorsqu'un jeu vidéo est affiché est souvent imparfait. Chaque image étant différente, il est logique que leur temps de calcul diffère également ce qui pose des problèmes de synchronisation. Une fréquence de rafraîchissement plus élevée, par exemple de 144 Hz, permet de limiter l'impact de ces problèmes mais pas de les supprimer. La carte graphique peut rater un cycle d'affichage, perdre du temps en attendant le suivant ou encore ne pas s'en soucier et causer des cassures dans les images affichées (tearing). En partant de ce constat, le principe de la FRV est simple : si le confort de jeu est impacté par le fait que la carte graphique doive essayer de se plier en deux pour se synchroniser par rapport à l'écran, pourquoi ne pas faire en sorte que ce soit l'écran qui se synchronise par rapport à elle ? Le concept semble évident mais son implémentation a demandé un effort particulier au niveau des écrans puisqu'il revient alors à ceux-ci d'afficher chaque image pendant une durée aussi précise que variable.  [ Avec FRV, l'image 1 reste jusqu'à ce que l'image 2 soit prête, la fluidité est préservée ] G-Sync : le premier ?Le principe de la FRV pour améliorer la fluidité des jeux vidéo a été rendu public et exploité en premier lieu par Nvidia avec G-Sync, mais il est difficile de savoir qui en est réellement à l'origine. D'un côté Nvidia indique avoir travaillé sur le sujet pendant plusieurs années et d'un autre côté il est apparu par après que le consortium VESA travaillait à peu près en même temps sur une approche similaire, mais standardisée pour le DisplayPort. C'est l'Adaptive-Sync. Un standard poussé par AMD qui le met en avant à travers sa marque FreeSync qui représente son exploitation par l'ensemble composé de ses cartes graphiques et de ses pilotes.  Le timing exact de ces développements est difficile à connaître, AMD et Nvidia faisant en sorte d'en dire le moins possible tout en défendant farouchement leur contribution. Il est évidemment possible qu'AMD ait poussé le consortium VESA à mettre au point un standard après avoir pris connaissance du projet G-Sync. Il est également possible qu'à partir de discussions initiales entre les membres VESA, Nvidia ait vu une opportunité de prendre tout le monde de court en passant par une implémentation propriétaire conçue pour réduire le temps de développement au niveau des fabricants d'écrans.  Quoi qu'il en soit, c'est bien G-Sync et Nvidia qui ont permis à la FRV de devenir réalité dès 2013 et qui ont à minima poussé AMD à accélérer la cadence de son côté. En rétrospective il est également évident que la coûteuse solution propriétaire de Nvidia a permis d'avancer beaucoup plus vite. Après une première démonstration de FreeSync, en janvier 2014, il aura fallu attendre mars 2015 pour que les premiers écrans débarquent… et décembre 2015 pour que FreeSync fonctionne enfin correctement avec de meilleurs écrans et des pilotes améliorés. Au final Nvidia et une partie des joueurs auront gagné 2 ans.  A noter que si FreeSync exploite le standard Adaptive-Sync à travers le DisplayPort, AMD en propose également une implémentation propriétaire pour la connectique HDMI. Elle fonctionne de manière similaire à l'Adaptive-Sync mais ne fait pas partie du standard HDMI pour l'instant. Une approche qui permet d'allonger la liste d'écrans compatibles FreeSync. FreeSync et G-Sync, quelles différences ?Si le fonctionnement de ces deux techniques d'affichage est similaire, leur implémentation diffère, nous en avons déjà parlé dans leurs tests initiaux respectifs. Rappelons simplement que dans le cas de G-Sync (desktop), Nvidia fait en sorte de contrôler l'écran en plus de la carte graphique et a pour cela développé un module spécifique à intégrer dans les moniteurs. Ce module G-Sync repose sur un processeur programmable de type FPGA associé à un buffer, ce qui implique un coût matériel important. FreeSync repose pour sa part sur Adaptive-Sync qui est un standard pris en charge par la plupart des scalers récents. Il s'agit de petits contrôleurs bons marchés car fabriqués en volume.  Nvidia explique que G-Sync (desktop) fonctionne de manière explicite, c'est-à-dire que la carte graphique communique avec l'écran (polling) pour s'assurer que celui-ci est bien prêt à recevoir chaque image. De son côté FreeSync et Adaptive-Sync fonctionnent de manière implicite. L'écran communique dès le départ la plage de fréquences de rafraîchissement qu'il est capable de prendre en charge. La carte graphique et les pilotes en déduisent comment gérer l'affichage. Cette différence subtile, d'apparence peu importante a pourtant un impact important sur la manière dont AMD et Nvidia assurent la fluidité à faibles fps. Si nos premières impressions sur FreeSync étaient mitigées, il y avait deux raisons principales. Tout d'abord le phénomène de ghosting était extrêmement mal pris en charge sur le premier écran testé. Ensuite, la fluidité souffrait grandement dès que le niveau de fps passait sous la limite basse de la plage de fréquences de rafraîchissement de l'écran. Ce point était particulièrement gênant puisque sur bon nombre de premiers écrans FreeSync, et encore aujourd'hui sur de nombreux modèles disponibles, la limite basse n'était pas si basse que cela. 40 Hz voire 48 Hz est courant. Or quand on vise un niveau de performances moyen proche de 60 fps, il arrive souvent de passer brièvement sous 48 ou 40 fps. C'est alors raté niveau fluidité. Les écrans G-Sync fonctionnent en général avec une limite basse de 30 Hz, ce qui demande des dalles de qualité élevée qui peuvent être validées pour ne pas poser de problème de respect des couleurs ou encore de scintillement à une faible fréquence de rafraîchissement. Rien n'empêche un écran FreeSync d'utiliser de meilleures dalles bien entendu, mais cela a un coût. Et dans tous les cas, même sous ces 30 Hz, les écrans G-Sync évitent les saccades.  Comme l'ont mis en évidence nos confrères de PCPerspective à l'aide d'un oscilloscope, Nvidia s'est directement attaqué au problème en ayant recours à une technique qui là aussi semble évidente. Si l'écran est limité à 30 Hz, que faire quand les performances passent à 29 fps ? Il suffit de passer à 58 Hz et de l'afficher deux fois. A 14 fps ? Il suffit de passer à 42 Hz et de l'afficher trois fois. Et ainsi de suite. Cette approche permet de simuler un écran avec une limite basse de 1 Hz (même si en pratique Nvidia ne va pas jusque là), et donc de maintenir la fluidité aussi longtemps que les performances elles-mêmes le permettent. C'est le module G-Sync qui se charge de garder la dernière image dans un buffer et de l'afficher autant de fois que nécessaire, avec une certaine marge de sécurité. Par exemple si les performances tournent autour de 29-30 fps, le module est calibré par Nvidia pour que l'écran reste à 58-60 Hz en doublant toutes les images plutôt que d'osciller entre 30 et 58 Hz. Bien que nous n'ayons pas pu le vérifier en pratique, nous supposons que les variations extrêmes peuvent entrainer des artéfacts tels qu'un scintillement. Quoi qu'il en soit, cet aspect du contrôle de l'écran par le module G-Sync est probablement la raison pour laquelle la carte graphique doit lui demander s'il est prêt à recevoir une nouvelle image. Cette communication a un impact sur les performances et la latence mais il est négligeable. LFC, trois lettres cruciales pour accompagner FreeSyncAu départ, FreeSync n'appliquait la FRV uniquement quand les performances se situaient à l'intérieur de la plage supportée par l'écran. Sous celle-ci, suivant le choix du joueur, nous retombions sur une fréquence fixe avec soit du V-Sync ON et de très grosses saccades, soit du V-Sync OFF, de plus petites saccades et du tearing. Avec un côté désagréable amplifié par la sortie brutale d'une fluidité optimale. Il aura fallu du temps à AMD pour s'attaquer à ce problème pourtant fondamental. Les pilotes Crimson Edition sortis il y a tout juste un an ont introduit une nouvelle fonctionnalité dénommée LFC pour Low Framerate Compensation. Comme son nom le laisse penser, elle va s'attaquer à la fluidité à faible niveau de performances, soit sous la limite basse de la plage de FRV. Contrairement à G-Sync, c'est l'ensemble carte graphique et pilotes qui vont décider à un moment donné de doubler, tripler ou quadrupler les images pour simuler une plage de FRV plus étendue. L'algorithme LFC tel qu'introduit au départ par AMD s'activait en principe automatiquement dès que le ratio entre les limites basse et haute de la FRV était au moins de 2.5x (sans modification du firmware de l'écran). Un ratio prévu de manière à avoir suffisamment de marge de sécurité pour éviter les trop gros écarts de fréquence de rafraichissement ou encore pour avoir le temps d'activer et de désactiver le mode LFC. De notre côté, ce mode LFC n'était au départ pas toujours fonctionnel dans tous les jeux et la situation s'est débloquée avec de nouveaux pilotes 2-3 mois après son introduction, bien qu'AMD nous ait indiqué ne pas avoir corrigé de bug spécifique à FreeSync. Mais il n'est pas impossible qu'une correction d'autre bug lié à l'affichage ait indirectement résolu le problème. C'est donc à partir de mars 2016, et grâce au mode LFC totalement fonctionnel que nous avons enfin obtenu des résultats à la hauteur de nos attentes avec FreeSync. A noter que si AMD parle toujours d'un ratio d'au moins 2.5x pour l'activation automatique du mode LFC, certains écrans récents le supportent avec un ratio de 2.14x voire même de 2.08x. Nous ne savons pas si les pilotes ont réduit leur marge de sécurité ou si ces écrans sont passés par une phase de validation supplémentaire suite à laquelle ils reportent aux pilotes qu'ils peuvent utiliser le mode LFC malgré le ratio de moins de 2.5x. Bien entendu avec un ratio inférieur à 2x, il est impossible d'exploiter cette technique du doublement des images et il en va de même pour G-Sync bien qu'à notre connaissance Nvidia impose une plage d'au moins 30-60 Hz. FreeSync, ça fonctionneA plusieurs reprises après notre article initial peu encourageant sur base de l'Acer XG270HU et de son première firmware, nous avons voulu revenir sur FreeSync. Pour cela nous nous sommes tournés vers un Asus MG279Q ainsi que vers une version commerciale du BenQ XL2730Z équipée du firmware corrigé par rapport à l'initial. Si le ghosting de l'écran Acer n'était pas présent, plusieurs problèmes persistaient jusqu'à l'arrivée du mode LFC et pour tout un tas de raison, notre article à leur sujet a malheureusement sans cesse été repoussé. Mieux vaut tard que jamais, après la sortie des Crimson ReLive Edition et avant de nous attarder plus en détail sur l'offre d'entrée et milieu de gamme d'AMD et de Nvidia, nous nous sommes repenchés sur le sujet. Si depuis mars la fluidité était au niveau attendu, quelques petits problèmes subsistaient, principalement parce qu'AMD n'avait pas encore implémenté le support de FreeSync en modes fenêtré et plein écran borderless, contrairement à Nvidia qui avait ajouté ce support il y a quelques temps. C'est désormais fonctionnel avec les derniers pilotes et nous n'avons plus rencontré de cas à problème. Tous les jeux testés sont parfaitement fluides, autant avec G-Sync qu'avec FreeSync, et il est difficile de quitter un de ces écrans pour un bon vieux modèle 60 Hz classique.  Le BenQ XL2730Z est un écran TN qui exploite une plage de FRV de 40 à 144 Hz en 1440p. A 550€, ce n'est pas un écran bon marché et la technologie TN n'est pas pour tout le monde, mais avec la LFC et un système de réduction du ghosting efficace, il propose d'excellents résultats pour les joueurs.  L'Asus MG279Q est lui aussi un écran 1440p 144 Hz, mais cette fois de type IPS. Un peu plus cher, comptez 630€, il est par contre évidemment plus polyvalent qu'un écran TN. S'il s'agit bien d'un écran 144 Hz, il est par contre limité à une plage de 35 à 90 Hz quand FreeSync est actif, ce qui permet de profiter du mode LFC et d'obtenir de bons résultats au niveau de la fluidité. Reste bien entendu qu'il serait préférable de profiter également de la réactivité et des performances jusqu'à 144 Hz. Nous ne savons pas précisément d'où vient cette limitation de la plage, du contrôleur ou de la dalle. Mais il est possible de la modifier ! Comme expliqué ci-dessus, FreeSync fonctionne de manière implicite en se basant sur les informations EDID reportées par l'écran. Il suffit de tromper le système en remplaçant celles-ci par d'autres valeurs et la carte graphique les appliquera en présumant qu'elles correspondent à l'écran. Un petit outil tel que CRU (Custom Resolution Utility) permet de modifier la plage FreeSync. Bien entendu tout n'est pas fonctionnel et mieux vaut se renseigner sur les forums spécialisés avant de tenter des modifications hasardeuses sur votre écran. Dans le cas du MG279Q, nous avons pu passer la plage de 35-90 Hz à 60-144 Hz sans rencontrer de soucis et en profitant toujours de la LFC sous 60 fps.  Dans les pilotes Radeon, une option de la page Affichage permet d'activer FreeSync s'il ne l'a pas été par défaut. FreeSync doit également être activé dans l'OSD de certains écrans. Mais attention, tout ceci ne garantit pas que FreeSync est bel et bien fonctionnel. Le vérifier avec l'outil de démonstration d'AMD ne le permet pas non plus, celui-ci passant outre de l'option configurée dans les pilotes. Le seul moyen simple de s'assurer avec certitude de son bon fonctionnement est d'observer la variation en temps réel de la fréquence de rafraîchissement, ce que certains écrans permettent de faire à travers leur OSD. FreeSync et son prix : un avantage pour les Radeon ? Oui !FreeSync fonctionne aussi bien que G-Sync, comme nous avons pu le constater, et permet de produire des écrans meilleurs marché en se basant sur des contrôleurs fabriqués en large volume. De quoi induire un avantage tarifaire indirect pour les Radeon ? Certainement, mais il convient de le tempérer quelque peu. Malheureusement, après une très longue attente, et pour convaincre les fabricants partenaires, AMD a probablement revu ses exigences à la baisse pour qu'un écran puisse obtenir le label FreeSync. Grossièrement, au bout d'un certain temps il a probablement été décidé que n'importe quel écran qui supporterait l'Adaptive-Sync ferait l'affaire. Cette absence d'exigences minimales suffisantes fait qu'il se trouve aujourd'hui sur le marché de nombreux écrans FreeSync qui ne sont pas réellement adaptés au maintien de la fluidité dans le cadre du jeu vidéo. De nombreux modèles, notamment chez Samsung, se contentent par exemple d'une plage de 48 à 72 Hz et ne supportent pas le mode LFC. Une vaste blague qui nuit à la marque FreeSync, mais qu'il n'est pas simple de rectifier d'autant plus que les fabricants d'écrans ne semblent pas vraiment enclins à mettre en avant le support du mode LFC, ou plutôt son absence. Or selon nous, seuls les écrans FreeSync avec support du mode LFC ont réellement de l'intérêt et sont à conseiller pour les joueurs. Si un écran FreeSync à 125€ peut sembler alléchant (LG 22MP68VQ-P), sa plage de FRV de 56 à 75 Hz sans LFC n'autorisera pas une expérience réellement meilleure que celle d'un écran non-FreeSync. Supporter FreeSync de manière à réellement garantir la fluidité demande d'exploiter une dalle de qualité, qui va directement coûter plus cher. Par exemple, chez iiyama, un 24" 1080p avec FRV de 55-75 Hz sans LFC coûte 165€ (G-MASTER GE2488HS-B2 Black Hawk) alors qu'il faut compter 300€ pour un modèle similaire en 35-120 Hz avec LFC (G-MASTER GB2488HSU-B2 Red Eagle). Des références proches, un écart tarifaire énorme et un seul écran qui permet de vraiment profiter de FreeSync. Difficile pour le consommateur de s'y retrouver, d'autant plus que les plages de FRV ne sont pas toujours clairement affichées alors que le support du mode LFC ne l'est presque jamais. AMD a mis en place sur sa page FreeSync une liste des écrans qui précise pour chacun d'entre eux la plage de FRV ainsi que le support ou non du mode LFC et ce pour les connectiques DP et HDMI qui peuvent différer (dans certains cas investir dans un câble DP changera totalement le comportement de l'écran au niveau de la fluidité!). Cette liste n'est cependant pas parfaitement à jour et il serait bien qu'AMD soit plus réactif à ce niveau, d'autant plus quand Samsung semble démultiplier les déclinaisons à l'infini. Vous l'aurez compris, il faut éviter les écrans FreeSync premiers prix. Du coup, un écran FreeSync avec LFC reste-t-il moins cher qu'un écran G-Sync ? Oui ! Et pas qu'un peu, avec un avantage qui tourne autour de 150 à 200€ suivant nos observations, même s'il peut y avoir d'autres éléments qui justifient la différence de prix :

Pour les écrans 4K c'est un petit peu plus compliqué par contre et aucun écran FreeSync actuel ne supporte le mode LFC et ne propose de plage très étendue. A l'exception de l'Acer BX320HK (35-60 Hz) qui coûte pas moins de 1000€, les écrans FreeSync 4K se contentent en général d'une plage trop étroite de 40-60 Hz. Les quelques écrans 4K G-Sync ont donc un avantage avec une plage de 30-60 Hz.  Si vous ne disposez pas encore d'écran G-Sync / FreeSync et devez en changer ou pensez le faire d'ici peu, cet écart tarifaire est bien entendu à prendre en compte et pourra être décisif, particulièrement dans le milieu de gamme et dans certains cas dans l'entrée de gamme. Un ensemble Radeon RX 480 8 Go + écran FreeSync permettra de gagner 200€ par rapport à un ensemble similaire composé d'une GeForce GTX 1060 6 Go et d'un écran G-Sync ! A budget identique il faudra faire l'impasse sur cette amélioration de la fluidité ou opter pour une carte graphique nettement moins véloce avec l'option Nvidia. Du coup on peut se demander pourquoi Nvidia n'a pas encore décidé de supporter l'Adaptive-Sync en plus de son module propriétaire. Car de toute évidence, au vu du fonctionnement de G-Sync sur portable, ses GPU en sont capables, même si le résultat serait peut-être un peu moins bon. Pourquoi laisser un tel avantage à AMD ? Nous supposons que cela découle d'une stratégie commerciale réfléchie et liée à la domination par Nvidia du marché des cartes graphiques "gamers". Avec G-Sync, Nvidia ne cherche pas à se démarquer de la concurrence pour reprendre des parts de marché, mais à pousser son offre haut de gamme un peu plus loin. Le but est d'offrir un confort de jeu amélioré aux joueurs qui sont prêts à mettre le prix pour avoir ce qui se fait de mieux, et au passage d'inciter leur fidélisation une fois qu'ils auront fait l'acquisition d'un écran G-Sync. Il aurait été contreproductif dans la position de Nvidia de pousser le marché vers des écrans G-Sync meilleurs marchés qui ne représentent pas de revenu supplémentaire alors qu'ils auraient pu inciter certains joueurs à se contenter de cartes graphiques moins véloces ou à retarder la mise à jour de leur carte graphique. C'est évidemment tout le contraire pour AMD qui cherche à convaincre les joueurs de lui (re)faire confiance. Si la stratégie de Nvidia est en fin de compte logique, nous ne pouvons évidemment que la regretter puisqu'elle a conduit à une division du marché des écrans destinés aux joueurs. Un revirement est évidemment possible à tout moment mais il ne devrait pas avoir lieu tant que l'avantage de FreeSync ne se traduira pas de manière suffisante au niveau des ventes de cartes graphiques. A noter qu'en dehors du cadre de G-Sync et FreeSync, les écrans 144 Hz permettent déjà d'améliorer la fluidité même quand les performances tournent autour de 60 fps puisqu'ils réduisent l'éventuel décalage au niveau de la synchronisation. Ce n'est pas aussi bien que de la FRV bien entendu, mais à défaut c'est préférable à un écran 60 Hz. Depuis quelques temps, tous les écrans 144 Hz sont soit compatibles G-Sync, soit FreeSync. Il serait peu opportun d'associer un onéreux écran G-Sync 144 Hz à une Radeon, mais par contre associer un écran FreeSync 144 Hz à une GeForce peut être un compromis intéressant. Sans se ruiner, cela laisse également la porte ouverte à une fluidité optimale lors d'une éventuelle future mise à jour vers une Radeon. D'où l'intérêt qu'a AMD de s'assurer qu'un maximum d'écrans disponibles supportent FreeSync, même si tous les systèmes ne les exploitent pas pleinement dans l'immédiat. Enfin, nous nous attendons lors du CES de janvier à quelques petites annonces au niveau des évolutions de FreeSync et de G-Sync, mais elles devraient se concentrer sur l'aspect qualitatif et donc être plutôt orientées haut de gamme. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |