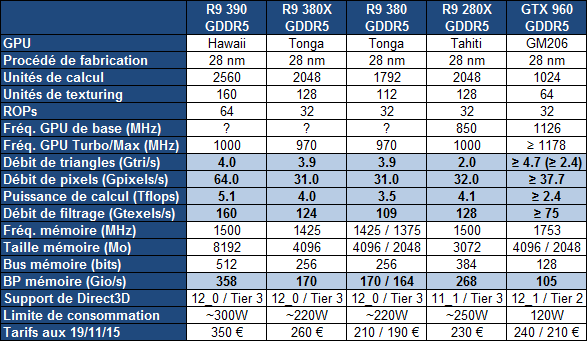

| |

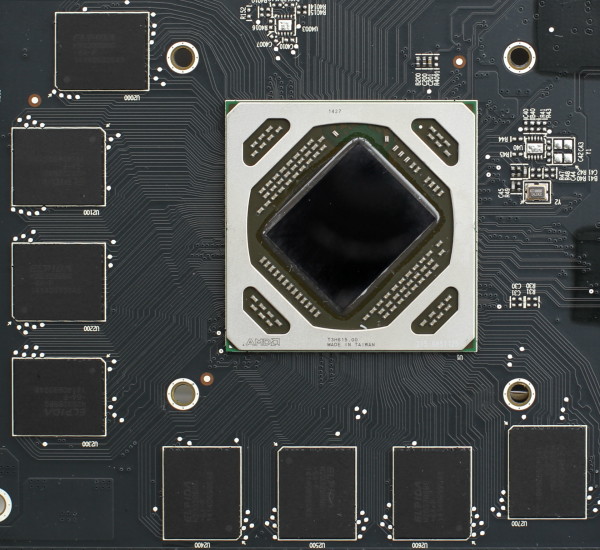

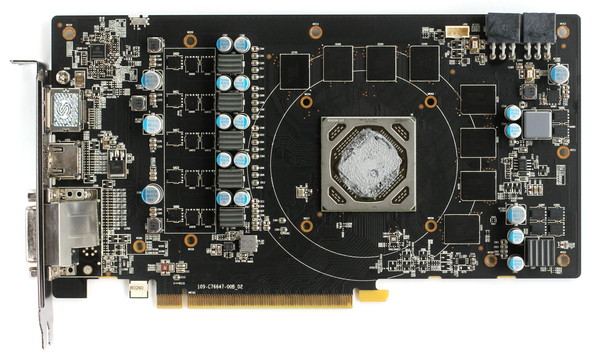

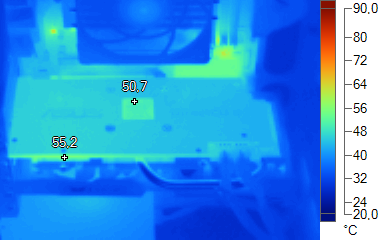

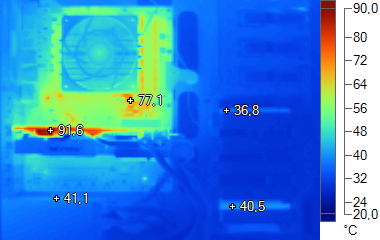

| AMD Radeon R9 380X : les cartes Asus Strix et Sapphire Nitro en test Cartes Graphiques Publié le Lundi 30 Novembre 2015 par Damien Triolet URL: /articles/945-1/amd-radeon-r9-380x-cartes-asus-strix-sapphire-nitro-test.html Page 1 - Introduction, spécifications Pour renforcer son offre face aux GeForce GTX 900, AMD introduit une nouvelle carte graphique milieu de gamme : la Radeon R9 380X basée sur le GPU Tonga. Lancé en septembre 2014, ce GPU Tonga aura tardé à être proposé en version plus musclée mais il monte enfin en puissance à travers cette nouvelle Radeon R9 380X. Trop timidement ? C'est ce que nous allons vérifier en nous penchant sur les variantes Strix d'Asus et Nitro de Sapphire.  Radeon HD 7970 v4Pour rappel, le GPU Tonga est en quelque sorte une version remise au goût du jour du GPU Tahiti, le premier de la famille GCN qui avait été inauguré avec la Radeon HD 7970, mise à jour en Radeon HD 7970 GHz Edition avant d'être renommée en Radeon R9 280X. Dans un sens, cette Radeon R9 380X peut ainsi être vue comme la 4ème révision de la Radeon HD 7970. Tonga embarque ainsi 2048 unités de calcul, comme Tahiti, mais supporte toutes les dernières petites évolutions de l'architecture qui apportent de petits gains de performances ainsi que de nouvelles fonctionnalités (FreeSync, TrueAudio, CrossFire XDMA, D3D 12_0…). Au départ, avec la Radeon R9 285, AMD s'est cependant contenté de configurer Tonga avec 1792 unités de calcul actives et par la suite, la R9 380 a repris cette même configuration. La Radeon R9 380X passe enfin à la vitesse supérieure avec l'ensemble des 2048 unités de calcul actives. Par contre, comme les dérivés précédents, elle se contente d'un bus mémoire de 256-bit, là où Tahiti profite d'un bus 384-bit. AMD n'étant pas très clair sur ce point, nous ne savons pas s'il s'agit du maximum supporté par Tonga ou d'un choix de configuration de la puce.  Au niveau des spécifications, la R9 380X est identique à la R9 380, si ce n'est pour le nombre d'unités de calcul et de texturing en hausse de 14%. De quoi laisser penser que leurs performances seront très proches alors que l'écart tarifaire est loin d'être négligeable sur ce segment. Par rapport à la Radeon R9 280X, la R9 380X affiche une puissance de calcul et de texturing similaire, mais profite d'une puissance géométrique doublée et se contente de 63% de la bande passante mémoire. De quoi nous laisser penser que là aussi les performances seront très proches.  Aucune carte de référence ne devrait se retrouver sur le marché, il s'agit à priori uniquement de modèles personnalisés par les partenaires d'AMD et qui reprennent dans bien des cas le même design que pour les Radeon R9 380. Page 2 - Tonga : 5 milliards de transistors, bus 384-bit? GPU Tonga : 5 milliards de transistorsTonga est l'avant dernier GPU de la famille GCN et en dehors du support de la mémoire HBM, il partage avec le GPU Fiji (Radeon R9 Fury) toutes les dernières évolutions en date de l'architecture d'AMD, mais avec un nombre d'unités de calcul qui reste au niveau du premier GPU GCN, Tahiti (HD 7970).  Le GPU Tonga accompagné de sa mémoire GDDR5. Alors que Tahiti est annoncé avec 4.3 milliards de transistors, qui occupent une surface de 352 mm², Tonga passe à 5.0 milliards de transistors pour 368 mm², selon nos mesures. Vous noterez au passage que la densité de transistors progresse quelque peu, ce qui est en partie lié à l'utilisation de contrôleurs mémoires plus denses. Si Tonga est bien fabriqué en 28 nm, tout porte à croire qu'il en exploite, tout comme Fiji, une variante particulière. Synapse Design, qui fournit différents services autour de la conception de puces, et qui compte AMD parmi ses clients, a dévoilé dans une présentation que l'un de ses clients avait développé 2 GPU en 28 nm HPM, l'un de plus de 350 mm² et l'autre de plus de 500 mm², ce qui correspond de toute évidence à Tonga et Fiji. Le 28nm HPM est la variante la plus avancée du 28 nm de TSMC et, sur le papier tout du moins, elle peut offrir un meilleur compromis que le 28 nm HP (utilisé par les autres GPU GCN ainsi que par les GPU Nvidia) au niveau du rendement énergétique tout en maintenant un haut niveau de performances (fréquence). La prestation de Tonga, que ce soit en terme de rendement énergétique ou de fréquence, ne montre cependant aucun avantage et au contraire ces deux points semblent légèrement en retrait en pratique. Un bus mémoire 384-bit ?Si tous les dérivés actuellement commercialisés du GPU Tonga se contentent d'un bus mémoire de 256-bit,un doute subsiste quant à la possibilité que la puce embarque en fait une interface mémoire de 384-bit, comme le GPU Tahiti. AMD n'a jamais répondu clairement aux questions concernant ce point important, nous indiquant un coup que la configuration de Tonga est identique à celle de Tahiti, un autre que les dérivés de Tonga ont été configuré suivant la demande supposée du marché. De quoi nous laisser penser qu'AMD a peut-être sacrifié un tiers de la bande passante mémoire pour proposer des variantes 4 Go 256-bit avec un coût moindre que ne l'auraient été des variantes 3 Go 384-bit. Rien ne nous permet cependant de confirmer cette théorie et il est possible que Tonga n'intègre réellement qu'un bus de 256-bit ou qu'une autre raison ait poussé AMD à limiter la largeur de ce bus. La théorie énergétique liée à des résultats moins bons que prévus avec le 28nm HPM ne serait alors pas délirante puisque Tonga en 256-bit est au moins aussi gourmand que Tahiti en 384-bit. Par rapport à nos précédentes interrogations concernant Tonga, à savoir le nombre d'unités de calcul et la quantité de cache L2 présents, AMD a cette fois confirmé qu'il s'agit bien de 32 CU (2048 unités FP32) et de 512 Ko pour les cartes 256-bit. Voici un résumé des caractéristiques de tous les GPU de la famille GCN : Oland : GCN 1.0, 6 CU, 1 triangle par cycle, 8 ROP, L2 256 Ko, 128 bits Cape Verde : GCN 1.0, 10 CU, 1 triangle par cycle, 16 ROP, L2 512 Ko, 128 bits Bonaire : GCN 1.1, 14 CU, 2 triangles par cycle, 16 ROP, L2 512 Ko, 128 bits Pitcairn : GCN 1.0, 20 CU, 2 triangles par cycle, 32 ROP, L2 512 Ko, 256 bits Tahiti : GCN 1.0, 32 CU, 2 triangles par cycle, 32 ROP, L2 768 Ko, 384 bits Tonga : GCN 1.2, 32 CU, 4 triangles par cycle, 32 ROP, L2 512 Ko (768 Ko?), 256 bits (384 bits?) Hawaii : GCN 1.1, 44 CU, 4 triangles par cycle, 64 ROP, L2 1024 Ko, 512 bits Fiji : GCN 1.2, 64 CU, 4 triangles par cycle, 64 ROP, L2 2048 Ko, 4096 bits HBM Et en image pour Tonga et Tahiti (dans le cas de Tonga nous avons représenté la possibilité qu'il intègre physiquement un bus 384-bit et 768 Ko de L2) :  [ Tonga ] [ Tahiti ] Par rapport à Tahiti, Tonga voit certes son bus mémoire amputé, mais AMD a mis en place des mécanismes pour en réduire l'impact (compression) et a doublé le nombre de processeurs géométriques chargés de la prise en charge des primitives, de leur découpe en pixels et de la tessellation. AMD a également modifié le front-end du GPU dans le cadre du calcul haute performance. Alors que Tahiti se contente de 2 ACE (Asynchronous Compute Engine) pour assister le processeur de commande principal au niveau des tâches de type compute, Tonga passe à 4 ACE. Ces processeurs de commandes multitâches se chargent de la sélection/préemption des tâches à travers leurs files d'attente, de la distribution des tâches vers les unités de calcul et de l'exécution des commandes de synchronisation. Ils sont eux-mêmes assistés par 2 HWS (Hardware Scheduler) chargés de soulager le CPU dans la gestion de l'ordonnancement des files d'attentes et des tâches. A noter que l'intégration d'ACE dans les GPU AMD leur permet de supporter le traitement concomitant de tâches graphiques et compute, ce qui autorise des gains de performances dans certaines situations sous Direct3D 12. L'architecture Maxwell de Nvidia souffre de certaines limitations à ce niveau comme nous l'avions expliqué ici. Tonga : GCN 1.2Officiellement, AMD ne différencie pas les différentes itérations de son architecture GCN. Il y a du GCN, du GCN un peu vieux et du GCN un peu nouveau. Pas très pratique pour s'y retrouver… Même s'il ne s'agit pas d'une forme sous laquelle communique AMD, nous préférons de notre côté parler de GCN 1.0 pour les premiers GPU de la famille, de GCN 1.1 pour Hawaii et Bonaire et de GCN 1.2 pour Tonga et Fiji.  AMD donne très peu de détails sur les nouveautés liées à GCN 1.2. Il est tout d'abord question d'une amélioration des performances en tessellation, un argument qui semble devenu obligatoire dans toutes les présentations de GPU. De notre côté nous n'avons pas remarqué d'évolution marquante. Ces optimisations ont probablement été mises en place pour limiter l'engorgement du GPU dans des cas spécifiques. Ensuite, pour faire face à la réduction de la bande passante mémoire, AMD a mis en place de nouveaux algorithmes de compression sans perte du framebuffer. Plus spécifiquement, il s'agit de codage différentiel pour les couleurs, également appelé compression delta. Nvidia exploite également cette technique sur ses GPU Maxwell 2. Le principe de base consiste à ne pas enregistrer directement la couleur mais sa différence par rapport à une autre. Ce n'est bien entendu utile que quand l'écart entre deux couleurs est suffisamment faible, de manière à ce que cette information représente moins de bits que la couleur en elle-même. Ce support a dû être intégré au niveau des ROP et peut-être au niveau des unités de texturing, de manière à ce qu'elles soient capables de lires ces nouveaux formats de données. A noter que comme Nvidia avec les GPU Maxwell, AMD a fait l'impasse sur la compression des textures ASTC pour ses GPU GCN 1.2. Nvidia nous avait expliqué que le coût de cette technologie était encore trop élevé au niveau des unités de texturing et n'avait pas de sens dans le cadre de gros GPU. Avec GCN 1.2, AMD a mis à jour le jeu d'instruction du GPU. Il est question de nouvelles instructions 16-bit, autant en entier qu'en flottants. Une précision moindre qui permet potentiellement des gains d'énergie, suivant son implémentation. La précision 16-bit est avant tout exploitée dans le monde mobile mais elle pourrait également permettre de rendre plus efficaces certains algorithmes de traitement vidéo. D'autres instructions ont été ajoutées, dédiées aux échanges de données entre threads, pour réduire les accès à la mémoire partagée, ce que Nvidia fait également sur ses derniers GPU. De notre côté, en observant le code compilé, nous avons pu remarquer que le support de quelques instructions semble avoir été supprimé (les fmac sont par exemple remplacés par des fmad), probablement parce qu'elles ne sont plus très utiles. Le code compilé est dans bien des cas constitué de légèrement moins d'instructions, ce qui peut potentiellement le rendre plus performant sur Tonga. Comme toutes les puces GCN "1.1 et 1.2", Fiji support le niveau de fonctionnalité matérielle 12_0 de Direct3D, mais fait l'impasse sur le niveau 12_1 supporté par les GPU Nvidia Maxwell de seconde génération. Par contre, au niveau de l'autre niveau de spécification important de Direct3D12, les "Binding Resources" (le nombre de ressources à dispositions des développeurs), Fiji est au niveau maximum, Tier 3, là où les GPU Nvidia sont limités au niveau Tier 2. Autant AMD que Nvidia ont ainsi l'opportunité de proposer aux développeurs des effets graphiques qui seraient incompatibles avec le matériel de l'autre. Pas de HDMI 2.0 ni de décodage H.265Lors de la sortie de Tonga, AMD avait annoncé avoir revu toute la partie vidéo. Tout d'abord avec un scaler de meilleure qualité, ensuite avec des mises à jour de ses moteurs d'encodage et de décodage.   Petite différence par rapport à Fiji, AMD n'a pas eu le temps d'intégrer le support du décodage H.265 (HEVC) à Tonga. Enfin, tout comme Fiji cette fois, Tonga ne supporte pas le HDMI 2.0, une connectique nécessaire pour jouer confortablement sur une TV 4K en 60 Hz, peu de modèles intégrant une entrée DisplayPort. Cette absence n'est cependant pas un gros problème pour les dérivés de Tonga dont la puissance n'est pas réellement adaptée au jeu en 4K. La plupart des vidéos 4K pourront être affichées en 30 ou 24 Hz, mais certaines vidéos en 60 ou 48 Hz et/ou en HDR pourraient poser problème. Face à la concurrence dont les derniers produits supportent tous cette connectique, il ne s'agit malheureusement pas d'une absence anecdotique. Page 3 - Asus Radeon R9 380X Strix OC Asus Radeon R9 380X Strix  Asus propose 2 Radeon R9 380X dans la famille Strix, l'une en version classique et l'autre en version OC. La première est cadencée aux fréquences de référence alors que la seconde profite d'un petit overclocking d'usine avec une fréquence GPU qui passe de 970 à 1030 MHz (+6%) alors que la mémoire reste aux 1425 MHz de référence. Nous avons testé ce modèle OC qui est annoncé par Asus à 300€. A noter que la R9 380X Strix est très proche de la R9 380 Strix. Le ventirad est identique et seul le PCB diffère quelque peu par rapport aux premières R9 380 Strix commercialisées puisqu'il est probable qu'il s'agisse ici d'une nouvelle révision commune.  Cette Radeon R9 380X d'Asus est équipée d'une variante du ventirad Strix relativement imposante par rapport à la taille du PCB. Si celui-ci se contente de 22.5cm de long, la carte graphique dans son ensemble monte ainsi à 27cm. Par ailleurs, le PCB est légèrement plus haut que la normale et la coque ainsi qu'un caloduc le surmonte de 2cm. Comme à son habitude, pour assurer le refroidissement, Asus a opté pour des caloducs à contact direct, en nombre réduit mais en versions relativement musclées : 1x 10mm et 2x 8mm. Une configuration et un positionnement qui sont ici idéaux par rapport à la taille et à l'orientation du GPU Tonga, un point important à signaler puisqu'il arrive régulièrement à Asus de proposer une configuration mal adaptée au GPU à refroidir. Ces caloducs rejoignent différentes zones du large radiateur en aluminium qui parcourt à peu près toute la longueur de la carte. Le ventirad n'étant en contact qu'avec le GPU, Asus a placé un petit radiateur sur les composants sensibles de l'étage d'alimentation. Les puces GDDR5 ne disposent pas de dissipateur mais ce n'est pas un problème puisqu'elles sont dans le passage du flux d'air. Asus a ajouté à sa carte une backplate dont le rôle est presque purement esthétique. Presque car si elle ne contribue pas au refroidissement (au contraire puisqu'elle enferme le PCB), elle fait office de support au radiateur qui dépasse du PCB. De quoi assurer la rigidité de l'ensemble. A noter qu'il est impossible de démonter cette plaque sans retirer le ventirad puisqu'elle est fixée depuis la face avant. Le refroidissement est assuré par 2 ventilateurs de 95mm qui restent à l'arrêt tant que le GPU ne dépasse pas 60 °C. Ce ventirad se comporte plutôt bien comme nous allons le voir, autant au repos qu'en charge lourde.  Le PCB est alimenté par deux connecteurs d'alimentation 6 broches et il est dommage qu'Asus n'ait pas opté pour un seul connecteur 8 broches, comme c'est le cas sur les R9 380 Strix, ce qui permet un montage plus propre pour une intensité maximale identique. Pour l'alimentation des divers composants, 6 phases sont dédiées au GPU et une de plus à la mémoire GDDR5 Elpida. Nous n'avons pas constaté de coil whine sur l'échantillon testé. Au niveau de la connectique, ce PCB propose deux sorties DVI Dual Link, une sortie DisplayPort 1.2a et une sortie HDMI 1.4a. Une des deux sorties DVI supporte un adaptateur VGA, non fourni par Asus. Nous avons pu pousser notre échantillon de 1030 MHz à 1100 MHz pour le GPU, un overclocking relativement modeste de 6.8%. Du côté de la mémoire c'est un petit peu plus compliqué car, comme nous l'avons vu sur certaines autres Radeon, c'est la tension GPU qui limite sa capacité à supporter une fréquence élevée pour la mémoire. Ainsi, si l'overclocking est appliqué alors qu'une charge 3D est déjà lancée, ce qui implique une tension GPU élevée, la mémoire est stable à 1700 MHz, mais en pratique ce n'est pas exploitable et les plantages seront nombreux au repos, en quittant les jeux ou pendant les périodes de chargement. En pratique nous avons ainsi dû nous contenter de 1550 MHz sur notre échantillon, soit un gain de 8.8%. Page 4 - Sapphire Radeon R9 380X Nitro Sapphire Radeon R9 380X Nitro  Sapphire propose pour l'instant une seule Radeon R9 380X, un modèle Nitro. Il profite d'un overclocking d'usine avec une fréquence GPU qui passe de 970 à 1040 MHz (+7%) alors que la mémoire passe de 1425 MHz à 1500 MHz (+5%). Cette référence est proposée par Sapphire à 270€ et son design est en tout point identique à celui de la R9 380 Nitro.  Le design retenu par Sapphire pour la R9 380X Nitro est relativement compact avec un PCB de 22.5cm dont la coque ne dépasse que de 8mm. Le PCB et la coque sont par contre 1.5cm plus hauts que la normale. Le design est relativement sobre et la carte est donne une sensation de robustesse lors de la manipulation grâce à une coque solidement fixée à la backplate. Pour assurer le refroidissement, Sapphire a opté pour 4 petits caloducs de 6mm de diamètre qui sont pris en sandwichs entre une base en cuivre et le radiateur en aluminium. Les ailettes de celui-ci sont positionnées horizontalement avec relativement peu de zones d'échappement en dehors des extrémités de la carte ce qui signifie qu'une partie de l'air chaud sera redirigé vers les baies à disques durs. Plusieurs plaques d'aluminium sont intégrées à ce bloc principal qui fait donc également office de dissipateur pour les composants sensibles de l'étage d'alimentation et pour les puces GDDR5. Sapphire a eu la bonne idée d'usiner la backplate de manière à ce qu'elle fasse également office de dissipateur pour l'étage d'alimentation. Le refroidissement est assuré par 2 ventilateurs de 100mm qui restent à l'arrêt tant que le GPU ne dépasse pas 51 °C. Une très mauvaise idée de la part de Sapphire puisqu'il s'agit généralement de la température au repos d'un GPU moderne refroidit passivement. Et malheureusement nos craintes de voir les ventilateurs passer leur temps à démarrer et à s'arrêter se sont confirmées lors des tests.  Le PCB est alimenté par deux connecteurs d'alimentation 6 broches et il est dommage que Sapphire n'ait pas opté pour un seul connecteur 8 broches, ce qui permet un montage plus propre pour une intensité maximale identique. Pour l'alimentation des divers composants, 5 phases sont dédiées au GPU, qui peut profiter d'une limite de consommation relevée à +/- 170W par rapport aux 150W des spécifications de référence, ce qui correspond à une consommation maximale de la carte d'environ 250W au lieu de 220W. Une phase de plus est dédiée à la mémoire GDDR5 Elpida et nous n'avons pas constaté de coil whine sur l'échantillon testé. Au niveau de la connectique, ce PCB propose deux sorties DVI Dual Link, une sortie DisplayPort 1.2a et une sortie HDMI 1.4a. Une des deux sorties DVI supporte un adaptateur VGA, fourni par Sapphire. Nous avons pu pousser notre échantillon que de 1040 MHz à 1075 MHz pour le GPU, un overclocking anecdotique de 3.3%. Du côté de la mémoire c'est un petit peu plus compliqué car, comme nous l'avons vu sur certaines autres Radeon, c'est la tension GPU qui limite sa capacité à supporter une fréquence élevée pour la mémoire. Ainsi, si l'overclocking est appliqué alors qu'une charge 3D est déjà lancée, ce qui implique une tension GPU élevée, la mémoire est stable à 1750 MHz, mais en pratique ce n'est pas exploitable et les plantages seront nombreux au repos, en quittant les jeux ou pendant les périodes de chargement. En pratique nous avons ainsi dû nous contenter de 1600 MHz sur notre échantillon, soit un gain de 6.6%. Page 5 - Protocole de test Protocole de testPour ce test, nous avons décidé de migrer notre système vers Windows 10 en version Threshold 2. Nous avons par ailleurs intégré Fallout 4 et Star Wars Battlefront alors que Splinter Cell Blacklist a été mis de côté. Nous avons envisagé de remplacer Batman Arkham Origins par Batman Arkham Knight mais celui-ci, même mis à jour, souffre de tellement de plantages qu'il nous a été impossible de jouer suffisamment pour sélectionner une scène de test. A notre niveau seul le benchmark intégré semble réellement fonctionnel, or nous utilisons exclusivement des scènes de gameplay. Tous les derniers patchs au 18/11/2015 ont été installés, la plupart des jeux étant maintenus à jour via Steam/Origin/Uplay. A noter qu'EA semble avoir décidé qu'un changement de carte graphique équivaut désormais à un système différent qui tente d'utiliser le même compte Origin, ce qui complique malheureusement nos tests puisque le maximum autorisé par tranche de 24h est vite dépassé. Nous ne savons pas si cela est lié à un changement de politique ou à un bug introduit avec une mise à jour récente d'Origin ou à un bug lié au passage à Windows 10. Nous avons opté pour la résolution de 1080p avec un niveau de détail maximal ou très élevé. Nous avons évité d'activer l'antialiasing de type SSAA, que nous jugeons beaucoup trop gourmand par rapport à ce qu'il apporte. Pour rappel, nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Nous avons utilisé les Catalyst 15.11.1 beta pour les Radeon et les GeForce sont quant à elles testées avec les pilotes 359.00 WHQL. Nous avons forcé l'activation du PCI Express 3.0 sur la plateforme X79 pour les GeForce. A noter que les Catalyst Crimson Edition apportent des petits gains de performances aux Radeon dans certains mais n'ont été fournis par AMD qu'après la fin de nos tests. Le gain moyen n'étant que de 1%, nous n'avons pas jugé bon de recommencer toutes nos mesures. Toutes les cartes ont été testées telles quelles avec une température ambiante contrôlée à 26 °C et, pour chaque jeux, nous avons pris le temps nécessaire pour que la fréquence GPU se stabilise. Les Radeon R9 380X d'Asus et de Sapphire étaient capables de maintenir leur fréquence maximale dans tous les jeux testés. En plus des performances aux fréquences de référence et compte tenu de l'écart relativement faible, nous nous sommes contentés de tester les performances sur la carte de Sapphire, la plus overclockées des deux. L'Asus se situe à peu près au milieu.  Configuration de testIntel Core i7 3960X (HT off, Turbo 1/2/3/4/6 cores: 4 GHz) Asus P9X79 WS 8 Go DDR3 2133 Corsair Windows 10 64 bits Pilotes GeForce 359.00 WHQL Catalyst 15.11.1 beta Page 6 - Consommation et efficacité énergétique ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 10 sur un écran connecté via DisplayPort en 1440p 120 Hz. Pour la charge, nous testons d'une part Anno 2070 en mode de qualité maximale qui représente un jeu très lourd et d'autre part Battlefield 4 en mode Ultra qui représente un jeu moins lourd. D'après nos observations, le passage de Windows 7 à Windows 10 n'a pas d'impact sur la consommation. Pour rappel, dans le camp des Radeon, c'est le moteur Powertune qui se charge de réguler la fréquence GPU pour maintenir la carte graphique dans les clous au niveau des températures et de la consommation. En pratique, c'est cette dernière qui peut être le facteur limitant bien que dans les jeux, même les plus lourds, les cartes testées n'ont pas atteint leur limite. Celle-ci est fixée à 150W au niveau du GPU, ce qui correspond à peu près à 220W au niveau de la carte dans son ensemble. De son côté, pour qualifier la consommation, AMD communique sur un chiffre magique de 190W sans expliquer comment il est obtenu. Si cette valeur correspond aux spécifications de référence, les fabricants restent libres de la modifier. La consommation maximale de la carte de Sapphire monte ainsi à 250W soit à peu près 170W au niveau de l'ASIC. La consommation au repos, sur le bureau Windows 10, est similaire pour les Radeon et les GeForce. Les premières ont par contre l'avantage en veille écran grâce au mode ZeroCore Power qui permet d'éteindre presque complètement le GPU. En charge une Radeon R9 380X OC consomme nettement plus qu'une GeForce GTX 960 et même plus qu'une GeForce GTX 970 OC, pourtant bien plus performante. Bien que ces données soient approximatives, compte tenu de la variation entre échantillons d'un même modèle, nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles, de quoi donner une idée globale sur le rendement énergétique de toutes ces cartes : [ Battlefield 4 ] [ Anno 2070 ] Comme nous l'avions déjà vu auparavant, Tonga ne change pas la donne sur le plan énergétique et l'architecture Maxwell de Nvidia domine largement. Vous pourrez remarquer que le bus de 384-bit permet à Tahiti et à la R9 280X d'afficher un meilleur rendement énergétique dans les jeux qui ont un besoin important de bande passante mémoire, comme c'est le cas dans Battlefield 4. Page 7 - Bruit, température GPU et thermographie Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge sous le test1 de 3DMark11. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe à moins de 20 dBA, ce qui est la limite de sensibilité pour laquelle il est certifié et calibré. En charge, le système de refroidissement d'Asus est le plus efficace même s'il faut garder en tête que la carte de Sapphire consomme 10 à 15W de plus. Alors que nous avons l'impression que le ventirad Strix de plusieurs cartes testées précédemment était quelque peu faiblard (par exemple sur la GTX 960 Strix), Asus a opté ici pour une variante qui semble bien adaptée. Les deux Radeon R9 380X stoppent complètement leurs ventilateurs au repos, une approche initialement poussée sur le marché par Nvidia avec les GTX 900 et qui permet de rendre les cartes graphiques totalement inaudibles. Tout du moins si la calibration a été effectuée correctement. C'est le cas pour la carte d'Asus mais pas pour celle de Sapphire. Sur de nombreuses cartes graphiques, nous avons pu observer que la température d'un GPU au repos, qui consomme à peu près 15W, se situe généralement autour de 50 °C quand il est refroidi passivement. C'est la raison pour laquelle la température de démarrage des ventilateurs est souvent fixée à +/- 60 °C par les fabricants. C'est ce que fait Asus. Par contre Sapphire a opté pour une température charnière de 50 °C. Dès que le GPU reste quelque dizaines de secondes à 51 °C les ventilateurs démarrent. Dès qu'ils retombent quelques dizaines de secondes à 50 °C, ils s'arrêtent. Le problème de la carte Nitro est que sans refroidissement sa température GPU dépasserait 51 °C alors qu'elle tomberait sous 50°C avec une vitesse minimale. Vous l'aurez compris, les ventilateurs passent leur temps à s'arrêter et à redémarrer, autant dans notre système de test fermé que sur une table de bench. Les ventilateurs exploités par Sapphire sur cette R9 380X Nitro sont capables de fonctionner à très faibles vitesse : +/- 250 RPM. A ce point de départ de la courbe de ventilation ils sont totalement inaudibles en pratique même si notre sonomètre a relevé 20.1 dBA au lieu de 19.8 dBA. Du coup pas de problème ? Malheureusement si car pour démarrer les ventilateurs ont besoin d'une tension plus élevée, un coup de boost qui les fait tourner très brièvement très vite. C'est ainsi leur démarrage qui s'entend et qui pourra rapidement agacer. Sapphire a à sa disposition deux possibilités pour corriger le tir : passer la vitesse de démarrage à 60 °C ou tout simplement laisser tourner les ventilateurs à faible vitesse. C'est à se demander si les ingénieurs qui paramètrent ces cartes les testent réellement… Nous avons remonté directement le souci à Sapphire mais n'avons pas eu de retour à ce jour. Bonne nouvelle, nous n'avons pas noté de coil whine sur les deux cartes testées. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne : La carte d'Asus est un petit peu mieux refroidie en charge que celle de Sapphire. A noter que la température de celle-ci au repos profite du fait que ses ventilateurs fonctionnent par intermittence. Thermographie infrarougeVoici les photos thermiques obtenues pour les Radeon R9 380X d'Asus et de Sapphire avec à chaque fois 45 minutes de mise en situation :  [ Sapphire R9 380X Nitro - Repos ] [ Charge ] Pour les deux cartes les plaques arrières masquent la chauffe réelle du PCB et de ses composants. Nous pouvons par contre observer clairement que la plaque arrière sur la carte de Sapphire diffuse effectivement une partie de la chaleur de l'étage d'alimentation, contrairement à celle d'Asus qui n'a qu'un rôle esthétique. Nous avons cherché à observer la température des composants de l'étage d'alimentation sous un autre angle ainsi qu'à l'aide d'une sonde glissée sous la plaque arrière et dans les deux cas nous avons observé 85 °C sur la carte de Sapphire et 100 °C sur celle d'Asus. Un niveau élevé mais qui n'est pas problématique pour ce type de composants. Il faudra cependant éviter de pousser la limite de consommation Powertune à son maximum dans le cadre de l'overclocking si vous comptez faire souffrir la bête sous Furmark. Voici ensuite ce que cela donne au niveau de l'ensemble du système :  [ Asus R9 380X Strix ] [ Sapphire R9 380X Nitro ] La carte de Sapphire renvoie plus d'air chaud vers les baies à disques durs que celle d'Asus, principalement dans la partie supérieure. La sonde interne du disque dur qui s'y situe dans notre système de test reporte d'ailleurs 44°C avec la Sapphire et 37 °C avec l'Asus (43 °C vs 41 °C pour la sonde du disque du bas). Page 8 - Benchmark : 3DMark Fire Strike 3DMark Fire Strike  Nous lançons le test Fire Strike avec les presets standard et extrême proposés par Futuremark. A noter que nous avons dû lancer le test en mode ligne de commande pour les Radeon R7 370 et R9 280X. Un bug dans les pilotes récents d'AMD limite étrangement ces 2 références (et probablement toutes les cartes à base de Tahiti et de Pitcairn) à leur fréquence GPU de base lorsque l'interface de 3DMark est lancée. [ Fire Strike ] [ Fire Strike Extreme ] La Radeon R9 380X aux fréquences de référence devance légèrement la R9 280X dans ce test qui dépend très peu de la bande passante mémoire. La GeForce GTX 960 est en retrait. Page 9 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons le mode de qualité maximale du jeu et effectuons un déplacement sur une carte en mesurant les performances avec Fraps. Dans Anno 2070, du côté des Radeon c'est avant tout la fréquence GPU qui compte, et probablement leur nombre de ROP plus que la puissance de calcul. Les R9 380X et 280X ont ainsi des performances similaires. Page 10 - Benchmark : Batman Arkham Origins Batman Arkham Origins  Avant-dernier opus de la série, son successeur est disponible mais trop instable pour servir de test, Batman Arkham Origins est basé sur l'Unreal Engine 3 en poussant un petit peu plus loin les effets graphiques dont certains ont été implémentés sur PC en collaboration avec Nvidia. C'est le cas du TXAA et d'effets GPU PhysX réservés aux GeForce (il n'est plus possible d'activer une version CPU de tous ces effets), mais également de l'occlusion ambiante de type HBAO+, d'un effet de Depth of Field plus évolué (NVDOF), d'ombres adoucies (PCSS) et de la tessellation (pour la cape et la neige) qui sont utilisables sur tous les GPU DirectX 11. Nous utilisons le mode de qualité maximale du jeu avec du MSAA 4x. Nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Steam. Dans Batman AO avec MSAA, la bande passante mémoire a un effet important sur les performances et la R9 280X en profite pour rester devant les R9 380X et R9 380 qui devancent malgré tout les GTX 960. Vous noterez le gap important par rapport aux cartes du segment supérieur. Page 11 - Benchmark : Battlefield 4 Battlefield 4  Battlefield 4 repose sur le moteur Frostbite 3, une évolution de la version 2 présente dans Battlefield 3. La base du rendu reste très proche (rendu différé, calcul de l'éclairage via compute shaders) et les évolutions visibles sont mineures, DICE ayant principalement optimisé son moteur pour les consoles de nouvelle génération. Parmi les petites nouveautés, citons un support plus avancé de la tessellation et une amélioration du module "destruction" du moteur. Sur PC, un mode Mantle spécifique aux Radeon et qui permet de réduire le coût CPU du rendu est proposé mais nous ne l'avons pas utilisé pour ce test. Pour rappel, il s'agit d'une API propriétaire de plus bas niveau dédiée aux Radeon HD 7000 et supérieures, qui a été développée par AMD et DICE. Depuis l'arrivée d'autres API de bas niveau, AMD a cependant cessé les développements autour de Mantle et n'a pas optimisé son utilisation dans les pilotes pour ses derniers GPU. Nous testons le mode Ultra avec MSAA 4x et nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin. Les GeForce sont plus efficaces que les Radeon sous le Frosbite Engine avec MSAA. De quoi permettre aux GTX 960 de lutter avec les R9 380X. Page 12 - Benchmark : Crysis 3 Crysis 3  Crysis 3 reprend le même moteur que Crysis 2 : le CryEngine 3. Ce dernier profite cependant de quelques petites évolutions telles qu'un support plus avancé de l'antialiasing : FXAA, MSAA et TXAA sont au programme, tout comme un nouveau mode appelé SMAA. Ce dernier est une évolution du MLAA qui permet, optionnellement, de prendre en compte des données de type sous-pixels soit à travers la combinaison avec du MSAA 2x, soit avec une composante temporelle calculée à partir de l'image précédente. Le SMAA 1x est la simple évolution du MLAA, le SMAA 2tx utilise une composante temporelle relativement complexe et le SMAA 4x y ajoute le MSAA 2x. Notez qu'il ne faut pas confondre le SMAA 2tx proposé en mono-GPU avec le SMAA 2x proposé en multi-GPU, ce dernier utilisant du MSAA 2x sans composante temporelle. Nous mesurons les performances avec Fraps et le jeu est maintenu à jour via Origin. Crysis 3 est un jeu très gourmand au niveau de la puissance de calcul mais qui a aussi besoin de pas mal de bande passante, ce qui fait que la R9 280X parvient à rester devant les R9 380X dont les performances sont ici similaires à celles des GTX 960. Page 13 - Benchmark : Dying Light Dying Light  Dying Light est un jeu de type survival horror animé par le Chrome Engine 6 de Techland et dans lequel le monde est plutôt vaste et ouvert. Nvidia a travaillé avec Techland pour y inclure certains effets issus de ses librairies Gameworks tels que le HBAO+ et le Depth of Field. Nous avons mesuré les performances avec Fraps sur un parcours bien défini. Le jeu est maintenu à jour à travers Steam. Dying Light souffrait de micro-saccades régulières qui impactaient fortement la fluidité sous Windows 7, mais elles ont disparu lors du passage à Windows 10. Les GTX 960 font ici à peu près jeu égal avec les R9 380 et 380X. Page 14 - Benchmark : Evolve Evolve  Evolve, développé par Turtle Rock Studios, est basé sur le Cry Engine 3. Contrairement à ce dernier, les modes d'antialiasing à base de MSAA, extrêmement gourmands avec ce moteur, ne sont pas proposés. Un nouveau mode de SMAA a par contre été développé par Crytek et intégré dans les branches plus récentes de son moteur : le 1tx. Il s'agit d'une version quelque peu simplifiée du SMAA 2tx, antialiasing à base de composante temporelle, qui a la particularité d'être compatible avec le multi-GPU. Nous mesurons les performances à l'aide de Fraps sur un parcours bien défini et le jeu est maintenu à jour avec Steam. Les Radeon apprécient particulièrement ce titre et les GTX 960 sont nettement derrière les R9 380X. Celles-ci se détachent enfin significativement de la R9 380, signe que la puissance de calcul brute fait ici la différence. Page 15 - Benchmark : Fallout 4 Fallout 4  Fallout 4 repose sur une version améliorée du Creation Engine introduit avec Skyrim et développé en interne par Bethesda. Un moteur qui permet de pousser la qualité graphique vers le haut par rapport au Gamebryo exploité pour les jeux de la génération précédente dont faisait partie Fallout 3. Dans la version qui équipe Fallout 4, l'éclairage gagne en réalisme notamment avec le passage au physically-based deferred renderer et l'ajout d'une composante volumétrique pour représenter l'atmosphère. La version la plus évoluée de cet effet a été développée en collaboration avec Nvidia et fait appel à la tessellation. Au niveau de l'antialiasing les options proposées sont par contre assez pauvres avec au mieux un Temporal AA qui fonctionne plutôt bien mais uniquement en mouvement constant. A l'arrêt ce type d'antialiasing est évidemment limité dans son action. Nous testons Fallout 4 avec Fraps sur un parcours bien défini en poussant toutes les options au maximum (y compris l'éclairage volumétrique ultra). Le jeu est maintenu à jour via Steam. Les R9 380X n'ont ici aucun mal à devancer les GTX 960, et ne sont donc pas désavantagées par les effets implémentés en collaboration avec Nvidia. La R9 280X est ici en retrait, probablement parce que l'effort d'optimisation d'AMD se concentre dorénavant sur les GPU plus récents. Page 16 - Benchmark : Far Cry 4 Far Cry 4  Dernier opus de la série, il est basé sur une petite évolution du Dunia Engine 2 qui avait été introduit avec Far Cry 3. Ses caractéristiques sont donc similaires et parmi les petites évolutions nous notons l'ajout par les développeurs du support de l'antialiasing SMAA 1x en plus du MSAA qui est très, voire trop, gourmand avec ce moteur. Nous activons le niveau de qualité Ultra du jeu avec du SMAA 1x. Nous utilisons Fraps sur un parcours bien défini. Les Radeon R9 380X devancent ici assez facilement les GeForce GTX 960. Page 17 - Benchmark : GRID 2 GRID 2  Développé par Codemaster, GRID 2 reprend une évolution légère du moteur DirectX 11 maison exploité par DiRT Showdown. Pour rappel, en partenariat avec AMD, les développeurs avaient mis en place un éclairage avancé qui prend en compte de nombreuses sources de lumières directes et indirectes ainsi qu'une approximation du rendu de type illumination globale. Ces techniques sont toujours exploitées, même si le partenaire principal de Codemaster est cette fois Intel qui a aidé à la mise en place d'optimisations spécifiques aux GPU intégrés à Haswell. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum, y compris l'adoucissement de l'effet d'occlusion ambiante, et activons le MSAA 8x. Nous utilisons Fraps sur l'environnement de Barcelone, le plus lourd dans le jeu. MSAA 8X oblige, la bande passante mémoire et les ROP gagnent ici quelque peu en influence par rapport à la puissance de calcul. Ce qui permet aux R9 280X et R9 380X OC de gagner quelques points sur la R9 380X de base qui peine à se détacher de la R9 380. Page 18 - Benchmark : Hitman Absolution Hitman Absolution  Hitman Absolution utilise un moteur plutôt lourd et qui manque probablement d'optimisations. La charge CPU est par ailleurs relativement élevée dans certaines scènes dans lesquelles une foule importante peut être animée. Différents effets DirectX 11 ont été intégrés avec la coopération d'AMD. Pour mesurer les performances, nous poussons les options graphiques au niveau ultra et utilisons fraps dans le jeu. Hitman Absolution fait également appel au MSAA, ici en mode 4x, ce qui donne un avantage à la R9 280X alors que les GTX 900 sont en retrait. Page 19 - Benchmark : Project Cars Project Cars  Project Cars est un jeu de course automobile développé depuis 2011 sur base d'un système de beta participative qui permettait d'accéder aux nouvelles builds régulières et d'interagir avec les développeurs de Slightlymad Studios (à l'origine des Need For Speed Shift). Son moteur au rendu différé supporte DirectX 11 et c'est ce mode que nous avons testé en poussant toutes les options en mode High à l'exception de l'antialiasing pour lequel nous nous somme contenté du seul SMAA Ultra. Nous avons testé le jeu via Fraps sur un parcours bien défini et avec de la pluie au niveau des conditions météo. Un détail important à préciser puisqu'il réduit significativement les performances. Nous avons opté pour 7 concurrents qui restent devant nous pendant la mesure des performances. Les Radeon ont beaucoup de mal dans ce jeu très attendu et ce n'est pas nouveau. Critiqué pour avoir favorisé Nvidia, le développeur s'est justifié en expliquant que ce n'était pas du tout le cas, mais qu'AMD n'avait pas voulu collaborer en amont de la sortie du jeu pour s'assurer d'optimiser les performances. Difficile de savoir ce qu'il s'est réellement passé, mais depuis AMD a commencé à introduire des optimisations spécifiques dans ses pilotes pour tenter de réduire quelque peu une forte limitation CPU Les Radeon sont très nettement derrière les GeForce et sont limitées par le CPU à +/- 51 fps. Page 20 - Benchmark : Star Wars Battlefront Star Wars Battlefront  Développé par EA DICE, Star Wars Battlefront exploite comme vous vous en doutez le moteur maison Frostbite 3 qui a été introduit avec Battlefield 4. Il s'en distingue cependant par quelques petites améliorations graphiques au niveau de la tessellation pour ajouter des détails aux terrains et de l'éclairage qui gagne en réalisme et profite d'un effet d'occultation ambiante à base de compute shaders plus évolués. Star Wars Battlefront fait par contre totalement l'impasse sur le support du MSAA et se contente du FXAA ou du TAA, qui, une fois encore, se comporte plutôt bien mais uniquement lorsque les mouvements sont suffisants. Nous testons le jeu avec Fraps sur un parcours bien défini et il est maintenu à jour via Origin. Les Radeon ont ici l'avantage, le jeu ne faisant pas appel au MSAA qui les fait souffrir plus que les GeForce avec ce moteur graphique. Page 21 - Benchmark : The Witcher 3 Wild Hunt The Witcher 3 : Wild Hunt  Très attendu, le dernier opus de The Witcher ne déçoit pas. Développé par CD Projekt RED, il repose sur le REDengine 3, un moteur conçu pour gérer de vastes mondes ouverts, raison pour laquelle il tourne exclusivement en 64-bit. CD Projekt RED s'est associé à Nvidia pour intégrer deux effets gaphique de la suite Gameworks : le HBAO+ et surtout HairWorks. Réponse au TressFX d'AMD, HairWorks améliore la chevelure des personnages, la crinière des chevaux et la fourrure de plusieurs animaux ou créatures rencontrés dans le jeu en faisant appel à un niveau de tessellation très élevé pour chaque brindille. HairWorks est donc très gourmand et Nvidia aurait fait en sorte que son implémentation complique le travail d'optimisation d'AMD, ce qui n'a pas manqué de créer la polémique, même si en pratique désactiver cet effet ne dénature pas vraiment le jeu. Nous avons d'ailleurs décidé de le tester sans HairWorks compte tenu du niveau de performances des cartes testées. Tous les autres paramètres sont poussés au niveau élevé. Nous effectuons un parcours bien défini avec Fraps. Sans HairWorks, les R9 380X devancent les GTX 960 d'un peu plus de 10%. Page 22 - Benchmark : Tomb Raider Tomb Raider  Tomb Raider a été l'une des meilleures surprises de 2013. Le rendu graphique est plutôt réussi, AMD ayant collaboré avec les développeurs pour s'assurer d'une version PC de bon niveau. C'est particulièrement le cas pour TressFX, l'option de rendu avancé des cheveux de Lara qui apporte une bonne dose de réalisme. Nous avons testé Tomb Raider en mode de qualité Ultime+ qui inclut l'effet TressFX et le niveau de qualité maximal pour les ombres. Nous avons mesuré les performances avec Fraps, sans utiliser le bench intégré qui correspond plus aux cinématiques qu'aux scènes de jeu classiques. Les Radeon R9 380X prennent ici assez facilement l'avantage sur les GTX 960. Page 23 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 à la Radeon R9 380 : [ Indice sans Project Cars ] [ Indice complet ] Au final, en moyenne, la Radeon R9 380X 4 Go n'affiche qu'un maigre gain de 4.4% sur la Radeon R9 380 2 Go et reste derrière la Radeon R9 280X 3 Go. Les résultats sont variables suivant les jeux, mais globalement l'écart est souvent très faible entre ces 2 références. La R9 380X Nitro de Sapphire profite de son overclocking pour faire grimper les performances de 6% et rattraper la R9 280X. Par rapport à la concurrence, la R9 380X devance la GTX 960 de référence de 15%, un écart qui reste similaire entre les R9 380X de Sapphire et la GTX 960 de MSI. L'écart par rapport aux cartes de la gamme supérieure est très important : une R9 390 est 40% plus véloce qu'une R9 380X et une GTX 970 est 55% plus performante qu'une GTX 960 ! Page 24 - Tonga vs Tahiti : round 2 Tonga vs Tahiti : round 2Tout comme lors du lancement de la Radeon R9 285 et de Tonga en version castrée, nous avons voulu observer de plus près les gains apportés par les petites améliorations de Tonga par rapport à Tahiti mais également les pertes liées à la réduction du bus mémoire de 384-bit à 256-bit. Pour cela, nous avons tout d'abord testé les R9 280X et 380X cadencées aux mêmes fréquences de 1000 MHz pour le GPU et de 1500 MHz pour la mémoire. Ensuite, pour isoler autant que possible les améliorations apportées à l'architecture GCN, nous avons réduit la fréquence mémoire de la R9 280X à 1000 MHz de manière à ce qu'elle propose une bande passante identique à celle de la R9 380X. Certes, configurés de la sorte, les deux GPU ne sont pas totalement égaux puisque des détails ne sont pas identiques tels que, par exemple, la taille du cache L2 ou encore la latence mémoire. Une approximation qui nous semble cependant acceptable pour observer de plus près Tonga et Tahiti. Voici ce que cela donne : [ Pourcents ] [ FPS ] Tonga affiche en moyenne un gain de 7.6% sur Tahiti configuré de manière à offrir une même bande passante mémoire. Un gain variable qui monte à 18% dans Fallout 4 et The Witcher 3 mais qui peut également être nul comme c'est le cas dans Hitman. Lorsque Tahiti peut profiter de sa bande passante mémoire 50% supérieure grâce au bus 384-bit, ses performances moyennes augmentent de 9%, ce qui reste relativement faible en terme de rendement mais lui permet d'être légèrement plus performant que Tonga en 256-bit. Page 25 - Conclusion ConclusionAvec la Radeon R9 380X, AMD étoffe son offre milieu de gamme mais sans réellement nous convaincre. La faute à un rapport performances/prix malheureusement sans grand intérêt pour cette nouvelle référence qui par ailleurs peine à se démarquer de sa petite sœur la Radeon R9 380. AMD a visiblement décidé de lancer ses nouvelles cartes graphiques à un niveau tarifaire plus élevé que par le passé. Si ne plus se focaliser uniquement sur ce point face aux GeForce est probablement un passage obligatoire pour redresser son image de marque, le faire alors même que ses parts de marché sont en berne est plus que délicat. Evidemment, si nous regardons la situation à travers la lorgnette préparée par le marketing d'AMD, à savoir une opposition limitée à la GeForce GTX 960, la Radeon R9 380X s'en tire honorablement avec 15% de performances en plus pour un tarif de lancement à peine 10% supérieur... tout du moins si nous ne prenons en compte que les cartes 4 Go. Car la GTX 960 existe également en version 2 Go qui s'en tire très bien dans les jeux actuels aux résolutions adaptées à sa puissance. Le problème est qu'en dehors de cette lorgnette il existe d'autres références. Ce test est d'ailleurs l'occasion de constater que la Radeon R9 380 a été repositionnée à un niveau tarifaire plus intéressant. A 210€ pour sa version 4 Go et 190€ pour sa version 2 Go, elle propose 10% de performances en plus qu'une GTX 960 pour 20 à 30€ de moins. De quoi faire de l'ombre à cette R9 380X 4 Go lancée à 260€ et qui se contente de proposer un gain de performances anecdotique. Pour jouer en 1080p pour environ 200€, la Radeon R9 380 est actuellement la solution la plus intéressante sur le plan du rapport performances/prix. Il faut cependant garder en tête que, tout comme la R9 380X, elle est plus gourmande qu'une GTX 960 ce qui implique que les nuisances sonores peuvent exploser si le fabricant n'a pas pris soin du refroidissement. C'est malheureusement le cas sur le modèle XFX que nous avons utilisé pour ce test et nous tâcherons de vérifier rapidement si d'autres modèles s'en tirent mieux sur ce point.  A ce sujet, nous avons été particulièrement déçus par la R9 380X Nitro de Sapphire dont le ventirad manque un peu de pêche en charge mais est surtout très mal calibré au repos, ce qui rend la carte agaçante avec des ventilateurs qui passent leur temps à s'arrêter et à redémarrer. La R9 380X Strix d'Asus s'en tire nettement mieux mais est affublée de la surtaxe habituelle du taiwanais qui la propose à pas moins de 300€, un tarif aussi rond que dissuasif. Et nous en arrivons à l'autre problème de la R9 380X, et particulièrement de ses variantes overclockées, qui souffre également de la comparaison avec les dérivés supérieurs du GPU Hawaii. Sans même nous focaliser sur les derniers stocks de R9 290 écoulés à prix cassés, le gap énorme entre les performances d'une R9 380X et d'une R9 390 éclipse directement la première pour le joueur qui a besoin de plus qu'une R9 380. Une comparaison encore plus difficile pour la nouvelle venue si vous êtes intéressé par l'un des jeux proposés en bundle par Nvidia avec les GTX 970, dont la valeur correspond à l'écart tarifaire entre ces cartes graphiques… Il est par ailleurs intéressant d'observer qu'autant AMD que Nvidia ont opté pour la même stratégie de ne pas combler ce trou béant dans leur gamme. Ainsi, nous ne pouvons que regretter qu'AMD n'ait pas saisi cette opportunité dans sa nouvelle gamme avec un dérivé d'Hawaii plus fortement castré et limité à 4 ou 6 Go. Le fait que Nvidia garde sous le coude depuis plusieurs trimestres une GTX 960 Ti dans la même veine l'en a probablement dissuadé, par peur d'impacter les ventes des modèles supérieurs sans en tirer de réel bénéfice compétitif. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |