| |

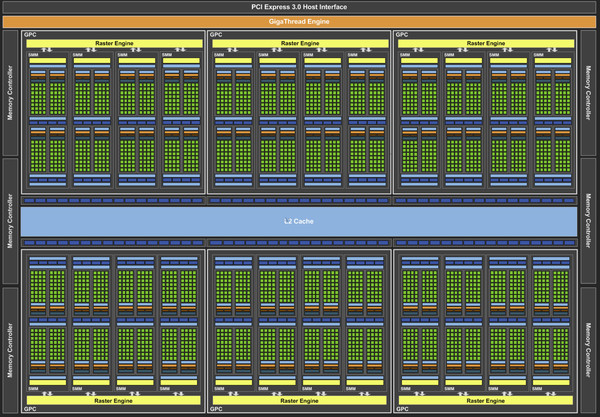

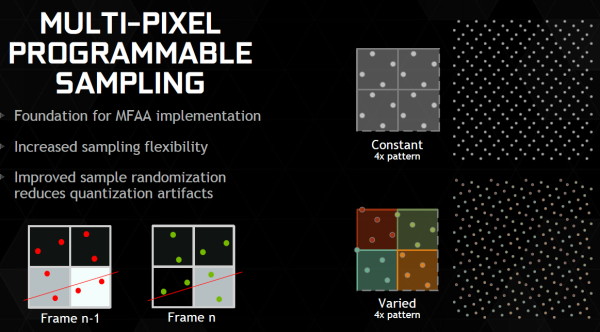

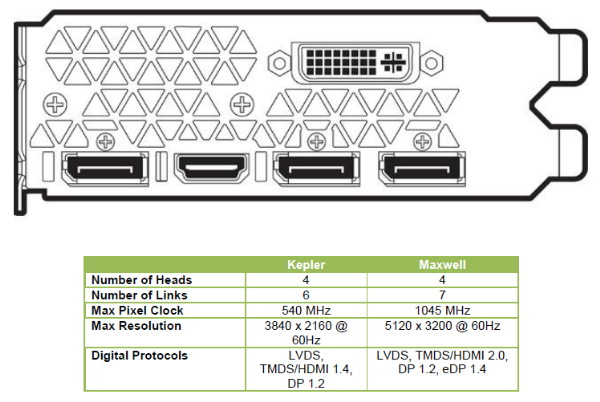

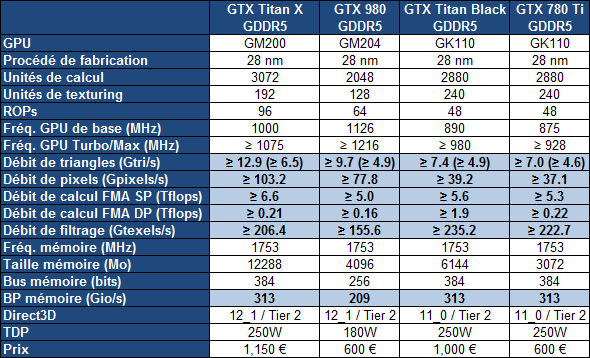

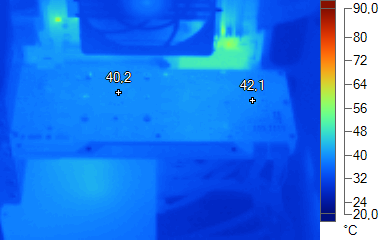

| Nvidia GeForce GTX Titan X 12 Go et GM200 en test: big Maxwell débarque ! Cartes Graphiques Publié le Jeudi 2 Avril 2015 par Damien Triolet URL: /articles/933-1/nvidia-geforce-gtx-titan-x-12-go-gm200-test-retour-carte-1000.html Page 1 - Introduction Comme pour la génération de GeForce Kepler, c'est dans la famille des GTX Titan de luxe que Nvidia introduit le plus gros GPU Maxwell qui embarque pas moins de 8 milliards de transistors. Au menu : plus de 6.6 Tflops, 12 Go de GDDR5 et un ventirad à la finition irréprochable. De quoi permettre à Nvidia de renforcer sa place de leader, mais faut-il craquer pour cette carte graphique à plus de 1000€ ? C'est la question à laquelle nous allons tenter de répondre à travers notre test complet.  Le GM200, un gros GPU en 28nm pour les joueursFace à la stagnation dans les process de fabrications adaptés à des puces telles que les GPU, Nvidia n'a pas eu d'autre choix que de prévoir une seconde génération en 28 nm. Et forcément celle-ci, Maxwell, devait faire mieux que Kepler, ce qui passait tout d'abord par un travail important sur l'efficacité énergétique. Augmenter les performances par unité de surface était également crucial pour rendre l'opération viable commercialement. Mais ce n'est pas tout. Pour pouvoir mettre au point un autre gros GPU, significativement plus performant, Nvidia a dû faire un autre compromis : se passer du calcul en double précision. La double précision requiert l'intégration d'unités de calcul 64-bit spécifiques, ce qui monopolise transistors et espace sur la puce quand elles sont présentes en nombre suffisant pour que ce type de calcul soit réellement exploitable. Pour la génération Maxwell, y compris pour ce nouveau GM200, Nvidia a ainsi fait le compromis de ne pas prévoir plus qu'un support à titre de compatibilité pour la double précision. Ses performances sont anecdotiques. Il s'agit d'une première pour un gros GPU depuis le GT200 de 2008. Pour les joueurs, cela n'a aucune conséquence, la double précision n'est exploitée que dans le monde professionnel, et encore uniquement dans certains cas. La portée du GM200 au-delà du monde du jeu vidéo s'en trouve quelque peu limitée, mais cela ne veut pas dire qu'il ne trouvera pas sa place dans le monde professionnel. Une Quadro M6000 basée sur ce GPU est d'ailleurs prévue, tous les usages n'ayant pas besoin de double précision. Et puis Nvidia a organisé sa stratégie autour de cette absence dans la génération Maxwell : le GK210, un nouveau GPU Kepler dédié au calcul haute performance a été lancé cet automne, et l'an prochain l'architecture Pascal apportera des évolutions majeures à ce niveau. Au final, par rapport au GM204 de la GeForce GTX 980,Nvidia a pu augmenter de 50% toutes les capacités du GPU utiles pour pousser vers le haut les performances dans les jeux vidéo. Suite à une malencontreuse erreur de manipulation, il faudra à l'avenir penser à ne pas nettoyer les fichiers xls avant une bonne nuit de sommeil, nos résultats en 4K qui incluaient les GTX 980 en SLI se sont envolés. Nous n'avons publié que les performances en 1440p dans un premier temps, mais nous sommes aux fourneaux pour réintégrer les résultats en 4K dès que possible. Mise à jour du 2 avril : Les résultats en 4K, qui incluent des GTX 980 en SLI et la R9 295X2, ont enfin été intégrés au dossier. Page 2 - GM200 : 8 milliards de transistors, GM204 x 1.5 GM200 : 8 milliards de transistorsPour sa dernière architecture en date, nom de code Maxwell, Nvidia a poursuivi l'effort entrepris lors du passage de Fermi vers Kepler pour une meilleure efficacité énergétique. C'était d'autant plus nécessaire que le procédé de fabrication n'évolue pas. Que ce soit pour les GPU Maxwell de première génération, ou de seconde génération, et même pour l'énorme GM200 qui est introduit aujourd'hui, Nvidia fait appel à la même variante du 28 nanomètres de TSMC (HP) que pour l'ensemble des GPU de la génération Kepler précédente. Pour rappel, voici la liste des GPU conçus par Nvidia en 28 nanomètres : GM200 : 8.0 milliards de transistors pour 601 mm² GK210 : ??? GK110 : 7.1 milliards de transistors pour 551 mm² GM204 : 5.2 milliards de transistors pour 398 mm² GK104 : 3.5 milliards de transistors pour 294 mm² GM206 : 2.9 milliards de transistors pour 228 mm² GK106 : 2.5 milliards de transistors pour 214 mm² GM107 : 1.9 milliards de transistors pour 148 mm² GK107 : 1.3 milliards de transistors pour 118 mm² GM108 : ~1.1 milliards de transistors pour 83 mm² GK208 : 1.0 milliards de transistors pour 79 mm²  Le GM200 de Nvidia. Un petit calcul rapide montre que les GPU les plus récents de Nvidia, dont le GM200, affichent une densité de transistors un peu plus élevée que celle de ses premières puces fabriquées en 28 nm, notamment le GK104. Ceci peut s'expliquer par une petite évolution des règles de design et par un effort d'optimisation plus poussé mais aussi par la proportion de mémoire SRAM (plus dense que les autres circuits) qui peut être plus élevée. Le GM200 est à peu près 10% plus gros que le GK110 qu'il remplace, mais le changement d'architecture et l'abandon du mode hautes performances pour le calcul en double précision va permettre à Nvidia d'augmenter sensiblement le nombre de blocs d'unités de calcul et de ROP. A noter que le nombre de 8 milliards de transistors pour le GM200 semble un petit peu élevé par rapport à ce que nous en savons. La comparaison avec le GM206 et le GM204 aurait plutôt laissé penser à une puce de 7.5 milliards de transistors. Nvidia n'a pas voulu commenter cette observation et nous ne savons pas d'où vient cette inflation de la complexité de la puce. Il est par exemple possible que certaines fonctionnalités spécifiques au monde professionnel aient été intégrées ou que plus de redondance ait été prévue par Nvidia sur cette énorme puce. GM204 x 1.5Pour rappel, alors que les GPU Kepler reposaient sur des blocs fondamentaux appelés SMX (Streaming Multiprocessor), qui contiennent unités de calcul et autres unités de texturing, ceux-ci sont appelés SMM dans le cas de la génération Maxwell. Ils ont subi un régime assez drastique afin de les simplifier suffisamment pour pouvoir en augmenter significativement le nombre. Tout comme les SMX, les SMM sont organisés en petits groupes, appelés GPC (Graphics Processing Cluster). Chaque GPC inclus un moteur de rastérisation qui reçoit les triangles traités par les SMX/SMM, les découpes en pixels avec lesquels il forme de petits groupes qui sont renvoyés vers les SMX/SMM en vue de leur calcul. Voici une représentation visuelle du GM200 (notez que la représentation miniature des SMM est basée sur la version officielle qui n'est pas tout à fait correcte, pour plus d'informations à leur sujet c'est par ici) :  Voici pour comparaisons les spécificités de tous les GPU 28 nm de la marque : GM200 : 6 GPC, 24 SMM, 96 ROP, bus 384-bit, 3072 Ko de L2 GK210 : 5 GPC, 15 SMX, 48 ROP, bus 384-bit, 1536 Ko de L2 GK110 : 5 GPC, 15 SMX, 48 ROP, bus 384-bit, 1536 Ko de L2 GM204 : 4 GPC, 16 SMM, 64 ROP, bus 256-bit, 2048 Ko de L2 GK104 : 4 GPC, 8 SMX, 32 ROP, bus 256-bit, 512 Ko de L2 GM206 : 2 GPC, 8 SMM, 32 ROP, bus 128-bit, 1024 Ko de L2 GK106 : 3 GPC, 5 SMX, 24 ROP, bus 192-bit, 384 Ko de L2 GM107 : 1 GPC, 5 SMM, 16 ROP, bus 128-bit, 2048 Ko de L2 GK107 : 1 GPC, 2 SMX, 16 ROP, bus 128-bit, 256 Ko de L2 GM108 : 1 GPC, 3 SMM, 8 ROP, bus 64-bit, 1024 Ko de L2 GK208 : 1 GPC, 2 SMX, 8 ROP, bus 64-bit, 512 Ko de L2 Alors que le GM107 était passé à 1 Mo de L2 par contrôleur mémoire de 64-bit, les GM20x s'en contentent de 512 Ko, soit 3 Mo au total dans le cas du GM200. Par contre, Nvidia est passé de 8 à 16 ROP par contrôleur mémoire, de quoi booster largement le fillrate, ce qui profite notamment aux plus hautes résolutions. Pour éviter d'être trop limité par le bus mémoire relativement étroit des GM20x, et la bande passante qui y est liée, Nvidia a amélioré quelque peu ses techniques de compressions sans perte du framebuffer. Plus spécifiquement, c'est le codage différentiel pour les couleurs, également appelé compression delta, qui progresse, exactement comme l'a fait AMD avec Tonga. Le principe de base consiste à ne pas enregistrer directement la couleur mais sa différence par rapport à une autre qui fait office de repère. Ce n'est bien entendu utile que quand l'écart entre deux couleurs est suffisamment faible, de manière à ce que cette information représente moins de bits que la couleur en elle-même. Ce type d'approche est exploitée depuis plusieurs générations de GPU mais les nouvelles puces Maxwell profitent d'un algorithme plus flexible, capable de profiter de cette compression dans plus de cas. Avec la seconde génération Maxwell, Nvidia a eu un petit peu plus de temps pour implémenter de nouvelles fonctionnalités. Le GM200 est sur ce point totalement identique au GM204. Elles s'articulent principalement autour de la mise à jour des moteurs de rastérisation, ces unités chargées de la découpe des triangles en pixels. Une limitation à leur niveau (absence de support de la fonction Target Independant Rasterization) empêchait jusqu'ici Nvidia de supporter le niveau de fonctionnalité matériel 11_1 de Direct3D bien que la plupart de ses autres spécificités soient bien supportées sur les GPU Kepler et Maxwell de première génération. Nvidia n'a pas simplement ajouté ce qui manquait au support du niveau 11_1 mais a fait en sorte de faire le maximum pour s'assurer du support du niveau 12_1. Celui-ci sera supporté par Direct3D 12 ainsi que par Direct3D 11.3 qui apportera l'équivalent sur l'API classique de Microsoft, tous les développeurs n'étant pas prêts à migrer vers la nouvelle API de bas niveau. Tant qu'à modifier les moteurs de rastérisation sur plusieurs points, Nvidia en a profité pour améliorer leur flexibilité par rapport aux grilles d'échantillonnage utilisées avec l'antialiasing. Elles sont dorénavant capables de faire varier la position des samples d'une image à l'autre et/ou d'utiliser une grille multi-pixels. Cette seconde possibilité permet de répartir différemment les samples d'un pixel à l'autre pour éviter un schéma uniforme moins efficace.  Faire varier la position des samples, c'est déjà ce que faisais ATI et AMD avec le Temporal AA. Et c'est ce que va faire Nvidia avec le MFAA dont le support concerne la majorité des jeux DirectX 10/11 avec les derniers pilotes. Pour rappel, Nvidia ne s'est pas contenté de recopier ce principe d'ATI, mais y a ajouté un filtre plus avancé qui combine downsampling et composante temporale basée sur l'image précédente. De quoi se rapprocher du résultat d'un MSAA 4x avec seulement deux samples par pixel et un surcoût modéré pour le filtre qui permet au final au très bon compromis entre performances et qualité visuelle. Vous pourrez retrouver plus d'informations à ce sujet par ici Pas de décodage H.265Avec les GM20x, Nvidia est passé au HDMI 2.0, qui apporte une hausse notable de bande passante afin de pouvoir gérer à l'instar du DisplayPort 1.2 les écrans 4K et 5K à 60 Hz sans avoir recours à un sous échantillonnage des informations de couleurs comme c'est le cas pour la 4K en HDMI 1.4a. A noter que chacun des 4 contrôleurs d'affichage est capable de gérer plusieurs flux MST de même résolution, ce qui permet par exemple d'utiliser un seul contrôleur pour adresser en DisplayPort un écran 4K "tiled" composé de deux dalles. Cela permet de gérer jusqu'à 4 écrans de ce type, à condition de disposer de 4 sorties DisplayPort (en pratique les fabricants en intègrent jusqu'à 3 à ce jour), contre 2 sur les cartes Nvidia précédentes.  Alors que le GM206 de la GTX 960 qui a été lancé fin janvier apportait quelques nouveautés sur le plan vidéo, celles-ci ne se retrouvent pas dans le GM200, qui a en fait été finalisé plus ou moins en même temps que le GM204 dont il partage les spécificités à ce niveau. Seul le GM206 est ainsi capable de prendre en charge complètement le décodage H.265 (HEVC) ainsi que le pilotage de 4 écrans 5K en MST. Comme le GM204, le GM200 reste limité à 2 écrans en 5K, chacun de ses 4 contrôleurs étant limité à la 4K dans le mode MST. Page 3 - Performances théoriques : pixels Performances texturingNous avons mesuré les performances lors de l'accès aux textures avec filtrage bilinéaire activé et ce, pour différents formats : en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16), en 128 bits (4x FP32), en profondeur de 32 bits (D32F) et en FP10, un format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis. Les GeForce GTX sont capables de filtrer les textures FP16 à pleine vitesse contrairement aux Radeon, ce qui leur donne un avantage considérable sur ce point. Notez que dans ce test, les GeForce à base de GK104/106/107 ont du mal à atteindre leur débit maximal alors que le GM107/200/204/206 en sont plus proches, une efficacité en hausse des unités de texturing qui est probablement liée au fait que leur proportion réduite permet de plus facilement les saturer. Les GM200, GM204 et GM206 sont capables d'accéder aux surfaces de type D32F aussi efficacement que les autres formats, comme les GPU Radeon, mais contrairement aux GPU GeForce précédents. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données : [ Standard ] [ Avec Blending ] Le fillrate était l'un des points forts du GPU Hawaii qui intègre pas moins de 64 ROP chargés d'écrire les pixels en mémoire, qui plus est d'une efficacité élevée avec blending. Mais avec le GM204, Nvidia est revenu et le GM200 enfonce le clou en prenant une avance considérable. A noter que les GeForce depuis Kepler sont capables de transférer les formats FP10/11 et RGB9E5 à pleine vitesse vers les ROP, comme les Radeon, mais le blending de ces formats se fait toujours à demi vitesse. Par ailleurs, si tous les GPU sont capables de traiter le FP32 simple canal à pleine vitesse sans blending, seules les Radeon conservent ce débit avec blending. Page 4 - Performances théoriques : géométrie Débit de trianglesÉtant donné les différences architecturales des GPU récents au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d'abord nous avons observé les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu'ils tournent le dos à la caméra) : Quand les triangles peuvent être éjectés du rendu, ce qui en concerne en pratique toujours une part conséquente, la plupart des GeForce GTX peuvent profiter d'un débit supérieur pour se démarquer des Radeon. A noter cependant que notre test n'est plus adapté pour le niveau de performances énorme du GM200 et bride les résultats à un peu plus de 8 milliards de triangles par seconde. Une fois que les triangles doivent être rendus, le débit maximal théorique des GeForce Kepler chute sur certains modèles alors que leur efficacité est plus généralement en baisse, peut-être parce que ces GPU sont engorgés à un endroit ou à un autre, ou encore parce que leurs performances ont été réduites artificiellement pour différencier les Quadro des GeForce. Quoi qu'il en soit, cela ne semble plus être un problème sur Maxwell de seconde génération. Le GM206 en profite pour devancer le GK110 sur ce point et le GM200 affiche un nouveau record. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation : Avec les GeForce GTX Kepler, Nvidia réaffirmait sa supériorité lorsqu'il s'agit de traiter un nombre important de petits triangles générés par un niveau de tessellation élevé. Le GM204 Maxwell de seconde génération a renforcé cet avantage lorsque les triangles ne sont pas affichés mais peinait à se démarquer du GK110 quand ils doivent être affichés. Le GM200 se détache cette fois à tous les niveaux, même si ici aussi nous suspectons notre test de la limiter quelque peu lorsque les triangles sont éjectés du rendu. Pour rappel, l'architecture des Radeon fait qu'elles peuvent être engorgées plus facilement par la quantité de données générées, ce qui réduit drastiquement leur débit dans ce cas. AMD a fait évoluer progressivement les différents buffers liés à la tessellation, et la manière de les utiliser, pour éviter autant que possible de se trouver dans ce cas. Hawaii et Tonga affichent un gain important au niveau du débit brut, soit lorsque les triangles générés ne doivent pas être rendus. Lorsque c'est le cas, ils se contentent par contre dans notre test d'une progression très légère. Notre test étant relativement lourd en termes de données générées par triangles, nous supposons que ces GPU souffrent d'un embouteillage à un endroit ou à un autre, peut-être au niveau du canal de transfert de ces données vers les contrôleurs mémoire (mais pas directement au niveau de la bande passante globale qui est loin d'être saturée). Page 5 - Spécifications, GPU Boost en pratique Spécifications  La GeForce GTX Titan X embarque un GPU GM200 en configuration complète, cadencé à une fréquence plus faible que celles des autres GPU de la famille, ce qui permet de réduire également la tension maximale et donc l'enveloppe thermique nécessaire pour accueillir un tel monstre. La fréquence GPU Boost communiquée (une spécification factice qui représente en quelque sorte le turbo maximal garanti) est relativement plus faible que sur le GM204, Nvidia ayant probablement jugé que les limitations de températures et de consommations limiteraient la montée en fréquence, dans des proportions plus fortes que pour la GTX 980 par exemple. Au niveau des débits bruts, la fréquence réduite de la GTX Titan X fait qu'elle se contente d'une avance de 33% sur la GTX 980, malgré l'augmentation de 50% du nombre de toutes ses unités. Par contre la bande passante mémoire est bien 50% supérieure. Rappelons cependant que sur la majorité des cartes graphiques Nvidia depuis la génération Kepler, la fréquence turbo maximale réelle n'est pas spécifiée, et elle varie qui plus est d'un échantillon à l'autre. Grossièrement, Nvidia applique ainsi un overclocking automatique sur les GPU qui sont capables de tenir la fréquence officielle à une tension plus faible que le maximum spécifié. Cela veut dire que la comparaison des spécifications papiers peut ne pas correspondre exactement à la réalité. Ainsi sur base de nos échantillons de ces cartes, nous avons observé que la GTX 980 de référence était souvent sous sa fréquence GPU Boost alors que la GTX Titan X est souvent au-dessus de la sienne. En pratique, l'écart de fréquences GPU entre ces deux cartes est ainsi bien plus faible que ce que ne laissent penser ce tableau de spécifications. La comparaison avec la précédente GTX Titan Black est plus compliquée. Le gain en puissance de calcul est réduit mais il faut rappeler que la capacité des GPU Kepler à l'exploite est plus faible que celle des GPU Maxwell dont l'architecture est plus efficace. Pour le reste, la puissance de texturing est en baisse, mais le fillrate est en hausse massive, alors que la bande passante mémoire est identique. La différence la plus importante est cependant à chercher du côté de la double précision. Le GM200 n'intègre pas un support performant de ce type de calculs et la GTX Titan Black est ainsi 9x plus véloce que la Titan X sur ce point. Nvidia a équipé sa GeForce GTX Titan X de pas moins de 12 Go de GDDR5. Une quantité de mémoire qui sera rarement exploitée mais qui, sans faire de mal, permet de renforcer l'aspect exclusif de cette déclinaison ultra haut de gamme. Comme nous l'expliquions ici, les GeForce Maxwell de seconde génération supportent le niveau de fonctionnalités 12_1 de DirectX 12. Par contre pour la flexibilité dans la gestion des ressources, elles se contentent du Tier 2, comme les GPU Kepler, là où les GPU AMD sont capables d'atteindre le Tier 3 depuis quelques temps. Ce n'est pas une capacité primordiale, mais Nvidia a préféré botter en touche et ne pas répondre aux questions qui concernent ces détails probablement jugés gênants. Nvidia a fixé une limite de consommation de 250W pour la GTX Titan X de référence mais en pratique c'est la limite de température qui sera le facteur limitant bien qu'elle ait été relevée de 79.5 °C à 83 °C pour permettra à la carte graphique d'encaisser une charge plus importante. GPU Boost en pratiquePar défaut, la courbe des fréquences/tensions de la GTX Titan X ne peut aller au-delà de 1.174V, ce qui est nettement plus faible que les 1.212V des autres GPU Maxwell mais logique pour ne pas trop faire exploser la consommation. A noter que l'algorithme GPU Boost bloque l'accès aux derniers points de cette courbe lorsque certaines conditions sont rencontrées. Nous n'avons pas encore pu les déterminer précisément mais elles semblent liées à la charge et à la température GPU, même quand les limites à ce niveau ne sont pas atteintes. Voici ce que nous avons observé sur notre échantillon de GTX Titan X avec une charge relativement lourde, mais inférieure à la limite : Si tGPU < 63°C : 1190 MHz @ 1.174V Si tGPU > 63°C : 1177 MHz @ 1.162V Si tGPU > 73°C : 1164 MHz @ 1.149V Si tGPU > 80°C : 1152 MHz @ 1.137V En pratique, la fréquence turbo maximale que la carte est capable de maintenir après quelques minutes dans les jeux est de 1152 MHz, ce qui reste 7% de plus que les 1075 MHz annoncés comme fréquence GPU Boost. Si les jeux sont un minimum lourds, la limite de température de 83°C est cependant atteinte. Voici les fréquences que nous avons relevées pour l'ensemble des cartes testées en 1440p :  [ 1440p ] [ 4K ] La fréquence notre échantillon variait entre 1050 MHz et 1152 MHz, ce maximum étant atteint dans Dying Light "grâce" aux micro-saccades dont il souffre. Dans les mêmes conditions, la fréquence variait entre 1126 et 1215 MHz pour la GTX 980 de référence. Au final entre ces deux cartes nous avons observé un écart moyen de 3% en faveur de la GTX 980, ce qui est bien loin des 13% qu'annoncent les fréquences GPU Boost de ces cartes ! Bien entendu il s'agit en partie d'une loterie et chaque exemplaire produira des résultats quelque peu différents, avec une plage de variation inconnue, Nvidia refusant catégoriquement d'en parler. Page 6 - La GeForce GTX Titan X de référence La GeForce GTX Titan X de référenceA l'exception de quelques modèles watercoolés, la carte de référence est la seule déclinaison commerciale de la GeForce GTX Titan X. Nvidia ne fournit que des cartes complètes à ses partenaires, et elles ne sont garanties que dans cet état. Il n'y aura donc pas de cartes personnalisées, à moins qu'un fabricant ne décide de prendre la garantie à sa charge et de proposer son propre ventirad en kit. Nvidia nous a fourni un échantillon de la carte de référence :  Nvidia reprend ici le même design que pour le ventirad des GeForce GTX 780, GTX 780 Ti et GTX Titan de référence dont la qualité de finition est excellente et participe au bon comportement de ces cartes sur le plan des nuisances sonores. L'évolution principale, voire unique, est esthétique, avec une finition rugueuse noire pour la coque en aluminium. Le résultat est plutôt réussi, cette coque s'associant parfaitement avec le revêtement noir du radiateur, qui avait été mis en place avec les GTX 780 Ti et GTX Titan Black. Vous noterez que Nvidia met en avant la marque Titan sur la coque, sans préciser le modèle exact. Comme pour les précédents modèles haut de gamme 250W, une chambre à vapeur prend place sous la coque et fait office de base pour le ventirad. Il s'agit d'une différence notable par rapport au ventirad de référence de la GTX 980 qui doit se contenter de 2 petits caloducs plats incrustés dans le bloc d'aluminium. Cette différence participe, avec l'augmentation de la limite de température et la taille plus importante de la puce à améliorer la capacité de dissipation et donc à permettre à la GTX Titan X d'encaisser une charge bien plus élevée. Grossièrement, là où une GTX 980 de référence pourra soutenir en boîtier fermé une charge totale de +/- 150W, la GTX Titan X pourra maintenir une charge de +/- 200W (nous ne pouvons observer que la charge totale et il y a probablement quelques watts liés aux 12 Go de mémoire). Vous remarquerez que, contrairement à la GeForce GTX 980, Nvidia n'utilise pas de backplate. Les rôles de celle-ci ne concernent que l'esthétique et la robustesse de la carte mais en contrepartie elle impacte le refroidissement de certains composants du PCB et peut limiter le flux d'air lorsque deux cartes sont placées côte à côte dans un système multi-GPU. C'est la raison pour laquelle Nvidia n'utilise jamais de backplate pour ses designs 250W, d'autant plus lorsque de nombreux composants sensibles prennent place à l'arrière du PCB comme c'est le cas pour la moitié des modules mémoire de la GTX Titan X.  Nvidia indique avoir travaillé en profondeur sur l'étage d'alimentation du GPU, composé de 6 phases pour le GPU et de 2 autres pour sa mémoire. Ils sont alimentés via 3 sources de 12V : deux connecteurs 8+6 broches ainsi que le bus PCI Express. Nvidia précise avoir sélectionné les composants de manière à éviter le coil whine. Notre échantillon en produit cependant un petit peu, rien de bien méchant, mais certains confrères nous ont fait part d'un niveau plus élevé sur leurs cartes. Attention, insistons bien sur le fait qu'il n'y a pas réellement de gros problème, nous sommes loin des niveaux très élevés qui impactent de nombreuses GTX 970 par exemple. Mais nous n'avons pas l'impression qu'il y ait de réelle amélioration sur ce point par rapport aux précédentes GeForce GTX haut de gamme de référence. A noter que pour intégrer 12 Go de GDDR5, Nvidia a préféré opter pour 24 puces Hynix 4 Gb (512 Mo) en mode clamshell et non pour 12 puces de 8 Gb (1 Go) qui auraient pu simplifier le design mais dont la disponibilité n'est peut-être pas suffisante. La connectique est similaire à celle des autres GTX 900 : une DVI Dual Link, une HDMI et 3 DisplayPort, dont 4 peuvent être utilisées simultanément. Page 7 - Consommation, efficacité énergétique ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 7 et en veille écran. Nous en avons profité pour tester la GTX 980 de référence en mode "Uber", c'est-à-dire en poussant ses limites de consommation et de température à leur maximum de manière à ce qu'elle maintienne la fréquence turbo maximale et d'observer comment se comporte le ventirad dans ces conditions. Pour la charge, nous testons d'une part Anno 2070 en mode de qualité maximale qui représente un jeu très lourd et d'autre part Battlefield 4 en mode Ultra qui représente un jeu moins lourd. Au repos, la consommation du GM200 est du même ordre de grandeur que celle du GM204. En charge il est évidemment plus gourmand. La consommation progresse de 37% dans Battlefield 4 et de plus de 40% par défaut dans Anno 2070, ce qui est rendu possible en partie par le ventirad plus costaud grâce à la chambre à vapeur, mais également par la limite de température plus élevée pour la GTX Titan X. Par rapport à une GTX 780 Ti, la consommation reste similaire, alors que les performances font un bond en avant. Bien que ces données soient approximatives, compte tenu de la variation entre échantillons d'un même modèle, nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles, de quoi donner une idée globale sur le rendement énergétique de toutes ces cartes : [ Battlefield 4 ] [ Anno 2070 ] L'efficacité énergétique des GeForce GTX 900 fait un bond en avant, et la GTX Titan X ne déroge pas à la règle. A noter que les résultats quelque peu en retrait de la GTX Titan X par rapport à la GTX 980 dans Anno 2070 sont probablement liés au fait qu'elle est proche de la limite CPU sous Anno 2070 en 1080p. Nous envisagerons à l'avenir de migrer cette partie de notre protocole de test vers du 1440p. Page 8 - Températures et nuisances sonores Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge sous le test1 de 3DMark11. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe à moins de 20 dBA, ce qui est la limite de sensibilité pour laquelle il est certifié et calibré. Au repos, toutes les GeForce GTX sont presque totalement silencieuses. En charge, le niveau atteint par la GTX Titan X est plutôt raisonnable pour une carte de ce calibre à base de ventilateur radial. Elle n'est pas silencieuse mais le niveau de bruit reste acceptable, d'autant plus qu'aucun son disgracieux n'est émis : seule la soufflerie sourde se fait entendre. La GTX Titan X est ici moins bruyante que la GTX 780 Ti malgré l'utilisation d'un ventirad identique ou presque. Le ventilateur tourne plus vite sur la GTX 780 Ti ce qui peut s'expliquer par la taille légèrement plus élevée du GPU, par une répartition différente du dégagement calorifique entre les différents éléments du PCB ou encore simplement par une petite dose de variabilité entre échantillon à ce niveau également (pâte thermique etc). TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne : La GTX 980 et GTX Titan X atteignent en charge leur température maximale. Dans le cas de la première, elle est même légèrement dépassée : la fréquence de base est atteinte donc pour ne pas trop pénaliser les performances, GPU Boost laisse la température aller au-delà de la limite de 80 °C. Une fois toutes les limites repoussées, en mode 'Uber', la température ne monte pas plus haut que 85 °C, ce qui s'explique par une courbe de ventilation agressive. Comme vous pouvez le voir plus haut, les nuisances sonores augmentent alors fortement. Thermographie infrarougeVoici les photos thermiques obtenues pour la GTX Titan X avec à chaque fois 45 minutes de mise en situation :  [ Repos ] [ Charge ] [ Charge 'Uber' ] Comme vous pouvez l'observer, en charge, c'est la mémoire GDDR5 qui chauffe le plus à l'arrière du PCB avec des températures qui dépassent facilement les 90 °C. Page 9 - Protocole de test Protocole de testPour ce test, nous avons repris notre protocole de 10 jeux utilisé précédemment, mais en y intégrant Dying Light et Evolve. Tous les derniers patchs au 13/03/2015 ont été installés, la plupart des jeux étant maintenus à jour via Steam/Origin/Uplay. Nous avons opté tout d'abord pour la résolution de 1440p avec un niveau de détail très élevé, de manière à obtenir à peu près 60 fps sur la GTX Titan X, ou plus si le jeu ne permet pas un niveau de détail plus élevé autre que du SSAA. Nous avons évité d'activer ce type d'antialiasing, que nous jugeons beaucoup trop gourmand par rapport à ce qu'il apporte. Ensuite, nous avons testé toutes ces solutions en 4K et y avons ajouté une paire de GTX 980 de référence en SLI ainsi que la Radeon R9 295X2. Nous avons baissé les paramètres graphiques de manière à viser 50 à 60 fps sur la GTX titan X, mais en gardant un niveau de qualité maximal pour les textures sans quoi passer en résolution 4K n'aurait plus aucun intérêt. Sur certains jeux ce n'était pas possible d'atteindre 50 fps en moyenne sans trop baisser la qualité et avec Evolve c'était tout simplement impossible même avec toutes les options réduites au minimum ! A noter que la consommation mémoire dans des conditions jouables sur GTX Titan X n'est pas aussi élevée en 4K qu'on pourrait le penser. Cela s'explique principalement par 2 points : l'antialiasing MSAA passe souvent à la trappe, et les textures, qui monopolisent une part importante de la mémoire, sont les mêmes en 4K qu'en 1440p. 5 des 12 jeux testés se contentaient de moins de 2 Go, 4 autres de moins de 3 Go. Far Cry 4 est monté à 3.3 Go et Dying Light à 3.6 Go. Mais c'est Evolve qui pousse vraiment l'utilisation de la mémoire avec 5.1 Go sur la GTX Titan X. Il faut cependant rappeler que mémoire utilisée et mémoire réellement utile sont deux choses différentes. Des textures devenues inutiles peuvent par exemple rester en mémoire. Ceci dit, quelques petits à-coups se font sentir sur les cartes 4 Go dans Evolve, des à-coups qui se transforment en grosses saccades sur les systèmes bi-GPU. Pour rappel, nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Toutes les cartes ont été testées avec les pilotes Catalyst 15.3 beta et GeForce 347.87 beta. Nous avons forcé l'activation du PCI Express 3.0 sur la plateforme X79 pour les GeForce. Toutes les cartes ont été testées telles quelles avec une température ambiante contrôlée à 26 °C et, pour chaque jeux, nous avons pris le temps nécessaire pour que la fréquence GPU se stabilise. Les performances des GeForce peuvent potentiellement être quelque peu surévaluées du fait de leur fréquence turbo variable que nous ne cherchons plus à limiter aux spécifications officielles depuis la génération GTX 700 avec laquelle a été introduite une limite de température qui est devenu l'élément de limitation principal pour les GeForce de référence. La R9 290X de référence n'est pas vraiment conseillée compte tenu de ses nuisances sonores atroces, raison pour laquelle nous avons opté pour la R9 290X Tri-X OC de Sapphire, qui est par ailleurs la plus répandue. Nous avons également intégré la GTX 980 G1 Gaming de Gigabyte qui permet de représenter les performances d'une "bonne" GTX 980 personnalisée.  Configuration de testIntel Core i7 3960X (HT off, Turbo 1/2/3/4/6 cores: 4 GHz) Asus P9X79 WS 8 Go DDR3 2133 Corsair Windows 7 64 bits Pilotes GeForce 347.87 beta Catalyst 15.3 beta Page 10 - Benchmark : 3DMark Fire Strike 3DMark Fire Strike  Nous lançons le test Fire Strike avec les 3 presets proposés par Futuremark : [ Fire Strike ] [ Fire Strike Extreme ] [ Fire Strike Ultra ] La GeForce GTX Titan X affiche un score graphique en hausse de 30% par rapport à la GTX 980 et de 50 à 60% par rapport à la GTX 780 Ti. Page 11 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons le mode de qualité maximale du jeu et effectuons un déplacement sur une carte en mesurant les performances avec Fraps. Dans Anno 2070, c'est avant tout la puissance de calcul qui compte et les GPU sont mis à rude épreuve par rapport à leurs limites de consommation ou de température. De quoi permettre aux GTX 900 de se démarquer dans ce jeu qui était dominé par les Radeon sur la génération précédente. C'est également le jeu dans lequel repousser les limites de températures et de consommation apporte les plus gros gains : +11%. En 4K, la GTX Titan X accentue quelque peu s'on avance sur la R9 290X. Les systèmes bi-GPU sont par contre 30% plus performants. Page 12 - Benchmark : Batman Arkham Origins Batman Arkham Origins  Dernier opus de la série, Batman Arkham Origins est toujours basé sur l'Unreal Engine 3 mais pousse un petit peu plus loin les effets graphiques dont certains ont été implémentés sur PC en collaboration avec Nvidia. C'est le cas du TXAA et d'effets GPU PhysX réservés aux GeForce (il n'est plus possible d'activer une version CPU de tous ces effets), mais également de l'occlusion ambiante de type HBAO+, d'un effet de Depth of Field plus évolué (NVDOF), d'ombres adoucies (PCSS) et de la tessellation (pour la cape et la neige) qui sont utilisables sur tous les GPU DirectX 11. Nous utilisons le mode de qualité maximale du jeu, avec du MSAA 8x. Nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Steam. Batman Arkham Origins est bien plus dépendant de la bande passante mémoire ce qui en fait un jeu plus difficile pour les GTX 900. La GTX Titan X domine cependant facilement la Radeon R9 290X de Sapphire. En 4K et sans MSAA, les GeForce ont l'avantage sur les Radeon. Page 13 - Benchmark : Battlefield 4 Battlefield 4  Battlefield 4 repose sur le moteur Frostbite 3, une évolution de la version 2 présente dans Battlefield 3. La base du rendu reste très proche (rendu différé, calcul de l'éclairage via compute shaders) et les évolutions visibles sont mineures, DICE ayant principalement optimisé son moteur pour les consoles de nouvelle génération. Parmi les petites nouveautés, citons un support plus avancé de la tessellation et une amélioration du module "destruction" du moteur. Sur PC, un mode Mantle spécifique aux Radeon et qui permet de réduire le coût CPU du rendu est proposé mais nous ne l'avons pas utilisé pour ce test. Pour rappel, il s'agit d'une API propriétaire de plus bas niveau dédiée aux Radeon HD 7000 et supérieures, qui a été développée par AMD et DICE. Nous testons le mode Ultra soit avec MSAA 4x et nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin. Les GeForce GTX 900 apprécient particulièrement ce jeu, d'autant plus qu'il ne les pousse pas dans leurs limites de consommation et permet à leurs GPU de tourner à des fréquences élevées. La GTX Titan X est ici 40% plus performante que la GTX 980. Les GTX 980 en SLI sont ici 30% plus performantes que la GTX Titan X. Page 14 - Benchmark : Crysis 3 Crysis 3  Crysis 3 reprend le même moteur que Crysis 2 : le CryEngine 3. Ce dernier profite cependant de quelques petites évolutions telles qu'un support plus avancé de l'antialiasing : FXAA, MSAA et TXAA sont au programme, tout comme un nouveau mode appelé SMAA. Ce dernier est une évolution du MLAA qui permet, optionnellement, de prendre en compte des données de type sous-pixels soit à travers la combinaison avec du MSAA 2x, soit avec une composante temporelle calculée à partir de l'image précédente. Le SMAA 1x est la simple évolution du MLAA, le SMAA 2tx utilise une composante temporelle relativement complexe et le SMAA 4x y ajoute le MSAA 2x. Notez qu'il ne faut pas confondre le SMAA 2tx proposé en mono-GPU avec le SMAA 2x proposé en multi-GPU, ce dernier utilisant du MSAA 2x sans composante temporelle. Nous mesurons les performances avec Fraps et le jeu est maintenu à jour via Origin. Crysis 3 est un jeu très gourmand au niveau de la puissance de calcul et la GTX Titan X s'en tire également très bien avec 40% de mieux que la GTX 980 qui peine par contre à se démarquer de la GTX 780 Ti. Ici aussi les cartes bi-GPU ont un avantage important sur la GTX Titan X. Page 15 - Benchmark : Dying Light Dying Light  Dying Light est un jeu de type survival horror animé par le Chrome Engine 6 de Techland et dans lequel le monde est plutôt vaste et ouvert. Nvidia a travaillé avec Techland pour y inclure certains effets issus de ses librairies Gameworks tels que le HBAO+ et le Depth of Field. Nous avons mesuré les performances avec Fraps sur un parcours bien défini. Le jeu est maintenu à jour à travers Steam. Dying Light entraîne une charge plutôt légère sur les GPU, ce qui s'explique principalement par des micro-saccades régulières qui impactent fortement la fluidité. Elles sont présentes autant avec les Radeon qu'avec les GeForce, mais uniquement en mode plein écran. Les développeurs ont visiblement bien du mal à corriger ces petits bugs. AMD ne dispose toujours pas de profil CrossFire adapté à Dying Light. Un seul GPU est donc en action sur la R9 295X2. Page 16 - Benchmark : Evolve Evolve  Evolve, développé par Turtle Rock Studios, est basé sur le Cry Engine 3. Contrairement à ce dernier, les modes d'antialiasing à base de MSAA, extrêmement gourmands avec ce moteur, ne sont pas proposés. Un nouveau mode de SMAA a par contre été développé par Crytek et intégré dans les branches plus récentes de son moteur : le 1tx. Il s'agit d'une version quelque peu simplifiée du SMAA 2tx, antialiasing à base de composante temporelle, qui a la particularité d'être compatible avec le multi-GPU. Nous mesurons les performances à l'aide de Fraps sur un parcours bien défini et le jeu est maintenu à jour avec Steam. La Radeon R9 290X semble apprécier particulièrement ce titre, dans lequel son niveau de performances est nettement supérieur à celui observé dans Crysis 3. De quoi lui permettre de devancer la GTX 980 de référence, mais la GTX Titan X garde une avance confortable de 30%. Arrivé avec les derniers pilotes betas d'AMD, le profil CrossFire pour Evolve permet à la R9 295X2 de prendre une nette avance sur les GTX 980 en SLI. Ces deux systèmes affichent par contre une fluidité inférieure à celle de la GTX Titan X qui profite ici de sa mémoire vidéo plus importante puisque 5.1 Go sont exploités par le jeu. En multi-GPU les saccades liées au manque de mémoire se trouvent être accentuées, ce qui nuit fortement au confort de jeu. Il faudra alors réduire la taille des textures. A noter que dans ce jeu, nous sommes loin des 50-60 fps que nous visons en adaptant les paramètres graphiques. En fait, nous sommes au niveau minimum proposés par le jeu et la GTX Titan X peine à atteindre 40 fps ! Page 17 - Benchmark : Far Cry 4 Far Cry 4  Dernier opus de la série, il est basé sur une petite évolution du Dunia Engine 2 qui avait été introduit avec Far Cry 3. Ses caractéristiques sont donc similaires et parmi les petites évolutions nous notons l'ajout par les développeurs du support de l'antialiasing SMAA 1x en plus du MSAA qui est très, voire trop, gourmand avec ce moteur. Nous activons le niveau de qualité Ultra, qui inclut le SMAA 1x et utilisons Fraps sur un parcours bien défini. La Radeon R9 290X s'en tire également assez bien dans ce jeu et égale la GTX 980 de référence. La GTX Titan X est 32% plus performante. Les Radeon semblent mieux encaisser la montée en résolution dans ce jeu. Page 18 - Benchmark : GRID 2 GRID 2  Dernier né chez Codemaster, GRID 2 reprend une évolution légère du moteur DirectX 11 maison exploité par DiRT Showdown. Pour rappel, en partenariat avec AMD, les développeurs avaient mis en place un éclairage avancé qui prend en compte de nombreuses sources de lumières directes et indirectes ainsi qu'une approximation du rendu de type illumination globale. Ces techniques sont toujours exploitées, même si le partenaire principal de Codemaster est cette fois Intel qui a aidé à la mise en place d'optimisations spécifiques aux GPU intégrés à Haswell. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum, y compris l'adoucissement de l'effet d'occlusion ambiante, et activons le MSAA 8x. Nous utilisons Fraps sur l'environnement de Barcelone, le plus lourd dans le jeu. La GTX Titan X est plutôt à l'aise dans ce jeu et affiche une avance de 39% sur la GTX 980. CrossFire apporte ici un gain plus important que le SLI, ce qui permet à la R9 295X2 de devancer la paire de GTX 980. Page 19 - Benchmark : Hitman Absolution Hitman Absolution  Hitman Absolution utilise un moteur plutôt lourd et qui manque probablement d'optimisations. La charge CPU est par ailleurs relativement élevée dans certaines scènes dans lesquelles une foule importante peut être animée. Différents effets DirectX 11 ont été intégrés avec la coopération d'AMD. Pour mesurer les performances, nous poussons les options graphiques au niveau ultra et utilisons fraps dans le jeu. Hitman Absolution est le jeu testé dans lequel les GeForce GTX 900 souffrent le plus, la bande passante mémoire étant un aspect primordial des performances. La GTX Titan X n'y est donc "que" 18% plus performante que la R9 290X de Sapphire. Son avance est par contre dans la moyenne par rapport à la GTX 980 : +35%. Ici aussi, CrossFire apporte un plus gros gain. Page 20 - Benchmark : Metro Last Light blockquote>Metro Last Light  Tout comme Metro 2033, sa suite Last Light développée par 4A Games est très gourmande. Elle repose sur une petite évolution du moteur DirectX 11 maison, le 4A Engine, ainsi que sur des environnements et éclairages plus riches. Le jeu pousse par ailleurs plus loin l'utilisation de la tessellation, mise en place en collaboration avec Nvidia, autant sur les personnages que sur les objets ou les sols, même si dans bien des cas la différence n'est cependant pas transcendante. Au niveau de l'antialiasing, le 4A Engine support l'AAA, un algorithme maison similaire au FXAA/MLAA/SMAA, ainsi que le SSAA extrêmement gourmand en mode 2x, 3x et 4x. Un mode 0.5x est également proposé et consiste alors à rendre le jeu dans une résolution inférieur qui est par la suite étendue. Le support de GPU PhysX est toujours de la partie. A ne pas confondre avec PhysX, qui gère globalement la physique au niveau du CPU, il s'agit d'effets accélérés par le GPU à travers une librairie propriétaire de Nvidia, ce qui implique qu'ils ne peuvent pas être accélérés sur une Radeon. Ils sont alors traités par le CPU, d'une manière non-optimisée, ce qui rend leur utilisation difficile en pratique. Nous avons testé le jeu via Fraps sur un parcours bien défini. Nous avons fait l'impasse sur le SSAA, bien trop gourmand. C'est dans ce jeu que la GTX Titan X affiche le gain le plus faible par rapport à la GTX 980, +26%. Nous ne savons pas ce qui limite ici ses performances, d'autant plus qu'il s'agit d'un jeu qui avantage en général les GeForce. La R9 290X rattrape en 4K une partie du retard mesuré en 1440p. Cela reste par contre insuffisant pour inquiéter une GTX 980. Page 21 - Benchmark : Splinter Cell Blacklist Splinter Cell Blacklist  Basé sur le LEAD engine, une version retravaillée en interne de l'Unreal Engine 2.5, Splinter Cell Blacklist profite pour la version PC d'effets graphiques supplémentaires mis en place en collaboration avec Nvidia tels que le HBAO+, la tessellation ou encore le TXAA. Notez au niveau de l'occlusion ambiante que le jeu propose de nombreuses options dont les plus avancées représentent l'effet le plus lourd du jeu. Nous mesurons les performances avec Fraps sur un parcours bien défini et le jeu est maintenu à jour via Uplay. Dans Splinter Cell, en partie dépendant de la bande passante mémoire avec MSAA 4x, la GTX Titan X affiche un gain de 36% sur la GTX 980. CrossFire affiche un gain plus important que le SLI dans ce jeu. Page 22 - Benchmark : Tomb Raider Tomb Raider  Tomb Raider a été l'une des meilleures surprises de 2013. Le rendu graphique est plutôt réussi, AMD ayant collaboré avec les développeurs pour s'assurer d'une version PC de bon niveau. C'est particulièrement le cas pour TressFX, l'option de rendu avancé des cheveux de Lara qui apporte une bonne dose de réalisme. Nous avons testé Tomb Raider en mode de qualité Ultime+ qui inclut l'effet TressFX et le niveau de qualité maximal pour les ombres. Nous avons mesuré les performances avec Fraps, sans utiliser le bench intégré qui correspond plus aux cinématiques qu'aux scènes de jeu classiques. Si la Radeon R9 290X s'en tire plutôt bien face à la GTX 780 Ti dans ce jeu, c'est également le cas de la GTX Titan X qui la devance de 46%. La Radeon R9 290X se positionne légèrement mieux en 4K qu'en 1440p. Page 23 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 à la GeForce GTX 980 de référence : La GeForce GTX Titan X affiche en moyenne un gain de 35% par rapport à la GTX 980, un gain sans réelle surprise par rapport aux spécifications de ces cartes. Repousser les limites de consommation et de température GPU permet de grappiller 2.8% de plus, c'est moins que pour la GTX 980 qui gagne 6.5%, mais cela peut être une particularité spécifique aux échantillons que nous avons testés. Par rapport à une GTX 980 personnalisées, telle que la G1 Gaming de Gigabyte, qui est l'une des plus performantes, l'avance de la GTX Titan X de référence chute à 21%. A l'inverse, par rapport à une GTX 780 Ti, dont les performances sont proches de celles de la GTX Titan Black, le nouveau haut de gamme de Nvidia fait un bond en avant d'exactement 50%. Pour pouvoir lutter face à cette GTX Titan X avec le futur GPU Fiji, c'est un gain de performances de 40% qui sera nécessaire à AMD par rapport à la Radeon R9 290X Tri-X OC de Sapphire, qui est capable de maintenir des fréquences élevées en permanence comme devrait le faire également la Radeon R9 390X que les rumeurs annoncent équipée d'un système de watercooling AIO. Et voici ce que cela donne en 4K : La GTX Titan X affiche un gain moyen identique à celui observé en 1440p par rapport à la GTX 980 de référence. En fait ce sont toutes les cartes mono-GPU qui se comportent globalement de la même manière en 4K avec qualité quelque peu réduite qu'en 1440p avec qualité très élevée. Les systèmes bi-GPU prennent la tête comme prévu avec une R9 295X2 qui égale les GTX 980 de référence en SLI. Cela s'explique principalement par le fait que cette Radeon, grâce au TDP autorisé par un système de watercooling, se comporte en fait plus comme une paire de cartes personnalisées que comme une paire de cartes de référence. Si ces systèmes affichent des résultats moyens similaires, d'un jeu à l'autre il peut y avoir d'énormes différences. La R9 295X2 a d'ailleurs l'avantage dans 6 des jeux testés et les GTX 980 en SLI la devancent dans les 6 autres. Si nous comparons ces GTX 980 en SLI à la GTX Titan X, elles ont une avance moyenne de 25%, qui varie entre 11 et 35% suivant les jeux. Excepté dans Evolve, nous n'avons pas noté de réel souci de fluidité avec les GTX 980 en SLI, leur avance sur le plan des performances compensant plutôt bien l'avantage d'un gros GPU sur ce point. Page 24 - Overclocking : GM200 et GTX Titan X Overclocking : GM200 et GTX Titan XAvant d'observer les capacités d'overclocking directes de la GTX Titan X, nous avons voulu nous pencher de plus près sur l'influence de l'overclocking du GPU et de la mémoire sur les performances du GPU GM200. Est-il plutôt limité par sa puissance de calcul ou par sa bande passante mémoire ? Pour cela nous sommes partis de fréquences de 1100 MHz pour le GPU et de 1750 MHz pour la mémoire, ce qui correspond à peu près aux fréquences relevées dans les jeux avec notre échantillon de GTX Titan X. Nous avons ensuite poussé ces valeurs dans chaque cas de 18%, soit 1300 MHz et 2070 MHz : [ % ] [ FPS ] Dans le cas d'Anno 2070 par exemple, seule la fréquence GPU compte, les gains liés à l'overclocking de la mémoire étant minimes. Etrangement par contre, dans les deux jeux très dépendants de la bande passante mémoire, Battlefield 4 avec MSAA 4x et surtout Hitman Absolution, l'overclocking seul de la mémoire n'apporte qu'un petit gain alors qu'il explose lorsque le GPU est également overclocké. Nous avons l'impression que le GM200, et peut être les autres GPU Maxwell, a besoin d'une fréquence GPU suffisante pour pouvoir exploiter de la GDDR5 hautement cadencée, mais plus de tests seront nécessaires pour nous en assurer. Overclocking de la GTX Titan XComme toutes les cartes graphiques, la GeForce GTX Titan X peut être overclockée. Elle reprend pour cela les mêmes interfaces que pour les GeForce GTX 700 et 900. Il est donc possible de modifier manuellement : - la fréquence GPU - la fréquence mémoire - la tension GPU maximale - la limite de température - la limite de consommation La limite de température déjà relevée quelque peu par Nvidia à 83 °C, par rapport aux 80 °C des GTX 900, est un élément qui peut être relevé pour gagner quelques points de performances. En contrepartie cela augmente la vitesse de ventilation et donc les nuisances sonores. A noter que si la limite est poussée à 91 °C, une fois celle-ci atteinte, le ou les ventilateurs montent instantanément à 100% et reviennent à un niveau normal dès que la température GPU a chuté de quelques degrés. En pratique il est cependant difficile d'atteindre une telle température avec la courbe de ventilation utilisée par Nvidia qui accélère très vite au-delà de 83 °C. Même avec les charges les plus lourdes, elle ne dépasse pas 85 voire 86 °C. La fonction d'overvoltage (OV) ou d'augmentation de la tension GPU reste similaire à ce que nous avons pu observer sur les GTX 700 si ce n'est que la plage semble être un peu plus élevée. Il ne s'agit pas d'une augmentation directe de la tension ni d'un offset comme sur les Radeon mais bien d'un allongement de la courbe des tensions/fréquences. Par défaut, la courbe ne peut aller au-delà de 1.174V, ce qui est plus faible que les 1.212V des autres GPU Maxwell mais l'OV la prolonge jusqu'à 1.237V, de quoi gagner 39 MHz sur notre échantillon quand les limites de consommation et de température ne sont pas atteintes. Lorsqu'elles le sont l'OV n'a aucun impact. A noter que l'algorithme GPU Boost bloque l'accès aux derniers points de la courbe de tensions/fréquences lorsque certaines conditions sont rencontrées. Nous n'avons pas encore pu les déterminer précisément mais elles semblent liées à la charge et à la température GPU, même quand les limites à ce niveau ne sont pas atteintes. Voici ce que nous avons observé sur notre échantillon de GTX Titan X avec une charge relativement lourde, mais inférieure à la limite : Sans OV : Si tGPU < 63°C : 1190 MHz @ 1.174V Si tGPU > 63°C : 1177 MHz @ 1.162V Si tGPU > 73°C : 1164 MHz @ 1.149V Si tGPU > 80°C : 1152 MHz @ 1.137V Avec OV : Si tGPU < 63°C : 1228 MHz @ 1.237V Si tGPU > 63°C : 1215 MHz @ 1.218V Si tGPU > 80°C : 1202 MHz @ 1.193V Augmenter la fréquence GPU sur GTX 900, tout comme sur les GTX 600 et 700, revient à appliquer un offset. C'est-à-dire que la fréquence est relevée sur tous les points de la courbe utilisée par GPU Boost. Vu sous un autre angle, cet offset revient à réduire la tension GPU appliquée à chaque niveau de fréquence. Ainsi, même si votre carte se retrouve limitée par sa température ou sa consommation et n'atteint pas sa fréquence maximale, l'overclocking GPU reste utile ! A noter que nous testons la stabilité d'un overclocking à différents niveaux de charge de manière à vérifier cette stabilité à différents points de la courbe des fréquences/tensions. Pour l'overclocking de la GTX Titan X, nous avons activé l'OV. Voici l'overclocking GPU que nous avons pu obtenir, en évoluant par pas de 26 MHz pour nous adapter aux étapes de 13 MHz de la courbe de fréquences mise en place par Nvidia : +208 MHz -> max 1436 MHz @ 1.237V. Atteindre 1.5 GHz semble difficile pour le GPU GM200, mais 1.4 GHz est déjà un très bon résultat. Difficile par contre pour la carte de référence de maintenir cette fréquence maximale puisque la température GPU atteint rapidement des paliers qui la font chuter de quelques crans. Au niveau de la mémoire, nous avons également cherché l'overclocking maximum en évoluant par pas de 25 MHz en fréquence réelle soit par pas de 50 MHz au niveau de la fréquence affichée par Afterburner : +"650" MHz -> 2075 MHz Voici les gains de performances que nous avons pu observer en appliquant l'OV, l'overclocking et en poussant alors les limites de consommation / température à leur maximum. Nous avons également intégrés les gains obtenus dans ce que nous appelons le mode 'Uber', ce qui se consiste simplement à pousser les limites de consommation / température à leur maximum. [ FPS ] [ % ] Pousser les limites permet de gagner 11% dans Anno 2070, mais ne change presque rien dans Battlefield 4 qui est moins lourd et flirte avec la limite de température par défaut. L'overclocking permet de gagner 12% de plus dans Anno 2070 et 18% de plus dans Battlefield 4 pour porter les gains totaux à 24% et 19%. Rappelons cependant, si cela était nécessaire, que l'overclocking est une loterie. Quel impact sur la consommation ?Nous avons mesuré la consommation sous Anno 2070 et Battlefield 4 avant et après overclocking. Attention, contrairement aux mesures de performances ci-dessus, notre protocole de mesure de la consommation se fait en 1080p, ce qui réduit légèrement la charge (~5%) compte tenu du haut niveau de fps atteint avec la GTX Titan X : [ watts ] [ % ] Repousser les limites de consommation et de températures fait grimper la consommation de 12% sous Anno 2070. En y ajoutant l'overclocking et l'OV, la hausse totale est de 25% sous Anno et de 28% sous Battlefield 4. Page 25 - Conclusion ConclusionAvec la GeForce GTX Titan X, Nvidia revient sur le segment à 1000$ qui a su trouver son public parmi les joueurs avec les premières GTX Titan. Cela reste une niche bien sûr, mais elle existe et pour faire l'acquisition de ce qui se fait de mieux en cartes graphiques, certains sont prêts à mettre le prix. Mais pas n'importe quel prix non plus, l'échec de la GTX Titan Z bi-GPU à 3000$ en témoigne. Ceci a probablement tempéré les ambitions inflationnistes du fabricant, d'autant que cette fois l'argument du GPGPU en double précision ne peut être avancé. A ce tarif, Nvidia propose son design de référence à la finition irréprochable et paré d'une jolie robe noire pour l'occasion. La GeForce GTX Titan X profite bien entendu de l'énorme GPU GM200 pour proposer les meilleures performances du moment avec 35% de mieux que la GTX 980 de référence. De quoi pouvoir jouer plus que confortablement en 1440p ou faire moins de compromis en 4K, sans devoir passer par le multi-GPU et ses effets indésirables. Et ce niveau de performances pourra être intégré dans à peu près n'importe quel boîtier, même compact, grâce au système de refroidissement à base de turbine qui expulse l'air chaud vers l'extérieur. Par rapport à une GTX 980 custom l'écart se réduit par contre à 20%, mais la GTX Titan X peut reprendre de l'avance via une marge importante côté overclocking.  Nvidia a par ailleurs équipé son nouveau ultra haut de gamme de 12 Go de mémoire GDDR5. De quoi voir venir et assurer un fonctionnement sans accrocs pour les jeux les plus lourds rendus dans des résolutions extrêmes, 4K, 5K ou surround, avec des systèmes équipés de 2, 3 ou 4 GTX Titan X. Pour le commun des mortels, celui qui doit se contenter d'une seule GTX Titan X avec un niveau de qualité adapté, ces 12 Go n'auront par contre à peu près aucune utilité. Si le budget de 1000$ ne vous fait pas peur, reste encore à savoir si se précipiter chez son revendeur est une bonne idée. Vu la chute de l'euro, il faudra probablement compter 1150 à 1200 € en France, c'est encore plus que les premières GTX Titan qui se retrouvaient chez nous sous cette barre des 1000 €. Par ailleurs, la disponibilité de la GTX Titan X ne sera pas immédiate. Elle est prévue pour la fin du mois, tout du moins en Europe, et seules des précommandes seront proposées dès demain. Face à ce budget conséquent, il faut évidemment prendre en compte le fait que la concurrence va également lancer un nouveau ultra haut de gamme que nous attendons dans le courant du printemps ou au début de l'été. Et Nvidia devrait y répondre très rapidement en proposant un dérivé un petit peu plus abordable du GM200 qui devrait être la GTX 980 Ti 6 Go. Si le budget n'est pas un problème et que vous ne jurez que par Nvidia, il sera difficile d'être déçu par cette GTX Titan X. Pour les autres, nous vous conseillerons plutôt de conserver vos deux reins pour l'instant, de patienter raisonnablement quelques semaines ou quelques mois, le temps d'avoir toutes les cartes en main pour faire votre choix. Ces nouveaux GPU GM200 et Fiji viendront dans tous les cas conclure l'aventure des GPU en 28nm débutée il y a un peu plus de 3 ans avec les GPU Tahiti puis GK104 d'une très belle manière, les performances ayant plus que doublé dans l'intervalle. Une prouesse qui nous rend encore plus impatients de voir ce que les ingénieurs pourront faire l'an prochain une fois qu'ils auront accès au 16nm et au 14nm ! Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |