| |

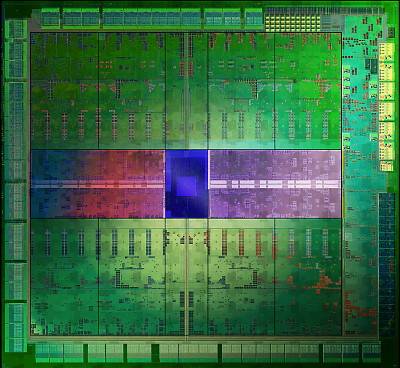

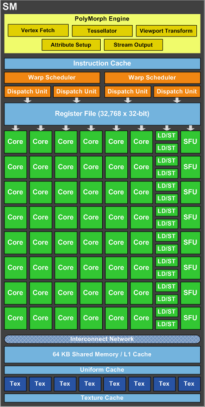

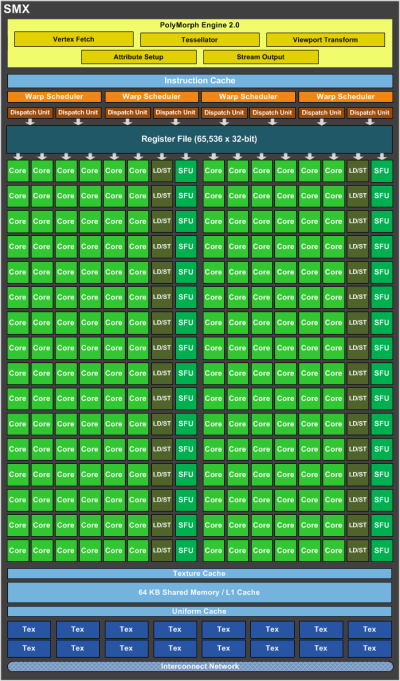

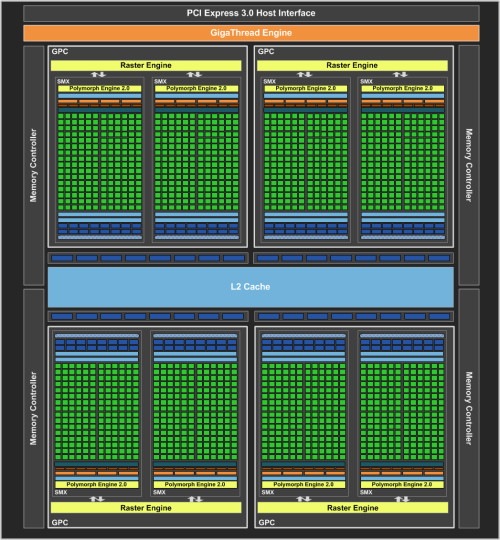

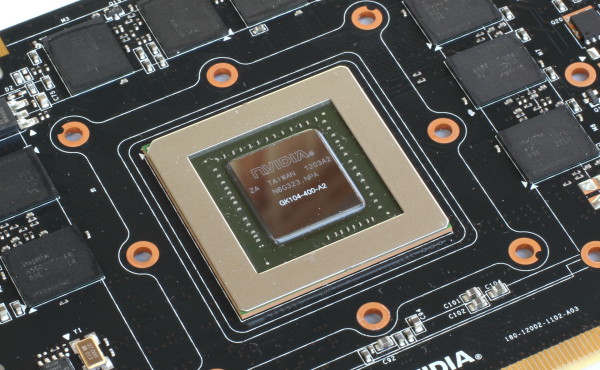

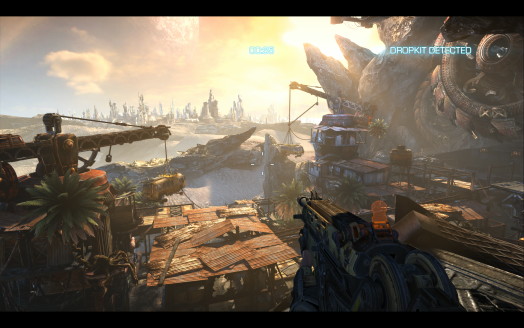

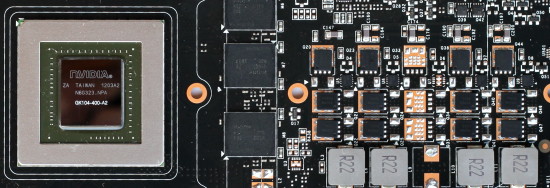

| Nvidia GeForce GTX 680 en test Cartes Graphiques Publié le Jeudi 22 Mars 2012 par Damien Triolet URL: /articles/857-1/nvidia-geforce-gtx-680-test.html Page 1 - Introduction Après 3 mois d'une domination des Radeon, Nvidia se devait de réagir ! C'est maintenant chose faite avec la GeForce GTX 680 qui introduit le premier GPU de la génération Kepler et entend bien surpasser la Radeon HD 7970… sans faire exploser le wattmètre.  GK100 ? GK104 ? GK110 ? Où est le gros GPU ?Sauf exception, AMD et Nvidia ont pour habitude de toujours lancer en premier lieu le plus gros GPU d'une nouvelle famille, qui fait alors office de porte étendard pour le reste de la gamme. Ce lancement est l'occasion d'une de ces exceptions. Nous ne connaîtrons probablement jamais les raisons exactes, Nvidia n'ayant pas pour habitude de parler de produits non annoncés qui ont été annulés ou retardés, mais de toute évidence un problème a fait que le concepteur des GeForce a dû revoir ses plans initiaux et annuler ou repousser la sortie du gros GPU de la famille Kepler, qui devrait voir le jour sous le nom de code GK110 plus tard dans l'année. Nous supposons que Nvidia a fait preuve de pragmatisme en essayant d'éviter les erreurs de la génération Fermi dont la commercialisation du plus gros GPU, le GF100, avait posé de nombreux problèmes. Si le gros GPU posait problème, il valait mieux se focaliser sur un plus petit GPU, d'autant plus quand celui-ci était très prometteur. C'est donc sur le GK104 que Nvidia a décidé de se focaliser en premier lieu, le successeur du GF114 des GeForce GTX 560 Ti.  Le GK104 et ses 3.5 milliards de transistors. De quoi ruiner ses ambitions de leader en termes de performances ? C'est probablement ce qu'a pensé Nvidia au départ, mais après avoir observé les performances de la Radeon HD 7970, il est apparu que celles-ci, bien que très performantes, ne proposaient pas un bond si important que cela par rapport à la génération passée, AMD ayant investi beaucoup de ressources pour poser les bases d'une architecture orientée vers le futur, notamment au niveau du GPU Computing. Elles n'étaient pas hors de portée du "petit" GK104, pensé uniquement pour offrir une efficacité optimale dans les jeux vidéo. Nvidia a alors travaillé d'arrache-pied pour pouvoir proposer une GeForce GTX 680 basée sur une version complète et cadencée à une fréquence élevée de ce GPU. Avec un effort supplémentaire sur l'optimisation des pilotes, la Radeon HD 7970 n'aurait qu'à bien se tenir. Un match serré en perspective ! Mise à jour du 23/11/2012: Contrairement à ce que nous écrivions initialement, la GeForce GTX 680 et le GPU Kepler GK104 (ainsi que ses dérivés GK107 et GK106) ne supportent pas complètement DirectX 11.1. Nvidia a brouillé les pistes en jouant de la confusion entre l'API DirectX 11.1, qui est rétrocompatible avec des fonctionnalités limitées pour les GPU DirectX 11, DirectX 10 et DirectX 9, et le niveau de fonctionnalité 11.1 qui n'est accessible qu'aux GPU qui le supportent. Tout comme une carte graphique DirectX 9, la GeForce GTX 680 est supportée par l'API DirectX 11.1, mais son niveau 11.1 n'est pas pris en charge. Seules les Radeon HD 7700, 7800 et 7900 en sont capables. Nous avons corrigé ce dossier pour prendre en compte cette nouvelle information. Vous pourrez retrouver plus de détails à ce sujet dans notre dossier consacré à DirectX 11.1. Page 2 - GK104 : Fermi au régime GK104 : Fermi au régimePour la génération Kepler, Nvidia n'est pas reparti de zéro, la génération Fermi ayant posé de bonnes bases, faites pour durer. Kepler est ainsi une petite évolution de l'architecture Fermi qui a pour but d'en corriger le gros point noir : le rendement énergétique plutôt faiblard. N'y cherchez pas un but écolo, mais simplement un moyen d'éviter de foncer droit dans le mur puisque conserver l'architecture Fermi en passant à une fabrication en 28 nanomètres n'aurait pas permis d'en profiter pleinement. La consommation excessive aurait été un frein à la complexification du GPU. Alors que Nvidia compare dans toutes ses documentations techniques l'architecture du GK104 à celle du GF100/110, cela n'a aucun sens en dehors de brouiller les pistes. Avec le GF104/114, introduit dans la GeForce GTX 460, Nvidia a proposé une variante de son architecture Fermi optimisée pour un meilleur rendement en jeu, là où le gros GPU visait un compromis laissant plus de place au GPU Computing. Pour rappel, vous pouvez retrouver notre description des différences par ici. C'est bien entendu à cette architecture du GF1x4 qu'il faut comparer celle du GK104 de manière à bien en saisir les évolutions. Les GPU Nvidia se basent sur des blocs fondamentaux appelés SM pour Streaming Multiprocessors. Ces SM contiennent un certain nombre d'unités de calcul et de texturing, du cache et de la logique de gestion. Chaque groupe de 4 SM forme un GPC, Graphics Processing Cluster, et dispose de son propre rasterizer, ce qui permet de traiter efficacement les petits triangles. Avec le GK104, le SM évolue et prend le nom de SMX. Voici une représentation de l'évolution du SM du GF1x4, à gauche, vers le SMX du GK104, à droite :   La taille du SMX explose ! Il passe de 48 unités de calcul principales et de 8 unités de texturing à 192 unités de calcul et 16 unités de texturing. Un changement radical ? Pas vraiment si nous y regardons de plus près. Nvidia introduit avec le SMX une première optimisation énergétique : l'abandon de la fréquence double pour les unités de calcul. Introduit avec le G80 et les GeForce 8800 GTX, le fonctionnement des unités de calcul à une fréquence double a permis à Nvidia de faire beaucoup en termes de performances avec relativement peu d'unités de calcul. Malheureusement cette approche a un coût, avec en besoin d'énergie plus important pour les unités elles-mêmes ainsi que pour la distribution du signal d'horloge. En passant au 28 nanomètres, Nvidia est moins limité par la surface qu'occupent les unités que par l'énergie nécessaire pour les animer. Ce compromis fait précédemment n'a donc plus de sens et le GK104 abandonne cette double fréquence et double l'ensemble des unités de calculpour compenser, y compris les SFU qui traitent les opérations spéciales (mais pas les unités chargées du calcul en double précision qui chute donc à un débit équivalent à 1/24ème de la simple précision). Voilà qui explique la moitié de l'évolution du SM vers le SMX. Pour la seconde, il faut en réalité voir le SMX comme deux SM collés l'un à l'autre de manière à partager un même cache L1 pour réduire le coût de ce dernier qui n'est pas très utile dans les jeux puisque les unités de texturing disposent de leurs propres caches dédiés. Rappelons qu'une partie de ce cache L1 fait office de mémoire partagée qui permet à différents éléments traités en parallèle de communiquer lors de l'utilisation du GPU Computing. Les GPU Fermi pouvaient répartir leur cache de 64 Ko entre une partie cache L1 de 16 ou 48 Ko et une partie mémoire partagée de 48 ou 16 Ko. Pour le GK104 un mode 32 Ko / 32 Ko est possible, ce qui permet de s'aligner plus efficacement sur les spécifications de DirectX 11. Par ailleurs, la bande passante offerte par ce cache a été doublée de manière pour éviter de créer une trop forte limitation. Chaque moitié de SMX est, en dehors du cache, indépendante l'une de l'autre. Ainsi, les 2 premiers schedulers ne peuvent accéder qu'à la première moitié des unités d'exécution et les 2 autres à la seconde. Tout comme pour le GF1x4, il s'agit d'une architecture superscalaire, puisque pour maximiser l'utilisation des unités de calcul, au moins 50% des instructions mathématiques doivent pouvoir s'exécuter par paire pour un warp donné (groupe de 32 éléments à traiter). Nous ne sommes donc pas en présence d'une architecture au comportement perçu strictement scalaire, mais le travail du compilateur reste relativement simple. Chaque scheduler dispose de ses propres registres (4096 x 32 bits) et de son propre groupe de 4 unités de texturing (chacun disposant d'un petit cache dédié) et peut initier l'exécution de 2 opérations par cycle. Il doit cependant partager les ressources à ce niveau avec un second scheduler : - unité SIMD0 32-way (les « cores ») : 32 FMA FP32 ou 4 FMA FP64 - unité SIMD1 32-way (les « cores ») : 32 FMA FP32 - unité SIMD2 32-way (les « cores ») : 32 FMA FP32 - unité SFU 16-way : 16 fonctions spéciales FP32 ou 32 interpolations - unité Load/Store 16-way 64 bits Notez que ce dernier point n'est pas très clair. Nvidia indique que la capacité en Load/Store d'un SMX n'évolue pas lorsqu'il s'agit de transactions 32 bits par rapport au SM Fermi, mais qu'elle est doublée en 64 bits. Nous supposons donc que le diagramme, qui est une simplification d'une architecture très complexe, est en partie erroné et qu'en réalité les 2 moitiés du SMX se partagent ces ressources. Charger ou écrire des données de 64 bits se fait par contre sans coût supplémentaire par rapport au 32 bits, Nvidia précisant que ce premier type d'accès est plus souvent un facteur limitant que le second. Nous en arrivons à la seconde évolution destinée à réduire l'empreinte énergétique de l'architecture. Les schedulers de Fermi font appel au scoreboarding pour vérifier à chaque instant quels registres sont en cours d'utilisation (et donc possiblement de modification) de manière à déterminer quelle instruction peut être initiée sur quel groupe de données. Kepler conserve ce mode de fonctionnement, important lorsque certaines opérations affichent une latence très importante, mais n'y a plus recours lorsque ce n'est pas nécessaire. L'exécution des instructions mathématique est parfaitement déterministe, leurs débits et leurs latences sont fixes. Il est dès lors possible pour le compilateur de prédire leur comportement exact et de le notifier dans le flux d'instructions de manière à ne plus faire appel à la logique complexe d'ordonnancement pour le traitement de séquences d'instructions à l'intérieur d'un même groupe de donnée. C'est ce que fait Kepler qui n'y a recours que pour les instructions à latence indéterminée (texturing, load, store) ainsi que pour déterminer sur quel groupe de données travailler. Une approche qui permet de réduire l'énergie consommée pour alimenter les unités de calcul. Notez enfin que le SMX étant grossièrement un assemblage de deux SM, le débit en terme de pixels et de triangles d'un SMX est égal ou double de celui d'un SM, soit un triangle (=un vertex fetch) tous les deux cycle et 4 pixels simples (32bits) par cycle. Page 3 - GK104 : GF114 x2 GK104 : GF114 x2Il était important d'introduire en premier lieu les évolutions mises en place au niveau des blocs d'unités de calcul du GK104 de manière à bien saisir à quoi correspond son organisation globale qui englobe pas moins de 1536 unités de calcul ! Un bond énorme par rapport aux 512 unités de calcul du GF1x0 et aux 384 du GF1x4. Il faut cependant prendre en compte la perte de leur double fréquence, ce qui consiste malgré tout alors à un doublement de l'ensemble des unités de calcul et de texturing par rapport à ce dernier GPU !  Le GK104 dispose de 8 SMX répartis dans 4 GPC mais se contente par contre d'un bus mémoire de 256 bits. Grossièrement ce GPU reprend le sous-système mémoire du GF114 mais double le nombre d'unités d'exécution et présente les débits en termes de triangles et de pixels du GF110. Un équilibre relativement intéressant mais qui laisse entrevoir des limitations au niveau du GPU computing et un manque de bande passante mémoire pour assurer de bonnes performances avec un niveau élevé de MSAA. Pour compenser cela, Nvidia a doublé la bande passante de son cache L2 de 512 Ko (elle passe à 512 octets par cycle) et travaillé en profondeur son contrôleur mémoire GDDR5. Alors qu'il peinait à monter en fréquence sur la génération Fermi, ce n'est plus le cas sur Kepler et la GeForce GTX 680 exploite une mémoire cadencée à 1.5 GHz (6 Gbps). Notez que le GK104 dispose de 32 ROP, ce qui correspond à son débit de pixel, contrairement aux GPU Fermi qui étaient bridés par le débit plus faible en pixels de leurs SM. Kepler est également capable de faire transiter à pleine vitesse entre les SMX et les ROP les pixels au format FP10 ou RGB9E5 qui permettent de compresser les données HDR en 32 bits. La capacité des ROP en terme de blending est par contre inchangée.  Le GK104, commercialisé en version A2. Procédé de fabrication 28nm oblige, la fréquence du GPU progresse significativement pour atteindre 1 GHz ou plutôt 1006 MHz voire plus étant donné la présence d'un mode turbo. Avec 3.5 milliards de transistors, le GK104 se content d'une surface de 294 mm², ce qui est plus petit que Tahiti (4.3 milliards de transistors et 352mm²) et que le GF114 (1.95 milliards de transistors et 367 mm²), ce dernier étant fabriqué en 40 nanomètres. Nvidia a fait l'impasse sur le support de Direct3D 11.1 mais a intégré le support du PCI Express 3.0 et a revu complètement son moteur d'affichage. Il supporte dorénavant le HDMI 1.4a 3 GHz, pour la 3D 1080p 60 Hz et le 4k, et plus important la gestion simultanée de jusqu'à 4 sorties vidéo ! L'avantage d'AMD avec Eyefinity se réduit donc drastiquement, d'autant plus que la GeForce GTX 680 peut piloter directement deux sorties DVI et une sortie HDMI, sans devoir passer par une sortie DisplayPort avec un écran natif ou un adaptateur actif.  Le multi-écrans selon Nvidia : 3 + 1. Par ailleurs, la GK104 intègre NVENC, un encodeur H.264 fixe qui permet de réduire la consommation par rapport à l'utilisation des unités de calcul du GPU pour traiter l'encodage. Il s'agit d'un moteur similaire à celui proposé par AMD avec le Video Codec Engine sur les Radeon HD 7000, mais Nvidia annonce des performances nettement supérieures : jusqu'à 240 fps en 1080p. Il sera intéressant de vérifier cela en pratique, ainsi que la qualité que NVENC peut atteindre. Page 4 - GPU Boost : le turbo non déterministe GPU Boost  La GeForce GTX 680 est la première carte graphique à proposer un mode turbo, qui permet de monter en fréquence dans les cas où la consommation reste en deçà d'une enveloppe définie. La GeForce GTX 680 est la première carte graphique à proposer un mode turbo, qui permet de monter en fréquence dans les cas où la consommation reste en deçà d'une enveloppe définie.L'approche de Nvidia est cependant différente de ce qui se fait dans le monde du CPU ou encore par AMD avec PowerTune. Les CPU et les Radeon disposent d'une unité capable d'estimer leur niveau de consommation en mettant en relation le taux d'utilisation de leurs différents blocs avec une table de données. Cette table de donnée est fixe pour chaque modèle et déterminée d'une manière conservatrice sur base d'un échantillon de peu économe, par exemple parce qu'il souffre de courants de fuite élevés. En pratique, ces composants surestiment avec une marge plus ou moins élevée leur consommation, mais tous les échantillons d'un même modèle affichent des performances identiques. Le GK104 ne dispose pas d'un tel mécanisme. Nvidia reprend donc les petits circuits introduits sur le PCB des GeForce GTX 500 pour mesurer l'intensité directement au niveau des sources d'alimentation 12V. Ces données sont reportées au pilote qui peut agir en connaissant la consommation réelle de la carte. Contrairement aux GeForce GTX 500, à l'exception de la GTX 590, ce monitoring de la consommation est actif en permanence. Il gagne également en finesse ce qui lui permet de faire varier la fréquence GPU tous les 100ms, autant à la baisse qu'à la hausse et par pas de 13 MHz, tout en adaptant la tension. Si le niveau de consommation dépasse un certain seuil, la fréquence sera réduite progressivement, à l'inverse s'il est plutôt faible, le GPU pourra monter quelque peu en fréquence. Cette approche n'est cependant pas déterministe. Suivant la qualité de l'échantillon du GPU, sa température, le rendement de son étage d'alimentation, la consommation va varier et donc la fréquence à laquelle le GPU fonctionne. Nous en arrivons là au point qui nous ennuie : Nvidia refuse de quantifier cette variation et prétend ne pas savoir. Par ailleurs, Nvidia refuse de donner la vraie limite de fréquence pour GPU Boost et se contente de parler pour la GeForce GTX 680 d'une fréquence GPU Boost de 1058 MHz définie comme étant une fréquence que toutes les cartes pourront au moins atteindre dans au moins quelques cas. En précisant que ses ingénieurs ont cependant observé des fréquences souvent supérieures en labo. En d'autres termes, chez Nvidia les ingénieurs ne fixent pas des spécifications mais observent la magie de la fréquence qui monte toute seule ! D'après nos observations, la fréquence maximale de GPU Boost est de 1110 MHz à comparer aux 1006 MHz de base, soit 8 bin de 13 MHz. Le dernier bin de 13 MHz est par contre plus difficile à atteindre une fois que le GPU est à température. La plupart des jeux testés ont profité sur notre exemplaire d'une fréquence de 1097 MHz. Enfin, notez que GPU Boost utilise une valeur inférieure au TDP comme consommation cible. Ainsi alors que le TDP de la GeForce GTX 680 est de 195W, GPU Boost se limite à 170W pour laisser le GPU monter en fréquence. Par contre il ne réduit pas la fréquence tant que le TDP n'est pas atteint.  Nvidia a travaillé avec l'auteur de Rivatuner de manière à pouvoir exposer le fonctionnement de GPU Boost, à permettre de modifier la valeur de consommation visée ainsi qu'à autoriser l'overclocking. Precision X d'EVGA, mais d'autres vont suivre, est ainsi déjà complètement fonctionnel. La valeur visée par GPU Boost est exprimée en tant que consommation de 100%, le TDP correspondant à 115%. Il est possible de faire varier cette limite entre 71 et 132%, ce qui correspond pour la GTX 680 à une plage de 121 à 224W. Augmenter cette valeur cible permet de maximiser l'utilisation de GPU Boost, mais est également nécessaire pour profiter de l'overclocking. A ce sujet notez qu'il n'est pas possible de désactiver directement GPU Boost ni d'en modifier le comportement. Si vous augmenter la fréquence de base du GPU de 1006 à 1106 MHz, GPU Boost conservera la même marge manoeuvre : 8 bins de 13 MHz. Page 5 - Spécifications, GeForce GTX 680 de référence Spécifications  Par rapport à la GeForce GTX 580, la GeForce GTX 680 double la puissance de calcul et augmente encore plus la puissance de texturing. Elle se contente par contre d'une bande passante mémoire identique. Sur le papier tout du moins, la Radeon HD 7970 garde un avantage. Pour ce test, Nvidia nous a fourni une GeForce GTX 680 de référence : La GeForce GTX 680 de référence          La GeForce GTX 680 se contente d'une longueur de 25.5cm de long, et est ainsi plus compacte que la Radeon HD 7970 ou que la GeForce GTX 580. Elle reprend un système de refroidissement à ventilateur radial similaire à celui proposé par Nvidia sur ses cartes graphiques haut de gamme précédentes. Avec un TDP de 195W, son bloc de refroidissement a par contre pu être simplifié. Exit la chambre à vapeur qui est remplacée par une base en cuivre de laquelle partent 3 caloducs aplatis incrustés dans le radiateur en aluminium. Une plaque métallique fait office du support pour le système de refroidissement, garanti la rigidité du PCB et est en contact avec les modules mémoires ainsi qu'avec les composants sensibles de l'étage d'alimentation. Une coque en plastique referme l'ensemble. Notez que si son design plutôt classique n'est pas pour nous déplaire, sa qualité de fabrication est minimale avec un bruit de plastique qui grince lors de sa manipulation. Nous sommes ici plutôt au niveau de finition d'une GeForce GTX 560 Ti que d'une Radeon HD 7970 ou encore que d'une GeForce GTX 580. Pour alimenter le GK104, Nvidia a prévu 5 phases sur son PCB, en plus des deux dédiées à la mémoire GDDR5 Hynix R0C certifiée à 1.5 GHz. Seules 4 de ces phases sont cependant nécessaires pour la GeForce GTX 680 et la cinquième reste inutilisée. La GeForce GTX 680 se contente de deux connecteurs d'alimentation 6 broches, qui correspondent à une consommation maximale de 225W selon les spécifications PCI Express. Notez que Nvidia a opté pour un double connecteur original pour gagner un peu de place, mais le PCB est prévu pour tout type de connecteurs, y compris 8+6 broches. La connectique a été revue et propose 2 connecteurs DVI Dual Link, un connecteur HDMI 1.4a 3 GHz et un connecteur DisplayPort 1.2. Page 6 - Nuisances sonores et température GPU Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe +/- à 21 dBA. Notez que pour toutes les mesures de bruit et de températures, nous nous sommes basées sur le vrai design de référence pour la Radeon HD 7950, différent de la carte presse fournie par AMD.  La GeForce GTX 680 est plutôt discrète au repos et moins bruyante en charge que la GeForce GTX 580 ou que la Radeon HD 7970. Notez cependant que la vitesse de son ventilateur varie lentement mais constamment avec un niveau sonore lui aussi variable entre 43.5 et 45.2 dBA. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  La GeForce GTX 680 est plutôt bien refroidie. Page 7 - Relevés et thermographie infrarouge Relevés et thermographie infrarougePour ce test, nous avons repris le nouveau protocole décrit ici. Voici tout d'abord un récapitulatif de tous les relevés :  La GeForce GTX 680 profite au repos de sa consommation revue à la baisse par rapport à celle de la GeForce GTX 580.  Les températures internes sont globalement inférieures en charge avec la GTX 680 par rapport à la GTX 580. Notez que dans notre test de charge, sous 3DMark 11, la fréquence du GK104 varie entre 1006 et 1097 MHz. Voici enfin, ce que tout cela donne à travers l'imagerie thermique :

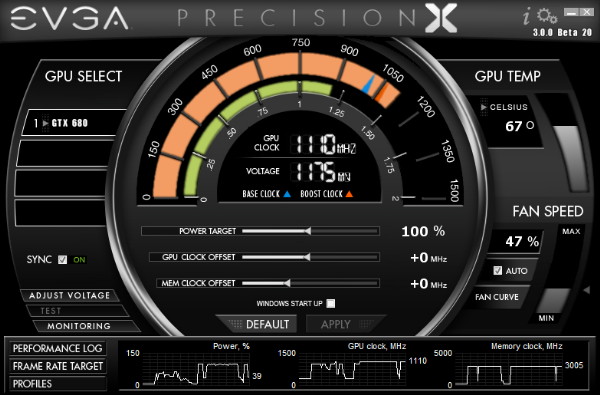

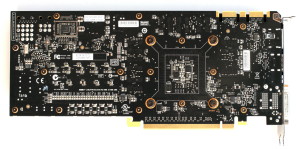

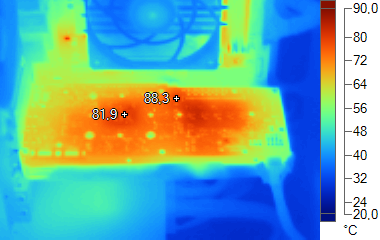

Ces clichés confirment que la GeForce GTX 680 est bien refroidie, même si son étage d'alimentation chauffe un peu plus que celui de la Radeon HD 7970. Page 8 - Consommation et performances/watt ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 7 ainsi qu'en veille écran de manière à observer l'intérêt de ZeroCore Power. Pour la charge, nous avons opté pour des mesures dans Anno 2070, en 1080p avec tous les détails poussés à leur maximum, ainsi que dans Battlefield 3, en 1080p dans le mode High :  Si la GeForce GTX 680 réduit drastiquement la consommation au repos par rapport à la GeForce GTX 580, avec un niveau légèrement inférieur à celui de la GeForce GTX 560 Ti, elle ne dispose pas d'une technologie similaire à ZeroCore Power pour éteindre presque totalement le GPU en veille écran. En charge, elle affiche une consommation généralement inférieure à celle de la Radeon HD 7970 mais ce n'est pas toujours le cas, par exemple dans Battlefield 3 où cette dernière est quelque peu plus économe. Nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles :  [ Anno 2070 1080p Max ] [ Battlefield 3 1080p High ] Grâce au procédé de fabrication en 28nm et à l'architecture revue du GK104, le rendement énergétique évolue bel et bien. Il est légèrement supérieur à celui de la Radeon HD 7970 dans Anno 2070 et 15% supérieur dans Battlefield 3 mais c'est la Radeon HD 7870 qui reste la plus effiace. Notons cependant que chaque jeu représente un cas particulier. Page 9 - Performances théoriques : pixels Performances texturingNous avons mesuré les performances lors de l'accès à des textures de différents formats en filtrage bilinéaire : en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16), en 128 bits (4x FP32), en profondeur de 32 bits (D32F) et en 32 bits RGB9E5, un format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis.  Les GeForce GTX sont capables de filtrer les textures FP16 à pleine vitesse contrairement aux Radeon qui compensaient jusqu'ici par une puissance de filtrage tellement supérieure, que même si elles doivent filtrer les textures FP16 à demi-vitesse, elles affichaient des débits proches des GeForce. Ce n'est plus le cas avec la GeForce GTX 680 qui prend une avance considérable sur ce point. Cependant, alors qu'elle profite dans notre test de GPU Boost pour tourner à 1110 MHz et afficher un débit théorique de 142 Gtexels/s, elle a du mal en pratique à atteindre cette valeur et affiche un débit près de 25% inférieur. Notez que nous devons augmenter la limite de consommation des Radeon HD 6900 ainsi que des Radeon HD 7700 et 7800 au maximum sans quoi les fréquences se réduisent dans ce test. De base, ces Radeon sont donc incapables de profiter pleinement de toute leur puissance de texturing ! Ce n'est pas le cas pour les Radeon HD 7900. Nous avons éclairci la part des performances qui ne peut ainsi être obtenue qu'en modifiant la limite PowerTune. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données :   Au niveau du fillrate, la GeForce GTX 680 et le GPU GK104 sont enfin capable de transférer les formats FP10/11 et RGB9E5 à pleine vitesse vers les ROP, bien que le blending de ces formats se fasse toujours à demi vitesse. Si les GeForce et les Radeon sont capables de traiter le FP32 simple canal à pleine vitesse sans blending, seules ces dernières conservent ce débit avec blending. Elles sont par ailleurs nettement plus rapides en FP32 quadruple canal (HDR 128 bits) Bien que les Radeon 7800 disposent du même nombre de ROP que les Radeon HD 7900, leur bande passante mémoire inférieure ne leur permet pas de maximiser leur utilisation avec blending ainsi qu'en FP16 et FP32 sans blending. Page 10 - Performances théoriques : géométrie Débit de trianglesEtant donné les différences architecturales des GPUs récents au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d'abord nous avons observé les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu'ils tournent le dos à la caméra) :  La GeForce GTX 680 ne fait pas mieux que la Radeon HD 7970 lorsque les triangles doivent être rendus, ses performances sont probablement contre réduites, Nvidia les bridant déjà sur les GTX 500 pour différencier les Quadro des GeForce. Quand les triangles peuvent être éjectés du rendu, la GeForce GTX 680 profite pleinement de sa capacité de prise en charge de 4 triangles par cycle pour prendre le large. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation :  Avec la GeForce GTX 680, Nvidia réaffirme sa supériorité lorsqu'il s'agit de traiter un nombre important de petits triangles générés par un niveau de tessellation élevé, les Radeon HD 7900 ne se démarquant pas des Radeon HD 7800 qui disposent du même nombre d'unités fixe dédiées à cette tâche. L'architecture des Radeon fait qu'elles peuvent être engorgées par la quantité de données générées, ce qui réduit drastiquement leur débit dans ce cas. Le doublement de la taille du buffer dédié à l'unité de tessellation dans le GPU des Radeon HD 6800 leur a permis d'être significativement plus performantes que les Radeon HD 5000. AMD a continué dans cette voie avec les Radeon HD 7000. Pour une raison inconnue, la GeForce GTX 570 est ici plus performante que la GeForce GTX 580 qui souffre peut-être également d'un engorgement, bien qu'il soit possible que ce soit lié à un profil géométrique des pilotes. Page 11 - Les pilotes, le test Les pilotes GeForce évoluentNvidia profite du lancement de la GeForce GTX 680 pour introduire la branche 300 de ses pilotes. En plus de nombreuses petites optimisations sur le plan des performances, ces pilotes apportent quelques petites nouveautés intéressantes. Tout d'abord, ils inaugurent la synchronisation verticale adaptative qui consiste à débrayer la synchronisation verticale lorsque les performances décrochent. Traditionnellement, sur un écran 60 Hz avec vsync ON, dans les passages où le GPU n'est pas capable de débiter 60 fps, il va se retrouver limité à 30 fps puis à 20 fps, 15 fps et ainsi de suite. De grosses chutes de performances qui sont désagréables et qui font que de nombreux joueurs préfèrent se passer de la synchronisation verticale et accepter les artéfacts liés à son absence (images brisées). La nouvelle approche de Nvidia, que nous attendions depuis longtemps de la part d'un fabricant de GPU, résout enfin cette problématique. Nvidia permet par ailleurs de spécifier si la synchronisation verticale doit se déclencher automatiquement sous la fréquence de rafraîchissement ou sous la moitié de celle-ci. Toujours au sujet de la synchronisation verticale, il est dorénavant possible de la désactiver en mode 3D Vision. Enfin, Nvidia a intégré une nouvelle option d'antialiasing qui permet de forcer un mode d'antialiasing de type FXAA, comme AMD le fait avec le MLAA similaire. Notez que Nvidia vient également de présenter le TXAA, un nouveau type d'antialiasing qui n'est cependant pas présent dans les pilotes et qui n'a strictement aucun rapport avec Kepler. Il s'agit d'une évolution du FXAA proposée aux développeurs en vue de l'intégration dans un moteur qui supporte déjà à sa base le MSAA. Elle consiste à optimiser le mélange du MSAA (2x) et du FXAA, ce que certains jeux font déjà approximativement en appliquant d'une manière brute les deux filtres l'un après l'autre sans optimiser leur complémentarité. Si cet algorithme fonctionne sur tous les GPU, Nvidia n'a pas encore décidé si son contrat d'utilisation autoriserait son activation sur les Radeon ou si les développeurs devront bloquer cette possibilité. Le testPour ce test, nous avons repris le protocole introduit lors du dossier consacré à la Radeon HD 7970 et qui inclut de nouveaux jeux : Anno 2070, Batman Arkham City, Battlefield 3, F1 2011 et Total War Shogun 2. Nous y avons ajouté Alan Wake. Nous avons décidé de ne plus utiliser le niveau de MSAA (4x et 8x), comme critère principal pour segmenter nos résultats. De nombreux jeux au rendu différé proposent d'autres formes d'antialiasing, la plus courante étant le FXAA développé par Nvidia. Cela n'a donc plus de sens d'organiser un indice autour d'un certain niveau d'antialiasing, ce qui nous permettait par le passé de juger de l'efficacité du MSAA qui peut varier suivant l'implémentation. En 1920x1080, nous avons dès lors exécuté les tests avec 2 niveaux de qualité différents : extrême et très élevé, ce qui inclus d'office un minimum d'antialiasing (soit du MSAA 4x, soit du FXAA/MLAA/AAA). Nous avons également exécuté des tests avec ce second niveau de qualité en 2560x1600 ainsi qu'en résolution surround, en 5760x1080. Nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Si vous êtes observateurs vous remarquerez que c'est également le cas pour la taille des barres dans les graphes. Les Radeon ont été testée avec les pilotes beta 8.95.5-120224a. Bien que Nvidia recommande de conserver les pilotes 295.x pour les tests des GeForce GTX 500, toutes les GeForce ont été testées avec les pilotes 300.99 beta qui apportent des gains de performances dans la plupart de jeux, significatifs dans certains cas avec plus de 5% sur toutes les cartes. Configuration de testIntel Core i7 980X (HT et Turbo désactivés) Asus Rampage III Extreme 6 Go DDR3 1333 Corsair Windows 7 64 bits Pilotes GeForce beta 300.99 Catalyst beta 8.95.5-120224a Page 12 - Benchmark : Alan Wake Alan Wake  Alan Wake est un portage console plutôt bien exécuté et basé sur DirectX 9. Nous utilisons les niveaux de qualité High proposés par le jeu auxquels nous ajoutons un niveau de qualité maximal qui fait passer le niveau de MSAA à 8x. Nous effectuons un déplacement bien défini et mesurons les performances avec fraps.  Les Radeon HD 7000 apprécient plutôt bien ce jeu dans lequel elles écrasent facilement les GeForce dont le modèle GTX 680 souffre particulièrement avec MSAA 8x, se faisant dépasser par la Radeon HD 7870.  Les Radeon conservent leur domination en très hautes résolutions. Vous noterez qu'à l'heure actuelle Nvidia ne dispose pas encore de profil SLI. Page 13 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons d'une part le mode de qualité très élevé proposé par le jeu et d'autre part un mode de qualité maximale qui complexifie les effets de post processing et augmente le niveau de filtrage anisotrope. Nous effectuons un déplacement sur une carte et mesurons les performances avec fraps.  Si les GeForce GTX 500 étaient en retrait dans ce jeu, la GeForce GTX 680 affiche une progression importante, mais ne parvient pas à dépasser la Radeon HD 7970 lorsqu'une qualité maximale est appliquée.  En très hautes résolutions, nous observons ici une égalité entre la GeForce GTX 680 et la Radeon HD 7970. Page 14 - Benchmark : Batman Arkham City Batman Arkham City  Batman Arkham City est mis au point avec une version récente de l'Unreal Engine 3 qui supporte DirectX 11. Bien que ce mode ait souffert d'un gros bug dans la version d'origine du jeu, un patch 1.1 a corrigé cela. Nous utilisons le benchmark intégré. Toutes les options sont poussées au maximum, ce qui inclut un niveau de tessellation extrême sur une partie des scènes testées. Les performances sont mesurées en mode Extreme (qui inclus les effets DirectX 11 supplémentaires) avec FXAA High (haute résolution), MSAA 4x et MSAA 8x.  Les Radeon souffrent avec MSAA 8x, un mode qui sature probablement le cache L2 et les contrôleurs mémoire. AMD nous a cependant indiqué qu'un problème avait été détecté et serait corrigé dans des pilotes à venir. Pas de nouvelles par contre concernant un éventuel profil CrossFire corrigé, puisque les performances y sont mauvaises en plus d'une fluidité réduite.  En hautes résolutions avec FXAA, la Radeon HD 7970 revient quelque peu. Page 15 - Benchmark : Battlefield 3 Battlefield 3  Battlefield 3 repose sur le Frosbite 2, probablement la moteur graphique le plus avancé à ce jour. De type rendu différé, il supporte la tessellation et calcule l'éclairage via un compute shader. Nous testons les modes Ultra et High et relevons les performances avec Fraps, sur un parcours bien défini. Notez qu'un patch destiné à améliorer les performances sur les Radeon HD 7000 est sorti le 14/02. Nous l'avons bien entendu installé et avons observé un gain de 1 à 2%.  La GeForce GTX 680 est particulièrement efficace dans Battlefield 3, affichant une avance de près de 20% sur la Radeon HD 7970 en mode de qualité élevée. En Ultra , qui inclut du MSAA 4x, elle se contente par contre de 12%.  En très hautes résolutions, l'avance de la GTX 680 se réduit. Notez que le rendu en surround est très saccadé sur les solutions multi-GPU. Malgré 50 fps en surround, les Radeon HD 7870 procure plutôt une sensation de type 25 fps et le jeu est injouable. Page 16 - Benchmark : Bulletstorm Bulletstorm  Bulletstorm se contente de DirectX 9, mais propose un rendu plutôt sympathique, basé sur la version 3.5 de l'Unreal Engine. Toutes les options graphiques sont poussées au maximum (high) et nous mesurons les performances avec Fraps avec MSAA 4x et puis 8x.  Avec MSAA 8x, la GeForce GTX 680 accuse le coup.  C'est également le cas en très haute résolution où la Radeon HD 7970 est plus performante. Page 17 - Benchmark : Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d'une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d'autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le dernier patch est installé.  Si les Radeon HD 7000 corrigent le problème de performances dans ce jeu, la GeForce GTX 680 y est encore plus performante, profitant entre autre des nouveaux pilotes de la série 300 qui apportent ici un gain de plus de 5% sur les GTX 500.  Bien que le jeu en lui-même supporte le surround gaming, ce n'est pas le cas de notre scène de test. Page 18 - Benchmark : Crysis 2 Crysis 2  Crysis 2 reprend une évolution du moteur de Crysis Warhead optimisée pour être relativement moins gourmande mais y ajoute, via un patch, un support de DirectX 11 dont le coût peut être assez important. C'est par exemple le cas de la tessellation, que nous évitons d'activer compte tenu du fait qu'elle a été implémentée en collaboration avec Nvidia d'une manière abusive, dans le but de faire plonger les performances sur les Radeon. Nous avions dévoilé cette entourloupe ici. Nous mesurons les performances avec Fraps sur la version 1.9 du jeu.  La GeForce GTX 680 voit son avance réduite en mode Ultra. Notez que les Radeon utilisent un profil CrossFire différent selon que les pilotes détectent l'activation du mode Ultra ou Extreme. Le profil du mode Ultra entraîne visiblement une limitation CPU légèrement plus faible ce qui explique que les Radeon HD 7870 en CFX y soient plus rapides qu'en mode Extreme.  En très hautes résolutions, nous observons une égalité entre la GeForce GTX 680 et la Radeon HD 7870. Notez qu'en surround, l'affichage n'est pas fluide sur les solutions multi-GPU qui donnent une sensation d'un niveau de fps deux fois moindre. Page 19 - Benchmark : F1 2011 F1 2011  Dernier né chez Codemaster, F1 2011 reprend une évolution légère du moteur de F1 2010 et de DiRT 3, qui conserve le support de DirectX 11. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons l'outil de test intégré sur le circuit de Spa-Francorchamps avec une seule F1.  La GeForce GTX 680 est particulièrement performante dans ce jeu, tout du moins quand le MSAA 8x n'est pas activé. Notez une limitation CPU importante pour CrossFire X dans ce jeu.  En très haute résolution, la GTX 680 garde l'avantage mais il se réduit. Page 20 - Benchmark : Metro 2033 Metro 2033  Toujours l'un des jeux les plus lourds, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n'avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l'avons testé en mode DirectX 11, avec une qualité maximale (ce qui inclus l'effet de DoF et le MSAA 4x) et une qualité très élevée avec la tessellation activée.  Aucune carte mono-GPU ne permet de jouer confortablement à Metro 2033 avec une qualité maximale. La GeForce GTX 680 est d'ailleurs peu performante dans ce mode très gourmand en bande passante mémoire.  En très haute résolution, nous observons une égalité entre les deux meilleures cartes mono-GPU du moment. Une fois de plus l'affichage souffre de micro-saccades en multi-GPU. Page 21 - Benchmark : Total War Shogun 2 Total War Shogun 2  Total War Shogun 2 a reçu un patch DirectX 11, développé en collaboration avec AMD. Il apporte entre autre un support de la tessellation et un effet de profondeur de champ de meilleure qualité. Nous l'avons testé en mode DirectX 11, avec une qualité maximale, du MSAA 4x et du MLAA.  Une fois n'est pas coutume, c'est avec MSAA 4x que la GeForce GTX 680 tire son épingle du jeu, les Radeon HD 7000 souffrant fortement de l'activation de ce filtre dans la plupart des moteurs au rendu différé.  En très haute résolution avec MLAA, la Radeon HD 7970 passe devant la GeForce GTX 680. Page 22 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 à la GeForce GTX 580 :  En moyenne, la GeForce GTX 680 dépasse la Radeon HD 7970 de 5.6% sur l'ensemble de nos tests qui proposent un mix de différentes techniques de rendu ainsi que de type d'antialiasings. Par rapport à la GeForce GTX 580, le gain est certes confortable, de près de 30%, mais en-deçà de ce à quoi Nvidia nous a habitués sur le haut de gamme. Il est intéressant d'observer que la GeForce GTX 680, qui représente une double GeForce GTX 560 Ti surcadencée mais à la bande passante mémoire limitée, dépasse de peu ces dernières en SLI. Par rapport à une seule de ces cartes, le gain est de près de 80%.  En très haute résolution, les performances de la GeForce GTX 680 sont relativement plus faibles et nous pouvons observer une égalité avec la Radeon HD 7970. Le gain sur la GeForce GTX 580 monte par contre cette fois à 35% en 2560x1600. Si le CrossFire de Radeon HD 7870 est la solution la plus efficace en 5760x1080, il est important de signaler que dans la majorité des jeux, contrairement à ce que laissent penser les chiffres de performances, la fluidité n'est pas au rendez-vous. Lors de tous ces tests, nous avons remarqué une tendance avec les Radeon : elles souffrent plus que les GeForce lorsque les moteurs au rendu différés utilisent du MSAA. Exploiter ce type d'antialiasing dans un moteur au rendu différé est complexe, vous pourrez en retrouver un exemple dans notre dossier Comprendre le rendu 3D étape par étape avec 3DMark 11. Il est possible qu'elles souffrent d'une limitation technique à ce niveau ou qu'AMD ait réduit ses efforts d'optimisations, préférant mettre en avant les antialiasings effectués en post-traitement, tels que le FXAA ou le MLAA, plus simples à supporter. Page 23 - Performances GPU Boost et overclocking Performances GPU Boost et overclockingNous avons voulu observer les gains apportés en pratique par GPU Boost que nous nous sommes arrangés pour neutraliser. Nous avons par ailleurs pu overclocker la GeForce GTX 680 en augmentant sa fréquence GPU de 100 MHz (elle varie donc entre 1106 MHz et 1210 MHz) et sa fréquence mémoire de 300 MHz, qui passe donc à 1800 MHz. La limite de consommation était alors poussée à son maximum, +32% soit 224W. Notez que GPU Boost complique fortement l'overclocking du GPU tant il est difficile de tester si la fréquence maximale qu'il va imposer dans certains cas est réellement stable, dans notre cas +125 MHz entrainait un plantage dans quelques cas simple mais semblait stable dans d'autres puisque GPU Boost ne poussait pas le GPU aussi haut. Par ailleurs, il impose un couple tension/fréquence prédéfini par Nvidia qui limite la marge de manoeuvre, tout du moins en attendant qu'un éventuel logiciel plus évolué permette de forcer une tension plus élevée. En attendant vous pouvez faire une croix sur les gros overclocking du GPU. Nous avons également inclus des résultats d'une Radeon HD 7970 de base et overclockée à 1075/1650 MHz, un overclocking qu'il est possible d'atteindre très facilement avec ce modèle. Ces résultats ont été obtenus en 1920x1080 avec un niveau de qualité extrême et très élevée :  Maintenez la souris sur le graphe pour afficher les résultats en fps. Il est intéressant de constater que sans GPU Boost, la GeForce GTX 680 se serait contentée d'égaler la Radeon HD 7970. L'overclocking de la GeForce GTX 680, et plus particulièrement de sa mémoire, profite le plus aux situations dans lesquelles elle était en retrait. Le gain moyen est de 13% avec un pic à 18% dans Alan Wake. La Radeon HD 7970 profite d'un gain de 15% avec cet overclocking relativement conservateur, ce qui lui permet de rattraper une partie de l'avance de la GeForce GTX 680. Notez qu'il s'agit ici d'une moyenne des gains et non pas d'un indice de performances qui utilise une pondération par rapport à la carte mono-GPU la plus performante dans chaque jeu et donne un résultat différent d'un point. Page 24 - Conclusion ConclusionAvec ce premier GPU de la génération Kepler, le GK104, Nvidia avait avant tout pour objectif de revoir complètement le rendement énergétique trop faible de la génération Fermi, qui aurait posé des problèmes de plus en plus difficiles à surmonter. Force est de constater que cet objectif est très largement atteint, une évolution fulgurante qui permet la mise au point de produits plus efficaces. Les choses ont fait qu'en cours de route, ce GPU au départ pensé pour prendre place dans le segment performance s'est avéré pouvoir être compétitif par rapport au GPU haut de gamme de la concurrence. Nvidia s'est assuré que ce soit le cas en préparant une GeForce GTX 680 aux fréquences élevées et des pilotes retravaillés, ainsi qu'avec la technologie turbo maison, GPU Boost, qui permet d'apporter quelques points de performances supplémentaires… tout juste de quoi se détacher de la Radeon HD 7970 dans notre panel de jeux.  Précisons cependant que si la GeForce GTX 680 reprend la couronne de la carte graphique mono-GPU la plus performante du moment, son avance reste en moyenne assez légère, et ses performances sont très variables d'une situation à l'autre. Elle souffre particulièrement lorsque l'antialiasing 8x, très gourmand en bande passante mémoire, est activé. Ajoutons à cela le manque de visibilité par rapport au comportement du GPU Boost sur les cartes que vous trouverez dans le commerce, Nvidia refusant catégoriquement de rentrer dans le détail de ses spécificités. Il faut dire que la technologie, contrairement à ce que font les CPU, n'est pas déterministe, ce qui signifie que deux échantillons d'une même carte auront des performances différentes. Nos tests ont montré que GPU Boost apportait 4 à 5% de performances supplémentaires sur un échantillon que nous supposons avoir été soigneusement sélectionné par Nvidia et testé dans des conditions idéales. Nous devons donc supposer qu'il s'agit là de la plage de performances dans laquelle se trouveront les GeForce GTX 680 une fois placées dans votre système, et que les performances pourraient en fait se rapprocher de celles d'une Radeon HD 7970. Au niveau de l'overclocking, le GK104 dispose de moins de marge que le GPU des Radeon HD 7900, GPU Boost puisant déjà en grande partie dans celle-ci. Par contre, l'overclocking de la mémoire peut être généreux et offre un rendement très élevé sur une GeForce GTX 680 qui manque quelque peu de bande passante mémoire, offrant ainsi un gain de performances sympathique particulièrement dans les situations où elle est un petit peu en retrait. Pour battre cette GeForce GTX 680 ainsi boostée, il faudra alors passer par un overclocking massif de la Radeon HD 7970, avec modification de la tension GPU et augmentation de toutes les nuisances liées.  Commercialisées à un même prix de 500€, il n'est dès lors pas simple de départager ces deux cartes graphiques, d'autant plus qu'en proposant la gestion de 4 écrans Nvidia fait disparaître l'argument Eyefinity d'AMD. Au final, la Radeon HD 7970 conserve un avantage au niveau de la consommation en veille qui pourra faire la différence pour certains usages, une capacité mémoire de 3 Go ainsi qu'une architecture qui supporte complètement DirectX 11.1 et est tournée vers le futur au niveau du GPU computing. Notre préférence penche cependant légèrement vers la GeForce GTX 680 qui bénéficie d'un rendement énergétique supérieur, de nuisances sonores légèrement plus faibles, de l'écosystème 3D Vision, le plus répandu pour la 3D stéréo, ainsi que de pilotes offrant quelques fonctionnalités innovantes telles que la synchronisation verticale adaptative et assurant en général plus rapidement un support optimal des nouveaux jeux. En général, mais pas toujours comme le démontre au passage les résultats des GeForce dans Alan Wake. En fonction de vos besoins vous pourrez donc pencher pour l'une ou l'autre de ses solutions. Il faut également avouer que ces 2 solutions ne présentent pas un rapport prestation/prix exceptionnel, AMD et Nvidia se contentent du strict minimum et la faible disponibilité de la production en 28nm empêche la concurrence de jouer pleinement son jeu. Leur intérêt est également discutable pour bien des usages puisque pour jouer en 1920x1080, une Radeon HD 7870 fera très souvent l'affaire en acceptant quelques compromis sur les options graphiques dans les jeux les plus gourmands. A l'inverse, pour jouer en surround avec un niveau de détail élevé, leur puissance reste insuffisante dans bien des jeux et passer à un système multi-GPU reste nécessaire... mais encore faut-il que ce dernier n'entraîne pas l'apparition de micro-saccades ! Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |