| |

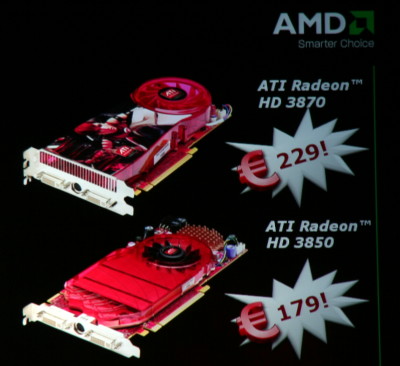

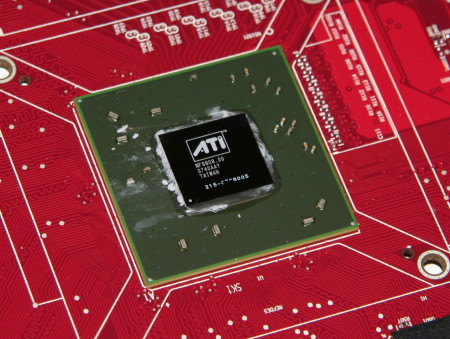

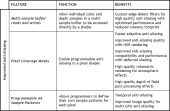

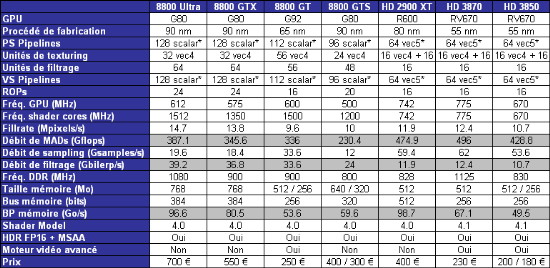

| AMD Radeon HD 3870 et 3850 Cartes Graphiques Publié le Jeudi 15 Novembre 2007 par Damien Triolet URL: /articles/693-1/amd-radeon-hd-3870-3850.html Page 1 - Introduction Ce mois de novembre est un mois important pour AMD qui lance pour la première fois une plateforme complète en même temps, Spider, qui inclus de nouveaux CPUs, les Phenom, de nouveaux chipsets, AMD série 7 et de nouvelles cartes graphiques, les Radeon HD 3800, introduites ce 15 novembre, quelques jours avant le reste de la plateforme.  Comme vous le savez probablement si vous avez suivi l'actualité, la compétition est féroce entre Nvidia et AMD sur le créneau performances que tous deux veulent avoir de leur côté. Les dernières sorties en jeux vidéo qui coïncident avec la possibilité pour les 2 fabricants de proposer un dérivé de leur architecture plus efficace amènent l'opportunité de pouvoir écouler des cartes graphiques performantes en volume. Un marché plus qu'intéressant, vous vous en doutez. Les produits et les prix ont ainsi été modifiés à plusieurs reprises dans les 2 camps. Nvidia s'est assuré d'être le premier sur les performances avec la GeForce 8800 GT qui a été équipée de plus de processeurs scalaires actifs qu'il n'était prévu au départ. De son côté, AMD, ne jouant pas sur la redondance de la même manière, n'avait pas une telle marge au niveau des performances. Par contre le fabricant a conçu une puce bien plus petite et donc moins chère et plus facile à produire, de manière à pouvoir attaquer Nvidia avec des prix très agressifs. Les prix d'AMD ont ainsi varié de nombreuses fois et viennent d'augmenter à l'heure où nous écrivons ces lignes en direct de la conférence de lancement.  Pour contrer la GeForce 8800 GT à 220-250€, AMD compte sur les Radeon HD 3800 qui seront commercialisées entre 180 et 230€. C'est moins cher que du côté de Nvidia mais plus cher que ce que nous avait annoncé AMD au départ (160-200€). Comme nous l'avons déjà dit dans le test de la GeForce 8800 GT, cette fin 2007 est une aubaine pour les joueurs qui pour un prix réduit vont pouvoir s'offrir une prestation haut de gamme. Avec la Radeon HD 3870, AMD compte bien essayer de s'approcher des performances de la Radeon HD 2900 XT et ce pour la moitié du prix. De quoi revenir dans la course dominée sans difficultés par Nvidia depuis 1 an ? Page 2 - RV670 en 55nm et DirectX 10.1 RV670 en 55nmAutant AMD est très conservateur par rapport aux procédés de fabrications utilisés pour ses CPUs, autant le fabricant utilise agressivement les tous derniers procédés de fabrications proposés par TSMC pour la fabrication de ses GPUs. Ainsi le RV670 qui équipe les Radeon HD 3800 inaugure le 55 nanomètres. Comme à son habitude, après le 65 nanomètres, TSMC propose un process "half node", entendez par là une technologie intermédiaire entre 2 procédés de fabrication. Le 55 nanomètres est ainsi basé sur la technologie 65 nanomètres du fondeur mais mise à jour de manière à graver plus finement. Comme d'habitude, l'intérêt est de baisser les coûts de production ainsi que la consommation de la puce, un point sur lequel AMD insiste fortement.  Le RV670 peut être vu comme un R600 (Radeon HD 2900 XT) plus efficace d'un point de vue design. Ainsi le RV670 reprend le shader core du R600 au complet, c'est-à-dire 64 unités vec5 pour traiter les shaders (AMD parle pour sa part de 320 processeurs scalaires "pour faire comme Nvidia", mais cela ne colle pas réellement à la réalité) et 16 unités de texturing. Vous pouvez consultez notre article dédié à la Radeon HD 2900 XT pour vous remémorer ces détails.  Qu'est-ce qui change ? Principalement le bus mémoire qui revient à 256 bits au lieu de 512 bits pour le R600. Ensuite une amélioration (supposée) des ROPs, étant donné qu'il semble évidant que les ROPs du R600 souffraient de certains problèmes ce qui bridait les performances avec antialiasing. AMD a toujours nié un quelconque problème de ce type, prétextant avoir fait dès le départ le choix de la flexibilité. Reste qu'avoir choisi volontairement de casser les performances d'un GPU dans le domaine qui a toujours mis la marque Radeon en avant nous semble plus qu'improbable… Quoi qu'il en soit, on peut supposer qu'AMD a travaillé ce point de manière à ce que la réduction de la largeur du bus mémoire soit compensée. Quelques petites nouveautés font leur apparition. Premièrement, le PCI Express 2.0 dont l'intérêt est encore à démontrer même si AMD annonce des gains de 10% sur la Radeon HD 3850 en version 256 Mo. Ensuite l'UVD est de la partie sur une puce performante. Et enfin, AMD est avec les Radeon HD 3800, le premier à supporter DirectX 10.1. Au finale ce RV670 fabriqué en 55 nanomètres devrait presque égaler le R600 (80 nanomètres), tout en étant composé de 34 millions de transistors en moins (666 millions contre 700 millions) et en étant plus de 2x plus petit ! Ce RV670 ne mesure ainsi que 192 mm² contre 408 mm² pour le R600 ! Pas mal, de quoi permettre à AMD d'être agressif sur les prix. DirectX 10.1Cette évolution de DirectX 10, légère, à l'image du shader model 3.0 introduit par DirectX 9.0c, est un argument important pour AMD puisqu'il est le premier à le supporter. DirectX 10.1 et les shader 4.1 apportent de petites améliorations dans différents domaines, de manière à corriger les manquements de la première mouture de DirectX 10, à ajouter un petit peu plus de flexibilité et à apporter un contrôle par les développeurs sur l'antialiasing. Si vous êtes intéressés par les détails, les voici :    Est-ce important de supporter DirectX 10.1 aujourd'hui ? C'est un plus c'est sûr, mais en même temps, les développeurs commencent seulement à utiliser DirectX 10 et ne devraient pas exploiter cette mise à jour avant un moment, d'autant plus qu'il faudra attendre le SP1 de Windows Vista pour le voir apparaître. Nvidia crie bien entendu haut et fort que DirectX 10.1 ne sert à rien, le contraire aurait été étonnant puisque Nvidia est en retard au niveau de son intégration dans ses GPUs. DirectX 9.0c c'était LA révolution, mais DirectX 10.1 c'est sans intérêt. La réalité se situe comme souvent entre les deux. Le fabricant est cependant arrivé, lors de la présentation du GeForce 8800 GT, à ce que le responsable de la division gaming de Microsoft affirme presque fermement que cette mise à jour de l'API ne sert à rien, de manière à anticiper l'arrivée du support chez AMD. Une bonne dose d'hypocrisie chez Microsoft donc… Quoi qu'il en soit il est évident qu'il faudra attendre de voir si les développeurs s'y intéressent avant qu'il ne devienne un avantage significatif. Mais en attendant, toute chose étant égales cela reste un point positif. Page 3 - Spécifications, les cartes, le test Les spécifications  Sur le plan des spécifications, la GeForce 8800 GT est proche de la GeForce 8800 GTX au niveau de la puissance de calcul et de filtrage des textures mais par contre très loin en terme de bande passante mémoire son bus étant limité à 256 bits. Il en va de même pour les Radeon HD 3800 par rapport à la Radeon HD 2900 XT. La HD 3870 est légèrement devant et la Radeon HD 3850 légèrement derrière, en ce qui concerne la puissance brute. Les cartesAMD nous a fourni une Radeon HD 3870 de référence :  La carte fait appel à un système de refroidissement double slot qui s'avère très silencieux en mode 2D. Il se fait légèrement entendre en charge mais cela reste d'un niveau plus que correct. Les 512 Mo de mémoire GDDR4 sont de marque Samsung en 0.8 ns. Powercolor a pu nous fournir sa Radeon HD 3850 :   La carte est équipée d'un ventilateur différent de celui de référence, plus silencieux en mode 3D mais un peu moins en mode 2D, ce qui est dommage. Ceci dit le niveau de bruit reste acceptable, et nous restons dans la catégorie faibles nuisances sonores. Cette version de la HD 3850 est overclockée et les fréquences passent de 670 / 830 MHz à 720 / 900 MHz soit des overclockings respectifs de 7 et 8 %. Pour les tests nous avons bien entendu cadencé la carte aux fréquences de référence. La carte est équipée d'un ventilateur différent de celui de référence, plus silencieux en mode 3D mais un peu moins en mode 2D, ce qui est dommage. Ceci dit le niveau de bruit reste acceptable, et nous restons dans la catégorie faibles nuisances sonores. Cette version de la HD 3850 est overclockée et les fréquences passent de 670 / 830 MHz à 720 / 900 MHz soit des overclockings respectifs de 7 et 8 %. Pour les tests nous avons bien entendu cadencé la carte aux fréquences de référence.Bonne nouvelle pour les amateurs de vidéo, la Radeon HD 3850 512 Mo de Powercolor, qui nous est annoncée au prix de 179€ par le fabricant, est équipée d'une sortie HDMI. Notez que nous avons rencontré un problème avec cette carte et certaines alimentations puisque il arrive que la carte ne veuille plus booter prétextant une mauvaise connexion de l'alimentation PCI Express. Probablement un petit bug qui empêche la bonne détection de cette connexion. ConsommationNous avons mesuré la consommation des différentes cartes. Ces données sont obtenues à partir des mesures effectuées à la sortie de la prise de courant : il s'agit donc de la consommation totale de l'alimentation de la machine, ici une Galaxy 850W d'Enermax.  Gros bénéfice du 65 nanomètres pour la GeForce 8800 GT, la consommation plonge et si la carte reste gourmande et a besoin d'un connecteur d'alimentation PCI Express, nous sommes très loin des extrêmes que sont les GeForce 8800 Ultra et Radeon HD 2900 XT. La consommation en idle diminue fortement, ce qui est une très bonne chose. Au repos une GeForce 8800 Ultra consomme ainsi 50 watts de plus que cette 8800 GT ! Il en va de même pour les Radeon HD 3800. Nous n'avons ici mesuré que la consommation de la 3870 puisque la 3850 utilisée pour ce test était le modèle overclocké de Powercolor ramené aux fréquences d'origine, ce qui aurait faussé les résultats. En idle la consommation de la Radeon HD 3870 est très très faible, encore plus réduite que celle de la GeForce 8800 GT ce qui est une bonne nouvelle. Sans rien faire, une Radeon HD 2900 XT gaspillait 60 watts de plus ! Pour obtenir ce résultat, AMD a introduit le Powerplay sur les GPU desktops. Ainsi fini les fréquences 2D et 3D, le GPU adapte dynamiquement les fréquences suivant la charge graphique. Si vous regardez une cinématique à 30 fps le GPU n'a pas besoin d'être cadencé à la même fréquence que celle qui permet aux joueurs exigeants de jouer à 100 fps par exemple. Pourquoi ne pas l'avoir fait plus tôt se demande-t-on ? Le testPour ce test, nous avons fait appel à 10 jeux dont 4 supportent DirectX 10. Les tests ont tous été exécutés en 1920x1200 et en 1280x1024 avec le filtrage anisotrope activé quand proposé par le jeu. Le HDR a été activé dans tous les cas où il est disponible. Enfin, le transparency/adaptive antialiasing était activé en mode multisampling, Nvidia venant d'en implémenter une nouvelle version plus efficace dans ses drivers. Du côté d'AMD il est forcé dans de nombreux jeux et il est maintenant possible de l'activer via le panneau de contrôle. Toutes les mises à jour pour Windows Vista relatives aux performances ont bien entendu été installées. ConfigurationIntel Core 2 Extreme QX6850 nForce 680i SLI EVGA 2 Go DDR2 Windows Vista Forceware 169.04 (169.05 pour Crysis) Catalyst 7.10 beta Page 4 - Video HD Lecture vidéo HD  Si les premières cartes haut de gamme d'une génération donnée sont généralement très mal loties niveau vidéo HD, heureusement AMD et Nvidia prennent soin de corriger ce point sur les dérivés. Ainsi si les GeForce 8800 GTS/GTX/Ultra et Radeon HD 2900 XT ne sont pas très efficaces sur le plan de l'accélération du décodage des vidéos HD, les GeForce 8800 GT et Radeon HD 3800 corrigent ce défaut. Pour rappel, AMD a l'avantage de prendre en charge complètement le décodage du VC-1 en plus du h.264 alors que Nvidia ne prend complètement en charge que ce dernier. Nous avons mesuré les performances des différentes solutions à travers la lecture de 2 HD DVD, l'un en VC1 (King Kong) et l'autre en H.264 (Babel). La configuration de test est ici différente puisque basée sur un Core 2 Duo E6400. Au niveau logiciel, toujours sous Windows Vista, nous avons utilisé Power DVD en version 3104 et en version 3501 pour les Radeon HD 3800 qui étaient incompatibles avec la version précédente.  Les nouvelles venues tiennent ici toutes leurs promesses. Nous nous sommes également intéressés à la qualité vidéo en nous basant sur les tests d'analyse de la suite HD HQV (voir ici pour le détail de tests).  La GeForce 8800 GT affiche le même résultat que la GeForce 8600 GTS. Les autres GeForce ont un problème avec l'inverse telecine et n'arrivent pas à reproduire ces vidéos avec une qualité correcte. Les 4 Radeon HD obtiennent un score de 100. La différence se situe au niveau de la réduction du bruit numérique. Du côté de Nvidia elle s'active via le panneau de contrôle des drivers suivant un niveau de 0 à 100. Poussé trop fort, il produit des défauts visuels. Nous l'avons donc positionné sur 51%. Notez que ce test est ici subjectif et que dans certaines vidéos il est bon de pouvoir désactiver cet effet, le bruit pouvant servir le film. Avec les derniers pilotes beta AMD utilisés pour ce test, il devient également possible d'activer et d'ajuster l'algorithme de réduction du bruit via les Catalyst. Page 5 - Enemy Territory : Quake Wars Enemy Territory : Quake Wars  Si Quake Wars est basé sur le moteur de Doom 3, celui-ci a subi quelques évolutions telles que le megatexturing qui permet de faciliter le travail des artistes mais entraine un surcout au niveau du "décodage" et de l'accès aux megatextures. Quake Wars est donc un petit peu plus gourmand que Doom 3 et Quake 4. Nous avons enregistré une démo lors d'une partie contre 4 bots. L'intelligence artificielle n'étant pas reproduite lors du timedemo, elle ne limite pas les résultats qui sont donc moins limités par le CPU qu'en situation réelle, tout du moins contre des bots. Toutes les options sont poussées au maximum dans le jeu, ce qui inclus un filtrage anisotrope 16x. Le patch 1.2 est utilisé.  Dans ce premier test, la GeForce 8800 GT se place à mi chemin entre les versions GTS et GTX. La Radeon HD 3870 égale la Radeon HD 2900 XT et se place donc au niveau de la 8800 GT en 1280x1024 et au niveau de la 8800 GTS en 1920x1200. La Radeon HD 3850 se place 15 à 20% derrière, Quake Wars étant très dépendant de la bande passante mémoire. Par contre elle reste très nettement devant les GeForce 8600 GTS et Radeon HD 2600 XT.  Une fois l'antialiasing activé, les performances de la GeForce 8800 GT chutent, à priori à cause de la bande passante mémoire réduite. Mais il est également possible qu'un manque de mémoire se fasse sentir, à l'image de la GeForce 8800 GTS 320. Du côté des Radeon, la baisse de performances est légèrement plus importante que pour les GeForce. Page 6 - Half Life 2 - Episode 2 Half Life 2 Episode 2  Toujours basé sur le Source Engine, Half Life 2 Episode 2 n'apporte pas de réelle nouveauté sur le plan technique et se contente de mieux utiliser et d'utiliser plus souvent ce dont est capable le moteur, ce qui rend le jeu plus gourmand que ses prédécesseurs. Nous exécutons une démo et toutes les options du jeu sont poussées au maximum, y compris le filtrage anisotrope qui est donc en 16x.  La GeForce 8800 GT talonne ici sa grande sœur et se démarque très nettement des 8800 GTS égalées par la Radeon HD 3850.  Situation identique une fois l'antialiasing 4x activé, si ce n'est pour les Radeon HD qui voient leurs performances se réduire relativement plus. Cette fois c'est donc la Radeon HD 3870 qui est au niveau de la GeForce 8800 GTS. Page 7 - S.T.A.L.K.E.R. S.T.A.L.K.E.R.  Nous effectuons un déplacement toujours identique et mesurons le framerate avec fraps. Nous testons le jeu avec un niveau de qualité élevé, éclairage dynamique complet, détails maximums (avec filtrage anisotrope 16x) et ombres des herbes. S.T.A.L.K.E.R. utilise un moteur à base de rendu différé ce qui est fondamentalement incompatible avec du MSAA, ce qui rends l'utilisation de l'antialiasing impossible. Une espèce de filtrage des arrêtes réalisé via un shader est activable mais il offre un résultat mitigé voir invisible, nous ne l'avons donc pas utilisé. Le patch 1.00004 est utilisé.  La GeForce 8800 GT se place entre la GTS et la GTX. La GeForce 8800 GTS 320 est nettement en retrait, 320 Mo étant insuffisants pour ce jeu. Les Radeon sont globalement en retrait dans ce jeu qui apprécient plutôt les GeForce. La Radeon HD 3870 est au niveau de la Radeon HD 2900 XT. Page 8 - Rainbow Six : Vegas Rainbow Six : Vegas  Premier jeu PC basé sur l'Unreal Engine 3.0, Rainbow Six : Vegas reste un jeu très gourmand. Nous mesurons les performances sur la scène d'introduction. Le mode HDR est activé et est plus ou moins obligatoire sans quoi le banding est très présent. Les ombres sont réglées sur "bas", les modes supérieurs entraînant une trop forte baisse de performances dans certains endroits.  Portage de la Xbox 360, le jeu semble naturellement bien aimer les Radeon HD qui partagent une architecture similaire à celle de la puce graphique de la console. Les Radeon HD 2900 XT et HD 3870 terminent donc en tête, une fois n'est pas coutume. La GeForce 8800 GT est ici très proche de la 8800 GTX, la puissance de calcul étant un élément primordial.  Le jeu ne supporte pas l'antialiasing mais Nvidia l'a implémenté dans ses drivers, tout comme pour Oblivion, contrairement à AMD qui ne s'est malheureusement pas donné cette peine. Cette fois la GeForce 8800 GT se place à mi chemin entre la GTS et la GTX et la GTS 320 ne dispose pas d'assez de mémoire pour que le jeu se lance en 1920x1200. Page 9 - Oblivion Oblivion  Nous effectuons un déplacement précisément défini afin qu'il soit toujours identique et que le test soit reproductible. Le HDR est bien entendu de la partie.  Très dépendant de la puissance de calcul en mode HDR, Oblivion place la GeForce 8800 GT tout près du modèle GTX et la Radeon HD 3870 fait jeu égal avec la Radeon HD 2900 XT.  Une fois le FSAA 4x activé, les 2 Radeon HD 3800 passent devant la Radeon HD 2900 XT et significativement dans le cas de la 3870 qui se permet de dépasser la GeForce 8800 GTX. Page 10 - Colin McRae DIRT Colin McRae DIRT  Pour tester le dernier opus des Colin McRae, qui est très gourmand, nous réalisons un déplacement bien défini en mode qualité élevée. Notez que l'activation de l'antialiasing est vivement conseillée compte tenu de la manière dont sont rendus les menus et du fait que les effets de post process employés amplifient l'aliasing. Le patch 1.2 est appliqué.  Une nouvelle fois, la GeForce 8800 GT se place entre les GTS et GTX. La Radeon HD 2900 XT et la Radeon HD 3870 sont pour leur part au niveau des GeForce 8800 GTS et la HD 3850 est légèrement derrière.  Pas de gros changement avec antialiasing, si ce n'est que les 320 Mo de la GeForce 8800 GTS 320 sont insuffisants. Page 11 - Bioshock Bioshock  Premier jeu basé sur l'Unreal Engine 3.0 à supporter DirectX 10, Bioshock est un jeu très réussi graphiquement et ce même en mode DirectX 9 alors qu'il est moins gourmand que Rainbow Six : Vegas. Nous effectuons un déplacement bien défini et toutes les options sont poussées au maximum.  En mode DirectX 9, la Radeon HD 2900 XT se montre plutôt véloce, très proche de la GeForce 8800 Ultra. Les Radeon HD 3800 sont ici moins performantes, mais la HD 3870 reste devant la GeForce 8800 GT malgré tout. La Radeon HD 2600 XT est devant la GeForce 8600 GTS mais ces 2 cartes sont nettement en retrait.  Tout comme pour Rainbow Six : Vegas, Nvidia permet d'activer l'antialiasing dans ce jeu qui ne le supporte pas à la base. AMD ne le permet pas. Pour une raison inconnue, il nous a cependant été impossible d'activer l'antialiasing sur les GeForce 8800 et 8600 GTS.  En mode DirectX 10, les performances des GeForce 8 restent similaires à ce que nous avons pu obtenir en mode DirectX 9. Par contre du côté de la Radeon, les performances baissent, fortement pour la Radeon HD 2900 XT et plus modérément pour les Radeon HD 3800. Le modèle 3870 passe ainsi devant la HD 2900 XT. Notez qu'il n'est pas encore possible d'activer d'antialiasing en mode DirectX 10, tant chez Nvidia que chez AMD. Page 12 - Company of Heroes Company of Heroes  Company of Heroes ayant reçu un patch DirectX 10 qui apporte un réel plus sur le plan graphique, nous avons décidé de l'ajouter à notre protocole de test. Toutes les options sont poussées à leur maximum, à l'exception des détails du terrain qui restent sur High (le mode Ultra étant réservé à DirectX 10) et des textures qui restent elles aussi sur High, le jeu indiquant un manque de mémoire système sur les GeForce en mode DirectX 9 avec les textures Ultra. Nous exécutons le test intégré sur la version 1.71.  La GeForce 8800 GT est tout juste devant la Radeon HD 2900 XT et nettement devant les 8800 GTS. Les Radeon HD 3800 se placent entre les GeForce 8800 GTS et GT.  Une fois l'antialiasing 4x activé, les performances des Radeon plongent, alors que les GeForce 8 affichent des résultats consistants.  En DirectX 10, les performances sont clairement inférieures, le moteur affichant des graphismes plus avancés. La Radeon HD 3870 dépasse la Radeon HD 2900 XT et se place au niveau de la 8800 GTS.  Classement identique avec antialiasing et perte relativement plus importante du côté des Radeon. Notez que les GeForce 8600 GTS et Radeon HD 2600 XT montrent ici leurs limites et se place très loin derrière. Page 13 - World in Conflict World in Conflict  Très réussi visuellement et très gourmand, il était logique de voir World in Conflict joindre notre suite de tests. Nous exécutons le test interne avec le patch 1.0002. Toutes les options sont poussées au maximum.  Les Radeon HD 2900 XT et HD 3870 se placent à la hauteur de la GeForce 8800 GTS, tout du moins en version 640 Mo, la version 320 Mo étant larguée, à cause d'une mémoire insuffisante.  Avec antialiasing 4x, la GeForce 8800 GT semble être quelque peu limitée par sa bande passante mémoire et ne se démarque donc que très peu de la 8800 GTS. Les Radeon voient leurs performances fondrent.  Les performances de toutes les cartes baissent légèrement en mode DirectX 10, si ce n'est pour la Radeon HD 2900 XT qui affiche une perte plus importante. Du coup les 2 Radeon HD 3800 passent devant.  Pour la seule et unique fois de ce comparatif, la GeForce 8800 GTS 640 Mo devance la 8800 GT. Un problème semble impacter les performances des Radeon qui sont très faibles dans ces conditions et souvent similaires entre les 2 résolutions, ce qui semble indiquer la présence d'un bug au niveau des pilotes. Page 14 - Crysis - démo SP Crysis - démo SP  Bien qu'il ne soit pas dans notre habitude d'utiliser des démos dans notre suite de test, il est difficile de faire l'impasse sur Crysis tant ce jeu est attendu et redéfinit la qualité graphique moderne. Nous exécutons le test interne en mode DirectX 9 High (forcé via l'ajoute de –dx9 derrière l'exécutable) et en mode DirectX 10 Very High. Notez qu'une polémique a fait surface au sujet d'un bug dans les pilotes Nvidia 169.04 dont la conséquence était que la réflexion à la surface de l'eau se trouvait déforméé puisqu'elle n'était pas actualisée assez souvent. Etant calculée moins souvent, les performances augmentaient, tout du moins dans certains conditions telles que le 1920X1200 avec AA4x en mode DirectX 10 (+30%). Nous pensions au départ qu'il s'agissait d'un bug du jeu. Mais il s'est avéré que renommer l'exécutable de manière à ce que le pilote Nvidia ne puisse plus le détecter corrigeait le problème. De quoi avoir quelques soupçons sur ce bug. Nous avons contacté Nvidia à ce sujet qui a confirmé le bug et le gain de performances qu'il pouvait entraîner. Nvidia nous a fourni un driver qui ne pose plus ce problème (169.05), que nous avons bien entendu utilisé ici. Le fabricant a également détaillé le bug en question de manière à éviter tout mal entendu à son sujet. Le moteur de Crysis essaye d'éviter de recalculer la réflexion sur l'eau autant que possible, ce qui est une optimisation logique. Pour ce faire, il utilise 3 données : le temps écoulé depuis la précédente actualisation, le mouvement de la caméra, et le nombre de pixels "eau" visibles à l'écran. Il serait bien entendu ridicule de recalculer toute une réflexion pour une poignée de pixels. C'est d'ailleurs cette dernière valeur qui est la source du problème. Pour connaître le nombre de pixels "eau" visibles, le moteur effectue un test d'occlusion sur le GPU, retourne le résultat au système qui l'utilise pour déterminer si la réflexion doit être mise à jour ou pas. Pour éviter de perdre du temps (CPU qui attend le résultat du GPU), pour une image donnée, le moteur se base sur le résultat du test d'occlusion d'une image précédente, une image de décalage par exemple. Or en SLI cela pose problème puisque une image de décalage signifie que le GPU2 va alors devoir attendre que le GPU1 ait effectué le test d'occlusion. Le SLI ne peut donc pas apporter le moindre gain. La démo et probablement le jeu devront être mis à jour pour prendre en compte les systèmes multi-GPUs en synchronisant l'utilisation des tests d'occlusions de manière à éviter de bloquer une partie du système. En attendant, et pour que le SLI montre des gains (tout en causant potentiellement des bugs), Nvidia a en quelque sorte faussé le test d'occlusion en reportant directement toujours la même chose au moteur : l'eau est visible mais sur très peu de pixels. Dans le cas où en réalité le test aurait détecté que l'eau n'est pas visible, les GeForce 8 traitent l'eau pour rien (mais sans actualiser la réflexion bien entendu). Dans le cas où le test aurait détecté que l'eau est visible en masse et donc que la réflexion doit être actualisée, les GeForce 8 reportent toujours que l'eau n'est que très peu visible et le bug apparaît. Au final, l'eau représentant souvent une partie importante de l'écran dans le test de la démo, les GeForce 8 sont avantagées par ce bug. Mais en quoi une optimisation pour le SLI est elle liée au problème en question ? Indirectement puisqu'un bug cette fois dans le driver lui faisait appliquer le profil SLI même avec un seul GPU. C'est ce que Nvidia a corrigé avec les pilotes 169.05. Le problème reste donc d'actualité en SLI et le restera jusqu'à ce que le jeu soit mis à jour pour permettre au SLI de fonctionner. Ceci étant dit, nous pouvons passer aux résultats.  La GeForce 8800 GT est proche de la GTX et tout juste devant les Radeon HD 2900 XT et HD 3870. La HD 3850 est pour sa part au même niveau que la GeForce 8800 GTS. Notez que seules les GeForce 8800 GT/GTX/Ultra permettent de jouer en mode High et en 1280x1024, et encore c'est tout juste. Le jeu est très gourmand à tous les niveaux, y compris sur la mémoire puisque les 320 Mo de la GeForce 8800 GTS 320 sont déjà insuffisants.  Avec antialiasing, de nombreuses cartes commencent déjà à voir rouge. Si les GeForce 8800 GTX et Ultra s'en tirent assez bien, la GT s'écroule en 1920x1200. Quant aux Radeon HD 2900 XT et HD 3800, elles voient leurs performances divisées par 2 !  Tous détails poussés à fond et en DirectX 10, la GeForce 8800 GT a du mal à se démarquer de la 8800 GTS 640 Mo en 1920x1200 mais reste devant les Radeon HD 2900 XT et HD 3870 qui sont au niveau de la 8800 GTS.  Jouer tout à fond en 1280x1024 avec la plus grosse carte haut de gamme du moment ? Impossible. Toutes les cartes sont à genoux. Vivement le SLI de GeForce 9800 ! Page 15 - Récapitulatif RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en se basant sur l'ensemble de résultats et en donnant le même poids à chacun des jeux. L'indice 100 a été attribué à la GeForce 8800 GT en 1280x1024.  En moyenne la GeForce 8800 GT se situe 10% en retrait par rapport à la GeForce 8800 GTX, ce qui plutôt pas mal pour une carte vendue à la moitié du prix ! Elle se place ainsi plus près de la GTX que de la GTS et très très loin devant le précédent haut du milieu de gamme Nvidia qu'est la GeForce 8600 GTS. La GeForce 8800 GT termine également devant la Radeon HD 2900 XT. La Radeon HD 3870 talonne cette dernière et la "petite" Radeon HD 3850 égale la GeForce 8800 GTS.  Avec le filtrage antialiasing 4x activé, la GeForce 8800 GT se place cette fois un peu plus près de la GTS ou un peu plus loin de la GTX, c'est selon. Mais les performances restent très bonnes. La GeForce 8800 GTS 320 Mo est ici clairement limitée par sa mémoire. Quant à la Radeon HD 2900 XT, ses ROPs bugués au niveau de l'antialiasing ont poussé AMD à utiliser une solution de rechange qui, si elle est très flexible, bride les performances. Du coup la Radeon HD 3800 s'en tire relativement mieux malgré son bus mémoire réduit de moitié. Ainsi le modèle 3870 est en moyenne devant cette Radeon HD 2900 XT. Néanmoins, les GeForce s'en tirent toujours mieux et la 8800 GT affiche un avantage significatif sur les Radeon HD 3800. Notez que les résultats obtenus sous Rainbow Six : Vegas et Bioshock ne sont pas pris en compte ici puisque certaines cartes ne sont pas capables d'afficher de l'antialiasing dans ces jeux. Cependant, le classement reste identique si nous les avions intégrés. Vous pouvez le consulter ici.  En DirectX 10, la GeForce 8800 GT ne déçoit pas et se positionne toujours entre la GTS et la GTX et devant la Radeon HD 2900 XT qui se fait dépasser ici aussi par la Radeon HD 3870.  En DirectX 10 et avec FSAA 4x, la GeForce 8800 GT est plus limitée, probablement par sa bande passante mémoire, mais reste malgré tout du niveau de la GeForce 8800 GTS 640 Mo, les 2 cartes terminant dans un mouchoir de poche. Dans ces conditions extrêmes, les GeForce 8800 GTX et Ultra conservent un avantage alors que les Radeon HD sont en retrait. Page 16 - Conclusion ConclusionUne fois n'est pas coutume, les 2 fabricants de GPUs nous proposent en même temps ou presque d'excellents produits. Alors qu'ATI et ensuite AMD a accusé des retards successifs par rapport à Nvidia, pour la première fois depuis longtemps, le fabricant revient à niveau et à l'heure. La conséquence est claire et directe : la concurrence entraîne une guerre des prix et des performances, chacun désirant essayer d'être légèrement mieux positionné que l'autre.  AMD et Nvidia sont en effet plus ou moins au courant de ce dont dispose l'autre dans ses cartons ou tout du moins le pressent, ce qui les oblige à anticiper sur les prix, mais également sur les spécifications finales d'une manière assez agressive lorsque tous les deux sont au rendez-vous. C'est tout bénéfice pour l'utilisateur et cela ne pouvait pas mieux tomber en pleine déferlante de très bons jeux gourmands graphiquement. Sur le plan des performances, c'est Nvidia qui l'emporte. La GeForce 8800 GT est la carte qui affiche les meilleures performances et ce d'une manière consistante avec et sans antialiasing, en DirectX 9 et en DirectX 10. Mais c'est également la carte la plus chère, dont les premiers prix approchent souvent les 250 €.  La Radeon HD 3870 est un cran derrière mais est moins chère, 230 € voire un peu moins et apporte un support complet de DirectX 10.1, un moteur vidéo plus universel et une consommation plus réduite, au prix cependant d'une occupation de 2 slots. La Radeon HD 3850 en version 512 Mo affiche un énorme intérêt puisque commercialisée à moins de 200 €. Bien sûr elle est un petit peu moins performante, mais affiche un rapport qualité prix très intéressant sous cette barre symbolique. La carte de Powercolor, si elle est bien proposée au prix de 180 € indiqué par le fabricant, avec 512 Mo, un léger overclocking et une connectique HDMI devrait séduire de très nombreux utilisateurs.  Reste qu'il nous est difficile de trancher définitivement entre ces 3 cartes à l'heure actuelle. Ce sont 3 bons produits, dans un mouchoir de poche, et leurs prix sont malheureusement plutôt flous. Annonces trop agressives parfois, changements de dernière minute, offre nettement inférieure par rapport à la demande, font qu'une inconnue subsiste. Votre budget sera aussi déterminant puisque entre une GeForce 8800 GT à 250 € et une Radeon HD 3850 à 180 € il y a une différence significative dans cette gamme. Enfin terminons par un petit mot sur les versions 256 Mo de ces cartes. Nous estimons que dans de plus en plus de situations, et cela va s'amplifier à l'avenir, 256 Mo sont insuffisants. Dès lors nous vous déconseillons d'opter pour l'une de ces cartes avec si "peu" de mémoire avant que les limitations entraînées aient été clairement analysées, de manière à éviter toute mauvaise surprise. Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |