| |

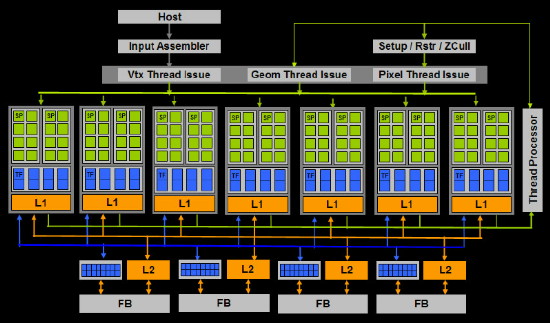

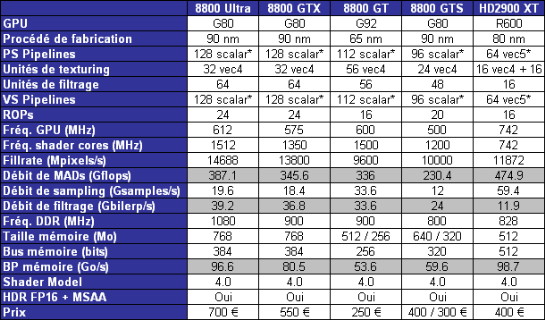

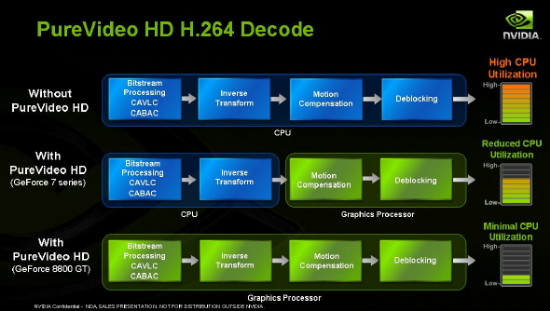

| Nvidia GeForce 8800 GT Cartes Graphiques Publié le Dimanche 11 Novembre 2007 par Damien Triolet URL: /articles/692-1/nvidia-geforce-8800-gt.html Page 1 - Introduction Tout juste un an après l'arrivée des GeForce 8800 GTX, force est de constater que Nvidia a affiché une domination sans faille sur le créneau haut de gamme. AMD s'est vite rendu compte ne pas pouvoir lutter avec la Radeon HD 2900 XT qui s'est contentée de s'opposer tant bien que mal aux GeForce 8800 GTS. Une architecture vectorielle moins efficace mais surtout un antialiasing très peu performant ont plombés les prétentions d'AMD. Par conséquent, la compétition a été réduite au strict minimum, Nvidia se contentant de lancer un ultra haut de gamme, de manière à rentabiliser au maximum une famille de GPUs très demandée.  La donne change en cette fin d'année avec l'arrivée de la GeForce 8800 GT destinée à rendre abordable la famille GeForce 8800, quitte à enlever une grande partie de l'intérêt des cartes plus haut de gamme qui se vendaient pourtant toujours très bien. Pourquoi sortir maintenant de son sac un produit moins cher alors que la version plein tarif se vend toujours très bien nous direz-vous ? Pour différentes raisons. La première est que toute une série de jeux très attendus et très gourmands sur le plan graphique sont en train de débarquer. Bioshock, Half Life 2 Episode 2, World in Conflict, Unreal Tournament 3, Gears of War et… Crysis. Tous ces jeux vont entraîner une vague de mise à jour importante parmi les joueurs et obliger les fabricants de PCs à intégrer des cartes graphiques plus performantes dans leurs machines destinées aux joueurs. Un gros volume en perspective et qui peut donc plus facilement s'attaquer avec des prix agressifs. La seconde raison est qu'AMD prépare une gamme de cartes graphiques qui promet d'afficher un très bon rapport qualité/prix, le fabricant n'ayant plus vraiment le choix. Avec une architecture mal adaptée pour lutter sur le très haut de gamme, AMD doit lutter sur le rapport performances/prix. Si Nvidia domine facilement le haut de gamme avec des cartes graphiques très rentables, et aurait pu continuer de le faire,  le fabricant n'a pas pour autant envie de laisser filer aussi facilement une grosse part du marché "joueurs" à son concurrent et préfère être agressif sur le prix de manière à consolider sa positon avant la tentative de "retour" d'AMD. le fabricant n'a pas pour autant envie de laisser filer aussi facilement une grosse part du marché "joueurs" à son concurrent et préfère être agressif sur le prix de manière à consolider sa positon avant la tentative de "retour" d'AMD.La GeForce 4 Ti 4200 version 2007 ?Cette concurrence annoncée ainsi que le potentiel énorme amené par la vague de nouveaux jeux nous place dans des conditions idéales pour le lancement d'une carte graphique à la fois haut de gamme et abordable. Ces conditions qui rendent la commercialisation viable d'un tel produit ne sont pas réunies si souvent comme le rappelle Jen Hsun Huang, le Président et CEO de Nvidia. De bons jeux et des cartes graphiques performances à moins de 300€, les joueurs PC sont gâtés en cette fin d'année. Page 2 - Un nouveau GPU qui garde ses secrets Une nouvelle pucePour permettre l'introduction d'une GeForce 8800 meilleur marché, Nvidia a développé un nouveau GPU, tiré de l'architecture GeForce 8 mais conçu dans l'optique de réduire les coûts de production. Premièrement le NVIO, la puce chargée de gérer les sorties vidéos des GeForce 8800 Ultra/GTX et GTS, disparaît et est intégrée au GPU. Mais ce n'est pas tout. Ce nouveau GPU, le G92, fait ainsi appel au procédé de fabrication 65 nanomètres, ce qui est une première chez Nvidia puisque le G80 (GeForce 8800 précédentes) était gravé en 90nm et les G84 et G86 (GeForce 8600 et GeForce 8400) l'étaient en 80nm. La réduction de la finesse de gravure permet de concevoir des puces plus petites et donc moins chères. Passer de 90 à 65nm permet à peu de choses près de doubler la densité des transistors et donc de réduire de moitié la taille de la puce. Mais ce G92 n'est pas simplement un G80 gravé plus finement. Il y a des différences. Malheureusement, Nvidia a soigneusement évité de répondre à toute question détaillée au sujet de ces différences, préférant se contenter de souligner les points principaux au niveau des "features" produit et surtout ne pas parler de la puce en elle-même. Ujesh Desai, General Manager pour les GeForce, a même été jusqu'à répondre "G92 ? je ne connais pas, c'est quoi ?" à une question concernant le G92. "G92, c'est peut-être ce qui est écrit en dessous du ventilateur de la carte graphique ?" avait envie de répondre l'assemblée. Nvidia semble en effet avoir décidé d'éviter de parler des puces pour se contenter de parler des noms de code des gammes de produits. Pour simplifier : au revoir G92 ("GPU capable de x à travers y unités"), bonjour D8P ("produit à 200€"). Cela laisse plus de flexibilité au marketing pour ajuster les produits et masquer des détails à la concurrence aussi longtemps que possible. La presse technique reste par contre sur sa faim puisqu'il est agaçant de ne pas pouvoir savoir de quoi est composé un GPU aussi bon soit-il.  Le schéma des unités de la GeForce 8800 GT, la puce en elle-même en contenant à priori plus. Enfin soit. Sur le plan des nouveautés dévoilées par Nvidia et disponibles sur la GeForce 8800 GT, nous noterons l'arrivée du PCI Express 2.0 et du VP2, le moteur vidéo de seconde génération qui prend en charge l'accélération H.264 à 100%. Concernant les spécifications, 112 processeurs scalaires et 16 ROPs sont annoncés pour la GeForce 8800 GT, à comparer aux 128 processeurs scalaires et aux 24 ROPs qui composent le G80. Il est probable que le G92 contiennent au moins 128 processeurs scalaires par contre nous supposons que les ROPs sont bien limités à 16 au niveau de la puce, tout comme le bus mémoire à 256 bits. Mais il ne s'agit que d'une supposition, Nvidia ne confirmant aucun détail lié à la puce. Petits détails techniques malgré tout dévoilés par Nvidia, l'amélioration du scheduler de manière à optimiser le load balancing et la structure des unités de texturing. Si dans le G80, il s'agit de blocs de 4 processeurs d'adresses liés chacun à 2 unités de filtrage, il s'agit de blocs de 8 processeurs d'adresses liés à 1 unité de filtrage dans le G92, tout comme c'était déjà le cas dans le G84 et G86. En gros cela permet de doubler la capacité du GPU à accéder aux textures basses précision quand elles ne sont pas filtrées ou limitées au filtrage bilinéaire. Il n'y a pas de différence en terme de débit pour les filtrages complexes ainsi que pour l'accès à des textures de plus haute précision (FP16, FP32). Plus que ce que Nvidia annonce ?Alors que le G80 est composé de 681 millions de transistors, le G92 affiche 754 millions au compteur. G80 – 8 ROPs – 128 bits du bus mémoire + NVIO + VP2 + processeurs d'adresses des textures et le compte est bon nous direz-vous. Ce n'est cependant pas aussi simple et ce nombre de 754 semble plutôt élevé. Car sur les 681 millions de transistors du G80, il y en a probablement une partie qui ne servent à rien, un premier GPU d'une génération donnée contenant toujours des fonctions buguées ou jugées inutiles au final, certaines unités ne sont pas implémentées d'une manière optimale et sont peaufinées par la suite etc. Du coup ce nombre plus élevé de transistors laisse planer de nombreuses questions sur ce que contient réellement le G92.  Plus que 16 ROPs et qu'un bus mémoire 256 bits ? Plus que 128 processeurs scalaires ? Une unité de tesselation ? Un support de la double précision sur les flottants ? Nvidia ayant annoncé qu'un GPU qui disposerait de cette capacité serait lancé cette année, le G92 nous ayant d'ailleurs été spécifiquement cité par Nvidia à ce sujet, en précisant qu'il ne serait accessible que à travers CUDA sur les produits Tesla et Quadro, nous nous attendions à une confirmation. La réponse de Nvidia a été "Non, pas de support de la double précision." Faut-il entendre par là que le marketing joue sur les mots en parlant du produit final "GeForce 8800 GT" qui ne supporte pas cette technologie alors que la puce "G92" la supporte ? Ou faut-il comprendre que Nvidia a rebroussé chemin, peut-être parce que cette implémentation s'est avérée boiteuse et préfère attendre un futur produit mieux conçu à ce niveau ? Page 3 - Spécifications, la carte, consommation, le test Les spécifications  Sur le plan des spécficiations, la GeForce 8800 GT est proche de la GeForce 8800 GTX au niveau de la puissance de calcul et de filtrage des textures mais par contre très loin en terme de bande passante mémoire son bus étant limité à 256 bits. La carte        La GeForce 8800 GT se contente d'un système de refroidissement single slot dont le côté esthétique est plutôt réussi. Par contre son efficacité est plus réduite que celle des systèmes que l'on retrouve sur les 8800 GTS/GTX et Ultra, ce qui est logique, ceux-ci étant nettement plus imposants. Du coup le ventilateur accélère plus souvent avec la GT, mais rien de très grave. Au repos la carte est silencieuse, un rien moins qu'une 8800 Ultra mais cela reste dans la catégorie "silence". En action le ventilateur se fait entendre quand il accélère mais elle reste nettement plus silencieuse qu'une Radeon HD 2900 XT par exemple. Les 512 Mo de mémoire GDDR3 embarqués sont signés Qimonda et il s'agit de mémoire 1 ns. La carte se "contente" d'un connecteur d'alimentation PCI Express 6 broches et n'offre par contre qu'un seul connecteur SLI, ce qui rend donc la GeForce 8800 GT incompatible avec le 3-way SLI qui devrait bientôt faire son apparition. Notez qu'il s'agit ici d'une carte de référence. Les premières cartes disponibles dans le commerce sont similaires, Nvidia livrant au départ uniquement des cartes toutes faites à ses partenaires. Cela permet à Nvidia de ne rien dévoiler ou presque à l'avance à ceux-ci sur le produit final tout en le rendant disponible au lancement. Les partenaires devraient pouvoir concevoir leur propre design par la suite. Côté overclocking, nous sommes passés de 600/1500/900 MHz (GPU, shader core, mémoire) à 690 / 1700 / 1060 MHz, ce qui représente un overclocking d'environ 15%. Nous nous attendions à un petit peu mieux du côté overclocking, mais ce résultat est dans la moyenne des cartes graphiques. Nous avons utilisé Riva Tuner 2.06 beta pour pouvoir overclocker indépendamment les 3 fréquences de la GeForce 8800 GT. ConsommationNous avons mesuré la consommation des différentes cartes. Ces données sont obtenues à partir des mesures effectuées à la sortie de la prise de courant : il s’agit donc de la consommation totale de l’alimentation de la machine, ici une Galaxy 850W d'Enermax.  Gros bénéfice du 65 nanomètres, la consommation plonge et si la carte reste gourmande et a besoin d'un connecteur d'alimentation PCI Express, nous sommes très loin des extrêmes que sont les GeForce 8800 Ultra et Radeon HD 2900 XT. La consommation en idle diminue fortement, ce qui est une très bonne chose. Au repos une GeForce 8800 Ultra consomme ainsi 50 watts de plus que cette 8800 GT ! Le testPour ce test, nous avons fait appel à 10 jeux dont 4 supportent DirectX 10. Les tests ont tous été exécutés en 1920x1200 et en 1280x1024 avec le filtrage anisotrope activé quand proposé par le jeu. Le HDR a été activé dans tous les cas où il est disponible. Enfin, le transparency/adaptive antialiasing était activé en mode multisampling, Nvidia venant d'en implémenter une nouvelle version plus efficace dans ses drivers. Du côté d'AMD il est forcé dans de nombreux jeux et il est maintenant possible de l'activer via le panneau de contrôle. Toutes les mises à jour pour Windows Vista relatives aux performances ont bien entendu été installées. ConfigurationIntel Core 2 Extreme QX6850 nForce 680i SLI EVGA 2 Go DDR2 Windows Vista Forceware 169.04 (169.05 pour Crysis) Catalyst 7.10 Page 4 - Video HD : performances et qualité Lecture vidéo HD  Si les premières cartes haut de gamme d'une génération donnée sont généralement très mal loties niveau vidéo HD, heureusement AMD et Nvidia prennent soin de corriger ce point sur les dérivés. Ainsi si les GeForce 8800 GTS/GTX/Ultra ne sont pas très efficaces sur le plan de l'accélération du décodage des vidéos HD, puisque reprenant le moteur vidéo VP1 des GeForce 7, la GeForce 8800 GT intègre le VP2, comme les GeForce 8400 et 8600. Nous avons mesuré les performances des différentes solutions à travers la lecture de 2 HD DVD, l'un en VC1 (King Kong) et l'autre en H.264 (Babel). La configuration de test est ici différente puisque basée sur un Core 2 Duo E6400. Au niveau logiciel, toujours sous Windows Vista, nous avons utilisé Power DVD en version 3104.  La GeForce 8800 GT tient ici ses promesses et avec la 8600 GTS se place loin devant les autres solutions haut de gamme. Nous nous sommes également intéressés à la qualité vidéo en nous basant sur les tests d'analyse de la suite HD HQV (voir ici pour le détail de tests).  La GeForce 8800 GT affiche le même résultat que la GeForce 8600 GTS. Les autres GeForce ont un problème avec l'inverse telecine et n'arrivent pas à reproduire ces vidéos avec une qualité correcte. Seule la Radeon HD 2900 XT obtient un indice de 100. La différence se situe au niveau de la réduction du bruit numérique. Du côté de Nvidia elle s'active via le panneau de contrôle des drivers suivant un niveau de 0 à 100. Poussé trop fort, il produit des défauts visuels. Nous l'avons donc positionné sur 51%. Notez que ce test est ici subjectif et que dans certaines vidéo il est bon de pouvoir désactiver cet effet, le bruit pouvant servir le film, or AMD ne permet pas de le désactiver ni de la paramétrer. Page 5 - Enemy Territory : Quake Wars Enemy Territory : Quake Wars  Si Quake Wars est basé sur le moteur de Doom 3, celui-ci a subi quelques évolutions telles que le megatexturing qui permet de faciliter le travail des artistes mais entraine un surcout au niveau du "décodage" et de l'accès aux megatextures. Quake Wars est donc un petit peu plus gourmand que Doom 3 et Quake 4. Nous avons enregistré une démo lors d'une partie contre 4 bots. L'intelligence artificielle n'étant pas reproduite lors du timedemo, elle ne limite pas les résultats qui sont donc moins limités par le CPU qu'en situation réelle, tout du moins contre des bots. Toutes les options sont poussées au maximum dans le jeu, ce qui inclus un filtrage anisotrope 16x. Le patch 1.2 est utilisé.  Dans ce premier test, la GeForce 8800 GT se place à mi chemin entre les versions GTS et GTX. La Radeon HD 2900 XT est en retrait et la GeForce 8600 GTS ne fait clairement pas partie de la même catégorie.  Une fois l'antialiasing activé, les performances de la GeForce 8800 GT chutent, à priori à cause de la bande passante mémoire réduite. Mais il est également possible qu'un manque de mémoire se fasse sentir, à l'image de la GeForce 8800 GTS 320. Page 6 - Half Life 2 - Episode 2 Half Life 2 Episode 2  Toujours basé sur le Source Engine, Half Life 2 Episode 2 n'apporte pas de réelle nouveauté sur le plan technique et se contente de mieux utiliser et d'utiliser plus souvent ce dont est capable le moteur, ce qui rend le jeu plus gourmand que ses prédécesseurs. Nous exécutons une démo et toutes les options du jeu sont poussées au maximum, y compris le filtrage anisotrope qui est donc en 16x.  La GeForce 8800 GT talonne ici sa grande sœur et se démarque très nettement des 8800 GTS. La 8600 GTS est près de 3x moins performante.  Situation identique une fois l'antialiasing 4x activé, si ce n'est pour la Radeon HD 2900 XT qui voit ses performances se réduire relativement plus. Page 7 - S.T.A.L.K.E.R. S.T.A.L.K.E.R.  Nous effectuons un déplacement toujours identique et mesurons le framerate avec fraps. Nous testons le jeu avec un niveau de qualité élevé, éclairage dynamique complet, détails maximums (avec filtrage anisotrope 16x) et ombres des herbes. S.T.A.L.K.E.R. utilise un moteur à base de rendu différé ce qui est fondamentalement incompatible avec du MSAA, ce qui rends l'utilisation de l'antialiasing impossible. Une espèce de filtrage des arrêtes réalisé via un shader est activable mais il offre un résultat mitigé voir invisible, nous ne l'avons donc pas utilisé. Le patch 1.00004 est utilisé.  La GeForce 8800 GT se place entre la GTS et la GTX. La GeForce 8800 GTS 320 est nettement en retrait, 320 Mo étant insuffisants pour ce jeu. Page 8 - Rainbow Six : Vegas Rainbow Six : Vegas  Premier jeu PC basé sur l'Unreal Engine 3.0, Rainbow Six : Vegas reste un jeu très gourmand. Nous mesurons les performances sur la scène d'introduction. Le mode HDR est activé et est plus ou moins obligatoire sans quoi le banding est très présent. Les ombres sont réglées sur "bas", les modes supérieurs entraînant une trop forte baisse de performances dans certains endroits.  Portage de la Xbox 360, le jeu semble naturellement bien aimer la Radeon HD 2900 XT qui partage une architecture similaire à celle de la puce graphique de la console. La Radeon termine donc première, une fois n'est pas coutume. La GeForce 8800 GT est ici très proche de la 8800 GTX, la puissance de calcul étant l'élément primordial.  Le jeu ne supporte pas l'antialiasing mais Nvidia l'a implémenté dans ses drivers, tout comme pour Oblivion, contrairement à AMD qui ne s'est malheureusement pas donné cette peine. Cette fois la GeForce 8800 GT se place à mi chemin entre la GTS et la GTX et la GTS 320 ne dispose pas d'assez de mémoire pour que le jeu se lance en 1920x1200. Page 9 - Oblivion Oblivion  Nous effectuons un déplacement précisément défini afin qu’il soit toujours identique et que le test soit reproductible. Le HDR est bien entendu de la partie.  Très dépendant de la puissance de calcul en mode HDR, Oblivion place la GeForce 8800 GT tout près du modèle GTX.  Classements similaires avec FSAA 4x. Page 10 - Colin McRae DIRT Colin McRae DIRT  Pour tester le dernier opus des Colin McRae, qui est très gourmand, nous réalisons un déplacement bien défini en mode qualité élevée. Notez que l'activation de l'antialiasing est vivement conseillée compte tenu de la manière dont sont rendus les menus et du fait que les effets de post process employés amplifient l'aliasing. Le patch 1.2 est appliqué.  Une nouvelle fois, la GeForce 8800 GT se place entre les GTS et GTX. La Radeon est pour se part au niveau des GeForce 8800 GTS alors que la GeForce 8600 GTS est nettement derrière.  Pas de gros changement avec antialiasing, si ce n'est que les 320 Mo de la GeForce 8800 GTS 320 sont insuffisants. Page 11 - Bioshock Bioshock  Premier jeu basé sur l'Unreal Engine 3.0 à supporter DirectX 10, Bioshock est un jeu très réussi graphiquement et ce même en mode DirectX 9 alors qu'il est moins gourmand que Rainbow Six : Vegas. Nous effectuons un déplacement bien défini et toutes les options sont poussées au maximum.  En mode DirectX 9, la Radeon HD 2900 XT se montre plutôt véloce, très proche de la GeForce 8800 Ultra. Le reste du classement est sans surprise.  Tout comme pour Rainbow Six : Vegas, Nvidia permet d'activer l'antialiasing dans ce jeu qui ne le supporte pas à la base. AMD ne le permet pas. Pour une raison inconnue, il nous a cependant été impossible d'activer l'antialiasing sur les GeForce 8800 et 8600 GTS.  En mode DirectX 10, les performances des GeForce 8 restent similaires à ce que nous avons pu obtenir en mode DirectX 9. Par contre du côté de la Radeon, c'est la chute libre pour une raison inconnue. Notez qu'il n'est pas encore possible d'activer d'antialiasing en mode DirectX 10, tant chez Nvidia que chez AMD. Page 12 - Company of Heroes Company of Heroes  Company of Heroes ayant reçu un patch DirectX 10 qui apporte un réel plus sur le plan graphique, nous avons décidé de l'ajouter à notre protocole de test. Toutes les options sont poussées à leur maximum, à l'exception des détails du terrain qui restent sur High (le mode Ultra étant réservé à DirectX 10) et des textures qui restent elles aussi sur High, le jeu indiquant un manque de mémoire système sur les GeForce en mode DirectX 9 avec les textures Ultra. Nous exécutons le test intégré sur la version 1.71.  La GeForce 8800 GT est tout juste devant la Radeon et nettement devant les 8800 GTS.  Une fois l'antialiasing 4x activé, les performances de la Radeon HD 2900 XT plongent, alors que les GeForce 8 affichent des résultats consistants.  En DirectX 10, les performances sont clairement inférieures, le moteur affichant des graphismes plus avancés. La Radeon se place au niveau de la 8800 GTS 320, soit derrière la 8800 GT.  Classement identique avec antialiasing et perte relativement plus importante du côté de la Radeon HD 2900 XT. Notez que la GeForce 8600 GTS montre ici ses limites et se place très loin derrière. Page 13 - World in Conflict World in Conflict  Très réussi visuellement et très gourmand, il était logique de voir World in Conflict joindre notre suite de tests. Nous exécutons le test interne avec le patch 1.0002. Toutes les options sont poussées au maximum.  La Radeon HD 2900 XT ne brille pas dans ce jeu et se place derrière la GeForce 8800 GTS, tout du moins en version 640 Mo, la version 320 Mo étant larguée, à cause d'une mémoire insuffisante.  Avec antialiasing 4x, la GeForce 8800 GT semble être quelque peu limitée par sa bande passante mémoire et ne se démarque donc que très peu de la 8800 GTS.  Alors que les performances des GeForce 8 baissent légèrement un mode DirectX 10, celles de la Radeon HD 2900 XT augmentent, ce qui la place à hauteur de la GeForce 8800 GT.  Pour la seule et unique fois de ce comparatif, la GeForce 8800 GTS 640 Mo devance la 8800 GT. Page 14 - Crysis - démo SP Crysis - démo SP  Bien qu'il ne soit pas dans notre habitude d'utiliser des démos dans notre suite de test, il est difficile de faire l'impasse sur Crysis tant ce jeu est attendu et redéfinit la qualité graphique moderne. Nous exécutons le test interne en mode DirectX 9 High (forcé via l'ajoute de –dx9 derrière l'exécutable) et en mode DirectX 10 Very High. Notez qu'une polémique a fait surface au sujet d'un bug dans les pilotes Nvidia 169.04 dont la conséquence était que la réflexion à la surface de l'eau se trouvait déforméé puisqu'elle n'était pas actualisée assez souvent. Etant calculée moins souvent, les performances augmentaient, tout du moins dans certains conditions telles que le 1920X1200 avec AA4x en mode DirectX 10 (+30%). Nous pensions au départ qu'il s'agissait d'un bug du jeu. Mais il s'est avéré que renommer l'exécutable de manière à ce que le pilote Nvidia ne puisse plus le détecter corrigeait le problème. De quoi avoir quelques soupçons sur ce bug. Nous avons contacté Nvidia à ce sujet qui a confirmé le bug et le gain de performances qu'il pouvait entraîner. Nvidia nous a fourni un driver qui ne pose plus ce problème (169.05), que nous avons bien entendu utilisé ici. Le fabricant a également détaillé le bug en question de manière à éviter tout mal entendu à son sujet. Le moteur de Crysis essaye d'éviter de recalculer la réflexion sur l'eau autant que possible, ce qui est une optimisation logique. Pour ce faire, il utilise 3 données : le temps écoulé depuis la précédente actualisation, le mouvement de la caméra, et le nombre de pixels "eau" visibles à l'écran. Il serait bien entendu ridicule de recalculer toute une réflexion pour une poignée de pixels. C'est d'ailleurs cette dernière valeur qui est la source du problème. Pour connaître le nombre de pixels "eau" visibles, le moteur effectue un test d'occlusion sur le GPU, retourne le résultat au système qui l'utilise pour déterminer si la réflexion doit être mise à jour ou pas. Pour éviter de perdre du temps (CPU qui attend le résultat du GPU), pour une image donnée, le moteur se base sur le résultat du test d'occlusion d'une image précédente, une image de décalage par exemple. Or en SLI cela pose problème puisque une image de décalage signifie que le GPU2 va alors devoir attendre que le GPU1 ait effectué le test d'occlusion. Le SLI ne peut donc pas apporter le moindre gain. La démo et probablement le jeu devront être mis à jour pour prendre en compte les systèmes multi-GPUs en synchronisant l'utilisation des tests d'occlusions de manière à éviter de bloquer une partie du système. En attendant, et pour que le SLI montre des gains (tout en causant potentiellement des bugs), Nvidia a en quelque sorte faussé le test d'occlusion en reportant directement toujours la même chose au moteur : l'eau est visible mais sur très peu de pixels. Dans le cas où en réalité le test aurait détecté que l'eau n'est pas visible, les GeForce 8 traitent l'eau pour rien (mais sans actualiser la réflexion bien entendu). Dans le cas où le test aurait détecté que l'eau est visible en masse et donc que la réflexion doit être actualisée, les GeForce 8 reportent toujours que l'eau n'est que très peu visible et le bug apparaît. Au final, l'eau représentant souvent une partie importante de l'écran dans le test de la démo, les GeForce 8 sont avantagées par ce bug. Mais en quoi une optimisation pour le SLI est elle liée au problème en question ? Indirectement puisqu'un bug cette fois dans le driver lui faisait appliquer le profil SLI même avec un seul GPU. C'est ce que Nvidia a corrigé avec les pilotes 169.05. Le problème reste donc d'actualité en SLI et le restera jusqu'à ce que le jeu soit mis à jour pour permettre au SLI de fonctionner. Ceci étant dit, nous pouvons passer aux résultats.  La GeForce 8800 GT est proche de la GTX et tout juste devant la Radeon HD 2900 XT. Notez que seules les GeForce 8800 GT/GTX/Ultra permettent de jouer en mode High et en 1280x1024, et encore c'est tout juste. Le jeu est très gourmand à tous les niveaux, y compris sur la mémoire puisque les 320 Mo de la GeForce 8800 GTS 320 sont déjà insuffisants.  Avec antialiasing, de nombreuses cartes commencent déjà à voir rouge. Si les GeForce 8800 GTX et Ultra s'en tirent assez bien, la GT s'écroule en 1920x1200. Quant à la Radeon HD 2900 XT, elle voit ses performances divisées par 2 !  Tous détails poussés à fond et en DirectX 10, la GeForce 8800 GT a du mal à se démarquer de la 8800 GTS 640 Mo en 1920x1200 mais reste devant la Radeon HD 2900 XT.  Jouer tout à fond en 1280x1024 avec la plus grosse carte haut de gamme du moment ? Impossible. Toutes les cartes sont à genoux. Vivement le SLI de GeForce 9800 ! Page 15 - Récapitulatif RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en se basant sur l'ensemble de résultats et en donnant le même poids à chacun des jeux. L'indice 100 a été attribué à la GeForce 8800 GTX en 1280x1024.  En moyenne la GeForce 8800 GT se situe 10% en retrait par rapport à la GeForce 8800 GTX, ce qui plutôt pas mal pour une carte vendue à la moitié du prix ! Elle se place ainsi plus près de la GTX que de la GTS et très très loin devant le précédent haut du milieu de gamme Nvidia qu'est la GeForce 8600 GTS. La GeForce 8800 GT termine également devant la Radeon HD 2900 XT.  Avec le filtrage antialiasing 4x activé, la GeForce 8800 GT se place cette fois un peu plus près de la GTS ou un peu plus loin de la GTX, c'est selon. Mais les performances restent très bonnes. La GeForce 8800 GTS 320 Mo est ici clairement limitée par sa mémoire. Quant à la Radeon HD 2900 XT, ses ROPs bugués au niveau de l'antialiasing ont poussé AMD à utiliser une solution de rechange qui, si elle est très flexible, bride les performances. Notez que certaines cartes voient leur score moyen réduit de par le fait qu'elles ne sont pas capables d'afficher de l'antialiasing dans Rainbow Six : Vegas et dans Bioshock. Cependant, le classement reste identique si nous avions exclu ces jeux. Vous pouvez le consulter ici.  En DirectX 10, la GeForce 8800 GT ne déçoit pas et se positionne toujours entre la GTS et la GTX et devant la Radeon HD 2900 XT.  En DirectX 10 et avec FSAA 4x, la GeForce 8800 GT est plus limitée, probablement par sa bande passante mémoire, mais reste malgré tout du niveau de la Radeon HD 2900 XT et de la GeForce 8800 GTS 640 Mo, les 3 cartes terminant dans un mouchoir de poche. Dans ces conditions extrêmes, les GeForce 8800 GTX et Ultra conservent un avantage. Page 16 - Conclusion ConclusionA la lecture de ce test, il apparaît évident que Nvidia frappe fort avec cette GeForce 8800 GT. Si les produits haut de gamme dérivés de la première architecture DirectX 10 de Nvidia nous avaient convaincus, il n'en allait pas de même des versions milieu de gamme puisque les GeForce 8600 GT et 8600 GTS nous avaient laissés sur notre faim en affichant des performances quelque peu décevantes. Il n'y avait donc pas réellement d'alternative DirectX 10 au haut de gamme plutôt onéreux, Nvidia n'ayant pas été inquiété par la concurrence.  Cette GeForce 8800 GT vient ainsi prendre place sur le plan tarifaire, entre le haut de gamme et le milieu de gamme, mais en offrant une prestation haut de gamme ! Pour 230 à 250€ vous disposerez ainsi de performances variant en général entre 75 et 90% de ce qu'affiche la GeForce 8800 GTX vendue à un prix supérieur de deux fois. La belle affaire pour les joueurs, d'autant plus en cette époque riche en sortie de très bons jeux. Mais ce n'est pas tout puisque Nvidia a soigné la consommation qui se réduit significativement, grâce entre autre à l'utilisation d'un procédé de fabrication plus moderne, et a intégré un moteur vidéo plus évolué qui permet à la GeForce 8800 GT d'être la première carte graphique performante et adaptée à la vidéo HD.  Le sans faute ? Question piège à quelques jours de la sortie de la Radeon HD 3800 d'AMD qui apportera le support du futur DirectX 10.1, nous réserverons donc cette réponse à l'article qui comparera les 2 solutions. Néanmoins, il est évident qu'il sera difficile pour AMD d'égaler cette GeForce 8800 GT sur le plan des performances dans ce segment de prix. Nous terminerons par une petite note sur les prix annoncés par les constructeurs, en l'occurrence par Nvidia. Le prix étant un élément très important dans l'analyse d'un produit, depuis quelques temps les fabricants de GPUs annoncent des prix tirés par le bas qui ne correspondent pas au prix du marché. Nvidia nous a ainsi annoncé un prix de lancement de 199$ (soit 179€ TTC), nous assurant que des cartes seraient disponibles à ce prix. Après avoir vérifié les prix pratiqués par Nvidia à ses partenaires, nous avons constaté (sans surprise) qu'ils étaient totalement incompatibles avec un prix de vente de 199$ même si le magasin et l'importateur ne prenaient pas de marge ! Nvidia a alors parlé de prix supposé dans le futur, puis de prix de la carte équipée de 256 Mo qui va bientôt arriver… Précisons que Nvidia Europe, habitué à ce que la presse n'aime pas se faire baratiner, a de son côté annoncé un prix réaliste de 219 à 249€. Et à ce prix la GeForce 8800 GT est un excellent produit. Du coup on se demande pourquoi avoir insisté sur un prix irréaliste du côté de Nvidia US. Pour faire peur à AMD ? Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |