| |

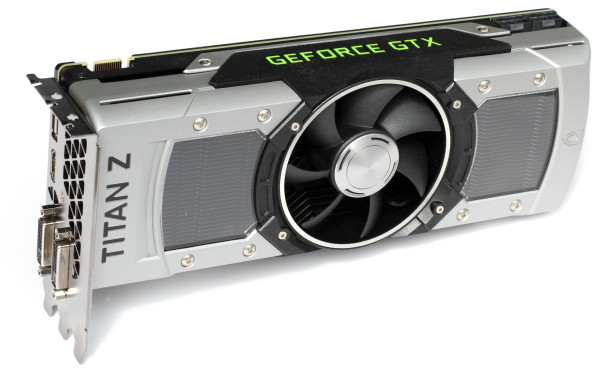

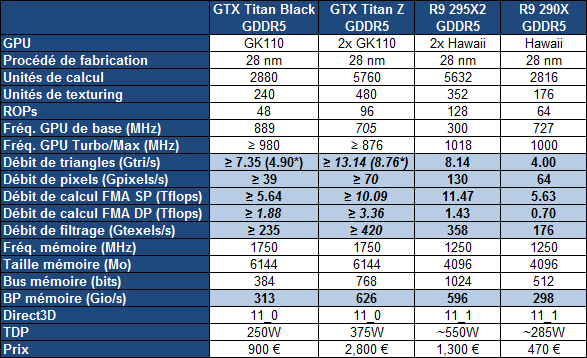

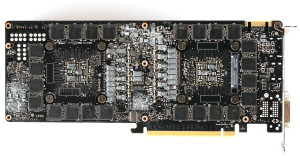

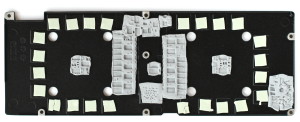

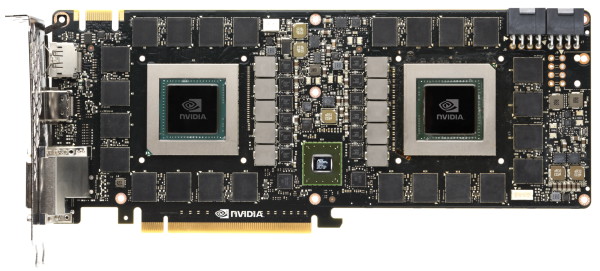

| Nvidia GeForce GTX Titan Z : la carte graphique à 3000€ en test Cartes Graphiques Publié le Vendredi 1er Août 2014 par Damien Triolet URL: /articles/925-1/nvidia-geforce-gtx-titan-z-carte-graphique-3000-test.html Page 1 - Introduction Au printemps, Nvidia a levé le voile sur un petit monstre qui était attendu depuis de nombreux mois par les amateurs de performances graphiques extrêmes : la GeForce GTX Titan Z équipée de 2 GPU GK110. Avec un surprise à la clé : son prix de près de 3000€, un nouveau record ! Nous avons enfin pu mettre la main sur cette carte graphique aussi exclusive qu'élitiste et bien entendu cherché à savoir comment elle se comportait face à la Radeon R9 295 X2.  Une carte graphique semi-pro ?Mettre au point une carte graphique fiable à base de 2 GPU, qui plus est quand ceux-ci sont déjà à la base relativement gourmands, est pour le moins complexe. La finalisation de la GeForce GTX Titan Z a ainsi pris plus de temps que prévu, ce qui explique selon Nvidia son retard de près de 2 mois. Aucune approximation ne peut bien entendu être tolérée sur un produit aussi exclusif et Nvidia a pris le temps de fignoler la bête. Impossible cependant d'ignorer qu'entre temps, AMD a également lancé une solution bi-GPU extrême avec la Radeon R9 295 X2. En ayant recours au refroidissement à eau, AMD s'est donné beaucoup plus de marge en terme de consommation maximale, ce qui influence directement les performances sur les gros GPU modernes. De manière évidente, avec un refroidissement à air, même de très bonne qualité, Nvidia n'avait aucune chance de l'emporter et préférait alors éviter toute confrontation directe. Pas si simple d'assumer une défaite avec un produit plus de 2x plus cher, même si les performances brutes ne font pas tout. Nous ne savons pas avec certitude si cette crainte d'une défaite a également joué dans la commercialisation tardive de la GeForce GTX Titan Z, mais cela a sans aucun doute été l'élément déterminant dans l'absence d'échantillons de test. Nvidia ne s'est pas contenté de ne pas en fournir à la presse mais a également exigé de tous ses partenaires qu'ils en fassent de même. Nous avons ainsi dû nous tourner vers un échantillon commercial, ce qui, comme vous pouvez l'imaginer, n'est pas évident pour une carte graphique aussi chère. Pour justifier sa réticence de dernière minute face aux tests de la GeForce GTX Titan Z, Nvidia nous explique qu'il ne s'agit pas réellement d'une carte graphique pour joueurs et qu'elle est en grande partie destinée aux professionnels. Comme toutes les GeForce GTX Titan, elle est en effet équipée d'une quantité de mémoire importante et libérée de toute limitation artificielle de sa puissance de calcul en double précision. Si nous acceptons bien volontiers de la qualifier de carte graphique semi-pro, de là à oublier qu'il s'agit avant tout d'une GeForce et donc d'une carte graphique dédiée au jeu, il y a cependant un pas difficile à franchir. Les services commerciaux de Nvidia ne sont d'ailleurs pas sur la même longueur d'onde que ses services de communications. Voici le résumé officiel affiché sur la page commerciale de la GeForce GTX Titan Z : GeForce® GTX™ TITAN Z is a gaming monster, the fastest graphics card we've built to power the most extreme PC gaming rigs on the planet. Stacked with 5760 cores and 12 GB of memory, this dual GPU gives you the power to drive even the most insane multi-monitor displays and 4K hyper PC machines. C'est donc sous cet angle que nous avons décidé d'aborder cette carte graphique. A noter cependant que dès mi-juin, quand nous avons commencé à travailler sur ce test, nous avons demandé à Nvidia s'ils avaient un exemple intéressant à nous proposer pour illustrer la capacité de calcul en double précision de la GeForce GTX Titan Z. Nous n'avons jamais eu de réponse. Il faut dire que l'aspect calcul massivement parallèle n'est pas simple à mettre en avant et Nvidia le sait très bien. Les tests pratiques ne sont pas courants et dépendent beaucoup de l'optimisation spécifique qui a été faite pour un GPU particulier alors que les tests synthétiques affichent des résultats très aléatoires suivant la fonction testée, qui peut s'accorder ou pas avec chaque architecture. Il faut ajouter à cela un support du multi-GPU qui n'est pas automatique. Par ailleurs, les Radeon récentes disposent d'une architecture plutôt polyvalente au niveau du calcul, ce qui leur donne un avantage dans de nombreux tests synthétiques. Même en double précision, là où les GeForce GTX Titan disposent d'une puissance de calcul plus élevée, les Radeon peuvent passer devant. Mais en réalité, pour Nvidia, le calcul massivement parallèle passe par son langage propriétaire CUDA et de ce point de vue, son dernier bébé n'a tout simplement pas de concurrence. Si ses deux GPU sont bien exploités, avec 10 Tflops en simple précision et 3 Tflops en double précision, la GeForce GTX Titan Z est l'accélérateur CUDA le plus performant du moment. Pour le reste, soit les performances en jeu et le comportement thermique de la carte, place aux tests. Page 2 - Spécifications, la GeForce GTX Titan Z Spécifications  La GeForce GTX Titan Z est une double GeForce GTX Titan Black. Elle est basée sur 2 GPU GK110 B1 identiques en tous points, en dehors de leur fréquence qui a été revue de manière à s'accorder avec le TDP qui ne progresse que de 250 à 375W (+/- 400W en réalité). Impossible bien entendu dans ces conditions, et avec un refroidissement à air, de proposer un même niveau de fréquence, même si Nvidia a probablement fait en sorte de sélectionner les meilleures puces GK110, c'est-à-dire celles dont la consommation relative est plus faible. La fréquence est contrôlée par GPU Boost qui fait en sorte de ne pas dépasser les limites de température (83 °C) et de consommation (voir détails plus bas). Si une de ces limites est atteinte, la fréquence GPU est réduite progressivement, jusqu'à la fréquence de base. Une fois celle-ci atteinte, GPU Boost laisse la température GPU (et la vitesse du ventilateur) progresser. Nvidia a spécifié cette fréquence de base à un niveau relativement faible dans le cas de la GeForce GTX Titan Z de manière à ne pas rentrer trop vite dans ce cas critique. Nvidia parle d'une fréquence GPU Boost de 876 MHz, mais rappelons qu'elle ne correspond techniquement à rien. Nvidia a besoin d'une telle fréquence en terme de communication et la définit au cas par cas suivant des critères qui ne sont pas communiqués. La seule chose dont nous sommes sûrs c'est qu'aucun échantillon d'une carte graphique ne sera équipé de GPU incapables de monter au moins à cette fréquence dans des conditions avantageuses (charge faible et GPU froid). En réalité, la fréquence turbo maximale de ces GPU est similaire à celle de ceux qui équipent les GeForce GTX Titan Black, et peut ainsi monter jusqu'à +/- 1.1 GHz dans le cas des meilleurs échantillons (1071 MHz dans notre cas). La GeForce GTX Titan Z n'est bien entendu pas capable de maintenir ces fréquences maximales dans les jeux, la limite de consommation est rapidement atteinte et la température quelques temps après. Suivant les jeux, après quelques minutes de charge, notre carte tournait ainsi entre 706 et 863 MHz. Par défaut, la double précision est désactivée. Il faut passer par le panneau de contrôle Nvidia pour l'activer, ce qui augmente quelque peu la tension relative et réduit par conséquent légèrement la fréquence maximale, probablement parce que ces unités de calcul spécifiques sont plus capricieuses. C'était déjà le cas sur la première GeForce GTX Titan, mais pour cette dernière la baisse de fréquence était très importante (par exemple de 1006 à 850 MHz). Dans le cas de la GTX Titan Z, et nous le supposons de la GTX Titan Black, la baisse de la fréquence maximale est bien plus faible (de 1071 à 1032 MHz). Au final, la GTX Titan Z affiche une puissance de calcul d'un peu plus de 10 Tflops à 876 MHz (et de plus de 12 Tflops si ses GPU ne sont pas limités par leur consommation ou par le ventirad et tournent à leur fréquence maximale). Là où elle se démarque de la Radeon R9 295 X2, c'est bien entendu sur la puissance de calcul en double précision avec 3.3 Tflops contre 1.4 Tflops (et presque 4 Tflops à fréquence maximale !). La GTX Titan Z affiche une bande passante mémoire similaire à la R9 295 X2, profitant d'une mémoire GDDR5 cadencée à 1750 MHz pour compenser les bus mémoire plus étroits de ses GPU. Chacun de ceux-ci dispose de sa propre mémoire de 6 Go, contre 4 Go du côté de la Radeon. GeForce GTX Titan Z de référence      La GeForce GTX Titan Z de référence reprend le design qui, depuis la GTX 690, est devenu habituel pour les solutions haut de gamme Nvidia. Ce design fait la part belle aux matériaux de qualité et est extrêmement bien fini en plus d'être travaillé dans le détail à tous les niveaux de manière à gagner quelques points d'efficacité. Pour cette nouvelle variante bi-GPU de son ventirad, Nvidia a opté pour une épaisseur de 2.5 slots qui permet d'exploiter des radiateurs plus volumineux et un ventilateur plus épais et performant. En pratique cela correspond évidemment à un encombrement de 3 slots au niveau des équerres PCI. Un petit espace supplémentaire qui permet de garantir une alimentation suffisante en air frais. Plus spécifiquement, le PCB est recouvert d'une plaque en aluminium en contact avec les puces mémoire de la face avant et les composants sensibles de l'étage d'alimentation. Au-dessus de celui-ci, un radiateur est intégré à cette plaque et est surmonté par le ventilateur. De chaque côté de ce dernier prennent place les blocs chambres à vapeur et radiateur de chaque GPU. L'air chaud sera ainsi expulsé via les 2 extrémités de la GTX Titan Z, ce qui signifie que seule la moitié de cet air chaud sera dirigée vers l'extérieur du boîtier. A l'arrière de la carte, une seconde plaque en aluminium recouvre également le PCB. Celle-ci n'est pas simplement là pour des raisons esthétiques et pour protéger la carte mais également pour faire office de dissipateur pour d'autres composants de l'étage d'alimentation, ainsi que pour l'autre moitié des modules mémoire. Au niveau de la connectique, Nvidia propose 2 sorties DVI Dual-Link, une sortie HDMI et une sortie DisplayPort. Deux connecteurs PCI Express 8 broches sont nécessaires et un connecteur SLI est présent pour pouvoir associer ensemble deux de ces cartes.  Le PCB de 28 cm est plutôt compact pour une carte de ce type (30.5 cm pour la Radeon R9 295 X2). A noter que nous avons évité de démonter complètement notre échantillon et que cette dernière photo est la photo officielle de Nvidia sur laquelle le marquage de GK110-350-B1 est masqué. Nous pouvons y observer le switch PCI Express 3.0 de PLX (PEX8747) ainsi que les différents circuits d'alimentation : 2x 6 phases pour les GPU et 2x 2 phases pour leur mémoire dédiée. Nvidia indique que le design de ces circuits d'alimentation des GPU est très complexe : pour la première fois ils ont été liés de manière à pouvoir faire du load balancing. Dans certains cas le circuit d'alimentation d'un GPU peut venir aider l'autre. Nous ne savons pas si cette possibilité est exploitée en pratique, ni dans quelle situation c'est le cas, ni comment cela fonctionne (une phase de l'un attribuée à l'autre ?). Sur ce PCB, Nvidia a mis en place 5 petits circuits de mesure de la consommation issue du 12V. Pourquoi 5 ? Probablement pour pouvoir assurer différentes protections sur chacun des canaux d'alimentation. Nous supposons que trois de ces circuits sont dédiés à chaque entrée 12V de la carte, les 2 connecteurs 8 broches et le bus PCI Express. Nvidia peut ainsi s'assurer que la limite de 5.5A pour le 12V du bus n'est pas dépassée tout comme celle des 12.5A des connecteurs 8 broches (en pratique Nvidia vise probablement une limite légèrement plus élevée au niveau de ces derniers). Ensuite, il semble que deux mesures supplémentaires soient effectuées juste avant l'entrée 12V des étages d'alimentation de chaque GPU (GPU + mémoire). De quoi cette fois pouvoir protéger chaque GPU d'une surconsommation. Un rapide aperçu des bios de la GTX Titan Z montre une limite de 189W par GPU (avec sa mémoire donc), ce qui nous donne une consommation totale de 378W + les extras en 12V (switch PCI Express) + le 3.3V. La consommation totale de la carte est ainsi plutôt de 400W et non de 375W comme annoncé par Nvidia. A 100% de consommation pour chaque GPU, et avant que la limite de température ne soit atteinte, nous avons d'ailleurs noté 399.4W. Il est possible de pousser la limite de consommation jusqu'à 120% ce qui correspond à 227W par GPU soit à peu près à 475W pour la carte dans son ensemble. Nous n'avons pas observé de limite de consommation plus élevée lorsque le multi-GPU n'est pas utilisé (faute de profil adapté) ou lorsqu'il est désactivé manuellement dans les pilotes et qu'un seul GPU est alors exploité. Dans ce dernier cas, la fréquence maximale du premier GPU a par contre progressé de 13 MHz, passant de 1071 MHz à 1084 MHz. Par défaut, avec le SLI activé, la fréquence appliquée est toujours identique pour les 2 GPU, ce qui veut dire que c'est le moins doué des GPU qui définit la fréquence. Dans notre cas, avec SLI actif, le GPU1 pouvait monter à 1071 MHz alors que le GPU2 le limitait à 1058 MHz bien qu'en pratique, à de rares et brèves exceptions, la fréquence maximale observable était plutôt de 1045 MHz. Nous avons observé de fortes augmentations de tension pour les niveaux de turbo les plus élevés : GPU1 @ 1.2000V : 1084 MHz GPU1 @ 1.1750V : 1071 MHz GPU1 @ 1.1375V : 1058 MHz GPU1 @ 1.1000V : 1045 MHz GPU1 DP @ 1.1750V : 1032 MHz GPU2 @ 1.1875V : 1058 MHz GPU2 @ 1.1500V : 1045 MHz Repos pour les 2 GPU : 0.8625V Page 3 - Consommation ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 7 ainsi qu'en veille écran de manière à observer l'intérêt de ZeroCore Power. Pour la charge, nous avons dû revoir notre protocole, ces solutions multi-GPU haut de gamme poussant les performances dans les limites du CPU, ce qui empêche d'observer leur consommation réelle. Nous avons remplacé Battlefield 3 par Battlefield 4, en passant en qualité Ultra et en 2560x1600. Anno est conservé et passe simplement en 2560x1600 au lieu du 1920x1080. A noter que 'Uber' dans le cas des GeForce GTX représente la modification de leurs paramètres pour autoriser une température et une consommation plus élevées (sans overclocking). Les GTX 780 Ti 'Uber' passent à 95 °C / 106% et la GTX Titan Z passe à 95 °C / 120%. Cela permet de libérer ces GeForce un petit peu comme le fait AMD avec le bios Uber de la Radeon R9 290X. Les Radeon ont l'avantage en veille écran étant donné qu'elles sont capables d'éteindre leurs GPU et leurs ventilateurs. Précisons que le ventilateur central de la R9 295 X2 se coupe bien dans ce mode mais pas celui présent sur le radiateur, ni les pompes. Sur le bureau Windows, malgré le fait que le second GPU reste éteint, la consommation est plus que doublée par rapport à celle des cartes mono-GPU. La consommation est lors similaire à celle de la GTX Titan Z. En charge, nous mesurons 360W dans Anno 2070 pour la GeForce GTX Titan Z alors que la Radeon R9 295 X2 atteint plus de 500W, un record qui la pousse bien au-delà des normes ou recommandations pour les connecteurs PCI Express, soit 375W au maximum pour la configuration de cette carte. Précisons cependant que la consommation via le bus PCI Express, qui peut représenter un stress pour la carte-mère, reste réduite (2.1A) pour la Radeon alors qu'elle s'approche de la limite pour la GTX Titan Z (5.2A). En libérant le GPU autant que possible de ses limites, soit en mode 'Uber', la consommation monte à plus de 450W dont 5.7A via le bus PCI Express. En mode classique, la GTX Titan Z se stabilise à 797 MHz dans Anno et à 876 MHz dans Battlefield 4. Les GPU atteignent la température de 82 °C, ce qui est le facteur limitant et correspond à une consommation moyen de 92% pour le GPU1 et de 90% pour le GPU2. En mode 'Uber', la fréquence GPU grimpe à 941 MHz dans Anno et à 1006 MHz dans Battlefield 4. Les GPU montent cette fois à 86 °C avec un niveau de consommation moyen de 115/116% dans le premier jeu et de 115/113% dans le second. C'est cette fois ce niveau de consommation qui limite le GPU, des pointes atteignant la limite maximale de 120%. Si mesurer la consommation des cartes seules est nettement plus précis qu'une mesure à la prise de l'ensemble du système, cette dernière reste utile pour comparer les systèmes multi-cartes, d'autant plus qu'ils impliquent l'alimentation de plus de lignes PCI Express. Il n'y a cependant pas de méthode parfaite à ce niveau étant donné que la charge CPU va varier avec la puissance graphique ou avec les pilotes. Il est possible d'assurer une charge CPU constante à travers des tâches de type Prime, mais elles peuvent avoir un impact sur les performances. Nous ne l'avons donc pas fait ici et il faut ainsi garder en tête que les systèmes bi-GPU vont voir leur consommation augmenter quelque peu à cause de la charge CPU en hausse. Par ailleurs, le rendement de l'alimentation n'est pas constant. Par exemple, sous 100W, une partie d'une réduction de la consommation peut être masquée par une baisse du rendement. Enfin, nous avons ajouté un ensemble CrossFire X de R9 290X OC de Gigabyte, de quoi avoir une idée de la consommation maximale d'un tel ensemble capable de maintenir de hautes fréquences tout comme la R9 295X2. Sur le bureau Windows en 2560x1600, toutes les solutions bi-GPU se comportement à peu près de la même manière, à l'exception de la GTX Titan Z, plus gourmande d'une quinzaine de watts. En charge, la consommation du système à base de Radeon R9 295X2 est supérieure à celle d'un ensemble de 2 Radeon R9 290X de référence en mode Uber, mais les fréquences maintenues sont plus élevées (GPU1/2 sous Anno : 970/995 MHz contre 880/995 MHz). A fréquence identique, les 2 Radeon R9 290X consomment légèrement plus. Les 2 cartes Gigabyte représentent une consommation près de 100W plus élevée que pour la R9 295X2 en charge très lourde, mais avec une fréquence encore plus élevée (1020/1040 MHz). Du côté des GeForce, la GTX Titan Z affiche une consommation similaire à celle des GTX 780 Ti en SLI, que ce soit en mode classique ou 'Uber'. Page 4 - Bruit et températures Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge sous le test1 de 3DMark11. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe à moins de 20 dBA, ce qui est la limite de sensibilité pour laquelle il est certifié et calibré. Dans le cas de la R9 295 X2, le radiateur du système de watercooling est placé sur la face arrière du boîtier, en haut, position recommandée par AMD. Il remplace alors l'un des ventilateurs classiques de 120mm et est bien entendu placé en expulsion. En charge, la Radeon R9 295X2 s'en tire très bien. Sans être silencieuse, la carte n'est pas beaucoup plus bruyante qu'une GeForce GTX 780 Ti alors qu'elle dissipe plus de 500W. Il est intéressant d'observer qu'en multi-GPU et en charge, l'avantage des GTX 780 Ti sur les Radeon 290X au niveau des nuisances sonores disparaît, le ventilateur des premières accélérant relativement vite pour ne pas laisser la température GPU progresser de trop au-delà de leur limite de 83 °C. La GeForce GTX Titan Z affiche de base des nuisances sonores similaires à celles d'une paire de GTX 780 Ti en SLI. Les fréquences de ses GPU tombent cependant au niveau de la fréquence de base, soit 705 MHz (ce qui représente une consommation de 90/85% soit +/- 350W), et la température des GPU monte légèrement au-delà de la limite de 83 °C. C'est ce dépassement de la température qui limite les performances au niveau minimal de la carte. En mode 'Uber', la température des GPU n'est plus un problème, c'est la consommation qui est le facteur limitant et les fréquences montent à 901 MHz (ce qui représente une consommation de 113/109% soit +/- 440W). La température des GPU a cependant progressé à un peu plus de 90 °C, et mécaniquement les nuisances sonores explosent. Au repos, les GeForce restent les plus silencieuses, malgré le fait que leurs ventilateurs restent en action, alors que la Radeon R9 295X2 est loin d'être discrète. Il s'agit d'un des compromis de ce type de systèmes de watercooling intégrés. Cet effet est probablement accentué par un ventilateur de mauvaise qualité. Le bruit des pompes se fait également entendre au repos, même si son influence sur la pression sonore mesurée reste limité. Ce bruit est similaire au coil whine mais constant et pourra en agacer certains. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne : La Radeon R9 295X2 est très bien refroidie, tant au repos qu'en charge. Il faut dire que la température limite de 75 °C, à partir de laquelle la fréquence GPU peut être abaissée jusqu'à 300 MHz, fait que le GPU ne dépassera jamais 74 °C. Refroidissement à air oblige, la GeForce GTX Titan Z fait chauffer plus ses GPU, mais pas réellement plus que les GTX 780 Ti en SLI. Plus précisément, nous avons noté pour les GPU 1 et 2 : GTX Titan : 86 / 84 °C GTX Titan 'Uber' : 93 / 90 °C GTX 780 Ti SLI : 86 / 83 °C GTX 780 Ti SLI 'Uber' : 91 / 86 °C R9 295 X2 : 74 / 74 °C Page 5 - Thermographie infrarouge Thermographiques infrarougeVoici ce que tout cela donne en charge à travers l'imagerie thermique :

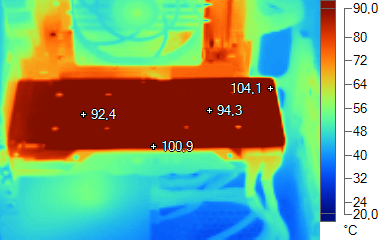

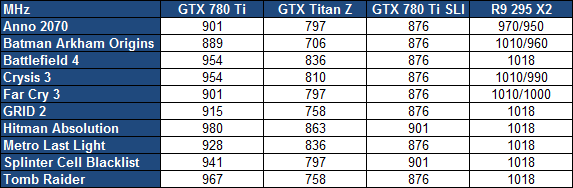

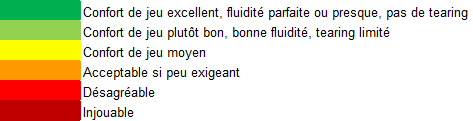

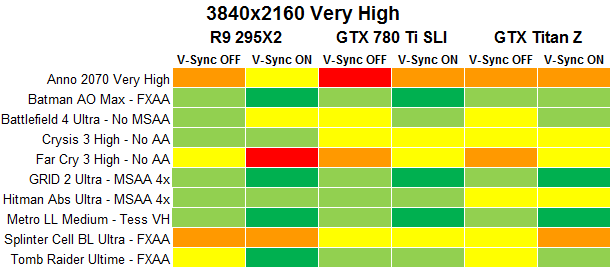

La GeForce GTX Titan Z chauffe, cela ne fait aucun doute. D'une part elle expulse une partie importante de l'air chaud qu'elle génère dans le boîtier et d'autre part sa plaque arrière n'a pas qu'un rôle esthétique et fait réellement office de dissipateur pour l'étage d'alimentation. Sur la totalité de sa surface, la température est supérieure à 90 °C. Dédier un ventilateur du boîtier à son refroidissement ne serait pas un luxe. Au niveau des systèmes, nous pouvons observer que les GTX Titan Z et GTX 690 entraînent une chauffe plus importante que pour la HD 7990 et bien entendu que pour la R9 295 X2 qui expulse presque la totalité de l'air chaud qu'elle génère en dehors du boîtier. Evitez de placer un disque dur à hauteur de ces cartes ! Vous pourrez observer que le câble d'alimentation chauffe par contre plus avec la R9 295 X2 que sur des cartes moins gourmandes, notamment au niveau du connecteur en sortie de l'alimentation (56 °C). Au niveau des cartes graphiques, l'étage d'alimentation de la Radeon R925X2 atteint 100 °C, ce qui explique pourquoi il dispose d'un ventilateur dédié. Du côté de la GTX Titan, c'est au niveau des composants des étages d'alimentation que la chauffe est plus importante mais elle se répartit sur toute la surface de la plaque arrière. Page 6 - Protocole de test Protocole de testPour ce test, nous avons repris les 10 jeux utilisés précédemment et les résultats des Radeon obtenus lors du test da la R9 295 X2. Nous avons mis à jour les performances des GeForce avec les nouveaux pilotes (sans noter de différence si ce n'est sous Splinter Cell Blacklist). Tous les jeux sont testés avec leur dernier patch au 07/04/2014, la plupart étant maintenus à jour via Steam/Origin/Uplay. Nous nous sommes concentrés sur la résolution 4K/UHD, soit du 3840x2160, la plus apte à trouver de l'intérêt dans une solution graphique telle que la 295 X2. Nous avons opté pour un niveau de qualité élevé à très élevé suivant les jeux, de manière à obtenir au moins 60 fps sur cette dernière. Pour rappel, nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Toutes les cartes ont été testées ou retestées avec les pilotes Catalyst 14.4beta V1.6 et GeForce 340.43 beta. Nous avons forcé l'activation du PCI Express 3.0 sur la plateforme X79 pour les GeForce. En plus de mesurer les performances, nous avons cherché à qualifier la fluidité en terme de ressenti pour la Radeon R9 295X2 ainsi que pour les GeForce GTX 780 Ti en SLI, avec et sans synchronisation verticale. Comme pour nos précédents tests, nous faisons en sorte de tester les différentes solutions en prenant en compte leur système de gestion de la consommation/fréquence/température de manière à vous proposer des résultats pertinents. Avant chaque mesure de performances, nous avons donc pris le temps de laisser toute les solutions atteindre leur température/fréquence de croisière, ce qui se fait au bout de quelques minutes pour les cartes refroidies par air, mais peut prendre 15-20 minutes pour la Radeon R9 295X2. En pratique, cette dernière arrive tout juste à maintenir sa fréquence maximale dans la plupart des jeux (GPU2 à 70-73 °C, baisse à partir de 74 °C). Nous avons observé une baisse dans Anno (970/950 MHz), Crysis 3 (1010/990 MHz), Far Cry 3 (1010/1010 MHz) et Batman AO (1010/960 MHz). Les GeForce GTX 780 Ti en SLI tombent rapidement à leur fréquence de base dans la majorité des jeux, soit 876 MHz. Il est intéressant d'observer que la réduction de leur fréquence est synchrone, elle baisse de manière identique sur les 2 GPU, contrairement aux Radeon ou aux GeForce de la série 600. Suivant le jeu, la fréquence des GPU de la GTX Titan Z est tombée entre 705 et 863 MHz. A noter cependant qu'elle est plus avantagée que les autres solutions par le fait que nous testons les performances sur un banc de test. Si nous avions mesuré les performances en boîtier fermé, elles auraient souffert plus pour la GTX Titan Z qui accumule une partie de l'air chaud à l'intérieur de celui-ci. Plus en détail, voici les fréquences que nous avons relevées :  En CFX, les Radeon R9 290X de référence issues du commerce ont en moyenne tendance à chuter nettement et fonctionnent souvent à leur fréquence de base, 727 MHz, au tout juste au-dessus, contrairement aux Radeon R9 290X finement triées par AMD qui arrivent à se maintenir bien plus haut. Dans notre cas, la Radeon R9 290X issue de commerce était la carte 1 et la Radeon R9 290X fournie par AMD la carte 2. Compte tenu du mode de rendu alterné utilisé en multi-GPU, les performances sont similaires à celles qui auraient été obtenues avec 2 cartes similaires à celle issue du commerce. Avec 2 cartes fournies par AMD, les résultats seraient bien entendu meilleurs. Si nous nous sommes contentés de tester les Radeon R9 290X de référence en mode Quiet, pour le bien de nos oreilles, nous avons par contre intégré un couple de cartes personnalisées. Il s'agit de R9 290X OC de Gigabyte capables, dans un système bien ventilé ou sur un banc de test, de maintenir leur fréquence maximale de 1040 MHz en permanence ou presque (Anno est l'exception avec 1030 MHz pour le GPU1).  Configuration de testIntel Core i7 3960X (HT off, Turbo 1/2/3/4/6 cores: 4 GHz) Asus P9X79 WS 8 Go DDR3 2133 Corsair Windows 7 64 bits Pilotes GeForce 340.43 beta WHQL Catalyst 14.4beta Page 7 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons le mode de qualité très élevée du jeu et effectuons un déplacement sur une carte en mesurant les performances avec Fraps. Dans Anno 2070, c'est avant tout la puissance de calcul qui compte et les GPU sont mis à rude épreuve par rapport à leurs limites de consommation ou de température. Les Radeon ont généralement l'avantage dans ce jeu et la R9 295X2 n'a aucune peine à se démarquer du SLI de GTX 780 Ti et de la GTX Titan Z. A noter l'écart important entre les systèmes bi-GPU à base d'Hawaii suivant qu'ils arrivent à maintenir ou pas une plus haute fréquence. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : tearing important, petites saccades Radeon R9 295X2 V-Sync ON : petits à-coups de temps en temps GeForce GTX 780 Ti SLI V-Sync OFF : tearing important, grosses saccades GeForce GTX 780 Ti SLI V-Sync ON : à-coups réguliers, manque de fluidité globale GeForce GTX Titan Z V-Sync OFF : tearing important, saccades GeForce GTX Titan Z V-Sync ON : à-coups réguliers, manque de fluidité globale Page 8 - Benchmark : Batman Arkham Origins Batman Arkham Origins  Dernier opus de la série, Batman Arkham Origins est toujours basé sur l'Unreal Engine 3 mais pousse un petit peu plus loin les effets graphiques dont certains ont été implémentés sur PC en collaboration avec Nvidia. C'est le cas du TXAA et d'effets GPU PhysX réservés aux GeForce (il n'est plus possible d'activer une version CPU de tous ces effets), mais également de l'occlusion ambiante de type HBAO+, d'un effet de Depth of Field plus évolué (NVDOF), d'ombres adoucies (PCSS) et de la tessellation (pour la cape et la neige) qui sont utilisables sur tous les GPU DirectX 11. Nous utilisons le mode de qualité maximale du jeu, avec du FXAA. Nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Steam. Dans Batman, la puissance de texturing et la bande passante mémoire prennent plus d'importance. Cette fois c'est Nvidia qui dispose d'une avance significative, tout du moins avec les GTX 780 Ti en SLI. Ce jeu est le plus lourd de ce protocole de test pour les GPU GeForce équipés de nombreuses unités de texturing et le ventirad de la GTX Titan Z n'arrive pas à suivre. Les GPU tombent à la fréquence de base et les performances chutent de 20% par rapport aux GTX 780 Ti en SLI. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing Radeon R9 295X2 V-Sync ON : fluidité excellente GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing GeForce GTX 780 Ti SLI V-Sync ON : fluidité excellente GeForce GTX Titan Z V-Sync OFF : léger tearing GeForce GTX Titan Z V-Sync ON : très petites saccades Page 9 - Benchmark : Battlefield 4 Battlefield 4  Battlefield 4 repose sur le moteur Frostbite 3, une évolution de la version 2 présente dans Battlefield 3. La base du rendu reste très proche (rendu différé, calcul de l'éclairage via compute shaders) et les évolutions visibles sont mineures, DICE ayant principalement optimisé son moteur pour les consoles de nouvelle génération. Parmi les petites nouveautés, citons un support plus avancé de la tessellation et une amélioration du module "destruction" du moteur. Sur PC, un mode Mantle spécifique aux Radeon et qui permet de réduire le coût CPU du rendu est proposé mais nous ne l'avons pas utilisé pour ce test. Pour rappel, il s'agit d'une API propriétaire de plus bas niveau dédiée aux Radeon HD 7000 et supérieures, qui a été développée par AMD et DICE. Nous testons le mode Ultra mais sans MSAA en 1920x1080 et relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin. Alors que la Radeon R9 290X en mode Quiet reste largement derrière la GeForce GTX 780 Ti, la R9 295X2 est capable de maintenir une fréquence maximale, de quoi dépasser les GeForce en SLI et la GTX Titan Z. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing Radeon R9 295X2 V-Sync ON : saccades par endroit GeForce GTX 780 Ti SLI V-Sync OFF : tearing important, gênant GeForce GTX 780 Ti SLI V-Sync ON : très petites saccades par endroit GeForce GTX Titan Z V-Sync OFF : tearing important, gênant GeForce GTX Titan Z V-Sync ON : très petites saccades par endroit Page 10 - Benchmark : Crysis 3 Crysis 3  Crysis 3 reprend le même moteur que Crysis 2 : le CryEngine 3. Ce dernier profite cependant de quelques petites évolutions telles qu'un support plus avancé de l'antialiasing : FXAA, MSAA et TXAA sont au programme, tout comme un nouveau mode appelé SMAA. Ce dernier est une évolution du MLAA qui permet, optionnellement, de prendre en compte des données de type sous-pixels soit à travers la combinaison avec du MSAA 2x, soit avec une composante temporelle calculée à partir de l'image précédente. Le SMAA 1x est la simple évolution du MLAA, le SMAA 2tx utilise une composante temporelle et le SMAA 4x y ajoute le MSAA 2x. Notez qu'il ne faut pas confondre le SMAA 2tx proposé en mono-GPU avec le SMAA 2x proposé en multi-GPU, ce dernier utilisant du MSAA 2x sans composante temporelle. Nous mesurons les performances avec Fraps et le jeu est maintenu à jour via Origin. Dans ce jeu très gourmand et où les fréquences ont tendance à baisser, les GeForce s'en sortent en général un petit peu mieux que les Radeon, excepté en très haute résolution comme c'est le cas ici avec des performances similaires pour la R9 290X Quiet que pour la GTX 780 Ti. Une fois encore, en maintenant sa fréquence à un niveau presque maximal, la R9 295X2 se démarque des GeForce en SLI. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing Radeon R9 295X2 V-Sync ON : très petites saccades GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing, petites saccades GeForce GTX 780 Ti SLI V-Sync ON : petites saccades GeForce GTX Titan Z V-Sync OFF : léger tearing, saccades GeForce GTX Titan Z V-Sync ON : petites saccades Page 11 - Benchmark : Far Cry 3 Far Cry 3  Far Cry 3 est relativement lourd, notamment à travers les effets d'occultation ambiante, de filtrage des surfaces alpha et bien entendu à travers la MSAA 4x ou 2x.Pour mesurer les performances, nous activons le HDAO et poussons le niveau graphique en mode élevé. Notez que le SSAO, moins gourmand, propose un rendu immonde, alors que le HBAO produisait des artefacts par endroit avant le patch 1.5 et, même une fois corrigé, affiche un résultat qui se rapproche du SSAO, inférieur au HDAO. Le HBAO ayant été développé à l'origine par Nvidia alors que le HDAO l'a été par AMD, certains testeurs, incités dans ce sens par Nvidia, préfèrent comparer les GeForce avec HBAO aux Radeon avec HDAO. Nous estimons cependant que cette approche n'est pas correcte, le HBAO étant moins gourmand et offrant un résultat inférieur, tout du moins dans ce jeu. Nous utilisons Fraps sur un parcours bien défini. En multi-GPU, la Radeon R9 295 X2 a un net avantage de 20% sur les GeForce GTX 780 Ti en SLI et de 30% sur la GTX Titan Z. Mais la fluidité est-elle au rendez-vous avec ce moteur particulièrement difficile sur ce point ? Pas vraiment… Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : tearing, à-coups par endroits Radeon R9 295X2 V-Sync ON : très gros à-coups GeForce GTX 780 Ti SLI V-Sync OFF : tearing, gros à-coups, cadencement irrégulier ? GeForce GTX 780 Ti SLI V-Sync ON : à-coups qui impactent la fluidité GeForce GTX Titan Z V-Sync OFF : tearing, gros à-coups, cadencement irrégulier ? GeForce GTX Titan Z V-Sync ON : à-coups qui impactent la fluidité Page 12 - Benchmark : GRID 2 GRID 2  Dernier né chez Codemaster, GRID 2 reprend une évolution légère du moteur DirectX 11 maison exploité par DiRT Showdown. Pour rappel, en partenariat avec AMD, les développeurs avaient mis en place un éclairage avancé qui prend en compte de nombreuses sources de lumière directes et indirectes ainsi qu'une approximation du rendu de type illumination globale. Ces techniques sont toujours exploitées, même si le partenaire principal de Codemaster est cette fois Intel qui a aidé à la mise en place d'optimisations spécifiques aux GPU intégrés à Haswell. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum, à l'exception de l'adoucissement de l'effet d'occlusion ambiante. Nous utilisons Fraps sur l'environnement de Barcelone, le plus lourd dans le jeu. Dans ce jeu, les Radeon ont un net avantage en multi-GPU, tout du moins quand elles sont capables de maintenir leur fréquence maximale. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing Radeon R9 295X2 V-Sync ON : fluidité excellente GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing GeForce GTX 780 Ti SLI V-Sync ON : fluidité excellente GeForce GTX Titan Z V-Sync OFF : léger tearing GeForce GTX Titan Z V-Sync ON : fluidité excellente Page 13 - Benchmark : Hitman Absolution Hitman Absolution  Hitman Absolution utilise un moteur plutôt lourd et qui manque probablement d'optimisations. La charge CPU est par ailleurs relativement élevée dans certaines scènes dans lesquelles une foule importante peut être animée. Différents effets DirectX 11 ont été intégrés avec la coopération d'AMD. Pour mesurer les performances, nous poussons les options graphiques au niveau ultra et utilisons fraps dans le jeu. Une fois de plus, la Radeon R9 295X2 se démarque en maintenant une fréquence GPU très élevée. A noter que même avec 4 Go par GPU, si nous activons le MSAA 8X, les Radeon en multi-GPU se retrouvent en manque de mémoire vidéo, raison pour laquelle nous nous sommes contentés du MSAA 4x. La GeForce GTX 690, avec seulement 2 Go par GPU est ici larguée pour la même raison, comme c'est d'ailleurs le cas dans de nombreux jeux. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing Radeon R9 295X2 V-Sync ON : léger lag GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing GeForce GTX 780 Ti SLI V-Sync ON : petites saccades par endroit GeForce GTX Titan Z V-Sync OFF : léger tearing, manque de fluidité GeForce GTX Titan Z V-Sync ON : saccades Page 14 - Benchmark : Metro Last Light Metro Last Light  Tout comme Metro 2033, sa suite Last Light développée par 4A Games est très gourmande. Elle repose sur une petite évolution du moteur DirectX 11 maison, le 4A Engine, ainsi que sur des environnements et éclairages plus riches. Le jeu pousse par ailleurs plus loin l'utilisation de la tessellation, mise en place en collaboration avec Nvidia, autant sur les personnages que sur les objets ou les sols, même si dans bien des cas la différence n'est cependant pas transcendante. Au niveau de l'antialiasing, le 4A Engine support l'AAA, un algorithme maison similaire au FXAA/MLAA/SMAA, ainsi que le SSAA extrêmement gourmand en mode 2x, 3x et 4x. Un mode 0.5x est également proposé et consiste alors à rendre le jeu dans une résolution inférieur qui est par la suite étendue. Le support de GPU PhysX est toujours de la partie. A ne pas confondre avec PhysX, qui gère globalement la physique au niveau du CPU, il s'agit d'effets accélérés par le GPU à travers une librairie propriétaire de Nvidia, ce qui implique qu'ils ne peuvent pas être accélérés sur une Radeon. Ils sont alors traités par le CPU, d'une manière non-optimisée, ce qui rend leur utilisation difficile en pratique. Nous avons testé le jeu via Fraps sur un parcours bien défini. Nous avons dû faire l'impasse sur le SSAA, bien trop gourmand et nous contenter du mode de qualité normale mais en poussant le niveau de tessellation sur très élevé. Les GeForce s'en sortent mieux que les Radeon dans ce jeu mais la R9 295X2 permet de revenir au même niveau que les GTX 780 Ti en SLI. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing Radeon R9 295X2 V-Sync ON : fluidité excellente GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing GeForce GTX 780 Ti SLI V-Sync ON : fluidité excellente GeForce GTX Titan Z V-Sync OFF : léger tearing GeForce GTX Titan Z V-Sync ON : fluidité excellente Page 15 - Benchmark : Splinter Cell Blacklist Splinter Cell Blacklist  Basé sur le LEAD engine, une version retravaillée en interne de l'Unreal Engine 2.5, Splinter Cell Blacklist profite pour la version PC d'effets graphiques supplémentaires mis en place en collaboration avec Nvidia tels que le HBAO+, la tessellation ou encore le TXAA. Notez au niveau de l'occlusion ambiante que le jeu propose de nombreuses options dont les plus avancées représentent l'effet le plus lourd du jeu. Nous mesurons les performances avec Fraps sur un parcours bien défini et le jeu est maintenu à jour via Uplay. Alors que les GeForce s'en tirent bien en mono-GPU, en multi-GPU leurs performances progressent moins que du côté des Radeon, ce qui leur permet de prendre les devants. A noter que les résultats des GeForce en SLI ont nettement progressé tant en termes de performances que de fluidité avec les pilotes récents. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : léger tearing, à-coups gênants Radeon R9 295X2 V-Sync ON : à-coups gênants GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing, quelques à-coups GeForce GTX 780 Ti SLI V-Sync ON : à-coups/saccades GeForce GTX Titan Z V-Sync OFF : léger tearing, quelques à-coups GeForce GTX Titan Z V-Sync ON : à-coups/saccades importantes Page 16 - Benchmark : Tomb Raider Tomb Raider  Tomb Raider a été l'une des meilleures surprises de 2013. Le rendu graphique est plutôt réussi, AMD ayant collaboré avec les développeurs pour s'assurer d'une version PC de bon niveau. C'est particulièrement le cas pour TressFX, l'option de rendu avancé des cheveux de Lara qui apporte une bonne dose de réalisme. Nous avons testé Tomb Raider en mode de qualité Ultime qui inclut l'effet TressFX. Nous avons mesuré les performances avec Fraps, sans utiliser le bench intégré qui correspond plus aux cinématiques qu'aux scènes de jeu classiques. La Radeon R9 295X2 profite une fois de plus du maintien d'une fréquence GPU très élevée pour prendre l'avantage sur les GTX 780 Ti en SLI alors que la GTX Titan Z se contente du niveau de performances des R9 290X en mode Quiet. Et la fluidité ?Voici notre impression : Radeon R9 295X2 V-Sync OFF : tearing gênant Radeon R9 295X2 V-Sync ON : fluidité excellente GeForce GTX 780 Ti SLI V-Sync OFF : léger tearing GeForce GTX 780 Ti SLI V-Sync ON : petit lag ou petits ralentissements (triple/double buffering) GeForce GTX Titan Z V-Sync OFF : léger tearing, petits ralentissements GeForce GTX Titan Z V-Sync ON : petit lag (triple buffering) Page 17 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Nous avons attribué un indice de 100 à la GeForce GTX 780 Ti : En moyenne, le passage au CrossFire X en double GPU permet de gagner 69% de performances pour les Radeon R9 290X, un gain en partie limité par une fréquence GPU qui a tendance à être réduite bien plus qu'en mono-carte. Du côté des GeForce GTX 780 Ti, le gain lié au passage en SLI se limite à 58%, ces dernières souffrant d'une baisse de leurs fréquences plus importante dans la plupart des jeux. En maintenant des fréquences GPU proches du niveau maximal, la Radeon R9 295X2 prend une avance importante sur les solutions concurrentes. 18% de mieux par rapport aux GTX 780 Ti en SLI et 29% de mieux par rapport à la GTX Titan Z. Cette GeForce GTX Titan Z se place en moyenne 8% derrière les GeForce GTX 780 Ti en SLI, un résultat honorable même s'il nous faut préciser une fois de plus que les mesures de performances sur banc de test l'avantagent. Suivant la lourdeur des jeux, elle est de 2% à 20% moins performances que les GTX 780 Ti en SLI, or une fois en boîtier fermé, elle se retrouverait bien souvent proche de l'extrémité la moins favorable de cette fourchette. Pour éviter cela il faudrait alors avoir recours à une ventilation très importante du boîtier. A noter que pour obtenir un niveau de performances élevé avec 2 Radeon R9 290X ou 2 GTX 780 Ti, il faut passer par des cartes partenaires, mais il faut alors également prévoir un boîtier très bien ventilé. De telles GTX 780 Ti en SLI afficheraient des performances très proches de celles des Radeon 290X de Gigabyte testées ici. Par rapport aux solutions de la génération précédente, la Radeon R9 295X2 pousse les performances à la hausse de 50% alors que la GTX Titan Z fait un petit mieux avec 54% de mieux que la GTX 690. Attention cependant, les 2 Go de mémoire de cette dernière sont clairement devenus handicapants lorsqu'il s'agit de jouer en 4K, surtout quand le MSAA est de la partie. Cela a tendance à creuser artificiellement cet écart. Pour traiter la question de la fluidité, nous avons repris la même formule que pour nos analyses similaires dans le cadre du multi-GPU en notant notre ressenti et en lui attribuant une couleur. L'approche n'a rien de scientifique et est totalement subjective mais nous permet de vous présenter un récapitulatif de nos impressions.  Voici ce que nous avons observé pour la Radeon R9 295X2 et pour les GeForce GTX Titan Z et 780 Ti en SLI :  Même si le résultat n'est pas parfait, l'avantage est globalement à la Radeon R9 295X2, qui profite entre autre d'un niveau de performances plus élevé. La Radeon R9 295X2 ou les systèmes multi-cartes à base de R9 290X, ne souffrent d'aucun problème particulier de régularité de la cadence d'affichage. Nous sommes donc loin des résultats désastreux de la Radeon HD 7990 à son lancement. Nous avons cependant l'impression que les mécanismes d'optimisation de la régularité du cadencement, en général particulièrement efficaces chez Nvidia, éprouvent plus de difficulté en très hautes résolutions, ce qui pourrait être lié au fait que le transfert entre GPU d'une image 4K prend plus de temps. Anno 2070, Far Cry 3 et Splinter Cell Blacklist sont les jeux qui posent le plus de problèmes en multi-GPU et en 4K. Page 18 - Conclusion ConclusionQuel est l'intérêt d'une carte graphique telle que la GeForce GTX Titan Z proposée au tarif démesuré de près de 3000€ ? Nous avons retourné cette question dans tous les sens et accepté de considérer la moindre petite niche qui pourrait trouver un intérêt raisonnable dans cette GeForce. Un exercice difficile. Nous n'avons aucun problème avec les produits de luxe, de telles cartes graphiques peuvent intéresser une clientèle professionnelle et il existe une niche de joueurs et de passionnés qui sont prêts à mettre le prix pour ajouter un modèle exclusif à leur collection ou pour obtenir la meilleure solution du moment, en ignorant toute autre considération telle que le rapport performances/prix. Encore faut-il qu'il s'agisse de la meilleure solution du moment. Ce n'est pas le cas. Nul doute que Nvidia aurait préféré pouvoir mettre en avant la GeForce GTX Titan Z comme la carte graphique la plus rapide du monde. Mais la réalité est tout autre : pour les joueurs, face à la Radeon R9 295 X2 d'AMD, la GeForce GTX Titan Z est largement tenue en échec. La solution d'AMD, grâce à un refroidissement à eau, affiche une domination de près de 30% ! Et cela alors que les conditions de mesure de performances, hors boitier, sont plus avantageuses pour la GTX Titan Z.  Alors oui, certains utilisateurs n'apprécient pas les systèmes de watercooling intégrés voire les Radeon tout court et ont besoin d'un niveau de performances inutile pour la majorité des joueurs. C'est par exemple le cas de celui qui veut jouer en 4K/UHD ou en surround avec un niveau de qualité élevé. Mais pour ces joueurs qui ne jurent que par les GeForce, 2 GTX 780 Ti proposent une même qualité de fabrication et des performances supérieures à la GTX Titan Z pour un tiers du prix ! Pour le joueur qui veut profiter de la quantité de mémoire supérieure, 6 Go par GPU, 2 GeForce GTX Titan Black proposent des performances supérieures pour "seulement" deux tiers du prix. Avec en bonus moins d'ennuis en cas de défaillance. Nvidia avance alors l'argument de la densité : une GTX Titan Z n'occupe que 3 slots contre 4 pour une paire de GTX Titan Black. Pour la majorité des systèmes cela ne fait cependant aucune différence, ils sont aptes à accueillir les deux solutions. Avec accord du banquier, il est possible de passer à 2 GTX Titan Z, mais, à moins d'être allergiques aux câbles, il est également possible de passer à 3 ou 4 GTX Titan Black. Il est probable que 3 GTX Titan Black affichent, dans les jeux, des performances similaires à 2 GTX Titan Z, avec un encombrement identique... et un coût divisé par 2. Nvidia mentionne également les systèmes mini-ITX équipés d'un seul slot PCI Express. Impossible d'y placer deux cartes graphiques. Mais s'ils sont un minimum compacts, le dégagement calorifique de la GTX Titan Z la rend inadaptée. A condition de passer au watercooling, nous en arrivons malgré tout à une première niche qui pourrait être intéressée, à une micro dose de raison au milieu de toute cette démesure. Ekwb propose un tel bloc de refroidissement, dont EVGA commercialise par ailleurs directement une déclinaison avec un petit surcoût de 300€, presque négligeable par rapport au tarif d'un tel monstre. Quid du minage des monnaies virtuelles ? Aucun intérêt, l'architecture du GPU GK110 n'est pas la plus adaptée et il sera difficile de rentabiliser une telle solution. Reste la question de l'usage professionnel au niveau du calcul en double précision et à condition d'accepter de faire l'impasse sur le support dédié de Nvidia et sur des fonctionnalités telles que l'Hyper-Q, réservés aux Quadro et Tesla. A ce niveau l'avantage de la densité prend alors un peu plus de sens, en grande partie parce qu'il est plus simple d'exploiter pleinement de nombreux GPU en parallèle en calcul qu'en rendu 3D temps réel. A condition que le code le prévoie explicitement bien entendu. Le passage au watercooling pourra ici aussi être envisagé pour tirer le meilleur de ces GeForce GTX Titan Z. Tant qu'à faire, pour une station de travail extrême installée dans un boîtier suffisamment grand, il sera relativement simple de placer 3 GTX Titan Z là où seules 4 GTX Titan Black peuvent prendre place. Avec un très bon refroidissement les performances atteindront alors les 10 Tflops en double précision, soit plus de 30% par rapport à ce que permettent les cartes mono-GPU similaires. Mieux vaut cependant être dans une situation dans laquelle le petit surcoût de 125% importe peu… Au final, les situations où cette GeForce GTX Titan Z peut avoir de l'intérêt sont pour le moins limitées. Trop chère, trop en retard et pas assez performante pour se démarquer… Après le succès relatif de la carte à 1000€, Nvidia n'a pas marqué ce nouvel essai et devra probablement revoir son approche lors de la prochaine génération. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |