| |

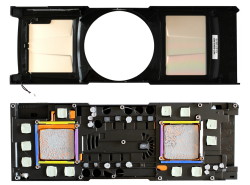

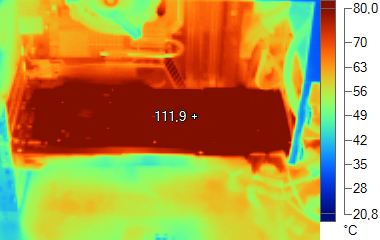

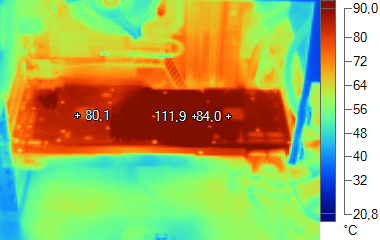

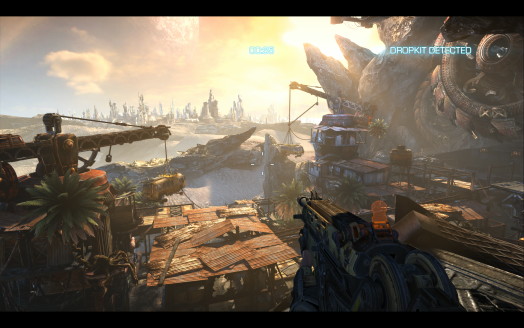

| Nvidia répond à AMD avec la GeForce GTX 590 Cartes Graphiques Publié le Jeudi 24 Mars 2011 par Damien Triolet URL: /articles/825-1/nvidia-repond-amd-avec-geforce-gtx-590.html Page 1 - Introduction Cela fait quelques mois déjà que Nvidia prépare la GeForce GTX 590 bi-GPU en réponse à la Radeon HD 6990 d’AMD. Contrairement à ce qu’il s’est passé avec la Radeon HD 5970, il est cette fois hors de question de laisser son concurrent parader seul en tête. Avec une solution moins avancée sur le plan de la gestion de la consommation, la tâche était ardue pour Nvidia qui a cependant pu profiter des retards successifs d’AMD pour peaufiner ses pilotes et adapter le positionnement de la GeForce GTX 590 par rapport à la prestation de la Radeon HD 6990. Un vainqueur va-t-il pouvoir ressortir de ce duel ? Pour répondre à cette question nous avons passé en revue les performances en résolutions classiques, en surround et en 3D Vision, sans oublier le comportement thermique et les nuisances sonores…  Au-delà de 300WAlors que les spécifications PCI Express 2.0 ne prévoient pas la possibilité pour une carte d’extension de consommer plus de 300W, AMD et Nvidia ont tous deux décidés de ne pas en tenir compte, ce qui est une première pour des cartes de référence. En dehors du fait que ces cartes ne seront pas validées par le PCI-SIG, cela n’a cependant pas de réelle conséquence, à condition de disposer d’une alimentation correctement dimensionnée.  S’il était difficilement envisageable que Nvidia parvienne à concevoir une carte graphique équipée de 2 GPUs GF110 dans une enveloppe de 300W, compte tenu de leur gourmandise et de l’absence de gestion avancée de la consommation, nous pouvions supposer qu’AMD s’en contenterait, en utilisant la technologie PowerTune pour en tirer un maximum de performances. Nvidia a probablement fait une supposition similaire et pour s’assurer une victoire écrasante, a visé une enveloppe thermique de 450W présentée en tant que « TDP jeu de 365W ». Mais voilà, AMD a également décidé de viser le plus haut possible en proposant une Radeon HD 6990 prévue pour 375W ou 450W, selon le bios utilisé. En découvrant ces spécifications finales, Nvidia a probablement très vite compris que le combat serait plus difficile que prévu… Page 2 - Spécifications, la GeForce GTX 590 Spécifications  La GeForce GTX 590 embarque 2 GF110 complets, comme la GeForce GTX 580. Leurs fréquences ont cependant été revues à la baisse et passent de 772 à 607 MHz pour le GPU et de 2004 à 1707 MHz pour la mémoire. Un couple de GeForce GTX 580 en SLI disposera ainsi d’une puissance de calcul supérieure de 27% et d’une bande passante mémoire en hausse de 17%. La GeForce GTX 590 de référencePour ce test, Nvidia nous a fourni une GeForce GTX 590 de référence :         Nvidia est parvenu à placer 2 énormes GF110 sur un PCB relativement compact. La GeForce GTX 590 ne mesure ainsi que 28cm soit un peu plus de 2cm de moins que la Radeon HD 6990 et seulement 1cm de plus qu’une GeForce GTX 580/570. Au niveau de la connectique, Nvidia a opté pour 3 sorties DVI Dual-Link ainsi qu’une sortie mini-DisplayPort. Un choix destiné à permettre la mise en place d’un système Surround ou 3D Vision Surround. Nvidia est parvenu à placer 2 énormes GF110 sur un PCB relativement compact. La GeForce GTX 590 ne mesure ainsi que 28cm soit un peu plus de 2cm de moins que la Radeon HD 6990 et seulement 1cm de plus qu’une GeForce GTX 580/570. Au niveau de la connectique, Nvidia a opté pour 3 sorties DVI Dual-Link ainsi qu’une sortie mini-DisplayPort. Un choix destiné à permettre la mise en place d’un système Surround ou 3D Vision Surround. La finition de l’ensemble est d’excellente facture, avec un logo GeForce illuminé et la possibilité de retirer le capot du ventirad sans devoir démonter entièrement ce dernier, ce qui annule la garantie. Il suffit de retirer 4 petites vis, et d’actionner un loquet de rétention pour avoir accès au ventilateur et aux radiateurs en vue de les débarrasser de la poussière. Globalement, le design de Nvidia reprend une approche similaire à celui d’AMD : les GPUs sont placés aux extrémités du PCB, l’étage d’alimentation est positionné au milieu et chaque GPU dispose de son propre radiateur basé sur une chambre à vapeur. Nvidia a cependant opté pour un ventilateur contrairement à AMD qui a utilisé une turbine. Dans tous les cas seule la moitié de l’air chaud est expulsée en dehors du boîtier. L’étage d’alimentation est composé de 5 phases pour chaque GPU ainsi que de 2 phases supplémentaires pour leur mémoire. Bien que cadencée à seulement 854 MHz (1707 MHz pour les données), c’est de la GDDR5 Samsung certifiée à 1.25 GHz qui accompagne les GPUs. Enfin, un traditionnel switch PCI Express NF200 se charge de connecter le tout. Pour alimenter cette GeForce GTX 590, deux câbles d’alimentation 8 broches sont nécessaires. Pour rappel, voici ce que les spécifications définissent comme valeur maximale pour chaque canal d’alimentation : - Bus PCIe : 75W - Connecteur 6 broches : 75W - Connecteur 8 broches : 150W Avec 2 connecteurs d’alimentation 8 broches, la GeForce GTX 590 peut donc afficher une consommation de 375W, ce qui correspond au « TDP jeu » de Nvidia qui ne veut cependant rien dire et est destiné à éviter de communiquer sur de trop gros chiffres. Le fabricant précise d’ailleurs que la limite de consommation est 25% supérieure à cette valeur, ce qui nous amène au TDP réel de 450W. Tout comme pour les GeForce GTX 580, 570 et 560 Ti, Nvidia a mis en place l’OCP pour protéger la GeForce GTX 590 d’une surconsommation. Différence importante par rapport aux autres cartes, l’OCP est actif en permanence et non plus uniquement pour une poignée de logiciels tels que Furmark. Une protection cruciale pour la GeForce GTX 590 comme nous avons malheureusement pu le constater après que notre premier échantillon ait rendu l’âme… Un bug rend possible l’installation automatique par Windows d’un pilote précédent qui ne supporte pas la GTX 590 et n’active pas l’OCP globalement. Un test de charge lourde a ainsi fait exploser la consommation… et la carte. Avant toute installation d’une GeForce GTX 590 nous vous conseillons donc de vous assurer que tout ancien pilote a bien été supprimé. Il va de soi qu’il est déconseillé d’utiliser des pilotes autres que les versions qui supportent officiellement la GeForce GTX 590 ! Page 3 - Consommation et bruit ConsommationNous avons mesuré la consommation des cartes graphiques seules. Nous avons effectué ces mesures au repos, sous 3D Mark 06 et sous Furmark. Notez que nous utilisons une version de Furmark non-détectée par Nvidia. Sur les GeForce GTX 580/570/560 Ti, Nvidia n’active l’OCP que quand un tel logiciel est détecté. A l’inverse, sur la GeForce GTX 590, l’OCP est toujours actif et entre en action sans devoir détecter l’application, nous avons pu le constater. Par contre, Nvidia a ajouté un « tweak » supplémentaire qui consiste à réduire les fréquences ou à ralentir le rendu dès qu’un logiciel tel que Furmark est détecté et peu importe le niveau de consommation. Nvidia se justifie en expliquant qu’il s’agit d’une sécurité de plus. De notre côté nous soupçonnons qu’il s’agisse également d’un moyen d’essayer d’éviter qu’une consommation élevée soit reportée dans les tests… Dans tous les cas, la version que nous avons utilisée n’était pas affectée par ce tweak.  Etrangement, le comportement de PowerTune semble différent pour les deux bios de la Radeon HD 6990, ce que nous pouvons supposer être lié à la température GPU. Plus elle est élevée, plus les courants de fuite augmentent, ce qui a un effet direct sur la consommation. Nous pouvons donc estimer qu’AMD n’a pas complètement pris en compte cette température plus élevée et n’a donc pas été très conservateur en définissant la table de correspondance pour PowerTune en mode 450 watts. Cela permet de donner plus de marge au GPU, soit pour l’overclocking, soit dans les situations de charge extrême comme c’est le cas dans Furmark. Ainsi en mode 375W, nous avons observé la fréquence GPU varier entre 535 et 830 MHz avec une moyenne de 560 MHz alors qu’en mode 450w, la fréquence GPU oscillait entre 670 et 880 MHz avec une moyenne de 765 MHz. Le gain de performances dans Furmark était alors d’un peu plus de 20% ! La GeForce GTX 590 affiche une consommation similaire à celle de la Radeon HD 6990 avec le bios 450W. Elle consomme par contre moins dans 3DMark avec 370W, ce qui correspond au « TDP jeux » annoncé par Nvidia. Nuisances sonoresNous plaçons les cartes dans un boîtier Antec Sonata 3 et mesurons le bruit d'une part au repos et d'autre part en charge. Le sonomètre est placé à 60cm du boîtier.  Nvidia a fait un excellent travail pour maintenir à un niveau raisonnable les nuisances sonores d’un monstre tel que la GeForce GTX 590. Si la Radeon HD 6990 reste discrète au repos, en charge, elle bat le triste record des GeForce GTX 480 en SLI avec plus de 59 dB. A ce niveau de bruit, sa turbine tourne à pleine vitesse soit 4900 TPM. Notez que dans le cas du mode 375W, les nuisances sonores varient d’une manière cyclique entre 52.8 dB et 59.4 dB. La turbine tourne à 3600 TPM, les températures augmentent, elle accélère progressivement jusque 4900 TPM, les températures baissent au bout de quelques dizaines de seconde, la turbine redescend progressivement jusque 3600 TPM, les températures augmentent au bout de quelques temps et ainsi de suite. Nous pouvons donc supposer que si vous prenez bien soin du refroidissement de votre boîtier, il soit possible d’éviter l’emballement de la turbine. Dans tous les cas, nous sommes loin du silence ! Page 4 - Températures TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  Les températures GPU montent relativement haut en charge, ce qui nous laisse penser que Nvidia a mis les nuisances sonores en priorité lors de la calibration de son système de refroidissement. Voici ce que cela donne en image grâce à la thermographie infrarouge :  GTX 590 au repos  GTX 590 en charge Ces clichés montrent que c’est l’ensemble de la GTX 590 qui atteint des températures élevées en charge avec une pointe au niveau de l'étage d'alimentation. Notez que ces clichés utilisent une échelle bien adaptée à la comparaison d'une très large gamme de cartes graphiques mais qui lisse les résultats au-delà de 80°C. Voici le même cliché mais avec une échelle différente qui permet de mieux représenter les différences entre les hautes températures :  La GeForce GTX 590 expulsant la moitié de l’air chaud vers l’intérieur du boîtier, les températures des composants qui l’entourent augmentent, c’est particulièrement le cas pour les disques durs qui seront soumis à rude épreuve comme vous pouvez le voir dans notre dossier consacré au dégagement thermique des cartes graphiques qui a été mis à jour avec les résultats complets de la GeForce GTX 590. Page 5 - Surround, 3D Vision, le test Surround gamingEtant donné le statut plutôt haut de gamme des solutions graphiques qui prennent place dans ce dossier, nous avons jugé intéressant d’observer leur comportement en surround gaming. Pour cela, nous avons utilisé 3 moniteurs en 1920x1080 pour une résolution totale de 5760x1080. Du côté d’AMD, toutes les Radeon HD 5000 et 6000 sont capables de supporter ce mode grâce à la technologie Eyefinity. C’est également le cas pour toutes les solutions CrossFire X. Attention cependant à la limitation au niveau du support de la connectique DVI/HDMI/VGA : les Radeon ne peuvent alimenter que deux de ces sorties. Pour le ou les écrans supplémentaires, il faut passer par du DisplayPort et utiliser un adaptateur actif (fourni avec les Radeon HD 6990) si vous ne disposez pas d’écrans supportant nativement cette norme. Dans le camp Nvidia, la donne est quelque peu différente puisque chaque GeForce ne peut piloter que deux écrans, peu importe la connectique utilisée. Pour profiter du surround gaming, il est donc obligatoire de passer par le SLI, ou par l’équivalent en terme de carte bi-GPU. Deux écrans sont alors connectés à l’une des cartes et le troisième à l’autre carte.  AMD et Nvidia proposent des fonctions similaires pour créer une grande surface d’affichage, qui sera vue comme un seul grand écran par Windows, mais également par les jeux, ce qui facilite le support du surround gaming. Les deux pilotes permettent de modifier la position des écrans dans la grande surface (il n’y a donc pas besoin de jongler avec les sorties jusqu’à avoir les écrans dans le bon ordre) et d’introduire une compensation pour éviter un décalage lié à la bordure des écrans (« bezel correction »). Nous n’avons pas activé ce mode qui agrandi la résolution, par exemple de 5760x1080 à 5920x1080, et introduit une charge supplémentaire. Notez que si le Control Center des Catalyst nous pose de nombreux problèmes depuis quelques mois, la page consacrée à Eyefinity ne nous a par contre jamais posé le moindre souci… contrairement aux pilotes Nvidia qui semblent très capricieux. Une fois la grande surface pour le surround en place, tout fonctionne parfaitement, mais encore faut-il arriver à l’activer ! Entre plantages du système, plantages du panneau de contrôle des pilotes, pertes d’affichage, nous avons essuyé de nombreux échecs. Au bout de nombreuses tentatives et de changement de connecteurs nous sommes finalement parvenus à profiter du surround gaming, sans qu’il n’y ait de logique ni de similitude entre les 3 systèmes testés. Nous supposons que ces problèmes sont liés d’une part à l’utilisation du HDMI (utilisé pour 2 ou 3 des écrans) et d’autre part à l’utilisation de modèles personnalisés des partenaires, à la connectique différente des modèles de référence. Dans tous les cas, il semblerait que Nvidia n’ait pas passé en revue assez de combinaisons lors de son processus de validation. 3D VisionPour ce test, nous avons décidé de nous intéresser aux performances en 3D stéréo 1080p. Etant donné que l’écosystème AMD est encore très pauvre (voire inexistant) à ce niveau, nous nous sommes tournés exclusivement vers 3D Vision, en excluant les jeux qui posent poblème : H.A.W.X., S.T.A.L.K.E.R. Call of Pripyat et Crysis Warhead.  Notons également que pour profiter de 3D Vision dans F1 2010, nous avons dû nous contenter du mode DX9, Nvidia trainant des pieds pour mettre en place un profil adapté au mode DX11 qui, pour rappel, a été mis au point en partenariat avec AMD. Serait-ce une façon d’exprimer un mécontentement à Codemasters à ce sujet ? Dans tous les cas ce sont les utilisateurs de GeForce qui sont pris en otages par ces petits jeux politiques. En mode 3D Vision, nous sommes limités à 60 fps. Nous avons cependant désactivé la synchronisation verticale dans tous les jeux de manière à éviter tout effet de pallier. Le testPour ce test, nous avons introduit l’excellent Bulletstorm à notre protocole. Les tests ont été exécutés en 1920x1200 avec MSAA 4x et avec MSAA 8x, ainsi qu’en 2560x1600 avec MSAA 4x, excepté pour Crysis et Far Cry 2 qui ont été testés dans plus de résolutions. Nous avons également testé toutes ces solutions en 5760x1080 avec et sans MSAA 4x. Tous les détails ont été poussés maximums. Les dernières mises à jour ont été installées et toutes les cartes ont été testées avec les derniers pilotes disponibles. Nous n’affichons plus les décimales dans les résultats de performances dans les jeux pour rendre le graphique plus lisible. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l’indice. Si vous êtes observateurs vous remarquerez que c’est également le cas pour la taille des barres dans les graphes. Les Radeon et les GeForce ont été testées avec le filtrage des textures réglé sur « qualité ». Toutes les Radeon ont été testées avec le pilote Catalyst 11.4 beta (8.84.3 beta 2). De leur côté, toutes les GeForce ont été retestées avec les pilotes beta 267.71 qui apportent des petits gains dans la plupart des jeux, particulièrement pour les GeForce 580 et 580 SLI. Configuration de testIntel Core i7 980X (HT désactivé) Asus Rampage III Extreme 6 Go DDR3 1333 Corsair Windows 7 64 bits Forceware 267.71 beta Catalyst 11.4 beta (8.84.3 beta2) Page 6 - Starcraft 2 Starcraft 2  Pour tester Starcraft 2, nous lançons un replay et mesurons les performances en suivant la vue d’un des joueurs. Toutes les options graphiques sont poussées au maximum. Le jeu n’intègre pas de support de l’antialiasing qui est donc activé par les panneaux de contrôle des pilotes AMD et Nvidia. Le patch 1.0.3 est installé.  Un problème introduit avec les derniers pilotes affecte les performances en mode CrossFire. Pour éviter toute tricherie, les développeurs de Starcraft 2 interdisent l’utilisation du surround gaming. La 3D stéréo est en revanche bien supportée :  Il faut pousser l’antialiasing jusqu’au mode 8x pour que les solutions les plus performantes prennent un avantage significatif. Page 7 - Mafia II Mafia II  Le moteur de Mafia II confie la gestion de la physique aux bibliothèques PhysX de Nvidia et en profite pour proposer un niveau de détails physiques élevé qui peut être partiellement accéléré par les GeForce. Pour mesures les performances, nous utilisons les benchmark intégré et toutes les options graphiques sont poussées à leur maximum tout d’abord sans activer les effets PhysX accélérés par le GPU :  La Radeon HD 6990 l’emporte ici en 2560x1600 alors que la GeForce GTX 590 est devant en 1920x1200. Ensuite, nous passons les détails PhysX à leur niveau élevé :  Avec les effets PhysX poussés au maximum, les performances plongent. Notez qu’elles sont en partie limitées par le CPU, tous les effets PhysX supplémentaires n’étant pas accélérés. Les Radeon restent bien entendu derrière.  Mafia II est capable de détecter qu’une grande surface d’affichage est liée à l’utilisation de 3 moniteurs, et reporte d’ailleurs 3x 1920x1080 et non 5760x1080, ce qui lui permet d’adapter automatiquement l’interface utilisation. Pour une raison inconnue, cette détection échoue cependant avec le couple Radeon HD 6990 + Radeon HD 6970 (triple CrossFire X) ainsi qu’avec la Radeon HD 5970. Sans cette détection, l’interface est inutilisable et le rendu du mode benchmark ne se fait que sur un écran. Du côté des GeForce, l’activation de l’antialiasing est sans effet. Nous supposons que Nvidia en bloque l’activation dans ses pilotes pour éviter les effets d’un manque de mémoire important.  La GeForce GTX 590 se démarque de la GTX 580 une fois l’antialiasing activé, mais reste derrière les GeForce GTX 570 en SLI. Page 8 - Crysis Warhead Crysis Warhead  Crysis Warhead a remplacé Crysis dont il reprend le moteur graphique très gourmand à tous les niveaux. Nous le testons dans sa version 1.1 hotfix et en mode 64 bits puisque c’est la principale nouveauté apportée. Crytek a renommé les différents modes de qualité graphique, probablement pour ne pas heurter les joueurs déçus de ne pas pouvoir activer le mode très haute qualité pour cause de gourmandise excessive. Le mode haute qualité est ainsi renommé « Gamer », et le mode très haute qualité « Enthousiast », c’est celui que nous avons testé.   Les Radeon HD 6900 se comportent ici plutôt bien et profitent de 2 Go de mémoire en 2560x1600 AA8x.  Les GeForce GTX 560 en SLI n’ont pas assez de mémoire pour lancer Crysis dans ces conditions. Il en va de même pour les Radeon en CrossFire lorsqu’elles ne sont équipées que de 1 Go de mémoire mais uniquement quand l’antialiasing est activé. Le triple CrossFire est ici très utile ! Crysis s’accommode difficilement de la 3D stéréo et Nvidia ne propose pas un profil très efficaces. Il faut donc faire trop de concessions graphiques, et même à ce moment-là le résultat 3D est très moyen. Nous considérons donc Crysis Warhead comme injouable en 3D stéréo. Page 9 - Bulletstorm Bulletstorm  Bulletstorm fait partie des meilleurs jeux du moment. Bien qu’il se contente de DirectX 9, il propose un rendu plutôt sympathique, basé sur la version 3.5 de l’Unreal Engine. Toutes les options graphiques sont poussées au maximum (high) et nous mesurons les performances avec fraps.  Les Radeon s’en tirent très bien dans ce jeu et la Radeon HD 6990 prend une avance significative sur la GeForce GTX 590.  Si les GeForce s’en tirent plutôt bien en surround gaming, elles sont par contre plus impactées par l’activation de l’antialiasing.  La GeForce GTX 590 égale les GeForce GTX 570 en SLI une fois 3D Vision activé. Ces systèmes prennent une avance importante sur une seule GeForce GTX 580 lorsque l’antialiasing est de la partie. Page 10 - Far Cry 2 Far Cry 2  La suite de Far Cry n’en est pas réellement une puisque Crytek était à l’origine du premier épisode. La licence appartenant à Ubisoft c’est ce dernier qui s’est chargé de son développement, Crytek optant alors pour Crysis. Pas facile de reprendre l’héritage de révolution graphique qui accompagne Far Cry, mais les équipes d’Ubisoft s’en sont bien tirées même si l’aspect graphique n’est pas aussi abouti que celui de Crysis. Le jeu est aussi moins gourmand ce qui n’est pas plus mal. Il supporte DirectX 10.1 pour améliorer les performances des cartes compatibles. Nous avons installé le patch 1.02 et utilisé le mode de qualité graphique « ultra élevé ».   Si les GeForce apprécient particulièrement Far Cry 2, le rendement de CrossFire est quelque peu plus élevé que celui du SLI, ce qui permet aux Radeon de bien se positionner. Etrangement les Radeon HD 6950 1 Go affichent des performances significativement plus élevées que les mêmes en version 2 Go.  Pour une raison qui nous est inconnue, les Radeon sont fortement limitées par le CPU en surround gaming dans Far Cry 2, ce qui permet aux GeForce de prendre l’avantage. Les solutions CrossFire restent cependant au-delà de 60 fps et permettent de profiter de Far Cry 2 sans problème dans ces conditions.  Toutes les solutions sont capables d’atteindre les 60 fps par œil dans ce test. Page 11 - H.A.W.X. H.A.W.X.  H.A.W.X. est un jeu d’action qui se passe dans les airs. Il utilise un moteur qui prend en charge DirectX 10.1 pour optimiser le rendu. Parmi les effets graphiques supportés, notons la présence de l’occlusion ambiante qui est poussée à son maximum tout comme les autres options. Nous utilisons le benchmark intégré et le patch 1.2 est installé.  Les GeForce sont ici plus efficaces et le couple de GTX 560 Ti égale la Radeon HD 6990.  Toutes les solutions testées ici permettent de profiter du surround gaming dans ce jeu, à l’exception de la GeForce GTX 580 bien entendu, puisqu’elle ne supporte pas du tout ce mode. Notez que dans cette résolution, H.A.W.X. ne propose plus d’antialiasing au-delà du mode 2x. H.A.W.X. ne permet pas de jouer en 3D stéréo sans désagréments importants. Page 12 - BattleForge BattleForge  Premier jeu à supporter DirectX 11, ou plus précisément Direct3D 11, il nous était difficile de ne pas l’intégrer à ce test. Une mise à jour déployée en septembre 2009 a en effet ajouté le support de la nouvelle API de Microsoft à BattleForge. Ce sont les Compute Shaders 5.0 qui sont ici exploités par les développeurs pour accélérer le traitement du SSAO, soit de l’occlusion ambiante. Par rapport à l’implémentation classique, via les Pixel Shaders, la technique permet d’exploiter plus efficacement la puissance de calcul disponible en saturant moins les unités de texturing. BattleForge propose deux niveaux de SSAO : High et Very High. Seul le second, appelé HDAO (High Definition AO), exploite les Compute Shader 5.0. Nous avons utilisé le benchmark intégré au jeu et installé la dernière mise à jour disponible à ce jour (1.2 build 304941).  Les GeForce GTX 560 Ti terminent ici au niveau de la Radeon HD 6990 qui ne se démarque qu’en 2560x1600 AA4x. AMD souffre ici d’une perte plus importante liée à l’activation de l’antialiasing 8x.  Les GeForce profitent ici d’un coût plus faible pour l’activation de l’antialiasing 4x.  La GeForce GTX 590 égale la paire de GTX 570 en SLI. Page 13 - Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d’une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d’autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le patch 1.2 est installé.  Les GeForce s’en tirent ici très bien et sont moins vite limitées par le CPU que les Radeon. Bien que Civilization V supporte le surround gaming, ce n’est malheureusement pas le cas de son outil de benchmark intégré.  Toutes les cartes sont étrangement limitées à +/- 30 fps, ce qui rend les déplacement sur la carte inconfortables. Page 14 - S.T.A.L.K.E.R. Call of Pripyat S.T.A.L.K.E.R. Call of Pripyat  Cette nouvelle suite de S.T.A.L.K.E.R. repose sur une évolution du moteur, en version 1.6.02, et supporte Direct3D 11 qui est exploité d’une part pour améliorer les performances et d’autres part la qualité avec en option des ombres et des éclairages plus détaillés ainsi qu’un support de la tessellation. Le mode de qualité utilisé est « maximum » et nous avons activé la tessellation. Le jeu ne supporte pas l’antialiasing 8x. Notre scène de test représente 50% en extérieur et 50% en intérieur et dans ce dernier cas nous sommes face à plusieurs personnages.  Les Radeon HD 6900 sont ici très efficaces, surtout en 2560x1600.  Les Radeon restent également très efficaces en mode surround, surtout avec antialiasing où elles profitent de leur mémoire de 2 Go. Les solutions 1 Go sont clairement limitées par leur mémoire. 3D Vision n’est supporté pour S.T.A.L.K.E.R. qu’avec un niveau de détails ridiculement faible. Nous le considérons donc comme incompatible. Page 15 - F1 2010 F1 2010  Dernier né chez Codemaster, F1 2010 reprend le même moteur que DiRT 2 et supporte ainsi DirectX 11, via le patch 1.1 que nous avons bien entendu installé. Ce patch ayant été développé en collaboration avec AMD, Nvidia nous a indiqué ne l’avoir reçu que tardivement et ne pas encore avoir eu l’opportunité d’optimiser ses pilotes pour ce jeu en version DirectX 11. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons l’outil de test intégré sur le circuit de Spa-Francorchamps avec une seule F1.  Dans F1 2010, les Radeon sont particulièrement à l’aise. Vous noterez que le triple CrossFire X n’apporte ici aucun gain.  F1 2010 est le jeu dans lequel le surround gaming apporte selon nous le plus. L’immersion et la sensation de vitesse en profitent pleinement. Si le triple CrossFire X n’apporte toujours aucun gain dans ce jeu, toutes les solutions bi-GPU à base de Radeon 2 Go permettent de profitent de F1 2010 avec antialiasing et en surround gaming. C’est un petit peu moins bien pour les GeForce GTX 580 en SLI, mais cela passe malgré tout avec une bonne fluidité. Il faudra par contre probablement faire l’impasse sur l’antialiasing avec les GeForce GTX 570 en SLI ou avec la GeForce GTX 590.  3D Vision n’est supporté qu’en mode DirectX 9, le rendu est alors peu gourmand et toutes les cartes atteignent facilement les 60 fps par œil. Page 16 - Metro 2033 Metro 2033  Probablement le jeu le plus lourd du moment, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n’avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l’avons testé en mode DirectX 11, avec une qualité très élevée et la tessellation activée avec MSAA 4x. Nous avons ensuite mesuré les performances avec MSAA 4x et le Depth of Field.  Les cartes équipées de seulement 1 Go de mémoire sont dépassées quand le Depth of Field est activé. La GeForce GTX 590 égale les GeForce GTX 570 en SLI mais reste derrière la Radeon HD 6990.  Très gourmand, Metro 2033 met bien entendu toutes les solutions graphiques à genoux en surround gaming. Pour en profiter avec un bon niveau de qualité, 3 GPUs sont nécessaires, équipés de 2 Go pour l’antialiasing.  Même chose en 3D Vision, il faudra passer par plus de 2 GPUs ou revoir les détails à la baisse. Page 17 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, d’autant plus avec les solutions haut de gamme dont les scores sont susceptibles d’être lissés par la limitation CPU de certains jeux, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Mafia II est ici intégré avec les scores obtenus sans les effets GPU PhysX. Nous avons attribué un indice de 100 à la GeForce GTX 580 en 1920x1200 avec AA4x :  Maintenez la souris sur le graphe pour classer les cartes par performances en 1920 AA4x. Comme nous le suspections, c’est la Radeon HD 6990 qui l’emporte avec une avance de 3 à 8% dans notre indice et avec son bios 375W. Une fois le bios 450W en place, cette avance varie entre 6 et 12%. Les GeForce GTX 570 en SLI sont également légèrement devant la GeForce GTX 590 alors que la couple de GeForce GTX 580 dispose d’une avance de 20 à 23%. Nous avons également mis sous forme d’indice les résultats obtenus en surround gaming, en excluant Mafia II qui pose plusieurs problèmes :  Maintenez la souris sur le graphe pour classer les cartes par performances en 5760x1080. Ici aussi, la Radeon HD 6990 dispose d’une petite avance sur la GeForce GTX 590, avance qui devient plus importante une fois l’antialiasing activé. Vous remarquerez que les cartes équipées de seulement 1 Go de mémoire sont fortement impactée dans ces conditions. Enfin, nous avons rassemblé les résultats en 3D Vision. Il ne s’agit pas d’un indice similaire aux 2 autres puisqu’il s’agit ici d’une moyenne non pondérée. Ces résultats indiquent donc la propension d’une carte à atteindre les 60 fps par œil :  La GeForce GTX 590 fait cette fois aussi bien que les GeForce GTX 570 SLI, profitant de sa mémoire plus importante dans certains cas. Page 18 - Conclusion ConclusionAffronter une Radeon à armes égales n’est pas évident pour Nvidia. Avec un même niveau de démesure pour la consommation maximale, la Radeon HD 6990 part d’entrée de jeu avec un avantage compte tenu de son rapport performances/watts légèrement supérieur. Comme nous le supposions, elle conserve donc la première place du podium face à la GeForce GTX 590. Ne s’intéresser qu’aux performances brutes serait toutefois bien trop réducteur face à des cartes graphiques extrêmes telles que celles-ci qui n’ont aucune utilité pour jouer dans des conditions classiques en full HD. Il convient ainsi de s’assurer qu’elles soient à la hauteur lors d’une utilisation extrême elle aussi, raison pour laquelle nous avons effectué bien plus de tests que d’habitude en incluant des résultats en surround gaming ainsi qu’en 3D stéréoscopique. La Radeon HD 6990 profite à ce niveau d’une mémoire vidéo de 2 Go par GPU associée à la technologie Eyefinity pour proposer une prise en charge de premier ordre du surround gaming. Malgré la puissance qu’elle affiche, nous avons cependant pu constater que cela restait insuffisant dans les jeux les plus gourmands pour lesquels il faudra revoir la qualité à la baisse ou passer au tri voire au quad GPU ! Malheureusement la Radeon HD 6990 souffre d’un défaut majeur qui refroidira les amateurs de performances : des nuisances sonores insupportables.  De son côté la GeForce GTX 590 s’en sort également honorablement en surround gaming, bien qu’elle souffre plus rapidement que les Radeon lors de l’utilisation de l’antialiasing puisqu’elle doit se « contenter » de 1.5 Go de mémoire par GPU. En revanche, elle profite pleinement de l’écosystème 3D Vision, seule solution réellement disponible pour jouer en 3D stéréo et en full HD. Mais là où elle se démarque le plus de sa concurrente directe, c’est sur le plan des nuisances sonores qui sont cette fois très bien maîtrisées. Si elle reste en général légèrement en retrait face à un couple de GeForce GTX 570 en SLI à la tarification similaire de 650€, sa quantité de mémoire plus élevée lui permet dans quelques cas de faire une différence plus importante. C’est cependant avant tout sur le plan thermique et de l’encombrement que ces solutions diffèrent. Les GeForce GTX 570 occupent 4 slots mais expulsent en dehors du boîtier la majorité de l’air chaud qu’elles produisent alors que la GeForce GTX 590 est relativement compacte mais n’en expulse que la moitié, la seconde étant repoussée à l’intérieur du boîtier, en direction des disques durs dont il faudra s’assurer du bon refroidissement, si vous tenez à vos données. Mettre au point cette GeForce GTX 590 était bien entendu une tâche ardue et au vu du niveau de consommation et de l’absence de vraie gestion à ce niveau, Nvidia a dû se contenter de bricoler des sécurités au niveau logiciel pour éviter que la carte ou le système soit endommagé lors des charges extrêmes. La fragilité relative de cette approche et le peu de marge de manœuvre qu’il reste rendent cette carte inadaptée pour les amateurs d’overclocking et de mods en tous genres, ce qui prive Nvidia d’une partie de la déjà très petite niche visée par ce type de produits. En fin de compte, en dehors de sa mission première qui est de ne pas laisser le champ libre à la Radeon HD 6990, cette GeForce GTX 590 ne sera utile que dans très peu de cas : pour un système 3D stéréo compact ainsi que pour pouvoir passer au quad SLI dans le cadre d’un système dédié au surround gaming. Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |