| |

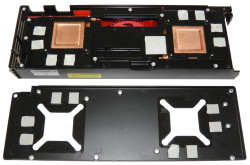

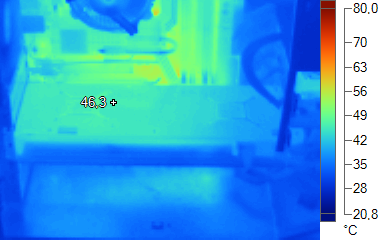

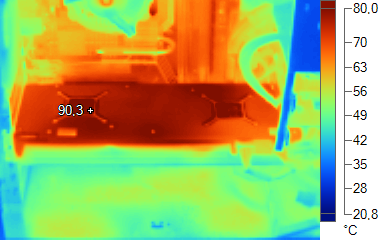

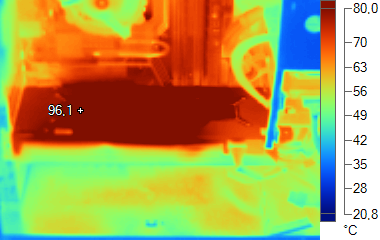

| AMD Radeon HD 6990, la carte de tous les records Cartes Graphiques Publié le Jeudi 10 Mars 2011 par Damien Triolet URL: /articles/822-1/amd-radeon-hd-6990-carte-tous-records.html Page 1 - Introduction D’abord prévu pour le mois de décembre, puis pour janvier, puis pour février, c’est finalement en ce début de mois de mars que débarque le nouveau vaisseau amiral d’AMD. Des retards qui s’expliquent par une mise en production très complexe pour un tel monstre de puissance qui embarque deux GPUs Cayman, similaires à ceux qui équipent les Radeon HD 6970. Le but affiché est clair : remplacer la Radeon HD 5970 en accentuant l’avance prise sur la GeForce GTX 580 tout en se préparant à affronter la future GeForce GTX 590. Le bi-GPU devenu une tradition  Depuis la génération des Radeon HD 3000, chaque famille de cartes graphiques a reçu une version bi-GPU en guise de fer de lance : Radeon HD 3870 X2, Radeon HD 4870 X2, Radeon HD 5970 et maintenant Radeon HD 6990. La plupart de ces cartes ont permis à AMD de prendre une avance sur Nvidia, qui, en concevant d’énormes GPU, a plus de difficultés à mettre au point des versions bi-GPU et doit souvent attendre un « die-shrink », une révision moins énergivore de ses GPUs, pour se lancer. Avec Cayman, dont vous pourrez retrouver le test ici, AMD a cependant visé plus haut que d’habitude. Si le résultat s’est avéré mitigé en termes de performances, il était cependant bien là au niveau de la consommation. AMD a malgré cela directement tenu à affirmer qu’une version bi-GPU restait à l’ordre du jour, nom de code Antilles, et profiterait de la technologie PowerTune pour gérer la consommation en hausse. Pour rappel, via de nombreux capteurs présents dans chaque bloc du GPU, PowerTune est capable de connaître le niveau d’activité du GPU et via une table de correspondance, d’en déduire le niveau de consommation que cela peut engendrer. Etant donné qu’il peut y avoir des variations importantes entre plusieurs échantillons d’un même GPU, pour mettre au point cette table de correspondance, AMD indique s’être basé sur le pire des cas, c’est-à-dire un GPU qui souffre de courants de fuite importants et utilisé à une température élevée. Suivant les échantillons, la consommation réelle peut donc être similaire ou inférieure, parfois de beaucoup, à celle estimée par le GPU, qui n’est en aucun cas capable de connaître la consommation réelle. Parallèlement à cela, AMD indique au GPU une valeur de consommation à ne pas dépasser. Dès que celle-ci est dépassée par la consommation estimée par le GPU, celui-ci réduit progressivement sa fréquence et la réaugmente dès que la consommation baisse. Le GPU est ainsi capable d’adapter en temps réel sa fréquence pour respecter une enveloppe thermique donnée. Du coup, nous en avions conclu qu’AMD utiliserait PowerTune pour proposer une solution qui offrirait les meilleures performances possibles dans une enveloppe thermique de 300W, le maximum défini par les normes PCI Express 2.0. AMD a cependant décidé d’aller au-delà, probablement pour éviter de proposer une carte qui au final aurait pu être moins performante que la Radeon HD 5970, basée sur des GPUs au rendement énergétique quelque peu meilleur. C’est donc 375W… ou 450W, au choix, que vise AMD avec la Radeon HD 6990 ! Un premier record qui ne manquera pas de soulever la polémique, d’autant plus que la question de la garantie est laissée de côté d’une manière plutôt ambigüe… Page 2 - Spécifications, la Radeon HD 6990 Spécifications  Alors que la Radeon HD 5970 utilisait une fréquence GPU revue à la baisse par rapport à la Radeon HD 5870, la Radeon HD 6990, en mode 450W, utilise une fréquence GPU identique à celle de la Radeon HD 6970. Par contre, en mode 375W, elle passe de 880 à 830 MHz, une baisse de 6%. Dans les deux cas la fréquence mémoire est cependant réduite et passe de 1375 MHz (2750 MHz pour les données) à 1250 MHz (2500 MHz pour les données). Gros avantage par rapport à la Radeon HD 5970 de référence, la Radeon HD 6990 est équipée par défaut de 2 Go de mémoire par GPU, de quoi pouvoir profiter de conditions de jeu extrêmes sans que la carte ne soit bridée par une insuffisance de mémoire. La Radeon HD 6990 de référenceAMD nous a fourni une Radeon HD 6990 de référence, qui est probablement le seul modèle qui sera disponible dans le commerce, ainsi que les photos de la carte démontées (face avant du PCB et ventirad), en précisant utiliser un pad thermique à changement de phase qui perdrait son efficacité si nous la démontions, ce que nous avons donc évité de faire :         La Radeon HD 6990 reprend un format identique à celui de la Radeon HD 5970 : le PCB mesure 29cm et le carter du ventirad le dépasse d’un bon centimètre, portant la taille totale à un peu plus de 30cm. Une carte qui ne rentrera donc pas dans tous les boîtiers. Heureusement, les connecteurs d’alimentation prennent place sur le dessus de la carte et non à l’arrière. Notez également qu’elle est plus haute de 2-3mm par rapport aux formats habituels. Au niveau de la connectique, AMD a opté pour un seul connecteur DVI Dual-Link accompagné de 4 sorties mini-DisplayPort. Il est donc possible de piloter jusqu’à 5 écrans sans utiliser les spécificités du DisplayPort 1.2 et 6 avec. AMD précise que le packaging de base de la Radeon HD 6990 inclura un adaptateur passif mini-DP vers HDMI, un adaptateur passif mini-DP vers DVI Single-Link ainsi qu’un adaptateur actif mini-DP vers DVI Single-Link. Il sera donc possible d’utiliser directement jusqu’à 3 écrans qui ne supportent pas nativement le DisplayPort. Un seul pourra cependant exploiter le DVI Dual Link (2560x1600 ou 1920x1080 120 Hz). Pour refroidir ces 2 GPUs, AMD a revu le système de refroidissement. S’il est toujours basé sur une turbine, celle-ci est placée au centre de la carte et expulse ainsi de l’air dans les deux directions : la moitié vers la grille d’extraction et l’autre moitié vers l’arrière de la carte. Ce design permet d’une part de mettre les deux GPU sur un pied d’égalité en terme de refroidissement et d’autre part de les espacer. Un espace qui est occupé par le switch PCI Express PLX ainsi que par l’étage d’alimentation composé de 4 phases pour chaque GPU et de 2 phases pour la mémoire de chacun. La mémoire GDDR5 est signée Hynix et certifiée à 1.25 GHz, soit sa fréquence de fonctionnement sur cette carte. AMD indique avoir pris soin de sélectionner les meilleurs exemplaires de son GPU Cayman pour équiper la Radeon HD 6990. Des critères plus stricts qui impliquent qu’il y aura moins de variation entre deux exemplaires et que la consommation devrait se rapprocher de la limite fixée pour PowerTune.  Ces GPU ont été validés à 880 MHz avec une tension GPU de 1.175V ainsi qu’à 830 MHz avec une tension de 1.120V. Comme les Radeon HD 6950 et 6970, la Radeon HD 6990 dispose de deux bios et d’un petit switch pour passer de l’un à l’autre. AMD a ici décidé d’exploiter cette fonctionnalité pour proposer deux modes différents. Le bios 1 exploite une fréquence GPU de 880 MHz et une limite de 450W pour PowerTune alors que le bios 2 se contente de la fréquence de 830 MHz et impose une limite PowerTune de 375W. Ces GPU ont été validés à 880 MHz avec une tension GPU de 1.175V ainsi qu’à 830 MHz avec une tension de 1.120V. Comme les Radeon HD 6950 et 6970, la Radeon HD 6990 dispose de deux bios et d’un petit switch pour passer de l’un à l’autre. AMD a ici décidé d’exploiter cette fonctionnalité pour proposer deux modes différents. Le bios 1 exploite une fréquence GPU de 880 MHz et une limite de 450W pour PowerTune alors que le bios 2 se contente de la fréquence de 830 MHz et impose une limite PowerTune de 375W.Ces deux valeurs de consommation dépassent la limite définie par le PCI Express 2.0 mais la seconde respecte cependant la limite de consommation par canal d’acheminement : - Bus PCIe : 75W - Connecteur 6 broches : 75W - Connecteur 8 broches : 150W Avec 2 connecteurs d’alimentation 8 broches, la Radeon HD 6990 peut donc afficher une consommation de 375W en respectant au moins ces standards. Pour le premier bios par contre AMD va au-delà des spécifications, ce qui pourrait poser problème avec certaines alimentations bien que la plupart des modèles puissants monorails puissent encaisser cette charge sans broncher. Attention cependant, si AMD indique avoir validé le tout avec le bios 1 et conseille à la presse d’utiliser celui-ci, il sera protégé par un autocollant sur les cartes du commerce… Se pose alors la question de la garantie, un point délicat sur lequel AMD évite de répondre clairement, se contentant de préciser que tout overclocking entraîne une rupture de la garantie. Nous pouvons donc en conclure que du point de vue d’AMD, utiliser ce bios « conseillé » annule la garantie. Au CeBIT, les différents partenaires d’AMD n’étaient visiblement pas au courant de ce système de deux niveaux de spécifications. Tous étaient très embêtés lorsqu’ils l’ont découvert et encore plus lorsque nous leur avons demandé comment ils prévoyaient de gérer de leur côté la garantie par rapport à ce point, certains étant réellement irrités d’être placés dans cette position par AMD. S’il semble évident qu’aucune carte ne sera acceptée en retour dans le cas où le bios 1 pose problème (cela peut être dû à un système mal adapté), que se passera-t-il si la carte venait à mourir alors que le bios 1 est utilisé et que l’autocollant a été retiré ? Tout dépendra probablement de la politique du fabricant qui pourra décider ou pas d’aller au-delà de la garantie AMD. Page 3 - Consommation, bruit ConsommationNous avons mesuré la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos, sous 3D Mark 06 et sous Furmark. Notez que nous utilisons une version de Furmark non-détectée par le mécanisme de limitation de la consommation dans les stress tests mis en place par Nvidia dans les pilotes pour les GeForce GTX 500.  Alors que la consommation au repos reste identique à celle de la Radeon HD 5970, et plutôt raisonnable pour une carte de ce calibre, elle explose en charge. Etrangement, le comportement de PowerTune semble différent pour les deux bios, ce que nous pouvons supposer être lié à la température GPU. Plus elle est élevée, plus les courants de fuite augmentent, ce qui a un effet direct sur la consommation. Nous pouvons donc estimer qu’AMD n’a pas complètement pris en compte cette température plus élevée et n’a donc pas été très conservateur en définissant la table de correspondance pour PowerTune en mode 450 watts. Cela permet de donner plus de marge au GPU, soit pour l’overclocking, soit dans les situations de charge extrême comme c’est le cas dans Furmark. Ainsi en mode 375W, nous avons observé la fréquence GPU varier entre 535 et 830 MHz avec une moyenne de 560 MHz alors qu’en mode 450w, la fréquence GPU oscillait entre 670 et 880 MHz avec une moyenne de 765 MHz. Le gain de performances dans Furmark était alors d’un peu plus de 20% !. Il faut noter que le comportement de PowerTune dans FurMark est extrême du fait de la lourdeur du test. Les jeux poussant moins le GPU dans ses derniers retranchements en terme de consommation, PowerTune n’agit alors quasiment pas. Notez que malgré cette consommation extrême, la Radeon HD 6990 ne dépasse pas la consommation maximale définie pour le bus PCI Express. Alors que la norme autorise les cartes graphiques à y puiser 5.5A en 12V, le niveau maximal observé, avec le bios 450W, a été de 5.32A. Il n'y a donc pas de risque d'endommager une carte-mère, contrairement à ce que nous avions pu observer avec les GeForce GTX 480 et 580. Nuisances sonoresNous plaçons les cartes dans un boîtier Antec Sonata 3 et mesurons le bruit d'une part au repos et d'autre part en charge. Le sonomètre est placé à 60cm du boîtier.  Si la Radeon HD 6990 reste discrète au repos, en charge, elle bat le triste record des GeForce GTX 480 en SLI avec plus de 59 dB. A ce niveau de bruit, sa turbine tourne à pleine vitesse soit 4900 TPM. Notez que dans le cas du mode 375W, les nuisances sonores varient d’une manière cyclique entre 52.8 dB et 59.4 dB. La turbine tourne à 3600 TPM, les températures augmentent, elle accélère progressivement jusque 4900 TPM, les températures baissent au bout de quelques dizaines de seconde, la turbine redescend progressivement jusque 3600 TPM, les températures augmentent au bout de quelques temps et ainsi de suite. Nous pouvons donc supposer que si vous prenez bien soin du refroidissement de votre boîtier, il soit possible d’éviter l’emballement de la turbine. Dans tous les cas, nous sommes loin du silence ! Page 4 - Températures TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  En mode 450W, la turbine atteint sa vitesse de rotation maximale et la température grimpe au-delà des 100 °C. Voici ce que cela donne en image grâce à la thermographie infrarouge :  HD 6990 au repos  HD 6990 375W en charge  HD 6990 450W en charge La Radeon HD 6990 expulsant la moitié de l’air chaud vers l’intérieur du boîtier, le températures des composants qui l’entourent augmente, c’est particulièrement le cas pour les disques durs qui seront soumis à rude épreuve comme vous pouvez le constater dans notre dossier consacré au dégagement thermique des cartes graphiques qui a été mis à jour avec les résultats complets de la Radeon HD 6990. Page 5 - Les pilotes, le test Un catalyseur à bugs ?Depuis quelques mois, nous avons constaté une recrudescence des petits bugs dans les pilotes Catalyst d’AMD. Installateur qui indique sans raison ne pas trouver de fichier INF, Catalyst Control Center qui refuse de se lancer prétextant qu’aucun pilote n’est installé alors que tout est en ordre, options qui disparaissent, options liées à de précédentes architectures qui s’ajoutent par-dessus celles des cartes récentes, paramètres affichés différents de ceux réellement activés… Nous avons arrêté de compter les heures perdues à cause de ces petits problèmes. AMD ne proposant pas de système de nettoyage dans son installateur, contrairement à Nvidia, ces problèmes amènent souvent dans une impasse de laquelle il est difficile de s’extirper. Certes, nous estimons que la plupart de ces problèmes sont liés aux nombreux changements de cartes graphiques nécessaires lors de nos tests, mais ils témoignent d’un problème de logique dans la manière dont sont codées certaines fonctions des pilotes, ou plutôt du Catalyst Control Center. A l’heure où AMD prépare son panneau de contrôle pour être utilisé par un plus large public à travers les systèmes Fusion, il serait bon de resserrer quelque peu les mailles du filet de la validation et de nous proposer une solution plus robuste. Pour ce test, AMD nous a fourni des pilotes en dernière minute et qui présentaient plusieurs problèmes de performances en CrossFire X. Ainsi, alors que ce mode donnait de très bons résultats dans Starcraft II et dans F1 2010 auparavant, ce n’était plus le cas avec les Catalyst 11.4 beta. AMD a corrigé le problème pour F1 2010 via une mise à jour des profils applicatifs (Catalyst 11.2 CAP3) mais pas pour Starcraft II. Là aussi, il est quelque peu inquiétant de voir s’ajouter des bugs liés au multi-GPU alors qu’au fil du temps il serait logique de s’attendre à ce que son utilisation se fasse d’une manière totalement transparente. AMD a visiblement bouclé ces pilotes dans l’empressement, ce que nous ne comprenons pas étant donné que nous n’avions pas rencontré ces problèmes lors du lancement des Radeon HD 6950 et 6970 en décembre et qu’AMD a eu 3 mois de plus pour peaufiner ses pilotes en vue de l’arrivée de la Radeon HD 6990. Surround gamingEtant donné le statut plutôt haut de gamme des solutions graphiques qui prennent place dans ce dossier, nous avons jugé intéressant d’observer leur comportement en surround gaming. Pour cela, nous avons utilisé 3 moniteurs en 1920x1080 pour une résolution totale de 5760x1080.  Du côté d’AMD, toutes les Radeon HD 5000 et 6000 sont capables de supporter ce mode grâce à la technologie Eyefinity. C’est également le cas pour toutes les solutions CrossFire X. Attention cependant à la limitation au niveau du support de la connectique DVI/HDMI/VGA : les Radeon ne peuvent alimenter que deux de ces sorties. Pour le ou les écrans supplémentaires, il faut passer par du DisplayPort et utiliser un adaptateur actif (fourni avec les Radeon HD 6990) si vous ne disposez pas d’écrans supportant nativement cette norme. Dans le camp Nvidia, la donne est quelque peu différente puisque chaque GeForce ne peut piloter que deux écrans, peu importe la connectique utilisée. Pour profiter du surround gaming, il est donc obligatoire de passer par le SLI, ou par l’équivalent en terme de carte bi-GPU. Deux écrans sont alors connectés à l’une des cartes et le troisième à l’autre carte. AMD et Nvidia proposent des fonctions similaires pour créer une grande surface d’affichage, qui sera vue comme un seul grand écran par Windows, mais également par les jeux, ce qui facilite le support du surround gaming. Les deux pilotes permettent de modifier la position des écrans dans la grande surface (il n’y a donc pas besoin de jongler avec les sorties jusqu’à avoir les écrans dans le bon ordre) et d’introduire une compensation pour éviter un décalage lié à la la bordure des écrans (« bezel correction »). Nous n’avons pas activé ce mode qui agrandi la résolution, par exemple de 5760x1080 à 5920x1080, et introduit une charge supplémentaire. Notez que si le Control Center des Catalyst nous a posé de nombreux problèmes récemment, la page consacrée à Eyefinity ne nous a par contre jamais posé le moindre souci… contrairement aux pilotes Nvidia qui semblent très capricieux. Une fois la grande surface pour le surround en place, tout fonctionne parfaitement, mais encore faut-il arriver à l’activer ! Entre plantages du système, plantages du panneau de contrôle des pilotes, pertes d’affichage, nous avons essuyé de nombreux échecs. Au bout de nombreuses tentatives et de changement de connecteurs nous sommes finalement parvenus à profiter du surround gaming, sans qu’il n’y ait de logique ni de similitude entre les 3 systèmes testés. Nous supposons que ces problèmes sont liés d’une part à l’utilisation du HDMI (utilisé pour 2 ou 3 des écrans) et d’autre part à l’utilisation de modèles personnalisés des partenaires, à la connectique différente des modèles de référence. Dans tous les cas, il semblerait que Nvidia n’ait pas passé en revue assez de combinaisons lors de son processus de validation. Le testPour ce test, nous avons décidé d’abandonner Need for Speed Shift et ArmA 2, totalement limités par le CPU avec des cartes graphiques du calibre de celles testées ici. Les tests ont été exécutés en 1920x1200 avec MSAA 4x et avec MSAA 8x, ainsi qu’en 2560x1600 avec MSAA 4x, excepté pour Crysis et Far Cry 2 qui ont été testés dans plus de résolutions. Nous avons également testé toutes ces solutions en 5760x1080 avec et sans MSAA 4x. Tous les détails ont été poussés maximums. Les dernières mises à jour ont été installées et toutes les cartes ont été testées avec les derniers pilotes disponibles. Nous n’affichons plus les décimales dans les résultats de performances dans les jeux pour rendre le graphique plus lisible. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l’indice. Si vous êtes observateurs vous remarquerez que c’est également le cas pour la taille des barres dans les graphes. Les Radeon et les GeForce ont été testées avec le filtrage des textures réglé sur « qualité ». Toutes les Radeon ont été testées avec le pilote Catalyst 11.4 beta (8.84.3 beta 2). De leur côté, toutes les GeForce ont été testées avec les pilotes beta 267.31. Configuration de testIntel Core i7 980X (HT désactivé) Asus Rampage III Extreme 6 Go DDR3 1333 Corsair Windows 7 64 bits Forceware 267.31 beta Catalyst 11.4 beta (8.84.3 beta2) + Catalyst 11.2 CAP3 Page 6 - Starcraft II Starcraft 2  Pour tester Starcraft 2, nous lançons un replay et mesurons les performances en suivant la vue d’un des joueurs. Toutes les options graphiques sont poussées au maximum. Le jeu n’intègre pas de support de l’antialiasing qui est donc activé par les panneaux de contrôle des pilotes AMD et Nvidia. Le patch 1.0.3 est installé.  Un problème introduit avec les derniers pilotes affecte les performances en mode CrossFire. Pour éviter toute tricherie, les développeurs de Starcraft 2 interdisent l’utilisation du surround gaming. Page 7 - Mafia II Mafia II  Le moteur de Mafia II confie la gestion de la physique aux bibliothèques PhysX de Nvidia et en profite pour proposer un niveau de détails physiques élevé qui peut être partiellement accéléré par les GeForce. Pour mesures les performances, nous utilisons les benchmark intégré et toutes les options graphiques sont poussées à leur maximum tout d’abord sans activer les effets PhysX accélérés par le GPU :  La Radeon HD 6990 en mode 375W égale ici les Radeon HD 6950 2 Go en CrossFire. Ensuite, nous passons les détails PhysX à leur niveau élevé :  Avec les effets PhysX poussés au maximum, les performances plongent. Notez qu’elles sont en partie limitées par le CPU, tous les effets PhysX supplémentaires n’étant pas accélérés. Les Radeon restent bien entendu derrière.  Mafia II est capable de détecter qu’une grande surface d’affichage est liée à l’utilisation de 3 moniteurs, et reporte d’ailleurs 3x 1920x1080 et non 5760x1080, ce qui lui permet d’adapter automatiquement l’interface utilisation. Pour une raison inconnue, cette détection échoue cependant avec le couple Radeon HD 6990 + Radeon HD 6970 (triple CrossFire X) ainsi qu’avec la Radeon HD 5970. Sans cette détection, l’interface est inutilisable et le rendu du mode benchmark ne se fait que sur un écran. Du côté des GeForce, l’activation de l’antialiasing est sans effet. Nous supposons que Nvidia en bloque l’activation dans ses pilotes pour éviter les effets d’un manque de mémoire important. Page 8 - Crysis Warhead Crysis Warhead  Crysis Warhead a remplacé Crysis dont il reprend le moteur graphique très gourmand à tous les niveaux. Nous le testons dans sa version 1.1 hotfix et en mode 64 bits puisque c’est la principale nouveauté apportée. Crytek a renommé les différents modes de qualité graphique, probablement pour ne pas heurter les joueurs déçus de ne pas pouvoir activer le mode très haute qualité pour cause de gourmandise excessive. Le mode haute qualité est ainsi renommé « Gamer », et le mode très haute qualité « Enthousiast », c’est celui que nous avons testé.   Les Radeon HD 6900 se comportent ici plutôt bien et profitent de 2 Go de mémoire en 2560x1600 AA8x.  Les GeForce GTX 560 en SLI n’ont pas assez de mémoire pour lancer Crysis dans ces conditions. Il en va de même pour les Radeon en CrossFire lorsqu’elles ne sont équipées que de 1 Go de mémoire mais uniquement quand l’antialiasing est activé. Le triple CrossFire est ici très utile ! Page 9 - Far Cry 2 Far Cry 2  La suite de Far Cry n’en est pas réellement une puisque Crytek était à l’origine du premier épisode. La licence appartenant à Ubisoft c’est ce dernier qui s’est chargé de son développement, Crytek optant alors pour Crysis. Pas facile de reprendre l’héritage de révolution graphique qui accompagne Far Cry, mais les équipes d’Ubisoft s’en sont bien tirées même si l’aspect graphique n’est pas aussi abouti que celui de Crysis. Le jeu est aussi moins gourmand ce qui n’est pas plus mal. Il supporte DirectX 10.1 pour améliorer les performances des cartes compatibles. Nous avons installé le patch 1.02 et utilisé le mode de qualité graphique « ultra élevé ».   Si les GeForce apprécient particulièrement Far Cry 2, le rendement de CrossFire est quelque peu plus élevé que celui du SLI, ce qui permet aux Radeon de bien se positionner. Etrangement les Radeon HD 6950 1 Go affichent des performances significativement plus élevées que les mêmes en version 2 Go.  Pour une raison qui nous est inconnue, les Radeon sont fortement limitées par le CPU en surround gaming dans Far Cry 2, ce qui permet aux GeForce de prendre l’avantage. Les solutions CrossFire restent cependant au-delà de 60 fps et permettent de profiter de Far Cry 2 sans problème dans ces conditions. Page 10 - H.A.W.X. H.A.W.X.  H.A.W.X. est un jeu d’action qui se passe dans les airs. Il utilise un moteur qui prend en charge DirectX 10.1 pour optimiser le rendu. Parmi les effets graphiques supportés, notons la présence de l’occlusion ambiante qui est poussée à son maximum tout comme les autres options. Nous utilisons le benchmark intégré et le patch 1.2 est installé.  Les GeForce sont ici plus efficaces et le couple de GTX 560 Ti égale la Radeon HD 6990.  Toutes les solutions testées ici permettent de profiter du surround gaming dans ce jeu, à l’exception de la GeForce GTX 580 bien entendu, puisqu’elle ne supporte pas du tout ce mode. Notez que dans cette résolution, H.A.W.X. ne propose plus d’antialiasing au-delà du mode 2x. Page 11 - Battleforge BattleForge  Premier jeu à supporter DirectX 11, ou plus précisément Direct3D 11, il nous était difficile de ne pas l’intégrer à ce test. Une mise à jour déployée en septembre 2009 a en effet ajouté le support de la nouvelle API de Microsoft à BattleForge. Ce sont les Compute Shaders 5.0 qui sont ici exploités par les développeurs pour accélérer le traitement du SSAO, soit de l’occlusion ambiante. Par rapport à l’implémentation classique, via les Pixel Shaders, la technique permet d’exploiter plus efficacement la puissance de calcul disponible en saturant moins les unités de texturing. BattleForge propose deux niveaux de SSAO : High et Very High. Seul le second, appelé HDAO (High Definition AO), exploite les Compute Shader 5.0. Nous avons utilisé le benchmark intégré au jeu et installé la dernière mise à jour disponible à ce jour (1.2 build 304941).  Les GeForce GTX 560 Ti terminent ici au niveau de la Radeon HD 6990 qui ne se démarque qu’en 2560x1600 AA4x. AMD souffre ici d’une perte plus importante liée à l’activation de l’antialiasing 8x.  Les GeForce profitent ici d’un coût plus faible pour l’activation de l’antialiasing 4x. Page 12 - Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d’une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d’autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le patch 1.2 est installé.  Les GeForce s’en tirent ici très bien et sont moins vite limitées par le CPU que les Radeon. Bien que Civilization V supporte le surround gaming, ce n’est malheureusement pas le cas de son outil de benchmark intégré. Page 13 - S.T.A.L.K.E.R. Call of Pripyat S.T.A.L.K.E.R. Call of Pripyat  Cette nouvelle suite de S.T.A.L.K.E.R. repose sur une évolution du moteur, en version 1.6.02, et supporte Direct3D 11 qui est exploité d’une part pour améliorer les performances et d’autres part la qualité avec en option des ombres et des éclairages plus détaillés ainsi qu’un support de la tessellation. Le mode de qualité utilisé est « maximum » et nous avons activé la tessellation. Le jeu ne supporte pas l’antialiasing 8x. Notre scène de test représente 50% en extérieur et 50% en intérieur et dans ce dernier cas nous sommes face à plusieurs personnages.  Les Radeon HD 6900 sont ici très efficaces, surtout en 2560x1600.  Les Radeon restent également très efficaces en mode surround, surtout avec antialiasing où elles profitent de leur mémoire de 2 Go. Les solutions 1 Go sont clairement limitées par leur mémoire. Page 14 - F1 2010 F1 2010  Dernier né chez Codemaster, F1 2010 reprend le même moteur que DiRT 2 et supporte ainsi DirectX 11, via le patch 1.1 que nous avons bien entendu installé. Ce patch ayant été développé en collaboration avec AMD, Nvidia nous a indiqué ne l’avoir reçu que tardivement et ne pas encore avoir eu l’opportunité d’optimiser ses pilotes pour ce jeu en version DirectX 11. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons l’outil de test intégré sur le circuit de Spa-Francorchamps avec une seule F1.  Dans F1 2010, les Radeon sont particulièrement à l’aise. Vous noterez que le triple CrossFire X n’apporte ici aucun gain.  F1 2010 est le jeu dans lequel le surround gaming apporte selon nous le plus. L’immersion et la sensation de vitesse en profitent pleinement. Si le triple CrossFire X n’apporte toujours aucun gain dans ce jeu, toutes les solutions bi-GPU à base de Radeon 2 Go permettent de profitent de F1 2010 avec antialiasing et en surround gaming. C’est un petit peu moins bien pour les GeForce GTX 580 en SLI, mais cela passe malgré tout avec une bonne fluidité. Avec les GeForce GTX 570 en SLI il faudra par contre faire l’impasse sur l’antialiasing. Page 15 - Metro 2033 Metro 2033  Probablement le jeu le plus lourd du moment, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n’avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l’avons testé en mode DirectX 11, avec une qualité très élevée et la tessellation activée avec MSAA 4x. Nous avons ensuite mesuré les performances avec MSAA 4x et le Depth of Field.  Les cartes équipées de seulement 1 Go de mémoire sont dépassées quand le Depth of Field est activé.  Très gourmand, Metro 2033 met bien entendu toutes les solutions graphiques à genoux en surround gaming. Pour en profiter avec un bon niveau de qualité, 3 GPUs sont nécessaires, équipés de 2 Go pour l’antialiasing. Page 16 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, d’autant plus avec les solutions haut de gamme dont les scores sont susceptibles d’être lissés par la limitation CPU de certains jeux, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Mafia II est ici intégré avec les scores obtenus sans les effets GPU PhysX. Nous avons attribué un indice de 100 à la GeForce GTX 580 en 1920x1200 avec AA4x :  Maintenez la souris sur le graphe pour classer les cartes par performances en 1920 AA4x. La Radeon HD 6990 rempli sa mission sur le plan des performances avec, en mode 375W, un gain de 22 à 32% sur la Radeon HD 5970 et de 46 à 57% sur la GeForce GTX 580. Le mode 450W permet de gagner de 2.9 à 3.4% sur le mode 375W, suivant la résolution, le gain le plus faible étant atteint avec MSAA 8x. Nous supposons ici que l’ensemble est en partie limité par sa bande passante mémoire, ce qui explique que ces gains soient plus faibles que la différence de fréquence de 6% qui sépare les deus bios. Par rapport aux systèmes CrossFire, le mode 375W de la Radeon HD 6990 la situe plutôt au niveau des Radeon HD 6950 2 GB alors que le mode 450W le situe à mi-chemin entre ces dernières et les Radeon HD 6970. La Radeon HD 6990 se situe à un niveau similaire à celui des GeForce GTX 570 en SLI et les GeForce GTX 580 en SLI prennent une petite avance. L’ensemble Radeon HD 6990 + Radeon HD 6970, proposé à un prix similaire à celui de ces dernières est cependant plus performant. Page 17 - Radeon HD 6990 vs CrossFire X Radeon HD 6990 vs CrossFire XNous avons mis en forme nos résultats de manière à mettre en évidence la différence de performances entre la Radeon HD 6990 et les Radeon HD 6950 et 6970 en CrossFire X :  Maintenez la souris sur le graphe pour afficher les performances relatives.  Maintenez la souris sur le graphe pour afficher les performances relatives.  Maintenez la souris sur le graphe pour afficher les performances relatives. Page 18 - Radeon HD 6950 CFX : 2 Go vs 1 Go Radeon HD 6950 CFX : 2 Go vs 1 GoNous avons également voulu mettre en évidence la différence de performances entre les systèmes CrossFire à base de Radeon HD 6950 2 Go et 1 Go :  La présence de 2 Go permet d’apporter un gain très important dans Crysis Warhead ainsi que dans Metro 2033. Au-delà du 1920x1200 avec FSAA 4x, il est impossible de jouer sur le système 1 Go dans ces jeux. Notez que dans le cas de Metro 2033, il ne s’agit pas de 1920x1200 AA8x, mais bien de 1920x1200 AA 4x + DoF. En dehors de ces deux cas, les performances du système CrossFire X à base de Radeon HD 6950 2 Go sont en général légèrement inférieures à celle des Radeon HD 6950 1 Go, phénomène que nous avions également observé avec une seule de ces cartes. L’écart est cependant étonnement élevé dans Far Cry 2.  En surround gaming, la présence de 2 Go prend plus d’importance et change complètement la donne dès que l’antialiasing est utilisé. Page 19 - Conclusion ConclusionSi la Radeon HD 6990 bat effectivement de nouveaux records, tous ne sont malheureusement pas positifs. Tout en se plaçant dans la lignée des Radeon bi-GPU précédentes, elle en amplifie les défauts: consommation et nuisances sonores explosent. Afin de propulser suffisamment d’air pour dissiper 375 à 450 watts, il n’y a pas de secret, l’unique turbine doit monter dans les tours et nous faire oublier le silence affiché au repos. Si vous êtes pointilleux sur ce point, autant être clairs dès le départ : passez votre chemin et tournez-vous plutôt vers un couple de GeForce GTX 570 en SLI, une solution bi-GPU haut de gamme plus acceptable au niveau des nuisances sonores bien que sa consommation soit similaire.  Avec PowerTune, nous pensions qu’AMD nous proposerait une Radeon HD 6990 plutôt sage mais le fabricant avait d’autres idées en tête : mettre au point un monstre de puissance en faisant exploser l’enveloppe thermique de 300 à 375 voire même à 450 watts. Il s’agit là d’une des particularités de ce modèle qui dispose de deux modes, chacun avec des fréquences et une limite de consommation différente. Le mode 450 watts, bien que conseillé d’un côté par AMD, doit cependant être considéré comme entraînant une rupture de la garantie. Il est avant tout conçu dans l’optique de pouvoir proposer une marge d’overclocking et de moins limiter le GPU dans les charges très lourdes. En pratique, dans les jeux, il n’apporte qu’un maigre gain par rapport au mode 375 watts. C’est ce second bios que nous vous conseillerons donc d’utiliser, d’autant plus que si vous prenez soin du bon refroidissement de votre boîtier, vous devriez pouvoir éviter aux nuisances sonores de s’envoler. Proposée à 600€, le public visé par cette carte est plus que réduit, d’autant plus que les Radeon HD 6950 ou 6970 en CrossFire affichent un rapport performances/prix similaire, un peu moins de bruit et un encombrement différent qui pourra s’adapter à plus de boîtiers. La Radeon HD 6990 sera surtout utile pour mettre en place un système extrême, sans devoir monopoliser tous les slots proposés par la carte-mère ou exiger un modèle XL-ATX, en lui adjoignant une seconde Radeon HD 6990 ou plus simplement une Radeon HD 6970. La puissance graphique permettra alors de profiter pleinement du surround gaming. Pour AMD, l’utilité principale reste bien entendu d’essayer de s’assurer de conserver la première place du podium en termes de performances. S’il semble évident que la future GeForce GTX 590 aurait repris facilement la tête face à la Radeon HD 5970, la Radeon HD 6990 semble très bien armée pour lui tenir tête, un duel qui ne saurait tarder… Terminons par un petit mot sur les pilotes. Quelques petits soucis de performances avec les derniers en date nous rappellent qu’ils jouent un rôle primordial dans le bon fonctionnement de tout système multi-GPU. Près de 6 ans après l’arrivée de ces systèmes, nous aimerions que ce rôle puisse enfin se faire oublier. AMD a fait un pas dans la bonne direction en permettant une mise à jour simple des profils applicatifs et un second pas intéressant sera de mettre en place une mise à jour automatique, ce qui ne devrait plus tarder. Il ne restera alors plus qu’à éviter de réintroduire des bugs là où tout fonctionnait correctement ! Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |