| |

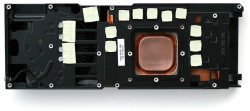

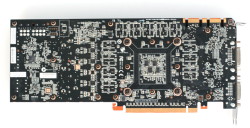

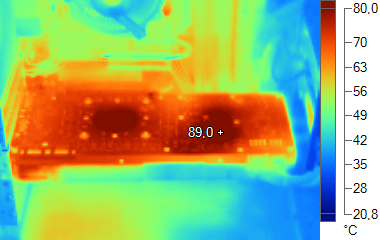

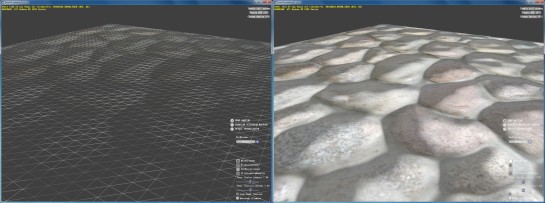

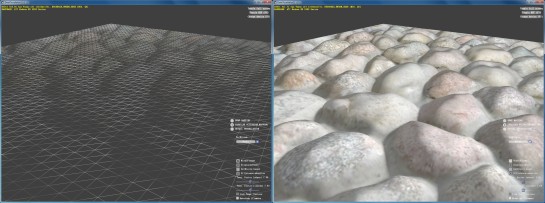

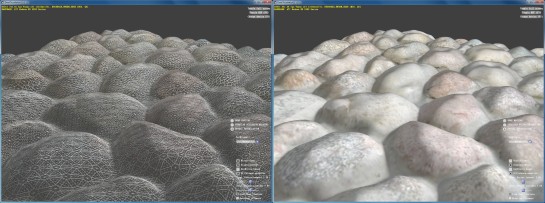

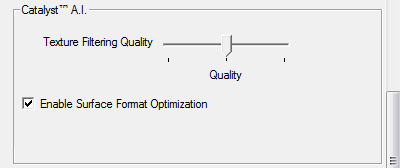

| Nvidia GeForce GTX 570 Cartes Graphiques Publié le Mardi 7 Décembre 2010 par Damien Triolet URL: /articles/811-1/nvidia-geforce-gtx-570.html Page 1 - Introduction Une semaine avant l’arrivée des Radeon HD 6970 et 6950, Nvidia prépare ses armes avec une première déclinaison de l’excellente GeForce GTX 580. Au menu proposé par la GeForce GTX 570, des performances du niveau de la GeForce GTX 480, une consommation mieux maîtrisée et des nuisances sonores réduites. Le GF110 castré  Pour cette GeForce GTX 570, Nvidia s’est bien entendu basé sur la dernière révision de son GPU haut de gamme nommée GF110 A1. Pour rappel il s’agit en réalité d’une « simple » révision du GF100 A3 exploité dans les GeForce GTX 470 et 480. Habituellement, cette révision aurait porté le nom de GF100 B1, mais pour des raisons commerciales Nvidia a préféré opter pour un nom de code qui inspire plus un sentiment de nouveauté plutôt que des corrections apportées au design de son GPU de 3 milliards de transistors. Ce GPU qui prend place sur la nouvelle venue est en partie castré, ainsi un de ses 16 blocs d’unités d’exécution est désactivé ainsi que l’un de ses 6 contrôleurs mémoire, de quoi former un mix, sur le plan de la configuration interne, entre la GeForce GTX 480 et la GeForce GTX 470, avec autant d’unité de calcul que la première mais un bus mémoire réduit comme sur la seconde. Des fréquences revues à la hausse ainsi que quelques petits correctifs apportés au GPU devraient permettre à la GeForce GTX 570 d’égaler la GeForce GTX 480… Page 2 - Spécifications, la GeForce GTX 570 Spécifications  Avec une fréquence GPU légèrement plus élevée, la GeForce GTX 570 affiche une puissance de calcul, de texturing ainsi qu’un fillrate en hausse de 5% par rapport à la GeForce GTX 480. La bande passante mémoire est par contre en recul de 14%. Par ailleurs, si les ROPs en moins ne limitent pas le fillrate, ils limiteront quelque peu les performances avec un niveau élevé d’antialiasing. La GeForce GTX 570 de référencePour ce test, Nvidia nous a fourni une GeForce GTX 570 de référence :      Pour cette GeForce GTX 570, Nvidia a repris le PCB de la GeForce GTX 580. Etant donné que le bus mémoire est réduit de 384 à 320 bits, 2 emplacements pour modules mémoire de 32 bits restent inoccupés. Il en va de même pour 2 des 6 phases de l’étage de l’alimentation qui n’ont pas été utilisées au vu de la consommation quelque peu revue à la baisse. La GeForce GTX 570 se contente enfin de 2 connecteurs d’alimentation 6 broches, ce qui implique une consommation qui ne devrait pas dépasser 225 watts, et ce qui colle au « TDP jeux » annoncé de 219 watts. La connectique est identique avec 2 sorties DVI Dual Link, une sortie mini-HDMI et 2 connecteurs SLI. Le ventirad est similaire à celui de la GeForce GTX 580, mais pas identique contrairement à ce que son aspect extérieur pourrait laisser penser. S’il repose toujours sur un radiateur dont la base est équipée d’une chambre à vapeur pour gagner en efficacité, son volume a été réduit, ce qui est logique puisqu’il recevra moins de watts à dissiper.  A gauche, le radiateur de la GeForce GTX 570, à droite, celui de la GeForce GTX 580. Pour tenter de contenir la consommation, Nvidia a intégré sur ce PCB des composants qui permettent aux pilotes (mais pas directement au GPU) de suivre la consommation du GPU ou plutôt l’intensité du courant qui passe par chacun des 3 canaux d’alimentation 12v (bus PCI Express et connecteurs). Nvidia n’a cependant pas activé de monitoring global et, pour éviter de réduire les performances dans les jeux ou dans 3DMark, se contente de mettre son système en action dans les versions courantes de Furmark et d’OCCT, soit dans les tests de charge extrême utilisés par les testeurs pour mesurer la consommation. Dans ces applications, si le pilote observe une consommation qui va au-delà d’une certaine limite, il baisse les fréquences de moitié, et encore une fois de moitié si ce n’était pas suffisant. En pratique, le système de Nvidia revient plus à empêcher d’utiliser de tels logiciels qu’à maintenir la consommation dans une enveloppe thermique bien définie. Nvidia nous a indiqué qu’il était voué à évoluer pour inclure plus d’applications à risque. Il n’est par contre improbable qu’il évolue vers une surveillance permanente de la consommation. Page 3 - Consommation, bruit ConsommationNous avons bien entendu utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos, sous 3D Mark 06 et sous Furmark. Notez que nous utilisons une version de Furmark non-détectée par le mécanisme de limitation de la consommation dans les stress tests mis en place par Nvidia dans les pilotes pour les GeForce GTX 500.  Si la GeForce GTX 580 est plus économe au repos que la GeForce GTX 480, elle est en charge aussi gourmande que cette dernière avec une consommation de 300W. La GeForce GTX 570 voit sa consommation au repos baisser encore un petit peu pour arriver au niveau d’une Radeon HD 5870 2 Go. En charge, sous 3DMark06, ce qui se rapproche le plus du maximum que vous rencontrerez en jeu, la GeForce GTX 570 affiche une consommation identique à celle de la GeForce GTX 470. Sous Furmark par contre la consommation grimpe à 250W. Comme les GeForce GTX 580 et 480, elle peut donc dépasser les normes définies par le PCI Express en matière d’alimentation lors d’une charge extrême. Etant donné que cela ne se passe qu’au niveau des câbles d’alimentation PCI Express, ce n’est pas réellement un problème. Pour rappel, avec les GeForce GTX 580 et 480, cela peut en être un au niveau de l’alimentation 12v tirée du bus puisque la limite de 5.5A fixée par la norme est franchie. Cela ne pose en pratique aucun problème sur une carte-mère milieu ou haut de gamme, par contre certains modèles d’entrée de gamme sont plus sensibles à ce niveau et peuvent même succomber à cette charge s’ils intègrent un fusible fixe. Il serait tant que Nvidia, et AMD également sur certains modèles, soient plus rigoureux à ce niveau ! Nuisances sonoresNous plaçons les cartes dans un boîtier Antec Sonata 3 et mesurons le bruit d'une part au repos et d'autre part en charge. Le sonomètre est placé à 60cm du boîtier.  Nvidia a visiblement très bien travaillé l’aspect sonore des ventirads des GeForce GTX 500 qui se montrent relativement discrètes au vu de la puissance à dissiper. Nous sommes très loin du désastre des GeForce GTX 480 et 470 de référence à ce niveau. Page 4 - Températures TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  Les GeForce GTX 500, en plus d’être plus discrètes, refroidissent mieux leur GPU que les GeForce GTX 480 et 470, ce qui démontre bien, si c’était encore nécessaire, que les ventirads de ces dernières étaient réellement mal conçus. Voici ce que cela donne en image grâce à la thermographie infrarouge :  GeForce GTX 570 au repos  GeForce GTX 570 en charge Vous pourrez retrouver plus de détails dans notre dossier consacré au dégagement thermique des cartes graphiques de référence. Page 5 - Tests théoriques : pixels Performances texturingNous avons mesuré les performances lors de l’accès à des textures de différents formats en filtrage bilinéaire. Nous avons conservé les résultats en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16) et en 128 bits (4x FP32). Nous avons ajouté les performances en 32 bits RGB9E5, un nouveau format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis.  Comme annoncé par Nvidia, les GeForce GTX 500 sont capables de filtrer les textures FP16/11/10 et RGB9E à pleine vitesse et sont à ce niveau respectivement 2.35x et 2.58x plus performantes que les GeForce GTX 480 et 470. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données :   En terme de fillrate, les Radeon ont un gros avantage sur les GeForce GTX 400/500, surtout en FP10, format traité à pleine vitesse alors que sur les GeForce il passe à demi vitesse. Compte tenu de la limitation de ces GeForce au niveau des datapaths entre les SMs et les ROPs, il est dommage que Nvidia n’ait pas donné à ses GPUs la possibilité de profiter des formats FP10 et FP11. Les GeForce conservent cependant certains avantages. Tout d’abord elles peuvent traiter le FP32 simple canal à pleine vitesse sans blending. Ensuite avec blending elles conservent une efficacité maximale en INT8 là où les Radeon subissent une perte. Page 6 - Tests théoriques : triangles Débit de trianglesEtant donné les différences architecturales des différents GPUs au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d’abord nous avons observé les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu’ils tournent le dos à la caméra) :  La GeForce GTX 580 est ici très performante et devance la GeForce GTX 480 de 30% lorsque les triangles sont rendus alors que théoriquement le gain aurait dû se situer entre 10 et 18%. Etant donné que les GeForces sont limitées artificiellement à ce niveau par rapport aux Quadros nous supposons donc que Nvidia a ici laissé un peu plus d’espace au GF110 par rapport au GF100, introduisant du coup une différence artificielle entre ces 2 révisions du GPU. Il se peut également que les GPUs incomplets perdent quelque peu en efficacité. Dès qu’il s’agit d’éjecter des triangles du rendu via le culling, aucune Radeon n’arrive à la cheville des GeForces haut de gamme. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation :  L’avantage des GeForces sur les Radeons est ici évident. AMD et Nvidia ont des approches très différentes et les GeForces affichent un débit qui varie suivant le nombre d’unités de traitement de la carte alors qu’il ne varie qui suivant la fréquence pour les Radeons. L’architecture de ces dernières fait qu’elles sont rapidement engorgées par la quantité de données générées, ce qui réduit drastiquement leur débit dans ce cas. Le doublement de la taille du buffer dédié à l’unité de tessellation dans le GPU des Radeon HD 6800 leur permet d’être significativement plus performantes que les Radeon HD 5800, sans toutefois pouvoir rivaliser avec les GeForces. Etrangement, la GeForce GTX 580 n’affiche qu’un gain très faible sur la GeForce GTX 480 et est même moins performante dans ce test lorsque les triangles sont éjectés du rendu via culling. Cela peut être lié à une configuration logicielle différente qui favorise certains cas (les plus importants probablement) mais peu entraîner une baisse dans d’autres (nous avions déjà pu observer cela avec certains profils des Quadros). Dans tous les cas, ce phénomène ne se retrouve pas sur la GeForce GTX 570 qui se comporte dans ce cas comme une GeForce GTX 480 aux fréquences boostées. Notez que nous avons bien entendu retesté la GeForce GTX 580 avec le même pilote que la GeForce GTX 570. Displacement mappingNous avons testé la tessellation avec une démo d’AMD intégrée par Microsoft à son SDK de DirectX. Cette démo permet de comparer le bump mapping, le parallax occlusion mapping (la technique de bump mapping la plus avancée utilisée dans les jeux) et le displacement mapping qui exploite la tessellation.  Le bump mapping basique.  Le parallax occlusion mapping.  Le displacement mapping avec tessellation adaptative. En créant de la vraie géométrie supplémentaire, le displacement mapping affiche une qualité nettement supérieure. Nous avons activé ici l’algorithme adaptatif par rapport à la distance qui permet d’éviter de générer de la géométrie inutile et trop de petits triangles qui ne vont pas remplir un quad, la zone de rendu minimale sur tous les GPUs et donc gâcher beaucoup de puissance de calcul. Nous avons mesuré les performances obtenues avec les différentes techniques :  Il est intéressant de remarquer que la tessellation ne se contente pas d’améliorer la qualité du rendu, mais également les performances ! Le parallax occlusion mapping est en fait très gourmand puisqu’il repose sur un algorithme complexe qui essaye de simuler la géométrie d’une manière réaliste. Malheureusement il génère beaucoup d’aliasing et le trucage est vite démasqué aux bords des objets ou des surfaces qui l’utilisent. Notez cependant que dans le cas présent l’algorithme de displacement mapping est bien aidé par le fait qu’il s’agit d’une surface plane à la base. S’il faut lisser les contours de la géométrie et en même temps appliquer le displacement mapping, le coût sera bien entendu plus élevé. Les GeForce encaissent ici beaucoup mieux la charge liée à la tessellation que les Radeon, bien que la série 6800 affiche un gain conséquent. L’utilisation d’un algorithme adaptatif qui va réguler le niveau de tessellation suivant les zones qui vont recevoir plus ou moins de détails, suivant la distance ou encore suivant la résolution de l’écran permet dans tous les cas des gains significatifs et sont plus représentatifs de ce que vont faire les développeurs. L’écart entre les GeForce et les Radeon se réduit alors, et ces dernières passent même devant dans certains cas. Page 7 - AMD sacrifie la qualité ? AMD sacrifie la qualité ?Avec l’arrivée des Radeon HD 6800 et des Catalyst 10.10 betas, AMD a décidé de revoir en partie le fonctionnement de Catalyst A.I., cette option du pilote qui s’occupe d’activer certaines optimisations génériques ainsi que les optimisations spécifiques à chaque jeu.  Auparavant il n’était possible d’activer que certaines optimisations plus agressives au niveau du filtrage ou de désactiver complètement Catalyst A.I. et l’ensemble des optimisations apportées par AMD. Dorénavant, il est possible de paramétrer les optimisations du filtrage des textures indépendamment. Par défaut, un mode « qualité » est activé, qui intègre cependant des optimisations quelque peu plus agressives qu’auparavant, ce qui introduit plus de fourmillement dans certaines textures et baisse donc la qualité. Contrairement à quelques confrères allemands, nous étions passés à côté de ce problème dans le test de la GeForce GTX 580. Si nous l’avions observé sur la Radeon HD 6800, pressés par le temps, nous n’avions pas remarqué que nos tests de qualité étaient faussés par un bug de l’interface du Catalyst Control Center qui, jusqu’à la version 10.10d, prenait en compte le niveau de qualité défini sur une Radeon HD 6800, mais sans en afficher le contrôle sur les Radeon HD 5800. Autrement dit, après avoir testé une Radeon HD 6800 en mode « haute qualité », qui désactive ces optimisations agressives, le paramètre restait actif alors que nous pensions tester la Radeon HD 5870 en mode par défaut. Les Catalyst 10.10e ont corrigé ce problème et affichent le paramètre de qualité du filtrage également avec les Radeon HD 5800. Après des tests plus approfondis, nous avons pu confirmer qu’AMD avait bel et bien réduit la qualité d’une manière générale, tout du moins sur toutes ses cartes haut de gamme des séries 5000 et 6000, ce que nous ne pouvons que regretter. Afin d’observer le gain apporté par ces optimisations que nous jugeons trop agressives, et qui réduisent la qualité là où Nvidia avait déjà un léger avantage, nous avons mesuré les performances sur l’ensemble de notre protocole de test avec les Catalyst 10.10e et les 2 modes de qualité du filtrage des textures, tant sur une Radeon HD 5870 2 Go que sur une Radeon HD 6870 :   Suivant les jeux, le gain de performances varie entre 0 et 8% avec un gain moyen de 1 à 2%. Notez que ce gain moyen correspond à l’influence de l’optimisation sur notre indice de performances. Elle est donc relativement modérée et ne change donc pas nos conclusions quant à ces produits puisque ce n’est pas pour 2% de performances en plus que nous vous conseillons un modèle plus qu’un autre. Vous remarquerez que la Radeon HD 6870 subit un impact légèrement plus important que la Radeon HD 5870, ce qui peut s’expliquer par ses unités de filtrage qui corrigent un autre problème, ce qui doit bien entendu avoir un petit coût en termes de performances. Notez que lors de nos tests nous nous contentons du niveau de filtrage maximal proposé directement par les jeux et ne forçons donc pas le filtrage anisotrope 16x dans le panneau de contrôle des pilotes. Si cela avait été le cas, l’influence de ces optimisations sur les résultats aurait en toute logique été plus importante. En 2010, rien ne justifie de sacrifier ainsi la qualité graphique proposée par défaut et nous espérons qu’AMD rectifiera le tir avec l’arrivée des Radeon HD 6900. Dans tous les cas vous aurez compris que c’est le mode « haute qualité » que nous utiliserons pour ce test. Page 8 - Le test Le testPour ce test, nous avons repris le même protocole que celui utilisé dans le test de la GeForce GTX 580 si ce n’est que nous n’avons pas conservé H.A.W.X. 2. Après avoir pu observer le jeu en lui-même, décevant tant sur le gameplay que sur l’aspect graphique, il nous a semblé inutile de le conserver. En dehors des terrains détailés, le rendu est plus que pauvre, globalement moins réussi que dans le premier volet. Il n’y a donc pas de raison de nous encombrer de ce logiciel aux choix techniques partisans qui en fin de compte ne nous en apprend pas plus que les tests théoriques dédiés à la tessellation. Les tests ont été exécutés en 1920x1200, sans FSAA, avec MSAA 4x et avec MSAA 8x. Notez à ce sujet que nous nous sommes bien assurés de tester ce mode sur les GeForce, ce qui n’est pas toujours évident. Dans les pilotes Nvidia, l’antialiasing 8x est un fait du MSAA 4x avec un CSAA 8x qui n’offre pas la même qualité qu’un MSAA 8x, qui est, lui, appelé antialiasing 8xQ. C’est donc bien celui-ci qui a été testé. Un an après sa sortie, nous avons décidé de ne plus placer DirectX 11 à part, d’autant plus que toutes les cartes testées ici sont compatible avec cette API. Jeux DirectX 11, 10 et 9 sont donc mélangés et nous avons opté pour un niveau de détails très élevé même dans les jeux les plus gourmands. Les dernières mises à jour ont été installées et toutes les cartes ont été testées avec les derniers pilotes disponibles. Nous avons décidé de ne plus afficher les décimales dans les résultats de performances dans les jeux pour rendre le graphique plus lisible. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l’indice. Si vous êtes observateurs vous remarquerez que c’est également le cas pour la taille des barres dans les graphes. Les Radeon ont été testée avec le filtrage des textures réglé sur « haute qualité » par rapport à nos deux précédents tests qui utilisaient le mode « qualité ». Cependant, il est utile de préciser que les Catalyst 10.10e apportent de petits gains de performances dans de nombreux jeux ce qui compense en grande partie la petite différence de performances liée à la désactivation de ces optimisations trop agressives. Configuration de testIntel Core i7 975 (HT et Turbo désactivés) Asus Rampage III Extreme 6 Go DDR3 1333 Corsair Windows 7 64 bits Forceware 263.09 beta Catalyst 10.10e Page 9 - Need for Speed Shift Need for Speed Shift  Pour tester Need for Speed Shift, nous poussons toutes les options à leur maximum et effectuons un déplacement bien défini. Le patch 1.1 est installé. Notez qu’AMD a mis en place une optimisation qui remplace certaines surfaces de rendu HDR 64 bits par d’autres en 32 bits. Nvidia crie bien sûr à la triche, mais cela ne nuit pas à la qualité. En réalité, AMD profite ici d’une particularité de son architecture qui est capable de traiter ces formats de HDR 32 bits à pleine vitesse. Les GeForce peuvent cependant également en profiter et Nvidia a fourni à la presse un petit outil qui permet de la mettre en place pour obtenir des mesures de performance comparables.  Dans ce premier test, la GeForce GTX 570 devance légèrement la GeForce GTX 480 et donc toutes les Radeon mono-GPU disponibles. Page 10 - ArmA 2 ArmA 2  Pour tester ArmA 2, nous effectuons un déplacement bien défini après avoir chargé une sauvegarde. Nous utilisons le niveau de détails « élevé » du jeu (visibilité à 2400m) en plus duquel nous poussons toutes les options avancées au niveau très élevé. ArmA 2 est particulier au niveau de la résolution puisqu’il permet de paramétrer différemment la résolution de l’interface de celle du rendu 3D qui est ramenée à hauteur de la première via un filtre. De notre côté nous utilisons une résolution de rendu identique à celle de l’affichage. Les paramètres proposé pour l’antialiasing dans le jeu sont peu clairs et différents entre les cartes AMD et Nvidia. Du côté d’AMD, 3 modes sont proposés : faible, moyen et élevé. Ils correspondent au MSAA 2x, 4x et 8x. Du côté Nvidia, ça se complique : - faible et moyen = MSAA 2x - élevé et très élevé = MSAA 4x - 5 = MSAA 4x + CSAA 8x (appelé 8x dans les pilotes Nvidia) - 6 = MSAA 8x (appelé 8xQ dans les pilotes Nvidia) - 7 = MSAA 4x + CSAA 16x (appelé 16x dans les pilotes Nvidia) - 8 = MSAA 8x + CSAA 16x (appelé 16xQ dans les pilotes Nvidia) Le patch 1.5 a été installé.  Ici aussi la GeForce GTX 570 devance légèrement la GeForce GTX 480 et revient sur les Radeon HD 5870 avec AA4x. Page 11 - Starcraft 2 Starcraft 2  Pour tester Starcraft 2, nous lançons un replay et mesurons les performances en suivant la vue d’un des joueurs. Toutes les options graphiques sont poussées au maximum. Le jeu n’intègre pas de support de l’antialiasing qui est donc activé par les panneaux de contrôle des pilotes AMD et Nvidia. Le patch 1.0.3 est installé.  Dans Starcraft 2, la GeForce GTX 570 est quelque peu pénalisée par sa bande passante plus faible que celle de la GeForce GTX 480. Notez la meilleure efficacité des Radeon avec AA8x. Page 12 - Mafia II Mafia II  Le moteur de Mafia II confie la gestion de la physique aux bibliothèques PhysX de Nvidia et en profite pour proposer un niveau de détails physiques élevé qui peut être partiellement accéléré par les GeForce. Pour mesures les performances, nous utilisons les benchmark intégré et toutes les options graphiques sont poussées à leur maximum tout d’abord sans activer les effets PhysX accélérés par le GPU :  La GeForce GTX 570 égale la GeForce GTX 480. Ensuite, nous passons les détails PhysX à leur niveau élevé :  Avec les effets PhysX poussés au maximum, les performances plongent. Notez qu’elles sont en partie limitées par le CPU, tous les effets PhysX supplémentaires n’étant pas accélérés. Les Radeon restent bien entendu derrière. Page 13 - Crysis Warhead Crysis Warhead  Crysis Warhead a remplacé Crysis dont il reprend le moteur graphique très gourmand à tous les niveaux. Nous le testons dans sa version 1.1 hotfix et en mode 64 bits puisque c’est la principale nouveauté apportée. Crytek a renommé les différents modes de qualité graphique, probablement pour ne pas heurter les joueurs déçus de ne pas pouvoir activer le mode très haute qualité pour cause de gourmandise excessive. Le mode haute qualité est ainsi renommé « Gamer », et le mode très haute qualité « Enthousiast », c’est celui que nous avons testé.  Dans Crysis Warhead, la GeForce GTX 570 fait légèrement mieux que la GeForce GTX 480. Page 14 - Far Cry 2 Far Cry 2  La suite de Far Cry n’en est pas réellement une puisque Crytek était à l’origine du premier épisode. La licence appartenant à Ubisoft c’est ce dernier qui s’est chargé de son développement, Crytek optant alors pour Crysis. Pas facile de reprendre l’héritage de révolution graphique qui accompagne Far Cry, mais les équipes d’Ubisoft s’en sont bien tirées même si l’aspect graphique n’est pas aussi abouti que celui de Crysis. Le jeu est aussi moins gourmand ce qui n’est pas plus mal. Il supporte DirectX 10.1 pour améliorer les performances des cartes compatibles. Nous avons installé le patch 1.02 et utilisé le mode de qualité graphique « ultra élevé ».  Les GeForce apprécient particulièrement Far Cry 2. La GeForce GTX 570 égale la GeForce GTX 480 en AA4x, est légèrement devant sans AA et légèrement derrière avec AA8x, mode dans lequel les ROPs et la bande passante supplémentaires de la seconde sont les plus utiles. Page 15 - H.A.W.X. H.A.W.X.  H.A.W.X. est un jeu d’action qui se passe dans les airs. Il utilise un moteur qui prend en charge DirectX 10.1 pour optimiser le rendu. Parmi les effets graphiques supportés, notons la présence de l’occlusion ambiante qui est poussée à son maximum tout comme les autres options. Nous utilisons le benchmark intégré et le patch 1.2 est installé.  La GeForce GTX 570 prend ici une avance significative sur la GeForce GTX 480. Page 16 - BattleForge BattleForge  Premier jeu à supporter DirectX 11, ou plus précisément Direct3D 11, il nous était difficile de ne pas l’intégrer à ce test. Une mise à jour déployée en septembre 2009 a en effet ajouté le support de la nouvelle API de Microsoft à BattleForge. Ce sont les Compute Shaders 5.0 qui sont ici exploités par les développeurs pour accélérer le traitement du SSAO, soit de l’occlusion ambiante. Par rapport à l’implémentation classique, via les Pixel Shaders, la technique permet d’exploiter plus efficacement la puissance de calcul disponible en saturant moins les unités de texturing. BattleForge propose deux niveaux de SSAO : High et Very High. Seul le second, appelé HDAO (High Definition AO), exploite les Compute Shader 5.0. Nous avons utilisé le benchmark intégré au jeu et installé la dernière mise à jour disponible à ce jour (1.2 build 298942).  Sans antialiasing et en mode 4x, la GeForce GTX 570 fait légèrement mieux que la GeForce GTX 480, mais se positionne par contre légèrement derrière en mode 8x. Page 17 - Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d’une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d’autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le patch 1.2 est installé.  La GeForce GTX 570 est ici 10 à 12% derrière la GeForce GTX 480. Page 18 - S.T.A.L.K.E.R. Call of Pripyat S.T.A.L.K.E.R. Call of Pripyat  Cette nouvelle suite de S.T.A.L.K.E.R. repose sur une évolution du moteur, en version 1.6.02, et supporte Direct3D 11 qui est exploité d’une part pour améliorer les performances et d’autres part la qualité avec en option des ombres et des éclairages plus détaillés ainsi qu’un support de la tessellation. Le mode de qualité utilisé est « maximum » et nous avons activé la tessellation. Le jeu ne supporte pas l’antialiasing 8x. Notre scène de test représente 50% en extérieur et 50% en intérieur et dans ce dernier cas nous sommes face à plusieurs personnages.  Sans antialiasing, la GeForce GTX 570 fait légèrement mieux que la GeForce GTX 480. Page 19 - F1 2010 F1 2010  Dernier né chez Codemaster, F1 2010 reprend le même moteur que DiRT 2 et supporte ainsi DirectX 11, via le patch 1.1 que nous avons bien entendu installé. Ce patch ayant été développé en collaboration avec AMD, Nvidia nous a indiqué ne l’avoir reçu que tardivement et ne pas encore avoir eu l’opportunité d’optimiser ses pilotes pour ce jeu en version DirectX 11. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons l’outil de test intégré sur le circuit de Spa-Francorchamps avec une seule F1.  Dans F1 2010, les Radeon sont particulièrement à l’aise et la GeForce GTX 570 devance légèrement la GeForce GTX 480, excepté avec AA8x. Page 20 - Metro 2033 Metro 2033  Probablement le jeu le plus lourd du moment, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n’avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l’avons testé en mode DirectX 11, avec une qualité très élevée et la tessellation activée avec et sans MSAA 4x. Nous avons ensuite mesuré les performances avec MSAA 4x et le Depth of Field.  Ici, nous pouvons observer un match nul entre les GeForce GTX 570 et GTX 480. Page 21 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, d’autant plus avec les solutions haut de gamme dont les scores sont susceptibles d’être lissés par la limitation CPU de certains jeux, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Mafia II est ici intégré avec les scores obtenus sans les effets GPU PhysX. Nous avons attribué un indice de 100 à la GeForce GTX 480 en 1920x1200 avec AA4x :  L’indice représente bien l’impression générale qui ressort des résultats obtenus dans la majorité des jeux : la GeForce GTX 570 devance très légèrement la GeForce GTX 480 sans antialiasing et avec antialiasing 4x et l’égale avec antialiasing 8x. Vous noterez également un écart plus faible entre les GeForce GTX 570 et GTX 580 qu’entre les GeForce GTX 470 et GTX 480 puisqu’il est de 10 à 17% contre 19 à 26% ! Du coup la GeForce GTX 570 affiche un gain moyen relativement important de 20 à 26% sur la GeForce GTX 470. Page 22 - Conclusion ConclusionAvec une nouvelle révision de son GPU phare dont la fabrication pose moins de soucis, Nvidia dispose de plus de marge de manœuvre et cela se ressent directement avec cette déclinaison de la GeForce GTX 580. Ainsi, Nvidia n’a pas eu à réduire autant les fréquences de la GeForce GTX 570 que ce ne fût le cas avec la GeForce GTX 470, de quoi rendre cette version castrée plus attrayante. Malgré un bus mémoire plus étroit, Nvidia parvient d’ailleurs à égaler le niveau de performances moyen de la GeForce GTX 480, qui se voit donc avantageusement remplacée par une carte nettement moins bruyante en charge et moins gourmande, bien que nous restions ici dans la fourchette haute.  Par rapport à la concurrence, comme toutes les GeForce haut de gamme récentes, la GeForce GTX 570 profite du support de PhysX, de l’écosystème 3D Vision et d’excellentes performances lorsqu’il s’agit d’engouffrer un niveau de tessellation élevé. Elle devance par ailleurs toutes les Radeon mono-GPU… tout du moins les modèles disponibles à ce jour. A l’heure où nous publions ce dossier, les Radeon HD 6900 sont enfin entre nos mains et avec un lancement prévu la semaine prochaine il paraît cette fois sage de patienter quelques jours de plus pour disposer de toutes les informations avant d’acheter. Qui plus est, si le prix de lancement de 350€ de la GeForce GTX 570 est plutôt bien justifié compte tenu du niveau de performances, il pourrait bien entendu y avoir un ajustement. Terminons par un carton rouge pour AMD qui a eu la très mauvaise idée, avec l’arrivée de ses Radeon HD 6800, de réduire par défaut, et pour l’ensemble de ses modèles haut de gamme, la qualité graphique à travers des optimisations trop agressives du filtrage des textures. En 2010, ce n’est plus acceptable ! Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |