| |

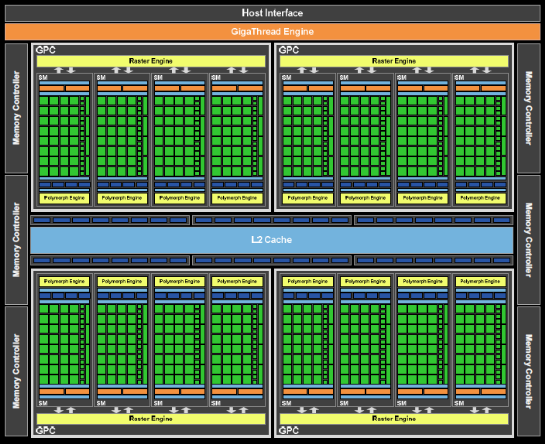

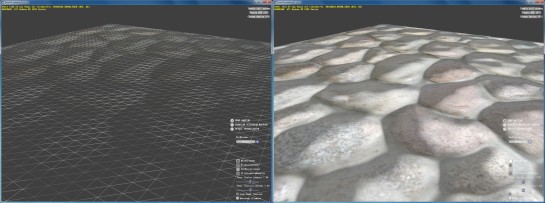

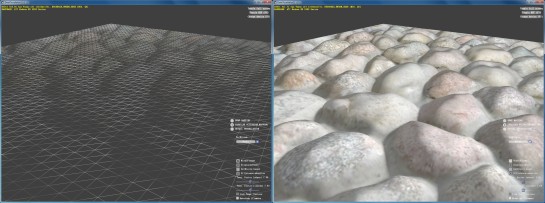

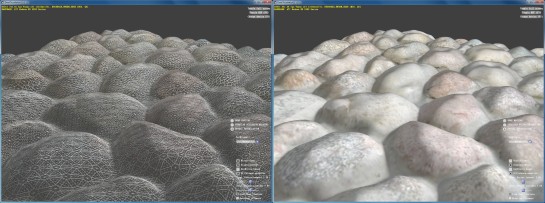

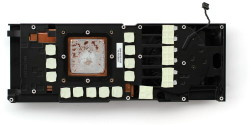

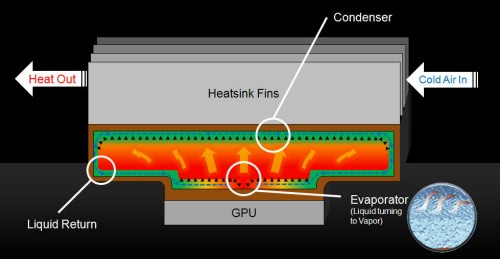

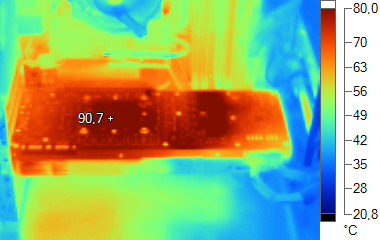

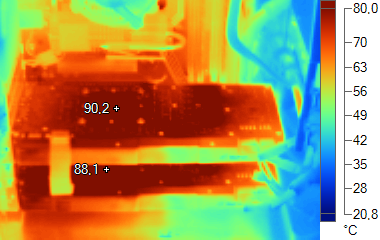

| Nvidia GeForce GTX 580 & SLI Cartes Graphiques Publié le Jeudi 25 Novembre 2010 par Damien Triolet URL: /articles/806-1/nvidia-geforce-gtx-580-sli.html Page 1 - Introduction Alors que nous attendions la GeForce GTX 580 en réaction à la future Radeon HD 6970, c’est finalement Nvidia qui dégaine le premier avec une mise à jour de son offre haut de gamme. Au menu : des performances en hausse et des nuisances sonores et thermiques en baisse ! Nous l’avons testée seule et en SLI.  Une nouvelle révision du GF100Pour rafraichir son haut de gamme, Nvidia n’a pas réellement développé de nouveau GPU, mais a plutôt peaufiné le GF100, le GPU des GeForce GTX 480/470/465. Si Nvidia a décidé de nommer GF110 cette nouvelle révision du GF100 pour des raisons d’image, elle correspond en réalité à ce qui a été évoqué très souvent en tant que GF100 B1 soit une version optimisée et en partie corrigée du GF100 A3 utilisé sur les précédentes GeForce. Lors de la mise au point du GF100, Nvidia a rencontré de nombreux problèmes dont les plus important ont bien évidemment été corrigés à travers plusieurs révisions de la puce. Jen-Hsun Huang, le CEO de Nvidia, nous a d’ailleurs précisé il y a quelques semaines qu’une mauvaise concertation entre différentes équipes travaillant sur la puce était la source de certains de ces problèmes, notamment au niveau de la communication entre les unités d’exécutions et les contrôleurs mémoire. Il n’est bien entendu jamais possible de peaufiner indéfiniment un design, vient un jour où il faut bien lancer un produit quitte à devoir faire quelques compromis par rapport au plan original. C’est ce qu’à dû faire Nvidia avec le GF100 A3 et la GeForce GTX 480. Avec un rendement plus faible que prévu au niveau de la fabrication, Nvidia a dû castrer son ultra haut de gamme en désactivant un de ses 16 blocs d’unités d’exécutions, une première. L’enchaînement de plusieurs révisions (A1, A2, A3) ainsi qu’une consommation plus élevée que prévu ont rendu difficile la mise au point d’un système de refroidissement efficace. C’est probablement la plus grosse erreur commise par Nvidia avec la GeForce GTX 480 qui a souffert d’une mauvaise image liée à ses nuisances sonores et thermiques.  Avec le GF100 B1, ou le GF110 A1, peu importe son nom, Nvidia dispose d’un GPU plus facile à dompter mais également du recul nécessaire pour revoir sa copie et nous proposer une carte graphique haut de gamme plus efficace. Nvidia en profite pour inaugurer une nouvelle famille, la série 500, pour plusieurs raisons. D’une part Nvidia compte bien essayer de se débarrasser de l’image en partie négative de la GTX 480 et d’autre part, pour des raisons commerciales, la règle d’une nouvelle famille par an semble inévitable, d’autant plus que la série 400, bien remplie, laisse peu de place pour introduire de nouveaux modèles dans le milieu de gamme. Page 2 - Le GF110, spécifications Le GF110Etant donné que le GF110 est une nouvelle révision du GF100 il en reprend logiquement l’organisation interne. Ce GPU est donc composé de 4 structures principales, les GPCs qui englobent chacun 4 SMs, les blocs d’unités d’exécution. Chacun de ces SMs dispose de 32 unités de calcul (les « cores » en termes plus commerciaux) et de 4 unités de texturing. Tout ce petit monde est rattaché à 6 contrôleurs mémoire de 64 bits qui incluent chacun 8 ROPs, chargés d’écrire les pixels en mémoire, et 128 Ko de cache L2. Nous obtenons donc au total 512 unités de calcul, 64 unités de texturing, un bus mémoire de 384 bits, 48 ROPs et 768 Ko de cache L2. Le tout pour un die énorme de 3 milliards de transistors. Si le support du calcul en double précision est toujours présent dans ce GF110, il n’est pas actif sur les dérivés GeForce, étant réservé au monde professionnel. Pour plus de détails sur l’architecture du GF110, nos analyses liées à celle du GF100 restent donc d’actualité.  L’organisation interne du GF110 est identique à celle du GF100. Qu’est-ce qui a donc changé entre le GF110 et le GF100 ? Peu de choses au final, les principales résultant d’un fignolage du design qui permet de produire plus facilement le GPU, de monter légèrement plus haut en fréquence et de consommer moins, à spécifications équivalentes, grâce à une réduction des courants de fuite. Pour cela, Nvidia précise avoir réévalué chaque bloc du GPU pour remplacer, partout où cela était possible, les transistors haute performance par des transistors plus économes. Quelques petits correctifs ont également été apportés. Ainsi, les unités de texturing sont maintenant capables de filtrer les textures FP16 (et donc FP10/11 et RGB9E5) à pleine vitesse alors que sur le GF100 A3 elles devaient se contenter d’un débit réduit de moitié. Etant donné que cette révision du GPU disposait déjà de datapaths adaptés à ces textures, soit ce qui est le plus coûteux à mettre en place, nous supposons que ce filtrage à pleine vitesse était bel et bien prévu mais n’a pas fonctionné pour une raison qui nous est inconnue. Plus qu’un ajout au GPU, il s’agit donc plutôt d’un correctif. Nvidia indique également avoir ajouté le support de formats de tiles supplémentaires pour maximiser l’efficacité du culling, l’élimination des surfaces cachées, dans un maximum de situations. Le moteur vidéo et le contrôleur audio n’ont par contre pas évolué. Contrairement aux petites GeForce 400, et comme la GeForce GTX 480, la GeForce GTX 580 et d'éventuels autres modèles basés sur le GF110 ne supporteront donc pas le bitstreaming des formats audio HD. Spécifications  La GeForce GTX 580 profite de l’utilisation d’un GPU complet, sans unités désactivées, et de fréquences revues à la hausse pour afficher une puissance de calcul et de texturing ainsi que des débits de triangles et de pixels en hausse de 18% par rapport à la GeForce GTX 480. La bande passante mémoire évolue par contre plus modestement avec un gain de 8%. Page 3 - En avant la tessellation En avant la tessellationAvec son architecture Fermi, Nvidia a placé de nombreuses caractéristiques au niveau du SM. Ainsi, le débit de triangles, les performances en tessellation et le débit de pixels sont intimement liés au nombre de SMs. Chacun peut traiter un triangle tous les 4 cycles et débiter 2 pixels par cycle. Avec le GF100/110, Nvidia a opté pour un nombre très élevé de SMs de taille moyenne, 32 unités de calcul, contre nettement moins de SMs, mais équipés cette fois de 48 unités de calcul pour ses dérivés de milieu et d’entrée de gamme. Ce nombre important de SMs permet au GF100/110 d’être très performant dans un maximum de situations mais a bien entendu un coup plus élevé par unité de puissance de calcul brute. Il permet également de donner un net avantage sur le plan des performances géométriques par rapport au milieu de gamme qui traditionnellement était aussi véloce que le haut de gamme. Couplé à la présence de 4 petits rasterizers, un par GPC, il est capable de maintenir un bon débit lors de la découpe en pixels de petites primitives, là où les gros rasterizers sont forcément moins efficaces. Tous les ingrédients sont donc là pour pouvoir traiter la tessellation avec un excellent niveau de performances et Nvidia compte bien entendu en profiter pour se démarquer de la concurrence, ce qui induit un lobbying intense auprès des développeurs en faveur de l’utilisation de cette technologie, ce qui peut conduire à certains résultats discutables, comme c’est le cas dans H.A.W.X. 2, qui semble avoir négligé de nombreux aspects graphiques au profit d’une tessellation extrême des terrains dont nous ne demandons si elle est réellement justifiée d’un point de vue qualitatif. Quoi qu’il en soit, le côté « tout-terrain » du GF100/110 lui permet d’avaler ces montagnes de triangles sans soucis. Pour accompagner le lancement de la GeForce GTX 580, Nvidia distribue 2 nouvelles démos technologiques présentant chacune une utilisation originale de la tessellation. La première, Endless City, représente une ville infinie créée au fur et à mesure que l’on s’y engouffre via un algorithme procédural. La tessellation extrême mais adaptative permet d’ajouter un niveau de détail impressionnant à l’ensemble, impossible à représenter en temps-réel avec des modèles géométriques fixes.   La seconde, Alien vs Triangles, met en avant le côté dynamique de la tessellation et du displacement mapping. Un alien est rendu avec de la tessellation et ses détails géométriques sont définis par un ensemble de 7 displacement maps différentes. Celles-ci permettent de modifier à loisir son aspect, avec des transitions naturelles grâce au morphing entre les différentes displacement maps. Par exemple il est possible de lui faire pousser une armure ou de le blesser, auquel cas dans la zone des blessures les displacements maps qui représentent sa chair et son squelette prennent le dessus sur celles qui définissent la peau ou l’armure.   Si ces démonstrations sont impressionnantes sur le plan technique, à l’instar de H.A.W.X. 2, elles ne s’attardent d’une manière logique que sur un aspect graphique bien particulier, négligeant le reste, contrairement à ce que font en principe les moteurs de jeux vidéo. La question est donc de savoir quand ces techniques vont se démocratiser et le niveau de détails qu’elles pourront apporter une fois implémentées dans un jeu. Nvidia croit bien entendu dur comme fer en une utilisation massive de la tessellation dans les jeux à venir, ce qui reste à démontrer dans le cadre de cette génération de cartes graphiques. Page 4 - Tests théoriques: pixels Performances texturingNous avons mesuré les performances lors de l’accès à des textures de différents formats en filtrage bilinéaire. Nous avons conservé les résultats en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16) et en 128 bits (4x FP32). Nous avons ajouté pour information les performances en 32 bits RGB9E5, un nouveau format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis.  Comme annoncé par Nvidia, la GeForce GTX 580 est capable de filtrer les textures FP16/11/10 et RGB9E5 à pleine vitesse et est à ce niveau 2.35x plus performante que la GeForce GTX 480. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données :   En terme de fillrate, les Radeon ont un gros avantage sur les GeForce GTX 500/400, surtout en FP10, format traité à pleine vitesse alors que sur les GeForce il passe à demi vitesse. Compte tenu de la limitation de ces GeForce au niveau des datapaths entre les SMs et les ROPs, il est dommage que Nvidia n’ait pas donné à son GPU la possibilité de profiter des formats FP10 et FP11. Les GeForce conservent cependant certains avantages. Tout d’abord elles peuvent traiter le FP32 simple canal à pleine vitesse sans blending. Ensuite avec blending elles conservent une efficacité maximale en INT8 là où les Radeon subissent une perte. Page 5 - Tests théoriques: géométrie Débit de trianglesEtant donné les différences architecturales des différentes GPUs au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d’abord nous avons observé les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu’ils tournent le dos à la caméra) :  La GeForce GTX 580 est ici très performante et devance la GeForce GTX 480 de 30% lorsque les triangles sont rendus alors que théoriquement le gain aurait dû se situer entre 10 et 18%. Etant donné que les GeForces sont limitées artificiellement à ce niveau par rapport aux Quadros nous supposons donc que Nvidia a ici laissé un peu plus d’espace au GF110 par rapport au GF100, introduisant du coup une différence artificielle entre ces 2 révisions du GPU. Dès qu’il s’agit d’éjecter des triangles du rendu via le culling, aucune Radeon n’arrive à la cheville des GeForces haut de gamme. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation :  L’avantage des GeForces sur les Radeons est ici évident. AMD et Nvidia ont des approches très différentes et les GeForces affichent un débit qui varie suivant le nombre d’unités de traitement de la carte alors qu’il ne varie qui suivant la fréquence pour les Radeons. L’architecture de ces dernières fait qu’elles sont rapidement engorgées par la quantité de données générées, ce qui réduit drastiquement leur débit dans ce cas. Le doublement de la taille du buffer dédié à l’unité de tessellation dans le GPU des Radeon HD 6800 leur permet d’être significativement plus performantes que les Radeon HD 5800, sans toutefois pouvoir rivaliser avec les GeForces. Etrangement, la GeForce GTX 580 n’affiche qu’un gain très faible sur la GeForce GTX 480 et est même moins performante dans ce test lorsque les triangles sont éjectés du rendu via culling. Nous supposons que cela est lié à une configuration logicielle différente qui favorise certains cas (les plus importants probablement) mais peu entraîner une baisse dans d’autres, nous avions déjà pu observer cela avec certains profils des Quadros. Displacement mappingNous avons testé la tessellation avec une démo d’AMD intégrée par Microsoft à son SDK de DirectX. Cette démo permet de comparer le bump mapping, le parallax occlusion mapping (la technique de bump mapping la plus avancée utilisée dans les jeux) et le displacement mapping qui exploite la tessellation.  Le bump mapping basique.  Le parallax occlusion mapping.  Le displacement mapping avec tessellation adaptative. En créant de la vraie géométrie supplémentaire, le displacement mapping affiche une qualité nettement supérieure. Nous avons activé ici l’algorithme adaptatif par rapport à la distance qui permet d’éviter de générer de la géométrie inutile et trop de petits triangles qui ne vont pas remplir un quad, la zone de rendu minimale sur tous les GPUs et donc gâcher beaucoup de puissance de calcul. Nous avons mesuré les performances obtenues avec les différentes techniques :  Il est intéressant de remarquer que la tessellation ne se contente pas d’améliorer la qualité du rendu, mais également les performances ! Le parallax occlusion mapping est en fait très gourmand puisqu’il repose sur un algorithme complexe qui essaye de simuler la géométrie d’une manière réaliste. Malheureusement il génère beaucoup d’aliasing et le trucage est vite démasqué aux bords des objets ou des surfaces qui l’utilisent. Notez cependant que dans le cas présent l’algorithme de displacement mapping est bien aidé par le fait qu’il s’agit d’une surface plane à la base. S’il faut lisser les contours de la géométrie et en même temps appliquer le displacement mapping, le coût sera bien entendu plus élevé. Les GeForce encaissent ici beaucoup mieux la charge liée à la tessellation que les Radeon, bien que la série 6800 affiche un gain conséquent. L’utilisation d’un algorithme adaptatif qui va réguler le niveau de tessellation suivant les zones qui vont recevoir plus ou moins de détails, suivant la distance ou encore suivant la résolution de l’écran permet dans tous les cas des gains significatifs et sont plus représentatifs de ce que vont faire les développeurs. L’écart entre les GeForce et les Radeon se réduit alors, et ces dernières passent même devant dans certains cas. Page 6 - La GeForce GTX 580 La GeForce GTX 580 de référencePour ce test, Nvidia nous a fourni une paire de GeForce GTX 580 de référence :      Pour cette GeForce GTX 580, Nvidia a repris un PCB similaire à de celui de la GeForce GTX 480 si ce n’est qu’il n’est plus troué étant donné que cela n’apportait en pratique aucun gain au niveau de l’apport en air frais. Le nouveau PCB a été optimisé pour être plus fiable par rapport à la consommation extrême de la GeForce GTX 580, identique à celle de la GeForce GTX 480. La connectique est elle aussi identique avec 2 sorties DVI Dual Link, une sortie mini-HDMI, 2 connecteurs SLI et des connecteurs d’alimentation 8+6 broches. La plus grosse évolution réside dans le système de refroidissement de la GeForce GTX 580. Nvidia utilise une turbine légèrement différente, qui produit moins de nuisances sonores. Par ailleurs, la partie externe du radiateur qui accumulait beaucoup de chaleur et la dispersait dans le boîtier disparaît au profil d’un modèle plus classique. Celui-ci gagne cependant en efficacité grâce à l’utilisation d’une chambre à vapeur, comme le fait AMD sur la Radeon HD 5970 par exemple.  Nvidia parle d’un TDP dans les jeux de 244W mais il est en réalité plutôt de 300W dans les stress tests.Pour tenter de contenir la consommation, Nvidia a intégré des composants qui permettent aux pilotes (mais pas directement au GPU) de suivre la consommation du GPU ou plutôt l’intensité du courant qui passe par chacun des 3 canaux d’alimentation 12v (bus PCI Express et connecteurs). Nvidia n’a cependant pas activé de monitoring global et, pour éviter de réduire les performances dans les jeux ou dans 3DMark, se contente de mettre son système en action dans les dernières versions de Furmark et d’OCCT, soit dans les tests de charge extrême utilisés par les testeurs pour mesurer la consommation. Dans ces applications, si le pilote observe une consommation qui va au-delà d’une certaine limite, il baisse les fréquences de moitié, et encore une fois de moitié si ce n’était pas suffisant. En pratique, le système de Nvidia revient plus à empêcher d’utiliser de tels logiciels qu’à maintenir la consommation dans une enveloppe thermique bien définie. Nvidia nous a indiqué qu’il était voué à évoluer pour inclure plus d’applications à risque. Il n’est par contre pas certain qu’il évolue vers une surveillance permanente de la consommation. Au niveau de l'overclocking, nos 2 échantillons ont accepté une fréquence de 875 MHz pour le GPU, testée stable sous une version de Furmark non ralentie par le mécanisme de Nvidia. Cela représente une augmentation de 13%. Enfin, précisons que si toutes les cartes alimentent le GPU en 0.962V au repos, la tension varie en charge suivant les exemplaires, ce qui permet à Nvidia de maximiser le nombre de puces qualifiées pour tenir certaines spécifications. Ainsi, en charge, l'un de nos exemplaires de test tournait avec une tension GPU de 1.050V alors que le second se contentait de 1.025V. Page 7 - Consommation, bruit ConsommationNous avons bien entendu utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos, sous 3D Mark 06 et sous Furmark. Notez que nous utilisons une version de Furmark non-détectée par le mécanisme de limitation de la consommation dans les stress tests mis en place par Nvidia dans les pilotes pour la GeForce GTX 580.  Si la GeForce GTX 580 est plus économe au repos que la GeForce GTX 480, elle est en charge aussi gourmande que cette dernière avec une consommation de 300W. Comme celle-ci, elle peut dépasser les normes définies par le PCI Express en matière d’alimentation lors d’une charge extrême. Si ce n’est pas un problème au niveau des câbles d’alimentation PCI Express, cela peut en être un au niveau de l’alimentation 12v tirée du bus puisque la limite de 5.5A fixée par la norme est franchie. Cela ne pose en pratique aucun problème sur une carte-mère milieu ou haut de gamme, par contre certains modèles d’entrée de gamme sont plus sensibles à ce niveau et peuvent même succomber à cette charge s’ils intègrent un fusible fixe. Il serait temps que Nvidia, et AMD également sur certains modèles, soient plus rigoureux à ce niveau ! Nuisances sonoresNous plaçons les cartes dans un boîtier Antec Sonata 3 et mesurons le bruit d'une part au repos et d'autre part en charge. Le sonomètre est placé à 60cm du boîtier.  Nvidia a visiblement très bien travaillé l’aspect sonore du ventirad de la GeForce GTX 580 qui se montre relativement discret au vu de la puissance à dissiper. Nous sommes très loin du désastre de la GeForce GTX 480 de référence à ce niveau. Reste à vérifier si cela n’a pas été fait au détriment des températures. En SLI, les GeForce GTX 580 sont légèrement moins discrètes que les Radeon HD 5870 en CrossFire X, mais par contre légèrement moins bruyantes en charge. Une paire de GeForce GTX 580 émet d’ailleurs moins de bruit qu’une seule GeForce GTX 480 placée dans notre système ! Page 8 - Températures TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  La GeForce GTX 580, en plus d’être plus discrète, refroidit donc beaucoup mieux son GPU que la GeForce GTX 480, ce qui démontre bien, si c’était encore nécessaire, que le ventirad de cette dernière était réellement mal conçu. Un bon comportement qui se retrouve également en SLI, alors que dans ce cas les GeForce GTX 480 pouvaient poser de très gros problèmes si un soin très particulier n’avait pas été apporté à l’aération du boîtier. Les GeForce GTX 580, même en SLI, pourront donc se contenter d’un boîtier « classique ». Voici ce que cela donne en image grâce à la thermographie infrarouge :  GeForce GTX 580 au repos  GeForce GTX 580 SLI au repos  GeForce GTX 580 en charge  GeForce GTX 580 SLI en charge Vous pourrez retrouver plus de détails dans notre dossier consacré au dégagement thermique des cartes graphiques de référence. Page 9 - Les pilotes, le test Les pilotesAvec l’arrivée des Radeon HD 6800, AMD a décidé de revoir en partie le fonctionnement de Catalyst A.I., cette option du pilote qui s’occupe d’activer certaines optimisations génériques ainsi que les optimisations spécifiques à chaque jeu. Auparavant il n’était possible que d’activer certaines optimisations plus agressives au niveau du filtrage ou de désactiver complètement Catalyst A.I. et l’ensemble des optimisations apportées par AMD. Dorénavant, il est possible de paramétrer les optimisations du filtrage des textures indépendamment. Par défaut, un mode « qualité » est activé, qui intègre cependant des optimisations légèrement plus agressives qu’auparavant pour les Radeon HD 6800, AMD justifiant cela par le fait que la qualité du filtrage a été améliorée à d’autres niveaux. Si la qualité du filtrage de la Radeon HD 6800 progresse dans certains cas par rapport à celle des Radeon HD 5800 par exemple, dans d’autres cas elle régresse quelque peu et peut introduire plus de fourmillement dans les textures. Passer en mode « haute qualité » permet de compenser en partie, mais en désactivant des optimisations globalement très utiles et sans faire disparaître l’optimisation qui pose problème et qui pourrait bien être implémentée au niveau du GPU et non des pilotes. Pour l’heure, nous avons donc décidé de rester sur le mode « qualité » pour les mesures de performances, mais tout en gardant en tête que les GeForce vont disposer d’un petit avantage qualitatif au niveau du filtrage des textures. Le testPour ce test, nous avons repris le même protocole que celui utilisé dans le test des Radeon HD 6800, si ce n’est que nous avons remplacé DiRT 2 par F1 2010. Les tests ont été exécutés en 1920x1200 et en 2560x1600, sans FSAA, avec MSAA 4x et avec MSAA 8x. Notez à ce sujet que nous nous sommes bien assurés de tester ce mode sur les GeForce, ce qui n’est pas toujours évident. Dans les pilotes Nvidia, l’antialiasing 8x est un fait du MSAA 4x avec un CSAA 8x qui n’offre pas la même qualité qu’un MSAA 8x, qui est, lui, appelé antialiasing 8xQ. C’est donc bien celui-ci qui a été testé. Un an après sa sortie, nous avons décidé de ne plus placer DirectX 11 à part, d’autant plus que toutes les cartes testées ici sont compatible avec cette API. Jeux DirectX 11, 10 et 9 sont donc mélangés et nous avons opté pour un niveau de détails très élevé même dans les jeux les plus gourmands. Les dernières mises à jour ont été installées et toutes les cartes ont été testées avec les derniers pilotes disponibles. Nous avons décidé de ne plus afficher les décimales dans les résultats de performances dans les jeux pour rendre le graphique plus lisible. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l’indice. Si vous êtes observateurs vous remarquerez que c’est également le cas pour la taille des barres dans les graphes. Mise à jour du 25/11/2010 : Nous avons ajouté les performances des GeForce GTX 460 1 Go en SLI et des Radeon HD 6850 en CrossFire X, deux systèmes qui promettent un niveau de performances proche de celui de la GeForce GTX 580, tout en étant moins chers à l’achat. Configuration de testIntel Core i7 975 (HT et Turbo désactivés) Asus Rampage III Extreme 6 Go DDR3 1333 Corsair Windows 7 64 bits Forceware 262.99 WHQL Catalyst 10.10d Page 10 - Need for Speed Shift Need for Speed Shift  Pour tester Need for Speed Shift, nous poussons toutes les options à leur maximum et effectuons un déplacement bien défini. Le patch 1.1 est installé. Notez qu’AMD a mis en place une optimisation qui remplace certaines surfaces de rendu HDR 64 bits par d’autres en 32 bits. Nvidia crie bien sûr à la triche, mais cela ne nuit pas à la qualité. En réalité, AMD profite ici d’une particularité de son architecture qui est capable de traiter ces formats de HDR 32 bits à pleine vitesse. Les GeForce peuvent cependant également en profiter et Nvidia a fourni à la presse un petit outil qui permet de la mettre en place pour obtenir des mesures de performance comparables.   Dans ce premier test, la GeForce GTX 580 prend une avance de 25% sur la GeForce GTX 480 ainsi que sur la Radeon HD 5870 en 2560x1600. Notez que pour une raison inconnue les performances chutent légèrement en SLI en 1920x1200 avec AA8x, à l’exception du système à base de GTX 460. Face aux petits systèmes multi-GPU, la GTX 580 conserve ici un petit avantage. Page 11 - ArmA 2 ArmA 2  Pour tester ArmA 2, nous effectuons un déplacement bien défini après avoir chargé une sauvegarde. Nous utilisons le niveau de détails « élevé » du jeu (visibilité à 2400m) en plus duquel nous poussons toutes les options avancées au niveau très élevé. ArmA 2 est particulier au niveau de la résolution puisqu’il permet de paramétrer différemment la résolution de l’interface de celle du rendu 3D qui est ramenée à hauteur de la première via un filtre. De notre côté nous utilisons une résolution de rendu identique à celle de l’affichage. Les paramètres proposé pour l’antialiasing dans le jeu sont peu clairs et différents entre les cartes AMD et Nvidia. Du côté d’AMD, 3 modes sont proposés : faible, moyen et élevé. Ils correspondent au MSAA 2x, 4x et 8x. Du côté Nvidia, ça se complique : - faible et moyen = MSAA 2x - élevé et très élevé = MSAA 4x - 5 = MSAA 4x + CSAA 8x (appelé 8x dans les pilotes Nvidia) - 6 = MSAA 8x (appelé 8xQ dans les pilotes Nvidia) - 7 = MSAA 4x + CSAA 16x (appelé 16x dans les pilotes Nvidia) - 8 = MSAA 8x + CSAA 16x (appelé 16xQ dans les pilotes Nvidia) Le patch 1.5 a été installé.   En 2560x1600 avec AA4x, nous avons observé un gain proche de 30% en passant de la GeForce GTX 480 à la GeForce GTX 580. Dans ces conditions le système CrossFire X de Radeon HD 6850 prend l’avantage sur cette dernière. Page 12 - Starcraft II Starcraft 2  Pour tester Starcraft 2, nous lançons un replay et mesurons les performances en suivant la vue d’un des joueurs. Toutes les options graphiques sont poussées au maximum. Le jeu n’intègre pas de support de l’antialiasing qui est donc activé par les panneaux de contrôle des pilotes AMD et Nvidia. Le patch 1.0.3 est installé.   Dans Starcraft 2, alors que les GeForce dominaient nettement à la sortie du jeu, AMD est bien revenu avec ses derniers pilotes et prend même une avance avec antialiasing 8x. Attention cependant, les Radeon 1 Go ne disposent pas de suffisamment de mémoire pour lancer ce jeu en 2560x1600 avec AA8x. Page 13 - Mafia II Mafia II  Le moteur de Mafia II confie la gestion de la physique aux bibliothèques PhysX de Nvidia et en profite pour proposer un niveau de détails physiques élevé qui peut être partiellement accéléré par les GeForce. Pour mesures les performances, nous utilisons les benchmark intégré et toutes les options graphiques sont poussées à leur maximum tout d’abord sans activer les effets PhysX accélérés par le GPU :   Nvidia conforte ici son avance. Les GeForce GTX 460 1 Go en SLI égalent la GeForce GTX 580 alors que les Radeon HD 6850 en CrossFire X sont en retrait en 1920x1200 mais devant en 2560x1600. Ensuite, nous passons les détails PhysX à leur niveau élevé :  Avec les effets PhysX poussés au maximum, les performances plongent. Notez qu’elles sont en partie limitées par le CPU, tous les effets PhysX supplémentaires n’étant pas accélérés. Les Radeon restent bien entendu derrière et le SLI n’apporte qu’un maigre gain. Page 14 - Crysis Warhead Crysis Warhead  Crysis Warhead a remplacé Crysis dont il reprend le moteur graphique très gourmand à tous les niveaux. Nous le testons dans sa version 1.1 hotfix et en mode 64 bits puisque c’est la principale nouveauté apportée. Crytek a renommé les différents modes de qualité graphique, probablement pour ne pas heurter les joueurs déçus de ne pas pouvoir activer le mode très haute qualité pour cause de gourmandise excessive. Le mode haute qualité est ainsi renommé « Gamer », et le mode très haute qualité « Enthousiast », c’est celui que nous avons testé.   Alors que Radeon HD 5870 2 Go et GeForce GTX 480 faisaient jeu égal dans Crysis Warhead, la GeForce GTX 580 permet à Nvidia de prendre une avance de 20 à 25%. Si le SLI de GeForce GTX 460 égale la GeForce GTX 580 et si les Radeon HD 6850 en CrossFire X passent devant, ce n’est le cas que dans les conditions qui ne surchargent pas la mémoire vidéo. Une fois que c’est le cas, la GeForce GTX 580 profite de sa mémoire de 1.5 Go. Page 15 - Far Cry 2 Far Cry 2  La suite de Far Cry n’en est pas réellement une puisque Crytek était à l’origine du premier épisode. La licence appartenant à Ubisoft c’est ce dernier qui s’est chargé de son développement, Crytek optant alors pour Crysis. Pas facile de reprendre l’héritage de révolution graphique qui accompagne Far Cry, mais les équipes d’Ubisoft s’en sont bien tirées même si l’aspect graphique n’est pas aussi abouti que celui de Crysis. Le jeu est aussi moins gourmand ce qui n’est pas plus mal. Il supporte DirectX 10.1 pour améliorer les performances des cartes compatibles. Nous avons installé le patch 1.02 et utilisé le mode de qualité graphique « ultra élevé ».   Les GeForce apprécient particulièrement Far Cry 2 et la GeForce GTX 580 creuse l’écart. Les petites cartes en bi-GPU prennent cependant l’avantage sur cette dernière. Page 16 - H.A.W.X. H.A.W.X.  H.A.W.X. est un jeu d’action qui se passe dans les airs. Il utilise un moteur qui prend en charge DirectX 10.1 pour optimiser le rendu. Parmi les effets graphiques supportés, notons la présence de l’occlusion ambiante qui est poussée à son maximum tout comme les autres options. Nous utilisons le benchmark intégré et le patch 1.2 est installé.   La GeForce GTX 580 prend ici une avance de 30 à 40% sur la Radeon HD 5870 et égale la Radeon HD 5970 dans certains cas. Les GeForce GTX 460 en SLI égalent ici la GeForce GTX 580 alors que les Radeon HD 6850 sont devant. Page 17 - H.A.W.X. 2 H.A.W.X. 2  Prévu pour la mi-novembre, H.A.W.X. 2 exploite un moteur DirectX 11 qui prend en charge la tessellation pour augmenter le niveau de détail des énormes terrains dans lesquels les joueurs évoluent. Peu avant la sortie des Radeon HD 6800, Nvidia a fourni à la presse un benchmark tiré de ce jeu et qui met fortement en avant les GeForce, de manière à démontrer l’intérêt de ses choix architecturaux. De son côté, AMD estime que les choix opérés par le développeur dans l’implémentation de la tessellation sont loin d’être optimaux, tant pour les GeForce que pour les Radeon. AMD nous a ainsi indiqué avoir fait plusieurs proposition d’optimisation à Ubisoft aux cours des derniers mois et regretter qu’elles aient toutes été ignorées à cause d’un accord de co-marketing entre Ubisoft et Nvidia. Sans donner plus de détails, AMD laisse entendre qu’Ubisoft et Nvidia se sont entendus pour ne pas utiliser d’algorithme adaptatif efficace, conçu pour éviter d’appliquer de la tessellation là où c’est totalement inutile. Etant donné qu’en dehors de cet aspect, le rendu de H.A.W.X. 2 semble relativement peu gourmand, Nvidia aurait ainsi fait du lobbying auprès d’Ubisoft pour que ce dernier ne mette pas en place une optimisation qui aurait certes profité aux GeForce mais surtout permis un gros gain de performances aux Radeon, supprimant alors cet énorme avantage qui tombe à pic pour sa communication. Si cela s’avère être réellement ce qui se passe, nous ne pouvons que regretter également de voir Ubisoft se moquer de la sorte des 25 millions d’utilisateurs de Radeon DirectX 11. AMD nous a indiqué continuer à proposer différentes optimisations aux développeurs de H.A.W.X. 2 et envisager d’essayer de les implémenter de son côté dans les pilotes pour la sortie du jeu. En attendant d’en savoir plus et la sortie du jeu, nous avons décidé de publier les résultats obtenus sous ce benchmark à titre informatif, mais de ne pas les prendre en compte dans l’indice de performances ni pour juger les différentes solutions.   Comme prévu, les GeForce GTX sont loin devant, même si les Radeon HD 6000 reviennent par rapport à la génération 5000. Page 18 - Battleforge BattleForge  Premier jeu à supporter DirectX 11, ou plus précisément Direct3D 11, il nous était difficile de ne pas l’intégrer à ce test. Une mise à jour déployée en septembre 2009 a en effet ajouté le support de la nouvelle API de Microsoft à BattleForge. Ce sont les Compute Shaders 5.0 qui sont ici exploités par les développeurs pour accélérer le traitement du SSAO, soit de l’occlusion ambiante. Par rapport à l’implémentation classique, via les Pixel Shaders, la technique permet d’exploiter plus efficacement la puissance de calcul disponible en saturant moins les unités de texturing. BattleForge propose deux niveaux de SSAO : High et Very High. Seul le second, appelé HDAO (High Definition AO), exploite les Compute Shader 5.0. Nous avons utilisé le benchmark intégré au jeu et installé la dernière mise à jour disponible à ce jour (1.2 build 298942).   Bien que d’un très bon niveau, nous supposons que les performances des GeForce sont ici limitées par leur relativement faible fillrate, ce qui impacte principalement les GeForce GTX 460. C’est pour cette raison que l’antialiasing a un coût presque nul pour les GeForce puisqu’elles sont saturées à un autre niveau. Page 19 - Civilization V Civilization V  Plutôt réussi visuellement, Civilization V exploite DirectX 11 d’une part pour améliorer la qualité et optimiser les performances du rendu des terrains grâce à la tessellation et d’autre part implémente une compression spéciale des textures grâce aux compute shader, compression qui permet de garder en mémoire les scènes de tous les leaders. Cette seconde utilisation de DirectX 11 ne nous concerne cependant pas ici puisque nous utilisons le benchmark intégré sur une carte de jeu. Nous zoomons légèrement de manière à réduire la limitation CPU qui est très forte dans ce jeu. Tous les détails sont poussés à leur maximum et nous mesurons les performances avec ombres et réflexions. Le patch 1.2 est installé.   Les GeForce sont ici nettement plus performantes que les Radeon qui semblent limitées par leurs performances géométriques ou par le CPU à un niveau relativement faible quand elles ne sont pas en multi-GPU. Page 20 - S.T.A.L.K.E.R. Call of Pripyat S.T.A.L.K.E.R. Call of Pripyat  Cette nouvelle suite de S.T.A.L.K.E.R. repose sur une évolution du moteur, en version 1.6.02, et supporte Direct3D 11 qui est exploité d’une part pour améliorer les performances et d’autres part la qualité avec en option des ombres et des éclairages plus détaillés ainsi qu’un support de la tessellation. Le mode de qualité utilisé est « maximum » et nous avons activé la tessellation. Le jeu ne supporte pas l’antialiasing 8x. Notre scène de test représente 50% en extérieur et 50% en intérieur et dans ce dernier cas nous sommes face à plusieurs personnages.   Nvidia conforte ici son avance. Notez que le CrossFire X de Radeon HD 5870 2 Go profite de sa mémoire importante en 2560x1600 pour égaler les GeForce GTX 580 en SLI. Le CrossFire X de Radeon HD 6850 est ici nettement plus performant que le SLI de GeForce GTX 460, ce qui lui permet de passer devant la GeForce GTX 580. Page 21 - F1 2010 F1 2010  Dernier né chez Codemaster, F1 2010 reprend le même moteur que DiRT 2 et supporte ainsi DirectX 11, via le patch 1.1 que nous avons bien entendu installé. Ce patch ayant été développé en collaboration avec AMD, Nvidia nous a indiqué ne l’avoir reçu que tardivement et ne pas encore avoir eu l’opportunité d’optimiser ses pilotes pour ce jeu en version DirectX 11. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum et utilisons l’outil de test intégré sur le circuit de Spa-Francorchamps avec une seule F1.   Dans F1 2010, la GeForce GTX 580 affiche des performances très proches de celles de la Radeon HD 5870. Ces dernières, en version 2 Go, prennent par ailleurs les devants en multi-GPU. Notez qu’en 2560x1600 avec AA8x, 1 Go de mémoire devient insuffisant dans ce jeu. Les GeForce GTX 460 en SLI sont ici nettement en retrait alors que les Radeon HD 6850 en CrossFire X prennent une avance considérable sur la GeForce GTX 580. Page 22 - Metro 2033 Metro 2033  Probablement le jeu le plus lourd du moment, Metro 2033 met à genoux toutes les cartes graphiques récentes. Il supporte GPU PhysX, mais uniquement pour générer des particules lors des impacts, un effet plutôt discret que nous n’avons donc pas activé pour les tests. En mode DirectX 11, il affiche des performances identiques au mode DirectX 10 mais propose 2 options supplémentaires : la tessellation pour les personnages et un effet de champ (Depth of Field) très évolué et très gourmand. Nous l’avons testé en mode DirectX 11, avec une qualité très élevée et la tessellation activée avec et sans MSAA 4x. Nous avons ensuite mesuré les performances avec MSAA 4x et le Depth of Field.   Avec la GeForce GTX 580, Nvidia creuse l’écart dans Metro 2033. Vous remarquerez l’excellente efficacité des systèmes multi-GPU dans ce jeu, ce n’est cependant pas suffisant pour que les couples de cartes milieu de gamme devancent la GeForce GTX 580. Page 23 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, d’autant plus avec les solutions haut de gamme dont les scores sont susceptibles d’être lissés par la limitation CPU de certains jeux, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Mafia II est ici intégré avec les scores obtenus sans les effets GPU PhysX et H.A.W.X. 2 n’est pas pris en compte. Nous avons attribué un indice de 100 à la GeForce GTX 480 en 1920x1200 :   En moyenne, la GeForce GTX 580 affiche des gains de 12 à 19% par rapport à la GeForce GTX 480 et, en attendant l’arrivée des Radeon HD 6900, conforte ainsi l’avance de Nvidia sur la Radeon HD 5870 qui atteint maintenant 20 à 30%. La Radeon HD 5970 garde globalement la position de la carte graphique la plus performante avec une avance qui s’est cependant réduite à moins de 10%. La GeForce GTX 580 passe même devant en 2560x1600 avec AA8x, la Radeon HD 5970 étant limité par sa mémoire vidéo de 1 Go par GPU dans plusieurs jeux. Les gains moyens apportés par le SLI et le CrossFire X sont similaire et tournent autour de 60 à 70%, ce qui témoigne d’une bonne efficacité. Ces gains sont un petit peu plus faibles avec les GeForce GTX 580, ce qui est lié à leur niveau de performances supérieur qui les amène plus souvent à butter contre la limitation CPU de certains jeux. Le système SLI de GeForce GTX 460 1 Go affiche des performances très proches de celles d’une GeForce GTX 580, à l’exception du 2560x1600 AA8x, conditions dans lesquelles elles ne disposent pas de suffisamment de mémoire pour certains jeux. Il en va de même pour les Radeon HD 6850 en CrossFire X qui, en dehors de ce cas, prennent cependant une avance de 6 à 10% sur la GeForce GTX 580 et donc sur les GeForce GTX 460 en SLI également. Page 24 - Conclusion ConclusionA l’issue de ce test, il apparaît évident qu’avec la GeForce GTX 580, Nvidia nous propose enfin ce qu’aurait dû être la GeForce GTX 480, à savoir une carte graphique aux performances à la hauteur de la débauche de transistors de son GPU et aux nuisances sonores et thermique maîtrisées. La GeForce GTX 580 affiche ainsi 15% à 20% de performances supplémentaires par rapport à la GeForce GTX 480, grâce à une nouvelle révision du GPU qui permet de proposer une déclinaison sans unités désactivées et aux fréquences boostées et ce pour une consommation identique. Encore heureux diront certains, puisqu’à 300W en pointe il aurait été malvenu de la tirer une fois de plus vers le haut. Malgré une tentative approximative d’essayer de le limiter au niveau des pilotes, le niveau de consommation reste donc extrême pour une carte mono-GPU. Ce n’est cependant pas un aspect disqualifiant dans la niche du très haut de gamme. A condition bien entendu de pouvoir gérer correctement cet afflux de chaleur. C’est le cas ici, et la plus grosse évolution est justement à chercher du côté du système de refroidissement de référence de cette GeForce GTX 580, pour lequel Nvidia a fait un très bon travail. Il refroidit beaucoup mieux le GPU tout en limitant les nuisances sonores à un niveau raisonnable, permettant à la GeForce GTX 580 d’afficher un comportement similaire à celui d’une Radeon HD 5870 sur ces critères.  En l’absence de toute compétition, AMD vous donnant rendez-vous le 22 novembre pour le lancement des Radeon HD 6900, et sans problème particulier à signaler, la GeForce GTX 580 ravi donc facilement la première place du podium, d’autant plus qu’elle profite d’un support très efficace de la tessellation et de l’accélération des effets GPU PhysX dans quelques jeux. Avec sa puissance de calcul très élevée elle ravira également les amateurs de 3D stéréoscopique, très gourmande, et qui profite de l’écosystème 3D Vision, le mieux installé en termes d’écrans compatibles. Son tarif annoncé et plutôt élevé de 480 € est donc logique au vu de la prestation et de l’absence de concurrence. Suivant le niveau de performances des Radeon HD 6900 il pourra bien entendu être revu et nous vous conseillons donc d’attendre la fin du mois, à moins d’être pressés ou fixés dans le clan GeForce. Enfin, nous pouvons rassurer les amateurs de performances extrêmes quant au comportement du SLI de GTX 580 qui ne pose pas de problème particulier, à condition de disposer d’une alimentation adaptée bien entendu. Notez par ailleurs que nous avons constaté une efficacité similaire, et plutôt très bonne, entre les technologies SLI et CrossFire X. Bien qu’AMD et Nvidia aient fait un gros travail sur ce point, celles-ci peuvent par contre toujours être soumises à un petit délai dans le support de certains jeux, ce qui posera problème pour les joueurs qui veulent pouvoir profiter des nouveaux jeux dès leur sortie. Mise à jour du 11 novembre 2010 : Contrairement à ce que nous avait affirmé AMD avant la publication de ce dossier, les Radeon HD 6900 n’arriveront finalement pas avant la mi-décembre, ce qui risque d’entraîner une disponibilité très limitée pour Noël. Si certains vont malgré tout patienter quelques semaines de plus, de manière à disposer de toutes les informations avant d’investir dans un modèle de près de 500€ et peut-être bénéficier d’un petit rabais, d’autres préféreront en toute logique s’en passer mais profiter de leur carte graphique dès aujourd’hui. Une seconde option tout aussi valable que la première, d’autant plus que nous nous attendons à ce que la prestation de la Radeon HD 6970 soit très proche de celle de la GeForce GTX 580. Mise à jour du 25/11/2010 Sur le plan des performances, les systèmes à base de GeForce GTX 460 en SLI et de Radeon HD 6850 en CrossFire X permettent d’égale la GeForce GTX 580, voire de la dépasser pour le second, tout en réduisant la note totale de plus de 120 €. Un excellent rapport performances/prix qu’il faut cependant mettre en relation avec les petits inconvénients liés au multi-GPU : encombrement du système et impossibilité de mise à jour future, délai dans le support de certains jeux, sensation de fluidité moindre dans certains cas à niveau de performance égal… Par ailleurs, il faut noter que ces cartes ne disposent que de 1 Go de mémoire, ce qui peut poser problème dans des conditions de jeu extrême. En ce qui nous concerne, à niveau de performances similaire, nous préférons toujours une carte haut de gamme mono-GPU. Difficile cependant d’ignorer l’argument tarifaire dans ce cas-ci : si vous êtes prêts à vous accommoder de ces petits inconforts, l’économie à réaliser est conséquente. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |