| |

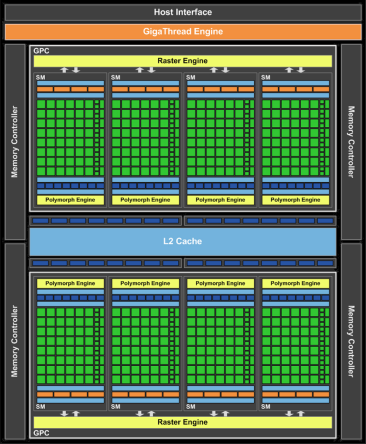

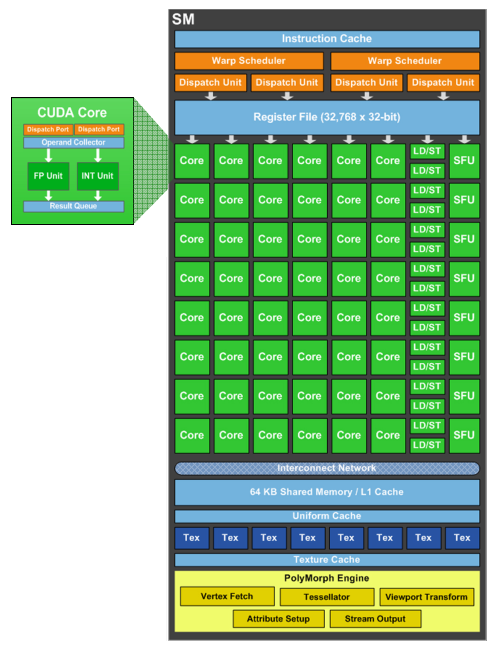

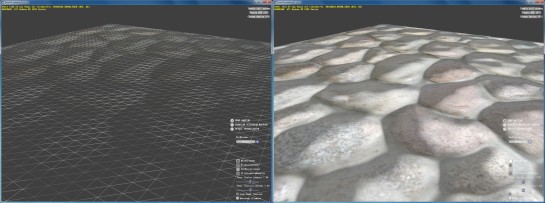

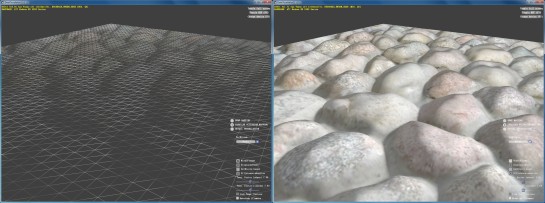

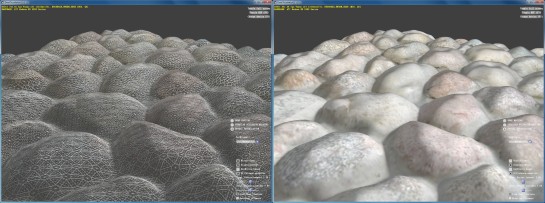

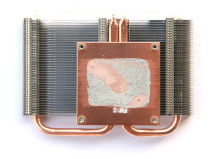

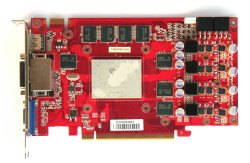

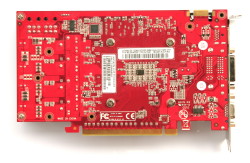

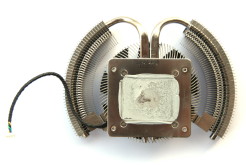

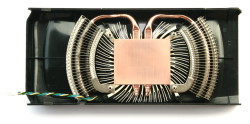

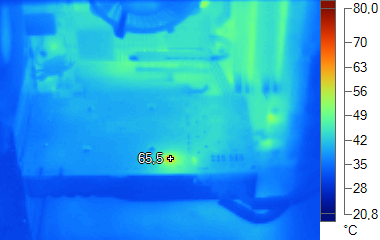

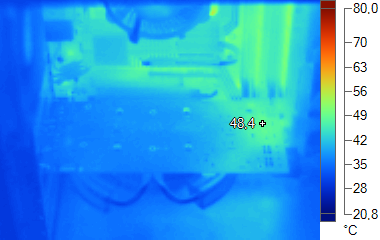

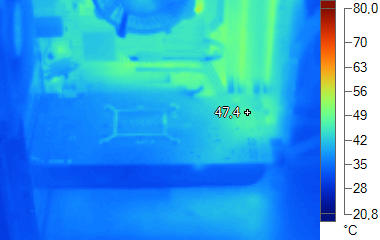

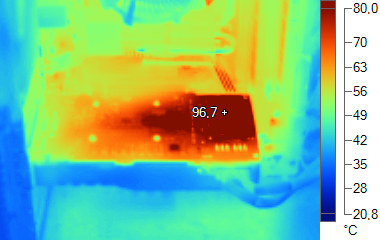

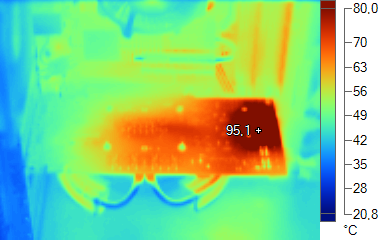

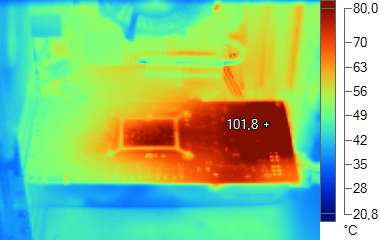

| Nvidia GeForce GTX 460 Cartes Graphiques Publié le Lundi 12 Juillet 2010 par Damien Triolet URL: /articles/795-1/nvidia-geforce-gtx-460.html Page 1 - Introduction Avec un nouveau GPU à l’architecture retouchée et dédié au segment 200-250€, Nvidia compte bien séduire de nombreux joueurs. C’est en effet aujourd’hui que le GF104 fait son apparition, embarqué sur la GeForce GTX 460 ; ou plutôt sur les GeForce GTX 460 que nous avons décortiquées tant sur le plan technique qu’au niveau de leurs performances pratiques.  Le GF104Le cycle classique d’introduction d’une nouvelle génération de GPUs consiste en l’arrivée d’un GPU haut de gamme suivi de plusieurs dérivés basés sur la même architecture. Un cycle qu’AMD a particulièrement bien exécuté sur les dernières générations de GPUs là où Nvidia à en partie échoué avec les GeForce 200. Il faut dire que Nvidia a investi beaucoup au niveau de ses architectures dans le GPU computing et a été surpris par l’efficacité des dernières Radeon. Depuis les Radeon HD 4800, AMD a conservé une longueur d’avance au niveau du rapport performances/prix, particulièrement sur ce segment sur lequel les joueurs veulent un GPU performant sans se ruiner. Le retard de Nvidia au niveau des GPUs DirectX 11, ainsi qu’une production limitée pour AMD ont maintenu un prix relativement élevé pour la Radeon HD 5850, laissant vide le segment très important de 200-250€. AMD a bien tenté de l’alimenter avec la Radeon HD 5830, mais celle-ci, peu intéressante, a sombré dans l’oubli avant de voir son prix passer successivement de 240€ à 220€, puis à 200€ et enfin à 170/180€ en réaction au lancement de ces GeForce GTX 460, mais également pour écouler les stocks d’invendus. Le segment phare pour les joueurs reste donc complètement ouvert et Nvidia compte bien se l’accaparer. Même en étant castré, le GF100 reste trop cher et pas assez efficace pour alimenter en volume ce segment. Il faut donc un nouveau GPU qui prenne place juste en-dessous du haut de gamme et un cran au-dessus du milieu de gamme habituel qui consiste à couper le GPU supérieur en deux. C’est exactement le GPU que Nvidia a conçu, en passant par une nouvelle architecture. Celle-ci intègre des modifications du même ordre que celles mises en place entre les G8x/G9x et le GT200, tout en recherchant à proposer un produit très efficace pour les joueurs, comme avec la GeForce 8800 GT. De cette démarche est né le GF104, équipé de 1.95 milliards de transistors. Voyons ce qu’il embarque. Page 2 - Architecture Fermi pour les joueurs Architecture Fermi pour les joueursPour rappel, le GF100 repose sur une première grosse structure, les GPCs (Graphic Processing Clusters). Au nombre de 4, ces GPCs intègrent chacun une unité de rastérisation et 4 SMs (Streaming Multiprocessors). Pour alimenter ces GPCs, 6 contrôleurs mémoire de 64 bits forment un bus de 384 bits. Avec le GF104, Nvidia est parti d’un demi-GF100 interfacé en 256 bits. Il repose ainsi sur 2 GPCs de 4 SMs. Jusque là, que du classique.  Maintenez la souris sur le schéma du GF104 pour le comparer à celui du GF100. A y regarder de plus près, les SMs du GF104 semblent plus larges. C’est effectivement le cas. Dans le GF100, chaque SM dispose 32 « cores » et de 4 unités de texturing. Plus en détail, nous retrouvons 2 schedulers qui alimentent 5 blocs d’exécution : - unité SIMD0 16-way (les « cores ») : 16 FMA FP32 - unité SIMD1 16-way (les « cores ») : 16 FMA FP32 - unité SFU 4-way : 4 fonctions spéciales FP32 ou 8 interpolations - unité Load/Store 16-way 32 bits - unité de texturing 4-way Pour le GF104, Nvidia a voulu ajouter des unités d’exécutions à plus faible coût et augmenter le ratio d’unités de texturing par rapport aux unités de calcul. Les SMs ont donc été élargis avec 48 « cores » et 8 unités de texturing. Un ratio qui vise directement le rendement dans les jeux. Plus en détail, les SMs du GF104 disposent de 2 doubles schedulers qui alimentent 6 blocs d’exécution : - unité SIMD0 16-way (les « cores ») : 16 FMA FP32 - unité SIMD1 16-way (les « cores ») : 16 FMA FP32 - unité SIMD2 16-way (les « cores ») : 16 FMA FP32 - unité SFU 8-way : 8 fonctions spéciales FP32 ou 16 interpolations - unité Load/Store 16-way 32 bits - unité de texturing 8-way  Maintenez la souris sur le schéma du GF104 pour le comparer à celui du GF100. Le demi-GF100 se transforme ainsi en un GPU nettement plus véloce avec seulement 25% de déficit au niveau des unités de calcul générales et un nombre identique d’unités de texturing et d’exécution des fonctions spéciales. Qui plus est, les unités de texturing ont été améliorées pour filtrer les textures FP16 (ainsi que FP11, FP10 et RGB9E5) à pleine vitesse. Il perd cependant la faculté de traiter à demi-vitesse les calculs en double précision qui sont fortement ralentis, ce qui est de toute manière également le cas sur les versions grand public du GF100. Si le GF104 peut envoyer 4 instructions par SM et par cycle contre seulement 2 pour le GF100, vous remarquerez que nous parlons de 2 doubles schedulers et non de 4 schedulers. La différence est subtile et marque un changement de religion chez Nvidia. Du G80 au GF100, tous les GPUs de la marque ont eu naturellement un rendement optimal grâce à un fonctionnement vu comme scalaire de la part du programme exécuté. Cela en opposition aux GPUs des Radeon qui ont un comportement vectoriel a l’efficacité forcément moindre. Si chaque SM du GF100 lance 2 instructions par cycle, elles s’exécutent sur 2 groupes de données différents, les warps de 32 éléments. Il n’y a donc jamais de problème de dépendance des instructions et le rendement est optimal ou presque. Cela change avec le GF104 dont chacun des 2 schedulers, pour alimenter ses unités supplémentaires, peut lancer 2 instructions par warp. Celles-ci ne peuvent bien entendu pas dépendre l’une de l’autre. Nvidia préfère parler de fonctionnement superscalaire plutôt que vectoriel 2D étant donné que chaque scheduler peut lancer n’importe quelle combinaison d’instructions indépendantes. Pour conserver un bon rendement, le compilateur des pilotes a été modifié et va essayer d’organiser le code de manière à s’adapter à cette particularité. La problématique se rapproche donc de celle d’AMD, bien que ce soit dans une toute autre mesure. Si toutes les instructions sont scalaires et dépendantes, le rendement de la puissance de calcul brute des Radeon tombe à 20% alors que dans le pire des cas il restera de 66% avec le GF104. Et dans le meilleur des cas il pourra égaler le GF100 avec moitié moins de SMs ! Pour le reste, les SMs du GF104 conservent le même nombre de registres, la même mémoire de 64 Ko pour le cache L1 et la mémoire partagée (16/48 Ko ou 48/16 Ko) et le Polymorph Engine chargé d’une partie des opérations géométriques telles que le vertex fetch, le culling et la tessellation. Le cache L2 global est toujours présent et lié aux contrôleurs mémoire, ce qui voit sa taille réduite de 768 Ko à 512 Ko. Dans l’ensemble nous retrouvons donc une architecture optimisée pour offrir un meilleur rendement dans les jeux actuels. Elle conserve cependant une limitation importante au niveau du fillrate… Page 3 - Architecture (suite), spécifications Plus de triangles, moins de pixelsDepuis le lancement de la GeForce GTX 480, nous avons eu un peu de temps pour observer certains détails de l’architecture. Tout d’abord au niveau géométrique où nous avons pu constater plusieurs choses bien que certains aspects de l’architecture conservent toujours quelques secrets. Le culling est très rapide sur le GF100 et sur le GF104. Cette opération consiste par exemple à rejeter un triangle qui tourne le dos à la caméra (back face culling), ce qui signifie qu’il n’est pas visible. Imaginez une sphère composée de multiples facettes affichée à l’écran. En réalité vous n’en voyez que la moitié des polygones, celle qui vous fait face. L’autre moitié n’est pas visible et peut donc être éjectée du rendu. Pour les objets et personnages plus complexes affichés dans un jeu, le principe est le même et statistiquement la moitié des polygones qui les composent peuvent être rejetés. Le faire rapidement est donc intéressant. Les GPUs AMD ainsi que le GT200 et ses prédécesseurs sont capables de rejeter un triangle par cycle. Dans le GF100 et le GF104, cette opération est distribuée et parallélisée. Elle prend place dans le Polymorph Engine de chaque SM. Nous avons pu observer que chaque SM est ainsi capable de rejeter un triangle tous les 4 cycles (fréquence GPU). Avec 16 SMs le GF100 peut donc en rejeter 4 par cycles et avec 8 SMs, le GF104 peut en rejeter 2 par cycle. Au niveau de la rastérisation, soit de la découpe des triangles en pixels, le GT200 et ses prédécesseurs étaient capable de traiter un triangle tous les 2 cycles alors que les Radeon atteignaient 1 triangle par cycle. Là aussi le GF100 a parallélisé cette étape du rendu puisque chacun des 4 GPCs dispose d’un rasterizer. En principe chacun de ceux-ci peut traiter un triangle par cycle et générer 8 pixels par cycle. En pratique s’ils peuvent bien générer 8 pixels par cycles, leur débit en triangles est limité artificiellement sur les GeForce pour laisser un avantage aux Quadro à ce niveau. Les tests que nous avons pu effectuer laissent penser qu’ils peuvent en pratique sur GeForce traiter un triangle tous les deux cycles. Si le GF100 était donc en pratique deux fois plus véloce que les Radeon, le GF104 ne fait que se mettre à leur niveau. Nous avons également pu en apprendre plus sur la limitation du fillrate du GF100 et du GF104 qui la partage. Elle se situe au niveau de la communication entre les SMs et les ROPs qui est limitée à 64 bits par cycle. Ainsi, en rendu classique, chaque SM peut débiter 2 pixels par cycle soit 32 au total pour le GF100 et 16 au total pour le GF104. Peu importe que le premier soit équipé de 48 ROPs et le second de 32 ROPs, la limite sera de 32 et 16 pixels par cycle. Les rasterizers offrent d’ailleurs un même débit. Nous pourrions nous dire que les ROPs étant plus lents en rendu FP16 (64 bits par pixel) et FP32 (128 bits par pixel), ils vont pouvoir tous être utiles avec ces rendus. Mais il n’en est rien puisque, encore une fois, le datapath entre les SMs et les ROPs est limité à 64 bits. Nous ne savons pas s’il s’agit là d’une limitation voulue dès le départ par Nvidia, s’il s’agit d’un compromis fait en court de route ou d’une solution de secours mise en place suite à un problème. Quoi qu’il en soit il s’agit selon nous d’une limitation importante de l’architecture qui empêche de profiter pleinement de la totalité des ROPs et dans une moindre mesure de la bande passante mémoire disponible. Lot de consolation, les ROPs « inutiles » sont mis à contribution lorsque l’antiliasing est utilisé puisque ce filtre augmente la charge sur les ROPs sans trop augmenter la quantité de données à transmettre entre les SMs et les ROPs. SpécificationsTout comme pour les GeForce GTX 400 basées sur le GF100, les GeForce GTX 460 exploitent un GF104 partiellement castré. Un de ses 8 SMs est donc désactivé. Par ailleurs, et c’est regrettable, Nvidia a décidé de lancer sous le même nom, GeForce GTX 460, une version 192 bits en plus de la version 256 bits. Alors que la version 256 bits est équipée de 1 Go de mémoire et de 32 ROPs, la version 192 bits n’est équipée que de 768 Mo de mémoire et de 24 ROPs, en plus de voir sa bande passante chuter de 25%. Selon nous il s’agit de 2 produits différents et en les proposant sous un même nom, Nvidia ajoute inutilement de la confusion. Certes il est possible de les identifier suivant la quantité de mémoire, mais que va-t-il se passer quand une version 192 bits et 1.5 Go va débarquer ? Il ne sera pas spécialement évident pour tous les acheteurs de comprendre qu’elle sera moins performante qu’une version 1 Go…   Page 4 - Tests théoriques - pixels Performances texturingNous avons mesuré les performances lors de l’accès à des textures de différents formats en filtrage bilinéaire. Nous avons conservé les résultats en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16) et en 128 bits (4x FP32). Nous avons ajouté pour information les performances en 32 bits RGB9E5, un nouveau format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis.  Si Nvidia avait conservé un rendement proche du maximum avec le GF100, il en va autrement du GF104 qui n’atteint ici que 88% de ses capacités de texturing. Il est cependant capable de traiter à pleine vitesse tous les formats jusqu’au FP16, contrairement aux autres GPUs testés ici. Ce que ce test ne montre pas, c’est que sans filtrage, les unités de texturing du GF100 sont capables, comme celles du GF104, de débiter chacune 64 bits de données. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données :   En terme de fillrate, les Radeon HD 5000 ont un gros avantage sur les GeForce GTX 400, surtout en FP10, format traité à pleine vitesse alors que sur les GeForce il passe à demi vitesse. Compte tenu de la limitation de ces GeForce GTX 400 au niveau des datapaths entre les SMs et les ROPs, il est dommage que Nvidia n’ait pas donné à son GPU la possibilité de profiter des formats FP10 et FP11. Les GeForce conservent cependant certains avantages. Tout d’abord elles peuvent traiter le FP32 simple canal à pleine vitesse sans blending. Ensuite avec blending elles conservent une efficacité maximale en INT8 là où les Radeon subissent une perte. Page 5 - Tests théoriques - géométrie Débit de trianglesEtant donné l’évolution apportée par Nvidia au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d’abord nous nous sommes penchés sur les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu’ils tournent le dos à la caméra) :  La GeForce GTX 480 s’avère ici très rapide et dépasse bien le débit d’un triangle par cycle. Dès qu’il s’agit d’éjecter des triangles du rendu via le culling, aucun autre GPU n’arrive à sa cheville. La GeForce GTX 460 s’approche d’un débit d’un triangle affiché par cycle et est également très rapide pour éjecter les triangles à travers le culling. Nous sommes cependant loin des maximums théoriques de 4 triangles par cycle pour le GF100 et de 2 triangles par cycle pour le GF104. Quelque chose les limite sans que nous sachions exactement de quoi il s’agit. Nous savons par contre que cette limitation n’existe pas sur les futurs dérivés Quadro. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation. Cet outil de test n’est pas encore finalisé et optimisé pleinement de manière à pouvoir atteindre des rendements optimaux. Il permet cependant déjà de comparer les solutions entre elles :  L’avantage des GeForce sur les Radeon est ici évident. Ces dernières semblent limitée à 1 triangle tous les 3 cycles quand la tessellation est utilisée. AMD nous a indiqué que ce n’était pas le cas et que l’unité de tessellation était bien capable de débiter 1 triangle par cycle. Un cas que nous ne sommes pas encore parvenus à reproduire, les Radeons étant très vite dépassée lorsque trop de triangles sont générés. Notez cependant qu’avec 270 millions de triangles par seconde il y a déjà de quoi rendre des scènes très complexes ! AMD et Nvidia ont des approches très différentes. Alors que les Radeon affichent des performances identiques à ce niveau, les GeForce affichent un débit qui varie suivant les performances de la carte. Nous avons également noté d'énormes gains du côté des GeForce lorsque les GPUs doivent charger plusieurs vertices par primitive. Le GF100 et le GF104 continuent de tourner très vite même s'il doivent en charger 2 ou 3 alors que les autres GPUs voient leurs débits chuter puisqu'ils ne peuvent charger qu'un vertex par cycle. Displacement mappingNous avons testé la tessellation avec une démo d’AMD intégrée par Microsoft à son SDK de DirectX. Cette démo permet de comparer le bump mapping, le parallax occlusion mapping (la technique de bump mapping la plus avancée utilisée dans les jeux) et le displacement mapping qui exploite la tessellation.  Le bump mapping basique.  Le parallax occlusion mapping.  Le displacement mapping avec tessellation adaptative. En créant de la vraie géométrie supplémentaire, le displacement mapping affiche une qualité nettement supérieure. Nous avons activé ici l’algorithme adaptatif qui permet d’éviter de générer de la géométrie inutile et trop de petits triangles qui ne vont pas remplir de quad et donc gâche beaucoup de ressources. Nous avons également mesuré les performances obtenues avec les différentes techniques :  Il est intéressant de remarquer que la tessellation ne se contente pas d’améliorer la qualité du rendu, mais également les performances ! Le parallax occlusion mapping est en fait très gourmand puisqu’il repose sur un algorithme complexe qui essaye de simuler la géométrie d’une manière réaliste. Malheureusement il génère beaucoup d’aliasing et le trucage est démasqué aux bords des objets ou des surfaces qui l’utilisent. Notez cependant que dans le cas présent l’algorithme de displacement mapping est bien aidé par le fait qu’il s’agit d’une surface plane à la base. S’il faut lisser les contours de la géométrie et en même temps appliquer le displacement mapping, le coût sera bien entendu plus élevé. Les GeForce GTX 400 encaissent ici beaucoup mieux la charge liée à la tessellation que les Radeon HD 5000. Avec un niveau de tessellation extrême, la GeForce GTX 460 est presque deux fois plus rapide que la Radeon HD 5870 dans ce test. L’utilisation d’un algorithme adaptatif qui va réguler le niveau de tessellation suivant les zones qui vont recevoir plus ou moins de détails, suivant la distance ou encore suivant la résolution de l’écran permet dans tous les cas des gains significatifs et sont plus représentatifs de ce que vont faire les développeurs. L’écart entre les GeForce et les Radeon se réduit alors, mais la GeForce GTX 400 conservent une avance significative. Page 6 - Les cartes Pour ce test, nous nous sommes penchés sur plusieurs modèles proposés par les partenaires de Nvidia : Gainward GeForce GTX 460 Golden Sample 1 GoGainward dispose déjà d’une solution entièrement personnalisée, tant au niveau du PCB que du système de refroidissement :       Particularité de la Golden Sample de Gainward, en plus d’un léger overclocking du GPU qui passe de 675 à 700 MHz, elle propose une connectique riche, directement sur la carte : 2 DVI, une VGA et une HDMI. Du coup Gainward n’a pas besoin de proposer le moindre adaptateur en bundle. Le PCB personnalisé est relativement court avec seulement 18.5 cm et les 2 connecteurs d’alimentation PCI Express prenne place sur le dessus. Le système de refroidissement double slot repose sur un radiateur relativement petit et léger, avec une base en cuivre de laquelle partent 2 heatpipes. Puces mémoires et étage d’alimentation ne reçoivent aucun radiateur et se contentent donc d’une exposition à l’air sous le carénage. Au sujet des puces mémoire, il s’agit de GDDR5 Samsung certifiée à 1 GHz. MSI GeForce GTX 460 Cyclone 768D5 OC EditionMSI propose dès aujourd’hui des cartes basées sur le modèle de référence mais également des cartes qui reprennent le même PCB mais avec un ventirad de la série Cyclone. Ce dernier modèle existe par ailleurs en version overclockée, comme celle que nous avons testée. Le GPU est ainsi cadencé à 728 MHz au lieu des 675 MHz de base. La mémoire reste par contre à sa fréquence d’origine de 900 MHz (1800 MHz pour l’envoi des données).      Notez que si le PCB est bien le modèle de référence, il est fabriqué par MSI. Le fabricant taïwanais précise utiliser des composants de classe militaire, argument commercial majeur de la marque. Si les composants semblent bel et bien de meilleure qualité que sur la carte de Gainward, l’avantage qu’ils apportent reste à démontrer, d’autant plus qu’ils nous semblent cette fois être similaires à ceux utilisés sur les autres cartes basées sur le PCB de référence… MSI livre sa carte avec un adaptateur DVI vers VGA et un adaptateur DVI vers HDMI, préférant ce dernier, probablement moins cher, à un adaptateur mini-HDMI vers HDMI. Le ventirad utilisé par MSI est relativement proche du système de référence, à ceci près qu’il n’y a pas de carénage sur la carte. Le modèle utilisé est cependant plus grand et accompagne d’en ventilateur de 9cm au lieu de 8cm. Tout comme pour la carte de Gainward, la mémoire GDDR5 est signée Samsung et certifiée à 1 GHz. Le modèle que nous avons testé est annoncé avec une disponibilité immédiate pour 209 €. Twintech GeForce GTX 460Twintech propose dès aujourd’hui des GeForce GTX 460 768 Mo et 1 Go de référence et compte essayer de s’aligner sur le prix planché annoncé par Nvidia et qui est respectivement de 200 et de 230€. Le fabricant nous précise cependant que la version 1 Go commercialisée, sera accompagnée d’un ventilateur personnalisé, bien que basée sur le même PCB de référence.      Le ventirad de référence, circulaire, dispose d’une base en cuivre de laquelle partent 2 heatpipes. Il est très proche d’un modèle Cyclone de MSI mais en plus petit. Le carénage permet de diriger une partie de l’air vers l’extérieur du boîtier. Une partie seulement compte tenu de la position centrale du ventilateur. La version 768 Mo utilise le même PCB que la version 1 Go. Seules 2 puces mémoires (qui peuvent être situées à des endroits différents suivant le bloc désactivé par Nvidia) manquent à l’appel compte tenu du bus réduit de 256 à 192 bits. Vous remarquerez que les cartes 256 bits embarquent un GF104-325 alors que les cartes 192 bits embarquent un GF104-300. Comme les autres GeForce GTX 460 passées entre nos mains, elles sont équipées de mémoire GDDR5 Samsung certifiée à 1 GHz. Page 7 - Consommation, bruit ConsommationNous avons bien entendu utilisé notre nouveau protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos, sous 3D Mark 06 et sous Furmark.  Avec un TDP annoncé de 150 watts pour la GeForce GTX 460 768 Mo et de 160 watts pour la version 1 Go, Nvidia a fait un gros effort sur la consommation de son dernier GPU. Cette petite différence entre les 2 modèles n’est pas réellement significative puisqu’elle est similaire à la variation qui existe entre 2 exemplaires d’un même modèle. En charge les GeForce GTX 460 affichent une consommation du même ordre que celle de la Radeon HD 5850 avec un petit avantage pour le modèle MSI. Au repos, c’est encore mieux, avec seulement 15/16 watts, un nouveau record sur ce segment. Nuisances sonoresNous plaçons les cartes dans un boîtier Antec Sonata 3 et mesurons le bruit d'une part au repos et d'autre part en charge. Le sonomètre est placé à 60cm du boîtier.  Le modèle de référence est relativement discret mais produit malgré tout un petit peu plus de bruit que la Radeon HD 5850 de référence, qui est particulièrement peu bruyante. La GeForce GTX 460 Cyclone 768D5 OC Edition de MSI est très proche du modèle de référence malgré l’overclocking d’un peu plus de 50 MHz. La GeForce GTX 460 Golden Sample de Gainward se comporte par contre moins bien à ce niveau. Si au repos elle n’est que légèrement plus bruyante, en charge elle se fait clairement entendre plus que les autres, avec un bruit qui plus plus gênant. Page 8 - Températures TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne :  Comme vous pouvez le voir, les GeForce GTX 460 sont bien refroidies. Au repos le GPU reste dans les 30 °C, alors que la température ambiante se situe entre 26 et 27 °C. En charge les températures restent également relativement faibles avec un avantage à MSI dont le système de refroidissement est plus efficace. Voici ce que cela donne en image grâce à la thermographie infrarouge :  Gainward GeForce GTX 460 Golden Sample 1 Go au repos  MSI GeForce GTX 460 Cyclone 768D5 OC Edition au repos  GeForce GTX 460 1 Go au repos  Gainward GeForce GTX 460 Golden Sample 1 Go  MSI GeForce GTX 460 Cyclone 768D5 OC Edition en charge  GeForce GTX 460 1 Go en charge Vous pourrez retrouver plus de détails dans notre dossier consacré au dégagement thermique des cartes graphiques qui a été mis à jour pour inclure les résultats de la GeForce GTX 460. Page 9 - Overclocking, protocole de test OverclockingNvidia annonce des capacities d’overclocking relativement importantes pour son GF104 et precise qu’atteindre 800 MHz au lieu de 675 MHz est relativement simple. Nous avons bien entendu voulu savoir ce qu’il en était. Voici ce que nous avons obtenu, sachant que nous n’avons pas essayé de pousser la GDDR5 au-delà de 1000 MHz et que nous avons testé la stabilité par pas de 25 MHz, sous Furmark : Gainward GeForce GTX 460 Golden Sample 1 Go : 850 MHz MSI GeForce GTX 460 Cyclone 768D5 OC Edition : 825 MHz GeForce GTX 460 1 Go : 850 MHz GeForce GTX 460 768 Mo : 800 MHz Les 4 cartes en notre possession ont donc toutes accepté 800 MHz pour le GPU et donc 1600 MHz pour les unites de calcul. Deux d’entre elles sont même montées jusqu’à 850 MHz (1700 MHz pour les unités de calcul), ce qui représente un gain très sympathique de 26%. Si le GF104 s’overclocke aussi bien, pourquoi le cadencer à seulement 675 MHz ? Difficile à dire bien entendu et il s’agit probablement d’une combinaison de raisons. Le GF104 est peut-être suffisemment stable pour jouer, mais pas assez pour être validé à cette fréquence. Peut-être que seuls quelques exemplaires tiennent ses fréquences et ont été utilisés sur les premiers lots destinés avant tout aux tests. Nvidia a peut-être voulu éviter de concurrencer trop le GF100 dont les stocks restent importants, les ventes de GeForce GTX 470 ayant été moins bonnes que prévues. Dans ce cas nous pouvons imaginer sans mal une GeForce GTX 475 basée sur un GF104 complet et poussé à 800 MHz. Le TDP d’environ 150 watts à 675 MHz est également important puisque de nombreux OEMs prévoient leurs systèmes avec une enveloppe thermique équivalente. Quoi qu’il en soit, le GF104 semble très prometteur du côté de l’overclocking et nous devrions voir arriver rapidement de nombreuses variantes aux fréquences relevées. Le testPour ce test, nous avons décidé de conserver notre protocole précédent. Nous avons donc utilisé ArmA 2, Need for Speed Shift, World in Conflict Soviet Assault, Anno 1404, Red Faction Guerilla, Crysis Warhead, Far Cry 2, HAWX, Battleforge, S.T.A.L.K.E.R. Call of Pripyat, DiRT 2 et Metro 2033. Nous avons également conservé Batman Arkham Asylum en tant que test des performances quand PhysX est utilisé. Les tests ont été exécutés en 1920x1200 et en 1680x1050, sans FSAA, avec MSAA 4x et avec MSAA 8x. Notez à ce sujet que nous nous sommes bien assurés de tester ce mode sur les GeForce, ce qui n’est pas toujours évident. Dans les pilotes Nvidia, l’antialiasing 8x est un fait du MSAA 4x avec un CSAA 8x qui n’offre pas la même qualité qu’un MSAA 8x, qui est, lui, appelé antialiasing 8xQ. C’est donc bien celui-ci qui a été testé. Nous avons opté pour un niveau de détail élevé mais pas extrême dans les jeux les plus gourmands. Nous avons ajouté des tests en 1680x1050 avec et sans FSAA dans les modes DirectX 11 avancés qui incluent toutes les options graphiques limitées à cette API. Ces tests sont faits à part puisqu’ils ne peuvent pas tourner sur les cartes DirectX 10. Nous avons décidé de ne plus afficher les décimales dans les résultats de performances dans les jeux pour rendre le graphique plus lisible. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l’indice. Si vous êtes observateurs vous remarquerez que c’est également le cas pour la taille des barres dans les graphes. Nous avons ajouté aux tests de performances dans les jeux les résultats obtenus sur une GeForce 8800 GT 512 Mo (qui est équivalente à une GeForce 9800 GT ou à une GeForce GTS 250) de manière à réprésenter les gains apportés par les nouvelles solutions graphiques face à cette carte qui équipe de nombreuses machines. Configuration de testIntel Core i7 975 (HT et Turbo désactivés) Gigabyte GA-EX58-Extreme 6 Go DDR3 1333 Corsair Windows 7 64 bits Forceware 258.80 Catalyst 10.6 Page 10 - Need for Speed Shift Need for Speed Shift  Pour tester le dernier né de la série des Need for Speed, nous poussons toutes les options à leur maximum et effectuons un déplacement bien défini. Le patch 1.1 est installé. Notez qu’AMD a mis en place une optimisation qui remplace certaines surfaces de rendu HDR 64 bits par d’autres en 32 bits. Nvidia crie bien sûr à la triche, mais cela ne nuit pas à la qualité. En réalité, AMD profite ici d’une particularité de son architecture qui est capable de traiter ces formats de HDR 32 bits à pleine vitesse, ce que ne peut pas faire Nvidia qui n’a donc pas de raison de mettre en place une telle optimisation.   Dans ce premier test, la GeForce GTX 460 1 Go devance légèrement la GeForce GTX 465 qui est presqu’égalée par la version 768 Mo. Page 11 - ArmA 2 ArmA 2  Pour tester ArmA 2, nous effectuons un déplacement bien défini après avoir chargé une sauvegarde. Nous utilisons le niveau de détails « élevé » du jeu en plus duquel nous poussons toutes les options avancées au niveau élévé. ArmA 2 est particulier au niveau de la résolution puisqu’il permet de paramétrer différemment la résolution de l’interface de celle du rendu 3D qui est ramenée à hauteur de la première via un filtre. De notre côté nous utilisons une résolution de rendu identique à celle de l’affichage. Les paramètres proposé pour l’antialiasing dans le jeu sont peu clairs et différents entre les cartes AMD et Nvidia. Du côté d’AMD, 3 modes sont proposés : faible, moyen et élevé. Ils correspondent au MSAA 2x, 4x et 8x. Du côté Nvidia, ça se complique : - faible et moyen = MSAA 2x - élevé et très élevé = MSAA 4x - 5 = MSAA 4x + CSAA 8x (appelé 8x dans les pilotes Nvidia) - 6 = MSAA 8x (appelé 8xQ dans les pilotes Nvidia) - 7 = MSAA 4x + CSAA 16x (appelé 16x dans les pilotes Nvidia) - 8 = MSAA 8x + CSAA 16x (appelé 16xQ dans les pilotes Nvidia) Les modes à utiliser de notre côté sont donc élevé (4x) et 6 (8x). Le patch 1.5 a été installé.   Cette fois l’avance de la GeForce GTX 460 1 Go sur la GTX 465 est plus importante. La Radeon HD 5850 reste cependant encore un cran au-dessus. World in Conflict Soviet Assault  Très réussi visuellement et très gourmand, World in Conflict supporte DirectX 10. Son add-on Soviet Assault ajoute quelques petits options graphiques supplémentaires, bien que le test interne, que nous utilisons, exploite la même scène. Nous utilisons le mode de qualité « très élevé » ce qui inclus le mode DirectX 10, poussons le filtrage anisotrope à 16x et activons toutes les options graphiques. Le jeu ne supporte pas le MSAA 8x.   Avec antialiasing 4x, la GeForce GTX 460 1 Go égale la Radeon HD 5850. La version 768 Mo reste quelque peu en retrait. Page 12 - Anno 1404 Anno 1404  Pour tester Anno 1404, nous effectuons un trajet bien défini sur une carte relativement lourde. Toutes les options sont poussées à leur maximum. Le patch 1.2 est installé.   Une fois encore, la GeForce GTX 460 1 Go passe devant la GeForce GTX 465 avec un écart grandissant avec l’augmentation du niveau de l’antialiasing. La version 768 Mo reste en retrait. Page 13 - Red Faction Guerilla Red Faction Guerilla  Très gourmand, Red Faction Guerilla est testé avec toutes les options poussées au maximum. Nous mesurons les performances durant la scène d’introduction.   Le fillrate semble avoir une petite influence dans ces résultats ce qui place pour une fois les GeForce GTX 460 derrière la GeForce GTX 465. Page 14 - Crysis Warhead Crysis Warhead  Crysis Warhead vient remplacer Crysis dont il reprend le moteur graphique très gourmand à tous les niveaux. Nous le testons dans sa version 1.1 hotfix et en mode 64 bits puisque c’est la principale nouveauté apportée. Crytek a renommé les différents modes de qualité graphique, probablement pour ne pas heurter les joueurs déçus de ne pas pouvoir activer le mode très haute qualité pour cause de gourmandise excessive. Le mode haute qualité est ainsi renommé « Gamer » et le mode très haut qualité « Enthousiast ». Nous avons testé ce dernier.   Avec antialiasing 8x, la GeForce GTX 460 768 Mo souffre d’un manque de mémoire. La version 1 Go prend par contre 10% d’avance sur la GeForce GTX 465. Page 15 - Far Cry 2 Far Cry 2  La suite de Far Cry n’en est pas réellement une puisque Crytek était à l’origine du premier épisode. La licence appartenant à Ubisoft c’est ce dernier qui s’est chargé de son développement, Crytek optant alors pour Crysis. Pas facile de reprendre l’héritage de révolution graphique qui accompagne Far Cry, mais les équipes d’Ubisoft s’en sont bien tirées même si l’aspect graphique n’est pas aussi abouti que celui de Crysis. Le jeu est aussi moins gourmand ce qui n’est pas plus mal. Il supporte DirectX 10.1 pour améliorer les performances du côté des Radeon. Nous avons installé le patch 1.02 et utilisé le mode de qualité graphique « ultra élevé ».   Encore une fois, la GeForce GTX 460 768 Mo égale la GeForce GTX 465 alors que la version 1 Go passe devant. Page 16 - H.A.W.X. H.A.W.X.  Dernier jeu de Tom Clancy, H.A.W.X. est un jeu d’action qui se passe dans les airs. Il utilise un moteur qui prend en charge DirectX 10.1 pour optimiser le rendu. Parmi les effets graphiques supportés, notons la présence de l’occlusion ambiante qui est poussée à son maximum tout comme les autres options. Nous utilisons le benchmark intégré et le patch 1.2 est installé.   La GeForce GTX 460 1 Go n’est pas loin de la Radeon HD 5850. Page 17 - BattleForge BattleForge  Premier jeu à supporter DirectX 11, ou plus précisément Direct3D 11, il nous était difficile de ne pas l’intégrer à ce test. Une mise à jour déployée le 30 septembre a en effet ajouté le support de la nouvelle API de Microsoft à BattleForge. Ce sont les Compute Shaders 5.0 qui sont ici exploités par les développeurs pour accélérer le traitement du SSAO, soit de l’occlusion ambiante. Par rapport à l’implémentation classique, via les Pixel Shaders, la technique permet d’exploiter plus efficacement la puissance de calcul disponible en saturant moins les unités de texturing. BattleForge propose deux niveaux de SSAO : High et Very High. Seul le second, appelé HDAO (High Definition AO), exploite les Compute Shader 5.0. Nous avons utilisé le benchmark intégré au jeu et installé la dernière mise à jour disponible à ce jour.   Battleforge est probablement le jeu dans lequel la GeForce GTX 460 est le moins à l’aise, sans antialiasing. Nous supposons que ses performances, ainsi que celles des autres GeForce GTX 400 mais dans une moindre mesure, sont ici plombées par la limitation que nous avons décrite au niveau du fillrate. C’est également pour cette raison que l’antialiasing a ici un coût presque nul pour les GeForce puisqu’elles sont fortement limitées à un autre niveau. Page 18 - S.T.A.L.K.E.R. Call of Pripyat S.T.A.L.K.E.R. Call of Pripyat  Cette nouvelle suite de S.T.A.L.K.E.R. repose sur une nouvelle évolution du moteur qui passe en version 1.6.02 et supporte Direct3D 11 qui est exploité d’une part pour améliorer les performances et d’autres part la qualité avec en option des ombres et des éclairages plus détaillés ainsi qu’un premier support de la tessellation ! Le mode de qualité utilisé est « élevé ». Dans un premier temps, nous n’avons pas activé les améliorations de la qualité disponibles dans la version Direct3D 11 du moteur de manière à avoir ici des chiffres comparables. Le jeu ne supporte pas l’antialiasing 8x. Notre scène de test représente 50% en extérieur et 50% en intérieur et dans ce dernier cas entouré de plusieurs personnages.   La Radeon HD 5850 conserve ici un avantage significatif et la Radeon HD 5830 égale les GeForce GTX 460 et 465 avec antialiasing. Ensuite nous avons exécutés des tests en activant une qualité maximale ainsi que la tessellation, qui a un impact négligeable dans la partie extérieure, mais important dans la partie intérieure :  La GeForce GTX 460 1 Go égale ici la GeForce GTX 465. La première est légèrement plus rapide dans la scène extérieure alors que la seconde l’est légèrement dans la scène intérieure qui fait appel à la tessellation. Page 19 - DiRT 2 DiRT 2  Le patch 1.1 est installé.   En mode DirectX 9, la GeForce GTX 460 1 Go devance la GeForce GTX 465 et égale la Radeon HD 5850. Ensuite nous avons exécutés des tests en DirectX 11 en poussant toutes les options au maximum également, ce qui inclut la tessellation :  Avec tous les effets DirectX 11 activés, la Radeon reprend la main quand l’antialiasing est de la partie. Page 20 - Metro 2033 Metro 2033  Nous l’avons testé tout d’abord en mode DirectX avec une qualité élevée :   La GeForce GTX 460 1 Go égale ici la Radeon HD 5850. La version 768 Mo souffre de sa quantité de mémoire limitée lorsque l’antialiasing est activé. Ensuite nous avons exécutés des tests en DirectX 11 en poussant la qualité sur le mode très élevé et en activant la tessellation et le Depth of Field. En qualité très élevée, le jeu applique de base un filtre appelé analytical antialiasing, qui essaye d’adoucir ce qu’il faut sur la scène avec un résultat parfois peu concluant. Le MSAA 4x reste également proposé.  Avec les options DirectX 11 activées, la GeForce GTX 465 reprend un très léger avantage sur la GeForce GTX 460 1 Go qui égale cependant toujours la Radeon HD 5850 quand l’antialiasing est activé. Dans tous les cas et bien que nous soyons dans la petite résolution de 1680x1050, aucune de ces solutions n’est assez performante que pour pouvoir profiter de ce niveau de qualité. Page 21 - Batman Arkham Asylum Batman Arkham Asylum  Enorme hit, nous ne pouvions pas ignorer Batman Arkham Asylum malgré le côté partisan des technologies qu’il exploite. Nous parlons ici bien entendu de GPU PhysX, une bibliothèque propriétaire au niveau de son accélération par le GPU qui ne supporte que les GeForce. Nous avons installé le patch 1.1 et utilisé le benchmark intégré avec toutes les options poussées au maximum, y compris les effets GPU PhysX. En aidant les développeurs à mettre en place l’antialiasing dans le jeu, Nvidia en a profité pour restreindre cette fonctionnalité aux seules GeForce. Comme nous le supposions dès le départ, il s’agit bien d’une implémentation standard et donc compatible avec les Radeon également mais protégée par Nvidia. Une pratique détestable qui a pour but principal de forcer les utilisateurs de Radeon, et les testeurs, à activer l’antialiasing via le panneau de contrôle, ce qui est nettement moins efficace que directement via le jeu puisque le pilote applique aveuglément l’antialiasing sur toutes les surfaces alors que ce n’est pas nécessaire. Heureusement, il suffit de faire passer une Radeon pour une GeForce avec ATI Tray Tools pour que le panneau de contrôle accepte d’activer l’antialiasing.  Les Radeon ne pouvant pas accélérer ces effets, ils sont limités par le CPU dont tous les cores ne sont, qui plus est, pas exploités. La GeForce GTX 460 768 Mo souffre ici de sa mémoire réduite, l’utilisation de GPU PhysX augmentant la consommation de mémoire vidéo. Page 22 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Batman Arkham Asylum en mode PhysX n’est pas intégré à l’indice. Nous avons attribué un indice de 100 à la Radeon HD 5850 en 1920x1200 avec MSAA 4x.   Avec un gain de 1 à 5% sur la GeForce GTX 465, la GeForce GTX 460 1 Go remplace avantageusement celle-ci ! Par rapport à l’offre d’AMD, cette même GeForce GTX 460 1 Go prend 8 à 30% d’avance sur la Radeon HD 5830, une avance qui grandit avec le niveau d’antialiasing. Elle reste cependant derrière la Radeon HD 5850, mais de peu avec un retrait de 10 à 3% qui cette fois se réduit avec le niveau d’antialiasing. La GeForce GTX 460 768 Mo est bien entendu un petit peu en retrait, surtout avec antialiasing 8x, mode dans lequel sa mémoire s’est avérée plusieurs fois insuffisante. Elle reste cependant dans tous les cas devant la Radeon HD 5830. Au niveau des cartes overclockées des partenaires, la carte de Gainward affiche un gain de 2 à 3% sur la GeForce GTX 460 1 Go de référence pour une augmentation de sa fréquence de 4%. Quant à la carte de MSI, elle affiche un gain de 6% par rapport à la GeForce GTX 460 768 Mo de référence pour une augmentation de 8% de la fréquence de son GPU. Nous avons également mis en indice les résultats obtenus en 1920x1200 dans les modes DirectX 11 des quatre jeux testés avec toutes les options activées. Pour Battleforge, il s’agit des mêmes résultats que ceux utilisés pour calculer l’indice ci-dessus, mais pour les autres jeux, ils incluent, entre autre, la tessellation.  Page 23 - Conclusion ConclusionAnnoncé comme très prometteur par différents bruits de couloir dès l’arrivée du GF100, le GF104 introduit aujourd’hui avec la GeForce GTX 460, tient toutes ses promesses. Nvidia parvient ainsi, ce qui n’était plus arrivé depuis longtemps, à proposer une carte graphique au rapport performances / prix similaire à ce que propose AMD. Qui plus est, cela se fait sur le créneau de 200 à 250€, très important pour les joueurs et dans lequel AMD n’a aujourd’hui aucun produit à proposer. Avec ses GeForce GTX 460, Nvidia a ainsi bel et bien tapé dans le mille. Il est probable que ce GF104 ait été influencé par le retour d’une concurrence acharnée d’AMD avec les Radeon HD 3800 puis 4800 qui avaient pris Nvidia de cours. En concevant des produits plus efficaces, AMD a pu engager une guerre des prix difficile à mener pour Nvidia, qui avait investi une partie plus importante de son architecture dans le GPU computing. De quoi perdre beaucoup de terrain sur ce qui est probablement le segment de marché le plus important. La réaction de Nvidia est ici sans équivoque. Alors que le premier GPU qui a suivi le G80 représentait 25% de sa puissance de calcul, que celui qui a suivi le GT200, après une attente très longue, en représentait 40%, Nvidia nous propose, seulement 3 mois après le GF100, un GF104 qui affiche 75% de la puissance de calcul de son GPU phare.  Pour cela, Nvidia a revu son architecture et l’a musclée au niveau des blocs fonctionnels de base qui, au prix d’un rendement revu quelque peu à la baisse, gagnent de nombreuses unités d’exécution. Ce sont les unités de texturing qui sont ici les mieux servies étant donné qu’elles assurent toujours un très bon retour sur investissement quand la cible est les joueurs comme c’est le cas ici. Une autre façon de voir les choses est la suivante : le GF104 troque une partie de l’efficacité de l’architecture GF100 au niveau du GPU computing contre un meilleur rendement dans les jeux. Nvidia est également parvenu à contenir la consommation de son nouveau bébé qui est particulièrement faible au repos et bien maîtrisée en charge, ce qui démontre qu’il n’a pas été poussé dans ses derniers retranchements et laisse une belle place à l’overclocking, comme nous avons pu le voir. La tessellation fonction phare de DirectX 11, reste très performante. Certes les unités sont à ce niveau réduites de moitié par rapport à une GeForce GTX 480 mais la GeForce GTX 460 reste deux fois plus performante qu’une Radeon HD 5870. Avec la GeForce GTX 460, GPU PhysX et le support de plus en plus répandu de CUDA dans les applications dédiées à la vidéo deviennent de réels bonus, une place qui leur correspond bien mieux que celle de lot de consolation face à un mauvais rapport performances / prix. Tout n’est pas parfait pour autant. Le GF104, comme le GF100 d’ailleurs mais d’une manière plus accentuée, souffre d’une limitation importante au niveau du débit de pixels qui bride quelque peu ses performances. Ce n’est pas un gros problème en pratique, étant donne qu’en contrepartie cela permet de profiter de l’antialiasing sans se poser de questions, mais nous sentons le GF104 quelque peu à l’étroit dans certains jeux, ce qui est dommage. Le plus gros reproche que nous pouvons formuler à Nvidia est, comme souvent, un poil dans la soupe d’ordre commercial. Le fabricant a ainsi eu la très mauvaise idée de donner un même nom à deux déclinaisons du GF104. Il y aura donc des GeForce GTX 460 différentes. Certes il est possible de les reconnaître d’après leur quantité de mémoire, mais nombreux sont ceux qui passeront à côté de cette nuance.  La première GeForce GTX 460 est équipée d’1 Go de mémoire, en attendant des variantes de 2 Go probablement peu utiles, et représente un choix très intéressant pour les joueurs. Annoncée à 230€, elle offre un rapport performances / prix similaire à celui de la Radeon HD 5850 ou de la Radeon HD 5830 fraîchement repositionnée et sera bien adaptée aux écrans offrant une résolution de 1680x1050, de 1920x1080 et même de 1920x1200. De ces 3 solutions, s’il faut trancher, c’est la nouvelle venue qui gagne notre préférence. Il va s’en dire qu’elle rend également complètement inintéressante la pourtant très récente GeForce GTX 465, plus chère et moins performante. En ce 12 juillet il ne fait clairement pas bon avoir un stock de celle-ci sur les bras. La seconde GeForce GTX 460 n’embarque que 768 Mo de mémoire, 25% moins de ROPs et une bande passante réduite d’autant. Elle sera donc moins efficace avec antialiasing. Sa mémoire vidéo réduite la limite en résolution, surtout si vous comptez la conserver quelques temps. A 200€, elle fera en général parfaitement l’affaire pour profiter de tous les raffinements graphiques en 1280x1024 ou en 1680x1050, et dans ces conditions nous la préférons à la Radeon HD 5830, si votre budget le permet. Attention à la version 1.5 Go qui fera son apparition et restera moins performante que la version 1 Go. Comme pour tout GPU supposé très populaire, de nombreux modèles de cartes sont en préparation chez tous les partenaires. Nous avons déjà pu en avoir un aperçu, tout d’abord avec la GeForce GTX 460 Cyclone 768D5 OC Edition de MSI, qui propose quelques points de performances en plus que la carte de référence associés à un meilleur refroidissement en charge. Ensuite avec la GeForce GTX 460 1 Go Golden Sample de Gainward qui est plus compacte et intègre directement toutes les sorties vidéo, mais qui en contrepartie est plus bruyante que le modèle de référence. Enfin terminons sur les prix. Officiellement ils devraient être de 200€ pour la version 768 Mo et de 229€ pour la version 1 Go. Certains partenaires nous ont cependant mentionné des prix plus élevés de 20€ pour les deux variantes, ce qui les rend alors moins intéressantes. La tarification officielle étant bel et bien viable selon nos informations, elle devrait rester à l’ordre du jour si Nvidia produit son GPU en volume suffisant. Si ce n’est pas le cas il est évident que les prix vont être poussés vers le haut… Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |