| |

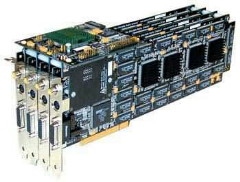

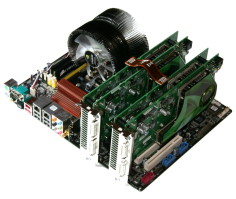

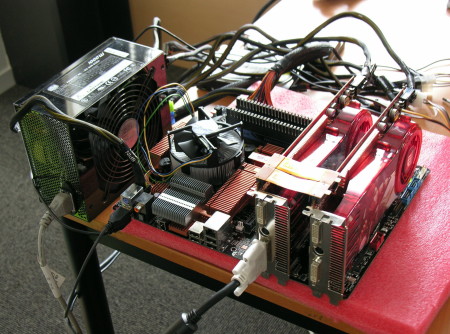

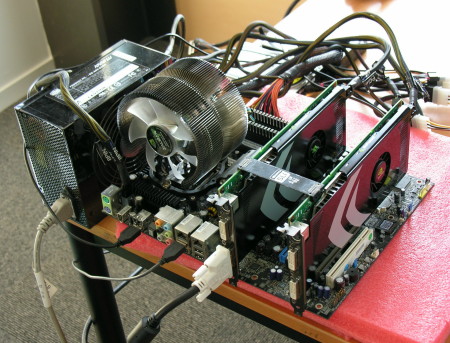

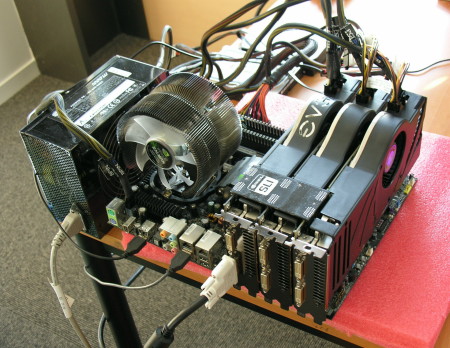

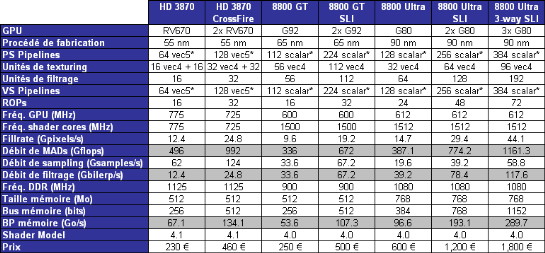

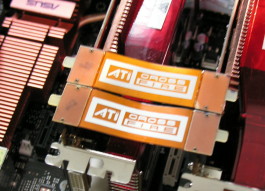

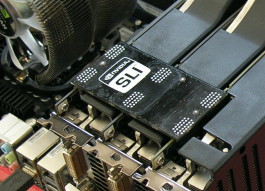

| 1, 2 ou 3 cartes graphiques ? Cartes Graphiques Publié le Vendredi 8 Février 2008 par Damien Triolet URL: /articles/699-1/1-2-ou-3-cartes-graphiques.html Page 1 - Introduction Après avoir réintroduit la possibilité d'exploiter 2 cartes graphiques en parallèle pour augmenter les performances avec le SLI, et s'être planté en beauté avec le Quad SLI qui tentait d'exploiter 2 doubles cartes graphiques, Nvidia a décidé fin 2007 de renforcer son offre multi-GPU avec le 3-way SLI ou triple SLI. L'occasion pour nous de faire le point sur les performances des systèmes SLI et CrossFire.  Le multi-GPULe rendu 3D est de par sa nature très largement parallélisable, c'est-à-dire qu'une même opération est exécutée sur un nombre important d'éléments distincts, et ce à plusieurs niveaux. Le traitement de la géométrie, de ses nombreux vertices / triangles peut se faire en parallèle, le calcul des pixels également, et enfin bien entendu le calcul des images.  Il est donc évident qu'il y a là l'opportunité de diviser le travail nécessaire au rendu 3D de manière à exploiter plusieurs processeurs graphiques. Encore faut-il parmi toutes ces possibilités en dégager la plus efficace et arriver à l'implémenter d'une manière performante et robuste dans les pilotes. Répartir le travail sur la géométrie, à l'intérieur d'une même image, entre 2 processeurs graphiques est faisable, mais plutôt complexe à mettre en place et avec des gains qui ne seraient pas intéressants d'autant plus que le traitement de la géométrie représente une tâche très simple dans de nombreux jeux. Séparer le traitement de la géométrie du calcul des pixels, avec un processeur graphique dédié exclusivement à l'une de ces tâches et un second à l'autre. Les architectures unifiées permettent en effet aux GPUs d'attribuer toutes leurs capacités de calcul à une tâche bien spécifique. Reste que cela irait à l'encontre du principe même de ces architectures unifiées qui est de répartir suivant la demande les capacités de traitement dont elles disposent.  Répartir le calcul des pixels entre plusieurs GPUs est une solution plus adaptée, tout du moins avec les GPUs classiques qui disposent d'unités de traitement dédiées au calcul des vertices et des pixels. Dans ce cas, chaque GPU va traiter complètement toutes les vertices (gaspillage de ressources dans un sens, mais de toute manière ils ont des unités dédiées qui se tourneraient les pouces ci ce n'était pas le cas), mais seulement une partie des pixels, par exemple, les pixels d'une moitié de l'écran, d'une ligne sur 2, ou de différentes petites zones de l'écran. On parle alors de rendu SFR (split frame rendering). Répartir le calcul des pixels entre plusieurs GPUs est une solution plus adaptée, tout du moins avec les GPUs classiques qui disposent d'unités de traitement dédiées au calcul des vertices et des pixels. Dans ce cas, chaque GPU va traiter complètement toutes les vertices (gaspillage de ressources dans un sens, mais de toute manière ils ont des unités dédiées qui se tourneraient les pouces ci ce n'était pas le cas), mais seulement une partie des pixels, par exemple, les pixels d'une moitié de l'écran, d'une ligne sur 2, ou de différentes petites zones de l'écran. On parle alors de rendu SFR (split frame rendering).  Cette répartition du travail sur les pixels peut être statique (fixée une fois pour toutes) ou dynamique (qui varie en fonction de la complexité de calcul de chaque zone de l'écran et de la puissance de chaque GPU). Cette solution a l'avantage de pouvoir répartir le travail efficacement entre 2 GPUs de puissance différente si la répartition est dynamique, mais rend difficile des gains de performances importants dans certaines situations. Si son exploitation basique est "aisée", elle peut devenir extrêmement complexe avec des moteurs de jeu plus avancés.  Répartir les images à calculer entre les GPUs est la solution la plus efficace à l'heure actuelle. Avec l'AFR (alternate frame rendering), chaque GPU se charge alors du rendu complet d'une image et n'a pas à se soucier des autres GPUs. Le seul défi à surmonter consiste à s'assurer qu'il n'y ait pas de dépendance entre images. S'il est assez simple d'éviter cela, dans de nombreux cas il revient au développeur du jeu de le faire et non au fabricant du GPU qui est plus ou moins impuissant à ce niveau. C'est la raison pour laquelle la méthode précédente a été au départ privilégiée avant d'être remplacée progressivement dans la plupart des cas par l'AFR qui est plus performant. Répartir les images à calculer entre les GPUs est la solution la plus efficace à l'heure actuelle. Avec l'AFR (alternate frame rendering), chaque GPU se charge alors du rendu complet d'une image et n'a pas à se soucier des autres GPUs. Le seul défi à surmonter consiste à s'assurer qu'il n'y ait pas de dépendance entre images. S'il est assez simple d'éviter cela, dans de nombreux cas il revient au développeur du jeu de le faire et non au fabricant du GPU qui est plus ou moins impuissant à ce niveau. C'est la raison pour laquelle la méthode précédente a été au départ privilégiée avant d'être remplacée progressivement dans la plupart des cas par l'AFR qui est plus performant.Répartir dynamiquement des threads, soit des opérations diverses à exécuter sur des éléments divers aux aussi, est la prochaine étape. Il s'agira avec un peu d'abstraction de répartir la masse de calcul à exécuter entre différentes puces, d'une manière similaire à ce qui se passe entre les différentes unités d'une même puce. Il y a encore de nombreux défis à relever pour y parvenir, notamment au niveau de la communication entre les GPUs et leur mémoire, mais il semble évident que ce soit la voie à suivre pour le futur. Page 2 - Le fiasco du Quad SLI, 3 mieux que 4 ? Le fiasco du Quad SLIL'arrivée du triple SLI a rappelé à certains de mauvais souvenirs. Lancée en partenariat avec Dell début 2006, ouverte à plus de partenaires quelques mois après et enfin libre d'accès au début de l'été de la même année avec l'arrivée de la GeForce 7950 GX2, la technologie a dès le départ suscité quelques inquiétudes puisqu'en dehors d'une poignée de benchmarks, elle n'était pas fonctionnelle. La faute aux pilotes trop jeunes nous a-t-on dit au départ. La faute à Windows XP un peu plus tard.  Le Quad SLI n'a jamais réellement fonctionné. Ses malheureux acquéreurs se sont donc fait avoir en beauté et les justifications de Nvidia à ce sujet sont peu convaincantes. Selon nous la raison probable de ce fiasco et que le marketing a décidé de lancer cette technologie trop tôt, histoire de faire un maximum de bruit, et ce bien avant d'avoir une visibilité réelle sur l'ampleur du travail nécessaire pour développer des drivers dignes de ce nom. Nvidia a dû réaliser que les ressources nécessaires au développement rapide de ces pilotes étaient bien trop élevées par rapport au petit marché que le Quad SLI peut représenter et a probablement alors décidé de le laisser tomber. Les GeForce 8 allaient bientôt arriver, tout comme Windows Vista, créant une charge énorme en termes de développement, qui avait vous vous en doutez la priorité. Le Quad SLI n'a jamais réellement fonctionné. Ses malheureux acquéreurs se sont donc fait avoir en beauté et les justifications de Nvidia à ce sujet sont peu convaincantes. Selon nous la raison probable de ce fiasco et que le marketing a décidé de lancer cette technologie trop tôt, histoire de faire un maximum de bruit, et ce bien avant d'avoir une visibilité réelle sur l'ampleur du travail nécessaire pour développer des drivers dignes de ce nom. Nvidia a dû réaliser que les ressources nécessaires au développement rapide de ces pilotes étaient bien trop élevées par rapport au petit marché que le Quad SLI peut représenter et a probablement alors décidé de le laisser tomber. Les GeForce 8 allaient bientôt arriver, tout comme Windows Vista, créant une charge énorme en termes de développement, qui avait vous vous en doutez la priorité.Perdre son temps avec un Quad SLI principalement destiné à jouer à celui qui a la plus grosse pour l'image était donc hors de question. Les produits ayant déjà été lancés, Nvidia a fait semblant de rien et déporté la faute sur Windows XP pour répondre aux critiques. Quand bien même ce serait le cas il fallait évaluer la faisabilité avant. Vendre une technologie, quelle qu'elle soit, avant qu'elle ne soit fonctionnelle, reste inacceptable. Du coup des craintes ont ressurgi avec l'arrivée du 3-way SLI. 3 c'est mieux que 4 ?Il est évident qu'avant de lancer le triple SLI, Nvidia s'est assuré de ne pas retomber dans le même piège, d'autant plus que le fabricant était attendu au tournant. Mais pourquoi est-ce que ça marcherait plus maintenant qu'il y a 2 ans ? Pour différentes raisons.  Une raison communément évoquée est le fait que Windows Vista facilite la répartition des images entre plus de 2 GPUs. C'est probablement le cas, mais dans une mesure qui nous semble nettement inférieure à ce que prétend Nvidia pour qui ce prétexte est un très bon argument pour faire passer d'une part l'échec du Quad SLI et d'autre part la réduction drastique de l'investissement dans les pilotes destinés à Windows XP. Le 3-way SLI est donc limité exclusivement à Windows Vista à l'heure actuelle. Selon nous les raisons principales qui font que le 3-way SLI et même un "nouveau" Quad SLI sont viables aujourd'hui se résument en 2 points. Des pilotes qui ont mûris et qui disposent d'un réel investissement en terme de rendu multi-GPU puisqu'il s'agit là de la voie pour le futur et d'autre part des jeux qui prennent maintenant de plus en plus en compte le multi-GPU. Il devient donc de plus en plus souvent possible d'utiliser "simplement" un rendu AFR dont la gestion de 2 à 3 voire à 4 GPUs est grossièrement similaire. Nous sommes donc loin d'un quadruple SFR ou d'un AFR de SFR qui étaient des modes utilisés avec le Quad SLI en 2006, ou plutôt des modes annoncés mais que Nvidia n'a jamais réellement pu dompter. Page 3 - Les systèmes, les spécifications Les systèmesPour tester les différentes solutions multi-cartes, nous devons parler de systèmes puisque toutes ne sont pas compatibles avec toutes les cartes-mères. Ainsi, le SLI de Nvidia est réservé exclusivement à ses propres chipsets (à l'exception de la plateforme Skulltrail d'Intel). Le triple-SLI est pour sa part actuellement limité aux nForce 680i et 780i. Du côté d'AMD, nous avons droit à plus d'ouverture puisque CrossFire est fonctionnel, en plus des chipsets maisons, sur les chipsets Intel suivants : P35, P965, 975X et X38.  La plateforme CrossFire repose sur un chipset X38 que nous avons préféré à un chipset AMD puisque la plateforme Phenom ne nous a pas encore convaincu. Or pour passer en Core 2 tout en conservant CrossFire, il faut utiliser un chipset Intel. Nous avons opté pour une carte-mère P5E d'Asus qui nous permet de rester en DDR2 comme sur les plateformes Nvidia. 2 Radeon HD 3870 viennent former le couple graphique.  Pour la plateforme SLI, nous nous sommes basés sur la carte-mère eVGA nForce 680i. Celle-ci reste limitée au PCI Express 1.1 mais comme vous avez pu le lire dans notre dossier consacré au nForce 780i, son support du PCI Express 2.0 n'est pas idéal et n'apporte pas de gain conséquent. Qui plus est les GeForce 8800 Ultra ne supportent pas le PCI Express 2.0. En plus des GeForce 8800 Ultra, nous avons testé un couple de GeForce 8800 GT.  Enfin, la plateforme 3-way SLI est bien sûr identique, à ceci près que cette fois ce sont 3 GeForce 8800 Ultra qui viennent s'y installer de manière à former le système ultime sur le plan graphique à l'heure actuelle. Les spécifications  Si le système 3-way SLI permet de faire exploser les capacités graphiques, cela se paye au prix fort puisqu'il faut investir dans 3 GeForce 8800 Ultra ou GTX. Rappelons que si la puissance de calcul et la bande passante mémoire s'additionnent dans un système multi-GPU, il n'en est rien de la quantité mémoire puisque les données sont dupliquées dans chaque mémoire locale. Qui plus est, le fonctionnement multi-GPU entraîne une consommation mémoire plus élevée. Ne serait-ce que pour pouvoir recevoir le travail des autres GPUs, il faut leur réserver une zone mémoire sur la carte graphique "maître". Par conséquent la pression sur la mémoire augmente quelque peu en SLI et en CrossFire. Il faudra donc à tout prix éviter d'associer des cartes graphiques en version bradées mais équipées de moins de mémoire (HD 3850 256 Mo et autres GeForce 8800 GT 256 Mo), bien qu'à priori vous pourriez penser qu'il s'agit là de bonnes affaires. Page 4 - La consommation, la mise en place, le test La consommationNous avons mesuré la consommation des différents systèmes. Ces données sont obtenues à partir des mesures effectuées à la sortie de la prise de courant : il s’agit donc de la consommation totale de l’alimentation de la machine, ici une Cooler Master Real Power M1000 (1000 watts). Nous avons ajouté la consommation d'un système équipé d'une Radeon HD 3870 mais basé sur le plateforme nForce 680i comme toutes les GeForce de manière à donner une idée de la différence de consommation liée à la carte-mère et au chipset.  L'utilisation du 55 nanomètre et du PowerPlay pour réduire la consommation permet au Radeon HD 3870 de rester très économes au repos. Une situation complètement différente dans le cas des GeForce 8800 Ultra qui sont, elles, très gourmandes. Une seule de ces cartes consomme ainsi plus que 2 GeForce 8800 GT ! Si la consommation des GeForce 8800 Ultra en charge peut être acceptée puisqu'il s'agit d'un système ultra haut de gamme, la consommation au repos est plus problématique. Chacune de ces cartes consomme au repos près de 100 watts, soit 300 watts gaspillés inutilement par l'ensemble… Quoi qu'il en soit il faudra veiller à disposer d'une alimentation à la hauteur pour profiter de tels systèmes. La mise en placeActiver le SLI ou le CrossFire dans les pilotes est très simples puisqu'il suffit de cocher une case dans le panneau qui leur est dédié. Tant AMD que Nvidia intègrent dans leurs pilotes une version hardware et software de leur technologie multi-GPU. La version hardware exploite la logique dédiée présente dans les GPUs ainsi qu'un connecteur spécifique pour transférer les informations (ou tout du moins une partie la plus importante possible) d'une carte à l'autre. C'est le mode le plus performant. La version software se contente du bus PCI Express pour transférer toutes les données entre les cartes et est donc un peu moins performante.   Les connecteurs CrossFire et le connecteur 3-way SLI. Nous avons bien entendu utilisé la version hardware dans tous les cas. Du côté de CrossFire, 2 connecteurs sont requis actuellement, un pour chaque direction. AMD nous a cependant indiqué que dans le futur un seul serait nécessaire. Du côté de Nvidia, un seul connecteur est requis pour le SLI, mais un connecteur spécial doit être utilisé pour le triple SLI. Celui-ci permet de relier toutes les cartes entre elles (la 1 à la 2, la 2 à la 3 et la 3 à la 1) mais n'était pas livré avec les cartes-mères nForce 680i. Il faudra donc penser à l'acquérir. Les cartes-mères nForce 780i l'incluent dans leur bundle. Notez que pour le SLI, Nvidia autorise également la version software. Ce n'est pas le cas du CrossFire avec 2 Radeon HD 3870 ni du triple SLI qui n'est activable qu'une fois le connecteur spécial mis en place. Le testPour ce test, nous avons fait appel à 10 jeux dont 4 supportent DirectX 10. Les tests ont été exécutés en 1920x1200 et en 2560x1600, la résolution des écrans 30". Le filtrage anisotrope ainsi que le HDR ont été activés dans tous les cas où ils sont disponibles dans le jeu. Enfin, le transparency/adaptive antialiasing était activé en mode multisampling. Toutes les mises à jour pour Windows Vista relatives aux performances et au multi-GPU ont bien entendu été installées. ConfigurationIntel Core 2 Extreme QX6850 eVGA nForce 680i SLI (GeForce) Asus P5E (Radeon) 2 Go DDR2 Windows Vista Forceware 169.04 (169.28b pour Crysis) Catalyst 8.1 hotfix. Page 5 - Enemy Territory : Quake Wars Enemy Territory : Quake Wars  Si Quake Wars est basé sur le moteur de Doom 3, celui-ci a subi quelques évolutions telles que le megatexturing qui permet de faciliter le travail des artistes mais entraine un surcout au niveau du "décodage" et de l'accès aux megatextures. Quake Wars est donc un petit peu plus gourmand que Doom 3 et Quake 4. Nous avons enregistré une démo lors d'une partie contre 4 bots. L'intelligence artificielle n'étant pas reproduite lors du timedemo, elle ne limite pas les résultats qui sont donc moins limités par le CPU qu'en situation réelle, tout du moins contre des bots. Toutes les options sont poussées au maximum dans le jeu, ce qui inclus un filtrage anisotrope 16x. Le patch 1.2 est utilisé.  Dans ce premier test, le SLI se comporte mieux que CrossFire. Par contre le triple SLI est ici limité par le CPU.  Une fois l'antialiasing activé, le triple SLI prend la tête mais les GeForce 8800 GT voient leurs performances plonger en SLI et en 2560x1600 à cause d'un manque de mémoire vidéo. Page 6 - Half Life 2 Episode 2 Half Life 2 Episode 2  Toujours basé sur le Source Engine, Half Life 2 Episode 2 n'apporte pas de réelle nouveauté sur le plan technique et se contente de mieux utiliser et d'utiliser plus souvent ce dont est capable le moteur, ce qui rend le jeu plus gourmand que ses prédécesseurs. Nous exécutons une démo et toutes les options du jeu sont poussées au maximum, y compris le filtrage anisotrope qui est donc en 16x.  Dans Half Life 2 Episode 2, CrossFire s'en tire mieux que le SLI, surtout en "basse" résolution. Le triple SLI souffre ici d'un problème et réduit les performances par rapport au SLI classique.  Avec antialiasing, CrossFire perd son avantage, mais le triple SLI réduit toujours les performances. Page 7 - S.T.A.L.K.E.R. S.T.A.L.K.E.R.  Nous effectuons un déplacement toujours identique et mesurons le framerate avec fraps. Nous testons le jeu avec un niveau de qualité élevé, éclairage dynamique complet, détails maximums (avec filtrage anisotrope 16x) et ombres des herbes. S.T.A.L.K.E.R. utilise un moteur à base de rendu différé ce qui est fondamentalement incompatible avec du MSAA, ce qui rends l'utilisation de l'antialiasing impossible. Une espèce de filtrage des arrêtes réalisé via un shader est activable mais il offre un résultat mitigé voir invisible, nous ne l'avons donc pas utilisé. Le patch 1.00004 est utilisé.  CrossFire affiche des gains très élevés, mais le SLI s'en tire également plutôt bien, à l'exception des 8800 GT en 2560x1600 qui semblent quelque peu bridée par leur 512 Mo, ce qui réduit le gain. Pour le triple SLI, le résultat n'est pas très intéressant puisque les performances baissent par rapport au SLI. Page 8 - Rainbow Six : Vegas Rainbow Six : Vegas  Premier jeu PC basé sur l'Unreal Engine 3.0, Rainbow Six : Vegas reste un jeu très gourmand. Nous mesurons les performances sur la scène d'introduction. Le mode HDR est activé et est plus ou moins obligatoire sans quoi le banding est très présent. Les ombres sont réglées sur "bas", les modes supérieurs entraînant une trop forte baisse de performances dans certains endroits.  Portage de la Xbox 360, le jeu semble naturellement bien aimer les Radeon HD qui partagent une architecture similaire à celle de la puce graphique de la console. Il en va de même pour CrossFire qui affiche un gain presque parfait. SLI et triple SLI affichent eux aussi de très bonnes performances bien que même en 2560x1600, le SLI est suffisant.  Le jeu ne supporte pas l'antialiasing mais Nvidia l'a implémenté dans ses drivers, tout comme pour Oblivion, contrairement à AMD qui ne s'est malheureusement pas donné cette peine. Cette fois, en 2560x1600, le triple SLI apporte un surplus de fluidité qui est plutôt utile. Les gains sont relativement élevés à tout niveau dans ce jeu. Page 9 - Oblivion Oblivion  Nous effectuons un déplacement précisément défini afin qu’il soit toujours identique et que le test soit reproductible. Le HDR est bien entendu de la partie.  Toutes les solutions multi-cartes sont ici limitées par le CPU, une seule carte graphique étant en général suffisante, même si 2 apportent un peu plus de confort en 2560x1600  Une fois le FSAA 4x activé, les solutions multi-cartes deviennent utiles, nous noterons par ailleurs le bon résultat des Radeon HD 3870 en CrossFire qui égalent presque les GeForce 8800 Ultra en SLI. Le triple SLI n'est ici pas très utile. Page 10 - Colin McRae DIRT Colin McRae DIRT  Pour tester le dernier opus des Colin McRae, qui est très gourmand, nous réalisons un déplacement bien défini en mode qualité élevée. Notez que l'activation de l'antialiasing est vivement conseillée compte tenu de la manière dont sont rendus les menus et du fait que les effets de post process employés amplifient l'aliasing. Le patch 1.2 est appliqué.  Colin McRae est la bête noire du multi-GPU, ce qui nous rappelle malheureusement que les jeux moins "tape à l'œil" qui sont moins utilisés pour faire la une en matière de performances ne reçoivent pas toujours un support satisfaisant de la part d'AMD et Nvidia. En CrossFire, les sprites qui représentent le public clignotent à tout va, en SLI, bien que les performances augmentent, des saccades énormes rendent le jeu injouable.  Même problème avec antialiasing. Il faudra donc désactiver le SLI ou CrossFire pour jouer à ce jeu. Page 11 - Bioshock Bioshock  Premier jeu basé sur l'Unreal Engine 3.0 à supporter DirectX 10, Bioshock est un jeu très réussi graphiquement et ce même en mode DirectX 9 alors qu'il est moins gourmand que Rainbow Six : Vegas. Nous effectuons un déplacement bien défini et toutes les options sont poussées au maximum.  L'Unreal Engine 3.0 est décidemment très apprécié par les systèmes multi-GPUs. Les gains sont ici très élevés. Compte tenu des chiffres très élevés, le triple SLI n'a pas d'intérêt pratique ici.  Tout comme pour Rainbow Six : Vegas, Nvidia permet d'activer l'antialiasing dans ce jeu qui ne le supporte pas à la base. AMD ne le permet pas.  En mode DirectX 10, les performances des GeForce 8 restent similaires à ce que nous avons pu obtenir en mode DirectX 9, par contre les gains en SLI et triple SLI sont moins élevés. Ce n'est pas le cas du côté de CrossFire mais les performances des Radeon HD 3870 sont à la base revues à la baisse en DirectX 10. Notez qu'il n'est pas encore possible d'activer d'antialiasing en mode DirectX 10, tant chez Nvidia que chez AMD. Page 12 - Company of Heroes Company of Heroes  Company of Heroes ayant reçu un patch DirectX 10 qui apporte un réel plus sur le plan graphique, nous avons décidé de l'ajouter à notre protocole de test. Toutes les options sont poussées à leur maximum, à l'exception des détails du terrain qui restent sur High (le mode Ultra étant réservé à DirectX 10) et des textures qui restent elles aussi sur High, le jeu indiquant un manque de mémoire système sur les GeForce en mode DirectX 9 avec les textures Ultra. Nous exécutons le test intégré sur la version 1.71.  Company of Heroes affiche lui aussi des gains très élevés en multi-GPU. Le triple SLI n'est pas utile ici. En fait, une carte est en général suffisante.  Situation identique avec antialiasing 4x activé, excepté pour les joueurs exigeants qui jouent en 2560x1600.  En DirectX 10, les performances sont clairement inférieures, le moteur affichant des graphismes plus avancés. Cette fois 2 cartes graphiques sont utiles même pour le 1920x1200. Les Radeon HD 3870 ne permettent pas de jouer en 2560x1600 dans ces conditions avec un confort suffisant.  Le triple SLI devient ici utile en 2560x1600. Page 13 - World in Conflict World in Conflict  Très réussi visuellement et très gourmand, il était logique de voir World in Conflict joindre notre suite de tests. Nous exécutons le test interne avec le patch 1.0002. Toutes les options sont poussées au maximum. Nous avons utilisé les Catalyst 7.12 pour ce jeu, les 7.11b ne fonctionnant pas correctement en CrossFire.  CrossFire souffre d'un bug plutôt gênant en DirectX 9 et ce même avec les Catalyst 7.12 et 8.1 : les textes sont brouillés ce qui rend impossible la navigation dans les menus. Si le SLI peut avoir ici un intérêt, le triple SLI lui n'en a pas réellement vu la limitation CPU. Etant donné qu'il entraîne une charge légèrement plus élevée à ce niveau ses performances sont mêmes quelque peu réduites.  Avec antialiasing 4x, les performances des GeForce 8800 GT en 2560x1600 s'effondrent par manque de mémoire vidéo.  En DirectX 10, CrossFire fonctionne correctement et apporte même un gain plus élevé que le SLI ce qui place les Radeon HD 3870 devant les GeForce 8800 GT. Le triple SLI ne se démarque toujours pas.  Les performances des GeForce 8800 GT s'effondrent ici aussi en 2560x1600 et ce dans des proportions encore plus élevées. Le triple SLI affiche un gain mais il reste trop réduit que pour être réellement utile. Page 14 - Crysis Crysis  Jeu incontournable, Crysis a été testé avec son patch en version 1.1 (optimisé pour le multi-GPU) ainsi qu'avec les derniers drivers en date spécifiques à ce patch : les Forceware 169.28b et les Catalyst 8.1 hotfix. Nous exécutons le test interne en mode DirectX 9 High (forcé via l'ajout de –dx9 derrière l'exécutable) et en mode DirectX 10 Very High. N'ayant plus accès à un écran 30" quand le patch est sorti, nous nous sommes limités à la résolution de 1920x1200, mais au vu des résultats, vous comprendrez sans difficulté qu'il n'est pas encore question de pouvoir jouer en 2560x1600 dans ce jeu !  Première remarque, la démo GPU intégrée à Crysis est limitée par le CPU à plus ou moins 35 fps. Le triple SLI ne peut donc pas s'exprimer ici et affiche même un petit recul par rapport au SLI étant donné son coût de gestion supérieur.  Avec antialiasing 4x, nous retrouvons une situation similaire bien que le nombre de fps soit un petit peu plus réduit. Il est donc possible que le triple SLI ne soit pas réellement fonctionnel dans Crysis en mode DirectX 9. Les performances des GeForce 8800 GT plongent en SLI, les GPUs étant trop à l'étroit avec "seulement" 512 Mo.  En DirectX 10 et tous les détails poussés à leur maximum, le triple SLI affiche enfin un gain, bien que timide. CrossFire est ici moins efficace que le SLI mais cela devrait s'améliorer puisque la Radeon HD 3870 X2 affiche, elle, des gains plus élevés.  Enfin, en DirectX 10 et avec antialiasing 4x, aucune de ces solutions n'est à la hauteur. Les GeForce 8800 GT en SLI souffrent ici encore d'un manque de mémoire. Page 15 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en se basant sur l'ensemble de résultats et en donnant le même poids à chacun des jeux. L'indice 100 a été attribué à la GeForce 8800 GT en 1920x1200. Rappelons que Crysis n'a été testé qu'en 1920x1200 et n'est donc pris en compte pour la moyenne que dans cette résolution.  En moyenne, les GeForce 8800 GT et Radeon HD 3870 affichent des performances très proches, par contre les 8800 GT prennent l'avantage en SLI. Le triple SLI a ici du mal à s'exprimer puisqu'il est souvent limité par le CPU, même en 2560x1600.  Avec le filtrage antialiasing 4x activé, il en a de même pour le triple SLI. Si les GeForce 8800 GT en SLI affichent de très bons résultats en 1920x1200, leurs performances plongent en 2560x1600 dans de nombreux jeux, ce qui les place en moyenne derrière une seule GeForce 8800 Ultra. Quant aux Radeon HD 3870, leurs ROPs bugués au niveau de l'antialiasing ont poussé AMD à utiliser une solution de rechange qui, si elle est très flexible, bride les performances. Du coup elles ne brillent pas dans ces conditions. Notez que les résultats obtenus sous Rainbow Six : Vegas et Bioshock ne sont pas pris en compte ici puisque les Radeon HD 3870 ne sont pas capables d'afficher de l'antialiasing dans ces jeux. Vous pouvez consulter le graphe qui les prend malgré tout en compte ici.  Avec les jeux DirectX 10, cette fois le triple SLI affiche un intérêt, surtout en 2560x1600. Ce n'est pas réellement lié à DirectX 10 mais plutôt aux rendus plus gourmands. SLI et CrossFire se comportent eux aussi plutôt bien.  En DirectX 10 et avec FSAA 4x, nous retrouvons une situation très proche à ceci près qu'en 2560x1600, les GeForce 8800 GT en SLI (et même seule) affichent des performances très faibles, n'étant pas à l'aise avec seulement 512 Mo alors que les Radeon HD 3870 s'en accommodent plutôt bien. Page 16 - Gains en 1920x1200 Gains en 1920x1200Nous avons mis en graphiques les gains de performances tirés des résultats obtenus dans les jeux de manière à les faire apparaître plus clairement. Si aucun résultat n'est donné, cela veut dire que le multi-GPU souffrait d'un bug qui rendait le jeu injouable. Un gain de 0% indique soit que le multi-GPU n'apporte pas de gain soit qu'il réduit les performances auquel cas il sera désactivé par le joueur. Nous n'avons donc pas pris en compte les résultats négatifs, mais bien des gains de 0% à la place. Notez que les gains du triple SLI doivent être comparés aux gains du SLI de GeForce 8800 Ultra et non du SLI de 8800 GT puisque celles-ci sont moins limitées par le CPU et profitent donc de plus de marge.  Les gains affichés par le SLI avec les 8800 GT et par CrossFire sont globalement similaires, chacun ayant un petit avantage dans certains jeux. Les gains sont moins élevés avec les GeForce 8800 Ultra étant donné qu'elles sont plus souvent limitées par le CPU. Le triple SLI n'est ici pas très intéressant.  Avec le filtrage antialiasing 4x activé, la charge augmente sur le système graphique ce qui permet, en théorie à tous les systèmes de mieux s'exprimer. Tous affichent donc des gains plus élevés que sans antialiasing, excepté les Radeon HD 3870. Pour une raison qui nous est inconnue, les faibles performances avec ce filtre semblent parfois amplifiées en CrossFire. Le triple SLI reste ici aussi peu intéressant.  Avec les jeux DirectX 10, cette fois le triple SLI affiche un intérêt. CrossFire est ici en retrait à cause d'un gain réduit dans Crysis.  CrossFire reprend du poil de la bête en DirectX 10 et avec FSAA 4x et affiche cette fois des gains assez réguliers et importants dans les 3 jeux testés. Page 17 - Gains en 2560x1600 Gains en 2560x1600Nous avons mis en graphiques les gains de performances tirés des résultats obtenus dans les jeux de manière à les faire apparaître plus clairement. Si aucun résultat n'est donné, cela veut dire que le multi-GPU souffrait d'un bug qui rendait le jeu injouable. Un gain de 0% indique soit que le multi-GPU n'apporte pas de gain soit qu'il réduit les performances auquel cas il sera désactivé par le joueur. Nous n'avons donc pas pris en compte les résultats négatifs, mais bien des gains de 0% à la place. Notez que les gains du triple SLI doivent être comparés aux gains du SLI de GeForce 8800 Ultra et non du SLI de 8800 GT puisque celles-ci sont moins limitées par le CPU et profite donc de plus de marge.La résolution de 2560x1600 devrait montrer des gains plus importants :  Les gains affichés sont effectivement plus élevés qu'en 1920x1200, ce qui profite avant tout aux GeForce 8800 Ultra en SLI et en triple SLI.  Avec le filtrage antialiasing 4x activé, le CrossFire affiche une nouvelle fois des gains plus réduits que sans ce filtre alors que nous devrions obtenir un résultat opposé. Cette fois les GeForce 8800 GT en SLI affichent elles aussi un gain en repli, mais dans leur cas, le problème vient de la mémoire qui est insuffisante. Pour une raison inconnue la pression sur la mémoire est plus élevée chez Nvidia que chez AMD.  Avec les jeux DirectX 10, et dans cette résolution, le triple SLI affiche un intérêt évident.  Le manque de mémoire des GeForce 8800 GT est une nouvelle fois flagrant. Page 18 - Récapitulatif des gains Récapitulatif des gainsPour en finir avec tous ces chiffres, nous vous proposons un graphique qui reprend tous les gains moyens par mode de rendu :  Ces résultats globaux ne permettent pas de départager le SLI et le CrossFire. Ces 2 technologies se valent, mais suivant les produits et les conditions, l'une sera devant l'autre et vice versa. En dehors des jeux récents, il faudra jouer en 2560x1600 pour profiter du triple SLI, ce qui était un résultat attendu. En théorie, les gains affichés par les GeForce 8800 GT devraient toujours être plus élevés que les gains affichés par les 2 GeForce 8800 Ultra. Ce n'est cependant plus le cas dès que l'on monte en complexité, les GeForce 8800 GT étant trop à l'étroit avec 512 Mo. Page 19 - Conclusion ConclusionComme nous le rappelons régulièrement, nous estimons que les systèmes multi-cartes ne prennent d'intérêt que sur le haut de gamme, de manière à pouvoir offrir un niveau de performances supérieur à ce qui se fait de mieux avec une seule carte graphique. Ceci principalement parce que l'évolution rapide de celles-ci rend la mise à jour du système via l'adjonction d'une seconde carte graphique milieu ou bas de gamme peu intéressante par rapport à son remplacement.  D'autant plus que les systèmes multi-cartes sont accompagnés d'un certain nombre d'inconvénients tels qu'une consommation et un encombrement revus à la hausse, mais également des résultats variables, parfois très bons, parfois moins, et des bugs plus nombreux qu'avec une seule carte graphique. Les systèmes multi-cartes ne sont donc pas encore prêts pour se démocratiser et sont à réserver aux utilisateurs avancés qui auront pris connaissance des aspects négatifs et qui suivront l'actualité de près de manière à toujours disposer des derniers pilotes.  Si les pilotes ont fortement évolué, tant du côté de Nvidia que d'AMD, SLI et CrossFire étant selon nous sur un pied d'égalité à ce niveau, ils n'affichent toujours pas la même robustesse qu'avec une seule carte graphique. De petits bugs subsistent, surtout dans les jeux qui sont moins sous le feu des projecteurs. Si les pilotes ont fortement évolué, tant du côté de Nvidia que d'AMD, SLI et CrossFire étant selon nous sur un pied d'égalité à ce niveau, ils n'affichent toujours pas la même robustesse qu'avec une seule carte graphique. De petits bugs subsistent, surtout dans les jeux qui sont moins sous le feu des projecteurs. Dans la majorité des jeux gourmands, les résultats sont à la hauteur. Une solution à base de 2 Radeon HD 3870 ou de 2 GeForce 8800 GT permet donc de s'offrir des performances de premier plan, mais pas toujours. Ainsi les Radeon HD 3870 affichent des résultats quelque peu décevants une fois l'antialiasing activé et un niveau de performances similaire à celui affiché par la Radeon HD 3870 X2 qui sera souvent plus intéressante.  Du côté des GeForce 8800 GT nous retrouvons également une limitation, au niveau de la mémoire dans ce cas particulier. Pour une raison qui nous est inconnue, les GeForce 8 semblent soit avoir besoin de plus de mémoire que les Radeon HD, soit faire un moins bon usage de la mémoire disponible. Du coup les 512 Mo limitent les performances dans certains jeux en résolution élevée et avec antialiasing activé. Une fois en SLI, cette consommation mémoire augmente encore un petit peu plus et les performances chutent au lieu de progresser. Ce couple SLI est donc plus à conseiller pour jouer en 1920x1200 dans des jeux complexes que pour jouer en 2560x1600 avec antialiasing en activant moins d'options ou avec des jeux plus simples. Du côté des GeForce 8800 GT nous retrouvons également une limitation, au niveau de la mémoire dans ce cas particulier. Pour une raison qui nous est inconnue, les GeForce 8 semblent soit avoir besoin de plus de mémoire que les Radeon HD, soit faire un moins bon usage de la mémoire disponible. Du coup les 512 Mo limitent les performances dans certains jeux en résolution élevée et avec antialiasing activé. Une fois en SLI, cette consommation mémoire augmente encore un petit peu plus et les performances chutent au lieu de progresser. Ce couple SLI est donc plus à conseiller pour jouer en 1920x1200 dans des jeux complexes que pour jouer en 2560x1600 avec antialiasing en activant moins d'options ou avec des jeux plus simples.Pour les amateurs de performances ultimes et de hautes résolutions avec antialiasing, il faudra passer par les GeForce 8800 GTX ou Ultra, mais là, le budget explose pour atteindre 1800 € rien que pour les cartes graphiques en triple SLI ! Une solution élitiste qui sera clairement à réserver à quelques joueurs fortunés qui auront pris la peine de vérifier qu'un tel système est adapté à leur écran et aux jeux pratiqués puisque les gains ne sont à l'heure actuelle intéressants que dans une poignée de jeux. Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |