| |

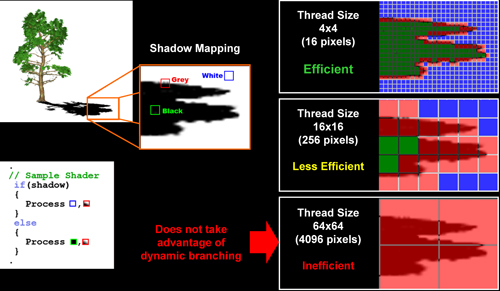

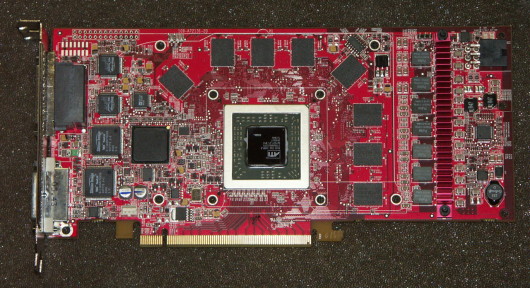

| Radeon X1900 XTX, X1900 XT et X1900 CrossFire en test Cartes Graphiques Publié le Mardi 24 Janvier 2006 par Damien Triolet URL: /articles/605-1/radeon-x1900-xtx-x1900-xt-x1900-crossfire-test.html Page 1 - Introduction, Pipelines En octobre dernier, ATI lançait avec plusieurs mois de retard le Radeon X1800 XT. Ses retards ne s´arrêtaient cependant pas là puisqu´il n´a été réellement disponible qu´à partir de novembre et décembre. En cause un problème de fabrication qui empêchait son fonctionnement aux fréquences visées et nécessaires pour devancer le GeForce 7800 de Nvidia. Parallèlement à la résolution de ces problèmes, son successeur était déjà en phase de finalisation sans connaître de réel souci ce qui lui permet d´arriver à l´heure. Enfin presque à l´heure puisqu´il était prévu pour fin 2005, mais étant donné qu´ATI s´est focalisé sur le X1800 ce petit retard n´a rien d´étonnant. Ce Radeon X1900, qui a déjà fait couler beaucoup d´encre, pourrait être vu comme une réponse au GeForce 7800 GTX 512 Mo lancé par Nvidia pour faire un pied de nez à ATI en novembre dernier. Mais en ce qui concerne ce GPU, ATI suit une roadmap planifiée il y a longtemps, même si elle entraîne le renouvellement du haut de gamme moins de 3 mois après son arrivée réelle sur le marché.  PipelinesLes rumeurs, discussions et interprétations sur les spécifications de ce GPU ont été nombreuses. Qu´en est-il réellement ? 16 pipelines ? 48 pipelines ? Mais qu´est-ce que c´est un pipeline ? A l´origine, lorsque l´on parlait de pixel pipeline, ou de pipeline tout court, on décrivait la chaîne de fabrication de pixels la plus basique qu´il soit : une unité de texturing raccordée à un ROP qui se charge, lui, de placer le fragment (qui est un candidat pixel) dans l´image, c´est-à-dire au bon endroit dans la mémoire vidéo. Avec l´évolution des GPUs, ceux-ci se sont vus adjoindre d´autres unités que l´unité de texturing pour arriver à un long pipeline qui contenait une ou deux unités de texturing, des unités de calcul et un ROP devenu plus complexe puisque capable de gérer les transparences (blending) et l´antialiasing de type multisample. Il est alors apparu que le ROP pouvait être dissocié du reste, ce qui fait que quand on parle de pipeline, c´est de ce reste que l´on parle. Les ROPs définissent le fillrate, c´est-à-dire le nombre de pixels qui peuvent être écrit en mémoire chaque seconde. Cette écriture consomme de la bande passante (64 bits par pixel, 96 bits en FP16/HDR, 160 bits en FP32, plus le blending...) et il apparaît évident que les 512 bits que peut transporter le bus mémoire chaque cycle (256 bits DDR), même avec les technologies de compression des données, ne peuvent pas recevoir les données d´un nombre très élevé de ROPs. 16 ROPs représentent le maximum raisonnable sur un bus mémoire 256 bits. La séparation des ROPs du reste permet d´augmenter ce reste à moindre coût sans ajouter de ROPs inutiles. Chez Nvidia, ce reste est une longue chaîne de fabrication de pixel (ou fragment), qui contient plusieurs unités de calcul en série dont l´une pilote l´unité de texturing. Cette longue chaîne est nécessaire pour masquer la latence requise par l´accès aux textures. La fabrication d´un pixel consiste à calculer un pixel shader et étant donné que celui-ci peut-être très long, il requiert en général plusieurs passages dans le pipeline, qu´il est logique de qualifier de pipeline de pixel shading. Chez ATI, le fonctionnement est un petit peu différent puisque les Radeon disposent de pipelines de pixel shading et de pipelines de texturing dissociés. Etant donné que la longueur du pipeline est utilisée pour masquer la latence du texturing, il est possible de n´utiliser qu´un très court pipeline pour la partie pixel shading. Par contre le système de gestion doit être plus complexe puisqu´il doit envoyer les pixels dans le bon pipeline au bon moment. Ainsi un pixel va faire un ou plusieurs allers-retours entre le pipeline de pixel shading et le pipeline de texturing. Les Radeon 9700 à X850 disposaient déjà d´une telle architecture, mais pas d´un système de gestion évolué ce qui fait qu´ATI ne pouvait pas en exploiter toute la flexibilité. Les Radeon X1000 en sont, elles, capables.  Avec le Radeon X1900, ATI a décidé d´augmenter le nombre de pipelines de pixel shading. Par contre les pipelines de texturing restent, eux, à 16. Le choix d´ATI est basé sur le fait que le nombre d´instructions mathématique dans un shader augmente beaucoup plus vite que celui des accès aux textures, ce qui est tout à fait vrai. Nvidia pense la même chose puisque les pipelines de pixel shading des GeForce 6 et 7 disposent chacun de 2 unités de calcul. Le but est le même que celui d´ATI, mais la stratégie est différente. Pour Nvidia, étant donné que la partie destinée à masquer la latence du texturing est intégrée dans le pipeline de pixel shading, il représente un grand nombre de transistors et en placer plus est très coûteux alors qu´ajouter une unité de calcul supplémentaire en série est relativement aisé. Chez ATI un pipeline de pixel shading est très petit ce qui fait qu´il est peu coûteux à ajouter. Avec le Radeon X1900, ATI a décidé d´augmenter le nombre de pipelines de pixel shading. Par contre les pipelines de texturing restent, eux, à 16. Le choix d´ATI est basé sur le fait que le nombre d´instructions mathématique dans un shader augmente beaucoup plus vite que celui des accès aux textures, ce qui est tout à fait vrai. Nvidia pense la même chose puisque les pipelines de pixel shading des GeForce 6 et 7 disposent chacun de 2 unités de calcul. Le but est le même que celui d´ATI, mais la stratégie est différente. Pour Nvidia, étant donné que la partie destinée à masquer la latence du texturing est intégrée dans le pipeline de pixel shading, il représente un grand nombre de transistors et en placer plus est très coûteux alors qu´ajouter une unité de calcul supplémentaire en série est relativement aisé. Chez ATI un pipeline de pixel shading est très petit ce qui fait qu´il est peu coûteux à ajouter.Tout ceci est relativement complexe et il faut trouver un moyen simple de le décrire. Auparavant, on parlait de pixel pipeline et d´unité de texturing, notés par exemple 4 x 2 ce qui signifiait 4 pipelines avec 2 unités de texturing chacun. Comment décrire en 2 chiffres une architecture actuelle ? Selon nous, la meilleure solution (ou la moins pire) est de le faire de la même manière ! A une petite nuance près : il faut parler de pipeline de pixel shading au lieu de pixel pipeline. Reste que le nombre d´unités de calcul n´est pas précisé, mais même indiquer ce nombre ne serait pas suffisant puisque l´efficacité des unités est aussi très importante. Au lieu de parler d´un certain nombre d´unités de calcul avec une certaine efficacité il est plus simple d´en faire abstraction et de parler simplement d´un pipeline de pixel shading capable d´une certaine efficacité. Ce paramètre étant variable il n´y a pas de moyen de l´indiquer d´une manière globale. Autrement dit selon nous, le plus simple reste de parler d´un GeForce 7800 GTX comme d´une architecture 24 x 1 et du X1800 comme une architecture 16 x 1. 48 pipelines pour le X1900, c´est vraiSuivant cela, qu´en est-il du Radeon X1900 ? La situation se complique puisqu´ATI y a intégré pas moins de 48 pipelines de pixel shading, ce qui donne, avec les 16 pipelines de texturing, 64 pipelines en tout. Parler de 64 pipelines amènerait de la confusion et ne correspondrait au modèle classique que l´on a l´habitude d´utiliser. Le plus simple est donc de parler d´une architecture 48 x 0.33, ce qui indique une puissance de calcul globale élevée mais réduite au niveau du texturing. Bien entendu, comme toute notation simple, elle est sujet à discussion. Si l´on veut décrire l´architecture plus fidèlement, il faut alors parler de 24 pipelines de pixel shading complexes pour le 7800 GTX, capables de traiter 2 instructions (dont éventuellement une de texturing) et de 64 pipelines de pixel shading simples pour le Radeon X1900 (dont 48 sont capables de traiter les instructions mathématiques et 16 celles de texturing).  ATI est cependant réticent à qualifier lui-même son GPU d´une architecture à 48 pipelines, plus que probablement par peur d´être critiqué par une attente non comblée de performances triplées par rapport à une architecture 16 pipelines. Mais aurait-il fallu parler de 2 GHz au lieu de 3 GHz pour un Pentium 4 simplement parce que l´Athlon a un meilleur rendement à fréquence égale ? Ce changement fait passer le nombre de transistors de 321 millions à 384 millions soit une augmentation de 20%. Page 2 - Spécifications, Pixel shaders Les spécificationsCet éclaircissement étant fait, passons aux spécifications concrètes des nouvelles cartes :  Le seul changement apporté au Radeon X1900 en terme d´unités de calcul concerne donc l´augmentation de pipelines de pixel shading, le reste ne bouge pas par rapport au X1800. Nous avons mis en évidence 3 lignes qui nous semblent importantes dans la compréhension des performances de ces GPUs. La première concerne le fillrate qui était déjà supérieur sur la Radeon X1800 par rapport à la 7800 GTX 512 Mo. Celui-ci étant qui plus est limité par le bus mémoire il n´y avait donc pas intérêt à l´augmenter, ce qui explique qu´il reste similaire sur les Radeon X1900. La seconde concerne la puissance de texturing et, là, Nvidia avait déjà un avantage de 30% mais ATI n´a pas estimé nécessaire ou a estimé trop coûteux de mieux équiper le X1900 à ce niveau. Nvidia conserve donc ici son avantage. La troisième ligne concerne la puissance de calcul mathématique, nous avons ici compté 2 instructions par cycle pour les GeForce contre une pour les Radeon, mais il faut savoir que tout cela est en réalité bien plus complexe. Néanmoins il apparaît que le Radeon X1800 avait un très large déficit de puissance de calcul par rapport au GeForce 7800 GTX et un énorme gouffre le sépare du 7800 GTX 512 Mo. Avec le Radeon X1900 ATI a décidé de faire disparaître ce gouffre sans quoi Nvidia aurait pris un très gros avantage sur les pixel shader complexes qui seront utilisés dans les jeux futurs. C´est un point très important puisque avec les jeux actuels on a l´habitude de penser que la Radeon X1800 est comparable au GeForce 7800 en terme de puissance de calcul alors que ce n´est pas le cas. ATI devait augmenter la puissance de calcul du X1800 pour le rééquilibrer. Reste que Nvidia conserve un avantage au niveau du texturing, l´architecture d´ATI n´est donc pas parfaite mais une architecture peut-elle l´être alors que de nombreux compromis sont de rigueur ? Pour terminer, vous noterez la très faible différence entre la Radeon X1900 XT et le modèle XTX : +4% en puissance de calcul et +7% en bande passante mémoire. C´est léger et ça ne justifie pas la différence de prix puisque la première est annoncée à 549€ contre 649€ pour la seconde ! Pixel shader : puissance de calculNous avons mis en graphique la puissance de calcul des X1800 XT, X1900 XTX et 7800 GTX 512 Mo en laissant comme paramètre inconnu le rendement par unité de calcul et non par pipeline de pixel shading ce qui nous permet d´afficher des données plus parlantes. Ainsi chacun des 24 pipelines de pixel shading de GeForce 7800 peut traiter soit 2 instructions mathématiques, soit 1 instructions de texturing + une 1 instruction mathématique par cycle. Pour les X1800 et X1900 chaque pipeline, qu´il soit de pixel shading ou de texturing, peut traiter une instruction par cycle. Le graphique représente la puissance de calcul d´après le rapport instructions mathématiques / instruction de texturing :  Les 4 courbes du GeForce 7800 GTX 512 Mo représentent le nombre de registres utilisés puisque sa puissance de calcul en dépend. Un haut c´est bien entendu le meilleur des cas et le compilateur intégré dans les drivers tente de rester dans ce cas. A gauche, il y a plus d´accès aux textures que d´autres instructions, ce qui arrive dans 2 cas différents : des cas relativement théoriques qui ne nous intéressent pas ici et d´autres où le filtrage et l´accès aux textures nécessitent plusieurs cycles ce qui revient à consommer plusieurs instructions. Le filtrage maximal, anisotrope 16x et filtrage trilinéaire, consomme 32 cycles ! Heureusement, ce filtrage complet n´est appliqué qu´à un nombre réduit de pixels. Lorsque l´on sélectionne un filtrage anisotrope, il s´agit du filtrage maximal autorisé, le GPU se chargeant de le simplifier pour les pixels qui n´en ont pas besoin (parfois plus que de raison pour augmenter les performances). Nvidia a ici un avantage. A 1, nous avons une instruction de texturing pour une instruction mathématique. Dans ces conditions, X1800 et X1900 ont une puissance de calcul similaire mais le GeForce 7800 GTX 512 Mo est devant. Une fois que ce rapport augmente, la X1900 se détache et atteint son maximum lorsqu´il y a à chaque fois 3 instructions mathématiques pour une instruction de texturing. Mais comme vous le voyez, l´avantage sur Nvidia n´est pas aussi énorme que cela et c´est donc bien la Radeon X1800 qui a un déficit de puissance de calcul plus que la Radeon X1900 qui en aurait plus que de raison. Performances en pixel shadingQue donne tout ceci en pratique ? Pour commencer, nous avons extrait des shaders de 3 applications qui en utilisent des complexes : 3DMark05, Far Cry et Tomb Raider AOD. Ceux-ci représentent des shaders de taille moyenne tels qu´on les trouve dans les jeux actuels. Nous les avons exécutés sur tout l’écran dans une application externe. Vous remarquerez que nous avons ici utilisé la Radeon X1900XT et non le modèle XTX de manière à pouvoir juger la différence entre X1800 et X1900 sur base de GPU cadencés à la même fréquence.  Dans les 2 premiers shaders, les 7800 GTX dominaient la X1800. La Radeon X1900 permet à ATI de repasser devant dans un des deux mais pas dans l´autre. Dans le troisième qui repose plus sur l´accès aux textures dépendantes (indirections), la X1800 était déjà devant et la X1900 ne fait que légèrement mieux. Ensuite nous avons testé les 2 tests pixel shader de 3DMark06. Le premier est complexe et le second, Perlin Noise, très complexe puisque composé de près de 500 instructions.  Dans le premier test, la Radeon X1800 était en retrait et la X1900 repasse tout juste devant la 7800 GTX 512 Mo. Dans le second, la X1900 prend le large et montre qu´elle apprécie particulièrement les pixel shaders très complexes comme on pouvait s´y attendre. Et enfin, nous avons testé 2 shaders d´éclairage qui représente un bon compromis entre des débits de calculs théoriques et pratiques :  Première constatation, comme nous vous l´expliquions, la X1800 a un déficit de puissance de calcul et les 2 7800 GTX sont nettement devant. Dans le premier test, la X1900 fait 2.3x mieux que sa petite sœur ce qui la place 33% devant la 7800 GTX 512 (23% quand celle-ci profite du FP16). Dans le second test, la Radeon X1900 XT est 2.6x plus rapide que la X1800 XT ce qui nous donne alors respectivement 55% et 33% de mieux que la 7800 GTX 512 suivant l´utilisation du FP32 ou du FP16. Page 3 - Branchements, Vertex Shader, Fetch4 BranchementsL’une des principales nouveautés qui a été introduite avec le GeForce 6800 est le branchement dynamique dans les pixel shaders. Cela permet de faciliter l’écriture de certains shaders et d’augmenter l’efficacité d’autres shaders en évitant de calculer une partie de ceux-ci sur les pixels qui n’en ont pas besoin. Par exemple pourquoi appliquer le filtrage très coûteux de l’adoucissement de bordure d’une ombre si le pixel est au milieu de l’ombre ? Un branchement dynamique permet de détecter si le pixel en a besoin ou pas. Splinter Cell Chaos Theory utilise cette technique alors que Les Chroniques de Riddick calcule tout pour chaque pixel. Les performances baissent de 10 à 15% dans le premier cas et de plus de 50% dans le second. Bien entendu les algorithmes ne sont pas identiques mais cela donne une image de ce que peuvent permettre les branchements dynamiques.  Mais tout n’est pas si rose puisque ceux-ci ne sont efficaces que dans des cas bien précis. Les branchements ont une réputation d´être difficile à gérer, c´est particulièrement le cas dans les CPU qui doivent prédire le résultat du branchement à l´avance pour masquer la latence du calcul de celui-ci. Dans un GPU, les pixels sont traités par groupes de centaines voire de milliers de pixels, ce qui permet de masquer automatiquement cette latence. Le problème des CPUs n´existe donc pas réellement. Par contre un autre problème se pose. Lors d’un branchement, tous les pixels doivent prendre la même branche sans quoi les 2 branches doivent être calculées pour tous les pixels, avec des masques pour n’écrire que le résultat de la branche requise pour chaque pixel. ATI dispose sur le papier d´un net avantage avec une unité de traitement dédiée aux branchements et des threads de très petite taille, voyons si cela se confirme en pratique via un petit test que nous avons développé qui nous permet de modifier la granularité du branchement, c´est-à-dire le nombre moyen de pixels consécutifs qui vont prendre une même branche. Nous spécifions la branche à prendre par colonne de pixels, une colonne sur 2 doit afficher un shader complexe et l´autre peut passer cette partie du rendu. Des triangles de taille moyenne en mouvement sont affichés à l´écran et traversent ces zones qui utilisent différentes branches, ce qui implique que tant les triangles et leur position que la taille de la colonne influent sur l´efficacité du branchement ce qui est proche d´une situation réelle.  Avec des colonnes étroites, les GPU ne peuvent pas profiter du branchement pour éviter la partie complexe sur la moitié des pixels, mais par contre doivent traiter les instructions de branchement, ce qui fait baisser les performances au lieu de les augmenter. Tout du moins chez Nvidia. ATI dispose d´une unité dédiée aux branchements qui travaille en parallèle des pipelines de pixel shading et de texturing ce qui masque le coût des instructions de branchement. Les petits threads d´ATI, de 16 pixels (4x4) permettent un gain de performances dès que la largeur des colonnes atteint 4 pixels alors qu´il faut attendre une largeur de 64 pixels chez Nvidia ! Vous remarquerez cependant que le Radeon X1900 ne commence à profiter des branchements qu´à partir d´une taille de colonne de 8 pixels (soit une granularité de 8x? pixels). Ceci est dû au fait que le Radeon X1900, du fait de son nombre plus élevé de pipelines de pixel shading, doit travailler sur des threads de 48 pixels au lieu de 16, ce qui le rend moins efficaces. Les threads ont une forme "en coin" qui représente 3 carrés de 16 pixels. Notez qu´un bug donne des résultats incohérents avec une taille de colonne de 16 pixels avec les drivers beta utilisés pour le test alors que ce problème n´existait pas avant. Nous avons donc retiré ceux-ci. ATI atteint malgré tout des gains nettement supérieurs à ceux que permet l´architecture de Nvidia, que ce soit avec la Radeon X1800 qu´avec la Radeon X1900. Notez qu´il s´agit bien ici de gain et pas de performances pures. Ainsi bien que profitant moins des branchements, la Radeon X1900 est presque 3x plus performante sur ce pixel shader que la X1800. Quant à la 7800 GTX qui dispose elle aussi d´une forte puissance de calcul à la base, elle est toujours devant la X1800 en étant parfois 2x plus performante. Globalement, l´efficacité des branchements chez ATI est donc de très loin supérieure à celle que l´on retrouve chez Nvidia, ce qui devrait permettre leur utilisation dans de plus en plus de cas, ce que les développeurs devraient apprécier. Si cela permettait à la X1800 de compenser son manque de puissance de calcul face à la 7800, cela permet à la X1900 de prendre une nette avance sur ce genre de shader. Nous avons ensuite exécuté un second test lié aux branchements dynamiques. Cette fois nous avons rendu une fractale de Mandelbrot (test qui était utilisé à l´époque des GeForce FX) d´une manière classique et ensuite à base de branchements. Cet algorithme utilise un nombre élevé d´itérations identiques qui dans le shader classique se retrouvent une à la suite de l´autre. Dans le shader à base de branchements, nous avons utilisé une boucle autour de 2 itérations avec un test qui vérifie si le calcul d´itérations supplémentaires est utile ou pas. Si il n´est pas utile nous sortons de la boucle en laissant tomber les itérations qui ne sont pas nécessaires.  Shader complexe exige, en version de base, le X1800 n´est pas à la fête. Le Radeon X1900 corrige cela et passe devant le 7800. Mais tout cela n´est plus une surprise. Les résultats obtenus à partir du shader qui utilise les branchements sont intéressants : ils confirment qu´ATI peut en tirer un bénéfice très important. Par contre ils montrent que ce n´est pas toujours le cas chez Nvidia, puisque dans le cas présent, le fait que le GeForce 7800 ne dispose pas d´unité de calcul dédiée aux branchements implique qu´il va perdre un nombre énorme de cycles à traiter ces branchements. Cela couplé au fait qu´il n´en tire des bénéfices qu´avec une faible granularité entraîne qu´il voit ses performances chuter. Un shader optimisé pour ATI peut donc réduire les performances de l´autre côté. Les choix des développeurs pourraient donc jouer un rôle important dans les performances des Radeon par rapport aux GeForce. Vont-ils utiliser les branchements ? Les méthodes classiques ? Les 2 méthodes ? Difficile de répondre à cette question aujourd´hui. Vertex ShaderNous avons testé les performances en T&L, VS 1.1, VS 2.0 et VS 2.X/3.0 dans RightMark :  Depuis notre précédent test, les performances en vertex shading de la Radeon X1800 ont progressé. Etant donné qu´il n´y a pas eu de changement à ce niveau, celles de la X1900 sont identiques. Notez qu´un bug empêche de faire tourner l´un des tests sur les Radeon. Avec les branchements statiques, Nvidia souffre d´un problème de performances mais celui-ci n´est pas nouveau et résulte probablement d´un bug dans les drivers que Nvidia n´est pas pressé de corriger. Contrairement à Nvidia, ATI fait l´impasse sur le support du Vertex Texturing qui pourtant nous semblait être requis pour pouvoir afficher le support des Vertex Shader 3.0. ATI prétend que son support n´est en réalité pas obligatoire, ce qui est étrange. En y regardant de plus près, nous avons remarqué qu´ATI reporte à DirectX le support du vertex texturing, mais ne l´autorise sur aucun format de texture, ce qui parait suspect et ressemble à une manière habile de contourner les spécifications de DirectX en affichant ainsi le support des Vertex Shader 3.0 sans que le Vertex Texturing ne puisse être utilisé. Bref tout ceci n´est pas très net. Mais quoi qu´il en soit, en pratique, le Vertex Texturing n´est pas très important, et mise à part 2-3 démos technologiques, il n´est pas utilisé parce que trop limité tout du moins dans son implémentation actuelle. Accès aux texturesLes Radeon X1900 sont identiques à ce niveau aux Radeon X1800, nous n´avons donc pas réalisé de tests supplémentaires à ce niveau, mais vous pouvez consulter ceux présents dans le test de la X1800. Les unités de texturing des X1900 ont cependant acquis une nouvelle capacité nommée fetch4 qui était déjà présente dans les Radeon X1300 et X1600. Lors du filtrage d´une texture, l´unité de texturing récupère 4 texels et les mélange entre eux via une interpolation linéaire. Certains rendus, comme celui de certaines ombres, ont besoin d´un autre filtrage (PCF par exemple). Dans ce cas, il faut accéder 4 fois à la texture en point sampling et utiliser un pixel shader pour filtrer les 4 texels de la bonne manière. Nvidia accélère le filtrage PCF en hardware et n´a donc pas besoin de faire cette opération. Par contre les Radeon n´en sont pas capables. Fetch4 permet en partie de contourner ce problème. Dans le cas d´une texture à 1 canal (comme les textures utilisées dans le rendu des ombres, ça tombe bien), fetch4 va remplir les 4 canaux utilisés habituellement par les 3 couleurs et la transparence avec les 4 texels qui vont donc être retournés au pixel shader tels quels, soit non filtrés. Le shader devra toujours s´occuper du filtrage par contre il ne faut plus qu´un accès à la texture au lieu de 4. 3DMark06 utilise cette possibilité des Radeon X1300/X1600 et X1900 et les développeurs devraient eux aussi le faire à l´avenir. Page 4 - CrossFire, Les cartes, Consommation, Le test CrossFire, rappel  Ce test est pour nous l´occasion de réévaluer la solution CrossFire d´ATI qui a évolué avec les Radeon X1800, mais pour une raison qui nous échappe ATI n´a pas voulu laisser la presse française la tester. La Radeon X1900 CrossFire reprend bien entendu l´évolution apparue avec la X1800, c´est-à-dire un nouveau connecteur et un Compositing Engine revu et corrigé de manière à pouvoir dépasser la résolution de 1600x1200 (limite des X800/X850 CrossFire) mais également à accélérer le SuperAA, l´antialiasing haute qualité qui consiste à rendre la même image sur les 2 cartes avec des samples positionnées différemment et ensuite à fusionner les 2 images. Cette opération est maintenant prise en charge par le Compositing Engine au lieu du GPU. Ce test est pour nous l´occasion de réévaluer la solution CrossFire d´ATI qui a évolué avec les Radeon X1800, mais pour une raison qui nous échappe ATI n´a pas voulu laisser la presse française la tester. La Radeon X1900 CrossFire reprend bien entendu l´évolution apparue avec la X1800, c´est-à-dire un nouveau connecteur et un Compositing Engine revu et corrigé de manière à pouvoir dépasser la résolution de 1600x1200 (limite des X800/X850 CrossFire) mais également à accélérer le SuperAA, l´antialiasing haute qualité qui consiste à rendre la même image sur les 2 cartes avec des samples positionnées différemment et ensuite à fusionner les 2 images. Cette opération est maintenant prise en charge par le Compositing Engine au lieu du GPU. Le Compositing Engine choisi par ATI a souffert de nombreuses critiques, notamment au niveau de son coût. Comparé au SLI il est nettement plus cher à mettre en place puisqu´il nécessite des composants supplémentaires au lieu de quelques transistors dans le GPU. ATI répercute ce coût à hauteur de 50€ sur la carte CrossFire Edition, ce qui est raisonnable et indique qu´ATI a probablement une marge plus réduite sur une X1900 CF que sur une X1900 classique mais ça ce n´est pas le problème des utilisateurs ! En contrepartie, ce Compositing Engine représente une solution plus performante mais impose l´utilisation d´une carte spéciale et pas simplement de 2 X1900. Les cartesPour ce test, ATI nous a fournit une Radeon X1900 XTX et une Radeon X1900 CrossFire Edition qui est cadencée aux mêmes fréquences que la Radeon X1900 XT.   Comme vous pouvez le constater, le design de référence est identique à celui des Radeon X1800 puisque le PCB n´a subi que des modifications mineures et puisque le système de refroidissement est parfaitement identique. Celui-ci sait se montrer bruyant dans des cas extrêmes mais le niveau sonore reste en général dans les limites de l´acceptable. Pas de souci particulier donc. Par contre la GeForce 7800 GTX 512 Mo conserve un avantage puisqu´elle est, elle, extrêmement silencieuse grâce à son système de refroidissement très évolué. ConsommationNous avons bien entendu évalué la consommation des diverses cartes. Ces données sont obtenues à partir des mesures effectuées à la sortie de la prise de courant : il s’agit donc de la consommation totale de l’alimentation de la machine, ici une Enermax 535W. Nous reportons les chiffres obtenus sous le bureau Windows, en charge sous un test de fillrate qui sature les pixel shader avec Prime95 et en charge sous 3DMark05 (GameTest 3) également avec Prime95, ce dernier permettant d’avoir une utilisation processeur constante quelles que soient les performances des solutions graphiques.  En 2D, la consommation des 4 Radeon est très proche et les GeForce consomment quelques watts de plus. En 3D la consommation augmente très nettement et d´une manière différente d´après la charge appliquée. Dans le test de fillrate, les X1800 s´en sortent bien et sont probablement capables de désactiver des blocs non utilisés alors que les cartes Nvidia tournent à plein régime et consomment nettement plus. Les Radeon X1900 se placent entre les deux et consomment entre 40 et 45 watts de plus que la X1800 XT ! Les 32 pipelines de pixel shading ici saturés par le test de pixel shader montrent donc qu´ils sont gourmands. Avec 3DMark05, la situation est différente et cette fois Nvidia consomme moins, ce qui place le GeForce 7800 GTX 512 Mo au niveau de la Radeon X1800 XT. Les Radeon X1900 font passer la machine au-dessus de la barre des 300 watts en consommant 25 watts de plus que la X1800 XT. Le testPour ce test, nous avons décidé de mettre à jour notre protocole en intégrant de nouveaux jeux et en modifiant notre procédure de tests avec d´autres. F.E.A.R., Serious Sam 2 et Age of Empire III fon ainsi leur apparition, Quake 4 remplace Doom 3 et Half-Life 2 Lost Coast est maintenant utilisé. Far Cry est toujours utilisé mais avec une autre démo qui repose plus sur la puissance du GPU. Splinter Cell Chaos Theory, Act of War, Colin McRae 05 et Pacific Fighters restent de la partie et sont testés de la même manière. Nous avons également décidé de garder le filtrage anisotrope activé dans tous les tests. Il augmente significativement la netteté des textures et plus on monte en résolution, plus c´est bénéfique. Il est donc logique de l´utiliser sur une carte haut de gamme, même si l´antialiasing est désactivé. Quand le jeu permet de le configurer directement, nous sélectionnons le mode le plus élevé proposé, sinon nous forçons le filtrage anisotrope 16x via le panneau de contrôle des drivers. Nous avons désactivé l´optimisation "Anisotropic sample optimizations" qui augmente le shimmering chez Nvidia, ce qui ne change pas grand-chose aux performances mais nous permet de tester avec une qualité plus proche entre ATI et Nvidia. Configuration de test :Asus A8N32-SLI Deluxe A8R-MVP AMD Athlon FX 55 2 x 1 Go de Corsair XMS 3200 Western Digital Raptor 74 Go Enermax 535W Windows XP SP2 Catalyst beta 8.203 ForceWare 81.98 Page 5 - HDR, F.E.A.R. Le HDR, rappelLe rendu HDR est la nouvelle fonction à la mode de nos cartes 3D mais de quoi s’agit-il exactement ? Simplement d’effets de lumière plus jolis ? C’est en fait plus compliqué que cela. Premièrement il n’y a pas "un" rendu HDR mais bien "des" rendus HDR qui ont chacun leurs avantages et leurs inconvénients : plus performant, meilleure précision, support du blending etc… Il revient donc aux développeurs de choisir le rendu HDR qui correspond le mieux à ce qu’ils veulent en faire et à leur moteur global. Le rendu HDR consiste en fait à ce que l’image ou une partie de l’image soit à un moment de son traitement, traitée avec un format à la dynamique plus étendue, c’est-à-dire avec un format dont l’écart entre la plus petite valeur et la plus grande qu’il peut représenter est plus important. Autrement dit, le HDR est un format de rendu temporaire de plus haute précision de calcul, ce qui permet de préserver la qualité de l’image lors de certaines opérations mais également d’appliquer à l’image des effets plus complexes qui ont besoin de cette précision. Le HDR, tout du moins dans l’état actuel des choses n’est jamais affiché directement, vous ne voyez donc pas une image au format HDR, mais une image qui en a profité à un moment donné lors de son calcul.  Il est possible de retranscrire l’image temporaire HDR en image affichable en laissant simplement tomber les informations supplémentaires contenues par le format HDR si celles-ci ne sont plus utiles. Mais il est possible d’aller plus loin et de se servir de toutes les données contenues dans le format HDR pour créer une nouvelle image au format classique mais enrichie, c’est le tone mapping qui est en fait utilisé dans d’autres domaines que la 3D, en photo par exemple. Le tone mapping consiste donc à interpréter les données HDR de manière à en tirer une image de qualité supérieure. Il existe de nombreux algorithmes de tone mapping et encore une fois, les développeurs produiront les leurs sur base de ce qu’ils veulent en faire : augmenter le contraste, changer la palette de couleurs, afficher des effets d’éblouissement etc. ATI et Nvidia supportent chacun un certain nombre de format HDR différents. Au niveau des différences importantes entre ATI et Nvidia : - ATI supporte le blending FX10, Nvidia pas - ATI supporte l’antialiasing de type multisample en FX10 et en FP16, Nvidia pas - Le filtrage des textures FP16 est gratuit chez Nvidia mais pas chez ATI Globalement, ATI est plus souple que Nvidia au niveau des formats HDR supportés, mais étant donné que Nvidia a été le premier sur la technologie, le FP16 est le principal format utilisé ce qui peut poser problèmes aux Radeon X1K qui ne filtrent pas nativement les textures FP16, ce qui peut causer quelques soucis tant que les shaders n’ont pas été adaptés pour pallier à ce manque. Dans notre panel de test, 5 jeux sur 10 proposent un mode HDR et 2 exclusivement à base de FP16. Si le HDR n´est pas très convainquant dans Splinter Cell et Serious Sam 2, il l´est particulièrement dans Half Life 2 et Far Cry avec des couleurs moins ternes et des données de meilleure qualité à fournir aux filtres de post processing dans Far Cry. F.E.A.R.Nous commençons les tests avec F.E.A.R. dont nous utilisons la démo intégrée. Malheureusement, celle-ci ne donne qu’un score entier ce qui peut par exemple entraîner une différence d’une unité dans les mêmes conditions à cause d’une variation normale de 2 dixièmes. Nous avons donc sélectionné pour chaque carte le meilleur de 3 résultats. Toutes les options graphiques sont poussées au maximum, à l´exception des soft shadows qui sont désactivés . Le filtrage anisotrope 16x est activé via le jeu.  Alors que le GeForce 7800 GTX 512 Mo était passé devant la X1800 XT, les X1900 reprennent les devants. Par contre, le SLI est plus bénéfique que CrossFire dans ce jeu ce qui fait qu´une fois en mode multi-GPU, c´est Nvidia qui repasse devant. Interrogé sur ce point, ATI nous a indiqué ne pas encore avoir intégré toutes les optimisations utiles aux très hautes résolutions en mode CrossFire dans les drivers. La raison est que certaines de celles-ci consomment un peu de CPU et vu que la majorité des tests se font en plus basse résolution, celles-ci ont été privilégiées dans un premier temps. CrossFire doit encore être optimisé afin de réduire son utilisation CPU et une fois que ce sera fait de nouvelles optimisations bénéfiques au rendement en haute résolution devraient apparaître. Reste à savoir quand ?  L´antialiasing s´avère particulièrement coûteux dans F.E.A.R., surtout pour Nvidia qui voit ses scores s´effondrer. Les systèmes d´optimisation du rendement tels que la compression des données Z et des couleurs sont probablement plus efficace chez ATI, ainsi que le ring bus. Du coup, une simple X1800 XT est devant 2 7800 GTX en SLI et la X1800 XL est devant la 7800 GTX. F.E.A.R. et ATI semblent donc faire bon ménage ! Page 6 - Half Life 2 Lost Coast Half-Life 2 Lost CoastPour ce test nous utilisons une démo interne que nous avons enregistrée sur Lost Coast de manière à pouvoir tester le HDR façon Valve qui utilise un format de rendu assez complexe qui ne fait pas usage des possibilités supplémentaires des GeForce 6 et 7 et des Radeon X1K mais tourne sur toutes les cartes DirectX 9 et ce avec MSAA. Le filtrage anisotrope 16x est activé via le jeu.  Dans Half Life 2, Nvidia est légèrement devant. Il n´y a que CrossFire pour donner l´avantage à ATI mais celui-ci n´est pas très important puisque toutes les solutions haut de gamme sont fortement limitée par le CPU dans ces conditions de jeu.  Une fois l´antialiasing active, l´avantage de Nvidia se réduit et le SLI repasse devant le CrossFire. Les 2 6800 GT se placent devant la 7800 GT en 1600 x 1200 mais restent derrière en 1920 x 1200.  En HDR, les performances baissent encore un peu ce qui permet au CrossFire et au SLI de se montrer réellement utiles. Nvidia conserve globalement la tête.  Nvidia est de nouveau devant et creuse l´écart cette fois avec +/- 10% d´avantage sur la X1900 XTX avec la 7800 GTX 512 Mo. La 6800 GT est moins à la fête et est ici complètement larguée. Page 7 - Far Cry Far CryNous utilisons une démo interne, qui mélange intérieurs et extérieurs, enregistrée dans la map "catacombs". Nous activons le filtre de post process "froid" ou "cold" qui améliore sensiblement l’image. A vrai dire, avec le post process et le HDR on change littéralement d’époque de rendu et on redécouvre le jeu. Ce filtre de post process entraîne une baisse des performances de +/- 20%. Le filtrage anisotrope 8x est activé via le jeu.  ATI est devant avec 10% d´avantage pour la X1900 XTX sur la 7800 GTX 512 Mo, par contre les X1900 en CrossFire semble avoir du mal à détecter le bon mode de rendu et les performances baissent au lieu d´augmenter, mais de toute manière il n´y avait pas de gain à attendre vu que le jeu est limité par le CPU dans ces conditions de jeu.  Même problème pour CrossFire avec l´antialiasing. Les Radeon, seules, respirent et creusent leur avantage sur les GeForce. En 1920, la Radeon X1800 XT passe tout juste devant la 7800 GTX 512.  Les Radeon et GeForce utilisent un rendu à base de FP16 similaire mais il n’est pas parfaitement identique puisque l’image est moins brûlée du côté d’ATI, ce qui résulte à priori d’un traitement plus fin des données HDR. ATI a fortement fait évoluer ses drivers au niveau des performances en HDR dans Far Cry. Lors de son lancement, la Radeon X1800 XT était moins performante qu´une GeForce 6800 GT dans ce test mais est maintenant passé devant la 7800 GTX. L´évolution a donc été fulgurante. Cette fois le CrossFire retrouve ses esprit et se place devant tout le monde, avec un net avantage sur le SLI qui a du mal à augmenter les performances. Une X1900 XTX est ainsi très proche de 2 7800 GTX 512 Mo.  FP16 oblige, les GeForce ne peuvent pas appliquer d´antialiasing avec le HDR. Les nouvelles venues augmentent les performances mais la différence n´est pas énorme par rapport à la X1800 XT. CrossFire est ici très utile et le 1600 x 1200 est presque utilisable dans des conditions confortables. Haute résolution, HDR, FSAA, que demander de plus ? Page 8 - Serious Sam 2 Serious Sam 2Nous avons enregistré une démo ici aussi et activé le filtrage anisotrope 16x dans le jeu.  ATI est devant mais de peu en 1600 x 1200. Vous remarquerez la grosse différence de performances entre la 6800 GT et la X1800 XL.  Avec l´antialiasing, Nvidia revient à égalité. Les X1900 n´amènent qu´un très petit gain dans ce jeu.  Alors que lors de notre précédent test le rendu était bugué sur les Radeon, il est maintenant correct avec le dernier patch qui ajoute en sus le support du FSAA avec le HDR. La correction du bug (les bloom maps n´étaient pas filtrées et donc pixellisaient) fait baisser les performances des Radeon mais celles-ci conservent malgré tout un net avantage. La Radeon X1900 XTX se place ainsi devant les 2 7800 GTX en SLI. Les X1900 CrossFire se placent loin devant. Les Radeon X800 sont incapables de supporter le rendu HDR FP16 utilisé dans Serious Sam 2 et ne peuvent donc pas exécuter ce test.  512 Mo sont nécessaires pour le HDR et le FSAA en 1920x1440, ce qui handicape la X1800 XL. Les autres cartes offrent des performances très proches et CrossFire s´exprime pleinement en apportant un gros gain. Page 9 - Splinter Cell Chaos Theory Splinter Cell Chaos TheoryNous utilisons une nouvelle fois une démo interne. Le SM 3.0 est utilisé sur toutes les cartes qui le supportent et les soft shadows et le parallax mapping sont activés. Le filtrage anisotrope 16x est activé via le jeu.  ATI est ici légèrement devant. Splinter Cell Chaos Theory étant très peu limité par le CPU, les systèmes multi-GPU s´en donnent à coeur joie. Pour une raison qui nous dépasse, les X800 CrossFire refusent de lancer Splinter Cell en 1600 x 1200 et font repasser la résolution en 1024 x 768.  Avec antialiasing, ATI creuse son avance.  Passer en HDR ou activer l´antialiasing revient au même sous Splinter Cell en terme de performances. Notez que le HDR est différent chez ATI et chez Nvidia. Avec les GeForce il s’agit de FP16, mais avec les Radeon il s’agit à priori plutôt de FX16, ce qui lui permet de fonctionner sur X800 mais réduit sensiblement sa qualité. Page 10 - Age of Empire III Age of Empire IIIPour tester ce jeu, nous avons sauvegardé une partie sur laquelle nous effectuons un déplacement bien défini en mode pause. Le filtrage anisotrope est activé via le jeu.  Dans Age of Empire III, c´est Nvidia le plus performant avec une GeForce 7800 GTX 512 Mo 20% plus performante que la dernière née d´ATI. La X1900 XT est tout juste devant la 7800 GTX.  Situation identique avec antialiasing si ce n´est que l´avantage de Nvidia se réduit.  Le rendu HDR produit un résultat similaire chez ATI et chez Nvidia mais est réalisé différemment. A base de FP16 chez Nvidia, il est en FX10 chez ATI. Ce mode FX10, si on ne laisse que 2 bits pour la transparence permet de tenir dans les 32 bits classiques ce qui est idéal pour les performances. Cependant le rendu HDR de Age of Empire est également gourmand en puissance de calcul ce qui fait que les X1800 se retrouvent larguées alors que les X1900 profitent de leurs 48 pipelines de pixel shading. L´écart n´est cependant pas énorme par rapport à la 7800 GTX 512 Mo qui peut elle aussi utiliser pleinement sa puissance de calcul.  Bien qu´il soit à base de FP16 pour les GeForce, le HDR peut ici être couplé avec l´antialiasing. Comment es-ce possible ? Il ne s´agit pas de multisampling mais d´un supersampling réalisé par le moteur du jeu : l´image est calculée dans une résolution 2.25 fois supérieure soit une 1.5 fois plus grande dans chaque dimension (2400 x 1800 au lieu de 1600 x 1200 par exemple) et ensuite réduite en taille. Si cela permet de disposer de FSAA sur GeForce, il faut garder à l´esprit que la qualité de l´antialiasing est nettement moindre face au multisampling 4x des Radeon X1000. Qui plus est la méthode utilisée pour les GeForce est très gourmande et leurs performances s´effondrent. Le CrossFire trône ici loin devant. Page 11 - Act of War, Colin McRae 05 Act of WarTout comme dans Age of Empire III, nous effectuons un déplacement précisément défini afin qu’il soit toujours identique et que le test soit reproductible. Le filtrage anisotrope 16x est activé via les drivers.  Dans Act of War, c´est Nvidia qui mène la danse et les pipelines de pixel shading supplémentaires des X1900 ne sont pas de grand secours sans unités de texturing supplémentaires.  Situation identique même si l´avantage de Nvidia se réduit comme c´est souvent le cas une fois l´antialiasing activé. Colin McRae 05Nous effectuons un déplacement précis et reproductible (puisque tout le temps tout droit jusqu’à un arrêt) dans un rallye du Japon. Le filtrage anisotrope 16x est activé via les drivers.  Dans ce jeu également, les 48 pipelines de pixel shading ne se montrent pas utiles et Nvidia reste légèrement devant. Par contre les performances augmentent plus en CrossFire qu´en SLI et ATI prend la tête en multi-GPU.  Avec antialiasing, X1800 XT et 7800 GTX 512 Mo font jeu égal, ce qui laisse un léger avantage aux X1900. En CrossFire, ATI creuse l´écart. Page 12 - Quake 4, Pacific Fighters Quake 4Nous avons enregistré une démo qui représente une scène d’action. Contrairement à Doom 3, il y a moins d’ombres et plus de monstres et de textures ce qui change la charge au niveau du rendu. Le filtrage anisotrope 8x est activé automatiquement par le jeu.  Bien que Quake 4 (et Doom 3) n´utilisent qu´un pixel shader simple mais sur énormément de pixels, la puissance de calcul des X1900 leur permet de gagner +/- 10 % sur la X1800 XT. Ce n´est cependant pas suffisant pour dépasser la 7800 GTX 512 Mo, mais force est de constater que les écarts sont ici très faibles et que toutes les derniers cartes sont à plus de 100 FPS en 1920 x 1200 !  Avec antialiasing, les 2 haut de gamme font jeu égal, par contre les cartes équipées de seulement 256 Mo sont fortement pénalisées, ce qui place par exemple, une X1900 XT devant 2 7800 GTX en SLI. Pacific FightersDans ce second jeu OpenGL de ce comparatif, nous mesurons les performances lors de la lecture d’un enregistrement d’une scène de combat. Le filtrage anisotrope 16x est activé via les drivers.  OpenGL, simulateur de vol et ATI ne forment pas un trio gagnant. Nvidia domine assez nettement dans ce jeu. Les solutions SLI sont bridées par le CPU et CrossFire ne semble pas bien efficace ici puisqu´il n´apporte qu´un gain minime, en plus de rendre le jeu saccadé. Nous avons indiqué le problème à ATI qui a pu le reproduire rapidement et y apporter un correctif que nous avons reçu en moins de 2 jours sous la forme d´un nouveau driver. Nous n´avons cependant pas eu le temps de mesurer les performances avec celui-ci. Quoi qu´il en soit la réactivé de l´équipe Catalyst d´ATI est impressionnante ! Ce correctif sera intégré aux Catalyst 6.2.  Avec antialiasing, ATI est moins largué par Nvidia mais ne peut pas s´approcher des performances de la 7800 GTX 512. Page 13 - 48 PS pipelines : les gains Gains apportés par les 48 pipelines de pixel shadingNous avons comparé les performances de la X1800 XT à celles d´une X1900 cadencée aux mêmes fréquences, soit 625/750 MHz, de manière à pouvoir juger du gain apporté par le nouveau GPU d´ATI.  En moyenne les gains tournent donc ici autour de 15%. Comme l´on pouvait s´y attendre, ils sont très faibles sur les jeux qui sont principalement basés sur le texturing (Serious Sam 2, Act of War, Colin McRae 05 et Pacific Fighters), réduits sur les jeux qui utilisent des shader de taille moyenne voir plus mais qui incluent toujours assez bien de texturing (Half Life 2, Quake 4 et Far Cry) et plus importants sur les jeux qui font appel à moins de textures et plus de math : Splinter Cell Chaos Theory, F.E.A.R. et Age of Empire III.  Résultats similaires, si ce n´est F.E.A.R. qui se trouve limité par la bande passante mémoire une fois l´antialiasing activé, ce qui réduit les gains apportés par le R580.  Une fois le HDR activé, et à l´exception de Serious Sam 2, les gains deviennent intéressants voire même énormes comme c´est le cas dans Age of Empire III !  Un peu plus réduits dans Half Life 2 et Far Cry, les gains restent impressionnants dans Age of Empire III. Page 14 - AA et AF haute qualité : coût Coût du Transparency / Adaptative AANvidia et ATI proposent maintenant tous les deux un mode d’antialiasing "intelligent" qui permet de forcer un mode supersampling sur les triangles qui en ont besoin. Cette technologie est utilisée pour lisser les contours des objets simulés à partir de tests alpha qui ne profitent pas du multisampling classique étant donné qu’il ne filtre que les polygones réels. Réservée aux GeForce 7800, cette nouvelle option est par contre fonctionnelle sur toutes les Radeon DirectX 9, c´est-à-dire à partir de la Radeon 9700 et dérivés.  Globalement le coût du TAA ou AAA est légèrement plus élevé chez ATI mais bizarrement, alors qu´il n´y a pas de différence avec les Radeon dans Quake 4, la 7800 GTX 512 Mo perd 7% ce qui fait qu´en moyenne la baisse est similaire chez les 2 fabricants de GPU. Dans Far Cry, Serious Sam 2, Act of War et Colin McRae 05 il est déconseillé de l’activer étant donné qu’elle réduit fortement les performances dans certains endroits. Gardez à l’esprit qu’il s’agit ici d’une baisse moyenne qui peut donc être plus élevée par endroits. Coût du filtrage anisotrope HQAvec les X1K, ATI est le premier fabricant à reproposer une mode de filtrage anisotrope digne de ce nom qui ne se base pas sur une optimisation qui consiste à réduire la qualité du filtrage sur certains angles, ce qui cause une baisse notable de la qualité dans certains jeux puisque sans raison certaines surfaces peuvent être floues.  A l’exception de Pacific Fighters qui repose presque exclusivement sur le filtrage, le coût de l’aniso HQ est très faible étant donné que la latence du filtrage qui augmente avec la qualité peut être masquée par le calcul des shaders, d’autant plus efficacement chez ATI que les unités de texturing sont découplées du reste. N’hésitez donc pas à l’activer. Page 15 - Multi-GPU : le gain Gain apportés par le multi-GPUEst-ce que le SLI apporte plus de gain que CrossFire ? Ou bien est-ce le contraire ?     Globalement, les 2 solutions apportent des gains similaires avec un petit avantage au CrossFire en HDR. Par contre en y regardant de plus près, il existe certaines disparités dans les résultats. Par exemple, CrossFire n´augmente pas les performances dans Far Cry sans HDR lors que le SLI le fait. Par contre, en HDR, le SLI n´améliore presque pas le résultat alors que CrossFire est très bénéfique. Dans Colin McRae, CrossFire est très efficace et le SLI l´est nettement moins, mais la situation est inversée dans F.E.A.R.. Tout cela nous laisse penser qu´il y a encore pas mal d´optimisations possibles au niveau des drivers, tant chez Nvidia que chez ATI. Page 16 - SuperAA vs SLI AA Super AA vs SLI AATant ATI que Nvidia proposent de combiner 2 cartes graphiques pour améliorer la qualité de l´antialiasing, au lieu d´augmenter les performances. Mais quelles sont les performances dans ces modes de rendu ? Lors de notre premier test en septembre, les performances étaient très faibles, mais Nvidia a bien travaillé sur ses drivers et ATI a équipé ses Radeon X1900 CrossFire d´un nouveau Compositing Engine qui permet d´éviter une forte chute de performances.  Le SuperAA 10x et le SLI 8x sont identiques en terme de travail effectué. Par contre le SuperAA 10x d´ATI produit une meilleure qualité grâce à la grille d´antialiasing programmable qui permet de sélectionner le meilleure positionnement pour chaque sample alors que Nvidia doit se débrouiller avec un positionnement fixe et utilisé une astuce pour déplacer légèrement le rendu de l´image sur chaque GPU. Grâce au Compositing Engine, le CrossFire est plus performant dans ce mode d´antialiasing avancé. 66% de mieux que la GeForce 7800 GTX 512 dans Quake 4 !  Les modes SuperAA 14x et SLI 16x sont plus complexes à départager au niveau de la qualité puisqu´ils sont très différent. Le Super AA 14x combine 2 images en AA 6x alors que le SLI 16x combine 2 images en AA 8xS qui est lui-même le résultat d´un supersampling 2x sur le sens de la hauteur (rende en 3200 x 1200 au lieu de 1600 x 1200). Encore une fois, le positionnement des samples chez ATI est optimal alors qu´il ne l´est pas chez Nvidia ce qui permet au SuperAA 14x d´afficher une meilleure qualité dans certains cas. Mais dans d´autres cas, le SLI 16x sera meilleur. Etant donné qu´il s´agit de supersampling, le coût sur les performances est nettement supérieur et ATI prend le large. Vous noterez que ces 2 modes d´antialiasing ne fonctionnent pas avec Splinter Cell chez Nvidia. La raison est que le driver empêche d´appliquer un antialiasing sur ce jeu. Page 17 - Récapitulatif des performances Récapitulatif des performancesNous avons calculé une moyenne des performances obtenues dans tous les modes pour chaque carte en donnant le même poids à chaque jeu et en donnant l’indice 100 à la Radeon X1800 XT en 1600 x 1200.  Sans antialiasing, Nvidia gagne d´une courte tête. Les Radeon X800 en CrossFire se placent au niveau de la Radeon X1800 XL, mais restent limitées au 1600 x 1200 et ne seront à priori jamais réellement disponibles. Les 6800 GT en SLI se place au niveau d´une 7800 GT. Vous noterez la différence moyenne de 4% entre les X1900 XT et la X1900 XTX et le gain de 20% de la X1900 XTX sur la X1800 XT.  Avec l´antialiasing c´est au tour d´ATI d´être très légèrement devant, tout du moins pour les cartes seules puisque le SLI est devant le CrossFire.  En HDR nous avons enfin un avantage significatif de la part des nouvelles venues puisque la X1900 XTX est 12% plus performante que la 7800 GTX 512 Mo. Il en va de même pour CrossFire qui passe devant le SLI. Par rapport à la X1800 XT, la X1900 XTX est 33% plus performante ce qui devient appréciable.  Ce graphe est un petit peu particulier puisque les performances directes des cartes ATI et Nvidia n´y sont pas comparées. La raison est que sur les 5 jeux qui proposent du HDR, ATI en fait tourner 4 avec antialiasing alors que Nvidia ne peut en faire tourner que 2 faute d´un support des surfaces multisamplées en FP16. Résultats les GeForce obtiennent un 0 dans ces tests ce qui fait chuter leur moyenne. Il en va de même des X800 qui, elles ne supportent le HDR et l´antialiasing que dans Half Life 2. Bien que dans ces conditions la bande passante est un des facteurs limitants les plus importants, les Radeon X1900 améliorent les performances par rapport à la X1800 XT de près de 28%. Page 18 - Conclusion ConclusionAvec le Radeon X1900 XTX, ATI reprend le leadership en terme de performances, tout en offrant toujours les avantages encore inexploités de son architecture, notamment au niveau des branchements dynamiques qui sont gérés d´une manière largement plus efficace que dans l´architecture des GeForce 7. Cependant, dans bien des jeux, les gains apportés par la Radeon X1900 restent limités et la GeForce 7800 GTX 512 y conserve la première place. Si lorsque l´on entend parler de 48 pipelines on pense à priori que les performances vont augmenter dans des proportions énormes, ce test prouve qu´il n´en est rien. Ce nombre n´est qu´un des éléments dans l´équation des performances. Qui plus est, en 3 mois est-il possible de changer complètement la donne au niveau des performances et ce en ajoutant 20% de transistors ? Non, bien entendu. Le Radeon X1900 permet donc d´augmenter les performances dans certains cas et malgré tout, parfois, de changer complètement la donne comme nous avons pu le voir dans Age of Empire III en version HDR avec un gain remarquable de plus de 75 % ! Faut-il être enthousiaste ou déçu par rapport à ce Radeon X1900 ? Question à laquelle il est difficile de répondre et chacun se fera son propre avis. Pour notre part, nous estimons qu´il s´agit d´une bonne évolution, mais pas d´une révolution, puisque ATI corrige avant tout la principale lacune du X1800 à savoir une puissance de calcul pur trop faible.  Bien entendu il reste que Nvidia propose avec le GeForce 7800 GTX 512 Mo une solution également très performante à tous les niveaux. Un peu moins performante en puissance de calcul, elle se trouve être plus performante dans les jeux moins gourmands. Tout dépend donc du type de jeux visé, mais étant donné que les cas où Nvidia est devant concerne des jeux au moteur graphique plus simple et que dans ces jeux, à de rares exceptions près (Pacific Fighters), ATI propose déjà un niveau de performances satisfaisant, n´est-il pas plus important de bénéficier de plus de performances dans les derniers jeux tels que F.E.A.R. ? Entre ces 2 solutions, il n´y a pas que les performances qui jouent. Ainsi, la Radeon a pour avantages de proposer un filtrage des textures de qualité supérieure, pour un coût réduit sur les performances, et également un mode de FSAA haute qualité en CrossFire significativement plus performant que celui de Nvidia, grâce au Compositing Engine. Par contre, la Radeon X1900 est assez gourmande en électricité, plus que la 7800 GTX 512 Mo dans des cas pratiques. Cette dernière est d´ailleurs bien plus discrète à l´usage grâce à un système de refroidissement haut de gamme. Mais pourrez-vous réellement faire un choix puisque les GeForce 7800 GTX 512 Mo sont introuvables ou disponibles au compte goûte alors que les Radeon X1900 sont disponibles en quantités plus conséquentes ?  Nous terminerons cet article en vous déconseillant clairement l´achat d´une X1900 XTX puisque par rapport à la X1900 XT, la différence de performances est négligeable alors qu´il y a 100€ d´écart. Nous nous posons de sérieuses questions par rapport à cette X1900 XTX. Quel peut bien être son intérêt ? Nous terminerons cet article en vous déconseillant clairement l´achat d´une X1900 XTX puisque par rapport à la X1900 XT, la différence de performances est négligeable alors qu´il y a 100€ d´écart. Nous nous posons de sérieuses questions par rapport à cette X1900 XTX. Quel peut bien être son intérêt ?!!! Aucune des cartes testées n´est compatible HDCP, le fonctionnement avec les vidéos HD n´est donc pas garanti !!! On remerciera ATI, Nvidia et leurs partenaires de ne pas pousser plus l´intégration d´une norme que l´industrie a décidé d´adopter. Tant ATI que Nvidia indiquent proposer des designs de référence compatibles HDCP mais personne ne semble décidé à les utiliser. ATI et Nvidia repoussent donc la faute sur les partenaires et les OEMs ce qui n´est pas complètement faux puisque cette absence de support aujourd´hui entraînera un renouvellement du matériel demain. Reste qu´ATI n´a pas pu nous fournir d´explication quant à la sortie de la Radeon X1900 All-in-Wonder, orientée multimédia, fabriquée et vendue sous la marque ATI mais non-compatible HDCP... Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |