| |

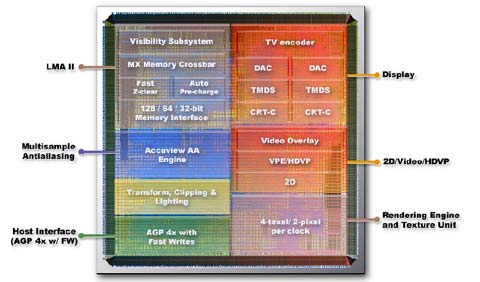

| GeForce4 MX Cartes Graphiques Publié le Jeudi 7 Février 2002 par Marc Prieur URL: /articles/411-1/geforce4-mx.html Page 1 - Introduction, les GeForce4 MX  Comme vous le savez déjà, NVIDIA profite de l’arrivée prochaine du printemps pour refaire de A à Z sa gamme de cartes graphiques. En sus des GeForce4 Ti, dont les versions 4400 et 4200 vont remplacer les GeForce3 Ti 500 et Ti 200 en gamme de prix, NVIDIA a lancé une nouvelle gamme de GPU, les GeForce4 MX. Comme vous le savez déjà, NVIDIA profite de l’arrivée prochaine du printemps pour refaire de A à Z sa gamme de cartes graphiques. En sus des GeForce4 Ti, dont les versions 4400 et 4200 vont remplacer les GeForce3 Ti 500 et Ti 200 en gamme de prix, NVIDIA a lancé une nouvelle gamme de GPU, les GeForce4 MX.Les GeForce4 MXContrairement à ce que l’on aurait pu penser, le GeForce4 MX n’est ni un GeForce4 Ti Light, ni un GeForce3 Ti Light. Pour mettre au point le GeForce4 MX, NVIDIA a en effet pris un peu de GeForce2 MX, un peu de GeForce4 Ti, le tout mijoté avec quelques fonctions qui lui sont propres.  Pour ce qui est du GeForce2 MX, NVIDIA en a repris la partie 3D de base. Le GeForce4 MX n’est donc pas, contrairement à ce que peut laisser penser son nom, un chip DirectX 8 mais DirectX 7. Adieu Pixel et Vertex Shaders, et même Environment Map Bump Mapping qui était pour rappel la seule fonction DX7 absente du GeForce2 MX. Le GeForce4 MX n’est donc pas taillé pour les jeux de demain, voir pour certains jeux d’aujourd’hui ! Toutefois, afin de combler ce manque NVIDIA à joué sur les fréquences et la bande passante mémoire comme nous le verrons un peu plus loin. De plus, le GeForce4 MX intègre, tout comme le GeForce4, la Lightspeed Memory Architecture II qui a pour but d’optimiser la gestion de la bande passante mémoire et du fillrate, en évitant au GPU de rendre les pixels cachés par exemple. La seule différence entre GeForce4 Ti et GeForce4 MX sur la LMA II se situe au niveau du contrôleur mémoire crossbar, qui n’est pas de type 4x64 bits mais de type 2x128 bits. Le GeForce4 MX a également hérité du GeForce4 Ti l’Accuview, dont le principal intérêt en pratique est de permettre d’activer le Quincunx Antialiasing sans perte de performances (sur GF3 Ti 200 les scores sous QIII Arena en 1024*768 32 bits sans FSAA/FSAA2x/FSAA Quincunx sont de 160,7/85,7/69,7, contre 165/102,2/102 sur GeForce4 MX 460). Page 2 - GF4MX (suite), Le test Mais le GeForce4 MX innove sur certains points, même s’il ne s’agit pas de là 3D. Comme le GeForce4 Ti il gère le bi-écran via le nView. Mais il va plus loin, en intégrant en sus des deux RAMDAC 350 MHz deux TMDS et une sortie TV (cette dernière, qui peut aller jusqu´au 1024*768, est de bonne qualité. Il est à noter qu’en mode Clone on ne peut régler les résolutions CRT/TV indépendamment. Si on est en 1280*1024 sur l’écran principal, il faudra donc utiliser un bureau virtuel sur la sortie TV). Contrairement au GeForce4 Ti qui nécessite des puces Silicon Image ou Conexant (par exemple) pour gérer le DVI ou la TV, le GeForce4 MX intègre donc ces deux fonctions ce qui permettra de faire des cartes moins chères. De plus, le GeForce4 MX est le premier GPU NVIDIA à disposer d’un décodage MPEG-2 Vidéo 100% hardware (enfin !). Le GeForce4 MX supporte également comme les puces ATI une méthode de désentrelacement sélectionnant pour chaque Pixel s’il vaut mieux utiliser la méthode du Bob ou du Weave. Le seul problème est qu’a l’heure actuelle aucun player DVD ne sait vraiment tirer partie de l’accélération hardware MPEG-2 du GeForce4 MX, et il est donc impossible dans ces conditions de la juger tant en terme de performances que de qualité. Il ne reste plus qu’a espérer que ce problème soit résolu au plus vite, que ce soit via une mise à jour des softs existants ou pourquoi pas via un player propriétaire comme le fait ATI.  Voici les différentes version du GeForce4 MX : - GeForce4 MX 460 : GPU à 300 MHz, 64 Mo de DDR-SDRAM à 275 MHz, 200 € - GeForce4 MX 440 : GPU à 270 MHz, 64 Mo de DDR-SDRAM à 200 MHz, 160 € - GeForce4 MX 420 : GPU à 250 MHz, 64 Mo de SDR-SDRAM à 166 MHz, 100-120 € Comme vous pouvez le voir, seules les versions MX 440 et 460 seront intéressantes si vous désirez un minimum de performances, le MX 420 se plaçant plutôt face à l’actuel GeForce2 MX 400. Le GeForce4 MX 440 se situe pour sa part dans la gamme actuelle de prix des Radeon 7500 et GeForce2 Ti, alors que le GeForce4 MX 460 se situe entre ces GPU et les Radeon 8500LE / GeForce3 Ti 200. Le testMSI France a pu nous prêter une partie de leur gamme GeForce4 MX. Celle ci se décompose de la manière suivante : - MSI G4MX460 : Disponible en version VIVO (VT) ou TV-Out seulement (T) - MSI G4MX440 : Disponible en version Bi-VGA + TV-Out (VPT) ou TV Out seulement (T) - MSI G4MX420 : Disponible en version TV Out (T) Nous avons pu tester les G4MX460 VT, G4MX440 T et G4MX420 T que voici :     Il est à noter que MSI n’a pas fait les choses à moitié du côté de la mémoire. En effet, la MX460 est dotée de mémoire BGA Samsung spécifiée à 3.3ns, soit 333 MHz. De son coté, la MX440 est dotée de mémoire Samsung à 4ns, soit 250 MHz. Etant donné que ces mémoires sont par défaut cadencées respectivement à 275 et 200 MHz, cela laisse une marge appréciable pour l’overclocking ! Reste maintenant à savoir si tous les constructeurs auront la même politique de qualité vis à vis de la mémoire. Il est à noter que MSI n’a pas fait les choses à moitié du côté de la mémoire. En effet, la MX460 est dotée de mémoire BGA Samsung spécifiée à 3.3ns, soit 333 MHz. De son coté, la MX440 est dotée de mémoire Samsung à 4ns, soit 250 MHz. Etant donné que ces mémoires sont par défaut cadencées respectivement à 275 et 200 MHz, cela laisse une marge appréciable pour l’overclocking ! Reste maintenant à savoir si tous les constructeurs auront la même politique de qualité vis à vis de la mémoire. Côté GPU, toutes les cartes étaient dotées du même chip. Marqué en tant que NV17 et produit durant la 49è semaine de l’année 2001 par TSMC, il s’agit d’une révision A3 – donc d’une finale. Logiquement le refroidissement employé par MSI varie selon les modèles ... d’ailleurs le GPU de la G4MX420 est surmonté d’un simple radiateur. Côté GPU, toutes les cartes étaient dotées du même chip. Marqué en tant que NV17 et produit durant la 49è semaine de l’année 2001 par TSMC, il s’agit d’une révision A3 – donc d’une finale. Logiquement le refroidissement employé par MSI varie selon les modèles ... d’ailleurs le GPU de la G4MX420 est surmonté d’un simple radiateur.Page 3 - GF4 MX420, GF4MX vs R7500/GF2Ti Le GeForce4 MX 420Pour commencer, nous avons effectué un test rapide en 1024*768 32 bits sous Quake III et Max Payne sur le GeForce4 MX 420, qui devrait remplacer le GeForce2 MX 400 en terme de positionnement prix (environ 100-120 €).  Certes, ses performances ne sont pas exceptionnelles, mais il est nettement plus performant que le MX 400 qu´il remplace. On reste toutefois derrière un GeForce2 Ti, ce qui fait un peu bizarre pour un ´GeForce4´. Le GeForce4 MX 420 devrait toutefois être un succès du coté des OEM, notamment du fait de sa dénomination. GeForce4 MX vs GF2 Ti / Radeon 7500Nous avons ensuite comparé les GeForce4 MX 440 et 460 aux chips DirectX 7 actuels de NVIDIA et ATI, à savoir le GeForce2 Ti, le Radeon 7500 (290/230) et le Radeon 7500 ´LE´ (250/230) (tests effectués en 32 bits).   Les GeForce4 MX 440 et 460 sont devant les Radeon 7500/GeForce2 Ti, et ce, que ce soit sous Quake III et dans une moindre mesure sous Max Payne (ce dernier étant notamment plus dépendant du CPU). Le GeForce4 MX 440, qui se situe dans la même gamme de prix que ces GPU, réussit donc son pari. Le GeForce4 MX 460 est pour sa part plus honéreux, puisque son prix devrait se situer entre celui d´une GeForce2 Ti/Radeon 7500 et celui d´une GeForce3 Ti 200/Radeon 8500 LE ... il était donc utile de le comparer à ces processeurs ! Page 4 - GF4MX vs R8500LE/GF3Ti200 GeForce4 MX vs GF3 Ti 200 / R8500 LE    Là encore, les tests ont été effectués en 32 bits. Le GeForce4 MX 460 offre d’excellentes performances, puisqu’elles sont comparables voir supérieures à celles d’un GeForce3 Ti 200 ou d’un Radeon 8500LE dans les jeux OpenGL ou DirectX 7.  Le test sous Aquanox, l’un des seuls jeux utilisant les fonctions de DirectX 8 est très instructif. En effet, NVIDIA indique que le GeForce4 MX dispose officiellement d’un support ‘limité’ des Vertex Shaders. En fait, il s’agit tout simplement d’une émulation software (via le CPU) des Vertex Shaders. Du coup, même si avec le processeur puissant de la configuration de test (P4 2.2 GHz) le GeForce4 MX ne semble pas largué dans les benchmarks (qui indique la moyenne des FPS obtenus), la démo utilisée n’était pas du tout fluide du fait de saccades assez régulières, et ce même en 1024*768 32 bits. Au contraire, sur GeForce3 Ti 200 ou Radeon 8500, de telles saccades n’apparaissaient pas. Nous avons du coup effectué quelques tests en 640*480 32 bits afin d’être encore moins limité par la bande passante mémoire et le fillrate des cartes. Sur Pentium 4 2.2, nous obtenions 87 fps sur GF3 Ti 200 et 69.9 fps sur GF4 MX 460 (24% d’écart), contre 86.6 et 61.1 fps sur Pentium 4 1.5 GHz (42% d’écart). Le GeForce4 MX, même dans sa version 460, n’est donc pas vraiment taillé pour les jeux de demain, contrairement à ce que pourrait laisser penser sa dénomination au premier abord. Page 5 - Conclusion Conclusion  Faut t’il être déçu par les GeForce4 MX ? Effectivement, si l’on s’attendait à de véritables GeForce4, on est loin du compte puisqu’il s’agit plutôt d’une puce hybride entre GeForce2 et GeForce4. Il est néanmoins compréhensible que NVIDIA veuille clarifier sa gamme en se débarrassant de la cohabitation des GeForce2 et GeForce3 pour se concentrer seulement sur une marque forte, le GeForce4. Espérons seulement que les néophytes se renseigneront assez lors de leurs achats afin de ne pas prendre ces GeForce4 MX pour des GeForce4 Ti ‘light’. Faut t’il être déçu par les GeForce4 MX ? Effectivement, si l’on s’attendait à de véritables GeForce4, on est loin du compte puisqu’il s’agit plutôt d’une puce hybride entre GeForce2 et GeForce4. Il est néanmoins compréhensible que NVIDIA veuille clarifier sa gamme en se débarrassant de la cohabitation des GeForce2 et GeForce3 pour se concentrer seulement sur une marque forte, le GeForce4. Espérons seulement que les néophytes se renseigneront assez lors de leurs achats afin de ne pas prendre ces GeForce4 MX pour des GeForce4 Ti ‘light’.En dehors de ce point litigieux, le GeForce4 MX remplit bien son rôle. Ses fonctions dédiées au bi-écran ainsi qu’au MPEG-2 vont enfin permettre à NVIDIA de rattraper ATI dans ces domaines, et les GeForce4 MX 420 et 440 semblent bien positionnés. En effet, le GeForce4 MX 420 (100-120 €) est un excellent remplaçant du GeForce2 MX 400, tout comme le GeForce4 MX 440 (160 € environ) l’est par rapport au GeForce2 Ti. En fait, seul le positionnement du GeForce4 MX 460 est questionnable : en effet, quitte à vouloir des performances, autant investir dans une carte un peu plus chère de type Radeon 8500 LE / GeForce3 Ti 200 (voir GeForce4 Ti 4200 dans deux mois) qui offre en plus le support de DirectX 8.0. De bonnes performances dans les jeux actuels c’est bien, mais il faut aussi assurer le futur ! Il est au passage dommage que NVIDIA n’ai pas voulu intégrer de véritable support DX8 dans ces GeForce4 MX. En effet, la démocratisation des cartes supportant les Pixel & Vertex Shaders n’aurait pu qu’encourager les développeurs à utiliser ces fonctions ... car il faut bien avouer que pour le moment, en dehors de quelques titres, ce n’est pas la bousculade ! Copyright © 1997-2025 HardWare.fr. Tous droits réservés. |