| |

| Nvidia Titan X 12 Go en test : pour 1300€, Pascal enfonce le clou ! Cartes Graphiques Publié le Jeudi 4 Août 2016 par Damien Triolet URL: /articles/953-1/nvidia-titan-x-12-go-test-1300-pascal-enfonce-clou.html Page 1 - Introduction  Depuis la génération Kepler, Nvidia a introduit une nouvelle catégorie de cartes graphiques ultra haut de gamme sous la marque Titan. Des déclinaisons également qualifiées de semi-professionnelles puisqu'elles peuvent proposer certaines fonctionnalités liées au calcul intensif ou encore une quantité de mémoire supérieure, adaptée au travail sur de larges ensembles de données. Voici pour rappel la liste des cartes Titan qui ont été lancées et ce qu'elles apportent par rapport aux GeForce classiques du moment, en plus de leur puissance brute plus élevée :

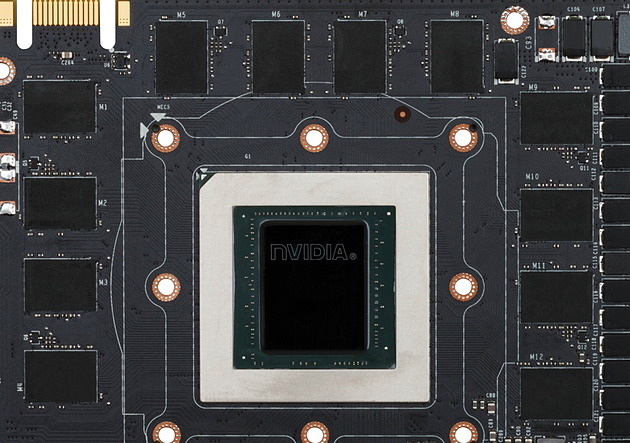

Progressivement, Nvidia a donc réduit les spécificités orientées "pro" des Titan. Cela n'empêche cependant pas le fabricant de pousser toujours plus cet aspect de ces cartes graphiques car il est vrai que certains professionnels qui ont besoin d'un maximum de mémoire ou de puissance de calcul peuvent y trouver un excellent compromis, s'ils n'ont pas besoin des fonctions spécifiques aux accélérateurs Tesla. C'est notamment le cas dans le domaine actuellement très animé du deep learning. Après quelques expérimentations, Nvidia doit en avoir conclu qu'il n'était pas nécessaire d'aller puiser dans les fonctionnalités habituellement réservées aux Tesla pour parvenir à toucher ce public. Pour renforcer quelque peu ce côté "pro", la nouvelle venue n'est d'ailleurs plus une GeForce GTX, c'est une Titan X "tout court". Mais ne vous y méprenez pas, c'est bien la division GeForce qui est responsable de ce produit, la carte graphique arbore toujours bien le logo GeForce GTX et les joueurs (fortunés) en restent une cible privilégiée. Grâce à un nouveau GPU, le GP102, cette Titan X (Pascal) va apporter un énorme gain en termes de performances par rapport à la GeForce GTX Titan X (Maxwell), avec laquelle il faudra éviter la confusion. Elle devrait également proposer de 25 à 30% de mieux que la GeForce GTX 1080 Founders Edition pour, on l'espère, pouvoir enfin jouer en 4K avec 60 fps et un niveau de qualité élevé sans avoir recours au multi-GPU. C'est ce que nous allons vérifier dans ce dossier, en n'oubliant pas d'observer la marge dont dispose son GPU au niveau de l'overclocking. Car après tout, cette Titan X est également un aperçu d'une future GeForce (un peu) plus abordable. A noter qu'elle est commercialisée exclusivement par Nvidia via sa propre boutique en ligne, et ce au tarif de 1300€ qui en fait en produit pour le moins exclusif. Tout comme cela a été le cas sur la génération Maxwell, Nvidia a développé au moins 3 GPU Pascal "G" destinés aux GeForce, qu'elles en portent ou pas officiellement le nom, en suivant à peu près des proportions de type 1, 2 et 3. Nous avons déjà pu apercevoir le numéro 2 avec le GP104 de la GeForce GTX 1080, et récemment le numéro 1 avec le GP106 de la GeForce GTX 1060. C'est cette fois le numéro 3 que Nvidia introduit aujourd'hui avec la nouvelle Titan X. Prénommé GP102, ce GPU embarque pas moins de 12 milliards de transistors et peut être vu comme une version "GeForce" du GP100 spécifique aux accélérateurs Tesla. Le GP102 reprend exactement la même architecture Pascal que les GP104 /GP106 et vous pourrez retrouver les détails la concernant dans les premières pages du dossier consacré à la GeForce GTX 1080. Comme les autres GPU Pascal, il est produit pour Nvidia par TSMC sur le procédé de fabrication 16 nm FinFET Plus (FF+). Après plus de 4 ans de GPU fabriqués en 28 nm chez le même TSMC, le passage au 16 nm FF+ représente une évolution significative qui permet de nouveaux compromis plus avantageux en termes de consommation énergétique, de performances et de fonctionnalités. Comme les GP104 et GP106, le GP102 profitent de circuits qui ont été travaillés de manière à pouvoir atteindre de très hautes fréquences sans pour autant sacrifier le rendement énergétique.  Le GP102 et ses 12 Go de mémoire GDDR5X interfacés en 384-bit.

Le GP102 et ses 12 Go de mémoire GDDR5X interfacés en 384-bit.Voici comment se situe le GP102 parmi les GPU récents :

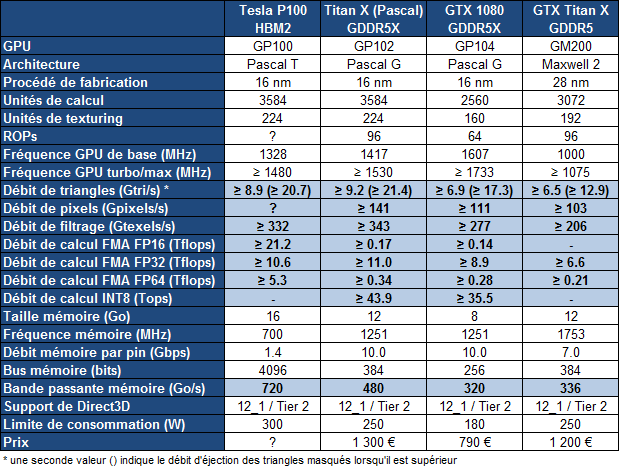

Le GP102 fait partie des gros GPU, même s'il se contente de 471 mm² et ne cherche pas à se rapprocher des limites du procédé de fabrication. Il représente probablement le plus gros GPU que l'architecture Pascal autorise dans le cadre d'une carte graphique raisonnablement refroidie. GP102 : GP104 x 1.5Pour comprendre l'architecture du GP102, quelques rappels s'imposent concernant la manière dont Nvidia schématise l'organisation interne de ses GPU. A un niveau élevé, ils se composent de un ou plusieurs GPC (Graphics Processing Cluster). Chacun contient un rasterizer chargé de projeter les primitives et de le découper en pixels. A l'intérieur de ces GPC, nous retrouvons un ou plusieurs TPC (Texture Processor Cluster). Ne vous fiez pas à ce nom, vestige de précédentes architectures, le TPC est aujourd'hui décrit comme la structure qui représente le Polymorph Engine, nom donné à l'ensemble des petites unités fixes dédiées au traitement de la géométrie (chargement des vertices, tessellation etc.). Enfin, au plus bas niveau, ces TPC intègrent un ou plusieurs SM (Streaming Multiprocessor) qui représentent le coeur de l'architecture. C'est à leur niveau que prennent place les unités de calcul (affreusement appelés "CUDA cores" par le marketing), les unités de texturing, les registres ou encore la mémoire partagée utile au GPU computing. Sur base de ces éléments, voici comment est organisé le GP102 ainsi que la version qui en est exploitée sur la Titan X :  [ GP102 ] [ GP102 sur Titan X ? ] [ GP102 sur Titan X ? ] Nous pouvons observer que le GP102 intègre 6 GPC, soit deux de plus que pour le GP104. Ils contiennent chacun 5 SM, comme pour les autres GPU de la famille. L'interface mémoire progresse également de 50% avec 96 ROP et un bus 384-bit. Pour la Titan X, Nvidia a désactivé 2 SM, de manière à faciliter la production en autorisant la validation de certaines puces qui ont de petits défauts sur certains SM. Nous ne savons pas comment ces 2 SM sont répartis dans les GPC. A noter que s'ils sont désactivés dans le même GPC, le fillrate sera réduit de 96 à 92 pixels par cycle, ce qui semble être le cas sur notre échantillon de test. Nous ne savons pas si ce cas de figure est généralisé, mais l'impact sur les performances devrait être minime. Voici pour comparaisons les spécificités de quelques GPU Nvidia sur 3 générations :

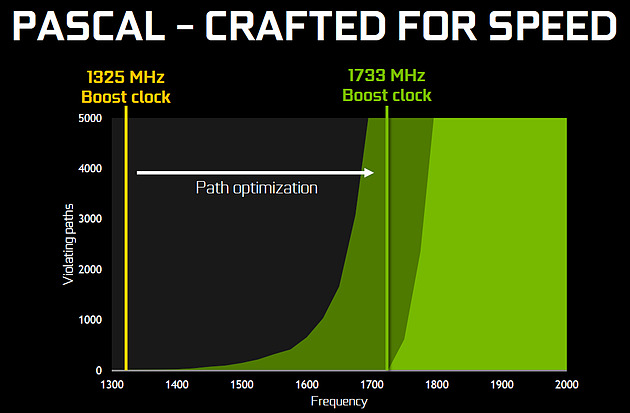

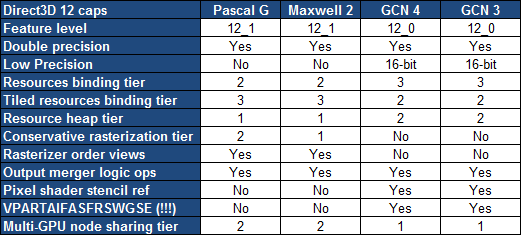

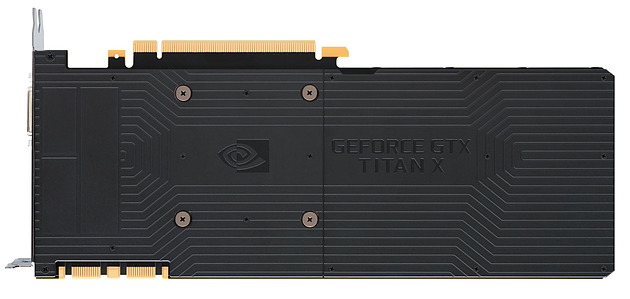

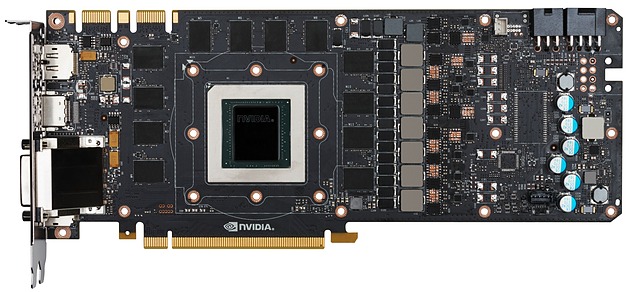

Par rapport au GM200, le GP102 apporte 25% d'unités de calcul et de texturing en plus, un chiffre qui tombe à 17% si nous prenons en compte la version exploitée sur la Titan X. Ce n'est pas très impressionnant vu sous ce seul aspect, mais il ne faut pas oublier que la fréquence va faire un bond énorme en avant :  Nvidia nous avait indiqué ne pas avoir travaillé particulièrement les fréquences du GP100, qui profite simplement des gains automatiques liés au 16 nm, mais il en va tout autrement pour les GP102, GP104 et GP106. Nvidia explique avoir passé en revue le moindre circuit du GPU pour retravailler tout point faible qui entravait la montée en fréquence. De quoi pouvoir proposer une fréquence turbo de référence de 1530 MHz sur la Titan X (Pascal) soit un bond énorme de 42% par rapport aux 1075 MHz du GM200 qui équipe la GTX Titan X (Maxwell). Et cela tout en laissant une marge d'overclocking importante puisque ces GPU Pascal G sont capable d'atteindre 2 GHz, à condition de pouvoir alimenter et refroidir la bête bien entendu ! Pour accompagner cette évolution de la puissance du GPU, il faut évidemment une interface mémoire capable de l'alimenter correctement. Nvidia reprend ici la même GDDR5X que celle introduite avec la GTX 1080. Elle permet d'atteindre un débit par pin de 10 Gbps, 43% plus élevé que les 7 Gbps de la mémoire exploitée sur la génération précédente. Et pour aller un peu plus loin dans la progression, Nvidia a pour rappel amélioré son système de compression sans perte du framebuffer. Plus spécifiquement, c'est le codage différentiel pour les couleurs, également appelé compression delta, qui progresse à nouveau. De quoi faire progresser la bande passante mémoire effective de 20% supplémentaires par rapport aux GPU Maxwell. Pascal et deep learningLe deep learning, ou l'apprentissage progressif par un réseau de neurones artificiels, est un débouché pour les GPU qui intéresse fortement Nvidia, même s'il s'agit d'un monde qui bouge beaucoup et dans lequel il est difficile de dire quelle solution s'imposera. Actuellement, les GPU Nvidia font parties des solutions les plus utilisées, notamment grâce à l'ensemble de bibliothèques et de SDK qui sont proposés aux développeurs. C'est le cas de cuDNN (CUDA Deep Neural Network) qui évolue progressivement et dont la version 5 promet des gains conséquents. Elle n'est cependant pas encore disponible publiquement pour la RC de CUDA 8.0 qui est optimisée pour les GPU Pascal. Car les GPU Pascal ont certains avantages sur leurs prédécesseurs quand il s'agit de traiter les algorithmes liés au deep learning et particulièrement l'inférence qui consiste en l'exploitation par un "client" d'un réseau neuronal qui a été entraîné au préalable. C'est par exemple le cas du système de pilotage d'une voiture. Alors que le GP100 dispose d'unités de calcul capable de traiter le format FP16 à double vitesse, pour doubler la puissance de calcul quand une faible précision est suffisante, les autres GPU Pascal, les GP102/GP104/GP106, profitent de deux instructions spécifiques à l'inférence : DP4A et DP2A. Il s'agit de produits scalaires avec accumulation qui ont la particularité d'exploiter des valeurs 8-bit et 16-bit associées dans des registres 32-bit. Avec un support natif de ces instructions, il est donc possible de traiter ces opérations 4x plus rapidement (INT8 avec DP4A) ou 2x plus rapidement (INT16 avec DP2A). Voici la description qui en est faite dans le guide de CUDA 8.0 : DP4A : DP2A : Ces instructions DP4A et DP2A sont spécifiques au niveau de fonctionnalité CUDA sm_61 qui correspond aux GP102, GP104 et GP106. Le GP100 est de niveau sm_60 et ne supporte donc pas ces instructions, ce qui est étrange même s'il est plutôt dédié à l'entraînement des réseaux neuronaux qu'à l'inférence. Si Nvidia met fortement en avant ce point avec la Titan X, ce n'est pas une fonctionnalité que lui est exclusive. Toutes les GeForce et Quadro Pascal peuvent également profiter de ces instructions à leur débit maximal.  La Titan X embarque un GPU GP102 partiellement castré, donc 6.666% des unités de calcul ont été désactivées. Ce qui au final très peu et permet un nouveau record au niveau de la puissance de calcul est atteint avec 11 Tflops, c'est 23% de mieux que pour la GeForce GTX 1080 alors que la bande passante augmente de 50%. De quoi laisser espérer une progression des performances de 30% qui va creuser encore un peu plus le fossé qui sépare actuellement les GeForce haut de gamme des Radeon. Nous pouvons observer que cette nouvelle Titan X se contente d'une fréquence GPU inférieure à celle de la GTX 1080 avec une fréquence GPU Boost officielle de 1.53 GHz. En pratique, le GP102 est capable d'atteindre des fréquences similaires à celles des GP104 et GP106, mais l'enveloppe thermique de la Titan X tient en laisse le GP102. Sa fréquence se réduit rapidement par rapport au maximum atteint par la carte, raison pour laquelle Nvidia communique sur un turbo relativement faible. La limite de consommation est plutôt large avec 250W, comme pour la GTX Titan X précédente, mais c'est plutôt la capacité de refroidissement du ventirad qui définira la puissance soutenue et donc la fréquence que l'on observe en pratique. Nous avons ensuite rassemblé les fonctionnalités exposées à travers Direct3D 12 :  La seule évolution notable entre les GPU Maxwell 2 et Pascal G concerne un support plus évolué de la rastérisation conservative. La nouvelle déclinaison de l'architecture GCN introduite avec la RX 480 n'apporte le support d'aucune nouvelle fonctionnalité de DirectX alors que nous espérions que les Radeon rattrapent les GeForce sur le niveau 12_1. Les GPU AMD conservent globalement un avantage avec plus de flexibilité au niveau de la gestion des ressources mais les GeForce Maxwell et Pascal sont les seules à supporter les Volume tiled resources. L'accès aux données entre GPU (en dehors des copies) est également plus flexible en SLI qu'en CrossFire. La nouvelle Titan X (Pascal) est exclusivement proposée par Nvidia, qui n'en fournit pas les éléments à ses partenaires pour que ceux-ci en proposent des designs alternatifs. A moins qu'ils n'aient l'autorisation d'acheter des cartes complètes à Nvidia pour les modifier et les revendre par la suite, c'est le seul design qui sera proposé avec un tarif de 1300€ en France. La Titan X reprend le même design et le même ventirad que la GeForce GTX 1080 Founders Edition, mais avec un coloris noir/argent au lieu d'argent/noir :  La coque extérieure, à la finition toujours irréprochable, est faite d'aluminium et propose un style plus agressif que pour les anciens modèles. Petite évolution par rapport à la GTX 1080 Founders Edition, l'élément décoratif de le turbine est dorénavant incrusté dans sa coque et non collé dessus, ce qui améliore la finition et évite l'impression d'un ventilateur qui tourne carré quand il n'a pas été parfaitement centré. Pour cette carte graphique qu'il ne faut absolument pas appeler une GeForce, un logo GeForce GTX vert illuminé par LED est présent sur la tranche. Son intensité lumineuse peut être contrôlée via GeForce Experience. C'est bien entendu subjectif, mais nous aurions préféré que Nvidia opte pour un coloris noir/noir comme sur la GeForce GTX Titan X Maxwell.  Comme la GTX 1080 FE, la Titan X reçoit une backplate. Celle-ci gagne en qualité et en minceur par rapport à la plupart des backplate et est pour la première fois exploitée sur un design de type 250W. Nvidia a eu la très bonne idée de la composer de deux pièces de manière à permettre de dégager l'arrière de la carte pour favoriser un meilleur apprivoisement en air dans le cadre du multi-GPU ou encore pour optimiser le refroidissement de l'étage d'alimentation si cela s'avérait nécessaire. A travers son système de fixation, elle participe quelque peu à dissiper la chaleur sur la zone autour du GPU. Du côté de l'étage d'alimentation, un tout petit pad thermique est placé sur un contrôleur présent à l'arrière du PCB et est en contact avec l'autre partie de la backplate. A noter que le démontage de chaque partie de la backplate, qui ne désolidarise pas le ventirad du PCB et n'annule pas la garantie, se fait via de nombreuses vis aussi fragiles que petites. Lors du remontage ne tentez pas de les serrer plus que très légèrement sans quoi la tête de vis se brise très facilement.  Le refroidissement est assuré par une turbine qui expulse de l'air à travers un radiateur en aluminium. Ce bloc de refroidissement est identique à celui de la GTX 1080 FE avec une chambre à vapeur à la base du radiateur, mais la turbine est par contre un modèle plus musclé que monte à 4800 RPM au lieu de 4000 RPM. Alors que la limite de consommation de la carte passe de 180W à 250W, comment se fait-il que cette Titan X s'en sorte sans évolution du bloc de refroidissement ? Pour plusieurs raisons : la courbe de ventilation est différente avec une limite de température du 84 °C au lieu de 83 °C (1 °C suffit pour avoir un impact notable) et la capacité de refroidissement augmente mécaniquement avec la taille de la puce à refroidir qui passe de 314 mm² à 471 mm². Malgré cela, la Titan X sera plus limitée par son système de refroidissement que ne l'est la GTX 1080 FE.  Le PCB est de son côté spécifique à la Titan X et probablement très proche de celui de la Quadro P6000 basée sur le même GPU. Des connecteurs SLI sont présents, la carte étant compatible avec le multi-GPU, ce qui n'est plus le cas de toutes les GeForce. Le PCB est prévu pour accueillir jusqu'à 7 phases pour le GPU et elles sont toutes exploitées. Deux de plus sont dédiées à la mémoire GDDR5X 10 Gbps de Micron. Ces étages d'alimentations sont approvisionnés via 3 sources de 12V : un connecteur 8 broches, un connecteur 6 broches et le bus PCI Express. Un espace a été prévu pour recevoir des composants supplémentaires mais nous n'avons aucune information concernant ce dont il s'agit.  Enfin, la connectique vidéo est similaire à celle des autres GeForce de référence : une DVI Dual Link, une HDMI et 3 DisplayPort, dont 4 peuvent être utilisées simultanément. Il y a cependant une petite différence visible pour les plus attentifs : il s'agit d'une sortie DVI-D et non plus DVI-I. En d'autres termes, la Titan X ne supporte pas la connectique VGA. Pour ce dossier, nous avons repris le protocole utilisé dans les derniers tests, mais en mettant bien entendu à jour l'ensemble des jeux. Tous les derniers patchs au 01/08/2016 ont été installés, la plupart des jeux étant maintenus à jour via Steam/Origin/Uplay. Nous en avons profité pour utiliser les pilotes 368.98 pour toutes les GeForce et les Crimson Edition 16.8.1 pour la Radeon R9 Fury X. Nous avons tout d'abord opté pour la résolution de 1440p sur base du niveau de détail maximal en évitant, sauf exception, d'activer l'antialiasing de type supersampling, ou SSAA, que nous jugeons beaucoup trop gourmand par rapport à ce qu'il apporte. Nous avons ensuite effectué des mesures en 4K avec un niveau de détail très élevé, qui correspond à ce que nous estimons être nécessaire pour réellement profiter de cette résolution. A quoi bon opter pour une image haute résolution si c'est pour la remplir d'ombres basses résolution pour assurer la fluidité ? L'occasion de vérifier s'il est enfin possible de jouer en 4K sans compromis. Toutes les cartes ont été testées avec une température ambiante contrôlée à 26 °C et, pour chaque jeu, nous avons pris le temps nécessaire pour que la température et la fréquence GPU se stabilise. Rappelons que nous avons mis à jour notre plate-forme de test qui est passée au X99 et au Core i7-5960X, poussé à 4 GHz. Au niveau de l'affichage, pour les tests jusqu'en 1440p nous avons opté pour l'Asus ROG Swift PG278Q mais limité à 120 Hz, certaines Radeon étant capricieuses en 144 Hz avec certains câbles sur ce moniteur. G-Sync était désactivé. Configuration de test

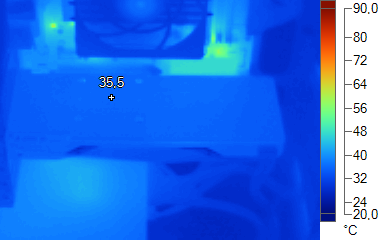

Nous avons mesuré les performances lors de l'accès aux textures avec filtrage bilinéaire activé et ce, pour différents formats : en 32 bits classique (8x INT8), en 64 bits "HDR" (4x FP16), en 128 bits (4x FP32), en profondeur de 32 bits (D32F) et en FP10, un format HDR introduit par DirectX 10 qui permet de stocker des textures HDR en 32 bits avec quelques compromis. Les GeForce GTX sont capables de filtrer les textures FP16 à pleine vitesse contrairement aux Radeon, ce qui leur donne un avantage considérable sur ce point. Le GP102 impose un nouveau record au niveau du débit de textures filtrées. FillrateNous avons mesuré le fillrate sans et puis avec blending, et ce avec différents formats de données : [ Standard ] [ Avec Blending ] Avec ses derniers GPU, qu'il s'agisse de Fiji ou de Polaris P10, AMD n'a pas fait évoluer le nombre de ROP ce qui les place en net retrait par rapport à la concurrence. Il n'y a qu'en HDR 64-bit qu'ils restent équivalents aux GeForce au niveau du fillrate. Ces dernières profitent d'une très haute fréquence GPU pour rentabiliser au maximum leurs ROP. Et avec 96 ROP, le GP102 s'impose facilement en haut du classement, même s'il reste en retrait par rapport au débit qu'ils autorisent. Ce que nous suspectons être lié à la désactivation de 2 SM dans le même GPC ce qui limite le fillrate à 92 pixels par cycle au lieu de 96. A noter que les GeForce depuis Kepler sont capables de transférer les formats FP10/11 et RGB9E5 à pleine vitesse vers les ROP, comme les Radeon, mais le blending de ces formats se fait toujours à demi vitesse. Par ailleurs, si tous les GPU sont capables de traiter le FP32 simple canal à pleine vitesse sans blending, seules les Radeon conservent ce débit avec blending. Les GeForce traitent le blending en FP32 à une vitesse de 1/8ème alors que ce format est "seulement" 4x plus gros que l'INT8. Par conséquent la limite au niveau du fillrate se transfère à leur niveau, ce qui permet de confirmer, autant en 1x FP32 qu'en 4x FP32, que la GTX 1060 et le GP106 disposent bien de 48 ROP fonctionnels. Étant donné les différences architecturales des GPU récents au niveau du traitement de la géométrie, nous nous sommes évidemment penchés de plus près sur le sujet. Tout d'abord nous avons observé les débits de triangles dans deux cas de figure : quand tous les triangles sont affichés et quand ils sont tous rejetés (parce qu'ils tournent le dos à la caméra) : Notre test atteint de toute évidence ses limites et a du mal à saturer un GPU aussi performant que le GP102 sur le plan du débit maximal de culling. Si les triangles sont affichés, on peut par contre observer qu'il domine largement la discipline. Ensuite nous avons effectué un test similaire mais en utilisant la tessellation. A noter que nous avons quelque peu revu notre test de manière à l'adapter à la puissance en hausse des GPU : Là aussi, notre test arrive dans ses limites. Les GeForce réaffirment ici leur avantage face aux Radeon qui peuvent se retrouver plus rapidement submergées en cas de génération massive de données ou de hull shaders lourds. Les GeForce profitent d'une architecture qui distribue le traitement géométrique au niveau des SM ainsi que de groupes de threads plus petits (32 vs 64) qui facilitent le maintien d'un taux d'occupation élevé. Nous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 10 et en veille écran. Pour la charge, nous testons d'une part Battlefield 4 en mode Ultra qui représente un jeu moyennement lourd et d'autre part The Witcher 3 qui remplace Anno 2070 pour représenter un jeu très lourd. Si ce dernier est à peu près aussi lourd qu'Anno 2070 pour les GeForce, il l'est par contre un peu moins pour les Radeon. Nous réévaluerons éventuellement la possible utilisation d'un autre jeu dans le futur. Nous avons testé les cartes graphique Nvidia de référence en mode 'Uber', ce qui consiste à relever leurs limites de consommation et de température au maximum pour voir ce qu'elles ont dans le ventre sans ces dernières. Aucun overclocking n'est par contre appliqué mais le turbo par défaut se maintient à une fréquence plus élevée. La consommation au repos du GP102 semble nettement supérieure à celle du GP104 est reste similaire à celle des GPU Maxwell. En charge, le système de refroidissement de la Titan X (Pascal) la limite à plus ou moins 210W sur notre band de test. C'est plus que les 155W de la GTX 1080 FE mais un peu moins que les 225W de la GTX Titan X alors que le ventirad est similaire, tout comme leur limite de consommation de 250W. C'est probablement lié à la taille de la puce qui est plus petite, à la calibration de la courbe de ventilation ainsi qu'au rendement supérieur de l'étage d'alimentation des dernières cartes graphiques Nvidia qui fait qu'une plus grosse partie de la consommation est dissipée par le ventirad. En mode 'Uber', la limite de consommation de la Titan X passe à 300W, contre "seulement" 275W pour la GTX Titan X. Et dans les jeux les plus gourmands, le GP102 profite pleinement de toute cette marge de manoeuvre. Bien que ces données soient approximatives, compte tenu de la variation entre échantillons d'un même modèle, nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles, de quoi donner une idée globale sur le rendement énergétique de toutes ces cartes : [ Battlefield 4 ] [ The Witcher 3 ] La Titan X (Pascal) affiche un rendement énergétique légèrement inférieur à celui de la GTX 1080 FE, mais qui reste dans le haut du panier et représente une grosse évolution par rapport à la génération précédente. En mode 'Uber', il se réduit, ce qui est logique vu que le GPU profite de toute la marge et voit sa tension augmenter significativement. Nous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge sous le test1 de 3DMark11. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe à moins de 20 dBA, ce qui est la limite de sensibilité pour laquelle il est certifié et calibré. Au repos, la Titan X se comporte comme la GTX 1080, leurs turbines étant calibrées pour une même vitesse minimale de 1100 TPM. En charge la Titan X n'est pas plus bruyante que la GTX 1080 FE, malgré la consommation supérieure, ce qui est plutôt une bonne nouvelle. Rappelons que comme pour les précédentes GeForce GTX équipées du ventirad maison haut de gamme, ces cartes produisent un souffle étouffé qui est peu désagréable, moins gênant que le bruit plus faible produit par certaines cartes personnalisées ou par des turbines d'entrée de gamme. En mode 'Uber' par contre, les nuisances explosent, la Titan X ayant à prendre en charge 300W. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne : Par défaut, la Titan X (Pascal) est bridée par sa limite de température de 84 °C, tout comme le sont les GTX 1080 FE et GTX Titan X par leur limite de 83 °C. En mode 'Uber' par contre la limite est de 90/92 °C n'est donc pas atteinte. Thermographie infrarougeVoici les photos thermiques obtenues avec à chaque fois 45 minutes de mise en situation :  [ GeForce GTX 1080 sans backplate - Repos ] [ Charge ] [ Charge 'Uber' ] [ Titan X (Pascal) avec backplate - Repos ] [ Charge ] [ Charge 'Uber' ] [ Titan X (Pascal) sans backplate - Repos ] [ Charge ] [ Charge 'Uber' ] [ GeForce GTX Titan X - Repos ] [ Charge ] [ Charge 'Uber' ] Pas de problème particulier à noter au niveau du refroidissement des VRM de la Titan X. Ils chauffent nettement plus en mode 'Uber' mais restent sous les 90 °C, ce qui est très raisonnable pour ce type de composants.  Nous lançons le test Fire Strike avec les presets standard et extrême proposés par Futuremark. Le mode ultra passe à la trappe, n'apportant pas réellement d'information utile de plus par rapport au mode extrême. A la place nous intégrons le nouveau Time Spy. A noter qu'avec les dernières mises à jour de 3DMark, les performances en mode standard baissent quelque peu pour l'ensemble des cartes testées. Elles progressent par contre en général très légèrement en mode extrême. [ Fire Strike ] [ Fire Strike Extreme ] La Titan X deviance la GTX 1080 FE de 28% dans Fire Strike et de 31% dans Fire Strike Extreme. 3DMark Time SpyNous lançons ensuite le nouveau test Time Spy qui exploite l'API Direct3D 12 : Dans Time Spy le gain est de 26% sur la GTX 1080 FE.  Après plusieurs années de bons et loyaux services, notamment en matière de mesure de l consommation, nous avons mis Anno 2070 à la retraite. Il est remplacé par Anno 2205, un peu plus lourd graphiquement mais moins gourmand énergétiquement. En 1440p, nous utilisons le mode de qualité maximale du jeu, qui inclut du MSAA 8x, et effectuons un déplacement sur une carte en mesurant les performances avec Fraps. Le jeu est maintenu à jour via Uplay. Dans ce premier jeu testé, plusieurs cas particuliers sont à observer. Tout d'abord, le SLI ne fonctionne pas. Ensuite, le moteur graphique semble profiter plus d'une haute fréquence que d'un GPU plus large ce qui peut laisser penser que le processeur de commandes limite ici quelque peu la Titan X. Nous passons ensuite en 4K, mode dans lequel nous nous contentons par ailleurs du MSAA 2x : Par rapport à la GTX 1080 FE, la Titan X se comporte un peu mieux en 4K dans ce jeu.  Ashes of the Singularity est un des premiers jeux DirectX 12 disponible. Il a la particularité d'être conçu en terme de gameplay pour ces nouvelles API avec des scènes très lourdes qui ont besoin d'un surcoût réduit des commandes de rendu ainsi que d'une bonne exploitation des CPU multicoeurs. Par ailleurs, AotS intègre un support du multi engine destiné à booster les performances GPU, ce qu'AMD appelle Async Compute. Cette option apporte des gains sur les Radeon mais est contreproductive ou n'a pas d'effet sur les GeForce, y compris sur la GTX 10x0. Nous avons utilisé la configuration par défaut du jeu qui active Async Compute sur Radeon et le désactive sur GeForce. Nous utilisons une partie du benchmark intégré avec un niveau de qualité Crazy en 1440p avec du MSAA 2x et en mode DirectX 12. Le jeu est maintenu à jour via Steam. La Titan X se place cette fois clairement en tête et la R9 Fury X se comporte très bien. Une fois le multi-GPU activé, le jeu plantait au démarrage. Nous avons donc dû nous contenter d'un GPU actif sur le système SLI. Nous passons ensuite en 4K, mode dans lequel nous nous contentons du niveau de qualité extrême sans MSAA : Cette fois le jeu accepte de tourner sur le système SLI qui prend la tête, mais la Titan X reste bien placée pour profiter de ce jeu dans cette résolution.  Battlefield 4 repose sur le moteur Frostbite 3, une évolution de la version 2 présente dans Battlefield 3. La base du rendu reste très proche (rendu différé, calcul de l'éclairage via compute shaders) et les évolutions visibles sont mineures, DICE ayant principalement optimisé son moteur pour les consoles de nouvelle génération. Parmi les petites nouveautés, citons un support plus avancé de la tessellation et une amélioration du module "destruction" du moteur. Sur PC, un mode Mantle spécifique aux Radeon et qui permet de réduire le coût CPU du rendu est proposé mais nous ne l'avons pas utilisé pour ce test. Pour rappel, il s'agit d'une API propriétaire de plus bas niveau dédiée aux Radeon HD 7000 et supérieures, qui a été développée par AMD et DICE. Depuis l'arrivée d'autres API de bas niveau, AMD a cependant cessé les développements autour de Mantle et n'a pas optimisé son utilisation dans les pilotes pour ses derniers GPU. Nous testons le mode Ultra avec MSAA 4x et nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin. Les GeForce sont beaucoup plus efficaces que les Radeon sous le Frosbite Engine avec MSAA. Nous passons ensuite en 4K : Le classement est similaire et la Titan X Pascal dépasse facilement les 60 fps.  Crysis 3 reprend le même moteur que Crysis 2 : le CryEngine 3. Ce dernier profite cependant de quelques petites évolutions telles qu'un support plus avancé de l'antialiasing : FXAA, MSAA et TXAA sont au programme, tout comme un nouveau mode appelé SMAA. Il s'agit d'une évolution du MLAA qui permet, optionnellement, de prendre en compte des données de type sous-pixels soit à travers la combinaison avec du MSAA 2x, soit avec une composante temporelle calculée à partir de l'image précédente. Le SMAA 1x est la simple évolution du MLAA, le SMAA 2tx utilise une composante temporelle relativement complexe et le SMAA 4x y ajoute le MSAA 2x. Notez qu'il ne faut pas confondre le SMAA 2tx proposé en mono-GPU avec le SMAA 2x proposé en multi-GPU, ce dernier utilisant du MSAA 2x sans composante temporelle. En 1440, nous mesurons les performances avec Fraps en très haute qualité avec SMAA 4x. Le jeu est maintenu à jour via Origin. Crysis 3 reste un jeu très gourmand lorsque l'on pousse ses options graphiques. La Titan X est cependant capable d'encaisser la charge. Nous passons ensuite en 4K en conservant la très haute qualité mais avec du SMAA 1x : Cette fois impossible pour la Titan X de s'approcher des 60 fps avec ce niveau de qualité qui propose pourtant des détails qui peuvent profiter de la 4K. Et ne comptez pas sur le SLI de GTX 1080 FE pour faire mieux, la fluidité est très mauvaise dans ce jeu.  Après une longue période en version beta, DiRT Rally est finalement sorti en version finale fin 2015. Il vient logiquement remplacer GRID 2 dans notre panel de test. Nous mesurons les performances avec Fraps sur une scène de test personnalisée qui inclut l'éclairage de nuit ainsi qu'une forte pluie. Toutes les options sont poussées au maximum, ce qui inclut l'advanced blending qui a un impact élevé sur les Radeon, ainsi que le MSAA 8x. Le jeu est maintenu à jour via Steam. Comme prévu la Radeon souffre alors que la Titan X profite d'un SLI peu efficace pour très bien se positionner. Nous passons ensuite en 4K en désactivant l'advanced blending et en réduisant le MSAA au 4x : La Radeon et le système SLI apprécient la désactivation de l'advanced blending. La Titan X s'en tire plutôtbien.  La nouvelle mouture de DOOM conserve la tradition d'un moteur graphique OpenGL mais vient de recevoir en option un moteur Vulkan. Une API qui fait donc son apparition dans notre suite de test. Le jeu n'est pas extrêmement gourmand, mais il est plutôt bien optimisé et atteint facilement 150 à 200 fps sur notre Core i7-5960X poussé à 4 GHz. Nous mesurons les performances avec Fraps sur un parcours bien défini. Le jeu est maintenu à jour via Steam. Nous avons activé le niveau de qualité nightmare et le mode Vulkan. Avec celui-ci, les GeForce Maxwell et Pascal profitent d'un petit gain de 1 à 5% très loin de celui obtenus sur Radeon qui peut monter jusqu'à 40%. Nvidia nous a indiqué que cela serait corrigé via un futur pilote. La Radeon profite pleinement de la version Vulkan pour monter d'un cran et se rapprocher de la GTX 1080 FE. La Titan X n'est cependant pas inquiétée. Le SLI n'est pas supporté et un seul GPU est actif, impacté qui plus est par le second qui entrave son flux d'air. Nous passons ensuite en 4K : Avec une moyenne de près de 80 fps, la Titan X permet de profiter de cette résolution sans soucis.  Dying Light est un jeu de type survival horror animé par le Chrome Engine 6 de Techland et dans lequel le monde est plutôt vaste et ouvert. Nvidia a travaillé avec Techland pour y inclure certains effets issus de ses librairies Gameworks tels que le HBAO+ et le Depth of Field. Nous avons mesuré les performances avec Fraps sur un parcours bien défini en qualité maximale en 1440p. Le jeu est maintenu à jour à travers Steam. Dying Light souffrait de micro-saccades régulières qui impactaient fortement la fluidité sous Windows 7 et avec toutes les cartes, mais elles ont disparu lors du passage à Windows 10. Les GeForce sont plus à l'aise que les Radeon dans ce jeu. Nous passons ensuite en 4K, mode dans lequel nous avons désactivé le PCSS : La Titan X s'en tire avec un bon niveau de performances.  Fallout 4 repose sur une version améliorée du Creation Engine introduit avec Skyrim et développé en interne par Bethesda. Un moteur qui permet de pousser la qualité graphique vers le haut par rapport au Gamebryo exploité pour les jeux de la génération précédente dont faisait partie Fallout 3. Dans la version qui équipe Fallout 4, l'éclairage gagne en réalisme notamment avec le passage au physically-based deferred renderer et l'ajout d'une composante volumétrique pour représenter l'atmosphère. La version la plus évoluée de cet effet a été développée en collaboration avec Nvidia et fait appel à la tessellation. Au niveau de l'antialiasing les options proposées sont par contre assez pauvres avec au mieux un Temporal AA qui fonctionne plutôt bien mais uniquement en mouvement constant. A l'arrêt ce type d'antialiasing est évidemment limité dans son action. Nous testons Fallout 4 avec Fraps sur un parcours bien défini en poussant les options au niveau Ultra avec en plus le HBAO+ et les lumières volumétriques en Ultra. Le jeu est maintenu à jour via Steam. La Radeon est également en retrait dans ce jeu et le SLI fonctionne plutôt bien. Nous passons ensuite en 4K en nous contenant du niveau Ultra classique : La Titan X atteint tout juste les 60 fps de moyenne.  Dernier opus de la série, Far Cry Primal nous envoie chasser le mammouth dans la préhistoire. Il est graphiquement similaire à Far Cry 4 même si son moteur graphique a reçu quelques petites améliorations. En 1440p, nous activons le niveau de qualité Ultra du jeu avec du SMAA 1x. Nous utilisons Fraps sur un parcours bien défini et le jeu est maintenu à jour via Uplay. Le classement est plutôt logique et quand le SLI fonctionne bien, il est nettement devant la Titan X. Nous passons ensuite en 4K, en conservant le niveau ultra : Quelques difficultés avec ce niveau de qualité pour la Titan X qui n'atteint pas les 60 fps mais affiche malgré tout une belle progression par rapport à la GTX 1080 FE.  Enfin, après de nombreuses demandes, nous avons ajouté GTA V à notre protocole de test. Plutôt gourmand du côté des GPU, il propose de nombreuses options graphiques. Nous testons le jeu avec Fraps en qualité maximale à l'exception du MSAA qui reste en 4x, le 8X étant trop gourmand et peu uitle. Le jeu est maintenu à jour via Steam. Le SLI est moyennement efficace dans ce jeu et la Titan X offre au ressenti une meilleure fluidité. Nous passons ensuite en 4K en désactivant le MSAA : Le classement des carte est similaire et la Titan X est adaptée à ce niveau de qualité.  Cette dernière mouture d'Hitman, proposée sous la forme d'épisodes, a la particularité de supporter DirectX 12, mode qui est devenu légèrement plus performant avec les derniers patchs et pilotes, autant pour les Radeon que pour les GeForce. Nous l'avons donc préféré au mode DirectX 11. Pour mesurer les performances en 1440p, nous poussons les options graphiques au niveau Ultra et utilisons Fraps dans le jeu maintenu à jour via Steam. C'est le jeu dans lequel la Radeon est le plus à l'aise et dans lequel la nouvelle Titan X affiche le gain le plus faible. Le SLI ne fonctionne pas en DX12 et n'apporte qu'un maigre gain dans le mode DX11 que nous avons utilisé à la place. Nous passons ensuite en 4K : Le SLI est cette fois plus utile mais des saccades plus importantes se font ressentir et le confort de jeu n'est pas là. La Titan X s'en tire mieux avec "seulement" 50 fps.  Project Cars est un jeu de course automobile développé depuis 2011 sur base d'un système de beta participative qui permettait d'accéder aux nouvelles builds régulières et d'interagir avec les développeurs de Slightlymad Studios (à l'origine des Need For Speed Shift). Son moteur au rendu différé supporte DirectX 11 et c'est ce mode que nous avons testé en poussant toutes les options au niveau maximal à l'exception de l'antialiasing qui monte par contre au DS4x. Nous avons testé le jeu via Fraps sur un parcours bien défini et avec de la pluie au niveau des conditions météo. Un détail important à préciser puisqu'il réduit significativement les performances. Nous avons opté pour 7 concurrents qui restent devant nous pendant la mesure des performances. Les Radeon ont beaucoup de mal dans ce jeu très attendu et ce n'est pas nouveau. Critiqué pour avoir favorisé Nvidia, le développeur s'est justifié en expliquant que ce n'était pas du tout le cas, mais qu'AMD n'avait pas voulu collaborer en amont de la sortie du jeu pour s'assurer d'optimiser les performances. Difficile de savoir ce qu'il s'est réellement passé, mais depuis AMD a commencé à progressivement introduire quelques optimisations spécifiques dans ses pilotes, sans grand succès comme vous allez le voir. Sans le MSAA, la Radeon se comporte assez bien par rapport à la GTX Titan X Maxwell. Par contre les GPU Pascal voient leurs performants faire un net bond. Nous passons ensuite en 4K avec du MSAA au lieu du DS4X : Le classement est similaire à la Titan X permet de jouer confortablement.  Le précédent Tomb Raider était déjà plutôt réussi graphiquement, et le nouveau titre va encore plus loin. Une vraie réussite qui se traduit par une gourmandise qui peut être élevée. Les développeurs ont cette fois travaillé avec Nvidia et proposent la première implémentation du VXAO, une technique de calcul de l'occultation ambiante dérivée du VXGI spécifique aux GPU Maxwell et Pascal. Nous poussons la qualité au niveau maximal avec HBAO+ et puis VXAO. Nous mesurons les performances sur un parcours bien défini avec Fraps. Le jeu est maintenu à jour via Steam. [ HBAO+ ] [ VXAO ] Avec HBAO+, le positionnement des cartes est ici proche de la moyenne. L'activation du VXAO réduit les performances d'un peu moins de 20%, ce que la Titan X encaisse sans broncher. Nous passons ensuite en 4K en nous contentant du mode de qualité très élevé prévu par le jeu : Le positionnement des différentes cartes est similaire à celui observé en 1440p, mais les performances sont en nette baisse. La Titan X reste un peu juste pour profiter de ce jeu avec ce niveau de qualité.  Développé par EA DICE, Star Wars Battlefront exploite comme vous vous en doutez le moteur maison Frostbite 3 qui a été introduit avec Battlefield 4. Il s'en distingue cependant par quelques petites améliorations graphiques au niveau de la tessellation pour ajouter des détails aux terrains et de l'éclairage qui gagne en réalisme et profite d'un effet d'occultation ambiante à base de compute shaders plus évolués. Star Wars Battlefront fait par contre totalement l'impasse sur le support du MSAA et se contente du FXAA ou du TAA, qui, une fois encore, se comporte plutôt bien mais uniquement lorsque les mouvements sont suffisants. Nous testons le jeu avec Fraps sur un parcours bien défini et il est maintenu à jour via Origin. La Radeon se positionne plutôt bien dans ce jeu, mais les cartes graphiques Pascal également. Nous passons ensuite en 4K : La Titan X reste proche des 60 fps sur notre scène de test. A noter qu'un lag important se fait sentir sur le système SLI.  En 1440p, nous testons le jeu en qualité maximale avec et sans HFTS, une technique de rendu des ombres très évoluée. Etant donné le cycle jour / nuit qui impacte les performances, nous devons utiliser le bench intégré. Nous n'utilisons cependant pas le score qu'il produit mais activons Fraps sur la partie du parcours qui correspond aux scènes de jeu, le benchmark ayant tendance à surévaluer les performances via des passages plus légers. Le jeu est maintenu à jour via Uplay. [ PCSS ] [ HFTS ] Classement assez logique entre les GeForce et là aussi la Titan X encaisse sans soucis la charge supplémentaire liée au HFTS. Nous passons ensuite en 4K, mode dans lequel nous réduisons la qualité au niveau ultra proposé par le jeu ce qui désactive pas mal d'effets gourmands. Malgré tout une Titan X reste ici aussi quelque peu insuffisante pour ce niveau de qualité. A noter que la fluidité est très approximative en SLI.  Très attendu, le dernier opus de The Witcher ne déçoit pas. Développé par CD Projekt RED, il repose sur le REDengine 3, un moteur conçu pour gérer de vastes mondes ouverts, raison pour laquelle il tourne exclusivement en 64-bit. CD Projekt RED s'est associé à Nvidia pour intégrer deux effets gaphique de la suite Gameworks : le HBAO+ et surtout HairWorks. Réponse au TressFX d'AMD, HairWorks améliore la chevelure des personnages, la crinière des chevaux et la fourrure de plusieurs animaux ou créatures rencontrés dans le jeu en faisant appel à un niveau de tessellation très élevé pour chaque brindille. HairWorks est donc très gourmand et Nvidia aurait fait en sorte que son implémentation complique le travail d'optimisation d'AMD, ce qui n'a pas manqué de créer la polémique, même si en pratique désactiver cet effet ne dénature pas vraiment le jeu. Nous l'avons testé en mode de qualité maximale en 1440p, ce qui inclus HairWorks. La Radeon est en retrait par rapport aux GeForce. Nous passons ensuite en 4K, avec un niveau de qualité extrême mais sans HairWorks et sans HBAO+, qui n'en fait pas partie : Le classement reste similaire si ce n'est que la Radeon revient au niveau de l'ancienne GTX Titan X. La nouvelle s'en tire plutôt bien en pratique mais si elle n'atteint pas les 60 fps. C'est bien le cas en SLI, mais la fluidité n'est pas parfaite. Bien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. Les résultats obtenus en 1440p avec VXAO et HFTS, options réservées aux GeForce, ne sont pas pris en compte ici. En 1440p, nous avons attribué un indice de 100 à la GeForce GTX 1080 FE : Nous obtenons pour la nouvelle Titan X un gain de 24% sur la GTX 1080 FE. A observer qu'une GTX 1080 très performante telle que l'AMP! Extreme de Zotac se place exactement entre ces deux solutions. Par rapport aux solutions haut de gamme précédentes, la Titan surpasse la R9 Fury X de 70% et la GTX Titan X Maxwell de 57%. Le système SLI de GTX 1080 FE est en moyenne 18% plus performants que la Titan X Pascal, mais ses résultats sont très variables d'un jeu à l'autre. Dans 4 d'entre eux il n'y a par ailleurs aucun gain avec le SLI. Quelques petites différences émergent en 4K, résolution qui profite en général aux GPU plus large et au muli-GPU. Le gain affiché par la Titan X sur la GTX 1080 FE monte ainsi à 28% et à 60% sur la GTX Titan X Maxwell. Le rendement du SLI est en moyenne meilleur qu'en 1440p, mais les disparités dans le comportement sont encore plus importantes. Globalement nous préférons la prestation de la Titan X. A noter que la R9 Fury X parvient ici au niveau de la GTX Titan X Maxwell, un bon résultat mais dans la plupart des jeux, le niveau de performances est insuffisant pour profiter de ces options graphiques. Pour rappel, comme pour les GeForce GTX, plusieurs paramètres sont actionnables pour booster les performances de la Titan X :

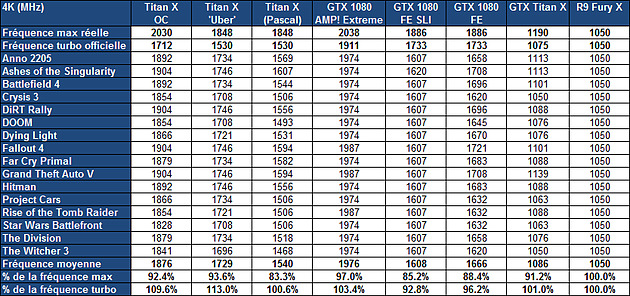

Pour mettre en place un overclocking et vous assurer de sa stabilité, nous vous conseillons de toujours pousser ces deux derniers paramètres à leur valeur maximale. Vous pourrez la ramener à leur valeur d'origine par la suite. L'overclocking basique consiste ensuite à appliquer un offset, tout d'abord sur la mémoire. Du côté du GPU, l'offset appliqué revient à déplacer la courbe des fréquences / tension. Pour les GeForce et Titan Pascal, il est possible de remplacer cet offset fixe par une fonction linéaire ou un offset personnalisé pour chaque point de tension. Pour en savoir plus, nous vous recommandons les pages dédiées du dossier de la GTX 1080. L'overclocking de notre Titan XDans le cadre de ce test, nous nous sommes contentés d'un overclocking classique et n'avons pas joué de l'overvolting qui n'apporte en général pas de gain tangible. Nous avons tout d'abord poussé les limites de température et de consommation à leurs maximums respectifs soit 90 °C et 120% (300W), ce qui a pour effet de changer le comportement de la Titan X qui en pratique évolue d'une limite stricte au niveau de la température GPU vers une limite large au niveau de la consommation. C'est ce que nous appelons mode 'Uber'. Nous avons ensuite pu pousser le GPU de 182 MHz. Sa fréquence turbo maximale réelle passe alors de 1948 à 2030 MHz, un gain de près de 10% Du côté de la GDDR5X, nous avons pu appliquer un offset de 700 MHz ce qui la pousse de 1250 MHz (10 Gbps) à 1425 MHz (11.4 Gbps), un gain de 14%. Nous avons mesuré les performances de la Titan X une fois overclockée, ainsi qu'en mode 'Uber', c'est-à-dire sans overclocking mais avec ses limites de consommation et de température poussées au maximum. Voici ce que cela donne tout d'abord dans 3DMark : [ OC - Fire Strike ] [ OC - Fire Strike Extreme ] [ OC - Time Spy ] On peut observer que le mode 'Uber' n'apporte que très peu de gain, 3DMark ayant comme défaut de ne pas laisser le temps aux GPU de chauffer. Il surévalue donc systématiquement les performances des designs de référence à base de turbine. Ensuite nous passons à l'ensemble de notre protocole : [ Performances Titan X (%) ] [ (fps) ] En mode Uber, la Titan X gagne de 5 à 11% suivant les jeux, avec une moyenne de 8%. Un gain relativement élevé qui démontre que les résultats obtenus sous 3DMark sont trompeurs et témoigne d'une forte limitation du point de vue thermique. Cela implique un potentiel intéressant pour d'autres systèmes de refroidissement qui seraient associés à ce GP102. De son côté, l'overclocking apporte un gain supplémentaire de 8 à 10%. Combiné au mode 'Uber', cela fait varier le gain total entre 14 et 21%, avec une moyenne de 18%. C'est un peu plus que ce que nous avons observé sur les GTX 1080 et 1070 FE. Fréquences relevéesEnfin, pour terminer, voici des tableaux qui récapitulent les fréquences moyennes approximatives soutenues que nous avons pu observer durant nos mesures de performances :  La fréquence maximale de notre échantillon de Titan X est de 1848 MHz, ce qui est nettement plus que la fréquence turbo officielle communiquée par Nvidia qui est de 1530 MHz. Mais en pratique dans les jeux elle se stabilise rapidement entre 1468 et 1620 MHz selon les cas. Sur base de tous ces chiffres, nous avons calculé une fréquence moyenne, qui vaut ce qu'elle vaut puisqu'il s'agit d'une approximation basée sur des approximations, mais qui permet de nous faire une idée du comportement des différents GPU par rapport à leur fréquence maximale. Notre exemplaire de Titan X affiche alors une moyenne de 1549 MHz en 1440p et de 1540 MHz en 4K, soit légèrement plus que la fréquence communiquée par Nvidia. En 4K, en mode 'Uber', la fréquence moyenne monte à 1729 MHz, alors qu'en overclocking elle est de 1876 MHz. Seul en tête, Nvidia poursuit sur sa lancée avec une nouvelle Titan X 12 Go équipée d'un GPU Pascal GP102 plus musclé que celui embarqué par les GeForce GTX 1080. 25% de performances supplémentaires par rapport à cette dernière, 60% par rapport à la GeForce GTX Titan X Maxwell lancée en mars dernier. De quoi permettre de réellement pouvoir commence à profiter de la résolution native des écrans 4K. Quelques petits compromis resteront nécessaires dans les jeux les plus lourds, et un écran G-Sync ne fera pas de tort, mais globalement nous pouvons dire que c'est le premier GPU capable de faire tourner la 4K avec un niveau de qualité digne de cette résolution. Certes le multi-GPU le permet également, et peut offrir un meilleur rapport performances/prix, mais le niveau de confort n'est pas le même, ne serait-ce que par rapport aux trop nombreux jeux qui ne l'exploitent pas bien. Pour jouer en 4K, cette nouvelle Titan X offre une prestation plus homogène et sur laquelle on peut compter dans toutes les situations.  Sans concurrence autre que celle de ses propres produits, nous pensons par exemple aux "super GTX 1080" telles que la version AMP! Extreme de Zotac testée ici, cette nouvelle Titan X s'inscrit dans la lignée directe des précédentes GeForce GTX Titan sur le plan tarifaire. C'est cher, très cher même. 1300€, rien que ça. Nvidia l'explique par le fait que cette carte est de type semi-pro et vise une clientèle particulière, par exemple dans le monde du deep learning, en plus des joueurs. Pour renforcer ce message autour de la marque Titan, elle est dorénavant officiellement positionnée à côté de et non plus dans la gamme GeForce GTX. Ne nous y trompons cependant pas, pour Nvidia c'est également un argument facile pour tenter de balayer du revers de la main toute polémique sur le tarif de cette Titan X. En pratique c'est dans la section GeForce qu'elle est présentée et elle arbore un logo GeForce illuminé sur sa tranche ainsi qu'une inscription GeForce GTX Titan X sur la backplate. Et ce n'est pas illogique. Bien sûr il y a une clientèle professionnelle pour ce type de carte graphique… mais il y en a également pour les GTX 1080. Et comme avec les Titan précédentes, Nvidia compte bien séduire les joueurs fortunés avec une solution exclusive. En ce qui nous concerne nous n'avons pas réellement de problème avec la commercialisation de cartes graphiques ultra haut de gamme. Il y a de toute évidence un marché pour cela, aussi petit soit-il, et au fond il n'y a pas de raison pour que le monde des cartes graphiques ne puisse pas avoir droit à des produits de luxes qui n'ont par principe que faire d'un rapport performances/prix pourtant crucial sur d'autres segments. Certes nous aimerions comme tout le monde que ce point évolue plus vite et il est facile d'être nostalgique d'une époque où les performances progressaient plus vite à un même niveau tarifaire. Mais nous n'en sommes plus là et il n'y a pas besoin aujourd'hui d'une Titan X, de la 4K native ou de pousser le moindre slider au niveau maximal pour profiter des derniers jeux. Par contre celui qui a les moyens de s'offrir ce nouveau monstre de Nvidia pourra bénéficier de quelques raffinements graphiques supplémentaires et d'un nouveau GPU en avant-première. Car c'est une autre façon de voir les choses. Nvidia aurait pu attendre l'an prochain ou l'arrivée d'une concurrence d'AMD avec Vega ou encore la montée en puissance de la capacité de production sur les nouveaux process pour remplacer la GeForce GTX 1080 avec une carte graphique plus musclée à un tarif similaire. Et c'est probablement ce qui se passera à un moment ou à un autre. Mais plutôt que de garder cette nouvelle puce sous le coude, elle est commercialisée dès aujourd'hui en petit volume, exclusivement via la boutique de Nvidia. Une vitrine technologique, un accès anticipé à ce nouveau GPU, c'est aussi ça que représente la Titan X et son tarif prohibitif pour la majorité d'entre nous. A ce sujet se pose évidemment la question de savoir quand une éventuelle GeForce GTX à base de GP102 verra le jour. Nous n'avons par exemple pas oublié la sortie de la GTX 980 Ti dans la foulée de la précédente GTX Titan X, ce qui avait rendue celle-ci à peu près sans intérêt pour les joueurs, aussi fortunés soient-ils. Est-ce que Nvidia va proposer rapidement une éventuelle GTX 1080 Ti par exemple ? Ce n'est que de la spéculation de notre part à ce point, mais nous estimons cette possibilité peu probable. La situation est aujourd'hui différente. D'une part il n'y aura pas de concurrence chez AMD capable de devancer la GTX 1080 avant, au mieux, la fin de l'année. D'autre part il n'y a pas d'espace dans la gamme actuelle pour une solution entre la GTX 1080 et la Titan X qui n'ôterait pas tout avantage à cette dernière vis-à-vis du monde professionnel. La précédente GeForce GTX Titan X avait pour rappel pu garder l'argument exclusif des 12 Go. Nous pouvons évidemment nous tromper, Nvidia a probablement prévu plusieurs scénarios suivant le niveau de performances de Vega, mais nous pensons plutôt que ce GP102 ne fera son apparition dans une GeForce GTX que l'an prochain. Et, c'est prometteur, nos tests au niveau de l'overclocking et des limites thermiques ont clairement mis en évidence le potentiel du GP102 lorsqu'il sera libéré avec des systèmes de refroidissement différents. A condition de ne pas avoir peur d'y mettre le prix et de prendre le risque de la perte de garantie, les plus téméraires pourront en profiter dès aujourd'hui. Une Titan X équipée d'un système de watercooling, tant qu'à faire, ça promet d'envoyer du lourd ! Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |