| |

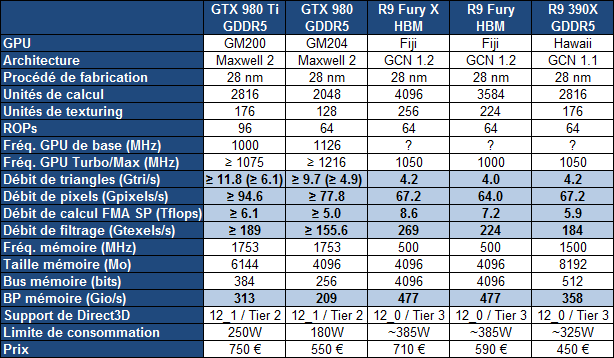

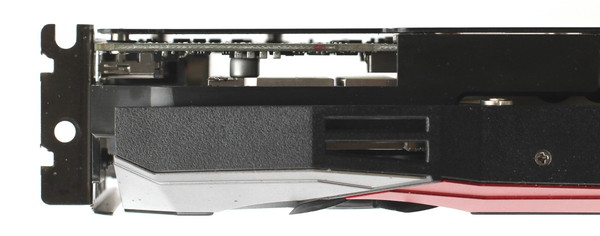

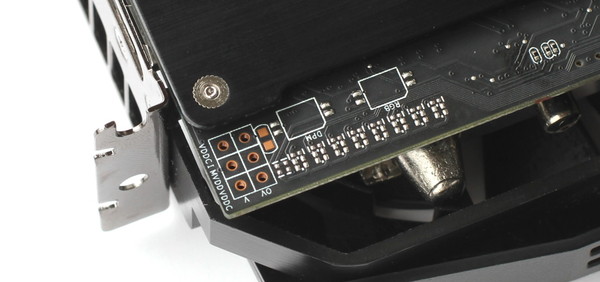

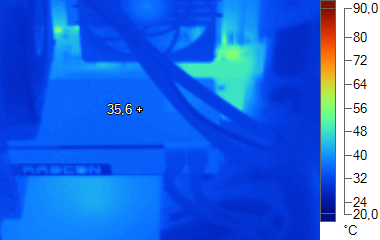

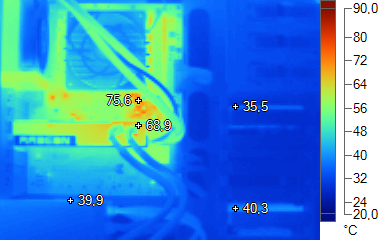

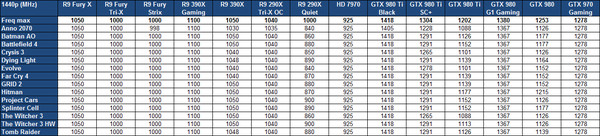

| AMD Radeon R9 Fury : Sapphire Tri-X et Asus Strix en test Cartes Graphiques Publié le Mardi 14 Juillet 2015 par Damien Triolet URL: /articles/938-1/amd-radeon-r9-fury-sapphire-tri-x-asus-strix-test.html Page 1 - Introduction Un peu plus de 2 semaines après la Radeon R9 Fury X avec refroidissement liquide, AMD lance la Radeon R9 Fury, sa petite sœur qui se "contente" de monstrueux systèmes de refroidissement à air. Avec seulement quelques unités de calcul en moins et des designs peaufinés par Sapphire et Asus, elle pourrait s'avérer être une variante plus intéressante du GPU Fiji.  Le 28nm et l'architecture GCN, un long parcoursLa Radeon R9 Fury embarque le même GPU Fiji et la même mémoire HBM que la Radeon R9 Fury X. Vous pourrez retrouver plus de détails à ce sujet dans le dossier consacré à cette dernière. Seules quelques unités de calcul manquent à l'appel, 8 des 64 Compute Units ayant été désactivées :  [ R9 Fury X (Fiji XT) ] [ R9 Fury (Fiji Pro) ] Comme le montre cette illustration, la différence est relativement mince entre ces deux déclinaisons du GPU Fiji (qu'AMD qualifie généralement de XT et de Pro). AMD a conservé la totalité du sous-système mémoire ainsi que les 4 Shader Engines qui définissent entre autre la puissance géométrique de la puce. Après avoir testé la R9 Fury X, nous avons eu le sentiment que le GPU Fiji n'était pas équilibré de manière idéale et qu'un ou plusieurs goulets d'étranglements l'empêchaient de profiter pleinement de sa puissance de calcul dans la majorité des jeux. De quoi nous laisser penser que la désactivation de quelques unités de calcul n'aura qu'un effet limité sur les performances ludiques de la Radeon R9 Fury, ce qui pourrait la rendre plus intéressante. Probablement suite à une disponibilité limitée du GPU Fiji, AMD n'a proposé le kit de développement initial de cette Radeon R9 Fury qu'à deux de ses partenaires : Sapphire et Asus. Ceux-ci ont ainsi pu développer leur solution de refroidissement personnalisée soit autour du PCB de référence (Sapphire) soit associée à un PCB revu (Asus). Nous ne savons pas exactement pourquoi AMD a opéré de la sorte ni quand et si cette solution sera proposée à d'autres partenaires, ce qui ne manquera pas de faire grincer des dents. Aucune carte de référence ne devrait être commercialisée. Dans l'immédiat, la Radeon R9 Fury est donc une exclusivité Sapphire et Asus. Trois cartes sont prévues : Sapphire Radeon R9 Fury Tri-X à 590€ : 1000/500 MHz Sapphire Radeon R9 Fury Tri-X OC à 600 € : 1040/500 MHz Asus Radeon R9 Fury Strix à 650 € : 1000/500 MHz Nous avons testé le modèle Sapphire Tri-X et intégré l'Asus Strix lors de la mise à jour du 14 juillet. Page 2 - Spécifications, 4 Go de HBM Spécifications  La Radeon R9 Fury X embarque un GPU Fiji complet, qualifié de "XT" par AMD, ce qui indique que la totalité de ses 4096 unités de calcul sont actives. En opposition, la R9 Fury se contente d'un GPU Fiji "Pro" dont 1/8ème des unités de calcul ont été désactivées, ce qui correspond à 8 des 64 Compute Units, à 512 unités de calcul et à 32 unités de texturing. La Radeon R9 Fury se contente ainsi de 7.2 Tflops contre 8.6 Tflops pour sa grande sœur, ce qui reste un avantage conséquent sur les GeForce GTX 980 et même GTX 980 Ti. Rappelons cependant que les débits bruts au niveau de la puissance de calcul ne peuvent pas réellement être comparés entre architectures. Les GeForce dispose par exemple d'unités supplémentaires pour traiter les opérations complexes et ainsi décharger ces unités principales, ce qui ne se retrouve pas dans ces chiffres. Le débit de pixels (fillrate) et de triangles n'évolue pas entre Fiji et Hawaii et est identique pour les R9 Fury X, R9 Fury et R9 390X (aux petites différences de fréquences près). Cela laisse un avantage conséquent aux GeForce GTX 980 Ti et GTX 980. A noter que pour ces dernières, le débit varie suivant le fait qu'il s'agisse ou pas de triangles qui seront éjectés du rendu (à peu près la moitié des triangles pris en charge seront éjectés). Le chiffre entre parenthèse représente le débit quand les triangles sont réellement transformés en pixels. Au niveau de la bande passante mémoire, l'avantage de R9 Fury et R9 Fury X est de 50% sur les solutions concurrentes, de 60% sur la R9 290X et de 33% sur la R9 390X. Ce à quoi il faut ajouter les gains liés à la compression sans perte du framebuffer dans le cas de ces deux dernières. Sur le plan de la consommation, AMD ne communique pas de TDP et se contente d'un chiffre magique appelé "Typical Board Power", qui permet en quelque sorte de brouiller les pistes en mettant en avant ce que le fabricant estime être la consommation typique des cartes. A côté de ce TBP de 275W, nous avons une limite de consommation globale de la carte qui se situe à +/- 385W. C'est ce chiffre qui est comparable comparable au TDP de 250W communiqué par Nvidia pour les GTX 980 Ti et Titan X. En pratique, AMD a cependant prévu beaucoup plus de marge que Nvidia au niveau de la consommation maximale. AMD a légèrement revu le fonctionnement de PowerTune par rapport à Hawaii, de manière à l'adapter au nouveau format de Fiji qui intègre la mémoire dans le packaging. Pour rappel, sur Hawaii, le contrôle de PowerTune se fait directement au niveau de la consommation directe de la puce (ASIC). Celle-ci est obtenue pour un mélange de mesures (puissance VDDC) et d'estimations (consommation liée aux différents bus, etc). Pour les spécifications de référence de la R9 290X, la limite de consommation de la puce est fixée à 208W, ce qui correspond à une consommation totale de la carte de +/- 285W. C'est très différent de ce que fait Nvidia avec GPU Boost qui contrôle la consommation 12V totale de la carte graphique mais ignore celle exacte du GPU. Chaque approche a des avantages et des inconvénients. Pour Fiji, le principe reste similaire à Hawaii, si ce n'est que PowerTune contrôle dorénavant l'ensemble GPU + HBM. Ainsi, AMD nous a indiqué que la limite de consommation au niveau du packaging a été fixée à 300W pour la R9 Fury X, ce qui correspond à une limite totale de la carte d'environ 385W (elle varie entre autre suivant le rendement des VRM). PowerTune mesure toujours le canal VDDC mais nous ne savons pas si le reste, y compris tout ce qui concerne la mémoire HBM, est mesuré également ou s'il s'agit d'un paramètre estimé qui s'intègre dans l'algorithme global. Réticent de prime abord à communiquer cette valeur de 300W, AMD tient à insister sur le fait qu'elle a été placée assez de manière à s'assurer que la R9 Fury X soit capable de maintenir une fréquence très élevée même dans les outils tels que Furmark. A noter que si la valeur de référence reste de 300W sur la R9 Fury, les partenaires ont la possibilité de la réduire pour éviter de trop faire souffrir leur solution dans les stress tests. 4 Go de HBM, mais pas plusComme nous en avons déjà parlé, Fiji est actuellement limité à 4 Go de mémoire HBM. Un point délicat en 2015 autant commercialement que pour convaincre de la pérennité d'une carte graphique ultra haut de gamme. D'autant plus qu'à côté de cela, les Radeon R9 390X et 390 ne sont proposées qu'en version 8 Go, ce qui sème la confusion sur la nécessité d'aller ou pas au-delà de 4 Go. AMD explique que 4 Go est une quantité de mémoire largement suffisante pour la majorité des jeux, ce qui est vrai, et que des optimisations pourront être mises en place au niveau des pilotes pour réduire la quantité de mémoire utilisée de manière à ne pas pénaliser les performances avec les jeux plus gourmands à ce niveau. Interrogé à plusieurs reprises, AMD n'a par contre pas pu nous donner de réponse plus spécifique à ce niveau, ni nous donner le moindre exemple concret de ce qui a été optimisé ou de ce qui est envisagé pour l'avenir. AMD nous a finalement précisé que sa méthode de prédilection est de travailler directement avec les développeurs de jeux vidéo pour s'assurer qu'ils exploitent correctement les ressources à leur disposition. De notre côté, sur le peu de temps que nous avons pu passer à essayer de mettre en difficulté les R9 Fury, nous n'avons pas constaté de problème lié à un manque de mémoire. Nous avons pu observer que le pilote se comportait différemment avec une R9 Fury X 4 Go qu'avec une R9 290X 4 Go. Dans certains jeux, la R9 Fury X consomme plus de mémoire, dans d'autre un peu moins. Et en observant la quantité de mémoire reportée par RivaTuner, nous avons l'impression que le pilote est plus agressif pour libérer de l'espace lorsqu'il estime que des données sont devenues inutiles. Bien entendu, il n'est pas impossible de placer les R9 Fury dans une situation où leur mémoire est clairement insuffisante. Mais dans ces cas le niveau de performance n'est alors plus du tout réaliste. Si les 4 Go ne semblent pas être un mauvais compromis avec une seule carte et un GPU offrant un tel niveau de performance, cela se complique par contre en CrossFire. Nous avons ainsi pu observer des situations réalistes et en principe jouables dans lesquelles il nous semble évident que la mémoire de 4 Go par GPU s'avère insuffisante. Pour régler le problème, la seule solution est actuellement de réduire le niveau de détail des textures, et il reste à voir si AMD pourra améliorer le comportement des R9 Fury avec de futurs pilotes. Page 3 - Sapphire Radeon R9 Fury Tri-X Sapphire Radeon R9 Fury Tri-XPartenaire privilégié d'AMD, Sapphire propose bien entendu une Radeon R9 Fury : la Tri-X. Elle est déclinée en deux versions, classiques et OC qui profite d'un overclocking du GPU de 1000 à 1040 MHz.  Sapphire combine au petit PCB de référence, identique à celui de la R9 Fury X, un système de refroidissement Tri-X pour le moins monstrueux. Il porte la longueur de la carte à 30.5 cm et occupe 3 slots PCI, son épaisseur étant de 2.5 slots. Par ailleurs, à l'arrière de la carte, certaines vis dépassent du PCB de 5mm. Il faut donc prévoir de l'espace autour de cette carte graphique. Elle se contente par contre de la hauteur classique pour les cartes d'extensions. Sapphire a opté pour une coque en plastique mais l'ensemble est plutôt bien fini. Pour fixer un énorme ventirad sur le petit PCB de 19 cm de long, Sapphire n'a pas cherché à lui attacher une rallonge en plastique comme avait pu le faire Nvidia sur certains designs qui avaient tendance à produire des vibrations. En pratique Sapphire compte justement profiter du fait que le radiateur dépasse du PCB pour optimiser le dégagement de l'air chaud. La plaque métallique de l'avant du PCB a simplement été prolongée de manière à ce qu'elle puisse faire office de structure de support perforée pour le radiateur. L'ensemble est ainsi robuste tout en autorisant l'air à traverser complètement la carte graphique sur les 11 derniers centimètres du radiateur.  Plus en détails, le ventirad Tri-X repose sur 2 radiateurs. Le premier intègre une base en cuivre, en contact avec le GPU et sa mémoire HBM. De cette base partent pas moins de 7 caloducs dont 2 de 6mm déportent une partie de la chaleur vers les extrémités du premier radiateur. Le second radiateur est bien plus imposant et profite pleinement de l'absence de PCB au bout de la carte graphique pour gagner en épaisseur. Il est parcouru par les 5 autres caloducs, 1 de 10mm, 2 de 8mm et 2 de 6mm. Une petite plaque en cuivre est fixée sur la partie de ce radiateur qui surmonte le PCB. Elle permet de refroidir les composants sensibles de l'étage d'alimentation. Une plaque métallique protège l'arrière du PCB et est utilisée pour faire office de dissipateur pour les composants de l'étage d'alimentation qui se trouvent de ce côté. Pour alimenter le tout en air, Sapphire a opté pour 3 ventilateurs de 90mm à double roulements à billes, de qualité supérieure à ceux utilisés par exemple sur les R9 290 Tri-X. A faible température GPU, ces ventilateurs restent à l'arrêt et Sapphire exploite ensuite la gestion des ventilateurs par PowerTune, une possibilité introduite avec les Radeon R9 290X mais généralement laissée de côté par les fabricants de cartes graphiques au profit d'une courbe de ventilation classique. Rappelons que ce nouveau système, plus évolué, permet d'adapter la vitesse des ventilateurs pour maintenir une température cible. Grossièrement alors qu'une courbe classique force par exemple une vitesse de 30% à 70 °C, de 40% à 75 °C et de 50% à 80 °C, la gestion PowerTune laisse le GPU atteindre 75 °C à faible vitesse et accélère ensuite les ventilateurs pour ne pas aller au-delà. La fonction de double bios est de la partie et Sapphire en profite pour proposer deux modes différents : Default et Unlocked. Voici les limites fixées par ces bios (température et ASIC) : Default : 75 °C et 300W (consommation totale de ~385W) Unlocked : 80 °C et 350W (consommation totale de ~450W) Le mode Unlocked propose ainsi plus de marge au niveau de la consommation, mais ce n'est pas réellement utile d'autant plus que PowerTune permet déjà de pousser la limite de consommation au niveau de l'ASIC de 300 à 450W (consommation totale de plus de 550W). Ce mode Unlocked permet par contre de réduire les nuisances sonores en autorisant une température maximale supérieure. PCB de référence obligé, un système de LED dénommé GPU Tach permet de visualiser le niveau de charge du GPU. Une LED verte indique quand le GPU est en mode ZeroCore Power, et 8 autres qui peuvent être configurées en rouge ou en bleu, représentent l'intensité de la charge GPU, sans que nous ne sachions à quoi cela correspond exactement. Au niveau de la connectique, nous retrouvons 3 DisplayPort et un HDMI. De toute évidence un adaptateur DP vers DVI ou HDMI vers DVI sera fourni avec ces cartes. A noter que nous ne sommes pas parvenus à connecteur un écran 30" en DVI Dual Link avec les adaptateurs que nous avions à notre disposition (y compris DP vers Dual Link actif alimenté). Au niveau de l'alimentation, 2 connecteurs 8 broches sont nécessaires. La carte peut donc consommer jusqu'à 375W en restant dans les normes PCI Express. Pour alimenter le GPU, AMD a opté pour un étage d'alimentation à 6 phases capable de délivrer jusqu'à 400A, de quoi laisser suffisamment de marge. OverclockingL'overclocking de la Radeon R9 Fury Tri-X de Sapphire s'est avéré pour le moins limité. La seule possibilité offerte officiellement est d'augmenter la fréquence GPU ou la limite de consommation PowerTune. Cette dernière est cependant placée par défaut à un niveau déjà très élevé. La relever, jusqu'à 50% de plus, n'aurait aucun intérêt. Dans le cas de la mémoire HBM, des outils tels qu'Afterburner permettent de débloquer la situation. Nous n'avons pas pu pousser le GPU au-delà de 1050 MHz, soit un maigre gain de 5%. Dès 1075 MHz, des artéfacts apparaissent rapidement à l'écran, suivis par un plantage. Quant à la mémoire HBM, son overclocking entraîne des artéfacts après quelques dizaines de secondes, même à seulement 525 MHz. Au final, l'overclocking n'a permis un gain de performances dans les jeux que de 3%, autant en 1440p qu'en 4K. A voir s'il sera possible plus tard de modifier la tension GPU pour aller au-delà. Page 4 - Asus Radeon R9 Fury Strix Asus Radeon R9 Fury StrixAsus est le second partenaire d'AMD pour le lancement de la Radeon R9 Fury et propose un modèle Strix cadence aux fréquences de référence de 1000/500 MHz. A noter cependant qu'un mode OC activable via l'utilitaire GPU Tweak pousse le GPU à 1020 MHz.  Asus a développé une R9 Fury entièrement personnalisée, du PCB au système de refroidissement. La R9 Fury Strix partage sur ce point un même énorme ventirad DirectCU III avec la GTX 980 Ti Strix. Celui-ci mesure 30cm et surmonte la hauteur PCI standard de près de 4cm, de quoi faire passer la R9 Fury Tri-X de Sapphire pour une "petite" carte graphique. Asus se contente par contre de 2 slots d'épaisseur. La coque en plastique donne à la R9 Fury Strix un look plutôt réussi et intègre sur le dessus une zone rouge avec logo Strix blanc illuminée par LED avec une approche de type pulsation qui n'est pas configurable. Nous aurions préféré un éclairage fixe ou tout du moins qu'Asus en propose l'option. Le ventirad est composé d'un large radiateur monobloc, assez mince mais qui occupe une large surface. Les ailettes sont positionnées horizontalement, ce qui signifie que l'air chaud sera expulsé principalement par les extrémités de la carte. Ce type d'organisation associée avec plusieurs ventilateurs (3 de 90mm dans ce cas) a souvent tendance à générer de petites perturbations audibles (type souffle du vent variable) puisque la manière dont le radiateur canalise les flux d'air fait qu'ils seront en partie en concurrence. A faible température GPU, ces ventilateurs restent à l'arrêt et en charge ils exploitent la gestion Powertune avec une température cible de 80 °C. DirectCU oblige, nous retrouvons des caloducs à contact direct pour former la base du ventirad. Asus a opté pour 3 caloducs de 10mm et 2 de plus de 6mm, qui traversent verticalement le radiateur. Le GPU, même avec sa mémoire HBM, n'étant pas aussi gros, seuls 2 caloducs de 10mm et un de 6mm sont en réalité en contact avec le GPU. Le rendement des deux caloducs supplémentaires est donc moindre. Pour en limiter l'effet Asus a conçu son design pour faire en sorte qu'il s'agisse des deux caloducs qui restent le plus près du GPU, une zone où la chaleur a moins besoin d'aide pour être transférée au radiateur. Au niveau de l'étage d'alimentation, les ailettes du radiateur sont prolongées et fixées à une petite plaque en aluminium. Une approche qui a le double avantage de permettre un refroidissement efficace de l'étage d'alimentation et d'améliorer la fixation de cet énorme radiateur au PCB. Par contre Asus se sert de petits condensateurs pour faire office du support du radiateur à l'avant de la carte, ce qui est loin d'être idéal :  Il n'y a pas de plaque métallique à l'avant du PCB, mais Asus utilise par contre une structure de renforcement qui part de l'équerre PCI et rejoint le dessus du PCB, de quoi garantir sa rigidité. Une plaque métallique protège par contre l'arrière du PCB mais n'a qu'un rôle esthétique. Elle n'est en contact avec aucun composant sensible, puisqu'il n'y en a pas à l'arrière du PCB, contrairement au design de référence.  Asus utilisant une interface thermique particulière, nous avons évité de démonter la carte de test. A noter qu'il n'est pas possible de retirer la plaque arrière sans démonter totalement le ventirad, Asus ayant placé les vis sur la face avant de la carte ! Vous pourrez retrouver des photos du PCB chez notre confrère Techpowerup par exemple. Le PCB développé par Asus mesure 27.5cm de long et dépasse la hauteur standard d'un peu plus d'un centimètre. Asus en a profité pour revoir la connectique et ajouter une sortie DVI en plus des 3 DispalyPort et du HDMI du PCB de référence. 2 connecteurs 8 broches restent nécessaires. La carte peut donc consommer jusqu'à 375W en restant dans les normes PCI Express. Au niveau de l'étage d'alimentation, Asus a opté pour des phases plus simples mais plus nombreuses. Celui du GPU passe de 6 à 10 phases alors que la mémoire passe de 1 à 2 phases. Difficile d'estimer comment les étages d'alimentation se comparent, mais alors que le PCB de référence prévoit une limite de consommation Powertune de 300W pour l'ASIC (GPU + HBM dans le cas présent), Asus l'a réduite à 216W, ce qui fait passer la consommation maximale totale de la carte de 385W à +/- 270W. En pratique cela n'a pas de réelle incidence sur les performances en jeux (les plus gourmands frôlent la limite), mais la fréquence GPU sera nettement réduite dans les stress tests tels que Furmark. Il est par contre toujours possible de pousser manuellement la limite de 50% (soit à 324W pour l'ASIC et à peu près 425W au total). Ce choix d'Asus semble donc tout à fait raisonnable.  Asus a fait l'impasse sur le dual bios ainsi que sur le système de LED GPU Tach qui permet de visualiser le niveau de charge du GPU, mais a prévu des points de mesure des différentes tensions. OverclockingL'overclocking de la Radeon R9 Fury Strix s'est avéré être encore plus limité que pour sur la Tri-X de Sapphire. Rappelons tout d'abord que le logiciel GPU TWeak permet d'activer un mode OC qui pousse le GPU de 1000 à 1020 MHz, soit un overclocking de 2%. De notre côté, nous n'avons pas pu pousser le GPU au-delà de 1025 MHz, soit un maigre gain de 2.5%. Dès 1050 MHz, les plantages sont réguliers. Quant à la mémoire HBM, son overclocking entraîne des artéfacts après quelques temps, même à seulement 525 MHz. Ici aussi, pousser la tension GPU pourrait débloquer la situation. A noter que lors de nos tests de charge, la tension moyenne à 1000 MHz constants sur la carte de Sapphire était de 1.199V alors qu'elle n'était que de 1.162V sur l'Asus. Page 5 - Consommation et efficacité énergétique ConsommationNous avons utilisé le protocole de test qui nous permet de mesurer la consommation de la carte graphique seule. Nous avons effectué ces mesures au repos sur le bureau Windows 7 et en veille écran. Pour rappel, AMD spécifie pour le GPU Fiji une fréquence maximale alors que la tension est variable. Le niveau de consommation peut donc varier un peu plus entre échantillons que sur les GeForce pour lesquelles Nvidia fait l'inverse et spécifie une tension maximale alors que la fréquence est variable, ce qui fait par contre varier le niveau de performances. Pour la charge, nous testons d'une part Anno 2070 en mode de qualité maximale qui représente un jeu très lourd et d'autre part Battlefield 4 en mode Ultra qui représente un jeu moins lourd. A noter que nous avons refait toutes nos mesures de consommation en 1440p. Elles étaient auparavant effectuées en 1080p, résolution qui pouvait pousser les solutions les plus performants dans la limite CPU. Les R9 Fury de Sapphire et d'Asus affichent une consommation inférieure à celle des R9 Fury X. Impossible cependant de savoir si cela est spécifique à nos échantillons ou s'il s'agit d'une tendance globale pour les R9 Fury. La consommation augmente quelque peu avec le bios unlocked de la Tri-X ce que nous supposons être lié à la température qui passe de 74 à 79 °C. Nous n'avons constaté aucune différence au niveau de la tension GPU entre ces bios mais par contre notre échantillon de la Strix profitait d'une tension GPU en charge un peu plus faible que celle de la Tri-X. Bien que la Strix reste en-dessous de sa consommation maximale de près de 270W que nous avons pu mesurer avec Furmark, Powertune estime que dans Anno 270 la limite de l'ASIC est atteinte (consommation directe du GPU et de la HBM, en partie mesurée, en partie estimée). La fréquence du GPU varie alors entre 996 et 1000 MHz, au lieu de 1000 MHz stable, ce qui participe à limiter la consommation de cette carte. Bien que ces données soient approximatives, compte tenu de la variation entre échantillons d'un même modèle, nous avons mis en relation ces mesures de consommation avec les performances, en retenant des fps par 100W pour que les données soient plus lisibles, de quoi donner une idée globale sur le rendement énergétique de toutes ces cartes : [ Battlefield 4 ] [ Anno 2070 ] Enfin, le rendement énergétique des Radeon repart à la hausse ! Ce n'est pas encore suffisant pour égaler les GeForce GTX 900, mais ces résultats sont encourageants. Page 6 - Nuisances sonores et températures Nuisances sonoresNous plaçons les cartes dans un boîtier Cooler Master RC-690 II Advanced et mesurons le bruit d'une part au repos et d'autre part en charge sous le test1 de 3DMark11. Un SSD est utilisé et tous les ventilateurs du boîtier ainsi que celui du CPU sont coupés pour la mesure. Le sonomètre est placé à 60cm du boîtier fermé et le niveau de bruit ambiant se situe à moins de 20 dBA, ce qui est la limite de sensibilité pour laquelle il est certifié et calibré. Au repos, les ventilateurs de la R9 Fury Tri-X sont à l'arrêt et la carte est totalement silencieuse. La mesure correspond à la limite de sensibilité de notre sonomètre. Vous remarquerez que le niveau sonore mesuré sur la R9 Fury Strix est légèrement supérieur alors que ses ventilateurs sont à l'arrêt ce qui est lié à un très léger coil whine qui n'a pas échappé à notre sonomètre mais que nous ne pouvons entendre qu'en étant très près de la carte avec le boîtier ouvert. En charge, et malgré le niveau de consommation important, la solution de Sapphire assure un bon refroidissement en toute discrétion. C'est probablement le système de refroidissement à air le plus performant à être passé entre nos mains. Il ne tourne qu'à 35% (1190 RPM) en Unlocked et qu'à 37% (1295 RPM) en Default. Il est capable de monter jusqu'à 3600 RPM si cela s'avérait être nécessaire. Malheureusement, l'étage d'alimentation du PCB de référence génère pas mal de coil whine en charge lourde. S'il était masqué par le bruit encore plus agaçant de la pompe de la R9 Fury X, il ressort nettement sur l'échantillon de R9 Fury Tri-X que nous avons testé. Sans ce coil whine, la pression sonore est d'ailleurs encore un peu plus faible (26.3 et 27.4 dBA en Unlocked/Default). Du côté de l'Asus Strix, bien que la consommation soit moindre, les nuisances sonores sont plus élevées en charge, même si elles restent raisonnables pour une carte graphique haut de gamme. Comme nous le suspections en observant son ventirad, des perturbations au niveau des flux d'air qu'elle produit se font entendre (type souffle du vent qui varie). Sans être extrêmement gênant, cela empêche le souffle modéré du ventirad de se faire oublier. Du coil whine se fait également entendre en charge sur la R9 Fury Strix, à un niveau supérieur par rapport au repos, mais qui reste inférieur à ce que nous avons pu constater sur notre échantillon de la Tri-X. TempératuresToujours placées dans le même boîtier, nous avons relevé la température du GPU rapportée par la sonde interne : Le système Tri-X de Sapphire ne fait pas le compromis de nuisances sonores réduits au prix de températures GPU extrêmes. Avec 74 °C en mode Default et 79 °C en mode Unlocked, il s'en tire plutôt très bien. Le ventirad d'Asus se contente ici de 79 °C pour le GPU en charge. Mise en parallèle avec le niveau de nuisances sonores et de consommation, cette dernière donnée indique clairement que le système Strix est nettement moins performant que le système Tri-X. Page 7 - Thermographie infrarouge Thermographie infrarougeVoici les photos thermiques obtenues pour ces différentes cartes graphiques avec à chaque fois 45 minutes de mise en situation :  [ Sapphire R9 Fury Tri-X - Repos ] [ Charge ] [ Charge Unlocked ] [ Asus R9 Fury Strix - Repos ] [ Charge ] [ MSI R9 390X Gaming - Repos ] [ Charge ] [ Sapphire R9 290X Tri-X - Repos ] [ Charge ] [ Gigabyte GTX 980 G1 - Repos ] [ Charge ] [ GeForce GTX 980 - Repos ] [ Charge ] [ GeForce GTX 980 Ti - Repos ] [ Charge ] Sur la R9 Fury X, une fois la plaque arrière retirée, nous pouvons observer que les VRM atteignent un peu plus de 100 °C. Cette plaque ne participant pas au refroidissement, leur température est probablement un petit peu plus élevée quand elle est en place. Sur la R9 Fury Tri-X, nous ne pouvons pas retirer la plaque arrière pour faire cette observation, celle-ci participant au refroidissement. Elle est cependant perforée et nous pouvons observer une température similaire dans le mode Unlocked (106 °C sous un autre angle contre 99 °C par défaut). Du côté de la R9 Fury Strix, impossible également de retirer la plaque arrière. Nous avons du coup poussé une sonde entre celle-ci et le PCB, au niveau de l'étage d'alimentation, et avons relevé 78 °C. Il ne s'agit probablement pas strictement du point le plus chaud, mais les températures de ce côté du PCB d'Asus, que ne reçoit aucun composant important contrairement à celui de référence, semblent inférieures. Voici ensuite ce que cela donne au niveau de l'ensemble du système, des clichés que nous avons intégrés compte tenu de la particularité du ventirad Tri-X de la R9 Fury de Sapphire qui laisse passer l'air au travers de la carte :  [ Sapphire R9 Fury Tri-X ] [ Unlocked ] [ Asus R9 Fury Strix ] [ MSI R9 390X Gaming ] [ Sapphire R9 290X Tri-X ] [ Gigabyte GTX 980 G1 Gaming ] [ GeForce GTX 980 ] [ GeForce GTX 980 Ti ] Comme toujours sur ces clichés, nous pouvons observer une nette différence entre les cartes qui expulsent l'air en dehors du boîtier et celles qui se contentent de brasser l'air à l'intérieur de celui-ci. La R9 Fury Tri-X renvoie pas mal d'air chaud vers le haut du boîtier et donc typiquement vers le CPU et sa mémoire. Le capteur DRAM de la carte-mère passe d'ailleurs de 57 °C sur la R9 Fury X à 75 °C sur la R9 Fury Tri-X. Cette dernière épargne par contre les disques durs, contrairement à la R9 Fury Strix d'Asus par exemple. Page 8 - Protocole de test Protocole de testPour ce test, nous avons repris le même protocole que celui mis en place pour la Radeon R9 Fury X. Tous les derniers patchs au 19/06/2015 ont été installés, la plupart des jeux étant maintenus à jour via Steam/Origin/Uplay. Nous avons opté d'une part pour la résolution de 1440p avec un niveau de détail très élevé, de manière à obtenir à peu près 60 fps sur les solutions haut de gamme, ou plus si le jeu ne permet pas un niveau de détail plus élevé autre que du SSAA. Nous avons évité d'activer ce type d'antialiasing, que nous jugeons beaucoup trop gourmand par rapport à ce qu'il apporte. D'autre part, nous avons mesuré les performances en 4K en faisant en sorte de sélectionner un niveau de qualité jouable sur les solutions ciblées par ce test. Nous avons intégré une Radeon HD 7970 pour contextualiser quelque peu l'évolution des performances ainsi que des GeForce GTX 980 et GTX 980 Ti personnalisées, de manière à illustrer ce dont sont capables les GPU Maxwell quand ils ne sont pas limités par le ventirad de référence de Nvidia. Pour rappel, nous n'affichons plus les décimales dans les résultats de performances dans les jeux pour rendre les graphiques plus lisibles. Ces décimales sont néanmoins bien notées et prises en compte pour le calcul de l'indice. Nous avons utilisé les Catalyst 15.7 WHQL pour les R9 Fury X et R9 Fury puisque ceux-ci affichent un petit gain de performances, notamment dans 3DMark Fire Strike (+5%) et dans Far Cry 4 (+4%). Un impact qui reste cependant léger au global : l'indice de performances de la R9 Fury X progresse de 114.7 à 115.6 en 1440p et de 127.4 à 127.8 en 4K. A noter par contre que nous n'avons observé aucun gain avec ces pilotes sur la R9 290X Tri-X de Sapphire et ce sur l'ensemble de nos benchmarks. Nous avons donc conservé les résultats obtenus avec les pilotes Catalyst 15.15beta pour les Radeon autres que les Fury. Les GeForce sont quant à elles testées avec les pilotes 353.30 WHQL.Nous avons forcé l'activation du PCI Express 3.0 sur la plateforme X79 pour les GeForce. Toutes les cartes ont été testées telles quelles avec une température ambiante contrôlée à 26 °C et, pour chaque jeux, nous avons pris le temps nécessaire pour que la fréquence GPU se stabilise. Les performances des GeForce peuvent potentiellement être surévaluées du fait de leur fréquence turbo variable. Mais nous ne cherchons plus à la limiter aux spécifications officielles depuis la génération GTX 700 avec laquelle a été introduite un contrôle de la température qui est devenu de fait l'élément de limitation principal pour les GeForce de référence. Nous somme cependant en train de reconsidérer cette approche étant donné que nous pouvons observer, avec les GTX Titan X et GTX 980 Ti, que nos échantillons de test reprennent un avantage parfois significatif par rapport aux fréquences officielles. Il n'est donc pas impossible qu'à l'avenir nous revenions à imposer à la carte de respecter la fréquence turbo officiellement garantie. Voici les fréquences moyennes approximatives que nous avons pu observer durant nos mesures de performances :   Nous pouvons y observer que les Radeon R9 Fury X et R9 Fury Tri-X sont capables de maintenir leur fréquence maximale en permanence. La R9 Fury Strix d'Asus parvient presque à faire de même, excepté dans Anno 2070 pour lequel elle flirte avec sa limite de consommation. La fréquence varie ainsi entre 996 et 1000 MHz en 1440p et entre 998 et 1000 MHz en 4K, pour des impacts respectifs sur les performances de 0.1 et 0.0 fps dans ce jeu.  Configuration de testIntel Core i7 3960X (HT off, Turbo 1/2/3/4/6 cores: 4 GHz) Asus P9X79 WS 8 Go DDR3 2133 Corsair Windows 7 64 bits Pilotes GeForce 353.30 WHQL Catalyst 15.7 WHQL / 15.15 beta Page 9 - Benchmark : 3DMark et Unigine Pour ce test, nous avons lancé différents benchmarks populaires : 3DMark Fire Strike  Nous lançons le test Fire Strike avec les 3 presets proposés par Futuremark : [ Fire Strike ] [ Fire Strike Extreme ] [ Fire Strike Ultra ] Avec les Catalyst 15.7, la Radeon R9 Fury X se rapproche de la GeForce GTX 980 Ti et l'égale en mode Ultra. La R9 Fury Tri-X devance par contre les GTX 980 dans tous les modes. Unigine Valley 1.0 & Heaven 4.0Les tests sont effectués avec tous les paramètres au maximum en 1920*1080 et MSAA 8x. [ Valley ] [ Heaven ] La Radeon R9 Fury Tri-X est au niveau de la GTX 980 G1 Gaming dans Valley mais se contente du niveau de la GTX 980 de référence dans Heaven, qui utilise beaucoup de tessellation. Page 10 - Benchmark : Anno 2070 Anno 2070  Anno 2070 reprend une évolution du moteur d'Anno 1404 qui intègre un support de DirectX 11. Nous utilisons le mode de qualité maximale ou très élevée du jeu et effectuons un déplacement sur une carte en mesurant les performances avec Fraps. En général, dans Anno 2070, c'est avant tout la puissance de calcul qui compte et les GPU sont mis à rude épreuve par rapport à leurs limites de consommation ou de température. Nous nous attendions du coup à ce que les Radeon R9 Fury se démarquent dans ce jeu mais le gain est limité par rapport aux Radeon R9 290X et 390X. C'est encore un petit peu moins bien en 4K, ce qui nous laisse penser que le GPU Fiji souffre d'une limitation interne. Page 11 - Benchmark : Batman Arkham Origins Batman Arkham Origins  Avant-dernier opus de la série, son successeur venant tout juste de sortir, Batman Arkham Origins est toujours basé sur l'Unreal Engine 3 mais pousse un petit peu plus loin les effets graphiques dont certains ont été implémentés sur PC en collaboration avec Nvidia. C'est le cas du TXAA et d'effets GPU PhysX réservés aux GeForce (il n'est plus possible d'activer une version CPU de tous ces effets), mais également de l'occlusion ambiante de type HBAO+, d'un effet de Depth of Field plus évolué (NVDOF), d'ombres adoucies (PCSS) et de la tessellation (pour la cape et la neige) qui sont utilisables sur tous les GPU DirectX 11. Nous utilisons le mode de qualité maximale du jeu, avec du MSAA 8x ou du FXAA High. Nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Steam. La R9 Fury X se rapproche ici quelque peu de la GTX 980 Ti, mais ne parvient toujours pas à l'égaler. La R9 Fury profite par contre de sa bande passante supérieure pour devancer la GTX 980 G1 de Gigabyte. En 4K avec FXAA, les résultats des nouvelles Radeon reculent quelque peu. Page 12 - Benchmark : Battlefield 4 Battlefield 4  Battlefield 4 repose sur le moteur Frostbite 3, une évolution de la version 2 présente dans Battlefield 3. La base du rendu reste très proche (rendu différé, calcul de l'éclairage via compute shaders) et les évolutions visibles sont mineures, DICE ayant principalement optimisé son moteur pour les consoles de nouvelle génération. Parmi les petites nouveautés, citons un support plus avancé de la tessellation et une amélioration du module "destruction" du moteur. Sur PC, un mode Mantle spécifique aux Radeon et qui permet de réduire le coût CPU du rendu est proposé mais nous ne l'avons pas utilisé pour ce test. Pour rappel, il s'agit d'une API propriétaire de plus bas niveau dédiée aux Radeon HD 7000 et supérieures, qui a été développée par AMD et DICE. Depuis l'arrivée d'autres API de bas niveau, AMD a cependant cessé les développements autour de Mantle et n'a pas optimisé son utilisation dans les pilotes pour ses derniers GPU. Nous testons le mode Ultra avec ou sans MSAA 4x et nous relevons les performances avec Fraps, sur un parcours bien défini. Le jeu est maintenu à jour via Origin. Les GeForce Maxwell apprécient particulièrement ce jeu, d'autant plus qu'il ne les pousse pas dans leurs limites de consommation et permet à leurs GPU de tourner à des fréquences élevées. Une nouvelle fois, les R9 Fury souffrent un peu plus en 4K que les GeForce, qui apprécient probablement plus que les Radeon de ne plus devoir appliquer le MSAA. Page 13 - Benchmark : Crysis 3 Crysis 3  Crysis 3 reprend le même moteur que Crysis 2 : le CryEngine 3. Ce dernier profite cependant de quelques petites évolutions telles qu'un support plus avancé de l'antialiasing : FXAA, MSAA et TXAA sont au programme, tout comme un nouveau mode appelé SMAA. Ce dernier est une évolution du MLAA qui permet, optionnellement, de prendre en compte des données de type sous-pixels soit à travers la combinaison avec du MSAA 2x, soit avec une composante temporelle calculée à partir de l'image précédente. Le SMAA 1x est la simple évolution du MLAA, le SMAA 2tx utilise une composante temporelle relativement complexe et le SMAA 4x y ajoute le MSAA 2x. Notez qu'il ne faut pas confondre le SMAA 2tx proposé en mono-GPU avec le SMAA 2x proposé en multi-GPU, ce dernier utilisant du MSAA 2x sans composante temporelle. Nous mesurons les performances avec Fraps et le jeu est maintenu à jour via Origin. Crysis 3 est un jeu très gourmand au niveau de la puissance de calcul et la Radeon R9 Fury X talonne la GTX 980 Ti alors que la R9 Fury Tri-X devance la GTX 980 G1 Gaming. Les R9 Fury se comportent également assez bien en 4K. Page 14 - Benchmark : Dying Light Dying Light  Dying Light est un jeu de type survival horror animé par le Chrome Engine 6 de Techland et dans lequel le monde est plutôt vaste et ouvert. Nvidia a travaillé avec Techland pour y inclure certains effets issus de ses librairies Gameworks tels que le HBAO+ et le Depth of Field. Nous avons mesuré les performances avec Fraps sur un parcours bien défini. Le jeu est maintenu à jour à travers Steam. Dying Light entraîne une charge plutôt légère sur les GPU, ce qui s'explique principalement par des micro-saccades régulières qui impactent fortement la fluidité sous Windows 7. Elles sont présentes autant avec les Radeon qu'avec les GeForce, mais uniquement en mode plein écran. Les développeurs ont visiblement bien du mal à corriger ces petits bugs… Les R9 Fury ne se comportent pas très bien dans ce jeu qui affiche une consommation mémoire très élevée. Nous n'avons pas constaté de saccades particulières et ne savons pas pourquoi leurs performances sont limitées à un niveau similaire à celui de la R9 390X. Ce n'est guère mieux en 4K. Page 15 - Benchmark : Evolve Evolve  Evolve, développé par Turtle Rock Studios, est basé sur le Cry Engine 3. Contrairement à ce dernier, les modes d'antialiasing à base de MSAA, extrêmement gourmands avec ce moteur, ne sont pas proposés. Un nouveau mode de SMAA a par contre été développé par Crytek et intégré dans les branches plus récentes de son moteur : le 1tx. Il s'agit d'une version quelque peu simplifiée du SMAA 2tx, antialiasing à base de composante temporelle, qui a la particularité d'être compatible avec le multi-GPU. Nous mesurons les performances à l'aide de Fraps sur un parcours bien défini et le jeu est maintenu à jour avec Steam. Les Radeon R9 290X/390X semblent apprécier particulièrement ce titre. La R9 Fury X se positionne également plutôt bien par rapport à la concurrence et devance enfin la GTX 980 Ti de référence, certes de peu. La R9 Fury Tri-X n'a ici aucun mal à devancer la GTX 980 G1 Gaming. En 4K, c'est encore mieux pour les Radeon : la R9 Fury X égale la GTX 980 Ti SuperClocked d'EVGA et la R9 Fury s'approche de la GTX 980 Ti de référence. Page 16 - Benchmark : Far Cry 4 Far Cry 4  Dernier opus de la série, il est basé sur une petite évolution du Dunia Engine 2 qui avait été introduit avec Far Cry 3. Ses caractéristiques sont donc similaires et parmi les petites évolutions nous notons l'ajout par les développeurs du support de l'antialiasing SMAA 1x en plus du MSAA qui est très, voire trop, gourmand avec ce moteur. Nous activons le niveau de qualité Ultra ou Medium avec du SMAA 1x et utilisons Fraps sur un parcours bien défini. Les Radeon s'en tirent également assez bien dans ce jeu, d'autant plus avec les pilotes 15.7 WHQL qui ont apporté quelques gains pour les R9 Fury. En 4K, les R9 Fury X et R9 Fury Tri-X devancent de peu les GTX 980 Ti SuperClocked et de référence. Page 17 - Benchmark : GRID 2 GRID 2  Dernier né chez Codemaster, GRID 2 reprend une évolution légère du moteur DirectX 11 maison exploité par DiRT Showdown. Pour rappel, en partenariat avec AMD, les développeurs avaient mis en place un éclairage avancé qui prend en compte de nombreuses sources de lumières directes et indirectes ainsi qu'une approximation du rendu de type illumination globale. Ces techniques sont toujours exploitées, même si le partenaire principal de Codemaster est cette fois Intel qui a aidé à la mise en place d'optimisations spécifiques aux GPU intégrés à Haswell. Pour mesurer les performances, nous poussons toutes les options graphiques à leur maximum, y compris l'adoucissement de l'effet d'occlusion ambiante, et activons le MSAA 8x. Nous utilisons Fraps sur l'environnement de Barcelone, le plus lourd dans le jeu. Les GeForce GTX 980 Ti et Titan X ont ici une avance confortable. Cela se tasse quelque peu en 4K, mais les R9 Fury restent en retrait. Page 18 - Benchmark : Hitman Absolution Hitman Absolution  Hitman Absolution utilise un moteur plutôt lourd et qui manque probablement d'optimisations. La charge CPU est par ailleurs relativement élevée dans certaines scènes dans lesquelles une foule importante peut être animée. Différents effets DirectX 11 ont été intégrés avec la coopération d'AMD. Pour mesurer les performances, nous poussons les options graphiques au niveau ultra et utilisons fraps dans le jeu. Hitman Absolution est le jeu testé dans lequel les GeForce GTX 900 souffrent le plus, la bande passante mémoire ou les ROP étant visiblement un aspect primordial des performances. La R9 Fury X ayant du mal à se distinguer de la R9 390X, nous sommes tentés de supposer que la seconde option est la bonne. La R9 Fury X reste malgré tout proche de la GTX 980 Ti et la R9 Fury devance largement les GTX 980. La R9 Fury X passe de peu devant la GTX 980 Ti et la R9 Fury s'en approche. Page 19 - Benchmark : Project Cars Project Cars  Project Cars est un jeu de course automobile développé depuis 2011 sur base d'un système de beta participative qui permettait d'accéder aux nouvelles builds régulières et d'interagir avec les développeurs de Slightlymad Studios (à l'origine des Need For Speed Shift). Son moteur au rendu différé supporte DirectX 11 et c'est ce mode que nous avons testé en poussant toutes les options au maximum ou en mode High à l'exception de l'antialiasing pour lequel nous nous somme contenté du seul SMAA Ultra ou High. Nous avons testé le jeu via Fraps sur un parcours bien défini et avec de la pluie au niveau des conditions météo. Un détail important à préciser puisqu'il réduit significativement les performances. Nous avons opté pour 7 concurrents qui restent devant nous pendant la mesure des performances. Les Radeon ont beaucoup de mal dans ce jeu très attendu et ce n'est pas nouveau. Critiqué pour avoir favorisé Nvidia, le développeur s'est justifié en expliquant que ce n'était pas du tout le cas, mais qu'AMD n'avait pas voulu collaborer en amont de la sortie du jeu pour s'assurer d'optimiser les performances. Difficile de savoir ce qu'il s'est réellement passé, mais depuis AMD a commencé à introduire des optimisations spécifiques dans ses pilotes. Les GTX Titan X et GTX 980 Ti sont ici limitée par le CPU et les Radeon sont très nettement derrière. En 4K avec un niveau de détails inférieur, la limite CPU se place à un niveau bien plus élevé, ce qui permet aux Radeon de bien mieux se positionner. Page 20 - Benchmark : Splinter Cell Blacklist Splinter Cell Blacklist  Basé sur le LEAD engine, une version retravaillée en interne de l'Unreal Engine 2.5, Splinter Cell Blacklist profite pour la version PC d'effets graphiques supplémentaires mis en place en collaboration avec Nvidia tels que le HBAO+, la tessellation ou encore le TXAA. Notez au niveau de l'occlusion ambiante que le jeu propose de nombreuses options dont les plus avancées représentent l'effet le plus lourd du jeu. Nous mesurons les performances avec Fraps sur un parcours bien défini et le jeu est maintenu à jour via Uplay. La R9 Fury X se contente ici du niveau de performances de la GTX 980 G1 Gaming de Gigabyte alors que la R9 Fury se place entre celle-ci et la GTX 980 de référence. En 4K c'est beaucoup mieux pour la R9 Fury X qui revient au niveau de la GTX 980 Ti alors que la R9 Fury devance facilement les GTX 980. Page 21 - Benchmark : The Witcher 3 Wild Hunt The Witcher 3 : Wild Hunt  Très attendu, le dernier opus de The Witcher ne déçoit pas. Développé par CD Projekt RED, il repose sur le REDengine 3, un moteur conçu pour gérer de vastes mondes ouverts, raison pour laquelle il tourne exclusivement en 64-bit. CD Projekt RED s'est associé à Nvidia pour intégrer deux effets gaphique de la suite Gameworks : le HBAO+ et surtout HairWorks. Réponse au TressFX d'AMD, HairWorks améliore la chevelure des personnages, la crinière des chevaux et la fourrure de plusieurs animaux ou créatures rencontrés dans le jeux en faisant appel à un niveau de tessellation très élevé pour chaque brindille. HairWorks est donc très gourmand et Nvidia a ferait en sorte que son implémentation complique le travail d'optimisation d'AMD, ce qui n'a pas manqué de créer la polémique, même si en pratique désactiver cet effet ne dénature pas vraiment le jeu. Nous avons d'ailleurs décidé de le tester avec et sans HairWorks en 1440p. Lors de la moyenne, chacun de ces modes testés se verra attribuer un coefficient de 0.5, de manière à ce que ce jeu n'ait pas plus de poids que les autres. Tous les autres paramètres sont poussés à leur maximum en 1440p alors que nous nous contentons du niveau Medium en 4K. Nous effectuons un parcours bien défini avec Fraps. A noter qu'avec ses pilotes récents, AMD a eu la mauvaise idée de s'attaquer à HairWorks en limitant via ses pilotes sur le niveau de tesselation maximal autorisé dans The Witcher III. Une optimisation que nous avons désactivée pour ce test, même si AMD a probablement des arguments à faire valoir face aux choix techniques de CD Projekt et surtout de Nvidia sur cet effet graphique. [ Sans HairWorks ] [ Avec HairWorks ] Sans HairWorks, la R9 Fury se positionne entre la GTX 980 G1 Gaming et la GTX 980 de référence, mais avec cet effet activé, elle recule derrière la GTX 970 Gaming de MSI. En 4K, sans HairWorks, c'est nettement mieux pour les R9 Fury. Page 22 - Benchmark : Tomb Raider Tomb Raider  Tomb Raider a été l'une des meilleures surprises de 2013. Le rendu graphique est plutôt réussi, AMD ayant collaboré avec les développeurs pour s'assurer d'une version PC de bon niveau. C'est particulièrement le cas pour TressFX, l'option de rendu avancé des cheveux de Lara qui apporte une bonne dose de réalisme. Nous avons testé Tomb Raider en mode de qualité Ultime+ en 1440p qui inclut l'effet TressFX et le niveau de qualité maximal pour les ombres. En 4K, nous désactivons cependant ce dernier et nous nous contentons du mode Ultime classique. Nous avons mesuré les performances avec Fraps, sans utiliser le bench intégré qui correspond plus aux cinématiques qu'aux scènes de jeu classiques. La Radeon R9 Fury X fait ici plus ou moins jeu égal avec la GeForce GTX 980 Ti et la R9 Fury Tri-X devance de peu la GTX 980 G1 Gaming. En 4K, la R9 Fury Tri-X augmente son avance sur la GTX 980 G1 Gaming. Page 23 - Récapitulatif des performances RécapitulatifBien que les résultats de chaque jeu aient tous un intérêt, nous avons calculé un indice de performances en nous basant sur l'ensemble de résultats et en attachant une importance particulière à donner le même poids à chacun des jeux. En 1440p, chacun des deux modes testés pour The Witcher 3 se voit attribuer un coefficient de 0.5. Nous avons attribué un indice de 100 à la GeForce GTX 980 de référence : [ Indice complet ] [ Indice sans Project Cars ] La Radeon R9 Fury Tri-X de Sapphire, cadencée aux fréquences de référence, affiche ici 91% des performances de sa grande sœur, la R9 Fury X. Un écart faible, mais qui se retrouve également avec le modèle inférieur : la R9 Fury Tri-X n'est que 7.5% et 5% plus rapide que les R9 390X de référence et de MSI. Face à la concurrence, et si nous ne prenons pas en compte Project Cars dans lequel les pilotes d'AMD souffrent d'un coût CPU élevé, la R9 Fury Tri-X devance la GTX 980 de référence de 10% et termine en moyenne à peu près au niveau de la GTX 980 G1 Gaming de Gigabyte. Le 4K et ses réglages associés qui réduisent le niveau de qualité sont plus à l'avantage du GPU Fiji, même si les GTX 980 Ti personnalisées restent hors de portée. La R9 Fury affiche toujours 91% du niveau de performances de la R9 Fury X mais l'écart avec la R9 390X de MSI progresse quelque peu : +8.5%. L'avance sur la GTX 980 de référence monte à 16.5% et la GTX 980 G1 Gaming est dépassée de 4%. Page 24 - Fiji XT vs Fiji Pro vs GM200 Fiji XT vs Fiji Pro vs GM200Pour vérifier plus précisément l'écart de performances entre les variantes XT et Pro du GPU Fiji des Radeon R9 Fury X et Fury, nous les avons testées à fréquence égale. Nous avons pour pousser la R9 Fury à 1050 MHz, ce qui nous a permis par la même occasion d'observer ses performances une fois overclockée puisqu'il s'agit de sa fréquence stable maximale. Nous en avons profité pour tester également à 1050 MHz les 2 variantes du GM200 de Nvidia : le GM200-400 de la GTX Titan X et le GM200-310 de la GTX 980 Ti. Comparer deux architectures différentes à une même fréquence est toujours délicat puisque cela revient souvent à supprimer à l'une des puces l'un de ses avantages. Un avantage qui fait partie intégrante du travail et des choix opérés par les différents architectes. Notre curiosité nous pousse malgré tout régulièrement vers ce type de comparaisons tout en gardant en tête qu'il ne faut pas leur donner plus de poids qu'elles n'en méritent. Rappelons que par rapport à Fiji XT, Fiji Pro perd 12.5% des unités de calcul/texturing alors que par rapport au GM200-400, le GM200-310 en perd 8.3%. Par ailleurs, les dérivés de Fiji ont une bande passante de 477 Gio/s à leur disposition alors que les dérivés du GM200 se contentent de 313 Gio/s. [ Ecarts (%) ] [ Performances (fps) ] En moyenne, Fiji Pro n'est que 4.5% en retrait par rapport à Fiji XT et le GM200-310 n'est que 3.5% derrière le GM200-400, ce qui démontre que ces deux GPU ne sont régulièrement limités sur d'autres fronts que leur puissance de calcul. Il s'agit probablement de la bande passante mémoire pour le GM200 et à priori d'autres points pour Fiji. Toujours sur base de notre indice, à fréquence égale, le GM200 a un avantage de 8.6% sur Fiji mais il peut varier énormément d'un jeu à l'autre : par exemple +32% dans The Witcher 3 ou encore +19% dans Battlefield 4. Par contre dans la moitié des jeux testés, les performances sont similaires. Page 25 - Conclusion ConclusionAvec quelques "si" au niveau du timing et des parts de marché, la situation pour AMD et les Radeon R9 Fury aurait pu être totalement différente. Si AMD avait pu écouler tout le stock de son GPU Hawaii l'an passé pour le remplacer par le GPU Fiji et non le proposer en parallèle... Si AMD avait pu lancer son nouveau GPU avant le GM200 de Nvidia et non après… Mais la réalité est plus compliquée pour le GPU Fiji. Au vu du timing de son arrivée et de ses performances dans les jeux actuels, en-deçà des espérances générées par ses spécifications, le positionner par rapport à la concurrence ainsi que par rapport à son prédécesseur est délicat. Un véritable jeu d'équilibriste auquel s'essaye tant bien que mal AMD avec la Radeon R9 Fury. Ainsi, si nous ne concentrons nos observations que sur les GeForce GTX 980, la Radeon R9 Fury ne s'en tire pas trop mal. Elle devance globalement la carte de référence de Nvidia de 8% en 1440p et monte à 17% en 4K. Les résultats restent également corrects face aux GTX 980 overclockées telles que la G1 Gaming de Gigabyte : performances similaires en 1440p et petite avance en 4K. Il est néanmoins logique d'être un petit peu déçu de ne pas voir AMD en faire plus que s'aligner sur le rapport performances/prix d'une solution lancée par Nvidia il y a 10 mois. Mais ce n'est pas là le plus gros problème de la Radeon R9 Fury.  Son plus gros problème c'est le GPU Hawaii. Les Radeon R9 390X et ses petites sœurs sont autant d'épines dans le pied de cette seconde carte graphique conçue autour du GPU Fiji. La R9 Fury n'est que 5 à 10% plus performante qu'une R9 390X alors que son tarif grimpe de 33%, de 450 à 600€, et que sa mémoire vidéo tombe de 8 à 4 Go, ce qui pourrait limiter la durée de vie, notamment pour celui qui envisage de passer au CrossFire par la suite. Et si 4 Go sont suffisants, les R9 290X qui sont toujours sur le marché proposent un rapport performances/prix encore un cran au-dessus. Il y a bien trop peu d'écart entre les différentes solutions haut de gamme proposées actuellement par AMD. Et ce n'est pas le décodeur H.265, principale nouvelle fonctionnalité de Fiji, qui fera passer le surcoût alors que le HDMI 2.0 et le HDCP 2.2 ne sont pas supportés. Si AMD ne tente pas de renforcer l'attrait des Radeon R9 Fury via une tarification plus agressive, c'est probablement parce que la faible production laisse penser que toutes les cartes trouveront preneur sans trop de difficultés. Car au fond, le joueur qui a une préférence pour le camp Radeon et ne jure pas que par le rapport performances/prix sera difficilement déçu par la R9 Fury : en dehors de quelques options récalcitrantes dans certains jeux, elle permet de jouer en 1440p dans d'excellentes conditions.  Et le principal partenaire d'AMD sur ce lancement, Sapphire, est parvenu à très bien maîtriser la bête sur les plans des températures et des nuisances sonores, tout du moins si nous faisons fi du coil whine qui peut venir gâcher la fête. Le ventirad Tri-X de la R9 Fury est probablement le plus efficace à être jamais passé entre nos mains, certes bien aidé par la HBM et un PCB court qui lui permet de gagner en volume et en efficacité. Un ventirad que nous sentons d'ailleurs frustré de ne pas pouvoir s'illustrer en overclocking : face à un GPU Fiji peu coopératif sur ce plan et sans possibilité d'augmenter sa tension il n'a pas vraiment l'occasion de sortir les muscles. L'autre interprétation de la R9 Fury est proposée par Asus dans la gamme Strix. Une solution qui souffre malheureusement de la comparaison avec celle de Sapphire : 50€ plus chère et équipée d'un ventirad nettement moins performant. Pas de quoi changer notre avis global donc : pour séduire un public plus large que les fans inconsidérés de la marque, AMD devra sans aucun doute revoir sa tarification. Mais au vu des faibles volumes de production, il n'est pas dit que cela soit nécessaire… Ce qui d'ailleurs n'est pas une mauvaise chose, une bonne gestion de l'offre et de la demande fait partie des éléments qui permettront à AMD de repartir sur un meilleur pied pour sa gamme de 2016. Copyright © 1997-2024 HardWare.fr. Tous droits réservés. |