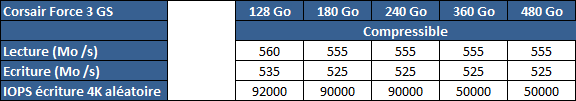

| |

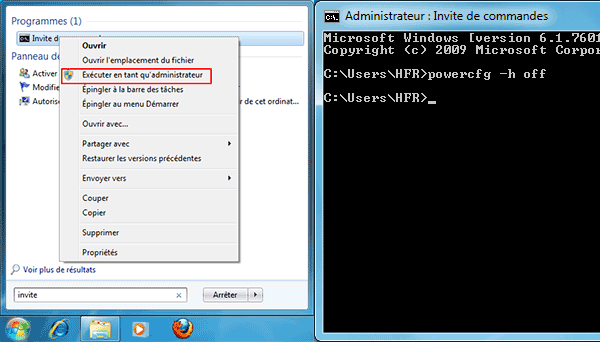

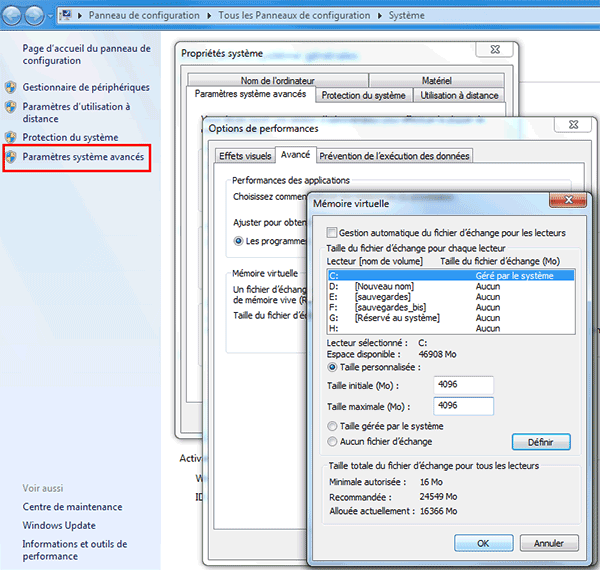

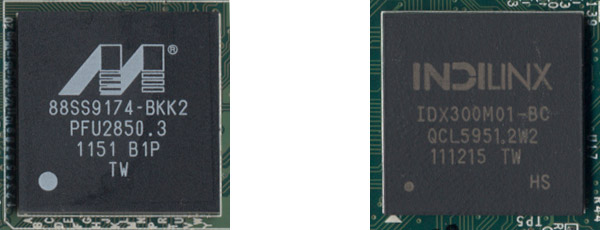

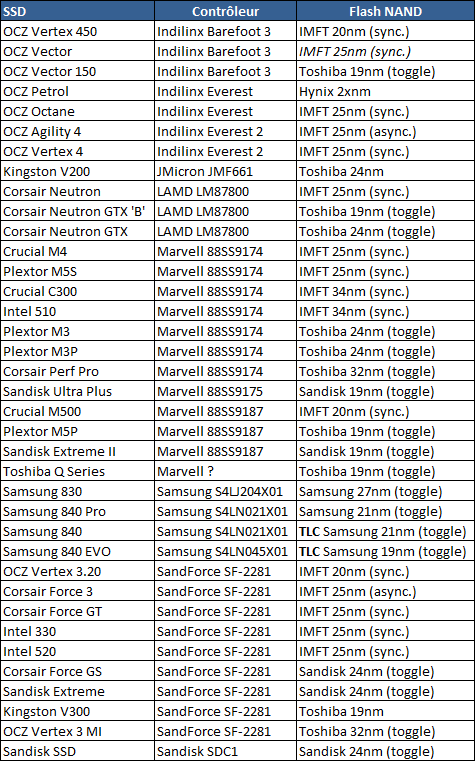

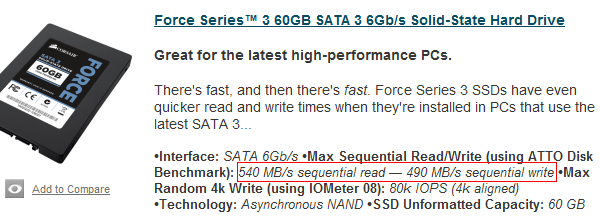

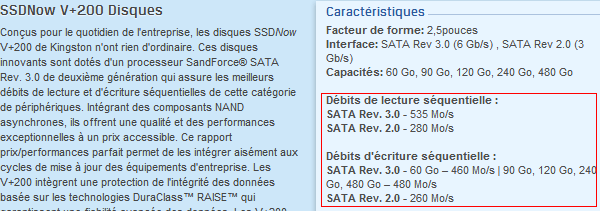

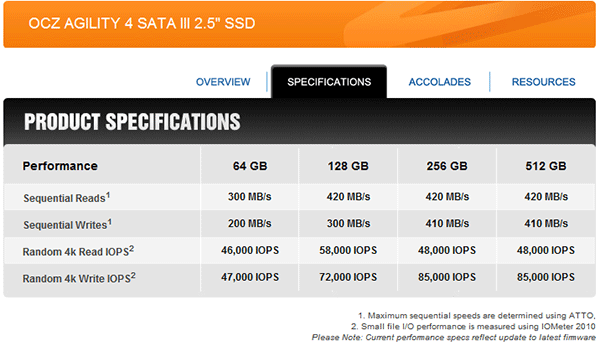

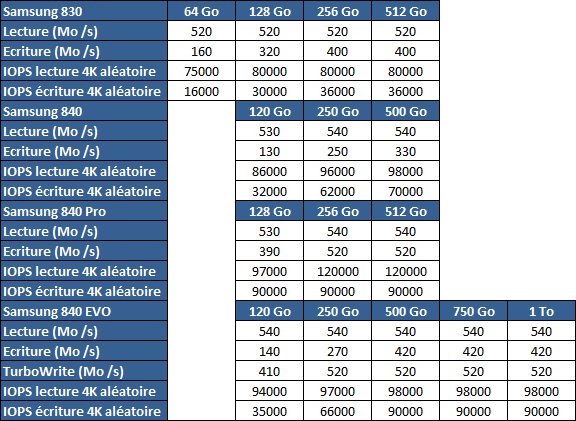

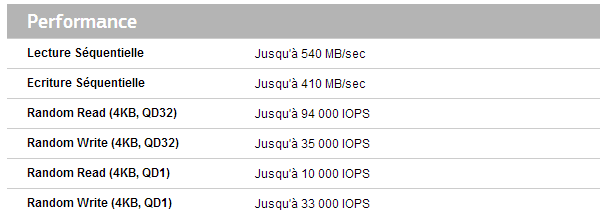

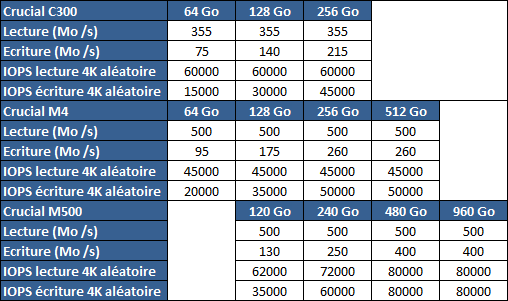

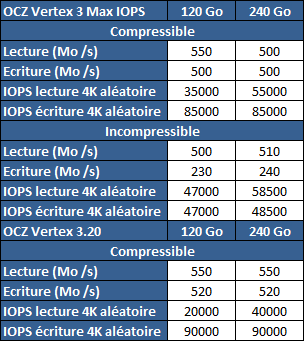

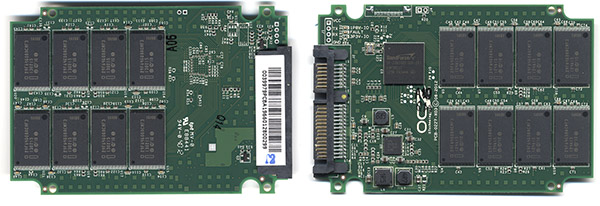

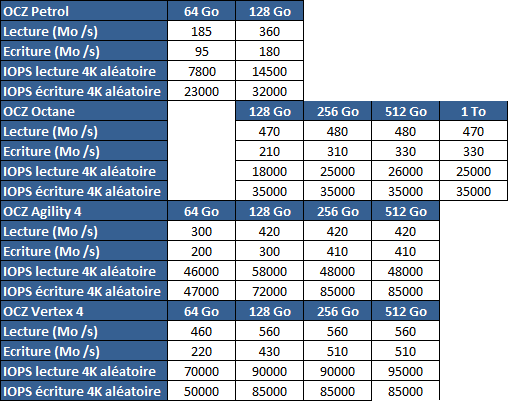

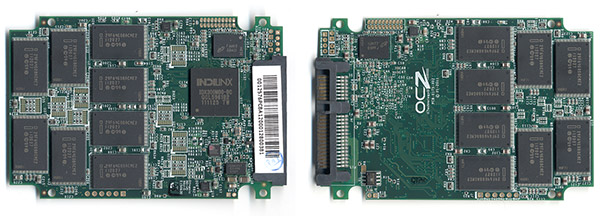

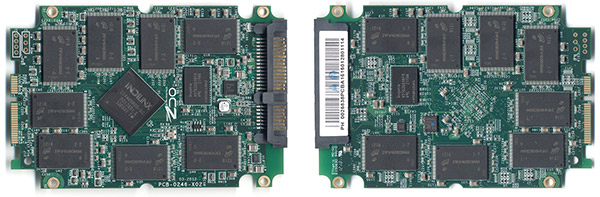

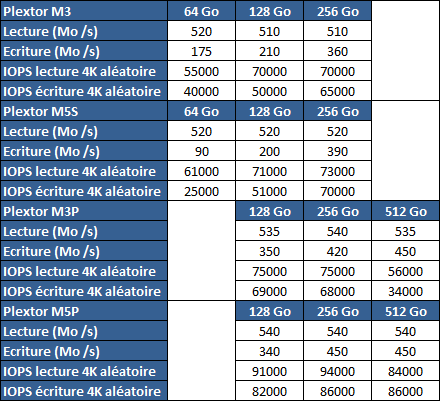

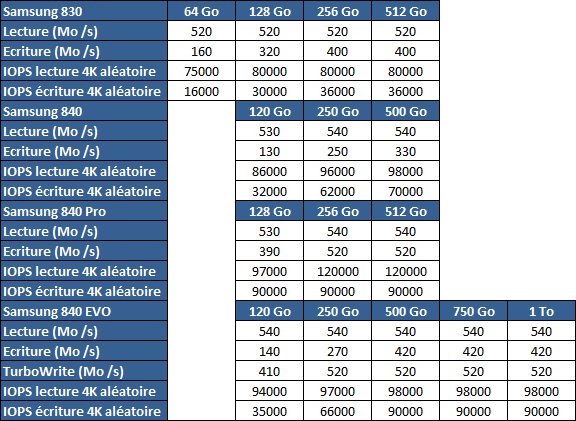

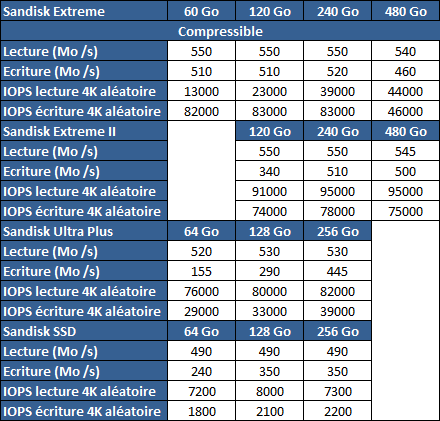

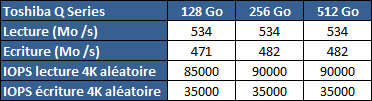

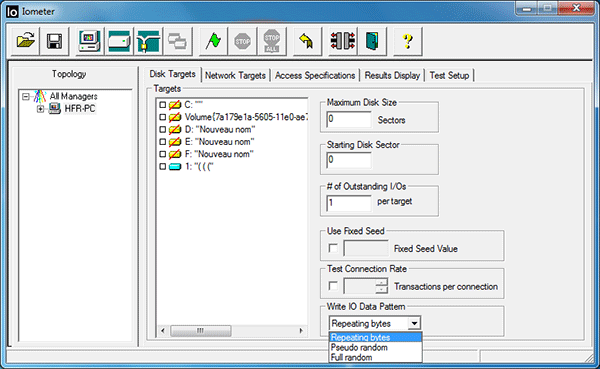

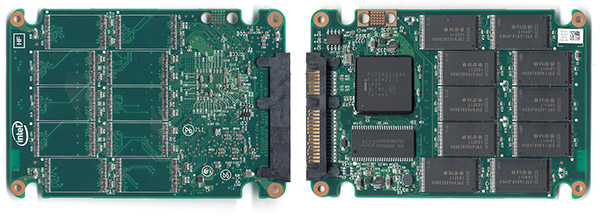

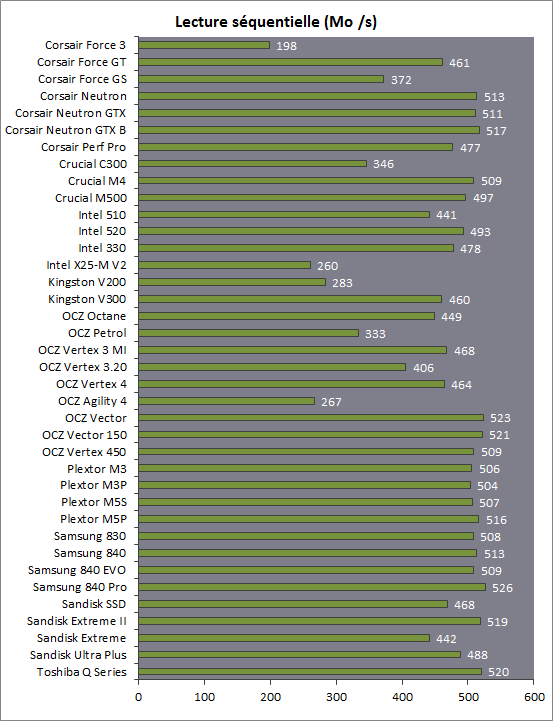

| Comparatif SSD 2012-2013 : 37 SSD SATA 6G 120 et 128 Go StockageSSD Publié le Vendredi 15 Novembre 2013 par Marc Prieur URL: /articles/860-1/comparatif-ssd-2012-2013-26-ssd-sata-6g-120-128-go.html Page 1 - Introduction La dernière mise à jour du 15/11/2013 a ajouté 6 nouveaux SSD détaillés iciEnfin ! Après de longues semaines d'élaboration, voici notre nouveau comparatif de SSD. Pour ce comparatif initialement mis en ligne en 2012 et les mises à jours qui ont suivi, nous avons décidé de nous concentrer sur la capacité phare de 120 à 128 Go et de limiter notre sélection aux SSD offrant une interface SATA 6 Gbps/s. Ce sont ainsi pas moins de 37 SSD qui sont passés sur notre banc de test : - Corsair Force 3 - Corsair Force GT - Corsair Force GS - Corsair Perf Pro - Corsair Neutron - Corsair Neutron GTX - Corsair Neutron GTX B - Crucial C300 - Crucial M4 - Crucial M500 - Intel 330 - Intel 510 - Intel 520 - Kingston V200 - Kingston V300 - OCZ Octane - OCZ Petrol - OCZ Vertex 3 MI - OCZ Vertex 3.20 - OCZ Agility 4 - OCZ Vertex 4 - OCZ Vertex 450 - OCZ Vector - OCZ Vector 150 - Plextor M3 - Plextor M3P - Plextor M5S - Plextor M5P - Samsung 830 - Samsung 840 - Samsung 840 EVO - Samsung 840 Pro - Sandisk SSD - Sandisk Ultra Plus - Sandisk Extreme - Sandisk Extreme II - Toshiba Q Series  Nous profiterons également de ce dossier pour faire le point sur de nombreux aspects de cette technologie. Bonne lecture à tous ! Un SSD, c'est quoi ?Avant toute chose, et pour ceux qui sortent d'hibernation, un petit rappel sur ce qu'est un SSD s'impose. Un SSD (pour Solid State Drive) est un support de stockage constitué de mémoire flash, en opposition au disque dur classique (HDD) qui stocke les données sur des plateaux magnétiques. Les avantages des SSD sur les disques durs classiques sont multiples, tout d'abord en termes de performances, mais aussi de nuisance sonore et de résistance aux chocs. Leur utilisation est transparente pour le système, ils sont adressés comme des disques durs par le contrôleur SATA. Leur désavantage se situe au niveau de la mémoire Flash dont la durée de vie est limitée. Ainsi, une Flash NAND MLC ne peut être écrite que 3 000 à 5000 fois pour celles gravées en 24-27nm, 10 000 fois pour celles en 34-35nm, mais ceci est heureusement compensé par des algorithmes de wear leveling qui répartissent l'usure entre les cellules et qui effacent complètement cette problématique sauf à réécrire complètement le SSD tous les jours, ce qui ne correspond pas vraiment à une utilisation classique. Les puces sont également limitées du côté de la rétention des données, puisque si une cellule neuve est capable de stocker les données 10 ans, arrivée en fin de vie cette durée se limite à 1 an. En pratique et avec maintenant 4 ans de recul sur cette technologie, on peut affirmer que la confiance affichée par les constructeurs dans la fiabilité la mémoire Flash est justifiée. Les nouveautésQuoi de neuf depuis notre comparatif précédent ? Après des débuts en fanfare, le monde du SSD semble s'être grandement calmé puisque les SSD phares de l'époque tels que le Crucial M4 ou l'OCZ Vertex 3 sont encore d'actualité. Bien sûr depuis de nouveaux modèles sont sortis, mais à défaut de pouvoir augmenter les débits en lecture puisqu'on est aux limites de l'interface SATA 6 Gbp/s ils se distinguent surtout par des débits en écriture plus élevés, notamment sur les modèles offrant de plus petites capacités (Samsung 830 et Plextor M3P par exemple). D'autres SSD se sont pour leurs parts concentrés sur les accès aléatoires, atteignant de nouveaux sommets dans ce domaine (OCZ Vertex 4). Les mois passés ont permis également de voir que nul n'était à l'abri d'une faille dans son firmware. En août, Intel a ainsi sorti pour ses SSD 320 un firmware visant à corriger un bug qui rendait le SSD parfois inutilisable en cas de coupure de courant inopinée. En octobre, SandForce a proposé de nouveaux firmware mettant fin aux écrans bleus rencontrés par certains en sortie de veille notamment. En janvier ce fut au tour de Crucial de mettre à jour son M4 contre un bug entraînant un écran bleu chaque heure une fois passé les 5184 heures d'utilisation et de Samsung de mettre en ligne un firmware pour le Samsung 830 corrigeant un souci d'écran bleu en sortie de veille. Attention toutefois, si cette liste peut paraitre alarmiste de prime abord, il faut bien préciser que ces problèmes n'étaient pas systématiques. Bien heureusement, une très grande majorité des utilisateurs profitent de leur SSD sans encombre ! Page 2 - Optimiser son SSD Optimiser son SSD sous WindowsDe multiples guides consultables sur Internet annoncent vous aider à optimiser votre SSD sous Windows. La première chose à faire n'a pourtant rien à voir avec l'OS ni même avec les SSD puisqu'elle s'applique aussi aux disques durs classiques, il s'agit d'activer dans le bios de votre carte mère le mode AHCI du contrôleur Serial ATA en lieu et place du mode IDE classique, ce qui n'est pas forcément le cas par défaut. L'AHCI permet au périphérique de stockage d'optimiser son traitement lors de multiples accès simultanés. Attention, il est préférable de faire cette manipulation avant l'installation de l'OS sous peine d'un écran bleu au redémarrage, mais Microsoft propose toutefois un "Fix It" pour Windows Vista ou 7 qui permet de passer en AHCI sans réinstallation.  En ce qui concerne les optimisations de Windows 7 et 8, il faut bien avoir conscience qu'il a été conçu avec une prise en charge native des SSD et il n'est dès lors pas utile d'effectuer la moindre optimisation pour ce qui est des performances au niveau de l'OS en lui-même. Derrière les "conseils d'optimisations" se cachent une sous-estimation complète de la robustesse des SSD actuels qui sont prévus pour encaisser à minima 20 à 40 Go d'écriture par jour pendant 5 ans, ce qui est très loin d'une utilisation classique qui se limitera généralement entre 5 et 10 Go. Dès lors, chercher à minimiser au maximum les écritures sur ce dernier n'est pas utile, et peut même être contre-productif pour la vitesse globale du système si on déplace certains fichiers temporaires sur un disque dur. De même si l'indexation des recherches par exemple est moins utile sur SSD que sur HDD, une recherche indexée restera plus rapide qu'une recherche classique sur SSD.  Ce n'est par contre pas le cas de Windows Vista qui nécessitera une désactivation de la défragmentation automatique, cette dernière étant contre-productive sur SSD (l'OS n'ayant pas connaissance de l'organisation interne des données sur la Flash) sauf sous Windows 8 ou la défragmentation sur un SSD envoie en fait la commande TRIM pour tout l'espace vierge du SSD. Vista ne supporte pas non plus la commande TRIM en temps réel contrairement à 7 : il faudra donc plutôt s'orienter vers des SSD doté de logiciels permettant de lancer régulièrement un TRIM sur l'espace libre, c'est le cas des Intel Toolbox et de Samsung SSD Magician.  Windows XP pour sa part nécessite en plus que les partitions soient créées manuellement (ou depuis un autre OS plus récent) avec un alignement optimal pour les SSD : avec l'alignement de base la première partition est créée à partir du 63è secteur d'un support de stockage (soit 32.5 Ko), ce qui tombe pile entre deux pages Flash d'un SSD. Une simple écriture de 4 Ko sera à cheval entre deux pages de 4 Ko du SSD, il lui faudra donc écrire ces deux pages. Windows Vista et 7 laissent 2048 secteurs de marge, ce qui permet d'éviter une usure superflue et des performances en berne. Max OS X et Linux  Quid des autres systèmes d'exploitation ? Chez Apple, Mac OS X supporte correctement les SSD, mais la gestion du TRIM intégrée depuis la version 10.6.8 n'est pas active si le SSD n'est pas celui livré par Apple. Trim Enabler permet toutefois de contourner ceci. Linux supporte pour sa part le TRIM depuis la version 2.6.33 du noyau en ext4, mais pour l'activer il faut monter les partitions avec l'option discard. Augmenter la capacité disponible sous WindowsSi Windows 7 et 8 n'ont pas besoin d'être optimisé en termes de performances, leur configuration peut toutefois être modifiée afin de libérer de l'espace sur votre SSD s'il est utilisé en tant que disque système. Deux fonctionnalités peuvent en effet être très gourmandes en espace disque relativement à la taille encore assez réduite des SSD : - Mise en veille prolongée - Mémoire virtuelle La mise en veille prolongée réserve sur le disque un espace en fonction de la taille de votre mémoire vive via le fichier hiberfil.sys, la désactiver permet donc de ne plus avoir ce fichier encombrant à la racine du SSD système. En contre partie vous ne pourrez par contre plus utiliser la veille de type "Suspend To Disk".  Pour supprimer hiberfil.sys, il faut exécuter la commande powercfg -h off en invite de commande La mémoire virtuelle est une zone mémoire située sur le disque système qui peut être utilisée comme de la mémoire vive si cette dernière n'est pas disponible en une quantité assez importante. Bien entendu si on en vient à l'utiliser c'est bien plus lent que la mémoire vive mais cela permet de ne pas avoir de plantage de l'application par simple manque de mémoire. Là encore toutefois Windows réserve de base l'équivalent de votre mémoire vive sur le SSD via le fichier pagefile.sys, et il est tout à fait possible de réduire cet espace réservé.  Pour réduire pagefile.sys il faut personaliser la taille du fichier d'échange en passant par Paramètres système avancés puis le bouton paramètres puis l'onglet avancé puis le bouton Modifier pour la partie mémoire virtuelle (ouf!) Contrairement à ce que beaucoup prétendent, il est impossible de donner une formule magique puisque tout dépend de l'usage du PC. Si vous la réduisez trop et qu'un programme nécessite plus de mémoire que le système ne peut lui proposer, il plantera, mais vu le faible coût de la mémoire les PC sont généralement surdimensionnés en mémoire vive par rapport à leurs besoins réels. Avec 4 Go de mémoire vive en utilisation courante on ne devrait guère avoir besoin de plus de 2 Go de swap et avec 8 Go une taille de 1 Go devrait couvrir la plupart des besoins. Sur un SSD de 64 Go avec 16 Go de RAM - ce qui représente il est vrai un cas extrême - la veille prolongée et le fichier d'échange occupent par défaut 28 Go d'espace ! Page 3 - Les contrôleurs et la Flash MLC et TLC Contrôleurs : Indilinx, JMicron, LAMD, Marvell, Samsung et SandForceCe qui fait le cœur même d'un SSD c'est bien entendu son contrôleur et sa mémoire Flash. Côté contrôleur, on retrouve sur les SSD SATA 6G de ce comparatif différentes puces : - Indilinx Everest : OCZ Petrol et Octane - Indilinx Everest 2.0 : OCZ Vertex 4 et Agility 4 - Indilinx Barefoot 3 : OCZ Vector, Vector 150 et Vertex 450 - SandForce SF-2281 : Corsair Force 3, Force GT et Force GS, Intel SSD 520 et 330, OCZ Vertex 3 Max IOPS, et Vertex 3.20, Sandisk Extreme - Marvell 88SS9174 : Corsair Performance Pro, Crucial C300 et M4, Intel 510, Plextor M3, M3P et M5S - Marvell 88SS9175 : Sandisk Ultra Plus - Marvell 88SS9187 : Plextor M5P, Crucial M500 et Sandisk Extreme II - Marvell ???? : Toshiba Q Series - Marvell 88SS9187 : Plextor M5P, Crucial M500 et Sandisk Extreme II - Samsung S4LJ204X01 : Samsung 830 - Samsung S4LN021X01 : Samsung 840 Pro et 840 - Samsung S4LN045X01 : Samsung 840 EVO - JMicron JMF661 : Kingston V200 - Link_A_Media Devices LM87800 : Corsair Neutron, Neutron GTX et Neutron GTX B - Sandisk SDC1 : Sandisk SSD En ce qui concerne les "puces" Indilinx Everest 1 et 2, il faut préciser que du point de vue hardware pur, il s'agit en fait (encore !) d'une puce Marvell, le 88SS9174 dans le cas de l'Everest et le 88SS9187 derrière l'Everest 2.0. A contraire le Barefoot 3 est bien 100% "maison". Les fréquences d'horloges sont par contre plus hautes et le firmware est par contre entièrement développé par Indilinx. Sachant que c'est bien le firmware plus que le hardware qui est le point clé d'un contrôleur, cela donne en partie raison au choix d'OCZ qui reste tout de même discutable. Ceci est d'autant plus vrai que si pour le contrôleur SandForce les marges de modification au sein du firmware semble plutôt réduites (les implémentations de Corsair, Kingston, OCZ et Sandisk sont semblables), seul Intel l'ayant a priori vraiment modifié, le firmware de Marvell a déjà été largement customisé par Crucial, Intel et Plextor sans pour autant qu'il y ai remarquage.  Du point de vue hardware, tous ces contrôleurs ont en commun d'être basés sur un ou plusieurs processeurs de type ARM pour le traitement de leurs algorithmes de gestion de la Flash. Ils disposent d'une interface SATA 6G pour communiquer avec la machine hôte et gère la mémoire Flash sur 8 canaux (sauf le JMF661 et le 88SS9175 sur 4 canaux), que ce soit avec des bus asynchrones ou synchrones, et à l'exception du JMicron ils peuvent utiliser un codage AES pour sécuriser les données. Si tous ces contrôleurs disposent d'une petite mémoire destinée à stocker le firmware et un minimum de données utilisateurs, respectivement 128 Ko et 64 Ko pour un Everest par exemple, ils font quasiment tous appels à une mémoire DRAM externe qui fait principalement office de cache en écriture et qui peut atteindre une taille de 1 Go sur l'Everest 2.0. Les exceptions sont le SandForce SF-2281, le Sandisk SDC1 et le contrôleur Marvell et employé sur le Toshiba Q Series. Du côté de la gestion de l'usure de la Flash, ils supportent bien entendu tous le wear leveling, un algorithme qui essaie d'égaliser l'usure des cellules Flash au sein du SSD, ainsi qu'une correction d'erreur ECC plus ou moins poussée afin de vérifier l'intégrité des données. Le SandForce SF-2281 est par ailleurs le premier à avoir introduit une technologie dénommée RAISE qui agit en quelque sorte comme un RAID 5 en interne. Une parité est donc calculée et dispatchée entre les die du SSD afin de se protéger de la perte des données en cas de perte d'une partie d'une puce Flash. Cette technologie a bien entendu un petit impact sur les performances et sur la capacité disponible, puisqu'elle grève la capacité de 8 Go sur les SSD l'utilisant. SandForce a depuis été imité par Indilinx qui propose une technologie similaire, RNA, sur l'Everest 2.0... tout comme Marvell qui intègre une fonctionnalité comparable sur le tout récent Marvell 88SS9187 (voilà un indice sur la puce qui se cache derrière l'Everest 2.0 !). Une autre technologie propre à SandForce n'a pas été copiée, il s'agit d'une compression en temps réel des données sur laquelle nous revenons sur cette page. Flash : MLC, TLC, Flash Forward (Toshiba et Sandisk), Hynix, IMFT (Intel et Micron) et Samsung  L'autre partie essentielle d'un SSD c'est bien entendu sa mémoire Flash. De nombreuses combinaisons sont proposées parmi les SSD de ce test, et nous avons essayé d'éviter tant que possible les redites afin d'éviter de faire dans la simple guerre des clones :  Un même contrôleur peut être associé à plusieurs types de NAND. Les premiers SSD SATA 6G utilisaient ainsi de la mémoire 32 ou 34nm fabriquée par IMFT (alliance Intel et Micron) ou Flash Forward (alliance Toshiba et Sandisk), on est depuis passé à de la mémoire 24 ou 25nm puis 20 ou 19nm. Le Petrol d'OCZ est le seul à faire appel à de la mémoire Hynix dont on sait juste qu'elle est gravée en 2xnm (soit entre 20 et 29nm…). Le M5P de Plextor est le premier à avoir fait appel à de la mémoire MLC gravée en 19nm, dont l'endurance est inchangée par rapport à la MLC 24nm Toshiba (officiellement 3000 cycles), il a depuis été rejoint par de nombreux modèles. Côté IMFT c'est l'Intel 335, équivalent au 330 mais qui n'existe pas en version 120 Go, qui est le premier à avoir utilisé la mémoire 20nm du consortium. Il a été rejoint par le Crucial M500, l'OCZ Vertex 3.20 et le Vertex 450. Il faut noter que chez IMFT on trouve deux type de Flash MLC 25nm, l'une certifiée pour 3000 cycles d'écritures, l'autre pour 5000 : Seuls l'Intel SSD 520 et le Kingston HyperX utilisent la 5000 cycles. En pratique toutefois les tests d'usure sur certains SSD tels que le Crucial M4 ont montrés que la 3000 était capable d'aller bien au delà, et dans tous les cas 3000 cycles restent suffisant pour une utilisation classique. Samsung 830 utilise de la mémoire 27nm MLC de sa propre marque sur le 830, alors que le 840 Pro intègre de la MLC 21nm annoncée au même niveau d'endurance de 3000 cycles. A contrario le 840 classique utilise de la TLC 21nm moins endurante puisque limitée officiellement à 1000 cycles d'écriture. La TLC est moins endurante que la MLC car on stocke 3 bits par cellule Flash ce qui correspond à 8 niveaux de tension possible contre 4 en MLC (et 2 en SLC). La programmation de ce niveau de tension est donc plus long ce qui stresse (et use) plus la cellule. L'écriture devant se faire en plusieurs passes, elle est également plus lente. Attention toutefois à ne pas faire dans l'alarmisme inutile, 1000 cycles sont suffisant pour un usage classique : cela correspond par exemple sur un SSD 128 Go à 5 ans et 10 mois avec 20 Go d'écritures par jour et une amplification en écriture assez élevée de trois (et donc 11 ans et 8 mois sur un 256 Go). Le 840 EVO utilise également de la TLC, elle est cette fois gravée en 19nm et les die ne sont plus 8 mais 16 Go (les pages passent aussi de 8 à 16 Ko). Le bus de communication entre la Flash et le contrôleur est également important : ce dernier peut être de type ONFI 1.0 dit asynchrone et limité à 50 MT/s mais aussi en ONFI 2.1 dit synchrone atteignant alors les 200 MT /s. Toshiba, Sandisk et Samsung utilisent de leur côté un bus similaire à l'ONFI synchrone dénommé Toggle. En clair, les mémoires Flash utilisant ce type de bus seront plus rapides, mais les asynchrones seront moins chères. Enfin vous aurez peut-être remarqué que nous avons mis en italique la Flash utilisée dans l'OCZ Vector. Les puces MLC que l'on trouve au sein du Vector ne comportent que le logo OCZ puisque ce dernier achète à IMFT des wafer complet et s'occupe du packaging des puces. L'avantage se situe au niveau du coût qui est moindre, mais on ne pourra se fier qu'à OCZ pour ce qui est du niveau de qualité de puces intégrées. Page 4 - SandForce, compression et débits : attention ! SandForce et compression : attention !Les contrôleurs SandForce sont les seuls à intégrer un algorithme de compression en temps réel. Basique, il permet de minimiser l'impact de certaines écritures sur la Flash, SandForce mettant par exemple en avant que les installations de Windows Vista et d'Office nécessitent 25 Go d'écritures sur le SSD qui sont réduites à 11 Go seulement par leur algorithme. L'intérêt est double, puisque d'une part on "use" moins la Flash, bien que ceci ne soit pas encore un problème vu les endurances actuelles des puces, mais d'autre part on dispose forcément d'un volume de cellules vierges plus importante que sur un autre SSD, ce qui n'est pas négligeable comme vous pourrez le voir en page suivante.  Les "spécifications" du Corsair Force 3 sont illusoires côté débit Le gros défaut de cette technologie et qu'elle complètement détournée par le marketing. En effet la plupart des benchmarks pour disques se contentent d'écrire des suites de 0 ou de 1, ce qui permet à l'algorithme d'être dans un cas optimal et d'afficher des taux de compression de l'ordre de 7 pour 1 alors que quand tout va bien comme dans l'exemple de SandForce on est plutôt à 2 pour 1 et qu'avec des fichiers déjà compressés un minimum (fichiers JPEG, MPEG3 ou MPEG4 par exemple) l'algorithme n'est tout simplement plus fonctionnel.  Même chose chez Kingston pour le V+200 Cela ne fait pas peur aux fabricants de SSD qui mettent fortement en avant les valeurs obtenues dans ces cas irréalistes ou la compression atteint son paroxysme. On peut par exemple voir des SSD tel que le Corsair Force 3 60 Go annoncés à des débits de 540 Mo /s en lecture et 490 Mo /s en écriture. Seul problème, en pratique on en est bien loin et OCZ qui dispose d'un modèle similaire, l'Agility 3, annonce pour sa part 525/475 Mo /s dans ce cas mais aussi 180 Mo /s en lecture et 65 Mo /s en écriture lorsque l'algorithme n'est pas fonctionnel. Plus réalistes, ces chiffres sont clairement moins vendeurs et peu souvent mis en avant, ne vous fiez donc pas forcément aux fiches techniques !  OCZ est plus honnête, mais il faut passer par le datasheet, la fiche produit initial ne fait pas mention du grand écart ! Il est assez simple de calculer le taux de compression réel obtenu par une puce SandForce puisque les informations SMART permettent d'avoir accès au volume d'écriture demandé par l'OS et à celui réellement écrit sur la Flash. On peut en déduire ce qu'on appelle l'amplification d'écriture, c'est-à-dire le ratio entre ce qui est écrit en NAND et ce qui est demandé par le système hôte, un phénomène que tous les contrôleurs cherchent à rapprocher de 1. SandForce avec son algorithme de compression est le seul qui peut amener ce ratio en dessous de 1 dans certains cas : - Benchmark d'écriture séquentielle incompressible : 1.09 - Benchmark d'écriture séquentielle compressible : 0.15 - Copie d'une image de Windows 7 + 3d Studio Max 2011 + Visual Studio 2011 + Bibble 5 Pro + BattleField 3 : 0.76 En écriture séquentielle incompressible, on obtient une amplification d'écriture légèrement supérieure à 1, ce qui est parfaitement normal puisque la compression ne fonctionne pas. Avec un benchmark compressible, là c'est carrément un facteur de 0.15 qui est obtenu (1.5 Go écrits en Flash pour 10 Go d'écritures demandées par le système hôte), ce qui est complètement irréaliste ! Si on copie notre image système de test, les 42 Go n'occupent que 32 Go, une économie de flash de 10 Go qui n'est pas négligeable. Il faut toutefois préciser que sur ses 42 Go, 1 Go sont en fait réservés par pagefile.sys qui est vide et donc très fortement compressible. L'image intègre également 1.55 Go pour le code source pour Visual Studio 2011 et 1.25 Go de photos JPEG pour Bibble 5 Pro. Du coup, entre les mesures compressibles et incompressibles, c'est le grand écart en écriture mais aussi en lecture sur certains SSD. Voyons ce qui se passe sur quelques SSD lorsqu'on lit les données. On distingue trois zones sur ces screenshots : - A : correspond à l'image système précédemment décrite - B : correspond à un fichier de 4 Go très compressible puis un fichier de 4 Go incompressible crées via IOMeter - C : correspond à la zone vierge de donnée du SSD Sur la zone vierge du Corsair Force 3, un SSD SandForce associé à de la mémoire asynchrone, on est maximum théorique avec près de 510 Mo /s. Mais en pratique sur la partition de données on en est loin puisqu'on atteint seulement 272.5 Mo /s en moyenne sur cette zone, avec un minimum à 187 Mo /s et un maximum à 509 Mo /s qui correspond entre autre à la zone occupée par pagefile.sys. Sur le fichier de test compressible on est à 425 Mo /s environ, et à 190 Mo /s sur le fichier incompressible. Sur un Corsair Force GT qui est cette fois associé à de la mémoire synchrone l'impact est bien plus faible dans le domaine de la lecture puisque la moyenne sur la partition de données est de 445,2 Mo /s, avec des variations entre 411 et 512 Mo /s. Enfin sur le Crucial M4 qui n'utilise pas d'algorithme de compression les débits ne varient quasiment pas : 490,6 Mo /s en moyenne sur la partition de données, contre 511.8 Mo /s au maximum sur la zone vierge. Afin de ne pas de ne pas rentrer dans le jeu du marketing des constructeurs de SSD utilisant un contrôleur SandForce, tous les tests de performances synthétiques effectués sur les SSD intégrés à ce comparatif seront effectués avec des données incompressibles. Page 5 - OCZ Indilinx Everest 2 / Barefoot 3 et débits : attention ! Indilinx Everest 2 et débits : attention !Les contrôleurs SandForce ne sont pas les seuls SSD à avoir un comportement qui sort des clous. En effet, l'Indilinx Everest 2 avec ses derniers firmware et le Barefoot 3 intègrent un algorithme permettant dans certains cas de maximiser les performances en écriture. Cette fois le phénomène n'a rien à voir avec le type de donnée que l'on écrit mais plutôt la manière dont le contrôleur va répartir les données au sein de chaque cellule Flash. OCZ est avare en détails sur cette technologie, nos questions s'approchant trop des limites de leur propriété intellectuelle. Soit ! Il ne nous reste plus que la méthode empirique pour essayer de comprendre ce qui se passe. Voici comment réagissent quatre SSD à deux écritures complètes, successives et continues de l'espace disponible pour l'utilisateur, à savoir le Plextor M5P qui fait office ici d'étalon et qui se comporte comme un SSD classique ainsi que les OCZ Vector, Vector 150, Vertex 450, Vertex 4 et Agility 4.

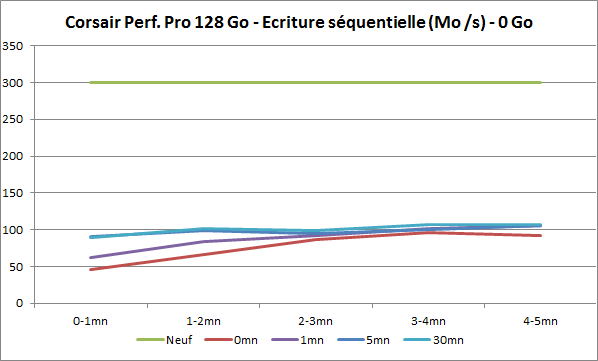

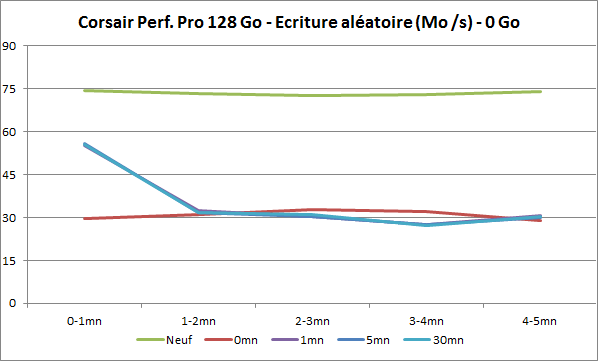

Sur le M5P, le débit est stable tout au long de l'écriture, et équivalent entre la première et la seconde passe. Sur les SSD OCZ c'est loin d'être le cas puisque sur environ la moitié de l'espace disponible on obtient d'excellentes performances, de 400 Mo /s sur le Vector 150 à 260 Mo /s sur l'Agility 4, alors que sur l'autre moitié ces débits sont divisés par 4 ! Sur la seconde passe (sans TRIM dans l'intervalle) les débits sont assez stables, variant entre 157 Mo /s et 201 Mo /s selon le modèle. On notera que la vitesse d'écriture sur le Vertex 4 correspond à celle qui était obtenue avec les premiers firmware. Quelle est donc la nouveauté qui a été introduite par OCZ ? Il convient avant toute chose de rappeler qu'une mémoire flash est composée de transistors possédant une grille flottante. Pour stocker un bit on piège plus ou moins d'électrons dans cette grille par effet de tunnel. Dans le cas d'une mémoire SLC on ne stocke qu'un bit par transistors, seuls deux niveaux de charge sont nécessaires et ils se programment assez rapidement. On stocke par contre deux bits par transistor au sein de la mémoire MLC, ce qui correspond à 4 niveaux de charge. La programmation du bon niveau de charge doit être plus précise et elle nécessite alors plus de passes, moins puissantes et plus longues, ce qui prend plus de temps. Au sein d'une cellule MLC il sera donc plus rapide d'écrire le premier bit que le second, et comme expliqué dans l'article, Characterizing Flash Memory: Anomalies, Observations, and Applications , les fabricants de Flash organisent les pages de la Flash de manière à avoir des pages qui ne correspondent qu'au premier bit, et d'autres qu'au second bit. Les premières sont donc nettement plus rapides que les secondes. L'astuce utilisée ici par OCZ sur les Vertex 4 et Agility 4 est d'utiliser prioritairement les pages les plus rapides au sein des cellules, ce qui correspond à ce servir de la MLC comme si il s'agissait de … SLC ! Mais après avoir écrit la moitié de la Flash disponible, il ne reste par contre plus que des pages Flash lentes correspond aux seconds bits à disposition, d'où l'effondrement du débit. Il ne s'agit pas d'un point de non-retour puisque le firmware profitera de toute période de repos du SSD pour libérer un maximum de pages "SLC". Les données écrites exclusivement au sein de pages "SLC" seront alors réécrites de manière classique sur la Flash, ce qui libérera l'équivalent de la moitié de l'espace Flash disponible pour de nouvelles écritures en mode "SLC". Attention, pour que l'espace Flash disponible corresponde à l'espace disque disponible, il faut pour rappel disposer du TRIM. Pour illustrer ce phénomène nous écrivons 64 Go de données sur le Vertex 4 et le Vector, effectuons une pause de 1, 5 ou 10 minutes puis écrivons de nouveau de manière séquentielle sur les derniers 64 Go disponibles. Les performances lors de cette phase d'écriture sont observées sous l'Analyseur de performances Windows.

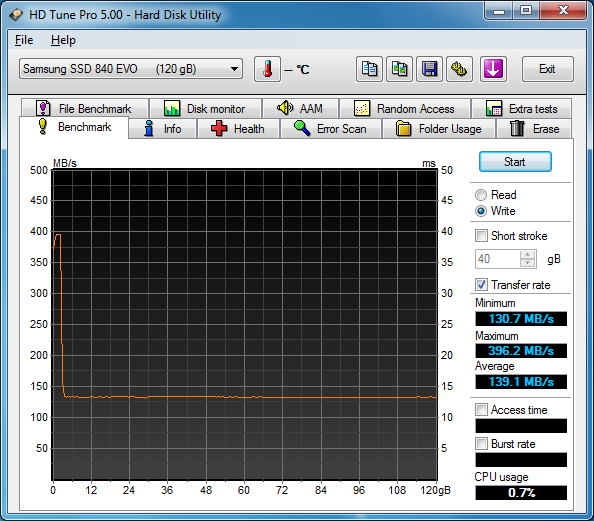

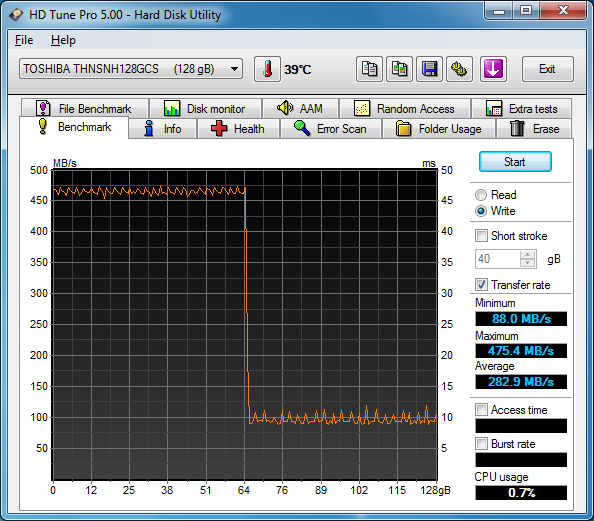

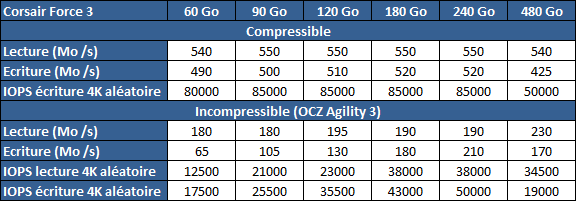

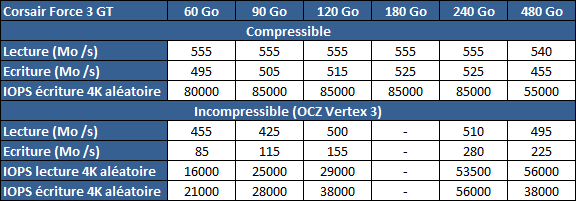

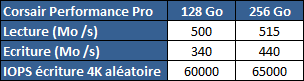

Comme vous pouvez le voir, plus on laisse de temps disponible au SSD, plus il peut consolider les 64 Go écrits précédemment de manière à libérer des pages "SLC" pour les futures écritures. Elle se fait selon nos estimations à environ 200 Mo /s, ce qui correspond à l'écriture en mode standard du Vertex 4. Durant cette période le Vertex 4 consomme environ 3 watts ce qui correspond à sa consommation en écriture classique, alors qu'un autre SSD serait au repos. Sur le Vector, l'algorithme semble moins agressif et le contrôleur ne cherche pas à libérer autant de page "SLC" que possible comme c'est le cas sur le Vertex 4 : il en a moins libéré après 5 minutes, et n'en libère pas plus après 5 minutes de repos supplémentaire. De plus si sur le Vertex 4 nous avons pu voir que ce mécanisme s'enclenchait même si on écrivait ne serait que 8 Go sur un SSD neuf, sur le Vector il ne se produit qu'une fois qu'on a écrit un volume plus important de donnée - 40 à 50 Go environ. Cette technique n'est pas sans conséquence sur l'amplification en écriture et l'usure des cellules Flash. OCZ se gardant de donner des détails, on ne peut faire que des suppositions sur l'amplification en écriture qui en découle. On peut ainsi penser que pour une écriture de 10 Go le SSD va écrire ses 10 Go sur des pages "SLC", puis de réécrire ses 10 Go de manière classique. Cela entraîne donc 20 Go d'écritures, dont 15 sur des pages "SLC", et 10 Go de pages SLC qui seront donc à effacer (contre 10, 5 et 0 sur un autre SSD). Il serait éventuellement possible de réduire cette amplification au dépends d'une fragmentation importante des données, en ne réécrivant que les derniers 5 Go dans les pages correspondant au second bit des cellules encore libres dans les blocs contenant déjà les pages "SLC" utilisés par les 5 premiers Go, mais cela parait peu probable. Et la lecture ?Quid de l'impact sur la lecture ? On commence par HD Tune dans lequel nous lisons tout le contenu du SSD après qu'il ait été écrit une première fois, puis après qu'il ait été écrit une seconde fois. Une nouvelle fois le Plextor M5P fait ici office d'étalon.

Comme attendu, sur le Plextor M5P le débit est stable tout au long de la lecture, et équivalent entre la lecture des deux passes d'écritures. Sur les OCZ c'est bien différent ! Sur la 1ère passe, on peut voir que les données écrites sur les pages "SLC" sont lues assez rapidement, avec des pics sur l'Agility 4 sur lesquels nous reviendront ultérieurement. Mais quand on lit les données écrites sur des pages lentes, les performances baissent : on passe de 480 à 370 Mo /s sur le Vector, 480 à 400 Mo /s sur le Vector 150, 450 à 325 Mo /s sur le Vertex 450, de 400 à 300 Mo /s sur le Vertex 4 et de 250-300 Mo /s à moins de 150 Mo /s sur l'Agility 4 ! Lire les données écrites à l'occasion de la seconde passe laisse par contre transparaître un débit stable et au niveau le plus élevé sur l'intégralité du SSD, exception faite des pics. Revenons sur les pics maintenant observés notamment sur l'Agility 4. Ce SSD est annoncé pour atteindre un débit de 420 Mo /s en lecture, ce qui est particulièrement élevé pour un SSD affublé de mémoire asynchrone. Dans nos tests habituels, vous verrez plus loin dans ce dossier qu'il ne nous a jamais été possible de passer ne serait-ce que la barre des 300 Mo /s. OCZ annonce que ce chiffre est obtenu sous le logiciel de test ATTO, voici les performances que nous avons obtenues : Effectivement, sur un test complet on atteint les 420 Mo /s dès lors que les accès font au moins une taille de 256 Ko. Si ensuite on relance un test en commençant à partir de cette valeur, il faut par contre attendre les accès de 2048 Ko pour atteindre ce débit. Et si on relance en commençant à cette nouvelle valeur, les 420 Mo /s ne sont atteint qu'avec les accès de 8192 Ko. Un comportement on ne peut plus étrange ! Sous HD Tune, si on ne mesure la vitesse en lecture que sur les 10 premiers Go sur un SSD rempli de données, on obtient ces résultats :

Sur le M5P mais aussi sur le Vector, la courbe est stable, alors qu'elle est instable sur le Vertex 4 et surtout sur l'Agility 4.