Nvidia GeForce GTX 660 Ti, Asus DirectCU II TOP, EVGA SuperClocked et AMD Radeon HD 7950 v2 en test

Publié le 17/08/2012 (Mise à jour le 07/09/2012) par Damien Triolet

Spécifications

Tout comme les autres GeForce 600, la GTX 660 Ti ne supporte pas complètement Direct3D 11.1, seules les Radeon HD 7700, 7800 et 7900 supportent le niveau de fonctionnalité 11_1, le plus évolué. Vous pourrez retrouver plus de détails à ce sujet dans notre dossier consacré à DirectX 11.1.

La GeForce GTX 660 Ti est très proche de la GeForce GTX 670, dont elle se différencie par une bande passante mémoire réduite de 25% et par un fillrate qui baisse de 14%. Notez que bien que le nombre de ROP passe de 32 à 24 (soit -25%), la GeForce GTX 670 n'est en réalité capable de débiter que 28 pixels par cycle et non 32, un petit goulet d'étranglement étant présent en amont.

Nvidia ne validant pas tous ses GPU à la même fréquence, leur puissance maximale variera dans une fourchette de 16%, et leur puissance pratique variera en plus de cela suivant la charge GPU et sa température.

La Radeon HD 7950 v2 profite pour sa part d'un gain de puissance de traitement de 6 à 16% sur la Radeon HD 7950 originale, gain qui variera suivant la charge GPU mais sera identique sur toutes les cartes.

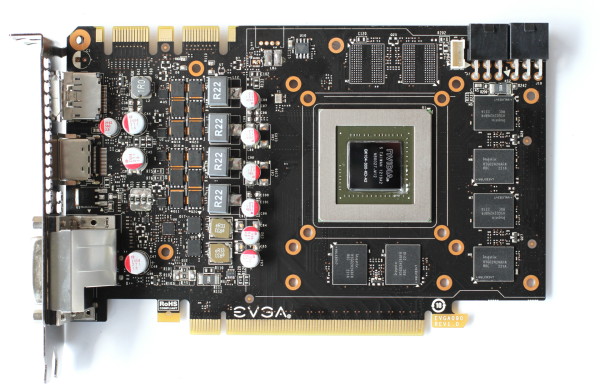

La GeForce GTX 660 Ti de référence

La GeForce GTX 660 Ti de référence est presqu'identique à la GTX 670. Elle est relativement compacte avec 24cm de long et le PCB l'est encore plus puisqu'il se contente de 17.2 cm ! De quoi donner à ces GeForce un design pour le moins original avec une rallonge en plastique à l'arrière du PCB qui permet de rendre la carte suffisamment longue pour accueillir un ventilateur radial, ou turbine.

Avec un TDP de 170W pour la GTX 670 et de 150W pour la GTX 660 Ti (et des consommations de 140 et 134W visées par GPU Boost), Nvidia peut se contenter d'un bloc de refroidissement très basique : un radiateur en aluminium équipé d'un large insert en cuivre à sa base. Un second petit radiateur est placé sur les composants sensibles de l'étage d'alimentation.

Une coque classique referme le tout. La qualité de finition de l'ensemble est plutôt faible, bien en-déca de ce à quoi nous nous attendons pour des cartes de cette gamme de prix. Une partie des exemplaires semblent d'ailleurs souffrir d'un bruit mécanique au niveau du ventilateur ou de son support, un problème que nous avons rencontré sur notre échantillon de GeForce GTX 670.

Pour alimenter le GK104, Nvidia a prévu 4 phases sur son PCB, en plus des deux dédiées à la mémoire GDDR5 Hynix R0C certifiée à 1.5 GHz. La GeForce GTX 660 Ti demande deux connecteurs d'alimentation 6 broches, qui correspondent à une consommation maximale de 225W selon les spécifications PCI Express. En pratique la consommation est nettement inférieure à cela.

Le PCB diffère légèrement de celui de la GeForce GTX 670 au niveau de l'organisation de la mémoire, la moitié des canaux ne pouvant accueillir qu'un seul module au lieu de 2. La configuration maximale sur le PCB de la GeForce GTX 660 Ti est ainsi de 3 Go interfacés en 256 bits contre 4 Go interfacés en 256 bits sur celui de sa grande sœur. Il est du coup impossible de placer 3 Go en 192 bits sur ce PCB pour former cette variante de la GTX 660 Ti, qui reprendra probablement le PCB de la GTX 670. Bien que cela n'ait aucune incidence pour l'utilisateur, nous ne comprenons pas pourquoi Nvidia a organisé ses PCB de la sorte…

La connectique est identique à celle de la GeForce GTX 680 et propose 2 connecteurs DVI Dual Link, un connecteur HDMI 1.4a 3 GHz et un connecteur DisplayPort 1.2.

La fréquence GPU Boost officielle des GeForce GTX 670 et 660 Ti est de 980 MHz pour une fréquence de base de 915 MHz. Nos exemplaires profitaient cependant d'une fréquence maximale respective de 1084 et 1071 MHz. D'après les informations que nous avons recueillies jusqu'ici, cette fréquence maximale pourrait monter jusqu'à 1136 MHz sur les meilleurs exemplaires. En d'autres termes, la fréquence maximale peut être du même ordre que celle d'une GeForce GTX 680, bien que les spécifications de base et GPU Boost officielles soient en retrait par rapport à celle-ci.

Sommaire

1 - Introduction

2 - PowerTune vs GPU Boost

3 - Spécifications, la GeForce GTX 660 Ti de référence

4 - GTX 660 Ti Asus DirectCU II TOP et EVGA SC

5 - Nuisances sonores et température GPU

6 - Relevés et thermographie infrarouge

7 - Consommation et performances/watt

8 - Protocole de test

9 - Benchmark : Alan Wake

10 - Benchmark : Anno 2070

11 - Benchmark : Batman Arkham City

12 - Benchmark : Battlefield 3

13 - Benchmark : Bulletstorm

2 - PowerTune vs GPU Boost

3 - Spécifications, la GeForce GTX 660 Ti de référence

4 - GTX 660 Ti Asus DirectCU II TOP et EVGA SC

5 - Nuisances sonores et température GPU

6 - Relevés et thermographie infrarouge

7 - Consommation et performances/watt

8 - Protocole de test

9 - Benchmark : Alan Wake

10 - Benchmark : Anno 2070

11 - Benchmark : Batman Arkham City

12 - Benchmark : Battlefield 3

13 - Benchmark : Bulletstorm

14 - Benchmark : Civilization V

15 - Benchmark : Crysis 2

16 - Benchmark : DiRT Showdown

17 - Benchmark : Max Payne 3

18 - Benchmark : Metro 2033

19 - Benchmark : The Witcher 2 EE

20 - Benchmark : Total War Shogun 2

21 - Récapitulatif des performances

22 - Performances des cartes Asus et EVGA

23 - Bus mémoire 192-bit : l'impact

24 - Radeon HD 7950 v2 : les gains

25 - Conclusion

15 - Benchmark : Crysis 2

16 - Benchmark : DiRT Showdown

17 - Benchmark : Max Payne 3

18 - Benchmark : Metro 2033

19 - Benchmark : The Witcher 2 EE

20 - Benchmark : Total War Shogun 2

21 - Récapitulatif des performances

22 - Performances des cartes Asus et EVGA

23 - Bus mémoire 192-bit : l'impact

24 - Radeon HD 7950 v2 : les gains

25 - Conclusion

Vos réactions

Contenus relatifs

- [+] 17/10: Nouveau bundle Nvidia: Assassin's C...

- [+] 30/08: Nvidia passe de Splinter Cell à Bat...

- [+] 09/07: Bundle GTX 600/700: Splinter Cell B...

- [+] 06/03: Les Z77A-G45, G43 et 660 Ti PE pass...

- [+] 11/02: Un bundle jeux free-to-play pour le...

- [+] 27/09: 660 Ti AMP! Extreme Edition chez Zo...

- [+] 07/09: Asus revoit le bios des GTX 670/660...

- [+] 07/09: Nvidia GeForce GTX 660 Ti, Asus Dir...

- [+] 22/08: Après la 660 Ti, voici la GeForce 6...

- [+] 20/08: GeForce GTX 660Ti : récapitulatif d...