NVIDIA GeForce 8800 GTX & 8800 GTS

Publié le 08/11/2006 (Mise à jour le 12/02/2007) par Damien Triolet

Les cartes

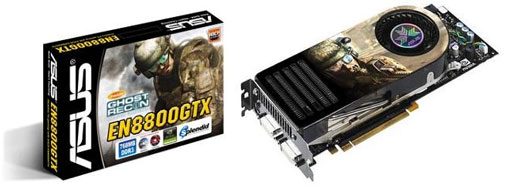

La première carte qui embarque le G80, la GeForce 8800 GTX nécessite une alimentation de 450 Watts et Nvidia parle d’alimentations de 750 à 1000 Watts pour les systèmes équipés de 2 de ces cartes en SLI ! Cette GeForce 8800 GTX emploie un GPU cadencé à 575 MHz (mais avec les processeurs de shaders à 1350 MHz) et de la mémoire 384 bits à 900 MHz, ce qui lui procure une bande passante confortable. Il faudra par contre débourser un peu plus de 650€ pour acquérir ce monstre de 27 cm de long et qui nécessite l’utilisation de 2 connecteurs d’alimentation. Quand au silence, il est de mise même si la carte est un rien moins silencieuse que la GeForce 7900 GTX, référence en la matière. On reste loin de la X1950 XTX cependant.

La seconde carte, la GeForce 8800 GTS utilise un GPU bridé puisque les processeurs de shaders passent de 128 à 96 et les unités de texturing de 32 à 24. Parallèlement, la fréquence du GPU est abaissée à 500 MHz (et 1200 MHz pour les processeurs de shaders) et la mémoire à 800 MHz mais cette fois en 320 bits. La puissance de calcul baisse donc de 33% et la bande passante mémoire de 25% mais le prix devrait cette fois se situer entre 450 et 500 €. Le système de refroidissement est similaire à celui de sa grande sœur, il est simplement un peu plus court. La carte est donc elle aussi silencieuse.

Cette GeForce 8800 GTS nous provient de Galaxy que nous remercions au passage pour nous l’avoir fait parvenir très rapidement. Etant donné que Nvidia fabrique toutes les cartes, elles sont toutes identiques et les partenaires n’ont que très peu de moyens de se différencier, tout du moins au départ. Galaxy nous annonce ainsi l’arrivée prochaine d’une GeForce 8800 GTX équipée d’un système de watercooling Zalman.

Enfin, Asus nous a fait parvenir une seconde 8800 GTX et GTS, ce qui nous a permis de tester le tout en SLI.

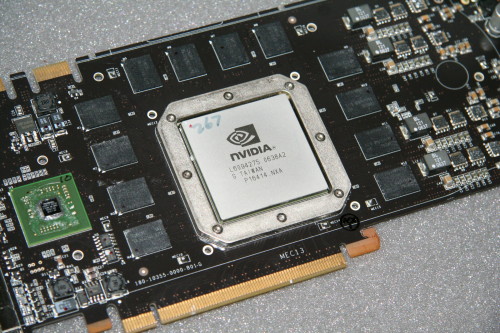

Vous noterez que chaque GeForce 8800 est lié à un chip compagnon, le NVIO (à gauche). Celui-ci prend en charge les entrées et sorties vidéos. Nous ne savons pas réellement pourquoi Nvidia a opté pour cette solution qui à priori est plus coûteuse que l'intégration dans le GPU. Peut-être pour pouvoir faire évoluer celle-ci rapidement sans devoir fabriquer un nouveau GPU ? Pour éviter de devoir acheter des puces Silicon Image ?

Toujours au sujet du PCB un petit détail intéressant : les GeForce 8800 GTS, bien qu'équipées de 640 Mo de mémoire 320 bits peuvent parfois en réalité embarquer 768 Mo de mémoire 384 bits bien qu'une partie de la mémoire ne serve à rien. La raison est qu'il peut être plus simple de ne fabriquer qu'un seul PCB avec tous les emplacements mémoire occupés que de fabriquer une version différente pour chaque ROPs qui a pu être désactivé puisque ce n'est bien entendu pas toujours le même qui pose problème.

ConsommationNous avons bien entendu évalué la consommation des diverses cartes. Ces données sont obtenues à partir des mesures effectuées à la sortie de la prise de courant : il s’agit donc de la consommation totale de l’alimentation de la machine, ici une Enermax 535W. Nous reportons les chiffres obtenus sous le bureau Windows, en charge sous un test de fillrate qui sature les pixel shader avec Prime95 et en charge sous 3DMark05 (GameTest 3) également avec Prime95, ce dernier permettant d’avoir une utilisation processeur constante quelles que soient les performances des solutions graphiques.

Force est de constater que les inquiétudes quant à la consommation de la GeForce 8800 GTX étaient quelques peu exagérées puisque en charge la carte ne consomme pas réellement beaucoup plus que la Radeon X1950 XTX d’ATI. Par contre en 2D Les GeForce 8 sont beaucoup plus gourmandes que les autres cartes. Notez enfin que la nouvelle architecture de Nvidia lui permet plus facilement de ne pas alimenter des circuits inutilisés ce qui est mis en évidence par notre shader qui sature uniquement les unités mathématiques de la puce. Dans ces conditions, sur GeForce 7 la consommation augmente par rapport à 3DMark alors qu’elle diminue dans le cas des GeForce 8.

Sommaire

1 - Le premier GPU DX10

2 - Historique

3 - Architecture GeForce 8

4 - ROPs, DirectX 10, CUDA, le G80

5 - Performances shaders et textures

6 - Performances branchements

7 - Filtrage des textures

8 - Antialiasing

9 - Les cartes, consommation

10 - GeForce 8800 GTS 320 Mo

11 - Drivers, CPU limited, le test

12 - Quake 4, F.E.A.R.

2 - Historique

3 - Architecture GeForce 8

4 - ROPs, DirectX 10, CUDA, le G80

5 - Performances shaders et textures

6 - Performances branchements

7 - Filtrage des textures

8 - Antialiasing

9 - Les cartes, consommation

10 - GeForce 8800 GTS 320 Mo

11 - Drivers, CPU limited, le test

12 - Quake 4, F.E.A.R.

13 - Half-Life 2 Lost Coast

14 - Far Cry

15 - Serious Sam 2

16 - Tomb Raider Legend

17 - Splinter Cell Chaos Theory

18 - Age of Empire III

19 - Oblivion

20 - Pacific Fighters, Colin McRae 05

21 - Need for Speed Carbon

22 - GeForce 8800 GTS : 320 vs 640 Mo

23 - Récapitulatif des performances

24 - Conclusion

14 - Far Cry

15 - Serious Sam 2

16 - Tomb Raider Legend

17 - Splinter Cell Chaos Theory

18 - Age of Empire III

19 - Oblivion

20 - Pacific Fighters, Colin McRae 05

21 - Need for Speed Carbon

22 - GeForce 8800 GTS : 320 vs 640 Mo

23 - Récapitulatif des performances

24 - Conclusion

Vos réactions

Contenus relatifs

- [+] 04/05: Nvidia abandonne son GeForce Partne...

- [+] 27/04: AMD Vega 7nm en labo, Zen 2 échanti...

- [+] 18/04: ASUS AREZ, l'effet GeForce Partner ...

- [+] 10/04: Nvidia : fin du support Fermi et 32...

- [+] 27/03: Pilotes Radeon et GeForce pour Far ...

- [+] 20/03: Pilotes GeForce 391.24 pour Sea of ...

- [+] 20/03: Microsoft annonce DirectX Raytracin...

- [+] 20/03: Radeon Software 18.3.3 beta avec Vu...

- [+] 08/03: 3 millions de GPU vendus pour le mi...

- [+] 08/03: Radeon Software 18.3.1 optimisé pou...