1er LCD à 100 Hz : la mort de la rémanence

Publié le 17/10/2006 par Vincent Alzieu

ConclusionAlléluia, enfin, un énorme progrès dans les jeux ! Hourra pour les 100 Hz, tout du moins celui-ci étant donné les diverses implémentations qui devraient arriver dans les mois à venir. Maintenant, le miracle n’est pas encore complet. Déjà, le rendu dans les films ne nous a pas convaincus. Cette fluidité, cette netteté paraissent paradoxalement excessives. Ce n’est plus un rendu naturel. Pas de chance, ce nouveau système a été implémenté sur un téléviseur. Ce n’est toutefois pas complètement raté pour cet usage : nous apprécions le rendu 100 Hz dans les jeux, dans les retransmissions sportives, dans certaines émissions TV même. Mais dans les films, aucun d’entre nous n’a apprécié.

Dans les jeux en revanche, qu’on soit sur PC ou sur console, les 100 Hz apportent un gain de confort considérable. C’est vraiment mieux avec que sans cette option activée, au point qu’on s’approche vraiment pour la première fois du rendu des jeux sur les écrans à tube.

Maintenant, l’apport est tel qu’on en vient tout de même à se poser une question "toute bête" : pourquoi s’escrimer à interpoler une image pour doubler la cadence et non pas véritablement imposer un support réel des 100 ou 120 Hz en sortie des consoles et / ou des cartes graphiques ? D’accord, aucune console prévue actuellement n’est capable de les tenir, mais nos ordinateurs si. Du moins, ceux qui ont une bonne carte graphique et / ou qui utilisent des jeux pas trop gourmands (en synchronisation verticale si votre carte graphique ne tenais pas les 100 fps vous passeriez directement à 50). Et là, pour l’instant, pas de réponse. Pour cela, il faudrait que les concepteurs des dalles nous répondent directement. Pour l’instant, la question reste en suspend...

Ce passage à un vrai 100 Hz semble d’autant plus utile que la solution actuelle présente au moins un inconvénient : mettons que la carte envoie à 50 Hz les images N puis N+2, et que l’écran calcule tout seul l’image intermédiaire, N+1. Pour établir cette dernière, il faut forcément que le téléviseur stocke en mémoire l’image d’avant (N) ainsi que celle d’après (N+2), ce qui implique surtout de connaître celle d’après (N+2) avant de pouvoir dessiner la N+1. Soit de retarder son affichage.

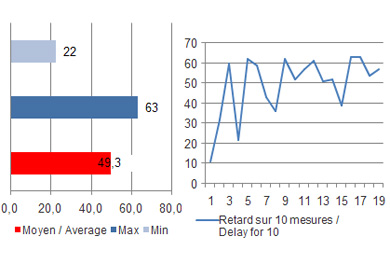

Comme on s’en était rendus compte récemment, les LCD ont déjà une tendance naturelle à accuser un retard sur les moniteurs à tube, là on l’accentue encore volontairement pour se donner le temps de calculer et d’afficher une nouvelle image. Chrono en main, comparé à un CRT placé en mode clone forcément sur prise VGA alors qu’on sortait directement en numérique sur le téléviseur, le retard relevé sur 20 images consécutives était le suivant :

Le retard minimum relevé est de 10 ms : le calcul peut donc être très rapide, surtout dans le cas d’un échec de la création d’une image intermédiaire puisque comme on l’a vu, dès que les changements sont trop complexes l’écran cesse de créer de nouvelles images. Or justement, dans le cas de notre chronomètre affiché sur les écrans, les variations sont trop grandes pour que le téléviseur joue à créer les images tampons.

En revanche, on peut monter bien au dessus comme l’indique le graphique : jusqu’à 60 ms de retard, soit 3 images complètes à 50 Hz. C’est supérieur à la moyenne des écrans précédemment testés. Pour rappel, un moniteur comme le ViewSonic VX922 accuse un retard moyen de seulement 2 ms sur les tubes...

Sommaire

A lire également

Vos réactions

Contenus relatifs

- [+] 11/01: CES: Un écran OLED 4K 21.6 pouces c...

- [+] 10/01: CES: Quatre écrans DisplayHDR en dé...

- [+] 10/01: CES: 7 écrans sur un portable via D...

- [+] 10/01: CES: USB-PD via HDMI Alt-Mode

- [+] 12/12: Vesa lance un standard pour les écr...

- [+] 12/06: Samsung CHG90, 49" 3840x1080 32:9

- [+] 13/04: Dell lance son OLED 4K à 3500$

- [+] 08/04: Des dalles 32:9 et 32:10 chez Samsu...

- [+] 22/02: AOC annonce les AG272FCX et AG322QC...

- [+] 11/02: NEC EX341R : 34" incurvé et UWQHD